Здравствуйте! На связи Максим Кульгин, моя компания clickfraud.ru защищает предпринимателей от ущерба, вызываемого действиями «плохих» роботов. Многие администраторы веб-сайтов настолько напуганы современными сетевыми угрозами, что без разбора готовы бороться против всех средств автоматизированного обхода. Оправдана ли такая глухая линия обороны? Вряд ли.

Существует огромное количество «хороших» роботов, без которых не то что не обойтись, а даже не выжить. Этот небольшой обзор поможет всем, кто ведет деятельность в интернете.

В конце статьи мы посмотрим, почему простое противодействие роботам бесполезно и кроме вреда и головной боли ничего не принесет. А заодно и подскажем: от кого защищаться и как именно.

Начнем с самого простого.

Любой маркетолог скажет, что содержимое сайта должно постоянно обновляться — снова и снова — только так можно заполучить благосклонность SEO (Search Engine Optimization, оптимизация под поисковые системы), а значит, и шанс на внимание со стороны целевой аудитории.

Однако бывает, что сайты содержат сотни и даже тысячи страниц. И что? Привлекать поисковики вручную? Если контента много и он обновляется часто — как гарантировать, что изменения действительно благотворно скажутся на SEO?

Вот тут-то и вступают в игру поисковые роботы! Такой робот прочитает карту сайта, сравнит даты последнего обновления (у себя и на сайте) — и проиндексирует новое содержимое!

Кто-то подумает, что поисковые роботы — это Google Bot, Yandex Bot, ну, может быть, ещё какой-то там bot. На самом деле их очень много! Тот, кто заинтересован в продвижении сайта должен знать о сетевых ботах хотя бы в общих чертах. Зачем? Чтобы использовать в свою пользу!

Здесь мы рассмотрим полный список всех роботов, которые неустанно читают сайты и о которых полезно знать. Но прежде чем нырнуть в мир, который невозможно было бы ни вообразить, ни описать ещё четверть века назад, давайте чуть ближе познакомимся с существами из цифрового мира.

Что такое поисковый робот?

Поисковый робот (их ещё называют ботами, пауками, сканерами, обходчиками) — это компьютерная программа, которая автоматически обходит веб-сайты по найденным ссылкам, читает и анализирует содержимое страниц, составляет краткую сводку для своего сервиса. Если робот работает на какую-то систему, то составление или обновление краткой сводки по веб-странице принято называть «индексацией».

Такой процесс необходим, чтобы пользователи могли мгновенно получать по своему запросу ссылки на нужные страницы из сотен миллионов существующих в интернете сайтов. Как правило, индексация — процесс автоматический, но в некоторых случаях она может быть инициирована и вручную.

Упорядочивание веб-страниц в выдаче, то есть выставление каждой некоторого рейтинга с точки зрения поисковой системы — сложная функция со множеством входных данных, наиболее влиятельные из которых: соответствие запросу, наличие внешних ссылок на страницу, авторитетность ссылающихся ресурсов и многое другое.

Всё это, включая время и труд, затраченные на создание страницы, не будет иметь ни малейшего значения, если поисковый робот на ней не побывает. Именно поэтому так важно не препятствовать роботам. Наоборот надо позволять им совершать обход и встречать как дорогих гостей: робот — друг человека! (Пока…)

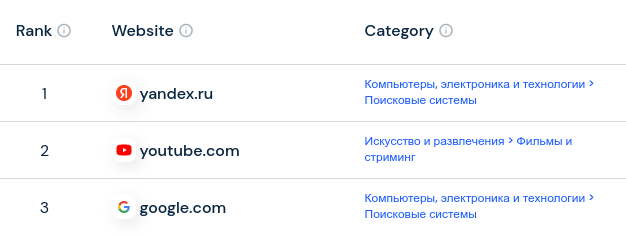

Роботы выполняют свою работу постоянно — это единственный способ поддерживать точность и актуальность информации в постоянно меняющемся интернете. При этом поисковые системы — самые часто посещаемые ресурсы.

Не существует единого поискового робота, который собирает информацию для всех. У каждой поисковой системы, у каждого сервиса — свой собственный неповторимый набор роботов и алгоритмов. Поэтому те, кто создает и поддерживает работу веб-сайтов — разработчики и маркетологи — держат список «хороших» роботов, чтобы беспрепятственно пропускать их к ресурсам, при этом блокируя деятельность «плохих» роботов.

Как действует поисковый робот?

На первый взгляд просто. Рано или поздно он самостоятельно попадет на нужную страницу и проиндексирует её: соберет ключевые слова и фразы, попытается определить тематику, изучит ссылки, по которым пойдет дальше.

Путь робота до каждой веб-страницы очень извилист. Начинается он с известных URL-адресов, с некоторого перечня сайтов, полученного на основе уже собранной информации.

Веб-мастер может контролировать каким роботам какие страницы позволено читать. Делается это с помощью специального файла robots.txt

Этот же файл подскажет: какие страницы и когда обновлялись. А поисковый робот помнит: когда и какие страницы он обрабатывал последний раз. Такая согласованность в обмене информацией благотворно сказывается на эффективности всех участников.

Надо заметить, что инструкциям файла robots.txt подчиняются только послушные, «хорошие» роботы. «Плохие» же роботы, роботы-воры, роботы-скликиватели и прочие попросту проигнорируют файл robots.txt. Это хорошо, что у них нет технической возможности плюнуть в его содержимое и растереть.

В чем отличие роботов?

Различные типы поисковых роботов используются для разных целей. Они отличаются и по стоимости, и по предназначению, и по функциональным возможностям. Условно их можно разделить на три типа:

собственные роботы, созданные разработчиками компании для внутренних задач, таких как аудит и оптимизация;

коммерческие роботы; используются готовые (например, Screaming Frog) или разрабатываются на заказ;

с открытым исходным кодом; бесплатные для использования, создаются различными хакерами и энтузиастами по всему миру.

ТОП-12 поисковых роботов

Не существует универсального робота, одинаково пригодного для любых задач. Вот некоторые из наиболее распространенных на сегодняшний день.

1. Googlebot

Googlebot — универсальный поисковый робот Google, отвечающий за поиск сайтов, которые будут отображаться в одноименной поисковой системе.

Хотя технически существует две разные версии Googlebot (Googlebot Desktop и Googlebot Smartphone), большинство экспертов считают Googlebot одним единственным роботом.

Это обусловлено тем, что оба используют один и тот же уникальный токен продукта (известный как «User Agent», «пользовательский агент»), который фигурирует в robots.txt.

Когда Googlebot работает над сайтом, то производит запросы на чтение раз в несколько секунд (если только его не заблокировали в настройках robots.txt). Резервная копия прочитанных страниц сохраняется в единой базе данных, называемой Google Cache, которая доступна онлайн и позволяет просматривать старые версии сайтов.

Кроме того, Google Search Console — ещё один инструмент, которым с удовольствием пользуются веб-мастера, в том числе и для понимания того, как Googlebot сканирует сайт, а также для поисковой оптимизации страниц.

User Agent: Googlebot

Full User Agent String:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

2. Bingbot

Bingbot был создан в 2010 году корпорацией Microsoft для своей поисковой системы Bing. Нужно гарантировать пользователям актуальность поисковой информации, а для этого необходимо иметь собственный поисковый робот для сканирования и индексации URL-адресов.

Как и Googlebot, Bingbot уважительно относится к предписаниям в файле robots.txt, так что разработчики или маркетологи могут определять: позволительно ли роботу от Microsoft сканировать содержимое сайта или нет.

Однако, в отличие от Googlebot, Bingbot может отличать версии сайтов для мобильных устройств: для чего как раз недавно перешел на новый тип пользовательского агента. Это, наряду с инструментами Bing для веб-мастеров, предоставляет большую гибкость в настройках того, как сайт отображается в результатах поиска.

User Agent: Bingbot

Full User Agent String:

Desktop – Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; bingbot/2.0; +https://www.bing.com/bingbot.htm) Chrome/W.X.Y.Z Safari/537.36

Mobile – Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/W.X.Y.Z Mobile Safari/537.36 (compatible; bingbot/2.0; +https://www.bing.com/bingbot.htm)

«W.X.Y.Z» подразумевают версию Microsoft Edge, например, 100.0.4896.127

3. Yandex Bot

Российским пользователям интернета представлять Яндекс не нужно. По эффективности поиска на русском языке Яндекс часто обходит всех конкурентов.

Yandex Bot — это робот, созданный специально для поисковой системы Яндекс.

Разумеется Yandex Bot подчиняется указаниям файла robots.txt.

Сверх того веб-мастера могут добавлять на страницы специальные теги Яндекс.Метрика — сервис, «который помогает получать наглядные отчеты, записи действий посетителей, отслеживать источники трафика и оценивать эффективность онлайн- и офлайн-рекламы».

Yandex Webmaster имеет много возможностей, которые невозможно осветить в рамках этой статьи.

Поддерживается IndexNow — простой способ для владельцев веб-сайтов мгновенно информировать поисковые системы о последних изменениях содержимого.

User Agent: YandexBot

Full User Agent String:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots)

4. Apple Bot

Несложно догадаться, что Apple Bot создан для индексации страниц, чтобы отдавать максимально релевантные результаты в Siri и Spotlight.

Apple Bot учитывает множество факторов в момент принятия решения о том, какой контент следует предпочесть в предложениях для Siri и Spotlight:

вовлеченность пользователей;

релевантность поисковых запросов;

количество и качество ссылок;

сигналы, основанные на местоположении;

дизайн веб-страницы.

User Agent: Applebot

Full User Agent String:

Mozilla/5.0 (Device; OS_version) AppleWebKit/WebKit_version (KHTML, like Gecko) Version/Safari_version Safari/WebKit_version (Applebot/Applebot_version)

5. DuckDuck Bot

DuckDuckBot — робот для DuckDuckGo, поисковой системы, которая предлагает «бесшовную защиту конфиденциальности в вашем веб-браузере».

DuckDuckBot предоставляет API (Application Programming Interface, программный интерфейс), которым могут пользоваться веб-мастера, чтобы узнать: проиндексировал ли DuckDuckBot сайт и когда. Во время обхода он обновляет свою базу данных, в которой отражены IP-адреса и другие данные о посещенных местах.

Что это дает?

Это помогает выявить любых роботов-самозванцев, вредоносных ботов, которые пытаются выдавать себя за DuckDuckBot.

Вообще, кроме DuckDuckGo кто-нибудь озабочен в той же степени вопросами безопасности, конфиденциальности и сохранности личной жизни пользователей сети? Оставим вопрос висящим в воздухе… (Может его «приземлит» кто-нибудь в комментариях?)

User Agent: DuckDuckBot

Full User Agent String:

DuckDuckBot/1.0; (+http://duckduckgo.com/duckduckbot.html)

6. Baidu Spider

Baidu — ведущая китайская поисковая система, а Baidu Spider — её поисковый робот.

Поскольку Google запрещен в Китае, все кто ориентирован на китайский рынок должны стараться понравиться этой системе, и поискового робота Baidu Spider нужно встречать с распростертыми объятиями, позволяя ему индексировать сайт.

Чтобы идентифицировать Baidu Spider, пришедшего на сайт, нужно искать следующие пользовательские агенты:

baiduspider

baiduspider-image

baiduspider-video

и другие подобные, начинающиеся на baiduspider.

Для тех, кто наоборот — не ведет бизнес в Китае — возможно имеет смысл заблокировать Baidu Spider в файле robots.txt, что предотвратит обход сайта этим роботом, тем самым исключив любую вероятность появления информации на страницах результатов поисковой системы Baidu.

User Agent: Baiduspider

Full User Agent String:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html)

7. Sogou Spider

Sogou — ещё одна китайская поисковая система, которая «первая проиндексировала 10 миллиардов китайских страниц».

Тем, кто ведет бизнес на китайском рынке нужно знать и об этой поисковой системе. Заявляется, что Sogou Spider следует предписаниям robots.txt, в том числе и параметрам задержки обхода. Получать информацию крайне трудно, так как практически вся официальная информация написана исключительно на путунхуа.

Как и в случае с Baidu Spider, тем кому не нужен рынок загадочной и экзотической восточной страны, следует отключить этот робот, чтобы не перегружать сервер понапрасну.

Full User Agent String:

Sogou Pic Spider/3.0( http://www.sogou.com/docs/help/webmasters.htm#07)

Sogou head spider/3.0( http://www.sogou.com/docs/help/webmasters.htm#07)

Sogou web spider/4.0(+http://www.sogou.com/docs/help/webmasters.htm#07)

Sogou Orion spider/3.0( http://www.sogou.com/docs/help/webmasters.htm#07)

Sogou-Test-Spider/4.0 (compatible; MSIE 5.5; Windows 98)

8. Facebook External Hit

Facebook External Hit, также известный как Facebook Crawler, обходит сайты, упомянутые на Facebook. Не следует забывать о том, что социальная сеть Facebook прошла долгий путь деградации, докатилась до того, что стала экстремистской организацией и теперь запрещена в РФ.

Использование собственного поискового робота позволяет Facebook создавать общедоступный предварительный просмотр каждой ссылки, размещенной на платформе. Заголовок, описание и уменьшенное изображение отображаются благодаря произведенному индексированию.

Посещение ссылки роботом должно благополучно завершаться в течение нескольких секунд, иначе Facebook не покажет сформированное содержимое в специальном фрагменте, сгенерированном перед публикацией.

User Agent: facebot

Full User Agent String:

facebookexternalhit/1.0 (+http://www.facebook.com/externalhit_uatext.php)

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php)

9. Exabot

Exalead — компания по разработке программного обеспечения, созданная в 2000 году со штаб-квартирой в Париже. Компания предоставляет поисковые платформы для потребительских и корпоративных клиентов.

Exabot — робот для поисковой системы Exalead, построенной на их продукте CloudView.

Как и большинство поисковых систем, Exalead при ранжировании учитывает как обратные (внешние) ссылки, так и качество контента на веб-страницах. Робот создает «основной индекс» и компилирует результаты, которые и увидят пользователи поисковой системы.

Full User Agent String:

Mozilla/5.0 (compatible; Konqueror/3.5; Linux) KHTML/3.5.5 (like Gecko) (Exabot-Thumbnails)

Mozilla/5.0 (compatible; Exabot/3.0; +http://www.exabot.com/go/robot)

10. Swiftbot

Swiftype — это пользовательская поисковая система для одного веб-сайта. Она сочетает в себе «лучшие технологии поиска, алгоритмы, платформу для приема контента, клиентов и инструменты аналитики».

Этот инструмент заинтересует прежде всего тех, у кого сложный сайт с большим количеством страниц. Swiftype предлагает полезный интерфейс для каталогизации и индексации всех страниц в автоматическом режиме.

Swiftbot — поисковый робот Swiftype. Однако, в отличие от других поисковых роботов Swiftbot обходит только те сайты, которые запрашивают клиенты Swiftype.

User Agent: Swiftbot

Full User Agent String:

Mozilla/5.0 (compatible; Swiftbot/1.0; UID/54e1c2ebd3b687d3c8000018; +http://swiftype.com/swiftbot)

11. Slurp Bot

Slurp Bot — поисковый робот Yahoo, который сканирует и индексирует страницы для этой, некогда самой популярной, поисковой системы.

Обладание собственным роботом необходимо для любой поисковой системы. Yahoo — это не только Yahoo.com, но и партнерские сайты: Yahoo News, Yahoo Finance, Yahoo Sports.

Без качественного поискового робота посетителю не предоставить релевантную поисковую выдачу, а значит, не получить его благосклонность, не продать рекламу, не заработать денег и — в конечном итоге — уйти в архивы истории.

На примере Yahoo видно, что робот — необходимое, но недостаточное условие для удержания успеха. И даже спонсирование фестивалей душевнобольных, свихнувшихся на теме своей половой принадлежности, не помогает обойти конкурентов.

Вернемся к технической составляющей. Правильно проиндексированный контент способствует максимально персонализированной выдаче поисковых результатов. Что в конечном итоге соответствует и интересам пользователя и карманам капиталистов-извращенцев.

User Agent: Slurp

Full User Agent String:

Mozilla/5.0 (compatible; Yahoo! Slurp; http://help.yahoo.com/help/us/ysearch/slurp)

12. CCBot

CCBot — это робот на основе Nutch, разработанный Common Crawl, некоммерческой организацией, специализирующейся на безвозмездном предоставлении копии Интернета предприятиям, частным лицам и всем, кто интересуется онлайн-исследованиями. Бот использует MapReduce — программируемую платформу, позволяющую на основе больших объемов данных получать ценные обобщенные результаты.

Данные Common Crawl могут использоваться для самых разных задач: от совершенствования программ перевода до предсказания трендов. Например, GPT-3 был обучен как раз на одном из таких наборов данных.

Full User Agent String:

CCBot/2.0 (https://commoncrawl.org/faq/)

ТОП-8 коммерческих роботов для профессионалов SEO

Поисковые роботы — не единственные цифровые обитатели во всемирной сети. Данный раздел содержит краткий обзор аналогичных инструментов, которые используют специалисты SEO.

Многие создатели зарубежных коммерческих систем находят время для просмотра телевизора. Что в свою очередь приводит к идее ограничения доступа к своим сервисам для посетителей с российскими IP-адресами.

Проблема обходится довольно легко. Мы писали об инструментах для преодоления неоправданных дискриминационных мер в отношении пользователей с российскими IP-адресами.

1. Ahrefs Bot

Ahrefs Bot — специализированный робот, который компилирует и индексирует базу данных из 12 триллионов ссылок, предлагаемую популярным SEO-сервисом Ahrefs.

Ahrefs Bot ежедневно посещает 6 миллиардов страниц веб-сайтов. Он считается «вторым по активности поисковиком», уступая только Googlebot. Как и многие другие «хорошие» роботы, Ahrefs Bot следует правилам, прописанным в robots.txt.

2. Semrush Bot

Этот робот дает возможность Semrush (один из лидеров рынка продуктов для SEO) собирать и индексировать данные сайтов для дальнейшего использования клиентами сервиса.

Данные используются в общедоступной поисковой системе обратных ссылок Semrush и различных инструментах, таких как: аудит сайтов, аудит обратных ссылок, разные «помощники» по оптимизации контента и созданию перекрестных ссылок.

Как говорит Олег Щеголев, основатель и руководитель Semrush:

— Я съем свою шляпу, если вы найдете другой инструмент, который позволит вам делать все эти вещи:

получать доступ к более чем 24 миллиардам ключевых слов для 130 стран;

проводить углубленный аудит веб-сайта на основе более чем 130 проверок;

получать рекомендации по улучшению контента для повышения рейтинга в поисковых системах;

отслеживать и анализировать веб-сайты конкурентов и маркетинговые стратегии;

создавать и отслеживать свои PPC-кампании;

готовить, планировать и размещать контент в социальных сетях;

создавать и планировать фирменные отчеты.

3. Rogerbot

Rogerbot — это поисковый робот ведущего SEO-сайта Moz. Он специально собирает контент для аудита специалистами кампании Moz.

Поскольку SEO стало важно как никогда, в 2016 году Moz приняли трудное, но необходимое решение отказаться от экспансии во входящий маркетинг и направили всю энергию на то, что по их мнению, получается лучше всего — на поиск.

«Мы вносим значительные улучшения в наши основные продукты — Moz Pro и Moz Local — и продолжаем добиваться прозрачности и четкого понимания всех особенностей в этой сложной области.»

4. Screaming Frog

Screaming Frog — это поисковый робот, который SEO-специалисты используют для аудита и нахождения путей улучшения рейтинга в поисковых системах.

После того как обход запущен, можно просматривать данные в режиме реального времени, выявлять неработающие ссылки, находить места для улучшения, видеть дублирующий контент, замечать отсутствующие или неправильно заданные метаданные и многое другое.

Чтобы настраивать параметры обхода, надо приобрести лицензию Screaming Frog.

5. Lumar (бывший Deep Crawl)

Lumar — это «централизованный командный центр для поддержания технического состояния сайта».

Lumar гордится тем, что является «самым быстрым сканером веб-сайтов на рынке» и может похвастаться способностью сканировать до 450 URL-адресов в секунду.

6. Majestic

Majestic в первую очередь фокусируется на отслеживании и идентификации обратных ссылок для заданных URL-адресов.

Компания утверждает, что обладает «одним из наиболее полных источников данных об обратных ссылках в Интернете».

Поисковый робот сайта делает все эти данные доступными для клиентов компании.

7. cognitiveSEO

cognitiveSEO — еще программный инструмент для SEO, который используют многие профессионалы.

Поисковый робот cognitiveSEO дает возможность пользователям выполнять комплексные проверки сайта, которые могут быть использованы для корректировки архитектуры и определения стратегии SEO.

Робот будет сканировать все страницы и предоставлять «полностью настроенный набор данных», уникальный для каждого отдельного случая. Этот набор данных также будет содержать рекомендации по улучшению с точки зрения других поисковых систем.

8. Oncrawl

Oncrawl — «ведущий в отрасли SEO-поисковик и анализатор журналов» для клиентов корпоративного уровня.

Можно создавать «профили обхода», где дается много параметров для настройки: начальный URL-адрес, ограничения, максимальная скорость и многое другое. Сохранив профиль, легко запустить повторный обход с теми же установленными параметрами.

Защищать ли сайт от вредоносных роботов?

Не все роботы «хорошие». Некоторые из них могут негативно повлиять на скорость отдачи. Другие могут попытаться взломать сайт. Третьи имеют иные злые намерения.

Вот почему важно отличать электронных посетителей и знать как заблокировать доступ для непрошеных гостей.

Для этого придется наверняка предпринимать несколько шагов.

Прежде всего нужно иметь списки «хороших» и «плохих» роботов, чтобы определять: кого пускать, а кого нет.

Зачем робот пришел на сайт? Что ему нужно?

В некоторых случаях злоумышленники хотят вызвать перегрузку сервера и тогда нападают целые полчища роботов.

Но самый распространенный случай — для того, чтобы «скликать рекламу» или как-то иначе исказить статистику посещений.

Как защититься

Первый шаг — определять User Agent, IP-адрес, и на основе этих данных принимать решение о доступе. Возможно придется делать обратные запросы DNS. Это ключевые идентифицирующие факторы, которые связаны с каждым ботом.

Проблема в том, что «плохие» роботы могут мимикрировать под известные роботы поисковых систем. Здесь знание IP-адреса, сопоставление его с оригинальными IP-адресами неподдельных роботов могло бы помочь, но…

По-настоящему зловредные роботы маскируются не под «хороших» или «плохих» роботов, а под человека: воспроизводят движения мышки, нажатия клавиш, неодинаковые паузы между действиями!

Такой робот со стороны сайта выглядит как обычный пользователь, и вычислить врага можно только с помощью изощренных математических методов, недоступных из-за своей сложности практически никому.

Здесь помочь можем только мы, clickfraud.ru. Наши научные разработки оценены правительственными структурами, что позволило нашей компании стать резидентом Сколково и получить государственный грант на дальнейшее совершенствование наших разработок.

Кстати, многие предприниматели даже не подозревают, что их рекламу «скликивают» и они просто теряют деньги. В таком случае можно бесплатно и без всяких обязательств самостоятельно оценить подверженность мошенническим атакам и опробовать наши решения. Имеется и калькулятор потерь.

Расскажите в комментариях свой опыт взаимодействия с сетевыми роботами. Или, наоборот, как вас принимали за одного из таких и как приходилось доказывать, что вы человек.

Ещё я веду телеграм-канал «Русский ИТ бизнес», где без смузи и маркетинговой чепухи рассказываю об изнанке бизнеса.

Комментарии (4)

Pogan

00.00.0000 00:00+4Дорогой автор, Вы явно перепутали конец предложения и конец абзаца. Рябит в глазах, как тельняшка. Ну и милые повторные пассажи про то, как необходимы боты, чуть ли не в каждом разделе. Оцениваю тошноту текста примерно в 8 баллов из 10.

SHOROOP

Вообще, судя по документации (и по опыту), подчиняется не всегда.

Если открыть доку Вебмастера, то сразу же в глаза попадет вот такое примечание:

Думаю, Вы согласитесь, что "разумеется, подчиняется" - уже не слишком соответствует реальности.

Плюс, насколько я помню, боты Яндекса игнорируют Crawl-delay и ориентируются только на настройки в Вебмастере, несмотря на то, что сейчас в документации поддержка директивы заявлена.

atoster

Никакого противоречия не вижу. robots.txt запрещает роботам сканировать сайт, но не запрещает поисковикам показывать страницы. Если поисковик ранее просканировал разрешенную в robots.txt страницу, то он ее может показывать даже после того как вы отредактируете robots.txt.

SHOROOP

Вот из доки Яндекса как раз и не очевидно, касается это ранее просканированных страниц или нет. Я от худшего варианта отталкиваюсь.