Технологии против технологий

Автор: Сергей Вирясов — директор производственного департамента Kokoc.com (Kokoc Group).

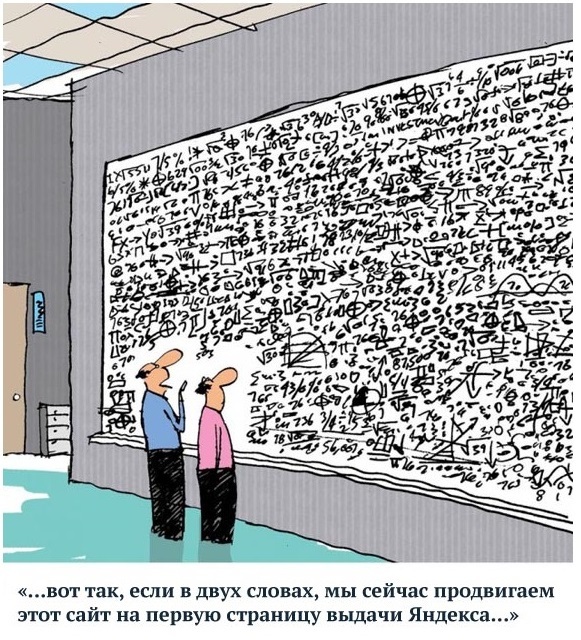

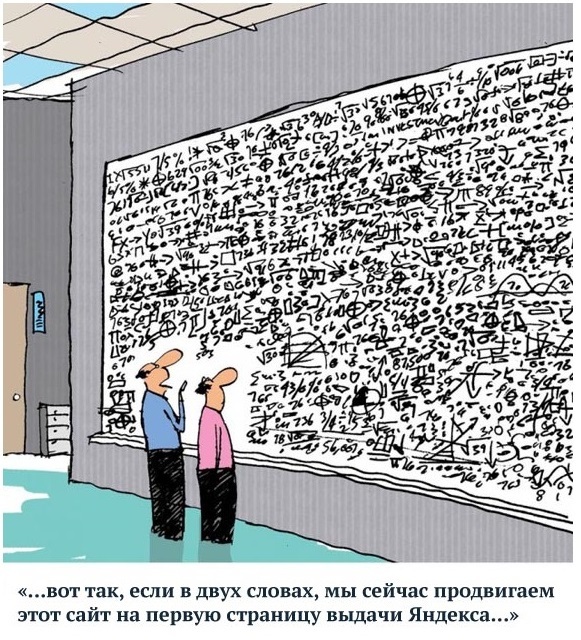

2015 год был тяжёлым для оптимизаторов и их клиентов. «Яндекс» запустил свой «Минусинск» (алгоритм, который находит сайты, покупающие ссылки для продвижения, и ставит их ниже в поисковой выдаче), обновил АГС (один из фильтров, применяемых «Яндексом»). В результате, сайты, покупающие и продающие ссылки, упали на 12-20 позиций в поисковой выдаче по всем запросам. SEO-компаниям пришлось пересмотреть методы работы, в частности — отказаться от ставки на «вечные ссылки».

В долгосрочной перспективе выживут ресурсы, чья оптимизация настроена не на наращивание трафика, а на привлечение клиентов — конвертацию посетителей в покупателей. Тяжело придётся коллегам, которые развивают сайт, добавляя только кнопки, формы и тексты. Это необходимая часть работы, но абсолютно бесполезная, если нет конкретного результата, выраженного в звонках, заказах и покупках.

Сегодняшние SEO-специалисты — неважно, работают они in-house или в агентстве — должны уметь собирать семантическое ядро за две минуты, распределять запросы по страницам за один час, делать текстовый анализ не только по словам, но и по словосочетаниям за 4 часа, оптимизировать сайты под подсказки. При этом специалист должен обладать стратегическим подходом и изначально обозначать точки роста бизнеса клиента.

Сегодня, принимая в работу сайты, мы сталкиваемся с большим количеством ошибок, независимо от того, кто занимался оптимизацией — агентство, фрилансер или штатный специалист. Некоторые недочёты можно исправить, изучив предпочтения пользователей, большинство — с помощью технологий. Мы, Kokoc.com, часто рассказываем о собственных технических разработках, но ещё ни разу не говорили, что это за инструменты и как они работают. Обстоятельства вынуждают нас это сделать сейчас.

Ошибки в сборе семантики

Многие оптимизаторы собирают семантическое ядро вручную, упуская часть запросов или выбирая неэффективные. В таком случае, сайт не продвинется в поисковой выдаче больше, чем на 30-40%. Естественно, заказчиков такой результат не устроит.

Чтобы продвинуть сайт в топ необходимо использовать программы, которые делают это грамотно и быстро. В течение нескольких лет мы разрабатывали собственный инструмент, который содержит более 90 млн запросов по разным тематикам. В итоге на сбор семантики уходит порядка двух минут (плюс проверка качества запросов на соответствие страницам сайта).

В пользу автоматизации этого процесса говорит простой пример: ручная фильтрация 50 000 запросов занимает в среднем два-три дня, а благодаря использованию технологий, наши оптимизаторы тратят на этот же объем один рабочий день. В большинстве своём SEO-компании используют сторонние сервисы для сбора семантики – к примеру, SEMrush или Key Collector. Многие крупные и средние игроки занимаются созданием собственных инструментов, но, судя по результатам, пока это только разработки.

Ошибки в структуре

У многих потенциальных клиентов, которые приходят к нам в работу, существуют проблемы со структурой сайта — не хватает фильтров, тегов и подкатегорий. А значит, пользователи быстро покидают ресурс, потому что не хотят тратить время на поиски нужного товара.

Допустим, в интернет-магазине продаётся 100 холодильников — и все они собраны в одной категории «Холодильники» без дополнительных фильтров. Пользователям это неудобно. Необходимо создавать релевантную страницу под каждый запрос. Так, для фразы «холодильник side by side 40 см» лучше сделать раздел со всеми моделями, подходящими под этот критерий, а не вести на страницу с одним холодильником.

Таким образом, при создании структуры сайта нужно учитывать изменившееся отношение к поиску. Пользователи стали более требовательными, они не хотят просматривать несколько различных страниц сайта, а рассчитывают получить предложение сразу.

В этом случае главный и единственный инструмент оптимизатора — опыт. Чем он богаче, тем быстрее и качественнее будет переработана структура сайта.

Ошибки в распределении запросов по страницам

На ручную обработку запросов уходит много времени. К примеру, чтобы распределить по страницам сайта 700 запросов, придется потратить день. При условии, что сроки всегда поджимают, а клиент требует результатов, оптимизаторы торопятся, качество работы страдает. В результате запросы распределяются кое-как, а это значит, что по многим из них сайт никогда не выйдет в топ поисковой выдачи.

Для экономии времени без потери качества мы создали «Кластеризатор», который делает это автоматически. Если вернуться к примеру с 700 запросами, на их распределение сервису необходим один час.

Большинство SEO-компаний используют для кластеризации запросов те же инструменты, что для сбора семантики. Правда, среди них есть те, кто занимался разработкой собственных сервисов на начальных этапах работы, но дорастить их до полноценных инструментов оказалось затруднительно из-за сложностей масштабирования при увеличении количества клиентов и проектов. На данный момент альтернативные «Кластеризатору» инструменты нам не известны.

Ошибки в текстовой оптимизации

Многие оптимизаторы уверены, что «тошнота» текста не должна превышать 3-5%, считают каждое слово в отдельности и не знают, что делать, если в тексте встречаются словосочетания. К примеру, на слово «холодильник»приходится 3% всего текста. А как посчитать словосочетание «купить холодильник»? Большинство оптимизаторов не могут внятно ответить на этот вопрос. Дело в том, что они пользуются общедоступными инструментами, которые не позволяют считать фразы. При такой работе сайт достигнет в лучшем случае средних результатов.

Мы решаем проблему с помощью собственной разработки – текстового анализатора, который автоматически подбирает релевантные запросу слова и словосочетания и указывает на фразы, которые к нему не относятся. Программа учитывает морфологию, существительные, глаголы, синонимы, части речи, количество точек и запятых. Таким образом, существенно повышается качество текстов с точки зрения поисковых систем, а значит, сайты выше ранжируются в выдаче. Ну и скорость. Вручную этот процесс займёт дни и недели, а текстовый анализатор выполняет работу в среднем за четыре часа.

Подобные инструменты есть у всех крупных игроков рынка. Средние и мелкие агентства проводят текстовый анализ «на глазок», основываясь на собственных ощущениях или пользуются примитивными сервисами — такими, как text.ru.

Работа с подсказками

Многие SEO-специалисты привыкли бороться за высокочастотные запросы, которые приносили клиенту большой объём трафика, но на смену им пришли подсказки. К примеру, когда пользователь начинает вводить в поисковой строке «Яндекса» фразу «купить диван», не дописав последнее слово до конца, он видит на первом месте подсказку «купить диван в Москве». Происходит это потому, что поисковик анализирует подсказки по разным типам запросов и ежеквартально обновляет список, чтобы максимально точно отвечать на вопросы пользователей.

Сегодня всё реже люди набирают запрос целиком — большинство переходит на предложенные поисковиком варианты. И если ресурс не использует возможности этого инструмента, то лишается львиной доли трафика. К примеру, интернет-магазин может находиться в топе по высокочастотным запросам, но трафик будет небольшим и не приведет к росту продаж. Причина, как говорилось выше, состоит в том, что многие пользователи выбирают подсказки, в которых этого интернет-магазина нет.

Сайт необходимо оптимизировать под поисковые подсказки: собрать ключевые слова под каждый запрос, провести кластеризацию и проанализировать существующие (или новые) страницы на предмет распределения по подсказкам. Возьмём простой пример: для анализа 1 млн запросов вручную необходимо несколько недель, и при этом велик риск, что по окончании анализа поисковик уже обновит подсказки. Чтобы не тратить время на этот процесс, мы разработали инструмент, который анализирует тот же объём запросов за две минуты.

Большинство компаний используют SEMrush и Key Collector, но на анализ с их помощью уходит больше суток, и кластеризация происходит некорректно. О качественных аналогах этих инструментов нам не известно.

Подводя итоги произошедших в 2015 году изменений, хочу сказать, что при текущих алгоритмах ранжирования поисковых систем для качественного продвижения сайтов SEO-агентствам необходимо разрабатывать собственные технологии. Оптимизаторам, которые к этому не готовы, придётся тяжело.

Источник: Секрет фирмы.

Автор: Сергей Вирясов — директор производственного департамента Kokoc.com (Kokoc Group).

2015 год был тяжёлым для оптимизаторов и их клиентов. «Яндекс» запустил свой «Минусинск» (алгоритм, который находит сайты, покупающие ссылки для продвижения, и ставит их ниже в поисковой выдаче), обновил АГС (один из фильтров, применяемых «Яндексом»). В результате, сайты, покупающие и продающие ссылки, упали на 12-20 позиций в поисковой выдаче по всем запросам. SEO-компаниям пришлось пересмотреть методы работы, в частности — отказаться от ставки на «вечные ссылки».

В долгосрочной перспективе выживут ресурсы, чья оптимизация настроена не на наращивание трафика, а на привлечение клиентов — конвертацию посетителей в покупателей. Тяжело придётся коллегам, которые развивают сайт, добавляя только кнопки, формы и тексты. Это необходимая часть работы, но абсолютно бесполезная, если нет конкретного результата, выраженного в звонках, заказах и покупках.

Сегодняшние SEO-специалисты — неважно, работают они in-house или в агентстве — должны уметь собирать семантическое ядро за две минуты, распределять запросы по страницам за один час, делать текстовый анализ не только по словам, но и по словосочетаниям за 4 часа, оптимизировать сайты под подсказки. При этом специалист должен обладать стратегическим подходом и изначально обозначать точки роста бизнеса клиента.

Сегодня, принимая в работу сайты, мы сталкиваемся с большим количеством ошибок, независимо от того, кто занимался оптимизацией — агентство, фрилансер или штатный специалист. Некоторые недочёты можно исправить, изучив предпочтения пользователей, большинство — с помощью технологий. Мы, Kokoc.com, часто рассказываем о собственных технических разработках, но ещё ни разу не говорили, что это за инструменты и как они работают. Обстоятельства вынуждают нас это сделать сейчас.

Ошибки в сборе семантики

Многие оптимизаторы собирают семантическое ядро вручную, упуская часть запросов или выбирая неэффективные. В таком случае, сайт не продвинется в поисковой выдаче больше, чем на 30-40%. Естественно, заказчиков такой результат не устроит.

Чтобы продвинуть сайт в топ необходимо использовать программы, которые делают это грамотно и быстро. В течение нескольких лет мы разрабатывали собственный инструмент, который содержит более 90 млн запросов по разным тематикам. В итоге на сбор семантики уходит порядка двух минут (плюс проверка качества запросов на соответствие страницам сайта).

В пользу автоматизации этого процесса говорит простой пример: ручная фильтрация 50 000 запросов занимает в среднем два-три дня, а благодаря использованию технологий, наши оптимизаторы тратят на этот же объем один рабочий день. В большинстве своём SEO-компании используют сторонние сервисы для сбора семантики – к примеру, SEMrush или Key Collector. Многие крупные и средние игроки занимаются созданием собственных инструментов, но, судя по результатам, пока это только разработки.

Ошибки в структуре

У многих потенциальных клиентов, которые приходят к нам в работу, существуют проблемы со структурой сайта — не хватает фильтров, тегов и подкатегорий. А значит, пользователи быстро покидают ресурс, потому что не хотят тратить время на поиски нужного товара.

Допустим, в интернет-магазине продаётся 100 холодильников — и все они собраны в одной категории «Холодильники» без дополнительных фильтров. Пользователям это неудобно. Необходимо создавать релевантную страницу под каждый запрос. Так, для фразы «холодильник side by side 40 см» лучше сделать раздел со всеми моделями, подходящими под этот критерий, а не вести на страницу с одним холодильником.

Таким образом, при создании структуры сайта нужно учитывать изменившееся отношение к поиску. Пользователи стали более требовательными, они не хотят просматривать несколько различных страниц сайта, а рассчитывают получить предложение сразу.

В этом случае главный и единственный инструмент оптимизатора — опыт. Чем он богаче, тем быстрее и качественнее будет переработана структура сайта.

Ошибки в распределении запросов по страницам

На ручную обработку запросов уходит много времени. К примеру, чтобы распределить по страницам сайта 700 запросов, придется потратить день. При условии, что сроки всегда поджимают, а клиент требует результатов, оптимизаторы торопятся, качество работы страдает. В результате запросы распределяются кое-как, а это значит, что по многим из них сайт никогда не выйдет в топ поисковой выдачи.

Для экономии времени без потери качества мы создали «Кластеризатор», который делает это автоматически. Если вернуться к примеру с 700 запросами, на их распределение сервису необходим один час.

Большинство SEO-компаний используют для кластеризации запросов те же инструменты, что для сбора семантики. Правда, среди них есть те, кто занимался разработкой собственных сервисов на начальных этапах работы, но дорастить их до полноценных инструментов оказалось затруднительно из-за сложностей масштабирования при увеличении количества клиентов и проектов. На данный момент альтернативные «Кластеризатору» инструменты нам не известны.

Ошибки в текстовой оптимизации

Многие оптимизаторы уверены, что «тошнота» текста не должна превышать 3-5%, считают каждое слово в отдельности и не знают, что делать, если в тексте встречаются словосочетания. К примеру, на слово «холодильник»приходится 3% всего текста. А как посчитать словосочетание «купить холодильник»? Большинство оптимизаторов не могут внятно ответить на этот вопрос. Дело в том, что они пользуются общедоступными инструментами, которые не позволяют считать фразы. При такой работе сайт достигнет в лучшем случае средних результатов.

Мы решаем проблему с помощью собственной разработки – текстового анализатора, который автоматически подбирает релевантные запросу слова и словосочетания и указывает на фразы, которые к нему не относятся. Программа учитывает морфологию, существительные, глаголы, синонимы, части речи, количество точек и запятых. Таким образом, существенно повышается качество текстов с точки зрения поисковых систем, а значит, сайты выше ранжируются в выдаче. Ну и скорость. Вручную этот процесс займёт дни и недели, а текстовый анализатор выполняет работу в среднем за четыре часа.

Подобные инструменты есть у всех крупных игроков рынка. Средние и мелкие агентства проводят текстовый анализ «на глазок», основываясь на собственных ощущениях или пользуются примитивными сервисами — такими, как text.ru.

Работа с подсказками

Многие SEO-специалисты привыкли бороться за высокочастотные запросы, которые приносили клиенту большой объём трафика, но на смену им пришли подсказки. К примеру, когда пользователь начинает вводить в поисковой строке «Яндекса» фразу «купить диван», не дописав последнее слово до конца, он видит на первом месте подсказку «купить диван в Москве». Происходит это потому, что поисковик анализирует подсказки по разным типам запросов и ежеквартально обновляет список, чтобы максимально точно отвечать на вопросы пользователей.

Сегодня всё реже люди набирают запрос целиком — большинство переходит на предложенные поисковиком варианты. И если ресурс не использует возможности этого инструмента, то лишается львиной доли трафика. К примеру, интернет-магазин может находиться в топе по высокочастотным запросам, но трафик будет небольшим и не приведет к росту продаж. Причина, как говорилось выше, состоит в том, что многие пользователи выбирают подсказки, в которых этого интернет-магазина нет.

Сайт необходимо оптимизировать под поисковые подсказки: собрать ключевые слова под каждый запрос, провести кластеризацию и проанализировать существующие (или новые) страницы на предмет распределения по подсказкам. Возьмём простой пример: для анализа 1 млн запросов вручную необходимо несколько недель, и при этом велик риск, что по окончании анализа поисковик уже обновит подсказки. Чтобы не тратить время на этот процесс, мы разработали инструмент, который анализирует тот же объём запросов за две минуты.

Большинство компаний используют SEMrush и Key Collector, но на анализ с их помощью уходит больше суток, и кластеризация происходит некорректно. О качественных аналогах этих инструментов нам не известно.

Подводя итоги произошедших в 2015 году изменений, хочу сказать, что при текущих алгоритмах ранжирования поисковых систем для качественного продвижения сайтов SEO-агентствам необходимо разрабатывать собственные технологии. Оптимизаторам, которые к этому не готовы, придётся тяжело.

Источник: Секрет фирмы.

Комментарии (3)

thecoder

25.12.2015 15:11+2Лучшее SEO, которое не боится алгоритмов — глубокое понимание предметной области, клиентов, терминологии, болевых точек и использование человеческого подхода к клиентам. Сеошники должны гореть в аду за эти «милионные семантики, распределенные по страницам с правильной перелинковкой». Сначала загадили сайты нечитаемыми текстами, теперь лезут во все дыры со своими базами. Единственное радует, за «4 минуты» и даже за 4 часа вы не найдете узкоспецифичные формулировки запросов и ключей, которые можно написать только будучи глубоко в теме бизнеса и хорошо зная своего клиента. Бизнес в принципе не должен зависеть от seo.

Temmokan

25.12.2015 19:43+3Я так понимаю, ответом на вопрос в заголовке будет примерно вот что: «купите у нас услуги продвижения сайта — узнаете».

Akuma

Так и какой ответ на вопрос «Какое SEO не боится алгоритмов Яндекса»?

Пусть у нас есть мега-крутой сайт, семантическое ядро (пусть собранное самим же яндексом), с великолепными текстами, прекрасной структурой и на этом сайт пользователи проводят каждый по несколько часов. Этот сайт все равно не выйдет в топ просто так. Мы снова завязываем все на проставлении/покупке ссылок.

Ведь так же?