Всем привет! Представляю вашему вниманию новую версию программы SiteAnalyzer, предназначенную для технического аудита и SEO-анализа сайтов (бесплатный аналог Screaming Frog SEO Spider).

В новой версии SiteAnalyzer 2.2 мы постарались добавить несколько давно назревших функций, а также оптимизировать и сделать более удобными некоторые из уже существующих инструментов. Ниже расскажем обо всем поподробнее.

Основные изменения

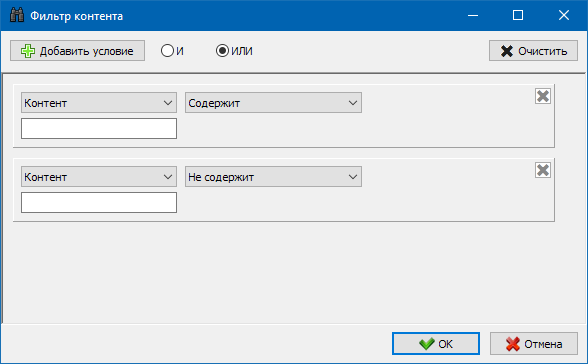

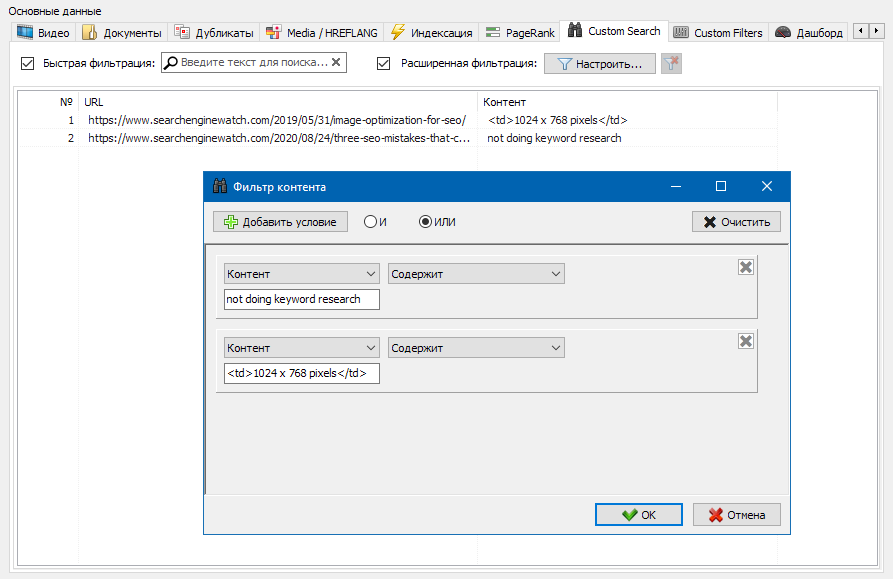

1). Добавлен модуль настраиваемых фильтров для поиска контента на страницах сайта во время сканирования.

По многочисленным просьбам, мы добавили долгожданную функцию поиска контента на сайте, которая позволяет производить поиск по исходному коду и отображать веб-страницы, содержащие искомый контент.

Модуль настраиваемых фильтров позволяет проверить наличие на сайте микроразметки, мета-тегов, систем аналитики, фрагментов произвольного текста либо HTML-кода.

В окне конфигурации фильтра есть несколько параметров для поиска определенных фрагментов текста на страницах сайта, либо, наоборот, для исключения из результатов поиска страниц, содержащих определенный текст либо фрагменты HTML-кода (данная функция аналогична поиску контента в исходном коде страницы по Ctrl-F).

Примечание. Для ознакомления с принципом работы модуля настраиваемых фильтров, можно выбрать пункт «Не содержит» в раскрывающемся списке фильтра и затем ввести название вашего бренда в поле ввода текста. В результате, после сканирования сайта, можно получить список страниц, не содержащих название вашего бренда и проанализировать, по каким причинам данные страницы содержат отличный от основного сайта шаблон.

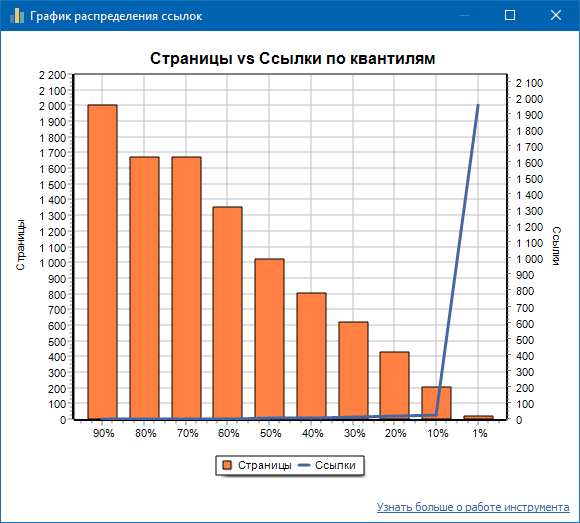

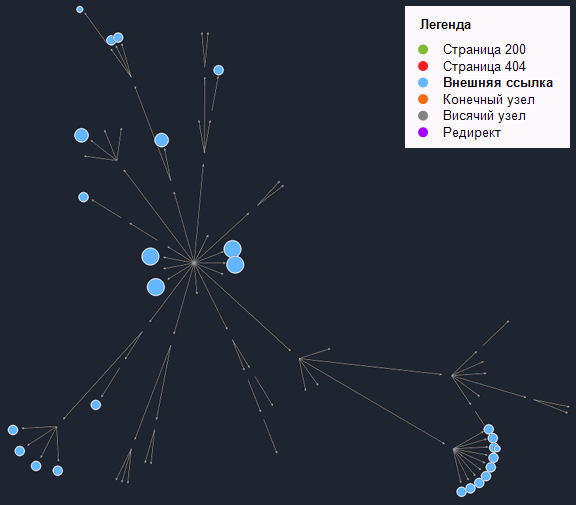

2). Добавлен график распределения внутренних ссылок на страницах сайта.

Данный график показывает распределение внутренней ссылочной массы на страницах сайта (можно сказать, что это визуализация перелинковки в наглядном виде, нежели она представлена на Графе визуализации).

Слева отображено число страниц, справа – число ссылок. Внизу – процентные квантили по страницам. При составлении графика дубликаты ссылок отбрасываются (если со страницы А на страницу Б ведет 3 ссылки, то мы их считаем за одну).

Например, исходя из скриншота выше, для сайта из порядка 70 страниц:

- 1% страниц имеют ~68 входящих ссылок.

- 10% страниц имеют ~66 входящих ссылок.

- 20% страниц имеют ~15 входящих ссылок.

- 30% страниц имеют ~8 входящих ссылок.

- 40% страниц имеют ~7 входящих ссылок.

- 50% страниц имеют ~6 входящих ссылок.

- 60% страниц имеют ~5 входящих ссылок.

- 70% страниц имеют ~5 входящих ссылок.

- 80% страниц имеют ~3 входящих ссылок.

- 90% страниц имеют ~2 входящих ссылок.

То есть, если мы видим, что у нас имеются страницы, на которые ведет менее 10 входящих ссылок, то такие страницы мы можем считать слабо залинкованными, а нормально залинкованных у нас 60% страниц. Исходя из этого, мы можем либо проставить больше внутренних ссылок на эти слабо залинкованные страницы (если страницы важны для продвижения), либо оставить как есть, если подобные страницы имеют малое значение и низкий приоритет.

На общей практике, страницы, имеющие менее 10 внутренних ссылок хуже краулятся поисковыми роботами, в частности, ботами Google.

Поэтому, если вы видите сайт, у которого нормально залинкованных всего 20-30% страниц от общего числа страниц на сайте, то имеет смысл углубиться в настройку перелинковки либо подумать, как поступить с этими 80-70% слабо залинкованных страниц (удалить, скрыть от индексации, поставить редиректы).

Пример слабо залинкованного сайта:

Пример хорошо залинкованного сайта:

Более подробно с описанием работы графика распределения внутренних ссылок можно ознакомиться в разделе Документация.

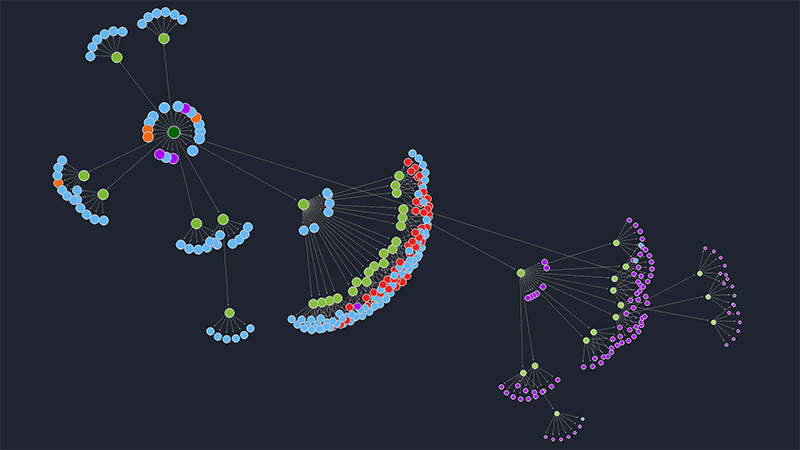

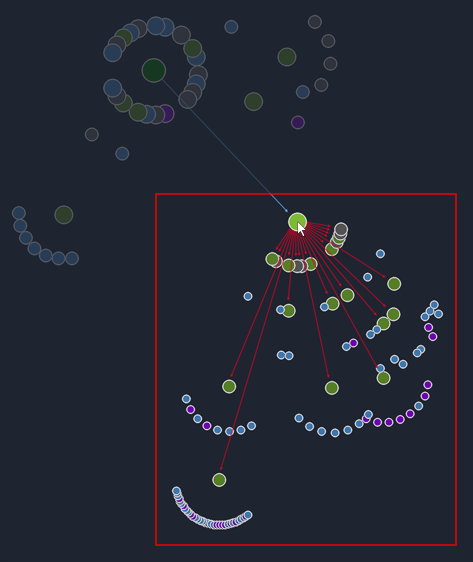

3). Оптимизирована работа с графом визуализации.

- При перетаскивании узлов графа добавлен пропорциональный перенос дочерних элементов.

- При выборе узла на графе, входящие и исходящие ссылки стали окрашиваться разными цветами для большей наглядности.

- Добавлена интерактивность в блок легенды графа визуализации: при клике на элементы легенды, на графе выделяются соответствующие узлы.

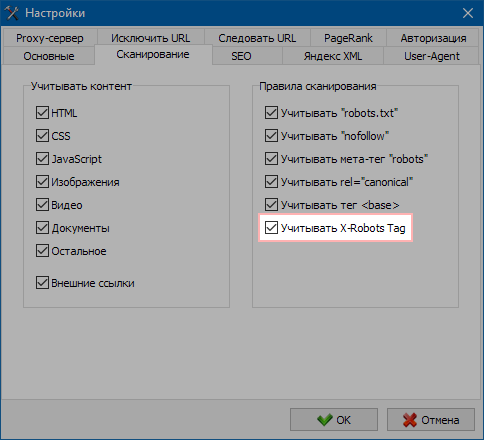

4). Добавлен учет заголовка "X-Robots Tag" при сканировании сайтов.

Появилась возможность отключать либо включать учет параметра "X-Robots Tag" в настройках программы при сканировании сайта, так как ранее он лишь отображался в статистике.

Примечание: заголовок X-Robots-Tag входит в HTTP-ответ для определенного URL. В заголовках X-Robots-Tag поддерживаются те же директивы, что и в мета-тегах robots. Любая директива, которая может использоваться в мета-теге robots, может быть указана в X-Robots-Tag.

Прочие изменения

- Оптимизирован парсинг заголовков H1-H6, использующих классы.

- Устранено зависание программы в конце сканирования на больших проектах.

- В разделе дубликатов Description исправлено некорректное отображение статистики.

- Исправлено некорректное отображение статистики страниц с кодом ответа 404.

- Для страниц, заблокированных в Robots.txt, теперь отдается код ответа 600.

- Параметр "Время отклика" стал рассчитываться более корректно.

- Исправлена не всегда корректная верстка карты сайта Sitemap.xml.

- Редиректы стали отображаться более корректно.

- Сортировка по URL стала более логичной.

ПС. Буду рад любым замечаниям и предложениям по улучшению функционала программы.

rudinandrey

Хорошая программа, просто хотел сказать Вам большое спасибо!!! единственно, там есть отчет, в котором показывается сколько ошибок, там дубликаты H1, description и я не понял, как можно их все найти, т.е. списком можно ли их увидеть, именно страницы, на которых есть эти ошибки?

Hidadmin Автор

Спасибо, стараемся!

По дубликатам: такое впечатление, что отвалился подсчет дублей :(

Исправим в ближайшие дни.