С каждым годом растет объем информации, генерируемой человечеством. Ее нужно как-то обрабатывать, хранить, анализировать. А значит, нужны центры обработки данных, которых тоже становится все больше. Их строят повсюду, причем не только на суше, но и на воде, в виде плавучих платформ. Есть даже подводные ЦОД, хотя они пока что работают в качестве тестовых объектов.

Все дата-центры объединяет одно — им нужны вода, электричество, сетевая инфраструктура и прочие ресурсы. Поэтому строить ЦОД можно далеко не везде. В некоторых случаях в качестве строительства выбирают места, где уже есть какие-то сооружения, их модифицируют и размещают внутри оборудование. Либо же комбинируют системы дата-центра с другими системами — например, заводов, фабрик, ферм. Вот о таких объектах сегодня и поговорим.

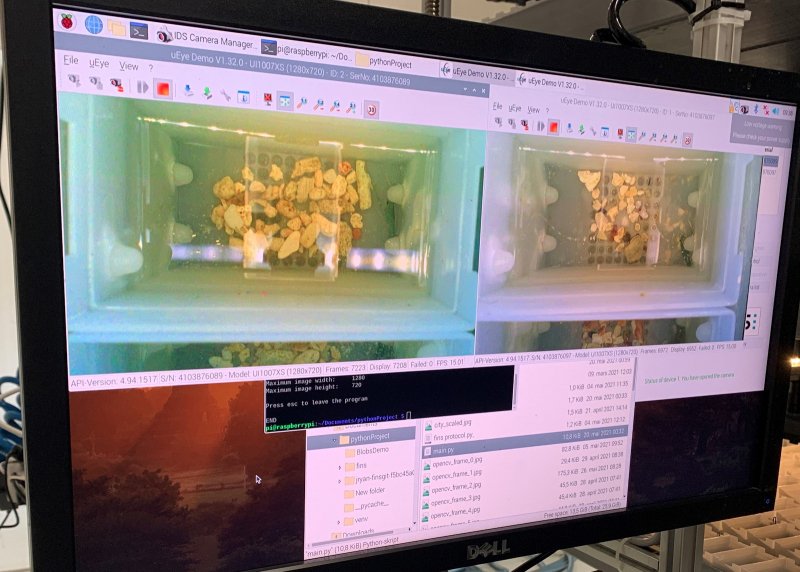

Обогрев фермы для омаров в Норвегии

Похоже, что сотрудники дата-центра пригласили омара на пивную вечеринку

Реализация этого проекта стартовала буквально на днях. Оператор дата-центров Green Mountain заключил договор с фермой по выведению омаров Norwegian Lobster Farm. Большинство видов омаров — теплолюбивые, а значит, ферме нужно либо располагаться в регионе с высоким уровнем инсоляции, либо подогревать водоем, где живут подопечные.

Норвежцы выбрали второй вариант. Согласно условиям договора, ферма будет получать тепло из ЦОД DC1-Stavanger. Конечно, не бесплатно, но, во всяком случае, стоимость получаемого тепла будет низкой. Во всяком случае, ниже, чем если бы пришлось тратить дорогое электричество или другие ресурсы на обогрев водоема.

Ферма, к слову, очень продвинутая, на ней используются современные технологии, включая компьютерное зрение, мониторинг каждого ракообразного и роботы, которые выполняют технические работы. Тепло, поступающее от дата-центра, будет использоваться для нагрева воды до температуры в 20 °С.

DC1-Stavanger расположен в относительно удаленном от населенных пунктов регионе, поэтому пустить тепло на обогрев домов не получится. Так что радоваться теплой воде будут исключительно обитатели фермы.

Tomorrow Water Project — ЦОД на отстойниках

Это проект компании Tomorrow Water, оператора очистных сооружений. Вероятно, девизом проекта можно сделать что-то вроде «Данные не пахнут». И действительно, очистные сооружения в большинстве своем отлично подходят для размещения ЦОД, больших и малых. У них несколько преимуществ:

- Строятся они, как правило, рядом с населенными пунктами.

- Рядом много воды, есть энергетическая инфраструктура.

- Несмотря на близость к населенным пунктам, во многих случаях вокруг очистных сооружений есть место для возведения дополнительных зданий.

- Современные технологии позволяют снизить объем полезного пространства, занимаемых такими сооружениями, что позволяет разместить больше оборудования в ЦОД.

Отдельные проекты дата-центров, стоящих около очистных сооружений, существуют (один такой проект реализован Microsoft лет 10 назад). Но это, как правило, не очень большие объекты. Компания Tomorrow Water стремится развивать концепцию «ЦОД на очистных сооружениях», и проводит собственные тесты. Максимальную площадь обычно занимают отстойники. Компания Tomorrow Water заменяет их системами биофильтрации, которым требуется на 80% меньше пространства. А на освободившейся территории строят разного рода сооружения. В 2017 году в Сеуле был построен музей, здание которого довольно велико.

Сейчас Tomorrow Water привлекает к своей инициативе операторов дата-центров. Компания предлагает партнерам поучаствовать в модернизации отстойников, в обмен на полезную площадь, воду и, соответственно, охлаждение. На призыв компании уже откликнулись компании из Калифорнии, США и Сингапура. В этих регионах вода и полезная площадь в дефиците, так что подобные проекты могут стать для операторов ЦОД идеальным вариантом.

Дата-центр рядом с терминалом СПГ

Речь идет о проекте, где система охлаждения дата-центра совмещена с терминалами по обработке сжиженного природного газа. Несмотря на вроде бы опасную идею (горючий газ и дата-центр как-то не очень сочетаются), проект такой системы обсуждается вот уже несколько лет. Дело в том, что терминалы СПГ, если не учитывать их опасность, являются идеальным вариантом для систем охлаждения. Во время регазификации происходит сильное охлаждение газа. И этот холод можно использовать для охлаждения дата-центра.

Кроме того, во время разжижения газа терминалу нужно тепло, которое способны поставлять дата-центры, причем в огромных количествах. Комбинация системы охлаждения ЦОД и терминала СПГ — неплохой вариант.

Сейчас его прорабатывает национальный университет Сингапура (NUS) и компания Keppel. Согласно планам, размещаться новый дата-центр будет на базе Singapore LNG Corporation (SLNG) на острове Джуронг. Проект поддерживает правительство Сингапура в рамках программы Green Data Centre Research Programme. В общем, если у проекта столько участников, возможно, он не такой уж и сумасшедший, как может показаться.

Плавучий дата-центр от Nautilus

Компания в начале года запустила свой дата-центр Stockton I. Сейчас он пришвартован в порте Стоктон, штат Калифорния, США. Это уже полностью функционирующий инфраструктурный объект, а не баржа с нагроможденным на ней оборудованием.

По словам инженеров, разрабатывавших плавучий ЦОД, срок его службы достаточно большой при условии надлежащей эксплуатации — десятки лет. Системы охлаждения размещаются под палубой, а сетевое оборудование и вся остальная периферия — на палубе, в специальной надстройке.

Что касается энергопотребления, то оно ниже, чем у обычных ЦОД, благодаря воде. Ее не нужно качать по трубопроводам издалека, энергопотребление ДЦ ниже, чем у стандартного объекта аналогичной мощности. У плавучего дата-центра PUE составил 1,15. По расчетам, проведенным специалистами по охране окружающей среды, негативное влияние объекта на окружающую минимально. Локальная и тем более глобальная экосистемы не пострадают.

Забортная вода пропускается через сложную систему трубопроводов из нержавеющей стали. Система также включает турбинные насосы, теплообменники, клапаны и прочие элементы. В минуту система прокачивает около 17 000 литров воды, при необходимости этот объем можно увеличить до 45 000 литров.

Что касается мощности, то она превышает 100 кВт на стойку, а общая мощность дата-центра достигает 7 МВт. Общая площадь для размещения оборудования составляет около 90 м2.

ЦОД на форелевой ферме

Кроме омаров, занимаются операторы ЦОД и выращиванием форели. Конечно, не сами, а при помощи партнеров. В 2021 году компания Green Mountain, довольно крупный оператор ЦОД и компания Hima Seafood заключили партнерское соглашение. Его суть — предоставление тепла дата-центром DC2-Telemark в Рьюкане, Норвегия форелевой ферме, принадлежащей Hima Seafood. Эта ферма — самая большая в мире.

Тепло направляется на обогрев водоемов с рыбой. Форель не очень любит тепло, но все же в условиях промерзающих резервуаров она существовать не может. Поэтому тепло от дата-центра обеспечит постоянный микроклимат в водоемах с форелью. К 2023 году объем поставляемой партнерами рыбы составит около 9000 тонн в год.

Дата-центр построил систему трубопроводов, по которым нагретая вода идет к резервуарам, охлаждается и возвращается в систему охлаждения ЦОД. Стоит отметить, что этот же дата-центр получает энергию от возобновляемых источников — прежде всего, микро ГЭС.

Дата-центр и ТЭЦ

В г. Фалун, Швеция, ЦОД построен рядом с местной теплоэлектроцентралью. ТЭЦ сжигает древесные отходы промышленности, так же здесь производятся пеллеты (древесные гранулы), которые используются шведами в качестве топлива для отопления домов.

Дата-центр, который получил название EcoDataCenter, получает энергию от этой ТЭЦ. Генерируемое тепло он отправляет для сушки пеллет, которые производит ТЭЦ. В год получается около 10 МВт тепловой энергии, чего достаточно для сушки первичного материала для пеллет, в результате экономится энергия.

Вероятно, масштабировать такой проект не получится, но в качестве тестового варианта — почему бы и нет.

Возможно, вам известны другие варианты необычных ЦОД? Если да, давайте обсудим в комментариях.

Комментарии (12)

DikSoft

24.07.2021 14:44-3Есть масса мест с неплохим географическим расположением, более-менее вменяемым политическим строем и отличным климатом.

Простой пример: Казахстан, конкретнее, северный Казахстан. Зима - free-cooling, лето - ветроэнергетика. До основных магистралей рукой подать, сейсмоустойчивость - супер, наводнения? Не, не слышали. Электричество - см.выше. Почему в первую очередь на слуху всякая экзотика, вместо простого выбора оптимального расположения в относительно дешёвых регионах. Рабочая сила - дешёвая, специалисты есть. Релокация , если не хватит специалистов - вообще не проблема. Транспортная доступность - всё рядом. Китай, Европа, далее по списку.

Если кто-то может объективно пояснить причину создания и "раскрутки" в первую очередь подобных тем, что в статье, экзотических проектов, очень бы хотел такое объяснение услышать. Спасибо.

0lom5zhdovdv

24.07.2021 18:01Фрикулинг не всегда так хорошо как звучит. Он трудноуправляемый и не совсем дешевый

DikSoft

24.07.2021 18:37Он гораздо более эффективен на перспективе в пару-тройку лет. Это подтверждается практикой. В некоторых климатах это так до сих пор.

Или концепция и практика уже поменялись?

firewind1

25.07.2021 03:14Конечно, зимой это рай для службы климат контроля ЦОДа в Казахстане. Но не забывайте, там резко, нет, РЕЗКО континентальный климат, что означает высокую вероятность сильной жары летом. А ветер может и не дуть в это время. Вот как-то так совпало, когда я работал в АО НИТ в Астане, мы (отдел мониторинга) сидели на смене, и регулярно один из нас бегал на крышу, открывал краник с холодной водой и поливал чиллеры сверху. Мне нравилось это делать, но потом жара спала, а мелкие неполадки, которые в сумме рушили весь климат в залах, кондиционерщики починили. Нормально ветер можно использовать только в районе Ерейментау, там и стоят сейчас ветряки, кстати. Или Вы местный, и так знаете об этом?

Rutel_Nsk

24.07.2021 21:46Импользовать дата-центры в качестве бойлеров для "производства горячей воды" очень хорошая мысль, правда учитывая их крайне низкое "техническое совершенство" надежность будет не очень.

Кстати горячая вода и потребители (пусть даже части) услуг одни и те же.

achekalin

25.07.2021 02:16-1в Рьюкане, Норвегия

Я понимаю, что, видимо, исходник в американском стиле написан (да, где дефолт-кантри - это США, что выглядит как «Вашингтон, округ Колумбия», в то время как для остальных стран пишется просто город и страна, «Москва, Россия»), но по-русски скорее пишут «в норвежском городе Рьюкане».

DikSoft

Такое аномальное потребление вероятнее всего может встретиться при майнинге. ЦОД ради майнинга? Офигенное решение экологической проблемы. Заниматься бесполезной и вредной вычислительной работой под видом спасения природы...

akaAzazello

ML, render farm, научные расчеты - везде GPU/заказные микросхемы и бешенное потребление

DikSoft

Вот чего-то такого бешеного не встречал пока в подобных задачах.

netch80

Безнадёжно отстаёте.

МГУ кластер "Ломоносов" (стартован в 2011) — 70кВт на стойку в первой очереди, около 90 во второй.

DikSoft

Я согласен, что в узкоспециализированных задачах такое может быть. Пример хороший, могу ещё подкинуть - СХД на HDD )))

Но речь же про массовые ЦОД общего назначения, нет?

Те же CUDA ориентированные сервера не жрут столько. Вероятность, что это под майнинг гораздо выше.

VerdOrr

4 GPU + 4 CPU / 1U - это минимум 1.5-2 кВт/1U, 60-80 кВт на стойку