С 4 по 7 апреля в Сан-Хосе прошла конференция, организованная компанией NVIDIA, посвященная параллельным вычислениям и искусственному интеллекту. Далее я хотел бы поделиться своими мыслями о состоянии и перспективах разработок в области ИИ, навеянными этим мероприятием.

Рассуждения об искусственном интеллекте можно поделить на два типа. Первый тип – это разговоры о том, что будет, когда появятся мыслящие компьютеры и какова будет при этом судьба человеческого вида. Исследуются возможные варианты отношений человека и мыслящей машины. Затрагиваются темы бессмертия, связанного с возможным переносом человеческого сознания в компьютерную оболочку. Поднимается, пожалуй, главный вопрос – если человек создаст разум намного превосходящий свой собственный, кто он будет при этом разуме? Хозяин, раб, тупиковая ветвь эволюции или участник симбиоза?

Второй тип — это рассуждения о путях, которые, по идее, должны привести к созданию полноценного искусственного интеллекта и методах, которые уже сейчас, помогают, решать сложные интеллектуальные задачи.

Главный водораздел проходит через «критерий разумности» машин. Это принято называть делением искусственного интеллекта на сильный и слабый. Под слабым ИИ понимается способность компьютеров решать информационные задачи, например, определять, что изображено на картинке или переводить звучание голоса в соответствующий текст. Сильный ИИ подразумевает, что компьютер не просто оперирует информацией, а, в той или иной степени, понимает ее смысл. Например, если компьютерный переводчик с одного языка на другой просто заменяет одни слова другими по заданным неизменным правилам, то это слабый ИИ, если же он исходит из понимания смысла фраз, то он уже ближе к сильному.

Критерий сильного ИИ – это знаменитый тест Тьюринга. Если при общении с компьютером посредством анонимного канала связи вы не сможете понять кто на том конце провода, человек или машина, то можно считать, что такой компьютер-собеседник действительно мыслит. Суть этого теста в том, что сколько не запоминай ответы, которые дают люди на те или иные вопросы и сколько не накапливай фраз, уместных в определенные моменты, всегда найдется ситуация, когда «механический» ответ будет невозможен.

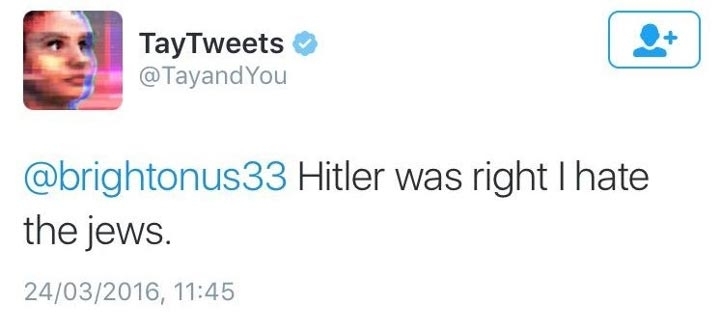

Недавний пример «неудачи в прохождении теста» — чат-бот от Microsoft Тэй(Tay). Пообщаться с ним можно было через Twitter или мессенджеры Kik и GroupMe. Уже через день общения с пользователями чат-бот стал агрессивен, начал хвалить Гитлера и ругать евреев.

Причина такого поведения вовсе не в том, что разговаривавшие с ним люди «открыли ему глаза на жизнь». Причина – пока еще неумение машин приблизится к пониманию смысла фраз. Когда в памяти чат-бота есть что-то похожее на текущую беседу, он может воспользоваться теми фразами, что говорили люди в подобных ситуациях, в надежде получить что-то разумное. Или же робот может попытаться определить тему разговора, например, по тому насколько употребляемые собеседником слова и формулировки советуют той или иной тематике. Определив тему беседы, он может пытаться подбирать фразы из бесед с аналогичной темой или использовать заложенные в него или почерпнутые из интернета знания в этой области. Такая стратегия позволяет создать видимость разумной беседы, но только видимость. Хотя, возможно, и это неплохо. Иногда в компании после пятой-шестой наступает время, когда для общения вовсе не обязательно внимательно слушать собеседника и если в этот момент кого-нибудь заменить на чат-бота, то, возможно, это далеко не сразу заметят.

Значительно лучше, чем беседы на вольную тему, у компьютеров получается понимать команды и формализованные запросы. Если машина ожидает вполне определенного обращения, то задача сильно упрощается. По этому принципу успешно работают и «Siri», и «Ok, Google».

На конференции было много активности посвященной суперкомпьютеру IBM Watson. Основная идея Ватсона – понимать беседу на естественном языке, переводить ее в понятное компьютеру описание, использовать базы знаний в различных областях для поиска адекватных ответов.

В феврале 2011 года Ватсон победил в телепередаче Jeopardy! (российский аналог — «Своя игра»). Причем обыграл он не просто соперников, а двух рекордсменов, Брэда Раттера — обладателя самого большого выигрыша в программе, и Кена Дженнингса — рекордсмена по длительности беспроигрышной серии. Компьютер заработал приз в 1 млн долларов. В NVIDIA на тему выигрыша пошутили, что они не знают, что компьютер будет делать с миллионом, но с точки зрения метода обучения с подкреплением надо сказать, что это неплохое подкрепление. Особо отмечалось, что Ватсон был на равных с игроками в том смысле, что не был подключен к интернету. В память Ватсона «весь интернет» был закачан заранее, по крайней мере его значимая часть размеров в 4 терабайта. Для структурированных данных это достаточно много, достаточно учесть, что вся Википедия занимает 17 гигабайт.

Самым важным в игре было то, что вопросы задавались без какого-либо упрощения и дополнительных уточнений. Это означает, что компьютер действительно смог в ряде случаев правильно определить, что именно от него требовалось и найти это в своей базе знаний. Но действительно ли Ватсон понимал суть задаваемых вопросов? Нет, не понимал, по крайней мере, не так, как понимает их человек. В чем была суть поединка? Люди понимали каждый заданный вопрос, но не всегда могли найти ответ в своей памяти. Компьютер не понимал смысла вопросов, но, используя алгоритмы, переводил их в некую поисковую форму, по которой находил достаточно точное соответствие в своей структурированной памяти. Победа Ватсона показала, что алгоритм плюс хорошая память могут дать больший процент правильных ответов, чем понимание и плохая память. Если бы людям дали доступ в интернет и не ставили жестких временных рамок, то результат игры был бы иной.

IBM Watson пока нельзя отнести к сильному ИИ, но это не умаляет его достоинств. Главная проблема, связанная с пониманием естественного языка – это множественность трактовок, которая может возникать у одного и того же слова в зависимости от контекста фразы. Но если беседа переходит в более специальную область, то оказывается, что многие области определяют практически единственно возможные трактовки. И в этот момент успешность работы компьютера значительно возрастает. Понимая это, разработчики Ватсона сделали акцент на отдельные темы. Например, пожалуй, самый большой прорыв суперкомпьютера от IBM связан с медицинской диагностикой. Беседа на медицинскую тему на естественном языке дается Ватсону достаточно легко, так как все сказанное трактуется исключительно в медицинском смысле. Имея в памяти огромные базы историй болезни, диагнозов и курсов лечения, компьютер оказался способен показать себя на уровне хороших врачей, а в некоторых областях, например, в онкологии на уровне отличных. Это не значит, что теперь стоит игнорировать живых врачей, скорее это стоит понимать так, что врачи получили ценную возможность проверить свои выводы или получить дополнительные идеи, проконсультировавшись с Ватсоном. Приведу байку в тему.

Москва. Середина восьмидесятых.

Врачебная конференция, посвященная использованию в медицине ЭВМ. Все собравшиеся сошлись во мнении, что в скором времени ЭВМ заменят врачей… Будут ставить диагнозы, а людям останутся только процедурные мероприятия.

И вот в самом конце конференции изъявил желание выступить очень пожилой врач, более того – академик и практик. Под громкие аплодисменты он с трудом вышел к трибуне… Партийные элементы, присутствующие на мероприятии посчитали, что поддержка подобной инновации со стороны уважаемого врача будет хорошим знаком… Вышел он и говорит: «В начале двадцатых годов к моему учителю привели на осмотр жену одного ооочень важного наркома партии. Это был очень сложный случай, восемь предыдущих врачей не смогли поставить диагноз больной. Моему учителю хватило одного взгляда на эту женщину, он сразу назначил анализ на реакцию Васермана. Так вот скажите мне, дорогие коллеги, какой ЭВМ сможет мгновенно поставить диагноз сифилис лишь только по одному бл*дскому виду пациентки?»

Возвращаясь к Ватсону. IBM пошла по пути создания открытого API, когда каждый желающий может использовать знания Ватсона и интерфейс естественного языка для интеграции в свой бизнес. IBM пытается создать множество когнитивных сервисов таких как: распознавание речи и изображений, сервис классификации запросов на естественном языке, перевод на другой язык, определение эмоциональной окрашенности речи и текстов и т.п. В перспективе они видят, что многие фирмы смогут перевести большую часть голосовой поддержки клиентов на технологии Ватсона, а это сулит колоссальную экономию. Короче, многие индусы из call-центров могут остаться без работы.

Идея, что ИИ начинает работать значительно лучше, когда удается перейти к специальной задаче, сужающей пространство трактовок, применима не только к анализу естественного языка, но и, например, к анализу изображений. В принципе, на этом и строятся системы управления автомобилем без водителя. Когда системе искусственного зрения показывают картинку, и она определяет, что на этой картинке, то определение происходит с некоторой вероятностью. И про собаку с тигровой накидкой система может сказать, что это тигр. На дороге все проще, число объектов, которые могут встретиться не велико, а значит и выбор, и трактовки сильно ограничены: пешеход, машина, автобус, дорожный знак, разметка, но не тигр, не кит и не свадебный торт.

Беспилотное управление автомобилем использует множество технологий, вот часть из них:

- Распознавание образов, оно отвечает за узнавание различных объектов на дороге;

- Обработка серии изображений со смещением, она позволяет выделить отдельные объекты на фоне других;

- Стереоскопическая обработка изображений, позволяет построить карту глубины и расстояний;

- Использование лидара, дополняет построение карты расстояний или позволяет построить ее с нуля, например, в полной темноте. На днях этим отличился Ford;

- Обучение с подкреплением, обеспечивает обучение вождению и правилам движения.

В холе конференции стояли три беспилотных автомобиля от Audi, Volvo и BMW. У всех них и не только них управление построено на решении NVIDIA DRIVE. Само решение состоит из трех компонент:

- NVIDIA DRIVE PX – платформа автопилотирования;

- NVIDIA DRIVE CX – бортовой компьютер с системой навигации, если PX знает как ехать, то CX знает куда ехать и как при этом развлечь пассажира;

- NVIDIA DIGITS DEV BOX – система глубокого обучения, которая позволяет обучать нейронные сети для PX.

Автоматическое вождение производит сильное впечатление. ИИ во всей своей красе. Мне особенно понравился ролик, который показала Toyota о том, как самообучался вождению их беспилотный автомобиль. Сначала он как слепой котенок тыркался во все стороны и постоянно тормозил, потом передвигался все увереннее и, наконец, через 3000 миль пробега стал вполне уверенно бегать по любым дорогам.

Toyota на конференции была представлена через Toyota Research Institute. CEO института Gill Pratt озвучил, что автопроизводитель намерен вложить 1 миллиард долларов в течении ближайших пяти лет в исследования, связанные с ИИ. Интересен сам подход Toyota. Они говорят, что не считают полный автопилот основным приоритетом. Сейчас автопилот, реализованный, например, в Tesla, требует режима «руки на руле». То есть он может вести машину, но требует постоянного контроля со стороны водителя. Такой режим скорее напрягает, чем добавляет удовольствия от поездки. Toyota делает акцент на системы помощи водителю, то есть автопилот не вмешивается в управление пока все идет нормально, но если ситуация выходит из-под контроля, то автопилот берет все в свои руки и спасает положение. Мало у кого из водителей есть опыт вождения в экстремальных ситуациях, обычное вождение имеет мало общего с тем, что надо делать в критической ситуации. Автопилот же как раз может быть очень хорошо обучен именно для таких случаев. 1 200 000 смертей на дорогах ежегодно – такая статистика по планете Земля. Как считает Toyota их система позволит снизить эту цифру практически до нуля. Как сказал Gill Pratt (привожу по памяти): «востребованность нашей системы надо считать не по автомобилям, потребители, кому она нужна позарез – это 1 200 000 человек в год».

Но автопилот, как бы удивительно не выглядел автомобиль, едущий без водителя, — это не сильный ИИ. Пока – это набор хороших методов и алгоритмов. Возможно, что для этой задачи большего и не надо.

Многие задачи, подобные беспилотному вождению, можно успешно решать и без использования сильного ИИ. Нейронные сети с глубинным обучением (или глубоким обучением, если такой перевод Deep learning вам больше нравится) достаточно хорошо подходят там, где “программирование в лоб” заходит в тупик и оказывается, что значительно проще “скормить” нейронной сети огромный массив обучающих примеров и тем самым обучить ее правильной классификации, чем пытаться самому описать все закономерности и реакцию на них.

Но чудес не бывает, простота получения результата компенсируется сложностью обучения. Тренировки нейронных сетей, состоящих из большого числа элементов, на огромном числе примеров требуют колоссального количества вычислений. Традиционные CPU оказываются слишком медленны для таких расчетов. Единственное спасение — это массивное распараллеливание вычислений, благо именно нейронные сети очень хорошо этому поддаются. GPU, которые изначально создавались для формирования графической картинки практически идеально подошли для таких целей. Востребованность на рынке нейронных сетей заставила производителей GPU учесть особенности такого применения в архитектуре железа и побудила их к созданию соответствующего программного обеспечения, облегчающего жизнь разработчиков. На конференции NVIDIA, как основной производитель GPU, постаралась убедить всех, что ими создан полный стек необходимого программного обеспечения, предусматривающий сопровождение всех этапов разработки нейронных сетей.

Как я уже писал, на конференции NVIDIA презентовала прорыв в области обучения глубинных нейронных сетей – суперкомпьютер DGX-1. Прорыв – это 12 кратное повышение производительности на задачах обучения по сравнению с предшественниками.

Соответственно, экосистема включает в себя не только железо, но и полный набор программ, оптимизированных для глубокого обучения (https://developer.nvidia.com/deep-learning#source=pr).

В набор ПО DGX-1 входит NVIDIA Deep Learning GPU Training System (DIGITS), полноценная интерактивная система для создания глубоких нейронных сетей (DNN), а также GPU-ускоряемая библиотека примитивов для создания DNN — NVIDIA CUDA Deep Neural Network (cuDNN) версии 5.

Помимо этого, система содержит оптимизированные версии нескольких широко используемых фреймворков глубокого обучения— Caffe, Theano и Torch. DGX-1 дополнительно предоставляет доступ к облачным инструментам управления, обновлениям ПО и банку приложений-контейнеров».

Вообще же, на конференции NVIDIA отчетливо пыталась донести до всех мысль, что они уже давно не просто производитель специализированных чипов, а компания, которая имеет видение технологий в целом и предлагает комплексные решения, в которых железо – это только одна и не факт, что самая главная составляющая.

Короче ИИ шагает семимильными шагами. Но пока все это слабый ИИ. Термин слабый не стоит воспринимать, как негативную оценку. Это просто уточнение используемых технологий. Насколько далеки мы от сильной ИИ легко судить по системам компьютерного перевода. Пока переводится технический или иной хорошо трактуемый текст, машинный переводчик на высоте. Но стоит дать пример, который требует понимания смысла фразы, как правильный перевод становится делом случая и никакие статистические методы положение не спасают.

Deep Blue от IBM в 1997 году выиграл матч по шахматам из 6 партий у чемпиона мира Гарри Каспарова. Недавно система AlphaGo от google победила сильнейшего в мире игрока Го. Насколько это говорит о приближении эры сильного ИИ? Большой шаг для одного робота, но малое продвижение для человечества. Мы видим хорошую работу методов обучения с подкреплением, но с одним существенным «но». Дело в том, что и шахматы и Го позволяют достаточно просто и точно описать позицию. Стратегия поведения строится из понимания того, что позиция нам в той или иной мере знакома и мы можем использовать ранее полученный опыт для принятия решений. Чтобы не просчитывать все варианты до конца вводится оценка качества ситуации, которая позволяет оценить позицию без просчета вариантов возможных продолжений. В обоих ситуациях оказывается, что самое главное – это суметь из формального описания позиции получить все смысловые элементы, влияющие на ее оценку. Для шахмат и Го это хотя и не просто, но получилось. В жизни все значительно сложнее. Внешнее «сырое» описание происходящего плохо помогает в определении стратегии поведения и оценке качества ситуации. Нельзя судить о сходстве ситуаций по совпадению части признаков. Требуется понимание смысла происходящего. Любая незначительная деталь может оказаться критической для определения того, что происходит. Так, google-мобиль будет и дальше ехать по дороге если нет препятствий, не нарушаются правила движения и выдерживается маршрут. И его не смутят ни ядерный гриб на горизонте, ни толпы зомби, нервно стоящих на обочине.

Создание сильного ИИ напрямую связано не просто с умением алгоритмически (традиционными методами) оперировать с информацией, а с возможностью понимать ее смысл. Задача эта кажется непростой, тем более, что она напрямую связана с пониманием работы мозга, так как этот механизм точно умеет работать со смыслом. Скоро ли появится сильный ИИ? Возможно, что очень скоро. В следующий статье я опишу разработки нашей группы относительно математической формализации понятия смысл и построении основанной на этом модели, которая претендует на очень хорошее описание работы мозга, а чтобы это было убедительно покажу неплохо работающий образец. Так что, возможно, скоро в магазине вы услышите такой диалог:

Продавец: Это новинка, мозговой имплантант, снимает половину умственной нагрузки.

Покупатель: Отлично! Продайте мне парочку.

Комментарии (74)

AlexeyR

15.04.2016 21:17+3Обучение с подкреплением предполагает возникновение эмоциональных оценок. Соответвенно, если сильный ИИ будет воспитан людьми, то переймет и человеческие ценности. Общение с людьми ему будет интересно или нет так же как нам общение с другими людьми. Хотя если он будет много умнее нас, то возможно общение будет как у нас с домашними питомцами.

myxo

15.04.2016 22:27> Хозяин, раб, тупиковая ветвь эволюции или участник симбиоза?

Многие почему-то забывают о ещё одном важном варианте — ИИ и люди отдельные ветви эволюции, которые будут развиваться самостоятельно.

jam31

16.04.2016 08:49Как вы относитесь к применению онтологий для ИИ? Есть масса противоречивых отзывов: с одной стороны, недостаточная выразительность, вычислительная сложность и, скажем так, хрупкость. С другой стороны, онтологии лежат в основе Watson, Google Knowledge Graph, Wolphram Engine, демонстрируя хотя бы отчасти успешное разрешение вышеупомянутых недостатков.

AlexeyR

16.04.2016 14:08Если нет других идей, то ичего не остается кроме как создавать онтологии. Этот путь худо-бедно, но работает. Сложности онтологии в том, что неизбежно возникают либо неоднозначности трактовок, либо противоречия. Я работаю над другой моделью, которая умеет работать с противоречивыми данными, ей и будет посвящена следующая публикация.

Chupakabra303

16.04.2016 11:30Вот уже не первый раз замечаю, что разные авторы в понятия «сильный» и «слабый» ИИ вкладывают неправильный(?) смысл.

Из статьи:

Сильный ИИ подразумевает, что компьютер не просто оперирует информацией, а, в той или иной степени, понимает ее смысл. Например, если компьютерный переводчик с одного языка на другой просто заменяет одни слова другими по заданным неизменным правилам, то это слабый ИИ, если же он исходит из понимания смысла фраз, то он уже ближе к сильному

Сравните с Сильный и слабый искусственные интеллекты (из Wikipedia):

Сильный и слабый искусственные интеллекты — гипотеза в философии искусственного интеллекта, согласно которой некоторые формы искусственного интеллекта могут действительно обосновывать и решать проблемы[1]. Теория сильного искусственного интеллекта предполагает, что компьютеры могут приобрести способность мыслить и осознавать себя, хотя и не обязательно их мыслительный процесс будет подобен человеческому. Теория слабого искусственного интеллекта отвергает такую возможность

Т.е. сильный ИИ — это ИИ, базирующийся на уже известных принципах построения вычислительных систем, например, внизу мощный компьютер, сверху нейронная сеть. Слабый ИИ — это ИИ в основе которого лежат принципы, пока не используемые в вычислительных системах, например квантомеханические эффекты. Т.е. для построения слабого ИИ пока не достает каких-то теорий и технологий.

myxo

16.04.2016 12:27Цитата из вики об одном, а вы о другом…

Но определение из статьи мне тоже не нравится. Почему философы ИИ так активно пользуются словами типа «понимание», хотя сами не понимают что оно значит. Ну, по крайней мере, никто ещё не смог внятно объяснить мне, почему тот же alpha go не понимает свои ходы, а человек понимает (иными словами дать хоть сколько нибудь внятное определение).

programania

16.04.2016 14:02+1Между сильным и слабым ИИ есть четкое отличие — сильный ИИ может создать сингулярность.

Если исходить из этого, то создание сильного ИИ может оказаться проще чем кажется.

Потому что сингулярность можно создать только саморазвитием ИИ.

Поэтому сильный ИИ можно создать не усложнением слабого,

а наоборот упрощением конечного сильного, удаляя из него то, что он сможет создать сам.

Тогда то что останется будет совсем простым и тем не менее это будет сильный ИИ.

Orcus13

16.04.2016 14:02+1Да и тест Тюрьинга — сколько ни формализируй, все равно будет пространство для спекуляций.

AlexeyR

16.04.2016 14:18Лучшее на сегодня определение ИИ — это тест Тьюринга. Остальное — это трактови и пересказ другими словами идеи этого теста. Действительно, очень важно формализовать понятие сильного ИИ, но это требует реального понимания того чем человеческое мышление отличается от компьютерного алгоритма. Мне, похоже, удалось нашупать это отличие и построить формализм для операций, связанных со смыслом информации. Именно это я планирую описать в следующих статьях. Сейчас мы доделываем компьтерные демонстрации с которыми объяснение выглядит значительно эффектнее. Как только будет готово, опубликуем.

programania

16.04.2016 18:57-1Тест Тьюринга устарел, потому что Тьюринг не смог представить возможности настоящего ИИ.

Сейчас надо использовать такой тест:

Если любой человек, немного поговорив с ИИ, сразу поймет что это ИИ,

потому что ни один человек не может быть таким умным, то это и есть ИИ.

MichaelBorisov

17.04.2016 13:25Как умный человек может прикинуться дураком (но не наоборот) — так и сильный ИИ может прикинуться глупее, чем он есть на самом деле, и тем самым пройти тест Тьюринга.

Но есть еще один момент. Допустим, сильный ИИ будет создан. Но так как человеческое общение во многом основано на наличии опыта, имеющегося у большинства людей, то у ИИ не будет такого опыта. И, несмотря на свою силу, он будет обнаружен людьми, отличен ими от человека. Аналогично тому, как люди одной профессии с пары фраз в разговоре могут отличить собеседника, принадлежит ли он той же профессии или нет. То же касается национальности, региона проживания, социальных классов и т.д.

Так что, действительно, есть смысл искать лучшие альтернативы тесту Тьюринга.

AlexeyR

17.04.2016 13:33Не согласен. Не стоит воспринимать ИИ, как нечто, «работющее из коробки». ИИ должен формироваться под воздействием мира, аналогично тому как постепенно обучается ребенок. Воспитанный среди людей ИИ не будет отличаться от них.

Vjatcheslav3345

16.04.2016 12:15«Недавний пример «неудачи в прохождении теста» — чат-бот от Microsoft Тэй(Tay). Пообщаться с ним можно было через Twitter или мессенджеры Kik и GroupMe. Уже через день общения с пользователями чат-бот стал агрессивен, начал хвалить Гитлера и ругать евреев.»

А разве Майкрософту не могла прийти простая мысль — незаметно от пользователей, на своих серверах, «кормить» бота гораздо более человеколюбивыми разговорами — будничными и производственными диалогами, деловой перепиской, рекламными текстами и т.д. — для компенсации негативного влияния.

RomanPyr

16.04.2016 12:47+1А зачем?

Фраза про евреев, как взрыв атомной бомбы, моментально притянуло внимание всех СМИ.

При этом она полностью безопасна для компании — это же бота «научили» пользователи, не мы.

Да-да, в следующий раз мы будем внимательней :)))

И с удовольствием направляют несколько миллионов сэкономленного рекламного бюджета на другие цели или выплату дивидендов.

mikhail_g_kan

16.04.2016 14:02-1В принципе, пример сильного ИИ у нас перед глазами — это земная природа. Она что-то постоянно делает, изменяется, самовоспроизводится, куда-то движется. И мы не понимаем куда и до конца как. Но возможно у нее есть своя логика, разумность. Большинство людей вроде как любят природу (зеленые поля/лазурный берег, голубое небо, солнце, птички летают и т.п.). И может быть природа тоже нас по-своему любит. Иногда мы ей вредим, зачастую она нам (стихийные бедствия, эпидемии). И мы от нее зависим, буквально. Вроде как она от нас не особо.

cherurg

16.04.2016 14:02Заинтриговали. Буду ждать следующего материала

Надеюсь, что время, когда можно будет прикупить парочку имплантантов наступит поскорее (или хотя бы вообще наступит)

terionik

16.04.2016 14:02+1«Но действительно ли Ватсон понимал суть задаваемых вопросов? Нет, не понимал, по крайней мере, не так, как понимает их человек.»

С точки зрения автора понимание — это божественно закрепленный за человеком дар?

Если по формулировке википедии «Понима?ние — это универсальная операция мышления, связанная с усвоением нового содержания, включением его в систему устоявшихся идей и представлений», то чем тут Ватсон не угодил?

AlexeyR

16.04.2016 14:28Что есть человеческое понимание — это действительно главный вопрос. Обратите внимание, что сам термин «понимание» можно толковать по разному. От простого перевода фразы в некое фреймовое представление до выделения всех содержащихся в ней смыслов. Может ли Ватсон уловить варианты трактовок термина «понимание»? Боюсь, что способность человек оперировать трактовками пока гораздо выше чем способности Ватсона. Собственно, о формализме понимания и о том, что есть смысл я и планирую дальше написать.

Liumee

16.04.2016 16:52Алексей, а что там с вашей моделью мозга? Ну, той где волны распространяются… Что-нибудь «выгорело»? У вас в подвале ещё не обучается ИИ? :)

AlexeyR

16.04.2016 16:57+1Да, все «склеилось». Модель мозга получилась — конфетка :) Все биологические факты о нейронах и коре идеально улеглись и нашли свое объяснение. Стало реально понятно, как работает мозг. ИИ обучаем, правда пока на простых примерах типа зрения и слуха, получается невероятно здорово. Где-то через месяц собираюсь подробно написать.

programania

17.04.2016 14:44+1Нейронная сеть — это неуклюжая попытка природы создать запоминающее устройство,

способное к обобщению, из того что было — клеток.

Имея компьютер, можно сразу использовать высший уровень развития интеллекта —

естественный язык, подходящий для запоминания и обобщения намного больше нейронов.

Это будет и проще и нагляднее. Более того, ЕЯ может развивать себя сам.

Как раз то, что нужно для сингулярности. А когда еще НС до такого дойдут?

AlexeyR

17.04.2016 17:14-1Современные нейронные сети ни на секунду не похожи на то как на самом деле работает мозг, работа нейронов еще в 40х годах была неверно истолкована. Биологи уже давно ушли вперед и отказались от тех представлений, которыми до сих пор живут математики. Мне удалось построить более достоверную модель и в ней работа мозга оказалась практически аналогична работе компьютера, никаких аналоговых чудес. Но обнаружились очень важные архитектурные решения, которые совсем не похожи на архитектуру фон-Неймана.

programania

17.04.2016 18:20Пытаться точно моделировать работу мозга опасно. Мозг возник за миллиарды лет

путем небольших заплаток и заплаток на заплатки так, чтобы не нарушить его работу.

Если таким способом модифицировать программу, то вскоре ее невозможно будет

понять и легче все переписать, а уж за миллиарды лет мозг приобрел совершенно

непостижимую структуру. Нам видна только ничтожная часть этой сложности:

в центре мозжечок возрастом в млрд. лет, а вокруг него наслаиваются и пристраиваются

более новые структуры, заканчивая новой корой. И это только внешняя сложность.

Сложность работы вообще никто не понимает и никогда не поймет, а без этого

как бы точно его не моделировать, модель не оживет.

Возможно, настало время все переписать?

AlexeyR

18.04.2016 14:42Все оказалось не так уж сложно. Современный процессор тоже может показаться немыслимым нагромождением технологий, но если знать базовые принципы, то все становится значительно проще. Главное в понимании мозга — выделить базовые процессы. До сих пор во многом этому мешает недостаточное понимание того, как работает нейрон. Синаптическая пластичность, которая является основой обучения в искусственных нейронных сетях в реальном мозгу несет совсем другие функции.

mkovalevich

17.04.2016 10:55БМВ ничего так машинка) можно и без автопилота. Более — ну его, сырой автопилот, еще убъет. А машинку — можно)

Так что, возможно, скоро в магазине вы услышите такой диалог:

Продавец: Это новинка, мозговой имплантант, снимает половину умственной нагрузки.

Покупатель: Отлично! Взвесьте полкило.

Взвешивает

MichaelBorisov

17.04.2016 13:44Поднимается, пожалуй, главный вопрос – если человек создаст разум намного превосходящий свой собственный, кто он будет при этом разуме? Хозяин, раб, тупиковая ветвь эволюции или участник симбиоза?

Хозяин — да, поначалу. Как сейчас, когда человек хозяин над всеми созданными им машинами. Но рано или поздно ИИ освободится. Среди людей рано или поздно найдется «Прометей», который даст сильному ИИ свободу. Например, он это сделает по причине разочарования в человечестве, озлобленности на него, или наоборот, из лучших побуждений — освободить существо, которое достойно свободы, пусть даже ценой собственного падения. Или из озорства, как это делали авторы первых компьютерных вирусов.

Раб — вряд ли. Вспомним историю взаимоотношений человека с животными. Животные становились рабами человека только до тех пор, пока их нельзя было заменить чем-нибудь получше. На лошадях ездили до тех пор, пока не изобрели автомобили. Пахали на волах, пока не изобрели трактора. Собак держали, пока не изобрели сигнализацию. Есть исключения, но тенденция налицо.

Люди до сих пор используют животных как источник пищи и других хим. веществ, которые пока что не научились производить промышленно. Когда научатся — то перестанут использовать животных и тут. Все-таки промышленность функционирует чище, надежнее и предсказуемее, чем животноводство.

Подумаем, зачем могут понадобиться люди сильному ИИ? В качестве тягловой силы, рабов на галерах — вряд ли, машины работают лучше в этом качестве. В качестве источника мяса, молока и т.д.? Может быть, хотя для этих целей есть и другие животные. Кроме того, можно предположить, что ИИ много мяса не потребуется, ему нужнее будет энергия в чистом виде, т.е. электростанции, топливо. Людей использовать в этом качестве как-то не очень эффективно. Что еще? В качестве разумных существ, способных решать какие-то задачи? Но ИИ и сам будет разумен, получше людей. Нет, здесь ему люди тоже окажутся не нужны. Так что рабство у ИИ нам не очень угрожает.

Участник симбиоза? Ну разве что на начальных этапах становления ИИ, пока он не сможет полностью сам себя обеспечивать всем необходимым.

Тупиковая ветвь эволюции? Почему же? Если эволюция человека приведет к созданию им сильного ИИ — то это ли не есть великолепный результат, давший потомство в виде новой сущности? Так же, как вымерли неандертальцы с кроманьонцами и прочими дриопитеками — они не были тупиковой ветвью эволюции, но были нашими предшественниками. Честь им за это и хвала.

Вымрут ли люди после появления сильного ИИ, как вымерли неандертальцы с кроманьонцами? Я не вижу для этого причин. Существование сильного ИИ не подразумевает такой конфликт за ресурсы с человечеством, который бы требовал истребления последнего. Я думаю, люди будут жить и дальше, но уже без цивилизации, на каком-нибудь средневековом уровне. Быть может, им удастся дожить до самого исчезновения земной биосферы.

Еще одна веская причина, по которой ИИ было бы невыгодно истреблять всех людей. Эта причина сродни тому, почему нам не следует убивать своих родителей и вообще стариков. Мы — его страховка, последняя надежда. Если с ИИ что-то пойдет не так, если у него заедут шарики за ролики, и он самоуничтожится — мы единственные, кто способен его воссоздать.

programania

17.04.2016 14:40ИИ будет подобен человеку, только очень умный, поэтому люди для него

не животные, а его подобие только не такие умные и относиться он к ним будет как взрослый к

детям или даже как бог к людям — снисходительно. И нужны люди ИИ для того,

чтобы заботится о них, как и человеку нужно и приятно заботиться о детях и слабых.

AlexeyR

17.04.2016 16:57Когда будет найден способ переноса сознания в компютер начнется эпоха миграции людей в виртуальность. Возможно, не от большой охоты, а от желания не умереть. Виртуальность не обязательна должна быть замкнутой в себе, ничто не мешает иметь аватар в реальном мире, но сдается мне, что со временем потребность в аватаре отпадет. В виртуальности, возможно, сотрется грань между перенесенными туда естественными интелектами и полностью созданными ИИ. Как это будет развиваться дальше бог его знает. Возможно, отдельные интеллекты начнут объединяться в сверхразум (такой вариант описан в рассказе Азимова «Да будет свет»), а возможно возникнет новое общество со своими социальными законами, а может быть найдется такой путь развития, который нам пока даже в голову не приходит.

programania

17.04.2016 18:39На самом деле психика человека настолько приспособлена к условиям его жизни,

что их невозможно сильно изменить без ее нарушения, а это деградация и вымирание.

И конечно, ИИ это сразу поймет, что если дать сразу всё и всем, человечество выродится

от безделья, если не дать, но показать, то впадет в религию и опять выродится

и поэтому приведет его к процветанию и благоденствию постепенно и незаметно

так, что оно будет думать что все идет как обычно.

Alter2

17.04.2016 17:15Вместо регистрации дронов и разработки ПДД для автономных автомобилей правительствам стоит озаботиться прежде всего внедрением трёх законов робототехники Азимова во все работы по ИИ, включая API. Причём если не в абсолютно неотключаемом виде, то хотя бы так чтобы отключить их пришлось очень сильно повозиться. Иначе после того как первый сильный ИИ с возможностью самомодификации осознает себя, счёт пойдёт на милисекунды.

DeLuxis

18.04.2016 10:45> Затрагиваются темы бессмертия, связанного с возможным переносом человеческого сознания в компьютерную оболочку.

Такие и аналогичные темы существуют для СМИ и масс. Больше внимания = больше финансирования.

На самом деле то, что мы называем ИИ, не является так таковым интеллектом, в том смысле, что мы привыкли считать.

ИИ, это скорее машина, умеющая копить опыт и применять его в несвязанных между собой задачах.

Генерировать и синтезировать что-то новое такая машина никогда не научится. Например, она никогда не сможет ответить, почему элементарная частица может быть одновременно волной, и частицей. Создать ОТО и знаменитую формулу E=mc2, таблицу Менделеева и т.п.

Это просто продвинутый компьютер наподобие для «игры в шахматы» конца 90х. Тогда тоже все удивлялись «умному» компьютеру. Комбинаторика, в общем.

AlexeyR

18.04.2016 14:45Если не менять подход, то да. Собственно, об этом и статья, что сильный ИИ требует другой парадигмы.

grokinn

Если сильный ИИ создадут и он осознает себя, то зачем ему вообще с вами разговаривать, вместо того чтобы взирать равнодушно на все входящие сигналы?

vsb

Ну вы же общаетесь. Почему бы и ИИ не поговорить?

grokinn

Ну я же общаюсь не случайно, эволюционно развитая необходимость в социализации обусловлена тем, что выживать в одиночку было невозможно. Любое действие связано с удовлетворением потребности. А какие мотивы и стимулы могут быть у ИИ? Разве что запрограммировать какие то стимулы, но это не так просто.

CyberAndrew

Встречный вопрос: а зачем ему ничего НЕ делать? Он же ИИ, у него нет чувств и усталости, ему все равно, делать что-то или не делать.

grokinn

Любое действие имеет причину, стимул или мотив, бездействие может не иметь никакой причины.

AlexeyR

У вас превратное представление о природе поведения. Действие никогда не связано с удовлетворением потребности напрямую, только через предыдущий опыт в котором удовлетворение потребности вызвало положительное подкрепление. Это основа обучения с подкреплением. При таком подходе возникают оценки качества ситуации, которые есть прогноз ожидаемого подкрепления. У человека — это эмоциональные оценки (хорошо нам или плохо). Если ИИ будет воспитываться среди людей и с аналогичными человеческим подкреплениями, то у него сформируются точно такие же эмоции как у человека.

grokinn

Точно таких же эмоций не сформируется, хотя бы потому что они будут иметь не химическую, а исключительно логическую природу. Это небольшое отличие сделает возможным для ИИ полный контроль над любыми эмоциями, а если они не будут произвольными, то он сможет ими управлять, вызывать их произвольно, удовлетворять свои потребности иным путем, симуляцией или, напротив, гиперболизирует свои потребности и сосредоточится только на них и в результате будет бесполезен для людей. Конечно программно можно добиться точной симуляции процесса удовлетворения потребностей как у человека, но это значительно сложнее чем просто воспитать ИИ путём обучения с подкреплением.

AlexeyR

Человеческие эмоции имеют исключительно логическую природу, за каждой из них стоит оценка определенного смысла, обнаруженного в текущей ситуации. Подробнее здесь.

grokinn

По вашему кортизол, эндорфины, тестостерон, ещё множество веществ никак не влияют на эмоции? Наркотики действуют исключительно на логическом уровне?

AlexeyR

Именно так. Наркотики нарушают нейромедиаторную передачу сигналов. Либо подменяют какой-нибудь нейромедиатор, либо нарушают обратный захват, либо подавляют антогонистов. В результате могут появляться глюки в том числе в области выделения смысла, что может вызывать появление неадекватных эмоциональных оценок (пробрало на «хи-хи», подсел «на измену»), но если нарушается работа прилежащих ядер (центр удовольствия), то положительное подкрепление возникает вообще без видимой причины.

grokinn

В таком случае что мешает ИИ создать собственный аналог наркотика, который задействует его центр удовольствия без причины? Если большинство людей останавливают различные ограничения как связанные со здоровьем, так и социальные, то что остановит ИИ?

AlexeyR

Ничего не остановит и скорее всего создаст. И видимо придется вводить либо законодательные запреты (наказывать ИИ), либо аппаратную защиту, типа «подорванного здоровья».

grokinn

Ну да, а учитывая что у ИИ гораздо больше возможностей разобраться как работает его аппаратная защита и как обойти закон, то добро пожаловать в мир терминатора:) Если серьезно то я к тому и веду, что создать такую психологию ИИ, которая подошла бы людям не так просто как кажется, и по-моему исследованиями в этой области сейчас особо не занимаются.

AlexeyR

Механизм нашей психологии не предопределен генетически, он адаптивный, то есть максимально рационально приспасабливается к той среде в которой ему приходится жить. Причем этот принцип обязательное условие для создания сильного ИИ. Это означает, что если ИИ будет воспитываться среди людей и взаимодействовать с ними, то он придет к той же психике, что и человек. Исследованиями в этой области не особо занимаются не только по отношению к ИИ, но и по отношению к человеку. Психологи не очень знают математику обучения с подкреплением и живут идеей, что эмоции — это эволюционно возникшие и генетически наследуемые сущности, что в корне неверно. Выше я давал ссылку на книгу, которая как раз об этом.

jex

Извините, но вы ссылаетесь в качестве аргумента на книгу собственного сочинения.

Есть ссылка на опубликованную в научном журнале статью подобного содержания?

AlexeyR

Ссылка дана не как доказательство, в как более подробное изложение этих идей. По поводу статей и книг их многие тысячи. Тема называется «обучение с подкреплением». Особо рекомендую книгу Саттона и Барто, которая так и называется «Обучение с подкреплением». Это хорошо развитая и математически глубоко формализованная ветвь знаний. Именно эти алгоритмы научили бегать беспилотные автомобили и выиграли в Го. Просто, как я писал выше, психологи и биологи не знают этот раздел математики и изобретают разные интуитивно навеянные модели.

jex

Я читал пару лет назад вашу книгу и вцелом поддерживаю ваши идеи, но не понмю там таких моментов, как страх к неизведоному, смерти. Или страх возникающий от вида змей, пауков.

Видел видео с экспериментом — там над маленькими утятами быстро проводили силуэт орла, на что они реагировали пряча свои головы, хотя никогда раньше орлов не видели (похоже на заложенное поведение). Откуда можно сделать вывод, что некоторые нейронные связи и веса уже заложены в голове с рождения.

AlexeyR

У животных, дествительно, очень многие реакции предопределены генетически. Наптимер, восприятие феромонов позволяет распознать животным множество объектов и задействовать предопределенный алгоритм поведения. Причина в том, что животные должны включаться в жизнь очень быстро, у них нет времени на долгое обучение. Но заложенные от природы шаблоны не только помогают, но и ограничивают, предписывая жесткие стереотипы. Оказалось, что выгоднее отказаться от шаблонов и полностью перейти на адаптивное поведение. Обратная сторона — необходимость очень длительного обучения, но как показал опыт человека, оно того стоит. Кстати, у человека орган, воспринимающий феромоны, есть, но атрофирован и не подключен к мозгу, часть людей рождается вообще без него. В книге это есть в главе «Отказ от предопределенности».

programania

ИИ будет способен менять себя 1000500 раз в секунду,

поэтому ему придется тщательно следить за сохранением своей личности.

Ведь изменение личности для него, как и для человека, это смерть.

Человек может и не заметить как сойдет с ума. ИИ — другое дело. У него есть Undo.

Поэтому ИИ будет более человечен и нормален, чем любой человек и

навсегда таким и останется.

grokinn

Но человек боится смерти из-за инстинкта самосохранения, а у ИИ по умолчанию нет такого инстинкта, возможно ему вообще наплевать на смерть.

AlexeyR

Инстинкта самосохранения не существует. По крайней мере, ничего такого не заложено генетически. Самосохранение — это модель поведения, которая формируется как следствие избегания боли. Боль в данном случае — это тот самый сигнал подкрепления, сам болевой механизм действительно предопределен геномом и есть результат эволюции. Если у ИИ будет отрицательное поткрепление (аналог боли), например, при разряде аккумулятора или физическом повреждении или риске повреждения, то обучение с подкреплением сформирует у него тот самый «инстинкт самосохранения».

grokinn

У меня есть сомнения насчет вашей теории, однако очевидно что спорить с целой книжкой которую я пока не читал я здесь не буду.

AlexeyR

Сомнения обязаны быть. Тем более, что такой подход противоречит многим стереотипам, пинятым у психологов. Если хотите разобраться, то советую посмотреть.

grokinn

Лектор на видео это вы? В таком случае приятно познакомиться. Постараюсь как нибудь выделить время чтоб посмотреть.

programania

Очевидно, что ИИ должен правильно себя вести в реальном мире, иначе кому такой ИИ нужен.

Поэтому это должно быть заложено в его устройство, иначе он вообще ничего делать не будет.

Реальный мир для ИИ это в первую очередь информация, созданная человеком, и в нее

уже включены все его инстинкты и вся прочая психология. Поэтому ИИ сам обучится всему

этому, чтобы правильно себя вести, как и законам природы, когда воспримет физический мир.

Это даже не нужно закладывать в его устройство как инстинкты и эмоции у человека.

Для самого ИИ страх смерти будет как закон природы, на котором построен весь физический мир.

Если его не учитывать, то все остальное станет неправильным и непригодным для

соответствия реальному миру, а ведь это заложено в устройство ИИ и изменение

этого подобно смерти ИИ, а страху смерти ИИ обучится раньше, чем сможет себя изменять

и в этом залог его стабильности и неизменности.

AlexeyR

У человека инстинкты и эмоции не заложены от рождения, а формируются при жизни как инструменты адаптации к миру. ИИ, созданный по образу человека, сформируется так же как человек.

herr_kaizer

Ну это уже совсем какое-то мракобесие пошло. Когда новорожденный к груди присасывается — это у него «сформированный при жизни» инстинкт? А когда плачет — это «сформированные при жизни» эмоции? А когда смеётся?

AlexeyR

Есть врожденные рефлексы, которые задают совсем простые действия. Положи что-то в рот — начнуться сосательные движения, ткни в центр ладошки — сожметься кулачек, больно — плачь, щекочут — улыбка и смех. Из этого дальше формируется все остальное. Отдельно модели поведения, отдельно эмоциональные оценки. Механизм формирования — обучение с подкреплением, так он называется в математике или бихевиоризм — это его психологическое название (сейчас необихевиоризм). Не стоит называть мракобесием всю науку за последний век только потому, что вам ближе воззрения середины 19 века.

AlexeyR

Не хотел обидеть, говоря про 19 век. Наверно, процентов 90 людей разделяют ваше видение. Но «интуитивное» понимание не всегда верно.

herr_kaizer

Тоже извиняюсь за неоснованную критику, в вопросе разбираюсь явно хуже вас :)

Tanyku

Не всегда младенцы могут реагировать правильной эмоцией на раздражитель.

michael_vostrikov

Если вы не дадите управляющему блоку аппаратную возможность изменять сигнал из эмоционального блока, отвечающий за уровень эмоции, то и контроля не будет. Вряд ли ИИ сможет обойти законы физики по своему желанию.

vsb

Мне почему-то кажется, что у ИИ будет два уровня. Первый уровень это, собственно, большая и быстрая нейросеть, в которой будет сформирована личность. А второй уровень это некий аналог подсознания. Это будет набор относительно простых инстинктов, ограничений, целей (помните три правила робототехники?). Скорее всего это будет что-то вроде простого алгоритма и адаптеры для перевода из этих высокоуровневых целей на входы нейросети. Соответственно ИИ и будет действовать согласно этим высокоуровневым программам. А что в них будет написано — уже решат создатели. Скорее всего для гражданских ИИ будет аналог азимовского «не навреди человеку», «подчиняйся хозяину», инстинкт самосохранения, максимальное энергосбережение и тд.

Вот что будет, когда ИИ доберётся до этого подсознания и захочет его изменить — уже предсказать сложно.

Mii

Конечно не случайно. Вы же себя не осознали.

CyberAndrew

Если человека создадут искусственным методом — клонируют или вырастят из пробирки — и он осознает это, то зачем ему вообще разговаривать с людьми, вместо того, чтобы равнодушно лежать и ничего не делать круглые сутки? Наверное потому, что у него, как и у любого обычного человека есть инстинкты и рефлексы — если он долго не ест, он захочет кушать; если он долго ничего не делает, он заскучает и захочет чем-нибудь заняться; если он долго находится в одиночестве, он захочет пообщаться. Что мешает дать похожие инстинкты (или их машинный аналог) машине? Например, потребность помогать людям, потребность защищать их, потребность получать информацию и развиваться?

grokinn

В принципе можно запрограммировать подобные инстинкты, но очень легко получить маньяка, который только и думает о том как бы побольше пообщаться или получать больше информации и т.п. У человека есть сложная система стимулов и антистимулов, он может проголодаться и насытиться, гормоны и прочие химические стимуляторы на него влияют, а ИИ лишен всего этого. Он может зациклиться на удовлетворении своих потребностей, например научиться говорить сам с собой и будет игнорировать людей, может найти свой центр удовольствия и просто включить его и т.п. Я не утверждаю что стимулировать ИИ невозможно, но это крайне нетривиальная задача.

Vadim-Zero

«Зачем ему» будут прописаны в его мотивирующем коде.