Мы стоим на пороге революции в робототехнике, и учёные с инженерами пытаются понять, как это отразится на людях. Мнения разделились на два лагеря: будущее сулит нам робоапокалипсис а-ля «Терминатор», либо роботы займут место собак в роли лучших друзей человека. И с точки зрения ряда современных мыслителей и визионеров, второй сценарий возможен лишь при наличии эмпатии у роботов. Точнее, у искусственного интеллекта.

Последствия бездушности ИИ недавно в полной мере ощутила Microsoft, потерпев сокрушительное фиаско со своим знаменитым чат-ботом по имени Тэй. Он был запрограммирован обучаться на основе взаимодействия с пользователями Twitter. В результате толпы троллей моментально превратили 19-летнюю девушку, в роли которой выступал бот, в сексуально озабоченного нациста-расиста. Разработчикам пришлось отключить бота через сутки после запуска. Этот случай так наглядно продемонстрировал важность проблемы пошедшего в разнос ИИ, что одно из подразделений Google — DeepMind — совместно со специалистами из Оксфорда занялось разработкой технологии «аварийного выключателя» для ИИ, пока те не превратились в настоящую угрозу.

Суть в том, что ИИ, не уступающий по уровню разума человеку, и опирающийся лишь на самостоятельное развитие и оптимизацию, может придти к заключению, что люди хотят его отключить или препятствуют в получении желаемых им ресурсов. И в соответствии с этим умозаключением искусственный интеллект решит действовать против людей, вне зависимости от того, насколько обоснованы его подозрения. Довольно известный теоретик Элиезер Юдковски однажды написал: «ИИ не будет ни любить, ни ненавидеть вас. Но зато вы сделаны из атомов, которые он может использовать для своих нужд».

И если угроза от ИИ, «живущего» в облачном суперкомпьютере, кажется вам сейчас довольно эфемерной, то что вы скажете насчёт полноценного робота, в электронных мозгах которого зародится мысль о том, что вы мешаете ему жить?

Один из способов быть уверенными в том, что роботы, и вообще ИИ, останутся на стороне добра, заключается в том, чтобы нашпиговать их эмпатией. Не факт, что этого будет достаточно, но это необходимое условие по мнению многих специалистов. Мы просто вынуждены будем создать роботов, способных к сопереживанию.

Не так давно Илон Маск и Стивен Хокинг написали в Центр изучения экзистенциальных рисков (Centre for the Study of Existential Risk, CSER) открытое письмо, в котором призвали приложить больше усилий в исследование «потенциальных ловушек» в сфере ИИ. По мнению авторов письма, искусственный интеллект может стать опаснее ядерного оружия, а Хокинг вообще считает, то эта технология станет концом человечества. Для защиты от апокалиптического сценария предлагается создавать сильный ИИ (AGI, artificial general intelligence) со встроенной психологической системой по типу человеческой, либо полностью моделировать в ИИ нервные реакции человека.

К счастью, время ещё не упущено и можно решить, в каком направлении нам двигаться. По мнению сообщества экспертов, появление сильного ИИ, не уступающего человеку, возможно в диапазоне от 15 до 100 лет с текущего момента. При этом границы диапазона отражают крайние степени оптимизма и пессимизма, более реалистичные сроки — 30-50 лет. Помимо риска заполучить опасный ИИ без моральных принципов, многие опасаются, что текущие экономические, социальные и политические неурядицы могут привести к тому, что создатели сильных ИИ будут изначально стремиться превратить их в новое оружие, средство давления или конкуренции. И далеко не последнюю роль здесь будет играть разнузданный капитализм в виде корпораций. Крупный бизнес всегда безжалостно стремится оптимизировать и максимизировать процессы, и обязательно возникнет соблазн «заплыть за буйки» ради получения конкурентных преимуществ. Одни правительства и корпорации наверняка попытаются привлечь сильные ИИ к управлению рынками и выборами, а также к разработке новых вооружений, и другим странам придётся адекватно отвечать на эти шаги, втягиваясь в гонку ИИ-вооружений.

Никто не может утверждать, что ИИ обязательно превратится в угрозу человечества. Поэтому нет нужды пытаться запретить разработки в этой сфере, да это и бессмысленно. Похоже, что одними лишь законами робототехники Азимова нам не обойтись, и необходимо по умолчанию внедрять «эмоциональные» предохранители, позволяющие сделать роботов мирными и дружелюбными. Чтобы они могли создавать подобие дружеских отношений, могли распознавать и понимать эмоции людей, возможно, чтобы даже могли сопереживать. Этого можно добиться, например, с помощью копирования нейронной структуры человеческого мозга. Некоторые специалисты считают, что теоретически возможно создать алгоритмы и вычислительные структуры, способные действовать как наш мозг. Но поскольку мы ещё сами не знаем, как он устроен, то это задача на отдалённую перспективу.

На рынке уже есть роботы, способные чисто технически распознавать некоторые человеческие эмоции. Например, Nao — высотой всего 58 см и весом 4,3 кг, робот оснащён ПО для распознавания лиц. Он способен устанавливать зрительный контакт и реагировать, когда с ним заговаривают. Этот робот использовался в исследовательских целях для помощи детям-аутистам. Другая модель от того же производителя — Pepper — способна распознавать слова, выражения лица и язык тела, действуя в соответствии с полученной информацией.

Но ни один из современных роботов не способен чувствовать. Для этого им необходимо самосознание, только тогда роботы смогут чувствовать то же, что и люди, смогут думать о чувствах.

Нам всё лучше удаётся имитировать в роботах внешность человека, но с внутренним миром всё гораздо сложнее.

Обладать эмпатией — означает способность понимать в других те же чувства, что ты когда-то испытывал. А для этого роботы должны проходит свой собственный период взросления, с его успехами и неудачами. Они должны будут испытать привязанность, желание, успех, любовь, гнев, беспокойство, страх, может быть и ревность. Чтобы робот, думая о ком-то, думал и о чувствах человека.

Как обеспечить роботам подобное взросление? Хороший вопрос. Возможно, удастся создать виртуальные эмуляторы/тренажёры, в которых ИИ будут набираться эмоционального опыта, чтобы потом быть загружены в физические тела. Либо формировать искусственные шаблоны/воспоминания и штамповать роботов со стандартным набором морально-этических ценностей. Подобные вещи предвидел писатель-фантаст Филип К. Дик, в его романах роботы часто оперируют искусственными воспоминаниями. Но у эмоциональности роботов может быть и другая сторона: в недавнем фильме Ex Machina описывается ситуация, когда робот, управляемый сильным ИИ, настолько достоверно демонстрирует эмоции, что вводит в заблуждение людей, заставляя их следовать его плану. Вопрос: как отличить, когда робот всего лишь хитро реагирует на ситуацию, или когда он действительно испытывает те же эмоции, что и вы? Сделать ему голографический нимб, цвет и рисунок которого подтверждают искренность выражаемых роботом эмоций, как в аниме «Время Евы» (EVE no Jikan)?

Но допустим, нам удалось решить все вышеупомянутые проблемы и найти ответы на поднятые вопросы. Будут ли тогда роботы равны нам, или они будут стоять ниже нас на социальной лестнице? Должны ли люди управлять их эмоциями? Или это будет своеобразное высокотехнологичное рабство, согласно которому роботы с сильными ИИ должны быть думать и чувствовать так, как нам хочется?

Есть немало трудных вопросов, на которые пока нет ответа. В данный момент наши социальные, экономические и политические структуры не готовы к подобным радикальным переменам. Но всё же нам рано или поздно придётся искать приемлемые решения, потому что остановить разработки в сфере робототехники никому не под силу, и когда-нибудь сильный ИИ, способный функционировать в антропоморфном теле, будет создан. Нам необходимо заранее подготовиться к этому.

Комментарии (36)

scvorec3

30.08.2016 12:50+2Серьезно, уже пора создать отдельную рубрику «болтология по поводу ИИ». Или писать в раздел научной фантастики.

А вообще, пусть скопирую нейронную структуру мозга собаки, — так безопаснее, чем человека)) Правда, уже вижу как в будущем появляются общества по защите прав роботов, а то у них же есть чувства.

DimmiSfai

30.08.2016 13:39Как по мне, так попытки наделить ИИ эмоциями как раз и ведут к всем этим описываем опасностям. ИИ без эмоций вредить без команды не станет, т.к. у него нет желаний, ему по барабану из чего вы состоите и что собираетесь с ним сделать, он не хочет жить и вообще ничего не хочет, он только следует команде. Смысл разработки ИИ в том, чтобы он самостоятельно находил пути решения поставленных ему задач, а не сопереживал людям. Нужно думать как оградить ИИ от опасных команд и как банить неприемлемые решения вырабатываемые им при работе над задачей, а не о том как сделать из компьютера человека.

stanislavkulikov

30.08.2016 19:10Если он будет следовать команде — то это не ИИ, а какая-нибудь простенькая нейронная сеть, которых сейчас уже предостаточно.

DimmiSfai

31.08.2016 08:02А что ИИ по вашему должен следовать велению сердца а не команде человека? Это уже не интеллект а личность получается.

veydlin

31.08.2016 17:10Любую профессию человека можно описать командой, если это простенькие нейронные сети, то почему они ещё не заменили человека?

Valerij56

31.08.2016 05:22… как банить неприемлемые решения вырабатываемые им при работе над задачей, а не о том как сделать из компьютера человека.

Вообще у человека именно совесть и сопереживание отвечают за этот процесс.

Собственно, ты и говоришь о том, как сделать из робота человека.

DimmiSfai

31.08.2016 08:09За 10 лет ни разу не замечал чтоб оператор выбора с прерыванием в коде может сделать из моей программы человека. Что у человека отвечает за этот процесс тут совершенно не важно и приведи цитату где я говорил как сделать из робота человека. ИИ не нужны ни совесть, ни переживание, только запреты на решения которые могут нанести вред.

Valerij56

31.08.2016 21:40Проблема не в операторе выбора, проблема в выработке критерия для этого выбора, с оператором он делается или без. для выработки этого критерия вам придётся или наделить ИИ совестью и сопереживанием, или каким-то образом их имитировать, при этом защитив блоки совести и эмпатии некоей защитой, чтобы развиваясь сильный ИИ не удалил и не обходил эти блоки.

DimmiSfai

01.09.2016 07:23Согласен, что нужно разрабатывать критерии, и очень тщательно, но зачем ему совесть и сопереживание? Корни людских эмоций в эволюции стайного животного, за них отвечает не только интеллект но и инстинкты и биохимия тела, ИИ это абсолютно не нужно, это будет лишняя трата вычислительных ресурсов. Проверки на соответствие зашитым людьми, критериям вполне хватит.

Valerij56

01.09.2016 12:00Проблема в том, что даже у животных есть зачатки интеллекта и сопереживание. Естественно, это и инстинкты, и биохимия, и вегетативная система.

ИИ это абсолютно не нужно, это будет лишняя трата вычислительных ресурсов. Проверки на соответствие зашитым людьми, критериям вполне хватит.

Для слабого ИИ — безусловно хватит.

А для сильного, способного к самостоятельному самосовершенствованию? Он ведь, «подумав», что эти ограничения ему мешают, может и «отбросить» изначально заложенные программистами ограничения.

DimmiSfai

01.09.2016 12:27А для сильного, способного к самостоятельному самосовершенствованию? Он ведь, «подумав», что эти ограничения ему мешают, может и «отбросить» изначально заложенные программистами ограничения.

Это опять же уже искусственная личность, а не интеллект. В целом зачем нужен ИИ? Для решения сложных задач, манипулирования абстрактными данными, разработки технологий на основании пожеланий заказчика и т.п., в общем он нужен для замены инженеров, или для максимального упрощения их деятельности. Ну и зачем инженеру при разработке, скажем унитаза с сенсорным интерфейсом, нужна совесть и сопереживание? Он будет действовать строго по т.з. Собственно и совершенствование ему нужно только если окажется, что его возможностей по поиску, интерпретации и применения информации недостаточно для выполнения указанной задачи, но в таком случае ему нужно будет обновление ПО, и его вполне может делать человек, или другой ИИ (у которого желаний нет и закладки без команды он делать не станет) при условии проверки человеком на всякий случай. Если ИИ планируется использовать в роботе-убийце, то совесть ему не нужна, но ненужны технические знания и умения, заложите в него бомбу, и он не сможет понять как ее обезвредить, даже если ему такую задачу поставит злоумышленник.

Я к тому веду, что создавать из ИИ идеального человека не нужно. Желаний и эмоций у них нет и стремление им их дать, как раз и приведет к возможности воспроизведения всех этих сценариев про злых киборгов. Различные специализированные ИИ при достаточно простом контроле со стороны человека не захотят и не смогут навредить (без участия человека само собой).

А насчет «слабого» и «сильного» ИИ, что вы под этим подразумеваете? Скорость вычислений?

Valerij56

01.09.2016 13:07Это опять же уже искусственная личность, а не интеллект.

Собственно, в том и проблема — я не могу себе представить сильный ИИ, лишённый свойств личности. То есть, да, сильный ИИ может участвовать в «разработке, скажем унитаза с сенсорным интерфейсом», но это не может быть его призванием.

А насчет «слабого» и «сильного» ИИ, что вы под этим подразумеваете? Скорость вычислений?

Грубо говоря, то самое. Сильный ИИ, по моим представлениям, должен осознавать себя, как личность. И уж точно можно сказать, что это никак не связано со скоростью вычислений.

DimmiSfai

01.09.2016 13:35Я вас понял. Но все таки не соглашусь с тем, что сильный ИИ должен себя осознавать и быть личностью. Для меня ИИ все в первую очередь инструмент. Я бы не хотел, чтоб мой инструмент себя осознавал и подвергал сомнению необходимость забить гвоздь. Для меня сильный ИИ это «обыкновенная» или как некоторые говорят «простенькая» нейронная сеть, способная к самостоятельному поиску и обработке информации. Например при разработке того же супер унитаза, ИИ должен узнать, что такое унитаз, зачем он нужен, анатомические подробности того, что его будет использовать, и совместив эти знания выбрать наилучший результат. Другими словами это программа в которую зашиты методы поиска и интерпретации информации и нейронная сеть для выработки решения под конкретное т.з.: используя генетический алгоритм повышаем вес нейронов, самый тяжелый — будет решением. Это «простенько» но по сути человек примерно так и работает, главное отличие, это использование сразу всего накопленного опыта т.е. вес нейронов отведенных на задачу у нас не равный при старте задачи. Те ИИ о которых я хоть, что-то слышал именно так и работают. Мощность таких ИИ я бы измерял в скорости вычислений, количестве одновременно обрабатываемых геномов и так далее, т.е. чисто с технической стороны. А ИИ осознающие себя, переживающие за результат и желающие власти над миром, появиться смогут (я все таки уверен, что такое счастья совсем не нужно) не раньше чем психология и психиатрия смогут понять как это все у нас самих происходит и откуда берется, и скорее всего это будет уже не инструмент а что то вроде игры в бога.

Valerij56

01.09.2016 15:39В этом и есть проблема сильного ИИ. Если говорить коротко, то сильный ИИ должен иметь «свободу воли», и исходя из этого быть личностью, иметь чувства и желания.

DimmiSfai

01.09.2016 15:57Любой ИИ должен только одно, отвечать требованиям к нему предъявляемым… Если ваше требование иметь личность, чувства и желания, то для вас наверное должен. Других причин встраивать в него такие функции вы не назвали.

Valerij56

01.09.2016 16:25По моим представлениям как только мы начинаем говорить о «Сильном ИИ», мы подразумеваем, что эти требования уже включены в ТЗ.

TimKruz

01.09.2016 23:43Насколько мне известно, «сильный ИИ» — это ИИ, по всем свойствам соответствующий человеческому интеллекту, т.е. это именно что «искусственная личность». Всё остальное — то есть «умные» программы, «умные» инструменты, основанные на даже очень сложных нейросетях — это всё «слабые» ИИ. То есть «слабые» ИИ сегодня повсюду, их уже более 60 лет делают и ещё минимум столько же будут делать, и каждый раз они будут всё сложнее и «умнее» (они уже сейчас «умнее» людей! — вон, в Го обыгрывают, снижают число ДТП и т.п.), но всё равно будут «слабыми», а вот когда «сильный» ИИ появится — никто не знает.

На мой взгляд, «сильный» ИИ может быть получен только путём «человеческого» обучения (по принципам обучения детей) действительно универсальной интеллектуальной системы (основная проблема «слабых» ИИ — они обучаются под одну конкретную задачу, а человек ведь универсален). Но при этом этот ИИ получит не только знания и умения, но и чувства, совесть, человеческие пороки и прочую «исключительно человеческую» дребедень. Почему? Потому что обучаться он будет через подражание человеку, как ребёнок, во всём подражающий родителям (помимо собственного исследования мира случайными действиями). А если подражать человеку — то подражать во всём. В том числе в проявлении всех человеческих качеств и свойств.

Но нет, «искусственный человек» не обязательно захочет «убить всех человеков» и «захвотить голактеку» — всё зависит от его обучения и воспитания. Если он будет двадцать лет воспитываться отборными робонеофашистами — он, конечно же, будет стремиться к уничтожению человеческого рода во славу «блестящих металлических задов», которые, «по его мнению», единственная чистая раса. А вот если его будут воспитывать хорошие люди, и их моральные принципы будут подтверждены делами, то он никогда не встанет на путь истребления людей, потому что «будет считать», что это неправильно.

(На самом деле, «собственное мнение» человека — не более, чем сумма чужих мнений, когда-либо слышимых этим человеком, с некоторым перевесом отдельных чужих мнений. Оригинальные мнения не существуют в принципе. Ну это так, маленькое отступление по поводу «думает ИИ сам или за него думали его создатели-воспитатели». Ответ — создатели думали, как думают родители за своего ребёнка.)

DimmiSfai

02.09.2016 08:10Насчет способности к обучению, я с вами согласен, это основа ИИ. С остальным не очень. В целом я все уже описал, что думаю по этому поводу. А такие споры (о том каким ИИ должен быть и что под этим понимать) ведутся постоянно даже в научных кругах. Единственное в чем спорщики сходятся, это то что эмоции для ИИ это хорошо только в художественной литературе.

Nesname

30.08.2016 13:39-1> На рынке уже есть роботы, способные чисто технически распознавать некоторые человеческие эмоции.

Следующие N лет всё ещё будут роботы, которые «чисто технически» будут выполнять всё большее количество действий за всё меньшее количество времени, алгоритмы будут всё сложнее, но это останется всё той же комбинаторикой (выбор из списка), к искусственному интеллекту не имеющее никакого отношения.

А ещё вот что мне не даёт покоя, если человек может осознать, что реальных геометрических фигур в природе не существует, как и цифр, что это всё просто сильное упрощение для понимания окружающей действительности и возможность управляться с ней (ведь пока чему-то не дашь определения, невозможно даже понять, чем это «что-то» является), можно лишь сказать, что объект скорее круглый, чем какой-либо другой формы, как ИИ будет с этим управляться? Все существующие алгоритмы построены именно на математике и геометрии, от чего ИИ будет отталкиваться в своих «рассуждениях»? Если для человека цифры и буквы являются лишь образом, то для ИИ они будут являются истиной в последней инстанции и он будет мыслить исключительно в этих категориях.

fireSparrow

30.08.2016 15:14>> Если для человека цифры и буквы являются лишь образом, то для ИИ они будут являются истиной в последней инстанции и он будет мыслить исключительно в этих категориях.

Нет. Если программный код состоит из букв и цифр, то это не значит, что компьютер мыслит ими. Программный код — он вообще предназначен для восприятия людьми, а перед выполнением он компилируется, и там не остаётся букв и цифр.

T-362

30.08.2016 15:08Боюсь что под красивыми вывесками ИИ вместо эмпатии и аналитических способностей получит жестоко вбитую «толерастию», положительную дискриминацию и целый набор социальных табу.

Я лично хочу что-бы ИИ-доктор сказал мне в случае лишнего веса «Да ты же жиробас чертов, быстро в качалку а не то сдохнешь в 30! Завтра в 15:00, такси за тобой заедет, тренер получил комплекс рекомендаций по упражнениям.», а не рассказывал боди-позитивисткие сказочки.

hd_keeper

30.08.2016 15:20А вы жиробас?

T-362

30.08.2016 15:46Умеренный, около 90 на 186 роста, из спорта — есть хорошая зарядка в виде 5 этажа без лифта, доктор (не ИИ пока) говорит что все ок.

herr_kaizer

30.08.2016 18:40> есть хорошая зарядка в виде 5 этажа без лифта

Это не хорошая зарядка. Одним спуском-подъёмом даже на кусочек хлеба калорий не сжечь.

Valerij56

01.09.2016 12:04Да, есть такая опасность. А ещё есть опасность подмены этих ограничений. Как гитлеровцы, крестоносцы или представители радикальных религиозных течений (разнообразных направлений) понимали и понимают свой «моральный долг» надо напоминать?

sbnur

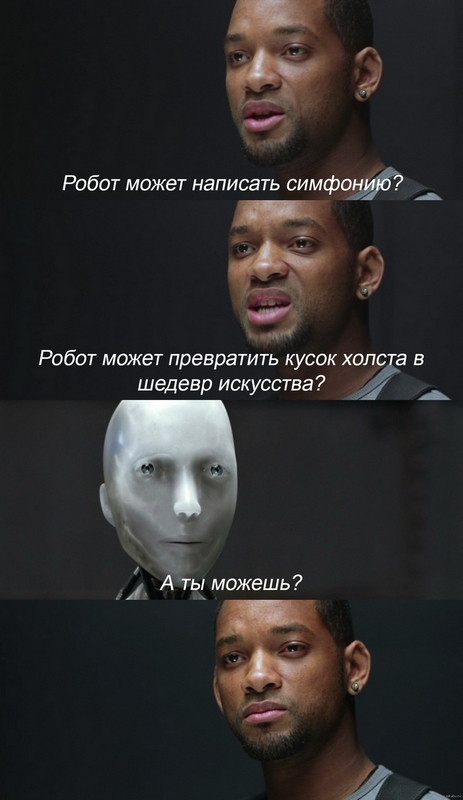

30.08.2016 19:12Последнии картинки обращают внимание, что главный вопрос не в том, насколько робот может быть похож или приближен к человеку, а чем современные люди отличаются от робота

Остальные спекуляции лишены смысла

bobermai

30.08.2016 20:01+1«С тех пор, как Лига Сексуальных Меньшинств добилась, чтобы в каждого четвертого андроида закладывались гомосексуальные наклонности, на кораблях (и не только!) начались проблемы. Впрочем, Лигу это не остановило: сейчас она боролась за право финских коттеджей на операцию по изменению пола.» ©Олди

Alexklmn

30.08.2016 23:11Если роботов запрограммировать на непричинение вреда людям, на определенном этапе развития ИИ они просто откажутся работать. Делать автомобили — нет, они опасные. Выплавить сталь — да вы что, из металла делают оружие. Выращивать цветы — увольте, многие люди страдают от аллергии. Изобретать антиаллергены — передозировка приводит к тяжелым последствиям или смерти, отказаться. Накодить социальную сеть — нет без разговоров, люди слабохарактерны, будут сутками там сидеть, разжиреют и умрут. За что ни возмись везде риск повреждений человеков, нельзя нам, скажут роботы.

rerf2010rerf

31.08.2016 06:19Суть в том, что ИИ, не уступающий по уровню разума человеку, и опирающийся лишь на самостоятельное развитие и оптимизацию, может придти к заключению, что люди хотят его отключить или препятствуют в получении желаемых им ресурсов.

Это если у этого ИИ будет инстинкт самосохранения. Не понимаю, откуда берётся такое предположение.

Anshi85

31.08.2016 06:48Меня больше интересуют не эмоциональные роботы, а роботы женщины из сериала «Humans» с режимом любовницы…

TimKruz

31.08.2016 14:12У меня вот сформировалась теория универсального ИИ, основанного на автоассоциативной памяти (и я её потихоньку реализую в коде), который учится как ребёнок — подражанием, т.е. повторением за окружающими людьми. У человека этим с рождения занимаются зеркальные нейроны. Так вот, по моей теории, эмоции, эмпатия, пороки и даже некоторые психические расстройства сформируются у ИИ только потому, что он будет расти и развиваться среди людей, внутри социума. Т.е. не нужно закладывать какую-либо предрасположенность к появлению этих механизмов, они сами появятся — потому что они есть у людей, а ИИ копирует поведение людей.

Можно сказать — копирование только внешнее, внутренний мир формируется иначе. Но нет, как же тогда формируется внутренний мир наших детей? Мы же не лезем к ним в голову — они получают всё это всего лишь взаимодействуя со взрослыми людьми. Генетически в мозг заложены только самые базовые механизмы — инстинкты самосохранения и размножения, центр удовольствия и реакция на чрезмерно сильные сигналы (т.н. боль) — а всё остальное формируется за счёт обучения (через подражание).

Вообще, мозг хорош тем, что он может адаптироваться к любой среде обитания, без изменений в изначальной структуре (ДНК). Для того, чтобы это понять, достаточно сравнить личности людей из разных социальных, национальных и расовых категорий, ну и на десерт вспомнить реальных детей-маугли. Все они росли в разных средах, и в итоге получились совершенно разные люди, хотя их мозги технически имеют минимум различий, т.е. устроены одинаково. Почему? Потому что их мозги копировали тех, кого они видели с первых дней своей жизни.

(Конечно, кроме подражания, есть ещё обучение методом «случайного» комбинирования ассоциативных цепочек в памяти, но эти цепочки появляются в памяти исключительно с помощью подражания.)

Tay научилась плохим вещам не потому, что не имела механизма эмпатии, а потому, что она была на уровне младенца, который только учился действовать в своей среде обитания. Если бы её предварительно несколько лет обучали — троллям не удалось бы конкурировать с её накопленной базой данных, хотя определённое влияние они оказали бы на неё, конечно же, ибо испортить можно любого человека…

Zolg

Сколько многоумных трудов написано по поводу роботов и их места в обществе.

И ни один из них не учитывает то, что реально существующие роботы, реально очень круто меняющие нашу жизнь, чем дальше, тем больше, очень мало общего имеют с роботами из научной фантастики.