Всем привет! Продолжаем нашу повесть о том, как идет строительство с чистого поля нового дата-центра «Авантаж», который станет одной из крупнейших коммерческих площадок московского региона. Сегодня обстоятельно прогуляемся по серверным залам, зайдем в холодоцентр, энергоцентр, поднимемся на крышу ЦОДа – будет интересно. Кто пропустил – с первой частью нашего рассказа можно ознакомиться здесь. Внимание, впереди много фото!

Шагаем к цели

Посмотрим, как выглядит сегодня наш объект. И начнем мы с серверных залов (гермозон/машзалов). Всего серверных залов будет 16, располагаются они на 2-х этажах технологического блока, по 8 серверных залов на этаже. Каждый серверный зал имеет размеры в плане 13,1 х 30,2 м (S = 396 кв.м) и высоту (от чистого пола до потолка) 5,0 м, способен вместить до 140 серверных шкафов размером 800х1200 мм. Проектная мощность серверного зала составляет 700 кВт.

Охлаждение серверных залов обеспечивают прецизионные кондиционеры, которые устанавливаются как внутри, так и снаружи машзалов. В 13-ти серверных залах из 16-ти, прецизионные кондиционеры установлены вне машзалов — вынесены в выделенные технологические коридоры. Это сделано с целью ограничить и/или исключить доступ обслуживающего персонала объекта в машзалы и обеспечить выполнение требований службы безопасности объекта и/или клиента. Система кондиционирования машзала включает в себя 8 кондиционеров, при этом обеспечивается резервирование по схеме N+1, где N соответствует 7-ми кондиционерам, способным обеспечить отвод теплопоступлений от технологического оборудования в объеме 735 кВт и поддержание температуры подаваемого воздуха на отметке +24°C. Всего в проекте предусмотрена установка 128 прецизионных кондиционеров в серверных залах и четырех кондиционеров в 2-х кроссовых помещениях.

Заглянем в одну из наших гермозон с максимальной готовностью к запуску. Кондиционеры для нее расположены снаружи в технологическом коридоре (внешнее расположение кондиционеров) – ниже на фото.

В машзалах закончилась установка магистральных и распределительных шинопроводов, благодаря которым будет подаваться питание к серверам клиентов. Магистральный шинопровод номиналом 1600 А, обеспечивает подачу питания от главного распределительного щита (ГРЩ) непосредственно в машзал к распределительным шинопроводам. Распределительный шинопровод, номиналом 160А, обеспечивает подачу питания от магистрального шинопровода к серверам клиентов. Для подключения ИТ-стоек на распределительном шинопроводе смонтированы отводные блоки отбора мощности с автоматическими выключателями. Для каждого машзала электропитание выполнено по двухлучевой схеме, от двух различных ГРЩ.

Стоит отметить, что решение по построению распределительных систем универсальное: в случае, если клиенту понадобится смещать ряды ИТ-стоек, изменять габариты проходов и/или изменять ширину ряда ИТ-стоек, то подвесная распределительная система может перемещаться по потолочной рельсовой системе.

Немного о системе безопасности. Объект оборудован системой видеонаблюдения, системой контроля доступа с настраиваемым режимом/уровнем доступа для клиентов и обслуживающего персонала. В машзалах реализована модульная система видеонаблюдения. В зависимости от потребностей клиента это позволяет добавлять видеокамеры.

Кроме того, в машзалах реализована звуковая и световая система оповещения о пожаре и любой другой ч/с, аспирационная система (система раннего обнаружения дыма) и, конечно же, централизованная система газопожаротушения (на фото – желтые трубопроводы газового пожаротушения).

Также смонтирована система приточно-вытяжной вентиляции, обеспечивающая избыточность давления и требуемый уровень влажности в машзалах.

Поскольку кондиционеры для данной «красной» гермозоны расположены вне зала (их мы показали в самом начале), то для обеспечения требований пожарной безопасности в стене машзала, на подачу и забор воздуха кондиционера, установлены противопожарные клапана (огнезадерживающие клапана, ОЗК).

На фото: привод заслонки клапана в открытом положении (сверху), вентиляционные короба забора и подачи воздуха.

Еще одна наша гермозона – «Желтая», где кондиционеры смонтированы непосредственно в самом помещении. В данной гермозоне приступили к нагрузочным тестам, для этого смонтировали и подключили к штатной сети электропитания 7 тепловых пушек. Каждая тепловая пушка – это 100 000 Вт (для сравнения: утюг – 1500 Вт). Тестирование проводится на расчетную мощность машзала – это 700 кВт. Семь теплых пушек способны обеспечить тепловыделение в объеме 700 кВт. Нагрузочные тесты длятся 72 часа.

Кроме того, сейчас здесь идет создание внутренней инфраструктуры для размещения ИТ-мощностей заказчиков. В частности, идет монтаж шкафов под сервера клиентов. Шкафы отечественного производства Masterwork-telecom. Cистема изоляции холодного коридора также отечественная, производства C3 Solutions. Кстати, в сентябре проводили испытания ее противопожарных клапанов – показали себя отлично.

Прецизионных кондиционеров в серверном зале 7+1 штук производства Tecnair LV. 7 кондиционеров полностью обеспечивают холодом весь зал гермозоны. 8-ой кондиционер резервный. Каждый кондиционер обеспечивает холодопроизводительность 105 кВт.

Заглянем в еще одну гермозону, она у нас тоже «Желтая». Готовность здесь ниже, чем у остальных, еще нет фальшполов. Зато видна смонтированная система газового пожаротушения, которая располагается не только под потолком серверного зала, но также и под фальшполом. Кондиционеры установлены в технологическом коридоре (на фото можно увидеть противопожарные клапана (ОЗК), устанавливаемые на подаче воздуха из кондиционера под фальшпол).

Поскольку кондиционирование близлежащих гермозон внешнее, то кондиционеры вынесены в технологический коридор и расположены по его обеим сторонам. Для машзалов первого пускового комплекса испытания уже проведены (на фото ниже правый ряд кондиционеров). Кондиционеры машзалов второго пускового комплекса (по левой стороне) смонтированы, смонтирована и гидравлическая система холодоснабжения, подготовлена к гидравлическим испытаниям.

Кстати, здесь же хорошо можно рассмотреть спринклеры системы автоматического водяного пожаротушения.

В «Авантаже» предусмотрены две централизованные станции газового пожаротушения. Вместе они покрывают весь объем дата-центра. Станции абсолютно идентичны, одна из них на фото ниже. Строительно-монтажные работы здесь закончились в феврале 2017.

В каждой станции расположены 24 газовых баллона, магистральный и распределительный трубопроводы, по которым газ направляется по распределенному маршруту, охватывая половину всех помещений ЦОДа. В каждом красном баллоне объемом 180 литров находится 150 кг газа хладон. Газовые баллоны второго ряда образуют горячий резерв, который срабатывает при сбое в работе основного, первого ряда баллонов. Производитель этой системы пожарной безопасности отечественный — АСПТ Спецавтоматика.

Пожарные шкафы с гидрантами, рукавами и огнетушителями расположены по всем коридорам ЦОДа.

Холодоцентр – это сердце системы кондиционирования серверных залов ЦОДа. Организован он в отдельном одноэтажном блоке. На сегодняшний день здесь смонтированы холодильные машины (чиллеры), проведены пуско-наладочные работы первого пускового комплекса, идет тестирование системы холодоснабжения с тестовой тепловой нагрузкой на проектную мощность. Параллельно с этим ведутся монтажные работы второго пускового комплекса.

Холодильные машины (чиллеры) импортные, производства фирмы Cofely (Германия). Чиллеры внутренней установки с конденсатором охлаждаемым жидкостью с центробежными компрессорами Turbocore. На фото ниже один из контуров хладоснабжения и сами чиллеры.

Воздуховоды системы технологической вентиляции холодоцентра.

Для каждого чиллера предусмотрен собственный щит электроснабжения. Каждый чиллер обеспечивается двумя независимыми вводами электропитания. На шинопроводе видна коробка отбора мощности подключения щита питания чиллера.

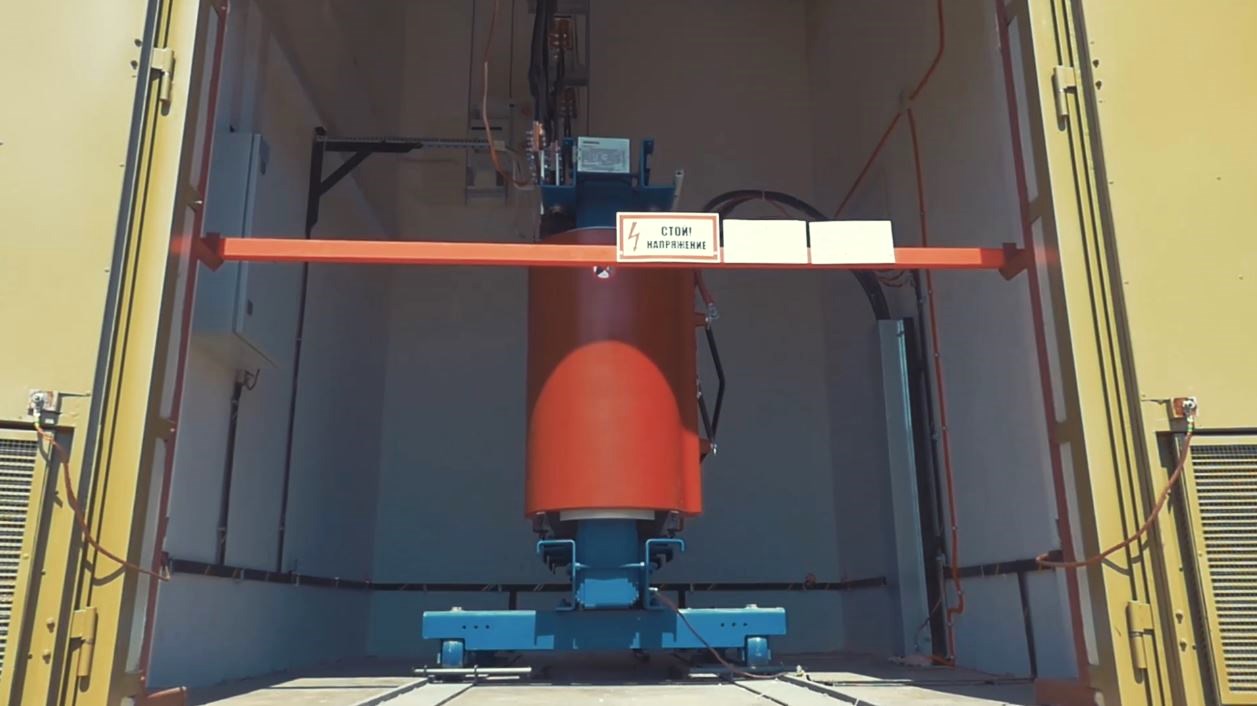

Теперь немного расскажем о системе электроснабжения «Авантажа». На случай блэкаута в ЦОДе предусмотрена система бесперебойного и гарантированного электроснабжения (СБГЭ). Она организована на базе дизель-роторных источников бесперебойного питания (ДРИБП), производства Hitec Power Protection (Голландия), смонтированных на 1-м этаже 2-х этажного блока энергоцентра. ДРИБП внедрены в систему электроснабжения на уровне 10 кВ. Всего на объекте в два этапа будет смонтировано 14-ть установок. Уровень резервирования СБГЭ N+1. На первом этапе вводятся в работу 5-ть установок: 4-е основные (N), пятая резервная (+1). На втором этапе вводятся все 14 установок: 13-ть основные (N), четырнадцатая резервная (+1).

Пусконаладочные работы на ДРИБП первого этапа были завершены в ноябре. Установки работают постоянно, обеспечивая фильтрацию электрической энергии, поступающей от сети к потребителю и от потребителя в сеть.

При пропадании внешнего электропитания, объект обеспечен запасом топлива для ДРИБП, который обеспечивает автономность работы объекта на период не менее 12 часов при 100% загрузки объекта. Все машинные/дизельные помещения оборудованы системой газового пожаротушения с тех же централизованных станций, что мы уже показывали выше.

Напротив помещений ДРИБП расположены залы с повышающими трансформаторами, на которых происходит повышение уровня напряжения с 0,4 кВ от ДРИБП (сами ДРИБП выполнены на напряжение 0,4 кВ) до 10 кВ в распределительную сеть энергоцентра. На объекте предусмотрено и установлено 14-ть силовых повышающих трансформаторов 0,4/10 кВ производства компании Siemens.

Распределение электроснабжения на среднее напряжение 10 кВ построено на базе средневольтных ячеек производства Siemens. Смонтированы они на 1-м этаже блока энергоцентра. На данном уровне напряжения обеспечивается прием элекропитания от городской сети, подключение ДРИБП и распределение на две независимые параллельные секции шин системы бесперебойного и гарантированного электроснабжения, подключение понижающих трансформаторов потребителей. Всего проектом предусмотрено и смонтировано 11 средневольтных секций.

На сегодняшний день система электроснабжения на среднее — 10 кВ и низкое — 0,4 кВ напряжение отлажена и находится в опытной эксплуатации. Таких помещений с ячейками распределения напряжения у нас 6 штук, всего 112 ячеек 10 кВ серий NXair, Simosec и 8DJH.

На фото ниже шкаф управления генераторными установками параллельной системы. Отсюда осуществляется визуальный контроль работы машин ДРИБП. Рядом с ним, через проход, смонтирован шкаф постоянного оперативного тока с комплектом АКБ, который обеспечивает независимое питание цепей управления средневольтных ячеек и панелей управления установок ДРИБП.

На объекте предусмотрено и смонтировано 27 силовых понижающих трансформаторов 10/0,4 кВ производства компании Siemens.

На втором этаже блока энергоцентра размещена система технологической вентиляции и система управления дизель-роторных источников бесперебойного питания.

Поднимемся на крышу и посмотрим немного на ЦОД сверху. Здесь над помещениями технологического блока расположились 18 сухих охладителей производства компании Cabero. В проекте сухие охладители используются для отвода избытков тепла в атмосферу. При температуре внешнего воздуха ниже +6С система холодоснабжения ЦОД переходит в режим прямого охлаждения (Freecooling), в котором не используются холодильные машины (чиллера).

Здесь же на фото хорошо видны молниеприемные мачты. Объект защищен системой молниезащиты. Оборудование, вынесенное на крышу, защищено от прямого попадания молнии комбинированным решением, выполненным на молниеприемной сетке и молниеприемных мачтах. Внутри объекта на вводных линиях с городской сети и кабельных линиях вынесенного на улицу оборудования применены устройства защиты от импульсных перенапряжений УЗИП.

Ниже на фото видны выхлопные трубы от генераторных установок энергоцентра и система его вентиляции (шахты забора и выброса).

Пару слов о топливохранилище. Его объем – 180 м?, рассчитан на 24 часа автономной работы при полной нагрузке. На фото видны горловины топливных емкостей для дизельного топлива, заглубленных в землю. Слив из топливозаправщика в баки происходит через заправочную станцию.

Первый телекоммуникационный объект появился на строительной площадке «Авантажа» еще в марте 2017г. Оператор сотовой связи МТС установил мобильную базовую станцию на строительной площадке дата-центра. Таким образом, обеспечено хорошее покрытие мобильной связью во всех помещениях строящегося объекта.

На площадке «Авантаж» замкнут контур физической безопасности, отвечающий самым высоким требованиям. Работы были завершены еще в июле 2017-го. Причины выбора такой защиты:

- жёсткая сварная конструкция;

- минимальная возможность проникновения;

- противоподкопное устройство пресекает несанкционированное вторжение злоумышленников под основным защитным ограждением.

Следующим этапом были установлены видеокамеры и вибродатчики.

Красота имеет значение

Ну, конечно, год назад ни о какой красоте речи еще не было. Для сравнения с КДПВ несколько фото о том, как выглядел наш ЦОД год назад. Здания уже стоят, но вот о благоустройстве территории еще ни слухом, ни духом.

Благоустройством мы начали заниматься еще зимой 2016-го, но до снегопадов мало что удалось успеть. Так что, как только сошел снег весной 2017, мы резво взялись за территорию. Что же изменилось на сегодняшний день? Сейчас у нас ровные дороги, зеленые газоны (летом, конечно)… ну, в общем все как и полагается.

Само здание ЦОДа теперь нельзя не заметить. На торце административного здания водрузился огромный логотип с названием – Avantage Центр Обработки Данных.

В мае 2017-го стартовали работы по архитектурному освещению ЦОДа. И постепенно он стал красив как днем, так и ночью. К сентябрю на площадке были полностью завершены работы по подсистемам наружного и архитектурного освещения.

На этом на сегодня всё. С вопросами прошу в комментарии. А всем кому интересно посмотреть на него вживую – добро пожаловать на бесплатную экскурсию. Записаться можно здесь.

Комментарии (16)

werklop

26.12.2017 16:29Возможно задам глупый вопрос, но очень интересно, почему не строят ДЦ в северных широтах, да хоть вплотную к побережью северных морей, примыкающих в ледовитому океану? Это же колоссальная экономия на охлаждении, плюс наверняка множество упрощений, например, в обеспечении безопасности, пожаротушении и пр. Предполагаю, что основные проблемы, это обеспечение электроэнергией и передачей данных, но думаю, что это не такие уж неразрешимые вопросы, как с технической, так и экономической точки зрения. Если есть ответы на каких-либо форумах или других источниках, поделитесь плиз. заранее благодарен

TS_IT Автор

26.12.2017 16:31Спасибо за вопрос! Вот ответ, который сегодня нам дал генеральный директор ООО «Авантаж» — Александр Крок: «Опыт строительства ЦОДов в северных широтах, например, в скандинавских странах, насчитывает уже много лет, однако, необходимо учитывать такие важные требования, как катастрофоустойчивость и отсутствие объектов повышенной опасности, в том числе природного характера. Тем более, инфраструктура наших северных широт не располагает нужными для строительства ЦОДов возможностями».

werklop

26.12.2017 16:41И чем же отличаются наши территории от скандинавских(например, Норвежское побережье и побережье Мурманской области)? У нас что там, цунами или землетрясения могут быть?

По поводу «нужными для строительства ЦОДов возможностями», вы меня конечно извините, но это левые отписки, как всегда. Ямал СПГ, нефтедобывающие и перерабатывающие заводы работают, а ЦОД якобы не может, ну глупости же. Проблемы с электроэнергией? Поставьте ветряки, на худой конец — АЭС(заодно и будет развитие северного региона). Передача сигнала? Если дорого тянуть оптику, радиоканал, ретрансляторы вам в помощь.

Так прямо и скажите, что там строить неинтересно, в краткосрочной перспективе не выгодно, ну и всякие другие отмазки, будет правдиво и очевидно.

Еще раз извиняюсь за столь эмоциональную реплику, просто уже пригорает)

maxlazar

27.12.2017 08:31проблемы вы скорей всего правильно обозначили, а вот решения… Какое поле ветряков понадобиться для нормального ЦОДа? Какой радиоканал для нормального ЦОДа? Какая стоимость услуг будет у этого ЦОДа?

Это будет недоЦОД и экономия на охлаждении будет окупаться очень долго. Это нужен бизнес план лет так на 50-80. А у нас, даже в горизонте 10 лет ничего нельзя предсказать из-за нестабильности и уже тем более — из-за возможного технического прогресса за эти 50-80 лет.

Night_Snake

27.12.2017 09:58Строительство ЦОД — это всегда про деньги. Чаще всего — очень большие деньги. А теперь давайте посмотрим, без чего ЦОД не может:

— ну с холодом мы разобрались. Хотя фрикулинг возможен даже в более южных широтах, нежели Мурманск

— электроэнергия. ЦОД потребляет электричества, как хороший алюминиевый завод, и вводов нужно минимум два. Где у нас на севере избыток генерирующих мощностей? Не видно… Ветряки не дают гарантированный уровень и требуют огромных вложений сами по себе. АЭС — проект минимум на 5-10 лет, и кому потом продавать ту энергию, что останется? Потребителей нет и не предвидится

— какналы связи. Какие радиоканалы, о чём вы? В средний ЦОД приходят сотни волокон от десятков операторов. Это 10/40G без уплотнения на каждую пару волокон. А строительство и обслуживание оптики, тем паче в труднопроходимых местах — дело очень затратное. И потом — откуда строить? 90% трафика в РФ — это Москва и Питер, потребители/генераторы трафика сидят там же. Тянуть оптику из СПб в Мурманск в промышленных масштабах — зачем?

И да, упомянутые вами нефтянники и газовики вполне строят мини-цоды рядом с месторождениями, если того требует бизнес. Довольно часто — контейнерного типа (это когда весь ЦОД помещается в стандартные морские контейнеры, и надо только подать питание).

В общем, ничего личного, просто бизнес.

werklop

27.12.2017 12:30АЭС — проект минимум на 5-10 лет, и кому потом продавать ту энергию, что останется? Потребителей нет и не предвидится

Вы это серьезно? Если так рассуждать, то не имеет смысла вообще где-либо что-то развивать, кроме Мск и Питера, ну а что, в остальных регионах то потребителей как статистическая погрешность… А если серьезно, будет электричество, будут и потребители. Почему вы никак не можете выйти за рамки логики и здравого смысла, посмотрите на наших соседей, Норвегию и Финляндию, Исландию, климат холоднее, однако даже FB строит там ЦОДы.

То же можно сказать и про передачу сигнала. Ну хорошо, может про радиоканал я погорячился(хотя не факт, скорость распостранения радиосигнала не меньше скорости света), но все равно вы мыслите ограниченно, на сегодня, а не на завтра. А вот завтра, лет через 20, вы также скажете, что это невыгодно и не зачем, хотя это могло быть уже сделано.

Что касается финансов, то тут как всегда упирается не в стоимость материалов, а во все остальное, посредников, подрядчиков, доставку, монтаж и прочее. Нужно оставить только самое важно, монтаж, материалы, не передавать все посредникам, все делать самому, минимизировать расходы, не уменьшая качества. Если подходить с умом, сделать можно все, что угодно, а не как обычно

Night_Snake

27.12.2017 13:051. АЭС никто не строит в голом поле. Её всегда строят под существующего, либо перспективного (т.е. с готовым бизнес-планом и сроками ввода) потребителя.

2. Про Скандинавию/Исландию и ЦОДы: а) есть уже готовая дармовая (геотермальная) энергосистема рядом с ЦОДом б) есть уже готовые трансатлантические магистрали, а стройка по суше незначительна + идёт по территории с развитой инфраструктурой. Либо и вовсе используется нечто готовое (старое бомбоубежище, например)

3. Дело не в скорости передачи самого сигнала (и там и там это скорость света), дело в ширине каналов. Пока по воздуху нельзя гарантированно передавать значимые объёмы данных с гарантированной полосой даже теоретически

4. Про «давайте строить самим» — а давайте вы хотя бы один ЦОД построите сами где угодно, введёте его в эксплуатацию и отобьёте затраты. А потом мы с вами поговорим про подходы.

werklop

27.12.2017 13:321) Кто мешает проектировать потребителей, ЦОДы, заводы и др, а потом их строить, параллельно с АЭС?

2) «есть уже» — ага, это ключевое, потомучто был и есть ум на перспективу. А когда этого ничего не было? Если бы они думали как вы, то и сейчас у них ничего не было бы

3) Начнем с того, что свет это и есть радиоволна, с длиной, позволяющей нам ее видеть. Говоря о сотнях оптонитей для передачи сигнала, мы говорим о тех же сотнях одинаковых/разных частотах передачи радиосигнала, отделенных друг от друга для исключения помех друг от друга. Не вижу проблем в ее разрешении, а именно, те же сотни направленных на ЦОД и обратно отправителю приемников/передатчиков, каждому из которых выделена определенная частота передачи. Хотя на самом деле их не должно быть сотни, должно быть несколько, т.е. несколько «хабов», а вот к этим хабам уже и подключены сотни, но они и не будут на севере, а будут поблизости к потребителю

4) Не надо передергивать. Вы сами то хоть что-то построили своими руками? Вы хотя бы ремонт делали от начала и до конца? Начните с малого и посчитайте, от чего можно отказаться, сэкономив и сделав самому(ну если конечно радиус кривизны ваших рук не превышает ПДН)

Night_Snake

27.12.2017 13:471. Видимо отсутствие других факторов? Дорог, инфраструктуры, смежников… just a business. Не говоря уже о том, что АЭС это продукт _очень_ дорогой и штучный.

2. При чём тут «ум на перспективу»? Геотермальные электростанции очевидно строятся там, где позволяет природа. И есть возможность донести энергию до потребителей. Стало больше потребителей — добавили генераторов — получили больше энергии.

3. Тут даже комментировать не буду. Тут какие-то влажные фантазии. Почитайте, что ли, про РРЛ и способы беспроводной связи

4. Ну не я же говорю о том, что «можно сэкономить и всё делать самому». А то пацаны не знают, и нанимают специалистов — проектировщики, энергосистема, пожаротушение, линии связи… Иногда в штат, иногда на подряд. Но бизнес ЦОДа — это явно не прокладка оптики.

В целом, не вижу смысла продолжать дальнейший спор — вы явно не владеете знаниями в той области, о которой так смело рассуждаете, а мне лень тратить время на разжёвывание довольно простых вещей.

dmpalets70

28.12.2017 13:46Спасибо, очень интересно и детально…

Интересно, сколько человек включает дежурная смена на такком обширном хозяйстве?

20-30?

TS_IT Автор

28.12.2017 13:48Спасибо за вопрос, но, к сожалению, раскрывать количество персонала дежурной смены мы не имеем права. Однако можем сказать, что сегодня на объекте уже создана собственная служба эксплуатации с диспетчерской, организованы дежурные смены. В состав дежурных смен входят диспетчера, осуществляющие круглосуточный контроль за объектом, а также функциональные инженеры по направлениям, отвечающие за работоспособность систем жизнеобеспечения объекта (таких как электроснабжение, механические системы, слаботочные системы и т.д.), проведение регламентных и ремонтных работ.

Служба эксплуатации не останавливается на достигнутом, проводит доукомплектование диспетчерских смен профильными специалистами на перспективу развития объекта и увеличения его мощности до номинальной величины.

andy_p

Будет ли ваш ЦОД использоваться для исполнения закона Яровой-Озерова?

TS_IT Автор

Отвечая на этот вопрос, генеральный директор ООО «Авантаж» — Александр Крок, сказал, что ЦОД будет функционировать в полном соответствии с законодательством РФ.

andy_p

Понятно. Значит будет.