Вдохновившись интернет-запросами в стиле «как сделать спиннер из картонки», я решил рассказать о том, что близко мне: как самому построить 10-гигабитную сеть. Гигабитный Ethernet вопросов уже не вызывает – справится даже школьник: потребуется коммутатор, медная витая пара и привычные RJ-45 разъемы.

А если хочется больше? Например, 10-гигабитное соединение для небольшого офиса или серверной. Какое оборудование понадобится и как его подключать – просто и по шагам в моей сегодняшней статье.

Выбираем коммутатор

Выбор коммутатора – то, с чего нужно начинать. Конечно, сразу хочется посмотреть в сторону любимого вендора. И если финансы позволяют, выбор очевиден. А если нет? Тогда есть два варианта: идем на eBay или смотрим предложения российской розницы. Здесь будет полезен маркет на nag.ru. Одна из последних находок – коммутатор NetGear на 8 портов стоимостью менее $85 за порт.

Обязательно проверяем находку по форумам – я рекомендую smallnetworkbuilder и reddit. Обращаем внимание на функции, которые коммутатор поддерживает. Не забываем и про такую особенность, как уровень шума, – особенно если выбираем коммутатор для дома.

Коммутатор NetGear на 8 портов.

Если мы выбрали коммутатор с RJ-45 портами, тут все просто: мы ограничены расстоянием в 55 метров с кабелями Cat6 и в 100 метров – с Cat6A. В этом случае используем привычные RJ-45 разъемы, изучаем плюсы и минусы 10GBASE-T и радуемся. Такие коммутаторы подходят для ToR (top-of-the-rack) – использования внутри стоек, когда нет нужды в длинных линках.

Если же мы получили коммутатор в SFP+ портами, то нужно выбрать трансиверы.

Коммутатор с портами SFP+.

Выбираем трансиверы

SFP+ – это разновидность SFP-разъема, который поддерживает скорости выше 4,25 Гбит/сек и используется для установки трансиверов со скоростями до 10 Гбит/сек (16GB FC). Трансивер, в народе «эсэфпишка» или «gbic», обеспечивает преобразование электрических сигналов в световые и обратно.

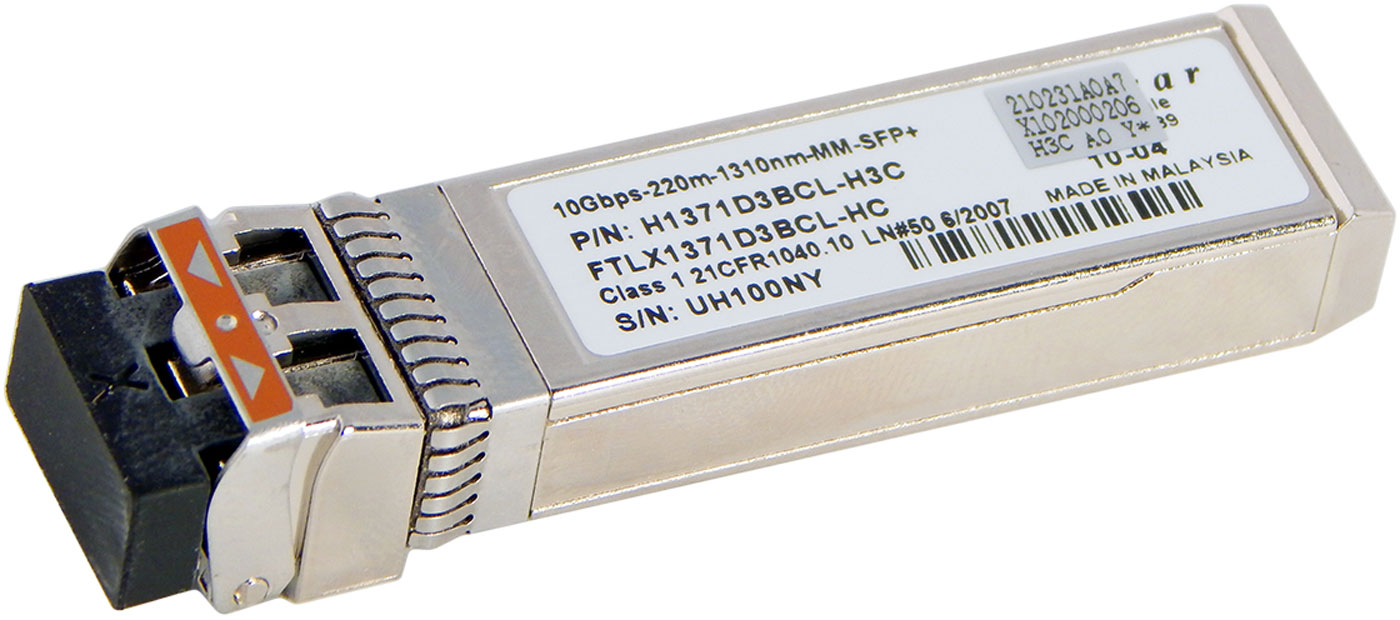

Трансивер на 10 Гбит/сек.

К сожалению, SFP+ трансиверы на 10 Гбит/сек с портами RJ-45 встречаются редко и стоят слишком дорого. Поэтому будем использовать оптический кабель.

При выборе трансивера нужно учитывать дальность передачи. Правило «чем больше – тем лучше» здесь не работает:

У трансиверов с разной дальностью передачи отличается длина волны и мощность излучателя. Для дома или офиса чаще всего достаточно трансивера SR.

- на расстояниях до 300 метров нужны трансиверы с маркировкой SR (short reach),

- на дистанциях от 300 метров и до 30 км – LR (long reach),

- а от 30 км до 40 км – ER (extended reach).

Кроме того, от расстояния зависит и тип применяемого оптического кабеля:

В 98% случаев ваш выбор – 10G MM SR LC-трансивер. LC – тип разъемов для подключения оптики. Об этом речь пойдет ниже.

- до 300 м используем multimode (MM, «мультимод»),

- более 300 м – singlemode (SM, «синглмод»).

Трансивер на 10 Гбит/сек short reach для оптического кабеля multimode.

Что делать, если вы хотите подключить к SFP+ разъему оборудование на 1 Гбит/сек с портами RJ-45? Не проблема – для этого есть соответствующие трансиверы.

Трансивер на 1 Гбит/сек с разъемом RJ-45.

Есть три момента, в которых легко ошибиться, выбирая трансивер:

- Трансиверы на 10 Гбит/сек выглядят абсолютно так же, как трансиверы для FC.

- Трансиверы производятся разными вендорами, и, к сожалению, вендорская прошивка может быть несовместима с частью оборудования. Можно временно стать хакером и перепрошить трансивер, но тогда вы лишитесь вендорской поддержки. Да и сложность такой операции довольно высокая.

- Трансиверы могут быть нужны и на стороне вашего Ethernet-адаптера, если они в него не встроены. И у адаптера могут быть другие требования к трансиверу, чем у коммутатора. Читаем документацию на адаптер.

Подключаем оптику

Коммутатор есть, трансиверы есть, еще раз проверяем оптические кабели. Как писал выше, для небольших расстояний подойдет мультимод. Бывает синего, фиолетового или красного цветов. Для больших расстояний, от 300 м, понадобится синглмод. Он, как правило, желтого цвета.

К трансиверу оптоволокно подключается с помощью LC-разъемов.

LC-разъемы для подключения оптики к трансиверу.

Обратите внимание!Будьте аккуратны с LC-коннекторами и открытыми торцами оптоволокна в них. Одна пылинка – и ваша сеть не будет работать стабильно. Производители рекомендуют включать каждый LC-разъем только один раз без переподключений.

Если ваша пара оптики оканчивается дуплексными разъемами, то вы не перепутаете левый и правый оптический провод, или «rx\tx». Один из них используется для приема данных, другой –

для передачи. А вот если разъемы отдельные, то легко перепутать левый провод с правым. Тогда соединение не установится, порт не поднимется. В такой ситуации надо поменять местами провода и попробовать установить соединение снова.

Протирать тряпочкой и дуть на торцы оптоволокна нельзя!

В исключительных случаях для проведения профилактики можно использовать специальные чистящие средства. Универсальным будет One-Click Cleaner MU/LC. Подходит для очистки оптики и портов с LC-разъемом.

Средство для очистки оптики One-Click Cleaner MU/LC.

Подключение в стойке

Создать 10-гигабитное Ethernet-соединение в пределах стойки или пары стоек можно по-другому. Здесь подойдут DAC-кабели, или твинаксы (twinaxial cable). Твинакс – это медный кабель, соединяющий два SFP+ трансивера. Пассивные твинаксы бывают длиной до 7 метров.

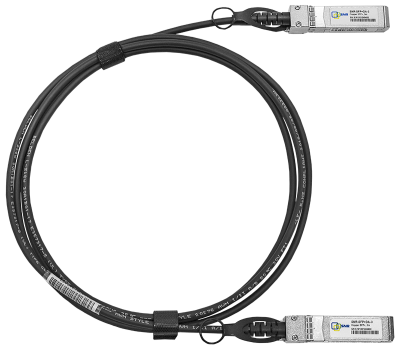

Это твинакс.

Использование твинаксов позволяет сэкономить бюджет. Но кабели эти довольно толстые и жесткие, аккуратный монтаж в стойке большого количества твинаксов очень сложен.

Резюмирую сказанное выше. Для соединения 10-гигабитной Ethernet-карты c портом 10G SFP+ коммутатора дома, в офисе или в стойке серверной вам нужны:Я понимаю, что в этой статье не вывел бином Ньютона. Ее цель – помочь начинающим быстро разобраться в физической коммутации оборудования в 10-гигабитных Ethernet-сетях.

- пара совместимых с вашим оборудованием SFP+ трансиверов MM SR на 10 Гбит/сек,

- двухволоконный мультимод с LC-разъемами нужной длины.

В моей практике несколько раз приходилось помогать довольно опытным системным администраторам с подключением. Не единожды наблюдал примерно следующую картину: в 10-гигабитном порту СХД установлен 10G MM SFP+ трансивер. В него подключен single mode LC LC провод. Другой конец провода приходит в 8G FC трансивер, установленный в FC адаптер сервера. Мало того, что ошибка с типом оптики, так и вообще вся схема логически неверная. «Брат, что ты хотел сделать?» – «Поднять iSCSI.» Вот такая быль из цикла «админы шутят».

UPD: добавлю по вашим комментариям

1) SFP+ трансивер 10Base-T (на витую пару) может стоить $300, а SFP+ на оптику MM $30. Это нужно учитывать при построении инфраструктуры.

2) в трансиверах и модулях на концах твинаксов зашиты определенные прошивки, обеспечивающие совместимость трансиверов с активным оборудованием. Существует возможность смены этих прошивок, при которой вы, конечно, теряете поддержку вендора, но получаете возможность работы оборудования с официально не совместимыми трансиверами.

Буду рад прочитать в комментариях, чего вам не хватает в рамках данной темы. Спасибо!

Комментарии (61)

gotch

06.02.2018 11:01«эсэфпишка» или «gbic», обеспечивает преобразование электрических сигналов в световые

Не совсем это так, как и следует из текста ниже.

Danieczka

06.02.2018 12:13Вообще, в контексте статьи такого поверхностного представления о функциях SFP вполне достаточно, но соглашусь с вами в том смысле, что фразы «SFP преобразует электрические сигналы в световые» и «Есть SFP с портами RJ-45» без дополнительных пояснений очень странно смотрятся вместе.

atd

06.02.2018 11:26> Твинакс – это медный кабель, соединяющий два SFP+ трансивера

трансиверы только в активных есть, а пассивных это просто сфп-разъём

> Для соединения 10-гигабитной Ethernet-карты c портом 10G SFP+… пара трансиверов MM SR, двухволоконный мультимод с LC-разъемами нужной длины.

До недавнего времени всю мелочь я тоже собирал на мультимоде/dac, но сейчас цены на одномод (не брендовый) практически сравнялись с мультимодом. А кабели/разъёмы на одномод дешевле и доступнее.

Так что перед покупкой стоит сравнить наличие и цены, может и SM будет лучше

gotch

06.02.2018 11:31трансиверы только в активных есть, а пассивных это просто сфп-разъём

А расскажите, пожалуйста, есть толк от коротких активных кабелей?

atd

06.02.2018 11:36я не видел коротких активных кабелей, если честно.

длинные видел, но по сути это неразборный xcvr-оптика-xcvr, и проще (и часто дешевле) собрать на отдельных трансиверах и проводе нужной длины

atd

06.02.2018 11:34P.S.:

>… Другой конец провода приходит в 8G FC трансивер, установленный в FC адаптер сервера. Мало того, что ошибка с типом оптики, так и вообще вся схема логически неверная. «Брат, что ты хотел сделать?» – «Поднять iSCSI.» Вот такая быль из цикла «админы шутят».

лол, а на первой картинке у нас что? ))

финисары на 10ге начинаются на ftlx, а ftlf — это как раз FC

msolovyev Автор

06.02.2018 11:51Сверху — кликбейт для привлечения внимания :) Там MM + 2 FC трансивера.

Chugumoto

06.02.2018 11:27а про 40G/100G будет?

Tufed

06.02.2018 16:19… интернет… в квартиру… с собственноручным проведением кабеля от ближайшего узла маршрутизации города.

Chugumoto

06.02.2018 16:34у меня нет квартиры :)

а вот из дома планирую уже все железки выселить в отдельно возведенную для них серверную…

и пока да — всего гигабит… но хочется чего-то большего… зачем апгрейдить на 1 шаг? лучше уж сразу на 2…

ну и да. не интернет. а скорость обмена между узлами сети

поэтому расстояния у меня маленькие :)

AllexIn

06.02.2018 18:40Если нет необходимости, то апгрейдить в два шага дешевле, чем сразу делать с запасом.

dmitry_dvm

06.02.2018 12:01+1А разница между 10G медью и оптикой на расстояниях меньше 300м есть вообще? Стоит ли заморачиваться со всеми этими SFP?

Dessloch

06.02.2018 21:22При таких расстояниях оптика имеет огромное преимущество-нет наводки от молнии. По опыту некоторых знакомых-каждое лето сгорает хаб или сетевая карта. Так что оптика между зданиями-не каприз, а жизненная необходимость.

mkm565

07.02.2018 12:05В нашей Солнечной Флориде, где летом сезон дождей, которые идут по три раза в день со всеми сопутствующими сценическими эффектами, у меня вылетало оборудование практически каждый год. Линия CAT-5 шла в трубе землей метров 100. Терять дорогй роутер было обидно, поэтому мы поставили оптику между дыркой в стене, откуда идет подземный кабель и раутер. 30 см. Помогло.

Теперь уже трeтий год собираемся проложить оптику вместо провода в земле, чтобы забыть об этих проблемах.

Dessloch

08.02.2018 07:55Вообще странно что молнии влияют на кабель, который в земле да ещё в трубе. Ну всякое бывает. Сейчас стоимость оптики такова что уже и нет смысла тянуть медь на большие расстояния. К тому же она и легче по весу.

Oakum

06.02.2018 12:13Также стоить иметь ввиду, что direct attach cable и витая пара дают чуть большую задержку чем оптика, что может помешать интенсивным операциям, как при экспорте дисковых объемов

atd

06.02.2018 12:19простите, а пассивный DAC какую задержку может вносить сверх физических лимитов?

скорость сигнала в меди примерно 2e8, скорость света в корнинге тоже примерно 2е8. Учитывая макс длину твинаксов, вся разница будет в пределах одной нано. Каким оборудованием вы её измерите?

И всё равно это фигня по сравнению с 200нс даже в самых дорогих cut-through свитчах.

batment

06.02.2018 13:10> скорость сигнала в меди примерно 2e8, скорость света в корнинге тоже примерно 2е8.

Я могу ошибаться (не сталкивался с этим лет 10), но по-моему там идет разное кодирование сигнала, то есть у меди на каждый бит проходит больше импульсов

atd

06.02.2018 15:01в DAC и оптике кодирование одинаковое (с точки зрения сетевухи, в среде очевидно разное), но.

а вот в витой паре другое, но не надо её мешать с DAC-ами.

P.S.: ссылка ниже, там норм инфа (DAC даже чуть быстрее, но незначительно)

berlevdv

06.02.2018 12:13На практике были случаи потери пакетов при использовании полуторометровых DAC-кабелей при соединении сетевая карта — маршрутизатор, в то время как полуметровые работали отлично или теже 1.5 метров между маршрутизаторами также отлично работали. Специалист из nag.ru объяснил это повышенным энергопотреблением DAC-кабелей, сетевая карта не вытягивала.

scruff

06.02.2018 13:57Прошу прощения, но вы так написали, что Трансивер, «в народе «эсэфпишка» или «gbic»» и я так понял, что как будто-бы одно и тоже. SFP выглядит: for-gsm.ru/publ/cifrovye_gadzhety/chto_takoe_sfp_transiver_i_zachem_on_nuzhen/3-1-0-2159

GBIC выглядит: ct-company.ru/catalog/cisco/Modul/100mbps-gbic/WS-G5487_.html

Разъемы для включения в коммутатор совсем разные. Я так лет 10 назад чуть не встрял с заказом SPF для Cisco 2980, которая «умеет» только GBIC. Поправьте меня если я не прав.

msolovyev Автор

06.02.2018 15:50В общем-то, для этого и написал статью. Работал ранее в организации, где SFP трансиверы называли gbic-ами, что совсем не верно.

scruff

06.02.2018 17:08Всё равно спасибо, Вы заставили меня вспомнить те технологии с которыми я работал лет 5-7 назад))) Сейчас направление работы немного другое.

KodyWiremane

06.02.2018 21:53Стоило бы подробней осветить этот факт в статье. А то иные читатели как не знали, что gbic — это GBIC, так и не узнают.

atd

06.02.2018 15:10> Существует возможность смены этих прошивок, при которой вы, конечно, теряете поддержку вендора, но получаете возможность работы оборудования с официально не совместимыми трансиверами.

Стоит немного поправить:

1. в трансиверы зашит обычно конфиг (из того, что можно поменять), его можно прошивать (если модуль даёт такую возможность) вполне безболезненно, гарантию (на свитч) это не испортит. А модуль в случае гарантийного случая можно перешить обратно (хотя я обычно выкидываю).

2. В свитчах в их софте («прошивке») обычно есть модуль, который проверяет что в железку сунули свой сфп-модуль. (Назвать _прошивкой_ кусок кода на питоне, который сравнивает 'Arista' == 'Arista' у меня как-то язык не поворачивается).

С не-родными модулями есть 3 варианта действий:

а) перешить имя трансивера на нужное

б) попросить вендора дать код разблокировки (это снимает свитч с гарантийных случаев связаных с сфп-портами)

ц) пропатчить этот кусок кода на свитче (тут в случае чего стоит не забыть всё вернуть обратно ;))

На моей практике, и по рассказам знакомых, ни разу проблем вызванных не-родными трансиверами не случалось (если использовать приличные модули, у меня всё финисары или аваги). Так что всё это видится просто как раскошеливание публики на $$$: ариста покупает у аваги модули по $10, ставит своё название, продаёт по $100.

navion

06.02.2018 15:26+1С не-родными модулями есть 3 варианта действий

По-моему код разблокировки есть только у Аристы (с какой-то версии EOS), а раньше была опция в конфиге как у остальных.

На моей практике, и по рассказам знакомых, ни разу проблем вызванных не-родными трансиверами не случалось

У Селектела облако ложилось из-за левых трансиверов.

atd

06.02.2018 15:42Интересно, что за модули селктел покупал.

У меня валяется несколько модулей SNR и ещё какой-то галимый китай. Один из них ушёл в несознанку в сетевухе, у другого RX работает, а TX не светит (хотя рапортует что всё ок).

lukve

06.02.2018 15:50Насчет очистки — при загрязнении очищать необходимо. Но, на фото инструмент для очистки разъёмов в оптических кроссах.

Для коннекторов можно использовать специальные салфетки. Например: skomplekt.com/tovar/7/1/9999957887

И обязательно закрывать не подключенные коннекторы колпачками.

msolovyev Автор

06.02.2018 15:52очистка может привести к дополнительному загрязнению. И коннекторы удобно очищать указанным инструментом, обратите внимание на его многофункциональный колпачек — переходник. По колпачкам — обязательно! еще бы кто-то это делал :)

swiing

06.02.2018 15:53Наверное, стоит добавить, что с DAC кабелями несовместимость прошивок может добавить сильной головной боли, как правило, трансиверы на обоих концах имеют одинаковую прошивку и могут быть совместимы, например, с сетевой картой и не совместимы с коммутатором. На сколько я понимаю, производители не оригинальных кабелей умеют выкручиваться из этих ситуаций.

MaxMxMz

06.02.2018 16:44Сталкивался что некоторые коммутаторы Allied Telesis работают только на 1-Метровом DAC, на 3х метровом уже нет линка. Лечилось сменой прошивки коммутатора.

JohnDoeEast

06.02.2018 17:40Косметическая поправка. Стандарт говорит про мм- до 250м. Но, разумеется, на 300м тоже поработает.

rrrrex

06.02.2018 19:06Да хотя бы гигабит начали нормально внедрять. А то даже в 2018 физ. абонентов подключают четырехжильным кабелем и никакого запаса по скорости нет.

blind_oracle

07.02.2018 09:16Подход у нас потому что изначально идиотский: каждый пров тянет оптику до дома сам, развешивая сопли между домами, а потом еще и витуху в доме.

В Швейцарии, к примеру, оптическую сеть строит вообще местная гос. электро компания и потом сдает в аренду всем операторам. Причем оптика есть в каждой квартире почти — ты просто сообщаешь провайдеру номер своей оптической розетки и он тебя коммутирует на узле связи к себе.

achekalin

06.02.2018 22:39Просим статью про настройку порта с точки зрения софта/ОС, чтобы по такой-то физике хотя бы мегабит 8 в каждую сторону летело успешно!

nidalee

06.02.2018 22:43А зачем дома может пригодиться 10Гбит?

scream_r

07.02.2018 12:05Ну например работа с видео, 4к например. И хранение материала на NAS. Собрать на nas быстрый массив можно, ещё бы гонять быстро его на рабочую станцию и обратно.

nidalee

07.02.2018 19:00Я очень слабо представляю массив, который сможет принимать и отдавать 10 гбит дома. Хотя с 4к видео работаю.

Это что за диски должны быть, если обычный HDD только ~гигабит забивает?

Taciturn

07.02.2018 22:19При линейном чтении/записи в один поток даже один диск может больше гигабита выдать. А RAID из многих — тем более.

scream_r

08.02.2018 12:11Ну 10 конечно не надо, но сейчас в nas 2 массива, каждый из который может давать под 200Мб/сек. С nas'ом 2 больших компа работает (не считая ноутов на wifi). NAS висит на одном гигабитном линке, в который он соответственно упирается. Конечно и 3-4 Гигабита хватит за глаза, но следующий за 1 гигабитом стандарт сразу 10ка.

xcore78

07.02.2018 03:39Шёл 2018 год, а люди продолжали выбирать между одномодом и многомодом.

blind_oracle

07.02.2018 09:20Ну на 10Гбит это еще может иметь смысл т.к. СМ в квартире не нужен, да и в пределах небольшого ДЦ тоже, а трансиверы стоят прилично дороже.

На гигабите уже да, считай одинаково.

ncix

07.02.2018 10:31Я понимаю, что в этой статье не вывел бином Ньютона. Ее цель – помочь начинающим быстро разобраться в физической коммутации оборудования в 10-гигабитных Ethernet-сетях.

Я новичок в сетевой оптике, и если честно многое не понял. Очень много терминов без объяснения (синглмод? мультимод? FC? SFP? и т.д.) Понятно что можно нагуглить всё, но было бы удобно всё это иметь в одной статье, раз уж выбран формат для новчиков.

И даже дочитав статью до конца так и не понял наверняка, можно ли построить 10-гигабитную сеть на меди или нельзя.

msolovyev Автор

07.02.2018 12:16SFP — стандарт портов для установки трансиверов в устройства, см фото выше.

SingleMode — вид оптического кабеля, обычно используется для передачи на дальние расстояния, оболочка преимущественно желтого цвета.

MultiMode — вид оптического кабеля, обычно используется для передачи в пределах ЦОДа, розовый, желтый, синий.

Подробно — habrahabr.ru/post/46818

FC — fibre channel — протокол, использующийся при построении SAN сетей.

Подробно — habrahabr.ru/post/214289

Да, вы можете построить 10G сеть на меди или на оптике.

Медь — вам нужен свич с медными портами, кабель указанных ваше категорий и карты с медными портами.

Оптика — вам нужен свич с оптическими портами, трансиверы на стороне свича и карт, собственно оптический кабель с разъемами, какрты с оптическими портами.

Предвижу вопрос — нет, вы не сможете самостоятельно установить оптические разъемы на оптический кабель, эта процедура требует очень специального дорогостоящего оборудования.

ncix

07.02.2018 12:23Спасибо!

Оптика — вам нужен свич с оптическими портами, трансиверы на стороне свича и карт, собственно оптический кабель с разъемами, какрты с оптическими портами.

вот про это не понял. Если порты оптические и кабель оптический, зачем нужен трансивер? У меня например в провайдерский роутер оптика заводится без всякого трансивера.

DaemonGloom

08.02.2018 06:33А можно фотографию этого дела? Обычно просто такое означает, что трансивер встроен. Либо мы говорим о технологии GPON, которая отличается от классического варианта и не предназначена для построения локальной сети.

xycainoff

07.02.2018 12:05+1Спасибо автору.

Прошу дополнительно пролить свет на тему MTU, jumbo и прочего L2 на 10 гигах.

VuX

07.02.2018 12:05Народ, подскажите, какие модули и кабель для гигабитного аплинка, лучше использовать для mikrotik rb260gs, воздушка, расстояниях 60-120 метров? Впервые сталкиваемся с оптикой, не знаем с какой стороны подойти)

dimsoft

07.02.2018 12:05На коротких расстояниях еще можно взять такую древность как CX4

на ebay сетевые от 30 уе. Правда кабели еще толще, чем DAC кабеля

gaidukav

08.02.2018 13:48Ох какая же нестабильная совместимость 10G оборудования от компании HPE…

Некоторые коммутаторы принимают SFP/SFP+ строго из своего списка совместимости, некоторые — всеядные. Даже «родные» DAC с одним(!) партнумбером, но от разных производителей, могут заработать а могут и нет… (дважды меняли комплект DAC-ов для свичей HP3500yl, только третий производитель поехал...), А вот свичи HPE5130 EI оказались всеядными (DAC и SFP/SFP+), так же всеядными оказались блэйдовые свичи HP6125G/XG и HPE6127XLG.

arsenenko

Спасибо!

Не хватает провайдера толкового =)