Самая большая голова Ленина в мире. Площадь Советов в Улан-Удэ

Когда ты берёшься за проект длиной два года с географией по всей стране, то ждёшь, проблем с согласованием, странных отношений с контрагентами, грузчиков с серверами в руках, непредоставленных портов по ТЗ и много другого. К этому меня жизнь готовила: всё это прекрасно описано в методологии подготовки проект-менеджеров.

Всё было не зря.

Такие истории очень хорошо рассказывать через пару лет в курилке, но не встречать на проектах.

Что надо было сделать

Осенью 2016 года одна крупная организация окончательно решила перейти на рабочих местах на VDI-доступ. Их прикладное ПО менялось, а компьютеры — нет. Поэтому в будущем это всё начало бы неминуемо тормозить. Прикинув стоимость обновления парка ПК, решили сразу сделать следующий шаг. И пошли на VDI.

В 2017 году мы закончили 5 тысяч рабочих мест в нескольких регионах.

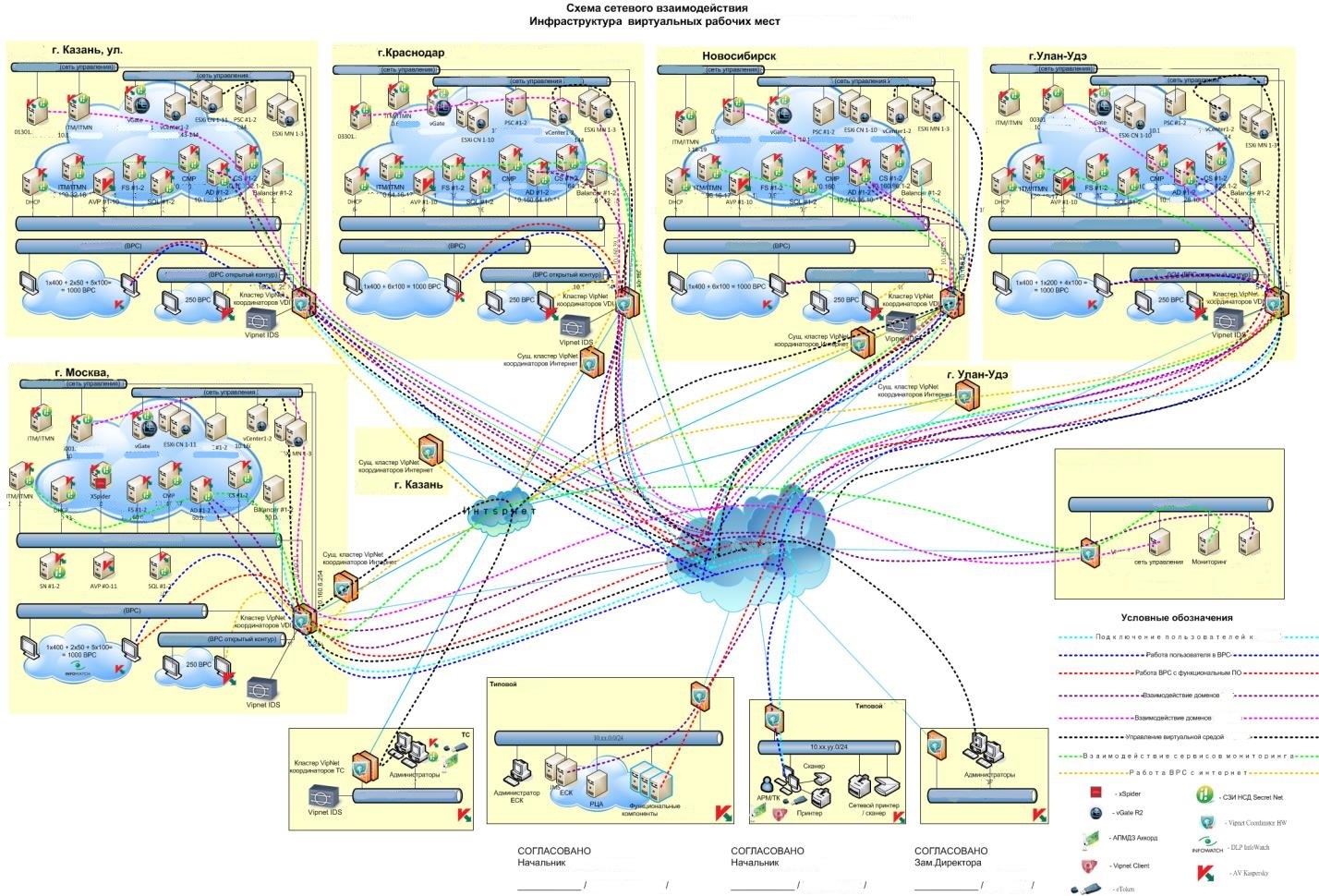

Архитектура решения была задана в момент конкурса. Она следующая:

Как видите, тут 5 серверных узлов (это размещение в дата-центрах и на отдельных площадках), по одному для группы регионов. Между собой эти пять площадок связаны по VPN через корпоративную сеть организации (есть некий узел с продакшн-серверами баз данных в центре). Внизу схемы — типы рабочих мест.

Софт:

Ядро — гиперконвергентная архитектура с VSan, VMWare — гипервизор до 7 версии. Одиннадцать серверов: по 3 сервера управления, 8 compute, коммутаторы. Физически это одна стойка: криптосредства, сеть управления, контроллеры, vSAN, продакшн. Каждая стойка может удерживать до 5 тысяч пользователей. В планах на следующий год — удвоение.

Удалённое сопровождение в контракте, но ездить надо ногами: не удаётся согласовать с безопасниками ряд вещей. Мы держим пять сотрудников, которые занимаются сопровождением из центра. Плюс у нас есть субподряды во всех регионах, чтобы прийти, заменить железку. ЗИП не храним, всё задублировано. У производителей железа покупаем на следующий рабочий день, ЗИП хранят вендоры.

На конечных рабочих местах с точки зрения пользователя мы не трогаем ничего, кроме того, что кладём ещё одну иконку на рабочий стол. С неё они подключаются. В какой-то момент их администраторы решат, что хватит обновлять ПО на локальных дисках и, когда пользователи попривыкнут, оставят только эту иконку.

Начало

На начало работ мы знали, что организации довольно дорого класть собственную оптику (что логично), поэтому она покупает каналы у магистральных провайдеров. В большинстве случаев это не проблема, но на Камчатке, например, у них спутниковый гейт. Это создаёт определённые сюрпризы для VDI. Забегая чуть вперёд — туда проект пока не распространили, но в ряде городов нам достались очень узкие каналы.

В отношении работы с приложением пользователи довольно нетребовательные к полосе — там статичные экраны, и двигается только курсор. Однако они довольно часто отправляют сканы документов, например, паспортов для профиля клиента. Это создаёт дополнительную нагрузку на канал.

Три базовые площадки — это их собственные серверные узлы в их собственных офисах в центре городов. Ещё две — это внешние дата-центры, где сделаны загородки под эту компанию.

Типовые сложности

Первый этап — обследование. Ездишь по точкам и смотришь глазами, где что будет стоять. Прикидываешь, как и чего: общаешься с местными айтишниками, проверяешь правила работ на площадках, смотришь, куда складывать коробки, кто чего будет поднимать на 4 этаж, нужны ли грузчики, как с пропусками для них. Ездили вдвоём: я, ПМ для организации, и архитектор (он же техруководитель проекта). Кое-где понадобились дополнительные маршрутизаторы. На двух площадках не было нужных провайдеров, заказчик пошёл договариваться с ними, чтобы они протянули туда линк.

Нужно было решать вышеописанную проблему с загрузкой канала сканами. Происходит вот что: весь поток со сканера отправляется на серверный узел, а уже там происходит обработка. Фактически же надо было делать предобработку в конечных подсетях ещё до ухода в корпоративную сеть. Есть регламент по сканированию, чтобы документ был различим. Есть средства VMware — мы привлекли их экспертов для оптимизаций, тестирования и ускорения. Они пошаманили, сделали преднастройки и вынесли вердикт: сделать быстрее, чем получилось, можно только расширением каналов.

Такая же работа была по печати.

Были проблемы с драйверами старых моделей МФУ. Каждый типовой образ делался совместно с людьми из региона. В каждом регионе нас сопровождала своя команда. Мы выдавали тестовый образ, они набивали дровами, ПО, тестировали, что всё это работает, дальше в боевой пул. Для каждого из регионов на рабочие места был создан свой базовый образ. Они отличаются набором драйверов для принтеров-сканеров и немного софтом. Пользователи одного региона работают с одним образом. Человек подключается и с этой виртуальной машины и ходит к своим приложениям. В «чужие» регионы пользователи не ходят.

Основные сложности, которые возникли при настройке VDI. Безопасники нам очень долго и упорно не хотели согласовывать в принципе подключение. Причина проста: текущая нормативная база по учёту подписей отстаёт от реальности. Нам пришлось разъяснять, переделывать и согласовывать бизнес-процессы. То есть мы взяли и начали писать их же регламенты работы.

После обследования и составления образов надо было просто поездить и расставить оборудование. Мы знали, что нас ждут сюрпризы.

Нетипичные проблемы

Итак, столица одного из сибирских регионов… вот ЦОД, вот ваше стойко-место. Всё готово, за исключением того, что внутри загородки нет питания. Люди, которые отвечают за ЦОД, нас уверяли, что для того, чтобы сделать розетку внутри загородки, надо выключить весь дата-центр. Надо согласовывать с налоговой и прочими товарищами, чтобы в этот день не было зарплат, налогов и вообще ничего критичного. Лучше это делать за полгода.

Мы занялись планированием. Попутно нашли подрядчика, который строил этот ЦОД. Вообще, для меня очень странно, что точки питания сразу не сделали, одна стоит до 5 тысяч рублей с автоматами. Помещение сделано хорошо, всё на Шнайдере. Оказалось, технологические розетки APC поставляются под заказ, потому что мало кому они нужны. Срок заказа 11–14 недель. Их нет НИГДЕ. Но нас, как в том анекдоте, спасло русское раздолбайство: в какой-то момент подрядчик подобрел и вспомнил, что у них в закромах есть одна неучтённая. И ЦОД отключать было не надо. В этом году ещё раз расширяемся, опять розетки не будет — заказчик обещал принять решение, оставаться на площадке или менять её за 2 недели до пуска оборудования.

А вот что было в городе-миллионнике — промышленный ЦОД, позиционирующий себя как очень крутой. Там вообще некуда выкинуть мусор было в прошлом году. Коробка от сервера осталась — сами вывозите. А ты в командировке. Заказываешь контейнер, вывозишь. Хорошо хоть мы, наученные горьким опытом, имеем наличные под аванс на случай ЧП. На месте получается всё сделать быстро, но с бухгалтерией потом закрывать все эти затраты — целое приключение. Попробуй обоснуй заказ на вывоз мусоровоза в командировочных расходах. До этого была проблема несколько лет назад: на обслуживание кондиционеров заказывали автовышки. Та же беда.

Вечерние вылеты. В 4 утра по Москве старт, перелёт через всю страну, в 8 утра прилетел и сразу едешь на совещание, тебя встречает заказчик. Оттуда на объект. И вот так пошёл второй рабочий день сразу за первым. А давайте то посмотрим, а давайте это — ты вроде не можешь отказаться. Нужно планировать дополнительный день всегда при таких перелётах.

К москвичам, которые приезжают тебе всё настраивать, относятся двояко. С одной стороны — не до конца доверяют, потому что чужой человек. С другой стороны, очень активно хотят помочь, потому что знают, что работы идут в разных регионах. Поэтому всё то, что можно решить на месте — решают. И ещё стараются показать город. Пока никого не знаешь — настороженно-благожелательное отношение. Ещё для них такие проекты — небольшой праздник, потому что айтишники могут просить что-то в федеральном центре. Все закупки у них централизованные: пишут обоснование в центр, а там закупают. Под наш проект прошли все обоснования «сделайте пошире и потолще Инет», «сделайте больше серверное помещение» и так далее.

Очень много было работ по коммуникации между их отделами. Со стороны заказчика в проекте участвовало много подразделений и департаментов, они все независимы. Каждый из смежных департаментов будет работать только по внутренним распоряжениям несмотря на всю вот эту пилотность проекта. Ты должен, несмотря на то, что они не общаются или плохо общаются — общаться со всеми, знакомиться, надоедать, писать. В итоге получается, что заниматься внутренней организацией их работы. В паре городов мы писали за них письма, который они пересылали уже другим людям внутри организации.

Комментарии (21)

Foggy4

02.08.2018 17:52Не поделитесь информацией, какая в итоге вышла экономия в процентах по сравнению с просто апгрейдом рабочих станций?

willyd

02.08.2018 21:29Там в основном будущие оперативные затраты считаются. Такой проект с учетом прямого привлечения VMWare и, наверное, не только его, плюс расширение интернета в регионах, в капитальных затратах вышел намного дороже обновления парка на 5к машин.

Зато теперь — сказка для поддержки. Ну и думаю, что постепенно еще краше станет, поскольку почти все новые рабочие станции будут тонкими клиентами.

Javian

02.08.2018 21:42Интересно всё таки как теория совпадет с практикой. Лет 5 назад видел как получилось немного не то, что ожидалось при установке тонких клиентов в коллцентре. Операторы держали открытыми много вкладок в браузере и тонкие клиенты загибались, заметно реагируя с задержкой, что создавало сложности при работе с клиентом. А старые ПК вполне комфортно работали.

willyd

02.08.2018 21:54+1Может тонкие клиенты просто загибались? Их задача вывести картинку, упрощенно говоря, с RDP. Как «статичный» браузер мог повлиять?

Другое дело, что есть форс-мажоры, которые хотелось бы избежать — типа выгоревший роутер в ритейле, и нехило бы иметь резерв, который будет работать в таком случае.

Javian

02.08.2018 21:59А это картинку должен кто-то подготовить на той стороне. И видимо не угадали нагрузку, которую создает обычный рабочий процесс оператора, а когда операторов несколько десятков… А обычные ПК — это были i5 с 4Гб ОЗУ. Операторы попробовав тонкие клиенты, предпочитали занять место за «обычным» ПК.

willyd

02.08.2018 22:04У меня есть догадка. Не знаю прав я или нет. Но с учетом сегодняшнего веюа, любой аутсорсинговый колцентр будет генерить очень много трафика.

К примеру, у них на обслуживании первая волна 20 магазинов. Зачастую сразу открывается окно этого магазина, где будет крутится каруселька, мигать баннеры, и т.д. и т.п. Так-то, скорее всего, или канал забьют, сам тонкий клиент такой калейдоскоп должен потянуть, если не совсем дохлый китаец на стареньком ARM.

Javian

02.08.2018 22:42Тонкие клиенты были некие Intel Celeron c 2 ГБ DDR3. Общего между группами было только, что работа велась через вебинтерфес неких приложений клиента. Параллельно могли быть открыты excel и некий дополнительный софт типа группового чата, и VoIP-телефония.

willyd

02.08.2018 22:54Я реально в замешательстве. Мне вот вспомнилось, что у нас в одном интернет-магазине стояли тонкие клиенты, нойнейм китайцы, и вообще проблема не было. Я общался с учредителем тогда, он был просто в восторге.

Может они их просто неправильно приготовили?

Javian

03.08.2018 07:59Возможно. В серверной первоначально стойки установлены только под VoIP. А тонкие клиенты появились через год. Подозреваю, что ничего нового не добавляли и реализовывали в этом филиале на существующей конфигурации.

furtaev

03.08.2018 03:47А с чего Вы взяли, что у заказчика — окологосударственной компании, была цель сэкономить, а не наоборот?

Foggy4

03.08.2018 10:12Видимо неверно понял фразу «Прикинув стоимость обновления парка ПК, решили сразу сделать следующий шаг.». Логично предположить, что если стоимость обновления ПК показалась высокой, то на VDI они сэкономили. Однако в моей практике все расчеты которые я делал показывали, что VDI будет СИЛЬНО дороже, думал, может автор какое-то ноу-хау применил, снижающее стоимость.

kvarkicn

03.08.2018 11:14Может быть еще такая ситуация (лично сталкивался): крупная госконтора, очень жесткие требования по ИБ, там даже кабели питания одобряются безопасниками. У них дикий зоопарк всякого треша, начиная от Pentium IV с Windows-XP и заканчивая 7ми корами с Win10 на борту у избранных.

Все это привести к единообразию практически нереально, необходимо все ПО одобрить у безопасников, каждую железку и патч-корд аналогично. Переходят на VDI ибо подключение и старый треш сможет держать, а одобрять-защищать нужно сравнительно небольшое количество серверов и все. Постепенно будут выводить старые компы и покупать новые уже в виде тонких клиентов.

InterceptorTSK

02.08.2018 22:46-1Что-то около 2006-2007 годов увиделось от сана сервер с сетевыми мониторами.

Канторам на вменяемое религия перейти не позволяет изначально?

Сервер с 30-ю мониками с бесплатным кард-врайтером вдовесок как подарок стоил вполне разумных денег. Про поддержку оного тут говорить вообще бессмысленно, ее ж тупо нет и не нужна она.

А когда в мон сунулась карта и без вообще каких либо телодвижений появился рабочий стол — я вообще отпал. Когда карта была вынута — он исчез. Когда была засунута другая карта — появился другой рабочий стол.

Дальше рассказывать или уже все и так понятно?)

AmberSP

03.08.2018 10:10Сколько в стране инженеров умеет работать с этим продуктом? Нормально работать, а не «тяп-ляп, вроде поехало. О, всё сломалось. Ну через месяц разберусь, как чинить».

InterceptorTSK

03.08.2018 21:21Сколько в стране инженеров умеет работать с этим продуктом?

Сколько в стране инженеров умеет работать с вебом? Из них тока 0.000001% спецификацию прочитали html-я последнего, из них 0.00001% поняли как оно реализовано во всех браузерах, и т.д.

Но оно работает как-то же? Понятно что через полнейшую жёпу, ибо придурки даже не в состоянии шрифты на сайт прикрутить.

Вот так же и с солярисом) Запускаете сервак удаленно, запускаете процессы, они изначально все в собственных виртуальных мошынах, ну это же солярис, ему виртуалки не нужны, ну и работает оно, куда денется-то?

Или у вас нелюбовь к джаве? Так там все на джаве, проблем нет.

К етому серверу идет толстая книжка, открываете, читаете просвящяетесь, но это конечно же не ваш метод, я понимаю.

При этом, тот кто купил ети серверы — получали даже очень ощутимый скидон на стажировку в пиндостан. Ну это так, к слову.

И да, оракл тут ни при чем был. Оракл появился позже. Ети серваки сделали изначально сановцы.

Но вы не отчаивайтесь) Силирон — это ваше все. Ставьте виртуалки до седьмого поту, они вас спасут)))

Sinatr

Никакого недоброжелательства, просто показалось забавным. Можно ли это называть кликбейтом?

mikkisse

Кто о чем думает. Я почему-то сразу подумал, что речь про VDI :)

kvarkicn

Аналогично, с Citrix-ом головного мозга даже мысли не возникло, что речь может идти о чем-то отличном от VDI.