Системы машинного зрения могут распознавать лица на одном уровне с людьми и даже создавать реалистичные искусственные лица. Но исследователи обнаружили, что эти системы не могут распознать оптические иллюзии, а значит, и создать новые.

Зрение человека – удивительный аппарат. Хотя оно развивалось в определённой окружающей среде миллионы лет, оно способно на такие задачи, которые никогда не попадались ранним зрительным системам. Хорошим примером будет чтение, или определение искусственных объектов – машин, самолётов, дорожных знаков, и т.п.

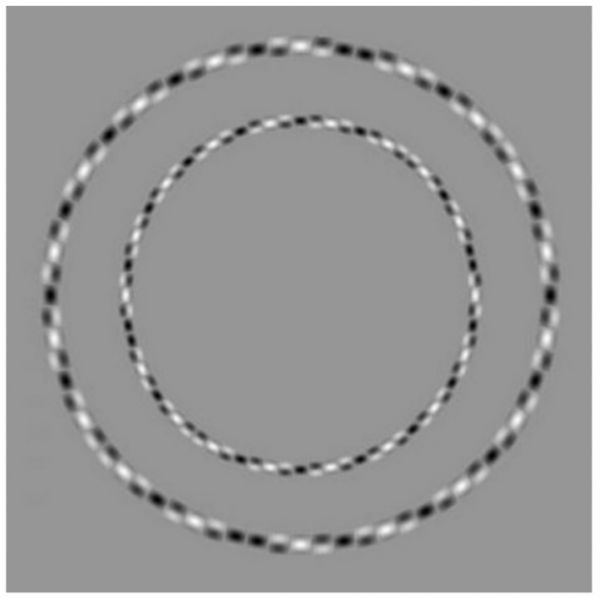

Но у зрительной системы есть хорошо известный набор недостатков, воспринимаемых нами, как оптические иллюзии. Исследователи определили уже много вариантов, в которых эти иллюзии заставляют людей неправильно оценивать цвет, размер, взаимное расположение и движение.

Сами по себе иллюзии интересны тем, что дают представление о природе зрительной системы и восприятия. Поэтому будет очень полезно придумать способ находить новые иллюзии, которые помогут изучить ограничения этой системы.

Концентрические круги?

Здесь нам должно пригодиться глубинное обучение. В последние годы машины научились распознавать объекты и лица на изображениях, а потом создавать похожие изображения. Легко представить, что система машинного зрения должна суметь распознавать иллюзии и создавать свои собственные.

Тут на сцену выходят Роберт Уильямс и Роман Ямпольский из Университета Луисвилля в Кентукки. Эти ребята попробовали провернуть такое дело, но обнаружили, что всё не так просто. Существующие системы машинного обучения не способны выдавать собственные оптические иллюзии – по крайней мере, пока. Почему же?

Сначала общая информация. Недавние подвижки в глубинном обучении основаны на двух прорывах. Первый — доступность мощных нейросетей и парочка программных трюков, позволяющих им хорошо обучаться.

Второй – создание огромных по объёму размеченных баз данных, на базе которых машины способны обучаться. К примеру, чтобы научить машину распознавать лица, требуются десятки тысяч изображений, содержащих чётко размеченные лица. С такой информацией нейросеть может научиться распознавать характерные закономерности лиц – два глаза, нос, рот. Что ещё более впечатляет, пара сетей – т.н. генеративно-состязательная сеть (ГСС) – способны научить друг друга создавать реалистичные и совершенно искусственные изображения лиц.

Уильямс и Ямпольский задумали научить нейросеть определять оптические иллюзии. Вычислительных мощностей достаточно, а подходящих баз данных не хватает. Поэтому их первой задачей стало создание базы данных оптических иллюзий для тренировки.

Это оказалось сложно сделать. «Статических оптических иллюзий существует всего несколько тысяч, а количество уникальных видов иллюзий очень мало – возможно, пара десятков», — говорят они.

А это серьёзное препятствие для современных систем машинного обучения. «Создание модели, способной научиться на таком небольшом и ограниченном наборе данных, станет огромным скачком вперёд для генеративных моделей и понимания зрения человека», — говорят они.

Поэтому Уильямс и Ямпольский собрали базу данных из более чем 6000 изображений оптических иллюзий, и натренировали нейросеть распознавать их. Затем они создали ГСС, которая должна самостоятельно создавать оптические иллюзии.

Результаты их разочаровали. «После семи часов тренировок на Nvidia Tesla K80 ничего ценного создано не было», — говорят исследователи, открывшие базу данных для использования всеми желающими.

Результат, тем не менее, интересный. «Единственные из известных нам оптических иллюзий были созданы эволюцией (к примеру, рисунки глаз на крыльях бабочки) или художниками-людьми», — указывают они. И в обоих случаях люди играли решающую роль в обеспечении обратной связи – люди могут видеть иллюзию.

А системы машинного зрения не могут. «Маловероятно, что ГСС сможет научиться обманывать зрение, не понимая принципов, лежащих в основе иллюзий», — говорят Уильямс и Ямпольский.

Это может оказаться сложной задачей, поскольку между зрительными системами человека и машины есть критически важные различия. Многие исследователи создают нейросети, ещё сильнее напоминающие зрительную систему человека. Возможно, одной из интересных проверок для этих систем будет то, смогут ли они увидеть иллюзию.

А пока Уильямс и Ямпольский не проявляют оптимизма: «Судя по всему, набора данных с иллюзиями может быть недостаточно для создания новых иллюзий», — говорят они. Так что, пока оптические иллюзии остаются бастионом человеческого восприятия, неподвластным машинам.

Комментарии (23)

Anthony_K

28.10.2018 14:46Извините за придирку, у вас неграмотно построены предложения. Цитата:

Хотя оно развивалось в определённой окружающей среде миллионы лет, оно способно на такие задачи, которые никогда не попадались ранним зрительным системам

Нет глагола, относящегося к «способно на». Нельзя быть «способным на задачи», можно либо быть способным решать задачи, либо быть способным задавать задачи.

Зрение способно на что (способно что делать)? Решать задачи, которые никогда не попадались ранее.

ЗЫ. Еще раз: извините за придирку, но давайте, всё же, держать марку. Публикация на хабре должна быть тождественно равна знаку качества.

phenik

28.10.2018 14:49+1Более простые сети, как и человек, испытывают иллюзии, вот исследование на эту тему. Там правда использовались простые иллюзии на контраст, тем не менее. Думаю на перейдолиях ИНСы могут накалываться, как и человек) Случайно тоже могут сгенерировать. Вообще у разных типов сетей должны быть свои иллюзии, связанные со спецификой архитектуры, как у людей.

TimsTims

28.10.2018 16:13А разве каждая неверная интерпретация объекта (баг) не является иллюзией для нейросети))?

aikixd

28.10.2018 16:39-1Если мне показали Васю, а я сказал что это Петя, значит ли это что у Васи оптическая иллюзия а не рожа?

TimsTims

28.10.2018 17:06Всегда есть причина, по которой вы так сказали. Не верно сработала ваша система осознания не сработала. Почему? Либо вы бухой в стельку, либо системе были поданы ложные данные, которые вызвали неверную ячейку памяти. Неверные данные на входе и есть иллюзия.

aikixd

28.10.2018 17:13+1Я бы не называл любую неверную работу сети иллюзией. Я могу видеть Петю вместо Васи и быть абсолютно уверенным в том, что я прав. При иллюзии же, я так или иначе понимаю что данные с разных источников не сходятся и разные части мозга начинают бороться за правду.

phenik

28.10.2018 17:46Между ошибкой распознания (для человека в случае лиц — обознаться) и иллюзией тонкая грань, но она имеется. Если сеть натренирована на распознание только конкретных лиц людей, и вместо Васи распознала Петю, то это ошибка распознания, можно сказать, что сеть «обозналась». А если сети показали гамадрила, и она распознала в нем Васю, то это иллюзия сети, связанная как с архитектурой, так и обучением. Эта ситуация принципиально не отличается от иллюзий которым подвержен мозг человека. И вы правы, в случае иллюзии, в мозге происходит конкурентная борьба нейронных сетей. Изменяя контекст, меняя наклон головы, освещенность и тд, мы даем преимущество той, или иной сети, склонясь к определенному выбору. Это для простых иллюзий типа перейдолии, механизм динамических иллюзий, включая с разным набором сенсорных систем, сложнее.

Space__Elf

28.10.2018 16:27+1У нейросетей — свои иллюзии, которые не видит человек, но нейросети обманываются.

QuaziKing

28.10.2018 17:12Интересно. Получается: чтобы получить много иллюзий для изучения принципа работы зрения нам нежно сначала получить много иллюзий чтобы построить нейросеть создающую много иллюзий. )

Danikey

28.10.2018 21:14-1И никто не сказал про то, что если нейронки начнут генерить иллюзии высокой сложности по запросу, то получим некоторое подобие контроля мозга. Представьте, что нейронка будет учиться на конкретном человеке, взламывая его восприятие самым оптимальным образом. А если взлом откроет дорогу более интересным вещам, вроде гарантированно работающего гипноза или «дайвинга», как в «Лабиринте отражения»? В итоге, получим нечто вроде «очков счастья», систем коррекции правонарушений, как в «Заводном апельсине», или систему изощрённых пыток, сводящих людей с ума почище химии. И не докажешь ведь ничего, за сумасшедшего сочтут. Напоминает продолжение программы MK Ultra, только уже в открытую.

Мне одному кажется, что такие технологии гораздо опаснее ИИ и автопилотов?

Silvatis

29.10.2018 02:15+1Была создана система зрения без «легаси» костылей днк-кода в виде саккад, слепого пятна, конкурентных «отмирающих» колонок клеток мозга итп… и жалуемся, что у них нет багов так как нет костылей? Серьезно?

Caseor

29.10.2018 03:05Silvatis, у вас есть информация, что иллюзии начинаются с оптической системы? Мне кажется, что они начинаются с Фурье-преобразования, алгоритмами по распознаванию фурье-образа, а заканчиваются распознаванием глубины изображения.

конкурентных «отмирающих» колонок клеток мозга

Это тоже как по мне сомнительная причина появления иллюзий. Есть ссылочка?

Silvatis

29.10.2018 13:15Вы хотите все иллюзии свести к одной ошибке? Есть множество иллюзий связанных с различными костылями: К примеру окрашивание в настоящие цвета монохромной картинки инверсным изображением полностью на сетчатке происходит (баг связанный с саккадами и работой «логической схемы» переключения между чб\цветными сенсорами). Так же в вики можно найти картинку с пропадающим крестиком из за слепого пятна. Еще есть иллюзия — гифка с зеленой точкой бегущей по кругу, которой нет: эта бага вообще без использования аппарата вычисления, связана со скоростью отклика на изменения сенсоров.

Что касается колонок — любой тест ведущего глаза является той самой иллюзией. Но тут уже пространственное восприятие, соответственно в 2D не проявляются.

>Мне кажется, что они начинаются с Фурье-преобразования

Я с вами частично не согласен. Наверняка какие — то из иллюзий связаны с процессом обработки, но чуть ли не все «движущиеся» иллюзии перестают двигаться, если подавлять саккады. У Искусственных нейросетей нет этой проблемы.

aikixd

Не понимаю на что они расчитывали. Мы, люди, никогда двухмерного изображения не видели. Все что мы "видим" это смесь (очень некачественной) картинки из глаза, пространтсвенного ощущения, воображения, опыта, настроения и т.д. Оптическая иллюзия появляется когда все эти компоненты не согласны с интерпретацией. У нейросетей просто нет инструментов что-бы их заметить.

zim32

На

bypeso

Некоторые видели, у некоторых один глаз, если уж подходить формально.

Первая картинка бьет по частоте сигналов, карандашный тест, вторая бьет по опыту.

Вот ИИ удивится нашим несовершенным нервам, мозгу и глазам

Danikey

Закрыть один глаз? О_-

Caseor