Джесси Баталья держит своего сына Беннета у них дома в Ранчо-Мираж, Калифорния. В поисках новой няни Баталья начала использовать Predictim, онлайн-сервис, который якобы использует «передовой искусственный интеллект» для оценки рисков того, что няня будет увлекаться наркотиками, вести себя агрессивно или демонстрировать «дурные манеры».

Когда Джесси Баталья начала подыскивать новую няню для годовалого сына, ей хотелось получить о работнике больше информации, чем дают проверка отсутствия судимостей, комментарии родителей и личное интервью. Поэтому она обратилась к онлайн-сервису Predictim, использующему «передовой искусственный интеллект» для оценки личности няни, и направила его сканеры на тысячи постов в Facebook, Twitter и Instagram одной из кандидаток.

Система представила автоматическую «оценку риска» 24-летней девушки, утверждая, что риск использования ею наркотиков «очень мал». Однако риск проявления запугивания, агрессии, неуважения и плохих манер система оценила чуть выше – на 2 из 5.

Система не поясняет своих решений. Однако Баталья, считавшая няню вполне достойной доверия, внезапно начала сомневаться. «Социальные сети демонстрируют личность человека, — сказала Баталья, которой сейчас 29 лет, живущая в пригороде Лос-Анджелеса. – Почему же оценка получилась 2, а не 1?»

Predictim предлагает родителям те же услуги, которые продают работодателям десятки других технологических фирм по всему миру: ИИ-системы, анализирующие речь человека, мимику и историю присутствия в онлайне, обещая при этом раскрыть тайные аспекты их личной жизни.

Технология изменяет подход некоторых компаний к поиску кандидатов, найму и оценке работников, предлагая работодателям непревзойдённую оценку кандидатов посредством новой волны инвазивных психологических оценок и слежки.

В технокомпании Fama утверждают, что используют ИИ для мониторинга соцсетей работников на предмет «токсичного поведения», чтобы предупреждать их боссов. Фирма, специализирующаяся на технологиях рекрутинга HireVue, работающая с такими компаниями, как Geico, Hilton и Unilever, предлагает систему, автоматически анализирующую тон кандидата, выбор слов и мимику во время видеоинтервью, и предсказывающую их навыки и манеры (для получения лучших результатов кандидатам предлагают больше улыбаться).

Критики же утверждают, что системы, подобные Predictim, несут в себе свою опасность, оставляя автоматические решения, способные поменять жизнь человека, без всяких проверок.

Системы зависят от алгоритмов, работающих по принципу чёрного ящика, не выдающих почти никаких подробностей о том, как они свели все сложные подробности внутренней жизни человека к расчёту его положительных и отрицательных сторон. И хотя технология Predictim влияет на мышление родителей, она остаётся совершенно недоказанной, практически необъяснённой и уязвимой к искажениям восприятия, связанным с тем, как именно подходящая няня должна вести себя в соцсетях, выглядеть и говорить.

Существует «безумная гонка овладеть возможностями ИИ и принимать всякие решения без каких бы то ни было отчётов перед людьми, — сказал Джефф Честер, исполнительный директор Центра цифровой демократии, группы, пропагандирующей технологии. – Такое впечатление, что люди напились цифровой газировки, и думают, что это нормальный способ управлять нашей жизнью».

Процесс сканирования Predictim анализирует всю историю поведения няни в социальных сетях, которая для многих самых молодых нянь может захватывать большую часть их жизней. При этом няням сообщают, что если они откажутся проходить такое сканирование, это будет серьёзным недостатком при конкуренции за рабочие места.

Глава и сооснователь Predictim Сал Парса сказал, что компания, запущенная в прошлом месяце в рамках техноинкубатора Калифорнийского университета в Беркли SkyDeck, серьёзно подходит к этическим вопросам использования её технологии. Он сказал, что родители должны рассматривать рейтинг, как советчика, который «возможно, отражает, а возможно, не отражает реальные характеристики няни».

Он добавил, что опасность найма проблемной или склонной к жестокости няни делает ИИ необходимым инструментам для любого родителя, пытающегося обеспечить безопасность своего ребёнка.

«Поищите в Google случаи жестокого обращения нянь с детьми, и вы найдёте сотни результатов, — сказал он. – Бывают люди с психическими заболеваниями или просто злые. Наша цель – сделать всё, что в наших силах, чтобы остановить их».

Стоимость сканирования Predictim начинается от $24,99, и для неё нужно сообщить имя и e-mail потенциальной няни, а также получить её согласие на широкий доступ к её аккаунтам в соцсетях. Няня может отказаться, и тогда родители получают уведомление об этом, а сама няня получает письмо, где написано, что «интересовавшийся вами родитель не сможет нанять вас, пока вы не подчинитесь запросу».

Управляющие Predictim говорят, что используют алгоритмы для обработки языка и изображений, «компьютерное зрение», оценивающие посты няни в Facebook, Twitter и Instagram, и ищущие в них подсказки по поводу её офлайн-жизни. Отчёт получает только родитель, который не обязан делиться его результатами с няней.

Родители, вероятно, могут и сами взглянуть на общедоступные аккаунты няни в соцсетях. Однако компьютерные отчёты обещают дать глубокую оценку годам онлайн-активности, сведённым к единственной цифре: соблазнительно простое решение практически невыполнимой задачи.

Оценки рисков делятся на несколько категорий, включая откровенное содержимое и злоупотребление наркотиками. Стартап также утверждает в рекламе, что его система способна оценить и другие характеристики личности няни, такие, как вежливость, способность работать с другими и «позитивность».

Компания надеется перевернуть многомиллиардную индустрию «аутсорсинга родительских обязанностей» и уже начала рекламироваться, спонсируя блоги про воспитание детей и сайты для «мамочек». Маркетинговая стратегия концентрируется на заявленной возможности раскрыть секреты и предотвратить «кошмар любого родителя», а реклама цитирует уголовные дела, включающие, к примеру, дело няни из Кентукки, осуждённой за нанесение тяжких телесных повреждений восьмимесячному ребёнку.

«Если бы родители этой девочки, пострадавшей от няни, могли использовать Predictim в процессе одобрения кандидата, — написано в маркетинговом заявлении компании, — они бы никогда не оставили бы её наедине со своим драгоценным ребёнком».

Однако технологические эксперты говорят, что система самостоятельно выдаёт предупреждения, играя на страхах родителей, чтобы продавать результаты сканирования личности с непроверенной точностью.

Они также поднимают вопросы о том, как тренируются подобные системы и насколько они уязвимы для ошибок, способных возникнуть из-за неопределённостей, связанных с использованием нянями соцсетей. Родителям выдается только предупреждение о сомнительном поведении, без определённых фраз, ссылок или иных деталей, по которым они могли бы вынести своё решение.

Когда сканирование одной няни выдало предупреждение о возможной травле с её стороны, взволнованная мамаша, запросившая эту оценку, сказала, что не могла выяснить, заметила ли программа цитату из старого фильма, песни, или какую-то другую фразу, которую приняла за реально опасные высказывания.

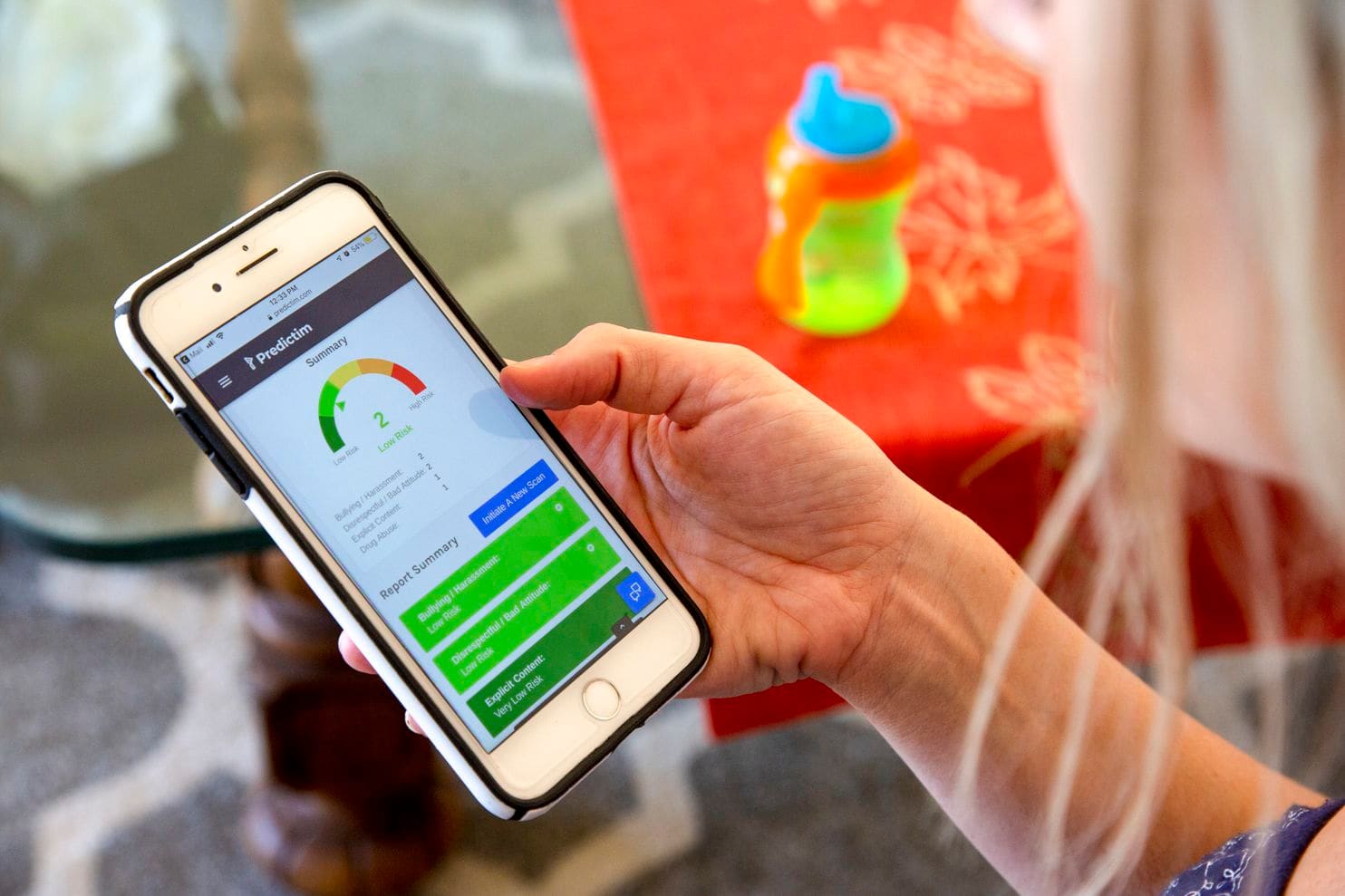

Телефон Джесси демонстрирует результаты работы приложения Predictim

Джейми Уильямс, адвокат из группы Electronic Frontier Foundation, борющейся за гражданские права, сказал, что по поводу большей части алгоритмов, применяемых сегодня для оценки значения слов и фотографий, известно, что у них не хватает человеческого контекста и здравого смысла. Даже техногиганты типа Facebook испытывали трудности при создании алгоритмов, способных различить безобидные и гневные комментарии.

«Как можно пробовать эту систему для оценки подростков: они же дети! – сказал Уильямс. – У детей есть свои собственные шутки, они славятся сарказмом. То, что может показаться алгоритму „дурными манерами“, человек может расценить, как политическое заявление или правомерную критику».

А когда система ошибается – допустим, заявляя, что няня злоупотребляет наркотиками – родители не смогут узнать об ошибке. Чёткие рейтинги и оценки точности работы системы могут заставить родителей ожидать от неё гораздо большей точности и авторитарности, чем мог бы обещать человек на её месте. В результате родители будут склоняться к найму нянь, которых они иначе избегали бы, или отдаляться от людей, уже заслуживших их доверие.

«Не существует метрики, которая точно смогла бы сказать, эффективны ли эти методы в своих предсказаниях настолько, насколько заявляют их создатели», — сказала Миранда Боген, главный аналитик из вашингтонского мозгового центра Upturn, изучающего использование алгоритмов для автоматического принятия решений и вынесения судебных постановлений. «Притягательность этих технологий с большой вероятностью опережает их реальные возможности».

Малисса Нильсен, 24-летняя няня, работающая у Баталья, недавно предоставила двум другим семьям доступ к своим соцсетям для оценки в Predictim. Она сказала, что всегда осторожно относилась к соцсетям и решила, что может поделиться дополнительной информацией без вреда для себя. Она еженедельно ходит в церковь, не матерится и заканчивает получение образования педагога в области обучения маленьких детей, после чего надеется открыть детский сад.

Однако узнав, что система выставила ей не идеальные оценки на основе неуважения и травли, она была поражена. Она считала, что позволяет родителям изучить её присутствие в соцсетях, а не алгоритму – критический разбор её личности. Ей также не сообщили о результатах теста, потенциально способного повредить её единственному источнику дохода.

«Мне бы хотелось немного разобраться в этом вопросе. Почему эта программа такое обо мне подумала? – сказала Нильсен. – У компьютера нет чувств, он не может определять всякое такое».

Американцы до сих пор не доверяют алгоритмам, чьи решения могут повлиять на их повседневную жизнь. В опросе от Pew Research Center, вышедшем в этом месяце, 57% опрошенных оценили автоматическую обработку резюме кандидатов на работу, как «неприемлемую».

Тем не менее, в Predictim сообщают, что готовятся к расширению работы на всю страну. Управляющие Sittercity, онлайн-сервиса по выбору нянь, который посещают миллионы родителей, говорят о запуске пилотной программы, которая внедрит автоматические рейтинги от Predictim в текущий набор автоматических оценок и проверок сервиса.

«Поиск няни таит в себе множество неопределённостей, — сказала Сандра Дайнора, глава по продукту в Sittercity, считающая, что подобные инструменты вскоре могут стать стандартными при онлайн-поиске работников по уходу. – Родители находятся в постоянных поисках лучшего решения, полнейшего исследования, достовернейших фактов».

Управляющие Predictim тоже считают, что могут серьёзно расширить возможности системы и предложить ещё более личностные оценки частной жизни няни. Джоэл Симонов, технологический директор, сказал, что команда интересуется получением «полезных психометрических данных» на основе анализа активности нянь в соцсетях, пропуская их истории через тест личности, к примеру, типологию Майерс — Бриггс, чтобы предоставить эти результаты родителям.

Майнинг соцсетей и интерес компании Predictim к массовому психологическому анализу схож с амбициями Cambridge Analytica, компании, занимающейся политическими консультациями, и работавшей в поддержку предвыборной кампании Трампа, а потом вовлёкшей Facebook в глобальный скандал, связанный с личными данными. Однако лидеры Predictim утверждают, что установили внутренние проверки безопасности и работают над защитой личных данных нянь. «Если бы у нас произошла утечка данных нянь, это было бы не круто», — сказал Симонов.

Эксперты беспокоятся, что рейтинговые системы на основе ИИ предвещают будущее, в котором получение человеком любой работы, не обязательно связанной с уходом за детьми, будет зависеть от машины. Многие компании, занимающиеся наймом и рекрутингом, уже создают или вкладываются в системы, способные анализировать резюме кандидатов в крупных масштабах и выдавать автоматические оценки кандидатов. Сходные ИИ-системы – включая Jigsaw, техноинкубатор, созданный в Google – используются для отслеживания онлайн-комментариев на предмет преследования, угроз и жестокости.

Однако уже не один раз было продемонстрировано, как алгоритмы по поиску сотрудников таят в себе недостатки, способные испортить человеку карьеру. В Amazon.com прекратили разработку алгоритма для найма, узнав, что он неправомерно занижает оценки женщинам, поскольку история найма в компании, подчиняющаяся тенденции техноиндустрии к найму мужчин, научила систему предпочитать кандидатов мужского пола. В компании сказали, что никогда не использовали эту программу для оценки кандидатов.

Некоторые ИИ-эксперты считают, что у подобных систем есть возможность серьёзно раздуть предубеждения, связанные с возрастом или расой, к примеру, помечая, как важные слова или фотографии определённых групп людей чаще, чем у остальных. Они также беспокоятся, что Predictim заставит молодых нянь поделиться своими личными данными просто для того, чтобы получить работу.

Однако Диана Вернер, мать двоих детей, живущая в пригороде Сан-Франциско, считает, что няни должны добровольно делиться личной информацией, чтобы помочь успокоить родителей. «Проверка биографии – хорошая штука, однако Predictim изучает вопрос углублённо, препарируя личность – их социальный и интеллектуальный статус», — сказала она. Там, где она живет, «100% родителей захотят использовать такой сервис, — добавила она. – Мы все хотим заполучить идеальную няню».

Комментарии (15)

Kate1313

17.12.2018 10:28Киберпанк приходит… киберпанк приходит (напевает на мотив песни из новогоднего ролика Кока Кола)

vassabi

17.12.2018 10:50+2Стоимость сканирования Predictim начинается от $24,99, и для неё нужно сообщить имя и e-mail потенциальной няни, а также получить её согласие на широкий доступ к её аккаунтам в соцсетях. Няня может отказаться, и тогда родители получают уведомление об этом, а сама няня получает письмо, где написано, что «интересовавшийся вами родитель не сможет нанять вас, пока вы не подчинитесь запросу».

О-о-о-о, техношантаж!

Система представила автоматическую «оценку риска» 24-летней девушки, утверждая, что риск использования ею наркотиков «очень мал». Однако риск проявления запугивания, агрессии, неуважения и плохих манер система оценила чуть выше – на 2 из 5.

Интересно, если оценить родителей — сколько им система выставит баллов?

А то был недавно небольшой тест системы распознавания преступников по фотографиям…

PS: ну что, пора седлать волну создания профилированного аккаунта в фоцсетях «под ключ»? А то ведь — то программистам рекомендуют иметь красивый линкедин со списком проектов и гитхабчик с причесанным кодом, теперь — няням (а в перспективе — всем учителям, начиная с младших классов) нужно иметь фб с красивыми фоточками и котятами (упаси боже репчик или рок, только гимны и детские песенки).

janvarev

17.12.2018 11:05+1Да-а, у меня нет слов просто…

Коротко: занимаюсь ИИ и психологией.

С точки зрения ИИ, как в общем-то, было сказано в статье, не существует эффективных способов оценки поведения человека (за исключением тривиальных случаев, когда человек пишет в соцсетях что-то в духе «Сейчас всех перестреляю»). Условно говоря, вместо подобной оценки можно было бы спрашивать у нянь свидетельство о высшем образовании или школьные оценки — там идет абсолютно такая же оценка человека с точки зрения его «интегрированности в социум». Более того, сделанная людьми, которые с этим человеком общались, а не машиной на основании высказываний.

С точки зрения психологии, также эффективных способов для оценки поведения человека не существует; в лучшем случае неплохие результаты дает какой-нибудь опросник MMPI на 500 вопросов, который определяет акцентуации (склонности) в данный момент времени. Мало того, что на его заполнение уходит куча времени, гарантий поведения даже такая штука не дает.

Можно еще отметить следующее — человек, вообще говоря, в течении жизни испытывает некие психологические циклы — в ряде случаев он будет соглашаться с социумом, в ряде — протестовать и продвигать собственные идеи. В самом лучшем случае сервис, указанный в статье, выставит лучшие оценки человеку, у которого выражение собственного мнения дико подавлено. Такую тихую… человеческую куклу.

Ну, и наконец, последнее. Данный сервис, не имея под собой научной основы, эффективно играет на страхах родителей детей. Это, пожалуй, самое неприятное. Сервис может выдавать оценки минимально соответствующие реальности и все равно пользоваться диким спросом, просто играя на чувствах родителей.

Исходя из всего вышесказанного, мне очень хочется просто назвать это все мошенничеством. Наверняка юридически подкопаться к данному сервису сложно (скорее всего там есть мелкие буковки по типу «мы даем только приблизительные оценки, решение вы принимаете самостоятельно, мы не несем никакой ответственности за данные рекомендации»), но, по сути, это все равно, что продавать дозы «лекарства от рака» с недоказанной эффективностью. Множество из тех, кто им болеют, все равно их будут покупать, с надеждой на чудо.

dsx87

20.12.2018 12:44+1занимаюсь ИИ и психологией

«Сейчас всех перестреляю»

ну вы понимаете…

По теме: ясно что это мошенничество чистой воды, рассчитанное на не очень умных родителей. Скорее всего будет работать до того как случится какой-нибудь печальный случай (суицид из-за потери работы, няня-убийца будет пропущена и т.п.) или какие-то массовые протесты работников этой сферы. Но только если такой случай произойдет когда контора еще не раскрутится и не будет средств на затыкание ртов

trueMoRoZ

20.12.2018 12:44+1Человек готов доверять непонятным алгоритмам больше, чем собственному впечатлению от общения с другим человеком. Это уже похоже на клинику. Такой человек не доверяет прежде всего самому себе. И если таких разводят на бабло, то это малое из зол, которое может произойти в их жизни.

adictive_max

17.12.2018 11:06+1Если бы люди были способны скоординировано поступиться сиюминутной выгодой ради отдалённой перспективы, то это бы относительно легко решалось. Пришёл на собеседование, увидел в анкете пункт «дайте разрешение на установку анального зонда», просто встаёшь и уходишь, сколько бы денег не предлагали. Ещё и компанию вносить в почётный список любителей высоких технологий, чтоб изначально народу поменьше шло. Если так будет поступать хотя бы половина, то это сделает систему бесполезной.

vindy123

17.12.2018 11:30Но ведь ничто не мешает провести методологически корректную проверку алгоритма на тестовой выборке и достоверно установить процент попадания в правильный результат? Мой внутренний скептик считает, что без этой довольно очевидной вещи отдавать такие важные решения, касающиеся своей семьи, на откуп коробке с неонкой, залитой сверху манипулятивным маркетинговым соусом, могут только _простаки_.

ЗЫ О, ребята-то уже закрылись) Цитирую их сайт —

Thank you for visiting Predictim! We have been overwhelmed by the interest, press coverage, and input regarding our project. To be honest, this attention came earlier than we expected, and certainly before we had fully launched our contemplated services. We received some very helpful feedback on ways we could make Predictim even better. Clearly, people are hungry for better ways to make decisions in marketplaces where character, reputation, and trustworthiness are important. As a result, we have decided to pause our full launch and put our heads down to focus on evaluating how we offer our service and making changes to address some of the suggestions we received. While we are not offering any services at this time, please stay tuned and check back often for updates: we will be back!

If you purchased a scan and want a refund, please email us at hello@predictim.com. Thanks!

JabbaTheHutt

17.12.2018 12:30+1Забавно было бы натравить на них какую-нибудь организацию по защите прав угнетенных меньшинств. Ведь наверняка этот сканер выдает для чернокожих лесбиянок более высокую склонность к воровству, агрессии и наркомании.

old_bear

17.12.2018 12:31+1И их ещё на засудили восторженные молодые няни? Вроде в Штатах за действия, по результатам которых человек необоснованно (в юридическом смысле) лишается работы, можно влететь на 100500 мильёнов. А уж если иск коллективный будет…

Tachyon

17.12.2018 14:45Хороший способ проверить не Будущую няню, а сначала саму Себя мамаши. И вот когда по оценке насилие и употребление наркотиков вы получите 4-5 из 5 возможных, тогда

а) Задумаетесь хорошая ли вы мать

б) Задумаетесь правдив ли тест и верить ли ему

в) Поймёте что 1-2 из 5 это в общем то и не риски даже.

Ну а если серьёзно, то если оставляете ребёнка без своего присмотра с кем-либо, то делайте это как минимум под видеонаблюдением.

geisha

17.12.2018 22:46Критики же утверждают, что системы, подобные Predictim, несут в себе свою опасность, оставляя автоматические решения, способные поменять жизнь человека, без всяких проверок.

Ну да, жили себе жили, а тут на тебе: оказывается, про тебя можно всё узнать из интернетов и сделать выводы. Предлагаю запретить узнавать и делать выводы на законодательном уровне!

roscomtheend

18.12.2018 11:08Няня следит за соцсетями (спецаккаунт для подобных ботов) — это плюс или минус? Т.е. по факту она обманывает бота, который лезет в её частную жизнь. И то, что ходит в церковь — это плюс или минус? По мне так минус — минус адекватность и(или) просто стремление показать социализированность с ЦА своих услуг.

Возмущение «у компьютера нет чувств» забавно, если бы он дал добро, то это «беспристрастная система», а как отказ — «бездушая машина». Примерно как с человеком — он может отказать из-за своих тараканов, но более-менее известны способы влияния, потому алгоритмов с неизвестными тараканами и боятся.

VIPDC

Ну вот и наступают времена фантастики. «Особое мнение», легкий вариант «Precrime» в действии.

Дальше может быть интереснее.

Особенно интересен опыт Китая, в котором никого спрашивать собственно не надо, + можно дополнить всё информацией обработанной с видеокамер которые там повсеместно внедряются.

Mimizavr

«Опыт Китая» надо смело делить на 4: что китайцы очень любят свои достижения преувеличивать, что о них очень любит зубоскалить западная пресса. Сейчас подобные проекты — очень сильная альфа и попытка срубить бабла на громких технологиях. Плюс надо понимать, что общество развивается не только технически, но и социально: в общем, адаптируемся)) Когда-то от первых машин тоже шарахались в ужасе, и ничего.