Ушами можно любить, на них можно вешать лапшу. А ещё ушами можно… видеть.

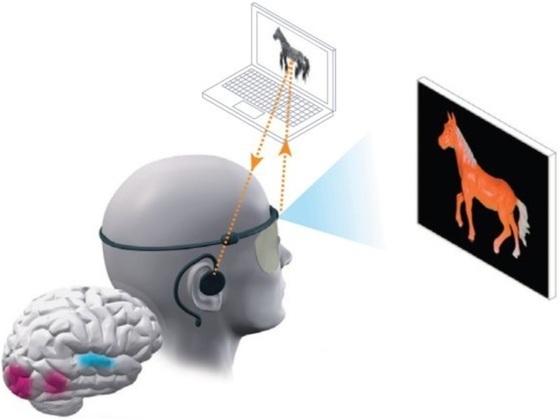

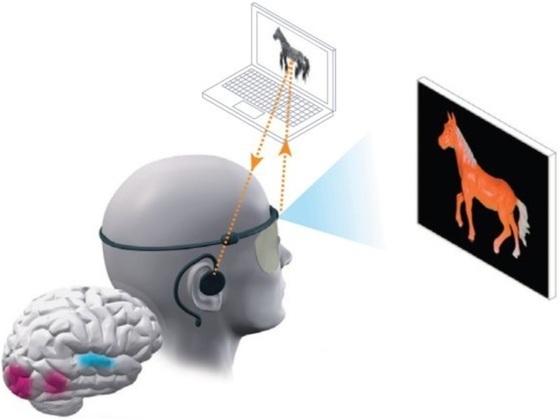

Много лет назад голландец Питер Мейер, сотрудник научно-исследовательского отдела компании Philips, начал работу над проектом Seeing With Sound, призванным заменить зрение незрячим людям. Идея была весьма необычной и на первый взгляд довольно спорной. Человеческий мозг довольно пластичен. И если превратить изображение с камеры в звуковую последовательность — возможно, после тренировок мозг пользователя сможет научиться воспринимать скрежещаще-свистящую трель не как звук, а как монохромную картинку и различать тёмные и светлые участки этого «аудио-изображения». На первый взгляд, идея неочевидная. Но её авторы сумели найти единомышленников и рискнули собственным временем и потраченными на оборудование деньгами. Так родилась система «звукового» зрения vOICe – (аббревиатура из трех заглавных букв звучит как «Oh I See»).

По отзывам экспериментаторов, после долгих и регулярных тренировок незрячие люди, пользующиеся vOICe'ом, могли передвигаться в помещениях, не натыкаясь на предметы, и даже читать крупный текст, например надписи на вывесках.

Такой проект не мог не привлечь внимание трансгуманистического сообщества РТД еще в 00-х, но только к середине 10-х прогресс железа и интернет-ресурсов позволил дать разработке vOICe новый импульс и организовать кампанию на Boomstarter, которая сегодня успешно завершается более чем на 100%. Базовый проект предусматривает создание 5 пилотных экземпляров системы для слепых пользователей плюс их обучение, но если кто-нибудь желает помочь еще одному человеку с ограниченными возможностями стать немножко Бэтменом, а заодно получить софт и обучающие материалы для экспериментов и сувенир на память, то это можно успеть сделать до 20:34 MSK 4 августа. Более подробно о проекте можно почитать на странице кампании, а сейчас несколько слов об истории его разработки от Яны Артищевой ака telegamochka:

Пять лет назад решили создать подобную систему и мы. Меня эта тема заинтересовала, т. к. имела непосредственное отношение к созданию носимого компьютера (НК). Кроме того, в то время наголовные дисплеи были малодоступны, дороги и громоздки, и меня интересовала разработка звукового интерфейса к НК. Так что когда мои друзья из РТД рассказали мне о проекте vOICe, я с большим интересом присоединилась к разработке.

Мы создали vOICe-систему на базе ASUS'овского нетбука и спортивного «хайратника» со вшитой в него веб-камерой. Система получилась громоздкая, не самая удобная, с небольшим (меньше часа) временем работы — но вполне пригодная для экспериментов.

К сожалению, в форумах незрячих мы не нашли поддержки. Не нашлось даже людей, которым бы было интересно опробовать систему. Впрочем, нетбук со стандартной ОС, лямками креплений и проводом от укреплённой на голове вебкамеры был малопригоден для того, чтобы незрячий человек мог им воспользоваться без посторонней помощи. Прототип есть прототип — и не более того…

Что гораздо менее удивительно — не заинтересовал наш проект и гос.институты.

И мы начали самостоятельно осваивать систему. Но зрячим это сделать гораздо сложнее. Во-первых, мотивация — она гораздо менее сильна. Да, мы сделали систему. Да, ею интересно научиться пользоваться. Интересно — но не более. Во-вторых, у зрячего человека из всех способов восприятия зрение — на первом месте, остальные же чувства, включая слух — как правило, на втором плане и мозг зрячего, как правило, менее искушен в обработке звуковой информации по сравнению с восприятием визуальных образов. Уловить фальшь певца, различить ноты сыгранного аккорда — да, на это мы способны. Но чтобы видеть с помощью слуха, зрячему нужно разрабатывать и разрабатывать слуховой инфо-канал. В то время, как у человека, долгие годы не использующего зрение, слух на порядок более приспособлен для «тонкой работы» со звуковой информацией. Достаточно вспомнить про незрячих людей, сумевших развить у себя способность к эхолокации, подобно дельфинам и летучим мышам.

И тем не менее, мне удалось добиться каких-то успехов в освоении vOICe. Ходить по комнате с завязанными глазами я не научилась, зато после нескольких недель тренировок я смогла сначала определять, какая фигура нарисована на озвучиваемой картинке — прямоугольник, овал или отрезок. Потом я научилась «слышать» несколько взаимно пересекающихся фигур, зарисовывать их взаимное расположение и определять яркость каждого объекта. Не на 100%, но на 60-70 мне удавалось довольно точно воспринять картинку. Пробовала я играть и в аудио-версию старого доброго «Вольфенштейна» — но, увы, абсолютно безуспешно.

Просуществовав чуть более года, наш проект постепенно угас.

Как видим, эпоха Raspberry Pi, Epson Moverio, Google Glass и краудфандинговых *starter'ов дает подобным проектам гораздо больше шансов на успех, чем 5 или 10 лет назад. Так получилось, что опубликовать конкретно этот проект на GT и вообще в хабрасемействе удалось только сегодня, на финишной прямой, но это только первый пилотный эксперимент. В связи с чем предлагаю подумать: а какие еще инициативы для помощи людям с ограниченными возможностями можно реализовать именно благодаря сегодняшним технологиям, и каких еще технологий универсального характера (платформ, подобно вышеупомянутым) нам еще не хватает, чтобы в течение 5-10 лет существенно увеличить количество и качество таких проектов?

Много лет назад голландец Питер Мейер, сотрудник научно-исследовательского отдела компании Philips, начал работу над проектом Seeing With Sound, призванным заменить зрение незрячим людям. Идея была весьма необычной и на первый взгляд довольно спорной. Человеческий мозг довольно пластичен. И если превратить изображение с камеры в звуковую последовательность — возможно, после тренировок мозг пользователя сможет научиться воспринимать скрежещаще-свистящую трель не как звук, а как монохромную картинку и различать тёмные и светлые участки этого «аудио-изображения». На первый взгляд, идея неочевидная. Но её авторы сумели найти единомышленников и рискнули собственным временем и потраченными на оборудование деньгами. Так родилась система «звукового» зрения vOICe – (аббревиатура из трех заглавных букв звучит как «Oh I See»).

По отзывам экспериментаторов, после долгих и регулярных тренировок незрячие люди, пользующиеся vOICe'ом, могли передвигаться в помещениях, не натыкаясь на предметы, и даже читать крупный текст, например надписи на вывесках.

Такой проект не мог не привлечь внимание трансгуманистического сообщества РТД еще в 00-х, но только к середине 10-х прогресс железа и интернет-ресурсов позволил дать разработке vOICe новый импульс и организовать кампанию на Boomstarter, которая сегодня успешно завершается более чем на 100%. Базовый проект предусматривает создание 5 пилотных экземпляров системы для слепых пользователей плюс их обучение, но если кто-нибудь желает помочь еще одному человеку с ограниченными возможностями стать немножко Бэтменом, а заодно получить софт и обучающие материалы для экспериментов и сувенир на память, то это можно успеть сделать до 20:34 MSK 4 августа. Более подробно о проекте можно почитать на странице кампании, а сейчас несколько слов об истории его разработки от Яны Артищевой ака telegamochka:

Пять лет назад решили создать подобную систему и мы. Меня эта тема заинтересовала, т. к. имела непосредственное отношение к созданию носимого компьютера (НК). Кроме того, в то время наголовные дисплеи были малодоступны, дороги и громоздки, и меня интересовала разработка звукового интерфейса к НК. Так что когда мои друзья из РТД рассказали мне о проекте vOICe, я с большим интересом присоединилась к разработке.

Мы создали vOICe-систему на базе ASUS'овского нетбука и спортивного «хайратника» со вшитой в него веб-камерой. Система получилась громоздкая, не самая удобная, с небольшим (меньше часа) временем работы — но вполне пригодная для экспериментов.

К сожалению, в форумах незрячих мы не нашли поддержки. Не нашлось даже людей, которым бы было интересно опробовать систему. Впрочем, нетбук со стандартной ОС, лямками креплений и проводом от укреплённой на голове вебкамеры был малопригоден для того, чтобы незрячий человек мог им воспользоваться без посторонней помощи. Прототип есть прототип — и не более того…

Что гораздо менее удивительно — не заинтересовал наш проект и гос.институты.

И мы начали самостоятельно осваивать систему. Но зрячим это сделать гораздо сложнее. Во-первых, мотивация — она гораздо менее сильна. Да, мы сделали систему. Да, ею интересно научиться пользоваться. Интересно — но не более. Во-вторых, у зрячего человека из всех способов восприятия зрение — на первом месте, остальные же чувства, включая слух — как правило, на втором плане и мозг зрячего, как правило, менее искушен в обработке звуковой информации по сравнению с восприятием визуальных образов. Уловить фальшь певца, различить ноты сыгранного аккорда — да, на это мы способны. Но чтобы видеть с помощью слуха, зрячему нужно разрабатывать и разрабатывать слуховой инфо-канал. В то время, как у человека, долгие годы не использующего зрение, слух на порядок более приспособлен для «тонкой работы» со звуковой информацией. Достаточно вспомнить про незрячих людей, сумевших развить у себя способность к эхолокации, подобно дельфинам и летучим мышам.

И тем не менее, мне удалось добиться каких-то успехов в освоении vOICe. Ходить по комнате с завязанными глазами я не научилась, зато после нескольких недель тренировок я смогла сначала определять, какая фигура нарисована на озвучиваемой картинке — прямоугольник, овал или отрезок. Потом я научилась «слышать» несколько взаимно пересекающихся фигур, зарисовывать их взаимное расположение и определять яркость каждого объекта. Не на 100%, но на 60-70 мне удавалось довольно точно воспринять картинку. Пробовала я играть и в аудио-версию старого доброго «Вольфенштейна» — но, увы, абсолютно безуспешно.

Просуществовав чуть более года, наш проект постепенно угас.

Как видим, эпоха Raspberry Pi, Epson Moverio, Google Glass и краудфандинговых *starter'ов дает подобным проектам гораздо больше шансов на успех, чем 5 или 10 лет назад. Так получилось, что опубликовать конкретно этот проект на GT и вообще в хабрасемействе удалось только сегодня, на финишной прямой, но это только первый пилотный эксперимент. В связи с чем предлагаю подумать: а какие еще инициативы для помощи людям с ограниченными возможностями можно реализовать именно благодаря сегодняшним технологиям, и каких еще технологий универсального характера (платформ, подобно вышеупомянутым) нам еще не хватает, чтобы в течение 5-10 лет существенно увеличить количество и качество таких проектов?

rPman

Как только в массовой продаже появятся доступные и дешевые (и не сильно громоздкие/заметные, как к примеру современные экшн-камеры, или встроенные к примеру в аксессуары типа очков, наголовного обруча или предметы одежды) носимые камеры, с трансляцией изображения в смартфон, то можете вспомнить об этом проекте, я думаю тогда он взлетит.

Основная сложность и предмет для исследования, по моему, тут форма преобразования изображения в звук. Например в какой координатной системе необходимо перекодировать изображение, стоит ли вести разложение по частотам видео изображения и как это делать, с целью обратного их преобразования уже в звуковой спектр и т.п.

p.s. Мне понравилась идея, озвученная тут (перевод Vert Dider), когда человек мог чувствовать предметы, изображение которых переводилось фактически один к одному на матрицу соленоидов, размещенных на спине.

Вообще то основная идея выступления была в том что мозг переварит практически любой способ подключения органов чувств, не удивлюсь если и обоняние можно завести через слух, а осязание через зрение (если кто то решится на такой эксперимент), и массив соленоидов (по мне так достаточно любой матрицы слабых раздражителей) на любой части тела, хоть к примеру и на обратной стороны ладони.

dkukushkin

Почему на спине? Нервные окончания пальцев рук более развиты. Сделать экран 10-10 см. из тех же соленоидов или подобного. Помоему даже зрячий сможет понять что за картинка, а слепой так и подавно (со шрифтом брайля они натренировались).

Основная проблема — где взять такой экран.

BalinTomsk

оказывается видеть можно и животом

balintomsk.livejournal.com/?skip=100

heathen

Скажите, а почему вы не нашли добровольца из людей, потерявших зрение? Это бы дало вашему проекту второе дыхание, и стало бы доказательством идеи? Общества слепых есть везде.

Tseikovets

Они находили и активно до сих пор ходят по обществам слепых. Просто люди им отвечают, что это не помогает в реальной жизни, но они до сих пор этого не хотят принять, считая, что им лучше знать, что нужно слепым и как им удобнее.

Сюда же вылезли для PR'а своей краудфандинговой компании. Самое же интересное в том, что деньги на всё это дают зрячие, которые просто не понимают, что технология мёртвая. Практически уверен, что среди спонсоров нет ни одного незрячего.

heathen

Честно сказать, это очень любопытное заявление. А чем обосновано то, что «это не помогает в реальной жизни»?

vxsw, дайте, пожалуйста, собственные комментарии. Вы проводили консультации с потенциальными пользователями, они видели прототип, пользовались им? Вы можете привести хоть какие-нибудь реальные отзывы незрячих людей из тех, кто знаком с проектом и пользовался прототипом?

Tseikovets

Ну вы себе вообще представляете, как работает эта технология?

Там всего лишь посредством звукового сигнала описывается контур предмета в фокусе камеры. Слева направо постоянно пробегает звук изменяющейся высоты — это координата x. Ну а высота сигнала описывает координату y. Скорость прохождения сигнала по условному кадру можно настроить, но у этого есть очевидный предел воспринимаемости. В итоге, технология лишь может описать контур предмета перед камерой примерно каждую секунду.

Есть дополнительные функции, типа произнести голосом доминирующий цвет в кадре, но это уже вторичная функция. Кстати, вот она как раз незрячими иногда реально используется посредством мобильного приложения.

А теперь просто представьте: у человека нет зрения, то есть минус 85-90% информации проходит мимо. Он начинает ориентироваться наслух. Слух становится главным чувством. Данная же технология предлагает забить канал слухового восприятия, подсунув вместо этого медленное покадровое описание контура предмета в фокусе камеры. Это просто неэквивалентная замена, поэтому у незрячих всего мира за эти несколько десятилетий данная технология и не нашла отклика.

Самое главное в том, что чистый ярко выраженный контур есть только на тех самых карточках, на которых часто и демонстрируют эту технологию. В реальной жизни, например, когда ходите по комнате или улице, в кадре такая мешанина, что и сигнал получается неинформативным.

По поводу отзывов реальных пользователей и консультации с ними — это бессмысленный разговор. Эти люди, форсят данную технологию уже очень много лет. Я их помню ещё в 2008-2009 году, но по-моему началось всё ещё раньше. Помню девочку по имени, если не ошибаюсь, Кристина, которая активно окучивала сетевые сообщества инвалидов лет пять назад. Помню и их главного — Данилу Медведева, который как-то пришёл на радио передачу для незрячих и рассказывал, что белой тростью можно отмахиваться от хулиганов, а вот для ориентирования в городе слепым нужно использовать звуковое зрение. При этом, там были и звонки реальных незрячих, в том числе пробовавших эту технологию. Они ему говорили, что это бред, но его это не смутило.

Так что с реальными пользователями они сталкивались и не раз, просто считают, что им виднее. Есть ли за этим какой-то меркантильный подтекст или это просто упрямство и желание облагодетельствовать насильно и на своих условиях, я не знаю. Таких оценок давать здесь не готов. Но люди реально уже много лет не хотят признать, что это не реальный инструмент, а всего лишь академический эксперимент одного человека, который сделал его в качестве хобби и сам на него забил уже много лет назад.

heathen

Спасибо за развёрнутый ответ, очень любопытно. Технологию в общих чертах представляю, но предполагал, что вопрос с окружающим звуком как-то решён.

norlin

Какое-то время назад видел описание аналогичного проекта (зарубежного). Там время освоения называлось, если не ошибаюсь, ~70 часов.

Сейчас сходу не гуглится ничего конкретного… Зато наткнулся на описание приложения для смартфона с аналогичной задачей. Это, кстати, очень крутая идея – в принципе, кроме смартфона больше ничего и не нужно. Никаких сложных медицинских девайсов, ничего такого. Только смартфон с камерой и наушниками + приложение.

Tseikovets

Ну вот только не надо лукавить: были и люди, которые это пробовали, и активная информационная компания с вашей стороны некоторое время назад. Видимо сейчас вы пошли на очередной заход.

Просто сама технология мертворождённая, что вам неоднократно говорили представители целевой аудитории, которые её пробовали, но почему-то вы тут об этом скромно умалчиваете.

Забивать слепым канал слухового восприятия, подсовывая вместо него плохой суррогат зрения, — это априори проигрышный вариант, но вы продолжаете насиловать эту старую технологию, которая была разработана уже несколько десятилетий назад и убедительно показала свою нежизниспособность. Распознавать с её помощью фигуры на специально подготовленных карточках — это абсолютно не то, что интересует слепых людей.

amarao

(задумчиво)

Аудиоканал даёт нам порядка 2х16000х8 бит информации в секунду (я беру реальную частоту и более-менее различимые уровни громкости). Это 256килобит/с. Предположим, что мы делаем моно-картинку. Насколько я понимаю, никакого MPEG в мозг передать не удаётся, то есть сигнал идёт некодированным. Если мы хотим передавать разрешение 320х240 (76 килопикселей), хотя бы два раза в секунду то имеем примерно 1-2 бита на пиксел.

В принципе, проходит, да, но едва-едва.

Но лучше мозг учить декодировать компрессированное видео. В 200 килобит вполне себе 360p можно закодировать разборчиво.

rPman

Неверно мыслите!

Информации на картинке может быть заметно меньше. Если вы привыкли считать килобитами, попробуйте оценить, сколько будет весить отвекторизованная картинка, в которой обведены только актуальные объекты?

p.s. я бы смотре в сторону разложение в ряд фурье (или другой ряд) изображения во времени и/или локальные изменения интенсивности/цвета в двухмерном пространстве (есть то же разложение фурье в 2д варианте). Прямая аналогия — есть импульсно-кодовое кодирование звука (обычно в wav хранится) а есть сохранение звука в виде разложения по спектру — mpeg, компактнее на порядок.

amarao

Это называется «компрессия» и предполагается, что мозг это сумеет декодировать.

Заметим, что приемлимо работать будет только на тех условиях, где предполагается монотонный фон. То есть цветастый зонтик у дамы впереди — и бедный пациент сворачивается клубочком из-за невозможности декодировать ЭТО.

SADKO

Ухо — не сэмплер, а спектроанализатор, если грубо, а там ещё есть регулировка чувствительности входа и отдельных полос.

Глаз то-же не камера, там достаточно много предварительной обработки, а про зрительную кору я вообще молчу.

Человека всякому можно научить, но лучше всего он учится и воспринимает когда информация поступает если не в доступной, то хотя бы в привычной форме.

От первого поколения имплантантов для не зрячих и глухих, было мало толку именно по этой причине.