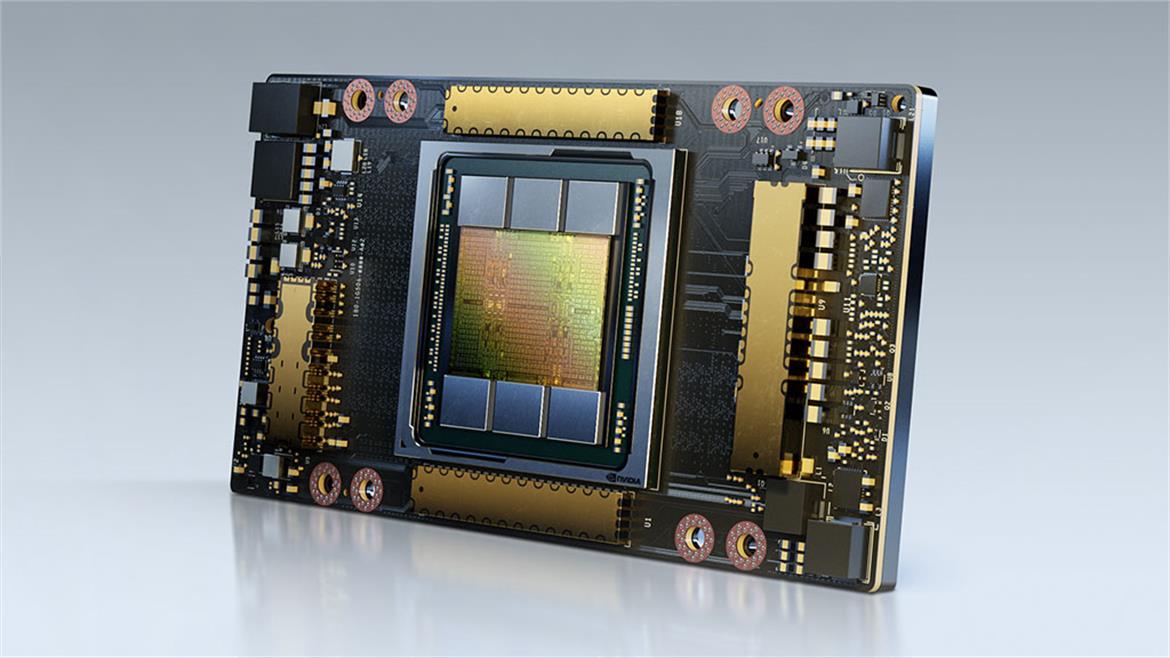

В мае этого года Nvidia представила мощный графический ускоритель под названием A100 с 40 ГБ памяти HBM2e. Карта разработана только для дата-центров. Ею комплектуются фирменные модули Nvidia DGX A100 для вычислительных кластеров, в том числе для суперкомпьютеров. В ноябре были запущены первые инстансы AWS на ускорителях A100 (инстансы EC2 P4d). Судя по всему, это A100 — де-факто самые производительные GPU в мире.

Сейчас представлена новая версия флагманского видеоускорителя, которая оснащается вдвое большим объёмом памяти — 80 гигабайт HBM2e. Это более продвинутый стандарт памяти, у которого увеличена тактовая частота, так что пропускная способность памяти в новой версии доведена до 3,2 Гбит/с на каждый пин, что даёт в сумме пропускную способность всей памяти 2 ТБ/с.

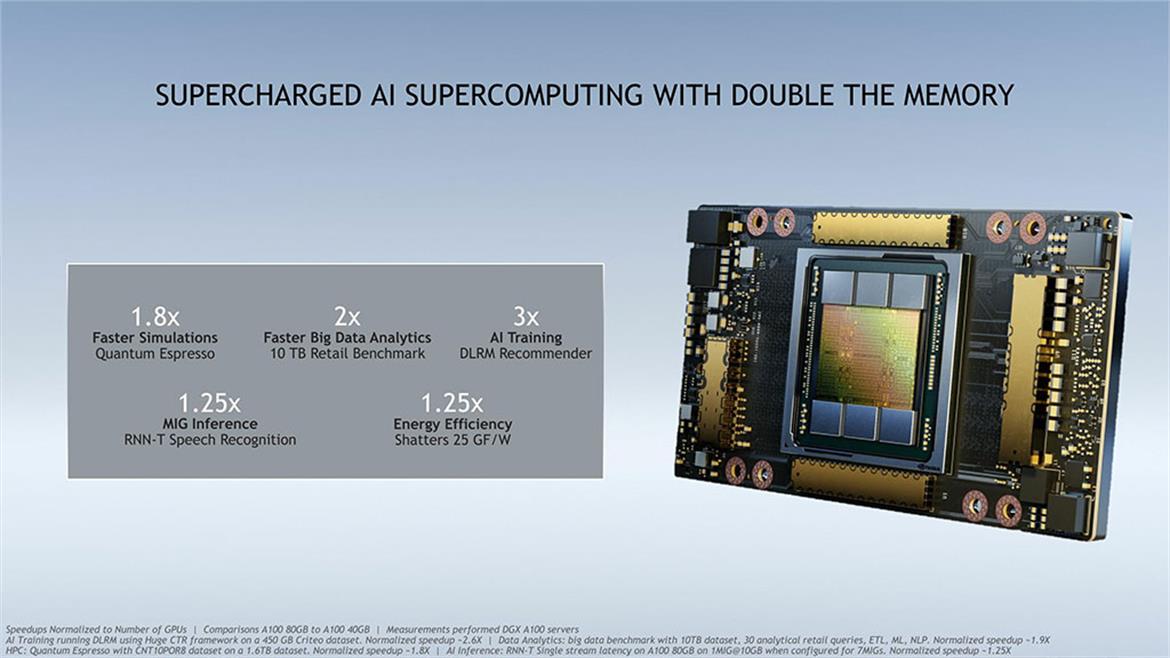

Nvidia не снимает старую модель с производства и будет одновременно продавать 40- и 80-гигабайтные версии. Основные заказчики — клиенты с большими наборами данных для обучения систем искусственного интеллекта. При работе с чрезвычайно большими наборами данных объём памяти является «бутылочным горлышком» в аппаратной части, то есть главным ограничивающим фактором. Таким образом, если графический ускоритель способен сохранить всю нейронную модель в локальной памяти целиком, то потенциально он может быть значительно быстрее, чем тот GPU, которому часто приходится выходить для обмена данными во внешнюю память за пределами платы.

Сравнение первого и второго поколения А100 с 40 и 80 ГБ памяти

Технические характеристики топовых ускорителей Nvidia

A100 (80 ГБ) A100 (40 ГБ) V100 Ядер FP32 CUDA 6912 6912 5120 Макс. частота 1,41 ГГц 1,41 ГГц 1,53 ГГц Частота памяти 3,2 Гбита/с HBM2e 2,4 Гбита/с HBM2 1,75 Гбита/с HBM2 Шина памяти 5120 бит 5120 бит 4096 бит Полоса пропускания памяти 2,0 ТБ/с 1,6 ТБ/с 0,9 ТБ/с VRAM 80 ГБ 40 ГБ 16 ГБ/32 ГБ Числа одинарной точности 19,5 TFLOPs 19,5 TFLOPs 15,7 TFLOPs Числа двойной точности 9,7 TFLOPs

(1/2 FP32 rate)9,7 TFLOPs

(1/2 FP32 rate)7,8 TFLOPs

(1/2 FP32 rate)Тензоры INT8 624 TOPs 624 TOPs N/A Тензоры FP16 312 TFLOPs 312 TFLOPs 125 TFLOPs Тензоры TF32 156 TFLOPs 156 TFLOPs N/A Интерконнект NVLink 3

12 Links (600GB/sec)NVLink 3

12 Links (600GB/sec)NVLink 2

6 Links (300GB/sec)GPU GA100

(826 мм2)GA100

(826 мм2)GV100

(815 мм2)Транзисторов 54,2 млрд 54,2 млрд 21,1 млрд TDP 400 Вт 400 Вт 300 Вт/350 Вт Процесс производства TSMC 7N TSMC 7N TSMC 12nm FFN Интерфейс SXM4 SXM4 SXM2/SXM3 Архитектура Ampere Ampere Volta

Как видим, единственное различие между 40-и 80-гигабайтной версиями A100 заключается в объёме и пропускной способности памяти. Обе модели сделаны на базе графических процессоров GA100 с максимальной тактовой частотой 1,41 ГГц. Аналогично, TDP у двух моделей тоже не отличается.

Вместо этого улучшения A100 сводятся к объёму и большей пропускной способности памяти. Оригинальный A100 оснащался шестью 8-гигабайтными стеками памяти HBM2, причём один из них был отключён. Это давало 40 ГБ памяти с пропускной способностью 1,6 ТБ/с.

В новом A100 сохранилась та же конфигурация 5/6 стеков, но здесь поставили новую память HBM2E. Это неофициальное название для последнего поколения стандарта памяти HBM2 с рекордной пропускной способностью 3,2 Гбит/с на пин. Улучшения в техническом процессе позволили производителю удвоить ёмкость памяти. Конечным результатом является то, что HBM2E предлагает и больше ёмкость, и больше полосу пропускания.

Судя по всему, выпуск новой версии A100 с большей пропускной способностью и большим объёмом памяти является не столько запланированным шагом, сколько побочным эффектом от улучшения техпроцесса. Samsung и SK Hynix совсем недавно начали массовое производство HBM2E.

В A100 сохраняется аппаратное ограничение в 7 инстансов на один ускоритель.

Nvidia выпускает A100 на серверных платах HGX и DGX. Для клиентов, которым нужны отдельные экземпляры ускорителя, по-прежнему предлагаются A100 в исполнении PCIe, хотя в варианте 80 ГБ они пока не доступны.

Конфигурация DGX — это новинка. В такую систему устанавливается восемь ускорителей, так что совокупный объём памяти достигает 640 ГБ.

Также доступна рабочая станция DGX Station A100. Это наследник прежней DGX Station образца 2017 года на ускорителях Volta.

По сути, DGX Station A100 — усечённая наполовину DGX A100 с четырьмя ускорителями A100 и одним процессором AMD EPYC. Энергопотребление пока неизвестно, но на пресс-конференции, заявили, что рабочая станция «работает от обычной розетки». Для сравнения, потребляемая мощность стандартной DGX A100 составляет 6,5 кВт.

Рабочая станция DGX Station A100

Станция DGX использует хладагент, то есть искусственное охлаждение (рефрижерацию), тогда как в DGX Station предыдущего поколения было простое водяное охлаждение. Можно предположить, что возникнет дополнительный шум, связанный с подключением компрессора.

Массовое производство обеих систем уже началось. Nvidia говорит, что они работают в нескольких небольших суперкомпьютерах, таких как Cambridge-1. Но продажи для всех желающих планируются только в феврале 2021 года.

maxpivovar

Где то плачет

Илон МаскTesla