Привет, %username%. Меня зовут Семён Климов, я менеджер проектов технического департамента в Selectel. Сегодня я расскажу, как мы разрабатывали корпусы серверов из линейки Chipcore (выделенные серверы по доступной цене). В далеком 2016 году перед нами встала нетривиальная задача: необходимо уйти от стеллажей с объемными системными блоками и привести железо к более компактному виду, который бы позволял размещать бо́льшее количество серверов на единицу площади.

С чего все начиналось

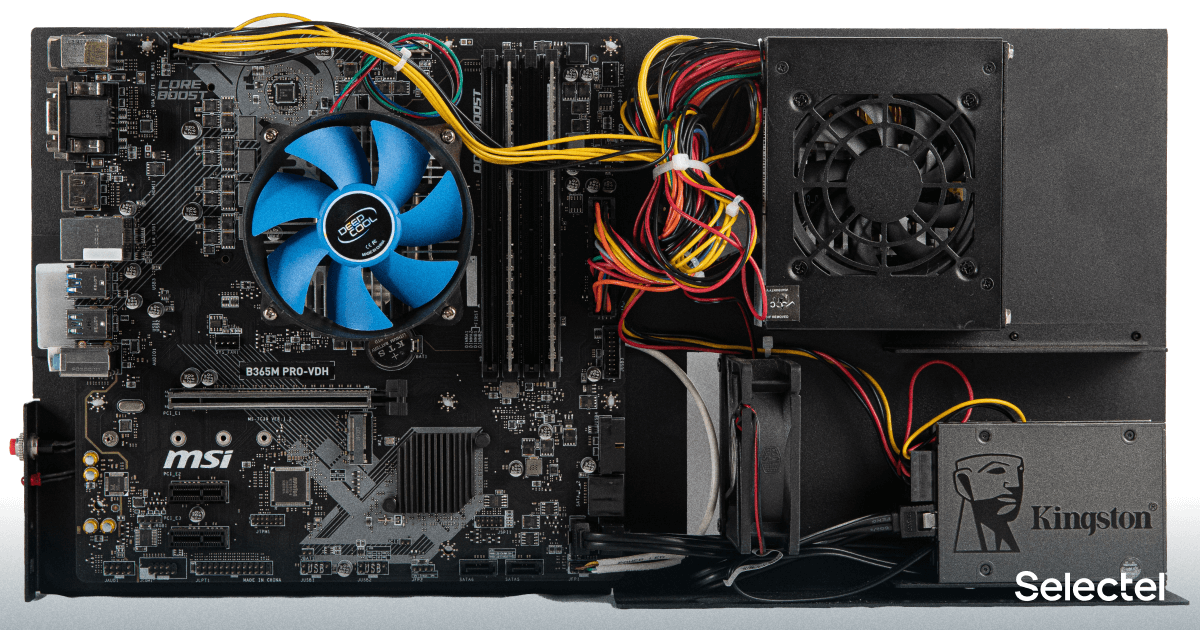

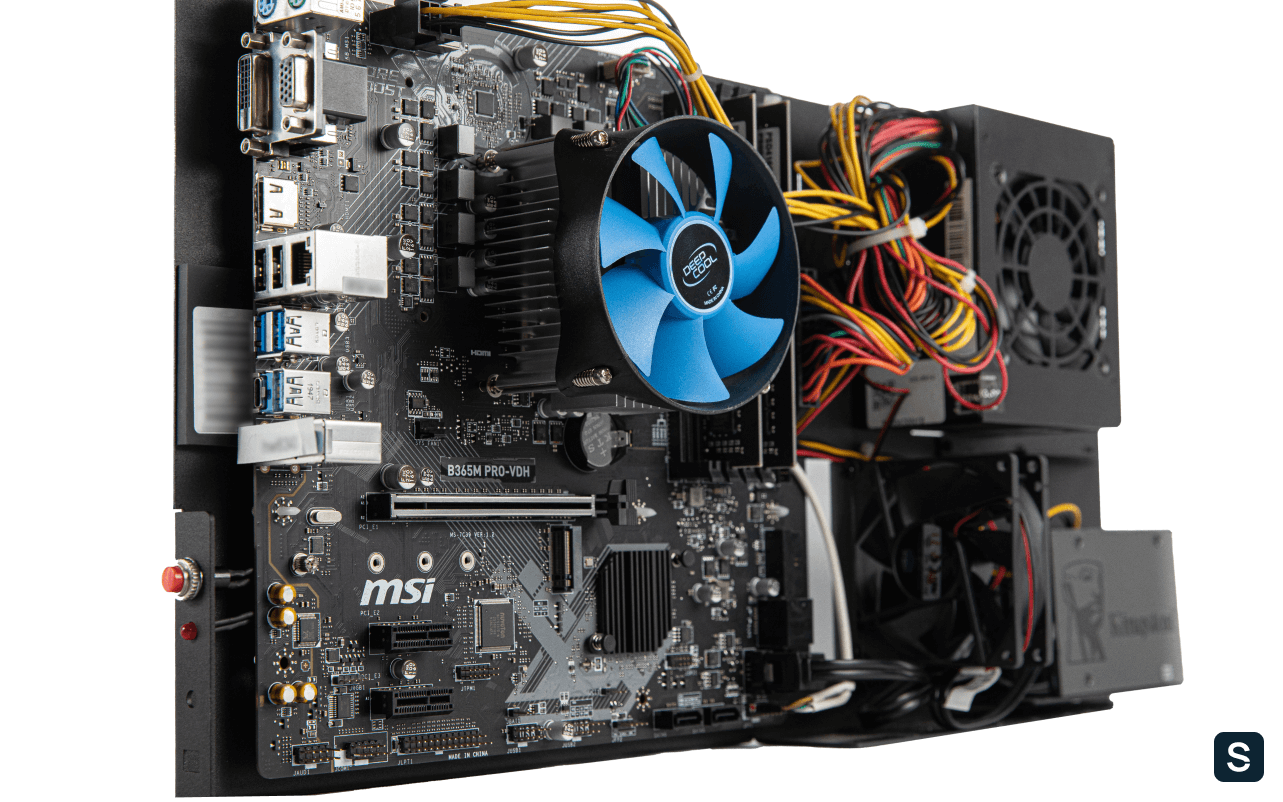

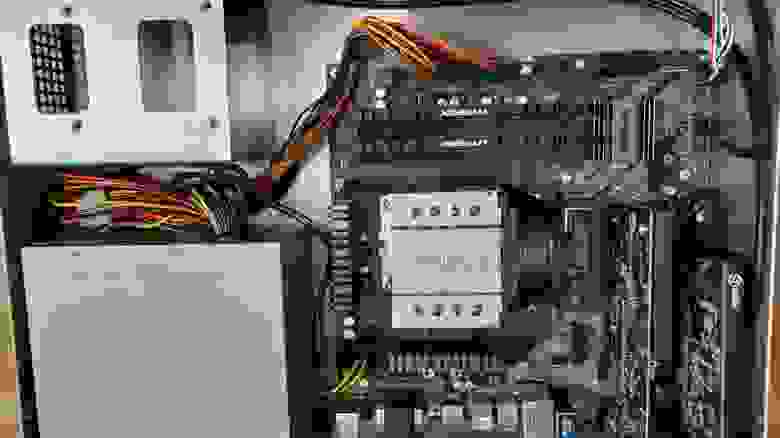

На первый взгляд задача выглядит простой: все элементы системного блока — материнскую плату, блок питания и диски — надо разместить компактнее на стеллаже с полками. Решили расположить комплектующие вертикально, на одном листе металла, что позволило бы уместить на одном стеллаже 72 сервера вместо 20.

Старое фото от 2015 года ЦОД Tehnodom

Старое фото от 2015 года ЦОД TehnodomВсе началось в начале 2016 года — с листочка бумаги формата А4, на котором был от руки нарисован примерный план расположения дисков, блока питания и материнской платы. План воплотился в чертеж благодаря проектировщику-фрилансеру, который честно отрисовал в AutoCAD наши «хотелки». Так был спроектирован первый образец пластины.

Затем мы начали искать завод, который возьмется за изготовление прототипа. Нашли такой в городе Арзамас Нижегородской области — ОАО «Рикор Электроникс». Радости не было предела: завод готов взяться за работу, если мы закажем не меньше сотни пластин. Спустя месяц я уже держал прототип в руках.

Радость была недолгой: пластина с комплектующими была неустойчива и падала при малейшем дисбалансе. Чтобы решить проблему, мы увеличили основание, на которое опиралась пластина, на 2 см и перенесли блок питания вниз. Это сместило центр тяжести — пластина стала устойчивее.

В процессе мы решили найти другого производителя корпусов — им стала компания «Мир металла» из города Подольск. Отправили ей все имеющиеся чертежи и даже образец готового изделия.

Но появился нюанс: текущие чертежи в формате AutoCAD не подходят, нужен формат для станков с ЧПУ. Причем станки на новом заводе отличаются от предыдущих, поэтому нужно адаптировать чертеж. Когда мы с этим справились, новый партнер изготовил тестовый экземпляр пластины. Казалось, что вот он — Chipcore моей мечты.

Огни-огни… так ярко светят они

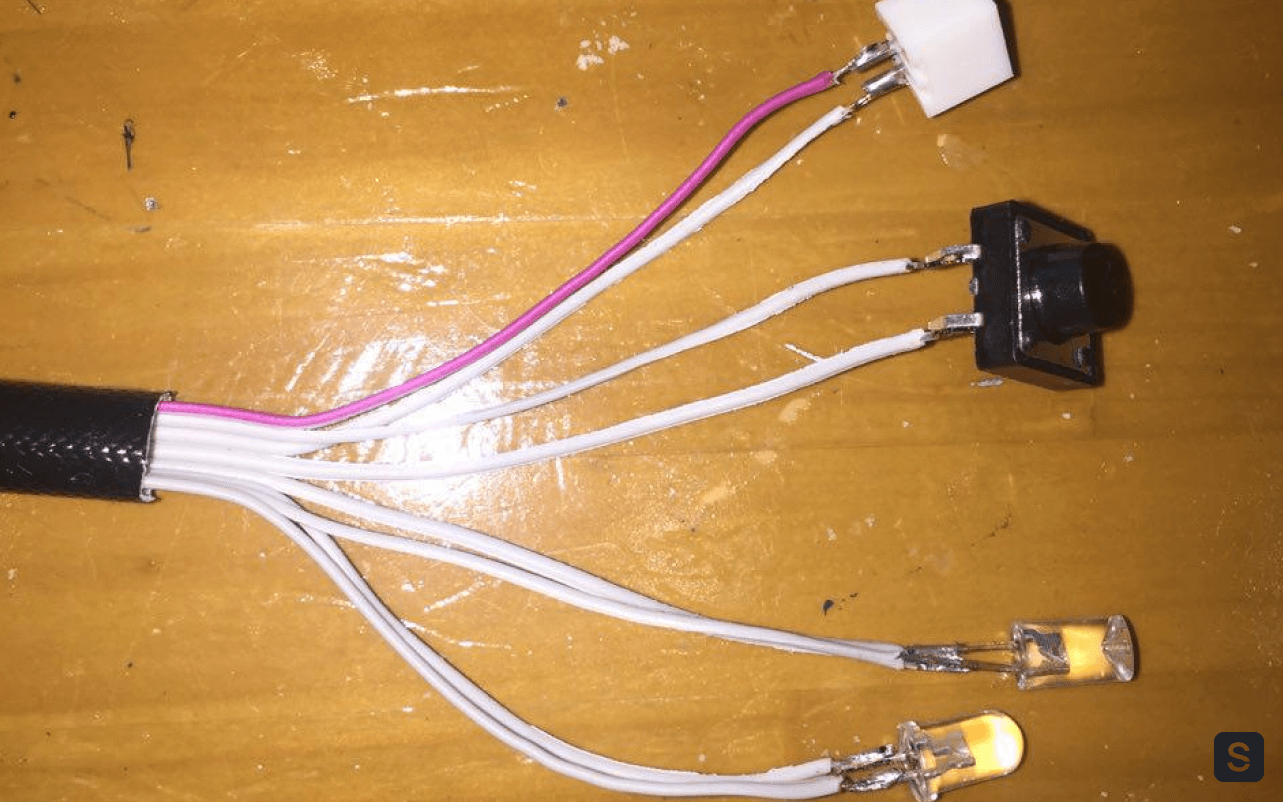

Через месяц к нам пришла сотня пластин. На них удалось обкатать несколько видов материнских плат и блоков питания. В результате мы выяснили, что некоторые провода блоков питания не дотягиваются до разъемов материнских плат! Это было первое (и не последнее) разочарование. Также мы поняли, что на текущих пластинах нам не хватает нескольких элементов для работы с сервером: нужно разместить кнопку питания, индикатор работы сервера и диска (два светодиода) и порт для удаленного управления.

В дальнейшем идея управления питанием через RS-485 с использованием Moxa умерла так и не родившись. От порта мы отказались.

Управление питанием серверов организовали через PDU. В поисках лучших кнопки, разъемов, светодиодов, сечения проводов были перекопаны километры интернета. И вот, появился нехитрый апгрейд пластины — уголок с индикацией и управлением. Именно этим «уголком» я вручную оснастил первые 100 пластин. Кстати, они верой и правдой работают до сих пор.

Паять проводочки к светодиодикам оказалось неблагодарным и трудозатратным делом. Решили найти готовые провода с нужным разъемом на материнскую плату. Опять же, Google мне в помощь. Дни и ночи в поисках и … ничего. Ничего, что удовлетворяло бы нашим требованиям.

Пришлось пойти проверенным способом — через производителя. Им стал небольшой подмосковный производитель кабельных жгутов и сборок. До сих пор им благодарен, так как они быстро схватили суть и выполнили требования на 100%. Уже через неделю у меня на столе лежала нужная кабельная сборка. От индикатора работы диска и разъема управления решили отказаться за ненадобностью.

Chipcore v2.0

После нескольких месяцев эксплуатации стало понятно, что серверы пользуются спросом, количество не занятых клиентами машин стремительно сокращалось. Мы заказали новую партию пластин (вновь 100 штук) с учетом доработок. Так появилась вторая версия корпуса для Chipcore.

В таком виде пластина всем понравилась — и отделу сборки, и инженерному отделу, производящему монтаж и обслуживание серверов.

Ничего не предвещало беды, но через полгода пришла большая партия материнских плат с другим расположением разъемов Ethernet. Монтаж стал похож на акробатические трюки. Пришлось переосмыслить пространство (и время), поработать с размерами, перебрать десятки вариантов, чтобы найти «тот самый».

Также в процессе эксплуатации стало понятно, что летом температура в серверной повышается, фрикулинг не справляется, а перегрев процессора вызывает троттлинг. С этим надо было что-то делать.

Первое, что пришло на ум, — поставить дополнительный кулер, который продувал бы воздух между плотно стоящими на стеллаже пластинами. И мы его поставили… на стяжки. Да-да, пришлось поставить кулеры на стяжки, чтобы хоть как-то решить вопрос перегрева. Это помогло, но только на маломощных процессорах. Температура же на производительных, «горячих» CPU упала незначительно. Нужно было придумать другое решение.

Путь к совершенству

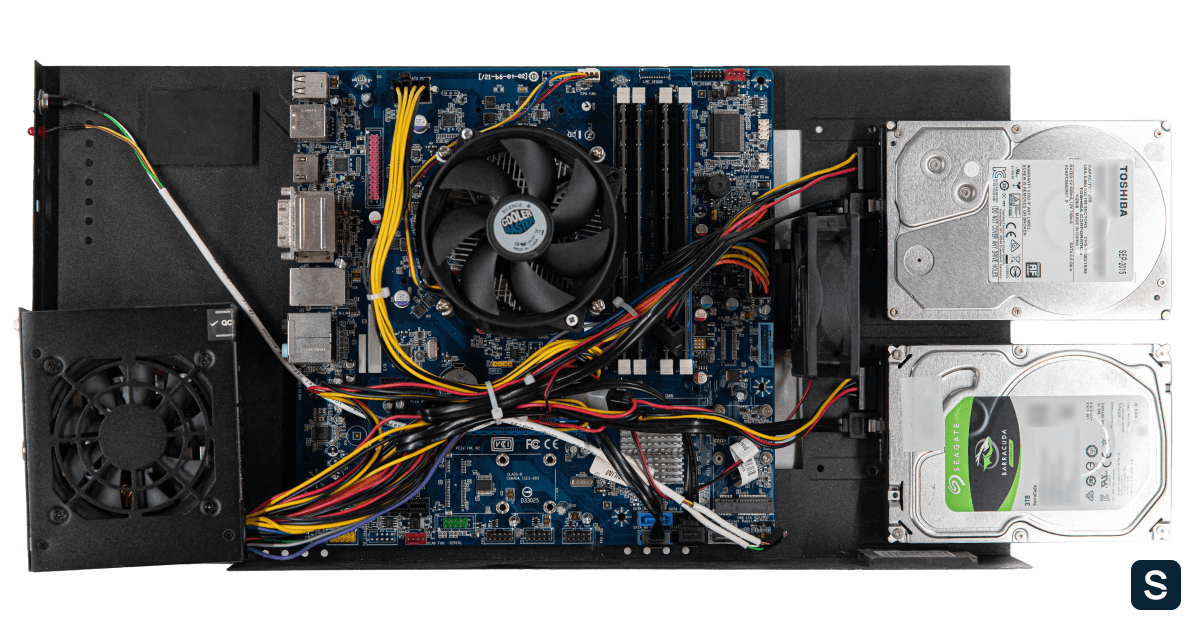

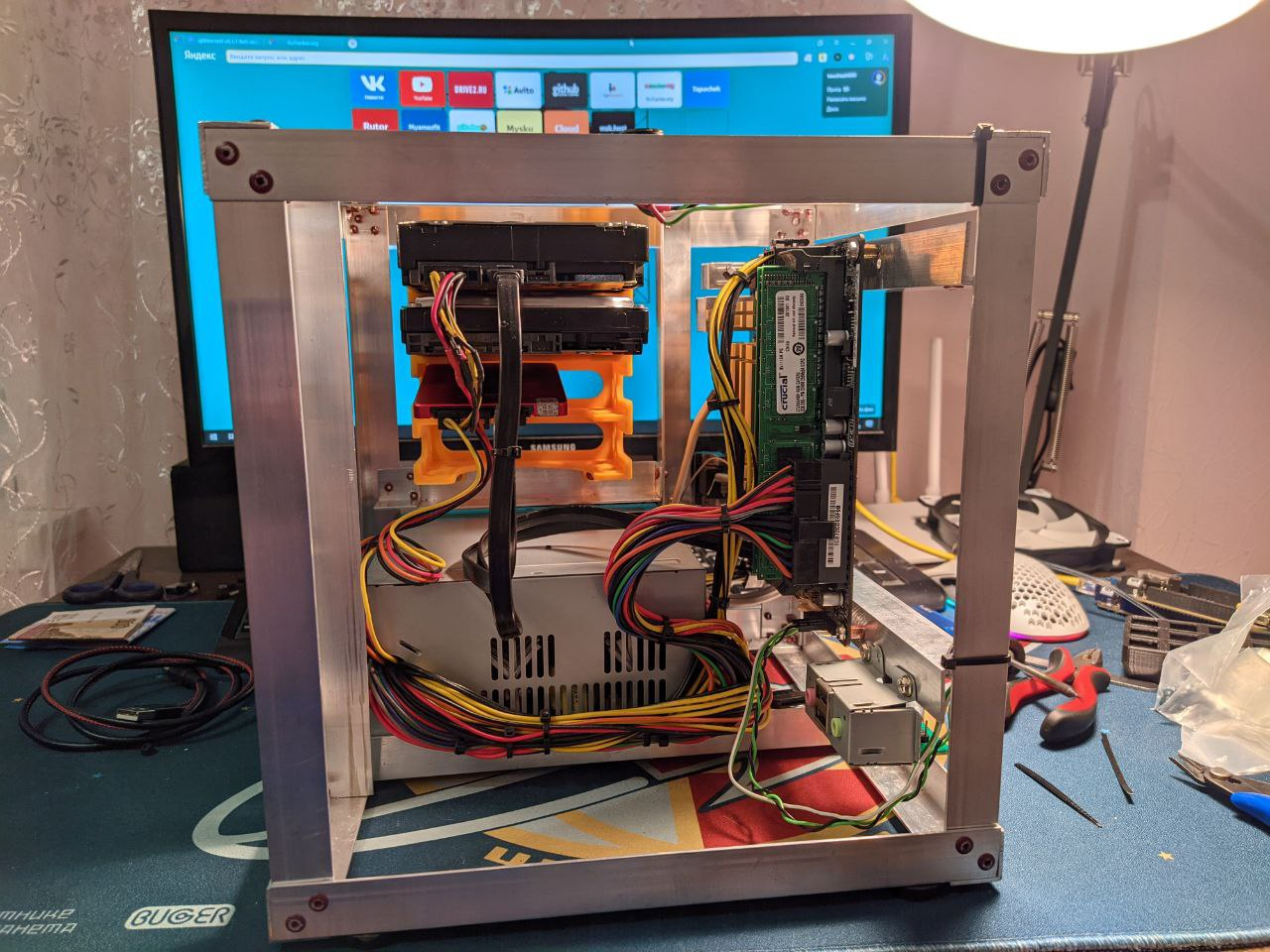

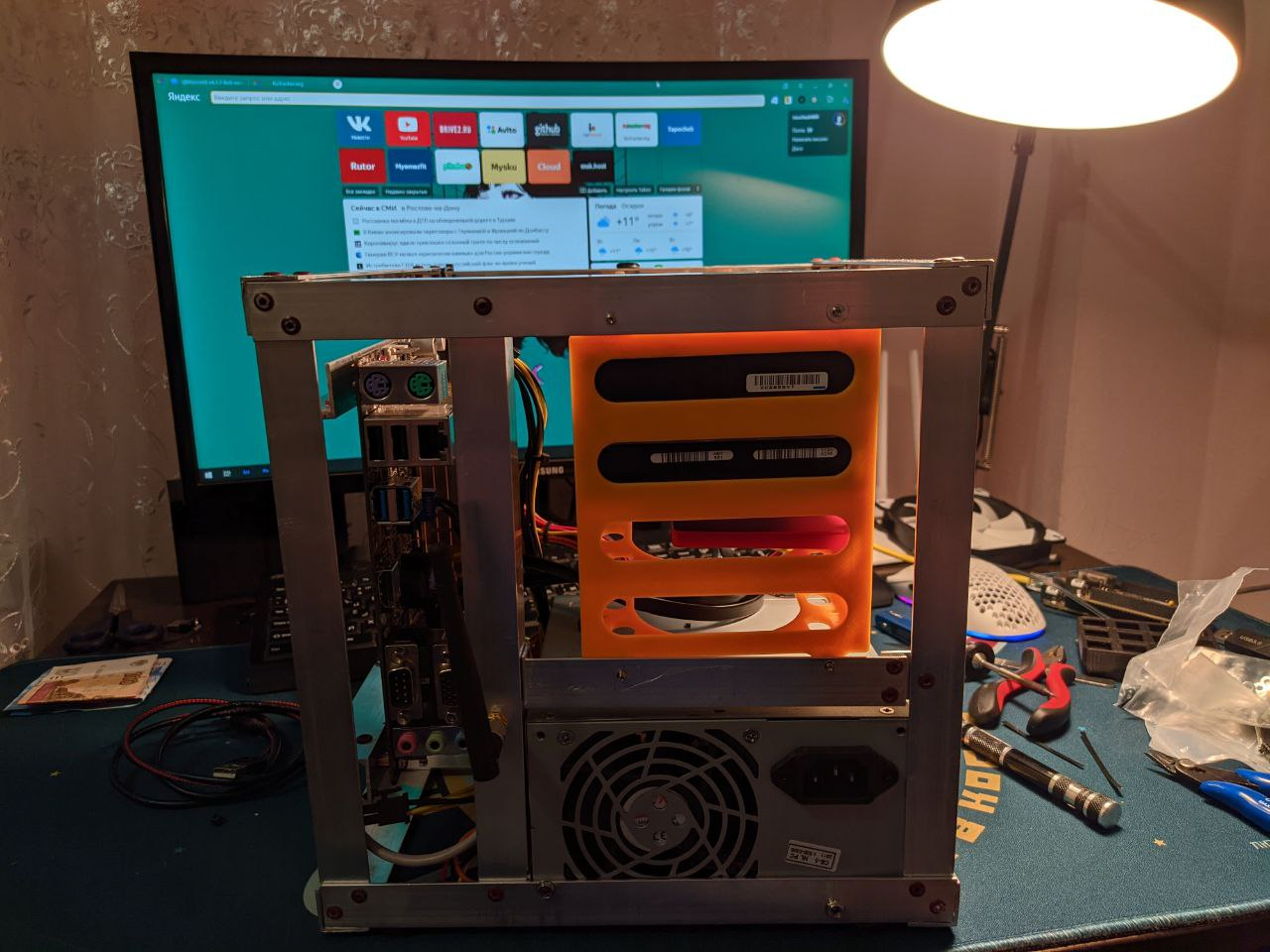

Новые требования мы учли в третьей версии Chipcore. На этот раз принципиально искали локального производителя, в идеале — из Петербурга. Не хотели терять время на транспортировке и считали ценной возможность в любой момент приехать на производство и показать пальцем, что куда надо перенести. Также близкое расположение производителя позволяло тестировать готовое изделие «с пылу с жару». Пришлось заново снимать мерки с произведенных образцов, чтобы перевести в программу для станков ЧПУ.

Крепление материнской платы на пластину решили заменить на пластмассовые RCD-12. Это немного удешевляло производство — из производственной цепочки исключался станок для впрессовывания винтового соединения. Ребра жесткости превратились из крестообразных в вертикальные — это улучшило охлаждение.

Появилось стационарное крепление для дополнительного кулера. Также мы переработали узел крепления SSD-дисков — теперь они крепились один над другим. Это позволило улучшить их охлаждение и увеличить площадь полезного места на пластине. Толщина металла выросла с 1 мм до 1,2 мм, что придало жесткость всей конструкции.

В таком виде наши серверы линейки Chipcore существуют по сей день. Но время не стоит на месте, а мы стараемся идти с ним в ногу, поэтому разработали стоечный Chipcore v2.0. Если эта статья вам понравится, то расскажем и о нем.

До новых встреч!

Комментарии (91)

lelik363

21.10.2021 16:46+3В чем смысл разработки собственного корпуса? Экономику считали?

Sem790 Автор

21.10.2021 17:32+2Ну экономику конечно считали.И по деньгам вышло немного дешевле. Да и серверов на одном стеллаже стало помещаться 72-шт, вместо 20-ти штук в стандартных корпусах.

norguhtar

22.10.2021 08:28+1А экономику с использованием промышленных корпусов? Просто мне интересно насколько дороже получается взять к примеру пустой промышленный корпус и пересадить туда БП и материнку с винтами.

1eternal

21.10.2021 17:24+6это не корпус, это поддон.

разработка слишком громко звучит для поддона по комплектуху.

знаю человека, кто разные корпуса проектирует от 2 недель.

SergeyMax

21.10.2021 18:16Четыре стеллажа с фото вполне заменяются парой блейдовых корзин C7000. В плюсах удалённый доступ к консоли, нет проблем удалённым с передёргиванием питания, и ещё внутре у неё не десктопы, а действительно серверы. В минусах наверное ценник, хотя и тут возможны варианты.

CherryPah

21.10.2021 18:33В минусах наверное ценник, хотя и тут возможны варианты.

Тут нет особого минуса в виде варианта, у них по факту самосбор вышел. При такой вводной взять семитонник с авито за условные 50к, причем вместе с БП - выглядит куда более разумной затеей

norguhtar

22.10.2021 08:36А ЗИП где для него брать будете? На авито? У нас десктопное железо использовалось из-за легкой доступности ЗИП.

CherryPah

22.10.2021 12:08+3Легкая доступность ЗИП это как? Сгорело и надо срочно поменять, бежим в ситилинк? Ну так это не ЗИП

ЗИП который должен лежать на складе - да, вполне там же на авито и находится. Ну или есть целые компании которые на бу серверах специализируются - там и выбор в наличии, и даже гарантию какую-никакую дадут.

Если не нравится самая идея БУ/рефаба - ну я бы тоже предпочел бы новый энтерпрайз, но мы обсуждаем это в контексте поста про самосбор.

PS. Пользователь 7 семитонников с авито, 5 трудятся, 2 в зипе. Из бонусов 3 последних пришли с продвинутыми лицензиями ilo и в комплекте насыпали OAшек на которых муха не сидела, с прошивкой из нулевых (видимо у предыдущего владельца тоже зипом все время владения провалялись).

PPS Понимаю что моя выборка не особо репрезентативна, но из поломок - на весь этот зоопарк >5 лет сдохла пара кулеров и один БП

norguhtar

22.10.2021 12:12Когда оно есть на складе, а как взяли со склада и тут же спокойно купили в ситилинке. И это будет дешевле и сильно прям быстрее чем искать ЗИП потом когда у всех эти БУ закончились.

Ну или есть целые компании которые на бу серверах специализируются - там и выбор в наличии, и даже гарантию какую-никакую дадут.

А это уже не особо отличается от обычного энтерпрайза. Разве что немного дешевле.

Ну и да этот вопрос и в 2008 поднимался и тогда купить что-то БУ в зип было знаете по сложнее :)

CherryPah

22.10.2021 12:53чем искать ЗИП потом когда у всех эти БУ закончились.

Линейки консьюмерского железа в ситилинке меняются тоже очень быстро. Что-то мне подсказывает что к тому моменту когда закончится БУ энтерпрайз, найти новый проц того же времени в магазине будет так же проблематично.

А это уже не особо отличается от обычного энтерпрайза. Разве что немного дешевле.

Не всегда, есть как обнаглевшие продаваны которые до сих пор рефаб пытаются продать по цене нового, да еще и по GPL-цене, как и те кто по цене авито и на авито и торгуют

Ну и да этот вопрос и в 2008 поднимался

Да понятно что у каждого своя правда =) Я по многим цодам гулял, видел какое железо у народа стоит, кто-то до сих пор в 2008 и остался. Я тут не так давно кроссировался с опсосом из большой тройки(ну вроде не бедная компания), так у них до сих пор на стыке стоит нокиевский свич 7210, вершина прогресса. Бывает в чатиках телекомовских до сих пор цисковские мангалы разыскивает (ичсх легко находит, потому что их на руках как грязи, у самого под столом стоит, с надеждой продать его хотя бы по цене металлолома)

norguhtar

22.10.2021 13:06Эээ нет. Тут не обязательно такой же. Работает РАВНОЦЕННЫЙ. В этом случае проблем нет.

Tyusha

21.10.2021 19:28В далёком прошлом знала сисадмина, который для удалённого холодного ресета "сервера" (по факту обычный ПК) установил компьютеры так, чтобы лоток дисковода компакт-дисков одного из компьютеров, выезжая, нажимал на кнопку питания "сервера". Открытие дисковода можно было вызвать удалённо.

a3or

23.10.2021 23:154 стойки по 72 десктопа = 288 декстопов, если взять даже не самое высокопроизводительное решение десктопов, то это тоже милииона на три решение. Так что не факт, что цена блэйдов будет значительно выше. Ну и цена допников, от количества PDU, стоимости времени на обслуживание и стоимости маршрутизаторов, до ценности площади помещения.

drWhy

21.10.2021 18:16+4Следующим после корпуса претендентом на сокращение является cтандартный блок питания ATX — он слишком габаритен и обычно обладает низкими КПД и ресурсом, да и вентилятор для такого применении размещён неудачно.

Дальше — замена слишком высокой и неэффективной системы охлаждения процессора, разбрасывающей горячий воздух вокруг, на пассивный серверный радиатор и организация воздушных потоков.

В общем, опять получится сервер.

Хотя если потрясти склады вендоров на предмет неактуальных остатков, то почему бы и нет.

drWhy

21.10.2021 21:35+4Впрочем, серверный блок питания необязателен. Для серии можно заказать простенький коммутатор в формате pico-PSU, который просто будет синхронизировать подачу напряжений и формировать сигнал Power Good, а блоки питания заказать мощные промышленные, на всю стойку. Получится дешевле одиночных серверных блоков питания.

Собственно pico-PSU не произвели впечатления надёжности, подходящей для серверного применения, да и мощность ограничена 180-240 Вт (но да, можно и 400 ;).

Или хардкорный вариант — трёхфазный трансформатор со вторичными обмотками на нужные напряжения, мостом из мощных силовых диодов, банком конденсаторов и без стабилизации — напряжение в сети выдерживается с точностью до +-5%, что вполне укладывается в требования стандарта ATX.

akhkmed

21.10.2021 21:49+2Для обычной электросети будет громоздко, вспомните трансформаторы телевизоров УПИМЦТ, а надо минимум вдвое больше. Но зато идеально подойдут трансформаторы 400 Гц, они компактные и недорогие, и их пока что ещё можно купить с хранения.

norguhtar

22.10.2021 08:26+2Как бы тут какой момент. Я такое делал еще аж в 2008 году пруф https://habr.com/ru/post/41819/

Там собственно схема удешевления была простая. Берем и покупаем промышленные корпуса, далее ищем отдельно радиаторы и десктопное железо и вуаля ценник становится сильно ниже.

Ну и кстати да можно покупать 2U корпуса под ATX блоки питания. Так я делал когда переводил всю серверную с башен на юниты. Это кстати давало одновременно и лучше плотность (в стойке освобождалось просто дохрена места), так и температурные режимы (коридор становился более правильно организованным).

Ну и тут у меня возникает вопрос. Насколько дешевле эти поддоны. И как эти поддоны ставятся в стойки. Не вижу описания.

Showvars

22.10.2021 11:19А что делать с охлаждением десктопного железа в 2U корпусе? Сам интересовался такими изощрениями и даже собрал себе два сервера на mini-ITX Celeron и AMD Ryzen. У всех десктопных материнок одна проблема, разъемы оперативной памяти перекрывают поток воздуха идущий со штатных вентиляторов, установленных на передней панели. Пробовал ставить на ЦПУ низкопрофильный кулер — процессор задыхается даже без нагрузки с закрытой крышкой. Я даже купил за невообразимые деньги "самолетный" кулер под нужный сокет, но в итоге получился вот такой прикол:

Фото

norguhtar

22.10.2021 11:28+2Ничего на самом деле, надо просто купить вот радиатор как на фото и развернуть его по потоку и снять вентиляторы. Обычно встроенных в переднюю стенку вентиляторов хватает чтобы охладить систему и планки не особо то и мешают.

Showvars

22.10.2021 13:08К сожалению, кулер не разворачивается, поскольку направление конструктивно привязано к расположению сокета. Не уверен, возможно ли это на других сокетах, но на AM4 только так. Знаю, что есть более «серверные» материнские платы, в которых и сокет повернут как надо, и память стоит вдоль потоку, но такие решения уже не входят в категорию cheap.

regint

26.10.2021 09:50Разве нет возможности бекплейт для процессорного радиатора снизу открутить, повернуть на 90 и закрепить снова его?

Showvars

26.10.2021 10:19Нет, к сожалению, бэкплейт у сокета AM4 имеет прямоугольную форму. Думаю теперь или найти серверную материнскую плату, или переехать на более "профессиональную" платформу.

norguhtar

22.10.2021 11:29+1Если надо подвести поток воздуха именно к радиатору на CPU 3D принтер в помощь. Моделируете воздуховод от вентилятора на радиатор. Такое даже в серверных корпусах встречалось.

CherryPah

22.10.2021 13:22Воздуховоды. Они собственно и в настоящих "серверных решениях" используются

isden

23.10.2021 09:46А я просто поставил на проц AIO водянку и вынес радиатор вбок. И горячая рязань на mini-itx вполне себе хорошо себя ощущает. Плюс AIO тут в том, что не надо заморачиваться всеми заморочками классической водянки, просто прицепил и работает.

antiBILLotic

21.10.2021 18:23А какова "целевая аудитория" клиентов? "Люди, которым нужен выделенный физический сервер под небольшие нагрузки"?

Из личного опыта - начиная работать в 2007 году в компании на ~50 сотрудников на таком "сервере" крутился небольшой пул сайтов компании (и крутился давно). После исчерпания ресурсов сего старичка всё переехало на 2U от IBM, но это было лет 10 назад... Неужели сейчас, в эпоху VDS, такое всё ещё актуально?

SergeyMax

21.10.2021 18:29+3Неужели сейчас, в эпоху VDS

А вы думаете, VDS где размещается?

myc

21.10.2021 22:51+2VDS стремно на таком железе размещать. Когда из-за перегрева начнут тормозить все VDS-ки, обиженные клиенты побегут в поддержку. К тому же виртуалки дешевле крутить в достаточно плотных железках. Если гнаться за дешевизной, то проще у китайцев купить б/у платформы предыдущих поколений. Выходит бюджетно, но с плюшками серверных платформ: нормальным охлаждением, ipmi и пр.

WondeRu

21.10.2021 18:56+2Почему прототипирование не делали на дереве или толстом картоне на самом первом этапе? Можно было бы избежать проблем с короткими проводами и тп. Прототип партией в 100 штук - это перебор

fortyseven

21.10.2021 20:04Читайте внимательнее, проблема с проводами вылезла при сборке с конкретными моделями бп и мат плат, о которых не могло быть известно на старте

lelik363

21.10.2021 21:31+3проблема с проводами вылезла при сборке с конкретными моделями бп и мат плат

Такие вещи обычно обдумываются при проектировании. Разве нет?

endoftime

22.10.2021 18:12Автор явно не мог проектировать под материнские платы описания которых не существовало, как и блоков питания. Задача же за дешего... Что купил закупочный с тем и работают...

Tyusha

21.10.2021 19:17+1В стародавние времена мне один спец по железу рассказывал случай. Приносят комп: не работает. Разобрали, посмотрели, включили — всё ок. Собрали корпус, включили — не работает. Опять вывернули комп — работает. Собрали — не работает.

Проблема оказалось в том, что жёсткий диск резонировал с корпусом из плохонького железа, и это вызывало перманентную парковку винта из-за вибрации.

scruff

21.10.2021 19:20Вот так вот арендуешь средненький выделенный сервер, а в итоге оказывается что всё собрано на полудесктопе. А уж на чём VDS-ки могут крутиться - одному провайдеру известно.

fortyseven

21.10.2021 20:02+8Мы ничего не скрываем, модель процессора, память и диски всегда указываются.

n_bogdanov

22.10.2021 00:56+3Так в начале статьи же сказано, что такое городилось под линейку chipcore. Это самые бюджетные "сервера", на десктопном железе. Для тех, кто хочет петпроект разместить дешево, но в нормальном цоде, чтобы сетка и питание были бы неплохими.

bod

21.10.2021 22:44+1Так вот на каких железках, много лет крутились мои проекты! И между прочим, ни одного сбоя. Забавно.

LeshaRB

21.10.2021 23:15-1А зачем сразу 100 заказывать? Если можно одну, все проверить и потом уже 100...

gedd

22.10.2021 06:54+3с теплоотводом в плате (это даже не корпус) такого исполнения просто беда, наверно вам стоит почитать что про движение потоков в корпусах, особенно серверных корпусах

в любом случае считаю что у вас все плохо, даже очень плохо ....

ramiil

22.10.2021 07:06+5

Похвастаюсь своими "художествами". Это ранняя версия - сейчас сменил охлаждение процессора(турбинка от какой-то видеокарты), перепаял конденсаторы и изолировал провода, ведущие к ним, добавил жесткий диск(крепление пришлось делать из планки от pci-платы. Для чего? Just for fun. Корпус, если что, заводской.

tlv

22.10.2021 17:56+1Лишенный корпуса ATX блок питания выглядит небезопасно, а банки на удлиненных неизолированный выводах так и тянут влезть туда пальцем. (кстати, а почему банки на 200В? Должны же быть на 400)

Опять же, ваше фото доказывает, что включался он не со строго надетой крышкой корпуса.

ramiil

26.10.2021 11:18Включается и работает он и с крышкой и без, провода к конденсаторам перепаял на изолированные и прикрыл места пайки термоусадкой, между платой и корпусом проложен изолирующий материал, плюс к плате приклеены ножки. Банки какие были на плате, такие и поставил, я их не менял, просто вынес, потому-что по высоте не влезали.

Areso

22.10.2021 23:59"Блок питания" и ввод выглядят очень опасно. Вижу тупо голые контакты на внутренней стороне ввода, или ошибаюсь?

lelik363

23.10.2021 10:06А еще на оголённых контактах 220V.

ramiil

26.10.2021 12:18Голые контакты тоже изолировал. Сейчас проблема не в электробезопасности, а в перегреве блока питания - очень уж в корпусе тесно. По другим моментам - смотрите комментарий выше. Это фото сбыло сделано очень сильно в процессе сборки.

meeshanya

22.10.2021 10:07+3Прослезился от иллюстрации чертежа "проектировщика-фрилансера" оформившего конструкторский документ по СПДС, присвоив ему шифр от раздела проекта архитектурных решений в строительстве)

uburame

22.10.2021 11:15+3А можно фото как оно в стеллажах размещается? Вертикально или горизонтально? Как отделяются потоки воздуха между холодным и горячим коридором? Как задаётся отступ от соседнего сервера?

Tarakanator

22.10.2021 11:40Вспомнил корпус Antec Skeleton

А в розницу не думали продавать? я б такой купил если:

1)была бы возможность крепления к стене.

2)была нужна в смене корпуса.

Назначение:

разместить пк на стене, чтобы не мешался.

водяное охлаждение

удобный доступ к железу.

Раньше я от подобного отказался из-за шума HDD, но сейчас всё переходит на SSD

dinarv

23.10.2021 16:31-1Почему бы не перейти на 12в блоки питания серверные и picoPSU?

Бу блоки стоят копейки при мощности 1-3кВт. Один такой блок сможет дюжину-другую ваших серверов питать, занимая при этом месте как пара обычных АТХ БП.

lelik363

23.10.2021 16:46Поломка одного источника приведет к остановке нескольких серверов. Обычно делают наоборот — несколько источников на один сервер — для надежности.

dinarv

23.10.2021 16:54Да, все так.

Но:

Надёжность серверных блоков все же выше в силу более высоких стандартов качества

Их так же можно зарезервировать - ничего не мешает включить параллельно 2 блока. Модуль синхронизации блоков (из того же сервера, что и б/у БП) переключит нагрузку.

drWhy

23.10.2021 19:321. КПД ~ 96% — вынужденно используется правильная схемотехника и качественные компоненты без копеечной на них экономии для максимального уплотнения и минимизации тепловыделения (для сравнения у обычных настольных БП КПД от 80%, т.е. пятая часть мощности уходит нагрев).

2. Блоки питания с поддержкой горячей замены поддерживают резервирование из коробки, но можно и проще — параллелить обычные БП с помощью дополнительных прямо включённых диодов.

И да, мощные блоки питания б/у стоят копейки при недостижимом для недорогих новых БП качестве.

Oxyd

24.10.2021 08:44+3По моему скромному мнению, штампованный лист железа очень смело называть корпусом.

NotebookKiller

25.10.2021 09:06+1На самом деле не только наши так кроят. Вон, хетцнеры так же https://www.youtube.com/watch?v=5eo8nz_niiM

Правда постепенно приходят к своим серверным платформам...

Magnum72

25.10.2021 14:30Что-то мне кажется, что с экономикой раскроя у вас беда. Не очень понятно, но мне кажется что вы отрезаете две трети переднего края и остаток загибаете, так же и с опорной подножкой.

dndzph

Я бы на вашем месте это не показывал... Для DIV подделки поставить дома в шкаф - супер, но для предоставления услуг клиентам - это не катит + постройка всего этого на обычном потребительском железе...

hellamps

цена...

panvartan

если вам нужна стойка, то няшный энтерпрайз пойдет, если вам нужно 100 стоек, то он избыточен во всем. Посмотрите на сервера фейсбук

ToSHiC

А что фейсбук? У них серверные стойки формата OCP, с шиной питания 48В и пулом блоков питания на стойку. Вот тут можно почитать спеку: https://www.opencompute.org/documents/open-rack-specification-v21 .

Уж всяко не консьюмерские материнки на поддонах.

aol-nnov

гугл начинал на обычном потребительском железе и выглядело гораздо страшнее (поищите) )))

lelik363

А к чему в итоге Google пришел? Так и остался на консьюмерском железе?

aol-nnov

К сожалению, у меня нет этой информации.

Вот есть вики (там же фотка гугла из нулевых) https://en.wikipedia.org/wiki/Google_data_centers#Original_hardware

mogaika

WVitek

У гугла сейчас такие размеры и количество оборудования, что под свои нужды "железо" разрабатывают сами.

lelik363

Понятно, что разрабатывает. Вопрос был в том, как оно выглядит?

drWhy

Лет пятнадцать назад встречал информацию, что основное железо — обычные десктопы, а данные размазаны по всем локальным дискам.

Позже Google предлагала заинтересованным организациям свой поисковик в виде отдельного сервера.

Впечатляет размах и оригинальность подходов, с которым компания использует доступное и создаёт своё оборудование и ПО для обработки существующего и накопления нового контента и добывания знаний.

datacentrexml

От вашего комментария мне стало настолько неприятно, что я даже зарегистрировался за 10 лет ридонли.

Нет ничего страшного в том чтобы хостить что-то на подобном железе, особенно в современном мире. Георспределенный кластер на подобных десктопах которые стоят в сараях будет надежнее любого количества брендовых серверов в одном хорошем датаценте, а стоить при этом будет дешевле.

Дешевле это не единственный аргумент, например десктопные i9k/i7K для некоторых задач подходят гораздо лучше чем серверные из-за большей производительности ядра. Пример такой задачи - игровой сервер (arma3,rust,mc etc) там не нужна супер надежность, а произодительность важна как никогда. Если нет возможности разместить его у себя, подобные хостинги это отличный вариант.

Печально, что у Selectel нет ECC памяти хотя intel i3 и ryzen её поддерживают. Но с приходом ddr5 эта проблема решится автоматически и повсеместно.

В том как выглядит "серверная" на картинках из поста тоже нет ничего страшного, но на месте авторов я бы обратил внимание на опыт OVH. Ovh тоже использует кастомные поддоны для плат, но размещены они горизонтально и, вероятно, плотнее чем блейды благодаря жидкостному охлаждению которое они разрабатывали самостоятельно с 2003 года. Опыт ovh многократно описан в интернете.

https://f990335bdbb4aebc3131-b23f11c2c6da826ceb51b46551bfafdc.ssl.cf2.rackcdn.com/images/ad0c01dfd7ace3c18b592b086ccf5d9d8bb8d1b3.pdf

https://www.youtube.com/watch?v=wrrZxmfevoE

lelik363

На чем основано утверждение?

norguhtar

вы в курсе что такое катастрофоустойчивые решения?

lelik363

Я в курсе… но речь идет о конструктивном исполнении и производительности оборудования, которое можно разместить на квадратном метре, а не о архитектуре ЦОД.

norguhtar

Ну тогда уточняйте. А то тут много площадок vs одна площадка. А одна площадка какая бы хорошей не была может умереть :)

Nordicx86

а виртуалки в AWS еще дешевле и без изобретения велосипеда и поездок по разным площадкам....

и вопросы:

на чем вы собрались собирать этот ваш гео распределенный кластер на Десктопах?

что вы будете делать когда вам в таком кластере будут нужные не десять машинок, а хотя бы 200 и я про виртуалки а не про физ. хосты?

А что будете делать когда вы начнете, а это будет уже на 10-12 VM на хост, упираться в лимиты "бытовых" процов по памяти, и дисковых подсистем....

Сети - о, это жесть особенно если вы используете D-link итп

norguhtar

А что такого? Если у вас критичный к деньгам сервис, платите другие деньги за другое SLA и будет другое оборудование.

Причем у вас всегда есть два пути

Дешевое оборудование и организация отказоустойчивости за счет ПО

Дорогое надежное оборудование и организация отказоустойчивости за счет него

Какой выбрать это зависит от задач.

MrRitm

Ну так никто и не скрывал никогда, что есть Chipcore - бытовое железо и низкая цена и Selectel - enterprise с соответствующими ценами. А далее уже выбирайте по задачам и бюджету. Или Вас смущает пластина с неприкрытым порно для Бэндера? Ну а как ещё можно бытовое железо разместить компактно, обеспечить быстрый доступ к любому узлу любой машины и хорошее охлаждение?