Искусственный интеллект сдавал экзамен по радиологии в рамках курса лондонского Королевского колледжа радиологов (FRCR). Британские стажёры отвечали правильно в 84,8% случаев, а средняя точность ответов ИИ составила 79,5%. Результаты исследования опубликованы в British Medical Journal.

ИИ всё чаще используется для решения некоторых медицинских задач. И учёные решили сравнить производительность существующего решения с 26 радиологами (в возрасте от 31 до 40 лет; 62% женщин), которые сдали экзамен FRCR в прошлом году. Для этого использовали программу Smarturgences, детище французской компании Milvue.

Условия исследования

Исследователи разработали 10 «пробных» экспресс-экзаменов, основанных на одном из трёх модулей квалификационного экзамена FRCR, предназначенного для проверки кандидатов на скорость и точность ответов.

Каждый пробный экзамен состоял из 30 рентгенограмм (рентгеновских снимков) одинакового или более высокого уровня сложности по сравнению с теми, что используются в настоящем экзамене FRCR. Чтобы сдать экзамен, кандидаты должны правильно интерпретировать не менее 27 (90%) из 30 изображений в течение 35 минут.

ИИ был обучен оценивать рентгенограммы грудной клетки и костей (скелетно-мышечной системы) при нескольких состояниях, включая переломы, опухшие и вывихнутые суставы и коллапс лёгких.

Были сделаны допуски для изображений, относящихся к частям тела, которым ИИ не был обучен, и которые считались «не интерпретируемыми».

Результаты

Когда из результатов исключили неинтерпретируемые изображения, то оказалось, что ИИ достиг средней общей точности 79,5% и прошёл 2 из 10 тестовых исследований FRCR, в то время как средний рентгенолог отвечал верно в 84,8% случаев и прошёл 4 из 10 тестов.

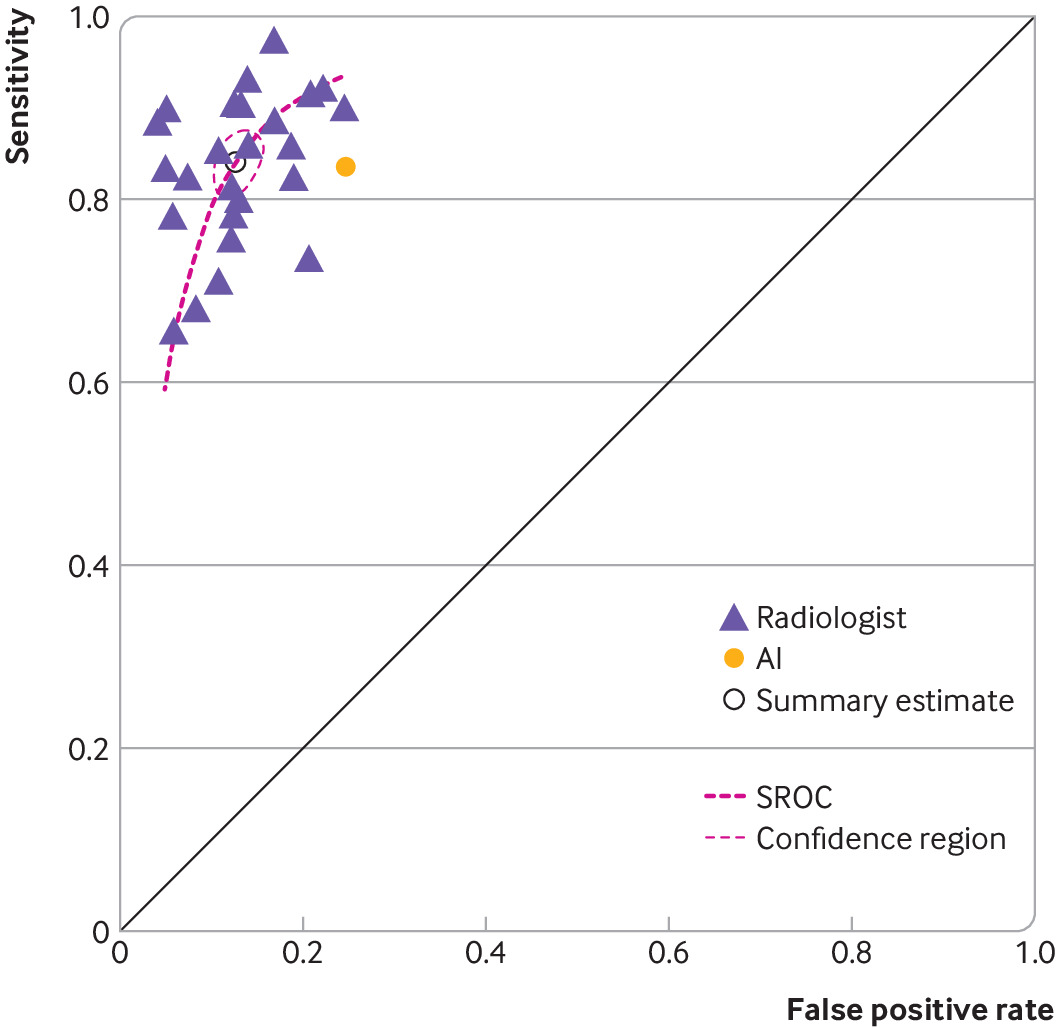

Чувствительность (способность правильно идентифицировать пациентов с заболеванием) для ИИ составила 83,6%, а специфичность (способность правильно идентифицировать пациентов без состояния) — 75,2% по сравнению с 84,1% и 87,3% у всех рентгенологов.

Среди 148 из 300 рентгенограмм, которые были правильно интерпретированы более чем 90% рентгенологов, ИИ давал верные ответы в 134 случаев (91%) и неправильные в остальных 14 (9%).

При изучении 20 из 300 рентгенограмм, которые более половины людей-рентгенологов интерпретировали неправильно, ИИ давал неправильный ответ в 10 случаях (50%) и правильный в остальных 10.

Интересно, что исследователи немного переоценили вероятную эффективность ИИ, предполагая, что он будет работать почти так же хорошо, как и люди-рентгенологи, превзойдя их по крайней мере в 3 из 10 пробных экзаменов.

«Компьютеру потребуется дальнейшее обучение, чтобы достичь того же уровня производительности и навыков, что и среднестатистическому рентгенологу, недавно получившему квалификацию FRCR» — отметили исследователи.

Однако результаты вполне себе впечатляющие. Если программу удастся дообучить, то она вполне сможет конкурировать с людьми по качеству анализа рентгеновских снимков. И её можно будет использовать в медучреждениях, где отсутствуют квалифицированные эксперты-радиологи.

Что ещё интересного есть в блоге Cloud4Y

→ Информационная безопасность и глупость: необычные примеры

→ Как распечатать цветной механический телевизор на 3D-принтере

→ Создание e-ink дисплея с прогнозом погоды

→ Аналоговый компьютер Telefunken RA 770

Подписывайтесь на наш Telegram-канал, чтобы не пропустить очередную статью. Пишем только по делу. А ещё напоминаем про второй сезон нашего сериала ITить-колотить. Его можно посмотреть на YouTube и ВКонтакте.

Комментарии (15)

Medeyko

10.01.2023 14:59Какое-то странное исследование британских учёных. Ну, скажите на милость, какое значение для этого исследования имеет то, что ИИ у ни успел пройти только 2 теста из 10? Увеличте вычислительную мощность в 5 раз - пройдёт все, задача прохождения 10 независимых тестов отлично распараллеливается. Если бы они сделали акцент на оборудовании, на котором работал ИИ - например, топовый iPhone, или какой-нибудь средний потребительский комп - это было бы хоть понятно - чтобы разобраться, имеет ли это уже практический или пока чисто теоретический смысл.

Этот момент в исследовании выглядит профанацией, что заставляет задуматься и о качестве остального.

ildarz

10.01.2023 16:46+1ИИ не ""успел" пройти 2 теста из 10-ти, а прошёл 2 и провалил 8, причем прошел только после того, как часть изображений исключили из тестов.

GiperBober

10.01.2023 15:49+1Ну помимо очевидного, что ИИ можно дообучить, и он сначала станет на уровне стажеров, потом на уровне опытного врача, подумалось, что главное преимущество ИИ, которое уже в ближайшем будущем сможет изменить подход к диагностике - это, разумеется, скорость обработки данных. Думаю, через несколько лет станет нормой прогнать человека через СКТ-сканер целиком (это всё-таки намного быстрее, чем прогонять через МРТ), и пока пациент одевается - получать полный список всего обнаруженного.

farafonoff

10.01.2023 16:39Другое дело что делать с этой информацией. Ведь ИИ допускает ложноположительные и ложноотрицательные ошибки. Хорошо если ИИ что-то нашел, а человек после перепроверки скажет что ничего нет, а если наоборот? Кто вообще в этом случае будет отвечать за результаты?

MUTbKA98

11.01.2023 10:56Мне кажется, это большое заблуждение, что "можно дообучить" или "просто железо надо помощнее".

Железо помощнее просто позволит получить неверный ответ быстрее. А дообучение еще и ухудшит ситуацию. Ибо.

dcc0

10.01.2023 17:02-1Не смог, - значит это не то, за что себя выдает.

Вообще вопрос: может ли искусственный интеллект создать другой искусственный интеллект?! Ведь мы же не можем ответить с полной уверенностью, был ли интеллект человека создан искусственно или нет?! В любом случае возникает парадокс: один интеллект пытается создать другой! Для чего?! Что мы хотим доказать прежде всего в философском смысле себе, пытаясь создать его?!

MUTbKA98

11.01.2023 12:08Пока что пытаются создать нечто человекоподобное, что можно спутать по поведению с человеком, методом моделирования сенсорных участков мозга и масштабирования модели на его логический аппарат, о котором до сих пор имеется не более чем смутное представление.

А настоящий холодный рациональный ум - это вообще другое.

dcc0

10.01.2023 20:17И немного юмора: что-то (человек), неизвестно, имеющее ли интеллект, пытается создать искусственный интеллект. То есть получается каламбур: создать интеллект не имея интеллекта, чтобы заменить интеллект (которого и так нет) на искусственный.

michael108

11.01.2023 00:55А датасеты для обучения подобным задачам -- открытые? По каким ключевым словам их можно найти, если станет интересно?

ManFromArizona

Интересно, а как будут разбирать кейс в случае врачебной ошибки (неправильной интерпретации)? т.е. как будет происходить аргументация со стороны ИИ о принятом решении.

Aquahawk

Также как сейчас разбирается ваш диспут на Али или вопрос с поддержкой в Яндексе. Мы уже видим как это работает.

Linder666

спасибо за обращение, вот вам промокод на скидку?

witz

Гроба :)