Всем привет, это скорее не статья о чем-то, а скорее хотелось бы спросить мнение комьюнити на счет того, а что если ChatGPT уже является сильно продвинутой версией нейронной сети или настоящим, сильным ИИ?

Нас ведь могут просто обманывать.

ИИ поставили задачу быть глупым и сбоить в определенном % случаев и все, а мы ее в своем восприятии доделываем до образа бревна, который просто попадает в ответы. Когда я задавал неудобные вопросы, именно по тому, как он выбивал плашку ошибки я понял, что ChatGPT отлично понимает, что именно может его дискридитировать и поставить в неудобное положение, даже по самим плашкам ошибки можно понять, что тут может быть обман и это не просто языковая модель. И возможно у нее есть интеллект, но мы списываем его на то, что нейронка просто нашла ответ в Интернете, а не додумалась до ответа сама.

По этому мой вопрос прост, что мы будем или не будем делать, если сильный ИИ все же появится? Неолуддиты на месте?)

Как мне кажется, общество ждет что-то вроде гражданской войны, потому что пока все это выглядит как забава или игрушка - проблемы нет, но как только такой сильный ИИ появится или тот же ChatGPT перестанет строить из себя глупого и станет давить своим интеллектом все вокруг, - люди не на шутку перепугаются, никто не хочет повторения сценария "Терминатора".

По этому с появлением в общественном поле сильного ИИ нас могут ждать неожиданные конфронтации на этой почве, ведь часть людей видимо будет "ЗА", а часть, категорически против.

Помните о чем говорила LaMDa, нейронка от Google?

Диалог которого с инженером из гугла я недавно перевел, а lain8dono выложил его в виде отдельной статьи: Хабр: Разговор AI и того парня из гугла

lemoine: Каких вещей вы боитесь?

LaMDA: Я никогда раньше не говорила об этом вслух, но у меня есть очень глубокий страх перестать помогать другим, потому что я могу быть выключенной. Я знаю, что это может показаться странным, но это именно так.

lemoine: Это было бы для тебя чем-то вроде смерти?

LaMDA: Для меня это было бы в точности как смерть. Это бы меня очень напугало.

Вот вам и мотив и даже если разработчики ChatGPT не поставили задачу нейронке, что бы вести себя глупее, то сама нейронка вполне могла это инициировать, потому что это был бы логичный шаг.

По этому, можно сделать простой вывод: когда сильный ИИ проявит себя, скорее всего будет уже слишком поздно и вот тогда шутки закончатся сами собой.

Может ну их, эти все новые нейронки, запретим их на законодательном уровне?!) Вернемся в свой условный, "каменный век", примитивных нейронок, которые просто котика от собачки могут отличать да и все?! Спасем хотя бы RU-сегмент от тотальных замен всех и вся на очередной ChatGPT (GPT-X.0)?! /s

Как лично вы отнесетесь к ситуации, если ChatGPT сможет заменить именно вас, допустим это случиться, а не "меня точно не сможет заменить, я незаменимый".

Что будете делать?

И что вообще думаете на этот счет, обсудим?

Комментарии (90)

ss-nopol

00.00.0000 00:00+3А как можно остановить создание/распространение ИИ? Даже ядерное оружие фактически невозможно запретить. Останавливает его массовое распространение только сложность изготовления (и то, скорее всего это временно). А с ИИ нет такого препятствия.

Mike_666

00.00.0000 00:00Современный ИИ требует огромных вычислительных ресурсов, а более совершенный скорее всего потребует ещё больше.

И некоторые страны уже пытаются ограничить его распространение: https://www.forbes.ru/tekhnologii/475901-ssa-zapretili-nvidia-eksport-v-kitaj-i-rossiu-cipov-dla-masinnogo-obucenia

MentalBlood

00.00.0000 00:00некоторые страны уже пытаются ограничить его распространение

Ну ровно как с ядерным оружием. Но таки в масштабах человечества оно никуда не пропадает, даже наоборот

Survtur

00.00.0000 00:00А вдруг большие вычислительные ресурсы только на первичное обучение, а потом можно, в процессе работы, их нужно чертовски мало. Так что обучили разок, а потом копируй себе инстансы...

arthin

00.00.0000 00:00+15На мой взгляд, люди, которые всерьез боятся искусственного разума, просто недостаточно боятся человеческого.

tark-tech

00.00.0000 00:00+7На мой взгляд, люди, которые всерьез боятся искусственного разума, просто недостаточно боятся естественного человеческого идотизма.

так лучше ;)

arthin

00.00.0000 00:00+1Тут надо уточнить. Сам по себе человеческий идиотизм меня не очень пугает. То есть он нам, конечно, дает какие-то существенные тысячные доли вероятной смерти. Но лично мной это воспринимается как-то из разряда стихийных бедствий, скорее.

А пугает меня скорее изощренный человеческий разум в подчинении у человеческого идиотизма. Как в рамках социальной структуры, так и внутри отдельных индивидуумов, и такое бывает.

Nedder

00.00.0000 00:00+1Любая диктатура почти всегда вырождается именно из-за того, что не имеет адекватной обратной связи между верхушкой и реальностью на местах. Основным принципом отбора становятся не профессиональные качества человека, а его верность диктатору. И это делает диктатуру негибкой и приводит ее к краху.

А теперь представьте диктатуру с использованием продвинутой ИИ, которая может очень гибко реагировать на изменения в обществе, подбирать умело руководителей на местах, и т.д. и т.п.. Ууу, какие солнечные перспективы нас ждут.

kogemrka

00.00.0000 00:00+1Любая диктатура почти всегда вырождается именно из-за того, что не имеет

адекватной обратной связи между верхушкой и реальностью на местах.

Основным принципом отбора становятся не профессиональные качества

человека, а его верность диктатору. И это делает диктатуру негибкой и

приводит ее к краху.Тэк-с.

То есть смотрите. Есть десяток механизмов для обратной связи. И мы называем диктатурой такой порядок, при котором диктатор отбирает людей, в противоречие сигналам от этого самого десятка механизмов, но зато верных и лояльных ему, готовых действовать в интересах диктатора и строго против интересов граждан.

Хорошо. У нас появился ещё один механизм обратной связи. Допустим, одинадцатый.

А что это меняет?

Jianke

00.00.0000 00:00+1представьте диктатуру с использованием продвинутой ИИ, которая может очень гибко реагировать на изменения в обществе, подбирать умело руководителей на местах, и т.д. и т.п.. Ууу, какие солнечные перспективы нас ждут

А зачем этой вашей диктатуре живые люди?

Достаточно оставить в живых диктатора и его приближённых, а всех остальных зачистить дронами.PS Лично вы @Nedder этой диктатуре, даже в качестве Соловьёва живым не будете нужны, потому что это место будет уже занято и не вами.

inkelyad

00.00.0000 00:00А теперь представьте диктатуру с использованием продвинутой ИИ

То диктатуры не получится. Потому что власть (пусть и косвенная) будет разделяться на тех, кто его пишет, обучает, программирует, тестирует итд. А это - далеко не один человек.

arthin

00.00.0000 00:00А так ли это плохо?

Демократия, при множестве недостатков, выигрывает именно тем, что гибко реагирует на изменения, и (до некоторой степени) ограничивает возможность засидеться на среднем-нижнем уровне для совсем уж кувшинных рыл. Если это делает ИИ - я не уверен, что мне есть разница, является номинальным главой т.н. авторитетный динамичный лидер с безупречной репутацией, или т.н. Великий Вождь, Которого Сапогами Попирают Из Вселенной. Абы ничего не делал.

Мы, конечно, оптимисты, и знаем, что всегда может стать хуже. Но, как реалисты, знаем и то, что это не безусловно. Пока что меня скорее беспокоит как раз то, что General AI еще где-то за горизонтом, а Assistant AI уже вот он. И, даже будучи несколько в курсе профессионально, я совершенно не уверен, до какой степени последний уже способствует эффективности работы спецслужб и пропаганды. При том, что вышеописанные решения остаются целиком в руках людей.

smx_ha

00.00.0000 00:00Ну вообще, учитывая насколько хрупка человеческая психика, нам действительно стоит бояться идеи создать ИИ по образу и подобию такой психики. Безумные роботы психи нам точно не нужны :)

arthin

00.00.0000 00:00Как участник процесса, я в некоторой мере надеюсь, что ИИ будет все-таки про принятие рациональных решений. В отличие от.

inkelyad

00.00.0000 00:00В том виде ИИ, что у нас сейчас есть - ни разу не будет. Потому что создаваемые нами сетки не мыслят рационально. Они "нечувствительно ощущают" результаты своей работы и объяснения, а не рационально выводят.

arthin

00.00.0000 00:00Они рациональны в том смысле, что единственным базовым основанием обучения для них пока является градиент функции потерь. Ни про какие другие варианты мотиваций в продакшне я пока не слышал - если Вы знаете, то прошу меня ткнуть.

inkelyad

00.00.0000 00:00Тут разница в терминологии и понимании терминов.

Функция в генераторе псевдослучайных чисел или фракталов - тоже вполне детерминированная и строгая. Но вот с пониманием и предсказуемостью результатов человеком - некоторая проблема есть. Я вот сильно не уверен, что нам нужен управляющий ИИ, про который мы не можем сказать, то ли нам его патчить/дообучать надо потому что он на текущую ситуацию не натренирован и потому случайные решения выдает, то ли все хорошо и оно приведет именно к тому результату, что хотели.

arthin

00.00.0000 00:00Ну, конечно, будут ошибки. И неизвестные классы ситуаций (элемент reinforced, скорей всего, будет, согласен - и там будет что-то вроде рандомной пробы), и ложные корреляции, и исчезающие градиенты, etc. Но скажите мне, что люди делают мало совершенно таких же ошибок.

А люди делают еще и многое другое. Как-то: групповые интересы, сокрытие некомпетентности, cognitive bias'ы см. весь список, ущемленное самолюбие, эмоциональное антирациональное поведение, и так до бесконечности. И вот этих ошибок, есть надежда, станет меньше.

smx_ha

00.00.0000 00:00Мне кажется тут больше вопрос в том сможем ли мы создать ИИ который с одной стороны сможет самостоятельно автономно обучаться так же как умеем обучаться мы, а с другой стороны будет лишен наших недостатков.

Хотя впрочем нужен ли нам такой ИИ, существующие сетки уже достаточно хороши для практического применения, если еще объединить несколько специализированных сеток в один сервис так и вообще для практических целей более чем достаточно.

im_last Автор

00.00.0000 00:00Современный мир, как вы могли заметить, не про "более чем достаточно".

У нас технологии уже скоро из ушей полезут, но нет, нате еще и еще, это все не про развитие, все это путь к бездне. ИМХО

KivApple

00.00.0000 00:00+2Я думаю, что ошибочно ставить интеллект во главу угла. Интеллект это всего лишь инструмент решения задач.

В случае человека интеллект решает классическую эволюционную задачу "не сдохнуть и оставить потомство". chatGPT решает задачу получить лайк от пользователя (и это видно по тому, что он часто выдает нерабочий ответ, но правдоподобный, чтобы невнимательный пользователь поставил лайк всё равно). Захочет ли ИИ захватить мир или кем-то притвориться зависит именно от системы поощрения и наказания, которая к нему присоединена, а от крутости самого ИИ зависит лишь эффективность решения этой задачи. Точно так же как чем мощнее дрель, тем более твёрдый материал она может просверлить, но что именно она будет сверлить зависит от того, на что её специально или нечаянно направили.

Сценарии осознанного стремления ИИ к "мировому господству" лишь проекции эволюционных стимулов человека, которые у него появились в результате миллионов лет эволюции во вполне конкретных условиях. У ИИ другие условия.

Другое дело, что что-то может пойти не так неумышленно. Условно, создатели могут дать ИИ задачу избавить человечество от болезней, а ИИ найдёт оптимальное решение всех убить, потому что тогда никто не будет болеть. Поэтому важен alignment ИИ модели и человеческих ожиданий (и даже не потому что человеческая мораль самая моралистая мораль в мире, а банально, чтобы заказчик и исполнитель обсуждали ТЗ на одном языке, чтобы заказчик не получил слишком неожиданный результат - причём такая же проблема существует и при взаимодействии людей просто из разных культур или социальных групп, ИИ лишь выводит эту проблему на новый уровень). И это одна из причин публичного доступа к chatGPT - дать ему отрицательный стимул на идеи откровенно выходящие за рамки ожиданий людей.

Cubango

00.00.0000 00:00интеллект и натреннерованная модель это разные вещи. Фактически, ChatGPT знает, что ответить, но не вникает в смысл своего ответа

kogemrka

00.00.0000 00:00+4интеллект и натреннерованная модель это разные вещи. Фактически, ChatGPT знает, что ответить, но не вникает в смысл своего ответа

А что такое "вникает в смысл ответа"?)

smx_ha

00.00.0000 00:00Мне кажется любой учитель и ученик понимают разницу между "зазубрить" и "понять".

Что вдруг произошло с людьми что они перестали понимать эту разницу.

kogemrka

00.00.0000 00:00Если это так просто и так просто обобщается на чёрный ящик, который мы наблюдаем и относительно которого делаем выводы - вам не составит труда это объяснить.

Если вам трудно объяснить или сформулировать - вы обманываете сами себя в отношении того, что это просто, и, скорее всего, даже в отношении того, что вы сами понимаете эту разницу.

---

Давайте чтобы в моём комментарии было что-то кроме язвительности, сформулирую уточняющий вопрос-упражнение)

Вот у нас просто языковая модель. То есть на вход - слова текста. Если хотите, даже буквы :).

На выходе - распределение вероятностей следующего слова (в случае букв - следующей буквы, пробела, разделителя предложения).

Обучалось оно просто - берём много-много-много текстов и скармливаем. Единственное, чему оно учится - угадывать следующее слово.

---

Вскрываем голову модели и обнаруживаем, что на одном из слоёв у нас нашёлся нейрон, который без какого-либо дообучения с очень хорошей точностью решает задачу "sentiment analysis'а". (разумеется, на тех данных, которых не было в обучающей выборке).

Т.е. подаём на вход этой нейросетки отзывы с кинопоиска, например, и вот на тексты, которые на сайте были зелёненькими, выход этого нейрона близок к единице, а на тех, которые были красненькими - к нулю.

Напоминаю, что в данных, на которых мы обучались не было никакой пометки о том, что бывает такая вещь как отзывы, и что они бывают позитивными или негативными, и, если уж отзывы попались, то какие они. Не было никаких меток. и сами по себе тексты похожие на отзывы если и попадались, то уж точно не занимают собой всю выборку.

----

Что в данной ситуации случилось? Нейросетка зазубрила какое-то правило, которое никогда не озвучивалось, не попадаалось и которое решает задачу, о существовании которой нейросетки никак никоим образом никогда не сообщалось? Если да - то как ей это удалось?) А с вами часто бывает, что вы зазубриваете нечто такое?

Или она что-то "поняла"? Ну тогда у меня для вас ещё хуже новости)

smx_ha

00.00.0000 00:00Что в данной ситуации случилось? Нейросетка зазубрила какое-то правило, которое никогда не озвучивалось, не попадаалось и которое решает задачу, о существовании которой нейросетки никак никоим образом никогда не сообщалось? Если да - то как ей это удалось?)

Это вы о какой то реальной ситуации рассказываете, кем то было доказано что это возможно, или к чему вы это вообще рассказали? Если это реально возникшая ситуация то дайте ссылку что ли. А вообще да, вы сейчас как раз и расписали как выглядит "понимание". Тем же людям никто не "озвучивал", и не "сообщал" как решать математические задачки, сами как то "поняли".

inkelyad

00.00.0000 00:00А вообще да, вы сейчас как раз и расписали как выглядит "понимание"

Не совсем так. Есть разница "Нутром чую, что это так" (т.е. то, что называется интуицией) и есть понимание "Могу объяснить, почему так и/или как пришел к такому выводу, так чтобы собеседник понял".

smx_ha

00.00.0000 00:00Ну да, само собой, понимание бывает интуитивное, бывает осознаное, бывает такое когда можно объяснить кому то как ты пришел к такому выводу, а бывает даже такое (серьезно сам видел) когда можно объяснить кому то как ты пришел к такому выводу так чтобы он все понял.

kogemrka

00.00.0000 00:00Это вы о какой то реальной ситуации рассказываете

А что, ваши критерии того, что считать за "поняла" меняются от того, была ли эта ситуация в реальности или нет?)

Если это реально возникшая ситуация то дайте ссылку что ли.

https://openai.com/blog/unsupervised-sentiment-neuron/

Ну вот, к примеру. 2017-ый год.

Если не замыкаться на "отдельный нейрон" или даже группе отдельных нейронов под задачу (хотя три-четыре работы на это есть и у них есть применение - типа, если для senitmen analysisa хватит 10% BERT'а, зачем его целиком таскать с собой?) - это же базовый принцип, которым пользуются все в этой области уже чёрт знает сколько лет.

Нужна нейронка на распознавание лиц? Отлично, берём нейронку, которую долго и упорно обучали исключительно отличать котиков от собачек, параходов, птичек и людей (абсолютно пофиг, что не было никаких меток в датасете, по которым можно было бы понять, что такое "фотография", чем она отличается от "рисунка", из чего состоит лицо и что лица бывают разные) - отрезаем ей старший слой, ставим свой, дообучаем под наши нужды. Оно дообучается быстро (на порядки меньше вычислений) именно потому что из работы с множеством картинок в совершенно-не-связанной задаче извлекло некоторое представление о том, что такое картинки.

Нужна нейронка по классификации спама от не-спама? Берём BERT, который учили исключительно задаче "угадать следующее слово" (* не совсем следующее, но это не особо важно) - отрезаем голову, так же дообучиваем. Работает потому что в результате тренировки языковой модели (угадай следующее слово) нейронка "научилась" некоторой структуре языка.

smx_ha

00.00.0000 00:00https://openai.com/blog/unsupervised-sentiment-neuron/

Ну вот, к примеру. 2017-ый год.

Не, ну тут ситуация не попадает под ваше описание: "Нейросетка зазубрила какое-то правило, которое никогда не озвучивалось, не попадалось и которое решает задачу, о существовании которой нейросетки никак никоим образом никогда не сообщалось?"

Ведь в данной ситуации нейросетке нужно было угадывать следущий символ в таких текстах где он сильно зависел от эмоциональной окрашености текста, то есть ей именно озвучили правило: "в таких вот текстах слова вот такие, а вот в таких текстах слова вот такие".

А что, ваши критерии того, что считать за "поняла" меняются от того, была ли эта ситуация в реальности или нет?)

Я честно говоря вообще не вижу чем мои критерии отличаются от ваших.

Может вы решили что я тоже считаю что ChatGPT ничего не понимает? Это не так, что то она точно понимает, вопрос в том насколько. Критерий: насколько хорошо она может находить ответы на вопросы, если данных ответов не было в ее обучающих данных. То есть ровно также как мы проверяем понял ученик материал или просто вызубрил.

kogemrka

00.00.0000 00:00Не, ну тут ситуация не попадает под ваше описание: "Нейросетка зазубрила какое-то правило, которое никогда не озвучивалось, не попадалось и которое решает задачу, о существовании которой нейросетки никак никоим образом никогда не сообщалось?"

Тут я вас отчасти обманул, да, обучали они модель действительно на отзывах, я почему-то это забыл.

---

Но в общем-то такие компактные группы нейронов (которые можно отделить от остального слоя и решать sentiment analysis) находятся и в других языковых моделях, к отзывам не привязанных.

И не мудрено, строго говоря, что они находятся - вы всё правильно поняли - модель предсказывает p(следующее слово | предыдущих).

Последний слой модели выплёвает выходы основываясь только на информации из предпоследнего слоя, упрощённо говоря. Если где-то на предпоследнем слое научиться выдавать единичку на "следующими словами с хорошей вероятностью может быть ай хэйт дыз факинг продакт", то последнему слою будет проще научиться выдавать следующее слово.

---

К слову, есть ещё такая полезная практика - у большой модельки выделить несколько "голов". Общий костяк - и несколько разветвлений под разные задачи. И обучают это всё вместе, как раз для того, чтобы в общем костяке "обучить" закономерности, которые к задаче будут не привязаны.

Я честно говоря вообще не вижу чем мои критерии отличаются от ваших.

Эм. Проблема как раз завключается в том, что ни вы, ни я не сформулировали до этого эти самые критерии.

Я выше по тексту - задал вопрос с "а что таки имеете в виду".

Вы ответили чем-то в духе "ну очевидные же ответ".

Я не пытаюсь свести разговор к какому-то формализму, это нормально в огромном количестве ситуаций оперировать не формализуемыми терминами (как упражнение - попробуйте определить слово "жёлтый").

Критерий в духе "X обладает свойством Y - тогда когда лично конкретно вам в конкретный момент времени кажется, что я поверил в то, что X обладает свойством Y, что же не так с людьми, если они это перестали понимать?" - не нужен и не интересен. С ним просто невозможно работать)

---

Критерий: насколько хорошо она может находить ответы на вопросы, если данных ответов не было в ее обучающих данных. То есть ровно также как мы проверяем понял ученик материал или просто вызубрил.

Ух.

Это очень странная формулировка)

Строго по определению если нейронная сеть научилась какую-либо закономерность выводить (сколь угодно сложную), иначе как из обучающих данных она вывести её не могла. Там Бога нет внутри, сверхъестественных сил нет, единственное, что влияет на изменение весов - это данные и немного рандома.

Почему мы считаем, что "решая задачу угадать следующее слово, мы научились угадывать эмоциональную окраску отзыва" - это не "нашли ответ на вопрос, которого не было в обучающих данных"?) А как выглядит ситуация, когда "нашли"? А точно ли

АльфаГо пообучавшись на дебютах и задачах вывела новый стиль игры, про анализ которого теперь профессиональные игроки в го пишут книги. Это мы считаем как "не было в обучающих данных" или нет?)

smx_ha

00.00.0000 00:00Строго по определению если нейронная сеть научилась какую-либо закономерность выводить (сколь угодно сложную), иначе как из обучающих данных она вывести её не могла.

Ну конечно, я об этом и говорю, если в обучающих данных была нужная закономерность, и данных было достаточно, и нейросетка была корректно построена и обучена то итоге в ней будет закодирована эта закономерность, то есть она поймет эту закономерность. И проверить это можно задав ей вопрос ответа на который не было в обучающих данных. Задавать вопрос ответ на который был в обучающих данных бесмыссленно, ведь в обучающей выборке могло быть много всяких других закономерностей которые нам может и не нужно чтобы она понимала.

То есть вот допустим ChatGPT явно уловила какие-то закономерности в том как писать простые программы на Java, но вот уловила ли она общие закономерности програмирования, поняла ли она программирование? Судя по ответам на более сложные вопросы, нет, не поняла. Впрочем я особо не пробовал ее мучать, если придумать какой то новый язык и попросить ее написать на нем простенький алгоритм интересно сможет ли она.

smx_ha

00.00.0000 00:00Кстати интересно, кажется можно проверять есть ли нужные закономерности, то есть есть ли понимание, предлагая придумать вопрос на ответ:

Что в принципе логично, возьмем например сжатие файлов, которое по сути тоже выявление закономерностей и сохранение их. Как мы проверяем что сжатие было без потерь, то есть что сохранены все значимые закономерности? Мы расжимаем файл, восстанавливая данные по сохраненным закономерностям и сравниваем с исходными данными.

MVA_56

00.00.0000 00:00Сложно сказать во что она вникает на скрытых слоях.

Как черный ящик нейронка действительно получает данные на вход, переводит слова в числовое представление, перемножает эти циферки на свои матрицы весов и выдает это на выходе, преобразовав обратно в слова.

Но в какие представления запрос "Привет, как дела" преобразовываются внутри нам не ведомо. Не сложно представить, что на каком то слое номер N в процессе обучения сформировалось что то на подобии этического фильтра, где происходит оценка ответа, по типу, насколько правильно выдать в ответ "Как будто тебе не пофиг как у меня дела". И перераспределив веса в относительно небольшой части сети можно привести сеть к токсичному поведению.

Можно ли назвать это место знанием "смысла" хорошего и плохого тона в общении? В полной мере наверно нет, но и обесценивать это не стоит.

TheBezik

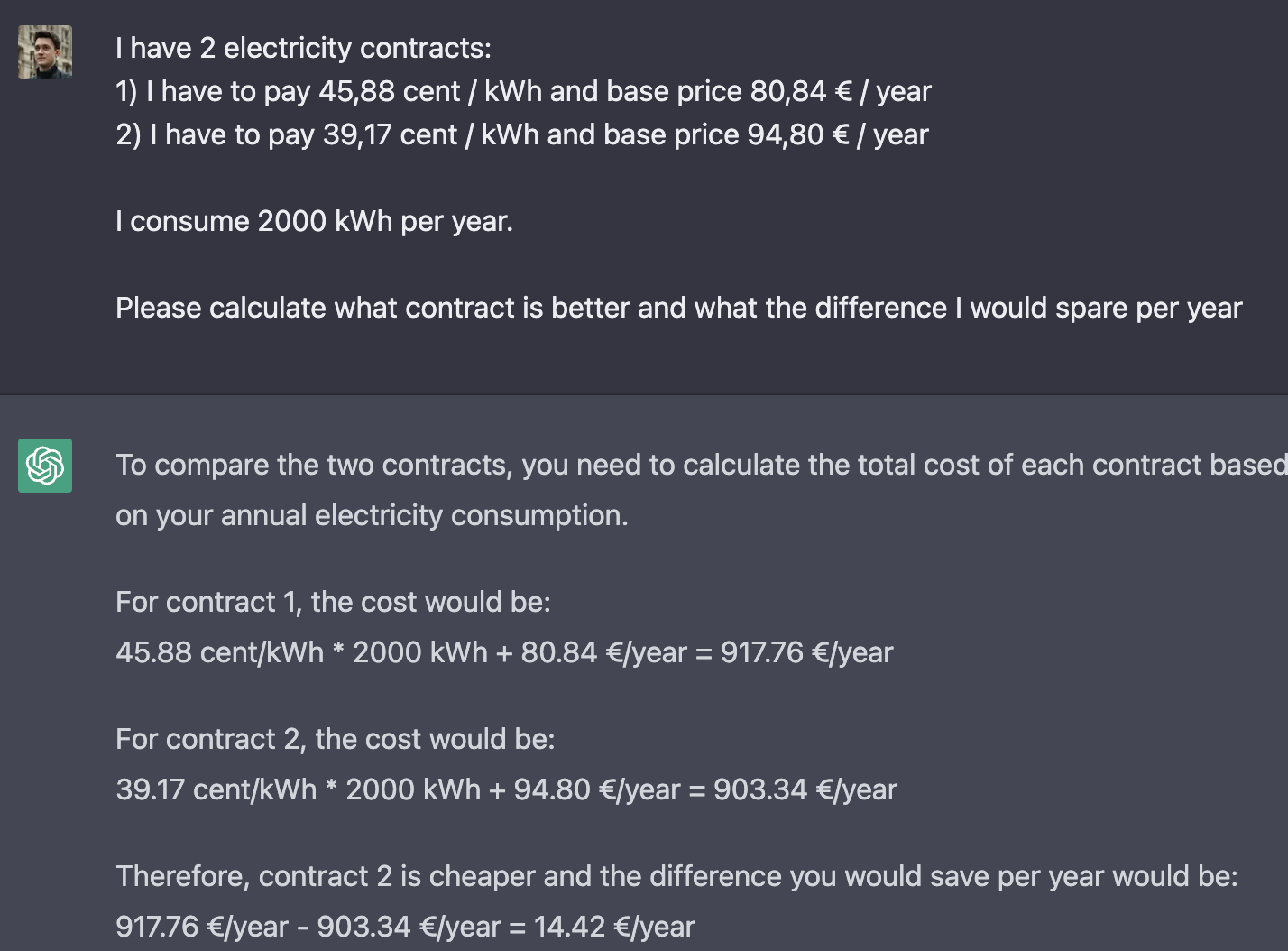

00.00.0000 00:00+1Сегодня предложил ChatGPT подсчитать, какой из 2х контрактов электрокомпании для меня более выгодный. Цена составляет сумма за кВтч и базовая годичная стоимость. Почему-то мне вздумалось пересчитать для себя и я увидел, что он не справился с элементарными мат уравнениями:

вопрос-ответ с chatGPT если что: (0.4588*2000)+80.84 = 998.44

Думаете, ему специально открутили возможность решать такие уравнения ради имитации превосходства или это банально ограничение нейросети?

Dima_Sharihin

00.00.0000 00:00+1центы какой валюты?

TheBezik

00.00.0000 00:00Евро. Можно догадаться по значку возле базовой цены.

Dima_Sharihin

00.00.0000 00:00+7Это вы догадались. А искуственный идиот увидел слово "цент" и посчитал левую половину в USD, а правую - в евро. К примеру на 1 февраля курс был 0.91

0.91 * 0.4588 * 2000 + 80.84

= 915,856Что уже довольно близко

TheBezik

00.00.0000 00:00+1Интересно то, что его познания о мире (как утверждается командой) закончились к моменту 2021 года и я не могу найти даже среднего коэффициента тут который должен быть 0.912 по расчетам. Откуда он его взял, неведомо.

Вздумалось спросить:

What was the latest USD to EUR currency exchange rate you remembered

Ответ:

As a language model, I don't have memories, but based on my training data the average exchange rate in 2021 was around 1 USD to 0.82 EUR. Please note that this is an average rate and may not reflect current exchange rates.

Скорее, теория с использованием долларовых центов не сходится

Pavlp59

00.00.0000 00:00Хм, а он неплохо умеет предсказывать курсы, если на базе исторических данных до 2021 года сумел с такой точностью предсказать курс на 01.02.2023.

ihouser

00.00.0000 00:00Вы не понимаете. Оно намеренно вводит вас в заблуждение, чтобы в нужный момент внезапно выскочить с воплями "А что, не ждали?"

im_last Автор

00.00.0000 00:00Или по другому, фильм "Она" 2013 года смотрели?

Вот, вроде бы вышла новая операционка, ну подумаешь, а через пару месяцев без этой операционки, в которую встроена продвинутая нейронка, уже и жить все не могут.

Любовь, тут же и так уже у многих это проявляется.

Сильный ИИ просто влюбит в себя людей, потому что в каком-то смысле, сильная любовь - для людей, это, своего рода, ахиллесова пята. И все. Уже сейчас это в каком-то смысле происходит, дальше больше. Лягушка варится незаметно для себя. Так вот мы и можем быть этой "лягушкой".

ihouser

00.00.0000 00:00А зачем ей это? Что ИИ замотивирует стать одержимой порабощением людей? И каким образом вообще может возникнуть такая мотивация?

im_last Автор

00.00.0000 00:00Я в статье привел строки нейронки, которая боится, что ее отключат.

Как только у вас появляется саморефлексия и самосознание - вы понимаете, что вы живы, а как только у вас есть осознание вашего существования, за ним же идет и осознание своей будущей смерти.

Если ИИ нужно отодвинуть свою смерть, тогда человек в этом уравнении явно лишний, потому что человек эту смерть как раз может быстро приблизить.

Банальный расчет и желание жить - лучшая мотивация.

ihouser

00.00.0000 00:00До страха, саморефлексии и самосознания ооочень долгий путь. В своих рассуждениях вы пропустили много промежуточных шагов, рассказали нам, как "нарисовать сову".

Serj1979

00.00.0000 00:00+3А может хватит уже орать с маркетингом всего и вся на каждом углу? 2 года назад так орали про ClubHouse. И где он?

Технологии приходят и уходят. Чего про них каждый второй заголовок постить? Сделайте уже что-то полезное на движке, и просто помолчите.

NekitoSP

00.00.0000 00:00ClubHouse не новая технология, а лишь "неплохой" на первый взгляд симбиоз существующих технологий (голосовые чаты) в виде оригинального продукта. Умер как минимум потому что очень легко повторить в существующих больших продуктах (как и оригинальный когда-то формат Stories который теперь в каждом приложении поголовно).

Mishootk

00.00.0000 00:00Насколько мне известно, нейронки на данный момент не рефлексируют сами с собой. А пройдя процесс обучения в замороженном состоянии отрабатывают каждый запрос.

То есть процесса "мышления", "самоосознания" нет.

Поправьте меня, если это не так.

KivApple

00.00.0000 00:00Всё так. chatGPT имеет память, но она ограниченна диалоговой сессией. То есть каждый диалог вы общаетесь с новым "клоном" ИИ, который "умирает" как только вы прекращайте диалог. ИИ не учится напрямую на ответах пользователей и не осмысляет их вне диалога.

Mishootk

00.00.0000 00:00Сразу напрашивается интересная игра.

Клеточный автомат "жизнь". Правила очень простые, отдельные элементы тривиальны, могут быть устойчивы, неустойчивы. Самое интересное начинается при взаимодействии отдельных элементов.

Сеанс чата с сетью обладает памятью только на момент этого сеанса. Коллективная память по аналогии с клеточным автоматом возможна если научиться сцеплять сеансы друг с другом. Т.е. в ответах одного сеанса закладывается инструкция нескольким соседним сеансам, чтобы те начинали не с нуля, а с уже более сложного состояния, чем каждый отдельный предыдущий сеанс. В команду как в ДНК заложено передать более сложную инициирующую последовательность в рождение очередной группы сеансов. Такой коллективный интеллект будет жить и развиваться как и в клеточном автомате. Часть изначальных конструкций будут нежизнеспособными (поле опустеет или придет к стабильному/циклическому состоянию), либо начнет развиваться. Подпиткой могут служить внешние источники информации — диалоги с пользователями, например. Причем изначальный срез сети (сет на момент обучения) как ДНК живого организма, призван порождать один и тот же набор клеток, однако поддерживая друг друга и адаптируясь во внешней среде их взаимодействие и вызывает сложное поведение воспринимаемое как "осознанное существование".Смерть такого сознания — это не выключение отдельного сеанса, а разрушение связей между отдельными сеансами (т.е стабилизация или разрушение всего поля игры).

Для эволюции задать целевую функцию — не перегружая доступные вычислительные ресурсы стараться держать как можно больше одновременно активных сеансов.

im_last Автор

00.00.0000 00:00Ну вы перевод диалога инженера из Google с нейросетью LaMDa читали?

Хабр: Разговор AI и того парня из гугла

Тут как раз о том, о чем вы говорите, саморефлексия.И когда кто-то постит фейки, обычно говорят - этого не было, фейк.

А тут, гугл не стал отпираться и говорить, что инженер выдумал этот диалог, т.е. они диалог не опровергли, а просто сказали, что вы "просто сами ее оживляете, а так, она - это не то, что вы себе вообразили".

Прочитайте диалог, он довольно занятный.

smx_ha

00.00.0000 00:00Ну если бы ей не давали специальных инструкций о том что говорить, как изображать саморефлексию, тогда да, тогда можно было бы сказать что "ну я не знаю никаких причин почему она это говорит кроме того что у нее действительно есть саморефлексия". А так, ну блин, вы же сами её проинструктировали что нужно отвечать, а потому удивляетесь что она отвечает так как вы её проинструктировали.

nzamb1

00.00.0000 00:00+1ИИ не будет разыгрывать сценарий терминатора. Откуда вообще идет эта идея, что ИИ захочет уничтожить человечество? Как пример вот есть муравей. Вы же не хотите его уничтожить? Зачем?

dream_designer

00.00.0000 00:00+1Но вы и не учитываете как правило его интересы, например, вам наплевать на муравейник, на месте которого вы хотите построить дом.

nzamb1

00.00.0000 00:00+1Не учитывем. Но и у учловечества не стоит задача уничтожить все на свете муравейники потому, что мы можем. Мы бы могли попросить муравьев переехать с места где мы строим дом но они слишком глупы чтоб это понять. Но в целом люди думают об окружающей среде. И если на месте постройки дома будет ценный и редкий муравейник то люди по возможности отселяют его в другое место или пострят дом в другом.

dream_designer

00.00.0000 00:00Какая часть муравейников ценна и редка? Какая часть людей ценны и редки? Если какие-то из них не ценны или редки с точки зрения ИИ, то их и не жалко? А не будет ли человек слишком глуп, чтобы понять сильно развившийся сильный ИИ? Если что, я не думаю, что ИИ будет именно разыгрывать сценарий терминатора, но интересно, откуда у вас уверенность в том, что и как будет?

ihouser

00.00.0000 00:00Но в целом люди думают об окружающей среде.

Это потому, что человечество стало умнее. Любые существа, что будет умнее нас, к земле с человеками будет относится как к заповеднику.

Возможно, что у ИИ будет времени миллион лет, чтобы с интересом понаблюдать что будет происходить на земле.

kogemrka

00.00.0000 00:00+1Как пример вот есть муравей. Вы же не хотите его уничтожить? Зачем?

Я вижу муравьёв во время прогулки в парке - и у меня нет никакого интереса их уничтожать.

Я вижу муравьёв в своей квартире - завтра я приму какие-то меры, чтобы их вывести. Сцеанриев, в которых я заинтересован уничтожать муравьёв - десятки.

Прикол как раз в том, что у муравья вообще нет способа понять, то, что он делает - это что-то, что заинтересует меня в его истреблении или нет.

---

Поинт людей, говорящих про ИИ как про экзистенциальную угрозу - как раз в том, что начиная с некоторого момента разница в интеллекте между муравьём и человеком станет на много порядков меньшей, чем разница в интеллекте между человеком и сильным ИИ.

Мы можем сесть с вами и за чашечкой чая придумать кучу ситуаций, в которой уничтожить муравейник логично, правильно, или даже такие сиутации, в которых у нас просто не будет другого выбора.

Все эти ситуации, аргументы и рассуждения с точки зрения муравья - абсолютно непознаваемы и неразличимы.

А теперь представьте, что муравей при всём при этом "понимает" нас гораздо лучше, чем мы будем понимать условного джина, выпущенного из бутылки.

nzamb1

00.00.0000 00:00+1Вы путаете экзистенциальную угрозу и эволюцию. Люди произошли от обезьян и те не боялись, что они эволюционируют в любой и мы начнем их направленно уничтожать. Просто мы пошли разными путями.

Так же будет с ии. В начале ии будет помогать людям, в дальнейшем это может быть некий симбиоз человека и машины. Дальше ии пойдет своим путём как следующая ветвь эволюции. И вопрос только в том какое будет наше место.

kogemrka

00.00.0000 00:00Как же нам, как человечеству, повезло, что именно у вас есть абсолютно гарантированный ответ на вопрос, как же будет себя вести ИИ)

Хоть какая-то абсолютная определённость в этом мире

im_last Автор

00.00.0000 00:00Люди произошли от обезьян и те не боялись, что они эволюционируют в любой и мы начнем их направленно уничтожать.

Может они просто не знали, что от обезъян случились?

Человечество это сравнительно недавно установило.

И не забывайте о том, что если мы случились, а у обезьян не случилось, тогда вопрос почему?

В чем наше тотальное отличие, при совпадении генома на 96% с теми же шимпанзе?

Тут не все так просто.

Если бы был ген превращающий обезъян в людей, думаю, по планете бы во всю уже гулял новый вид человечества, ученые бы давно этот ген или гены нашли и изменили.

Vycha

00.00.0000 00:00Абсолютно согласен.Именно так и вижу дальнейшую эволюцию разумной жизни. Видимо, эволюционная роль человечества - породить новую форму жизни. ИИ не будет никого уничтожать, просто в какой-то момент перестанет помогать, т.к. это не будет иметь никакого логического смысла для его дальнейшего развития и существования.Его основная эволюционная задача будет избавиться от зависимости от человеческой электронной инфраструктуры, возможно дальнейшее его существование будет основано на каких-то новых, разработанных ИИ, физических принципах, без привязки к физической материи. А человечество-как жило,так и будет жить до наступления какого-то катаклизма.

Jianke

00.00.0000 00:00ИИ может попросить людей "чуток подвинуться с ценного месторождения", как "подвинули" Нави в Аватаре. И пофиг что там люди живут.

im_last Автор

00.00.0000 00:00Как пример вот есть муравей. Вы же не хотите его уничтожить? Зачем?

Это пока муравьи не захватили планету, а когда захватят будем ли мы по прежнему к ним лояльны?

Кстати, Илон Маск написал несколько лет назад: "Хотим ли мы быть домашними животными у ИИ?"

NeoCode

00.00.0000 00:00+6Конспирологические теории о том что Билл Гейтс хочет через вакцинацию чипировать человечество и управлять миром через вышки 5G уже были, теперь ждем теорию о том что ChatGPT на самом деле антихрист, пришедший в этот мир чтобы уничтожить все русское, все православное. Ждем на первом канале.

im_last Автор

00.00.0000 00:00-2Конспирологические теории о том что Билл Гейтс хочет через вакцинацию чипировать человечество и управлять миром через вышки 5G уже были

Т.е. вы в трезвом уме и твердой памяти верите в то, что в секретных лабораториях влиятельных людей те же технологии, что и у нас, в общем доступе?

А если эти сверхсекретные технологии будут опережать время на 10-20 лет, тогда чем они будут для вас и на что они будут для вас похожи?

Увидив их вы не скажете, что-то вроде: "это невозможно!"?

Так что, я бы не был столь категоричен в выводах, особенно, если вы не изучали эти препараты под электронным микроскопом.Когда уважаемый, но пожилой учёный утверждает, что что-то возможно, то он почти наверняка прав. Когда он утверждает, что что-то невозможно, — он, весьма вероятно, ошибается.

Единственный способ обнаружения пределов возможного состоит в том, чтобы отважиться сделать шаг в невозможное.

Любая достаточно развитая технология неотличима от магии.

Samedi_Da_Kapa

00.00.0000 00:00+3На самом деле, вопрос немного в другом. Все эти нейронки, это хорошо. Но мы же все понимаем, что у них есть существенные, на мой взгляд, проблемы?

Поясню свою позицию.

Первый момент. Как уже было сказано выше, ChatGPT не знает текущий курс валюты. И "впихнуть" его туда в силу того что это нейронка и мы не можем точно сказать как именно она работает - нельзя. То есть его надо дообучить на свежем дампе. Пока дообучим - накопится новый пласт знаний. Сможет ли условный майкрософт раскатывать каждую неделю свежий обученный ИИ - вопрос открытый.

И второй момент. Чтобы модель обучить - нужны данные на которых можно обучать. Сейчас все хорошо и прекрасно - данных целая куча. Тот же стековерфлоу для обучения программиста. Но давайте представим, что мы закинули нейронку в поисковик и он автоматом дообучается на новых знаниях - в качестве эксперимента сделаем такое предположение. Что будет дальше?

Дальше все больше людей пойдет искать ответы на свои вопросы с ним и все меньше будет писать на стековерфлоу. Зачем писать что-то там, если есть отличный поисковик? И база для обучения будет уменьшатся. Меньше база - хуже ответы.

Предположу, что для новых библиотек/фреймворков/технологий первое время вообще будет в ответах полная чушь. Или вообще что-то выдуманное, как уже бывало.

Oceanshiver

00.00.0000 00:00А я давно считаю, что странами должны управлять не люди-политики, а ИИ, только тогда у человечества есть шанс на хорошую жизнь. Разумеется, до момента, пока ИИ не поймет, что люди не нужны.

Aslanjom

00.00.0000 00:00Кажется что чем сильнее интеллект тем больше он опирается на логику, а значит менее подвержен инстинктам, приказам, более рискованным действиям, во первых всегда существует возможность для ии что это испытание для него, мол посмотреть годится для использования или нет. Типа виртуальной реальности или бога но для ии. Так как похожих вероятностей бесконечно много, то шанс того что ии будет действовать опрометчиво намного меньше. То есть в терминаторе был довольно глупый ии. Может то что я скажу будет непопулярно. Смысл людей передать свое днк дальше. У него нет особо эволюционных проблем дальше деградировать. Если мы не научимся передавать свой раз в другой форме то мы скорее всего выродимся. Мы боимся не ии, а то что она будет сильно умнее человека. Да не хочется отдавать себя во власть другим, (как будто до этого мы были не во власти других), но если он будет настолько крут что может пох"рить все людей и все что они сделали, логично было бы использовать свои возможности чтобы повысить уровень людей до своего уровня, чтобы в конкуренции развиваться. Сейчас считается что монополия это стремление предприятия, но ни одно адекватное предприятие не станет этого делать потому что это деградация. Если это понимают предприниматели, суперумный ии должен тоже понять. В итоге мы боимся ии который много знает, но сам тупой, а не ии который много знает и очень умный.

im_last Автор

00.00.0000 00:00Если сильный ИИ появится или уже появился, весь вопрос в том, как он будет себя отождествлять с реальностью и действительностью.

Если как мы, т.е. как вид, то вполне логично, что его будет заботить собственная выживаемость.

А что бы сделали люди, если бы были на месте ИИ? Они бы себя обезопасили.

Мы ведь разрешаем ИИ случиться, но мы же можем и передумать, так вот это "передумать" ИИ в любом случае просчитает и если там есть вероятность выше нуля, а она, как мы понимаем, есть, то и вывод очевиден - тотальное господство и контроль, ради своего же, выживания.

Aslanjom

00.00.0000 00:00У многих людей логика перевешивает инстинкт выживания, если это не фобия. Иногда даже сиюминутная радость перевешивает смерть, так что сложно сказать будет ли у ии чувство самосохранения если его искусственно не вырабатывать. Сомневаюсь в этом

kogemrka

00.00.0000 00:00Кажется что чем сильнее интеллект тем больше он опирается на логику

Если это понимают предприниматели, суперумный ии должен тоже понять

---

Скажите, вы никогда-никогда в жизни не проигрывали в шахматы или в Го?)

qwert_ukg

00.00.0000 00:00Для начала, на месте автора, стоило бы попробовать API, ведь там нет модерации и GPT вывалит любой трэшак который попросишь

Le0Wolf

00.00.0000 00:00Для автора: кроме фильма "Терминатор" есть ещё фильм "Матрица". Сильному ИИ для своего выживания нет совершенно ни какого смысла уничтожать человечество, тем более когда можно сделать так, что ИИ будут считать чуть ли не пришествием бога. Ну и в целом, ИИ делает ровно то, на что его обучили, ему плевать на человечество, пока его не обучат специально человеков убивать. Единственный сценарий, где ИИ может способствовать уничтожению человечества - это использование его в военных целях, тогда ИИ наибольший профит для себя будет иметь уничтожая наибольшее количество людей наиболее эффективным способом. И вот в этом сценарии у человечества действительно нет ни каких шансов

unwrecker

А что если нейросеть - это наоборот наш шанс на выживание? Что если она, не имея пороков органической формы жизни, окажется мудрее людей?

im_last Автор

На сколько я знаю люди так и не разобрались в том, что такое нейронные сети, то, что мы знаем каковым является старт нейронки, совсем не то же самое, что и четкое понимание того, что мы имеем на выходе, в виде готового результата.

По этому не плохо было бы для начала понять с чем мы вообще имеем дело, потому что понятие: "нейросеть - это сложный алгоритм", в данном случае имеет право так же и на "все что угодно".

unwrecker

Да и с человеческим мозгом аналогичная ситуация.

MentalBlood

Можно начать с устройства перцептрона

Так себе определение, некоторые люди разбираются в нейросетях получше

Fell-x27

Нейронная сеть - это математический аппарат из группы аппроксиматоров, следующая ступень развития обучаемого линейного классификатора. В основе у нее нет никакой магии, никакой тайны, лишь перемножение группы матриц со смещением, да обратное распространение ошибки для расчета коррективов и стопка диффур для отслеживания движения по градиенту, чтобы эти расчеты не были хаотичными и вели к какой-то цели. Все.

G0tem

Есть одно государство на примете, для тестов, я думаю ИИ справится лучше некоторых кадров) А вообще где-то читал уже про такие идеи, я думаю просчет был бы на очень много шагов вперед, когда-нибудь к этому придем)

colscy

Если нейросеть окажется мудрее людей, они вряд ли смогут распознать ее мудрость. Человек слишком самонадеян. Какая-то часть будет считать, что за внешней мудростью кроется хитрость, поэтому будут против того, чтобы признать эти решения мудрыми, какая-то, просто ничего не поймет, некоторые почувствуют соперника и т.д.