Привет, меня зовут Иван. В Nubes я отвечаю за направление виртуализации и поддержку облачных сервисов.

После ухода с российского рынка известных платформ виртуализации мы стали активно искать альтернативные варианты, и особый интерес у нас вызвали азиатские решения. До этого мы уже успели протестировать несколько сервисов, как отечественных, так и зарубежных, и вот нам попался совершенно новый для нашего рынка продукт — HCl от Sangfor. В этом посте рассказываем про наш опыт по установке Hyper Converged Infrastructure.

Статья несет в себе исключительно ознакомительную информацию и написана для тех, кому интересно узнать о других, не таких классических, как VMWare, KVM, Hyper-V решениях.

Архитектура решения

Архитектура Sangfor HCI состоит из двух частей: HCI и SCP.

HCI

Sangfor Hyper Converged Infrastructure основан на архитектуре гиперконвергентной инфраструктуры и имеет стандартные решения:

aSV — cерверная виртуализация. Гипервизор.

aSAN — виртуальное хранилище (условный аналог vSAN).

aNET — сетевая часть виртуализации.

aSEC — решение в рамках безопасности.

SCP

Sangfor Cloud Platform — решение для управления ресурсами на базе Sangfor HCI. Более подробно расскажем о нем в следующей статье, посвященной SCP.

Для того чтобы собрать стенд для тестирования, можно использовать два варианта:

Готовое решение с предустановленным aServer.

Third-Party Server.

Мы пошли по второму пути и использовали то, что уже было под рукой, — ThinkSystem SR650 в количестве 3 шт. с такими характеристиками:

Xeon 4216 2.10GHz x2;

128 Gb RAM;

Intel X722 на два 10 GbE порта;

1x SSD Lenovo DC S3520 Series 240 Gb под ОС;

4x Lenovo PM863a 960 Gb под данные.

Стоит учитывать то, что официальная документация рекомендует нам 6* 1 GE портов и + 2 * 10 GE, с агрегацией и другими рекомендациями, но в тесте можно обойтись и нашей конфигурацией.

Подробнее о настройках кластера и сети будет в следующей статье.

Далее в документации есть требования к конфигурации сервера.

RAID Card:

Должен поддерживаться режим сквозного доступа (JBOD, не raid).

Диск кэша и диск данных должны быть сконфигурированы в сквозном режиме.

Поддерживается RAID1 (используется сторонним сервисным системным диском).

Используйте инструмент развертывания, чтобы проверить совместимость RAID-карты и ее встроенного ПО. Оборудование, которое не соответствует требованиям, не будет разрешено добавлять в виртуальное хранилище.

ЦП:

Рекомендуется, чтобы основная частота процессора была больше 2,0 ГГц (рекомендуется использовать процессор серверного уровня).

RAM:

Объем оперативной памяти должен быть не менее 64 ГБ (мы как раз столько и используем).

Выше также ничего интересного, но далее указаны два наиболее важных пункта.

Системный диск:

В качестве системного диска рекомендуется использовать корпоративный жесткий диск. На системном диске сервера запрещено развертывать один диск RAID0.

Емкость должна быть не менее 128 Гб. Запрещается использовать SD-карту в качестве системного диска HCI. Причина, по которой его нельзя использовать, заключается в том, что у него есть проблемы с надежностью, производительностью и стабильностью.

Сторонний сервис использует два диска для создания RAID1.

Диск с данными:

Распределенное хранилище использует твердотельные накопители в качестве кэш-дисков.

В качестве диска с данными используется SATA (или SAS).

Твердотельный накопитель: чем выше соотношение емкости жесткого диска, тем выше общая производительность.

Используйте инструмент развертывания, чтобы проверить совместимость встроенного ПО SSD. Если он не соответствует требованиям, его нельзя будет добавить в виртуальное хранилище.

Мы столкнулись с ситуацией, описанной в четвертом пункте, но поддержка Sangfor, в рамках теста, смогла пометить диски как подходящие для создания виртуального хранилища. Остальные требования и рекомендации можно описать одной фразой «Используйте энтерпрайз диски, и всё будет хорошо».

Настройки хостов

Перед установкой необходимо изменить ряд настроек в BIOS'e хостов. Никаких сверхъестественных манипуляций проводить не нужно, все в рамках стандартной подготовки хоста:

Синхронизация времени BIOS — OS.

Включение режима виртуализации.

Выключение режима энергосбережения.

Автовключение при старте.

Конфигурация менеджмент интерфейса.

Каждый пункт подробно и со скриншотами описан в документации. Там есть даже табличка CPU C-state.

Установка гипервизора

Вот и подобрались к самому интересному — установке гипервизора.

Вот так выглядит первое меню установщика:

Есть опции для миграции, а также для загрузки в дебаг. Нам ничего не нужно было мигрировать, а трудностями занималась поддержка, поэтому выбрали easy-mode и просто установили гипервизор.

Если заниматься своими делами при загрузке установщика, то можно автоматически провалиться в китайскую версию и ребутаться пару раз, как я. Не повторяйте моих ошибок.

Как видно из скрина ниже, Sangfor не использует для установки гипервизора флешки.

Чисто теоретически можно использовать флешку на 128 Гб и более, но официальная документация ясно дает понять о том, что "Enterprise hard disk is recommended for system disk." Поддержка, скорее всего, напишет в стиле: «Неподдерживаемое решение. Переставьте гипервизор, учитывая рекомендации. Мы можем закрыть тикет?»

Поэтому имеем несколько вариантов установки гипервизора:

Можно собрать диски в Raid1.

Можно не собирать рейд и накатить все один диск.

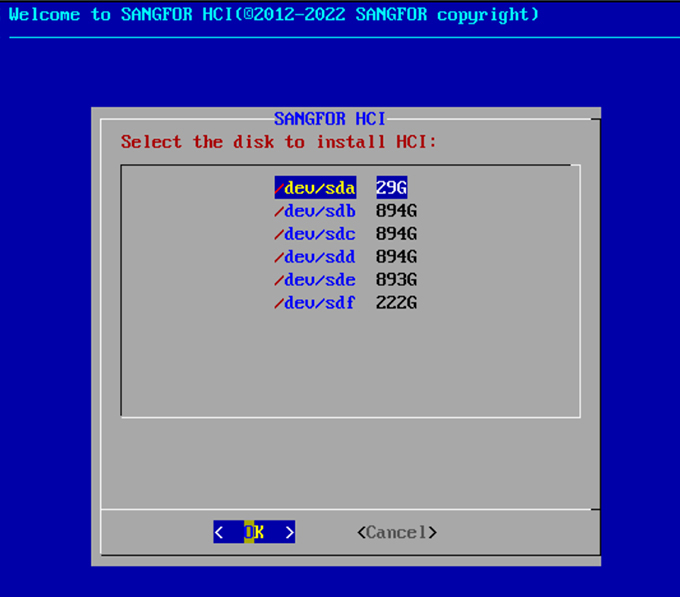

Для установки требуется 111 Гб; если подходящих дисков нет, инсталляция дальше не пойдет. Если таких дисков несколько, то установщик предложит выбрать место для софта:

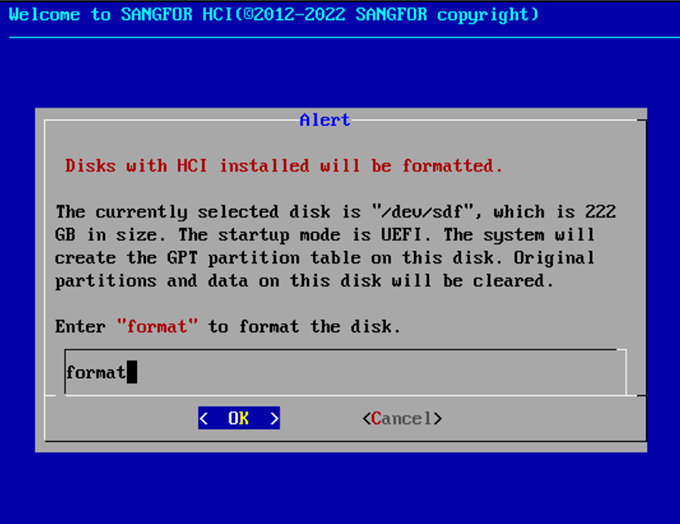

Далее появится алерт о том, какие операции будут совершены с диском:

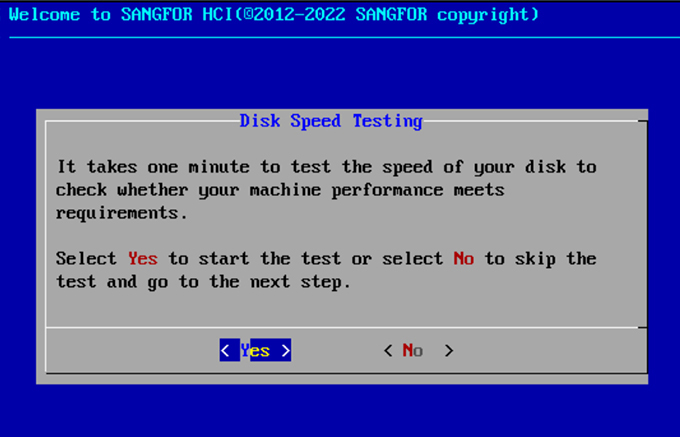

Затем установщик предложит пройти тест диска:

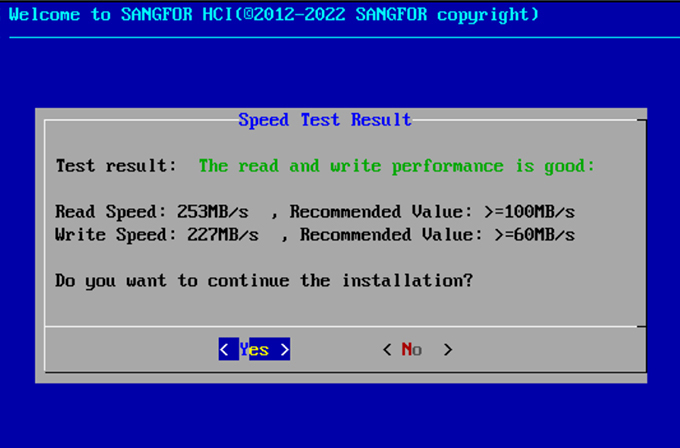

И выдаст результаты тестирования:

Точное время ожидания не скажу, но пару раз у меня возникали сомнения, а не зависло ли все.

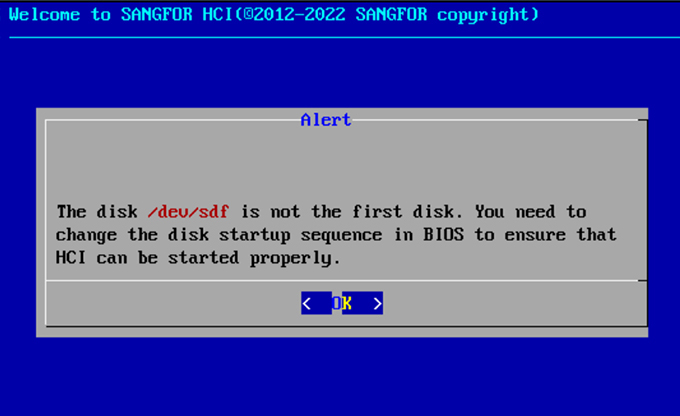

Финальное предупреждение о том, что выбранный диск не является первым смонтированным.

После чего начинается достаточно долгое ожидание при 60% установки.

Отбросив подозрения о зависшем установщике, мы проваливаемся в меню первичной настройки. Далее вас проведут по пунктам за ручку по сетевым настройкам, и....всё. На этом установка завершится, и через пару минут мы сможем увидеть вполне красивый такой GUI, расположенный точно на том адресе, который мы указали в настройках.

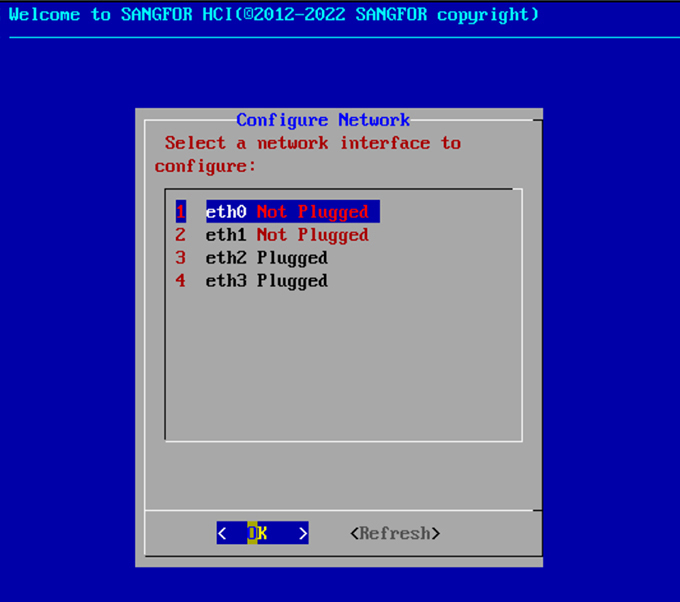

Настраиваем IP-адрес. Выбираем конфигурацию сети:

Отказываемся от настройки IP в других сетях:

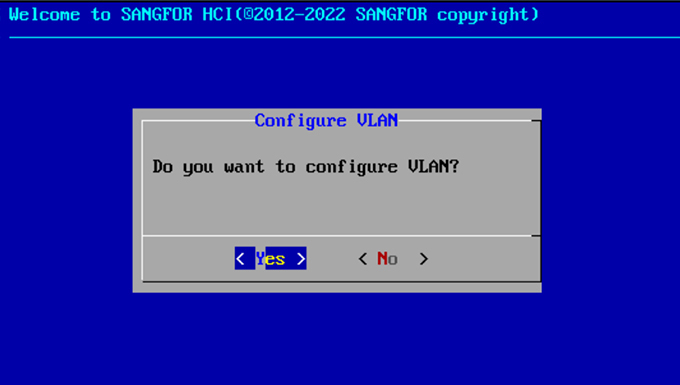

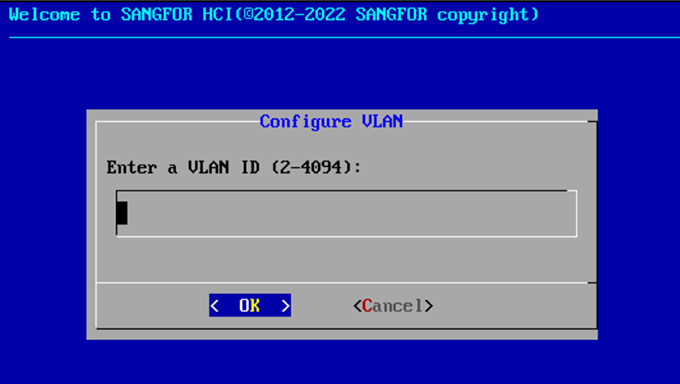

Соглашаемся произвести настройку VLAN:

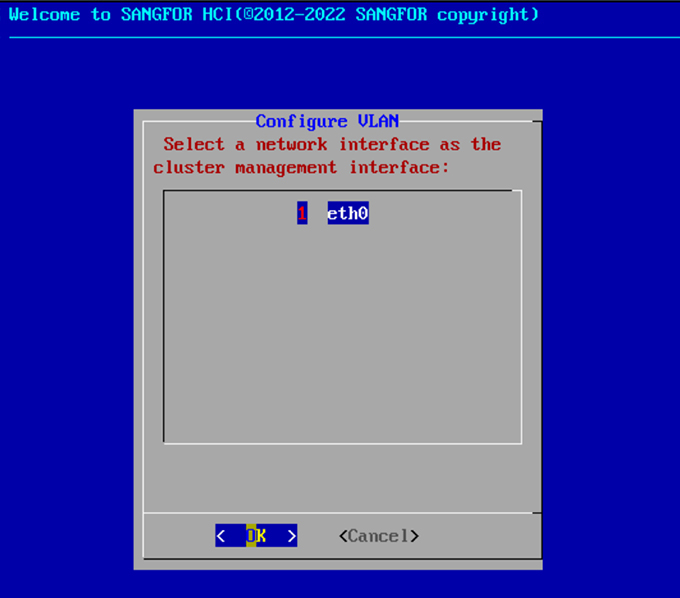

Дальнейшая настройка в интерфейсе VLAN:

Выбор интерфейса для менеджмента трафика.

Если у Вас, так же как у меня, появится возможность протестировать решение HCI от Sangfor, то советую внимательно прочитать главу 2 "Installation And Deployment", а потом уже приступать к развертыванию. Если сравнивать с той же VMware, то процесс установки не является каким-то архисложным, но имеет ряд требований и действий, которые необходимо провести до установки.

Мы пока не будем проводить системный сравнительный анализ с VMware, выводы еще делать рано.

Задавать вопросы можно в комментариях, а я пока буду писать следующие посты, в которых расскажу про настройки кластера и развертывание решения Sangfor SCP (Sangfor Cloud Platform), которое является аналогом VMware Cloud Director.

Комментарии (3)

vesper-bot

30.06.2023 18:09Мало для статьи. "Устанавливаем гипер" - хорошо, но мало. Одни грабли с "совместимостью" (небось по VID/PID либо как нутаникс по имени список проверялся) - хорошо что описали, но тоже мало. В конце концов, HCI это не один только гипер, это и настройка внутренней сети, и описание технологии, на которой сделана гиперконвергенция (грубо, у Nutanix это выделенная ВМ на каждом сервере, которая формирует кластер zookeeper для ресурсов типа ВМ и блоков от их дисков, а здесь что?), и хотя бы описание поддерживаемых источников для миграции на этот Sangfor.

eiw

30.06.2023 18:09+2В этом продукте особенно интересно понять, насколько хорошо быстродействие и стабильность стораджевой части, SDS. Как я понимаю, она реализована на GlusterFS, и тут интересно насколько у вендора получится решить врождённые проблемы производительности. Если сможете провести нагрузочные тесты будет очень интересно взглянуть на результат.

Thomas_Hanniball

А где картинки с интерфейсом самого продукта? Как он хоть внешней выглядит? Как в нём отображается только что установленный сервер?