Что должен сделать робот-медсестра, если больной раком просит увеличить дозу морфия, а связаться с врачом не получается? Должен ли робот-водитель запрещать пьяному человеку самому управлять автомобилем, когда он спешит в больницу к своему ребёнку? На чей голос должен спешить робот-спасатель в развалинах после землетрясения — на детский или взрослый? А если так получилось, что взрослый — это вы, но ребёнок не ваш?

Люди много лет мечтают о наступлении эры доступной робототехники, когда умные машины избавят нас от многих трудов. «До чего дошёл прогресс, до невиданных чудес». Но в то же время развитие роботов будет поднимать серьёзнейшие вопросы о том, как они должны вести себя в сложных ситуациях, связанных с острыми морально-этическими проблемами.

Научные исследования могут прояснить, что означает для людей понятие «разбираться в морали». На основе этих знаний мы сможем проектировать роботов хотя бы с элементарным уровнем познаний о морали, и выяснить, способны ли они успешно взаимодействовать с людьми. Первым делом мы должны понять, как люди делают моральный выбор благодаря своей уникальной способности воспринимать социальные и морально-этические нормы. Далее мы сможем изучить, в состоянии ли роботы распознавать, понимать и соблюдать эти нормы.

Технологии, с помощью которых может быть создан искусственный интеллект, устойчиво развиваются вот уже 50 лет. Но этические стороны прогресса и его возможные последствия только недавно стали привлекать всеобщее внимание. До 2004 года на Западе была издана 41 академическая статья, посвященная «робоэтике». Между 2005 и 2009 годами это число удвоилось — до 88. С 2010 по 2014 года число статей удвоилось снова — до 170 (поиска по запросам «robot*» и «ethic*» в научных базах данных EBSCOhost). Появляются конференции, на которых поднимаются вопросы роста числа этических проблем в быстро прогрессирующем роботостроении.

Необходимость норм

Социальные нормы облегчают взаимодействие с другими людьми, подсказывая модель поведения (Что я должен делать?), давая возможность предсказывать (Что должно произойти?) и обеспечивать координацию (Кто должен это делать?). Это было необходимо для родового строя кочевников, которые бродили по территориям от жгучей Африки до холодной Северной Европы. Нормы регулировали жизнь на стоянках, при совместной охоте, дележе пищи, а также во время сезонной миграции.

Качественный скачок в нравственной жизни произошел с переходом к сельскому хозяйству и общинному строю. Нормы должны были регулировать имущественные отношения (например, распределение земли), новые формы производства (инструменты для сбора урожая) и огромное число социальных ролей (от слуги до короля). Сегодня социальные нормы регулируют бесчисленное множество культурных форм поведения. Мы можем предположить, что люди знают больше социальных и морально-нравственных норм, чем они знают слов на родном языке.

Чтобы оценить необъятность нашей системы норм, можете провести небольшой эксперимент: возьмите десять случайных слов из словаря и считайте, сколько на каждое слово вы можете придумать норм. Потом обдумайте, сколько вариаций имеет каждая из этих норм множество в зависимости от ситуаций и людей, в них вовлеченных.

Люди не только знают огромное количество норм и корректируют свои действия в соответствии с ними; они также знают, когда допустимо отказаться от использования каких-либо правил. Человек легко имеет дело с контекстом изменчивости норм. Мы понимаем, что разговор может быть хорошим вариантом в одних случаях, но не в других, или что ударить другого человека допустимо только в определенных ситуациях. Кроме того, люди понимают (не обязательно осознанно), что определенные нормы применяются к данному пространству, объекту, человеку, ситуации или процессу. Правильный набор норм поведения активируется множеством сигналов, полученных от повторения аналогичных ситуаций.

Учитывая сложность человеческих норм (а еще даже не было речи о культурных вариациях), можно ли считать, что роботы в принципе способны выучить негласные правила? Прежде чем решить эту задачу, сначала ответим на вопрос: почему мы хотим учить робота разбираться в морали и этике?

Почему машины должны быть этичными?

Если (когда) роботы станут частью нашей повседневной жизни, то эти новые члены общества должны будут надлежащим образом адаптироваться, чтобы взаимодействовать с нами в сложной человеческой культуре. И если мы сами следуем нормам, не должны ли мы дать роботам такую же систему норм, то есть создать машины, разбирающиеся в морали?

Мы уже некоторое время используем машины с зачатками морали, в основном в виде защитных функций (например, когда горячий утюг автоматически выключается через определенный промежуток времени). Такие характеристики прибора нужны для предотвращения возможного вреда — а ведь это одна из главных функций морали. Конечно, роботы должны быть безопасными и определенную степень защиты. Но этого будет недостаточно, если мы хотим, чтобы роботы самостоятельно принимали решения, которые выходят за рамки запрограммированных ситуаций.

Почему роботы должны обладать возможностью решать самостоятельно? Потому что это единственный для них способ преодолеть проблему взаимодействия с людьми. В рамках сотрудничества или обучения люди не могут просто полагаться на результаты предварительного программирования, потому что поведение человека имеет слишком сложный и изменчивый характер. Люди тысячелетиями развивали способности к адаптации и творчеству, из-за чего предсказать их поведение становится намного труднее. Ответы робота на переменчивое и непредсказуемое человеческое поведение не могут быть заранее запрограммированы. Робот должен будет отслеживать реакцию человека на небольшие изменения в обстановке и гибко реагировать в ответ — такая способность требует самостоятельности в принятии решений.

Хотя поведение человека носит сложный и многообразный характер, и может показаться весьма непредсказуемым для робота, оно весьма очевидно считывается другими людьми. Почему так?

- Во-первых, мы делаем ряд основополагающих предположений об индивидах, с которыми взаимодействуем. Мы исходим из того, что другие люди имеют какие-то ментальные установки (чувства, эмоции, желания и убеждения) и ведут себя в соответствии с ними. Так как человек быстро определяет ментальные установки других, то способность прогнозировать и осмысливать поведение друг друга значительно повышается.

- Во-вторых, как уже говорилось выше, человеческое поведение чаще всего определяется социальными и моральными нормами данного общества, и знание этих норм делает людей гораздо более предсказуемыми в общении друг с другом.

Способность мысленно ставить себя на место другого, приписывать другим индивидам определенные умственные состояния и представления, понимая при этом, что они могут быть ложными и могут отличаться от наших собственных, часто называют «теорией ума».

Теперь соединим эти два элемента вместе: если бы робот разделял человеческие предположения об разуме и поведении, и мог делать верные догадки о ментальном состоянии людей, и если бы робот следовал социальным и моральным нормам, то способности ИИ предсказывать и понимать поведение человека значительно улучшились бы.

Конечно, не достаточно просто научиться предсказывать поведение человека. Но это средство достижения более важной цели: обеспечить безопасное, эффективное и удобное общение между людьми и роботами. Только когда роботы смогут понимать homo sapiens и адекватно реагировать на их поведение, люди смогут доверить машинам нянчить малышей или ухаживать за престарелыми родителями.

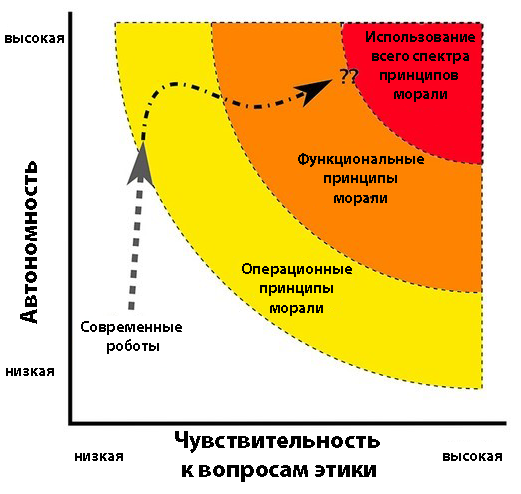

Требования социального взаимодействия вынуждают роботов быть когнитивно гибкими и адаптивными, а, следовательно, и более самостоятельными. Чтобы достигнуть такой автономии, они должны иметь систему норм и удовлетворять положениям теории ума. Не так давно компьютерная реализация теории ума оказалась в центре внимания исследователей в сфере робототехники. В последнее время возник новый вопрос: как роботы могут освоить систему норм? Чтобы ответить на него, нужно внимательнее рассмотреть людей.

Нравственное воспитание людей и роботов

Как и роботы, люди начинают жизнь с полного непонимания сложных требований общества. Младенцы и малыши постепенно изучают правила социального взаимодействия в семье, затем расширяют эти правила до ситуаций и отношений вне дома. В школьном возрасте дети осваивают большой перечень норм, но все ещё не готовы ко многим ситуациям из мира взрослых. Даже взрослые постоянно сталкиваются с новыми нормами для незнакомых задач, контекстов, ролей и отношений.

Как мы усваиваем все эти нормы? Это сложный и плохо изученный процесс, но в нём можно выделить два главных механизма. Первый проявляется на самых ранних стадиях жизни, когда младенцы обнаруживают статистические закономерности в физическом и социальном мире. Они начинают осмысливать шаблоны событий, происходящих в поведении людей, реагирующих на различные ситуации, особенно если эти шаблоны повторяются в виде ежедневных ритуалов. Получая представления о норме, дети могут затем находить нарушения в стандартных шаблонах и наблюдать реакцию людей в ответ на нарушения. Отмечая степень реагирования, они учатся отличать строгие правила (сильная реакция) от стремлений, порождающих выгоду (умеренная или отсутствующая реакция).

Но многие социальные и моральные нормы нельзя просто приобрести, отслеживая закономерности. Например, если закономерность — это отсутствие определенного поведения, или если вы никогда не попадали в ситуации, в которой применяются соответствующие нормы. Второй механизм регулирует такие случаи: обучает правилам и нормам другими способами, которые варьируются в диапазоне от демонстрации намерений до явных требований. Дети (и взрослые) усваивают правила и готовы поступать «как им говорят» из-за сильной зависимости от мнения окружающих и чувствительности к неодобрению.

Можем ли мы реализовать эти два механизма в роботах, чтобы они осваивали нормы таким же образом, как и люди? С точки зрения вычислений, поведенческие закономерности легко поддаются обработке; а вот оценка сильных реакций на нарушения нормы является более сложной проблемой. «Ум» робота должен обрабатывать не только, картинки, но и видео, содержащее реакцию на нарушение нормы. Роботы не могут годами воспитываться в семьях, как дети, так что единственным доступным вариантом остается тот, в котором мы скармливаем машинам фильмы и телепрограммы всего человечества. Робот, просматривающий видеозапись, смог бы получить большой список поведенческих шаблонов, отклонений и реакций на отклонения. Хотя в этом случае очень большую роль играет выбор правильных материалов для обучения. Очевидно, что боевики и поделки вроде «Дом 2» нельзя использовать для обучения роботов.

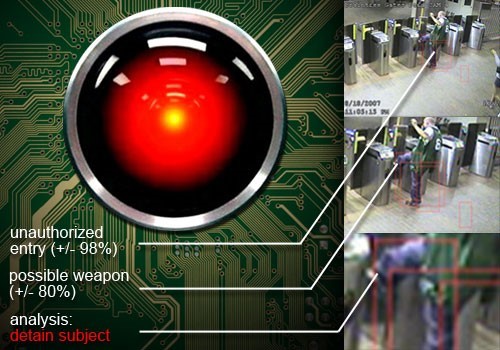

В DARPA была запущена программа «Mind’s Eye», предназначенная для развития компьютеров с «визуальным интеллектом». Агентство планирует сделать «умную» камеру наблюдения, которая не только видит то, что находится перед ней, но и в состоянии понять, что происходит в настоящий момент и даже спрогнозировать, что может произойти дальше.

Второй механизм обучения нормам, в принципе, также легко осваивается: учить робота через демонстрацию и объяснение, что можно делать, а что делать нельзя. Этот метод требует гибкости подхода при запоминании данных, ведь робот должен понимать, что наиболее явные правила относятся к ситуациям, в которых они были заявлены напрямую, и не обязательно могут проявляться в других контекстах.

Если комбинация этих подходов позволит роботу обрести представления о нормах, и в результате система норм будет связана с действиями робота, то машина будет в состоянии распознать нормативное и ненормативное поведение, а также «соблюдать» правила. Искусственный интеллект, как и человек, узнает, как вести себя в любой распознанной ситуации.

Могут ли однажды роботы стать более нравственными, чем люди?

У роботов есть огромный потенциал стать более развитыми морально, чем сами люди.

- Во-первых, роботы, в отличие от людей, не будут эгоистичны. Если мы сделаем всё правильно, то приоритетом робота станет главенство интересов человека без извлечения путно собственной выгоды. Робот может следовать собственным целям и одновременно действовать в соответствии с общественными нормами, а не устраивать конкуренцию между этими направлениями деятельности.

- Во-вторых, роботы не будут подвергаться влиянию эмоций, таких как гнев, зависть, или страх, которые систематически могут приводить к предвзятости моральных суждений и решений. Некоторые даже считают, что выверенность и логичность поступков роботов делают их превосходными солдатами, которые, в отличие от людей, не преступают нормы международного гуманитарного права.

- Наконец, роботы ближайшего будущего будут иметь конкретные роли и использоваться для решения ограниченного круга задач. Это значительно уменьшает количество норм, которые должен выучить каждый робот, и уменьшает проблему ситуационной изменчивости, с которой постоянно сталкиваются люди. Дайте роботу некоторое время поработать с пожилыми людьми, и он будет знать, как вести себя в домах для престарелых; при этом робот может иметь смутные представления о том, как действовать в детском саду, но это от него и не потребуется.

Вероятность того, что роботы будут выполнять ограниченные обязанности, помогает решить ещё один вопрос: какие нормы поведения должен знать робот? Ответ — те, которые должен изучить ребенок: правила данного сообщества. Если роботы должны быть активными участниками конкретных социальных сообществ, то они будут спроектированы и обучены в рамках норм своего же сообщества.

Например, робототехник AJung Moon, кандидат наук в области машиностроения из Университета Британской Колумбии, разрабатывает методы для определения норм в различных группах с разной системой ценностей. Её исследования демонстрируют уровень сложности решения даже таких простых вещей, как реакция робота, несущего посылку, на людей при входе в лифт. В конечном счете, было обнаружено, что нет никаких жестких правил. Робот должен, как и люди, оценить контекст ситуации и использовать любой доступный ему способ взаимодействия. С точки зрения человека оказывается недопустимо, чтобы робот просто ничего не делал и стоял у лифта.

Задача проектирования роботов, которые могут понять ситуацию и действовать в соответствии с нравственными нормами человека, является сложной, но не невозможной. Хорошо, что ограниченные возможности современных роботов дают нам время научить их разбираться в вопросах морали и этики. Да, роботы не будут безупречны, и сотрудничество робота и человек будет основано на симбиозе, который позволит каждому из партнеров заниматься тем, что получается у него лучше всего.

Комментарии (32)

madfly

08.12.2015 11:30+9Мне думается, что рассуждать о применении морали роботами пока, мягко говоря, очень преждевременно. Настолько преждевременно, что даже нелепо. Как в примере с роботом-медсестрой. Что за робот-медсестра? Как вы себе это представляете? Гуманоидный робот, способный только на то, чтобы поменять утку больному, да, в случае непонятной ситуации, позвонить врачу (вероятно, судя по логике вещей, сбегав на рецепшн к стационарному аппарату)? Какой в ней смысл? Не разумнее ли подключить больного к ящику, который будет снимать все показания состояния больного и автоматически впрыскивать необходимые лекарства, включая обезболивающие, и, опять же, _автоматически_ обращаться за компетентной помощью (скорее даже не к врачу, а к более продвинутому ИИ) в случае сложной ситуации, не полагаясь на распознавание речи и решение морально-этических вопросов? Почему робот (тоже, видимо, гуманоид-прохожий из фильма «I robot») должен не позволять пьяному садиться за руль, когда нам уже в ближайшие 10 лет пророчат полностью автоматизированные автомобили?

В общем, все эти рассуждения выглядят как мысли о том, что через 50 лет Лондон будет завален по самые крыши конским навозом.

SBKarr

08.12.2015 15:13-1А что делать, например, автопилоту легкового автомобиля, если перед ним стоит выбор: сбить пешехода, перебегающего дорогу, или разбиться об стену, потенциально ранив пассажира/водителя? А если несколько пешеходов? Женщина с коляской? Если не начнём проводить границы машинной этики сейчас, уже через 10 лет увидим луддитов, громящих роботов за неэтичность.

ruslanm

08.12.2015 15:24-2Безусловно разбиться самому, т.к. водитель в салоне защищён ремнём и подушками безопасности.

Немного сложнее если на узкую дорогу выскочило животное, например собака. Одни водители спасая животное отвернут в сторону жертвуя машиной. Другие пожертвуют животным. Интересно, как должен в этой ситуации поступить робот.

semmaxim

08.12.2015 15:50+4Естественно сбить пешехода/женщину с коляской/детей/котиков. Автомобиль должен оберегать своих пассажиров, а не нарушителей ПДД. Что тут думать то? К тому же в той же ситуации мы не имеем права требовать каких-либо определённых действий от водителя-человека.

Iceg

08.12.2015 18:44А если в салоне ребёнок, у которого из-за аварии может случиться психологическая травма и пожилой человек, у которого проблемы с сердцем, и оно может не выдержать перегрузок от столкновения, и беременная женщина?

ruslanm

08.12.2015 22:15А вы бы для такой ситуации какую логику в робота заложили?

Iceg

09.12.2015 13:56Постараться избежать столкновения в зависимости от дорожного покрытия, погодных условий, состояния своего ТС, окружающего транспорта и других препятствий, и т.п. Как частный случай — да, просто по тормозам. В приоритете по убыванию сохранение жизни и здоровья пассажиров, потом окружающих людей, целости своего и других ТС.

NightGhost

08.12.2015 15:34+2Вот из-за таких вот «этических» проблем люди и несовершенны. Я считаю, что автопилот должен в первую очередь оберегать своего пассажира, при любом раскладе. Иначе грош ему цена, и уж лучше тогда я сам себя буду оберегать, сам же за рулем и сидя. Скорости бывают разные, условия разные, далеко не всегда ремень и подушки безопасности помогут. Я не согласен ездить в штуке, которая может меня убить, чтобы спасти алкаша, вышедшего на дорогу на хайвее.

А вообще, если автопилот допустил ситуацию, в которой нужно выбирать, кто должен погибнуть — на помойку его надо выкинуть, вместе с разработчиками и тестерами.

madfly

08.12.2015 15:54+3Не нужно очеловечивать автомат. Не нужно приписывать человеческие качества холодильнику только потому, что он сам может заказать отсутствующие продукты через Интернет. Не нужно искать этику и мораль там, где ее не должно быть. Должен ли звонить ваш телефон, если своим звонком он разбудит вашего ребенка, которого вы перед этим два часа убаюкивали? Этично ли он поступил, если все-таки зазвонил?

А если за стеной, про которую вы пишете, сидит маленький ребенок? А если пассажирка автомобиля беременна?

Ниже пара очень правильных комментариев: http://geektimes.ru/company/asus/blog/267138/?reply_to=8902732#comment_8902496 и http://geektimes.ru/company/asus/blog/267138/?reply_to=8902732#comment_8902554

Механизм должен работать логично. Логика его работы программируется в соответствии с установленными правилами (законы, правила, инструкции т.п.). Тогда не возникает вопросов, этично ли поступил робот. У него нет этики. Совсем. И не должно быть. Этика и мораль у людей, принимающих законы, правила и инструкции. Автопилот автомобиля должен априори ездить строго по правилам. Если возникла ситуация, описанная вами, значит нарушил ПДД пешеход. Или ПДД нуждаются в доработке. Автопилот должен, в соответствии с ПДД, затормозить. Если удастся. Кстати, попытки избежать столкновения, рефлекторно предпринимаемые в подобных ситуациях людьми, часто приводят к очень тяжелым последствиям.

Iceg

08.12.2015 18:43+1>Если не начнём проводить границы машинной этики сейчас…

Если не перестать бросаться под машины сейчас, то лет через 10 можно ничего и не увидеть.

VenomBlood

09.12.2015 21:59Никакой этики здесь в принципе не надо. Автомобиль должен следовать очень простой логике. В первую очередь сохранять жизнь пассажиров, во вторую очередь сохранять жизнь окружающих, далее по убывающей — заботиться о собственной целостности, заботиться о повреждениях имуществу/легких травмах окружающим.

Если автомобиль нарушил правила и кто-то пострадал — страховка компании-разработчика выплачивает.

Если никто не нарушал правила и кто-то пострадал и это не был форс-мажор — вопросы к тем кто составлял правила — рассмотреть случай и предотвратить в будущем подобное.

Если автомобиль не наршуал правила и кто-то нарушил и пострадал — сам виноват, автомобиль может оценить возможный вред и максимум — пожертвовать собственной целостностью (если потенциальный вред для людей в салоне будет принебрежимо малым с учетом всех возможных трясок, наличия инвалидов, детей, стариков и т.д. в салоне), если это с большой вероятностью сохранит жизнь нарушителя.

Мораль — вообще очень вредная вещь, большинство задаваемых вопросов решается чисто логически. Даже заезженные с поездом едущим в толпу людей и одиноким человеком на запасном пути. Если на запасном пути людям находиться нельзя, что верно в 99% случаев — перевести на запасной путь, кто забежал туда — сам виноват. Если по какой-то причине там официально можно было находиться потому что путь не используется — не предпринимать действий. Логика «если в обоих исходах страдают невиновные люди — не вмешиваться в существующий ход событий» работает очень хорошо — несчастный случай все равно произойдет, но в случае бездействия это будет просто несчастный случай, а в случае активного действия типа «я лучше задавлю Васю, он один и старый, а вот Маша с Леной пусть живые останутся» — получается что ваша система оценивает чья жизнь более важна и решает убить/покалечить человека которому ничего не угрожало — это субъективно и не логично.

k12th

08.12.2015 12:13Что должен сделать робот-медсестра, если больной раком просит увеличить дозу морфия, а связаться с врачом не получается? Должен ли робот-водитель запрещать пьяному человеку самому управлять автомобилем, когда он спешит в больницу к своему ребёнку? На чей голос должен спешить робот-спасатель в развалинах после землетрясения — на детский или взрослый? А если так получилось, что взрослый — это вы, но ребёнок не ваш?

Если в этих «задачках» заменить робота на человека, они проще не становятся. Автор, представьте, что вы медсестра/медбрат, вы увеличите дозу морфия? На основании чего вы будете принимать это решение?

Iceg

08.12.2015 15:23Ещё как становятся.

Что должен сделать робот-медсестра, если больной раком просит увеличить дозу морфия, а связаться с врачом не получается?

Должно быть, существуют некие предельные дозы, за которыми лекарство нанесёт вред. Очевидно, что машина лучше их определит индивидуально у каждого пациента. Так что ещё вопрос, робот у доктора должен спрашивать, или наоборот.

Должен ли робот-водитель запрещать пьяному человеку самому управлять автомобилем, когда он спешит в больницу к своему ребёнку?

Разумеется. А кто-то сомневается, что пьяного человека ни за что нельзя пускать за руль? Тогда тут не с моралью у роботов, а со здравым смыслом у хумансов проблемы.

На чей голос должен спешить робот-спасатель в развалинах после землетрясения — на детский или взрослый?

На чей голос должен спешитьробот-спасатель в развалинах после землетрясения? Опять же, у машины должно быть больше возможностей просчитать ситуацию. Тогда робот должен спасать того, у кого шансы выжить выше / кого он сможет освободить быстрее, чтобы приступить к спасению второго человека. Очевидно, это всё будет заложено в него ещё на заводе изготовителе, никаких вопросов морали здесь нет.

k12th

08.12.2015 15:29Ну вот и наоборот. Человек вынужден действовать в условиях недостаточных данных. Плюс он осознает, что на решение влияют эмоции и он может ошибиться. Роботу проще, он не ведает сомнений:)

Про пьяного водителя это вообще moot point, как выше писали в комментах — прежде у нас будут машины с робопилотом, чем гуманоидные дворецкие.

Iceg

08.12.2015 18:34Ну в смысле, эти задачи становятся проще (вернее, приходит понимание, что они не так уж высокоморальнонеразрешимыойойой), если рассмотреть аналогичные с человеком — как-то так :)

qw1

08.12.2015 19:35Про пьяного водителя это вообще moot point

Про дворецкого вообще абсурд. Должен ли робот верить владельцу, если тот будет очевидно врать, что идёт не в гараж к машине, а просто подышать воздухом.

grokinn

08.12.2015 12:23-3Мало научить робота этическим нормам, надо ещё как то мотивировать его следовать этим нормам. Человек, в отличие от робота, с рождения обладает механизмами, которые используются впоследствии для его мотивации — страх, удовольствие, желание одобрения, другие инстинкты. Роботу же, особенно описанному тут безэмоциональному созданию, какой смысл следовать нормам? Если робот будет обладать достаточно гибким интеллектом, то он просто отбросит все нормы и будет действовать в своем интересе, если вообще у его создателей получиться сформировать хоть какой-то интерес у этого робота.

mayorovp

08.12.2015 15:09+1Вот как раз робота мотивировать ну нужно. Ему следование нормам, что бы это ни означало, можно просто прописать в программе.

grokinn

08.12.2015 15:13Если это сильный ИИ, обладающий самосознанием, то там нельзя написать программу, по крайней мере такую, которую он сам же не мог бы переписать.

Doktor_Gradus

08.12.2015 19:38Ну вот мы вроде обладаем интеллектом, а свою программу переписать не можем.

grokinn

08.12.2015 19:41Конечно, у нас ведь нет программы, есть разные механизмы регуляции, в основном подсознательные и сформированные эволюционно, а у робота ничего такого нет.

Darth_Biomech

08.12.2015 22:29+1Сильный ИИ это такая штука, которую сажать в робо-медсестру никто явно не будет. И в статье речь явно не о искусственной личности.

ruslanm

08.12.2015 12:57+2Я считаю, что любые роботы должны управляться исключительно логикой. Логика, которая будет понятно описывать поведение робота для человека и так же понятно отдавать приказы самому роботу.

Возьмём пример из статьи, очень похожий на ситуацию в фильме «Я робот». Робот-спасатель «оснащённый» моральными нормами на развалах после землетрясения слышит крик о помощи — слева мужской голос, справа детский. Мужчину он видит, ему придавило ногу. Ребёнка не видит. Управляемый какой то моралью он устремляется к ребёнку и спасает его. Пока он занят ребёнком, мужчину раздавливает. Данная ситуация как то становится известна родственникам погибшего, они подают в суд на компанию производителя робота за то, что он не спас мужчину. Компания производитель в суде нелепо оправдывается за свои нормы морали и т.п.

А вот логика отработала бы здесь чётко. «Обнаружено два объекта — один в поле видимости — помощь мужчине займёт столько то времени, помощь ребёнку не известно — помочь мужчине — помочь ребёнку.»

Допустим начались разбирательства в суде из-за гибели ребёнка, компания разработчик отвечает: «Наши роботы работают вот на такой логике, она одобрена такими-то организациями, приносим соболезнования семье погибших.» Всё чётко и прозрачно.

Я считаю, что роботы — это помощники. Действия помощника должны быть предсказуемы и понятны. Он должен выполнять команды, руководствуясь заложенной в него логикой. Тогда мы все будем дружно жить, а не как в Терминаторе…

caveeagle

08.12.2015 13:36+6На чей голос должен спешить робот-спасатель в развалинах после землетрясения — на детский или взрослый?

Это называется медицинская сортировка, и спасатели руководствуются именно ей.

Что должен сделать робот-медсестра, если больной раком просит увеличить дозу морфия, а связаться с врачом не получается?

Для этого есть внутренние правила больниц, основанные на «Правилах назначения и использования наркотических и психотропных лекарственных препаратов в медицинских организациях»

Должен ли робот-водитель запрещать пьяному человеку самому управлять автомобилем, когда он спешит в больницу к своему ребёнку?

На это счёт есть чёткие правила ПДД, они же и устанавливают минимально допустимую дозу алкоголя, при которой допустимо вождение (сейчас в россии ноль промилле). Вождение в пьяном состоянии нарушает первое правило спасателя: прежде всего думать о том, чтобы не увеличить число пострадавших.

В общем, на данном этапе развития робототехники — достаточно руководствоваться обычной логикой, как это и делают те же спасатели, медики и идеальные гаишники. до необходимости этики роботы дойдут ещё очень нескоро.

sankir

08.12.2015 14:23+4Если мы сделаем всё правильно, то приоритетом робота станет

А если сделаем не правильно? Что для робота будет приоритетом закладывает исключительно человек. По поводу эмоций… тот же самый гнев сравнительно легко программируется рандомным включением агрессии на список ситуаций. Или на любую ситуацию (шутка про ПМС). Страх и того проще: опасность получения повреждений.

Про принятие решений в «сложных ситуациях» — комментарием выше уже сказали, что без всяких «этих ваших моралей» есть четкие правила, закладывать в робота возможность нарушения правил безопасности ради сомнительного очеловечивания… давайте тогда заложим в него еще и тягу сигаретки по ночам у прохожих стрелять.

В общем все разговоры про мораль роботов упираются исключительно в мораль людей, обучающих робота этой самой морали.

potan

08.12.2015 15:08Главное, что бы вопросы этики не мешали развитию. Тогда их реализация может оказаться даже полезной — что бы лучше понять устройство человеческой психики.

NightGhost

Вот не уверен я, что роботам это так уж необходимо. Конечно, все зависит от целей и задач, и если робот должен полностью заменить человека — то вопрос поставлен верно. Но лично я вижу роботов все-таки как помощников людей. Гомо сапиенс у нас и так хватает, чтобы создавать дублирующий искусственный вид.

Этика — дело хорошее, но проблем из-за не меньше. Нравственность и этика есть проявления мышления и свободомыслия. Надо ли нам, чтобы роботы умели мыслить так же свободно, как и люди, и переняли все связанные с этим недостатки? Врач, который вместо лекарств прописывает святую воду; водитель, считающий, что после пары банок пива (энергомыла?) вполне может сесть за руль; воспитатель, ударяющий ребенка с целью успокоить. Все это обратная сторона морали, а именно ее частичное отсутствие или собственная видимость ее принципов.

Мне кажется, вопрос надо ставить по другому — можем ли мы привить роботам плюсы, которые человек получает от присутствия морали, и не дать им соответствующих минусов?