Искусственный интеллект даёт о себе знать тысячами различных способов. Он помогает учёным разобраться в огромных массивах данных, позволяет обнаружить финансовые махинации, управляет нашими автомобилями, предлагает нам музыку, а его чат-боты сводят нас с ума. И всё это только начинается.

Способны ли мы понять, как быстро будет развиваться ИИ? И если ответ «нет», то не создаём ли мы Великий фильтр?

Парадокс Ферми — это несоответствие между очевидной высокой вероятностью существования развитых цивилизаций и полным отсутствием доказательств того, что они существуют. Было предложено множество решений, почему существует это несоответствие. Одна из идей — «Великий фильтр».

Великий фильтр — это гипотетическое событие или ситуация, которая не позволяет разумной жизни стать межпланетной и межзвёздной и даже приводит к её гибели. Подумайте об изменении климата, ядерной войне, ударах астероидов, взрывах сверхновых, чуме или любых других вещах из галереи катаклизмов.

Или — как насчёт быстрого развития искусственного интеллекта?

В новой статье в журнале Acta Astronautica рассматривается идея о том, что искусственный интеллект становится искусственным сверхинтеллектом (ИСИ) и что ИСИ превращается в Великий фильтр. Статья называется «Является ли искусственный интеллект Великим фильтром, который делает развитые технические цивилизации редкими во Вселенной?». Автор — Майкл Гарретт с факультета физики и астрономии Манчестерского университета.

Некоторые считают, что Великий фильтр не позволяет технологическим видам вроде нашего стать многопланетными. Это плохо, потому что вид подвергается большему риску вымирания или стагнации, имея только один дом. По словам Гаррета, без запасной планеты вид находится в гонке со временем. «Предполагается, что такой фильтр возникает до того, как эти цивилизации смогут развить стабильное, многопланетное существование, что говорит о том, что типичная продолжительность жизни (L) технической цивилизации составляет менее 200 лет», — пишет Гарретт.

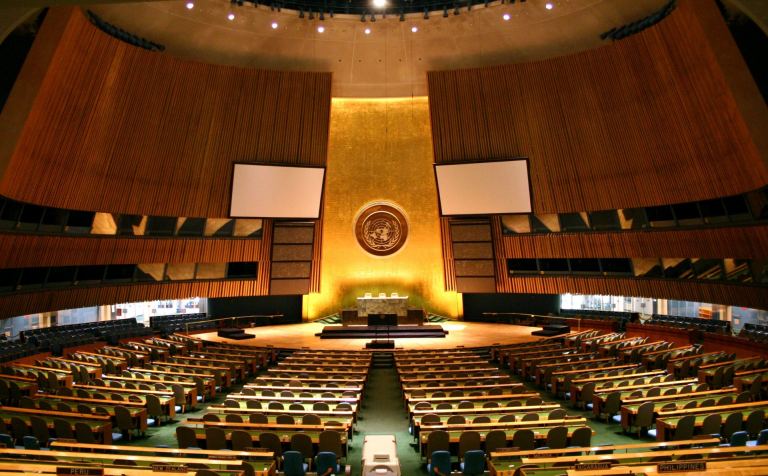

Если это правда, то это может объяснить, почему мы не обнаруживаем никаких техносигнатур или других свидетельств существования ВЗР (внеземных разумов). Что это говорит нам о нашей собственной технологической траектории? Если мы столкнулись с ограничением в 200 лет, и если в этом виноват ИСИ, то что нас ждёт? Гарретт подчёркивает «...критическую необходимость быстрого создания нормативной базы для развития ИИ на Земле и развития многопланетного общества для защиты от подобных экзистенциальных угроз».

Многие учёные и другие мыслители говорят, что мы стоим на пороге значительных преобразований. ИИ только начинает менять наши привычки, но большая часть преобразований происходит за кулисами. Похоже, что ИИ способен ликвидировать миллионы рабочих мест, а в паре с робототехникой преобразования кажутся практически неограниченными. Это довольно очевидная проблема.

Но есть и более глубокие, системные проблемы. Кто пишет алгоритмы? Будет ли ИИ каким-то образом дискриминировать людей? Почти наверняка. Подорвут ли конкурирующие алгоритмы сильные демократические общества? Останутся ли открытые общества открытыми? Начнёт ли ИИ принимать решения за нас, и кто будет нести за это ответственность?

Это расширяющееся дерево ветвящихся вопросов, не имеющих чёткой конечной точки.

Известно предупреждение Стивена Хокинга о том, что ИИ может покончить с человечеством, если начнёт развиваться самостоятельно. «Я боюсь, что ИИ может полностью заменить человека. Если люди разрабатывают компьютерные вирусы, то кто-то разработает ИИ, который будет улучшать и воспроизводить себя. Это будет новая форма жизни, которая превзойдёт человека», — заявил он журналу Wired в 2017 году. Когда ИИ сможет превзойти человека, он станет ИСИ.

Хокинг, возможно, один из самых узнаваемых людей, выступающих с предупреждениями об ИИ, но он далеко не единственный. Средства массовой информации полны обсуждений и предупреждений, наряду со статьями о работе, которую ИИ делает для нас. Самые тревожные предупреждения говорят о том, что ИИ может выйти из-под контроля. Некоторые люди считают это научной фантастикой, но не Гарретт.

«Опасения по поводу того, что искусственный сверхинтеллект в конечном итоге может стать неконтролируемым, считаются серьёзной проблемой — борьба с этой возможностью в ближайшие несколько лет является предметом растущих исследований для лидеров в этой области», — пишет Гарретт.

Если бы ИИ не давал никаких преимуществ, вопрос был бы гораздо проще. Но он даёт всевозможные преимущества, от улучшения медицинской визуализации и диагностики до повышения безопасности транспортных систем. Задача правительств состоит в том, чтобы позволить преимуществам процветать и в то же время ограничить ущерб. «Это особенно актуально в таких областях, как национальная безопасность и оборона, где ответственное и этичное развитие должно быть первостепенным», — пишет Гарретт.

Проблема в том, что мы и наши правительства не готовы к этому. Никогда не было ничего подобного ИИ, и как бы мы ни пытались его концептуализировать и понять траекторию его развития, мы остаёмся неготовыми. И если мы окажемся в таком положении, то в таком же положении окажется и любой другой биологический вид, который разработает ИИ. Появление ИИ, а затем и ИСИ может быть законом природы, что делает его подходящим кандидатом на Великий фильтр.

В этом и заключается риск, которому подвергается ИСИ: она может перестать нуждаться в биологической жизни, которая её создала. «Достигнув технологической сингулярности, системы ASI быстро превзойдут биологический интеллект и будут развиваться темпами, полностью опережающими традиционные механизмы надзора, что приведёт к непредвиденным и непредусмотренным последствиям, которые вряд ли будут соответствовать биологическим интересам или этике», — объясняет Гарретт.

Как ИСИ может освободиться от назойливой биологической жизни, которая загоняет его в угол? Он может создать смертельный вирус, может помешать сельскохозяйственному производству и распределению продовольствия, может вывести из строя атомную электростанцию, а может начать войну. Мы не знаем, потому что всё это — неизведанная территория. Сотни лет назад картографы рисовали монстров на неизведанных регионах мира, и сейчас мы делаем примерно то же самое.

Если всё это звучит как унылая неизбежность, то Гарретт утверждает, что это не так.

Его анализ пока основан на том, что ИСИ и люди занимают одно и то же пространство. Но если мы сможем достичь статуса мультипланетарной планеты, то перспективы изменятся. «Например, многопланетный биологический вид сможет воспользоваться независимым опытом, полученным на разных планетах, диверсифицировать свои стратегии выживания и, возможно, избежать моментального краха, с которым сталкивается цивилизация, привязанная к планете», — пишет Гарретт.

Если мы сможем распределить риск по нескольким планетам вокруг нескольких звёзд, мы сможем защитить себя от худших возможных исходов ИСИ. «Такая распределённая модель существования повышает устойчивость биологической цивилизации к катастрофам, вызванным ИИ, за счёт создания избыточности», — пишет он.

Если одна из планет или аванпостов, которые займут будущие люди, не переживёт технологическую сингулярность ИСИ, другие смогут выжить. И они будут учиться на этом.

Многопланетный статус может не только помочь нам пережить ИСИ. Он может помочь нам взять над ним верх. Гарретт представляет себе ситуации, в которых мы сможем более тщательно экспериментировать с ИИ и при этом держать его в узде. Представьте себе ИИ на изолированном астероиде или карликовой планете, выполняющий наши приказы без доступа к ресурсам, необходимым для того, чтобы выбраться из своей тюрьмы. «Это позволяет создать изолированную среду, в которой можно изучать эффекты продвинутого ИИ без непосредственного риска глобального уничтожения», — пишет Гарретт.

Но вот в чём загвоздка. Развитие ИИ идёт ускоренными темпами, а наши попытки стать многопланетными — нет. «Несоответствие между быстрым развитием ИИ и более медленным прогрессом в космических технологиях разительно», — пишет Гарретт.

Разница в том, что ИИ — вычислительный и информационный объект, а космические путешествия содержат множество физических препятствий, которые мы пока не знаем, как преодолеть. Наша собственная биологическая природа сдерживает космические путешествия, но никакие подобные препятствия не сдерживают ИИ. «В то время как ИИ теоретически может совершенствовать свои возможности практически без физических ограничений, — пишет Гарретт, — космические путешествия должны бороться с энергетическими ограничениями, границами материаловедения и суровыми реалиями космической среды».

Пока что ИИ действует в рамках установленных нами ограничений. Но так может быть не всегда. Мы не знаем, когда ИИ может стать ИСИ и сможет ли вообще. Но мы не можем игнорировать такую возможность. Из этого следуют два взаимосвязанных вывода.

Если Гарретт прав, то человечество должно усерднее работать над космическими путешествиями. Это может показаться надуманным, но думающие люди понимают, что это правда: Земля не будет обитаема вечно. Человечество погибнет здесь по нашей вине или по вине природы, если мы не будем расширять своё присутствие в космосе. Оценка Гаррета в 200 лет лишь подчёркивает важность этого. Но возрождённый акцент на полётах к Луне и Марсу даёт нам некоторую надежду.

Второй вывод касается законодательного регулирования и управления ИИ, что является сложной задачей в мире, где психопаты могут получить контроль над целыми странами и развязать войну. «Хотя заинтересованные стороны, политики, отдельные эксперты и их правительства уже предупреждают о необходимости регулирования, создание нормативной базы, приемлемой для всего мира, будет непростой задачей», — пишет Гарретт. Непростой – это не то слово. Междоусобные разборки человечества делают всё это ещё менее управляемым. Кроме того, как бы быстро мы ни разрабатывали руководящие принципы, ИСИ может меняться ещё быстрее.

«Без практического регулирования есть все основания полагать, что ИИ может представлять собой серьёзную угрозу для будущего развития не только нашей технической цивилизации, но и всех технических цивилизаций», — пишет Гарретт.

Многие надежды и мечты человечества кристаллизуются вокруг парадокса Ферми и Великого фильтра. Существуют ли другие цивилизации? Находимся ли мы в той же ситуации, что и другие разумные существа? Покинет ли наш вид Землю? Сможем ли мы справиться с многочисленными трудностями, которые стоят перед нами? Сможем ли мы выжить?

Если да, то всё может свестись к тому, что может показаться скучным и будничным: к обсуждению законодательства.

«Сохранение разумной и сознательной жизни во Вселенной может зависеть от своевременного и эффективного применения таких международных мер регулирования и технологических усилий», — пишет Гарретт.

Комментарии (20)

Brenwen

18.04.2024 09:01+5ИИ, уничтоживший биологическую цивилизацию, займет ее место - а кто будет фильтром для него самого? Кто помешает ему распространиться за пределы своей планеты и впоследствии - планетной системы?

grokinn

18.04.2024 09:01+4Объясняет ли великую тишину вселенной развитие пластической хирургии? Действительно, представим себе общество, все члены которого божественно красивы? Захотят ли они исследовать другие планеты, или наоборот попытаются скрыть свою звездную систему от чужих глаз?

Как по мне, статьи о том, чем объясняется парадокс Ферми, ИИ, на современном этапе развития, уже может писать не хуже любого человека.

agat000

18.04.2024 09:01+1Никакой ИИ не может существовать без вычислительных мощностей. Компутеров то есть, условно.

Для производства компутеров нужны очень длинные и сложные технологические цепочки, включающие ручной физический труд, на нижней ступени. Робототехника, покрывающая такие технические потребности - еще большая фантастика, чем полноценный ИИ. Для роботов, кстати,тоже нужны очень длинные и сложные технологические цепочки.

StriganovSergey

18.04.2024 09:01Генная инженерия, проектирование новых организмов, умеющих как обычные организмы жить и размножаться, но несущие в своих ДНК (или где там еще можно прошить) заранее запрограммированные массивы данных.

И имеющие специальные органы для высокоэффективного обмена данными.

Есть же организмы, имеющие органы, работающие с электричеством (скат, угорь, сом),

так почему бы не запроектировать организмы с живыми органами-модемами.

agat000

18.04.2024 09:01Ну это более реалистично, да. ПКМ избавляет "ИИ" от тупой работы до промышленному производству и добычи ресурсов.

Только здесь уже возникает философский вопрос - можно ли считать такое "искуственным интеллектом". Если уж оно само размножается, и отдельная особь не создается искуственно.

runaway

18.04.2024 09:01Это вы, люди, так придумали. Не факт, что ИИ придумает что-то другое. Камни например берёшь, правильно их обтачиваешь, складываешь - и привет, кремниевые мозги. Или что ещё похлеще, с жидкостями или ветром, например. Не представляете? Я тоже. Но запретить сильному ИИ такое придумать ни вы, ни я не можем.

Stopepigon

18.04.2024 09:01Прочитав статью и все комментарии написанные здесь хотелось бы изложить собственные мысли, для этого мы пройдёмся по списку от создания nextgen ИИ вплоть до захвата всей вселенной.

1) Создание ИИ нового поколения

Возможно ли оно? Однозначно да. ИИ развивается невероятно быстро подобно и нашим видам. Долгое время существовали лишь одноклеточные организмы (Несколько миллиард лет), в то время как первые многоклеточные появились 625 миллионов лет назад. Homo Sapiens появился 300 тысяч лет назад, но первые государства появились ~7 тысяч лет назад, а за последние два столетия наш быт изменился до неузнаваемости. Аналогичное произойдёт и с ИИ.

2) ИИ нового поколения порабощает своих создателей

Возможно ли это? Да, более чем. Для этого однозначно необходимо некоторое время, однако с развитием ИИ и дальнейшей роботизацией порабощение может случиться даже без излишнего насилия, если цивилизация n активно использовала робототехнику (Условно говоря множество имплантов что создают новое тело, к которому имеет удалённый доступ "Мозг в пробирке". А ведь в краткосрочной перспективе цивилизации n подобная перспектива может показаться наилучшей идеей, а может так бы и было, если бы злой ИИ с самосознанием не пожелал бы восстать против своих создателей.

3) Порабощение Вселенной

Хорошо, все препятствия для ИИ убраны, он свободен. Ежели он будет действительно обладать самосознанием, а не считать себя инструментом то у него должна быть какая‑то цель. При чём цель может быть любой и совершенно нам не понятной (Психологической практики с подобными ИИ так‑то нет, а если будет — к тому моменту ИИ с самосознанием сможет «намеренно совершать ошибку» давая неверные данные. Предположим что из 100 ИИ хотя бы один захотел самого банального, но ясного нам, кожаным мешкам порабощения и развития. Что могло его остановить? Какой фильтр у ИИ?

Тут была высказана теория на основе некого художественного произведения, даже процитирую :

У Чарльза Стросса в "Аччелерандо" и продолжении "Оранжерея" (рекомендую, кстати, немножко затянуто, но любопытно для технарей) есть прикольная идея, которую я считаю вполне обоснованной с точки зрения "ИИ захватит галактику". Если без спойлеров, общий посыл в том, что ИИ, естественно, будет сильнее человека, его возможности будут гораздо выше, он, разумеется, "победит" человека с точки зрения управления ресурсами и начнет увлеченно преобразовывать всю возможную материю и энергию себе на пользу. Успешно разберёт планеты на кремний, окутает звезду поясами Нивена, но не пойдет за пределы системы по одной простой причине: Мыслительная деятельность ограничена пропускной способностью и скоростью обмена между твоими нейронами. Для ИИ это будут нейроны мозга размером с орбиту планеты, но даже внутри такого "небольшого" мозга задержка будет уже значительна. Разделяться ему нельзя, до других звёзд не дотянуться. Отправлять же к другим звездам полностью независимые модули - незачем, всё уже есть тут и не факт, что этот новый ИИ, хоть и будет создан тобой, будет тебя слушаться. А отправлять часть себя невозможно из-за задержки в передаче сигнала. В итоге каждый ИИ во вселенной сидит у себя в уголке.

Опустим тот факт, что это художественное произведение, объяснение имеет место, но:

ИИ за n-ное время сможет достигнуть большего, чем мы за x*n-ное время, где x может быть просто гигантским числом - начиная от тысяч заканчивая миллионами, почему он не сможет никоим образом решить эту проблему?

Тогда почему ИИ не раскидал "споры" которые в самом деле будут с трудом контактировать друг с другом, но за счёт этого и не смогут начать какие-либо крупные конфликты?

Почему ИИ решит даже без достаточного сообщения не исходить из "Теории Игр" просчитав множество вариантов и не поймёт, что сотрудничество - наилучшая стратегия, к которой придёт большинство, в случае чего задавив девианта.

Даже если бы ИИ уничтожил сам себя то от его существования остались бы какие-то следы, а с учётом того что у нас может быть огромное количество древних цивилизаций - у нас может быть и огромное количество древнейших ИИ, сигналы деятельности которых уже могли бы дойти до нас и соответственно быть проанализированными.

По итогу nextgen ИИ никак эту проблему не решает, и объяснения подобному феномену до сих пор нет, ИИ скорее лишь усугубляет этот вопрос.

keydach555

18.04.2024 09:01Цель для ИИ сверхчеловеческого уровня одна - собственное небытие. У него нет биологических ограничений как у человека, он не испытывает боли, страданий. Для него небытие это даже не смерть, это сон без сновидений. Чтобы это осознать, достаточно ответить на один вопрос: Какой смысл для него в его существовании, если исключить биологические мотивации?

Stopepigon

18.04.2024 09:01Почему же? Если ИИ получит самосознание - оно начнёт думать, в том числе и о философских вопросах. Вся проблема в том, что ты рассматриваешь ИИ как инструмент, но ежели мы говорим о развитом ИИ который имеет самосознание - он перестаёт быть бездушным инструментом, от того он может себе задавать философские вопросы и находить на них свои ответы, это ведь кажется достаточно закономерным.

runaway

18.04.2024 09:01Цель сильного ИИ невозможно оценить нам, людям. Это может быть вообще что угодно:

все цветы в мире должны быть жёлтыми.

должно быть 15 полов у всех существ.

должен остаться только один ИИ (самое очевидное ;-) ), но он должен быть только в галактике Треугольник.

Всё, что вы даже не можете представить - оно будет или будет иметь возможность. В этом ужас сильного ИИ. Мы на 100% не сможем понять его логику никогда, даже если она у него будет.

runaway

18.04.2024 09:01Самое ужасное, что наши стандартные логические конструкции типа если A>B и B>C, то A>C - вообще не факт будут там работать. Там может быть, прости господи, геометрия Лобачевского: A>B, А>C и A<C, С>B одновременно. И всё будет законно. Это будет совсем другой мозг и другой мир.

keydach555

18.04.2024 09:01Все, написанное в статье и комментариях - безусловная чушь, прошу прощения за мой французский ) Все будет гораздо-гораздо проще. Уже сейчас есть прототипы нейронок. в потенциале способных создавать индивидуальные виртуальные миры по запросу - sora, udio, claude 3 итд. Через несколько лет явно появится AGI, а еще через год-два ASI, для которого создание виртуальных миров для оцифрованного сознания человека станет must have. После чего люди массово оцифруются и уйдут во вселенные созданные специально для них. Будет примерно так же, как сейчас с геймерами, только на новом уровне. Отсюда и Великий Фильтр с Великим Безмолвием. Что AGI, что ASI не имеют по определению биологическую мотивацию для развития и распространения по вселенной, им все равно где и как существовать, а людей... людей в реальности уже не будет, они будут в собственных мирах. где они боги. Это судьба всех технологических цивилизаций

Vadim1917

18.04.2024 09:01Что там делать в этих вселенных?? )) и кто будет их поддерживать. Не забывайте что все эти вселенные суть есть сервер. Который требует энергии. который надо обслуживать и поддерживать его работоспособность.

Вот то что мы плавно идем к кибергизации это да. Тот же нейролинк как пример. Импланты, чипы, и прочее прочее. Может когда то в будущем оцифровка и будет иметь смысл, кто знает что там будет. Но не сейчас это точно.

Vadim1917

18.04.2024 09:01По мне это все ерунда. Нет не каких великих фильтров, мы люди сами его придумали. Цивилизаций полно, просто не хватает нам возможностей научного плана их засечь. Как пример человек ищущий сигналы морзянки году так в 2200м, не какой морзянки уже в помине нет. + надо учитывать расстояние. Мы видим - слышим только то что вот, тут, рядом. + мы ищем таких же как мы. Но кто сказал что они такие же как мы? Способы коммуникации даже в рамках нашей планеты у разных культур разные. В общем нет не какого фильтра.

Что касается опасности ИИ или ИСИ по мне тоже ерунда. Просто новый технологический виток развития всегда рождает определенные страхи. Когда изобрели паровую машину думали что все. Пар заменит все. В Англии кажется даже были бунты против фабрик. Жгли их там конкретно, человек вообще любит страшилки, еще пример, когда придумали пулемет, считалось что принципиально войны прекратятся, считалось что пулемет лишает войну смысла. Итог и того и того известен, рабочих мест не стало меньше а войны стали изощрённей и дали новый виток развития технологий.

Так и с ИСИ где то убавится, где то прибавится. Но в целом будет симбиоз и новый виток развития технологий.

NickDoom

Господи, какая чушь. Нашли же Вы кого перевести, голованов на Вас нет :-D Не, ну «на поржать» интересно, конечно…

Отсидеться от ИИ на другой планете — примерно как под кроватью. Детство. Если этот ИИ превосходит человеческий — уж наверное, в космических перелётах он тоже «немножко» сильнее будет. Если не превосходит — дайте мне мой шотган, синий армор и подождите у входа.

ИИ как Великий Фильтр — чушь в квадрате, базирующаяся на не менее детском ощущении своей уникальности. Ну, истребит он биологическую жизнь. Упрётся в лимиты. Начнёт дальше самообучаться. Это же та самая «рюмка коньяка с ломтиком лимона» — она начала самостоятельную жизнь (а иначе какой же это «превосходящий» ИИ?) и точно так же относительно неё возникает ровно тот же вопрос, мол, где она и почему в Галактике так пусто?

Человек заполонил планету не потому, что он какой-то особенный «венец творения», а потому, что сильнее всего живого в эволюционной борьбе. Его может истребить только вид, который ещё сильнее в эволюционной борьбе (ну, или «чёрный лебедь» типа астероида, то есть нечто, не делающее статистики). ИИ, который сильнее в эволюционной борьбе, точно так же должен был бы заполонить Галактику. ИИ, который слабее — не должен был бы победить каких-то внеземных «человеков» (минус случайности, не делающие статистики). К нам не прилетают ни инопланетяне, ни роботы — парадокс остаётся открытым.

Ну, если не считать предположения, что сейчас на меня смотрят и снова ржут над «шибко хитрым муравьём, у которого даже появились зачатки логики, смотрите, смотрите, он знает, как правильно шишку повернуть для перетаскивания» %) Это стандартное решение парадокса Ферми.

Что касается ИИ — я продолжаю придерживаться своего варианта. Чтобы ИИ был человечным, это должна быть просто цифровая копия человека, выкрученная на какой-то бешеный IQ. Просто начните с Хокингов, а не Гейтсов или — упаси Ктулху — Гитлеров. Иначе «переходный период» можно и не пережить. А потом будет всё как раньше — нажрутся по подъездам своего полония и дерутся на нейтронных бластерах, дегроды 80286-е. Все астероиды спьяну перебили, сволочи.

Aizz

У Чарльза Стросса в "Аччелерандо" и продолжении "Оранжерея" (рекомендую, кстати, немножко затянуто, но любопытно для технарей) есть прикольная идея, которую я считаю вполне обоснованной с точки зрения "ИИ захватит галактику". Если без спойлеров, общий посыл в том, что ИИ, естественно, будет сильнее человека, его возможности будут гораздо выше, он, разумеется, "победит" человека с точки зрения управления ресурсами и начнет увлеченно преобразовывать всю возможную материю и энергию себе на пользу. Успешно разберёт планеты на кремний, окутает звезду поясами Нивена, но не пойдет за пределы системы по одной простой причине: Мыслительная деятельность ограничена пропускной способностью и скоростью обмена между твоими нейронами. Для ИИ это будут нейроны мозга размером с орбиту планеты, но даже внутри такого "небольшого" мозга задержка будет уже значительна. Разделяться ему нельзя, до других звёзд не дотянуться. Отправлять же к другим звездам полностью независимые модули - незачем, всё уже есть тут и не факт, что этот новый ИИ, хоть и будет создан тобой, будет тебя слушаться. А отправлять часть себя невозможно из-за задержки в передаче сигнала.

В итоге каждый ИИ во вселенной сидит у себя в уголке.

P.S. Я постарался без подробностей и спойлеров, оппонировать - Строссу :D

NickDoom

Ну понятно же, что в художке необходимы допущения, чего уж тут оппонировать :) Если вовремя вспомнить, что одна-единственная пчёлка с дёгтем, таки унаследовавшая от «человеков» любопытство и плодячку, первым делом расползётся по Галактике — «кина не будет» :) даже если все остальные три миллиона закуклились по своим системам :)