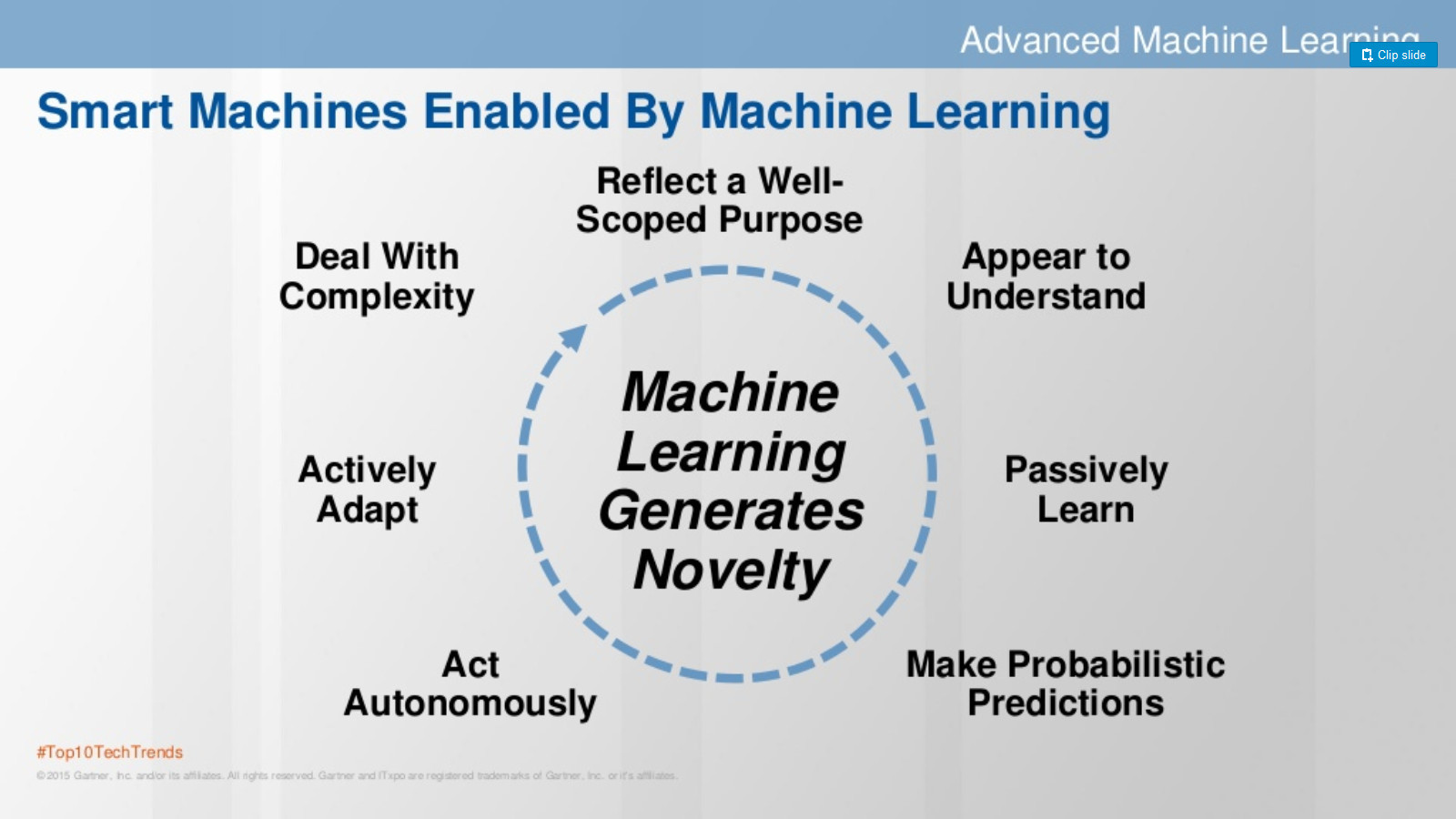

Чем больше занимаешься этой темой, тем более интересно становится, особенно в свете происходящих предсказаний типа наступления эры роботов, умных машин и т.п. И это не удивительно, что такие машины будут созданы, т.к. эволюция показывает, что человек учится расширять себя, создавая симбиоз человек-машина. Бывает идешь у своего забора, торчит гвоздь. Ох как трудно его забить без молотка. А молотком – раз и там. Поэтому не удивительно, что появляются такие же «помощники» для мозговой деятельности.

По ходу изучения темы, я не переставал думать о том, что, кажется, машинное обучение объясняет, как устроен наш разум. Ниже я перечислю уроки, которые я извлек о человеке, изучая машинное обучение. Не претендую на правоту, приношу извинения, если все это очевидно, буду рад, если материал позабавит, или если будут контр-примеры, чтобы начать (опять) жить верой в «непонятное». Кстати, у Вышки есть курс, где машинное обучение используется для понимания работы мозга.

1) Ансамбль простейших алгоритмов может разбираться в невообразимой куче данных с хорошей точностью. В этой связи вспоминается недавно почивший Мински, который написал целую книгу о бестолковых агентах, которые в совокупности образуют наш разум. Такое трактование разума, позволяет представить, что все волшебство, которое есть наш разум, не более, чем совокупность простых моделей, обученных опытом.

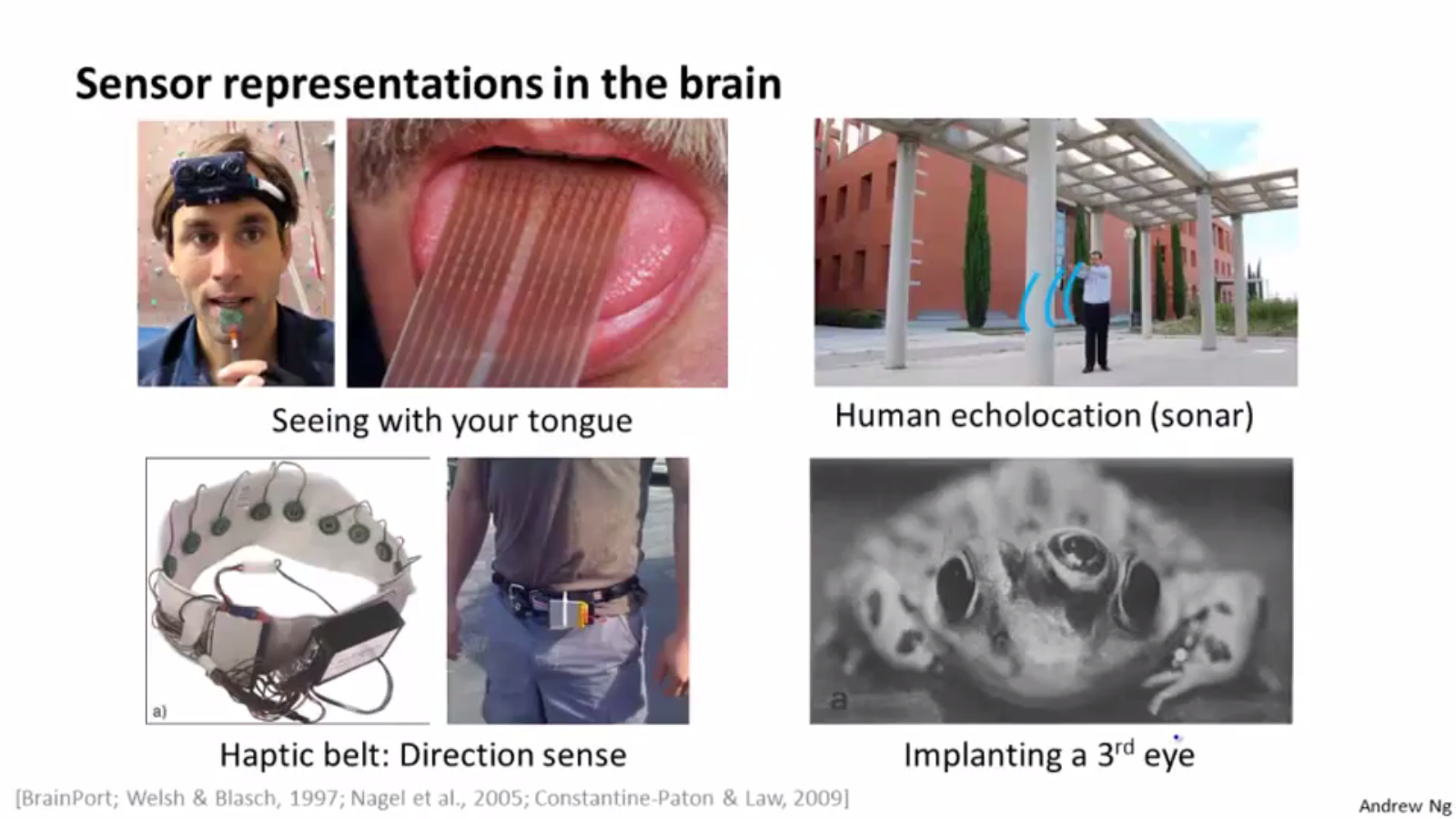

2) В плане обучения опытом, вспоминается один из любимых слайдов Andrew NG:

На нем Andrew заостряет внимание на том, что мозг может научить свой другой отдел (где пока нет модели) тем функциям, которые были утрачены, например, видеть языком.

3) Исследователям мозга известно, что разум закладывается, когда человек совсем мал. Происходят фантастические изменения – из звуков человек начинает понимать речь, распознавать родителей / чужих. Малыши пока бьют компьютеры, но это только показывает, что, похоже, наш разум – это очень хорошие модели, натренированные на гигантском объеме информации (напр., 3 года непрерывных картинок), гигантскими биологическими нейронными сетями (86 миллиардов нейронов).

4) Похоже, что некоторые модели можно как-то объяснить и изменить – есть область типа «sandbox» («давай подумаем, почему это так», методы коррекции типа психоанализа и т.д.), а некоторые уходят в бессознательный «production» (привычки и автоматические действия: вождение автомобиля после многолетней практики, дыхание, движение и др.). Пример того, как работает «production» – классический кейс Clive Wearing. Человек полностью потерял способность запоминать. «Having watched a certain video recording multiple times on successive days, he never had any memory of ever seeing the video or knowing the contents, but he was able to anticipate certain parts of the content without remembering how he learned them.» Т.е. модель, натренированная в прошлые дни, есть в памяти и дает предсказания для очередного просмотра. Модель – осталась в памяти, данные о прошлом – нет.

5) Вероятно, многие люди ленятся создавать или обновлять свои модели и живут на том, что в “production”, на готовых моделях, созданных на исторических данных, которые уже не актуальны. Поэтому так трудно изменить человека: конечно, он будет больше доверять (бессознательно) модели, натренированной на гигантском объеме прошлой информации, чем новым достоверным данным, объем которых меньше.

6) Животные живут только на моделях в “production” – они не могут проанализировать модель аналитически и без переобучения изменить модель (ceteris paribus). Они будут выделять слюну без еды, от света лампочки.

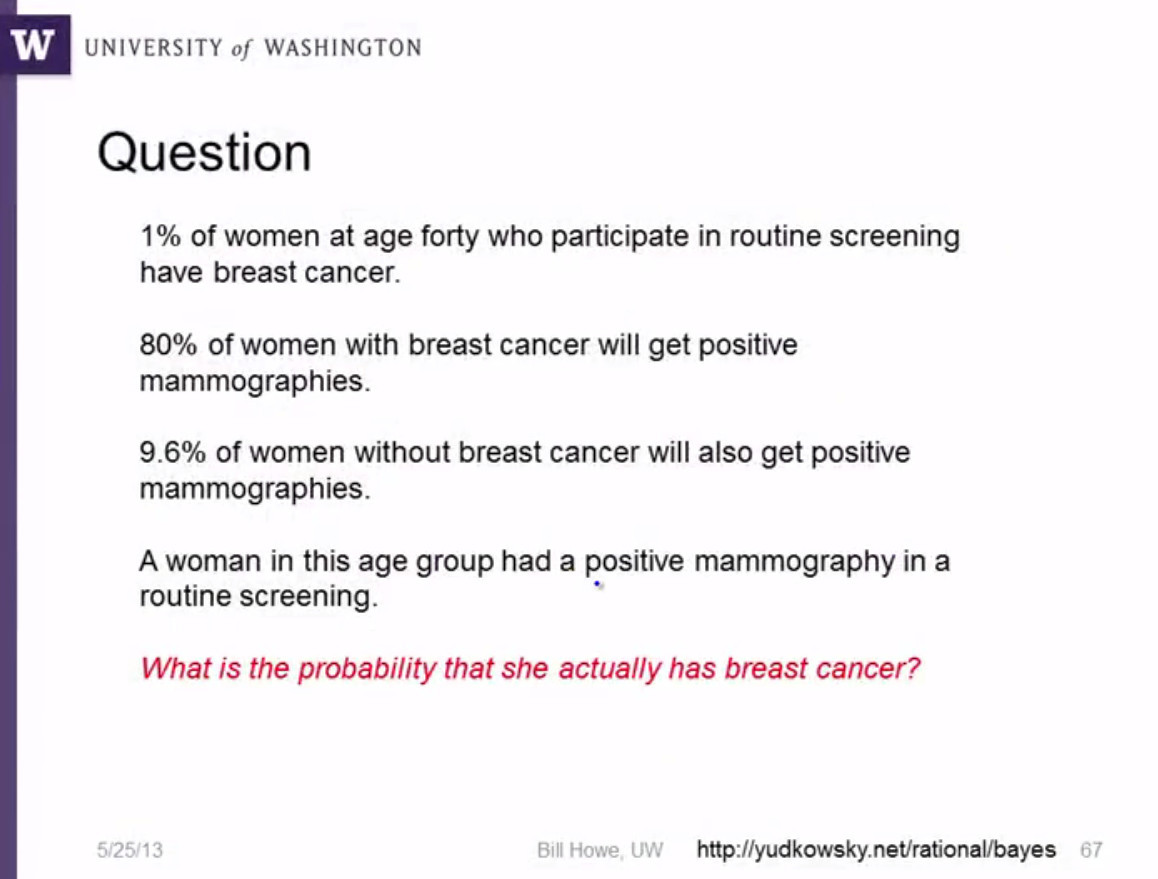

7) Мозг часто уступает машине (аналитике), особенно, если не думать тщательно. Например, классика жанра из курса Bill Howe, Practical Predictive Analytics: Models and Methods:

15% (!) докторов отвечают правильно (ответ: 7.8%).

8) Интуиция – это сложные модели, которые нельзя объяснить. Интуиция – всегда основана на данных и моделях. Лучший пример из книги Malcolm Gladwell “Blink” – “the tennis coach who knows when a player will double-fault before the racket even makes contact with the ball”. Т.е. его модель, натренированная на годах наблюдений, дает очень точное предсказание попадет ли мяч в поле, имея только данные до удара.

9) В принципе, можно сделать следующее обобщение: «Человек умен в какой-то области настолько, насколько хорошо он построил алгоритм, обученный в этой области.» Для этого, как правило, нужно много наблюдений. Тот же Гладвэлл говорит, что данных нужно, примерно, за 10,000 часов практики.

10) Почему некоторые не могут поумнеть, даже имея большой опыт? Заметьте, что именно так часто определяют дурака: «тот, который делает в схожих обстоятельствах (при тех же данных) одну и ту же ошибку.» Вероятно, сложность моделей у всех разная, как и способность обучать модели.

11) Для тренировки модели нужны положительные и отрицательные примеры. Нельзя научить алгоритм или человека только на примерах одного типа. Человек не научится, если его всегда ругать или повторять, что все ОК.

12) Машинное и человеческое обучение предсказывает не со 100% вероятностью. 25% ошибки – это промах в одном случае из четырех. Не надо удивляться, что идеальный алгоритм с такой ошибкой часто ошибается (примеры: предсказание курса валюты, GDP в этом году, игры Dota2 и т.п.) Не надо удивляться, что очень умные могут быть не правы очень часто. Кстати, помогают средние большого числа предсказаний – по ним лучше судить, чем по одному наблюдению.

13) Любовь, музыка, искусство и т.д. явно связаны с той натренированной моделью (прошу понимать в нужном смысле), которая преобразует данные, поступающие от объекта восхищения, в вероятность «успеха», активацию связей, которые нам «нравятся» и т.д.

14) Машинное обучение построено на минимизации ошибки предсказания, что соответствует самому определению умного человека (разума) – тот, кто дает правильный ответ, то есть имеет минимальную ошибку.

15) Способность же объяснить почему именно так работает алгоритм вторично, как для человека, так и для машины. В этой связи вспоминается Будда:

«One day Malu?kyaputta got up from his afternoon meditation, went to the Buddha, saluted him, sat on one side and said:

‘Sir, when I was all alone meditating, this thought occurred to me: There are these problems unexplained, put aside and rejected by the Blessed One. Namely, (1) is the universe eternal...’

Выдержка из ответа Будды:

‘…Suppose Malu?kyaputta, a man is wounded by a poisoned arrow, and his friends and relatives bring him to a surgeon. Suppose the man should then say: “I will not let this arrow be taken out until I know who shot me; whether he is a K?atriya (of the warrior caste) or a Brahma?a (of the priestly caste) or a Vaisya (of the trading and agricultural caste) or a Sudra (of the low caste); what his name and family may be; whether he is tall, short, or of medium stature; whether his complexion is black, brown, or golden: from which village, town or city he comes. I will not let this arrow be taken out until I know the kind of bow with which I was shot; the kind of bowstring used; the type of arrow; what sort of feather was used on the arrow and with what kind of material the point of the arrow was made.” Malu?kyaputta, that man would die without knowing any of these things…

…Therefore, Malu?kyaputta, bear in mind what I have explained as explained and what I have not explained as unexplained. What are the things that I have not explained? Whether the universe is eternal or not, etc., I have not explained. Why, Malu?kyaputta, have I not explained them? Because it is not useful, it is not fundamentally connected with the spiritual holy life, is not conducive to aversion, detachment, cessation, tranquility, deep penetration, full realization, Nirva?a. That is why I have not told you about them.»

Только зарегистрированные пользователи могут участвовать в опросе. Войдите, пожалуйста.

Комментарии (15)

sim0nsays

12.03.2016 22:48+5Есть такой анекдот про Джеффри Хинтона:

Приходит Хинтон вечером домой и с порога говорит — "Наконец-то! Я понял, как на самом деле работает мозг!"

Дочка — "Папа, опять?"

brainick

12.03.2016 23:32+3Читая эту дилетантскую статью почему-то вспомнилось

1.

"

Ужасно я предан науке! Рубль сей парус девятнадцатого столетия для меня не имеет никакой цены, наука его затемнила у моих глаз своими дальнейшими крылами. Всякое открытие терзает меня как гвоздик в спине. Хотя я невежда и старосветский помещик, а все же таки негодник старый занимаюсь наукой и открытиями, которые собственными руками произвожу и наполняю свою нелепую головешку, свой дикий череп мыслями и комплектом величайших знаний. "

2. Мой перевод статьи Марра. https://megamozg.ru/post/24094/

«Вы заметили, что подобно поганками после дождя, появилась огромная масса людей, называющих себя «специалистами по анализу данных»? И ваш сосед, и смазливая тёлка, с которой вы бухали на вечеринке и даже ваш знакомый бухгалтер — все вдруг сменили название профессии в визитке!»

Habr and Rock n Roll's Dead.

rocknrollnerd

13.03.2016 00:00+1Нельзя научить алгоритм или человека только на примерах одного типа.

У Кевина Мерфи в его талмуде про это забавно было: "родители могут показать детям на что-нибудь и сказать — "смотри, вон собачка". Но они почти никогда не делают наоборот: "смотри, вон не-собачка")

Так что с негативными примерами не все так просто и очевидно, как кажется на первый взгляд.

VDG

13.03.2016 01:08+2А у того Кевина дети-то есть? Всё нормально у них с негативными примерами.

Смотри. Это кииииса.

А это кто у нас? Собаааачка.

Ой, а где собачка? Нееет собачки. Убежала собачка.

yorko

13.03.2016 13:41+2Мне тут ближе пример с одноклассовой классификацией (можно это назвать и concept learning) и частичным обучением (Semi-Supervised Learning).

Ребенок живет в мире громадного числа объектов, которые он сначала не может классифицировать (непомеченная выборка). Мы ему показываем 2-3 раза ложку, и он скоро обучается понятию "ложка". При этом, конечно, не надо ребенку показывать миллион ложек и миллион не-ложек, как это делается в простом подходе к обучению с учителем.

Так что мое мнение, что мы еще очень много для SSL можем почерпнуть из наблюдений за детьми. И также мне кажется, ребенок может прийти к какому-то понятию и без отрицательных примеров (решая задачу одноклассовой классификации).

rocknrollnerd

14.03.2016 10:55Да, суть примерно в этом) Суровые психологи называют это fast mapping, кажется.

Aracon

13.03.2016 16:34+1"Это собачка. А это кто? — Соба!!! — Нет, это киса!" — Обучаем-то классификации на несколько классов, а не на два (собачки и не собачки). Так же и в машинном обучении показывали бы примеры разных классов и требовали соответствующий сигнал на выходе. Так что не вижу особых отличий.

ServPonomarev

13.03.2016 07:52+1Я бы сказал, что машинное обучение, в его современной ипостаси глубоких сетей — моделирует на приемлемом уровне только работу неокортекса (коры). А неокортекс — это по сути гигантский фильтр, пропускающий сквозь себя только важные для выживания сигналы, отсеивающий все остальные.

Что важно в человеческом сознании, и что пока никак не получается промоделировать? Эмпатия. Возможность построить в себе модель другого человека и спрогнозировать его реакции на собственные действия. Такого нет даже близко. Впрочем, как и возможности построить модель окружающей среды (для прогона вариантов своих действий и выбора приемлемого варианта). А такие модели постоянно строят животные.

При этом, механизм эмпатии — вещь не выучаемая, а наследственная.

father_gorry

13.03.2016 15:29+1> Способность же объяснить почему именно так работает алгоритм вторично, как для человека, так и для машины

А это неправда. Способность выявлять закономерности (низший уровень мышления) имел и первобытный человек. Способность их анализировать, создавать и тестировать модели, породила науку, которая и создала практически весь современный мир, в котором мы с вами находимся. В том числе и модели, по которым вы обучаете свои программы.

zim32

13.03.2016 18:11+1Может я чего не понимаю, но как можно сравнивать запрограммированный заранее пусть и очень хороший классификатор с мозгом? Мозг — результат постоянной адаптации нервной системы на протяжении миллионов лет, к постоянно меняющимя внешним условиям и его задачи выходят далеко за примитивое сегментирование изображений и прочие ноухау современных систем анализа данных.

ИИ выиграл в го!!! Да это революция, это впервые, но при чем тут интеллект. Это хорошо натренированная система рефлексов не более того.

ivankomarov

14.03.2016 08:57+1В том то и суть парадигмы машинного обучения, что программа меняется в зависимости от внешних условий. Сама.

Действительно, пока даже ребёнок бьёт машину в примитивном распознавании. Но, может быть, это потому, что алгоритм плох? Прогресс алгоритмов показывает, что это, по видимому, так.

Чтобы сравнивать искусственный интеллект с биологическим, хорошо бы определиться, что значит последний. Но это тяжело. Самое простое, устоявшееся, определение — это когда машина не отличима от человека в его делах. Думаю, что все больше областей человеческой деятельности попадает под "неотличимо" (а часто просто хуже).

zim32

14.03.2016 11:42-1Ну т.е. по этой логике калькулятор который считает лучше человека, можно относить уже к ИИ?

ivankomarov

14.03.2016 12:23Не знаю. Скорее нет, т.к. только частью является.

Собственно "на калькуляторе" и считается основной объем вычислений для машинного обучения. Здесь смысл, который я хотел донести, идет от Мински — совокупность неразумных агентов вместе составляют ИИ.

Danov

Кто-то из современных великих (академиков?) сказал, что мозг это очень сложная система и его работу можно описать ЛЮБОЙ моделью. И от каждого описания может быть некая польза. Вот вы описали с точки зрения машинного обучения. В целом, интересно. Важно не останавливаться только на этом представлении. Есть еще много других. Например, включающие эмоциональные проявления.