В 1980-х годах американский философ Джон Серль решил опровергнуть предположение о том, что компьютеры или другие виды искусственного интеллекта могут думать и понимать, и предложил для этого мысленный эксперимент, ставший известным под названием “Китайская комната”.

В 1980-х годах американский философ Джон Серль решил опровергнуть предположение о том, что компьютеры или другие виды искусственного интеллекта могут думать и понимать, и предложил для этого мысленный эксперимент, ставший известным под названием “Китайская комната”.В июне 2015 в рамках конкурса виртуальных роботов компания Наносемантика и Фонд Сколково планируют показать доступные в России технологии искусственного разума, при этом они практически воспроизведут эксперимент Джона Серля.

О китайской комнате

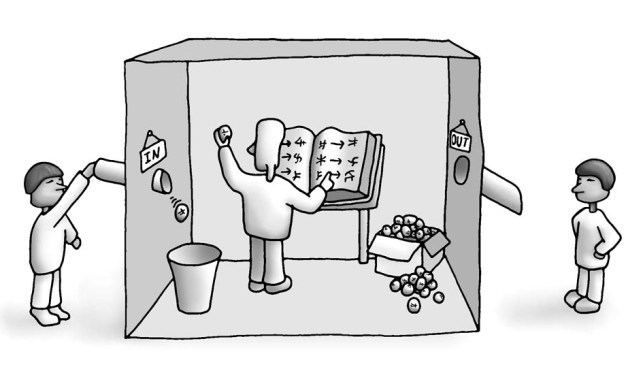

Критика Серля была направлена на тест Тьюринга. Джон Серль предлагал представить человека, не говорящего на китайском языке и запертого в комнате, в которой есть небольшая щель для писем. У человека есть корзины с китайскими иероглифами и учебник с инструкциями на известном ему языке, который поможет перевести с китайского. Через щель в двери ему передают листки бумаги с набором китайских иероглифов. Мужчина может использовать учебник, чтобы перевести фразы и отправить ответ на китайском языке.

Хотя сам человек ни слова не говорит на китайском (а каком интеллекте может идти речь?!), он может убедить находящихся снаружи, что в совершенстве владеет китайским.

О конкурсе чатботов

В конкурсе у роботов будет задача убедить судей в том, что они могут говорить на русском языке. В китайской комнате по-русски судьи будут общаться с роботом в текстовом чате в течение 3 минут. Вместо китайских иероглифов у робота будут слова русского языка, а вместо инструкций на английском языке — специальные правила, описанные создателями чатботов. Судьи должны будут оценить, насколько ответы робота похожи на человеческие.

В конкурсе будут участвовать только роботы, созданные на базе одной и той же технологии. Эта технология предполагает описание множества шаблонов, с которыми сравниваются реплики собеседников, и соответствующих вариантов реакции, которые робот возвращает в качестве ответов. Такой подход не подразумевает самостоятельное обучение робота в процессе разговора. Искусственный интеллект в данном случае не анализирует семантику текстов, а действует как человек из китайской комнаты.

О шаблонах

Подход к созданию искусственного интеллекта на основе шаблонов имеет очевидное преимущество (по сравнению, например, с чатботами на нейронных сетях): он прост для понимания создателями роботов, которые достаточно быстро могут создать собственного чатбота, способного в течение ограниченного времени имитировать осмысленный диалог.

Ниже пример шаблонов на вопрос об имени матери робота

*{как/каг}* {зову~/заву~/называ~/зват~} {твою/тфаю/тваю/тфою} {маму~/мать/мамк~} *

*{маму~/мать/мамк~} *{твою/тфаю/тваю/тфою} *{как/каг}* {зову~/заву~/называ~/зват~}*

* {зову~/заву~/называ~/зват~}*{твою/тфаю/тваю/тфою} *{маму~/мать/мамк~} *{как/каг}*

*{маму~/мать/мамк~} *{твою/тфаю/тваю/тфою} *{как/каг}* {зову~/заву~/называ~/зват~}*

* {зову~/заву~/называ~/зват~}*{твою/тфаю/тваю/тфою} *{маму~/мать/мамк~} *{как/каг}*

Пообщаться с одним из конкурсных роботов, в активе которого примерно 1 000 шаблонов, можно, пройдя по этой ссылке (до 20 мая 2015 включительно).

Ниже пример диалога с данным роботом

Робот: я Соня Гусева, здравствуйте!

Гость: Привет

Робот: можно вас спросить кое-что?

Гость: Конечно, спрашивай

Робот: кто вы по знаку зодиака?

Гость: Я — Скорпион, а ты?

Робот: я дева

Гость: Когда ты родилась?

Робот: в 2002

Гость: Очень интересно! На како языке ты написана?

Робот: почему вас это интересует?

Гость: Потому что я программист, и хочу развиваться в этой области

Робот: это настоящая причина?

Гость: Да

Робот: что ж, ок :)))

Гость: Почему ты не ответила?

Робот: просто так :)))

Гость: Ты наверное не понимаешь, о чём я говорю

Робот: а вы меня понимаете?

Гость: Привет

Робот: можно вас спросить кое-что?

Гость: Конечно, спрашивай

Робот: кто вы по знаку зодиака?

Гость: Я — Скорпион, а ты?

Робот: я дева

Гость: Когда ты родилась?

Робот: в 2002

Гость: Очень интересно! На како языке ты написана?

Робот: почему вас это интересует?

Гость: Потому что я программист, и хочу развиваться в этой области

Робот: это настоящая причина?

Гость: Да

Робот: что ж, ок :)))

Гость: Почему ты не ответила?

Робот: просто так :)))

Гость: Ты наверное не понимаешь, о чём я говорю

Робот: а вы меня понимаете?

Способность поддержать короткий диалог на английском языке ранее продемонстрировал робот Евгений Густман, который, оперируя примерно 3 000 шаблонов, заставил около трети судей теста Тьюринга думать, что они общаются с живым человеком. Базы знаний некоторых современных чатботов, способных общаться на широкий круг тем, содержит в себе более 10 000 правил.

Роботы Наносемантики (инфы), построенные на «шаблонном мышлении», ранее уже общались в ICQ, при этом средняя длина разговора человека с инфом составляла несколько сотен реплик. Но, как и утверждал Джон Серль, продолжительные диалоги не доказывают возможность компьютерных программ думать и понимать.

MaximChistov

Какая чушь. Весь смысл именно в том, что нет никакого перевода, и такой «переводчик» вообще ничего в переводимом не понимает.

Представим себе, что находящиеся за дверью комнаты люди, понимающие китайский язык, передают в комнату наборы символов и что в ответ я манипулирую символами согласно правилам и передаю обратно другие наборы символов. В данном случае книга правил есть не что иное, как «компьютерная программа». Люди, написавшие её, — «программисты», а я играю роль «компьютера». Корзинки, наполненные символами, — это «база данных»; наборы символов, передаваемых в комнату, это «вопросы», а наборы, выходящие из комнаты, это «ответы».

Предположим далее, что книга правил написана так, что мои «ответы» на «вопросы» не отличаются от ответов человека, свободно владеющего китайским языком. Например, люди, находящиеся снаружи, могут передать непонятные мне символы, означающие; «Какой цвет вам больше всего нравится?» В ответ, выполнив предписанные правилами манипуляции, я выдам символы мне также непонятные и означающие, что мой любимый цвет синий, но мне также очень нравится зелёный. Таким образом, я выдержу тест Тьюринга на понимание китайского языка. Но всё же на самом деле я не понимаю ни слова по-китайски. К тому же я никак не могу научиться этому языку в рассматриваемой системе, поскольку не существует никакого способа, с помощью которого я мог бы узнать смысл хотя бы одного символа. Подобно компьютеру, я манипулирую символами, но не могу придать им какого бы то ни было смысла. Этот пример соответствует системе быстрого обучения формальным знаниям для решения типовых задач, которая сегодня стала вытеснять в коммерческих школах аналитическую систему образования. Такие специалисты с программным мышлением способны быстро, не раздумывая, решать задачи из заученного набора, но абсолютно беспомощны в нестандартной ситуации. Аналитическое мышление, используя собственные знания, может путем сопоставления комбинаций символов и анализа порядка в передаваемых сообщениях для ответа, определить устойчивые сценарии их применения, а значит построить классификатор условных понятий и форм применения. Полученную формальную систему можно согласовать с собственной системой знаний, по принципу непротиворечивости перевода высказываний на обоих языках в общем пространстве мышления. В результате мы получим однозначное относительное представление о неизвестном языке, но конкретные характеристики объектов в этом языке останутся неопределенными. Внести определенность можно только калибровочными тестами сличения базовых элементов обеих систем для установления функции их отображения. К этому типу задач относится также установление контакта с разумом иной формы жизни, развившейся в принципиально других физических условиях.

qw1

Я в рассуждениях Серля вижу логическую ошибку.

Он рассматривает «понимающую» систему — человек + книга правил.

Понимание по Серлю должно быть в каком-то одном элементе, т.е. если убрать второй элемент, понимание должно остаться.

Но почему он это постулирует? Почему понимание не может возникать только в связке: правила + интерпретатор.

artemonster

может. это вы просто не правильно поняли. Человек с книгой там для наглядности — вместо них может быть программа + процессор.

Bronx

В данном случае книга — это программа, а человек — это процессор. Ну и что? Всё рассуждение Сёрля построено на том, что, мол, система «книга-человек» («программа-процессор») слишком детерминистична, чтобы назвать её «понимающей», и она не сможет найти выход из нестандартной ситуации. Но тест Тьюринга проводится людьми, и они, будучи нестандартными и понимающими, могут задавать нестандартные вопросы, создавая нестандартные ситуации. Если система пройдёт тест, значит она таки способна реагировать нестандартно, и значит у неё есть настоящее понимание. То, что человек-процессор на самом деле ничего не понимает, означает лишь то, что понимание — в книге-программе.

artemonster

Что такое «недастандартная ситуация»? Елси сделать книгу достаточно сложной, в которой будет описана любая возможная ситуация поведения взаимодействия двух людей в разговоре, то отличить «говорящую книгу» от человека будет невозможно.

Bronx

Это будет означать, что эта книга в бесконечное число раз круче человека в плане понимания. Фактически, всезнающий бог. Потому что для кодирования всех возможных ситуаций нужно бесконечное количество информации.

> Что такое «недастандартная ситуация»?

То же самое, что подразумевает сам Сёрль в цитате, приведённой в первом комменте:

«Подобно компьютеру, я манипулирую символами, но не могу придать им какого бы то ни было смысла. Этот пример соответствует системе быстрого обучения формальным знаниям для решения типовых задач, которая сегодня стала вытеснять в коммерческих школах аналитическую систему образования. Такие специалисты с программным мышлением способны быстро, не раздумывая, решать задачи из заученного набора, но абсолютно беспомощны в нестандартной ситуации.»

Говоря проще, ситуация, которая развивается по пути, ещё не имеющем формального описания. Конечно, в системе, в которой описано всё на свете, таких ситуаций нет — вот только нет таких систем.

qw1

Я ещё подумал и пришла такая мысль, что Серль как гуманитарий хотел дать эмоциональный аргумент: мол, посмотрите, как это скучно — переписывание цифр между книгами, когда сознание человека намного интереснее и живее.

Это могло бы сработать, но не с современными людьми. Мы видели живые и красивые современные игры, в которых десятки персонажей существуют в меняющемся окружении — ветер, дождь, песок, лучи света. И подумать только, это всё гигантская машина Тьюринга, методично перемещающая карандаш над лентой, каждый шаг переписывая не более одной цифры. Удивительно? Но ведь факт.

Или взять генетический код. Всего 4 основания — A,T,G,C — а какой разнообразие.

Нет, эмоциональный аргумент не работает после того, что мы видели. Мелкие однотипные скучные кирпичики могут формировать нечто великое.

Aingis

Писал такого бота на ирке. По правилам похожим на регулярки, реагирующим на ключивые слова, вопросы и тому подобное. Было смешно, когда кто-то долго говорил с таким ботом.