В марте 2016 года один из сильнейших из людей игроков в го впервые проиграл компьютерной системе, играя без форы. До этого момента лучшем достижением считали выигрыш при 4 камнях форы, а игра на равных была ещё далеко — возможно, где-то в следующем десятилетии. Внезапно на сцене появилась система AlphaGo от британской DeepMind, которая со счётом 4:1 обыграла одного из самых известных игроков последних лет Ли Седоля.

В марте 2016 года один из сильнейших из людей игроков в го впервые проиграл компьютерной системе, играя без форы. До этого момента лучшем достижением считали выигрыш при 4 камнях форы, а игра на равных была ещё далеко — возможно, где-то в следующем десятилетии. Внезапно на сцене появилась система AlphaGo от британской DeepMind, которая со счётом 4:1 обыграла одного из самых известных игроков последних лет Ли Седоля.Год назад южнокорейский игрок 9-го профессионального дана проиграл компьютерной системе подразделения Google, и в восприятии многих го перешла в разряд игры, в которую машины играют сильнее лучших из людей. Больше AlphaGo почти никак не «светилась». В апреле этого года DeepMind разразилась объявлением: AlphaGo сыграет с игроком первой строчки рейтингов Кэ Цзе. Сам он сообщал о намерении сыграть против ИИ ещё летом прошлого года, но лишь в этом году была объявлена точная дата матча. DeepMind пообещала, что программа дополнительно сыграет против сразу пяти мастеров.

Игры прошли в запланированные дни, и их результат окончательно показал, что уровень AlphaGo значительно выше человеческого. Та четвёртая игра матча Ли Седоль — AlphaGo, наверное, останется последней победой человека над этим ИИ: по завершении игр разработчики заявили об уходе системы из го.

Мы обсудили с двумя профессиональными игроками уровень этой версии программы, а также будущее отношений человека и систем компьютерного го.

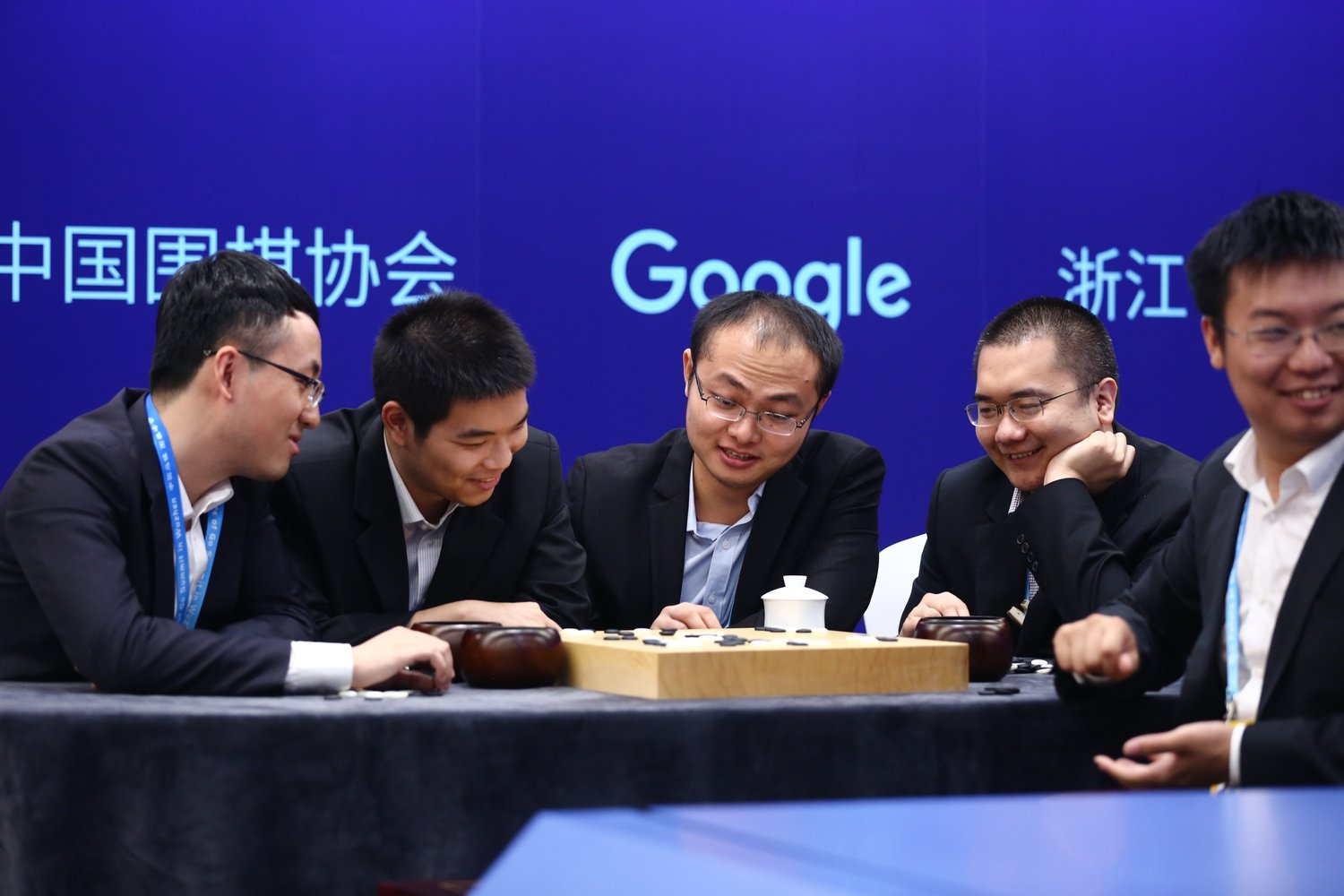

На фото: почти готовые признать поражение пять мастеров го недоумевают — система AlphaGo, их оппонент, начала играть лениво, словно предчувствуя победу.

Зачем американской компании азиатская настольная игра?

Google с гордостью демонстрирует достижения британского подразделения DeepMind. Эту компанию поисковик купил в 2014 году за полмиллиарда долларов США. Направление деятельности DeepMind Technologies Limited — системы искусственного интеллекта: специалисты используют машинное обучение для создания алгоритмов, которые, к примеру, сами в совершенстве овладевают видеоиграми. Деятельность продуктов не ограничивается аркадной классикой Atari 2600 — DeepMind пытается применять свои системы для анализа медицинских данных.

Впрочем, весь бизнес Google в той или иной степени построен на умных системах. В 2016 году 88 % выручки холдинга Alphabet обеспечила реклама. Это Google AdWords, видеореклама на YouTube и прочие инструменты. Для контекстной рекламы важно правильно угадать интересы пользователя, поэтому интернет-гигант собирает огромные объёмы данных о пользователях и анализирует их. Проектов с зачатками ИИ много: голосовой помощник в Android и колонке Home, алгоритмы камеры последнего смартфона Pixel, нейронный перевод Google Translate, машинное зрение робомобилей Waymo. Даже клавиатура в смартфоне может претендовать на звание «умная».

AlphaGo можно назвать демонстрацией могущества ИИ-начинаний внутри поисковика. Неудивительно, что матчи проводят заметно. В прошлый раз игры проходили в гостинице Four Seasons в Сеуле. На этот раз Google совместно с Китайской ассоциацией вэйци и местным бюро спорта организовала Future of Go Summit (Саммит «Будущее го») в городе Вужене в провинции Чжэцзян. Это довольно значительное сотрудничество с китайскими властями, если учесть, что сервисы Google заблокированы на территории материкового Китая. Увеличились ставки на выигрыш: Ли Седоль мог получить в случае победы миллион долларов, Кэ Цзе обещали полтора.

Noah Sheldon, Wired

Подготовка

20 лет назад Каспаров впервые проиграл шахматному компьютеру Deep Blue. Через десятилетие превосходство компьютерного алгоритма над человеком в шахматах уже не вызывало вопросов. Почему же азиатскую игру компьютеры не покорили раньше?

Внешне го проще: два игрока пытаются отгородить на доске область большего, чем оппонент, размера, размещая камни двух цветов. Но на стандартной доске 19?19 возможных позиций камней в гугол (10100) раз больше, чем позиций фигур на шахматной доске. Это уже ставит крест на возможностях перебора «в лоб».

Ходов в партии го больше, чем в шахматах, а вскоре после начала игры приходится учитывать почти все из 361 точек на доске. Начальные ходы — фусэки — быстро начинают уходить в что-то оригинальное. В шахматах фигуры убывают с доски, в го камни добавляются. Невозможно применить многие из алгоритмов, которые характерны для шахматных систем. До AlphaGo лучшие из систем использовали экспертные базы с хорошими ходами, оценку ходов с помощью поиска по дереву или метода Монте-Карло, но даже они могли обыграть лишь любителя, но не профессионала.

В DeepMind улучшили существующий подход. К методу Монте-Карло добавились нейросети политики и ценности, которые натренировали на 160 тыс. партий с сервера KGS, а затем в играх системы против самой себя. Получившийся продукт сначала сравнили с другими компьютерными системами, затем человеком — с одной из ранних версий AlphaGo играл трёхкратный европейский чемпион Фань Хуэй. Человек проиграл пять из пяти игр.

И это было лишь начало испытания ИИ против человека. В Европе уровень владения го ниже, чем в Азии, на родине игры. Поэтому лишь после победы над известным корейским Ли Седолем AlphaGo можно было признать системой, играющей лучше человека.

В чём-то Future of Go Summit напоминал события 20-летней давности. IBM выставила против человека специализированный шахматный компьютер, а Google демонстрировала не только силу программного обеспечения, но и специализированный модуль для машинного обучения Tensor Processing Unit (TPU).

Свёрточные нейронные сети — это, как правило, вычисления на графических ускорителях: подключаемых по шине PCIe видеокартах, обычно предназначенных для обсчёта и вывода на экран графики в играх. Особенности архитектуры видеокарт — сотни и тысячи ядер на чипе — помогают в хорошо распараллеленных задачах, а вот центральные процессоры для таких задач подходят хуже. Как AMD, так и Nvidia выпускают специализированные профессиональные «числодробилки», подтягивается Intel с линейкой сопроцессоров Xeon Phi.

Одна из версий TPU.

Google утверждает, что создала микросхему специализированного назначения (ASIC), на которой можно создать значительно более мощную архитектуру нейросетей. В задачах машинного обучения TPU может превосходить традиционные видеоускорители и центральные процессоры в 70 раз, в 196 раз — по количеству вычислений на ватт.

В марте прошлого года против Ли Седоля играл целый вычислительный кластер. Накануне и во время игры СМИ повторяли, что это были 1920 процессорных ядер и 280 видеоускорителей. Проверить, что там на самом деле, было, конечно, невозможно — AlphaGo запускалась в облаке Google, а в отель Four Seasons проложили оптоволокно для связи. Лишь в мае 2016 года Google призналась, что уже больше года использует TPU в дата-центрах. Секретным соусом версии AlphaGo Lee оказались 50 плат TPU.

Серверы, обыгравшие корейского мастера 9-го дана.

Против Кэ Цзе выставили одну машину с всего одним модулем TPU. Было ли Цзе легче?

Игра первая

Reutersz/Stringer, Quartz

Запись трансляции на английском языке

Запись трансляции с комментариями на русском языке (Илья Шикшин и Ксения Лифанова)

Ходы игры

В период после 29 декабря 2016 года на корейском сервере Tygem и китайском Fox появился неожиданно сильный игрок. Он называл себя Magister или Magist, затем сменил ник на Master и продолжил сокрушать оппонентов. Профессионал 9-го дана Гу Ли назначил награду в 100 тысяч юаней (порядка 14,4 тыс. $) тому, кто обыграет Master. Но неведомый игрок не знал поражений: подряд выиграл 60 партий у профессиональных игроков высокого уровня. Как китайские, так и корейские разработчики ИИ стремились повторить и превзойти успех AlphaGo, возможно, это их попытки?

4 января 2017 года глава DeepMind Демис Хассабис признался, что Magister или Master — это тестовая версия AlphaGo, которую испытывали в неофициальных онлайн-поединках. Хассабис поблагодарил всех участвовавших в тесте. Интересно, что уже тогда Кэ Цзе проиграл AlphaGo три игры.

Игравшая в новогодние дни версия AlphaGo запускалась на одной машине, в компьютере установили всего одну плату TPU. 23 мая против Кэ Цзе выставили примерно ту же конфигурацию. Она «думала» на 50 ходов вперёд и успевала рассмотреть 100 тыс. ходов в секунду.

23 мая, в первой игре, Цзе выбрал чёрные камни, что в го означает ход первым. Он начал игру необычно, подсмотренной стратегий AlphaGo матчей января. Комментаторы обращали внимание, что Цзе заимствует стратегии Master и в обычных играх против людей — те 60 матчей оказали широкое влияние на мир го. Система AlphaGo отвечала уверенно и управилась быстрее, чем ожидалось. Через три с половиной часа комментаторы заговорили, что у Кэ Цзе мало шансов отыграться. Через час человек признал поражение. AlphaGo выиграла с преимуществом в всего пол-очка.

AlphaGo продолжала играть сама с собой и учиться. Как утверждают в DeepMind, версия для игры в Ли Седолем была на три камня (для игры на равных нужно было бы три камня форы) сильнее версии для игры с Фань Хуэем, версия AlphaGo Master — на три камня сильнее AlphaGo Lee.

Уже после первой игры Цзе заявил, что никогда больше не будет играть против машины в одиночку, что будущее принадлежит ИИ. В письме «Последняя битва» 19-летний чемпион признал, что бездушная компьютерная система может быть умнее его, но он не будет сдаваться.

Пытался ли Кэ Цзе играть как-то по-особенному против компьютера? Как утверждает семикратный чемпион Европы Александр Динерштейн (3 профессиональный дан, 7 дан EGF), эти попытки не принесли успеха:

«Как и Ли Седоль в первой партии матча, Ке пробовал играть нестандартно в дебюте, так, чтобы компьютер думал самостоятельно. Но отличие го от шахмат в том, что в шахматах дебюты разработаны на десятки ходов вперед, а в го уже первыми ходами можно получить полностью уникальную позицию, которая ранее не встречалась на практике. В шахматах мы называем это «неправильные дебюты» и стараемся наказать соперника за нешаблонную игру. А в го выигрывает не тот, у кого лучше память, а тот, кто лучше понимает игру.»

Обладатель 1 профессионального дана и 7 дана EGF Илья Шикшин считает, что в первой игре Кэ Цзе ожидал «человеческий» стиль оппонента:

«В первой партии Кэ Цзе пытался играть как с человеком. В результате достаточно быстро обнаружилось, что Кэ отстает, и шансов отыграться у него нет. Во второй и третьей партиях Кэ пытался максимально усложнить ситуацию на доске, чтобы запутать программу. Однако спровоцировать AlphaGo на ошибку так и не получилось.»

Игра вторая

Запись трансляции на английском языке

Запись трансляции с комментариями на русском языке (Илья Шикшин и Тимур Санкин)

Ходы игры

Кэ Цзе занимает первую строчку нескольких рейтингов, к примеру, Go Ratings. Естественно, положение обязывает стать эдаким бенчмарком производительности систем компьютерного го. Чтобы показать, может ли машина играть сильнее человечества, достаточно выиграть у сильнейшего из них. Это и нужно было сделать AlphaGo в трёх играх, чтобы навсегда войти в историю. До Future of Go Summit в неофициальных играх Цзе проигрывал несколько игр подряд как самой AlphaGo, так и другому, менее известному алгоритму.

В марте этого года программа FineArt заняла первое место в 10-м Чемпионате систем компьютерного го Университета электрокоммуникаций в Японии (Computer Go UEC Cup). Она одержала победу во всех 11 играх против других программ и обошла такие известные алгоритмы, как французский CrazyStone, Darkforest от Facebook и японский Deep Zen Go. Затем FineArt сразилась против игрока 7 профессионального дана Итирики Рё. Программа играла на равных, без камней форы, и победила.

Стоит заметить, что AlphaGo обходит стороной подобные соревнования компьютерных систем. Видимо, в DeepMind предпочитают пышные мероприятия с играми против самых именитых игроков, а оценку продукта против других программ оставляют внутренним тестам.

FineArt — разработка лаборатории ИИ китайского телекоммуникационного гиганта Tencent, известного множеством веб-порталов, мессенджером QQ.com и WeChat, платёжными инструментами TenPay и другими продуктами. Tencent начала разработку FineArt в марте 2016 года, как раз накануне знакового матча AlphaGo — Ли Седоль. FineArt работает похожим на AlphaGo образом: это всё те же натренированные на больших датасетах и играх против самих себя нейросети политики и ценности, которые DeepMind описала в научной работе, выпущенной при первых публикациях об AlphaGo. Первые версии компьютерной системы от Tencent начинали играть на китайском сервере Fox под разными псевдонимами, пока не было выбрано имя FineArt или ?? — фраза из древнего китайского стихотворения.

Впервые на foxwq.com против FineArt Кэ Цзе играл ещё в прошлом ноябре. Тогда человек победил и проиграл. Обновлённая версия FineArt от февраля 2017 года не оставила ему шансов: Цзе проиграл 10 раз подряд.

25 мая состоялась вторая игра поединка Кэ Цзе и AlphaGo. На этот раз компьютер играл чёрными камнями и ходил первым, что, как говорят в DeepMind даёт небольшое преимущество оппоненту-человеку в силу особенностей системы. Цзе известен хорошим навыком игры белыми камнями. Но всё равно немалую часть игры он провёл в сильном напряжении: Цзе сжимал пряди своих волос между большим и указательным пальцем. Позднее в пресс-конференции он сравнил AlphaGo с игроком-богом.

Человек делал мудрые решения в первую половину матча. Хассабис писал в своём микроблоге, что согласно оценкам AlphaGo, Цзе играл идеально. В пресс-конференции после игры он рассказал, что видел шанс на победу. Но во второй половине он начал сдавать позиции. К третьему часу игры Цзе использовал примерно в два раза больше игрового времени, чем AlphaGo. К четвёртому часу AlphaGo упростила сложные позиции, которые создал человек в начале игры, что комментаторы расценили как дурной знак для Цзе. Через 15 минут он признал поражение.

Два поражения Кэ Цзе — это победа AlphaGo в серии из трёх игр, третья встреча могла лишь показать, насколько человек сильнее, чем машина. Что интересно, в стране проведения матча освещение СМИ было на уровне фактической цензуры. За два дня до первой игры испарились представители государственного телевидения, во время игр в Китае доступных трансляций не было. Единственная видеотрансляция на китайском языке шла на YouTube, заблокированном на территории Китая. Если местные СМИ и рассказывали об играх против ИИ, то они избегали упоминания слова «Google».

Игра третья

В рамках Future of Go Summit искусственный интеллект играл не только против Кэ Цзе. 26 мая AlphaGo утром помогала двум мастерам сразиться друг с другом, после полудня — играла против группы людей. Видимо, первым Google хочет намекнуть, насколько сильно машинное обучение поможет людям, вторым — насколько ИИ может быть умнее человечества.

Гу Ли во время парной игры, Google

Запись видеотрансляции на английском языке

Ходы парной игры

Правила парного го подразумевают, что вместо двух человек камни на доске поочерёдно расставляют четыре, при этом переговоры между членами каждой из команд запрещены. В данном случае каждая из команд состояла из человека и компьютера. Вначале ходил Гу Ли (9-й профессиональный дан) за чёрных, затем Лянь Сяо (8-й профессиональный дан). После этого один раз ходили их помощники — идентичные версии AlphaGo. Цикл повторялся. В этой игре победу одержали чёрные.

Пять игроков, которые сразились против AlphaGo. Слева направо: Си Юэ, Ми Ютин, Тан Вэйсин, Чэнь Яое, Чжоу Жуйян, Google

Ходы командной игры

В командном го пять мастеров 9-го профессионального дана расставляли на доске чёрные камни, их оппонент — одна копия AlphaGo — белые. Игрокам-людям разрешалось совещаться друг с другом и обсуждать ходы, и команда играла с заметным удовольствием, пусть и сохраняя сбалансированный стиль игры. AlphaGo победила и здесь.

Запись трансляции на английском языке

Запись трансляции с комментариями на русском языке (Илья Шикшин)

Ходы третьей игры

Последняя игра с Кэ Цзе прошла 27 мая. AlphaGo вновь играла чёрными камнями. И вновь на доске были показаны несколько удивительных комбинаций камней. К примеру, AlphaGo сделала необычный седьмой ход. Несмотря на все старания Кэ Цзе, через три с половиной часа ему пришлось признать поражение и в заключительной игре.

Будущее AlphaGo

Ни один человек, ни целая группа из пяти мастеров не смогли обыграть новую версию ИИ. Очевидно, это уже не та программа, которую DeepMind показала в марте 2016 года. Александр Динерштейн так характеризует изменения системы:

«Она стала ещё менее прогнозируемой. Причина здесь в том, что прошлая версия училась на партиях людей, а нынешняя — на партиях AlphaGo с AlphaGo. Она играла сама с собой миллионы раз, делая выводы и учась на своих ошибках. И если в шахматных программах заложены базы человеческих партий, которые приносят компьютеру пользу (Крамник, к примеру, настаивал на том, чтобы компьютер не пользовался ими в матче), то AlphaGo плевать хотела на всё, что мы когда-либо изобрели в го. Ей не нужны наши дебютные разработки. От людей она переняла лишь правила го. Всё остальное — её собственный опыт.»

В ответе на этот же вопрос Илья Шикшин замечает, что поменялась в большей степени эффективность:

«Если версию AlphaGo, игравшую с Ли Седолем, казалось, что можно победить при безошибочной игре, то нынешнюю версию AlphaGo человек победить уже не может. Стиль игры у AlphaGo в принципе не поменялся — это брать от позиции максимум. Только теперь программа делает это ещё эффективнее.»

Возможно ли, что на свете живёт ещё один человек — не обязательно кто-то конкретный, — который может обыграть AlphaGo? Как говорит, Динерштейн, перевес на стороне машины:

«AlphaGo уже не та, что мы видели в матче с Ли Седолем. Её создатели говорят, что она стала играть на 3 камня сильнее. По шахматным меркам это может означать фору в коня. И если с прошлой версией еще можно было бороться, то теперь вопрос закрыт. В мире нет человека, который способен одолеть AlphaGo в партии на равных.»

Илья Шикшин считает, что шансы были, но ИИ быстро улучшает свой уровень:

«Возможно, текущую версию AlphaGo, игравшую с Кэ Цзе, и мог бы обыграть кто-то из людей. Но надо понимать, что это далеко не предельный уровень программы. Прошлогодняя версия AlphaGo, игравшая с Ли Седолем, была существенно слабее нынешней. А о том, в какую силу программы будут играть через год, можно только догадываться.»

По мнению Динерштейна, Кэ Цзе сам не допускал значительных ошибок со своей стороны:

«Кэ пытался найти слабости в игре программы. Играл не так, как он обычно играет с людьми. Обострял, боролся. Он сделал всё что мог, но шансов во всех 3 партиях у него не было. Средняя партия в го длится 250 ходов. Здесь же к 50-му ходу AlphaGo получала подавляющий перевес, и дальше её задачей было его удержание. Программа очень хорошо умеет это делать — она выбирает ходы, которые увеличивают вероятность победы, а люди зачастую напоминают раджу из мультфильма «Золотая антилопа» — они хотят увеличить свой перевес, выиграть не одно очко, а десять. Эта жадность часто приводит к катастрофе.»

При этом ИИ AlphaGo Master, с которой сразился Кэ Цзе, играет без ошибок, утверждает Динерштейн:

«В матче с Ли Седолем эксперты находили ошибки программы. Здесь же даже лучшие мастера мира говорят, что не видят их. Думаю, что с AlphaGo вопрос окончательно закрыт. Ли Седоль был последним человеком на земле, кто обыграл эту программу. Если игру Кэ еще можно было как-то улучшить, то игра компьютера с нашей точки зрения была близка к идеальной.»

Похожее мнение высказал Илья Шикшин:

Я не считаю, что Кэ Цзе допускал серьёзные ошибки. Считать, что были ошибки — все равно что считать, что у Кэ Цзе были шансы. Но шансов не было. AlphaGo играет на уровень сильнее.

Наверное, самая мощная система компьютерного го уходит — её не будут продавать как коммерческий продукт, она больше не будет пытаться доказать своё превосходство. В посте «Следующий ход AlphaGo» DeepMind объяснила, что команда разработчиков проекта будет распущена — специалисты займутся другими проблемами, которые можно решить машинным обучением: диагностированием болезней и поиском методов их лечения, улучшением эффективности энергопотребления и изобретением новых материалов. А вот AlphaGo участвовать в матчах больше не будет.

Две официальных игры со значительным вниманием СМИ — и резкий отказ от дальнейшего развития. Можно обвинить Google в том, что за счёт го компания хвасталась своими наработками ИИ. Но DeepMind заметно старается помочь сообществу игры: подразделение обещает опубликовать научную работу, где объясняются все изменения, которые были внесены в AlphaGo. И вот уже с этими данными другие разработчики смогут создать или улучшить собственные системы, намекают в DeepMind. Видимо, Google не интересует создание игрового ИИ как коммерческого продукта. DeepMind также собирается выпустить инструмент для анализа позиций, с помощью которого игрок сможет увидеть, как думает AlphaGo.

Кроме обещаний компания оставила подарок в виде 50 игр AlphaGo против самой себя. Как замечает Илья Шикшин, «из этих 50 партий могут получиться 50 учебников». Он говорит, что уровень настолько высок, что потребуется длительный анализ, чтобы разобраться в показанных играх. Александр Динерштейн указывает, что есть проблема копирования стиля ИИ: в дебюте можно играть, как AlphaGo, но что делать потом?

Будущее го

Чтобы одолеть Ли Седоля, понадобился целый вычислительный кластер, для Кэ Цзе — всего одна машина с одним модулем TPU. Всё ближе ситуация, когда мобильная микросхема с крошечным энергопотреблением может превзойти лучших из людей в го.

В шахматах такое уже никого не удивит. Это даже не единичные случаи. К примеру, текущий чемпион мира по шахматам Магнус Карлсен на личном канале YouTube иногда продвигает мобильное приложение своего имени Play Magnus. Приложение базируется на одном из мощнейших шахматных движков Stockfish. Оно намеренно занижает свою производительность и эмулирует уровень владения шахматами Магнуса в разном возрасте.

Неудивительно, что на серьёзных шахматных чемпионатах использование электронных устройств жёстко регулируется. Александр Динерштейн говорит, что в го может произойти что-то похожее:

«Да, наверное, и у нас скоро возникнет проблема с читерством, но пока можно иметь телефон в кармане и не бояться получить за это техническое поражение в турнире. И в Интернете люди играют, и онлайн-турниры с призами проводятся. Видимо причина в том, что самые сильные программы пока недоступны для скачивания.»

Илья Шикшин считает, что введение ограничений возможно:

«Пока что я не слышал о правилах, регулирующих использование гаджетов на соревнованиях по го. Но вероятно, вскоре они появятся.»

Одной научной публикации об AlphaGo в журнале Nature в 2016 году хватило для того, чтобы в 2017 на соревнованиях компьютерных систем го была достигнута игра на равных с профессиональными игроками. Разработчики существующих продуктов копируют подход DeepMind, уровень игры программ растёт. Александр Динерштейн:

«За последний год программы резко усилились. Еще пару лет тому назад, мы легко обыгрывали их на 3-5 камнях форы. Сейчас же непонятно, кто кому должен эту фору давать.»

Если DeepMind действительно поделится данными по улучшению AlphaGo Lee до AlphaGo Master, то, вероятно, компьютерные системы превзойдут человека. Что, если в дальнейшем играть придётся, делая поправку на более слабую белковую команду? Будет ли интересно наблюдать за подобной игрой? Александр Динерштейн:

«Да, скоро мы не сможем играть с программами на равных, но в го игра на форе не менее интересна. Думаю, что нам предстоит увидеть ещё много матчей, где фора будет меняться от партии к партии. У топ-мастеров спрашивали, на какой форе они готовы сыграть с богом, если на кону будет стоять их жизнь. Ответы были разные, но большинство сходится во мнении, что на 4 камнях человек никогда не проиграет. Посмотрим, так ли это. Кстати, Ли Седоль в своем недавнем интервью утверждает, что легко одолеет AlphaGo на 2 камнях форы. Я, правда, в этом сомневаюсь.»

Илья Шикшин:

«Первое время точно будет интересно. Го Сейген — один из сильнейших игроков в го XX века — утверждал, что ему потребовалось бы 5 камней форы, чтобы победить Го-бога (соперника, играющего идеально). Полагаю, что многим игрокам в го интересно было бы проверить, насколько они далеки от Го-бога.»

В любом случае, игроки согласны, что популярность го выросла. Александр Динерштейн:

«Благодаря этим матчам много новых людей узнали о го. Приходит много шахматистов, людей, связанных с программированием. В комментариях к статьям в СМИ перестали спрашивать о том, что это за игра. Люди не просто комментируют новости и сочувствуют мастерам го. Они даже предлагают свои методы борьбы с компьютером. Так, к примеру, кто-то предлагал перейти на игру в «Чапаева».»

Илья Шикшин:

«Появление AlphaGo было закономерным. Рано или поздно это должно было случиться. В этом, конечно, есть как положительные, так и отрицательные стороны. Из положительного — множество людей узнало о го, уровень людей в го может возрасти, благодаря программам. Из отрицательного — множество людей расценивают это как некую потерю, вскоре действительно появятся ограничения на использования гаджетов во время соревнований.»

«Не стоит забывать, что го — это не только спорт. Го — это часть восточной культуры. Го — это искусство, способ самопознания, самовыражения и общения. Состязательная часть — лишь одна из составляющих мира го.»

Будущее ИИ

AlphaGo — это не какой-то прототип «Скайнета» и даже не впечатляющая форма сильного ИИ. Это программа: камни на доске всё так же расставляет оператор. AlphaGo — это узконаправленная система, которая умеет только играть в го. AlphaGo не может ранжировать результаты поисковой выдачи, не умеет играть в старые игры Atari, не узнает человека по лицу, не распознает рак груди по маммографии, не сможет поддержать беседу.

Однако в основе AlphaGo лежат всё те же общие принципы, которые можно использовать в широком круге задач. Это обучение с подкреплением, метод Монте-Карло, функция ценности. Обычные компоненты собраны в новом и не совсем стандартном виде. AlphaGo не уходит работать в какую-то другую структуру холдинга Alphabet. Это в большей степени проявление количества и качества человеческого таланта, доступного для решения неигровых проблем.

С созданием автотранспорта не ушли в небытие ни соревнования по бегу людей, ни скачки лошадей. Зато зародились автогонки — спорт, который имеет своих поклонников. Возможно, в будущем команды, представляющие техногигантов, будут выставлять ботов на соревнования по решению какой-либо задачи — не обязательно только го, — подчиняясь строгим ограничениям. Примерно так же, как в «Формуле-1» характеристики двигателей строго ограничены, можно ввести ограничения и здесь. К примеру, не больше 10 миллиардов транзисторов на вычислительной машине, не более 500 ватт энергопотребления и так далее.

Впрочем, это лишь фантазии. В конкретно данном случае ИИ AlphaGo ни разу не выставляли в соревнованиях против других программ — только против людей или самого себя (парное го в Вужене). Ближайший конкурент AlphaGo — разработанный с теми же принципами FineArt от китайской компании Tencent. Боится ли DeepMind китайской копии? Как говорит Александр Динерштейн, стиль FineArt всё же отличается от AlphaGo:

«Если кто и обыграет AlphaGo — то её компьютерные аналоги. Мы не видели игр AlphaGo против других программ. Возможно, уже сейчас FineArt способна бороться с ней на равных. Что меня удивляет — это различие стилей игры. Казалось бы, одинаковые технологии: нейросеть и Монте-Карло, но при этом игра Deep Zen Go или FineArt похожа на игру топ-профи, а AlphaGo — это совсем другое. Люди никогда так не играли. Как сказал Ши Юэ, один из сильнейших китайцев: «Это игра из будущего». Её невозможно обыграть. Мало того, даже понять ходы не просто. Там встречаются такие ходы, которые люди в принципе не рассматривают как возможные. Если предположить, что именно так и выглядит лучшая стратегия в го, то мы можем смело выкинуть на помойку все те книги, которые издавались за 4000-летнюю историю го.»

Илья Шикшин прямо утверждает, что FineArt уступает AlphaGo:

«Программа FineArt так же, как и другие сильнейшие на сегодняшний день программы, были созданы на основе статьи об AlphaGo, которая вышла в журнале Nature в январе 2016 года. Полагаю, что DeepMind просто не интересно соревноваться с программами, которые появились благодаря их собственным разработкам. AlphaGo играет значительно сильнее FineArt и других программ. FineArt выигрывает, примерно, 7 из 8 партий у сильнейших профессионалов. AlphaGo выигрывает все.»

Ситуация с FineArt и игра AlphaGo в Китае — это в значительной степени иллюстрация меняющегося пейзажа развития систем искусственного интеллекта.

В последние дни в американских изданиях прошла заметная волна публикаций (1, 2, 3) о том, что Китай норовит обогнать США в сфере ИИ. Вероятно, начала её статья в New York Times. Автор пусть и признавал, что Китай находится на шаг позади, но задавался вопросом о скорости сокращения дистанции. На данный момент КНР расходует миллиарды государственных долларов на финансирование стартапов машинного обучения и привлечение учёных из других стран. В статье приведён случай немецкого эксперта робототехники, который отправился не в престижный вуз Европы или США, а в Китай. Его переманили грантом в шесть раз выше, что открыло возможность открыть лабораторию, нанять ассистента и прочий персонал.

Не отстают частные китайские компании. К примеру, местный поисковый гигант Baidu совместно с государством открыл лабораторию, которую возглавляют исследователи, в прошлом занимавшиеся китайскими боевыми роботами. Тот же Baidu работает над беспилотными автомобилями, системами распознавания речи и визуальной информации. Часть разработок превосходит западные аналоги. В октябре 2016 года Microsoft объявила, что её система распознаёт человеческую речь так же хорошо, как и люди. Эндрю Ын, на тот момент ещё работавший в Baidu, заметил, что этот рубеж в Китае прошли ещё в 2015 году.

Как FineArt от Tencent может уступать AlphaGo от Google, так и китайские попытки работать с ИИ могут быть позади американских. Но отставание сокращается. Показательные матчи программы от DeepMind против азиатских мастеров го изменили тон государственных обсуждений о финансировании. Их содержание стало более широким и чётким, заявили NYT китайские профессора.

Потенциал систем искусственного интеллекта замечают, даже попытки догнать вызывают беспокойство. Возможно, это лишь бурное лето перед очередной зимой ИИ. Возможно, это новый этап гонки за мировое технологическое превосходство.

Комментарии (39)

WinPooh73

07.06.2017 22:00+3Если победа в декабре-январе на серверах у всей мировой элиты со счётом 60-0 это "больше никак не светилась"...

Vjatcheslav3345

07.06.2017 23:30Следующей целью игровых программ может стать киберспорт.

Kolegg

08.06.2017 00:39+3Представители гугла еще после матча с Седолем сказали, что следущий шаг — старкрафт. На последнем близконе было анонсирование сотрудничество с близарда с гуглом в этом направлении.

ankh1989

08.06.2017 06:16Таким заявлениям доверять не стоит. Команда АльфаГо наверно хотела бы заняться старкрафтом, но вот десятки больших менеджеров над ними могут решить, что намного выгоднее заняться оптимизацией рекламного движка, чтоб он точнее показывал рекламу.

Vjatcheslav3345

08.06.2017 06:58+3С другой стороны, после покорения игрулек, следующей вершиной может стать архитектура — ведь если подумать, архитектурный проект — тоже есть, также как в го, выбранная комбинация объёмов и пространств (внутреннего пространства жилья или городского района, торгового центра или завода) но правила её выбора — гораздо менее формализуемые и число вариантов опять бесконечно выше, по сравнению с го.

Вот на этом поле было бы интересно потягаться с мировыми мастерами и получить мощный практический выхлоп — это когда каждый человек на Земле может строиться или ремонтироваться по проектам, которые лучше, чем в принципе способен разработать человек...

orcy

08.06.2017 07:18В старкрафт таком боту много можно сделать за счет микроменеджмента (типа управление порядком построения юнитов). Мне кажется было бы честно если бы игрокам можно было бы писать макросы для таких же действий, тогда было бы соревнование стратегий, а не микроконтроля.

ankh1989

08.06.2017 09:45Это просто решается: всё управление только через мышку/клавиатуру либо через программный интерфейс который даёт аналогичную скорость. Интерес ведь не в скорости, а в страгии и тактики в условиях неполной информации (то есть придётся как то моделировать эту недостающую информацию, строить что то вроде графа возможных моделей как в го, находить наилуший «ход» который мксимизирует вероятность выигрыша).

KvanTTT

08.06.2017 11:11+1Насчет микроконтроля уже обсуждалось — достаточно будет ограничить количество действий в секунду и тогда компьютеру придется придерживаться более разумной страгии.

Ну и микроменеджментом не все решается.

Louren325

08.06.2017 11:54Честно говоря — в этом нет смысла.

Как пример могу привести https://www.youtube.com/watch?v=mrbYd4OFrWE. Этим роликом можно начать и закончить разговор о том, что человек может каким-либо образом победить машину без искусственных ограничений. В данном ролике в пике сплита программа показывает ~ 16000 апм'а (Actions per minute — действий в минуту). Самый высокий апм от человека который я видел лично — был ~620-640 в пике от DongRaeGu на каком-то из GSL.

Вот тут есть 2 варианта с реализацией киберспортивного ИИ — отсутствие или наличие ограничений.

1) Нет ограничений. Мы получаем безграничный апм (Старкрафт), мгновенную (в 1 кадр) реакцию (все игры), 100% точность попаданий (Контра/шутеры) или близкую к ним, если оружие снарядное или это скиллшоты(LoL, Dota), идеальное уклонение от скиллшотов (LoL, Dota) и т.д.

2) Ограничения есть. Тогда смысл в этом?

Да, очень много разговоров про «стратегическую часть» и то что «ИИ должен оперировать только данными которые он „видит“ на экране», но… Почти любую игру можно разобрать на паттерны и зачастую они на столько простые, что их можно уложить в примитивное if-then-else — привет кучи ботов, которые зачастую играют лучше большинства игроков (тут я тоже могу привести достаточно примеров).

Как-то так. Война проиграна ещё не начавшись.

unclejocker

08.06.2017 16:59+1Насколько я знаю, топовые игроки в старкрафт пока что уделывают любого бота если не в первой партии, то во второй и всех последующих (после изучения стратегии).

iDm1

09.06.2017 12:23+1На одних заранее заложенных «if-then-else» достойного оппонента человеку в StarCraft не создать. В игре важна разведка действий оппонента, т.к. только подготовившись к ним заранее можно им эффективно противостоять. Сюда входит направление развития оппонента, его наиболее вероятные стратегические решения, а так же что ему известно о вашей игре.

Используя четкую заранее заложенную логику будет необходимо регулярно дорабатывать ее вручную, после нахождения человеком очередного способа ее обмануть. А вот обучение на играх против людей и самого себя может позволить не только «предугадать», что делает человек, а и передать инициативу игры в руки ИИ. Вот это и будет его победой.

Louren325

09.06.2017 17:45К сожалению большинство из комментирующих, как и Вы, собственно, давно не смотрели матчи по старкрафту. Почти все комментарии обсуждают сферического коня в вакууме, из серии «как должно быть».

Возьмём недавний матч https://www.youtube.com/watch?v=fHERKiSZLbo, первый сет. Там нет ничего из того о чём говорят большинство местных комментаторов: нет разведки, нет «гениальных билдов», есть просто камень (ранний пул с газом -> спидлинги) и 2 хаты до пула. Игра закончилась за 4 минуты. Все решения о билдах были в слепую.

Понимаете, сейчас современный профессиональный старкрафт как раз об ошибках микроменеджмента и большинство стратегий из разряда камень-ножницы-бумага. Игроки — люди, они могут ошибаться и принимать абсолютно неправильные решения. Весь экшен и «интерес» от игры как раз и заключается в том что часто с заранее проигрышной стратегией из-за ошибок оппонента — победить можно из отставания. С хорошо прописанной логикой боты не будут допускать подобных ситуаций, только и всего.

Как ещё один яркий пример хочу привести ещё одну недавнюю игру — https://youtu.be/HfL2EmmaJpE?t=1443

Сет длился 11 минут и был проигран из-за одной ошибки. В видео она с 24:03. Одна ошибка стоила террану игры. Именно о таких моментах сейчас старкрафт, не о стратегической части, которая давно стала чем-то мифическим.

iDm1

09.06.2017 20:05Гадаете по комментариям? Я и сам играл еще с BroodWar, а сейчас в основном смотрю стримы профессиональных игроков.

В своем случае не берусь твердо утверждать про ваш опыт в StarCraft по данному комментарию, но вообще похоже на мнение человека слабо знакомого с RTS в целом.

Ошибки микроменеджмента, безусловно, так же стоят игры, но ИИ в этой сфере всегда был сильнее человека и при этом все равно не мог ему противостоять. Смотря игры двух профессионалов вы не замечаете и не понимаете важных моментов разведки и принятия дальнейших решений, для игроков-людей это само собой разумеющиеся вещи.

А вы попробуйте против них сыграть. Даже с макросами на микро у вас не будет шансов, так же как и у текущего ИИ.

В этом и состоит задача в данном случае, получить ИИ, который не будет совершать глупых ошибок в макро, как это происходит сейчас. Эта задача сама по себе очень интересна.

Louren325

09.06.2017 20:30«Играл» ещё ничего не значит. Так-то можете погуглить мой ник. В 2012-14 годах я официально комментировал WCS, был одним из стримеров Кореи 2.0 вместе с Алексом007 http://old.sc2tv.ru/content/%D0%BA%D0%BE%D1%80%D0%B5%D1%8F-20-wcs-2013-season-1-codes-ro8-innovation-vs-roro-bomber-vs-symbol, был топ300 по птс в европе и т.д. Второму старкрафту я отдал несколько лет жизни и уж в нём я разбираюсь хорошо. Кстати профиль http://eu.battle.net/sc2/ru/profile/296779/2/Louren/. 8 сезонов в мл, 4.5к игр, завязал ~ в 2014 году до выхода LotV.

В том-то и дело что я играл на semi-pro уровне, доходил до 1/4-1/2 на всяких там зотак-капах и часто пересекался с прогеймерами. Плюс мы делали передачу «побег из бронзы» куда приглашали текущих на тот момент прогеймеров и разбирали очень много аспектов игры. Именно исходя из опыта тысяч игр, сотен часов стримов и десятков общения с про я и делаю эти выводы.

«Попробуйте» — пробовал и частенько выигрывал, именно по этому я и утверждаю что у людей, которые не разбираются в старкрафте переоценен фактор разведки и какие-то извращённые понятия о макро игре. И в сотый раз скажу что человек — слишком несовершенен и шанса против хорошего ИИ у него нет. Все существующие боты — слишком примитивны и их создатели не преследовали цели создать идеальную машину, не говоря уже про эти принудительные ограничения в апм.

darkfrei

08.06.2017 02:17После каждой победы отнимать камень, после проигрыша — добавлять. На каком уровне будет ИИ?

И ещё в парном Го, где с одной стороны по очереди играют два топовых игрока, а с другой стороны по очереди новичок и ИИ? Перетянет ли балласт или ИИ сможет вытянуть?

Kolegg

08.06.2017 09:04Нее, тут никто не потянет. Даже в шахматах если будет играть 1 разряд и ИИ против 2 гроссмейстеров — гроссы победят в подавляющем большинстве случаев.

tieonabe

08.06.2017 11:54Половина ходов новичка — это слишком жёсткий камень на шее у ИИ, шансов у такой пары нет.

Не особо шарю именно в го, но 100% уверен, что в любой вменяемой игре ходы приносят реальную пользу только в виде осмысленной их комбинации. Новичок запорет одно «комбо», так как не увидит его, а профи даже без общения точно будут видеть смысл ходов друг друга и поддержат нужные комбинации.

mikeee1

08.06.2017 05:54+4Все таки не совсем корректно говорить, что для игры понадобился всего 1 модуль.

Вероятно, что для теренированной нейронки уже не нужно кластера, т.к. все «веса» определены и просто расчет намного менее затратен, чем обучение. Обучение как раз таки требовало 50 модулей.ankh1989

08.06.2017 06:17+2Ну так и на запуск линкуса хватит и смартфона, но вот чтоб написать этот линукс ушло немеренно времени и энергии.

3aicheg

08.06.2017 07:20+3В октябре 2016 года Microsoft объявила, что её система распознаёт человеческую речь так же хорошо, как и люди.

— Доктор, моя система очень плохо распознаёт речь!

— Не переживайте, они все плохо распознают.

— Да, но мой сосед объявил, что его система распознаёт так же хорошо, как и люди!

— Так в чём проблема, и вы объявите.

mst_72

08.06.2017 11:55Если я что-то в чем-то понимаю, то получается что в Go технически получается выиграть при помощи простого решения оптимизационной задачи.

Т.е. Alpha Go постоянно выбирала максимально подавляющие ходы. А человек просто чисто технически не мог решать оптимизационную задачу.

Забавно.

mypallmall

08.06.2017 14:21Против Кэ Цзе выставили одну машину с всего одним модулем TPU.

Есть пруфлинк?

atomlib

08.06.2017 15:06Ссылка в предыдущем от утверждения предложении http://www.sohu.com/a/143092581_473283

leshabirukov

08.06.2017 15:13Тонко. А по-английски нет? Или Гугл решил раскрывать подробности только по-китайски?

atomlib

08.06.2017 15:22+1Есть сделанная с рук запись этой презентации https://www.facebook.com/GOking2007/videos/1364474096921048/

leshabirukov

08.06.2017 15:09Действительно странно.

Про TPU было известно две вещи, что основной вычислитель это массив 256х256 8-битных умножителей, и что используется он по data flow схеме, что разумно — если одна из матриц-сомножителей не константа, то уж больно много надо данных одновременно подгружать.

Но тогда выходит, что один TPU одновременно эмулирует только 256х256 = 65 536 синапсов, что совсем мало для DNN.

Очень интересно, как они подгружают веса (синапсы) и где их хранят.

AntonSor

Пройдет ещё немного времени, и такие машины всего с одним чипом TPU, способные предугадывать действия человека, будут стоять в каждом фонарном столбе и при первых признаках девиантного поведения вызывать карету до вытрезвителя.

AntonSor

А в случае более продвинутого алгоритма — вызывать и «электрического пса» с ядовитым жалом.

AntonSor

А в спокойном состоянии транслировать рекламу.

darkfrei

Зачем им транслировать рекламу? Оценить потребность конкретного человека, найти товар, заказать вместо него и отправить ему

посылкой на домпочтой-такси в любую точку мира. При правильном анализе возврата товара не будет или крайне мало, можно и не замечать.Here_and_Now

Без рекламы релевантных товаров будет слишком мало.

Fiz_ruk

Эээ, а зачем ИИ человек вообще?

jryj

Смысл рекламы отнюдь не в том, что бы продать человеку то, что ему надо.

darkfrei

Если бот АльфаПродавец будет продавать успешно без рекламы, то зачем она нужна?

Durimar123

А для тех кто не хочет смотреть рекламу, вызывать «электрического пса».

x67

Причем предиктивно — до появления даже мыслей о возможности подумать на тему «девиантного» поведения.

Вопрос к людям: что делать, когда станем в один ряд с другими бесполезными формами жизни? Будут ли в зоопарке хорошо кормить и тепло одевать? Будет ли вообще зоопарк для нас?

SLY_G

Слишком большой переход — от одной игры к оценке поведения человека. Это если учесть, что сам человек не знает, что есть нормальное поведение.