О том, что собой представляет так называемый Закон Мура на Geektimes, наверное, рассказывать в подробностях не стоит — все мы знаем о нем, хотя бы и приблизительно. Если вспомнить кратко, то этот закон — эмпирическое наблюдение, которое сделано Гордоном Муром. Формулировок самого закона было несколько, но современная гласит, что количество транзисторов, размещаемых на кристалле интегральной схемы, удваивается каждые 24 месяца. Чуть позже появилась разновидность закона, где фигурирует не два года, а 18 месяцев. Это связано уже не с Муром, а с Давидом Хаусом из Intel. По его мнению, производительность процессоров должна удваиваться каждые 18 месяцев из-за одновременного роста как количества транзисторов, так и быстродействия каждого из них.

Со времени формулировки закона разработчики электронных элементов стараются шагать в ногу с установленными временными рамками. Вообще говоря, для 1965 года закон был чем-то необычным, его даже можно назвать радикальным. Тогда «мини ЭВМ» все еще не были очень уж маленькими, занимая в помещении объем обычного рабочего стола, а то и больший. В то время сложно было представить, что компьютеры со временем могут даже стать частью холодильника, стиральной машины или другой бытовой техники. Большинство людей никогда не видели компьютер, а те, кто видели, почти никогда с ними не работали. Ну а те, кто работали, использовали перфокарты и другие не слишком удобные инструменты взаимодействия с ЭВМ, которые, в свою очередь, работали для решения достаточно узкого круга задач.

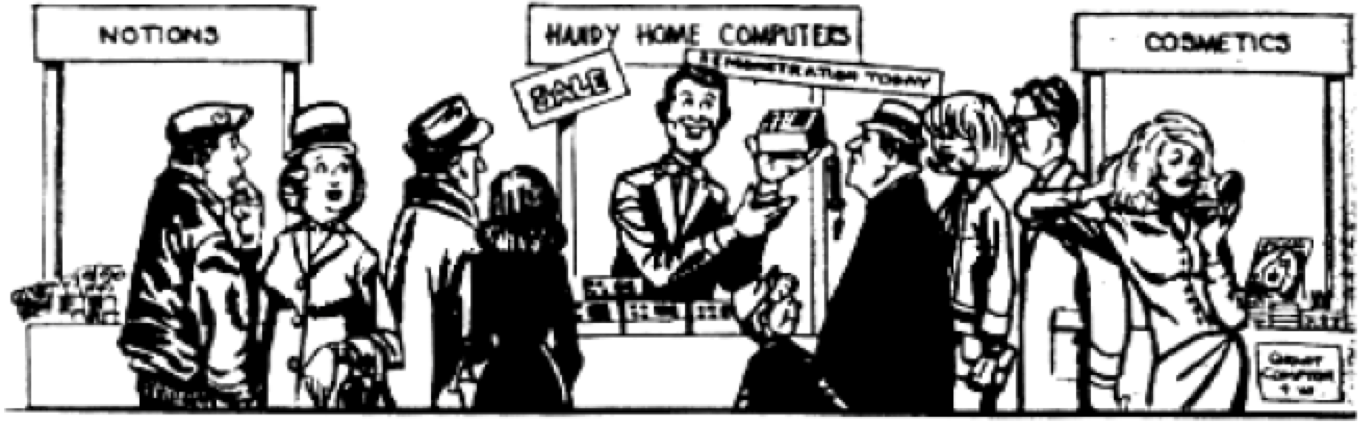

Над идеей Мура после того, как о ней стало известно, начали даже подшучивать в журналах. Например, в одном из них разместили вот такую вот карикатуру:

Тогда было сложно представить, что вскоре даже такие компьютеры вовсе не будут считаться маленькими. Иллюстрацию, кстати, видел Мур, и она его очень удивила своей оригинальностью. Насколько можно судить, художник пытался передать несколько скептический настрой в отношении идеи постоянного уменьшения размеров ПК. Но через 25 лет эта иллюстрация стала вполне себе обыденной реальностью.

Влияние Закона Мура

Как уже говорилось выше, существует несколько вариаций Закона Мура, речь не идет только лишь о постоянном увеличении числа транзисторов в чипе. Одно из последствий идеи Мура — попытка выяснить, насколько быстро будут работать все уменьшающиеся по размеру транзисторы. Также ученые и специалисты по информационным технологиям, используя идею Мура, пытались и пытаются предзаказать, насколько быстро будет расти объем ОЗУ, основной памяти, насколько производительными будут чипы и т.п.

Но главное — не в том, какая из версий Закона Мура более любопытна/полезна, а в том, какое влияние основная идея оказала на наш мир. Здесь можно выделить три основные формы влияния. Это соперничество разработчиков, прогнозирвание и изменение архитектуры вычислительных систем.

Соперничество

Закон Мура можно использовать для того, чтобы выяснить, сколько информации можно хранить в объеме одного чипа. Этот закон, кстати, вполе можно отнести к RAM. На заре компьютерной техники, вернее, ПК, компьютерный чип мог хранить

Прогнозирование

Зная о тенденции увеличения числа транзисторов в объеме чипа (а формула изначально была достаточно четкой) инженеры любой из компаний, выпускающих электронные компоненты, могли примерно представить себе, когда какое поколение чипов выйдет. И это был довольно точный прогноз. Также можно было себе представить, в каком году и с какой производительностью будет работать процессор.

Инженеры на предприятиях стали составлять производственные планы, ориентируясь, в основном, на Закон Мура. Продавцы компьютерной техники хорошо представляли себе, когда какое поколение машин должно уйти с рынка, и когда какое должно появиться.

Закон Мура, можно сказать, наладил производственный процесс выпуска электронных компонентов и систем. Сюрпризов в этом плане не было, да и быть не могло, ведь все работали примерно с одинаковой скоростью, не пытаясь обогнать или отстать от временных рамок, заданных Муром. Все было превосходно предсказуемым.

Архитектура ПК и элементов

Все тот же Закон Мура позволил инженерам разработать дизайн чипов, который стал на долгое время эталоном. Речь идет об Intel 4004 и его последующих инкарнациях. Была разработана специализированная архитектура, которая получила название архитектура фон Неймана.

В марте 1945 года принципы логической архитектуры были оформлены в документе, который назывался «Первый проект отчёта о EDVAC» — отчет для Баллистической Лаборатории Армии США, на чьи деньги осуществлялась постройка ЭНИАКа и разработка EDVACа. Отчет, поскольку он являлся всего лишь наброском, не предназначался для публикации, а только для распространения внутри группы, однако Герман Голдстайн — куратор проекта со стороны Армии США — размножил эту научную работу и разослал её широкому кругу ученых для ознакомления. Так как на первой странице документа стояло только имя фон Неймана[1], у читавших документ сложилось ложное впечатление, что автором всех идей, изложенных в работе, является именно он. Документ давал достаточно информации для того, чтобы читавшие его могли построить свои компьютеры, подобные EDVACу на тех же принципах и с той же архитектурой, которая в результате стала называться «архитектурой фон Неймана».

После завершения Второй Мировой войны и окончания работ над ЭНИАКом в феврале 1946 года команда инженеров и ученых распалась, Джон Мокли, Джон Экерт решили обратиться в бизнес и создавать компьютеры на коммерческой основе. Фон Нейман, Голдстайн и Бёркс перешли в Институт перспективных исследований, где решили создать свой компьютер «IAS-машина», подобный EDVACу, и использовать его для научно-исследовательской работы. В июне 1946 года они[2][3] изложили свои принципы построения вычислительных машин в ставшей классической статье «Предварительное рассмотрение логической конструкции электронно-вычислительного устройства». С тех пор прошло более полувека, но выдвинутые в ней положения сохраняют свою актуальность и сегодня. В статье убедительно обосновывается использование двоичной системы для представления чисел, а ведь ранее все вычислительные машины хранили обрабатываемые числа в десятичном виде. Авторы продемонстрировали преимущества двоичной системы для технической реализации, удобство и простоту выполнения в ней арифметических и логических операций. В дальнейшем ЭВМ стали обрабатывать и нечисловые виды информации — текстовую, графическую, звуковую и другие, но двоичное кодирование данных по-прежнему составляет информационную основу любого современного компьютера.

Все основы, которые были заложены несколько десятков лет назад и стали основой. В дальнейшем почти все оставалось неизменным, разработчики лишь старались сделать компьютеры все более производительными.

Стоит помнить, что в основе всего лежит Закон Мура. Все его инкарнации служили поддержкой базовой модели развития компьютерной техники, и уже мало что могло привести к разрыву этого цикла. И чем активнее шло развитие компьютерной техники, тем глубже, можно сказать, увязали в законе разработчики этих систем. Ведь создание иной архитектуры ЭВМ занимает годы и годы, и мало кто из компаний мог себе позволить эту роскошь — поиск альтернативных путей развития компьютерной техники. Научно-исследовательские организации вроде МИТ проводили храбрые эксперименты вроде Lisp Machine и Connection Machine, здесь же можно упомянуть и один из японских проектов. Но все это закончилось ничем, в ходу осталась архитектура фон Неймана.

Работа инженеров и программистов теперь заключалась в оптимизации работы своих программ и «железа», с тем, чтобы каждый квадратный миллиметр чипов работал все более эффективно. Разработчики соревновались в кэшировании все больших объемов данных. Также различные производители электронных компонентов старались (и стараются до сих пор) разместить как можно большее количество ядре в рамках одного процессора. Как бы там ни было, вся работа сосредоточилась на ограниченном количестве процессорных архитектур. Это X86, ARM и PowerPC. Тридцать лет назад их было гораздо больше.

X86 используются преимущественно на десктопах, ноутбуках и облачных серверах. ARM процессоры работают на телефонах и планшетах. Ну а PowerPC в большинстве случаев используются в автомобильной индустрии.

Интересным исключением из жестких правил игры, установленных Законом Мура, можно назвать GPU. Их разрабатывали для того, чтобы с высокой степенью эффективности обрабатывать графическую информацию, поэтому их архитектура отличается от процессорной (еще бы). Но для того, чтобы справляться со своей задачей, GPU пришлось дорабатывать независимо от эволюции процессоров. Архитектуру видеокарт оптимизировали для обработки большого количества данных, необходимых для прорисовки изображения на экране. Поэтому здесь инженеры разработали иной тип чипов, который не заменил существующие процессоры, а дополнил их возможности.

Когда закон Мура перестанет работать?

В обычном смысле он уже перестал работать, в том классическом понимании, о котором шла речь выше. Об этом свидетельствуют различные источники, включая, например, этот. Сейчас гонка еще продолжается. Например, в том же выпущенном 1971 году первом коммерческом 5-х битном процессоре Intel 4004 было 2300 транзисторов. Через 45 лет, в 2016 году, компания Intel представила 24-ядерный процессор Xeon Broadwell-WS с 5,7 млрд транзисторов. Этот процессор выпускается по 14 нм технологии. IBM не так давно анонсировала 7 нм процессор с 20 млрд транзисторов, а затем и 5 нм процессор с 30 млрд транзисторов.

Но 5 нм — это слой толщиной всего в 20 атомов. Здесь уже инженерия подступает вплотную к техническому пределу дальнейшего совершенствования техпроцесса. Кроме того, плотность размещения транзисторов в современных процессоров очень велика. На квадратный миллиметр — 5 или даже 10 миллиардов транзисторов. Скорость передачи сигнала в транзисторе очень высока и меет большое значение. Частота ядра работы современных наиболее быстрых процессоров составляет 8.76 ГГц. Дальнейшее ускорение тоже хотя и возможно, но является технической проблемой, причем очень и очень большой. Именно поэтому инженеры предпочли создавать мультиядерные процессоры, а не продолжать наращивать частоту работы одного ядра.

Это позволило сохранить темпы увеличения количества операций за секунду, предусмотренных законом Мура. Но все же сама мультиядерность это некоторое отступление от закона. Тем не менее, ряд специалистов считает, что не имеет значения, каким образом мы пытаемся «успеть», главное, что темпы развития технологий, в частности, компьютерной техники, более-менее соответствуют закону Мура.

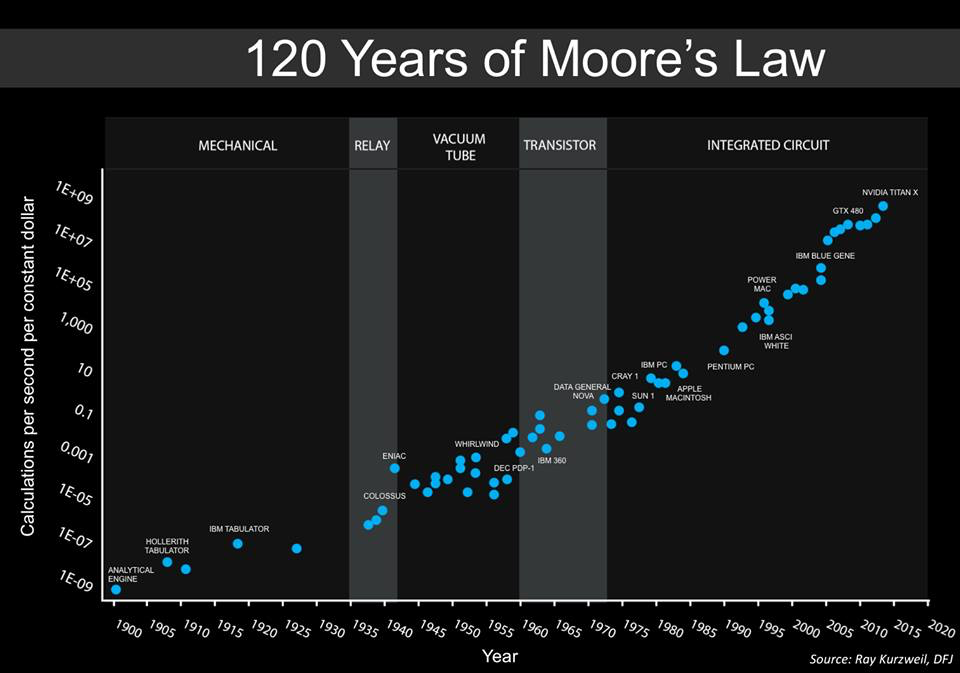

Ниже показан график, построенный Стивом Джурветсоном, сооснователем компании Draper Fisher Jurvetson. Он утверждает, что это дополненный график, ранее представленный Рэем Курцвейлом.

На этом графике показана относительная стоимость количества операций на единицу времени (1 секунда). То есть мы можем наглядно видеть, насколько подешевели компьютерные вычисления с течением времени. Причем вычисления становились все более универсальными, если так можно выразиться. В 40-х годах существовали специализированные машины, предназначенные для взлома военных кодов. В 1950-х ЭВМ стали использовать для работы с общими задачами, и эта тенденция сохраняется до сих пор.

Интересно то, что на графике последние две позиции — это GPU, GTX 450 и NVIDIA Titan X. Что интересно — в 2010 году на графике не было никаких GPU, лишь мультиядерные процессоры.

В общем, GPU уже здесь, и многие ими довольны. Кроме того, сейчас все популярнее становится такое направление, как глубокое обучение, одно из проявлений нейросетей. Их разработкой занимаются многие компании, большие и маленькие. И GPU идеально подходят для нейросетей.

К чему все это? Дело в том, что общий рост количества вычислений пока сохраняется, да, но вот методы и оборудование меняются.

Что все это значит?

Сейчас меняется сама форма компьютерных вычислений. Архитекторам вскоре не нужно будет думать о том, что еще предпринять, чтобы успеть за законом Мура. Сейчас постепенно внедряются новые идеи, которые позволят достичь высот, недоступных обычным компьютерным системам с традиционной архитектурой. Возможно, в скором будущем скорость вычислений будет иметь не такое и большое значение, улучшить производительность систем можно будет иначе.

Самообучающиеся системы

Сейчас многие нейросети зависят от GPU. Для них создаются системы со специализированной архитектурой. Например, корпорация Google разработала собственные чипы, которые получили название TensorFlow Units (илиTPUs). Они позволяют сохранять вычислительные мощности за счет эффективности производимых вычислений. Корпорация Google использует эти чипы в своих дата-центрах, на их основе работают многие облачные сервисы компании. В результате эффективность работы систем выше, а потребление энергии — ниже.

Специализированные чипы

В обычных мобильных устройствах сейчас работают ARM-процессоры, которые являются специализированными. Эти процессоры обрабатывают информацию, поступающую с камер, оптимизируют обработку речи, в режиме реального времени работают с распознаванием лиц. Специализация во всем — вот, что ожидает электронику.

Специализированная архитектура

Да, свет клином не сошелся на архитектуре фон Неймана, сейчас разрабатываются системы с разной архитектурой, предназначенной для выполнения разных задач. Эта тенденция не только сохраняется, но даже ускоряется.

Безопасность компьютерных систем

Киберпреступники становятся все более умелыми, при взломе некоторых систем сейчас можно получить миллионы, десятки миллионов долларов. Но в большинстве случаев взломать систему можно из-за программных или аппаратных ошибок. Подавляющее количество приемов, используемых взломщиками, работают на системах с архитектурой фон Неймана, но они не будут работать с другими системами.

Квантовые системы

Так называемые квантовые компьютеры — экспериментальная технология, которая, кроме всего прочего, является еще и очень дорогой. Здесь используются криогенные элементы, плюс много всего другого, чего нет в обычных системах. Квантовые компьютеры абсолютно не похожи на привычные нам ЭВМ, и закон Мура к ним никак не применим. Тем не менее, с их помощью, как считают специалисты, можно радикально повысить производительность некоторых типов вычислений. Возможно, именно закон Мура привел к тому, что ученые и инженеры начали искать новые способы повышения эффективности вычислений, и нашли их.

В качестве послесловия

Скорее всего уже через 5-10 лет мы увидим абсолютно новые системы вычислений, речь сейчас о полупроводниковой технике. Эти системы будут опережать наши самые смелые планы и развиваться очень быстрыми темпами. Скорее всего, специалисты, стремясь обойти закон Мура, создадут новые технологии разработки чипов, которые, если бы о них нам рассказали сейчас, показались бы нам магией. Что сказали бы люди, жившие 50 лет назад, если бы им дали современный смартфон? Мало кто понял бы, как все работает. Так и в нашем случае.

Комментарии (39)

dfgwer

18.07.2017 21:48Думаю, скоро более массово появятся «огроменные» нейроморфные чипы. Пластина 300мм диаметром целиком сделанная как один нейроморфный чип. Нейронные сети смогут игнорировать отдельные дефекты чипа. На такой пластине можно рывком поднять число транзисторов до многих триллионов, может даже квинтиллион транзисторов на 450мм 5нм пластинке.

SkyPhantasm

18.07.2017 22:33Думаю тренд 2020-2030 годов, будет отказ от мощных клиентских систем, и интенсивное развитие серверной части и сетевых технологий.

Hellsy22

19.07.2017 02:07+2Зачем? Это было актуально в эпоху слабых ARM-процессоров и тяжелого, изначально ориентированного на десктоп, софта.

sHaggY_caT

24.07.2017 00:36Как Вы себе представляете Tegra кластер внутри смартфона или даже десктопа :)?

Облачные вычисления продолжат и дальше уничтожать сервера в офисах, и профессию системного администратора (просьба не путать с эникеем)

black_semargl

21.07.2017 15:59+1Для того чтобы крутить стерео 8к видео — без мощной системы никак не обойтись.

VerdOrr

18.07.2017 22:51+2SkyPhantasm Что-то мне это напоминает…

Ах, да — «The Network is the Computer» (с) John Gage, Sun Microsystems, 1984

=)

Vadzimkan

18.07.2017 23:40+2Через 5-10 лет мы увидим на прилавке в лучшем случае то, что сейчас можно увидеть в качестве прототипов. Добавят несколько ядер, оптимизируют под нейросети и т.д. Сомневаюсь в том, что нас ждёт что-то революционное. Будут дальше допиливать потихоньку камни, как это происходило прошлые 5 и 10 лет.

Hellsy22

19.07.2017 01:10Интересно, сколько транзисторов в процессоре Xeon Phi 7290F с его 72 ядрами?

Art3

19.07.2017 03:36О том, что собой представляет так называемый Закон Мура на Geektimes, наверное, рассказывать в подробностях не стоит — все мы знаем о нем, хотя бы и приблизительно. Если вспомнить кратко, то этот закон — эмпирическое наблюдение, которое сделано Гордоном Муром.

andrey_gavrilov

19.07.2017 05:25Мало кто знает, но есть

отрасль, параметры в которой росли быстрее, чем по закону Мура (sic!)

(это магнитный УТС, Управляемый Термоядерный Синтез)

Siper

19.07.2017 08:25Если экстраполяция оказалась бы верной (как для закона мура) мы бы имели коммерческие реакторы еще 10 лет назад.

andrey_gavrilov

19.07.2017 09:02в моем комментарии нет никакой экстарполяции, от слова «вообще нет» (1) (чтобы не было недопониманий — убедитесь, пожалуйста, что знаете значение этого слова). Кроме того, я указал причину, почему этот рост параметров закончился, и когда он закончился(2).

Он закончился во второй половине 90-х, при том ровно потому, что на новые установки, — которые нужны, если вы хотите получить новые результаты, — перестало хватать денег.

При том деньги, как показывают планы ERDA-1976, не очень и большие нужны были.

В итоге мы имеем то, что имеем, — на весь американский магнитный УТС было потрачено с 1953 по 2016 включительно меньше, чем за четрые года на Манхеттенский проект, или, к примеру, меньше, чем на программу «Аполлон» тратили _в_год_(1) _несколько_лет_подряд_(2).

Коммерческих термоядерных реакторов у нас ни сейчас, ни десятью годами ранее нет и не было лишь по одной простой причине: не заплатили.

За что заплатили — то и получили.

На самом деле даже больше — все успешно пущенные установки магнитного УТС (так отсекаем аварийные советские, не отремонтированные из-за развала СССР) с 70-х годов дали либо запланированные, либо лучшие, чем запланированные результаты.

Т.е. получили даже «с горочкой».

Вот когда вы дом заказываете, вы же не возмущаетесь, если вам его не построят в случае, если вы не заплатите? Вот с УТС та же история — не заплатили.

Siper

19.07.2017 15:36Я не конкретно про ваш комментарий, я про приведенный график 2003 года.

Вы все правильно сказали — росли.

andrey_gavrilov

19.07.2017 17:03Ясно.

На самом деле даже этот график — не является экстраполяцией,

в этом легко убедится:

смотрим на обсуждаемый график

andrey_gavrilov

19.07.2017 17:16ну и в целом, я о том, что ваше предыдущее утверждения — содержит ошибки:

— показана экстраполяция (это не так),

— она оказалась ложна «сама по себе» (что тоже по сути ошибка, — продолжи мы график, т.е. — сделай мы экстраполяцию (1), И, УБЕРИ ТЕ ПРИЧИНЫ (я о них говорил прямым текстом — «перестали строить новые ловушки, ибо денег, выделяемых на УТС на них не хватало), ПО КОТОРЫМ ЕГО ПРОДОЛЖЕНИЕ В РЕАЛЬНОСТИ ОСТАНОВИЛОСЬ(2), т.е. „дай денег на новые ловушки“ — то да, „мы бы жили при коммерческих термоядерных реакторах“.

Это просто область так работает — хочешь новых результатов, строй новые ловушки. Говорить „ага“, в стиле анекдота про русских мужиков с японской бензопилой, в случае, когда график перестал продолжатся из-за того, что банально „денег не заплатили“ на продолжение работ (на установки следующего класса) — это немного за пределами адекватности просто.

Ну не знаю, как понятнее объяснить. Типа — это как вот смотреть, как ваши личные флешки росли в объеме-на-флешку год от года, а потом вдруг перестать выделять деньги на покупки новых флешек, и в итоге — начать удивляться, „что это объемы-то перестали расти!“, ага.

arthi7471

19.07.2017 12:47+2А толку? ПО, к сожалению, настолько потеряло оптимизацию что сожрет все эти перспективные ресурсы и останемся мы почти на том же месте. Как можно из-за пары макросов утяжелить программулину чуть ли не в три раза?

Когда вышел первый ипхоне примерно в то же время был выпущен samsung i-900. Сей аппарат имел все то что имеют сейчас современные андроиды при этом девайс имел по современным меркам никакие характеристики. Core player уже тогда спокойно хавал потоковое видео например.

Или скупе на заре своего становления был весьма легкий и имел почти все примочки что и современные версии только современный, добавив пару плюшек, стал весить в несколько раз больше. Впрочем это болезнь всех современных мессенджеров. Аська весила несколько килобайт. Или пресловутый фотошоп в крайних версиях внес пару плюшек при этом разжирел знатно. Хрюша на одинадцатилетнем эйсере шуршит так же быстро как вин10 на коржике пятом. Вобщем пока не будет нормальной оптимизации толку от мощи будет не так уж и много.

IMHOvsb

19.07.2017 17:42Потребитель может бухтеть про медленный скайп и ставить мемасики про жрущий память хром, но не пошевелится, чтобы попробовать поискать что-нибудь лучше. По простой причине — функционал для него всегда важней нефункциональных характеристик (в том числе производительности). Зачем ставить какой-нибудь matrix, если в хроме все друзья и видео работает лучше? Зачем ставить какой-нибудь lynx, если 80% сайтов работают только в современных браузерах? Сильно тормозит — всегда можно купить последний айфон или макбук. Поэтому никогда не будет оптимизации в ширпотребных программах, только в очень низкоуровневых компонентах вроде движка нейросети или видеокодека.

Farxial

20.07.2017 00:30Т.е., по-вашему, проблема просто в отсутствии стимуляции производителей говнософта конкуренцией? А без этого они как будто не могут.

А ещё то, что «получше», может быть в каком-то плане и похуже (например, не будет каких-нибудь полезных функций). А если всё же альтернатива будет объективно лучше, то весь проект с потрохами может купить производитель говнософта и всё снова станет хуже (примеры, известные мне: Skype, ВК), поэтому тут нужна ещё и моральная благонадёжность разработчика софта, обеспечение которой в масштабах системы, к сожалению, пока является отдельной проблемой. А пользователь, получается, должен быстро переучиваться и уметь выбирать себе правильный софт, наплевав на бренд, чтобы в проблемной ситуации суметь переключиться на другой софт. В принципе верно (и к этому тоже нужно стремиться), но производителей говнософта это всё равно не оправдывает.

Farxial

20.07.2017 01:00Забыл дописать.

В случае смены владельца годного проекта новый владелец может также изменить лицензию. Тогда, если проект был open-source, в лучшем случае его можно будет только форкнуть, а «официальная» версия будет развиваться самостоятельно (если проект был куплен — скорее всего, с материальной оплатой труда) и с выгодного состояния. Для развития форка также потребуется команда разработчиков, готовая поддерживать качество проекта, которая должна будет найтись в адекватные сроки.

zaq1xsw2cde3vfr4

19.07.2017 17:54Вы совершенно не правы. Дело не в оптимизации, а в усложнении системы. Можно конечно заняться самым любимым занятием линуксоидов 10-15 летней давности (перекомпиляцией системы с подгонкой под конкретно имеющееся железо) и получить прирост производительности в 0.05%, но оно того не стоит в 99% случаев. Ну и конечно есть ПО, которое для «резвости» требует настройки специалистом, а не ламером.

Alex27398

19.07.2017 12:49. Эти системы будут опережать наши самые смелые планы и развиваться очень быстрыми темпами.

10 лет назад был 2007. Был iPad и iPod, КПК, были точно такие же ноутбуки, хоть и более толстые, а на пк из 2007 годится почти для любых современных домашних задач. Для обычного пользователя мало что изменится.

5 лет назад был 2012. Тесла производится с 2012. GTX 450, которую упомянули в статье — с 2010. Изменений почти нет.

zaq1xsw2cde3vfr4

19.07.2017 18:01Изменения есть, но потребности обывателя покрыли технологиями ~10 летней давности. Сейчас разницу чувствуют те, кому требуется высокая производительность.

Hellsy22

20.07.2017 08:41Извините, не совсем понял вашу мысль. Вы хотите сказать, что GTX 450 и, скажем, GTX 1050 не отличаются хоть сколь-нибудь заметно для пользователя?

Optimuss

19.07.2017 12:49Ещё в 1990-х ожидали точку бифуркации в области вычислений на 2020-й. По-моему, всё к этому и идёт.

Siper

19.07.2017 15:42Нет, ну лет через 400 количество транзисторов в процессоре конечно превысит количество атомов во Вселенной. Но никакой бифуркаци закон Мура не подразумевает.

maslyaev

19.07.2017 16:56+2Три соображения.

Во-первых, нужно понимать, что восходящих экспонент в природе (то есть в реальном мире) не бывает. Нисходящие бывают, а восходящие — нет. То, что бывает похоже на восходящую экспоненту бывает при цепных реакциях, которые в итоге выжирают ресурс продолжения своего развития и благополучно выходят на насыщение. Это называется «логистическая кривая», и её начало действительно легко спутать с экспонентой. Так что у нас есть все шансы дожить (м.б. даже очень скоро) до кончины закона Мура. Лучше сразу быть психологически к этому готовыми.

Во-вторых, дрессировка нейросетей и намайнивание коинов — прекраснейшие и достойнейшие задачи, но нужно понимать, что подавляющее большинство повседневно используемых нами инфотехнологий очень плохо параллелится. То есть не важно, четыре процессора в компе или четыре тысячи, Ворд будет подтормаживать примерно так же. На квантовые компьютеры тоже надежды не очень много. На квантовом компьютере веб не посёрфишь. Они для другого делаются.

В-третьих, закон Мура нас, программистов разбаловал. Мы привыкли, что развитие аппаратной части с лихвой компенсирует все наши мелкие архитектурные косяки и нашу кодерскую лень. Ну и что, что после добавления вкусной фичи всё стало в два раза медленнее работать? Да наплевать! Через пару лет, когда создаваемое пойдёт в широкое использование, прогресс аппаратуры всё компенсирует. А теперь всё, не компенсирует. Печалька.

DRDOS

19.07.2017 20:26-1Закон Мура типична выдумка, журналюг!

Бред для болтовни, есть этот закон, нет этого закона, никому он не нужен!

Кроме тех кому нужно на шару написать диссертацию!

paranoya_prod

20.07.2017 09:22+1Через 5-10 лет мы увидим очередные новые инструкции, плюс Н-дцать ядер, чуть больше оперативки с каким-нибудь DDR7 и новые поколения GPU.

Нейроморфные технологии будут уделом специальных лабораторий и университетов. Квантовые вычисления слегка продвинутся. А мы все будем сидеть на тех-же технологиях, что и сейчас, разве что слегка поменяются материалы для производства чипов, которые позволят ещё больше вместить транзисторов, увеличить мегагерцы и снизить TDP, сделать чипы «3D».

Всё, ничего из разряда «Вов!/Ух-ты!» не будет ещё лет сорок. Наши технологии уже подошли к рубежу, который мы не будет перескакивать, потому что это невыгодно с денежной точки зрения.

Skerrigan

20.07.2017 10:29чуть больше оперативки с каким-нибудь DDR7

Простите, вы о чем?! DDR3 более 8Гб не позволял, в то время как DDR4 позволяет до 512Гб ОЗУ на плашку!

Вы степень прогресса не замечаете? Да и за 10 лет не придет еще 3 поколения. Раз в 4 года примерно идет смена и то, что-то мне подсказывает, что текущего поколения нам хватит на очень долго.

paranoya_prod

20.07.2017 12:19+1DDR7 — просто некое понятное название очередной версии ОЗУ. Через десять лет может не быть аббревиатуры DDR, а будет какая-нибудь QDR1.

kissarat

Не думаю, что через 5-10 лет что-то радикально измениться, например вычисления на основе графена или других материалов. Не исключено, что станут возможними нейросети на основи тканей мозга.

fgmatrix

Ага, как не заморачивались где ться, а где тся писать — так и продолжат

kissarat

Не все же Великоруссы