О причинах этих решений и ситуации в индустрии, рассказываем дальше.

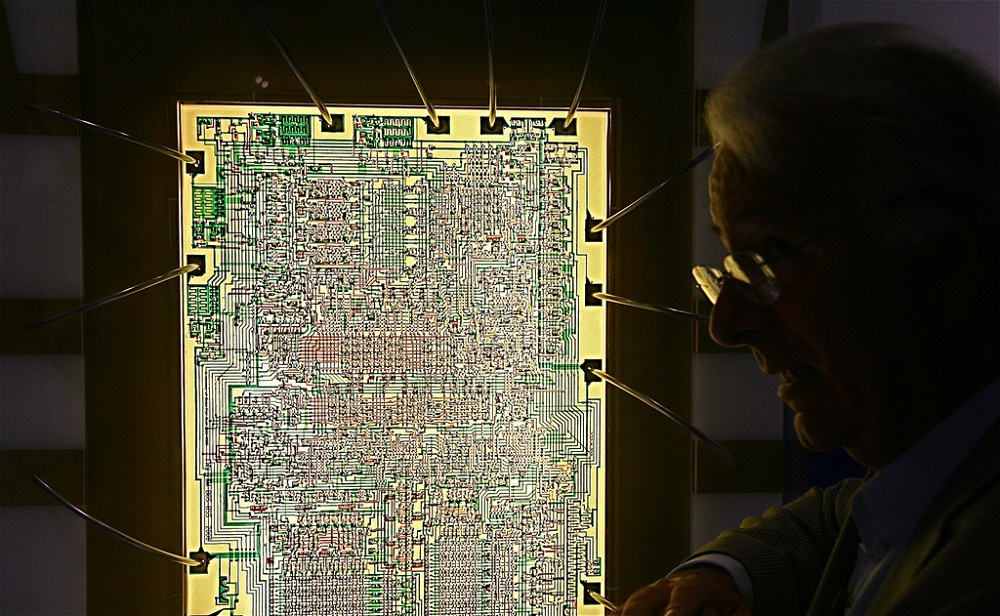

/ фото Intel Free Press CC

Пара слов о технологических процессах

Отдельные транзисторы на чипе формируются методом литографии — элементы вытравливаются на кристалле с помощью света. Компании уменьшают техпроцессы, чтобы увеличить количество продукции из одной заготовки и снизить энергопотребление финального чипа. Производитель получает возможность увеличить быстродействие микросхемы, оставив её размеры на прежнем уровне.

Долгое время эта тенденция (на уменьшение техпроцессов) оставалась справедливой. Но сейчас ИТ-компании начали откладывать или вообще прекращать разработку новых техпроцессов. Отчасти это связано с удорожанием оборудования и высоким уровнем брака.

Подробнее в ситуации разбираемся далее.

Почему GlobalFoundries отменили 7-нм

GlobalFoundries производят кремниевые пластины на восьми заводах по всему миру. Компания должна была выпустить на рынок 7-нм микросхемы во втором квартале 2018 года. Однако за пару недель до предполагаемого релиза, GlobalFoundries решили всё отменить.

Вместо этого, организация сосредоточит свои усилия на разработке специализированных норм производства 14LPP (Low-Power Plus) и 12LP (Leading-Performance) и создании различных встроенных запоминающих устройств.

Платформа 14LPP — это усовершенствованная версия 14-нм процесса на базе 3D FinFET-транзистора. Она повышает производительность устройств на 55% и уменьшает их энергопотребление на 60% (по сравнению с 28-нм). А 12LP — это техпроцесс изготовления полупроводников, заточенный под нужды систем ИИ, смартфонов и автомобильной электроники.

По словам CTO GlobalFoundries Гэри Пэттона (Gary Patton), причиной стратегического поворота стали не технические проблемы, а финансовые вопросы. Компания вложила миллиарды долларов в разработку 7-нанометровых микросхем. Первое поколение, в котором используют иммерсионную литографию, было почти завершено. Но на второе и третье (они требовали более глубокие УФ-диапазоны для увеличения плотности транзисторов) средств уже не хватало.

Вместе с отменой 7-нм, GlobalFoundries остановили разработку 5-нанометровых и 3-нанометровых техпроцессов. Из-за смены курса GlobalFoundries сократит пять процентов сотрудников и пересмотрит соглашения с AMD и IBM. В частности, с IBM компания поработает до конца года, а дальше прекратит исследования новых техпроцессов.

Кто еще отложил разработку

Еще одной организацией, которая отложила выход чипов по новому технологическому процессу, стала Intel. ИТ-гигант передвигает масштабный релиз 10-нм схем уже два года. В этот раз старт продаж первых 10-нм продуктов передвинули на конец 2019.

По словам представителей компании, причина задержки — низкий выход годных процессоров. Есть мнение, что проблема связана с технологией multi-patterning и применением кобальта.

Производственные объемы растут медленнее, чем планировалось. Технически Intel уже поставляет 10-нм микросхемы малыми партиями. Например, первые Core i3-8121U — 10-нм процессоры семейства Cannon Lake — уже работают в ноутбуках Lenovo. Однако о массовом производстве чипов говорить не приходится.

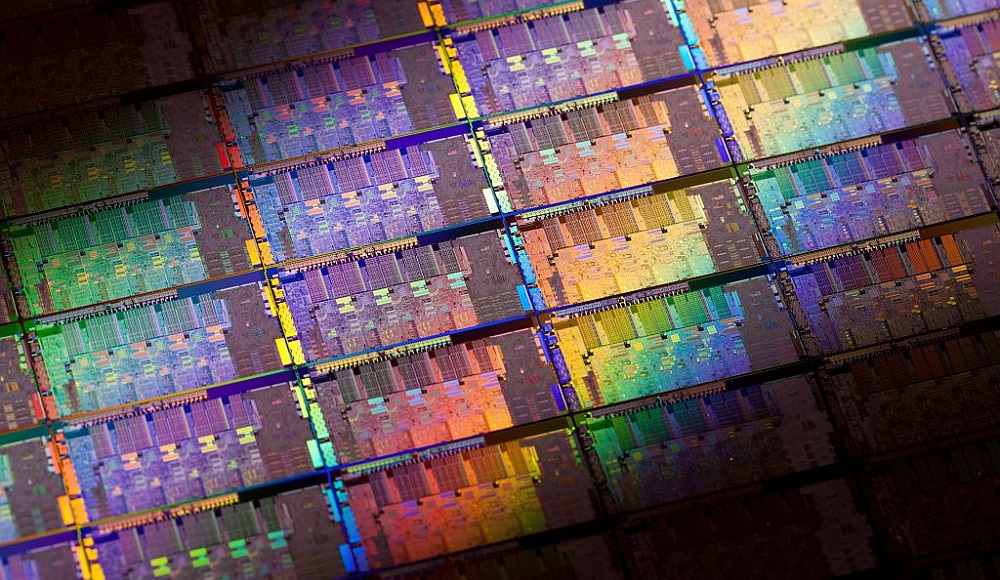

/ фото Intel Free Press CC

Другие игроки рынка тоже не торопятся ставить разработку новых техпроцессов на поток. В UMC пока остановились на 14-нм техпроцессе, а в Samsung обещают 7-нм, но тоже не раньше 2019.

Основные причины

Как мы уже говорили, дороговизна перехода — одна из причин, почему GlobalFoundries свернули свои проекты. И по мнению Gartner, она является основной. По оценкам аналитиков стоимость разработки 7-нм технологии составляет примерно 270 млн долларов.

Оборудование для EUV-литографии, нанолисты, экзотические материалы вроде рутения — все эти вещи стоят недешево, но без некоторых из них уже сложно обойтись. Чтобы окупить инвестиции в производство, нужно выпускать по 150 млн чипов в год. Поэтому реализация 7-, 5-, 3- и 2-нм процессов может оказаться коммерчески невыгодной.

При этом даже если микросхему и создают, то «выхлоп» по производительности не всегда оказывается значительным. Например, в Qualcomm считают, что 5-нм процесс не сильно превзойдет 7-нм по характеристикам, а вложить в его разработку придется несколько миллиардов долларов.

Вторая причина — велика вероятность ошибки и ее цена. К примеру, задержки в поставках 10-нм техпроцесса Intel «влетели в копеечку» одному из ИТ-гигантов с капитализацией в 20 млрд долларов.

Резиденты HN выделяют и другие причины замедления прогресса в индустрии полупроводников. Например, один из пользователей полагает, что уменьшение размеров кристалла плохо сказывается на его охлаждении. Поэтому компании стараются вложить средства в разработку более энергоэффективных технологий, а не уменьшение размеров кристаллов (именно по этому пути пошли в GlobalFoundries).

Почему обновления все-таки нужны

Представители индустрии считают, что уменьшать техпроцессы все равно придется. Это позволит обеспечить эффективную работу систем ИИ, МО, 5G-сетей и IoT. По предварительным расчетам разработчиков из TSMC, 7-нм техпроцесс улучшит производительность на 30% и вполовину уменьшит энергопотребление процессора (по сравнению с 10-нм).

Однако Дэвид Хемкер (David Hemker), старший VP в компании Lam Research, производящей полупроводники, подчеркивает, что отрасли понадобятся новые решения, чтобы справиться с растущими сложностями производственных процессов.

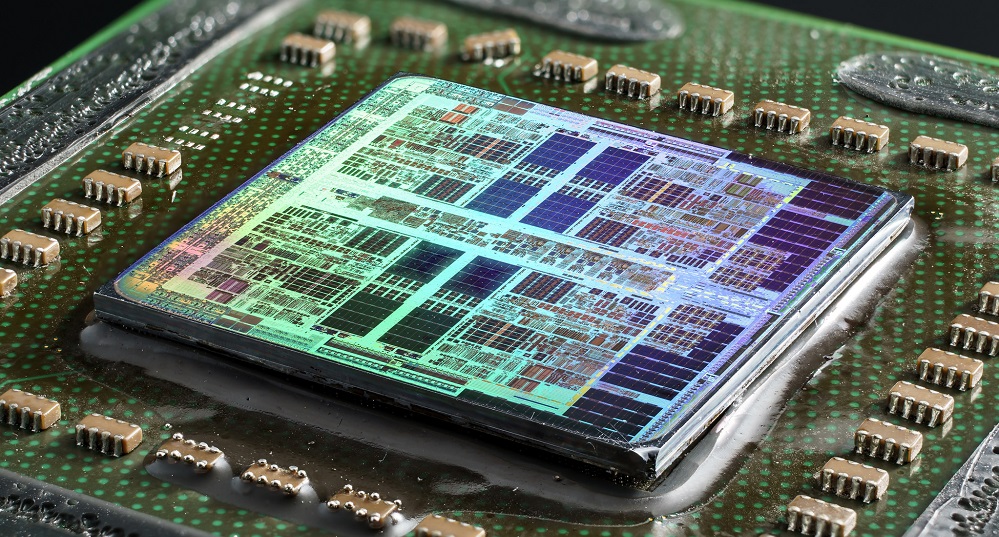

/ фото Fritzchens Fritz PD

Пока что EUV-литография генерирует слишком много дефектов при производстве чипов. Но если продолжить совершенствовать технологию, она должна сократить время и расходы на разработку новых техпроцессов.

Несмотря на все сложности производства, некоторые представители индустрии уже делают прогнозы на процессы менее 5-нм и говорят о сроках выпуска таких чипов. Так, например, в TSMC — тоже занимающейся производством полупроводников — уже строят планы по разработке 3- и 2-нм техпроцессов. А исследовательский центр Imec вместе с компанией Cadence Design Systems даже разработали тестовые образцы микропроцессоров по технологии 3-нм.

Поэтому в будущем мы определённо увидим применение этим технологиям, только этот момент может наступить немного позднее, чем предполагалось изначально.

P.S. Дополнительные материалы из Первого блога о корпоративном IaaS:

- Новая функциональность в VMware vSphere 6.7

- Примеры использования СХД NetApp в различных сферах бизнеса

- Тестирование дисковой системы в облаке

P.P.S. Статьи по теме из нашего блога на Хабре:

- Японцы представили прототип процессора для эксафлопсного суперкомпьютера

- Компания IBM представила первый в мире 5-нанометровый чип

- Почему компьютерные чипы стали быстрее «стареть» и что с этим делать

Чем мы занимаемся в ИТ-ГРАД: • IaaS • PCI DSS хостинг • Облако ФЗ-152

Комментарии (98)

Crysdd

06.09.2018 17:32+4По оценкам аналитиков стоимость разработки 7-нм технологии составляет примерно 270 млн долларов

Примерно как один голливудский фильм.

alexanster

06.09.2018 22:35+9На самом деле стоимость разработки 7-нм технологии на порядки больше, а в оригинале говорится, что 271 млн долларов — это разработка какого-нибудь чипа, который будет выпускаться по данной технологии. Такой перевод.

amartology

07.09.2018 09:10+2Дада, это плохой перевод. Разработка технологии стоит десятки миллиардов долларов.

Am0ralist

07.09.2018 14:38То есть как полсотни голивудских фильмов?

amartology

07.09.2018 15:15Вы так говорите, как будто голливудские фильмы чем-то хуже айфонов и криптомайнеров, в которые идут 7 нм технологии.

Am0ralist

07.09.2018 16:54Да нет, просто очень удобный способ ведения сравнительных подсчетов)

Например, у Наса проблемы с плутонием из-за того, что сумма на восстановление производства равна примерно бюджету дилогии УС2…

yarric

06.09.2018 18:51Придётся забросить Java и .NET с их виртуальными машинами под виртуальными машинами и снова вспоминать FORTRAN, COBOL, BLISS, С и ассемблер :)

vics001

07.09.2018 13:44Java и .NET давно не являются виртуальными машинами, они выполняют процесс компиляции (JIT). Android вообще компилирует AOT.

Точно так же как обычный разработчик С++ напишет на ассемблере то, что работает так же по скорости как и C++, без премудростей ускорения.

yarric

07.09.2018 21:11В теории звучит красиво, на деле — тормоза.

vics001

08.09.2018 01:35На деле писал алгоритмы просчета маршрутов получил на Intel Java 7 сравнимую скорость с С++, а без достаточных оптимизаций С++ компилятора и кода вообще хуже. Начал разбираться как так, тут native, а тут Java. Оказалось вычисления были сравнимы по операциям, а вот память выделять было лучше большими кусками, что и делает Java. На ARM разница было до 10 раз, а на x86 openjdk разницы почти не было.

История не о том, что на С++ нельзя написать супербыстрый код, а о том, что при сравнительных трудозатратах получается абсолютно сравнимый и приемлимый вариант. А учитывая кол-во выстрелов в ногу в С++ и управления памятью, трудозатраты на С++ всегда больше.

yarric

08.09.2018 09:47В любом случае на практике native работает быстрее, что видно на примере тех же мобильных платформ.

Кстати я C++ не упоминал:)

Vitalley

09.09.2018 04:33Не правильно считаются трудозатраты, кодеров то подсчитали, а теперь давайте подсчитаем затраты пользователей этого продукта.

Arxitektor

06.09.2018 21:02Примерно как один голливудский фильм.

Это да даже как-то маловато по деньгам.

Тогда у Apple легко хватит денег на 7 и на 5 нм.

Если брать WiKi то шаг кристаллической решетки кремния а = 0,54307 нм.

Как думаете какой ТП станет коммерчески не выгодным 5 нм?

Судя по новостям 7 нм уже на самой грани.

придётся забросить Java и .NET с их виртуальными машинами под виртуальными машинами и снова

И еще пару раз под виртуальными машинами ) плюсам контенеры всякие )

Хотя будут как АДМ клепать мелкие кристаллы по 7 нм. И лепить их в нужном количестве.

Вроде АМД говорили что будем кристалл из двух 6 ядерных блоков.

12 ядер. ) *4 = 48 на проце.

Mad__Max

07.09.2018 03:17+1Выше уже отметили — в оригинале это стоимость разработки одной модели конкретного чипа для производства по 7нм технологии.

In total, the average IC design cost for a 16nm/14nm chip is about $80 million, compared to $30 million for a 28nm planar device, according to Gartner. In comparison, it will cost $271 million to design a 7nm chip, according to the firm.

Стоимость смены самой технологии производства (разработка соответствующих процессов и необходимого для их проведения оборудования) еще несколько поколений назад была на порядок больше (~ несколько миллиардов долларов), и примерно на 2 порядка больше проектирования конкретного чипа по тем технологиям.

Данных по 5-7 нм. тех процессам не видел, но судя по тренду роста затрат речь идет о вложениях от 10 миллиардов долларов и выше.

GeMir

06.09.2018 21:40+2уменьшать разрешающую способность все равно придется

Повышать? Чем ниже разрешение, тем «толще» линия.

BD9

07.09.2018 03:26+10Не «методом литографии», а «методом фотолитографии».

Не «элементы вытравливаются на кристалле с помощью света», а «электронная схема создаётся на кристалле с помощью света и светочувствительных химических веществ». Травление — кислотой (или щёлочью).

«Долгое время эта тенденция (на уменьшение техпроцессов) оставалась справедливой» — это закон (эмпирическое правило) оставался справедливым.

Иммерсионная фотолитография: от англ. immerse — погружать в жидкость. Вместо линз и воздуха используются линзы и жидкость.

Не «более глубокие УФ-диапазоны», а глубокий ультрафиолет, переходящий в мягкий рентген.

Не «уменьшение размеров кристалла плохо сказывается на его охлаждении», а рост плотности теплового потока плохо сказывается на возможность его охладить (переносимая энергия в единицу времени на единицу площади).

Не «EUV-литография генерирует слишком много дефектов при производстве чипов», а «при использовании фотолитографии в глубоком УФ процент выхода годных изделий остаётся низким».

Не «менее 5-нм», а «менее 5 нм» — без тире.

«в TSMC — тоже занимающейся производством полупроводников» — ага, один из основных мировых производителей полупроводниковой продукции оказывается тоже ими занимается.

«Как мы уже говорили, дороговизна перехода — одна из причин, почему GlobalFoundries свернули свои проекты. И по мнению Gartner, она является основной» — нет, не это. Основная причина — сворачивание научных разработок по физике в бывших лидерах — СССР и США. Китай ещё не полностью замених их в этом вопросе. В США политики предпочитают покупать голоса избирателей льготами, а производством руководят «эффективные менеджеры», которые порезали расходы на НИОКР ради собственной годовой премии.

Пока что в ближайшем будущем переходят на 7 нм только TSMC и Samsung.

Фотолитография в глубоком ультрафиолете

Электронная литография

Ионно-лучевая литография

Рентгеновская литография

Желающие могут перевести такие статьи, как приведённые ниже — пользы будет больше, чем от имеющейся:

Extreme ultraviolet lithography

Multiple patterning

purpure

07.09.2018 11:02Не «элементы вытравливаются на кристалле с помощью света», а «электронная схема создаётся на кристалле с помощью света и светочувствительных химических веществ». Травление — кислотой (или щёлочью).

ИМХО, правильнее будет «рисунок топологии электронной схемы будущего чипа формируется на поверхности кристалла с помощью света и светочувствительных химических веществ».

Про травление уже говорил ниже. В остальном всё по делу.

beeruser

07.09.2018 14:06+3Основная причина — сворачивание научных разработок по физике в бывших лидерах — СССР и США.

С чего бы? GF прямо сказали что им арабы отказались оплачивать банкет.

К тому же уже сделаны тест чипы на 3нм у IMEC. Видимо научные разработки СССР им были совсем не нужны.

totally_nameless

07.09.2018 04:37Травление — кислотой (или щёлочью).

Справедливости ради, не всегда — Dry_etching

Не «EUV-литография генерирует слишком много дефектов при производстве чипов», а «при использовании фотолитографии в глубоком УФ процент выхода годных изделий остаётся низким».

Проблема комплексная. В низком проценте выхода годных кристаллов может быть виноват и сканер, который делает маску, и оборудование, которое осуществляет etching/deposition.

Когда говорят, это виновата EUV литография, обычно имеют ввиду, что сканер не mass-production ready. Другими словами он делает нормально, но медленно. Первый EUV сканер ASML поставила в Intel аж в апреле 2017. Большой шаг, кстати. С тех пор Intel и ASML тестируют и допиливают.

Главная надежда на EUV еще и потому, что старые ухищрения вроде OPC и Multiple_patterning для повышения точности печати маски постепенно перестают работать ниже 10nm. Для EUV они (почти) не нужны из-за того, используется лазер с длиной волны 13.5nm вместо 193nm, как в предыдущих. Именно поэтому, должна уменьшиться стоимость разработки нового чипа.

Одна из основных проблем с EUV — низкая энергия лазера долетающая до фотомаски, приходится держать «долгую выдержку», а попытки повышения мощности вызывают такой каскад инжереных проблем, что несколько книг можно написать.

TSMC — тоже занимающейся производством полупроводников

Тоже повеселило… Это как сказать, что GM тоже производит автомобили.

purpure

07.09.2018 10:20Справедливости ради, не всегда — Dry_etching

Справедливости ради, классическое проявление как раз и производится щелочными растворами разными. Dry etching — это процессы травления слоёв структур будущих чипов по маске, сформированной процессами фотолитографии. У вас же по ссылке именно это и описано:

Dry etching is used in conjunction with photolithographic techniques

gshamshurin

07.09.2018 07:01+2Я под выход 10-нм десктопных чипов (пониженное тепловыделение при повышенной производительности) уже и самый топовый пассивный кулер для нового процессора купил, и самый топовый пассивный кулер для видеокарты и даже блок питания с пассивным режимом работы. А выход всё откладывается, откладывается, откладывается.

Мне кажется, по закону Мерфи, 10-нм чипы выйдут ровно через месяц после того как я устану ждать и соберу новую систему на будущем 14-нм i9-9900 :(

8street

07.09.2018 09:25+1Перейти с 14 на 7нм это примерно тоже самое, как перейти со 100 до 50нм. Разница в 2 раза. В прошлом на это потребовалось около 10 лет. А еще я помню, лет 10 назад утверждалось, что кристаллы с менее 10нм техпроцессом производить не удастся. И тогда начали искать замену кремнию. Помню графену пророчили высокое будущее. Жаль, что все заглохло.

San_tit

07.09.2018 09:35Не заглохло, но исследования пока на уровне производства отдельных транзисторов и простых микросхем даже в РФ (из того, что я слышал лично), как дела вообще обстоят: не знаю, но что-то ещё делается. Интерес упал скорее из-за того, что преодолели очередной непреодолимый рубеж техпроцесса.

amartology

07.09.2018 10:20+2А еще я помню, лет 10 назад утверждалось, что кристаллы с менее 10нм техпроцессом производить не удастся.

Так и не удается) Если строго подойти к старому определению проектных норм, а не к маркетинговому буллшиту про 10-7-5 нм, то проектные нормы 7 нм TSMC на самом деле где-то в районе 40 нм находятся.

Varim

07.09.2018 10:54проектные нормы 7 нм TSMC на самом деле где-то в районе 40 нм находятся.

А вы не знаете случайно, в двух словах, что они сейчас называют 7 нм? Я предположу что раньше это было отношение длины на кол-во транзисторов, а сейчас, возможно, поперечный размер проводника между транзисторами.

Хотя 2 нм, наверное даже для проводника слишком тонко. Неужели маркетологи сейчас вообще ни на что физическое не опираются?

amartology

07.09.2018 11:28+2А вы не знаете случайно, в двух словах, что они сейчас называют 7 нм?

Случайно знаю. Раньше «проектнми нормами» называли минимально возможный топологический размер, который обычно совпадал с минимальной длиной канала транзистора. Потом уменьшать длину канала стано невозможно по физическим причинам (электроны начали пролетать из истока в сток насквозь, без взаимодействия с каналом), а красивые цифры инвесторам показывать все равно приходилось. Плюс в какой-то момент начали появляться FinFET, в которых длина канала не прямо зависит от литографии.

В итоге никакого физического смысла в цифре названия техпроцесса нет уже несколько лет как, это просто условная система нумерации поколений. По факту например, у Самсунга в 7 нм и 5 нм сами транзисторы будут одинаковые, а все изменения коснутся других частей технологии.

purpure

07.09.2018 11:29Число, которое указывается в проектной норме техпроцесса — это минимальная длина канала транзистора для данного техпроцесса. Например, для проектных норм, допустим, 40 нм, минимальная длина канала транзистора составит те же 40 нм. Однако, по этому же техпроцессу 40 нм в топологии схемы могут использовать транзисторы и «пожирнее» — 65 нм и т.д. Самые маленькие транзисторы используют, в основном, в блоках логики микросхем (чтобы работали быстрее), остальные элементы могут быть выполнены по более толстым нормам (в пределах разумного, конечно же).

По поводу того, какие уловки используют для преодоления барьера при уменьшении проектных норм, немного написано в статье amartology. Но я бы также с удовольствием послушал его более развёрнутый комментарий на эту тему :)

P.S.: Эх, опередили меня.

amartology

07.09.2018 11:35+9Я и опередил. Не знаю, насколько комментарий выше может считаться развернутым, но если действительно интересно, я могу даже наверное написать статью о том, какого на самом деле размера эти 7-10 нм.

splav_asv

07.09.2018 11:29Вроде бы размер норм близок к длине затвора транзистора. Ширина проводника примерно в 4 раза больше.

geher

07.09.2018 11:31Сейчас это вроде размер затвора транзистора, если не путаю.

Учитывая успехи в посттоении экспериментальных мономолекулярных элементов (вроде про работающий диод что-то было), при такой оценке можно говорить в теории и о 2 нм техпроцессе, особенно если рассматривать не ширину, а толщину затвора.

amartology

07.09.2018 11:51+1если рассматривать не ширину, а толщину затвора.

Делать затвор тоньше перестали еще на 45 нм, когда туннельный эффект через SiO2 начал приводить к тому, что транзисторы из MOSFET стали превращаться в JFET. Тогда в ход в затворах вместо SiO2 пошли соединения гафния (high-K диэлектрики), из которых затвор можно сделать толще, предотвратив туннелирование.

Но вообще с точки зрения маркетинга идея богатая, можно 180 нм переименовать в 10 нм)

Mad__Max

07.09.2018 23:32Не требовалось.

В реальности 100 нм ==> 50 нм перехода правда не было, но например очень близкие реальные 130 нм ==> 90нм ==> 65 нм гораздо быстрее проскочили, чем за 10 лет:

130нм освоили в 2001м году, а в 2004м уже были первые чипы на 65нм. Или если по выходу серийной массовой продукции — то 2002 и 2006 годы соответственно. Т.е. всего 4 года.

Ну или 90 нм ==> 45 нм, примерно те же 4-5 лет на переход, а не 10+.

И это были те же самые уменьшения ровно в 2 раза (или в 4 раза если по площади элемента). Причем в отличии от текущих маркетинговых попугаев это было реальное уменьшение размеров практически всех элементов в 2(4) раза!

8street

08.09.2018 08:36Точно не помню про переход с 100 до 50, это я так сказал, для ровного счета. А вообще, у меня в 98м году был P2 на 180нм, а в 2008 стояла карта 8800gtx с 90нм чипом. Ну не 10 лет, а 7-8.

DrPass

08.09.2018 11:17+1а в 2008 стояла карта 8800gtx с 90нм чипом

Ну то просто карта такая. Процессоры-то в 2008-м Интел уже по 45 нм выпускала.

Mad__Max

09.09.2018 03:28P2 скорее всего на 250 нм был (ядро Deschutes). 180 нм только самые поздние мобильные версии P2 выпускались и они попозже появились, а в обычных компах только с P3. Которые изначально тоже на 250 нм технологии производились — ядро Katmai и только потом были на 180нм переведены уже в 2000м году — ядро Coppermine.

Ну а карта просто по несколько устаревшему (на тот момент) процессу. У того же Intel еще аж 2006 году уже вышли серия процессоров Core 2 изначально производившихся по на 65нм технологии.

Т.е. в рамках одной компании(Intel) и одной продукции (CPU)

1997 — выход P2 на 250нм

2006 — выход Core 2 на 65 нм

Тут почти 4 кратное уменьшение норм меньше чем за 10 лет.

im_stD

07.09.2018 09:54Разрешите «вопрос на понимание»: в начале статьи написано — «Производитель получает возможность увеличить быстродействие микросхемы, оставив её размеры на прежнем уровне.» Быстродействие увеличивается за счёт того, что уменьшается длина проводника между слоями? То есть электрический сигнал быстрее проходит?

Temtaime

07.09.2018 10:14Полагаю, потому что можно засунуть больше исполнительных блоков в тот же физический размер.

Если бы сигнал ходил быстрее — повышали бы частоту, а с этим есть проблемы.

amartology

07.09.2018 10:24Быстродействие микросхемы в целом увеличивается за счет роста количества транзисторов,

а быстродействие отдельных элементов может стать даже хуже из-за того, что растет влияние паразитных емкостей, сопротивлений и индуктивностей соединений. Если раньше транзистор для переключения заряжал затвор следующего транзистора и немного паразитных емкостей, то сейчас он заряжает длинную линию связи со следующим элементом и, на сдачу, сам следующий элемент.

crea7or

08.09.2018 22:42А с частотами какая проблема? Больше 10-ти лет назад были 3ГГц+ процессоры — так они там и болтаются.

amartology

08.09.2018 23:03С частотами проблема такая, что зарядка паразитных емкостей межсоединений занимает много времени и тратит много энергии. Для того, чтоб разгонять те процессоры до 3 ГГц, делали конвейер на 20+ ступеней, чтобы за один такт делались очень маленькие и поэтому очень быстрые вычисления. Но эта концепция дошла до логического предела, поэтому потом произошло резкое падение частоты за счет упрощения конструкции ядра с одновременным размещением на кристалле нескольких ядер.

purpure

07.09.2018 10:42+1В принципе, практически в каждом комментарии ругают перевод (и небезосновательно), но я не мог не зацепиться:

Однако Дэвид Хемкер (David Hemker), старший VP в компании Lam Research, производящей полупроводники

Lam Research — компания, которая занимается изготовлением оборудования для производства полупроводников.

Тема микроэлектроники сама по себе сложна для восприятия обычному обывателю, а с таким подходом к публикации статей и подавно. Не надо так.

Alex023

07.09.2018 11:04Поэтому в будущем мы определённо увидим применение этим технологиям, только этот момент может наступить немного позднее, чем предполагалось изначально.

Вынесет всё — и широкую, ясную

Грудью дорогу проложит себе.

Жаль только — жить в эту пору прекрасную

Уж не придется — ни мне, ни тебе.

Н.А. Некрасов

dubakov

07.09.2018 13:16Когда я был молодым, а компьютеры были 486-ми, в каком то умном журнале я читал, что технологический предел составляет примерно 35 нанометров. Меньше сделать невозможно. Что изменилось?

amartology

07.09.2018 15:24Многое. Появились новые материалы (в частности, High-K диэлектрики), а транзисторы стали непланарными. Последние лет пятнадцать ученые только и занимаются тем, что ищут способы обойти этот технологический приедел)

timdorohin

07.09.2018 16:27Давно интересует вопрос, можно ли с современной литографией (или не очень современной, но с энергоэффективным техпроцессом) уйти в настоящее 3д (объемные схемы расположения транзисторов, что должно также сократить среднюю длину проводника — в конце концов мы уже не на плоскости) и получить эдакий кубик сантиметр на сантиметр, работающий на 50-100-200МГц в котором миллион вычислительных ядер связанных сетью (так называемая Сеть-на-кристалле, NoC)?

amartology

07.09.2018 16:43Технологически это очень сложно. Точнее, в принципе реализуемо (флэш-память тому пример), но неразумно дорого. Но по этому пути уже частично идут — при помощи 3D-интеграции и TSV. Вот тут я немного писал об этом. Связывать вообще все и везде не надо, можно делать сверху вниз только какие-то магистральные шины, а локальные. Собственно, большинство современных высокопроизводительных схем так и сделаны сейчас, только немного не в тех масштабах, о которых вы говорите.

Кроме того, от кубика в кубический сантиметр (или кубический дециметр) довольно тяжело отводить килоВатт тепла)

timdorohin

07.09.2018 16:57Кроме того, от кубика в кубический сантиметр (или кубический дециметр) довольно тяжело отводить килоВатт тепла)

А я потому и упомянул частоты 50-100-200МГц, с ULP техпроцессом скорее всего получится <15Вт на кубик. ЕМНИП техпроцессы с минимальной утечкой до сих пор 130-65 нм… хотя они и в работе не особо жрут тоже.

tnenergy

07.09.2018 16:54А охлаждать как?

timdorohin

07.09.2018 16:59Это вопрос тепловыделения, на низких (до пары сотен мегагерц) частотах и низком напряжении чипы могут быть очень холодными.

amartology

07.09.2018 17:56Тогда расскажите, какой смысл делать много чипов на низкую частоту, когда можно сделать один на высокую? Физику не обмануть же, у вас есть энергия на логическое переключение, и если для решения вычислительной задачи вам нужно сделать Х переключений, то нет разницы, на скольких чипах и с какой частотой вы их сделаете.

timdorohin

07.09.2018 20:19+1если для решения вычислительной задачи вам нужно сделать Х переключений, то нет разницы, на скольких чипах и с какой частотой вы их сделаете.

Маленький прикол — эффективность процессоров падает с ростом частоты (так как ради повышенной частоты повышают напряжение, а от него потери зависят квадратично)

Если бы сейчас могли упихать миллион-другой ядер в кристалл — пихали бы, особенно в специальные устройства. Видеокарты тоже уперлись в кристалл, поэтому если раньше он топтались в догигагерцовом диапазоне, то сейчас начали из него выходить — не могут наращивать ядра, так приходится наращивать частоты.

Mad__Max

07.09.2018 23:54Есть и огромная разница — низкочастотные чипы намного эффективнее в плане кол-ва операций / Вт мощности или Дж потраченной энергии.

Именно поэтому мощные процессоры для серверов или суперкомпьютеров делают много-многоядерными, но относительно низкочастотными. И одна из причин превосходства GPU над CPU по эффективности вычислений. А любители практикуют downclock+undervolt вместо разгона чипов для долгоиграющих задач, когда вычисления идут 24х7.

Естественно все на классах задач который эффективно могут разбиваться на нужное кол-во выч. потоков. Если задачу невозможно разложить подобным образом, то особых альтернатив высокой частоте и разным «хакам» типа сильно спекулятивного исполнения нет.

В научных исследованиях вообще экспериментируют с совсем низкими частотами и рабочими напряжениями или даже несинхронными чипами не имеющими какой-то конкретной частоты и достигают выигрышей в энергоэффективности вычислений на несколько порядков.

amartology

08.09.2018 11:01В научных исследованиях вообще экспериментируют с совсем низкими частотами и рабочими напряжениями или даже несинхронными чипами не имеющими какой-то конкретной частоты и достигают выигрышей в энергоэффективности вычислений на несколько порядков.

И иногда при некоторых условиях достигают)

Практически все, что реально можно использовать в прикладных задачах, уже реализовано, инженеры гигантов рынка не просто так свой хлеб едят. В том числе переход с длинных конвейеров и больших частот в Pentium 4 на разумно низкие частоты и многоядерность в Core.

yarric

08.09.2018 12:39+1Скорее гиганты рынка наоборот склонны допиливать однажды удавшуюся технологию, а вот реальных инноваций они не любят из-за высокого технологического риска.

Mad__Max

09.09.2018 03:53Ну и как раз там где энергию считают — уже сейчас используют меньшие частоты и большее кол-во ядер именно для прикладных задач: типовые для мощных серверов и суперкомьютеров в 1.5-3.5 ГГц, против 3.5-5 ГГц для «потребительских» процессоров.

Например недавний лидер (1 место в мире в 2016-2018 годов) среди самых мощных суперкопьютеров использовал процессоры работающие на частоте всего 1.45 ГГц: www.nextplatform.com/2016/06/20/look-inside-chinas-chart-topping-new-supercomputer

В общем так уже сейчас разменивают меньшее потребление энергии на ед. выполненных расчетов в обмен на удорожание и усложнение чипа. Или в эконом. терминах — снижают эксплуатационные расходы(на энергию и охлаждение в основном) за счет увеличения капитальных.

При длительных высоких нагрузках это окупается.

В научной части это тоже не голая теория, если планы не порушатся, то некоторые из следующих рекордных суперкомпьютеров будут работать на основе процессоров с рабочими частотами даже ниже 1 ГГц, но при этом обладать рекордным количествами выч. ядер и демонстрировать новые рекорды по энергоэффективности.

Возвращаясь к исходному вопросу — про «настоящие 3D процессоры» — такие были бы востребованы даже при работе на очень низких частотах и напряжениях (и как следствие с небольшим удельном тепловыделении, позволяющим снять большую часть проблем с охлаждением в объеме).

Не в потребительском ширпотребе конечно, но для серьезных задач.

DGN

08.09.2018 00:18-1Можно, но надо учиться прокачивать через кристалл жидкий гелий. Иначе не снять тепло.

Alex_Q

08.09.2018 16:51Тогда можно было бы сразу уйти в резонансное туннелирование и всякие гетеростуктуры

svcoder

07.09.2018 14:05+1Если сравнить процессоры 3930K и 7800X, разница в техпроцессе чуть больше чем в 2 раза 32нм против 14нм, а энергопотребление одинаковое (130W против 140W), учитывая что частота у последнего на 10% выше

Ultratech

07.09.2018 15:18В ASIC-майнерах для биткоина DragonMint от Halong Mining используется 10-нм техпроцесс.В асиках B2 от GMO Internet 7-нм техпроцесс, прием предварительных заказов на B2 стартовал 6 июня, первые устройства, как ожидается, поступят покупателям в октябре.

С точки зрения ценовой политики японское устройство оказывается более дорогим: $1999 за B2 против $837 Antminer S9 с 16-нм чипами. При энергопотреблении 1950 Вт производительность B2 составляет 24TH/s, в то время как у Antminer S9 этот же показатель составляет 14TH/s, при его энергопотреблении 1200 Вт.

По сравнению с B2 на 7 нм, устройство с 16-нм техпроцессом стоит в 2,39 раз дешевле, уступает в производительности в 1,71 раз, при этом кушает в 1,6 раза меньше электроэнергии. 7 нанометровая овчинка выходит слишком дорогой и выделки при текущих рыночных ценах на биткоин не стоит.

Хотя как некий технологический прорыв безусловно интересно

DGN

08.09.2018 00:23Цены на ASIC это маркетинг чистой воды. Никак не связаны с себестоимостью, а лишь с предпологаемым профитом.

Кстати говоря, S9 в специальной жидкости разгоняется до 19ТH при росте потребления 2100 Вт.

abrwalk

07.09.2018 15:51-3Какими будут процессоры Intel Core следующего поколения впринципе понятно уже сейчас.

Возьмут нынешнее 8-е поколение Coffee Lake — сменят жвачку на припой — и вуаля. -20 по цельсию при тех же частотах и напряжении — новое поколение!

(гугли скальпирование процессоров если не понял что я такое несу)

Ну и, разумеется, для проформы добавят какую-нибудь marketing-инструкцию по типу MMX-2020, чтобы не сильно бугуртили.

sumanai

07.09.2018 19:46сменят жвачку на припой

Не сменят, все технологические линии с припоем отправлены на слом уже пару лет назад как.

beeruser

07.09.2018 21:43+3Значит пошли на помойку и забрали обратно, т.к. Core i9-9900K уже показали с припоем

Mad__Max

08.09.2018 00:02Скорее топовые потребительские чипы просто перевели на окончательную сборку на одной из линий использовавшихся для серверных процессоров.

Из которых припой никуда и не уходил.

rogoz

08.09.2018 02:06По результатам гугления Skylake-X(LGA2066) и Skylake-SP(LGA3647 Xeon) без припоя.

Так что на помойку сходить пришлось.

Ogura

08.09.2018 18:37Есть очень простой способ решить проблему низкого выхода.

А именно-матрица.

Матрица это тип мультипараллельных вычислительных систем где данные передаются от процессора к процессору так же как внутри процессора между более простыми компонентами программы нежели процессы причем у каждого своя шина памяти, минуя память все буферизации кроме аппаратного планировщика. Фактически только язык Occam умел с ними работать. При таком подходе и хорошо составленном программном обеспечении, увеличение количества процессоров ведет к пропорциональному увеличению быстродействия.

Хотя разработка ПО отпугнула многих.

Но зато получается что если сделать процессор с минимальной производительностью и минимальной ценой, то поставив больше процессоров можно получить большею производительность.

Но интересно было то что попытавшись разработать самый простой и процессор с налучшим показателем цена/производительность он почему-то получился в несколько раз быстрее тогдашнего i386 при меньшей цене.

(Увы фирма InMOS разработчик таких процссоров разорилась несмотря на 200 миллиардов фунтов правительственных денег по ценам второй половины 1980-х годов.)

Но попытки воссоздать матрицу производились и позже, причем попытались не устанавливать многоядерные процессоры с предсказанием ветвлений и крайне сложными суперскалярными схемами. А простыми схемами, просто много работающих параллельно.

При попадании производственного дефекта на один из процессоров, его можно просто игнорировать не загружая в них ПО. А если на кристалле микросхемы несколько сотен процессов, то даже десяток негодных и схема может быть вполне пригодной для эксплуатации.

Мало того простота электрической схемы и логической модели процессоров позволяет их довольно легко отлаживать к тому же разгонять на очень большую частоту, особенно при низких температурах.

Такой подход применяла некоторая организация с начальством которой я недавно рассорился.

Hardcoin

Не верится. Это можно было бы продать или пустить в работу. Думаю, это "почти" настолько большое "почти", что денег давать никто не захотел.

amartology

Там ещё проблема в том, что пока они это делали, крупнейший клиент (AMD) успел уйти к конкурентам, а продолжать вваливать сотни миллионов в разработку, которая никому не нужна — это действительно неправильно.

Hardcoin

А к каким конкурентам? К Самсунгу? Если у них 7нм в более готовой стадии — тогда логично. А если нет — то 7нм это круче всего, что есть на рынке (коммерчески доступного), как это может быть никому не нужным? Или я чего не догоняю просто?

splav_asv

К TSMC.

Mad__Max

А что к TSMC ушло? Графические чипы (GPU) они и так с древних времен у них всегда заказывали. Еще когда GPU были ATI, не AMD.

А процессоры (CPU, APU) вроде никуда от GF не уходили.

Разве что SoC в частности кастомные чипы для игровых приставок уплыли.

splav_asv

Да почти всё: https://www.forbes.com/sites/marcochiappetta/2018/08/27/all-of-amds-7nm-processors-to-be-manufactured-at-tsmc/#46e867684642

Mad__Max

А, ну т.е. это только речь о планах на следующие поколения чипов.

Тогда тут совершенно не ясно где курица, а где яйцо: толи GF сворачивают работу из-за ухода крупнейшего клиента(заказчика), толи это AMD уходит к TSMC из-за того, что GF все никак не может 7 нм родить.

Они то с учетом тесных связей между компаниями(когда бывшей вообще одним целым) о проблемах/внутренних планах знали наверняка за долго до того, как это было публично озвучено.

splav_asv

Всё так. Окончательные образцы в кремнии Zen 2 уже есть. И, видимо, они с TSMC.

Могу лишь предположить, что GF сроки завалила и AMD приняла решение переметнуться целиком. И GF пришлось сворачиваться из-за потери заказов.

martin_wanderer

Вспоминается одна психологически-экономическая задачка: проектируем самолет стоимостью, условно, 100 млн долларов. Уже потрачено 90, когда выясняется, что конкуренты нас опеределили: их продукт заведомо лучше и как минимум не дороже, и, главное, уже готов. Имеет ли смысл завершать разработку?

Нормальному человеку жалко потраченных средств и сил, но единственно выгодное решение — срочно закрыть проект, а оставшиеся деньги пусть на что-то, что принесет прибыл, в отличие от…

Alexsandr_SE

Не верно. Текущие разработки пойдут в следующие разработки. Если конечно нет идеи все продать и уйти на пенсию. TSMC как мне кажется не справится с выпуском нужного кол-ва кристаллов для видеокарт и ЦП и кучи других заказов.

splav_asv

Значит сможет лицензировать техпроцесс.

sumanai

Это не отменяет закрытия текущего проекта.

Alexsandr_SE

Но это не переводит все деньги в убытки. Иначе эти 90 млн. просто выкинули на ветер. Нужно использовать все, что можно из новых наработок. Вплоть до выкладывания таки оставшихся 10 млн. Нужно все считать, нет единого решения на все случаи.

grekmipt

В общем случае данное утверждение неверное, и как раз таки основанное на ошибочном психологическом восприятии. В подобной ситуации надо осознать что 90 млн УЖЕ выкинуто. Их нет и они не будут компенсированы.

Но при этом так же надо осознавать, что начиная с этой точки, стоимость разработки вашего продукта равна 100-90=10 млн, т.е. меньше в 10 раз. Либо вы инвестируете 10 млн и получаете продукт, либо не инвестируете и не получаете. Уже профуканные 90 млн — это просто некий исторический факт не имеющий отношения к дальнейшим инвестициям. И вопрос на который надо ответить — в том, будет ли отдача от этих вложенных 10 млн выше инвестиций (т.е. выше этих 10 млн, а не исторических 100). Если выше — то разумеется надо эти 10 млн тратить, ибо это будет прибыльно (или, что то же самое, это сократит потери ваших 90 млн на величину прибыли от этих вложенных 10 млн). А разработать продукт за 10 млн или за 100 млн — это очень большая разница, сильно влияющая на дальнейшую ценовую политику по этому продукту, и соответственно на объемы продаж и маржу. Если проинвестировав 10 млн (и таки доделав продукт) вы с них потом заработаете скажем 30 млн, то тем самым полные потери проекта будут сокращены с 90 до 70 млн, что очень даже хорошо.

martin_wanderer

Согласен, любые инвестиции оцениваются в сравнении с другими вариантами. Тут предполагалось, что отдачи совсем не будет, ибо конкуренты займут рынок

unxed

И надо учитывать, что заявления конкурентов о готовности продукта и его характеристиках тоже могут оказать ложными, как раз чтобы вынудить вас свернуть проект.

mapron

Немного не в тему, вспоминается история разработки Starcraft-а, когда близы на демо у конкурентов увидели изометрию в стратегии, и решили сделать так же у себя срочно. Как оказалось, у конкурента ничего рабочего не было по итогу, но Starcraft уже переписали (и не зря)

DrPass

Правильный ответ: в условии задачи недостаточно данных для принятия решения. Следующий вопрос — сможет ли конкурент удовлетворить весь спрос и полностью охватить рынок, пока не выйдет наш продукт? Чаще всего на этот вопрос отвечают «нет». Далее, можно ли внести в разработку изменения, несколько увеличить срок и удорожить её, но на выходе получить иной продукт, который будет несколько выше классом, чем у конкурентов, и который можно будет продать с «люксовой» наценкой? И так далее. Стратегий масса, и «похоронить проект и зафиксировать убытки» — это самая крайняя из них.