Внимание — под катом много фото.

Мы в 1сloud предоставляем услуги аренды виртуальной инфраструктуры с 2012 года. Наш проект начал работу в Петербурге, но со временем мы расширили географию. Сегодня наше железо размещается в четырех дата-центрах: Xelent, Dataspace, Ahost и beCloud. Первый находится в Санкт-Петербурге, второй — в Москве, третий — в Алма-Ате (Казахстан), четвёртый — в Минске (Беларусь).

Во всех этих дата-центрах установлено примерно одинаковое оборудование. И далее мы расскажем, как оно размещается в московском дата-центре.

Безопасность дата-центра

Начнем показ с внешнего периметра дата-центра DataSpace. Здание обнесено пятиметровым мелкоячеистым забором с вращающимися шипами сверху и противоподкопной защитой. Проходы на территорию закрыты полноростовыми турникетами. Рядом с ними стоят посты службы безопасности.

Чтобы попасть «за забор», нужно предъявить бесконтактный ключ и пройти идентификацию на КПП. Если сотрудник забыл удостоверение (паспорт), ему придется идти за ним домой.

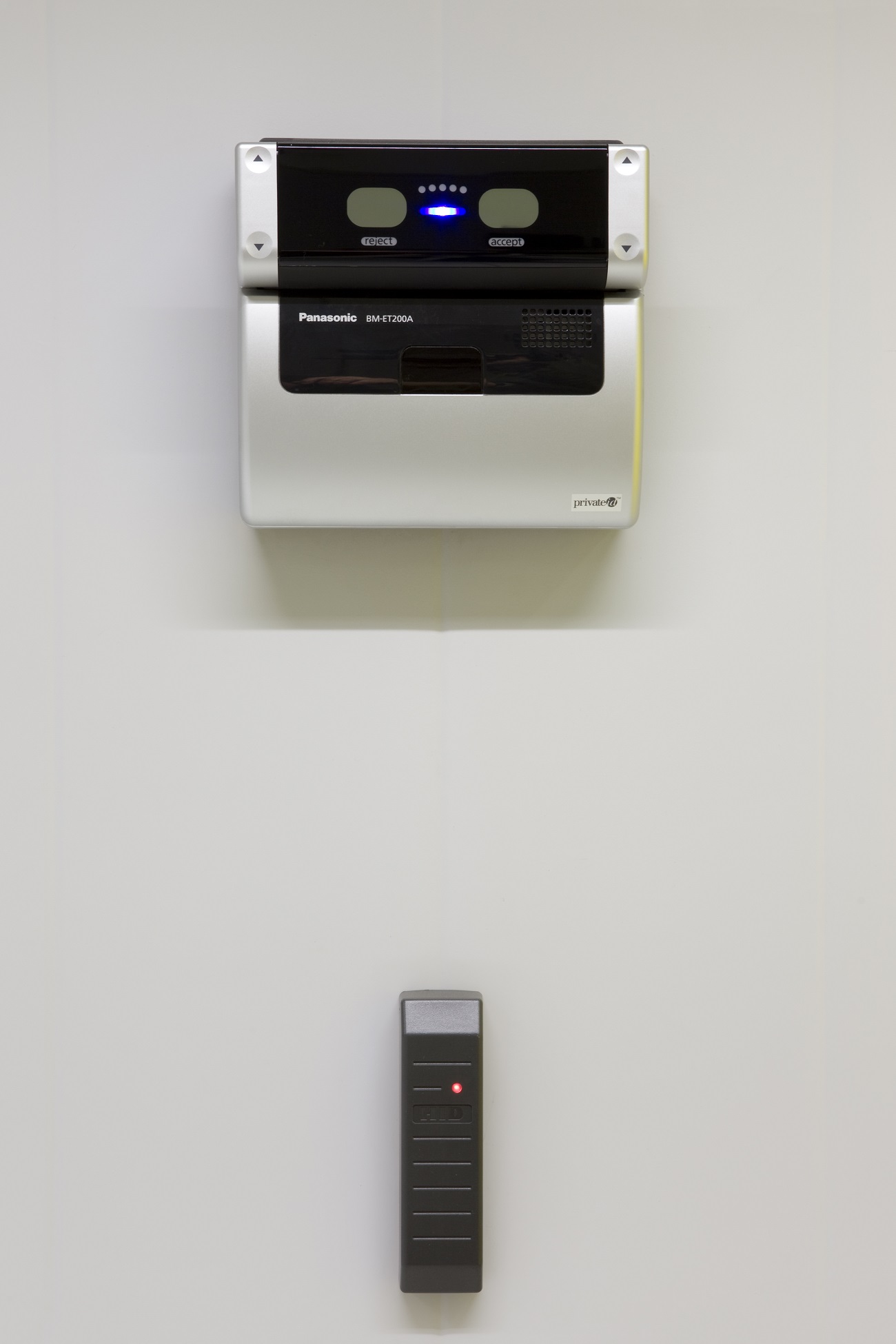

Следующий «рубеж» — бронированные шлюзовые кабины в зоне приема посетителей. В кабинах стоят считыватели карт доступа и сканеры отпечатка ладони.

Между кабинами можно увидеть две таблички Tier III. Dataspace — это первый дата-центр в России, который прошел три этапа сертификации Tier III от Uptime Institute.

На фото выше — сканер сетчатки глаза. Они установлены на входе во все помещения с критическим оборудованием инженерной инфраструктуры центра обработки. Помимо сканеров, доступ все так же контролируется электронными ключами.

Также на всей территории дата-центра ведется видеонаблюдение. По всему комплексу установлено более ста видеокамер, записи с которых хранятся не менее пяти лет.

Дата-центр предоставляет возможность организовать выделенное защищенное пространство (клетку).

Наше оборудование расположено в обычных стойках DataSpace. Мы арендуем стойки целиком. У нас большой объем оборудования, поэтому доступ к нему должен быть только у наших специалистов.

Электропитание и охлаждение

Один из наиболее заметных нюансов в зале — заземление. Шина медная и подключена к внешнему контуру заземления.

Согласно требованиям ЦОД, заземляется все оборудование, требующее для своей нормальной работы отдельной линии заземления, в соответствии со стандартом ГОСТ 12.1.030-81 (система стандартов безопасности труда).

Работы по подключению оборудования к сети электропитания и к шинам защитного заземления проводят исключительно сотрудники дата-центра. Все провода маркируются.

Хаотичное распределение кабелей приводит к потерям воздушного потока, что может вызвать перегрев оборудования и вывести его из строя. Чтобы исключить перегрев (и выполнить требования корпоративных стандартов качества выполняемых работ) в DataSpace кабели проложены в специальных лотках. В качестве бонуса эффективный кабель-менеджмент помогает снизить энергопотребление систем кондиционирования.

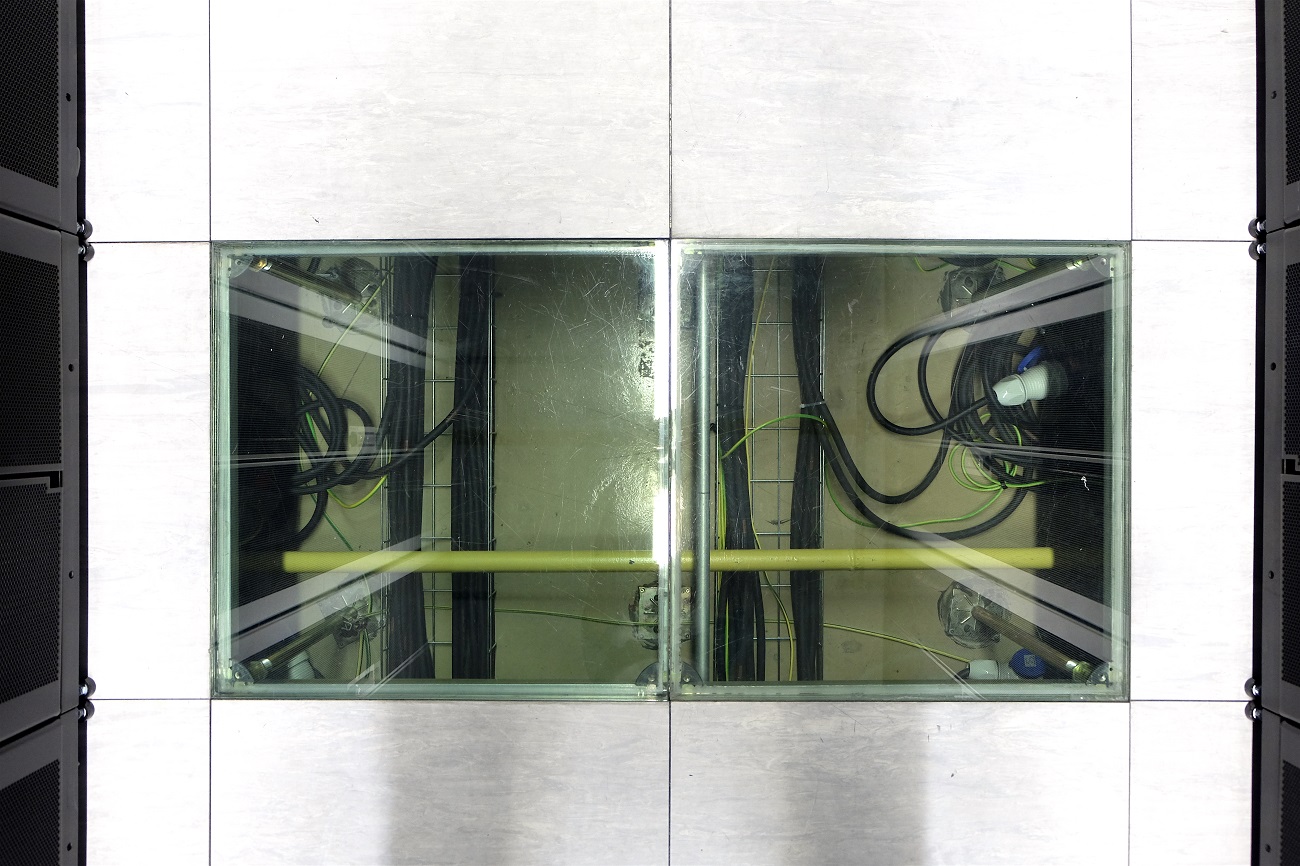

Стандартно, каждая стойка получает два независимых защищенных луча электропитания. Кабели электропитания проложены под фальшполом, высота которого составляет 60 см. Фальшпол можно трансформировать, изменять расположение плит. Это дает возможность при необходимости переставлять стойки с оборудованием.

В машинных залах дата-центра организованы холодные коридоры. Из них оборудование получает воздух для охлаждения и выдувает его в сторону горячего коридора. Холодный коридор отделен от горячего, чтобы избежать перемешивания воздуха и, опять же, сократить расходы на кондиционирование.

К слову, параметр энергоэффективности функционирования ЦОД DataSpace (этот параметр называется PUE) составляет 1,5. Он равен отношению общей мощности, потребляемой дата-центром, к мощности, потребляемой железом в стойках. Для сравнения, средний коэффициент PUE по Европе равняется 1,8.Помимо кабель-менеджмента и холодных коридоров, достигнуть такого показателя энергоэффективности DataSpace помогает технология фрикулинга. ЦОД отключает чиллеры зимой и охлаждает машинные залы за счет холодного воздуха с улицы. Это позволяет значительно сократить траты электроэнергии и уменьшить счета за электричество.

Стойки и оборудование

В дата-центре двенадцать серверных залов площадью в 250 кв. метров каждый. Все они одинаковые и стоят на втором, третьем и четвёртом этажах. В каждом зале стоят примерно 88 стоек.

У каждого клиента ЦОД свои ключи от стоек с оборудованием. Дубликат есть у сотрудников DataSpace, поэтому если нужно сделать простую операцию с железом: заменить диск, переключить соединение, произвести реконфигурацию оборудования, необязательно высылать своего специалиста. Можно попросить об этом инженеров на месте — это нормальная практика, которая предоставляется в рамках клиентской поддержки ЦОД.

На фото ниже — подъемный стол, на котором перемещают серверы, коммутаторы и другое оборудование. Без таких «тележек» никак — вес отдельных шасси с дисками может составлять десятки килограмм. Если пришла большая поставка железа, сотрудники дата-центра могут предоставить эти тележки (и другой рабочий инструмент) в пользование.

Далее, покажем само железо. Начнем с системы хранения данных NetApp E2860. Максимальное количество поддерживаемых дисков — 60 штук. Пока что в ней заняты 30 слотов — там стоят 8-терабайтные накопители. Еще у нас есть более ранняя модель СХД — NetApp E2760.

Это довольно медленные системы, потому они используются в качестве холодного хранилища — там лежат бекапы.

Сзади у NetApp E2860 расположились контроллеры и блоки электропитания.

Еще одна из установленных СХД — NetApp FAS2554 с полкой расширения DS4246. В ней стоят SATA-диски в количестве 24 штук. Каждый из них имеет объем в 4 ТБ. Это хранилище тоже отведено под бекапы и «медленные» датасторы.

Cisco UCS FI 6296 — свитчи комплекса Cisco UCS. Это центральные устройства, которые отвечают за подключение всех серверов в стойке к сетям 10GbE и Fibre Channel. Система имеет 48 фиксированных портов и слоты для трех расширительных модулей, каждый из которых добавляет еще 16 Ethernet-портов. При этом порты многофункциональны — они поддерживают технологию FCoE (Fibre Channel over Ethernet).

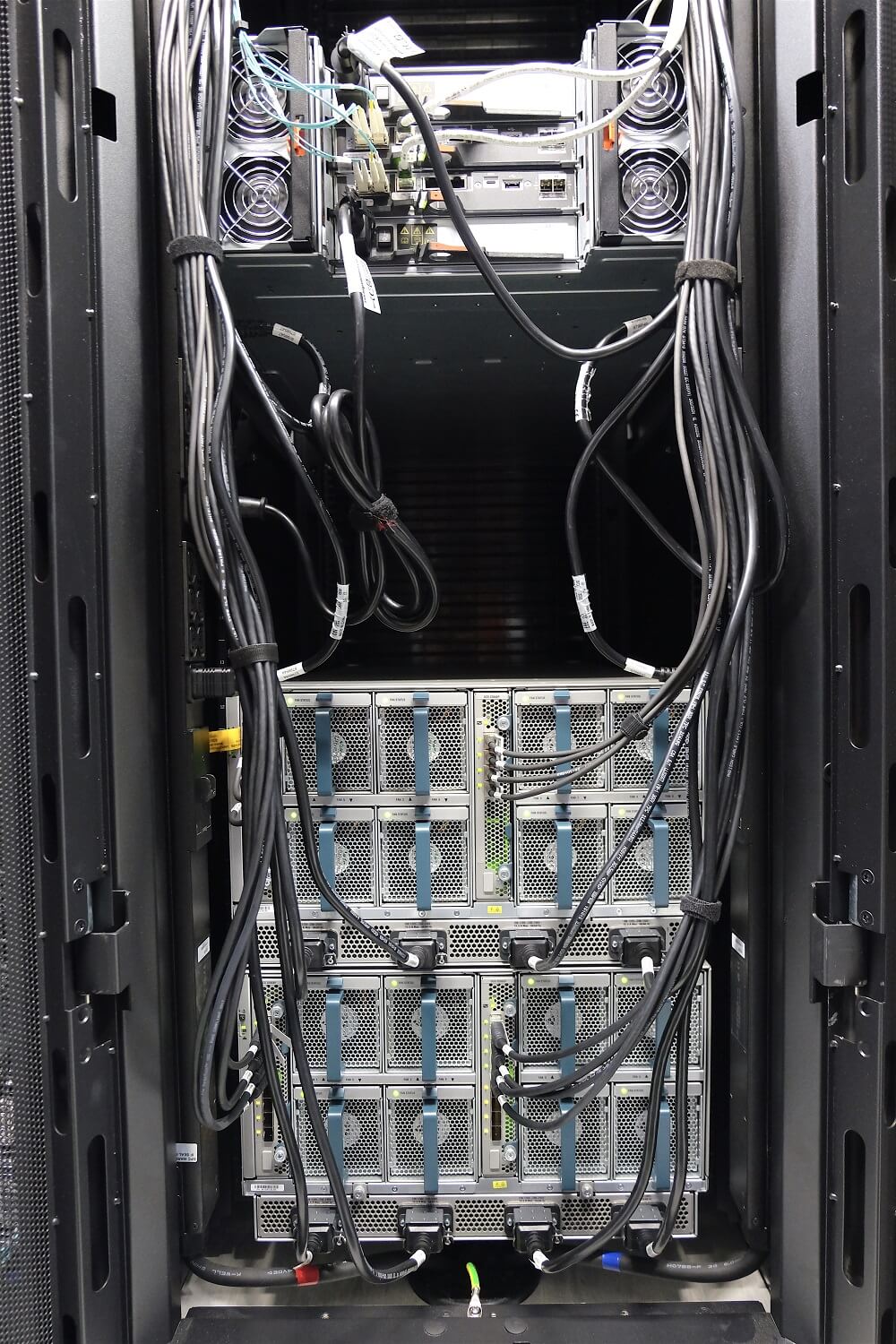

К Cisco UCS FI 6296 подключаются серверные корзины Cisco UCS 5108 с блейд-серверами B200 M3, B200 M4 и B480 M5. В частности, модель B200 M3 имеет два 10-ядерных процессора Intel Xeon E5-2690 v2, а B200 M4 — два 20-ядерных процессора Intel Xeon E5-2698 v4.

Здесь видно NetApp E2860, установленный в верхней части стойки и две корзины Cisco UCS 5108 внизу.

СХД NetApp AFF300, специально оптимизированная для работы с SSD-накопителями. Над ней расположилась полка DS224С с двадцатью четырьмя SSD-дисками по 7,6 ТБ.

Всего система NetApp AFF300 может обслуживать до 30 ПБ дискового пространства на быстрых «твердотельниках».Управляют системой два 16-ядерных процессора Intel Broadwell-DE. Их частота составляет 1,70 ГГц. Каждый контроллер имеет четыре модуля оперативной памяти RDIMM ECC по 32 ГБ (это 128 ГБ в сумме). 120 ГБ выделено под кеш, а оставшиеся восемь — под энергонезависимую память NVRAM.

На фото выше — СХД NetApp FAS8040 с полками расширения DS2246. Это гибридные полки с SAS-дисками емкостью в 1,2 ТБ. Массивы серии FAS8000 тоже имеют многопроцессорные CPU от Intel и NVRAM. Они гарантируют уровень доступности системы не ниже 99,999%.

В этой СХД используются SSD-накопители, которые выступают в роли флеш-пула (flash pool).

Так выглядят NetApp FAS8040 и полки расширения DS2246 сзади с коммутационными проводами.

И, наконец, в наших стойках стоят кластерные свитчи NetApp CN1610. Они используются для объединения контроллеров FAS8040, FAS8080, AFF300 в единый кластер СХД (Clustered ONTAP).

На этом мы закончим нашу фотоэкскурсию по облаку 1cloud.

Если у вас есть вопросы о структуре и архитектуре облака, можете написать нам на почту: support@1cloud.ru. Наши специалисты помогут и проконсультируют.

Несколько постов из нашего корпоративного блога:

Комментарии (41)

Ivanii

25.11.2018 14:00Если земля лежит отдельно от питающей сети то при грозовом разряде в «витке» между питанием и землей формируется ЭДС и чем толще земля тем больше возможной ток…

third112

25.11.2018 15:31в DataSpace кабели проложены в специальных лотках

А почему не в коробе (пластмассовом или из листового металла)? — Так кабели лучше защищены от случайных повреждений, нпр., при ремонте близкорасположенных светильников и т.д. И потом пыли меньше набирают. Даже если противопылевой режим помещения, то немного пыли всегда есть.В машинных залах дата-центра организованы холодные коридоры. Из них оборудование получает воздух для охлаждения и выдувает его в сторону горячего коридора.

Здесь не понятно: холодный воздух поступает на стойку снизу из под фальшпола?

algotrader2013

25.11.2018 18:00СХД NetApp AFF300, специально оптимизированная для работы с SSD-накопителями. Над ней расположилась полка DS224С с двадцатью четырьмя SSD-дисками по 7,6 ТБ.

Наверное, вопрос нубский, но мне, как неспециалисту в СХД, любопытно, какой суммарный поток данных может отдать такая система при линейном чтении. Также интересно, как организована сеть, чтобы не стать узким горлышком для 24 одновременно задействованных SSD — простым умножением выходит 103Гбит/с для самых дешевых дисков, а если говорить о серьезных дисках, то цифры вообще космические.

И, как я понимаю, такое количество дисков — это работа почти в холостую —

Всего система NetApp AFF300 может обслуживать до 30 ПБ дискового пространства на быстрых «твердотельниках».

То есть, СХД способна работать с потоком данных от тысяч быстрых дисков?

navion

25.11.2018 18:44Наверное, вопрос нубский, но мне, как неспециалисту в СХД, любопытно, какой суммарный поток данных может отдать такая система при линейном чтении.

В районе 6 ГБ/с с пары контроллеров. У классических СХД огромный оверхед и они используют всего 10% от возможностей дисков.

algotrader2013

25.11.2018 19:41Спасибо за ссылку — у меня не нагугливалась. Интересно, а если собрать сервер вроде описанных тут, то получится ли отдать хотя бы 10ГБ/c по сети, используя несколько сетевых карт?

justhabrauser

25.11.2018 21:12Сейчас мне накидают, конечно — но есть вопрос: почему же этот ваш 1cloud

так хреновоне очень хорошо работает?

Одно дело — реклама на хабре. Совсем другое — когда бухгалтеры глотки выгрызают перед квартальными.

1cloud Автор

26.11.2018 18:40Добрый день.

Не совсем понятно, с какой проблемой вы столкнулись?

Напишите, пожалуйста, в личку — разберемся.

facetus

25.11.2018 21:52А кто ваши клиенты? Не конкретно, но так чтоб понимать…

1cloud Автор

26.11.2018 18:45Клиенты очень разные.

От рядовых пользователей, которым нужно сайт разместить на VDSке, до больших компаний, которые строят на нашей базе распределенную инфраструктруру для своих сервисов, ИТ-отделов и т.д.

Интеграторы, вебстудии, 1C-франчайзи и вольные админы, фрилансеры всех мастей, маркетологи и т.д.

Сервис позволяет решать задачи в очень широком диапазоне, потому разных клиенстких кейсов тоже очень много.

gangstarcj

25.11.2018 22:37Вокруг турникета на второй фотографии такие огромные дыры. Любой форточник залезет без проблем

awsswa59

26.11.2018 07:46Когда нам рассказывают про импортозамещение вы можете поглядеть как оно выглядит на самом деле. И российского наверно только коврики резиновые и воздух.

1cloud Автор

26.11.2018 18:48О каком-либо импортозамещении в рамках серверного оборудования и всего с ним связанного сейчас не может быть и речи.

Его просто нет по факту. А то что есть — непригодно для коммерческих сервисов.

super-guest

26.11.2018 13:53Интересно, а как осуществляется эвакуация в случае пожара? Через те же «стаканы» и «миксер» или есть задняя дверка?

navion

26.11.2018 14:25Точно есть дебаркадер для ввоза оборудования, потому что даже обычный сервер через такие двери хрен затащишь, а клиенты привозят целые стойки.

navion

26.11.2018 14:31На пятой фотке точно клетка в машзале? Как-то черезчур брутально, обычно они сделаны изящней:

valdemartorch

26.11.2018 18:52Почему нет вида всего ангара?

1cloud Автор

26.11.2018 18:53Пост задумывался именно как фотоэкскурсия.

+ на объекте снимать можно только согласованные места. Там размещено оборудвоание очень многих больших компаний. Не все их них хотят, чтобы их оборудование попало в кадр.

tvr

27.11.2018 12:53Там размещено оборудование очень многих больших компаний. Не все их них хотят, чтобы их оборудование попало в кадр.

«У нас есть ТАКИЕ приборы! Но мы вам о них не расскажем.»

Хотя казалось бы, что может быть лучшей рекламой, чем бренд крупным планов в интерьере хорошего ЦОДа? Или там хамон с пармезаном в холодильниках?

Tetragonchik

26.11.2018 18:57Весомый аргумент в вечном холиваре «свой сервер или арендованный».

1cloud Автор

26.11.2018 18:58Это дейсвительно весомый аргумент.

Обеспечить схожий уровень безопасности и стабильности, как это делает ЦОД, большинству компаний не под силу, просто из-за масштаба.

Yo1

27.11.2018 10:33+1после вашего фейла с левым юзером, весьма смелое заявление.

я бы доверился лишь первой тройке…

1cloud Автор

27.11.2018 16:36Фейл был знатный, тут даже спорить не станем.

Тем не менее, ситуацию мы эту отработали, уязвимость закрыли, в процессах учли…

Человеческий фактор присутсвует везде, к сожалению.

Но, опять же, учитывая объемы задач связанных с безопасностью и админитсрированием, которые решает iaas-провайдер, накопленный опыт у него, в том числе по отработанным ошибкам, гораздо выше чем у сотрудников обычного ит-отдела.

Anton23

Мда уж, жесть. Безопасность — как будто в секретной лаборатории.

ProgerMan

Почти также, как проход на закрытую территорию в одном закрытом уральском городке. Хотя работают там с вещами поопасней, что очень удивило.

1cloud Автор

На то он и центр обработки ДАННЫХ.

Данные сейчас реально становятся чуть ли не главным активом большинства компаний.

И отношение к ним должно быть соответсвующим.

По крайней мере мы придерживаемся такой позиции.

1cloud Автор