Часть 1: 1976-1995 годы

Часть 2: 3Dfx Voodoo

Падение 3Dfx и расцвет двух гигантов

На рубеже веков отрасль графики демонстрировала тенденции к дальнейшей консолидации.

С профессионального рынка полностью ушла iXMICRO, а NEC и Hewlett-Packard выпустили свои последние продукты — серии TE5 и VISUALIZE FX10. После продажи RealVision компания Evans & Sutherland тоже покинула отрасль, сосредоточившись на проекционных системах для планетариев.

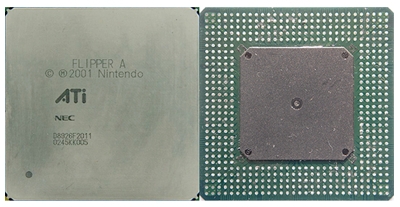

На рынке потребительской графики ATI объявила о приобретении в феврале 2000 года ArtX Inc. за 400 миллионов долларов. ArtX разрабатывала GPU под кодовым названием Project Dolphin (который позже назвали «Flipper») для Nintendo GameCube, что значительно увеличило годовую прибыль ATI.

GPU компании ATI для GameCube

Также в феврале 3dfx объявила о сокращении штата на 20%, а сразу после этого купила Gigapixel за 186 миллионов и получила её технологии рендеринга на основе тайлов.

Тем временем S3 и Nvidia завершили свои масштабные патентные войны и подписали семилетнее соглашение о перекрёстном лицензировании.

Примерно в апреле-мае VIA получила контроль над S3, которая сама завершала процесс реструктуризации после приобретения Number Nine. Как часть реструктуризации S3 компания выполнила слияние с Diamond Multimedia благодаря обмену акциями на сумму 165 миллионов долларов. Отдел FireGL компании Diamond, занимавшийся профессиональной графикой класса high-end, был переименован в SONICblue и в марте 2001 года продан ATI за 10 миллионов.

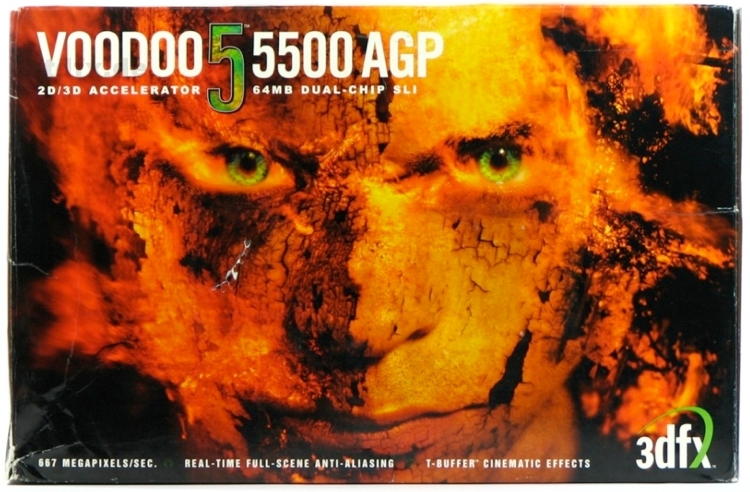

В апреле 3DLabs приобрела Intense3D компании Intergraph, а ближе к концу года разыгралось последнее действие драмы 3dfx, хотя компания лелеяла надежды о светлом будущем, ведь долгожданная Voodoo 5 5500 близилась к июньскому дебюту. Последняя нанесла ответный удар GeForce 256 DDR и выиграла соревнование в высоких разрешениях.

Раньше 3dfx была эталоном сырой производительности, но теперь основной упор делался на качество картинки с полноэкранным сглаживанием. В Voodoo 5 появилась технология T-buffer, альтернативная стандартным преобразованиям и освещению: по сути, она брала несколько отрендеренных кадров и собирала их в одно изображение. При этом создавалась слегка размытая картинка, которая в последовательности кадров сглаживала движение анимации.

Технология 3dfx стала прародителем множества современных методик повышения качества изображения наподобие мягких теней и отражений, размытия в движении, а также размытия глубины резкости.

«Лебединая песня» 3dfx — Voodoo 4 4500 — появилась после нескольких отсрочек 19 октября. В отличие от неё, 4200 и 4800 так и не были выпущены. Изначально выход карты планировался на весну, параллельно с конкурентом — Nvidia TNT2, но вместо этого ей пришлось соревноваться со знаковой GeForce 256 DDR, а также с гораздо более мощными GeForce 2 GTS и ATI Radeon DDR.

14 ноября 3dfx объявила, что она запоздало снижает объёмы производства и продаж карт под собственным брендом. Слухи об этом циркулировали уже давно, но сильно недооценивались. Подлили масла в огонь и новости о том, что материнские платы для будущих Pentium 4 не будут поддерживать передачу по AGP 3.3V, требуемую серии Voodoo 5.

Дизайн коробки Voodoo5 5500 AGP

Похоронный звон для 3dfx прозвучал через месяц, когда Nvidia приобрела её портфолио интеллектуальной собственности за 70 миллионов долларов плюс долю в миллион акций. Светлые головы Интернета заметили, что позже команда инженеров 3dfx, перешедшая в Nvidia, «отомстила» за это и показала свой потенциал, выпустив с запозданием слабый графический NV30 для карт FX 5700 и FX 5800.

Начало эпохи борьбы Nvidia и ATI

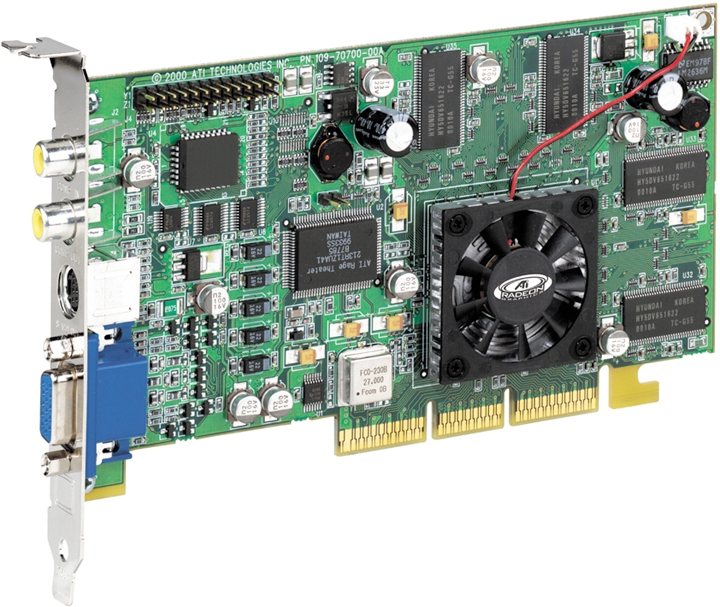

Перед выпуском Voodoo 5 компания ATI объявила о выпуске Radeon DDR, «самого мощного графического процессора для десктопных PC». Предварительные обзоры карты были опубликованы уже 25 апреля, и всего спустя двадцать четыре часа Nvidia ответила на это объявлением о выпуске GeForce 2 GTS (GigaTexel Shader). В последнюю была добавлена собственная версия Nvidia технологии ATI Pixel Tapestry Architecture, названная Nvidia Shading Rasterizer. Она позволяла реализовать аппаратно для каждого пикселя такие эффекты, как зеркальное затенение, объёмные взрывы, преломления, волны, смешение вершин, теневые объёмы, рельефное текстурирование и карты высот.

Считалось, что эта функциональность появилась ещё в предыдущем чипе NV10 (GeForce 256), но была отключена из-за аппаратных проблем. Кроме того GTS повторяла за Charisma Engine ATI, обеспечивая поддержку в GPU вычисление всех преобразований, усечений и освещения. Несмотря на это, ATI сделала ещё один шаг вперёд, добавив вершинный скиннинг для более плавного движения полигонов и интерполяции ключевых кадров: разработчикам достаточно было создать начальный и конечный меш анимации, а ядро Charisma вычисляло промежуточные меши.

ATI Radeon DDR

ATI Radeon DDR была выпущена в розничную продажу в августе 2000 года. Radeon DDR, имевшая превосходную реализацию T&L и поддержку некоторых функций будущего DirectX 8, наряду с GeForce 2 GTS ознаменовала эру использования DVI-выходов благодаря интеграции интерфейса в сам чип. Однако DVI-выход чаще встречался в OEM-картах, поскольку розничные продукты обычно были оснащены раъёмами VIVO.

Недостаток Radeon DDR заключался в том, что вместо обещанных 200 МГц и 183 МГц частоты ядра и памяти были снижены. Кроме того, на момент выпуска драйверы снова оказались далеко не оптимальными. Возникали проблемы с 16-битным цветом и сбои совместимости с чипсетами VIA, но это не помешало карте доминировать среди конкурентов в разрешениях выше 1024x768x32. Цена в 399 долларов за версию с 64 МБ хорошо согласовалась с 349-399 долларами за GeForce 2 GTS 64MB, которую она обгоняла в бенчмарках на 10-20%, что помогло ATI сохранить себе первое место на рынке графики.

У Nvidia дела тоже шли не так уж плохо. Компания объявила о чистой прибыли в 98,5 миллиона за фискальный год и о рекордных доходах в 735,3 миллиона, вызванных в первую очередь её стратегией сегментации рынка: в июне была выпущена ослабленная версия карты MX, в августе — модель Ultra с повышенной частотой. Последняя сместила Radeon с трона самой производительной карты, но стоила при этом 499 долларов. Модель Pro появилась в декабре.

Кроме выпуска версий карты GeForce 2 для каждого ценового сегмента, от бюджетной MX до профессиональной Quadro 2, Nvidia также выпустила свой первый мобильный чип GeForce2 Go.

Пока 3dfx в ноябре испытывала предсмертную агонию, Imagination Tech (бывшая VideoLogic) и ST Micro попытались выйти на бюджетный рынок с большими объёмами продаж, выпустив PowerVR series 3 KYRO. Карта, продававшаяся в диапазоне от 80 до 110 долларов (в зависимости от размера буфера кадров), была выгодной покупкой для игры в разрешениях от 1024x768 и ниже. Если бы GeForce2 MX вышла позже, то она стала более популярной, или имела бы не такую агрессивно низкую цену.

KYRO II появилась в апреле 2001 года, по сравнению с оригиналом в ней были повышены тактовые частоты, а сама карта производилась по более мелкому 180-нанометровому техпроцессу ST Micro. Но карта снова столкнулась с жёсткой конкуренцией GeForce 2 MX. Nvidia изменила название карты на MX200 и скинула 40% от её цены, в то же время выпустив MX400 с повышенной частотой и той же ценой, что и у Kyro II.

Когда PowerVR не удалось сохранить за собой первенство в рендеринге на основе тайлов, а ST Micro закрыла свой графический бизнес в начале 2002 года, Imagination Technologies перешла от десктопной графики к мобильной и использовала свой опыт для разработки графики system on chip. Компания лицензировала Series 5/5XT/6 для использования в процессорах ARM на рынках ультрапортативных устройств и смартфонов.

К началу 2001 года на рынке дискретной графики для PC сложилась монополия двух компаний, в дополнение к которым Intel поставляла широкий диапазон чипсетов с интегрированной графикой.

Тем временем Matrox и S3/VIA цеплялись за остатки своих традиционных рынков.

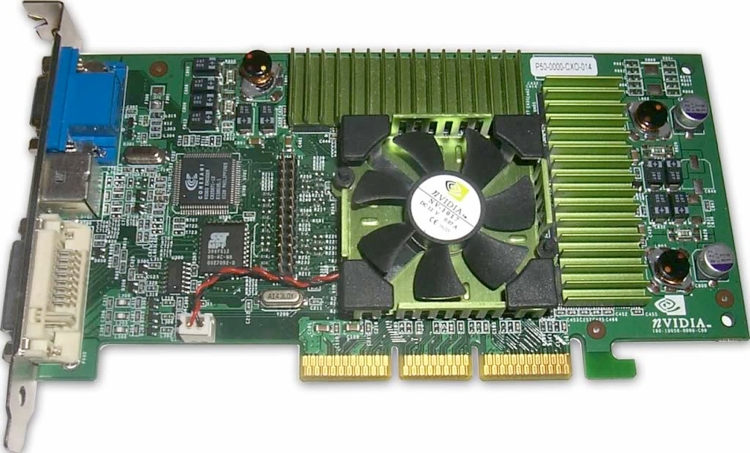

Воспользовавшись импульсом, созданным серией GeForce 2, Nvidia объявила о выпуске 27 февраля 2001 года GeForce 3 по цене от 339 до 449 долларов. Эта карта стала новым царём горы, но в полную силу она раскрывалась только в максимальном разрешении 1600x1200 и с полноэкранным сглаживанием.

Стандартная карта Nvidia GeForce 3

Первые драйверы были багованными, особенно в некоторых OpenGL-играх. Что на самом деле привнесла новая GeForce, так это поддержку DirectX 8, multisampling AA, quincunx AA (по сути, это 2xMSAA + постобработку размытием), анизотропную фильтрацию 8x, непревзойдённую способность обрабатывать 8xAF + трилинейную фильтрацию, а также программируемый вершинный шейдер, позволявший более точно управлять движением полигональных мешей и обеспечивать плавную последовательность кадров анимации.

Также в карте появилась поддержка LMA (Lightspeed Memory Architecture) — по сути, она являлась версией HyperZ разработки Nvidia. Она отсекала пиксели, оказавшиеся на экране за другими (Z occlusion culling), а также сжимала и распаковывала данные для оптимизации использования шины (Z compression).

Наконец, в рамках Crossbar Memory Controller Nvidia реализовала алгоритмы балансировки нагрузки. Crossbar Memory Controller состоял из четырёх независимых субконтроллеров памяти, позволявших более эффективно направлять входящие запросы к памяти (в то время отраслевым стандартом был один контроллер).

Nvidia NV2A внутри Microsoft Xbox

Позже к линейке продуктов Nvidia добавился NV2A — версия GeForce 3 с атрибутами GeForce4, которая использовалась в игровой консоли Microsoft Xbox.

На этот момент Nvidia контролировала 31% рынка графики, Intel — 26%, а ATI — 17%.

Пока Nvidia дополняла линейку GF3 ослабленной Ti 200 и разогнанной Ti 500, ATI торопилась выпустить Radeon 8500. Карта была построена на основе GPU R200 с использованием 150-нанометрового техпроцесса TSMC (такой же использовался в NV20 карты GeForce 3). О выпуске чипа было объявлено в августе, и его с нетерпением ждали, потому что Джон Кармак из id software сказал, что новый Doom 3 на ней будет работать «в два раза быстрее», чем на GeForce 3.

Официальное заявление ATI о разработке R8500 было встречено с таким же энтузиазмом. Но реальность оказалась жестокой — после выпуска карты в октябре выяснилось, что в играх она проявляет себя на уровне ослабленной GF3 Ti 200. Сырые драйверы и отсутствие работающего сглаживания Smoothvision сильно повлияли на оценки R8500 в первых обзорах. К сезону праздников появилась вторая серия обзоров, показывающая, что драйверы стали лучше, повысив производительность R8500 и поставив её между Ti 200 и стандартной GF3.

Сравнение спецификаций

| Частота ядра (МГц) | Число пиксельных конвейеров | Скорость заполнения (Мпикс./с) | Число текстурных блоков на пиксельный конвейер | Скорость заполнения (Мтекс./с) | Частота памяти (МГц) | Ширина шины памяти (бит) | Скорость пропускания памяти (ГБ/с) | |

| GeForce3 Ti 200 | 175 | 4 | 700 | 2 | 1400 | 400 | 128 | 6.4 |

| GeForce3 | 200 | 4 | 800 | 2 | 1600 | 460 | 128 | 7.4 |

| GeForce3 Ti 500 | 240 | 4 | 960 | 2 | 1920 | 500 | 128 | 8.0 |

| Radeon 64MB DDR | 183 | 2 | 366 | 3 | 1100 | 366 | 128 | 5.9 |

| Radeon 8500 | 275 | 4 | 1100 | 2 | 2200 | 550 | 128 | 8.8 |

Тем не менее, очень конкурентоспособные цены и более широкий набор функций (качество 2D-изображения, воспроизведение видео, производительность при сглаживании) сделали карту достойным конкурентом GF3 и Ti 500.

Годовые продажи ATI упали до 1,04 миллиарда и она зафиксировала общие убытки на 54,2 миллиона. Компания начала продавать партнёрам лицензии на создание и продажу графических плат, перенаправив свои ресурсы на проектирование и изготовление чипов.

Плата ATI Xilleon

Также ATI дебютировала с Set-Top-Wonder Xilleon — платформой разработки, основанной на SoC Xilleon 220, в которую входили полнофункциональный процессор, графика, ввод-вывод, видео и аудио для приставок, интегрированных в конструкцию цифровых телевизоров.

Чтобы дополнить Xilleon, ATI приобрела в июне 2002 года за 20 миллионов NxtWave Communications. Эта компания специализировалась на цифровой обработке сигналов и приложений для ТВ-приставок и наземных цифровых сетей.

Придерживаясь своего цикла выпуска продуктов, Nvidia выпустила в феврале 2002 года GeForce. Первоначальная линейка состояла из трёх моделей MX, трёх мобильных моделей, основанных на MX, и двух производительных моделей Titanium (Ti 4400 и Ti 4600). Все они были построены на 150-нанометровом техпроцессе TSMC. По сути, GeForce 4 был готов к выпуску ещё за два месяца до этого, но его отложили, чтобы не мешать продажам GeForce 3 в сезон праздников.

Серия MX предназначалась для бюджетного сегмента, но была малопривлекательной, потому что основывалась на устаревшей архитектуре GeForce 2. В них было добавлено декодирование MPEG2, но карты, как и предыдущая линейка GF2 MX, вернулись к поддержке только DirectX 7.0/7.1. Ценовой диапазон от 99 до 179 долларов отражал ограниченность набора возможностей.

С другой стороны, модели Titanium имели превосходную производительность, и в некоторых случаях на 50 с лишним процентов обгоняли GeForce3 Ti 500. За один день Ti 4600 стала чемпионом по производительности, с лёгкостью обогнав Radeon 8500, а Ti 4200 стоимостью 199 долларов обеспечивал наилучшее соотношение цены и качества.

Однако затем появилась Radeon 9700 Pro, мгновенно оставив позади все остальные карты.

ATI Radeon 9700 Pro (FIC A97P)

GPU ATI R300, разработанный коллективом, который ранее был ядром ArtX, наделал много шума и появился очень скоро. В нём первом появилась поддержка DirectX 9.0, и он стал первой архитектурой с поддержкой shader model 2.0, vertex shader 2.0 и pixel shader 2.0. Другие примечательные достижения чипа: он стал второй серией GPU с поддержкой AGP 8x — первой была линейка SiS Xabre 80/200/400, и первым GPU с компоновкой flip-chip.

О компоновке flip-chip в GPU: в предыдущих поколениях графических чипов и других интегральных схем использовался метод проводникового монтажа. При такой методике чип располагается на плате с логическими блоками, расположенными под металлическими слоями, контактные площадки которых соединялись тонкими проводниками, ведущими вдоль краёв чипа к шариковым выводам или контактам с обратной стороны. Flip–chip позволяет избавиться от проводников благодаря контактам (обычно припаиваемым в массиве шариковых выводов), расположенным непосредственно на «верхушке» чипа, который затем переворачивается (flip), чтобы точки пайки напрямую контактировали с подложкой или платой. Далее чип подвергается локализованному нагреву (оплавлению) для расплавления припоя, который образует соединение с нижними контактами на плате.

ATI дополнила линейку в октябре, выпустив непрофессиональную 9700 по цене 299 долларов для тех, кому не доступна была самая мощная модель за 399 долларов. Тем временем, урезанные 9500 Pro (199 долларов) и 9500 (179 долларов) устремились в мейнстримные сегменты рынка, а FireGL Z1/X1 заполнила нишу профессиональной графики с ценовым диапазоном 550-950 долларов. Также в декабре появилась All-In-Wonder 9700 Pro (449 долларов).

Продажи ATI скорее всего выросли из-за того, что многие карты можно было модифицировать до более дорогих версий. Например, можно было при помощи эталонной платы превратить карту 9500 в 9700, а 9800 Pro — в XT. Для последней был написан патч к драйверу, чтобы проверить, будет ли он воспринят модификацией, которая состояла в припаивании резистора или настройке чипа управления напряжением GPU и памяти при помощи карандаша. Среди аппаратных модификаций также встречалось превращение различных моделей 9800 в FireGL X2, а пропатченный драйвер Omega мог превращать 9800 SE 256MB ценой 250 долларов в 9800 Pro 256MB за 499 долларов.

В дополнение к дискретным картам ATI выпустила десктопную интегрированную графику и чипсеты. Это были A3/ IGP 320, предназначенные для работы с процессорами AMD, RS200/IGP 330 и 340 для чипов Intel, а также мобильная серия U1/IGP 320M для платформ AMD и RS200M для Pentium 4-M. Все они были дополнены южными мостами ATI, а именно IXP200/250.

Между выпусками GeForce4 и R300 компания SiS объявила о выходе линейки Xabre. Карты стабильно были медленнее, чем продукты Nvidia и ATI в тех же ценовых диапазонах, и оказались ослабленными отсутствием конвейеров вершинных шейдеров. Из-за этого карты сильно зависели от драйверов и разработчиков игр, которым нужно было выжимать максимум из программной эмуляции; поэтому SiS едва удерживалась на рынке десктопной дискретной 3D-графики.

Также в линейке Xabre было реализовано «турботекстурирование» («Turbo Texturing»): технология, благодаря которой частоты кадров значительно увеличивались при помощи снижения качества текстур и отсутствию анизотропной фильтрации. Всё это не повышало любовь рецензентов к этим картам.

Линейка Xabre оказалась последней, выпущенной под знаменем SiS, так как спустя пару месяцев, в июне, компания отделила свой графический отдел (которому дали название XGI) и выполнила слияние с Trident Graphics.

Первая карта из серии Nvidia FX появилась 27 января 2003 года; это была печально известная FX 5800 по прозвищу «пылесос» («Dustbuster») и немного более быстрая (читай: менее медленная) FX 5800 Ultra. По сравнению с текущим чемпионом, ATI Radeon 9700 Pro (и версией без Pro), FX была гораздо громче, обеспечивала посредственную производительность анизотропной фильтрации (AF) и сглаживания (AA), и в целом была гораздо более тормозной. ATI была так далеко впереди, что не самая лучшая карта Radeon 9700, выпущенная пятью месяцами ранее, с лёгкостью обгоняла Ultra, и при этом была на 100 долларов дешевле (299 против 399 долларов).

Предполагалось, что чип NV30 выйдет в августе, примерно в то же время, что и Radeon 9700, но проблемы с нагрузкой и высокое количество брака в 130-нанометровом техпроцессе Low-K TSMC заставили Nvidia притормозить. Кто-то утверждал, что компании не хватает инженерных ресурсов, потому что многие разработчики были привлечены к созданию чипа NV2A для консоли Xbox, SoundStorm APU, а также чипсетов для материнских плат.

Стремясь двигаться вперёд, Nvidia приступила к проекту производства нескольких чипов серии FX по более стандартному 130-нанометровом техпроцессу low-K на основе фторсиликатного стекла (FSG).

В марте ATI обновила линейку своих карт, начав с 9800 Pro, имевшей GPU R350, который по сути являлся R300 с некоторыми улучшениями в инструкциях кеширования и сжатия Hyper-Z.

В апреле за ним последовали RV350 и RV280. Первый из них, используемый в Radeon 9600, был построен на основе того же 130-нанометрового техпроцесса low-K TSMC, который применяла Nvidia, RV280, устанавливавшийся в Radeon 9200, был почти неизменным RV250 из Radeon 9000 с поддержкой AGP 8x.

GPU Xbox 360 (ATI C1 / Xenos)

В том же месяце ATI и Nintendo подписали технологическое соглашение, которое в результате приведёт к созданию GPU Hollywood для консоли Nintendo Wii. В августе ATI заключила вторую консольную сделку, когда Microsoft подписала с ней контракт на разработку GPU для Xbox 360.

Всего спустя три с половиной месяца после бесславного выпуска FX 5800 Nvidia сделала ещё одну попытку при помощи NV35 (FX 5900 и FX 5900 Ultra). Новый драйвер Detonator FX значительно улучшил AA и AF, почти поравнявшись в качестве с продуктами ATI. Однако 5900 удалось достигнуть того, чего не смогла достичь 5800. Она вытеснила ATI Radeon 9800 Pro с трона самой быстрой карты, однако при цене в 499 долларов позволить её себе могли немногие.

Как и ожидалось, в сентябре ATI вернула себе лавры, выпустив 9800 XT. Превосходная поддержка драйверов, в основном в некоторых DX9-играх, также сделала XT во всех отношениях лучшей по сравнению с продукцией Nvidia, обеспечив лидерство ATI к завершению года. Карта 9700 Pro осталась примечательной платой для мейнстримного рынка, а FX 5700 Ultra по цене 199 долларов завоевала сегмент «ниже 200».

После убытков 2002 года в 47,5 миллиона ATI рванула вверх, получив в 2003 году прибыль в 35,2 миллиона. Солидную её часть составили высокие цены на доминирующие карты 9800 и 9600. Тем временем, благодаря FX 5200 Nvidia удержала 75% бюджетного рынка карт с поддержкой DirectX 9.

Трейлер с демонстрацией эффектов Source DirectX 9.0, показанный на презентации Radeon 9800 XT и 9600 XT

Недавно созданная XGI в сентябре-ноябре выпустила потомков серии Xabre. Линейка карт, теперь называющаяся Volari, ранжировалась от V3 за 49 долларов до сдвоенного GPU Duo V8 Ultra. По сути, V3 была ребрендингом Trident Blade XP4 с поддержкой DX 8.1, а остальная часть серии (V5 and V8) разрабатывалась на основе предыдущей SiS Xabre и имела поддержку DX9.0.

По большей части все модели имели низкую скорость, за исключением V3 нижнего уровня, обеспечивавшей производительность на уровне GeForce FX 5200 Ultra и Radeon 9200. Duo V8 Ultra стоила примерно на 20% дороже, чем Radeon 9800 Pro 128MB, однако обеспечивала производительность на уровне 9600XT или даже чуть ниже.

Линейка Volari компании XGI продолжилась в 2005 году картой 8300, которая была приблизительно равна Radeon X300SE/GeForce 6200 при цене в 49 долларов, а также картами Z9/Z11 и XP10. В октябре 2010 компания снова была поглощена SiS.

Ещё одной компанией, вернувшейся на рынок десктопной графики, стала S3. После того, как графический отдел был продан VIA за 208 миллионов плюс долг компании в 60 миллионов, реструктурированное предприятие в первую очередь сконцентрировалось на проектировании чипсетов.

В январе было объявлено о разработке десктопных карт DeltaChrome, но по давней привычке S3 первые модели S4 и S8 начали появляться в каналах розницы только в декабре. Эти новые карты имели большинство обязательных для 2003 года функций: поддержку DirectX 9, 16x AF, поддержку HD 1080p и поддержку изображения в портретном режиме.

К сожалению, покупатели теперь рассматривали рынок десктопной графики как арену двух конкурентов, и S3 не была ни одним из них. Хотя S3 стремилась оставаться конкурентоспособной, ATI и Nvidia подталкивали друг друга к постоянному повышению уровней производительности и качества картинки.

За DeltaChrome в 2005 году последовала GammaChrome.

В 2005 году Nvidia и ATI продолжили выпускать продукты по очереди. В марте Nvidia выпустила свою первую карту на GDDR3 (это была FX 5700 Ultra), за которой последовала серия GeForce 6 и серия 6800 класса high-end. Изначально линейка состояла из 6800 (299 долларов), GT (399 долларов), Ultra (499 долларов) и её разогнанного варианта под названием Ultra Extreme (549 долларов), составившего конкуренцию ATI X800 XT Platinum Edition. Последняя продавалась производившими платы партнёрами ATI.

14 марта 2005 года к линейке добавилась 6800 Ultra 512MB, продававшаяся по невероятной цене в 899 долларов; компания BFG изготовила её разогнанную версию за 999 долларов. Выпущенная в сентябре серия 6600 была нацелена на средний ценовой сегмент.

В набор функций серии 6000 входили поддержка DirectX 9.0c, shader model 3.0 (хотя карта и не могла использовать её в полной мере), движок декодирования и воспроизведения PureVideo и поддержка SLI — технология использования нескольких GPU, приобретённая у 3dfx.

Возврат старой функции: SLI

В технологии SLI по версии 3dfx каждое устройство отвечало за рендеринг попеременных растровых строк; Nvidia подошла к задаче немного иначе. Компания реализовала рендеринг части кадра (split frame rendering, SFR), при котором каждый GPU рендерил верхнюю или нижнюю часть кадра, рендеринг попеременных кадров (alternate frame rendering, AFR), при котором GPU рендерили кадры по очереди, а в некоторых случаях драйвер просто отключал SLI, если игра не поддерживала эту функцию.

Хотя о технологии было заявлено в июне, для создания систем с несколькими GPU требовалась материнская плата с чипсетом nForce4, крупные розничные поставки которых начались только в конце ноября. Подлило масла в огонь и то, что до следующего года выпуск драйверов был очень нерегулярным.

В обзорах того времени обычно рассказывалось о текущей производительности; говорилось, что две карты нижнего уровня (например, 6600 GT SLI, которые можно было купить за 398 долларов) чаще всего равнялись одной мощной карте при низких разрешениях и качестве картинки. Однако при максимальных разрешениях и включенном сглаживании системы с одной картой имели преимущество. Производительность SLI и ATI CrossFire тогда, как иногда и сейчас, бывала нестабильной: эти технологии могли работать идеально или не работать вовсе.

Партнёры Nvidia по производству плат сразу же увидели маркетинговые возможности заново изобретённой технологии: Gigabyte выпустила двойную карту 6600 GT SLI (3D1), за которой последовали двойная 6600 (3D1-XL) и 6800 GT (3D1-68GT). Эти карты требовали не только чипсета nF4, но и материнскую плату под брендом Gigabyte.

Что касается одиночных карт GPU уровня high-end, то 6800 Ultra и X800 XT/XT PE были приблизительно одинаковы, и по цене, и по производительности. Но у них существовали и проблемы. Последняя появилась в мае и на протяжении всего цикла производства страдала от проблем с поставками, в то время как флагманская 6800 Ultra Nvidia чрезвычайно запоздала и вышла в августе; в некоторых регионах у неё тоже были проблемы с поставками, потому что карту продавали не все партнёры компании.

6800 GT обычно обгоняла X800 Pro при цене в 399 долларов, а 6600 GT заполнила ценовую нишу в 199 долларов.

Активная конкуренция с Nvidia в этом году не помешала доходам ATI: прибыль за год достигла максимума и составила 204,8 миллиона при продажах примерно на 2 миллиарда.

С получившей хороший приём картой 6600 GT связана одна странность: изначально она была выпущена как карта для PCI Express, в то время, когда PCI-E поддерживалась только в материнских платах Intel, предназначенных для процессоров Pentium 4. Эти чипы обычно отставали в играх от продукции AMD, в которых, разумеется, использовалась шина данных AGP.

Серия 7000 компании Nvidia начала выходить со сборочных линий намного раньше, чем заполнилась линейка серии 6000. 7800 GTX появилась аж за пять месяцев до того, как свет увидела 6800 GS с ограниченными возможностями. Первая продукция в серии 7800 была основана на GPU G70, созданном по 110-нанометровому техпроцессу TSMC, но её быстро сменила серия 7900 на основе G71, производимая по 90-нанометровому техпроцессу TSMC.

Хотя в названиях плат NV сменились на G, последняя серия архитектурно была связана с серией NV40 карт GeForce 6000. И хотя она была ненамного больше по площади, чем NV40-45 (334 мм?), в G70 размещалось на восемь миллионов больше транзисторов (всего их было 302 миллионов), что позволило добавить на треть больше вершинных конвейеров и на 50% больше пиксельных конвейеров. В большинстве случаев G70 заменялся в производстве через девять месяцев, но GS и GTX 512MB были заменены через 3 и 4 месяца.

В бюджетной нише 7100 GS продолжала использовать TurboCache (способность платы задействовать часть системной памяти), которая появилась в предыдущем поколении — GeForce 6200 TC.

Nvidia GeForce 7800 GTX

В другой ценовой категории 7800 GTX 256MB вышла в розничную продажу 22 июня по рекомендуемой цене в 599 долларов, хотя реальная цена во многих случаях была выше. ATI вернула себе лавры первенства в нише одиночных GPU, выпустив X1800 XT, однако спустя тридцать пять дней Nvidia ответила на это 512-мегабайтной версией 7800 GTX и возвратила себе титул.

Два месяца спустя ATI выпустила X1900 XTX, конкурировавшую с флагманами Nvidia. Эта гонка за мощностями привела к тому, что обе карты продавалась по цене 650 долларов. Одним из последствий перехода карт к 512-мегабайтному буферу кадров стало то, что теперь благодаря dual link DVI было возможно играть в разрешении 2560x1600 с 32-битным цветом.

Первоначальный дизайн ATI CrossFire, для которого требовалось использование внешнего Y-образного кабеля

В мае 2005 года ATI объявила о разработке своей технологии для нескольких карт Crossfire, которая стала доступной после выпуска в сентябре чипсета Xpress 200 Crossfire Edition и платы X850 XT Crossfire Master. Из-за одиночного режима TMDS изначально разрешение и частота обновления были ограничены 1600x1200 и 60 Гц, но вскоре его заменил TMDS с двойным режимом, обеспечивающий разрешение 2560x1600.

В отличие от решения Nvidia с двумя картами, обменивающимися данными через мостовой разъём, ATI реализовала мастер-карту с TMDS-ресивером, получавшей входящие данные от ведомой карты через внешнее устройство и чип композитинга Xilinx.

Как и SLI компании Nvidia, CrossFire обеспечивала попеременный рендеринг кадров (AFR) и рендеринг части кадра (SFR), но также имела технику рендеринга под названием SuperTiling. Она увеличивала производительность в некоторых приложениях, но не работала с OpenGL и не поддерживала ускоренную обработку геометрии. Как и SLI, Crossfire столкнулась с проблемами, связанными с драйверами.

Изначально ATI намеревалась выпустить карты на основе R520 (первые карты компании с Shader Model 3.0) в июне-июле, но баг, поздно найденный в библиотеке ячеек, вызвал задержку в 4 месяца.

Первыми были выпущены X1800 XL/XT с ядром R520, бюджетные карты X1300 с RV515, который по сути имел одну четверть от графических конвейеров R520, и X1600 Pro/XT на основе RV530, который был схож с RV515, но имел повышенную скорость передачи данных из шейдеров и вершинных конвейеров в блоки текстурирования и конвейеры растровых операций.

Из-за первоначальной задержки с выпуском R520 этот GPU и его производные всего спустя три с половиной месяца были заменены серией X1900 на основе R580, в которой использовался новый 80-нанометровый техпроцесс TSMC. RV570 имел половину ресурсов графических конвейеров (карты X1650 GT/XT и X1950 GT/Pro), а урезанный RV530 превратился в RV535, который использовался в X1650 Pro, а также в X1300 XT.

Годовой доход ATI вырос до рекордных 2,2 миллиарда — максимума в истории компании; этому способствовали поставки GPU Xenos для Xbox 360. Однако прибыль снизилась до 16,9 миллиона.

К этому времени выпуск любой графической карты, основанной не на GPU Nvidia или ATI, воспринимался с любопытством, если не с энтузиазмом. Именно в такой ситуации оказалась выпущенная в ноябре переработанная графическая линейка S3.

Chrome S25 и S27 благодаря своим высоким частотам обещали хорошую производительность в играх, но на деле оказались посредственными. Из-за своей цены в 99 долларов (S25) и 115 долларов (S27) картам пришлось конкурировать с Nvidia 6600/6600GT и ATI X1300Pro/X1600Pro, но ни по одному из параметров (кроме энергопотребления) продукты S3 не могли с ними соперничать. Это незначительное преимущество испарилось, когда ATI/AMD и Nvidia нацелились на начальный сегмент рынка HTPC, по сути убив последующие карты S3 серий Chrome 400 и 500.

Дополнительной трудностью для S3 стало то, что стоимость изготовления карт приводила к исчезающе малым прибылям. Компании требовались крупномасштабные продажи на рынке, которым владели два главным поставщика. В июле 2012 года S3 приобрела за 300 миллионов долларов компания HTC; этот ход изначально рассматривался как средство воздействия в юридических спорах HTC и S3 с Apple.

В 2006 году Nvidia и ATI по-прежнему господствовали в обзорах прессы.

ATI приобрела Macrosynergy — шанхайский центр проектирования и разработок, штат которой работал в Калифорнии и изначально был частью группы XGI. В мае компания купила за 44 миллиона BitBoys.

Тем временем, в марте вышел первый продукт Nvidia в категории одиночных плат с двумя GPU, которые ранее выпускали ATI, 3dfx и XGI. Карта 7900 GX2 представляла собой сэндвич из двух плат, на которых была установлена пара 7900 GTX с пониженными частотами. Но Asustek не стала дожидаться системы Nvidia на двух GPU, и выпустила свою собственную версию в виде Extreme N7800GT Dual (900 долларов, изготовлено 2000 устройств), в которой были соединены два GPU 7800 GT.

Благодаря этой карте Asus заинтересовалась в выпуске ограниченным тиражом плат с двойными GPU; вероятно, этот ход ужесточил отношение Nvidia к своим партнёрам по производству, потому что в момент выпуска продукция Asustek перетянула к себе всё внимание.

На мейнстримном рынке с более крупными масштабами продаж и 7600 GT, и GS обеспечивали солидную производительность и долговечность, а ATI X1950 XTX и Crossfire были на вершине рейтингов рынка top end для карт с одиночным GPU. X1900 XT и GeForce 7900 GT имели примерно одинаковую производительность и были нацелены на верхнюю часть мейнстримного рынка.

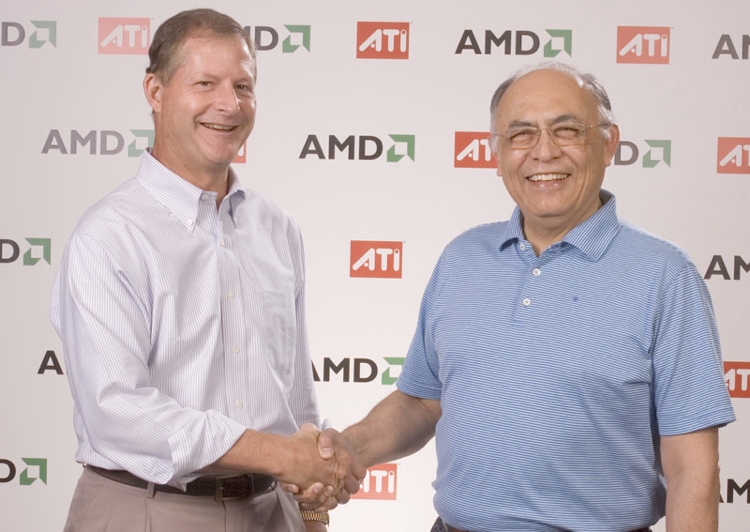

Дэвид Ортон из ATI и Хектор Руис из AMD официально объявляют об историческом слиянии

Спустя двадцать один год независимого существования, 25 октября 2006 года ATI была приобретена AMD за общую сумму в 5,4 миллиарда долларов — 1,7 миллиарда получено от AMD, 2,5 миллиарда заимствовано у кредитных организаций, 57 миллионов акций и 11 миллионов опционов/акций с ограничениями AMD, оценено в 1,2 миллиарда. На момент покупки примерно 60-70% доходов от чипсетов/интегрированной графики ATI получала благодаря партнёрскому соглашению по производству материнских плат для платформ Intel.

После того, что большая часть рынка чипсетов интегрированной графики для Intel перешла к Nvidia, рыночная доля ATI значительно снизилась. Логика покупки заключалась в том, что AMD получала быстрый доступ к технологиям GPU, вместо того, чтобы тратить 5,4 миллиарда на разработку собственных технологий и лицензирование сторонних. В то время AMD нацеливалась на быструю реализацию Torrenza и связанных с ней проектов Fusion.

Спустя две недели после покупки ATI компания Nvidia начала эпоху унифицированных шейдерных архитектур графики для PC. На консолях унифицированная архитектура уже появилась благодаря компании ATI и её GPU Xenos, установленному в Xbox 360.

Этот пост является третьей частью серии из четырёх статей. В четвёртой и последней мы расскажем о разработке продуктов Radeon под крылом AMD, продолжившейся конкуренции между GeForce и Radeon и переходе к потоковой обработке.

Комментарии (13)

Sdima1357

09.12.2019 11:30В nv30 появилась поддержка формата float32, что позволило использовать их для вычислений. Фактически это первые GPGPU.

ExtenZ

09.12.2019 12:23Интересно, с каких поколении GPU поддерживал аппаратное декодирование mpeg3 (для *.AVI *.mp4)

Victor_koly

09.12.2019 13:19Джон Кармак чуток ошибся со сроками выхода Doom 3. Radeon 8500 вовсю тестировали в 2001 году, а игра вышла через 3 года.

MrPrayer

09.12.2019 14:02+1Придерживаясь своего цикла выпуска продуктов, Nvidia выпустила в феврале 2002 года GeForce.

«GeForce 4», как я понимаю.

DrunkBear

09.12.2019 15:59По сути, семейство GeForce4 — это 2 абсолютно разных семейства, объеденённые хитро

жомудрым маркетингом и гневом пользователей «не в теме», которые купили не то:

MX — переиначенные Gf2 и Ti — те самые Gf4 из роликов и рекламы.

У меня многие знакомые по ошибке покупали GeForce4 MX вместо Ti (нам в магазине предложили сэкономить!) и обнаруживали, что в играх совсем не та картинка — а обменять было уже нельзя.

PS Забавно но факт: топовые версии линейки Gf4 (mx 460 / ti 4600) вживую ни разу не видел, только с паутиной на полках магазинов.

ICELedyanoj

09.12.2019 17:06Да, как раз обретался на рынке железа в начале нулевых и самой популярной карточкой у клиентов, имевших деньги, как раз и была GF4 MX440. Помню как собрали несколько компьютеров на этих карточках, как обычно прогнали 3DMark и выяснилось, что своих денег эта «элитная карточка», мягко говоря, не отрабатывает. Магазин у нас был провинциальный, интернет по диал-апу, поэтому пришлось потратить достаточно много усилий для того, чтобы собрать достаточно аргументов для того, чтобы убедить клиентов тратить свои деньги на что-нибудь другое.

DrunkBear

09.12.2019 17:202 собранные железки с 3dmark в цикле?

Или дорого было?

ICELedyanoj

10.12.2019 07:25Давно было дело, не помню всех подробностей. У нас была достаточно навороченная методика тестирования каждого собранного ПК перед доставкой пользователю, но отчётливо помню разочарование от этой карточки по соотношению цена/качество.

DrunkBear

10.12.2019 11:00На сколько помню, на запуске Gf4mx стоили неадекватные суммы и при этом сметались с полок, gf4 же — ты ролики видел?!

mukoladerevlo

11.12.2019 02:06спасибо за статью,

еще можно было написать про RSX, тандем sony и nvidia, использовался в ps3.

«RSX использует большую часть технологий NVIDIA 7900GTX, который основывается на архитектуре G71. С появлением G71 стало возможным обеспечивать исполнение 136 шейдерных операций за один период тактовых импульсов, и ожидается, что RSX получит то же число параллельных пиксельных и вершинных шейдерных потоков, что и G71, обладающий 24 пиксельными и 8 вершинными потоками»

всегда поражался, как долго с ps3 выжимали все соки, и насколько хорошую картинку она обеспечивала

ExtenZ

Спасибо