Чем больше вычислительных ресурсов мы установим в единицу объема машинного зала, тем рентабельнее будет весь комплекс и тем сильнее он будет греться. Системы охлаждения совершенствуются, однако отвод тепла от электронных компонентов по-прежнему основан на использовании вентиляторов и массивных радиаторов. Можно изолировать холодные или горячие коридоры, устанавливать продвинутые системы мониторинга и управлять воздушными потоками в реальном времени, но технологический предел эффективности таких решений уже достигнут. И где разумная тому альтернатива?

Специалисты HOSTKEY завершили пилотное внедрение альтернативной разработки компании «Теркон» — создателя систем охлаждения для космических аппаратов. Ниже — подробности внедрения, нюансы самой технологии и результаты тестов.

Центры обработки данных потребляют большое количество электроэнергии, около 60% которой расходуется на работу серверов и выделение ими тепла, 30% на охлаждение и 10% — на обеспечение бесперебойного питания. У старых ЦОД показатели могут быть хуже (40/50/10).

Почему «Теркон»?

Существуют различные способы охлаждения ИТ-оборудования, вплоть до погружения серверов в электрически нейтральный жидкий теплоноситель. Их выбор ограничен в первую очередь техническими условиями дата-центра, поэтому перспективную экзотику пришлось отмести. Нам требовалось более приземленное решение, совместимое с выпускающимися серийно серверами и, что самое главное, с инженерной инфраструктурой площадки.

В более эффективном отведении тепла от оборудования заинтересован в первую очередь оператор ЦОД, который делится с нами некоторыми бенефитами: уменьшается стоимость аренды в пересчете на единицу вычислительной мощности, а значит наши услуги становятся более конкурентными.

Одним из экспериментов HOSTKEY в этом направлении стало тестовое внедрение двухфазной системы теплоотвода «Теркон». Решение российского производителя имеет ряд преимуществ:

снижение прямых энергозатрат на охлаждение серверов за счет уменьшения потребления воздуха;

более высокая безопасность оборудования по сравнению с жидкостными системами;

возможность адаптировать систему охлаждения под нестандартные решения;

поддержка отечественного производителя — их и так мало;

система не требовательна к обслуживанию и работает по принципу «поставил и забыл» — уменьшается нагрузка на персонал.

Помимо плюсов, у системы «Теркон» есть и минусы, главный из которых — недостаточная проработанность технологии. «Из коробки» ничего не заводится. Точнее, во время пуско-наладочных работ возникают решаемые проблемы.

Что такое «Теркон»?

Ключевой элемент систем охлаждения компании «Теркон» — контурные тепловые трубки (КТТ) для передачи тепла, охлаждения и термостабилизации. Они монтируются к процессору и другим тепловыделяющим элементам сервера, а конденсатор терконов — к теплообменной шине охлаждения. Шина охлаждается гликолем из контура кондиционирования ЦОД, а в трубках отсутствуют механические подвижные части, что увеличивает срок службы и стабильность работы системы охлаждения.

У нас в качестве теплоносителя используется аммиак марки А, но производитель предлагает решения на этаноле, метаноле, ацетоне, фреонах и даже на воде. Система обходится без компрессоров благодаря фазовому переходу «жидкость-пар» — в этом, к слову, заключается ее принципиальное отличие от жидкостного охлаждения, требующего установки циркуляционных насосов. Пар под воздействием сил капиллярного давления движется по паропроводу — это изотермический процесс — и поступает в зону конденсации, где постепенно происходит обратный фазовый переход. Из зоны конденсации выходит переохлажденная жидкость.

Движение по конденсатопроводу также считается изотермическим, и в нем идет потеря давления. Жидкость доходит до компенсационной полости, где подогревается до температуры линии насыщения. Далее через центральный канал или запорный слой она пропитывает капиллярную структуру, где в пароотводных каналах снова происходит фазовый переход.

Схема работы контурных тепловых трубок:

Система охлаждения на основе контурных тепловых трубок позволяет увеличить мощность ИТ-нагрузки до 25 кВт и разместить в стойках большее количество серверов за счет отказа от громоздких радиаторов и теплоотвода за периметр машинного зала. В отличие от традиционных тепловых трубок, КТТ обеспечивают теплоперенос на расстояние до 22 метров.

Процесс монтажа

В сборке системы охлаждения «Теркон» нам помогал Александр — специалист компании-производителя. Он дважды выезжал в 14-й машинный зал DataPro, куда предварительно доставили радиаторы.

В первую командировку Александр показал команде наших инженеров, как собирать и ставить систему охлаждения. Совместно с ним мы установили первый сервер, остальные два собрали и поставили самостоятельно. Отметим, что сервер с трубками в стойку устанавливать лучше вдвоем, поскольку в одиночку есть риск повредить оборудование.

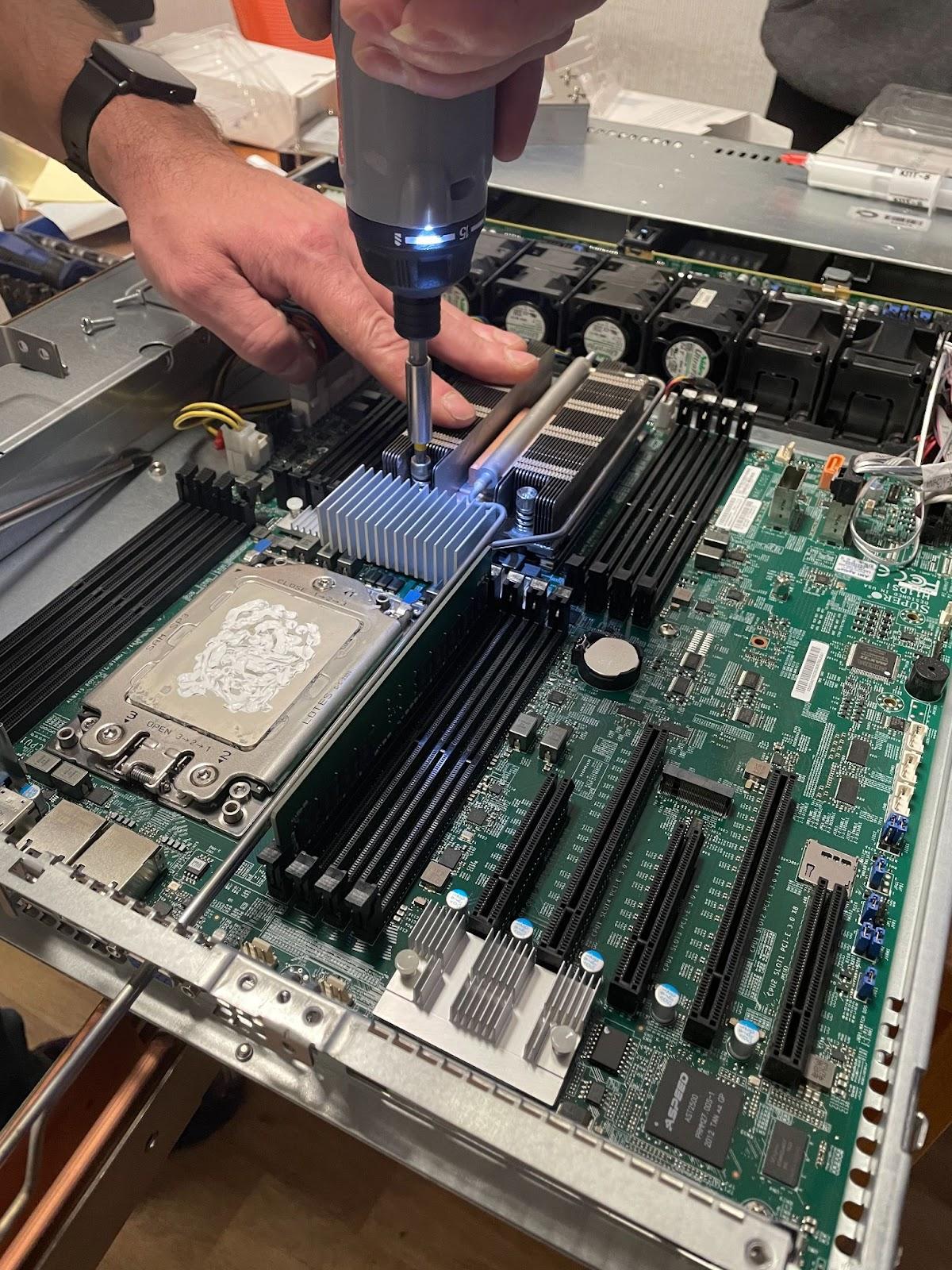

Процесс установки делится на два этапа. Сначала готовится сервер, снимаются штатные радиаторы и монтируется система охлаждения «Теркон» (это занимает примерно 30 минут).

Затем готовый сервер ставится в стойку: если салазки в ней уже смонтированы, это может занять до 15 минут: в отверстия охлаждающей шины бывает трудно попасть с первого раза (необходимо регулировать контакт винтовым зажимом).

Процедура несложная, но требует определенной сноровки, а эффективность охлаждения с применением КТТ зависит от используемых термопаст и посадки испарителя: чем плотнее, тем лучше.

Отметим также, что мы не снимали вентиляторы: установка дополнительной пассивной системы охлаждения должна была снизить нагрев электронных компонентов и кардинально уменьшить потребление воздуха. Можно ли обойтись вообще без кулеров, сказать сложно. В сервере нагреваются не только процессоры или другие устройства с радиаторами, к которым подводятся тепловые трубки. К тому же отсутствие принудительной вентиляции может нарушить направление воздушного потока из холодного коридора в горячий. В любом случае при низких оборотах кулеры потребляют мало электроэнергии.

45 минут, и первый сервер готов: видеозапись монтажа

Мы собрали три сервера, а затем приступили к тестам, результаты которых привели Александра на площадку HOSTKEY во второй раз.

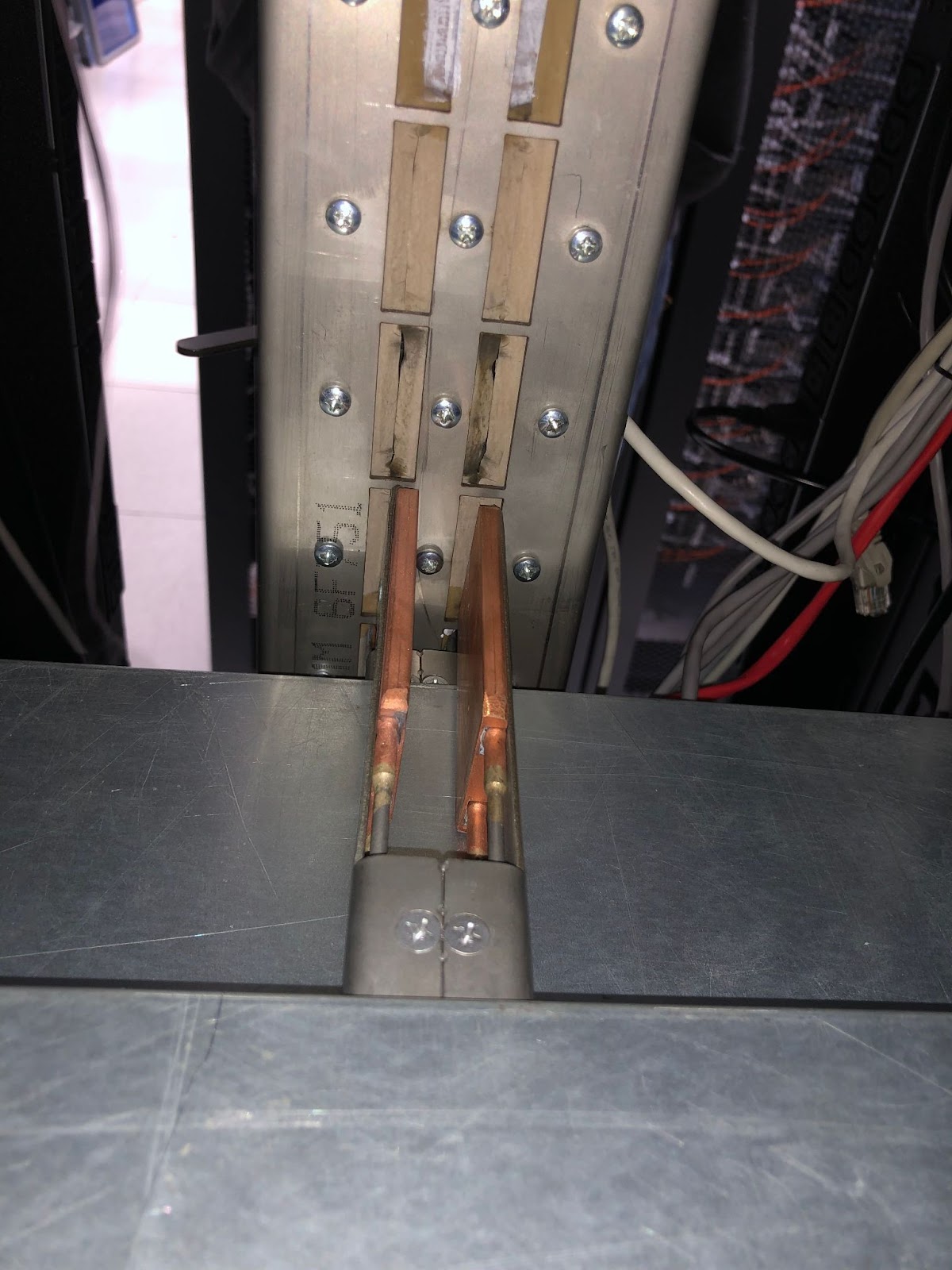

Подключение к теплосъемнику выглядит следующим образом:

Положение зажима «открыто» необходимо для ослабления фиксации пластин, чтобы извлечь сервер.

Положение зажимов «закрыто» позволяет обеспечить плотное прилегание пластин к шине, что повышает эффективность охлаждения.

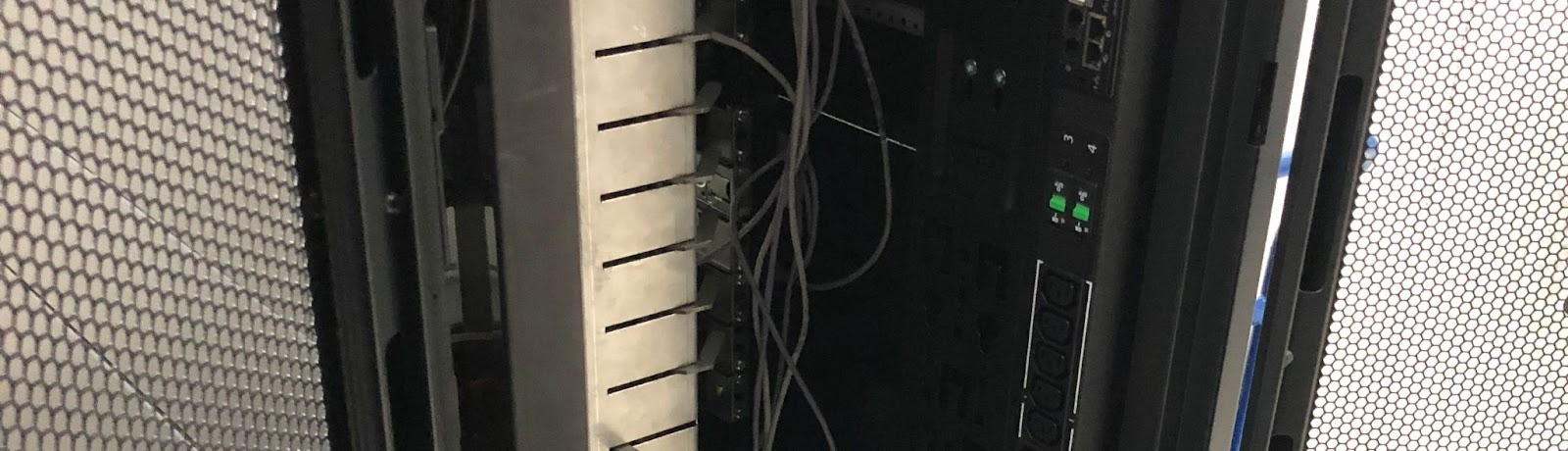

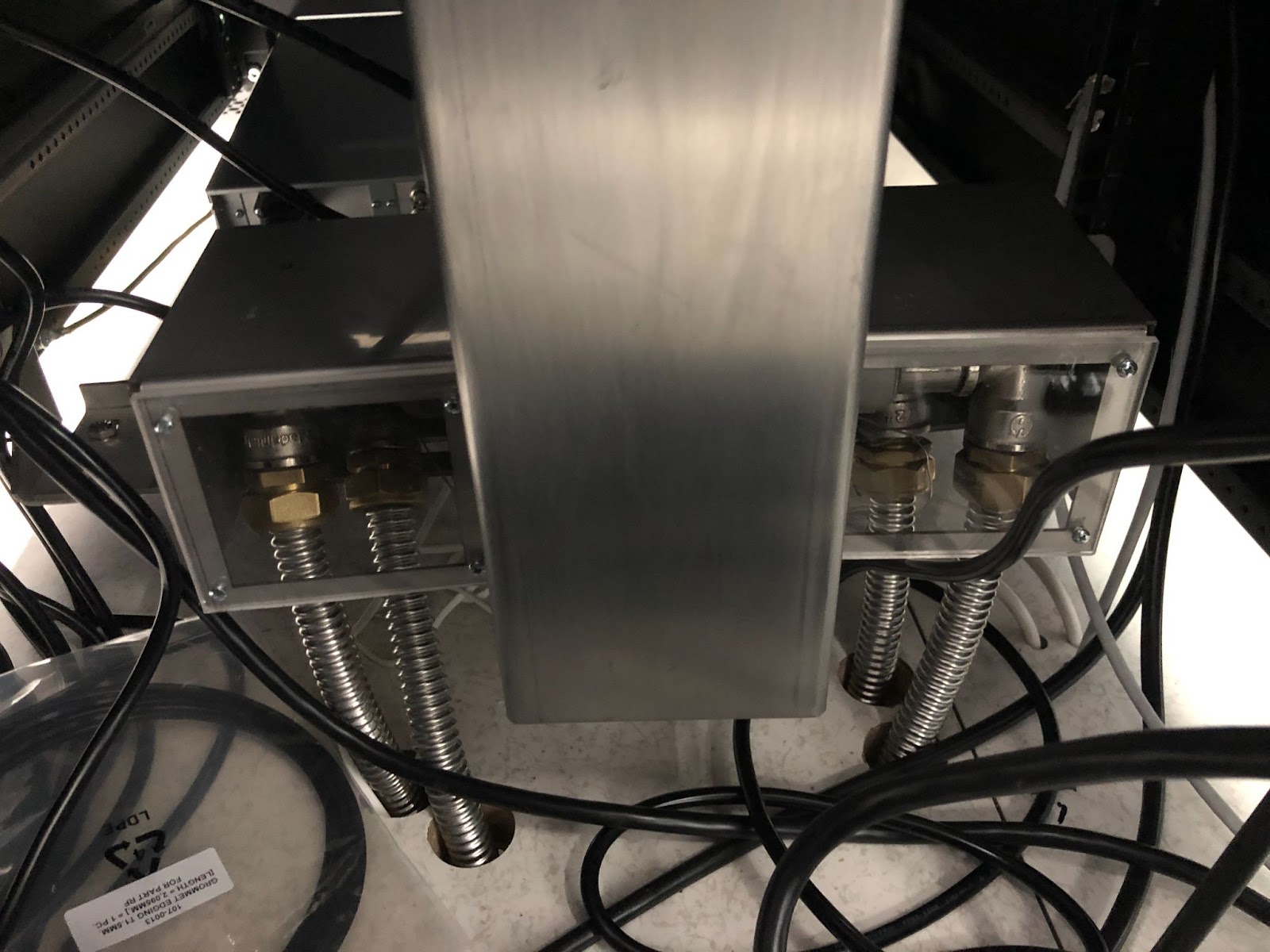

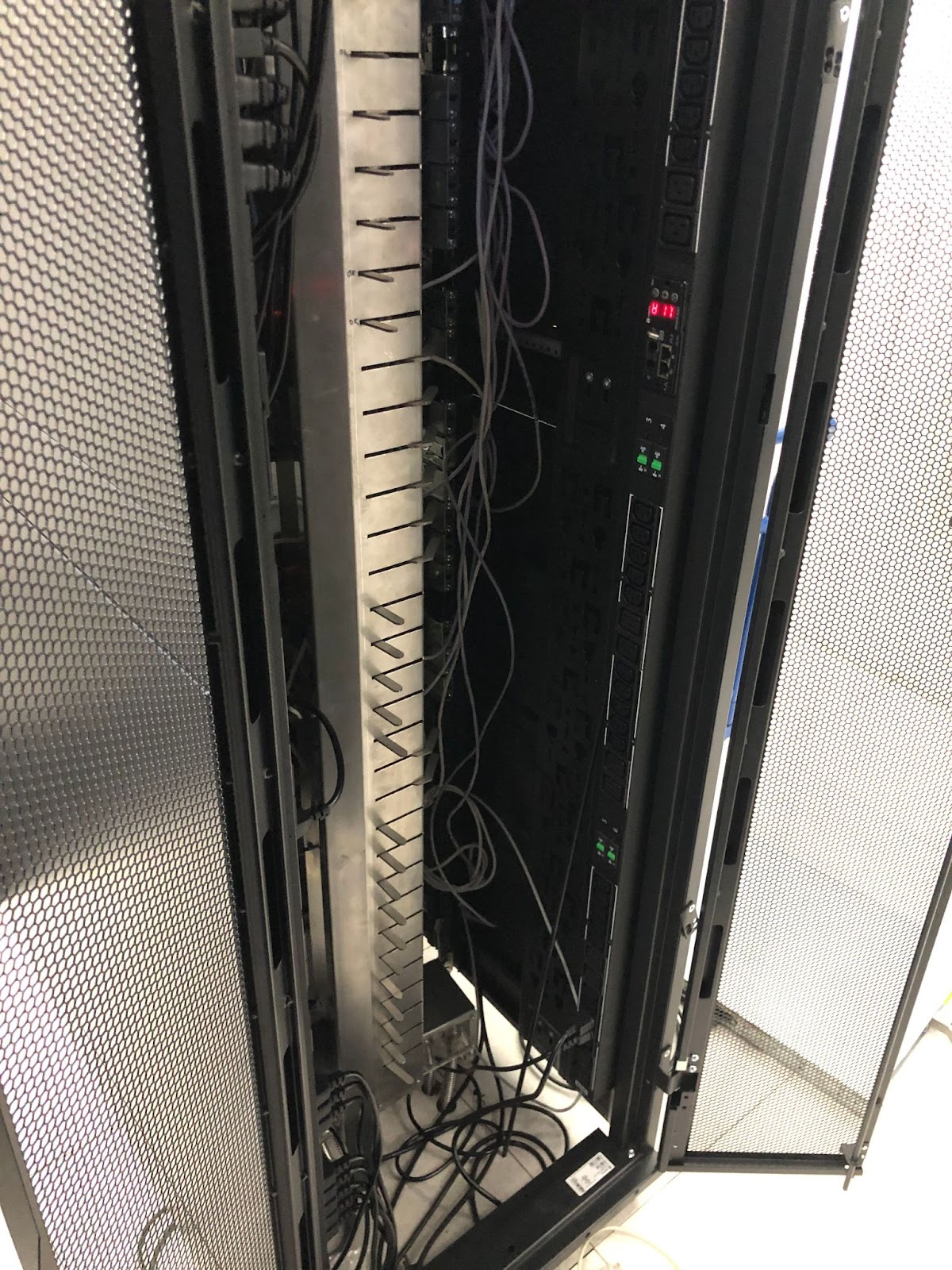

Комплекс соединительных трубок для системы охлаждения занимает два нижних юнита (они становятся недоступными для монтажа серверов). Трубы подведены в фальшполу дата-центра прямо под серверную стойку: в итоге тепло от процессоров по КТТ выводится из объема сервера на внешний жидкостный теплообменник и далее на уличные системы охлаждения ЦОД.

Шина в сборке расположена посередине стойки. В дальнейшем мы планируем сдвинуть ее, поскольку в нынешней конфигурации неудобно подключать патчи и видеокабель.

Пластины со стороны сервера и слоты в шине под эти пластины:

Тестирование

Для пилотного внедрения мы взяли серийные серверы Supermicro такой конфигурации:

Платформа |

1 x SM 1U CSE-815TQ-563CB |

Материнская плата |

1 x SM H11DSi |

CPU |

2 x AMD EPYC 7451 2.3GHz (24 cores) |

RAM: |

2 x 16 Gb DDR4 REG |

HDD: |

1 x 240Gb SSD |

Потребовалось также ПО LinX 0.7.0 для AMD — GUI для тестового приложения Intel Linpack. Серверы были подключены к модулю удаленного управления питанием RPCM 1502, что повысило стабильность характеристик тока и позволило снимать показатели потребления электроэнергии. Этот модуль — еще одна российская разработка.

Для дополнительной проверки корректности данных по энергопотреблению мы использовали ваттметр и данные с модуля IPMI.

Всего пришлось провести три цикла тестов. Результаты первого не соответствовали нашим ожиданиям и заявленным производителем показателям системы охлаждения. Мы предположили наличие дефекта радиаторов.

Во время второй командировки дефект был подтвержден специалистом ООО «Теркон-КТТ», который сделал сортировку радиаторов на складе. На этом этапе мы добавили еще несколько тестовых серверов: в итоге у нас осталось 20% радиаторов, а 80% было отправлено на доработку в Екатеринбург. Третий цикл тестов был проведен для сравнения воздушной системы охлаждения и КТТ.

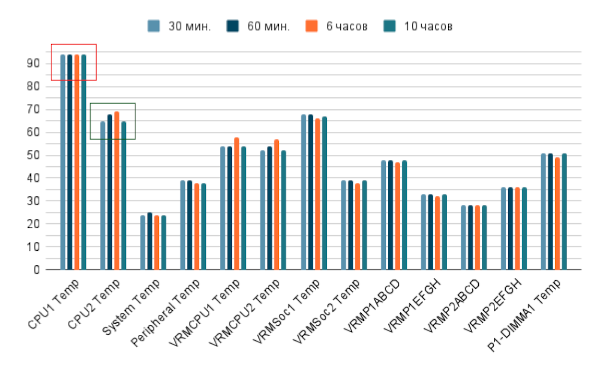

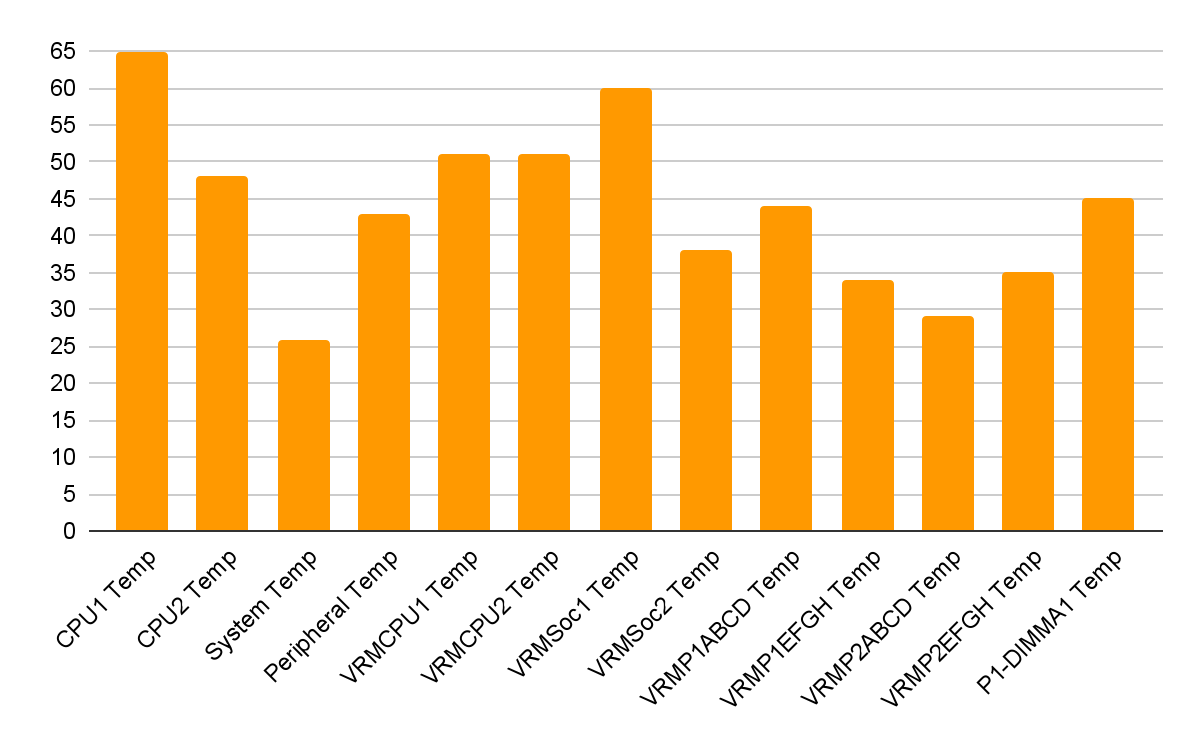

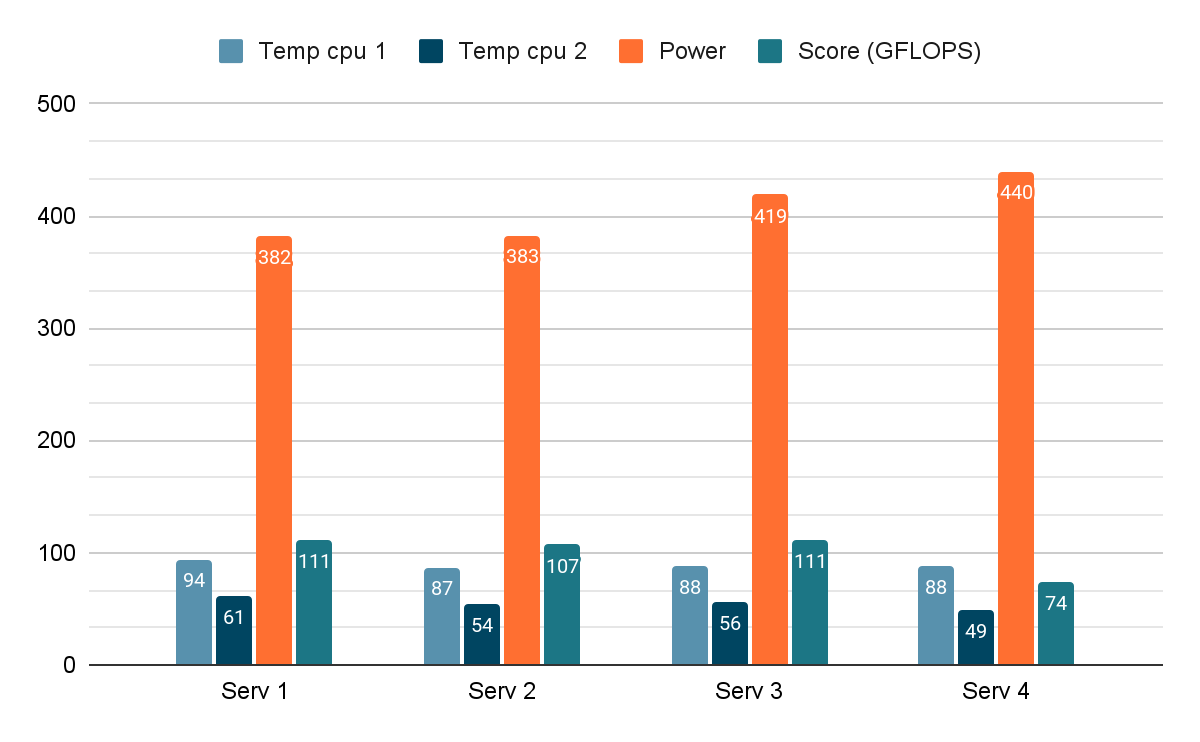

Результаты неудачных тестов

Для начала приведем результаты тестов, которые нас не устроили.

Сервер 1

Сервер 2

Сервер 3

Особое внимание следует обратить на результаты тестирования первого сервера: температура CPU в +94°C явно угрожает стабильной работе оборудования. Причина такого результата — дефект радиатора, который был подтвержден Александром во время второй командировки.

Позже, во время визита к нам, генеральный директор ООО «Теркон-КТТ» Аркадий Иванов показал еще ряд нюансов, повышающих качество и стабильность работы системы охлаждения. На контактную поверхность процессора и термоинтерфейса трубки следует наносить термопасту MX-4, а на контактную поверхность конденсаторной пластины трубки, которая крепится к шине — КПТ 19. Такое сочетание термопаст имеет важное значение, поскольку MX-4 обеспечивает лучшую теплопередачу, а КПТ 19 не сохнет.

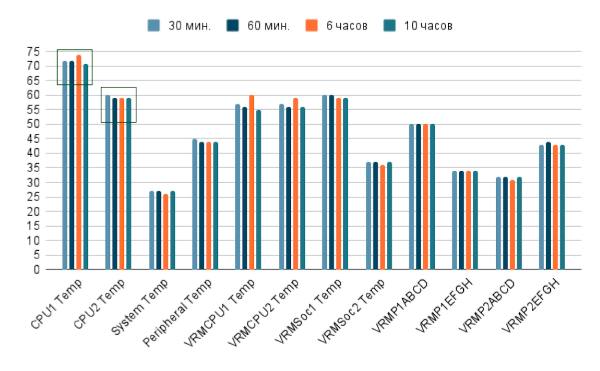

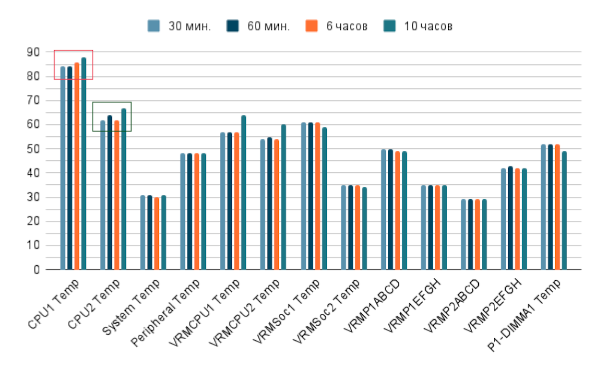

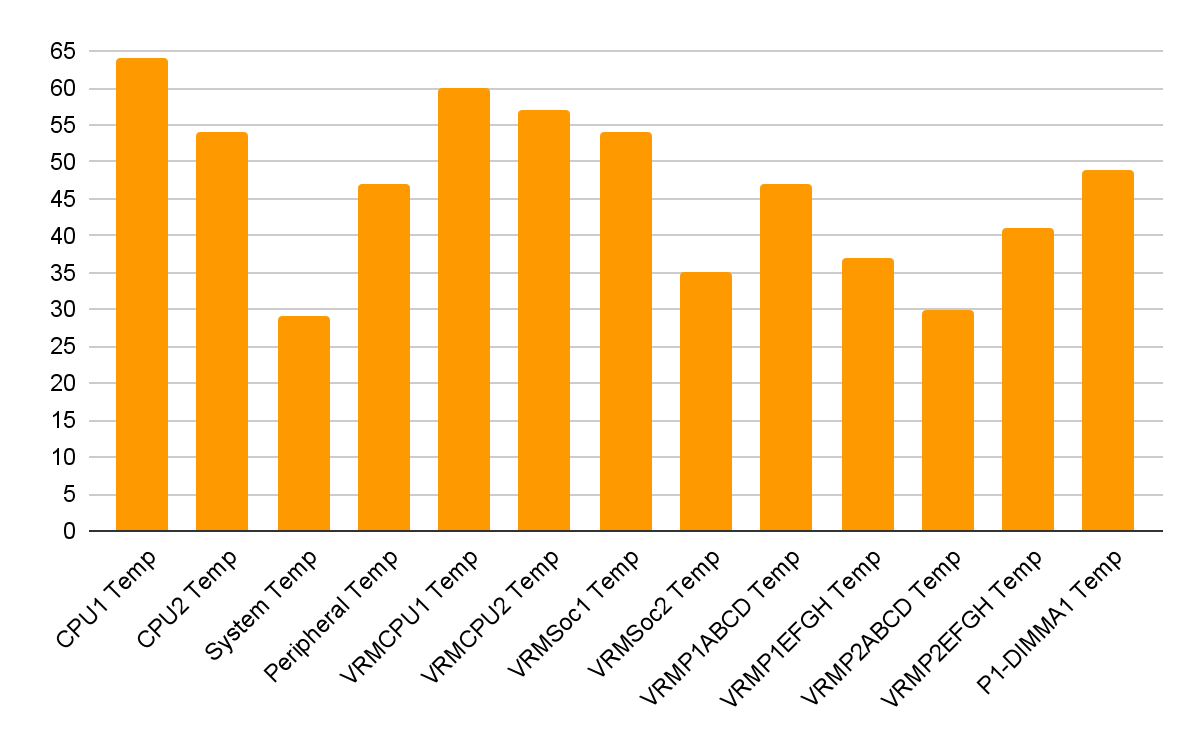

Успешные тесты

После замены радиаторов и использования правильного сочетания термопаст мы смогли получить приемлемые результаты. Отметим, что если в серии неудачных тестов разброс температур был большим, то после исправления ошибок результаты на различных серверах оказались практически идентичными.

Температура

Сервер 1

Сервер 2

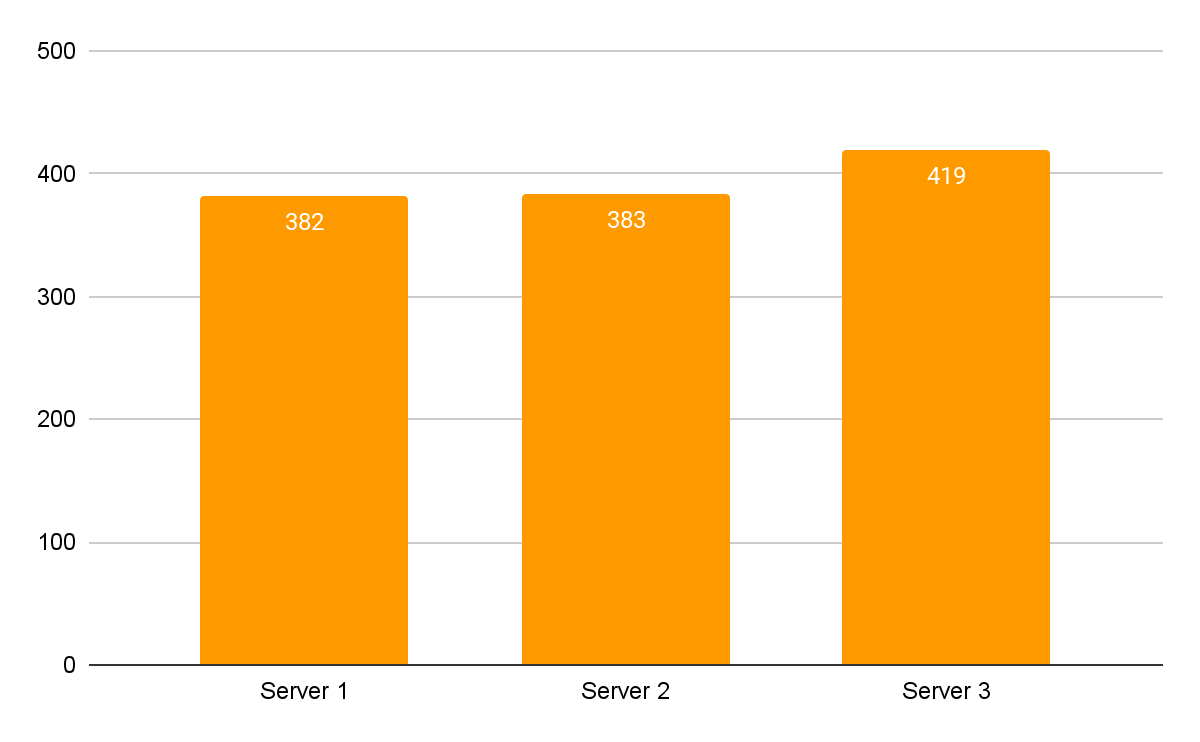

Энергопотребление

Охлаждение на базе КТТ снижает энергопотребление за счет уменьшения объема потребляемого системой воздуха и снижения затрат на кондиционирование. Энергопотребление непосредственно сервера и системы охлаждения на базе КТТ в целом не отличаются от показателей стандартных систем охлаждения. При проведении тестирования мы получили следующие средние показатели энергопотребления серверов (Вт):

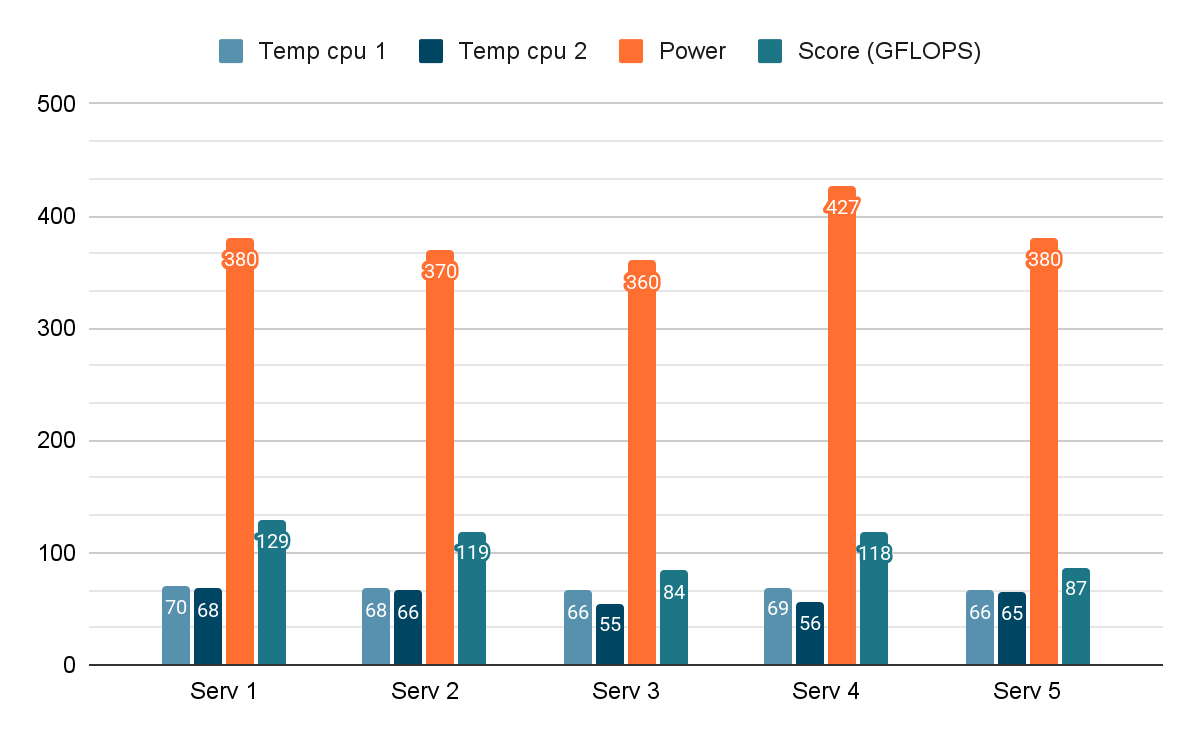

Экономия от использования системы «Теркон» более наглядно проявляется при рассмотрении работы вентиляторов: в зависимости от температуры охлаждения процессора автоматика снижает количество оборотов на 10-40% по сравнению с работой стандартных систем.

Потребление мощности сервера на вентиляторах и на КТТ

КТТ

Воздух

Скоростью вентиляторов можно управлять через IPMI. Разница в потреблении питания между минимальным и максимальным показателем скорости (8400 – 12600) составила 30 – 50 Вт, а разница в температурах между максимальной и минимальной скоростью вращения вентиляторов — примерно 5°C. Производительность не зависит от скорости вращения вентиляторов, при этом сравнительно низкая производительность отдельных серверов (менее 100 GFLOPS) объясняется одноканальной памятью.

Выводы

Использование контурных тепловых трубок позволяет обеспечить стабильное и равномерное охлаждение двух процессоров, а также снизить энергопотребление (в среднем до 383,4 Вт для КТТ против 406 Вт для воздушного охлаждения). Лучшее охлаждение дальнего процессора повышает и производительность работы оборудования.

С «Теркон» мы можем использовать одноюнитовые сервера с потреблением в 400 Вт. С низкопрофильными радиаторами такие машины обычно перегреваются, поэтому приходится ставить корпуса на 2U и активные радиаторы. Повысив плотность размещения примерно вдвое, можно существенно сэкономить на аренде площадей в ЦОД: если принять среднюю стойку на 42U без расходов на электроэнергию за 50 000 рублей в месяц, то в год мы можем потратить меньше на 600 000 рублей (1250 рублей в пересчете на сервер в месяц).

Несмотря на ряд сложностей с настройкой оборудования и браком в первой поставке радиаторов, следует признать опыт работы с решением «Теркон» успешным. Довольно быстро нам удалось собрать действующую систему пассивного охлаждения, которая соответствует заявленным характеристикам. Отдельно стоит отметить клиентоориентированность производителя: ввод оборудования в эксплуатацию и решение проблем с ним проходили с участием представителей компании-разработчика.

TL;DR: Решения «Теркон» упрощают работу с серверным оборудованием и позволяют ощутимо снизить стоимость эксплуатации ИТ-инфраструктуры.

Применение альтернативных решений позволит HOSTKEY предлагать клиентам высокопроизводительные выделенные серверы дешевле без потери качества.

А специальный промокод «Я С ХАБРА» откроет врата щедрости: назовите его консультанту на сайте при размещении заказа — и получите дополнительную скидку.

Платить можно как всегда в рублях с НДС российской компании или в евро — компании в Нидерландах.

Комментарии (77)

Devd

07.05.2022 03:30+2Следует заметить, что терконы перестают работать при перегреве.

ULP

07.05.2022 10:55Сомневаюсь, для этого охлаждение должно перестать работать. Теплоноситель конденсируется и поступает в радиатор, где меняет фазу. Там непросто перегреться, трубка рассчитана на более чем 200Вт, а охлаждение идёт от гликолевой централи самого цод

Devd

07.05.2022 11:32Просто предупреждаю, что есть такая особенность и надежда только на аварийное отключение процессора. Уже не редкость процессоры с тепловыделением 300 Вт и тут водяное охлаждение вне конкуренции.

edo1h

07.05.2022 04:55+1снизить энергопотребление (в среднем до 383,4 Вт для КТТ против 406 Вт для воздушного охлаждения).

что-то не верится

ULP

07.05.2022 10:564 вентилятора, по 7-10вт на каждый. Все так и выходит. Если в 2Ю корпусе, то выйдет ещё больше

Serge78rus

07.05.2022 13:24А удастся на столько же сбросить обороты вентиляторов, если поставить планки памяти по максимуму, а не по одной на процессорный сокет, как у Вас на фото? Ведь она тоже греется и температура нескольких планок при слабом обдуве будет явно выше одиночной.

cofein51

07.05.2022 14:18Возможно они на фото только по одной, что бы примерять СО и не повредить остальные.

Serge78rus

08.05.2022 00:16В статье есть таблица с тестовой конфигурацией, где указано два процессора и две планки памяти:

CPU 2 x AMD EPYC 7451 2.3GHz (24 cores)

Впрочем, ULP уже ответил на мой вопрос

RAM: 2 x 16 Gb DDR4 REG

WicRus

07.05.2022 09:53+1Интересная идея. Лично мне всегда импонировала такая реализация данной идеи: вывести из сервера тепло термотрубкой, а дальше использовать контур жидкостного охлаждения. Правда под такую идею нужна подготовленная инфраструктура.

Вопрос по вашей реализации, а есть сравнение КТТ с обычным теплотрубками по производительности и цене?

ULP

07.05.2022 10:58Не встречал "обычных теплотрубок" в эксплуатации в ЦОД, только внутри пассивных радиаторов. Не с чем сравнивать, бывает только громоздкая водянка от dynatron https://www.dynatron.co/product-page/l8

Devd

07.05.2022 11:36В 1U корпусе можно охладить 490W только с помощью водянки https://www.alphacool.com/enterprise-solutions-sets

ULP

07.05.2022 11:53Можно, только потом придётся эти 490 ватт охлаждать кондиционером в машинном зале. ЦОД выгодно делать это напрямую, тогда в зале можно поставить больше оборудования

Devd

07.05.2022 12:02Например у OVH все датацентры с централизованным водяным охлаждением.

edo1h

07.05.2022 17:44В 1U корпусе можно охладить 490W только с помощью водянки

уверены?

https://www.supermicro.com/en/products/system/gpu/1u/sys-120gq-tnrt

2x270 Вт на воздухе. при этом ещё и gpu можно воткнуть.

ULP

07.05.2022 18:53Больше 150вт с процессора в 1ю без ухищрений не продувается, сколько раз пробовали. Приходится 2ю корпуса ставить и активные радиаторы, да и мельчить нет смысла с таким потреблением

edo1h

08.05.2022 00:55хм…

обычная одноюнитная микра с одним эпиком 7453.

смотрю потребление по 12 В в простое, 4+100 Вт, температура +35℃

запускаю mprime, потребление становится 52+225 Вт, температура +61℃

да, это не паспортные 225 Вт tdp, но непохоже, что упёрлись именно в отвод тепла с одноюнитовой платформы — по температуре запас есть.

надо попробовать покрутить параметры bios.

ULP

08.05.2022 10:38Проще ваттметр на питание поставить и по нему смотреть. Плюс надо что бы она так минут 15 простояла, тогда прогревается и начинает тротлить. Но с 7453 наврятли проблемы будут

edo1h

08.05.2022 11:17не проще. это надо искать ваттметр (а лучше два), ехать в офис,…

а тут глянул в ipmi какой ток на выходе у блоков питания, остаётся сложить два числа.вдогонку, изменил настройки в bios (перевёл Determinism Slider в Power + установил cTDP и PPT в допустимые по спекам 240 Вт), после этого под mprime потребление выросло до 337 Вт (со 104 в простое). температура процессора выросла до 69℃.

так что говорите, больше 150 Вт с сокета в 1u снять нельзя? )))P. S. вот процессору с tdp 280 Вт в таком корпусе, наверное, будет жарко.

amarao

07.05.2022 11:03Сколько киловатт может стойка отводить через эту систему?

ULP

07.05.2022 11:11500-600вт на юнит примерно, там есть трубки разного диаметра.

amarao

07.05.2022 11:1948*600 = 28КВт на стойку? Звучит как утопия.

randomsimplenumber

07.05.2022 11:26Так ведь вся потребленная сервером энергия конвертируется в тепло.

amarao

07.05.2022 11:28+1Я про другое. 28кВт на стойку - это довольно много. Обычно стойки 14кВт, 30 - это уже прям для data science.

vconst

07.05.2022 14:5728 киловатт — утопия? ))))

Мировой рекорд — 400 киловатт на одну стойку, а 200 киловатт просто штатное решение, без напряга. Хотя и 200 квт тоже были мировым рекордом, только предыдущим

ULP

07.05.2022 15:46Можно ссылочку? 400квт на стойку это там газовая горелка высокого давления по центру?

vconst

07.05.2022 16:00servernews.ru/1014165

Плотность вычислений у них тоже одна из самых высоких в мире, если вообще не самая высокаятам газовая горелка высокого давления по центру?

Там 300 процессоров в одном шкафу

amarao

07.05.2022 22:46Я не сказал "рекорд". ДЦ, который может спокойно шлёпать стойки на 28кВт и не париться про перегрев коридора, это круто.

vconst

08.05.2022 01:56+1Я не сказал «рекорд»

Верно, но тут дело в другом.

Я считал, что довольно неплохо ориентируюсь в современных компьютерных технологиях. До недавнего времени, когда вскользь ознакомился с миром HPC, заглянув в него краем глаза, просто с рассказов одного друга, который занимается этим много лет и делает абсолютно уникальные вещи

Выглядело это примерно как в популярном комиксе:

Мой мир уже никогда не будет прежним и все будет в сравнении :)

Первое впечатление было примерно как у топикстартера, только я спросил не про горелку высокого давления, а предположил, что шкаф просто набили нихромом ))

Потому, цифры типа «аж 25 киловатт на стойку!» или «стойка на целый петабайт!» — уже совсем не впечатляют…

Никого не хотел обидеть :)

ULP

08.05.2022 10:43У Ломоносова производства Т-платформ была схожая плотность и фрезированные радиаторы жидкостные размером 200х600 что ли по 3000 баксов за штуку. Мэйнфреймы IBM сразу на жидкости идут, мы имеем опыт эксплуатации сразу нескольких проектов с полным погружением. Был бы проект и бюджет, а решение найдётся

vconst

08.05.2022 13:20+1К слову, Ломоносов этот только зимой работает в полную мощность. Летом охлаждения хватает всего на треть

amarao

08.05.2022 14:21+1У меня давно назрел вопрос, в чём разница между суперкомпьютером и вычислительным кластером на 3-5 ДЦ?

Можно жечь 400кВт на стойку, а можно сделать 20 стоек по 20 кВт. Я не знаю, что из них будет дешевле. С учётом, что HPC интерконнект - это просто чуток более быстрая сеть, а ни о каком SMP там даже близко речи не идёт, почему надо гиперуплотняться? Для красивой звёздочки в топе линпака?

ULP

08.05.2022 14:55Можно за вводную взять что стойко-место без электричества на 3х32А (3х32х220=21кВт) в цод стоит 300 евро в месяц. Это отражает затраты на теплоудаление и гарантированное энергоснабжение плюс обслуживание плюс некоторую прибыль, около 100 евро со стойки. КАПЕКС на такую стойку составляет около 20000 евро в ЦОД от 200 стоек (без учёта недвижимости), т.е. грубо 10 годовых с вложений. Отсюда есть некоторые выводы по количеству стоек на квт мощности:

1) мельчить имеет смысл если мы ограничены в площади машзала, например у нас бункер или интерконнект имеет максимум длинны в 1 метр и не выходит за стойку или у нас общая шина на базе чего-то и её можно вести только в печатной плате без ухищрений (PCIe x16)

2) цена прибамбасов для охлаждения делает эту разницу в 300 евро в месяц существенной что бы заморочится на неё (4000 в год на стойку если грубо).

3) мы можем экономить на кондиционерах, но тут мы рассматриваем прямое охлаждение в той или иной его форме. Ovh именно так и поступает.

Т.е. если мы используем (использовали до известных событий) сознательно 8-и процессорные матери на Платинум с кучей памяти и 400Г инфинибанд интерконнектом, то нам должно быть абсолютно до фонаря сколько стоит стойка, помещение и все прочее на фоне затрат на сервер, где нужен общий интерконнект.

Если там обычные лезвия с 100Г интерконнектом и парой камней, то мельчить экономического смысла нет, надо просто взять больше стоек.

Я так себе это представляю.

amarao

08.05.2022 15:23А можно чуток понизить плотность/надёжность (перенеся её на софт) и получить на процах попроще большее число нод, которые дают тот же результат дешевле.

Я не знаю про HPC, но когда я себе видеокарту выбирал, sweet spot по метрике "попугаев/€" оказался примерно сразу после top 10 видеокарт. (Итого - RX 6600, без XT).

Вероятнее всего, с процессорами так же. Плотность и нахождение в топе (платинумы) даёт премию к цене.

В целом, мне вот очень интересно, чей суперкомпьютер самый быстрый. netflix'овый или youtube'овый?

ULP

08.05.2022 15:52Софт часто уже есть и переписывать его не вариант. А часто он уже готовый, без исходников или те исходники на фортране 40 лет назад написали. Часто проще сделать больше ядер, быстрее интерконнект, срубить на этом - чем потратить лет 10 работы роты разработки с неочевидным результатом и сроками.

amarao

08.05.2022 16:00суперкомпьютеры для софта 40-летней давности. Окаай. Наверное, это специальная дисциплина такая.

ULP

08.05.2022 16:09+1Думаете его эльфы в таймстопе с нуля каждый раз пишут? Мы имели опыт с очень известным софтом для геофизики, вот ноги именно там. Думаю системы моделирования и предсказания тоже не вчера написали, только на новом железе они быстрее работают

vconst

08.05.2022 15:23Честно говоря — у меня нет готового ответа :) Я же там не работаю, а так — зайти в гости, выпить пару литров чая, потискать котов, потрепаться о том о сем

Из всех этих разговоров могу сделать несколько предположений: может быть для уменьшения длины связей между серверами; или для упрощения охлаждения. Не в последнюю очередь потому, что «нам нравится делать странные вещи» :)

Буду в гостях — спрошу поконкретнее)

zorn_v

07.05.2022 14:01-2> Звучит как утопия.

Почему ? Вам же уточнили - там есть трубки разного диаметра.

Никакого лукавства, обычная "средняя по больнице" )

xaosxaos2

08.05.2022 10:02-3Тестируем космические технологии

Боюсь показаться токсичным, но где тут раскрытие космических технологий то? Что тут есть снятие тепла и передача его в атмосферу, что тут нового-то? Ожидал что-то как они увидеть как они умудряются скидывать тепло в вакууме или преобразование тепла, а тут что? НИЧЕГО.

ULP

08.05.2022 10:46Контурные тепловые трубки изначально используются в качестве систем охлаждения космических аппаратов, они куда сложнее и эффективнее чем обычные тепловые трубки.

xaosxaos2

08.05.2022 12:11-2Простите, можете ткнуть в статье где идёт об этом рассказ техническая часть хотя бы на уровне жестов, но сложнее чем сказали вы? По-сути вы ничего не сказали, кроме как сложнее, ну и куда девать тепло в вакууме? Атмосферы НЕТ! Где вся соль то?

xaosxaos2

08.05.2022 13:01-2Господа минусующие, у вас совесть есть? Никто из вас даже не удосужился даже как-то опровергнуть слова и показать факты на деле, что я ошибаюсь или не прав. Вы только способны на токсичное поведение, потому что вы можете и на этом всё.

mayorovp

08.05.2022 13:17+1А почему вам кто-то должен что-то объяснять? Особенно очевидные вещи.

Разумеется, для излучения тепла нужны радиаторы. К этим радиаторам тепло нужно как-то доставить. Для доставки тепла нужны, в том числе, тепловые трубки.

xaosxaos2

08.05.2022 13:59-1Разумеется, для излучения тепла нужны радиаторы.

Чего чего? Излучение тепла? Я может чего-то не понимаю, но одно дело когда радиатор в атмосфере и совсем другое когда он в вакууме, это абсолютно разные вещи. В первом случае молекулы атмосферы контактируют с поверхностью радиатора и забирают тепло, во втором случае забирать нечему (у нас вакуум). И следовательно его надо как вы написали его излучать. И разница сколько можно отвести тепла в первом и во втором случае уж наверняка отличается на порядок.А почему вам кто-то должен что-то объяснять?

Ну а для чего ещё нужны комментарии собственно? Чтобы сказать «ух ты это было круто, давай ещё?» Или вам в школе дали таблицу умножения и сказали учи, а объяснять не будем? Нет? Значит всё таки необходимо объяснять даже очевидные вещи, особенно если об этом попросили.

ULP

08.05.2022 14:15Температура материала может изменяться вследствие передачи энергии теплоносителю (воздуху, воде, жидкому натрию, ..) или при излучении электромагнитной энергии (инфракрасные лучи и т.п.) именно второй способ характерен для охлаждения электроники в КА. Не помню что там про это в школе говорили, но вроде это очевидно.

xaosxaos2

08.05.2022 14:22-2Так я вам это и пытаюсь донести. И то что работает в КА оно будет работать грубо говоря на земле, но не наоборот. Земные вещи напорядок эффективнее, ну в том плане что метр радиатора тут вам отведет столько тепла, сколько не сможет на КА. Это же тоже очевидно? И хватит пользоваться преимуществом, то что я не могу тоже вас минусить, это ребячество иначе просто перестану общаться с вами.

P.S. Вы так и не ответили на мой первый вопрос, где описание того новшества которое ууу так подняло тепловод на другой уровень на земле?

mayorovp

08.05.2022 14:41+1Тот факт, что радиаторы в космосе менее эффективны, никак не отменяет необходимости собрать тепло и передать его на радиаторы.

Описание новшества под названием "контурные тепловые трубки", сокращённо "КТТ", дано в тексте статьи, под заголовком "Что такое «Теркон»".

И хватит жаловаться на минусы, это способ выражения несогласия а вовсе не какое-то выдуманное вами "преимущество".

xaosxaos2

08.05.2022 14:47-2И хватит жаловаться на минусы, это способ выражения несогласия а вовсе не какое-то выдуманное вами «преимущество».

Почему это? Вы ограничиваете меня в моих правах? Я же не могу поставить минус выражаясь вашим языком, тем самым выразить несогласие с вашим мнением. Вы можете. Что видят другие, минусы в меня а у вас нет, значит я заведомо не прав и зачем разбираться давай я ещё туда в копилку. Плюс ладно коменты, это пустяки вы и в карму полезли, тоже видимо не совпадение по мнениям…

mayorovp

08.05.2022 15:01Минусы в карму возникают когда вы пытаетесь запретить ставить минусы комментариям.

xaosxaos2

08.05.2022 15:04Минусы в карму возникают когда вы пытаетесь запретить ставить минусы комментариям.

Вот врать не надо тут? Минусы появились после второго комментария и до третьего то есть до вот этого комментарияГоспода минусующие, у вас совесть есть?

SIMPLicity

09.05.2022 16:19Почему аммиак?

Что будет при течи в контуре?

Каковы затраты на мониторинг? Или просто "сотрудник носом повёл и учуял, что где-то подтекает"? Или "когда глаза режет,- начинаем дигностику"? Я вот ни на одном радиаторе не увидел проводков от встраиваемых датчиков давления аммиака в контуре ...

PS Идея может быть и хорошая, но реализация фигня: всё равно по машзалу (хорошо-хорошо,- под полом машзала, рядом с шиной питания) циркулирует жидкость; а в каждом серваке потенциальная достаточно

вонючаятоксичная аммиачная "бомба" . Закатывать сервак по рельсам вдвоём не супер как-то (хотя это редко когда делается,- факт). Перемонтаж брендового сервака со вскрытием корпуса и проч... - тоже имхо "не супер".Есличо, я в сервера ни разу не супер,- просто прикидываю на "рядовой сервер", типа дома такая штука живёт:

... Так у него основной тепловыделитель - это два блока питания по 750 ватт. Процы, как и сервак, старые, режим охлаждения - в зависимости от температуры.

В общем, мне кажется, оттестированный аммиачный вариант - ну это весьма экзотичная штука.

t38c3j

На сколько такие системы по концепции эффектны для пк в полном контуре вместе башенного кулера или водянки? Мне видится проблема в обслуживании, как вспомню холодильники))

ULP

Для ПК просто водянка ставится. Для сервера она обычно слишком крупная

vconst

Есть решения водянки для серверов и показатели показывают отличные

Когда в ВК заменили воздух на воду — производительность выросла в 6 (шесть) раз

ULP

Можно ссылочку? Никогда не слышал

vconst

rscgroup.ru/news/rsc-vk

Можете и другие новости почитать, из последнего — СХД 1 петабайт в 1 юните

ULP

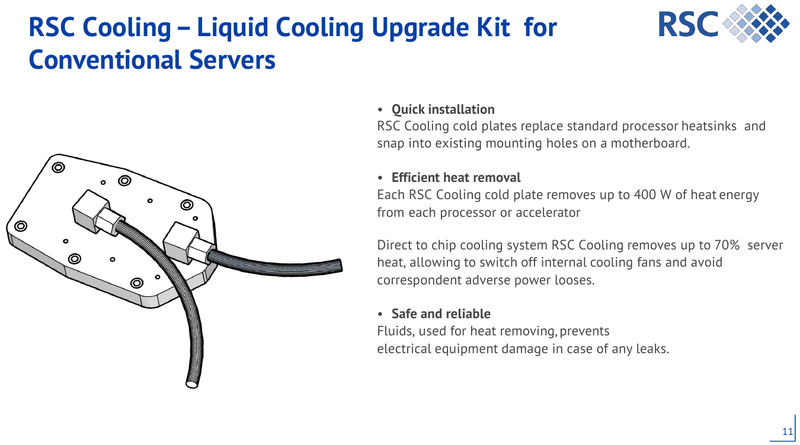

А, это они с 2х16А на воздухе перешли на 3х32А на воде, так как электричество было, а кондиционирование было расчитанно на 7квт на стойку. Это можно только в своём ЦОД, в коммерческом так не выйдет сделать. Такая водянка широко используется OVH с момента основания.

vconst

У РСК есть комплекты водянки и для стандартных серверов

ULP

Думаю они золотые по цене, для суперкомпьютеров на деньги налогоплательщиков это норм, а для гражданского использования это перебор. Потом мы сейчас не про теоретически возможные варианты, а про то что в Датапро можно это заказать за счёт ЦОД и это выгодно ЦОД и более-менее удобно в эксплуатации

vconst

Суперкомпьютеры логичнее рекламировать, чем решения для обычных ЦОДов, которых ребятами из РСК сделано более чем достаточно. Тот же апгрейд ВК — явно не «на деньги налогоплательщиков» :)

Тем не менее, как-то не очень много у них конкурентов, хоть бы и «на деньги налогоплательщиков», ибо построить супер мирового уровня — задача, мягко говоря, не самая простая.

Но таки да, технологии по настоящему уникальные, потому дешевыми быть не могут

ULP

Спроса нет, вот почему. Это все экспериментальные установки ручной работы.

vconst

Спрос есть, это не экспериментальные установки — все работает и крутится, просто это не ширпотреб. HPC — это не самая большая отрасль, но одна из самых наукоемких

Не всем нужно сверхплотное размещение серверов, от 100 штук в одном шкафу, достаточно и обычных стоек — на пару десятков, а там и водянка не очень нужна. Чаще всего место для шкафов стоит не настолько дорого и нет необходимости в быстром интерконнекте, чтобы тратиться на подобные решения.

Ессно, что «условный камаз» куда востребованнее, чем карьерный грузовик

Dakar

Кмк, не сильно отличается от водянки в домашнем применении. Только мороки больше. Термоконтур на металлических трубках, соответственно заточен под конкретные мать, корпус. Водянка на шлангах в этом плане универсальна. А смысл и того и другого один и тот же-увести тепло туда, где попросторней и можно использовать большой радиатор.

ULP

Тут решается задача что бы тепло от процессора не попало в машиный зал , где его придётся убирать кондиционером. Водянка с радиатором это не решает