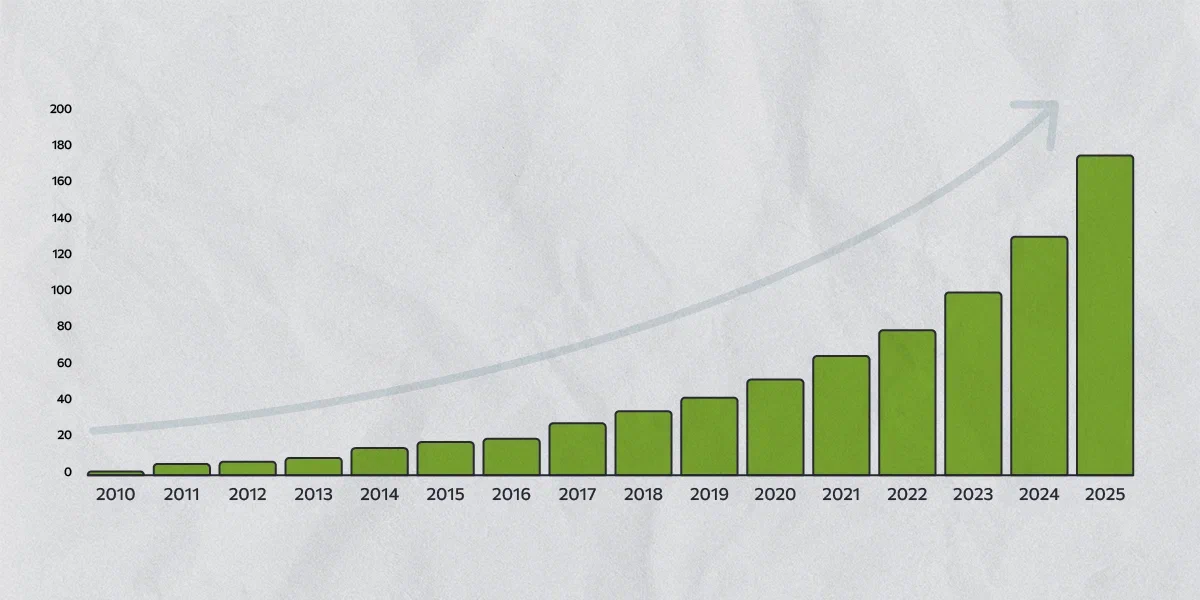

Ожидается, что в 2025 году ежегодный объем генерируемых данных превысит 160 зеттабайт. Однако почти все генерируемые сегодня данные (98%) затем удаляются или перезаписываются. Подобное отношение к генерируемым данным объясняется просто: у компаний пока еще не хватает инструментов для работы с такими колоссальными объемами. Но ведь эти данные — буквально золотая жила для бизнеса, поскольку оттуда можно выуживать ценнейшую информацию. И терять их для крупных компаний, значит, недополучать значительную долю прибыли.

В статье рассмотрим, как машинное обучение помогает обрабатывать большие объемы данных и извлекать ключевую информацию, скрытую в них. И, разумеется, приведем примеры совместного использования Big Data и Machine Learning (ML), а также расскажем об интересных проектах для тех, кто хотел бы начать работать с большими данными и ML.

На пользу друг другу

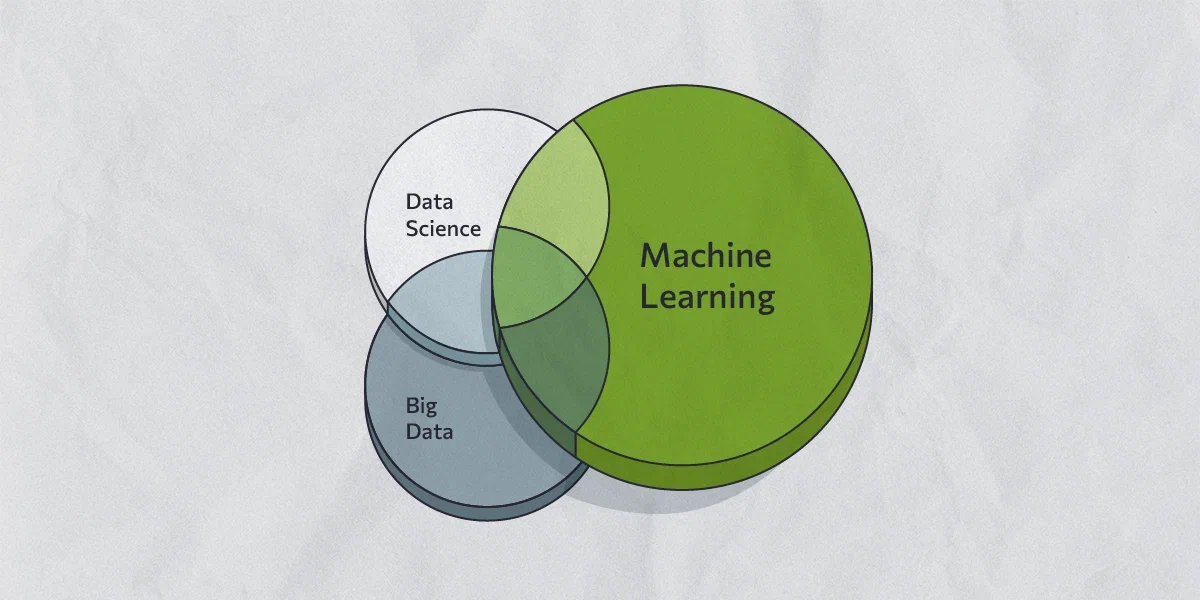

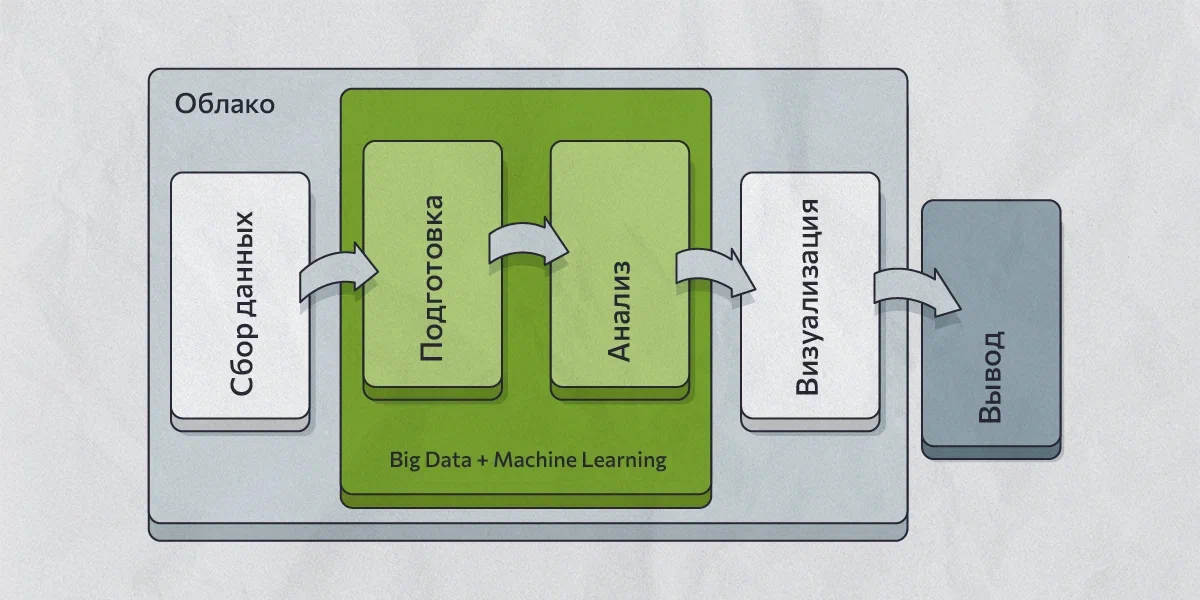

Алгоритмы машинного обучения становятся более эффективными по мере роста объемов обучающих данных. И объединяя большие данные с машинным обучением, мы получаем двойную выгоду: алгоритмы Machine Learning помогают нам справляться с непрерывным потоком данных, а объемы и разнообразие потоков данных прокачивают алгоритмы, делая их более совершенными. Давайте посмотрим, как в идеале должен работать процесс интеграции этих двух технологий.

Передавая большие объемы данных алгоритму машинного обучения, мы ожидаем увидеть определенные результаты (например, скрытые от менее совершенных инструментов паттерны или закономерности), которые могут помочь в дальнейшем моделировании. Некоторые компании используют полученные данные для автоматизации рабочих процессов, но чаще всего аналитики просматривают результаты работы алгоритма и выискивают в них ценную информацию, которая может помочь оптимизировать бизнес-схемы. И это на самом деле правильно.

В то время как ИИ в десятки и сотни раз превосходит людей по производительности, ему не хватает определенных способностей для принятия решений. Компьютерам еще только предстоит приобрести многие качества, присущие людям, но пока критическое мышление и гибкость в анализе им не свойственны. Вот и получается, что без эксперта, загружающего правильные данные, ценность результатов, сгенерированных алгоритмом, значительно уменьшается. А без эксперта, интерпретирующего вывод, предложения, сделанные алгоритмом, могут поставить под угрозу благосостояние компании. Современный ИИ — прежде всего помощник эксперта и еще долгие годы таковым и останется. Теперь несколько примеров, которые продемонстрируют, как большие данные и машинное обучение могут эффективно работать вместе.

Облачные сети

У исследовательских компаний в различных областях есть большие объемы данных (например, медицинских), которые они хотят тщательно проанализировать. Но для этого им требуются серверы, онлайн-хранилища, сетевые ресурсы, а также нужно позаботиться и о конфиденциальности. Всё это приводит к солидным расходам. Здесь и приходят на помощь облачные сервисы, предлагающие всю необходимую инфраструктуру и модели машинного обучения для анализа данных в управляемой среде.

Модели машинного обучения такого типа включают распознавание изображений и анализ текста с ускорением на GPU. Правда, эти алгоритмы чаще всего не обучаются после развертывания, но их можно распространять и поддерживать с помощью сетей доставки контента (CDN).

Веб-скрейпинг

Под скрейпингом понимают извлечение данных со страниц различных веб-ресурсов. Представим, что производитель электронных устройств узнает о состоянии рынка и обратной связи от покупателей из квартальных отчетов ритейлера. В своем желании выяснить, что могло быть упущено из отчетов, производитель решает извлечь из сети определенные данные, включая отзывы о продуктах, оставленные на различных площадках. Собирая эти данные и передавая их в модель глубокого обучения для анализа, руководство предприятия сможет понять, что необходимо улучшить в производственном процессе, чтобы увеличить продажи.

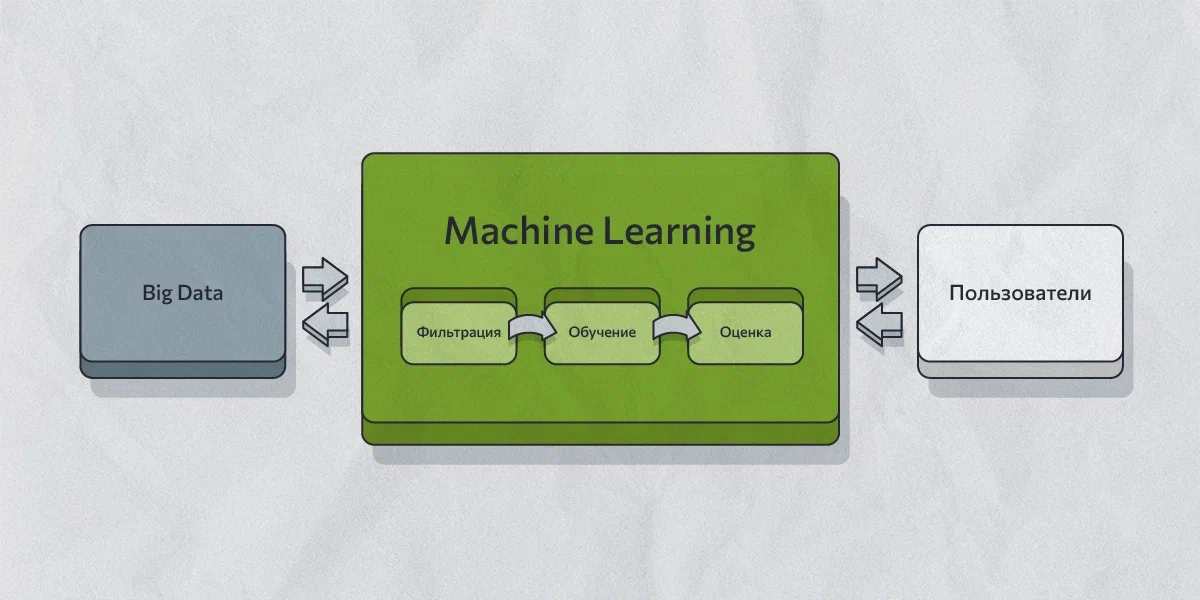

Однако веб-скрейпинг предполагает получение достаточно разнородных пакетов данных из множества источников, поэтому не менее важной частью процесса является фильтрация источников и типов данных. Для работы с отфильтрованными (то есть качественными) данными задействуются технологии интеллектуального анализа, Data Mining, позволяющие обнаруживать ценную информацию. По сути, Data Mining — это уже обученные алгоритмы по моделям Machine Learning.

Системы «умных» рекомендаций и прогнозирование в реальном времени

Такие системы используют Big Data для накопления истории посещений веб-ресурсов тысячами и миллионами пользователей. А алгоритмы машинного обучения задействуются здесь для анализа этих данных и формирования рекомендаций с последующей корректировкой, в зависимости от новых вводных. Так работают, например, системы рекомендаций Youtube или музыки ВК. Эти примеры — еще одна наглядная демонстрация, как большие данные и машинное обучение могут работать вместе.

Производители беспилотных автомобилей внедряют технологии Big Data и Machine Learning в свои системы прогнозирования ситуаций в реальном времени, на основе которых и работает их техника. Те же автомобили Tesla реагируют на внешние раздражители, используя постоянно обновляемые массивы данных для решений, которые принимаются на основе непрерывно совершенствующихся алгоритмов машинного обучения. Кстати, про беспилотные авто мы уже рассказывали раньше.

IoT, Интернет вещей

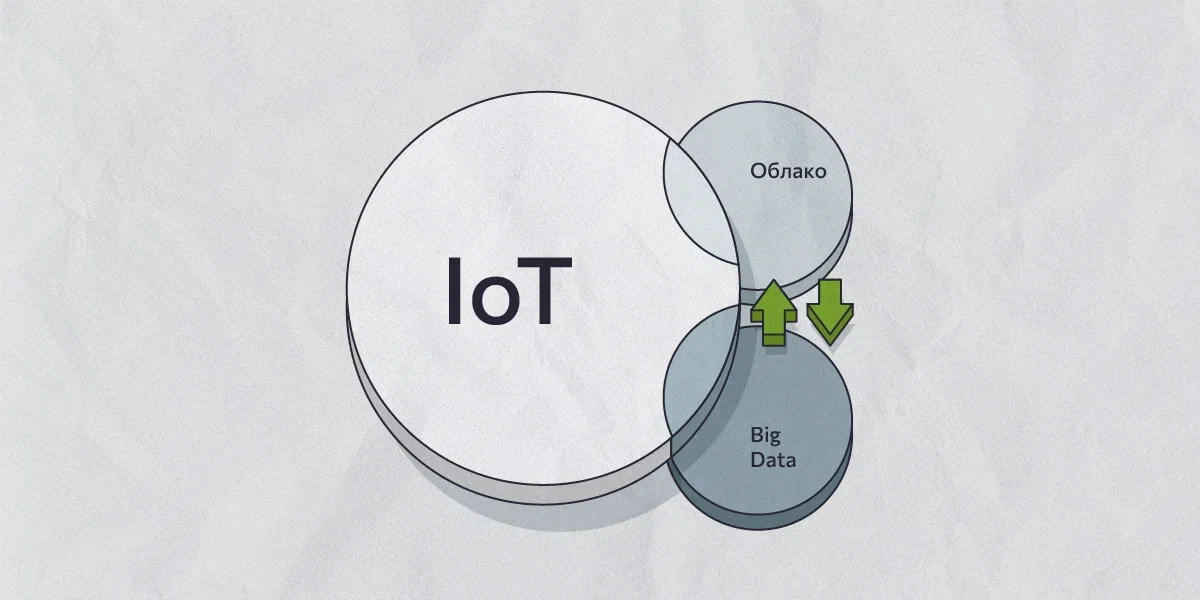

В основе Интернета вещей (IoT) лежат три технологии — это Big Data, 5G и AI на основе ML. IoT предполагает подключение множества гаджетов по сети и обеспечение беспрепятственной связи устройств друг с другом, а для этого требуются широкие каналы связи и технологии хранения и обработки больших объемов данных. Таким образом, IoT действует фактически как цифровая «нервная система». А AI позволяет извлекать из данных нужную информацию, что делает системы IoT намного более интеллектуальными.

Если же задействовать обученные алгоритмы Data Mining, появляются возможности для качественного глубокого анализа огромных объемов данных IoT. А это открывает возможности для изучения поведения пользователей услуг или покупателей. Новая технология, ставшая результатом совместной работы Big Data и AI на основе ML, получила название IoB, Интернет поведения или привычек (Behaviors). При помощи алгоритмов машинного обучения маркетологи, анализируя огромные массивы данных IoT, пытаются понять, когда и при каких условиях пользователи совершают покупки.

Системы кибербезопасности

Большие данные нуждаются в серьезной защите, особенно если они связаны с такими чувствительными областями, как финансы или медицина. Это особенно важно, учитывая, что ML и AI увеличивают объемы обрабатываемых данных. Примером того, как машинное обучение используется для повышения кибербезопасности, является разработка интеллектуального антивирусного программного обеспечения, которое может распознавать любое вредоносное ПО или вирус. «Умные антивирусы» призваны точно определять новые угрозы и быстро выявлять старые. Такие пакеты уже предлагают известные разработчики антивирусного ПО (например, Norton, Bitdefender), где для определения и нейтрализации угроз задействуется ИИ.

Проекты для обучения новичков и тех, кто хочет повысить свой уровень

Программисты, никогда до этого не работавшие с большими данными и машинным обучением, могут наработать навыки на сотнях проектов. Так, авторы этой статьи предлагают целых 180 проектов на Python для погружения в технологии. И это не только предсказание всевозможных цен при помощи ML и Big Data, но и, например, отслеживание подозрительных транзакций, системы рекомендаций, анализ качества продуктов, экономические прогнозы, работа с текстом (распознавание языков, выделение ключевых слов, отслеживание фейков) и многое другое. По каждому проекту даны подробные инструкции с примерами кода.

А здесь проекты разделены по уровням (начальный, средний, продвинутый), при этом в меню слева можно также выбрать и другие категории: Python, Python + Django, глубокое обучение, ИИ. В общем, еще одна огромная база проектов на любой вкус, с открытым исходным кодом и подробным разбором. Конечно, всё полностью на английском, так что заодно прокачаете и его.

О перспективах

Как видим, связка Big Data и Machine Learning уже дает свои плоды в масштабных IT-проектах. Эти технологии дополняют друг друга, делая работу отдельных приложений и целых систем по-настоящему эффективной. Поэтому углубленные знания в этих областях, понимание того, как работают эти технологии в связке, будет вашим конкурентным преимуществом при работе в компаниях, занимающихся обработкой и анализом больших массивов данных. Получить эти знания как раз и помогут обучающие проекты, которые и сами по себе могут вырасти в нечто большее, чем учебный материал. Если же у вас есть свои идеи проектов для обучения, делитесь ими в комментариях!

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

— 15% на все тарифы VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.