Модели глубокого обучения обладают потрясающим свойством — они становятся лучше с увеличением объёма данных, и кажется, что этот процесс практически неограничен. Чтобы получить качественно работающую модель, недостаточно больших объёмов данных, нужны ещё и точные аннотации. Хотя большие объёмы данных помогают модели решать проблему несогласованности данных в разных аннотациях, люди всё равно могут совершать повторные ошибки, укореняющиеся в модели.

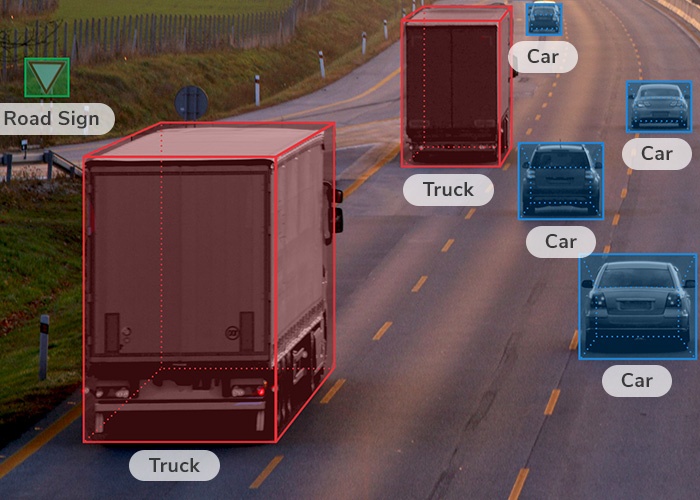

Например, когда человеку нужно нарисовать вокруг объекта прямоугольник, он обычно стремится, чтобы объект точно попал в этот прямоугольник, то есть склонен ошибаться в сторону увеличения прямоугольника. Использование такой модели для избегания столкновений приведёт к ложноположительным результатам, из-за чего беспилотный транспорт будет останавливаться без причины.

Превышение размера ограничивающих прямоугольников — пример систематической ошибки, а бывают ещё и случайные. Случайные и систематические ошибки влияют на обученную модель по-разному.

Случайные и систематические ошибки

Из-за случайных ошибок модели требуется больше данных, чтобы сойтись к тому же результату. Модель, обученная на данных со случайными ошибками, в конечном итоге придёт к тем же параметрам, только медленнее и с необходимостью большего количества данных.

Из-за систематических ошибок модель сходится к другому результату, и увеличением количества данных ситуация не улучшается. Модель, обученная на слишком крупных прямоугольниках, будет возвращать слишком крупные прямоугольники вне зависимости от количества данных обучения.

Стратегии устранения этой проблемы

Простой, хотя и дорогостоящий способ работы со случайными ошибками заключается в использовании большего количества данных обучения. Также существуют более сложные и экономичные подходы, например, если данные обучения взяты из различных источников и если каждый источник имеет разную величину случайных ошибок, то можно сгладить влияние ошибок, при обучении придав источникам с меньшим количеством ошибок больший вес.

С другой стороны, систематические ошибки можно устранить только исправлением данных или разобравшись в природе ошибки в такой степени, чтобы превратить её в случайную. В этой области существует множество интересных техник, в том числе Golden Label Correction, при которой вы аккуратно аннотируете подмножество данных, чтобы характеризовать степень неслучайности остальной части данных.

В конечном итоге, чтобы эффективно и экономно преодолевать ошибки аннотирования, нужно понять, как генерируются ошибки. Ещё раз рассмотрим пример со слишком большими ограничивающими прямоугольниками. Учитывая склонность неопытных работников к преувеличению прямоугольников, наша компания использует простые модели для проверки на превышение размеров. Со временем, благодаря обратной связи от этих моделей, работники учатся делать меньше систематических ошибок, рисуя более точные ограничивающие прямоугольники. Совместив подробные спецификации аннотирования с обучением аннотаторов и пониманием систематических ошибок, мы можем эффективным образом создавать качественные аннотации в больших масштабах, упрощая экономичное обучение точных моделей.

Комментарии (5)

ElenaVolchenko

09.11.2022 10:45+2А как же переобучение?

Я б посмотрела более свежие публикации по вопросу выбора размера выборок и бесконечного их увеличения. Статья 2017 года не кажется супер актуальной на сегодня.

JohnSelfiedarum

09.11.2022 14:00+1Мусор на входе = Мусор на выходе.

Любая модель так отрабатывает, и модели нейронных сетей в том числе!

vrecobra

09.11.2022 15:11+1Систематическая ошибка, которая мне сразу бросается в глаза на картинке выше - нет ни одного примера обнаружения мотоцикла на дороге. Весьма показательно в контексте нескольких случаев, когда автопилот Теслы таранил мотоциклистов в тёмное время суток...

Vasyutka

Да, учить ИИ без понимания как он работает - довольно не эффективно :).