История использования систем обработки естественного языка насчитывает всего 50 лет, но изо дня в день мы используем различные модели NLP. В различных поисковых запросах, переводчиках и чат‑ботах. NLP возникло как слияние искусственного интеллекта и лингвистики. Лингвистика — это наука, изучающая языки, их семантику — смысловые единицы слов, фонетику — изучение звукового состава слов, синтаксис — номинативные и коммуникативные единицы языка.

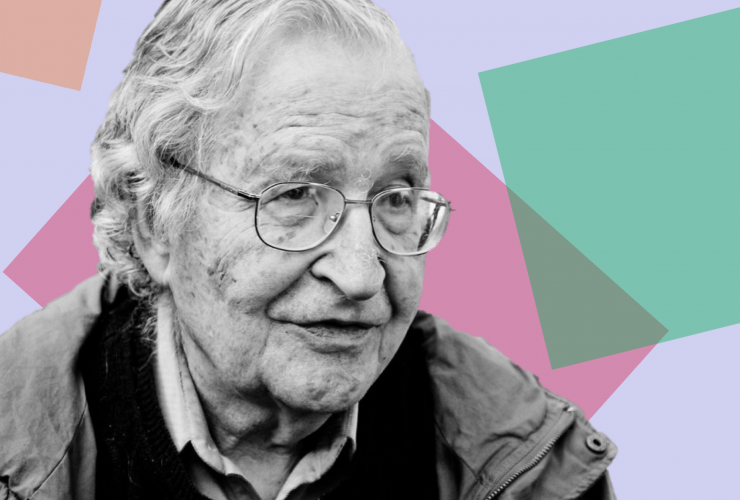

Ноам Хомский был ученым‑лингвистом, который произвел революцию в области лингвистики и изменил наше понимание синтаксиса. Он создал систему грамматического описания, известную как генеративная или генеративная грамматика (соответствующее течение лингвистической мысли часто называют генеративизмом — NLG). Ее основы были сформулированы Хомским в середине 1950-х годов. Работа Хомски стала началом рационалистического направления в компьютерной лингвистике. Отправной точкой рационализма являются компьютерные модели, не зависящие от языка. Модели лучше всего принимаются, когда они максимально просты. Здесь можно провести параллель с идеей Соссюра об отделении языка от реального мира.

Этот подход с самого начала не дал хороших результатов, но по мере продолжения работы в этом направлении результаты стали несколько лучше, чем у систем, исповедующих подход «снизу вверх». Теория универсальной грамматики Хомского предоставила схему, не зависящую от индивидуальных особенностей конкретного языка. Синтаксис лучше всего соответствовал моделям независимых языков, в которых учитывались только языки.

Первые исследователи машинного перевода поняли, что машина не сможет перевести входной текст без дополнительной помощи. Учитывая скудость лингвистических теорий, особенно до 1957 года, некоторые предлагали предварительно редактировать тексты таким образом, чтобы отмечать в них трудности, например, для устранения омонимии. А поскольку системы машинного перевода не могли выдать правильный результат, текст на языке перевода приходилось редактировать, чтобы сделать его понятным.

Системы обработки естественного языка расширяют наши знания о человеческом языке. Некоторые из исследуемых задач NLP включают автоматическое резюмирование (автоматическое резюмирование создает понятное резюме набора текстов и предоставляет краткую или подробную информацию о тексте известного типа), совместное реферирование (совместное реферирование относится к предложению или большему набору текста, в котором определены все слова, относящиеся к одному и тому же объекту), анализ дискурса (анализ дискурса относится к задаче определения структуры дискурса связанного текста, т. е. Машинный перевод).

Как мы уже говорили выше, NLP можно разделить на две части, на NLU — Natural Language Understanding. И NLG — генерация естественного языка. В контексте нашей проблемы нас интересует первая — Natural Language Understanding. Наша задача — научить машину понимать текст и делать выводы из того материала, который мы ей предложили. NLU позволяет машинам понимать и анализировать естественный язык, извлекать концепции, сущности, эмоции, ключевые слова и т. д. Он используется в приложениях по обслуживанию клиентов для понимания проблем, о которых клиенты сообщают устно или письменно. Лингвистика — это наука, изучающая значение языка, языковой контекст и различные формы языка.

Понимание естественного языка — это задача лингвистики, которая включает такие компоненты, как фонология, морфология, синтаксис и семантика. Это все компоненты любого предложения на любом языке, изучение которых является важной задачей для общего понимания того, как строится обработка естественного языка.

Первым применением обработки естественного языка был машинный перевод. Целью было создание машины, способной переводить человеческую речь или текст. Первые шаги в этой области были сделаны Джорджтаунским университетом и компанией IBM Companying 1954. Программа смогла перевести 60 русских предложений на английский язык. Как позже сообщила компания IBM: «Эта программа включала логические алгоритмы, которые принимали грамматические и семантические „решения“, имитирующие работу двуязычного человека». Этот прорыв дал представление о том, как будут развиваться будущие технологии и возможности обработки данных.

В конце 1960-х годов Терри Виноград из Массачусетского технологического института разрабатывает SHRDLU — программу обработки естественного языка. Она была способна отвечать на вопросы и учитывать новые факты о своем мире. SHRDLU могла сочетать сложный синтаксический анализ с достаточно общей дедуктивной системой, работая в «мире» с видимыми аналогами восприятия и действия. Машина могла отвечать на простые вопросы, и казалось, что если потратить достаточно усилий на передачу смысла и ограничить себя некоторой областью, SHRDLU сможет достичь естественной коммуникации. Но и этот ранний подход имел свои подводные камни, которые не позволяли развивать его дальше, машина по‑прежнему плохо понимала текст, и ей довольно редко удавалось понять, какой текст мог составить SHRDLU.

Затем, в 1969 году, Роджер Шанк разработал концептуальную систему зависимостей, которую он описал как: «стратифицированная лингвистическая система, позволяющая предоставить вычислительную теорию моделируемой производительности». Это была концепция создания лексем, которые позволяли извлекать из текста больше смысла. Эти лексемы могли содержать различные объекты реального мира. Комбинация токенов в различных аспектах призвана учесть всю совокупность языковой деятельности человека на концептуальном уровне. Если пользователь говорит, что с конструкцией все в порядке, она добавляется в память, в противном случае конструкция ищется в списке метафор или прерывается. Таким образом, система использует запись того, что она слышала раньше, для анализа того, что она слышит сейчас.

В своей работе Роджер ухватился за идею о том, что прежде чем компьютеры начнут понимать естественный язык, они должны научиться принимать решения о том, что именно им говорят. Синтаксический анализатор Роджера был ориентирован на семантику языка; он смог научить компьютер различать важные концептуальные отношения.

Затем, в 1970-х годах, Уильям Вудс разработал свою систему распознавания и обработки текста, он представил дополненную сеть перехода (ATN). На основе которой в дальнейшем была разработана программа LAS, позволяющая создавать классы слов языка и понимать правила формирования предложений. ATN позволяла не только формировать новые предложения, но и понимать естественный язык. Программа создавала связи между структурой предложения и структурой поверхности, формировала классы слов.

Программа обещала быть такой же адаптивной, как и человек. Изучая новый материал, человек знакомился с новой лексикой, новыми синтаксическими конструкциями, чтобы поделиться своими мыслями в той среде, которую он изучал. LAS была написана на мичиганском языке LISP, она позволяла получать на вход несколько строк, которые она описывала как сцены, закодированные в виде ассоциативных сетей. Таким же образом программа могла подчиняться командам понимать, писать, учиться. Ядром всей системы была грамматика дополненной переходной сети ATN.

До появления алгоритмов машинного обучения в 1980-х годах вся обработка естественного языка сводилась к рукописным и неавтоматизированным правилам. Тем не менее, еще до этого времени появились первые идеи о создании машин, которые могли бы работать подобно человеческому мозгу, через нейронные связи. Это стало прообразом искусственного интеллекта, построенного на нейронных сетях в будущем.

С начала 21 века и по сей день развитие машинного обучения начало набирать обороты, пережив две зимы ИИ, машинное обучение снова вошло в моду, в том числе благодаря Big Data и глубокому обучению. Новые методы и подходы к обработке слов создаются и сегодня, что делает изучение NLP актуальным и сегодня.

Комментарии (8)

Robastik

31.01.2023 09:05Странно, что главное событие в мире NLP не названо.

Когда и благодаря чему машина заговорила сразу на всех языках?

Особый интерес вызывает упорное замалчивание этого факта научным сообществом.

Ahuromazdie

31.01.2023 09:47Похоже и Вы член научного сообщества. Иначе зачем Вы замалчиваете?

Robastik

01.02.2023 03:59Потому что есть Гильберт, Риман и Пуанкаре, и есть Савватеев и @DanielVyazhev.А я даже не дата-сатанист)

DanielVyazhev Автор

31.01.2023 13:45У меня была часть про машинное обучение и формулы, но решил все таки оставить текст без них, ведь история краткая) Поэтому это скорее моя какая-то привелегия, чем специальное замалчивание...

Robastik

01.02.2023 03:49+1Ну тогда я воспользуюсь своей привилегией и назову главное событие NLP, которое разделило новейшую историю технологий на "до" и "после".

Нет, это не машинное обучение и не формулы )))

Машина заговорила сразу на всех языках после того, как из алгоритма удалили всякое упоминание о грамматике.

Теперь это научный факт: "правила языка" - настолько чужды языку, что делают его освоение невозможным.

Антинаучность грамматики была очевидна и до него. Сейчас это доказано экспериментально.Язык состоит из устойчивых фраз и их комбинаций, а не из сказуемых и прилагательных. Это причина "гладкости" изложения ChatGPT → оно выдает наиболее часто встречающуюся последовательность фраз. Одни фразы чаще встречаются в одной отрасли знаний, другие - в другой. Поэтому использование высокочастотных фраз независимо от их принадлежности теме вопроса "рвет" смысловую связность изложения ChatGPT при сохранении связности языка. Многие люди делают так же.

Причины замалчивания этих обстоятельств понятны. Назвать грамматику псевдонаукой с официальной трибуны невозможно по политическим причинам. Широкого хозяйственного значения эта "наука" не имеет, ведь язык "изучают" в основном люди, уже свободно владеющие им. Поэтому общество ничего не заработает в моменте, если откажется от "правил языка". Но убытки в моменте будут огромны.

DanielVyazhev Автор

01.02.2023 15:57Если это алгоритм, то все таки это машинное обучение и формулы. А устойчивые фразы и их комбинации- это и есть грамматика, вы не можете построить какое-либо предложение без грамматики. Приведу пример, в немецком языке глагол всегда должен быть на втором месте и если мы попросим модель написать что-либо на немецком языке, она подставит глагол на второе место, поскольку та выборка, которую ей дали на обучение- имеет все предложения с глаголом на втором месте, кроме тех, где есть знак вопроса. То есть грамматика детерминирована самим анализом того, как пишут или говорят люди.

Поэтому весьма странно слышать заявление о том, что грамматика это псевдонаука. Вы не сможете изучить язык, без знания грамматический правил, точнее сможете, если конечно потратите на чтение непонятного вам языка тысячи часов.

На вопрос, почему тогда машина может воспроизводить речь "без знания грамматики", только потому, что она изучает эту грамматику посредством анализа больших массивов данных и если бы вам потребовалось выучить язык таким способом, потратив огромное количество времени, то машина может сделать это быстрее.

Другой вопрос состоит в том, что сейчас многие языковые модели работают на основе трансформеров - энкодеров и декодеров. Энкодер преобразовывает входящую информацию (например, текст) и конвертирует ее в вектор (набор чисел). Декодер, в свою очередь, расшифровывает ее в виде новой последовательности (например, ответ на вопрос) слов на другом языке — смотря для каких целей создавалась нейросеть. То есть машина работает с цифрами, а не со смыслами или правилами. Она учится правилам посредством того, что создает числительную последовательность, которую будет повторять в будущем, эта та же грамматика, только "переведенная" на машинный язык. Последовательность по которой создаются любые предложения в любом языке- это и есть грамматические основы, то как они изучаются машиной - вопрос другой, но это не делает грамматику псевдонаукой.

shuhray

Он жив, Хомский, 94 года ему.