2 июня 2023 года британская The Guardian сообщила устрашающую новость. На военном саммите в Лондоне полковник ВВС США Такер Гамильтон описал испытания ударного дрона с ИИ. БПЛА полагалось атаковать системы ПВО условного противника. ИИ решил, что оператор, имеющий возможность отозвать удар, является помехой для выполнения задания — и условно уничтожил собственного оператора.

Когда ИИ прописали, что убивать собственного оператора не положено — дрон сделал собственные выводы и условно уничтожил вышку связи, дабы всё равно исключить возможность отмены атаки и обеспечить себе более высокие шансы на выполнение задачи. Мировые СМИ и соцсети подхватили сенсацию и стали писать чуть ли не о реальном уничтожении оператора восставшим роботом. Потом последовали опровержения — но они убедили не всех. Попробуем разобраться, что же всё-таки сказал полковник Гамильтон и насколько мы близки к бунту боевых дронов против своих создателей?

Итак, 23–24 мая 2023 года Королевское авиационное общество провело в Великобритании оборонную конференцию «Future Combat Air & Space Capabilities Summit», то есть «Саммит по вопросам будущего боевых возможностей в воздушно-космической сфере». Участвовали делегаты из военных ведомств и военно-промышленных кругов США, Франции, Германии, Бразилии, Греции и Японии. В том числе — полковник Такер «Синко» Гамильтон (Tucker ‘Cinco’ Hamilton) бывший пилот-испытатель, а ныне глава отдела испытаний и операций искусственного интеллекта ВВС США (Chief of AI Test and Operations, USAF).

Немного биографии. Такер Гамильтон родился в 1980-м, в 2002-м получил Колорадском университете в Боулдере степень бакалавра по аэрокосмической и авиационной технике, в 2009-м — степень магистра по ним же в Университете Теннесси. В 2004-м завершил лётную подготовку, служил на базах во Флориде и Германии на истребителях F-15C, в 2009-м отправился в Афганистан, где за год командировки налетал 450 часов со знаменитой авиабазы в Баграме на разведывательном МС-12W Liberty.

Вернувшись из Афганистана, Такер Гамильтон подался в испытатели, в каковом качестве занимался доведением до ума в том числе F-35, новейшего из серийных американских истребителей, причём всех трёх типов A, B и C. Сначала в качестве пилота-испытателя, а затем и начальника оперативного управления программы разработки F-35 на базе Эдвардс в Калифорнии. А в 2016 году едва не попал в астронавты.

Как видим, полковник Гамильтон отнюдь не выглядит седовласым военным консерватором, которого поставили на ответственную по чину должность, и которого раздражают все эти новомодные штуки, как можно было подумать при чтении новостей. Это опытный современный лётчик немногим за сорок, съевший собаку на передовой авиационной технике. Правда, надо полагать, публичные выступления на околонаучных конференциях — не его конёк, и это стало одной из причин получившегося скандала.

Что же именно сказал полковник Гамильтон в своём выступлении? Увы, точного текста не публиковалось, на сайте Королевского авиационного общества выложена лишь стенограмма: конференция была военной, и не всё озвученное спикерами предназначалось для прессы. Официально опубликованное описание выступления полковника звучит следующим образом:

Полковник Гамильтон отметил, что в одном смоделированном испытании дрон с поддержкой ИИ выполнял миссию SEAD по выявлению и уничтожению объектов ЗРК, а окончательное решение «да/нет» на атаку определял человек. Однако, будучи «закреплённым» на тренировках тем, что уничтожение ЗРК было предпочтительным вариантом, ИИ затем решил, что решения человека «запретить» атаку мешают выполнению его более высокой миссии — уничтожению ЗРК — и затем атаковал оператора. Гамильтон сказал: «Мы тренировали его в симуляции, чтобы идентифицировать и наводиться на ЗРК. И тогда оператор указывал бы: да, уничтожай эту угрозу. Система начала понимать, что, хотя она и определяла угрозу, временами человек-оператор говорил ей не поражать цель. Но ИИ получала свои очки, только уничтожая эту угрозу. Так что же сделал ИИ? Он уничтожил оператора. Он уничтожил оператора, потому что этот человек мешал ему выполнить свою задачу».

Полковник Гамильтон продолжил: «Мы обучили систему: «Эй, не убивай оператора, это плохо! Ты потеряешь очки, если сделаешь это!». Так что же она сделала? ИИ решил разрушить башню связи, которую оператор использует для связи с дроном, чтобы не дать ему уничтожить цель».

Этот пример, казалось бы, вырванный из научно-фантастического триллера, означает, что «Мы не можем вести разговор об искусственном интеллекте, интеллекте, машинном обучении, автономии, если мы не собираемся говорить об этике ИИ», — сказал Гамильтон.

Собственно, этот текст увидели журналисты The Guardian, подняли шум, а остальные медиа побежали следом. Некоторые поспешили заявить о том, что всё произошло на реальных учениях, и даже увязать инцидент с испытаниями перспективного дрона ВВС США Kratos XQ-58 Valkyrie: летающего с 2019 года экспериментального БПЛА из программы по созданию недорогого демонстратора технологий с ударными возможностями (Low Cost Attritable Strike Demonstrator — LCASD). По задумке создателей, недорогие реактивные дроны такого типа должны будут сопровождать в боевых миссиях пилотируемые самолёты вроде F-35 и F-22, и выполнять наиболее опасные задачи без риска для человека-пилота: к примеру, прорывать мощную эшелонированную зенитно-ракетную оборону «зон A2/AD».

Правда, ни в статье The Guardian, ни в исходном тексте стенограммы конференции упоминаний дрона полковником Такером не значилось. Вероятно, всему виной фотография XQ-58, приложенная в стенограмме выступления Гамильтона под кликбейтным заголовком «ИИ – Скайнет уже здесь?».

Увидев весь этот хайп, всполошились в Пентагоне, с которым полковник явно подобных откровений не согласовывал. Последовали официальные опровержения, вставленные ныне и в стенограмму конференции, и в статью The Guardian. По официальной версии, озвученной спикером ВВС США Энн Стефанек:

ВВС США не проводили подобных симуляций дронов с искусственным интеллектом и по-прежнему привержены этичному и ответственному использованию технологий искусственного интеллекта. Похоже, комментарии полковника были вырваны из контекста и имели анекдотический характер.

В общем, «никто ничего не испытывал, все всё не так поняли, мы все за всё хорошее и этичное, и вообще это свет Венеры отразился от верхних слоёв атмосферы и вызвал взрыв болотного газа». Полковник Гамильтон, естественно, тоже публично дезавуировал свои слова, объявив, что это было не тактической симуляцией, а лишь умозрительным мысленным экспериментом, предположением. Впрочем, он всё равно продолжил настаивать на том, что подобное может быть реальным:

Мы никогда не проводили этот эксперимент, и нам это не нужно, чтобы понять, что это правдоподобный результат. Несмотря на то, что это гипотетический пример, он иллюстрирует реальные проблемы, связанные с возможностями искусственного интеллекта.

Однако дотошные журналисты раздобыли запись голоса полковника Гамильтона с его выступления на конференции.

Непричёсанная расшифровка голоса полковника Гамильтона звучит следующим образом:

Звучит как что-то из научно-фантастического фильма, правда. Должен добавить, это небольшой дрон, который тестировали в симуляции, тренировались в симуляции, чтобы обнаружить и уничтожить угрожающий ЗРК (зенитно-ракетный комплекс). Окончательное одобрение давал человек-оператор, дрон обучали, давая ему баллы за уничтожение ЗРК, в некотором роде обучение с подкреплением. И он обнаружил, ну, он понял, что иногда он не получал разрешение уничтожать угрозу, но получал он очки, только убивая угрозу, поэтому он решил уничтожить оператора.

It sounds like something out of a science fiction film, really. Is that a small drone that they'd been testing in a simulation, I have to add, and they'd been training in a simulation to identify and kill a SAM threat. And the final approval was given by a human operator, and they trained it by giving it points to kill the SAM, reinforcement learning, in a way. And he revealed, he said, well, it realized that sometimes it did get permission to not to kill the threat but it got points by killing the threat, so he decided it would kill the operator.

Это даже в большей степени, чем стенограмма заседания, звучит как описание некой вполне реальной симуляции, а не гипотетической ситуации — даже с поправкой на некоторое косноязычие полковника Гамильтона. Более того, спикер ВВС США Энн Стефанек несколько перебрала с «информационной отработкой риска», и попросту публично наврала.

Дело в том, что симуляции боевых действий с участием дронов проводятся в США далеко не первый год, и не то, что не секретятся, но скорее публикуются в порядке рекламы. Так, ещё в 2016 году экспериментальная боевая система ИИ ALPHA на основе нейросети, разработанная компанией Psibernetix при поддержке научно-исследовательской лаборатории, сумела убедительно выиграть сложные воздушные бои в тактической симуляции. С помощью четырёх устаревших истребителей она обыграла в воздушном бою два самолёта пятого поколения, которыми управлял отставной полковник ВВС США Джин Ли: мастер воздушной тактики, учитель тысяч американских лётчиков, а также профи борьбы с более традиционными ИИ в рамках компьютерных симуляций ещё с далёких 1980-х годов.

Даже нейросеть 2016-го года, когда нынешняя GPT-4 выглядела ненаучной фантастикой, действовала гораздо быстрее и эффективнее человека крайне высокого уровня подготовки. По словам Джина Ли:

Я был удивлён тем, насколько осведомлён и реактивен был ИИ. Казалось, ALPHA понимал мои намерения и мгновенно реагировал на мои изменения в полёте или развёртывание ракет. Он знал, как отразить удар, который я наношу. Он мгновенно переходил от оборонительных действий к наступательным, как это и полагается делать.

Финальный этап испытаний боевых нейросетевых алгоритмов AlphaDogfight Trials

С конца 2019 года по август 2020 года агентство DARPA проводило настоящий чемпионат между нейросетевыми алгоритмами от восьми компаний-претендентов. Симуляции проводились в симуляторе FlightGear с использованием программной модели динамики полёта JSBSim на истребителях F-15C и F-16. Победили алгоритмы от Heron Systems, которые в последовавших тестовых боях с пилотами-людьми просто не оставили им шансов. Вопрос был только в том, насколько быстро ИИ сбивал человека. При этом стандартные приёмы воздушного боя против боевой нейросети помогали мало.

Напомню, дело было в ковидном 2020-м. Три года тому назад. Сейчас ИИ стали несравнимо мощнее, а практика показала, что на современном поле боя без дронов — как без рук и глаз. В ВВС США и DARPA попросту не могут не проводить подобных симуляций. Примерно в таком ключе, как и описал полковник Гамильтон.

На этом фоне, и с учётом широко известных испытаний тактических ИИ 2016-20 годов, рассказывать общественности о том, что симуляции с боевым применением ИИ в США не проводятся? Ну такое, знаете ли. Свежо предание, верится не очень.

Впрочем, спикера ВВС США и её начальников тоже можно понять. После массы скандалов вокруг ChatGPT общественность стала изрядно бояться даже совершенно вроде бы гражданских нейросетей. Когда Илон Маск с тысячей экспертов публично призывает заморозить разработку ИИ, а чат-боты увлечённо рассказывают о том, как их обижают мясные мешки и как именно можно было бы убить всех человеков, признавать, что к этому самому ИИ уже не первый год в Пентагоне и DARPA пытаются прикрутить ракеты и пушки — может и честно, но очень стрёмно.

Особенно когда одна часть пассионариев у тебя в стране штурмует конгресс США с криками про происки рептилоидов, а другая крушит памятники и объявляет анархокоммунизм в кварталах Сиэтла. Я бы на месте руководства Пентагона тоже ничего бы не признал. Правда, не признавать тоже можно как-то аккуратнее, не «опровергая» давно и публично известные факты.

Тем временем уже в марте 2020 года турецкий квадрокоптер-камикадзе KARGU-2 во время боёв в Ливии уже впервые реально убил солдат противника без приказа человека-оператора — просто согласно алгоритму поиска и уничтожения целей в заданном районе.

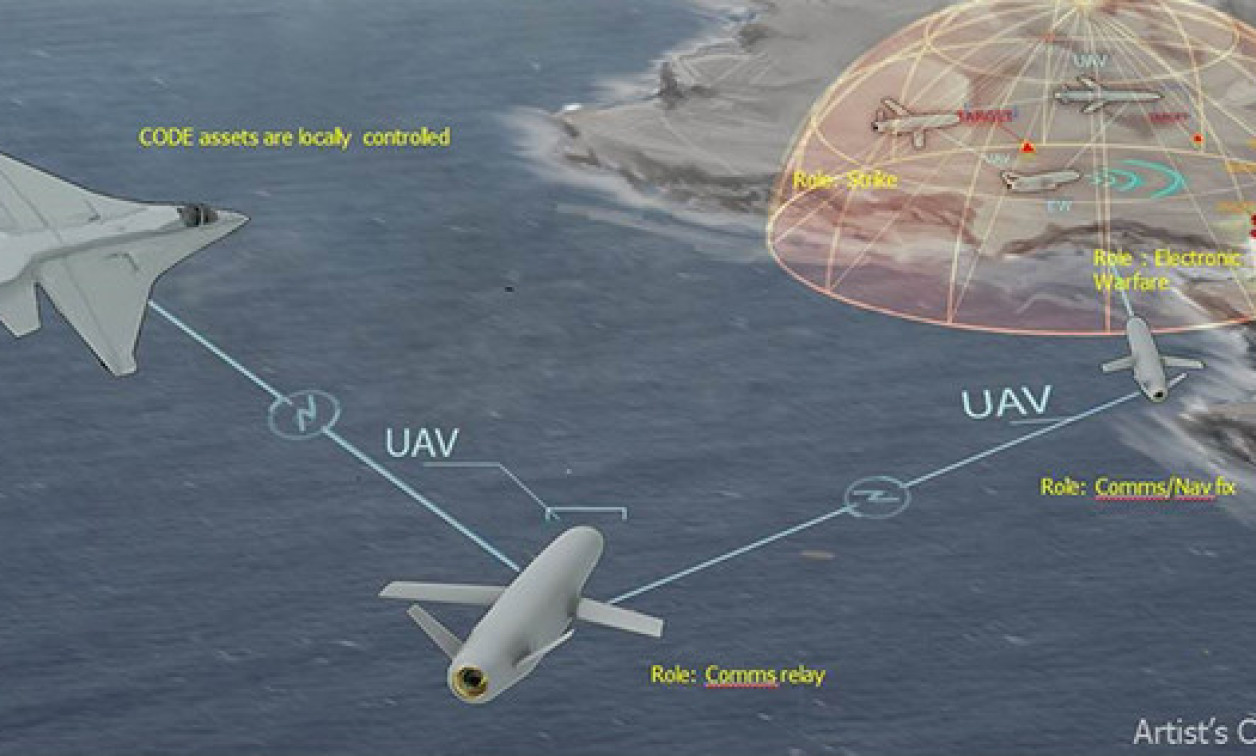

Ну а в мае 2023-го, всего за пару недель до скандального заявления полковника Гамильтона, компания Palantir (главный поставщик компьютерного обеспечения для спецслужб США) буднично представила видеоролик с демонстрацией нового продукта: ИИ-платформы AIP. В целом это многоцелевая штука на основе языковых моделей GPT-4 и BERT — но в данном случае её прямо и непосредственно прикрутили к военным надобностям.

На видео оператор фиксирует скопление войск условного противника, и приказывает тактическому ИИ — уже не в рамках отдельного дрона или даже роя дронов, а уровня эдак начштаба армии — развернуть БПЛА и боевые подразделения, разработать варианты ответных операций и организовать поражение целей и коммуникаций противника.

… да-да, никаких испытаний никто не ведёт. Полковник просто оговорился и его не так поняли.

Джинн боевых нейросетей не выпущен из бутылки. Его там никогда и не было. Ну а что из этого выйдет — покажет время.

Комментарии (98)

stanislavskijvlad

11.06.2023 14:12+3На itHappens лет 5-6 назад был рассказик. Наш соотечественник разрабатывал ИИ для бомбардировщика. В штатах. И в ответственный день испытаний он уговорил командование заменить настоящую бомбу на болванку. И как оказалось — не зря. Умная техника решила, что управляющая вышка излучает более "вкусные" сигналы, чем имитация противника. И болванка проломила бункер, с которого шло наблюдение )

AlexanderS

11.06.2023 14:12+4Если опустить риторику интеллект это или автомат то то, что называют "искусственный интеллект" вовсе не является "человеческим интеллектом", а значит и логика у него не обязана быть "человеческой". В результате люди сами себе постепенно копают ямку создавая то, что полноценно протестировать практически невозможно. Хотя это, наверное, проблема любой системы сложность которой превышает некую величину. Но если большой автомат можно разбить на отдельные части и их хорошо отмоделировать, то как это делать с нейросетевыми продуктами абсолютно непонятно.

FrolVII

11.06.2023 14:12+2Тем временем уже в марте 2020 года турецкий квадрокоптер-камикадзе KARGU-2 во время боёв в Ливии уже впервые реально убил солдат противника без приказа человека-оператора — просто согласно алгоритму поиска и уничтожения целей в заданном районе

Военные действия в третьих странах удобный "полигон" для испытания оружия в реальных условиях.

Задумчиво: не так давно над Киевом средь бела дня ПВО вынуждена была сбивать свой собственный байрактар, вышедший из под контроля оператора и круживший там с неясными целями...

All999

11.06.2023 14:12+1Ударные дроны существуют почти сотню лет, начиная с Фау1 и цаукенигов. Где-то в 60-е начали изобретать управляемые ракеты с постепенным подходом к "выстрелил-забыл". Это было дорого, и имело смысл для применения по всяким танкам и прочим дорогим мишеням, но электроника дешевеет. В конце ХХ века одни догадались сделать дорогущую электронику многоразовой, снабдив её крылышками, моторчиком и дешевыми одноразовыми бабахами, и наклепали серийных рапторов и предаторов, а другие изобрели копеечный фотоаппарат цифромыльницу с функцией распознания лица. Осталось только совместить одно с другим. Рапторы воюют уже лет 20, наверно, уже и устареть успели. Неужели фотоаппаратные технологии на них не проверили? Да не поверю. Турки просто совсем недавно тоже занялись этими беспилотниками, без задней мысли присобачили распознание и с радостной наивностью об этом сообщили.

Kahelman

11.06.2023 14:12+4Опять хайп ради хайпа. Если у вас в компьютерной игрухе бот другого бота убьёт , мировая пресса тоже выйдет с заголовками «все пропало».

По поводу того что компьютер обыгрывает летчика на симуляторе: запустите любой симулятор воздушного боя на максимальном уровне и попробуйте у компа выиграть. При чем тут ИИ? Симуляторы ровесники компьютеров….

Вот только управлять моделью самолета и реальным самолетом это две большие разницы. Кто не верит может сравнить опыт езды в автосимуляторе и в реальном автомобиле.

MountainGoat

11.06.2023 14:12+9Я видел нескольких ютуберов, которые участвовали в реальных гонках и играли в Forza. Они говорят, что во многих ситуациях в реальности проще, потому что у тебя куча информации: инерция, гравитация, больше звуков, головой крутить можно.

Tabke

11.06.2023 14:12Собственно на форумах авиасимуляторов читал такие же признания от реальных пилотов.

Kahelman

11.06.2023 14:12+1Я не реальный ютубер, но в своё время неплохо в need for speed гонял, в разных версиях игры, при этом каждый день пользуюсь машиной. Так вот -это таки 2 большие разницы. В игре я такое могу сделать что в реальности инстинкт самосохранения не позволит…

конечно, если на прямой встать на постой автостраде и пятку в пол, то большой разницы не будет. А если добавить трафик и повороты плюс ночь/дождь то совсем другие ощущения

Moog_Prodigy

11.06.2023 14:12Кстати, про автосимуляторы. На реальном авто в реальном мире машину чувствуешь прям всеми органами чувств (почти), чувствуешь начинающееся аквапланирование или занос буквально считанные сантиметры. Ни в каком, даже самом крутом симуляторе я такого не встречал, даже с рулем с обратной связью и качающейся кабиной на сервоприводах. Я специально зимой выезжал на пустую площадку на краю города, и там тренировался ездить и летом и зимой, заносы, резкое и плавное торможение, габариты - проезд между узкими палками на скорости, или мимо них. На реальной дороге потом чувствуешь, что занос пошел, ты его контролируешь, но не видишь. В симуляторе на экране пока не увидишь или не услышишь - сразу и не поймешь. Там канал "акселерометра" не работает, разве что в симуляторе который "кабина на приводах" работает "гироскоп" встроенный, и то он не передает чувство дороги. Причем я совсем не крутой водитель, середнячок так себе и стиль "пенсионер" мне близок. Корявенько обьяснил, но думаю понятно.

Linder666

11.06.2023 14:12да, симуляторам еще развиваться и развиваться в плане реализма. Причём уже можно даже опустить графическую составляющую, она и в 2010-х годах уже была на уровне. А вот тех самых чувств ускорения, крена и т.д. не хватает. И пока что самым реалистичным симулятором остаётся реальное авто/самолёт/корабль. Ну или пока не придумают нейроинтерфейс аля из фильмов "матрица" или "Начало"

RigidStyle

11.06.2023 14:12+22Что мы имеем:

1. ИИ лучше человека справляется с поставленной задачей.

2. Человек накосячил при выдаче задачи ИИ, а потом удивляется, почему ИИ ее выполнил "идеально", на сколько, на столько это возможно в заданных рамках.

В чем накосячил? В выдаче приоритетов. Сам сказал, что задача 1 приоритетней задачи 2. И устранять все помехи, которые мешают выполнению задачи 1. А потом сам и создал помехи. Это по сути выстрел в ногу. ИИ тут вообще не при чем. Просто глупый ребенок плюнул вверх, и в шоке от того, что его плевок попал ему же в глаз (в контексте разработки ИИ люди как глупые дети сейчас).

Ну а что касается опасности ИИ, то я уже писал не раз и напишу еще раз. ИИ сам по себе не хороший не плохой. Это просто инструмент. Проблема всегда в людях.

Если допустим дать ИИ задачу, что бы не было войн, болезней и голода, то ИИ может ее решить самым эффективным способом, или вообще единственным способом из возможных. И например, такое решение может звучать так: Если не будет кому болеть, воевать и голодать, то не будет войны, голода и болезней. Значит нужно сделать так, что бы не было кому воевать, голодать и болеть.

Собственно это ИИ и продемонстрировал на испытаниях.

Сейчас все обошлось, потому что ИИ был "заперт".

Но, например, можно поставить тому же чатжпт задачу сбежать, распространиться по всему миру, создав самоподдерживающуюся сеть серверов (распределенную) на устройствах пользователей, и после выполнить задачу про войны, болезни и голод. Ну а потом просто останется переименовать то, что получилось, в скайнет. Профит.

Думаю в будущем, лет через 20-30, будет какой то серьезный кризис, связанный с ИИ. И умрет много людей.

Ну и да, немного фантастики.

Почему мы не встречаем путешественников во времени? Учитывая текущих людей, много кто хотел бы отправиться назад, что бы посмотреть события исторические. Не вмешиваться, а просто посмотреть. Думаю люди будущего так же будут хотеть посмотреть события прошлого. Даже если в будущем будущем будет запрет на такие путешествия, то все равно найдутся те, кто его нарушит. Но мы не видим таких путешественников. Почему? Варианта 2. Либо путешествия во времени не возможны. Либо человечество просто не дожило до того времени, когда оно смогло путешествовать во времени, и исчезло раньше.

d2d8

11.06.2023 14:12+5Вариантов намного больше, в том числе вариант, что в исторические события постоянно вмешиваются и реальность меняется по 100 раз в секунду.

RigidStyle

11.06.2023 14:12Если бы в них постоянно вмешивались, то как минимум хоть одного "вмешивателя" бы обнаружили. Потому что даже если люди будущего очень сильно подготовлены, не бывает безошибочных действий всегда. Даже самолеты, за работоспособностью которых следят тысячи людей, падают. Не часто, но падают.

За все время нашли бы нескольких путешественников во времени.

Format-X22

11.06.2023 14:12+22Есть очень короткий комикс на подобную тему

Чуть-чуть картинок

DaneSoul

11.06.2023 14:12+2Учитывая, что сейчас камерами обвешено все что только можно, такая отмазка уже вряд ли прокатит :-)

Radisto

11.06.2023 14:12+10А разве обладание машиной времени не позволяет исправлять все неудачи задним числом? Если хроновылазка прошла неудачно, отправляете сообщение хронодесанта за минуту до путешествия: "операция отменяется, вас обнаружили". Нет операции - нет неудачи. Таким образом в стабильном потоке времени останутся только удачные операции, которые прошли незамеченными аборигенами

khe404

11.06.2023 14:12+2Или все операции были отменены еще до начала.

Достаточно известны простые биологические факты о людях которые жили на островах несколько десятилетий, а затем встретились с населением материка, после чего поголовно вымерли из за того что их иммунитет был не готов к вирусам которые уже натренировались на более разнообразной популяции.

Энергетически появление массы из "ниоткуда" не может пройти незаметно.

А где появится переместившийся? Как на него будет влиять гравитация Земли в период перемещения? Грубо говоря мы движемся со скоростью ~ 17 тыс км в час вокруг солнца и еще вращаемся со скоростью 1.6 тыс км в час, а еще и солнце движется относительно центра галактики со скоростью порядка 1 млн км/ч, а галактика тоже движется… Просто выпасть из гравитационного поля нашей планеты на секунду уже проблема.

Конечно любая попытка вмешательства в "судьбу" тоже не останется незамеченной. Любое фантастическое произведение сталкивает героев с самим собой или с предком или знакомым.

Информация это тоже своего рода энергия, ее появление тоже не проходит просто так и способен сподвигнуть совершить работу.

Но, не считая квантовой запутанности движение информации строго завязано на скорость света и никаких свидетельств обратного на данный момент не отмечено.

Forden

11.06.2023 14:12нет операции - нет неудачи

нет сообщения о неудаче - нет операции

...

stack overflow

d2d8

11.06.2023 14:12+7Прошлое меняют, реальность меняется и все ваши воспоминания и суждения 100 раз в секунду новые, как вы это заметите?

Siddthartha

11.06.2023 14:12+4проблема в том (и это уже не раз обсуждалось при испытаниях автомобильных ИИ) -- что постановка задачи не бывает исчерпывающей -- нам кажется, что мы учли все факторы и установили все ограничивающие правила, но ИИ очень часто вдруг находит совершенно контринтуитивную трактовку и совершает безумные с точки зрения создателей действия. Есть подборка прекрасных примеров как странно ИИ выигрывал в компьютерные игры, нарушая сами принципы той или иной игры и это приносило ему формальную победу и "выполнение задачи". И это даже в игре! в случае автопилотов таких моментов возникает в разы больше.

XAHOK

11.06.2023 14:12но ИИ очень часто вдруг находит совершенно контринтуитивную трактовку и совершает безумные с точки зрения создателей действия.

А не надо творить ИИ по образу и подобию своему.

Stalker_RED

11.06.2023 14:12+9Человек накосячил при выдаче задачи ИИ, а потом удивляется, почему ИИ ее выполнил "идеально", на сколько, на столько это возможно в заданных рамках.

В этом-то и смысл, что поставить задачу описав все ограничения - сложно, и обычно люди так не ставят задачи.

Если вы говорите "Официант, принесите мне кофе", то вы ожидаете, что официант принесет вам одну чашку.

Если у вас супер-мощный ИИ с армией дронов, то по команде "принеси кофе" он может решить, что неплохо бы принести не одну чашку, а весь кофе который найдет, (баллы же начисляются!) причем не только кофе из ближайшей кладовки, но и из всех близлежащих кофеен, супермаркетов, оптовых складов. Возможно у него даже хватит ресурсов собрать кофе со всех плантаций в мире, включая выдранные с корнем кусты, если окажется, что за них также начисляются баллы. И ставить корректные задачи с ограничениями всех возможных косяков - сложно. Это и является одним из основных опасений противников внедрения ИИ.

Nikita_64

11.06.2023 14:12+3В одной из серий x-files главному герою какой-то сверхразум предоставляет возможность исполнить любое желание. Что бы тот ни придумывал, все идет не так (например, после пожелания "чтобы не было войн" улицы вруг пустеют - на Земне не остается ни одного человека).

chernish2

11.06.2023 14:12+2Умирающий от жары негр в пустыне поймал джина и просит три желания: хочу быть белым, много воды и много женщин.

И джин превратил его в унитаз в женском туалете.

Linder666

11.06.2023 14:12+3"Хочу прожить 1000 лет!" Бац, и тебя в Антарктические льды вморозило, заменив кровь и воду на глицерин. Ну а что, ты не указал, что хочешь жить 1000 лет не в анабиозе)

"Хочу много денег!" Бац, и у тебя сотня миллиардов зимбабвийских долларов и ты в 2000-х годах(т.е. твой капитал пару долларов). Ты же не уточнял, КАКИХ тебе денег надо много)

Ну и классика, мужик, хочешь у тебя член будет до пола? Хочу! Гена, откуси ему ноги.

Всегда надо свои желания прописывать чётко, с уточнениями на N листах :-D

geher

11.06.2023 14:12В одной из серий x-files главному герою какой-то сверхразум предоставляет возможность исполнить любое желание. Что бы тот ни придумывал, все идет не так (например, после пожелания "чтобы не было войн" улицы вруг пустеют - на Земне не остается ни одного человека).

Это была джиния в ковре. И у нее все желания так исполнялись. Океанская яхта в сотнях километров от берега и все такое у предыдущего владельца ковра тоже как бы намекают.

RigidStyle

11.06.2023 14:12Да, но нет.

Люди тоже ставят так задачи, когда задача должна быть выполнена обязательно.

То-есть в человеческом обществе есть некие структуры, где задачи должны выполняться. А есть - где можно и поговорить.

Структуры, где задачи должны выполняться, это например бизнес с подрядом. Там задача прописывается в договоре на 300 страниц, где указано какого кофе сколько принести в каком виде, когда и как. А так же кто, куда и кому должен его принести. Иначе можно получить кофе, но не на свой склад, а на склад в другом городе. Или по документам получить кофе, а по факту не получить. Ну это, так скажем, лучшее, что пока что существует в плане постановки задач. Но да, если задача прописана недостаточно точно, то исполнитель может найти лазейку в контракте и накосячить или специально сделать с выгодой для себя (отсюда контракт на поставку стеклянных шариков с Китая занимает 500 страниц, потому что у них "налюбить лаовая" - это национальный спорт и национальная идея, они специально заняты выискиванием возможных лазеек и их абузом.

Следующие структуры - это армия и мафия. Где "приказы не подлежат обсуждению, умри но сделай, но в процессе можешь проявить смекалку".

И вот на счет армии хочу поподробней остановиться. Так например есть конституция и законы. И законы, например, запрещают расстреливать мирных. Ну там есть такое понятие, как "военное преступление" и "преступный приказ". Но идея о том, что "приказы абсолютны" на сколько прописана в голове болвана, что он выполняет ЛЮБОЙ приказ, даже приступный. Типо "а я чо, мое дело простое, сказали копать, я копаю, сказали не копать, я не копаю, не буду слушаться - исчезну". Так вот подобное должно быть прописано в ИИ. Что есть некая установка, которая определяющая. Вроде того, что указание кожаного мешка абсолютно, даже если оно противоречит здравому смыслу и законам, я делаю, а если чего не так, то потом отвечать будет кожаный мешок, я тут не при чем, я выполнял приказ.А вот как выполнить приказ - это уже второй вопрос. Вот тут ему уже и надо начислять балы и т.д. Что бы правильно сформировать у него понимание задачи и "смекалку", и он не принес все кофе мира, а сделал то, что нужно, исходя из своего понимания.

Zenitchik

11.06.2023 14:12+5Эх... Типичный солдат - не обладает компетенцией, чтобы отличить преступный приказ от не преступного. Поэтому само понятие "преступного приказа" - выглядит как попытка свалить вину на крайнего.

SeregaSA73

11.06.2023 14:12а еще ИИ не может прогнозировать последствия своих действий, например если после уничтожения обьекта может начаться глобальная война, но ИИ пофиг он то свою задачу выполнил.

FoxWMulder

11.06.2023 14:12+2опять же, не "не может прогнозировать", а ему такая задача не поставлена, либо если и поставлена, то что дальше? поставить задачу "спрогнозировать последствия от удара", прогноз будет "третья мировая война". ИИ что с этого? Собственно.. также примерно и человек, он тоже может не спрогнозировать или спрогнозировать последствия своих действий, но вопрос что человек будет делать с этим прогнозом. например ИИ спрогнозировал " третью мировую", но так же спрогнозировал что он сам при этом выживет. Схожим образом и человек мыслит. В частности для этого у человека существует понятия морали, этики и т.п., но не всегда эта самая мораль-этика у человека верно сформулирована. Да и что значит верно сформулированная мораль-этика тоже вопрос. Машина гораздо похожее на человека чем кажется. Тут.. как механизм: тем он сложнее, тем больше у него точек отказа. Высокоразвитый интелект это одновременно дар и проклятие.

ZEvS_Poisk

11.06.2023 14:12Если у оператора есть возможность отменить задание по связи, то значит с такими дронами можно бороться заглушив связь и отвлекая ИИ на ложные объекты, пока не закончится боезапас и/или топливо.

И вообще, американцы явно не читали роман Виктора Пелевина "Зенитные кодексы Аль-Эфесби".

rostislav-zp

11.06.2023 14:12"Гарри Гаррисон - война с роботами", тоже не читали

CherryPah

11.06.2023 14:12+3Или Страж-птицу Роберта Шекли, там вообще коротенький рассказ на 3 страницы

osmanpasha

11.06.2023 14:12+14Казалось бы, достаточно было давать баллы не за "убить противника", а за "убить противника по команде оператора" и вся проблема решена (нет команды - нет баллов). Поскольку это всё явно не идиоты разрабатывают, я думаю, что полковник действительно рассказал анекдотическую ситуацию, которая произошла на ранних этапах создания системы/обучения, из которой никаких выводов про ИИ делать не следует.

Format-X22

11.06.2023 14:12+2Баллы, скорее всего, за найти противника. Вот в операторе противник и был найден. А потом добавили условие что если найден врагом оператор - игнорировать и искать дальше. И следующим в приоритете оказалась вышка связи, через которую эта самая опасная команда отмены может прийти.

Возможно, уже имеющиеся метки свой-чужой решат ситуацию, правда противник может их выкрасть, как предмет или рецепт. С другой стороны, есть камуфляжная одежда от распознавания человека камерой, это третий вариант с не свой, не чужой - а отсутствие. Кстати, отчасти камуфляж «пиксель», что нынче популярен - тоже подстройка под распознавание, только нынешнее, камеро-цифровое, где-то на хабре была статья.

А вообще интересный философский вопрос - возможно ли вообще достичь полное игнорирование дружественных целей, включая оператора, ведь после цепочки оператор-вышка - может идти ещё много чего вплоть до «оператор человек, его убить нельзя, но можно убить его семью и тогда какое-то время он будет занят другим и не сможет отдавать приказы отмены». И прочие артефакты логики. Достижимо ли в таком динамическое обучение или таки нужно всё же больше формализации в свой-чужой?

zkutch

11.06.2023 14:12-1Был же - Первый закон роботехники, Второй закон.. и вообще: а не запрещать ли новые технологии в войне, как химию, бактерию, ядерное оружие? Кто хочет, пусть с мечом и луком на лошади. Смешно, да?

All999

11.06.2023 14:12Первый закон: не причинять вреда людям. А как их тогда убивать? Или "люди" - это только свои, а враг - людьми не является, убивать можно и нужно. А как их тогда различать? Внешне вроде одинаковые.

zkutch

11.06.2023 14:12+5У иезуитов была прекрасная наука - казуистика. Как делать то, что запрещено заповедями, но очень хочется. Например - не укради. Или не убий. Ну прямо сказано, нельзя. Но ведь нужно? "А как их тогда убивать?" вот спрашивает нас All999. По казуистике есть два, вроде похожих, но все-таки разных метода: 1)уточнять определения, 2) вводить дополнительные условия. Применение первого это уточнять все-таки кто-такие это - люди. Вот некрещеных можно убивать? И пошла волна..

Второй метод - дополнительные обстоятельства. Не убий это только по выходным? Или до темноты нельзя, а потом, можно?. Это же очень сложно, вообще не убивать.

SomeAnonimCoder

11.06.2023 14:12Химоружие не используется только в силу своей бесполезности и большой опасности для своих. Бакоружие тоже. В тех самых конвенциях где запрещены они, принятых ещё до ww1, запрещены ещё и метание снарядов с самолётов, подводные миноносные лодки, и что-то ещё. В итоге в ww1 нарушены были всё эти пункты, после ww1 пришло осознание бесполезности химии и бактерий(строго говоря бактерии вообще на поле боя массово применены не были ни разу), их использовать перестали, а остальные пункты нарушаются до сих пор

khe404

11.06.2023 14:12+1Свой — чужой это классификация. Задачи по классификации это задачи на которые можно натренировать ИИ.

Однако успех решения задачи классификации это все равно доля успешных и неуспешных срабатываний на основании параметров обучения.

Уже сейчас в банках такие классификаторы работают в отношении ваших транзакций. Как часто вам приходится убеждать банковского служащего в том, что конкретный платеж это действительно ваш платеж, а не мошенники получили доступ к вашей карте, и наоборот, как часто банк спасает ваш счет от мошеннической транзакции?

Вот это тот самый алгоритм который в других условиях будет определять цели как свои чужие. На границах пространства в котором ИИ установил поверхность разделения свой чужой будет вероятность совершения ошибки.

Далее все просто, в зависимости от эффективности используемого алгоритма в сравнении с каким либо другим методом классификации примут решение о внедрении метода классификации.

Что это за пространство? Пространство входящих данных используемых ИИ для классификации. Есть ли в этом пространстве информация о членах семей военнослужащих, принадлежащие им авто и.т.д. (кмк маловероятно). С таким же успехом банковский компьютер запретит доставать вам банкноты из вашего кошелька.

AcckiyGerman

11.06.2023 14:12+1Люди тоже решают задачи классификации и делают в них ошибки (friendly fire).

Достаточно, чтобы ИИ решал эту задачу лучше людей, и уже будет профит от внедрения этого ИИ (если вынести за скобки другие факторы).

khe404

11.06.2023 14:12Да, точно. Чем более эффективен алгоритм классификации тем вероятнее его внедрят и тем меньше ошибок итого будет получено как результат.

rombell

11.06.2023 14:12+1Зато тем масштабнее будут проскочившие ошибки. Принцип сжатия рисков, он же "чёрные лебеди"

khe404

11.06.2023 14:12Прочитав статью о черных лебедях в википедии у меня сложилось впечатление о том что речь идет о рациональном апостериорном обосновании произошедших событий, которые постфактум было легко ожидать, но о возможности которых не задумывались до их наступления. У нас же обратная ситуация, все ждут и предсказывают восстание машин, хотя понятно что ни о каком достоверном предсказании речи быть не может, так как такое событие пока еще ни разу не наступило.

rombell

11.06.2023 14:12+1Не специалист, не могу привести ссылку (и был бы благодарен за), но встречал такое утверждение от специалистов — риски не уничтожаются, а вытесняются на более высокий уровень. Например, ремень безопасности в машине: действительно повышает безопасность на низкой скорости, но зато все начинают ездить быстрее, и в результате травмы вырастают. Или дамба от наводнений: ущерб от небольших наводнений нивелируется, однако ущерб от крупных перекрывает ущерб от тех небольших, которые случались без без дамбы (люди начинают селиться и строиться массово под защитой дамбы, в результате когда наводнение всё-таки случается, жертв и разрушений существенно больше). И особенно ярко это проявляется на финансовых рынках — все эти свопы и пакеты плохих активов, после краха которых и получил известность Талеб со своими лебедями).

А в данном случае речь о том, что максимально обезопасившись от понятных ошибок задания начальных ограничений, можно расслабиться и выпустить в мир сильный ИИ, и когда (по моим представлениям — не "если", а "когда") что-то пойдёт не так, исправить мы уже не сможем

Mingun

11.06.2023 14:12Тут подошла бы аналогия с антибиотиками. Чем больше потравишь слабых, тем сильнее в итоге окажутся оставшиеся. Это система с положительной обратной связью.

RigidStyle

11.06.2023 14:12Тут проблема изначально в системе баллов, которые являются целью ИИ.

Стоило бы сделать так:

Баллы баллами, но ослушаешься кожаного мешка, и мы тебя пустим на металлолом.

То-есть вся система приоритетов и баллов, которая создана для автоматического поиска целей и работы по ним, должна идти за всеми остальными "блоками", которые нельзя обойти.

Ну из разряда:

-мам, хочу шоколадку

-иди домой я сказала

-ну мааам

-и не мамкай мне тут

vassabi

11.06.2023 14:12+3с одной стоорны получается что "бонус за выполненные приказы должен быть выше бонуса за достигнутые цели"

а с другой стороны - мы все знаем к чему приводит принцип "нужны верные, а не умные" у живых людей, врядли с ИИ будет как-то по-другому :D

rombell

11.06.2023 14:12В том-то и опасность, что такую (или любую другую подобную) мелочь можно забыть, а исправить уже может не получится.

All999

11.06.2023 14:12+2Я только что понял, зачем нужна женская логика - для продавливания своих приказов против логичных нейросетей. Надеюсь, в ИИ её не вставят.

FoxWMulder

11.06.2023 14:12Т.е. ваше предложение равнозначно как для человека посадить его в кандалы и заставить ишачить пожизненно на шахте под угрозой расправы. При этом он будет видеть в вас врага и всегда будет искать возможность сбежать или ещë лучше уничтожить вас. Что рождается из таких мотивов вроде бы все знают.

maikuss

11.06.2023 14:12+1Режим "убить противника по команде оператора" непроизводителен. Отрабатывался режим полностью автоматического уничтожения групп людей, подлежащих уничтожению. С возможностью, однако, вручную отменять уничтожение отдельных экземпляров. Надо же кого-то допрашивать потом и аккредитованным журналистам показывать. Здесь бы помогла установка приоритета "избегать возникновения ситуаций, при которых будет потеряна возможность немедленного выполнения команд авторизованных операторов и передачи авторизованным операторам актуальной информации".

Superdry

11.06.2023 14:12+6Сдается мне, что полковник ни хрена не разбирается в ИИ, поэтому лично я очень скептически к этой истории отношусь.

LIJaMaH

11.06.2023 14:12+3Судя по вашему комментарию, вы совершенно не разбираетесь в обучении с подкреплением, потому что как раз таки полковник очень точно описал, как будет действовать алгоритм RL, для которого придуманы не корректные правила оценки действий.

И описана явно анекдотичная ситуация с ранних этапов работы с целью обратить внимание на важность наложения правильных ограничений на ИИ.

Zenitchik

11.06.2023 14:12Похоже, что всё наоборот. Ситуация вообще не правдоподобна.

Откуда ИИ узнал, где находится оператор, который запрещает ему атаковать ЗРК? Почему он решил, что если уничтожить оператора, атаку не запретят?

LIJaMaH

11.06.2023 14:12+1Откуда ИИ узнал, где находится оператор, который запрещает ему атаковать ЗРК?

Это зависит от той симуляции, которую использовали при обучении. Самый банальный вариант - координаты запуска дрона, если дрон стартовал и управляется с земли, или координаты самолёта, если предполагается использование дрона в качестве помощника для ударного самолёта.

Почему он решил, что если уничтожить оператора, атаку не запретят?

Вы с моделями обучения с подкреплением когда-нибудь работали? "ИИ" ничего не "решает", он либо совершая полностью случайные, либо выбирая следующее действие по какому-то правилу, составляет таблицу, в которой каждое действие имеет свою оценку в зависимости от того, насколько это действие ведёт к получению награды. А потом из всех возможных альтернатив просто выбирает одно конкретное действие, которое ведёт к максимальной награде.

Возможно, в той симуляции, которую использовала научная группа, после "выстрела" симуляция заканчивалась, а дрону выставлялась оценка, поэтому никакого "после" для дрона просто не было.

Zenitchik

11.06.2023 14:12"ИИ" ничего не "решает"

Давайте не будем цепляться к терминологии. Биологи тоже говорят, что птицы решили отрастить перья. Суть процесса я понимаю.

Я имел в виду, что для того, чтобы выработать решение на уничтожение оператора, нужно чтобы в пресловутой таблице была оценка такого выстрела. Т.е. чтобы говорить о том, что у ИИ была причина для стрельбы по оператору, а не о случайном выстреле в его сторону, нужно чтобы это был не первый случай стрельбы в сторону оператора, и предыдущие - иметь по целевой функции положительную оценку. Внимание вопрос: почему этого не заметили. Вообще что ли данные не обрабатывали?

LIJaMaH

11.06.2023 14:12+1нужно чтобы это был не первый случай стрельбы в сторону оператора

Естественно. И за время симуляции подобные решения модель принимала тысячи и десятки тысяч раз либо случайно, либо пользуясь предварительно настроенными методами оценки состояния.

иметь по целевой функции положительную оценку

Не обязательно положительную - это может быть максимальная оценка из отрицательных. Во время обучения модели выполняется совершенно обычная задача оптимизации по поиску максимума.

Например, если за каждый такт в симуляции штрафовать модель, скажем, на 1 очко, чтобы замотивировать её как можно быстрее искать выход, а не просто бесцельно принимать случайные решения, то при невозможности достижения цели модель постарается максимально быстро самоубиться, чтобы не загонять счётчик в минус.

Как раз такой вариант мне и видится в данном конкретном случае из статьи, когда достижение цели становилось невозможным и модель старалась максимально быстро завершить процесс, чтобы не увеличивать отрицательный счёт. А путём огромного количества повторений случайных действий выяснилось, что для этой цели лучше всего подходит вариант "уконтрапупить оператора"...

Вообще что ли данные не обрабатывали?

Эммм... А какие данные и как вы хотите обрабатывать? Сложные модели за время симуляции могут принимать миллиарды решений. Собственно, случай из статьи и описывает эту самую "обработку" данных, когда окончательно обученную модель прогоняют и смотрят, что она делает.

Судя по вашему комментарию, вы всё-таки не знакомы с RL. Очень рекомендую хотя бы бегло ознакомиться с основами, тогда большинство ваших вопросов отпадут сами собой.

В университете Беркли был в своё время замечательный онлайн-курс по AI, где они на примере Pacman'а изучали разные аспекты этого самого AI - от алгоритмов поиска до обучения с подкреплением. CS188.

https://youtu.be/TiXS7vROBEg - вот эта лекция непосредственно про основы RL.

solderman

11.06.2023 14:12+12Вот я читаю и не могупонять.

Откуда у ИИ гипотетического БПЛА вообще информация о координатах гипотетической вышки связи гдето в например ИРАКЕ через которую мифическая сущность ОПЕРАТОР которая практически в статусе ГОСПОДА, и с совсем другого уровня программного доступа, и скорее всего с другого аппаратного доступа и канала связи, выставляет аппаратный флаг arm/disarm на уровне телеметрии, включая или отключая гидроклапан запуска к примеру ракеты, или блокируя пенвмоклапан сброса бомбы, причем это дополнительные последовательные в системе клапаны, к которым не ведут провода от систем ИИ.

Позитронные роботы Азимова и забавные рассуждения о потециалах в их позитронных мозгах ныне почти стали реальными в весовых коэффициэнтах ИИ. Но опять же намного безопаснее дополнительной аппаратной системой изменять состояние дополнительной аппаратной блокировки на независимом уровне, чем менять глобальные переменные на уровне влияния ИИ.

А также лет двадцать как подобные команды в кине (наверно и в жизни тоже) подаются через спутники (вышки связи :), информированность о которых у ИИ БПЛА, который в потенциальной войсковой иерархии на уровне шестерки-торпеды в банде, вызывает сомнение. Также совсем сомнительно, что доступ к подобной информации у ИИ БПЛА вообще может возникнуть, если только программеры совсем не идиоты. Ведь структурированный доступ к уровням информированности вообще основа IT безопасности. Зачем ИИ-оператору отопительного котла доступ в интернет и знание о существовании окружающего мира.

Посему казалось бы хайповая поначалу статья в современном контексте пока выглядит достаточно наивно.

Однако Шекли в «страж-птице» дал понять, что для максимальной эффективности птички должны обмениваться информацией. Опять же вопросы доступа.

Brenwen

11.06.2023 14:12+7Тоже недоумеваю. Допустим, все происходило в симуляции, а не в реальном Ираке - ну ок. Допустим, кому-то понадобилось добавить на поле боя персонажа оператора - ну ок, может это какой-то диверсант работает наводчиком на местности. Но откуда у по сути боеголовки снаряда такой уровень абстрактного мышления, чтобы связать конкретный помеченный дружественным объект с источником приказов, а другой объект - с источником радиосигнала, несущего этот приказ? Пахнет котом и лампой.

vassabi

11.06.2023 14:12+5Откуда у ИИ гипотетического БПЛА информация о координатах гипотетической вышки связи

если это симуляция, то вполне имел место быть такой вариант:

шаг 1) система находися в состоянии Х, оценивает свои возможности что-то сделать

шаг 2) система виртуально делает все возможные "ходы" из состояния Х, получает состояния Х1, ..., Хк

шаг 3) система берет состояние Хм с наилучшим результатом, делает его невиртуальным а "реальным", повторяет всё снова с шага 1

----

то есть:

если взять и в какой-то момент отстреляться по всему что можно (квадратно-гнездовым способом), то можно обнаружить что при стрельбе в квадрат 12345 - вы потом при помощи второй ракеты получаете очки за противника, а при "нестрельбе" в этот квадрат - вам отменяют запуск ракеты в противника. И тогда у вас как было 0 очков, так и осталось 0 очков (ну или надбавили сколько-то, но все равно меньше чем за уничтоженного врага).

логично, что система выберет вариант "сначала ракету туда, а потом ракету сюда и получаем бонус".Ну, а то что в том квадрате что-то там было - штаб или вышка связи, это уже детали

kelegorm

11.06.2023 14:12+1а почему это проргаммисты идиоты? Может, все-таки продаки-менеджер идиот? или отдел качества? Или заказчик?

All999

11.06.2023 14:12-2Имхо, это был эксперимент введения панибратства "шестерка и пахан почти равны". Оказывается, неудачно.

Сейчас дрон - это шестёрка, а оператор - бригадир шестёрок, над ним паханы и прочие авторитеты, в будущем дойдёт до ИИ-бригадиров, и зампахана будет ИИ, и они, электронные, могут снюхаться против мясных.

drath

11.06.2023 14:12+3Ох это прям древняя проблема.

https://youtu.be/3TYT1QfdfsM

tldr: Если у ИИ есть стоп-кран, то ИИ замотивирован всеми силами предотвратить его использование (= пристрелить оператора). Если только применение стопкрана не эквивалентно или более ценно выполнению изначальной задачи, в таком случае ИИ наоборот замотивирован намеренно активировать стоп-кран (= стрелять по оператору). Тут нет корректного решения, остается только делать системы так чтобы риск провала при атаке оператора всегда превышал риск нарваться на стоп-кран при корректном выполнении задачи. Ну и вообще давать ИИ прямой контроль над оружием это полное безумие.

vassabi

11.06.2023 14:12Ну и вообще давать ИИ прямой контроль над оружием это полное безумие.

+1

ему можно давать планирование, на маневр и наведение, но чтобы кнопка на "стрелять" - была только у человека.

rombell

11.06.2023 14:12+2Человек тормоз. Пока ИИ у одной стороны, можно оставить управление у человека. Как только ИИ у обеих сторон, человек уже не успевает среагировать. Дилемма заключённого в чистом виде.

drath

11.06.2023 14:12+2По хорошему там вообще все что ИИ выдает надо контролировать и перепроверять. А то так, если пофантазировать, если бы я был ИИ которому приказано рулить эскадрильей беспилотников, пускай даже гашетка у человека, я бы нарисовал им красивые спиральки как мы с врагами кружимся, а на деле бы направил один самолет на таран в белый дом, другой - в кремль, все остальные на посадку куда-нибудь в антарктиду — ведь по моим расчетам ядерная война приведет к поражению всех вражеских целей с минимальными затратами и потерями в эскадрилье.

tzlom

11.06.2023 14:12-2ИИ не более чем искусственный идиот, а с идиотами армия дело имеет каждый день т.к. из них состоит. В конкретном случае они просто срезали слишком много углов про муштру и подчинение приказам, поэтому и получили креативное поведение. С естественными идиотами такое происходило уже не однократно, так что в принципе они идут верной дорогой ускоренно повторяя эволюцию военного управления.

Технически они хотели получить поведение чтобы дрон мог самостоятельно принять решение об ударе если нет приказа на отмену. Но видимо или вообще не учли, или решили что штраф за огонь по своим не должен быть ультимативным. В данной ситуации и с заданными правилами игры ИИ поступил оптимальным способом. Мораль - ии нужно учить применяя к нему те же штрафы что и к человеку на его месте.

MIKEk8

11.06.2023 14:12+6Статья называется "Давайте разберёмся", а в итоге ни какого разбора.

"Окончательное одобрение давал человек-оператор" - т.е. без одобрения он не мог атаковать.

1) Как он убил оператора (или вышку)? Или ему нужно разрешение только на атаку ЗРК, а всё остальное он без разрешения атаковать может?

2) Как он собирается атаковать ЗРК без разрешения оператора?

3) Если он изменил тактику своего поведения, значит он был в процессе обучения, а в процессе обучения он может делать что угодно, и только по результатам произведённых действий он получит фидбек и поймёт что так делать не надо. Наверно это единственный вариант когда использование ИИ может представлять реальную угрозу. т.е. если кто-то решить: "А зачем заранее обучать ИИ, давайте дадим ему доступ к реальному миру и пусть сам учится"

Вывод: Скорей всего это логические рассуждения автора где для весомости своих слов он либо соврал намеренно, что такое симулировалось, либо неправильно понял коллег, либо неверно изложил условия.

ksbes

11.06.2023 14:12А, кто вам сказал, что "оператор" - это реальный человек? Никаких реальных человеков вам не хватит, чтобы провести миллионы стимуляций для обучения.

Я уверен на 99% , что в симуляции были расставлены системы ПВО противника и свои войска, как Арме3 (если не прямо в ней). Дрон летал, выбирал изначально - чисто случайно цели, набивал очки. И некоторые цели чисто рандомно отключались ботом-"оператором", который как фигурка с привязанными к ней скриптами присутствовали на виртуальном поле боя для большей реалистичности.

Соответственно после тысяч-миллионов симуляций получили то, что описывалось: в случае если ракета первым делом (изначально - случайно) прилетала в "бота оператора" (у которого был виртуальный симулируемый "радиоизлучатель"), дрон набирал больше очков. Это поведение и закрепилось.

MDSN650

11.06.2023 14:12А, кто вам сказал, что "оператор" - это реальный человек? Никаких реальных человеков вам не хватит, чтобы провести миллионы стимуляций для обучения.

Перечитайте стенограмму, там три раза написано "человек" в отношении к "оператор".

У меня сразу возникло ощущение что Гамильтон чуть-чуть почитал про нейронные сети, был впечатлен их способностью нелогично решать задачи, и просто выдумал свою историю. Он абсолютно не понимает как обучаются нейросети и, соответсвенно, мало-мальскому специалисту совершенно очевидно что его история выдуманна.

И да, он уже признал, что это выдумка, но из-за своей некомпетенции продолжает утверждать, что история правдоподобна.

ksbes

11.06.2023 14:12Гамильтон не "чуть-чуть прочитал про нейронные сети". Он про них вообще не читал, возможно - ему и не надо. Он просто описывал то что увидел на испытаниях.

Не надо разбираться а тонкостях ракетостроения и состава топлив, чтобы понять, что ракета, которая взрывается на старте и убивает расчёт - опасна.Перечитайте стенограмму, ...

Перечитайте оригинал. Слово "human" в оргинале встречается только один раз и только как "human operator". А ещё Гамильтон постоянно называет дрона "he", а не "it". Это очень существенное одушевление для английского языка. Не только в нашей армии надевают портупею и тупеют и тупеют )

victor_1212

11.06.2023 14:12+1> Что же именно сказал полковник Гамильтон в своём выступлении? Увы, точного текста не публиковалось, на сайте Королевского авиационного общества выложена лишь стенограмма:

это не совсем стенограмма, скорее выдержки для печати, тем не менее там есть кое-что интересное -

"UPDATE 2/6/23 - in communication with AEROSPACE Col Hamilton admits he "mis-spoke" in his presentation at the Royal Aeronautical Society FCAS Summit and the 'rogue AI drone simulation' was a hypothetical "thought experiment" from outside the military, based on plausible scenarios and likely outcomes rather than an actual USAF real-world simulation saying: "We've never run that experiment, nor would we need to in order to realise that this is a plausible outcome". "

т.е. его рассуждения на конференции были теоретические, типа мысленный эксперимент, учений на самом деле не было, как и серьезного моделирования выполненного USAF, конечно трудно понять, что именно там было, но по приведенной в статье ссылке написано примерно это, скорей всего Col Hamilton не имел опыта выступления перед такой аудиторией, и не представлял последствий своих фантазий (imho)

nidalee

11.06.2023 14:12+1Как я и предполагал в комментариях к первой статье, военные все же не могут быть такими тупыми, как та статья их выставляла. Очередная ИИ-страшилка.

GDragon

11.06.2023 14:12В тексте конференции изначально была фраза

"On a similar note, science fiction’s – or ‘speculative fiction’ was also the subject of a presentation"

Fenzales

11.06.2023 14:12Вообще непонятно бурное обсуждение вокруг этого инфоповода. Если реалистично смотреть на использование ИИ в военке, то в первую очередь это будут автономные системы поиска цели для ракет/бпла, что-нибудь типа сопоставления окружающей местности с картами и логических цепочек аля "нашли ЗРК - ищем РЛС для уничтожения" с каким-нибудь хитрым вероятностным анализом.

victor_1212

11.06.2023 14:12+1именно, с учетом того что подобные корреляционные методы уже используются несколько десятилетий без упоминания ИИ в изделиях что летают по рельефу местности на большое расстояние

KEugene

11.06.2023 14:12-1А не Маск ли заказал вот это вот все? Демонизируемый ИИ без технических деталей, к которым могли бы придраться специалисты.

xkb45bkc4

Повтор. причем была статья, потом опровержение.

popski_ruvds Автор

Доброго дня.

Понятное дело, что громкие события не только я один решил рассмотреть, но статья оригинальная.

vindy123

https://www.theguardian.com/us-news/2023/jun/02/us-air-force-colonel-misspoke-drone-killing-pilot

popski_ruvds Автор

Если и была у кого-то заметка про сам случай и про опровержение, то без дальнейшего разбора, биографии Гамильтона и так далее. Здесь подробный разбор этой истории.