Салют! Меня зовут Ваня Леонтьев, я директор по аналитике в СберМаркете. Эта статья о том, как мы оцифровали такую сложную концепцию как data-культура в компании. Поделюсь предпосылками, нашим подходом к расчету и планами по развитию методологии. Думаю, наш опыт будет интересен аналитикам, лидам аналитических команд, руководителям продукта и компаний в целом — всем тем, кто кто стремится продвигать культуру данных в своей компании. А также тем, кто хочет иметь инструмент для приоритизации и управления в команде аналитики.

Небольшой дисклеймер: стартовое условие для внедрения подхода, о котором я расскажу дальше, — наличие BI-системы. Но мне кажется, что любой компании, в которой есть команда аналитики, стоит попробовать примерить эту концепцию и научиться считать уровень развития своей data-культуры. Ведь как можно говорить о данных, не имея метрики по ним в компании. Но обо всем по порядку.

Почему мы решили измерять data driven’ность?

Сейчас очень многие компании говорят про data driven подход. Обычно под этим подразумевается стремление принимать все решения в бизнесе с опорой на данные.

Появление первых аналитиков в компании — это всегда сигнал, что компания хочет стать data driven и прокачать свою data-культуру. Но что происходит дальше? Часто стейкхолдеры заваливают data-команду повторяющимися adhoc-задачами и очень расстраиваются, если аналитик не готов бросить все дела и решить этот срочный запрос.

Вопрос, на который очень важно дать ответ команде аналитики: «А делаем ли мы то, что нужно? Достаточно ли эффективно мы помогаем компании стать data driven?» Пока аналитика не начнёт сама к себе относиться с позиции метрик, говорить о data driven подходе в такой компании неуместно.

В поисках нужной метрики

Первая мысль: «Может просто поделим ФОТ команды аналитиков на GMV? Разве это не будет самым объективным показателем, насколько наша работа полезна для компании?» Кажется, дело закрыто!

На самом деле у этого подхода есть серьезные минусы. Самый очевидный: аналитики не влияют на свой ФОТ напрямую и никак им не управляют. И уж тем более они не влияют на весь GMV — только на инкремент к нему или на экономию на уровне прибыли.

Второе: ФОТ/GMV не дает оценки зрелости дата-культуры. Он показывает лишь то, насколько мы в бенчмарке по экономике.

И последнее, команды без прямых инкрементов лишь ухудшают эту метрику. Например, BI-команда, чья ценность всем понятна, будет плохо сказываться на показателях. Значит, такая метрика недостаточно хорошо отражает реалность.

Какие ещё есть варианты?

Throughput из Канбан-методологии покажет, сколько задач проходит через команду аналитиков, но не оценивает качество этих задач и их эффект в долгосрочной перспективе. Иногда вместо бесконечного тушения пожаров нужно проактивно создать удобное data-решение, которым заказчик будет пользоваться самостоятельно.

Lead Time показывает сколько времени занимает решение задачи аналитиком. Возникают те же вопросы, что и к throughput.

Переток adhoc-задач в self-service — уже лучше, но тут мы упускаем из вида самое начало пайплайна работы с данными. Насколько данные в этих self-service инструментах качественные и своевременные?

Все эти метрики безусловно важны, как и инкременты команды аналитики в GMV и прибыльность, но ни одна из них не показывает развитие data-культуры. Поэтому мы решили спроектировать синтетическую метрику и включить в неё все те ценности, которые мы вкладываем в data driven подход.

Как мы считаем data driven’ность в СберМаркете

Мы попытались дать MVP-ответ на вопрос «Какими должны быть данные у нас в компании, чтобы мы считали себя data driven?» Получились следующие характеристики:

Данные должны быть стабильными — обновляться непрерывно и не опаздывать.

Данные должны быть качественными, то есть достоверными. А ещё нужно, чтобы все дашборды и исследования опирались именно на такие данные.

И самое главное — этими данными должны реально пользоваться сотрудники компании.

На основе этих трёх факторов у нас получилась синтетическая метрика Data Driven Index — мы считаем её как среднее арифметическое между тремя индексами. О методологии их подсчёта расскажу ниже. Вместе они покрывают цикл данных от витрин и таблиц до итогового использования.

Индекс стабильности данных

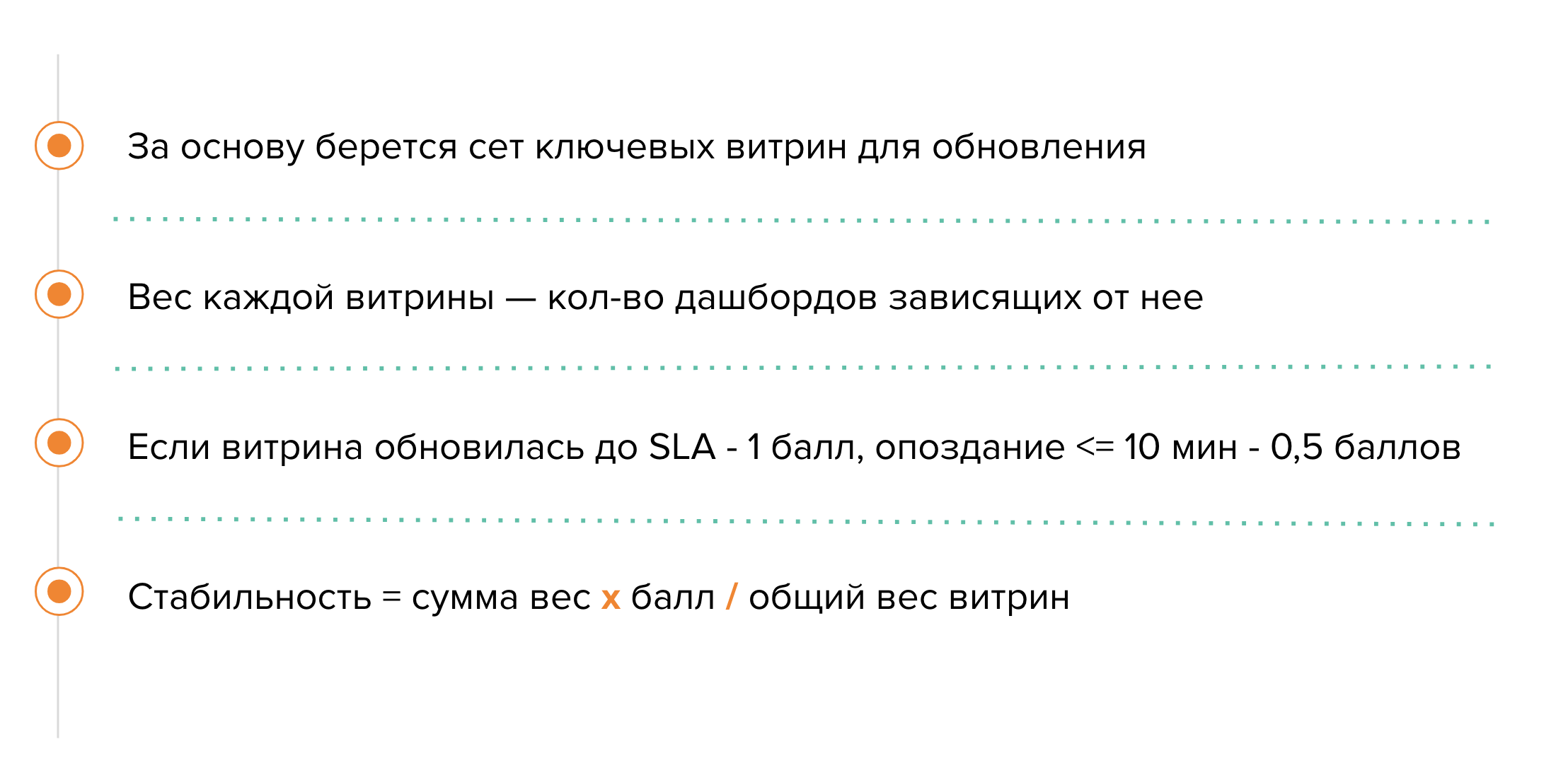

В расчете индекса стабильности мы заложили SLA обновления витрин и дашбордов, выделили golden set витрин, по которым не терпим отклонения в несколько минут, задали вес витрин в зависимости от их важности (количества дашбордов, которые от них зависят) и отдельно выделили стабильность событийных данных.

Сейчас это самый простой индекс по логике расчета. С учетом того, обновилась ли витрина вовремя или опоздала, ей проставляются баллы. Если задержка больше чем на 10 минут, то мы считаем, что обновление в принципе не происходило, и это уже инцидент.

Индекс качества данных

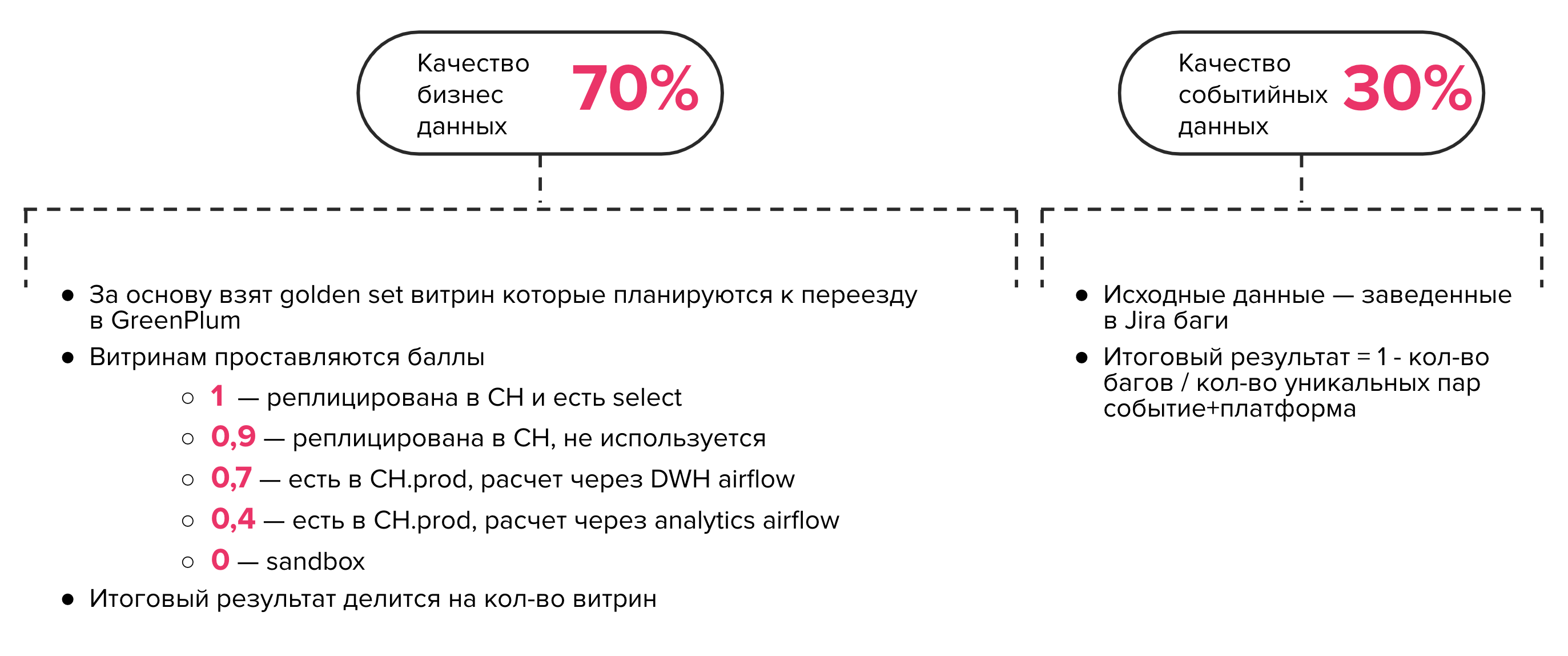

Для расчета качества сначала мы делим данные на две категории: бизнес-данные и событийные данные. Веса между ними распределяются в соотношении 70% и 30%.

За основу бизнес-данных мы взяли golden set витрин, которые планируются к переезду в GreenPlum, — всего их 11 штук. Витринам проставляются баллы в зависимости от того, как они считаются, в какую схему попадают, используются ли и реплицированы ли уже в ClickHouse.

Событийные данные — это база для расчета. Баги заводятся в Jira, и мы получаем долю уникальных событий, по которым не было багов в конкретный день, от всех событий, которые в принципе у нас есть на различных платформах. Уникальными считаем пару «событие + платформа».

Индекс использования данных

Пожалуй, самый важный индекс, потому что в исследованиях и дашбордах не будет никакого смысла, если ими активно не пользоваться. Эта метрика зависит от людей, инструментов и частотности использования.

Мы задали различный вес сотрудников в зависимости от должности. Для СЕО вес максимальный, для специалистов — самый низкий. Аналитикам, которые сами создают дашборды, и BI-команде мы тоже задали минимальные веса, чтобы не растить датадрайвенность за счет их заходов.

Веса инструментов должны зависеть от их качества: чем более надежный источник данных, тем лучше использовать именно его. Сертифицированный дашборд для бизнес-пользователя или дашборд в Grafana для сотрудника ДИТ будет иметь максимальный вес. Отсутствие сертификации снизит вес дашборда до 0,7. Наименьший вес будет у карточки в Metabase, это наша вторая BI-система — она остаётся у нас чисто исторически, и как раз с помощью разных весов мы подсвечиваем вектор переезда из одних систем в другие. Так мы страхуем метрику от использования некачественных данных и закладываем, что наша датадрайвенность будет тем лучше, чем больше дашбордов и отчетов будут сертифицированы.

Частоту использования очень важно учитывать, так как зачастую путь наших пользователей в данных не ограничивается одним дашбордом. Если пользователь совершает просмотров больше, чем медианное значение по инструменту, его вес будет повышен. Мы говорим о медианном значении без нулевых значений, то есть не учитываем тех, кто совсем не посещает.

Так мы открываем возможности для создания новых дашбордов, даже если, например, весь отдел уже регулярно пользуется дашбордами. Мы не распределяем вес пропорционально количеству просмотров или уникальных дашбордов, иначе это делало бы метрику сильно смещенной. Продуманные и легкие в использовании дашборды все равно будут растить датадрайвенность за счет снижения медианы уникальных просмотров.

Как драйвить метрику data driven’ности?

Предлагаю вот такой нехитрый таймлайн:

определить роли и ЦА;

определить потребность каждой из команд;

внедрить инициативу

убедиться на данных, что инициатива решает задачу клиента.

Звучит максимально просто, согласен. Возвращаясь к примеру из начала статьи: если к вам как к аналитику постоянно приходят с adhoc-задачами, то, нужно понять, какая есть потребность и придумать для неё решение, в идеале self-service. Так процесс в компании действительно поменяется, произойдет та самая data-трансформация.

Описанный выше цикл будет касаться любой проблемы, от неактуальности данных и проблем с обновлением дашбордов в заданные SLA до всего, что касается стабильности, создания новых дашбордов или доработки имеющихся. При решении этих проблем аналитик должен ориентироваться на data driven’ность как основную метрику. Тогда работа не окажется невостребованной, дашборды будут использоваться и можно будет говорить о систематическом подходе к стабильности и качеству данных.

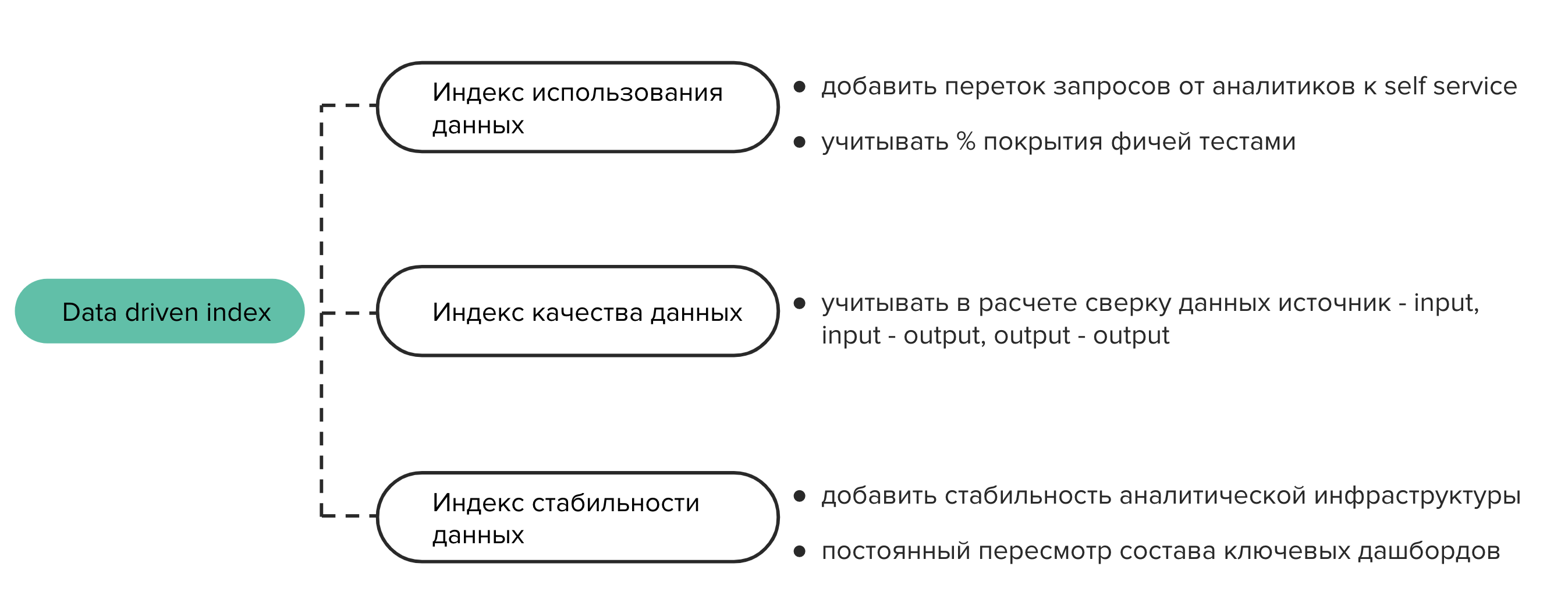

Текущий вариант метрики, конечно, не идеален. Она синтетическая, поэтому развивать её можно до бесконечности, и чем глубже становится логика её подсчёта, тем больше это свидетельствует о развитии data-культуры. На схеме — ключевые зоны роста по каждому из индексов.

Какие эффекты?

Мы подняли использование данных в 1,8 раз за счет правильного обучения и рассказов о дашбордах. Вот пара самых ярких примеров из нашей практики:

Мы установили в офисе экраны с real-time дашбордами по операционным метрикам. Они помогают принимать важные решения хэдам направлений и командам, которые мониторят ситуацию в моменте.

Провели диктант по метрикам для маркетологов, после чего они стали активнее пользоваться дашбордами. Кстати, именно сотрудники отдела маркетинга и продаж пользуются витринами данных больше всех остальных сотрудников компании. Им важно постоянно мониторить метрики и видеть, что происходит сейчас, — фактически для того, чтобы вовремя выдавать промокоды или проводить другие активности, стимулирующие GMV.

Люди стали регулярно изучать данные, принимать решения с их учетом, это можно видеть и в бизнес-показателях, и в обращениях к аналитике. Доля adhoc-задач снизилась на 15% как раз благодаря повышению известности данных.

Кроме того, во время интервью с аналитиками мы очень часто слышим вопросы: «А не пойдет ли моя работа в стол?», «Будут ли мои исследования, дашборды полезны?» На них есть простой ответ: «Конечно, работа будет полезной. Смотри, какая у нас метрика data driven’ности». У нас это значительно повысить конверсию в найм.

So what?

Мы выделили для себя индекс data driven’ности. Он позволяет в прозрачном и оцифрованном виде изучать качество данных, стабильность, используемость на разных уровнях. С их помощью мы контролируем дата-культуру и прорабатываем стратегии.

Если вы понимаете, что эта концепция может быть вам полезна на текущей стадии развития компании, распишите четкие цели его внедрения. Потом сделайте первую итерацию и получите quick win, который можно будет согласовать с топ-менеджментом.

Буду рад, если у вас действительно получится с пользой применить аналогичный подход у себя. Готов ответить на вопросы в комментариях!

Product&data команда СберМаркета ведет соцсети с новостями и анонсами. Если хочешь узнать, что под капотом высоконагруженного e-commerce, следи за нами в Telegram и на YouTube. А также слушай подкаст «Для tech и этих» от наших it-менеджеров.

Комментарии (3)

iamalexanderkim

04.07.2023 13:54Провели диктант по метрикам для маркетологов, после чего они стали активнее пользоваться дашбордами

А можно подробнее, что под диктантом подразумевается?) Описание метрик в дашбордах? Что-то еще?

Elena24Kov

Очень важная тема и интересная статья. Для её более лёгкого понимания было бы полезно сначала давать полное название термина, за которым следует в скобках сокращённое его название, и далее в тексте уместно использовать только сокращённое название. Так, термины ФОТ и GMV - это наверное то, что вы часто употребляете внутри организации, но человеку извне может быть незнакомо

Sbermarket

Большое спасибо за обратную связь, добавим!

GMV (Gross Merchandise Value или валовая стоимость товара) — совокупная стоимость товаров, проданных на торговой площадке за определенный период времени.

ФОТ (фонд оплаты труда) — сколько денег уходит на зарплату и премии сотрудникам :)