Автор статьи: Артем Михайлов

В последние десятилетия марковские цепи стали широко используемым инструментом в обработке естественного языка и моделировании текстовых данных. Они представляют собой вероятностную модель, которая основывается на предположении о марковских свойствах последовательности событий.

В данной статье мы рассмотрим основные принципы и подходы к использованию марковских цепей в обработке естественного языка и моделировании текстовых данных. Мы изучим, как марковские цепи могут быть применены для предсказания следующего слова в тексте, генерации новых текстовых данных, анализа структуры и семантики текста, а также решения других задач текстовой обработки.

Основы марковских цепей

Марковские цепи являются мощным инструментом для моделирования случайных процессов, основанных на последовательности состояний и переходах между ними. В этом разделе мы рассмотрим основные принципы марковских цепей, начиная с понятия состояния и переходов.

Состояние в марковской цепи представляет собой определенную конфигурацию системы в данном временном периоде. Например, если мы моделируем процесс перемещения человека в городе, то состояние может быть определено его текущим местоположением. Переходы, с другой стороны, представляют процесс изменения состояний со временем. В нашем примере, переход может быть перемещением человека из одного района в другой.

Марковские цепи могут быть классифицированы по различным типам состояний и переходов. Одним из вариантов является разделение цепи на цепи с абсорбирующими и непоглощающими состояниями. В цепях с абсорбирующими состояниями существуют такие состояния, из которых невозможно покинуть. Это может быть полезно для моделирования долгосрочных состояний, например, состояния покоя или окончательного результата эксперимента. Непоглощающие состояния, с другой стороны, позволяют цепи перемещаться между состояниями вечно и никогда не останавливаются.

Другой важной характеристикой марковских цепей является их однородность или неоднородность. Однородные цепи имеют фиксированные вероятности перехода между состояниями и эти вероятности не меняются со временем. Неоднородные цепи, напротив, имеют переменные вероятности перехода, которые могут изменяться в зависимости от времени или других факторов.

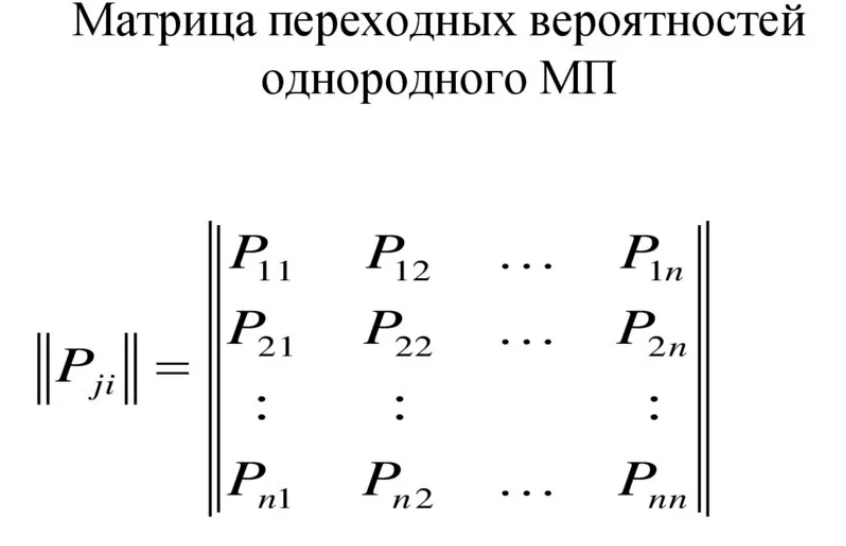

Матрицы переходных вероятностей являются основным инструментом для представления марковских цепей. Это квадратные матрицы, где элементы определяют вероятности перехода из одного состояния в другое. Каждая строка матрицы представляет состояние, а каждый столбец представляет состояние, в которое можно перейти. Сумма элементов в каждой строке должна быть равна единице, что отражает факт сохранения вероятности.

Используя матрицы переходных вероятностей, мы можем моделировать и анализировать различные статистические свойства марковских цепей, такие как эргодические состояния или вероятности достижения определенных состояний.

Более подробно про марковские цепи мы разбирали в нашей статье с заголовком «Искусство прогнозирования: погружение в Марковские цепи»

Применение марковских цепей в обработке естественного языка

От моделирования языковых структур до статистического анализа текстов, марковские цепи позволяют создавать эффективные и точные модели для решения сложных задач.

Одним из главных преимуществ использования марковских цепей в обработке естественного языка является их способность моделировать структуру текста. В отличие от традиционных методов, основанных на грамматиках или правилах, марковские цепи позволяют автоматически извлекать статистическую информацию о взаимосвязи между словами и их последовательностями. Это позволяет строить гибкие и адаптивные модели, способные точно предсказывать следующее слово или фразу на основе имеющегося контекста.

Для построения модели марковской цепи, текст обрабатывается и анализируется для извлечения статистической информации. В основе модели лежит предположение о том, что вероятность появления следующего слова зависит от предыдущих слов или символов. Таким образом, модель может запомнить последовательности слов и определить наиболее вероятное следующее слово или фразу на основе контекста.

Например, представим, что у нас есть текст: "Я люблю заниматься спортом". Для построения модели марковской цепи, мы можем разделить этот текст на последовательности слов, например, ("Я", "люблю"), ("люблю", "заниматься"), ("заниматься", "спортом"). Затем, на основе этих последовательностей, мы можем определить вероятности появления следующего слова или фразы. Например, какую вероятность имеет появление слова "спортом" после слова "заниматься".

Пример:

import random

# Текст для обучения модели марковской цепи

text = "Я люблю заниматься спортом"

# Разделение текста на последовательности слов

sequences = text.split()

# Создание словаря для хранения последовательностей и их следующих слов

model = {}

for i in range(len(sequences) - 1):

if sequences[i] not in model:

model[sequences[i]] = []

model[sequences[i]].append(sequences[i+1])

# Функция для предсказания следующего слова на основе текущего слова

def predict_next_word(current_word):

next_words = model.get(current_word)

if next_words:

return random.choice(next_words)

else:

return None

# Предсказание следующего слова

current_word = "заниматься"

next_word = predict_next_word(current_word)

print("Следующее слово после '{}' - '{}'".format(current_word, next_word))В этом примере мы сначала разделили исходный текст на последовательности слов. Затем мы создали словарь, где ключами являются слова, а значениями — следующие слова в тексте. Далее мы определили функцию predict_next_word, которая выбирает случайное следующее слово на основе текущего слова из модели марковской цепи. Наконец, мы вызвали эту функцию для слова "заниматься" и вывели результат.

Автопредсказание следующего слова на основе контекста является одной из самых распространенных и важных задач в обработке естественного языка. Ее цель заключается в том, чтобы предсказать наиболее вероятное следующее слово или фразу, исходя из предыдущих слов или фраз текста.

Марковские цепи предоставляют эффективный инструмент для моделирования и решения этой задачи. Основная идея заключается в том, что вероятность появления следующего слова зависит от контекста, предыдущих слов или фраз. Марковская цепь моделирует эту зависимость, определяя вероятности перехода от одного слова к другому в зависимости от рассматриваемого контекста.

Для решения задачи автопредсказания используется модель марковской цепи n-го порядка, где n определяет количество предыдущих слов, учитываемых при предсказании следующего слова. Например, в случае n=1, модель будет учитывать только последнее слово в контексте. В случае n=2, будет учитываться два последних слова, и так далее.

Для построения модели марковской цепи необходимо иметь достаточный объем обучающих данных, состоящий из текстовых корпусов, чтобы определить частотности и вероятности перехода от одного слова к другому в разных контекстах. Эти данные можно использовать для создания матрицы переходных вероятностей, которая указывает вероятность появления каждого следующего слова в зависимости от предыдущих слов.

Пример:

import random

class MarkovChain:

def init(self, n):

self.n = n

self.transitions = {}

def train(self, corpus):

for sentence in corpus:

words = sentence.split()

if len(words) <= self.n:

continue

for i in range(len(words)-self.n):

context = tuple(words[i:i+self.n])

next_word = words[i+self.n]

if context not in self.transitions:

self.transitions[context] = []

self.transitions[context].append(next_word)

def generate_next_word(self, context):

context = tuple(context)

if context in self.transitions:

possible_next_words = self.transitions[context]

next_word = random.choice(possible_next_words)

return next_word

else:

return None

# Пример использования модели марковской цепи

corpus = [

"предсказать наиболее вероятное",

"появления следующего слова",

"и так далее"

]

model = MarkovChain(n=2)

model.train(corpus)

context = ["предсказать", "наиболее"]

next_word = model.generate_next_word(context)

print("Следующее слово:", next_word)Класс MarkovChain представляет модель марковской цепи. Он инициализируется параметром n, который определяет порядок модели (количество предыдущих слов, учитываемых при предсказании). Метод train принимает список предложений корпуса и обучает модель, заполняя матрицу переходных вероятностей transitions. Метод generate_next_word принимает контекст (предыдущие слова) и возвращает наиболее вероятное следующее слово для данного контекста.

Пример использования показывает, как создать модель марковской цепи с порядком 2 и обучить ее на небольшом корпусе. Затем мы можем указать контекст ("предсказать", "наиболее") и получить предсказание следующего слова с помощью метода generate_next_word. В данном случае, выводится одно из возможных следующих слов — "вероятное".

Помимо автопредсказания, марковские цепи также находят применение в автокоррекции и исправлении опечаток. Благодаря своей способности моделировать вероятности появления последовательностей символов или слов, марковские цепи могут быть использованы для определения наиболее вероятной корректировки опечатки или исправления ошибки в слове. Это помогает повысить точность автокоррекции и обеспечить более надежную обработку текста.

Однако, несмотря на все преимущества марковских цепей в обработке естественного языка, существуют и определенные ограничения. В частности, марковские цепи не учитывают смысловую связь между словами и не уделяют должного внимания семантическому анализу текста. Это может приводить к некорректным предсказаниям или моделированию. Поэтому вместе с марковскими цепями часто применяются и другие методы и модели для более точного анализа и обработки текста.

Марковские цепи в моделировании текстовых данных

Основная идея заключается в том, что вероятность появления определенного слова или символа зависит только от предыдущих слов или символов в тексте. Данные зависимости улавливаются и сохраняются в виде математической модели — марковской цепи. Каждое состояние в цепи представляет собой конкретное слово или символ, а переходы между состояниями соответствуют статистическим вероятностям. Таким образом, модель может предсказывать наиболее вероятное следующее слово или символ на основе предыдущих.

Создание моделей на основе марковских цепей для генерации текста является процессом, включающим несколько ключевых шагов. Во-первых, необходимо провести предварительную обработку текстовых данных, удалить неинформативные символы и провести токенизацию предложений или слов. Затем происходит построение самой марковской цепи, где осуществляется подсчет вероятностей переходов между состояниями. Различные подходы могут использоваться для определения порядка модели, то есть количества предыдущих слов или символов, которые учитываются при генерации.

Примеры успешного использования марковских цепей в моделировании текстовых данных многочисленны и разнообразны. Генерация текста на основе марковской цепи может использоваться в различных областях, таких как автоматическое дополнение текста в поисковых системах, создание реалистичных диалоговых систем, генерация текстовых описаний товаров в электронной коммерции и многое другое.

Пример:

import random

def build_markov_chain(text, order):

markov_chain = {}

words = text.split()

for i in range(len(words)-order):

prefix = tuple(words[i:i+order])

suffix = words[i+order]

if prefix in markov_chain:

markov_chain[prefix].append(suffix)

else:

markov_chain[prefix] = [suffix]

return markov_chain

def generate_text(markov_chain, order, length):

seed = random.choice(list(markov_chain.keys()))

generated_text = list(seed)

for _ in range(length):

prefix = tuple(generated_text[-order:])

if prefix in markov_chain:

next_word = random.choice(markov_chain[prefix])

generated_text.append(next_word)

else:

seed = random.choice(list(markov_chain.keys()))

generated_text += list(seed)

return ' '.join(generated_text)

# Пример использования

text = "Это пример текста, на основе которого будет построена марковская цепь"

order = 2

length = 10

markov_chain = build_markov_chain(text, order)

generated_text = generate_text(markov_chain, order, length)

print(generated_text)В данном примере мы сначала вызываем функцию build_markov_chain, которая строит марковскую цепь на основе входного текста и заданного порядка модели (в данном случае порядок равен 2). Функция делит входной текст на слова, затем проходит по каждому слову и его следующему слову, сохраняя информацию о вероятности перехода.

Затем мы вызываем функцию generate_text, которая использует построенную марковскую цепь для генерации нового текста заданной длины (в данном случае длина равна 10). Функция выбирает случайное начальное состояние (seed) из марковской цепи и затем постепенно добавляет новые слова на основе вероятностей перехода в марковской цепи.

Преимущества и ограничения марковских цепей

Преимущества марковских цепей в обработке естественного языка и моделировании текстовых данных связаны с их простотой и эффективностью.

Одним из основных преимуществмарковских цепей является их способность предсказывать последовательности на основе вероятностей и статистических данных. Это позволяет им генерировать тексты, которые визуально и семантически похожи на исходный текст. Например, марковская цепь может быть использована для автоматической генерации текстов на основе собранных новостных статей или литературных произведений.

Однако марковские цепи имеют некоторые ограничения, которые необходимо учитывать при их применении. Во-первых, марковские цепи предполагают, что вероятность следующего элемента зависит только от предыдущих элементов последовательности. Это значит, что они не учитывают контекст, который находится за пределами заданного окна. Если в тексте есть глубокие зависимости или долгосрочные связи между элементами, марковская цепь может быть недостаточно точной.

Второе ограничение марковских цепей связано с их неспособностью обрабатывать вариативность и неопределенность в данных. Так как марковские цепи работают на основе статистических данных, они могут не всегда улавливать сложные метафоры, идиомы или сарказмы. Они также не могут прогнозировать неожиданные и новые фразы или слова, которые могут появиться в тексте.

Для улучшения результатов применения марковских цепей в обработке естественного языка и моделировании текстовых данных можно использовать комбинацию с другими методами и моделями. Например, можно воспользоваться рекуррентными нейронными сетями или глубоким обучением для учета долгосрочных зависимостей и контекста. Также возможны различные приемы фильтрации и предобработки данных, которые позволят учесть специфику конкретной задачи.

Заключение

В заключение, марковские цепи — это мощный инструмент для обработки естественного языка и моделирования текстовых данных. Они обладают простотой и эффективностью, позволяющей автоматически извлечь правила и особенности языка из больших объемов текстовых данных. Однако их использование имеет некоторые ограничения, связанные с контекстом и вариативностью данных. Для улучшения результатов можно комбинировать марковские цепи с другими методами и моделями.

Приглашаем на открытое занятие «Конечный марковский процесс принятия решений и управление методом Монте-Карло», которое пройдет 11 июля. Основное внимание на этом занятии уделим Марковскому процессу принятия решений (MDP) и управлению Монте-Карло (MCC). Первый является математической основой для моделирования принятия решений в условиях, когда результаты действий ненадежны. А второй — метод поиска оптимальных стратегий. На занятии разберем, как работает этот метод, на простом примере, чтобы создать интуитивное понимание.

Урок завершится обзором доступных пакетов с открытым исходным кодом для решений RL в бенчмаркинге. После урока слушатели получат вводные задачи по RL в качестве домашней работы.

Урок будет особенно полезен для DS/ML/DL специалистов и IT-специалистов, которые хотят погрузиться в обучение с подкреплением.

Комментарии (2)

rqdkmndh

07.07.2023 05:32Не покидает ощущение, что текст статьи был сгенерирован GPT, а затем немного отредактирован человеком.

checkpoint

Как выглядит матрица переходов состояний для n=1 мне понятно (она приведена в тексте статьи). Можно ли продемонстрировать как выглядит матрица для n=2 или n=3 ? Как рассчитывается количество строк и столбцов в матрице при произвольном n ?

Еще один непонятный момент. Как кодируется состояние для n > 1 ?