В статье будут рассмотрены варианты конструкции электронного оборудования для ЦОД, которые с одной стороны позволят кардинально увеличить отводимую тепловую мощность от оборудования, а с другой стороны реализовать простую и эффективную систему охлаждения ЦОД с близкой к идеалу PUE.

В данном случае не ставится цели оценить затраты на реализацию и эксплуатацию подобных решений. И глобально, даже необходимость их создания. Вполне понятно, что возможно нет запроса запихивать 40-50 кВт мощности в одну стойку. Но на перспективу, запрос на «уплотнение» ЦОДов и улучшение их энергоэффективности вроде существует, поэтому есть смысл рассмотреть варианты конструкций, которые могут их удовлетворить. С одной стороны никакой привязки к «экономике» не будет, но с другой стороны конструкции должны быть основаны на понятных и более-менее отработанных решениях с адекватной стоимостью. Т.е. перспективные наноматериалы с теплопроводностью алмаза и обрабатываемостью алюминия не рассматриваем. Возможная ценность данных рассуждений в том, чтобы попытаться переосмыслить подходы к конструированию оборудования и телекоммуникационных стоек. Принципы этих конструкций были заложены давным-давно и глобально они никак не поменялись. Для охлаждения на них просто навешиваются некие апгрейды, типа вентиляторов помощнее, или водяных плит на процессоры, или теплообменника в стойку. Получилось ли их пересмотреть можно оценить далее.

1. Требования к перспективной конструкции

Сформулируем технические требования к нашей конструкции таким образом.

1) Мощность современной стойки 42U достигает 15 кВт. Наша перспективная конструкция должна обеспечивать мощность стойки 42U 40-50 кВт и «приемлемую» температуру корпусов электронных компонентов. Конкретную допустимую температуру корпусов ЭРИ оговорим далее. Мощность всегда принимается постоянная, т.е. вопрос непостоянства вычислительной нагрузки не рассматривается. Либо можно принять, что это некая усредненная мощность.

2) Конструкция должна обеспечивать легкую реализацию общей системы охлаждения ЦОД с PUE близкой к идеалу, будем считать, что это цифра равна 1,1.

Небольшая ремарка по цифре 1,1

Эта цифра обычно приводится для ЦОДов с адиабатическим охлаждением. Как именно она считается и какие затраты мощности учитывает в открытом доступе данных особо нет. Мы будем считать все затраты мощности на систему охлаждения, т.е. учитывать внутренние вентиляторы оборудования

Подробно систему охлаждения ЦОД рассматривать не будем, но должно быть понятно, как ее реализовать. Чуть позже детализируем, что понимается под «легкостью реализации». И здесь сразу оговорим температуру наружного воздуха. Примем ее 40°С. Цифра взята немного «с потолка», но на первый взгляд она представляется оправданной даже для стран с жарким климатом. Конечно, конкретная ее величина это также вопрос более детальной проработки.

3) Конструкция должна обеспечивать удобное обслуживание оборудования. Т.е. должна быть реализована возможность «горячей» замены модулей. Под модулем в данном случае будет пониматься печатная плата с одним процессором. Реальное наполнение данного модуля, процессор, видеопроцессор, несколько процессоров, память или что-то еще, мы глубоко рассматривать не будем. Это гораздо более сложный вопрос. Пока просто оговорим некий условный модуль (по сути, тепловую нагрузку) и будем строить конструкцию из этих модулей.

4) Конструкцию будем строить на основе реально существующих/продаваемых (возможно и не существующих, но реализуемых путем понятных изменений существующих) компонентов и материалов. Также конструкция должна быть рассчитана на массовые индустриальные электронные компоненты и стандартные печатные платы. Какие-то кастомные решения не рассматриваем.

Определившись с требованиями, будем детализировать элементы системы. И начнем с системы охлаждения ЦОД.

2. Описание системы охлаждения ЦОД

Как уже говорилось ранее, детально систему охлаждения ЦОД описывать не будем. Оговорим только, что подразумевается под «легкостью реализации» из п.1.2 и требования, которые это наложит на конструкцию оборудования. Для начала классифицируем известные системы охлаждения ЦОД. Глобально их можно разделить на два класса по типу охлаждающего агента: воздушные и водяные. В свою очередь, воздушные, можно разделить на следующие классы:

1) Охлаждение воздуха с помощью кондиционеров.

2) Охлаждение воздуха с помощью системы чилер-фанкойл. Чилер охлаждает жидкость, перекачивая тепло во внешнюю среду, а фанкойл охлаждает воздух, продувая его через теплообменник, через который циркулирует холодная жидкость.

3) Адиабатическое охлаждение. Охлаждение продуваемого воздуха за счет распыления в нем воды и ее испарения в потоке воздуха. Соответственно часть теплоты воздуха переходит в теплоту водяных паров, температура воздуха при этом падает, влажность повышается.

Также можно выделить два принципиальных способа жидкостного охлаждения.

4) Водяное охлаждение «холодными» плитами (водяными блоками). Т.е. непосредственно на тепловыделяющие элементы ставится «плита» через которую циркулирует холодная жидкость.

5) Охлаждение полным погружением оборудования в циркулирующую жидкость.

Все указанные системы охлаждения обладают определенными недостатками.

Для систем 1,2 PUE дата-центров ограничены КПД холодильного цикла, т.е. достигнуть близких к идеальным PUE порядка 1,1 невозможно принципиально. Плюс само оборудование является достаточно сложным и дорогим.

Системы 3 требуют расхода воды для их работы и не могут охладить воздух ниже температуры мокрого термометра. Т.е. если внешний воздух повышенной влажности, то реализовать фрикулинг будет затруднительно.

Также в системах 1,2,3 в PUE видимо не учитывается потребляемая мощность внутренних вентиляторов оборудования, которая может составлять 5-10% от общей потребляемой мощности сервера.

Системы 4 получаются сложными конструктивно.

Системы 5 пожароопасны (из-за необходимости применения диэлектрических масел в качестве охлаждающей жидкости). Видимо, очень неудобны в обслуживании.

Итак, пришло время сформулировать, что такое «легкость реализации» для системы воздушного охлаждения ЦОД. Самое простое, что может быть – это охлаждение наружным воздухом без какого-либо предварительного охлаждения. Т.е. оборудование должно охлаждаться воздухом с входной температурой 40°С. Этого вполне реально добиться, но «честно» посчитанный PUE для воздушного охлаждения вряд ли достигнет цифры 1,1.

Более перспективной представляется система жидкостного охлаждения. Требования к ее «легкости» сформулировать сложнее. Оттолкнемся от понятных недостатков жидкостной системы охлаждения типа 4 (тип 5 рассматривать большого смысла не вижу). Проблема может быть в большом количестве стыков, которые могут протекать, и в необходимости сборки-разборки данных стыков при обслуживании/замене оборудования. Либо в сложности сборки-разборки самого оборудования. Т.е. понятно, что можно реализовать систему трубок и водяных плит внутри сервера и при этом у нас будет два водяных стыка на один сервер, но замена, скажем, процессора в сервере будет невозможна без разборки стыков и полной разборки сервера. Поэтому требования сформулируем таким образом:

1) Начальная температура воды для охлаждения те же 40°С.

2) Минимальное количество стыков в пересчете на один процессорный модуль. Тут сложно сказать какая цифра будет хорошей. Но просто оттолкнемся от конструкции, которая будет описана далее. Это порядка 20 процессорных модулей (1 сервер 3U) на 2 стыка. На самом деле можно получить меньше или больше в зависимости от выбранного размера модулей и высоты сервера.

Конечно, идеал в данном случае – это два стыка на стойку. Т.е. некая холодная плита или связанные плиты внутри стойки, от которых охлаждается внутреннее оборудование. Тогда стыки необходимо разбирать только при замене самого конструктива стойки. Такое реализовать можно, но это будет более сложная конструкция.

3) Возможность замены модулей без разборки водяных стыков. Т.е. модули из сервера мы достаем и меняем, не трогая стыки. Для замены сервера целиком разбираем два стыка.

Также упомянем, что возможность реализации водяного охлаждения для всех видов оборудования внутри ЦОД позволит реализовать самую эффективную систему охлаждения. Необходимо охлаждать только воду до температуры внешнего воздуха (в принципе, можно охлаждать и ниже, используя градирни, но это добавить некоторые ограничения, как для адиабатического охлаждения). Это можно сделать с помощью пруда-охладителя или забирать воду из ближайшей реки и возвращать туда же. Для работы системы необходимы будут только насосы и фильтры. Их суммарная мощность должна быть ниже мощности вентиляторов на аналогичные мощности охлаждения. С другой стороны, если понятно, как реализовать подобную конструкцию для модулей типа процессоров, графических процессоров, SSD, RAM, преобразователей питания, то HDD, аккумуляторы могут вызвать затруднения.

Прежде, чем перейти к самой конструкции необходимо также уточнить вопрос с допустимой температурой корпусов ЭРИ.

3. Температурный режим электронных компонентов

Конечно, допустимая температура корпусов ЭРИ должна определятся по результатам анализа надежности. В данном случае мы не будем углубляться в этот вопрос. Возьмем типичный процессор, просто в качестве отправной точки для дальнейших рассуждений. Например, Intel Xeon Gold 5220R. В спецификации производителя указана максимальная допустимая температура корпуса Tcase=86°С. Опять же, не углубляясь в вопросы тепловых сопротивлений кристалл-корпус и режимы работы оборудования, возьмем запас по максимальной температуре в 10°С и немного округлим, соответственно максимально допустимая температура корпуса процессора в наших модулях будет 75°С. Запас необходим, хотя бы на неточность моделирования МКЭ. Итак, общий перепад температур, который должна обеспечить конструкция оборудования 75-40=35°С.

4. Предварительный анализ перепада температур

Остановимся подробнее на анализе отдельных составляющих общего перепада температур. Этот общий перепад можно представить как сумму последовательных перепадов на разных частях конструкции от корпуса процессора до входного потока воздуха. Пока будем считать, что наша расчетная схема состоит из последовательно соединенных тепловых сопротивлений (эквивалент закона Ома, который часто используется для теплового анализа).

, где

,

- перепад температуры на одном из элементов конструкции.

Первый , который неизбежно появится независимо от того, какая будет конструкция – это перепад температуры охлаждающего агента. Если сначала рассматриваем воздушное охлаждение, то это будет нагрев воздуха, т.е. разница температур на входе в оборудование и на выходе. Собственно все тепло, которое выделилось в оборудовании, должно быть «унесено» продуваемым воздухом. Зная плотность и теплоемкость воздуха при заданной температуре, несложно посчитать требуемый расход при заданном перепаде температур

. Пока возьмем мощность сервера 3U равной 3,6кВт. Далее рассмотрим эту цифру подробнее, пока просто используем как факт. И чтобы рассчитать требуемый расход воздуха надо определиться, сколько градусов из

мы готовы выделить на нагрев воздуха. Например, если выделяем 15°, то на все остальное остается 20°. Это на самом деле довольно мало. Но пока примем так. Посчитаем расход воздуха.

где

– мощность сервера, 3,6 кВт,

– перепад температур воздуха, 15°С

– плотность воздуха при заданной температуре. Возьмем температуру 50°С, тогда плотность равна 1,093 кг/м3

– теплоемкость воздуха при заданной температуре, 1005 Дж/(кг·К) при 50°С.

Тогда м3/с.

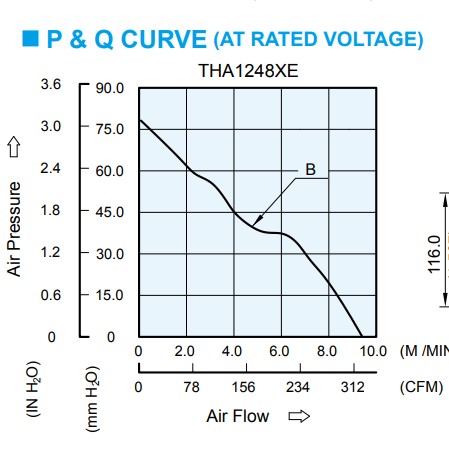

Попробуем сразу подобрать вентилятор на подобный расход. Конечно, сначала необходимо определиться с типоразмером вентилятора, а он в свою очередь зависит от конструкции оборудования. И для начала рассмотрим конструкцию, в которой будет использоваться один радиатор для охлаждения всего «сервера» 3U. Максимальный стандартный типоразмер вентилятора, который поместится в высоту 3U 120x120мм. Возьмем один из самых мощных предлагаемых вентиляторов модель THA1248BE производителя Delta Electronics.

График производительности и характеристики вентилятора приведены на картинках ниже.

Мы видим, что максимальный расход воздуха, который может выдать вентилятор равен 9,01 м3/мин, что соответствует 0,15 м3/с. Что уже меньше, чем рассчитанный ранее расход. В реальности расход воздуха, выдаваемый вентилятором, будет еще меньше, т.к. указанный максимальный соответствует нулевому воздушному сопротивлению. Создаваемый вентилятором перепад давления разбивается на две составляющих.

, где

- динамический напор вентилятора, который характеризируется кинетической энергией потока и соответственно скоростью потока. Т.е. это та часть мощности вентилятора, которая «тратится» на создание скорости и соответственно расхода воздуха.

- статический напор вентилятора, который необходим на преодоление аэродинамического сопротивления радиатора.

Численное моделирование показывается, что статический напор для радиатора с длиной 600-700мм (глубина сервера) с большим количеством ребер будет лежать в пределах 150-1000 Па, соответственно расход выдаваемый вентилятором придется поделить минимум на два. Для указанного вентилятора это будет порядка 0,075 м3/с. Т.е. нам понадобится эквивалент трех указанных вентиляторов для достижения нужного расхода. На текущий момент такого вентилятора в данном типоразмере не существует, т.к. в нем, видимо, нет потребности, но создание его представляется выполнимым. Либо можно взять четыре вентилятора 60x60мм, либо девять 40x40, у которых гораздо шире выбор по мощности и расходам. С точки зрения надежности так будет даже лучше. Для дальнейших рассуждений просто умножим характеристику вентилятора по оси X (расход) и потребляемую мощность на три. Т.е. 300Вт мощности уже будет использовано для охлаждения внутри самого устройства. Наш PUE уже равен 3,9кВт/3,6кВт = 1,08. Проблема здесь в том, что чем больше мы хотим уменьшить , тем сильнее будет расти мощность всех используемых вентиляторов, т.к. пропорционально растет требуемый расход воздуха. Меньше 15° эту составляющую лучше не делать. И прежде, чем перейти к моделированию первого варианта конструкции рассмотрим еще одну

, чтобы понять, сколько остается на внутренние сопротивления конструкции. Это перепад температуры на ребрах радиатора,

.

По-хорошему нельзя выделить на эту составляющую больше 10°, иначе на все остальные перепады останется меньше 10°С. Прикинем, каким будет перепад температуры на ребрах в случае использования одного радиатора на сервер. Размеры радиатора в этом случае будут понятны 120x120мм по размеру вентилятора и длина равная глубине оборудования за вычетом толщины вентилятора. Если глубина оборудования 700мм, то длина радиатора будет примерно 600мм, 100мм оставим на толщину вентилятора. Понятно, что можно поставить рядом два радиатора и вентилятора, заняв таким образом площадь 120x240мм, но это фактически «съест» половину объема 19 дюймовой стойки (ну или придется увеличить ширину стойки), поэтому для начала попробуем ужаться.

Итак, из ширины радиатора 120мм будем считать, что примерно половина приходится на ребра, остальное на воздушные промежутки между ними. Перепад температуры в твердом теле при условии равномерности теплового потока рассчитывается следующим образом.

, где

– длина ребра 0,06м. Учитываем только половину длины ребра 60мм вместо 120мм, т.к. считаем, что тепло равномерно снимается потоком воздуха по всей длине, т.е. на половине длины тепловой поток будет уже 1,8 кВт, и далее будет линейно уменьшаться до нуля. При этом перепад температуры будет эквивалентен перепаду температуры на половине длины твердого тела, при условии, что вся мощность снимается в конце.

– теплопроводность материала радиатора. Возьмем «среднюю» теплопроводность алюминиевого сплава (другие варианты для материала радиатора рассмотрим далее) 120 Вт/(м*К).

– площадь сечения ребра, 0,06x0,6=0,036м2

В итоге получаем: , что недопустимо много. Можно поделить эту цифру на два, если предположить, что источник тепла расположен посередине ребра, т.е.

м . И все равно 23°С – это слишком много. Опять же можно использовать медь в качестве материала радиатора,

Вт/(м*К), либо чистый алюминий с порядка 200 Вт/(м*К). Радиаторы из чистого алюминия, насколько мне известно, используются и наверняка дешевле, чем радиаторы из меди и естественно легче. Остановимся на таком материале. Тогда

, уже близко к тому чего мы добиваемся.

Рассмотрим проблему с другой стороны. Мощность, отводимая от поверхности при конвективном теплообмене, описывается следующей формулой:

, где

– коэффициент конвективной теплоотдачи,

S – площадь поверхности, – перепад температур между воздухом и поверхностью.

Для начала посчитаем площадь одного ребра м2.

Коэффициент аналитически рассчитывать не будем, в этом нет большого смысла, все равно дальнейший расчет будет вестись методом КЭ. Для оценки воспользуемся онлайн калькулятором. Для его использования необходимо также посчитать скорость потока воздуха согласно простой формуле:

, где

– площадь воздуховода, в данном случае 120x120/2=0,0072 м2. Тогда скорость потока в радиаторе будет 30,3 м/с. Конечно, это очень много (практически ураган) и наверняка очень шумно. На примере данного числа уже видно, что отвод подобной мощности с таких объемов может вызвать другие проблемы. Но пока продолжим рассуждения.

Для рассчитанной скорости и длины поверхности 0,6м калькулятор дает Вт/м2К. В калькуляторе предполагается одинаковая температура по всей поверхности, что в нашем случае не так. На самом деле температура ребер будет расти, как в направлении от тепловыделяющей поверхности к вершинам ребер, так в направлении «внутрь» устройства, от «холодного» коридора к «горячему». И по опыту при указанной скорости потока значение

выглядит очень низким. Если в калькуляторе указать длину 0,1м, то

Примем это значение, дальнейшие расчеты МКЭ показывают, что оно более чем достижимо. Т.о. при перепаде температур 15°С с одного ребра можно снять 142 Вт мощности. Тогда количество необходимых ребер 3600/142=25шт. В ширину 120мм вполне возможно уместить такое количество. Видим, что коэффициент конвективной теплоотдачи и площадь ребер радиатора не должны быть лимитирующим фактором для подобных конструкций.

Итак, что мы видим по итогу данных рассуждений:

1) Получить перепад температур в 35°С при использовании алюминиевых радиаторов сложно, наиболее реально это при условии непосредственного расположения радиаторов на тепловыделяющих компонентах. Т.к. перепад температур по конструкции должен получаться не более 10°С, а это довольно мало, если использовать конструкцию, которая должна собрать тепло от многих модулей в один радиатор. Но эту конструкцию мы все равно рассмотрим, т.к. она будет отправной точкой для конструкций с водяным охлаждением и будет иметь другие не очевидные преимущества.

2) Самым лимитирующим фактором является высота ребер алюминиевого радиатора. Т.е. для выбранного форм-фактора радиатора едва получается обеспечить нужный перепад температур по ребрам. По-хорошему надо увеличивать ширину радиатора, чтобы уменьшить высоту, что в свою очередь приведет к раздуванию объема оборудования. Либо необходимо кардинально увеличить теплопроводность ребер.

Далее от общих рассуждений перейдем к рассмотрению различных вариантов конструкций. И начнем с конструкции модуля.

5. Конструкция модуля

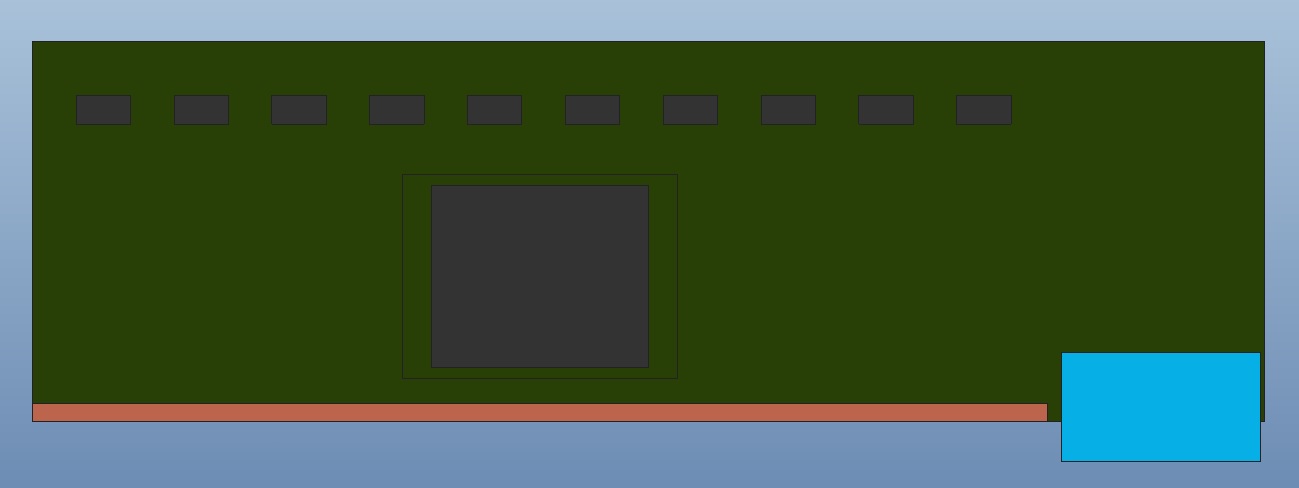

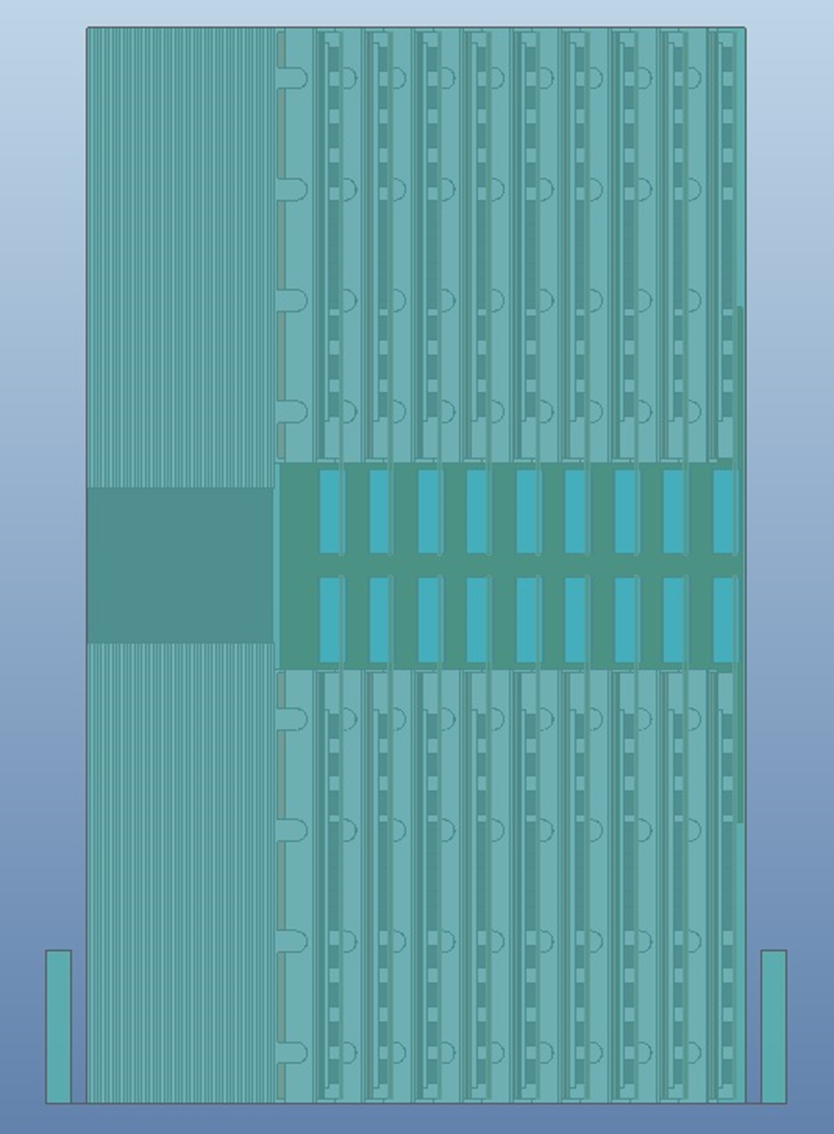

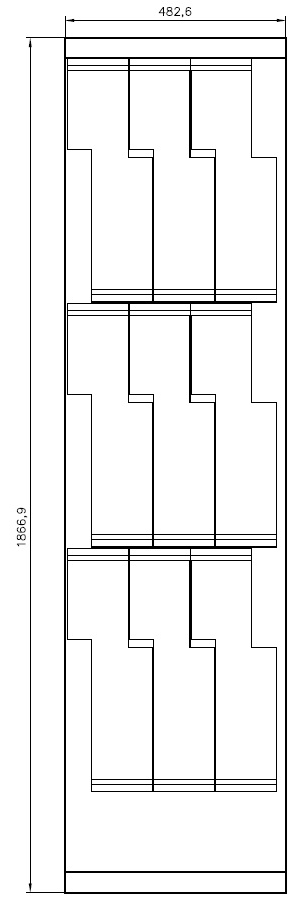

Как мы уже говорили ранее, модуль представляет собой печатную плату с одним процессором. Исходя из высоты оборудования 3U и глубины 700мм, можно задать размер печатной платы 340x105 мм. Вид печатной платы представлен на рисунке.

В центре расположен процессор, который был выбран ранее Intel Xeon Gold 5220R габаритными размерами 60×50мм, это примерные размеры верхней крышки процессора, а не самого корпуса, т.к. для теплоотвода важна только эта площадь. Сверху ряд компонентов размером 15×8мм, которыми условно обозначены прочие тепловыделяющие компоненты. Справа снизу расположен кросс‑платный разъем, который смотрит «вниз». Вопрос о том, почему он расположен именно так, пока оставим. Эта плата, как уже упоминалось выше, — по сути, тепловая нагрузка, без привязки к какому‑либо электрическому дизайну, но тем не менее пара слов о том почему выбрана такая «архитектура» оборудования. А именно кросс‑плата с разъемами, в которую могут «втыкаться» различные активные модули. С точки зрения конструктора такая «архитектура» дает преимущество по сравнению с обычной конструкцией серверов: материнская плата с несколькими процессорами, в которую втыкаются «райзеры». Это возможность реализовать «горячую» замену/апгрейд любого процессора, SSD‑диска, видеокарты и т. п. без разборки оборудования. т. е. любой модуль может доставаться с лицевой, либо задней панели оборудования. Современная «соединительная» промышленность предлагает кросс‑платные разъемы (для «слепого» монтажа) с любыми типами контактов: высокоскоростные, силовые, ВЧ и т. д. и очень высокой плотности. Для примера можно использовать разъемы samtec xcede. Для использованной ширины 55мм в такой разъем можно вместить порядка 300 высокоскоростных контактов и блок силовых контактов 6шт. по 10А каждый. т. е. задача связи нескольких процессоров или памяти с процессорами представляется решаемой. Единственное, что смущает — это возможная длина связи между различными модулями, которая может получится в районе 1м. Также с точки зрения конструкции — это наиболее сложная «архитектура». Почти любая конструкция, где мы соберем несколько модулей в блоки и будем обеспечивать только горячую замену блоками будет проще. Конечно, можно придумать более сложные конструкции из блоков, но в общем вышеприведенное утверждение будет верно. Чем сильнее мы разбиваем конструкцию на мелкие элементы замены, тем она сложнее. Далее рассмотрим тепловыделение элементов модуля.

Общее тепловыделение принято равным 200Вт и оно распределяется следующим образом:

Процессор – 150Вт

10 «прочих» тепловыделяющих компонентов по 4Вт каждый, всего 40Вт.

Остальные 10Вт равномерно распределены по объему печатной платы и учитывают прочие мелкие тепловыделения в резисторах, индуктивностях, проводниках и т.п.

Далее возможны два принципиально разных варианта конструкции модуля, по крайней мере, я так вижу принципиальную разницу.

Тепло будет сниматься с одной из «сторон» модуля для последующей «передачи» тепла с нескольких модулей на общий радиатор.

Тепло будет сниматься непосредственно с радиатора, расположенного на модуле.

Конструкции типа 2) лучше подходят для воздушного охлаждения. Воздух обладает низкой плотностью и соответственно очень низкой теплоемкостью в пересчете на объем. Поэтому попытка собирать тепло на один радиатор от нескольких модулей приводит к высоким скоростям потока. А также при воздушном охлаждении у нас есть дополнительный которого фактически нет в случае водяного охлаждения. Конечно, можно попробовать подключать к радиаторам воздуховоды с повышенным давлением, но вряд ли это будет экономически оправдано. Соответственно, конструкции модулей типа 1) больше подходят для водяного охлаждения, т.к. вода позволяет реализовать принципиально другие плотности теплопередачи и такие конструкции позволят ужимать объем оборудования и также создавать конструкции, у которых будет минимальное количество водяных стыков. Но мы, как и обещали, сначала пойдем по пути наибольшего сопротивления и посчитаем конструкцию сервера с воздушным охлаждением и модулями типа 1).

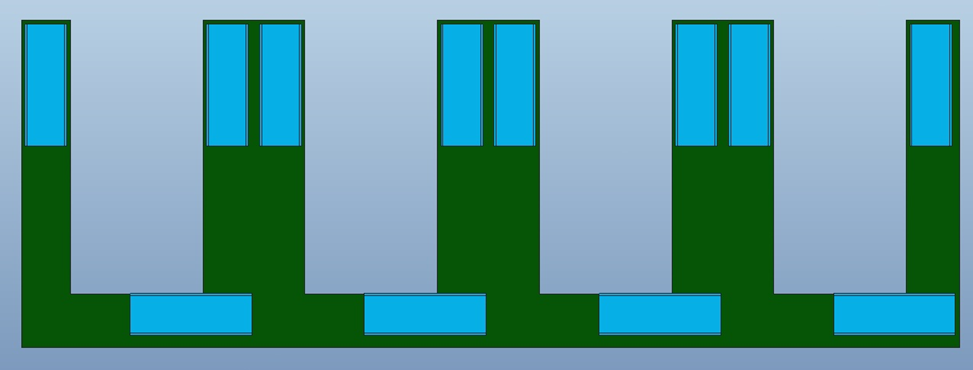

Итак, тепло с приведенной выше печатной платы будем снимать с нижней («длинной») поверхности. Низ и верх тут условен, важнее, что необходимо выбрать именно длинную сторону, т.к. короткая на первый взгляд выглядит «привлекательнее», но чтобы снимать тепло с нее необходимо повышать плотности тепловых потоков и «длину» передачи тепла, что сильно затрудняет задачу. Итак, нижняя поверхность – это та, где расположен кросс-платный разъем.

С торца платы снять тепло невозможно, поэтому необходимо ставить на печатную плату некий радиатор, который будет снимать тепло с крышек компонентов, а также тепло, выделяющееся непосредственно в печатной плате, и передавать его на плиту, которая соберет тепло от нескольких модулей. Также тепловой поток придется «развернуть» на 90°, т.к. с торца радиатора его снять не получится. И связано это с необходимостью обеспечить тепловой интерфейс между радиатором модуля и плитой. Площадь этого интерфейса должна быть сильно больше, чем площадь торца радиатора, т.к. все интерфейсы, которые будут «разборными» будут иметь не очень большую теплопроводность и для приемлемого перепада температур необходимо увеличивать их площадь, а тепловые интерфейсы, которые обеспечат идеальный тепловой контакт, типа пайки или сварки, будут неразборными. Вопрос тепловых интерфейсов мы рассмотрим позже, чтобы не перегружать рассуждения.

Сразу можно сказать, что делать радиатор из алюминия бесполезно, т.к. – перепад температуры по конструкции модуля должен быть порядка 5°, т.к. 15+10° из общего перепада мы уже «забронировали» ранее, а есть еще плита, в которой тоже будет

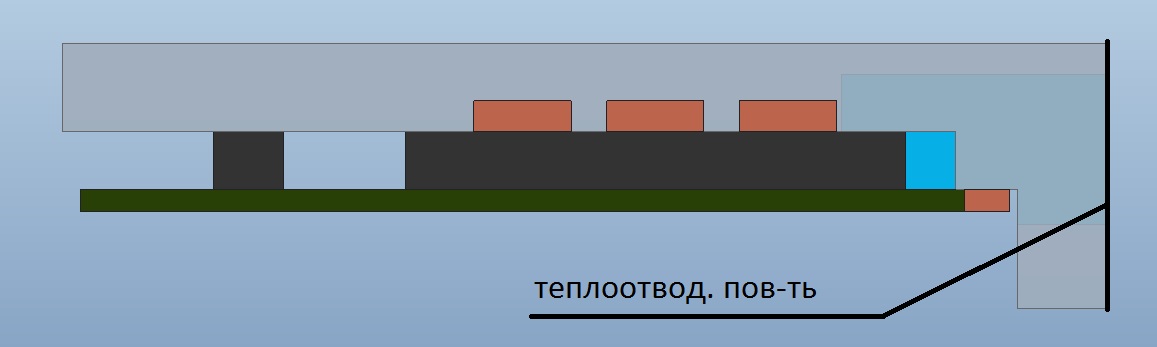

а еще перепады температур на упомянутых тепловых интерфейсах. Попробуем для начала добавить в алюминиевый радиатор тепловые трубы (далее ТТ). Довольно простое и дешевое решение. Общий вид такого радиатора представлен на рисунке.

Алюминиевая часть представляет из себя уголок толщиной 10мм. Высота всех компонентов на печатной плате для простоты взята одинаковой, для разной высоты можно делать локальные утолщения (бобышки) на радиаторе. Эти бобышки могут добавить 1-2° перегрева компоненту при значительной толщине в несколько мм. Принцип должен быть такой, что самый тепловыделяющий элемент (процессор) или самый перегревающийся, должен контактировать непосредственно с радиатором, а прочие через бобышки. То же касается толщин тепловых интерфейсов, т.е. радиатор должен прижиматься к самому тепловыделяющему компоненту и обеспечить с ним минимальную толщину теплового интерфейса), но пока не будем углубляться в этот вопрос. Вид сбоку представлен на рисунке

Площадь теплоотводящей поверхности будет 280x30мм. Три ТТ проложены вдоль длинной стороны радиаторы. Их цель распределить общее тепло процессора на всю длину радиатора. В данном случае перепад температуры по радиатору (как по твердому телу) будет условно складывать из двух составляющих. Перепад сверху вниз, от процессора, и перепад вбок вдоль длинной стороны. Т.е. тепло не будет распространяться вертикально вниз, оно будет также растекаться вдоль. И чем сильнее оно растечётся вдоль, тем больше будет общая площадь сечения «задействованная» для передачи тепла вниз. Чтобы задействовать всю площадь сечения можно использовать ТТ проложенные таким образом.

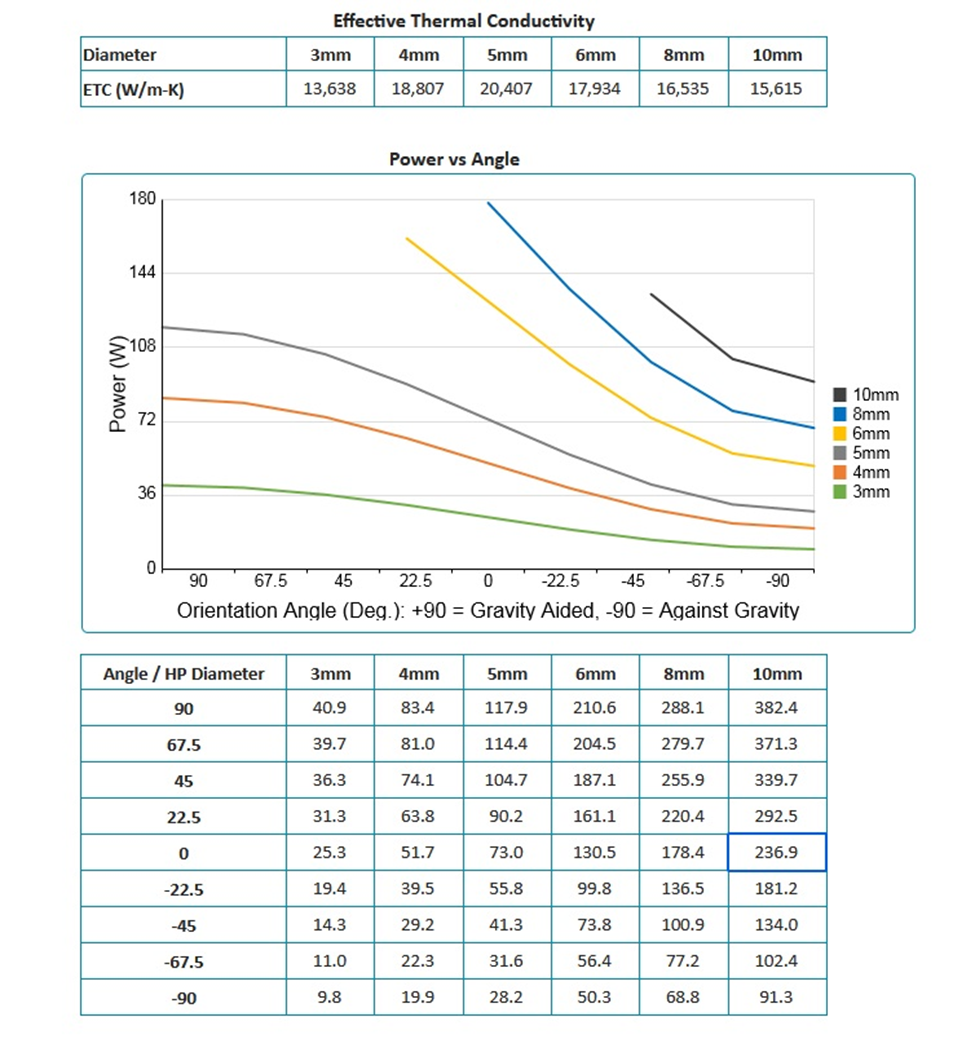

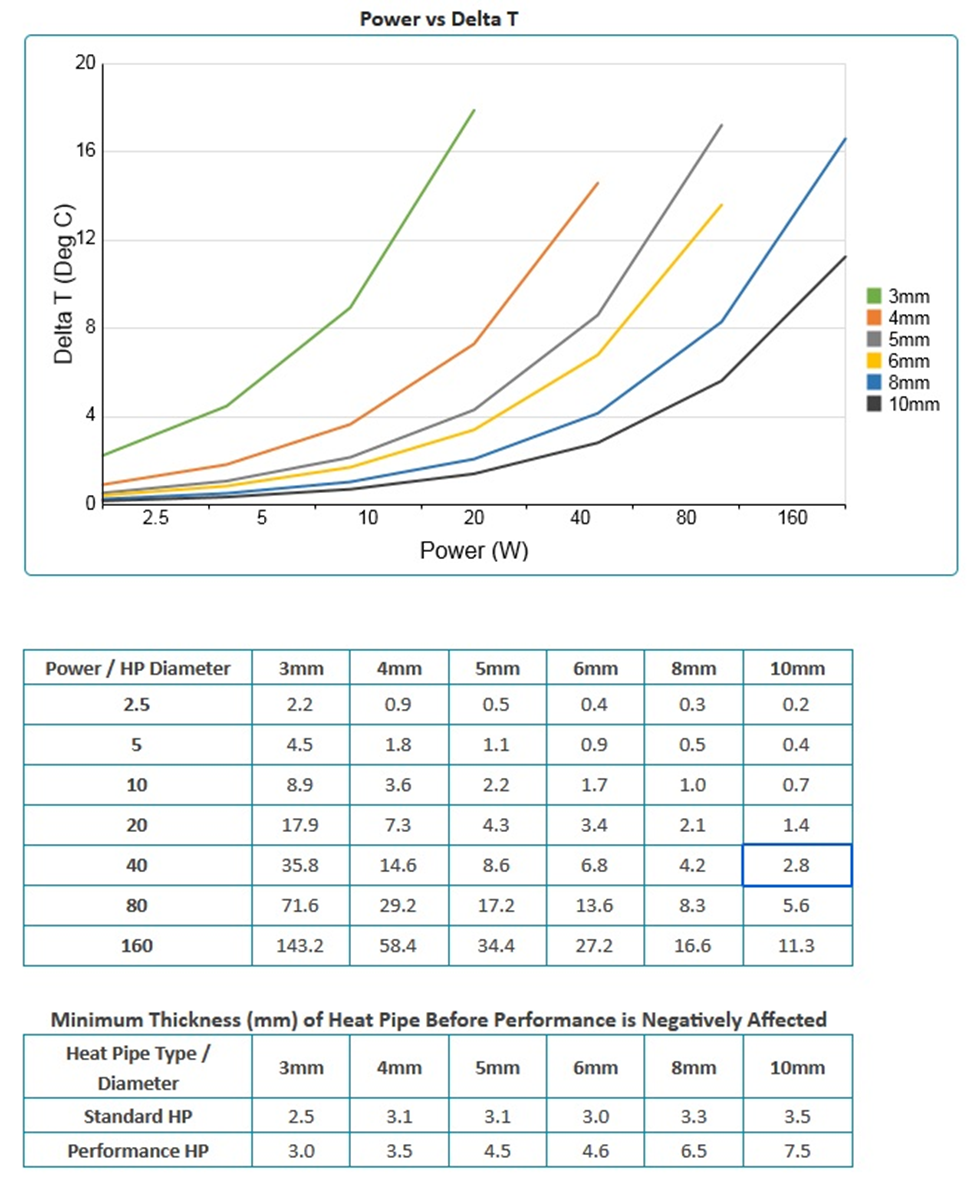

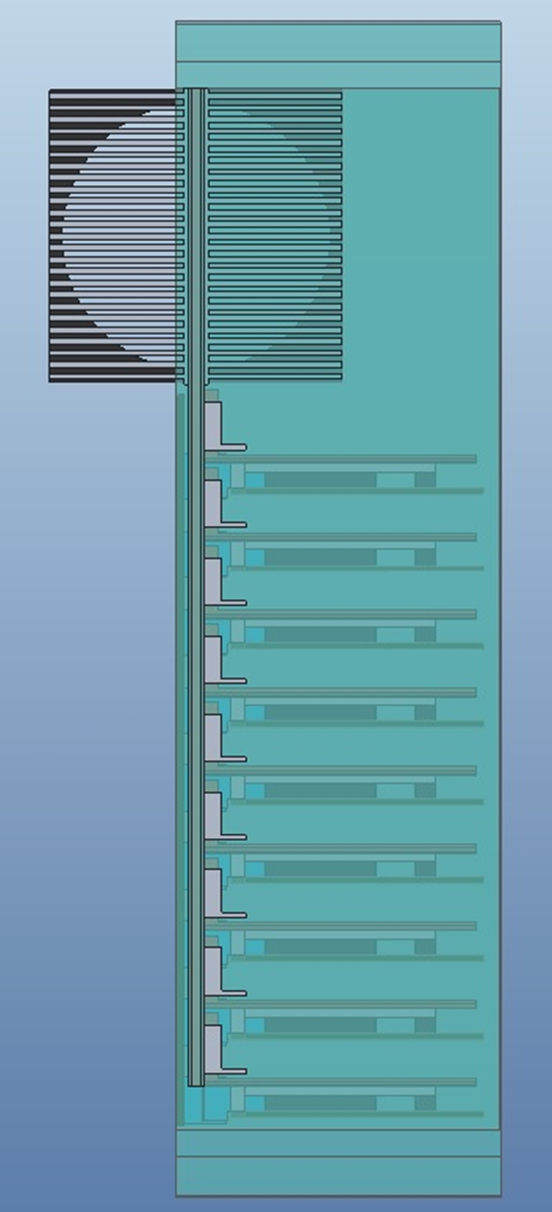

Для моделирования ТТ воспользуемся калькулятором производителя. В частности этим https://celsiainc.com/resources/calculators/heat-pipe-calculator/. Т.к. в данном случае у нас один испаритель и два конденсатора, источник тепла расположен ровно посередине, то можно разбить ТТ на два одинаковых куска, у которых испаритель равен половине длины процессора, а конденсатор половине длины радиатора за вычетом длины процессора. Введем следующие параметры в калькулятор: длину ТТ – 140мм, длину испарителя – 30мм, длину конденсатора – 100мм (оставим небольшой запас 10мм). Тип ТТ стандартная, температуру эксплуатации 60°. Получаем следующие результаты, ниже на рисунках.

На рис.5 мы видим эквивалентную теплопроводность ТТ, будем использовать ТТ диаметром 10мм. Вт/м*К. Следующий график – зависимость передаваемой мощности от угла ориентации ТТ относительно силы гравитации. В том случае, если конденсатор ТТ расположен над испарителем сила тяжести будет помогать конденсированному теплоносителю стекать вниз к источнику тепла. Если наоборот, то будет мешать и силы поверхностного натяжения должны преодолевать силу тяжести, чтобы фитиль мог смачиваться. От ориентации кардинально зависит передаваемая мощность. В данном случае угол равен 0°, ТТ расположены параллельно земле. Нам нужна передаваемая мощность на одну ТТ – 50Вт. Рекомендуется брать эту мощность с запасом 20-25%. В данном случае легко проходим. Следующий график – это зависимость перепада температур от мощности и соответствующая таблица. В нашем случае температура будет лежать между 2,8° и 5,6°. Судя по цифрам зависимость линейная, поэтому мощности 50Вт будем соответствовать перепад температуры 3,5°. С другой стороны можно посчитать этот перепад исходя из приведенной выше

и площади сечения ТТ диаметром 10мм по той же формуле, что использовалась для расчета перепада температуры по длине ребра радиатора.

Длина пути считалась по формуле половина длины испарителя плюс половина длины конденсатора плюс запас 10мм. По тому же принципу, который использовался для расчета перепада температуры по длине ребра радиатора. Результат получился несколько отличным от таблицы. Без консультации с производителем сложно сказать, в чем причина. В данном случае просто упростим себе жизнь и в модели используем уменьшенную теплопроводность=13607 Вт/м*К

Также в последней таблице мы видим допустимую толщину для сплющивания тепловой трубы. В данном случае удобнее использовать сплющенные ТТ, будем их моделировать прямоугольником 4x10мм. Площадь этого прямоугольника почти в два раза меньше, чем площадь круга диаметром 10мм, что в данном случае делать с теплопроводностью не совсем ясно, предположим худшее и оставим ее такой же, как для круглой ТТ.

Тепловые интерфейсы между элементами модели зададим следующим образом (пока без пояснений, чтобы не перегружать рассуждения. Проблему тепловых интерфейсов рассмотрим позже).

Радиатор – крышка процессора и ТТ – крышка процессора – 40000 Вт/м2*К.

Радиатор – крышка прочих тепловыделяющих компонентов – 6000 Вт/м2*К.

ТТ – радиатор – объединяющий интерфейс, будем считать, что ТТ припаяны к радиатору.

Нижняя поверхность процессора – печатная плата – 500 Вт/м2*К, будем считать, что процессор установлен в сокет, т.е. тепловой интерфейс между его контактами и печатной платой будет плохой.

Нижняя поверхность тепловыделяющих компонентов – печатная плата – 8000 Вт/м2*К, будем считать, что это BGA – компоненты.

Радиатор – печатная плата – 10000 Вт/м2*К.

Теплопроводность алюминиевого радиатора 150 Вт/м*К.

Теплопроводность печатной платы анизотропная 0,4 Вт/м*К перпендикулярно плоскости, 30 Вт/м*К в плоскости.

Температура нижней поверхности (контактирующей с плитой) 70°С.

Запустим расчет и посмотрим, что получается.

Результат неудовлетворительный. Температура корпуса процессора получилась 90°С, температура корпусов прочих компонентов 93,7°С. Т.е. вместо мы получили 20-25°С. По итогу можно сказать, что для получения требуемой

требуется передавать тепло исключительно ТТ, любые теплопередачи через значительные длины твердых тел приводят к недопустимому перепаду температур. Есть два пути:

Использовать гнутые ТТ, у которых конденсатор будет проходить по нижней поверхности радиатора. Более дешевое решение, но с ним возникает ряд конструктивных проблем: теплоотвода от прочих компонентов, расположенных вне зоны, где проложены ТТ, габаритов модуля из-за радиуса изгиба ТТ и т.п.

Можно применить испарительную камеру (vapor chamber). Более универсальное и несколько более дорогое решение. По принципу действия испарительная камера (далее ИК) и ТТ не отличаются. Различия только в конструктивном исполнении. Далее будем применять ИК. Но конечно, в зависимости от типа модуля и его реального тепловыделения можно применить и радиатор с изогнутыми тепловыми трубами.

Моделировать ИК по тому же принципу не получится. Моделировать их в виде твердых тел с очень большой теплопроводностью не совсем верно и не понятно какую брать теплопроводность. По современным представлениям выделяют следующие тепловые сопротивления в такой двухфазной системе. Передача тепла через стенку ИК, далее через толщину пористого фитиля, который с точки зрения моделирования можно представить, как медь, но с уменьшенной в несколько раз ???? (теплопроводность через воду, которая заполняет поры фитиля можно не учитывать). Толщина будет считаться до границы раздела фаз между водой и паром, которая проходит где-то внутри фитиля. Далее необходимо учесть скачок температуры на границах раздела фаз.

По поводу скачка на границе раздела фаз

Согласно последним тенденциям в расчете двухфазных систем охлаждения температура на границе раздела фаз не константа, как вроде бы должно быть. Физику это явления я пока не понял, а просто посчитал теплопроводности элементов ИК по предложенной методике. Для желающих углубиться можно поизучать например эту статью:

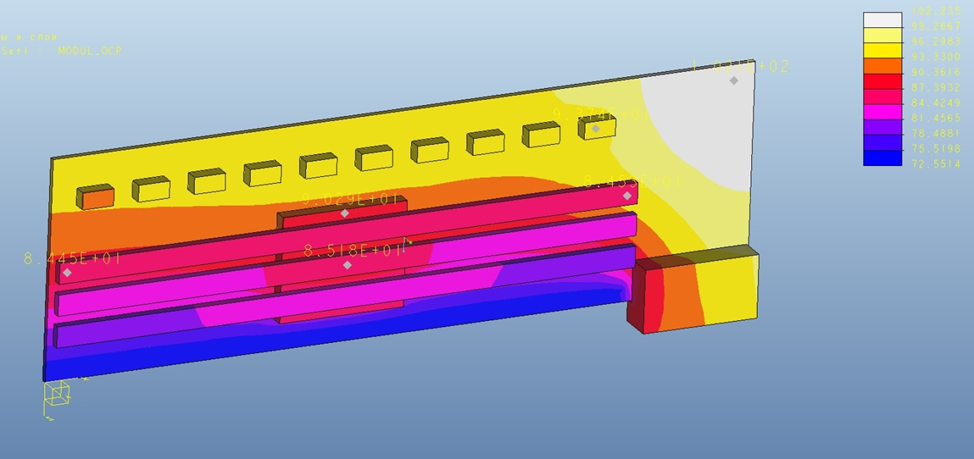

Теплопередачу через паровой канал и в обратную сторону на стороне конденсатора. Т.е. если не моделировать процессы в ТТ напрямую с кипением и конденсацией жидкости, то необходимо использовать для моделирования несколько твердых тел с разной теплопроводностью, в том числе с анизотропной. Вопросы расчета этих теплопроводностей рассмотрим позже. Вид модуля с ИК представлен на рисунке.

По сравнению с предыдущим вариантом вместо радиатора в виде уголка у нас появилась ИК в виде уголка. ИК не обязательно должны быть плоскими, возможны Г-образные и П-образные формы. ИК состоит из одной плоской детали из листа и другой детали в виде штампованной из листа «ванночки» с ободком. По ободку две половинки могут быть сварены/спаяны/склеены. Внутри «ванночки» расположен фитиль и поддерживающие структуры. Собственно, можно реализовать форму, которая позволяет штамповка и гибка. Конечно, можно реализовать и сложную пространственную структуру, просто это будет значительно дороже. К ИК приклеены две алюминиевые детали. Первая – это рамка, которая необходима для реализации крепежных отверстий и «бобышек» для компенсации разновысотности компонентов на плате. Эта рамка должна быть приклеена к ИК теплопроводным клеем или припаяна. Наверное, можно реализовать бобышки и крепежные отверстия на самой ИК, вопрос в том, что будет дешевле и проще с технологической точки зрения. Ответить на него сходу тяжело, для расчета будет хуже вариант с дополнительной рамкой, поэтому считаем его. Вторая алюминиевая деталь – это элемент жёсткости, который необходим, чтобы прижимать конденсатор ИК к плите. Необходимо значительное давление, чтобы реализовать хороший термоинтерфейс и скорее всего прижимать ИК напрямую нельзя, т.к. это может ее повредить. Вид сбоку с пояснениями показан на рисунке.

Расположение модуля будет именно как на данном рисунке, т.е. плоскость платы параллельно земле (перпендикулярно силе тяжести), расположение зоны конденсации вдоль направления силы тяжести. Для работы тепловой трубы хорошо, когда конденсатор расположен над испарителем, в данном случае площадь зоны конденсации не очень большая, поэтому хорошо, если она будет работать в оптимальном режиме. На рисунке также отмечены три структуры, которые моделируются разными деталями. Стенка ИК толщиной 0,5мм, материал медь, фитиль толщиной 1,5мм – пористая структура из меди с λ=40 Вт/м*К. Паровой канал толщиной 1,5мм с λ=2*10^6 Вт/м•К. В зоне конденсации фитиль отсутствует, т.к. по идее он там не нужен, конденсированная вода будет стекать под действием силы тяжести. Толщины фитиля и парового канал выбраны немного «с потолка», но судя по реально существующим конструкциям этого должно быть достаточно с запасом.

Тепловыделения на элементах те же самые.

Добавились новые термоинтерфейсы (опять же пока без пояснений).

Алюминиевая рамка – ИК – объединяющий тепловой интерфейс, будем считать, что рамка паяется к ИК низкотемпературным припоем, алюминиевый элемент жесткости – ИК – 16000 Вт/м2•К (приклейка теплопроводным клеем).

Фитиль – паровой канал и паровой канал – стенка ИК – 22500 Вт/м2•К.

Смотрим, что получается.

И для наглядности температуры только ИК

В итоге, мы видим, что перепад температур по ИК будет в районе 5°С. Т.е. получить общий перепад по модулю в районе 5°С никак не получится. Если мы правильно организуем все термоинтерфейсы и используем современные материалы, то получим температуры компонентов 78-79°С. Можно попробовать выиграть еще пару градусов, используя медь, а не алюминий, но это уже не очень технологично. Пока остановимся на данном результате. И перейдем к моделированию остальной части конструкции.

6. Конструкция оборудования с воздушным охлаждением и общим радиатором

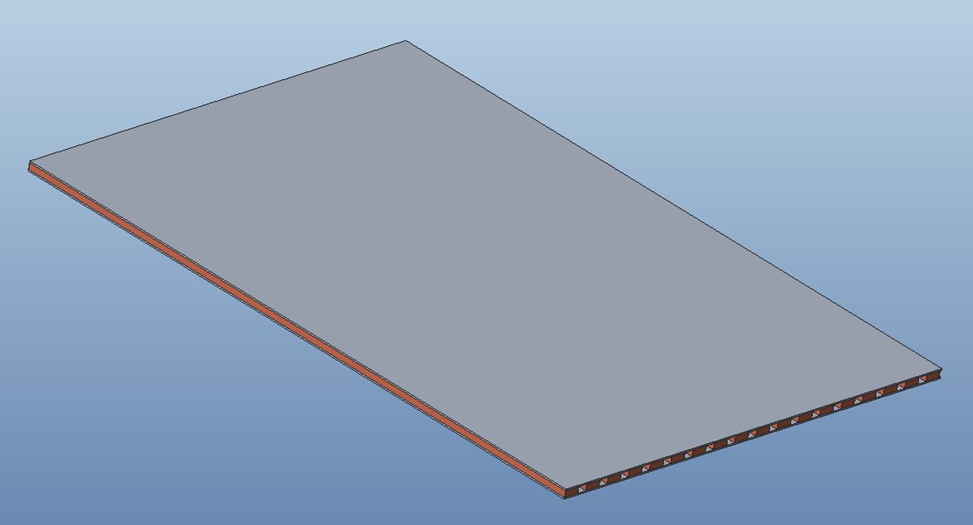

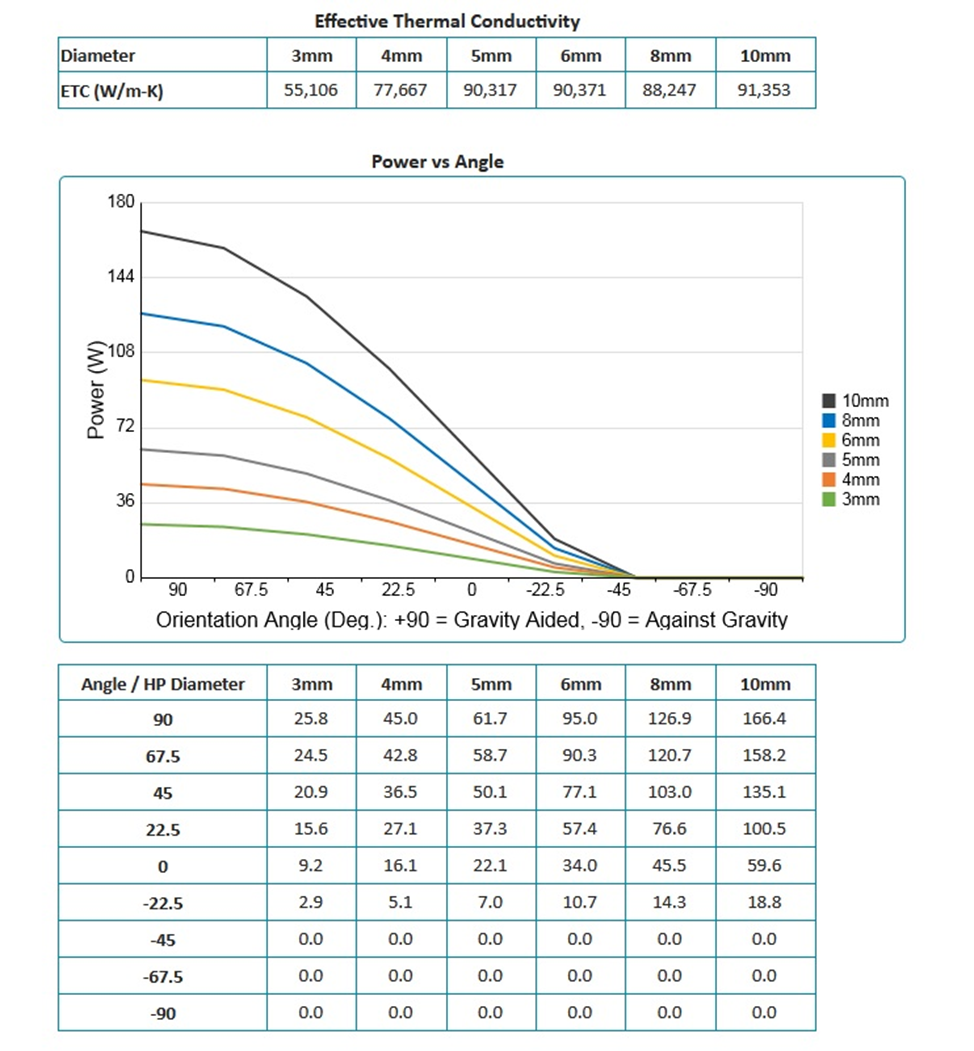

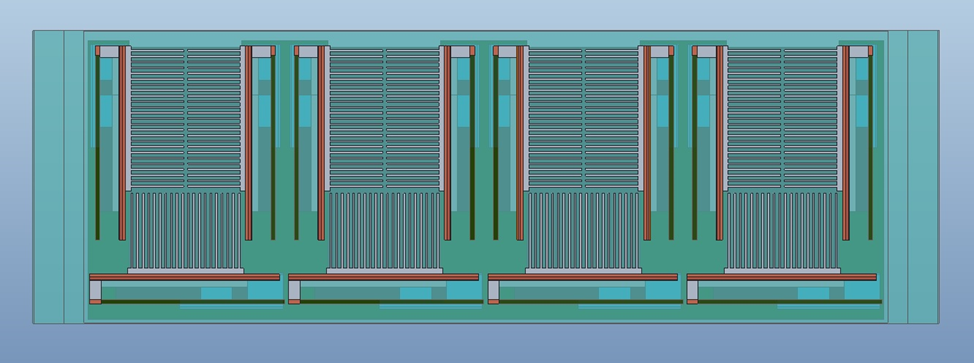

Итак, если мы хотим собрать тепловыделение нескольких модулей и передать его на общий радиатор, то понадобится плита с высокой теплопроводностью. Если рассматривать только пассивные устройства, то варианты опять те же тепловые трубы и испарительная камера. Т.к. тепловые трубы считаются более дешевым вариантом, то рассмотрим его. Хотя в данном случае можно использовать термосифон, т.к. устройство придется расположить вертикально и вполне возможно, что термосифон будет дешевле. Пока рассмотрим плиту с ТТ. Она будет выглядеть примерно так:

Два алюминиевых листа толщиной 1мм, между которыми вклеены, а лучше впаяны ТТ (сечение ТТ в расчетной модели 4x10мм). Всего 18 на половину сервера.

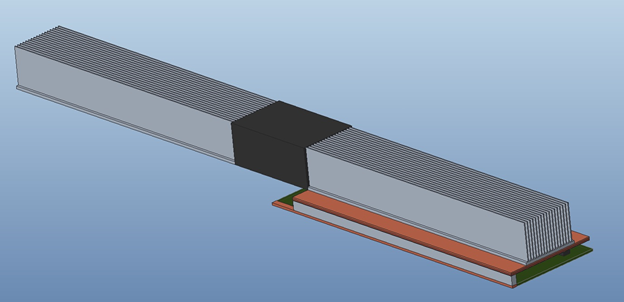

Общий вид сервера представлен на рисунке.

Вид сверху

В стойке сервер должен быть расположен, как указано на рисунке, т.е. вертикально. Всего в устройстве 18 модулей, девять в каждой половине. Общая глубина устройства 700мм, высота 3U. Общее тепловыделение 2•9•200=3600Вт. Вентилятор 120x120мм глубиной 100мм расположен в центре радиатора.

Введем следующие параметры ТТ в калькулятор: длину – 408мм, длину испарителя – 286мм, длину конденсатора – 120мм. Тип ТТ стандартная, температура эксплуатации 60°. Получаем следующие результаты, ниже на рисунках.

В данном случае мы видим, что из-за большой длины ТТ она уже не сможет работать против силы тяжести, т.е. если испаритель находится над конденсатором, то передаваемая мощность 0. Если ТТ расположена горизонтально, то передаваемая мощность 60Вт, что при 18 ТТ на плиту будет недостаточно. Если же расположить плиту вертикально, когда радиатор расположен вверху, то передаваемая мощность 166Вт. Достаточно с необходимым запасом. Перепад температуры по таблице при 100Вт передаваемой мощности равен 3,275°С. По той же методике, что и раньше вычислим теплопроводность ТТ для моделирования. Получим Вт/м*К

Перед тем, как перейти к моделированию, пара слов о расположении радиатора. Т.к. необходимо расположить источник тепла в середине ребер, он будет не эстетично торчать влево на 60мм, соответственно крайний левый сервер в стойке будет съедать порядка 70мм пустого пространства. В данном случае опять же вижу два варианта: кардинально увеличить теплопроводность ребер, чтобы расположить источник тепла с краю. Например, использовать медь, либо материалы типа теплопроводных графитовых пленок, но с ними тоже много вопросов. Второй вариант – использовать изогнутую форму плиты, но тогда изгиб «съест» достаточно много места внутри сервера по вертикали, т.к. радиус изгиба ТТ или термосифона должен быть порядка 3-5 толщин, а также нежелательно делать изгиб под 90°, как уже говорилось ранее это может сильно снизить общую передаваемую мощность. В общем, оба варианта имеют серьезные издержки. Пока посчитаем указанный вариант. Чтобы не перегружать расчет будем моделировать один модуль в задней части с 1/9 части радиатора. В передней части добавим нагрузку мощностью 200Вт. В радиаторе заложено 27 ребер в каждой половинке, соответственно можно оставить 6 ребер с одной стороны. Расчетная модель представлена на рисунке. Направление потока воздуха на «нас». Теплопроводность ТТ в плите уменьшена в 4,5 раза, чтобы учесть уменьшение мощности.

Также добавим несколько тепловых интерфейсов в модель.

ТТ – алюминиевые панели плиты – объединяющий интерфейс, считаем что они паяются низкотемпературным припоем.

Стенка ИК – плита – 10000 Вт/м2*К.

Радиаторы – плита – 26600 Вт/м2*К.

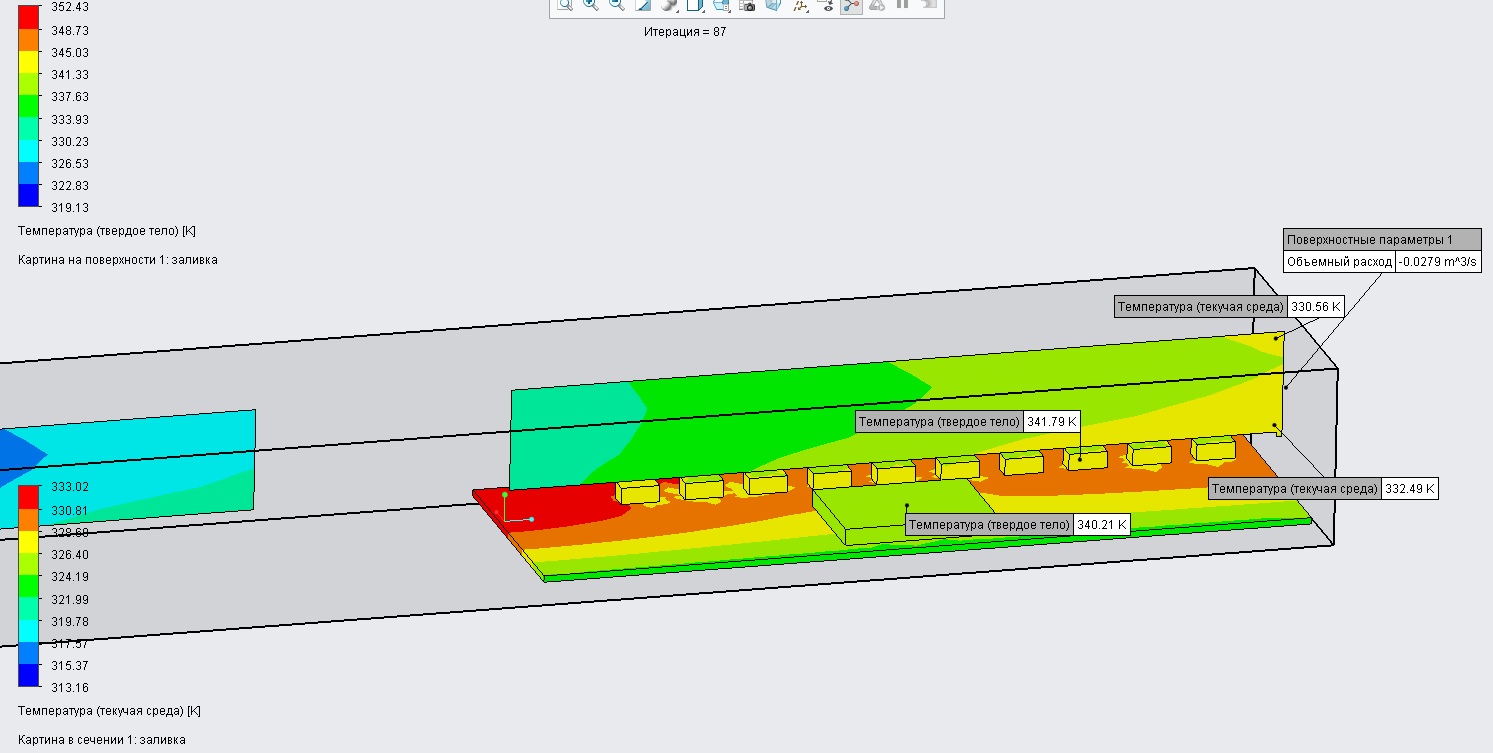

Расчетная модель показана на рисунке.

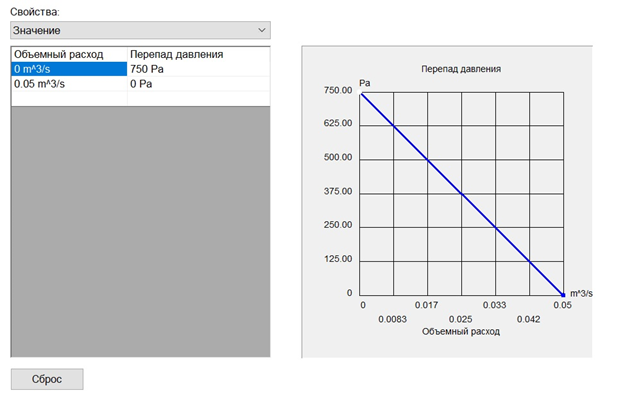

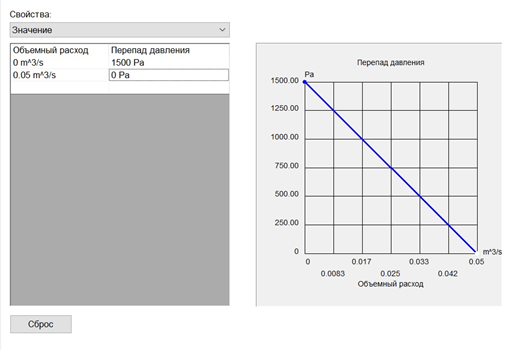

Также приведем характеристику использованного в расчете внутреннего вентилятора.

Т.к. задается мощность 1/9 от номинальной, то в расчете используем 1/9 часть вентилятора. Т.е. берем максимальный расход 0,05м3/с = 0,45×1/9. Характеристику пока возьмем линейную. И попробуем посчитать, что получилось.

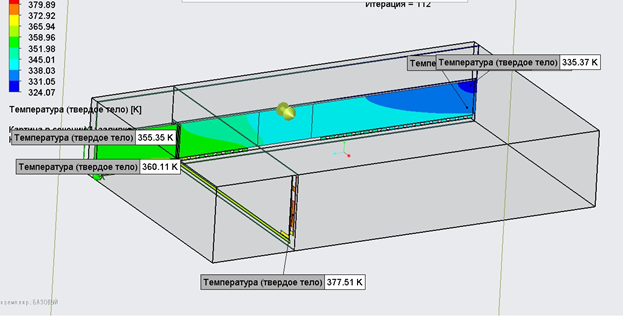

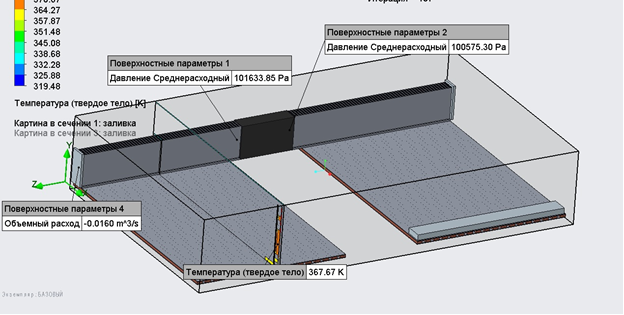

На рисунке приведены температуры в сечении, проходящем через процессор и в сечении вдоль ребра радиатора.

И температура воздуха в пространстве между ребрами радиатора.

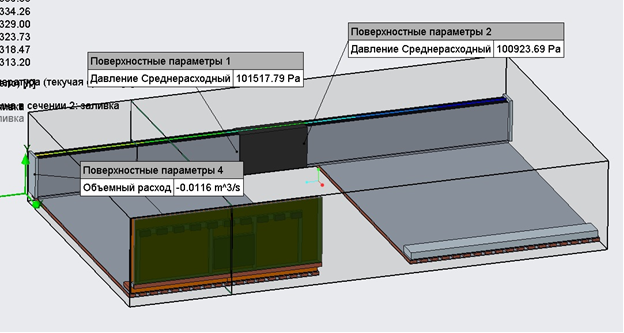

Результат получился неудовлетворительным, температура процессора 104℃. Причина в данном случае в большом аэродинамическом сопротивлении радиатора и соответственно низком расходе вентилятора. Цифры приведены ниже на рисунке.

Видим, что разница давлений, которую создает вентилятор, равна примерно 600Па, что находится на пределе его возможностей. И расход 0,0116м3/с более чем в два раза ниже ожидаемого 0,025м3/с (половина от максимума). И также перепад температур по ребрам радиатора тоже больше ожидаемого, что видимо, является следствием низких скоростей потока (порядка 12м/с при ожидаемой 30м/с) и плохой теплоотдачи. Т.к. раздувать габариты радиатора нежелательно попробуем для начала «улучшить» вентилятор. Если посмотреть «серверные» вентиляторы типоразмеров 40x40 и толщиной от 28 до 56мм, то среди них есть модели с давлением до 2200 Па, у самых высоконапорных. Но их мощность на единицу расхода будет выше. Т.е. если мы возьмем вентилятор с тем же максимальных расходом, но давлением до 1500Па, то его мощность вырастет примерно в 1,5 раза. Т.е. на 3,6кВт мощность вентилятора будет 450Вт. Характеристика представлена на рисунке.

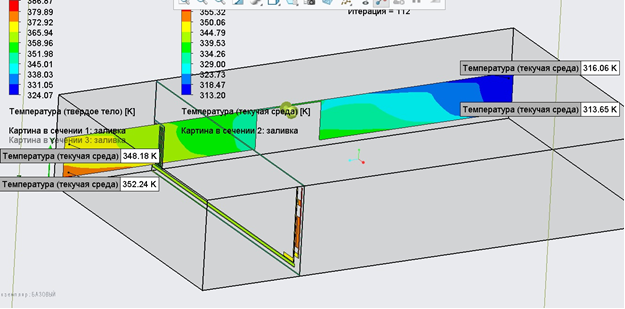

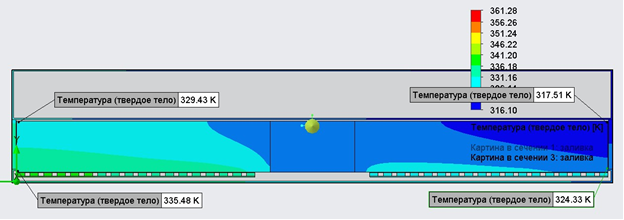

Результаты расчета в том же формате.

Температура процессора 95℃. Расход вырос до 0,0160м3/с, но не в два раза как ожидалось. К сожалению, при росте скорости потока выросло и сопротивление радиатора, видно, что перепад давлений, создаваемый вентилятором уже 1060 Па. К сожалению, придется раздувать габариты радиатора, увеличивая промежутки между ребрами. В исходной модели ребра толщиной 2мм, с промежутком 2мм. Увеличивая промежуток до 4мм, мы увеличиваем ширину радиатора в 1,5 раза.

И также, чтобы не проходить лишние итерации, сразу улучшим характеристику вентилятора, судя по тому, что предлагается в продаже, кривая вентилятора может быть более пологая в области высоких перепадов давлений, но его мощность соответственно будет еще выше. Приведем улучшенную характеристику вентилятора.

Мощность данного вентилятора оценим уже в 600Вт. И посмотрим на результаты расчета.

Получаем температуру 82℃. При этом расход воздуха 0,0327м3/с > 0,025м3/с, который требовался по предварительным расчетам. Помимо увеличения промежутков, небольшой эффект также дает увеличение количества ребер, т.е. используем 12 ребер толщиной 1 мм, с промежутком 2мм.

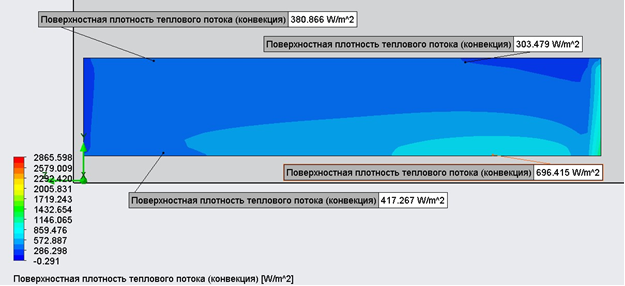

Расход при этом падает, но температура немного снижается до 353К или же 80°С. Температура воздуха на выходе 52-57°С. Очень близко к тому, что хотелось. Далее вопрос будет лишь в том, насколько нам нужны следующие 5°С. За них придется платить дальнейшим ростом мощности вентилятора, либо использованием других материалов радиатора, либо увеличением его габаритов. Также упомянем, но ничего не будем делать с тем фактом, что мы не учли в расчете тепловую мощность самого вентилятора. Очевидно, что не вся энергия перейдет в энергию потока воздуха и часть ее будет рассеиваться там же на вентиляторе. Т.е. сам вентилятор будет слегка подогревать поток воздуха.

Ради интереса приведем перепады температур по различным элементам конструкции, согласно расчету МКЭ и сравним с тем, что анализировали в разделе 4. Выделим 4 составляющих:

– перепад температуры воздуха, 12-17℃

– перепад по ребрам радиатора, 7-6℃

– перепад по плите, 7,4℃

– перепад по конструкции модуля, 11,7℃

Т.е. мы видим, что перепады по ребрам и по воздуху сложно получить в таком явном виде, как в теоретических рассуждениях. Но если взять средние 14,5 + 6,5 + 7,4 + 11,7 = 40,1, то получим расчетные 80℃. И также мы видим, что перепад по воздуху такой же, как в расчете, хотя в итоге расход выше расчетного, а перепад по ребрам меньше. Большая часть тепла снимается внизу, отдача тепла не линейная. Это, например, видно по распределению плотности теплоотдачи с ребра, вниз она выше, чем вверху.

Из этого можно сделать вывод, что ребра трапециевидной формы должны давать некоторый выигрыш при той же массе. Если сделать ребра трапециевидными (ширина ребра внизу 1,5мм, вверху 0,5мм), то результат получится следующий.

Улучшение на 0.5℃, что несущественно. Понятно, что из-за уменьшения промежутка между ребрами снизу (1,5мм вместо 2мм), расход в нижней части также уменьшается. Т.е. трапециевидной формой ребер можно попробовать выиграть массу или температуру, но при росте габаритов радиатора, чтобы промежуток между ребрами в нижней части также оставался 2мм.

Также мы видим, что перепад по плите 7,4℃ достаточно велик, скорее всего мы перезаложились, т.к. все время предполагали худшее об используемых ТТ, и вполне возможно он будет меньше. И оптимальным направлением улучшения конструкции для достижения желаемой температуры мне видится уменьшение высоту ребер радиатора, либо повышение их теплопроводности.

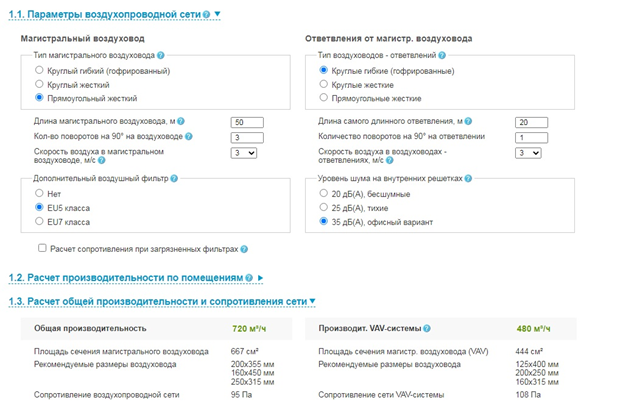

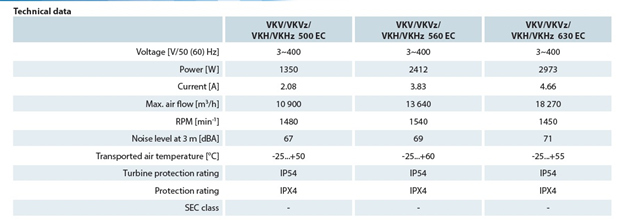

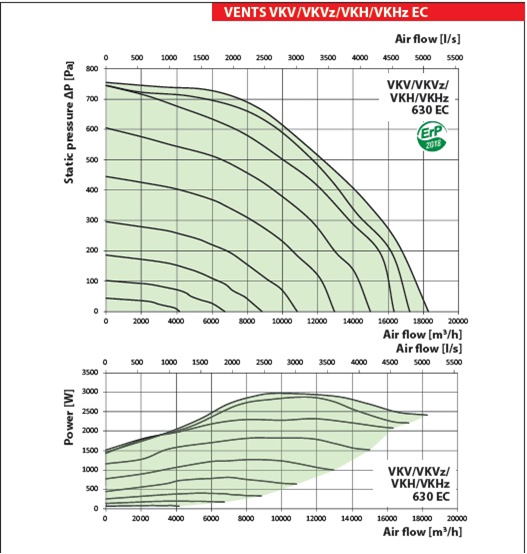

Остановимся пока на этом и попробуем оценить мощность прочих вентиляторов ЦОДа. Нам точно понадобится вентилятор, вытягивающий горячий воздух за пределы здания и возможно нагнетающий вентилятор. Есть надежда, что напор данных вентиляторов не должен быть большим. Оценим мощность вытяжного вентилятора. Для оценки напора воспользуемся он-лайн калькулятором систем вентиляции. Он дает следующие результаты сопротивления воздуховодной сети.

Всего 95 Па. И приведем характеристики мощного вентилятора для установки на крыши зданий.

Возьмем его производительность для статического давления 200 Па, т.е. 17тыс. м3/час. Его мощность при этом будет максимальной 3000Вт. Путем несложных вычислений получим, что для удаления воздуха с объемным расходом 0,261 м3/с, нам понадобится еще 166Вт мощности, округлим до 200Вт. Итак наш PUE для ЦОДа, составленного из серверов подобной конструкции будет равен 4,4/3,6=1,22. Понятно, что мы не учли прочие мощности необходимые для функционирования ЦОДа, поэтому в реальности он будет выше. Фактически, при использовании воздушного охлаждения вряд ли получится получить PUE меньше 1,2, если считать его честно. Даже за цифру 1,2 придется платить раздуванием габаритов радиаторов, чтобы снизить их аэродинамическое сопротивление. Т.е. поместить радиатор в размер 180x120x600(700)мм на 3,6 кВт отводимой мощности не получится. Тут уже вопрос, что надо оптимизировать с точки зрения экономики, вполне возможно, что выгоднее уменьшать мощность, увеличивая вес и объемы.

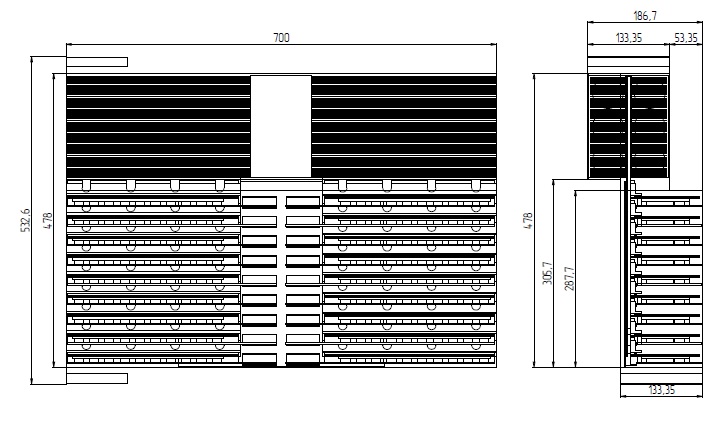

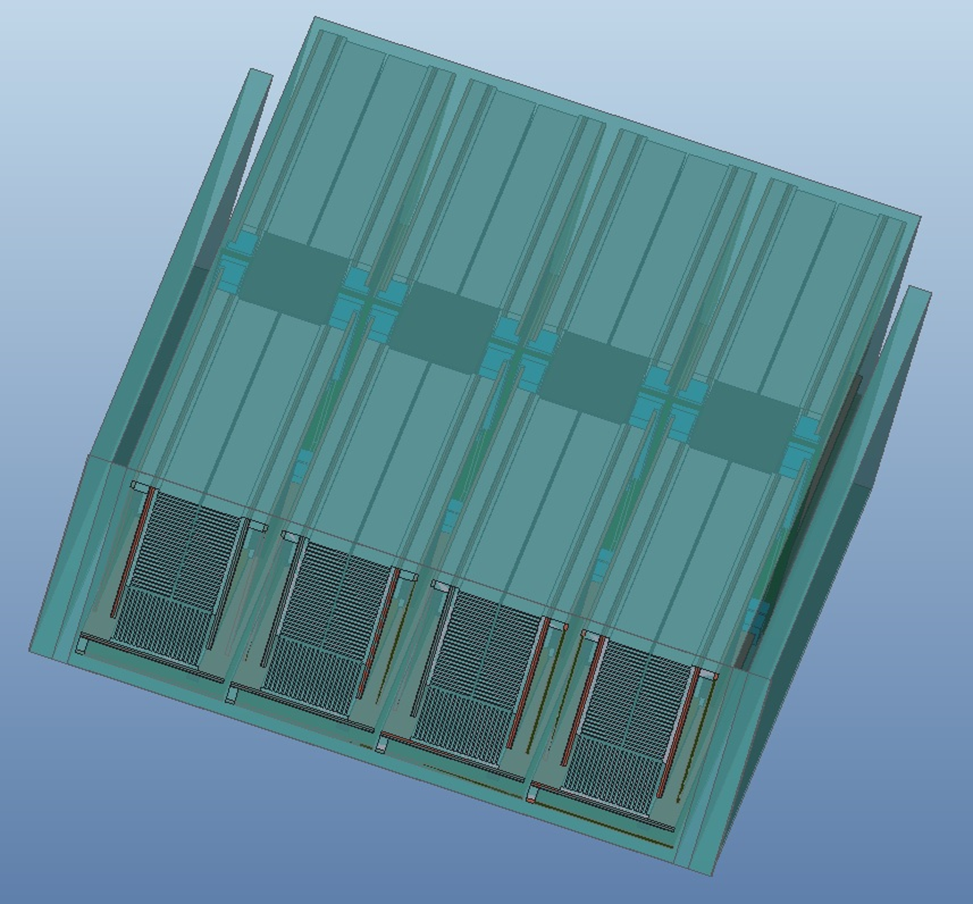

Итак, финальные габариты нашего устройства будут примерно такими:

Конечно, такая конструкция будет неудобна при размещении в стойке. Компоновка в стандартной стойке будет выглядеть примерно так.

Получилось разместить всего 9 серверов. Понятно, что можно корректировать типоразмеры оборудования и стойки, чтобы вместить, например, 10 «условных» устройств в тот же объем. И в итоге получим 3,6*10=36кВт общей мощности в стойке. Т.е. снова немного не дотянули до требований собственного ТЗ (п.1.1). Не будем на этом зацикливаться и перейдем к рассмотрению конструкций типа 1 из раздела 6, когда радиаторы будут расположены непосредственно на модулях.

7. Конструкция оборудования с воздушным охлаждением и отдельными радиаторами

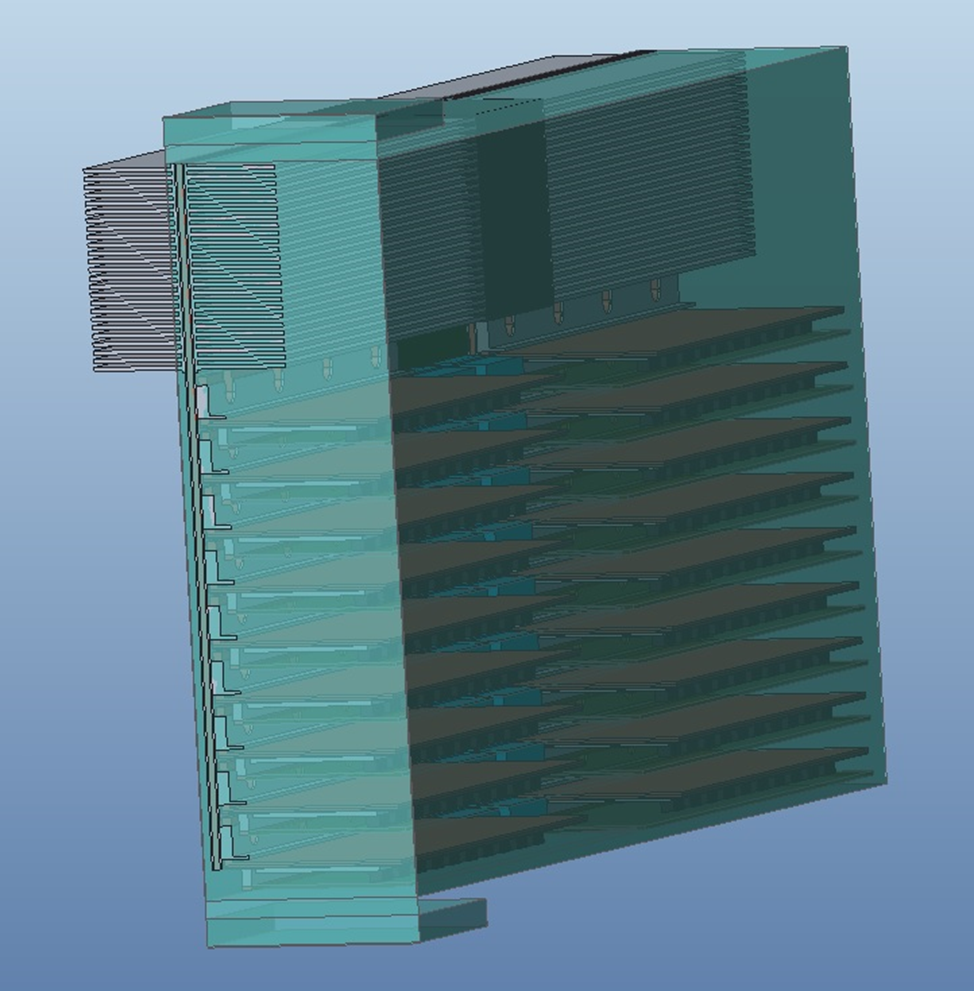

Итак, если использовать тот же типоразмер печатной платы для модулей, то наиболее логично они компонуются в сервере следующим образом.

На рисунке представлен вид со стороны передней панели (с задней будет такой же вид, только зеркальный). Расположение в стойке будет такое же, как на рисунке, т.е. стандартное, никаких «новшеств» не требуется. Высоту сервера пришлось немного увеличить до 3,5U, зато количество модулей выросло до 12x2, он располагаются своего рода блоками по 3x2шт. в каждом. На каждый блок полагается по два вентилятора типоразмером 60x60мм. На каждый модуль было выделена примерно такая же площадь радиатора, как в предыдущем варианте, но важным преимуществом является то, что высота ребер значительно снизилась до 40мм у нижнего модуля и до 28 у боковых. И понятно, что полностью уйдет составляющая . Также видим, что практически в тот же объем поместилось 12 модулей вместе 9. Связано это с тем, что для типа 1) необходимо добавлять довольно широкие полки на ИК для обеспечения площади теплового интерфейса с плитой и в устройстве получилось довольно много пустого пространства. Вопрос ширины этих полок сильно зависит от допустимых плотностей мощности в конденсаторе ИК, но вряд ли получится эту ширину значительно уменьшить. В данной конструкции такой проблемы нет. В целом, конструкция похожа на конструкцию серверов OCP типа Tioga Pass и им подобных «блочных» конструкций. Вид сверху на устройство приведен на рисунке.

В изометрии.

Существенной проблемой в данной конструкции будет кросс-плата. Ее придется расположить вертикально и соответственно отвода тепла с нее будет очень затруднен, это должно быть преимущественно пассивное устройство. В предыдущей конструкции не представляет проблемы отводить мощность с кросс-платы через плиту. Также в данном случае почти вся площадь кросс-платы будет занята вырезами под вентиляторы. Ее конфигурация приведена на рисунке.

Возможно, ли будет реализовать необходимые электрические связи через такой конструктив открытый вопрос. Конечно, есть опция немного увеличить площадь кросс-платы уменьшая площадь радиаторов/вентиляторов, т.к. дальнейший расчет покажет, что по температурам есть запас.

В расчете также будем учитывать один модуль и радиатор с нагрузкой для облегчения. Для расчета выберем нижний модуль, т.к. он работает в худших условиях. Во-первых, он расположен параллельно земле, что хуже для работы ИК, в боковых конденсатор расположен над испарителем, возможно их вообще можно выполнить в виде термосифона, без фитиля. Во-вторых, у него получились более высокие ребра. Расчетная модель приведена на рисунке.

Данная расчетная модель конечно упрощена не совсем верно, т.к. в такой конфигурации не учитываются утечки воздуха через щели между модулями, которые снижают расход воздуха через радиатор. Если в конструкции 1ого типа радиатор очень легко изолируется кожухом и утечки не надо учитывать, то в данном случае устранить щели будет гораздо сложнее. Но для рассмотрения концепции упростим себе задачу.

Тепловые нагрузки и тепловые интерфейсы заданы такими же, как в предыдущей модели.

Т.к. ребра радиатора ниже, то есть возможность увеличить промежутки между ними до 2,5мм при той же толщине 1мм. Требования к вентилятору также немного снизим, используем двойную характеристику, приведенную на рис.22, при которой общая мощность вентиляторов оценивалась в 450Вт на 18 модулей. В данном случае модулей 24, поэтому мощность вентиляторов на сервер будет 600Вт, а мощность сервера 4,8кВт.

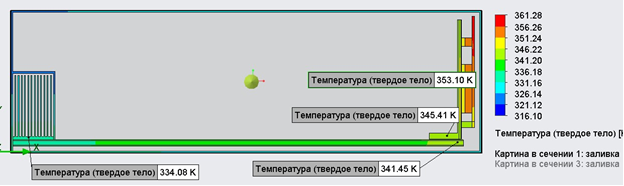

Результаты расчета приведены на рисунке.

Видим, что температура процессора всего 67℃. Ситуация кардинально улучшилась несмотря на то, что перегрев воздуха даже немного вырос, т.к. объемный расход упал. Но при этом полностью был исключен перепад температуры по плите, а перепад температуры по конструкции модуля сильно уменьшился, т.к. съем тепла идет непосредственно с поверхности ИК.

И соответственно у данной конструкции будет лучший PUE, т.к. достаточно вентилятора с худшей характеристикой. Понятно, что его можно еще улучшить, т.к. есть запас по температурам. 5,67/4,8=1,18 – PUE по охлаждению для данной конструкции.

В стойке высотой 42U помещается 12 устройств высотой 3,5U, если взять запас, то 11. Соответственно, общая мощность стойки 11*4,8=52,8кВт. Уложились в требования ТЗ, даже с запасом.

Итак, по данному варианту можно сделать вывод, что он позволяет получить нужные температуры с запасом. Компоновка модулей внутри сервера плотнее, площадь ПП для размещения компонентов в том же объеме выше. В стойке данный вариант также компонуется классическим способом без лишних проблем. Основной проблемой будет кросс-плата.

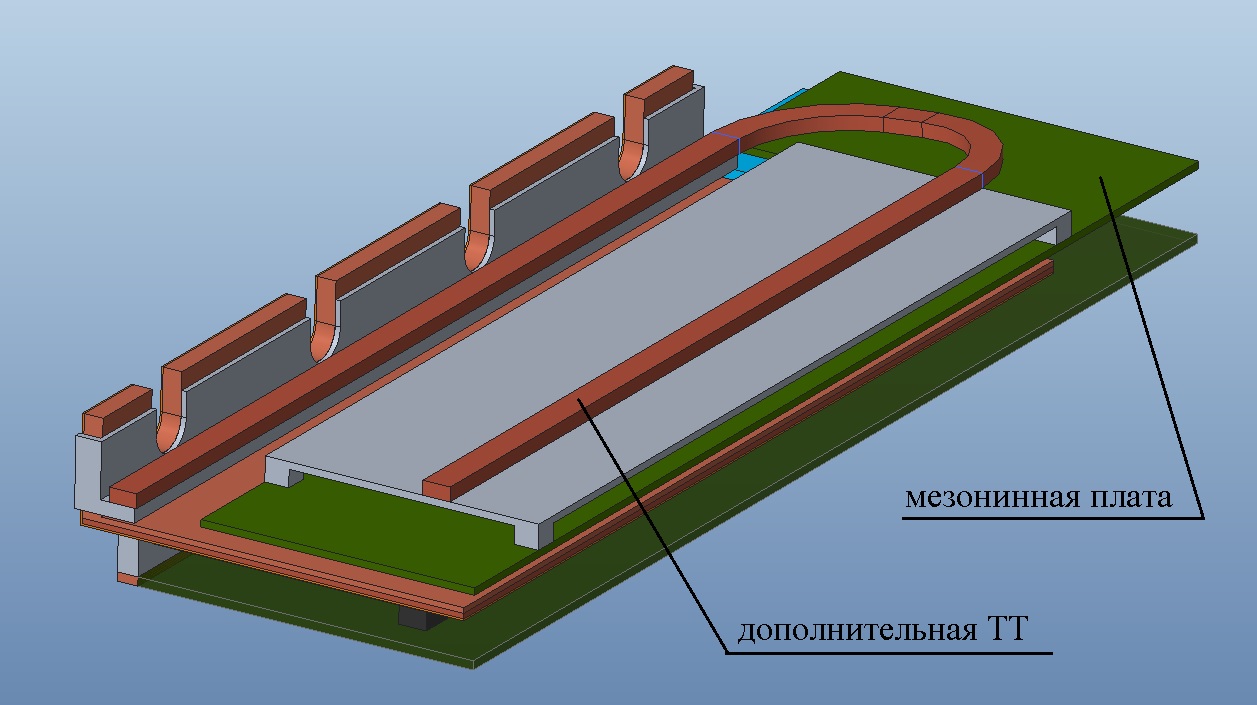

Площадь ПП для размещения компонентов конечно можно увеличить и для 1ого типа где-то в 1,5 раза, добавив мезонинные платы к готовым модулям (для этого скорее всего придется увеличить шаг модулей и соответственно уменьшить их общее количество на сервер). Охлаждение мезонинных плат будет затруднено и не только из-за того, что в конструкции нет запаса по температурам. Даже если увеличить общий радиатор, сбрасывать тепло с мезонинной платы на другую сторону ИК скорее всего не получится, т.к. это усложнит конструкцию ИК в связи с добавлением второго фитиля на обратной стороне и для обратной стороны фитиль будет расположен над паровым каналом, и конденсированная вода должна будет подниматься против силы тяжести. Возможно небольшую мощность получится передать. Либо можно использовать дополнительную ТТ. Возможная конструкция изображена на рисунке.

Прежде, чем перейти к окончательному сравнению вариантов с воздушным охлаждением поговорим еще об одной проблеме.

8. Обслуживание из горячего коридора

Оба рассмотренных варианта конструкции предполагают обслуживание (замену модулей) с лицевой и задней панели. Соответственно если в «холодном» коридоре предполагается температура до 40℃, то в «горячем» для конструкции 2ого типа до 57-59℃, что видимо не очень комфортно для работы персонала. По сути, даже «холодный» коридор будет не самым приятным местом. Единственным хорошим вариантом решения данной проблемы мне видится только переход на водяное охлаждение или «гибридные» конструкции, где не будет горячих или холодных коридоров. Для воздушного охлаждения любое решение имеет существенные недостатки. Приведем возможные варианты решения

1) Самый очевидный, менять одновременно по два модуля, лицевой и задний. Для обоих вариантов это может создать дополнительные конструктивные сложности. Для 1ого варианта придется увеличить длину устройства прижима модулей к плите на всю глубину сервера. Для 2ого варианта придется либо перенести кросс-плату на заднюю панель, превратив платы модулей в длинную «колбасу» с соответствующей длиной электрических связей, либо раздуть габариты устройства в ширину и высоту, разместив кросс-платные разъемы между боковыми модулями, либо менять не модули, а целиком блоки из нескольких модулей с отдельной кросс-платой.

2) Для 1ого варианта можно вставлять модули сверху в устройство. Такой вариант будет проще с конструктивной точки зрения, т.к. не понадобятся специальные прижимные устройства, но в этом случае для обслуживания придется выдвигать сервер из стойки. Для этого надо либо отключать все кабели, либо закладывать в кабели петлю/улитку на глубину сервера.

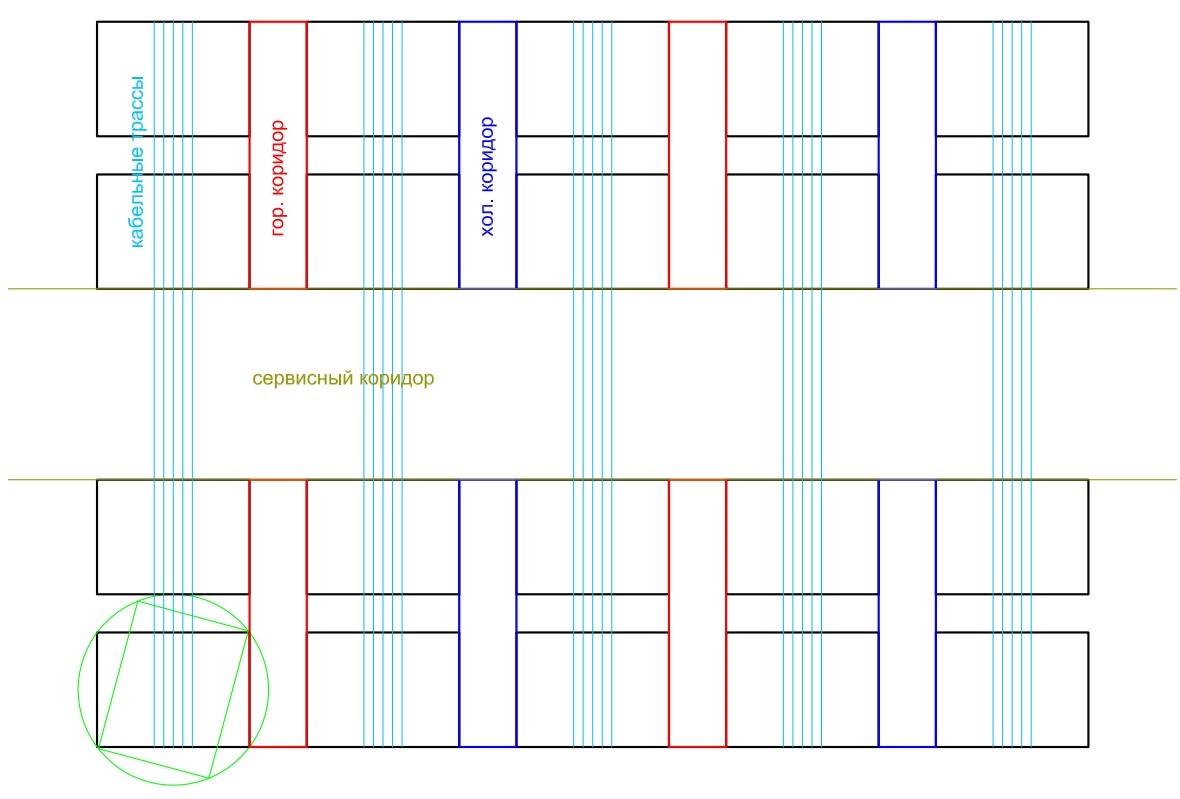

3) Разместить стойки боком к коридору, из которого производится обслуживание. Для обслуживания придется вращать стойку или выкатывать. Возможная компоновка ЦОДа (вид сверху) для данного варианта приведена на рисунке.

Для обслуживания придется поворачивать стойку, развернутое положение показано зеленым на рисунке, а в рабочем положении стойки будут повернуты боком к сервисному коридору. Холодные и горячие коридоры будут представлять собой прямоугольные трубы, которые могут, например, проходить снизу вверху через все этажи здания. Также между рядами стоек понадобится дополнительный зазор на поворот. Можно упростить схему, убрав зазор, если просто выкатывать стойку в сервисный коридор. Данный вариант, помимо раздувания объема ЦОДа, добавит очевидную проблему с кабелями. В случае поворота весь пучок кабелей должен заходить в стойку близко от центра вращения. В случае выкатывания стойки пучок кабелей должен иметь петлю/улитку на ширину стойки и также заводится в стойку в одном месте. Понятно, что можно сокращать число кабелей, например, выполняя все связи внутри стойки в виде шин или кросс-плат, шлейфов, но это потребует соответствующих подходов к проектированию стоек и оборудования в них. Плюс данного варианта в том, что холодные и горячие коридоры станут необитаемы.

4) Для 1ого варианта конструкции также возможно подключение воздуховодов напрямую к радиаторам и подача/отвод воздуха через необитаемые вертикальные трубы. Выглядеть это будет примерно так.

Две стойки, между ними холодный коридор, из которого воздух в вентиляторы подается через воздуховоды. Холодный коридор и воздуховоды нарисованы голубым цветом. Сечение воздуховода в данном случае 250x164мм, расход воздуха на три сервера 0,0393=0,81м3/с. При этом скорость потока воздуха будет порядка 24м/с, что немало и наверняка создаст значительные воздушные сопротивления. При этом по картинке видно, что, выпирая в коридор даже на 200мм, данные воздуховоды будут мешать обслуживанию стоек. В данном случае можно играть различными конструктивными параметрами для решения проблемы. Можно располагать по два сервера в ширину стойки, делая стойки уже, а горячие и холодные коридоры чаще, что снизит расходы в подводящих воздуховодах. Можно утапливать воздуховоды в стойку, увеличивая ширину радиаторов и соответственно уменьшая их глубину, но это будет уменьшать полезный объем стойки.

Пока это все варианты, которые приходят в голову и у каждого из них, как уже было сказано, есть издержки. Далее перейдем к сравнению рассмотренных типов конструкций с воздушным охлаждением.

9. Сравнение вариантов конструкций с воздушным охлаждением

Для сравнения, все достоинства и недостатки соберем в табличку, т.к. это наиболее наглядно. Но прежде, чем перейти к табличке озвучим одно не очевидное преимущество 1ого варианта конструкции. Исходя из того, что было сказано ранее кажется, что 2ой вариант практически во всем лучше. Но в 1ом варианте воздушный поток полностью изолирован от электроники. Воздух и все, что в нем может содержаться воздействует только на вентилятор и радиаторы, а отсек с модулями очень легко выполнить пыле-влагозащищенным. Фактически, достаточно сделать в стойке дверцу с уплотнениями на каждый ряд устройств, которая будет закрывать модули вместе с подключенными кабелями, но не перекрывать вентиляторы или воздуховоды. Можно высказать предположение, что ЦОД составленный из стоек подобного типа не будет требовать капитального строения как такового, а только забора и навеса, защищающего от дождя. И это возможный способ снизить затраты на создание и эксплуатацию. Для 2ого варианта реализовать полную изоляцию электроники и разъемных соединений от охлаждающего воздуха намного сложнее, если вообще возможно.

Таблица сравнения конструкций с воздушным охлаждением.

Параметр для сравнения |

Конструкция 1ого типа (единый радиатор для всего сервера) |

Конструкция 2ого типа (отдельные радиаторы для каждого модуля) |

Примечание |

Температура корпусов электронных компонентов не более 75℃ |

Не выполняется или выполняется с трудом, без запаса |

Выполняется с запасом |

Сравнение для одинакового объема радиатора в пересчете на один модуль |

Предполагаемый PUE ЦОДа по системе охлаждения |

1,22 |

1,18 |

|

Оцениваемая мощность стойки 42U, кВт |

36 |

52,8 |

|

Модульность конструкции |

да |

да |

|

Количество модулей на одно устройство |

18 |

24 |

Для устройств приблизительно равного объема. Для 1ого типа возможно добавить доп. мезонинные платы в модули, но теплоотвод от них будет затруднен. |

Количество серверов в стойке 42U |

10 |

11 |

|

Необходимость специальных прижимных устройств для установки модулей |

да |

нет |

Если серверы не выдвигаются из стойки для обслуживания, в противном случае можно обойтись без прижимных устройств |

Возможность замены всех модулей из холодного коридора |

затруднена |

затруднена |

|

Возможность реализации необитаемых холодных и горячих коридоров |

Проще |

Сложнее |

В сравнении друг с другом |

Площадь кросс-платы |

Достаточная, с возможностью расширения на всю площадь модульного отсека |

Недостаточная, возможность увеличения затруднена |

|

Теплоотвод с кросс-платы |

Возможен, в тех же пределах, что и с модулей |

Очень затруднен |

|

Стоимость компонентов системы охлаждения |

Выше |

Ниже |

В сравнении друг с другом |

Утечки охлаждающего воздуха через щели в конструкции |

Нет |

Тяжело устранить |

|

Пыле-влагозащищенность электроники и внешних разъемных соединений |

Легко реализуется |

Очень затруднена |

На этом анализ перспективных конструкций с воздушным охлаждением завершим. Здесь полагается сделать какие-то выводы, но сделать их на данном этапе сложно. Для правильного выбора некой перспективной конструкции необходимо рассмотреть массу других вопросов. Но я приведу вывод в формате личного мнения. Конструкция 2-ого типа в моем представлении - это условный максимум (по крайней мере с точки зрения отводимой мощности воздушным охлаждением), который можно выжать из "классической" конструкции серверов или из блочных конструкций типа оборудования OCP последних поколений. Мы убираем из конструкции все "лишние" воздушные сопротивления, занимаем весь свободный объем радиаторами и получаем подобную конструкцию. Но перспектив развития я для нее не вижу. А вот у конструкции 1-ого типа (с общей плитой) гораздо более интересные перспективы. Она может эволюционировать в пыле-влагозащищенные конструкции с воздушным охлаждением для уличного исполнения со встроенной системой терморегулирования. Либо в конструкции с водяным охлаждением, которые будут просты в обслуживании и позволят еще увеличить мощности охлаждения относительно приведенных. А также получать PUE по системе охлаждения менее 1,05. Насосы для них не требуют высоких давлений или других особых характеристик. Для полноты картины (в том числе и по описанным конструкциям) необходимо также рассмотреть следующие темы:

Подбор и реализация термоинтерфейсов.

Конструкция прижимных устройств.

Конструкции с водяным охлаждением и «гибридные» конструкции.

Оставим их для следующих статей.

Спасибо за внимание!

Комментарии (21)

not-allowed-here

15.08.2023 20:59а почему не смотрите на фазовые иммерсионные системы? там по сути даже конструкцию самого оборудования менять особо не нужно благодаря относительно низкой вязкости инженерные жидкости типа NOVEC 7000 хорошо проникают везде. Делали подобное в виде стенда для Майнингового Оборудования. там и по больше чем 50-60кВт на стойку реальны.

Garry_D Автор

15.08.2023 20:59Мне казалось, что иммерсионные очень неудобны в обслуживании, надо лезть в жидкость, чтобы заменить какое-то устройство или сначала ее сливать, а потом его менять. Возможно также стоимость или протечки. Поправьте, если это не так.

not-allowed-here

15.08.2023 20:59сильно зависит от Технологии для ПМС(полиметилсилоксановая жидкость) и подобных все именно так как вы описываете - они густые и сливаются плохо, оставляют пленку и плохо вымываются из радиаторов и тонких полостей.

Для Novec есть сложности только с тем Что он дороговат - по сути имея вязкость чуть меньше чем у Воды он практический без проблем легко и оперативно сливается и заливается не оставляя следов на оборудовании. у нас возник вопрос только с HDD - они не всегда герметичны.... даже делали Экспериментальный стенд с полу погруженным сервером где HDD обдувались родными вентиляторами в той же камере.по протечкам - тут очень большой технологический вопрос, но вполне решаемый по сути для Фазовых систем все легко контролируется датчиками давления, т.к. наличествует фазовый переход. Для ПМС и подобных обычный поплавковый датчик. плюс жидкости вполне пригодны к вторичной очистке при наличии простейшей фильтрации на самых обычных "водяных" фильтрах 25-50мкм.

единственное для ПМС систем надо контролировать уровень набранной влажности и иногда Жидкости должны подвергаться процедуре осушения.

в целом тут встает очень сильный вопрос - а так ли важна Тепловая плотность? и не разумнее ли нарастить число корпусов, но уменьшить плотность до классической(15-25 кВт на стойку)? и расчет должен вестись именно в Этом плане соотношения доп. затрат на высокоплотные Стойки и результирующей эффективности системы.

Garry_D Автор

15.08.2023 20:59Понятно, в общем фазовые иммерсионные системы - это своего рода тепловая трубка, только "вокруг" оборудования. Все же с точки зрения удобства обслуживания у конструкции на "внутренних" тепловых трубках будет преимущество, не надо ничего сливать или герметизировать, если конечно оставить за скобками вопрос переделки всего оборудования.

Возможно тепловая плотность не так важна, как удобство и затраты. По PUE описанная система конечно проиграет иммерсионной из-за затрат мощности на вентиляторы. ИМХО идеальной (опять же если не учитывать затраты на перепроектирование самого оборудования) была бы система, как в 1ом варианте, только радиатор надо заменить на водяной блок и тогда PUE будет близок к 1 и удобство обслуживания сохранится. Но вопрос конечно очень сложный, как учесть все затраты на ту или иную систему и понять, что предложенная система более эффективна или нет.

not-allowed-here

15.08.2023 20:59есть в РФ такая контора Теркон-КТТ:

Они делают Контурные тепловые трубки - думаю вам будет Очень интересно с ними пообщаться....

Garry_D Автор

15.08.2023 20:59Да, контора интересная читал про нее. Правда, не уверен, что тут будут полезны КТТ, в моем представлении КТТ это такое специфичное решение, когда надо передать высокую мощность на какой-нибудь отдаленной радиатор, расположенный в другой плоскости относительно печатной платы. Своего рода аналог водяных блоков в жидкостной системе охлаждения.

not-allowed-here

15.08.2023 20:59просто у них габаритное решение позволяет интегрироваться в любой готовый сервер рассчитанный на воздух, а ваше потребует проектирования фактический с нуля....

скажем прямо - в вашем случае реализуемость концепции на 200% зависит от готовности участвовать вендоров, а каких-то супер преимуществ вы не показываете....те же КТТ вполне готовое решение решающее проблему внедрения жидкостного охлаждения в массовые сервера и изолирующее жидкостную часть от электроники.

Garry_D Автор

15.08.2023 20:59Да, согласен КТТ вполне себе решение, но сборка разборка (обслуживание) этого дела затруднена. Надо доставать сервер из стойки, отключать, на каждый процессор ставить испаритель КТТ. И потом надо конденсатор каждой КТТ подключить к некой водяной плите или к теплообменнику. Мне кажется из-за этого данное решение не очень идет. Предложенная система в этом плане проще. Но в общем понятно, что суперпреимуществ у него нет. Оно плюс-минус решает большинство проблем, с моей точки зрения опять же, но ценой перепроектирования оборудования. Было бы какое-то супер решение, наверняка его кто-нибудь уже придумал)

not-allowed-here

15.08.2023 20:59да собственно вендоры голосуют Рублем и пошли именно по схеме аналогичной предложенной Терконом - Lenovo, Dell, Huawei выпустили линейки серверов с частично разнесенным жидкостным охлаждением.....

про остановку для монтажа и т.п. - а это неизбежно и пока что сильно дешевле перепроектирования, т.к. цикл разработки сервера со всеми расчетами, моделированием и прототипами 15-22 млн долларов и порядка 6-9 месяцев с момента получения референса от Вендора Процессоров и Чипсетов

Garry_D Автор

15.08.2023 20:59Да, конечно, если смотреть на затраты в краткосрочной перспективе - это будет дешевле и результат более гарантирован. Единственное замечание, по сравнению с Терконом указанное решение удобнее, т.к. для монтажа сервера подключается две трубки, возможно через быстросъемные гидравлические разъемы (если использовать КТТ, то надо монтировать каждый конденсатор КТТ, что дольше и сложнее), по крайней мере у OCP есть подобные спецификации https://www.opencompute.org/documents/ocp-universal-quick-disconnect-uqd-specification-rev-1-0-2-pdf Я в общем из этого делаю вывод, что запрос на простоту и быстроту монтажа все-таки есть, может вывод и не слишком обоснованный. Опять же если вендоры рассматривали решения подобные предложенному и отвергли его с точки зрения экономики или чего-то еще, то это одно, а если не рассматривали, то может оно и имеет право на жизнь, т.к. его условно и не было в кандидатах на "голосование".

little-brother

Ко мне лет 5 назад прибегали с таким запросом - еще и с 19" оборудованием. Что-то близкое для решения этой задачи ранее было - Schroff LHX 40, но это без резервирования (фактически шкаф = 1 нода). Да и конструктив шкафа, честно скажу - так себе, какой-то хлипенький.

Garry_D Автор

Ну, упомянутый теплообменник требует холодной воды на входе для работы, т.е. эту воду предварительно придется охладить до температуры ниже окружающей среды, а значит хороший PUE мы никак не получим. Понятно, что под уже существующее оборудование проще взять что-то типа такого теплообменника. Резервировать его наверное можно просто поставив в стойку две штуки. А в статье несколько другая идея, более "глобальная", что надо изменить конструкцию самих серверов, чтобы отводить подобные мощности причем воздухом с температурой внешней среды, не теряя дополнительную энергию на его охлаждение.

little-brother

Имхо, именно из-за необходимости доработки серверного оборудования погружные системы не пошли в массы. А там pue хорош и дороботок относительного описанного в статье намного меньше требуется.

Комментарий был к тому, что 40 квт на шкаф существующая задача, а не задел на будущее.

not-allowed-here

а чем вас Rittal Inrow LCP теплообменники не устраивают? ну кроме доступности и цены вполне себе 40-55кВт https://www.rittal.com/it-solutions/fileadmin/Redakteur/Downloads/Know-How-EN/Rittal_Whitepaper_Rittal_Liquid_Cooling_Packages_5_1964.pdf

Garry_D Автор

Теплообменники требуют холодной воды на входе, т.е. воду сначала надо охладить и соответственно затратить на это дополнительную энергию. Я не вижу, чем это принципиально отличается от системы чилер-фанкойл, кроме того, что позволяют "уплотнить" стойку с точки зрения тепла, хотя сами занимают место и добавляют стоимость.

not-allowed-here

у нас в РФ 9 месяцев в году температура ниже +5 градусов.... затраты только на перекачку теплоносителя, работу сухих градирен и обслуживание смесительных систем которые регулируют температуру носителя не позволяя ей опустится ниже критических значений.... да согласен летом будут Проблемы и потребуется обеспечивать примерно 2000 часов работ Чиллеров.... но видится мне что В данных условиях Фрикулинг будет отбивать процентов так 90 затрат на охлаждение в год

Garry_D Автор

Да, идея предполагает, что надо заново перепроектировать все оборудование и за счет этого получить некие преимущества. Вполне допускаю, что никто не захочет это делать с точки зрения соотношения затрат и пользы.

frozzzen

https://www.youtube.com/watch?v=5eo8nz_niiM

https://wiki.helsinki.fi/display/~pervila@helsinki.fi/Data+Centers+around+the+World

Немного погуглил за вас. Буквально 5 секунд. И да, предположение "Самое простое, что может быть – это охлаждение наружным воздухом без какого-либо предварительного охлаждения. Т.е. оборудование должно охлаждаться воздухом с входной температурой 40°С. Этого вполне реально добиться, но «честно» посчитанный PUE для воздушного охлаждения вряд ли достигнет цифры 1,1." выглядит слабо и не соответствует действительности.

Garry_D Автор

И что, первая ссылка, первый же абзац скорее подтверждает мое утверждение. Он о том, что как считать PUE и какие затраты в нем учитывать. Понятно, что можно взять водопроводную воду и охлаждать ей, считая, что PUE близок к 1. Я привел рассуждения, достаточно простые конечно, но однозначные что и и как я считал.

frozzzen

Вы понимаете, как работают дата-центры Hetzner? Электроника охлаждается воздухом обыкновенным, без холодильных установок, трансформаторного масла и других жидкостей. Та же самая кухня у гугла, амазона и фейсбука. И это как-то связано с OCP. И выше перечисленные компании не покупают у вендоров серверы, а творят их "на коленке" методом распределенного производства. И да, PUE у них обычно 1,1...1,2, как линеечку не прикладывай. Этим инновациям больше 10 лет, например. Ваш Кэп.

Garry_D Автор

Вы видимо в амазоне работаете или в гугле, если знаете что у кого они покупают. Раз вы специалист по работе с гуглом зайдите на сайт OCP и поизучайте проект https://www.opencompute.org/projects/cooling-environments там почему-то есть и иммерсионное охлаждение и охлаждение водяными блоками и теплообменники, люди работают, спецификации там разные выпускают. И кэп подсказывает, что очень многое зависит от расположения ЦОДа, в Финляндии проблем с фрикулингом скорее всего не будет вообще, в Москве возможно пару месяцев в году, а в Техасе будет большую часть времени.