В Части 1 этой статьи вы можете узнать об эволюции метрик качества машинного перевода, а также об основных традиционных метриках. В Части 2 мы рассмотрели наиболее известные референсные нейросетевые метрики, расчет которых требует эталонного перевода (reference). В последней – третьей – части поговорим о безреференсных нейросетевых метриках, а также выясним, какова сравнительная эффективность различных традиционных и нейросетевых метрик.

Безреференсные системы оценки

В NLP cуществует отдельная задача Quality Estimation (QE) – предсказание качества машинного перевода в отсутствие референса, то есть без ориентира в виде эталонного перевода, выполненного человеком. Задача QE может решаться как на уровне отдельных слов, так и на уровне предложений.

Современный подход к QE заключается в дообучении мощных предобученных многоязычных нейросетевых моделей-энкодеров (таких как BERT, XLM-R) для прямого сравнения машинного перевода и первоисточника на исходном языке.

В последние годы модели QE достигли довольно высокого уровня корреляции с человеческой оценкой качества перевода предложений (коэффициент корреляции Пирсена до 0.9 для некоторых языковых пар - WMT2020: Specia et al., 2020).

Оценки, получаемые на выходе моделей QE, по сути представляют собой безреференсные метрики качества машинного перевода. Их можно рассматривать как альтернативу значительно более распространенным традиционным и референсным нейросетевым метрикам.

Обучение моделей QE выполняется на датасетах, содержащих человеческие оценки качества перевода. Также выполненные человеком оценки используются и при определении степени адекватности метрик качества машинного перевода. Рассмотрим подробней, как получают такие данные.

Подходы к человеческой оценке качества перевода

Существует ряд подходов к выполнению человеческой оценки качества машинного перевода. Но для целей сравнительной оценки адекватности метрик, ежегодно проводимой в рамках Metrics Shared Task WMT (см. подробней под катом ниже) использовались только оценки двух видов:

DA (Direct Assessment) – субъективная оценка лицами, не являющимися экспертами-переводчиками. Применялась в WMT Metrics Shared Task до 2020 года включительно;

MQM (Multidimensional Quality Metrics) – оценка, выполняемая профессиональными переводчиками, по заданному перечню критериев и ошибок перевода. C 2021 принята в качестве «золотого стандарта» человеческой оценки качества перевода для WMT Metrics Shared Task.

Что такое Metrics Shared Task WMT?

WMT или Conference on Machine Translation – это самая известная конференция по машинному переводу, проводится Ассоциацией компьютерной лингвистики (ACL). Аббревиатура WMT осталась от прежнего названия: Workshop on Machine Translation.

Начиная с 2008 года, в рамках WMT проводится конкурс на лучшую метрику качества машинного перевода – Metrics Shared Task. Метрики, предложенные на этот конкурс, применяются к машинным переводам моделей, участвующих в WMT Translation Task.

Кстати, если придумаете свою метрику, подать её на конкурс можно вот здесь.

COMET-Kiwi

Модель COMET-Kiwi (Rei et al., 2022) агрегирует две QE модели. Первая из них имеет классическую для QE моделей архитектуру «предсказатель-оценщик», в рамках которой выполняется совместный энкодинг машинного перевода и первоисточника. Эта модель обучена на выполненных человеком оценках качества машинного перевода (а именно Direct Assessment, данные WMT за период 2017-2019) и дообучена на датасете MLQE-PE (Multilingual Quality Estimation and Post-Editing Dataset, 2021).

Вторая модель – та же модель разметки последовательностей, обученная на данных MQM, что и в COMET версии 2022 года (COMET-22, Rei et al., 2022), но не использующая референс.

Признаки, извлеченные из обеих QE моделей, взвешиваются при помощи настраиваемых гиперпараметров таким образом, чтобы на выходе получить одну агрегированную оценку.

MS-COMET-QE-22

MS-COMET-QE-22 (Kocmi et al., 2022) построена на базе архитектуры COMET в варианте без референса, но обучена на существенно более объемном датасете человеческих оценок качества перевода, охватывающем 113 языков. Кроме того, создатели модели уделили особое внимание предобработке человеческих оценок, исключив из датасета оценки потенциально низкого качества.

MATESE-QE

Модель MATESE-QE (Perrella et al., 2022) имеет в своей основе мультиязычную модель-энкодер с архитектурой трансформера, дообученную, чтобы выявлять ошибки перевода.

Найденные в каждом предложении ошибки модель классифицирует по степени серьезности: в диапазоне от несущественных (им присваивается оценка -1) до максимально существенных (оценка -5). Итоговая оценка качества перевода всего текста формируется в логике, позаимствованной у Freitag et al. (2021a) – путем усреднения оценок для отдельных предложений, составляющих текст.

Дообучение выполнено на данных MQM. Сравнив результаты несколько базовых моделей (XLM-RoBERTa, RoBERTa, mBART), создатели метрики остановились на XLM-RLARGE.

REUSE

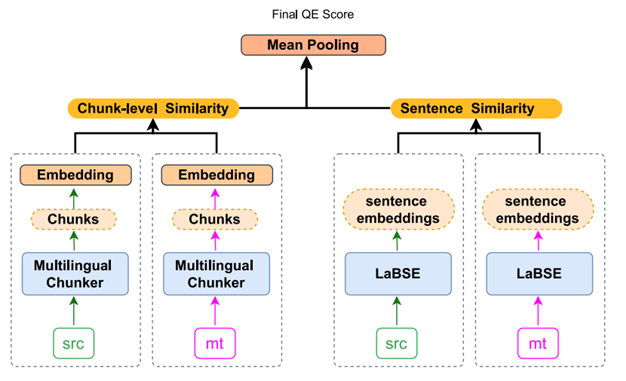

Метрика REUSE (REference-free UnSupervised quality Estimation Metric, Mukherjee and Shrivastava, 2022). Для расчета этой метрики переведенное и исходное предложения дополнительно разбиваются на словосочетания. Оценка качества перевода выполняется как на уровне предложений, так и на уровне словосочетаний.

Близость словосочетаний оценивается на основе контекстных эмбеддингов из модели BERT, а близость предложений – на основе эмбеддингов модели LaBSE (Language-agnostic BERT Sentence Embeddings, Feng et al., 2020). Далее выполняется усреднение оценок степени близости по всем словосочетаниям и предложениям, что и дает итоговое значение метрики REUSE.

HWTSC-Teacher-Sim

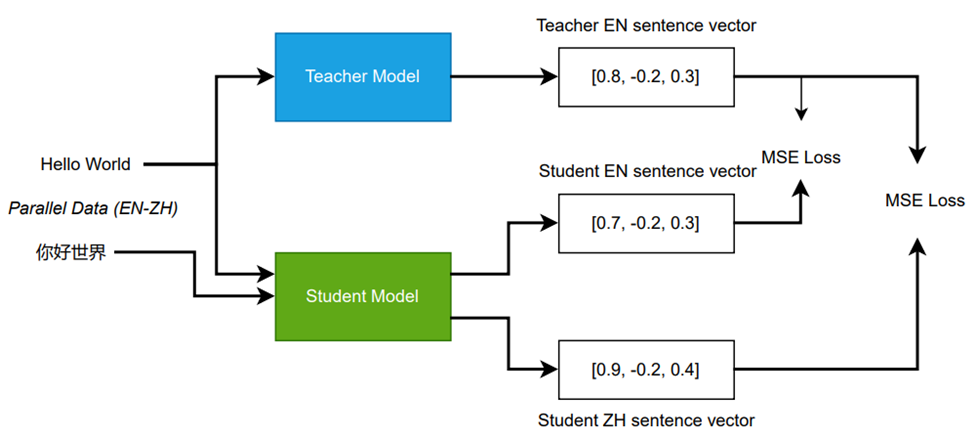

Метрика HWTSC-Teacher-Sim предложена Huawei и описана в Liu et al., 2022 (первоисточник Zhang et al., 2022b – за пэйволлом). Для расчета этой метрики применяется мультиязыковая дистилляция знаний (Reimers and Gurevych, 2020b), путем которой обеспечивается соответствие эмбеддингов языков перевода и оригинала – см. схему ниже.

В качестве модели-учителя использована моноязычная Sentence BERT (Reimers and Gurevych, 2019). В качестве модели-ученика могут использоваться многоязычные модели (например, mBERT либо XLM-R). Дистилляция позволяет максимизировать близость пар предложений на языках оригинала и перевода. После дистилляции выполняется дообучение модели на данных MQM, после чего оценка степени близости, даваемая этой моделью, может быть использована в качестве метрики качества перевода.

Сравнение адекватности метрик

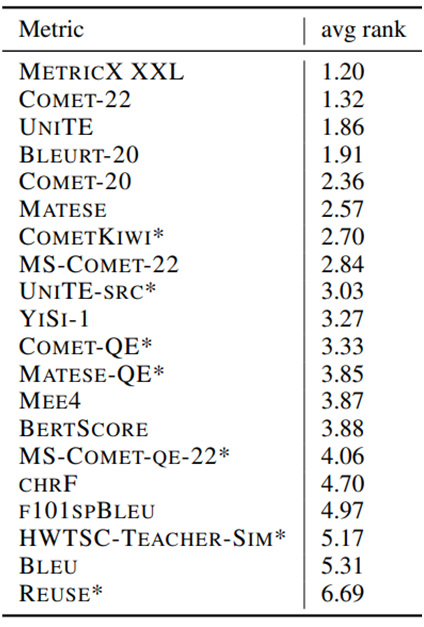

По итогам WMT Metrics Shared Task 2022 опубликован рейтинг ряда традиционных, нейросетевых, а также безреференсных метрик (их названия помечены звезочкой – *) по степени их корреляции с человеческой оценкой качества перевода:

Традиционные метрики (BLEU, chrF) существенно отстают от наиболее продвинутых нейросетевых. Лучше всего показали себя референсные нейросетевые метрики. Топовая метрика – MetricX XXL, а из задокументированных метрик наиболее адекватна метрика COMET в версии 2022 года (Rei et al., 2022).

Безреференсные метрики хуже топовых референсных нейросетевых, но большинство из них опережает традиционные.

Заключение

В этой статье, включающей также Часть 1 и Часть 2, мы проследили эволюцию метрик качества машинного перевода вплоть до сегодняшнего дня. Несмотря на сохраняющуюся популярность традиционных метрик, нейросетевые метрики уже значительно превзошли их.

На сегодняшний день референсные нейросетевые метрики лучше всего коррелируют с человеческими оценками качества машинного перевода. Но им на пятки уже наступают безреференсные нейросетевые метрики, и рискну предположить, что именно с их совершенствованием будет связано дальнейшее развитие метрик машинного перевода.

Что можно сказать с уверенностью, так это то, что самая широко известная и популярная метрика качества машинного перевода – BLEU – должна, наконец, уступить место более современным и адекватным метрикам.