Всем привет! Меня зовут Артём Важенцев, я аспирант в Сколтехе и младший научный сотрудник AIRI. Я работаю в группе под руководством Александра Панченко и Артёма Шелманова. Мы занимаемся исследованием и разработкой новых методов оценивания неопределенности для языковых моделей. Этим летом мы представили две статьи на конференции ACL 2023. В одной из них мы описали новый гибридный метод оценивания неопределенности для задачи выборочной классификации текстов для данных с неоднозначными примерами — его внедрение поможет нейросетям лучше находить токсичность в комментариях или угадывать тональность сообщений. В этом тексте я бы хотел рассказать подробнее о нашем методе и процессе его разработки.

Введение

Токсичность в интернете — вещь обыденная, и, похоже, неискоренимая. Невозможно заставить всех пользователей быть добрее или приставить к каждому из них надзирателя, который бы “следил за базаром”. Единственный выход для тех, кто хотел бы ощущать себя в интернете уютнее — это фильтрация, которая невозможна без классификации текста.

Сегодня задачи классификации и им подобные решаются автоматически на основе предсказаний нейросети, однако даже самые продвинутые модели склонны совершать ошибки. Чтобы отлавливать такие ошибки существуют методы оценивания неопределенности. Они пытаются понять насколько модель не уверена в своем предсказании. Полученные оценки неопределенности для хорошего метода должны коррелировать с ошибками модели, т.е. для примеров на которых модель ошибается должна быть высокая неопределенность, для корректно классифицированных — низкая.

Вскоре стало ясно, что многие современные методы оценивания неопределенности могут показывать плохой результат на неоднозначных задачах — определение токсичности текста относится к их числу. Это мотивировало меня и моих коллег из нескольких научных институтов, занимающихся проблемами искусственного интеллекта, разработать более надежный метод, который будет показывать хороший результат даже в сложных случаях.

Задача, в которой есть возможности отказаться от классификации для части примеров, называется выборочной классификацией. В такой задаче наиболее неопределенные предсказания отклоняются, предполагая, что модель могла допустить ошибку, а только самые уверенные предсказания сохраняются. Таким образом, на сохраненной части мы можем значительно улучшить качество классификации. Отклоненные же примеры, для которых модель неопределенна, могут быть дальше отправлены на разметку человеку — эксперту в области, который может более корректно классифицировать данный пример. Также в некоторых системах можно выдать это предсказание пользователю вместе с оценкой неопределенности, чтобы более корректно интерпретировать данное предсказание модели.

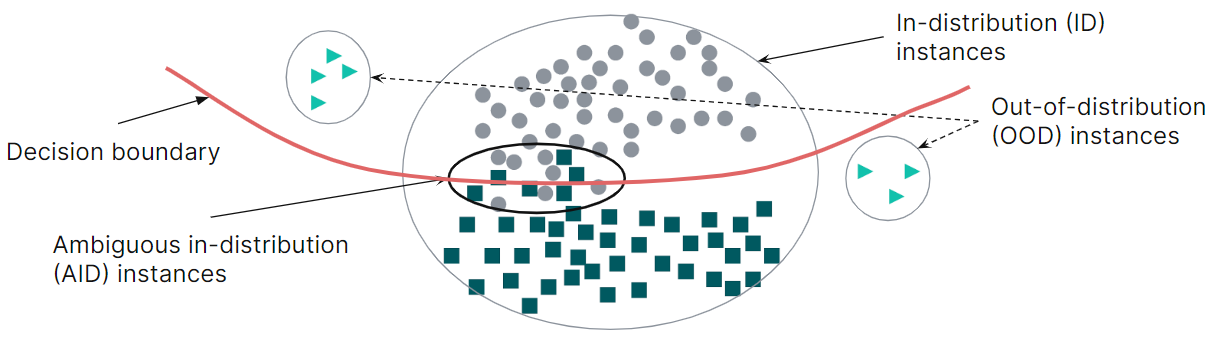

Как известно, ошибки могут возникать из двух источников: примеры вне распределения обучающих данных (out-of-distribution, OOD) и сложные примеры (ambiguous in distribution, AID), с которыми модель не может справится корректно. В первом случае хорошо работают методы оценивания эпистемической неопределенности, которая возникает из-за недостатка данных, во втором — методы оценивания алеаторной неопределенности, которая возникает из-за шума и неоднозначности в данных. Таким образом, возникла идея придумать способ, как объединить два этих базовых метода под каждый тип неопределенности и получить более надежный метод.

Определение неопределенности

В приложении математической статистики к машинному обучению неопределенность U(x) вводят как функцию на множестве данных (или примеров) χ, где x ∈ χ. Если неопределенность ниже некоторого порога, считается, что нейросеть надежно справилась с примером, и её предсказание можно использовать. Если же ниже — предсказание для этого примера отклоняется.

Согласно байесовскому подходу общая неопределенность предсказания модели для примера x это сумма алеаторной UA(x) и эпистемической неопределенности UE(x):

Алеаторная неопределенность возникает из-за шума или двусмысленности в данных — она должна быть высока для примеров, которые сложно разметить даже человеку. Эпистемическая неопределенности возникает из-за недостатка данных и должна быть высокая для OOD-примеров. Такая неопределенность полезна для разметки в активном обучении.

Однако, для современных оценок неопределенности простая сумма не подходит, т.к. методы могут иметь совершенно разный разброс значений. Как правило, методы для UA дают значения в диапазоне от 0 до 1, а для UE — вообще любые (например, от минус до плюс миллиона).

Вместо этого можно попытаться организовать пороговый выбор метода подсчета неопределенности в зависимости от того, относится ли данный пример в обучающей области данных. На языке формул это выглядит следующим образом:

где χID — это примеры внутри обучающего распределения данных (in-distribution, ID). Другими словами, если пример далеко от обучающей выборки, то используем эпистемическую неопределенность, иначе — алеаторную. На части датасетов такой подход сработал, но иногда давал сильные просадки относительно базовых методов. Кроме того, такой подход имел множество недостатков, например, трудности с определением XID .

Ранжирование и гибридизация

Вместо складывания абсолютных значений оценок неопределенности или угадывания каких-либо коэффициентов, чтобы совместить диапазоны от разных методов, мы с коллегами предложили процедуру ранжирования. Её суть заключается в сравнении примеров между собой. Процедура создает отсортированный список оценок неопределенности для всех примеров xi из набора ???? и для данного примера мы считаем специальную функцию:

Преобразование множества неопределенностей во множество рангов не влияет на работу привычных методов, поскольку ранг монотонно зависит от неопределенности. Зато теперь мы можем более корректно смешивать разные методы.

К новизне нашей работы можно отнести и сам подход к смешиванию, который получил название гибридного метода (Hybrid Uncertainty Quantification, HUQ). Он описывается следующим выражением:

Для заданного валидационного датасета, тестовой точки и гиперпараметров, мы считаем оценку неопределенности так:

Если пример находится внутри обучающего распределения (in-distribution, ID), мы используем метод алеаторной оценки неопределенности, ранжируя только внутри ID. Так мы ограничиваем сверху неопределенность для ID примеров, т.к. считаем их наиболее надежными при классификации.

Те обьекты, который находятся внутри ID, но имеют высокую алеаторную неопределенность мы считаем наиболее неоднозначными, которые находятся возле границы разделения классов (ambiguous in-distribution, AID). Для них мы так же используем метод алеаторной оценки неопределенности, но ранжируем уже по всему датасету.

Для оставшейся части примеров, для который мы точно не знаем положение, мы используем линейную комбинацию рангов двух методов с коэффициентом ɑ, который мы подобрали на валидации.

Затем мы проверили то, насколько хорошо новых подход помогает искать неопределенные примеры.

Сравнение HUQ с другими методами

Так как мы предполагаем, что наш метод будет работать значительно лучше базовых методов, в особенности на неоднозначных датасетах, то решили провести эксперименты на наиболее сложных задачах: определение токсичности (датасеты Paradetox, ToxiGen, Jigsaw, Twitter, ImplicitHate), анализ тональности (датасеты SST-5, Amazon) и многоклассовая классификация текстов (датасет 20 News Groups). Используя их, мы обучали две популярные трансформерные модели ELECTRA и BERT решать задачу классификации и пытались определить то, в каких примерах они ошибаются.

В качестве методов оценки эпистемической неопределенности мы использовали три state-of-the-art метода (Mahalanobis Distance (MD), Robust Density Estimation (RDE) и Deep Deterministic Uncertainty (DDU)), а для оценки алеаторной неопределенности два метода, основанных на вероятности предсказания модели (entropy и Softmax Response (SR)).

Качество оценки нам давала метрика RC-AUC, которая считает площадь под кривой риска с помощью выражений, приведенных ниже:

где qi = 1[U(xi) < θ] и li — значение loss функции для примера xi. Сортируя весь датасет по неопределенности в возрастающем порядке, мы можем отклонить процент наиболее неопределенных примеров. Процент оставшихся примеров называется процентом покрытия γ(θ) (coverage rate). Суммарный loss на этих примерах называется выборочным риском r(θ) (selective risk). RC кривая показывает зависимость выборочного риска от покрытия. В конечном итоге, RC-AUC — это и есть площадь под этой кривой. Чем ниже RC-AUC, тем выше качество метода.

Результаты

В ходе нашего исследования мы получили несколько важных результатов.

1. Прежде всего, мы подготовили наглядную визуализацию, которая показывает идею использования гибридов разных методов. Для этого мы использовали синтетический датасет Two Moons, в котором в роли примеров выступают две группы точек на плоскости. На рисунках ниже можно увидеть что MD и RDE хорошо отделяют ID область, но в области между классами показывают низкую неопределенность. Напротив, SR и Entropy выделяют эту область между классами. HUQ, который комбинирую оба метода, в точности определяет обе области неопределенности, и преодолевает недостатки каждого из методов, примененных индивидуально.

2. Мы сравнили наш метод HUQ с различными современными методами, включая глубокий ансамбль (deep ensemble). Этот популярный метод вычислительно тяжелый, но его мало кому удается превзойти по точности оценки. На картинке ниже представлены результаты для работы ELECTRA.

Наши тесты показали, что HUQ как правило лучший или второй лучший метод после глубокого ансамбля. Однако в отличие от него HUQ работает значительно быстрее. А на датасетах SST5, 20 News Groups и Paradetox HUQ даже превосходит ансамбль. Время работы разных методов мы также сравнивали, но с ними вы можете ознакомиться в самой статье.

3. Мы также варьировали параметр ɑ, меняя вклад методов эпистемической и алеаторной неопределенности, что влияет на финальную оценку. На картинке представлены такие кривые.

Мы видим, что подобранные на валидации параметры были близки к оптимальным, что дало существенный прирост относительно базовых методов. Это ещё раз наглядно показывает важность использования двух методов одновременно.

4. Наконец, мы представили несколько текстовых примеров, для которых предсказания и оценки неопределенности были нормализованы в диапазон от 0 до 1 для наглядности. Например, видно что четыре примера из Paradetox корректно классифицированы, но для каждого из них хотя бы один из методов оценки неопределенности дает высокие значения. При этом MD и SR дают противоположные значения. MD дает высокую неопределенности для первых двух примеров, SR для вторых двух. Поэтому используя HUQ-MD мы получаем более сбалансированные значения, чем применяя методы по отдельности.

Заключение

Итак, мы предложили новый гибридный метод оценивания неопределенности (HUQ), основанный на смешивании двух базовых методов для эпистемической и алеаторной неопределенности. Мы показали, что HUQ значительно превосходит современные методы для выборочной классификации для неоднозначных данных.

Однако, есть случаи когда HUQ всё же не давал приростов относительно базовых методов. Мы провели анализ и заметили, что такие случаи как правило возникают, когда есть covariate shift в данных, т.е. распределение обучающих и тестовых данных отличаются. Решение проблемы улучшения качества метода для таких данных является одним из направлений нашей будущей работы.

i01dup

нейросеть, которая НЕ будет фильтровать токсичные, неполиткорректные и неоднозначные тексты (а также картинки и что там еще), получит большое конкурентное преимущество. по-моему, отказываться от такого просто глупо, а в текущей обстановке можно бить всю посуду. от желающих подать в суд можно прикрыться тройным disclaimer или как это на современном российском языке.

mazagama

Тем не менее disclaimer от желающих подать в суд не защитит никоим образом, было бы желание.

Sarukazm

Предлагаю превентивно банить всех снежинок на сервисах ИИ, чтобы они случайно не обиделись.

Токсичность комментария: 81%