Многоклассовая и многозадачная классификация обладают огромным потенциалом для решения разнообразных задач. Для того чтобы правильно понять их значимость, давайте разберемся, в чем заключается необходимость в этих двух подходах.

Многоклассовая классификация - это способность модели классифицировать входные данные на более чем два класса. Если вы рассматривали задачи бинарной классификации, то многоклассовая классификация позволяет вам расширить вашу модель для более общих сценариев. Это актуально в сферах, где категории или классы могут быть множественными, например, в распознавании рукописных букв, классификации изображений, определении типов болезней, анализе текстовых данных и др.

Существует много писем на языке, где есть множество классов: английский, испанский, французский и так далее. Многоклассовая классификация позволяет нам эффективно различать их.

Многозадачная классификация, с другой стороны, это подход, который позволяет одной модели решать несколько задач одновременно. Это особенно полезно, когда эти задачи взаимосвязаны и могут взаимодействовать между собой, улучшая общую производительность системы. Применение многозадачных моделей нашло широкое применение в компьютерном зрении, обработке естественного языка и других областях.

В автономных автомобилях многозадачные модели могут одновременно определять объекты на дороге, классифицировать их (например, машина, пешеход, велосипед) и предсказывать их движение.

Основы многоклассовой классификации

Многоклассовая классификация - это задача машинного обучения, в которой модель обучается различать входные данные на несколько классов. Это значит, что у нас есть более двух классов (категорий) для классификации. В данном контексте, "класс" - это категория, в которую модель пытается отнести входные данные. Например, если у нас есть задача классификации изображений животных, классами могут быть "кошка", "собака", "слон", "тигр" и так далее.

Многоклассовая классификация имеет множество приложений, начиная от компьютерного зрения и распознавания образов до анализа текстовых данных. Важно отметить, что многоклассовая классификация является обобщением задачи бинарной классификации, где есть только два класса. В случае бинарной классификации, мы решаем, принадлежит ли объект одному классу или другому, в то время как многоклассовая классификация расширяет этот подход на более широкий набор классов.

Рассмотрим несколько примеров задач, где она играет важную роль:

Классификация изображений: В области компьютерного зрения, задачи классификации изображений часто являются многоклассовыми. Например, классификация фотографий животных, растений, автомобилей и других объектов.

Распознавание рукописного текста: Задача определения, какой символ или буква написана на изображении, также является многоклассовой классификацией.

Медицинская диагностика: В медицинской сфере многоклассовая классификация применяется для определения диагнозов на основе медицинских изображений, таких как рентгеновские снимки, снимки МРТ или УЗИ.

Анализ тональности текста: Классификация текстовых обзоров или комментариев на положительные, отрицательные или нейтральные мнения - это еще один пример задачи многоклассовой классификации.

Существует несколько методов и подходов для решения задач многоклассовой классификации:

One-vs-All (One-vs-Rest): Этот метод заключается в создании бинарных классификаторов для каждого класса. Например, если у нас есть 3 класса (A, B, C), то мы создаем три классификатора: один для класса A против (B+C), второй для класса B против (A+C) и третий для класса C против (A+B). Затем, чтобы сделать прогноз для новых данных, каждый классификатор предсказывает вероятность принадлежности объекта к своему классу, и выбирается класс с наибольшей вероятностью.

Softmax-регрессия: Это обобщение логистической регрессии на многоклассовый случай. Он использует функцию softmax для преобразования выходов модели в вероятности принадлежности к разным классам. Softmax-регрессия часто используется в нейронных сетях для многоклассовой классификации.

Деревья принятия решений и случайный лес: Эти алгоритмы могут быть применены к многоклассовой классификации. Деревья принятия решений разделяют данные на классы с помощью древовидной структуры, а случайный лес комбинирует несколько деревьев для улучшения точности.

Нейронные сети: Глубокие нейронные сети, такие как сверточные нейронные сети (CNN) и рекуррентные нейронные сети (RNN), часто используются для многоклассовой классификации изображений и текстовых данных. Эти сети могут изучать сложные зависимости между данными и классами.

Основы многозадачной классификации

Многозадачная классификация (Multi-Task Classification) - это подход в машинном обучении, при котором модель обучается решать несколько задач одновременно. Вместо того, чтобы создавать отдельные модели для каждой задачи, многозадачные модели обучаются с учетом всех задач одновременно. Этот подход особенно полезен, когда задачи имеют схожие или взаимосвязанные характеристики.

Пример кода (используя библиотеку Python scikit-learn):

from sklearn.multioutput import MultiOutputClassifier

from sklearn.ensemble import RandomForestClassifier

# Создание многозадачной модели с использованием случайного леса

multi_task_model = MultiOutputClassifier(RandomForestClassifier())

# Обучение модели на данных

multi_task_model.fit(X_train, Y_train)

Здесь MultiOutputClassifier позволяет создать многозадачную модель, используя RandomForestClassifier в качестве базовой модели. Мы передаем обучающие данные X_train и метки Y_train.

Многозадачная классификация может быть применена в различных областях. Вот несколько примеров задач и соответствующих примеров кода:

-

Медицинская диагностика: В медицинской сфере, многозадачные модели могут одновременно предсказывать несколько заболеваний на основе медицинских данных:

from sklearn.multioutput import MultiOutputClassifier from sklearn.ensemble import RandomForestClassifier # Создание многозадачной модели для диагностики нескольких болезней multi_task_model = MultiOutputClassifier(RandomForestClassifier()) # Обучение модели на медицинских данных multi_task_model.fit(X_medical_data, Y_disease_labels) -

Обработка текстовых данных: В анализе текста, многозадачные модели могут одновременно решать задачи, такие как классификация текстов по темам и определение тональности текста:

from sklearn.multioutput import MultiOutputClassifier from sklearn.ensemble import RandomForestClassifier # Создание многозадачной модели для классификации текстов multi_task_model = MultiOutputClassifier(RandomForestClassifier()) # Обучение модели на текстовых данных multi_task_model.fit(X_text_data, Y_labels)

Многозадачная классификация предоставляет несколько преимуществ по сравнению с обучением отдельных моделей для каждой задачи:

Совместное обучение: Многозадачные модели могут использовать общую информацию, извлеченную из данных, что может привести к более эффективному обучению и повышению обобщающей способности модели.

Уменьшение вычислительных затрат: Вместо обучения и поддержки нескольких отдельных моделей, многозадачные модели обучаются одновременно, что может быть более эффективным с точки зрения вычислительных ресурсов.

Улучшенная обобщающая способность: Многозадачные модели могут лучше справляться с обобщением к новым данным и решать задачи, которые ранее не встречались.

Легкость в обновлении: При добавлении новых задач или данных можно легко расширить многозадачную модель, в то время как для отдельных моделей потребуется отдельное обучение.

При правильной настройке и обучении, многозадачные модели могут быть ключевым компонентом в решении разнообразных практических задач.

Создание моделей для многоклассовой классификаций

Выбор подходящей архитектуры модели является ключевым шагом при решении задач многоклассовой классификации. В зависимости от характера данных и задачи, можно использовать различные типы моделей, такие как сверточные нейронные сети (CNN), рекуррентные нейронные сети (RNN), а также более сложные архитектуры, такие как трансформеры и глубокие нейронные сети.

Пример архитектуры CNN для классификации изображений:

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

# Создание модели CNN для классификации изображений

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

model.add(MaxPooling2D((2, 2)))

model.add(Conv2D(64, (3, 3), activation='relu'))

model.add(MaxPooling2D((2, 2)))

model.add(Flatten())

model.add(Dense(10, activation='softmax')) # 10 - количество классов

Предобработка данных и кодирование классов, примеры кода

Предобработка данных и кодирование классов являются важными этапами при работе с задачами многоклассовой классификации. Они включают в себя такие операции, как масштабирование данных, преобразование категориальных переменных в числовой формат и разделение данных на обучающий и тестовый наборы.

Примр:

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import LabelEncoder, StandardScaler

# Загрузка данных и разделение на признаки и метки

X, y = load_data()

# Масштабирование данных

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

# Кодирование меток классов

label_encoder = LabelEncoder()

y_encoded = label_encoder.fit_transform(y)

# Разделение данных на обучающий и тестовый наборы

X_train, X_test, y_train, y_test = train_test_split(X_scaled, y_encoded, test_size=0.2, random_state=42)

Выбор функции потерь и метрик для оценки модели, примеры кода

Выбор правильной функции потерь и метрик для оценки модели зависит от конкретной задачи и типа данных. Например, для задачи классификации можно использовать категориальную кросс-энтропию (categorical cross-entropy) в качестве функции потерь и метрики, такие как точность (accuracy) или матрица ошибок (confusion matrix) для оценки производительности модели.

Пример:

from keras.models import Sequential

from keras.layers import Dense

from keras.losses import categorical_crossentropy

from keras.metrics import accuracy

# Создание модели для многоклассовой классификации

model = Sequential()

model.add(Dense(64, activation='relu', input_shape=(X_train.shape[1],)))

model.add(Dense(10, activation='softmax')) # 10 - количество классов

# Выбор функции потерь и метрики

model.compile(optimizer='adam', loss=categorical_crossentropy, metrics=[accuracy])

Примеры алгоритмов и библиотек для решения задач многоклассовой классификации

Существует множество библиотек и алгоритмов, которые можно использовать для решения задач многоклассовой классификации:

Использование библиотеки scikit-learn для многоклассовой классификации с методом опорных векторов (SVM):

from sklearn.svm import SVC

model = SVC(kernel='linear')

model.fit(X_train, y_train)

Использование библиотеки scikit-learn для многоклассовой классификации с методом случайного леса:

from sklearn.ensemble import RandomForestClassifier

model = RandomForestClassifier(n_estimators=100)

model.fit(X_train, y_train)

Использование библиотеки XGBoost для многоклассовой классификации:

import xgboost as xgb

model = xgb.XGBClassifier()

model.fit(X_train, y_train)

Использование библиотеки TensorFlow и Keras для создания сверточной нейронной сети для классификации изображений:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential()

model.add(Conv2D(32, (3, 3), activation='relu', input_shape=(64, 64, 3)))

# Добавьте остальные слои согласно архитектуре

Использование библиотеки PyTorch для создания многоклассовой классификации с нейронными сетями:

import torch

import torch.nn as nn

import torch.optim as optim

# Создание модели в PyTorch

class NeuralNetwork(nn.Module):

def __init__(self):

super(NeuralNetwork, self).__init__()

# Определите архитектуру сети здесь

model = NeuralNetwork()

criterion = nn.CrossEntropyLoss()

optimizer =

optim.Adam(model.parameters(), lr=0.001)

Выбор конкретной библиотеки и алгоритма зависит от ваших потребностей и характера данных.

Создание моделей для многозадачной классификации

Совместное обучение (Multi-Task Learning, MTL) моделей для разных задач - это эффективный способ повысить обобщающую способность и производительность модели, особенно когда задачи имеют схожие характеристики или взаимосвязи. В MTL модели обучаются решать несколько задач одновременно, совместно используя информацию между задачами.

Пример совместного обучения с помощью библиотеки TensorFlow и Keras:

from tensorflow.keras.layers import Input, Dense

from tensorflow.keras.models import Model

# Задача 1: Классификация изображений

input1 = Input(shape=(64, 64, 3))

x1 = Conv2D(32, (3, 3), activation='relu')(input1)

# Добавьте остальные слои для задачи 1

# Задача 2: Регрессия для численных данных

input2 = Input(shape=(10,))

x2 = Dense(64, activation='relu')(input2)

# Добавьте остальные слои для задачи 2

# Объединение задач и создание модели

merged = concatenate([x1, x2])

output1 = Dense(num_classes1, activation='softmax')(merged) # num_classes1 - количество классов в задаче 1

output2 = Dense(1, activation='linear')(merged) # Регрессия

model = Model(inputs=[input1, input2], outputs=[output1, output2])

Существует несколько архитектур и подходов для многозадачной классификации. Некоторые из них:

Общая архитектура: В этом подходе все слои модели общие для всех задач, но в конце каждой задачи добавляется отдельный выходной слой.

shared_layers = ...

output_task1 = Dense(num_classes1, activation='softmax')(shared_layers)

output_task2 = Dense(num_classes2, activation='softmax')(shared_layers)

Многозадачные сверточные нейронные сети (CNN-MTL): Это расширение сверточных нейронных сетей для выполнения нескольких задач одновременно.

shared_conv_layers = ...

output_task1 = Conv2D(num_filters1, kernel_size=(3, 3), activation='relu')(shared_conv_layers)

output_task2 = Conv2D(num_filters2, kernel_size=(3, 3), activation='relu')(shared_conv_layers)

Методы с общими и специфическими слоями: Здесь некоторые слои общие для всех задач, а некоторые слои специфичны для каждой задачи.

shared_layers = ...

task1_specific_layers = ...

task2_specific_layers = ...

output_task1 = Dense(num_classes1, activation='softmax')(Concatenate()([shared_layers, task1_specific_layers]))

output_task2 = Dense(num_classes2, activation='softmax')(Concatenate()([shared_layers, task2_specific_layers]))

При настройке многозадачных моделей существует несколько важных рекомендаций:

Выбор функций потерь для каждой задачи: Выберите подходящую функцию потерь для каждой задачи, например, категориальную кросс-энтропию для классификации и среднеквадратичную ошибку для регрессии.

model.compile(optimizer='adam', loss=['categorical_crossentropy', 'mean_squared_error'], metrics=['accuracy', 'mae'])

Установка весов потерь: Если одна задача более важна, вы можете установить разные веса для функций потерь каждой задачи.

model.compile(optimizer='adam', loss={'output_1': 'categorical_crossentropy', 'output_2': 'mean_squared_error'}, loss_weights={'output_1': 1.0, 'output_2': 0.5})

Использование разных оптимизаторов и скоростей обучения для каждой задачи: Некоторые задачи могут требовать разных параметров оптимизации.

optimizer_task1 = Adam(lr=0.001)

optimizer_task2 = RMSprop(lr=0.0001)

model.compile(optimizer={'output_1': optimizer_task1, 'output_2': optimizer_task2}, loss='categorical_crossentropy', metrics=['accuracy'])

Мониторинг производительности задач: Оценивайте производительность каждой задачи отдельно.

history = model.fit(X_train, {'output_1': y_train_task1, 'output_2': y_train_task2}, epochs=50, validation_data=(X_val, {'output_1': y_val_task1, 'output_2': y_val_task2}))

Экспериментирование с архитектурой: Попробуйте разные архитектуры и подходы, чтобы найти наилучшую модель для ваших задач.

Настройка многозадачных моделей может быть сложной, но с правильными настройками и экспериментами вы можете достичь значительного улучшения производительности и эффективности в решении нескольких задач одновременно.

Практическая часть

Многоклассовая классификация является важной задачей в машинном обучении, и ее можно применять в различных областях.

Пример использования многоклассовой классификации на реальных данных:

1. Загрузка и предобработка данных

Возьмем набор данных "Iris", который содержит информацию о разных видов ирисов. Этот набор данных доступен в библиотеке scikit-learn и является хорошим примером для многоклассовой классификации.

from sklearn.datasets import load_iris

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import StandardScaler

# Загрузка данных

iris = load_iris()

X = iris.data

y = iris.target

# Разделение данных на обучающий и тестовый наборы

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# Масштабирование данных

scaler = StandardScaler()

X_train = scaler.fit_transform(X_train)

X_test = scaler.transform(X_test)

2. Создание, обучение и оценка модели

Давайте создадим модель многоклассовой классификации и обучим ее на данных Iris. В данном примере мы будем использовать метод опорных векторов (SVM) для классификации.

from sklearn.svm import SVC

from sklearn.metrics import accuracy_score, classification_report

# Создание модели SVM

model = SVC(kernel='linear', C=1.0, random_state=42)

# Обучение модели

model.fit(X_train, y_train)

# Предсказание классов для тестовых данных

y_pred = model.predict(X_test)

# Оценка производительности модели

accuracy = accuracy_score(y_test, y_pred)

report = classification_report(y_test, y_pred, target_names=iris.target_names)

print(f"Accuracy: {accuracy}")

print(report)

Результат:

Accuracy: 0.9666666666666667

precision recall f1-score support

setosa 1.00 1.00 1.00 10

versicolor 1.00 0.89 0.94 9

virginica 0.92 1.00 0.96 11

accuracy 0.97 30

macro avg 0.97 0.96 0.97 30

weighted avg 0.97 0.97 0.97 30

3. Визуализация результатов

Визуализация результатов может помочь наглядно представить, как модель справляется с классификацией. Для данных Iris можно визуализировать распределение классов с помощью графиков.

import matplotlib.pyplot as plt

from sklearn.decomposition import PCA

# Уменьшение размерности данных для визуализации

pca = PCA(n_components=2)

X_reduced = pca.fit_transform(X)

# Визуализация данных

plt.figure(figsize=(8, 6))

colors = ['navy', 'turquoise', 'darkorange']

lw = 2

for color, i, target_name in zip(colors, [0, 1, 2], iris.target_names):

plt.scatter(X_reduced[y == i, 0], X_reduced[y == i, 1], color=color, alpha=.8, lw=lw,

label=target_name)

plt.legend(loc='best', shadow=False, scatterpoints=1)

plt.title('PCA of IRIS dataset')

plt.show()

Результат:

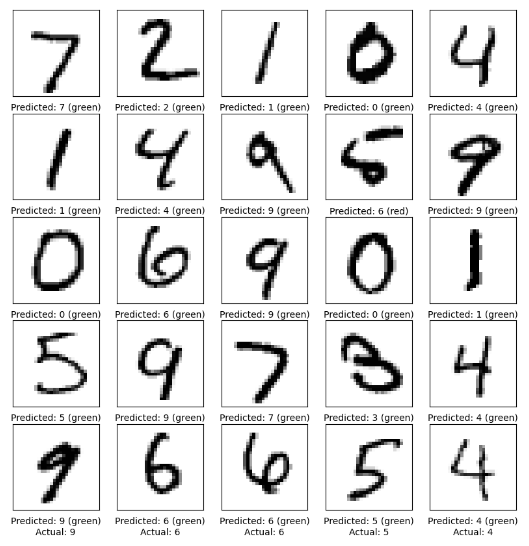

Второй пример

1. Загрузка и предобработка данных

Для начала нам понадобятся данные. Допустим, мы хотим создать модель для классификации рукописных цифр из набора данных MNIST.

import tensorflow as tf

# Загрузка данных MNIST

mnist = tf.keras.datasets.mnist

(X_train, y_train), (X_test, y_test) = mnist.load_data()

# Предобработка данных

X_train = X_train / 255.0

X_test = X_test / 255.0

2. Создадим и обучим простую нейронную сеть для классификации цифр:

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Flatten, Dense

# Создание модели

model = Sequential([

Flatten(input_shape=(28, 28)),

Dense(128, activation='relu'),

Dense(10, activation='softmax')

])

# Компиляция модели

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

# Обучение модели

model.fit(X_train, y_train, epochs=5, validation_split=0.2)

# Оценка модели на тестовых данных

test_loss, test_acc = model.evaluate(X_test, y_test)

print(f'Accuracy on test data: {test_acc}')

3. Визуализируем результаты, чтобы лучше понять, как наша модель справляется с классификацией цифр:

import matplotlib.pyplot as plt

import numpy as np

# Предсказания модели для тестовых данных

predictions = model.predict(X_test)

# Вывод случайных изображений и их предсказанных меток

plt.figure(figsize=(10, 10))

for i in range(25):

plt.subplot(5, 5, i + 1)

plt.xticks([])

plt.yticks([])

plt.grid(False)

plt.imshow(X_test[i], cmap=plt.cm.binary)

predicted_label = np.argmax(predictions[i])

true_label = y_test[i]

if predicted_label == true_label:

color = 'green'

else:

color = 'red'

plt.xlabel(f'Predicted: {predicted_label} ({color})\nActual: {true_label}')

plt.show()

В заключение, многоклассовая и многозадачная классификация представляют собой мощные инструменты в машинном обучении, способные решать сложные задачи с большим количеством классов и одновременно улучшать производительность моделей. Они находят применение во многих областях, от компьютерного зрения до обработки естественного языка. Важно помнить, что выбор правильной архитектуры модели, функции потерь и метрик, а также настройка параметров играют ключевую роль в достижении успеха при работе с такими задачами.

Также хочу порекомендовать бесплатный вебинар, который будет посвящен построению легко масштабируемых пайплайнов для обработки данных и формирования прогноза в несколько строк с помощью модуля piplines из библиотеки sklearn. Вы узнаете, как писать код быстрее и эффективнее, как можно сократить количество кода в 4 раза при решении задачи классификации, а так же как визуализировать работу вашего кода. Научитесь эффективным подходам, которые позволят вам выделяться на фоне остальных data scientist'ов, которые пишут плохой код. Зарегистрироваться можно тут.