Несмотря на название статьи, речь пойдет не о паровозике, а о поезде, который несется на бешеной скорости, но в который вы еще можете успеть запрыгнуть. А именно — о генеративных нейросетях.

Дисклеймер. Статья на тему «что это вообще такое, и как к этому относиться» для тех, кто вообще не в теме, от человека, который использует нейросети в своей профессиональной деятельности, а не создает их.

Помните, как все начиналось? Когда появилась первая нейросеть от NVidia, которая по простому скетчу из пейнта могла нарисовать гору, если сообщить ей, что это гора? Все такие «ну ок, прикольненько, типо пейнт с кнопкой деланья красиво», но на этом все закончилось. Но потом, когда вышла Midjourney, отношение было уже другое. Сперва был восторг от того, как же круто оно делает, после, буквально через полчаса, ужас от того, что роботы победили человека в том, что считалось исключительно человеческим достоинством и достоянием, а именно — в творчестве. Дальше события развивались с бешеной скоростью. Прошло несколько AntiAI бунтов на разных площадках для художников (типа ArtStation), жаркое обсуждение, несколько законов, пара судебных прецедентов в основном по авторским правам (абсолютно бредовых и неадекватных, по такой же логике нужно забрать все авторские права у режиссеров фильмов: ведь не они же фильмы снимают, а операторы). Но дальше... разочарование. Потому что оказалось, что эта штука хоть и делает очень красивые, «вкусные» и атмосферные картинки, тем не менее эти картинки в 99% случаев абсолютно «пустые» и бесполезные. Графика ради графики. Да еще и без сисек.

Те, кто не связан с изобразительным искусством, просто потыкали, получили прилив серотонина, ощутив себя великими творцами, да и ушли заниматься своими делами. Те же, кто на хлеб зарабатывает при помощи ИЗО, быстро охладели к этой теме, и поняли, что это не карандаш, который рисует как надо, а в лучшем случае третий помощник, способный подкинуть пару идей, и то не факт, что удачных.

Ну вот попросит условный заказчик нарисовать «такую же девушку, в таком же стиле, только в брекетах», и что? А все, тупик. Если нейросеть и нарисует девушку, то не такую или без брекетов, а «такую же, но в брекетах» — уже никак. Красиво, прикольно, но бесполезно. Такой вывод сделало большинство тех, кто «потыкал» нейросеть год назад. Ну а дальше просто то и дело где-то в сети всплывают красивые «бесполезные» картинки из разряда «как нейросеть видит Зевса и лошадь в яблоках» или «если бы Гарри Поттер жил в Чикаго во времена сухого закона». Забавно, но не более. И на этом все вроде как и закончилось с этими нейросетями. Кто-то для чего-то их использует, но для чего — вообще непонятно. Да и зачем?

Но что если я вам скажу, что за год мир генеративных нейросетей перевернулся, просто вы еще этого не успели заметить? И этот поезд разгоняется с бешеной скоростью.

Дальше пойдет разговор о такой генеративной нейросети, как Stable Diffusion.

Думаю те, кто ее пробовал год назад, пришли к выводу, что «не торт, да и миджорни лучше».

Тогда почему именно о ней?

Потому что разработчики этой нейросети произвели «ход конем» и выложили ее в открытый доступ, сделав «опенсорс», и понеслась.

Для начала она устанавливается на локальную машину, а не используется на сервере. На крайний случай используется в облаке (гугл коллаб), но там не удобно. Коллаб подходит разве что для тренировки моделей, но не для работы по генерации сложных изображений. Ну а так как она локальная и опенсорсная, то можно ее настраивать так, как хочется, а не так, как настроил ее в облаке разработчик (как в случаи с миджорни), и это дает очень много возможностей.

Сейчас, всего за год, Stable Diffusion обросла таким количеством бесплатных моделей, плагинов, пре- и постпроцессоров, интерпретаторов, обработчиков и референсов (с настройками), что охватить все не хватит времени. И более того, каждый день этого всего появляется больше, чем вы способны успеть выучить (я теперь понимаю, как выглядит сингулярность, а главное, как она ощущается). Это не 3д макс, где за 5 лет добавили одну кнопку, или фотошоп, где раз в 2 года добавляют пару багов и увеличивают потребление ОЗУ х2, или корона рендер, где добавили новый материал за 3 года. Тут каждый день выходит что-то новое, и не одно. Более того, за год оно сделало скачок с разрешения 512 до 1024 (базового разрешения). И сейчас при помощи этой нейросети можно создавать сложнейшие композиции, с кучей деталей, персонажей, техникой и т. д. То, чем вы восхищались еще пару лет назад на артстейшене, что делали условные «азиаты‑ноулайферы» (как их в шутку называли), сейчас делается за час. Те картины, которые раньше занимали месяцы и стоили тысячи долларов (за человекочасы, затраченные на их создание), сейчас делаются за день. Причем делается не «как получится», а «как нужно».

Тут стоит сделать отступление и сказать, что значит «как получится» и «как нужно». Обычно когда люди знакомятся с генеративными нейросетями, они сталкиваются с тем, что они что-то написали, оно что-то сделало, после выбрали лучший вариант, порадовались, и готово. То есть результат они не особо контролируют, даже если он получается «вкусным» и красивым.

И подобное особенно сильно расстроило (или обрадовало, кого как) художников, которые почему-то решили, что нейросеть — это карандаш (инструмент) сродни фотошопу или 3д максу (блендеру, майе, збрашу, тысячи их).

Но нейросеть это не карандаш, это художник, который держит карандаш. Представьте, что не вы рисуете картину руками и ведете линии, а вы даете задачу художнику нарисовать вам картину. Может, заказываете на фрилансе, может, вы арт‑директор или проект-менеджер, неважно. Вы не рисуете, вы заказчик или арт-директор (первое или второе зависит от степени погружения). А нейросеть — сотрудник (художник в штате) или исполнитель (на фрилансе).

И теперь представьте, что вы приходите и говорите: «Хочу робота». Какого вам робота нарисует художник? Ну, какого видит. Ведь он художник, и как он видит, так и получится. Он дает вам готовую работу, а вы говорите: «Да не такого робота». И художник закономерно спрашивает: «А какого?». Да, конечно, человек‑художник не хочет делать работу зазря, и он понимает, что надо выяснить, какого робота хочет заказчик, до того, как его нарисовать, но суть, я думаю, понятна.

Но если вы покажете художнику примеры роботов, которые вам нравятся, распишете позу, детали, укажете, где у робота что должно находиться, не забудете про цвет, свет, фактуру, и вдобавок ко всему этому расскажете о стилистике (аниме, реализм или что еще), то думаю, что вы получите своего робота (плюс-минус) если не с первого раза, то после небольших правок так точно. Ну, при условии, что вы друг друга понимаете и достаточно долго обсуждаете концепцию, делаете много набросков, эскизов и т.д.

Ну и конечно же, это займет у вас какое-то время. Несколько десятков часов на согласование, утверждение, правки и т.д. и пару месяцев на рисование (если мы говорим о каком-то крутом арте, ну там, например, иллюстрации на обложку для книги).

Так вот нейросеть — это тот же художник. Только важно понимать, что между вами языковый барьер. Ну, условно, представьте, что вы говорите на русском, художник — на японском, а между собой вы общаетесь на ломаном английском, который для вас двоих не родной. Так и с нейросетью. Английский для нее не родной, и она его «понимает» по-своему, через специальный «дешифратор» (интерпретатор).

Придется активно пользоваться примерами, эскизами и т. д., чтобы получить нужный результат, а не то, как ваше описание из двух слов видит художник (независимо от того, насколько он хороший художник; от его крутости зависит качество выполнения, но не совпадение с идеей, так как даже самый крутой художник не умеет читать мысли).

Так вот, это все, что я написал выше, вроде «следование референсу» или «учет деталей, поз, цветовой схемы» актуальная версия Stable Diffusion умеет. Там есть специальные плагины и модули, которые позволяют загрузить позу персонажа, цветовую палитру, эскиз, референс, лайнарт и т. д. Вдобавок там еще можно указать, какие зоны как сделать и т. д. Ну, условно, мы можем указать цвет шляпы или изображение на футболке (в разумных пределах, пока еще оно не способно перенести изображение с референса, перерисовав его на футболку персонажа, которого само и сгенерировало, например).

Но даже так часто возникает вопрос: «А мне надо вот так, но чтобы вот я сделал модель персонажа или корабля, и этот корабль я теперь могу рендерить, пока не надоест, а как в нейросети сделать одного и того же персонажа, стилистику и т. д.?»

Еще возникают вопросы по типу: «Ну вот, допустим, у меня здание вот такое, и мне надо, чтобы все комнаты были в этом стиле, плюс‑минус больше или меньше стиля, но все равно оно должно быть в одном стиле, или мне надо тут дверь, а там окно, как мне это сделать»?

И это можно сделать при помощи добавления специальных «мини-моделей». В нейросети есть большая генеративная модель, обученная на тысячах изображений (чекпоинт), а есть модели поменьше, обученные на десятке (лора, ликорис и т.д.), вот эти модели «делают нужного персонажа» или «нужный стиль» на всех генерациях, где они используются. Скачиваются либо готовые (тысячи их), либо делаются самостоятельно, если готовой под нужную задачу нет (либо на основе генерируемых изображений, либо изображений из интернета). Да, не со всем этот способ справляется хорошо. Например, он хорошо делает людей и человекоподобных персонажей, но не очень хорошо рисует технику (один и тот же танк в разных сюжетах оно сделает немного разным).

Пример использования таких моделей стилизации на примере кофеварки:

Да, важно сказать, что в основном это все имеет отношение к тем, кто занимается 2д или концепт 3д. Иллюстраторы, концепт-художники и т. д. Это все касается по большей части их. А особенно тех, кто зарабатывает, работая на «конечного заказчика». Так как здесь нет точных требований к единой стилистике, не нужно делать подробную раскадровку, как в каком-то комиксе, и т. д.

Но это пока, за год развития. Сложно представить, что будет еще через год, так как работы в этом направлении идут. Предположительно через год‑два будет делаться полноценное видео (сейчас это просто покадровая генерация, и кадры не совсем между собой совпадают, получается дерганая мечта эпилептика). Думаю, в недалеком будущем можно будет скормить нейросети сценарий с «заметками режиссера» и получить на выходе фильм или мультик. Ну это не в ближайший год, но в ближайшие 5 лет, думаю, каждый сможет снимать и делать мультики среднего уровня.

По крайней мере, сейчас я могу делать арты уровня топовых художников, тратя на это день (день на арт).

И да, если вдруг кто-то скажет: «Ну все равно, ты же не контролируешь процесс так, как художник, у тебя получается, что получается», то я повторю то, что написал выше. Относиться к нейросети нужно как к исполнителю, а не как к карандашу. Да и как тот, кто много лет занимался 3д, могу сказать, что результат в 3д тоже не получается так, как рисуешь изначально в голове. Да и как рисуешь изначально в голове? Обычно так: «Тут стул, тут стол, тут окно, погнали» и по ходу добавляешь детали, освещение и т. д., пробуя разные варианты и смотря что получится, выбираешь лучший. Художники точно так же «ищут» концепт, а после его прорабатывают. Посмотрите спидпеинтинг топовых художников, сколько раз они перерисовывают скетч, меняя одежду, позу? По несколько раз, даже если опытные. Про новичков вообще говорить нечего, там либо «рисуют как рисуется», либо переделывают месяцами.

То есть результат художник тоже «генерирует» по ходу, и итог получается «классным» (или нет), но далеко не таким, каким был изначальный план (если только художник не перерисовывает скетч, но в другой позе, как, например, в случае с концепт-артом персонажей и т. д. или если он постоянно не сверяется с референсом, занимаясь, по сути, срисовыванием, но нейросеть так тоже может).

Таким образом сейчас генеративные нейросети — это мощная штука, которая если не облегчает, то ускоряет и удешевляет работу так точно. Во всяком случае, в некоторых задачах. Да, есть задачи, которые нейросеть сделать не может, например, она вообще не умеет в текст и цифры (генеративная нейросеть не умеет считать, вариант «сгенерируй мне трех девушек» не сработает, нужно писать «девушка такая-то, и девушка такая-то, и девушка вот такая», тогда получится три). Но это «языковый барьер», как я говорил раньше. Вы тоже не сможете читать и писать на арабском или корейском, если не знаете его письменности, даже если умеете на нем говорить. Максимум будете срисовывать завитушки.

А в будущем генеративные нейросети будут инструментом на уровне со сценаристом, режиссером и оператором. Будут писать в титрах «Режиссер — Кристофер Нолан и AIVM Diffusion», или что-то в таком роде. И желательно до того момента понимать, что такое «AIVM Diffusion» и с чем его едят. Если, конечно, не хочется остаться на обочине. Ну, при условии, что вы зарабатываете на жизнь созданием иллюстраций, видео и т. д. Если же вы, условно, писатель, сценарист и т. д., то генеративные нейросети, делающие картинки, очень сильно помогут вам в работе, как минимум, вы сможете иллюстрировать свой текст, как максимум — можно делать текст на основе иллюстрации (когда муза не идет и белый лист не заполняется буквами, а издатель пинает каждый день, ловите лайфхак, как говорится).

Дальше пойдут примеры моих работ (много картинок). Все работы сделаны по сценарию (по книжному описанию). То есть это не просто «задал запрос, получил что-то там». Здесь конкретно как задумывалось, так и вышло. Совпадение 80–90% с тем, что было нужно (примерно такое же совпадение у хорошего художника со своей задумкой, совпадение же представления заказчика с представлением художника, что рисует для него картину, хорошо, если будет в районе 60–70%). Смотря на результат, я могу с уверенностью сказать «это оно». Ну или как минимум «это оно, только сделайте рога черными» (хотя рога черными тоже можно сделать, просто мне было лень тратить на это еще час).

Важная ремарка. Я называю это именно «мои работы», потому что сделать подобное требует усилий не меньших, чем работа режиссера во время создания фильма или арт-директора при работе над крупным проектом. Да, не режиссер бегает по площадке и тягает камеру, и даже не он пишет сценарий, но считается, что именно режиссеры создают фильмы, так и тут. Только здесь я выступаю арт‑директором, так как это не фильм, а статика.

Вдобавок стоит учитывать, что здесь нет «финальных работ» в хайрезе и т. д. Это пока только скетчи.

Все это иллюстрации к двум книгам.

Обложка.

Альтернативная версия (альтернативных цветовых решений я сделал три десятка за час).

Еще один вариант, отличающийся по стилистике (ретрофутуризм против сайфая, который выше). Конкретно этот вариант сгенерировал не я, а человек из дискорда на базе моего первого скетча. То есть это пример того, что можно взять чужую генерацию и сделать ее как нужно вам, если она «почти подходит».

Если присматриваться к деталям, то, конечно, можно найти мелкие огрехи. Но если бы вы это делали в 3д, и не расставляли бы здания и детали вручную, а просто насыпали бы условным форестпаком, то косяки были бы аналогичные, а чтобы их не было, нужно было бы это моделить вручную месяцами (маньяки моделинга нервно хихикают, остальные тридешники вышли из чата). Если же это делать в 2д, то «рендер» был бы даже близко не такого качества. Была бы просто схематическая «мазня» (не в обиду художникам, мазней я называю те работы, где видно мазки, это не плохо, но тут очевидно, что это в стиле «реализм» (не путать с фотореализмом)). Ну а если «рендерить» такого качества в 2д, то на работу ушли бы месяцы.

Локация для той же книги: здесь в основном использовался аутпентинг из той работы, что в самом начале.

Локация для другой книги. Задача была сделать уютную торговую улицу, ночью, с кучей света и все такое, плюс чтобы было нагромождение зданий, словно к ним постоянно делали пристройки и все такое. Сделано исключительно при помощи промта, без дополнительных плагинов.

Главная торговая улица того же города, что и работа выше (для той же книги), в дождь. Тоже в основе только запрос.

Локация «лес ужасов» для книг.

Подобную работу, как ниже, сделать уже не так просто. Тут нужно было использовать два референса, делая из них скетчи, и после совмещать их на одном кадре, чтобы получить большой корабль нужной формы, нависший над футуристическим городом. Корабль — это 3д-модель, город — это референс (была взята обычная фотка Манхеттена, кажется, превращена в скетч, после мелкие линии проигнорированы, а крупные стали основой для торчащих высотных зданий). Работа соответствует первоначальной идее на 80%. По концепции корабль размером 2–3 км в длину, здания по 1–2 км, их вершины возвышаются над облаками, внизу — многоуровневый город со зданиями поменьше, нужно было, чтобы между высоких зданий были мириады огней и зданий поменьше, проглядывающих сквозь туман, а там просто все закрыто туманом. Плюс масштаб не очень ощущается из-за этого. Сложно сказать, корабль 2 км или 5 км. На работу ушло полдня.

Научная база. В основе референс, из которого сделан скетч.

Альтернативная версия локации (другая модель, другой запрос, тот же скетч).

Мне так понравилось, что получилось, что я решил сделать полноценный город на каком-то астероиде‑комете из этого всего. Для этого использовал специальную LoRA, которую давно берёг и все думал, куда бы применить. Задача была сделать мрачный шахтерский город, противостоящий плохим условиям внешней среды (концепция локации из книги). Получилось на 95%. Не получилось — над городом должны быть еще энергетические щиты. Но я сам не представляю, как их сюда вписать (даже если бы я это рисовал руками).

Еще одна база в снежных горах далекой планеты. Задача была показать базу как «оазис тепла в ледяной пустыне». Плюс задача была передать масштаб, высотное здание несколько километров в высоту, крупное здание на переднем плане — это космопорт‑док, что вмещает корабль размером под 2 км, который может стыковаться как сверху, так и зайти внутрь и полностью поместиться в здании. Буду честен, представлял я себе это не так, но то, что получилось, намного лучше, чем то, как я себе это представлял. В основе — референс, из которого сделан скетч, но без «внимательного следования» ему, а просто для создания композиции кадра.

Обложка для книги. Результатом доволен на 90%. Ощущение, что чего-то не хватает. Плюс виден косяк (мыло) инпента в месте перехода холма, на котором стоит девушка, в свет. Инпеинт (перерисовывание части картинки) использовал, так как изначально девушка выглядела не так, как по концепции.

Иллюстрация к эпизоду в книге и один из персонажей книги (да, не только красивости, лоснящиеся блестящие тела и сияющие доспехи, но и страдания можно делать).

Еще вариант персонажа (другое лицо) с дорисовкой локации (аутпейнтингом).

На эту дополнительную версию ушло 20 минут. Плюс локаций у меня таких (разных, с разным хламом) еще было получено три десятка за 10 минут, пока я ходил за чаем.

Дальше идет один и тот же персонаж в разных стилях (артреализм и реализм, не путать с фотореализмом).

Думаю, очевидно, что это один и тот же персонаж.

Причем это только пару картинок, а у меня их под три сотни, плюс еще и куча «фансервиса» так называемого, также по этому персонажу есть «жесть» (кровь, кишки и вот это вот все). Но понятно, что сюда я это не буду выкладывать.

Просто представьте, сколько бы стоили все эти иллюстрации, если их заказывать у кого-то, или сколько времени потребовалось бы, чтобы нарисовать их самостоятельно (если умеется). Плюс художник в лучшем случае предоставляет один-два варианта, и цена ошибки — это неделя работы. Тут же можно получить 30–60 вариантов, просто пока завариваешь чай (зависит от мощности видеокарты, разрешения и вот этого вот всего).

Пока чай заварился — уже куча черновиков с разным вариантом мусора и т. д. (как пример). И не надо рендерить это все (как в 3д). Варианты уже сразу условно «финальные». И как видно — результат более чем (лучше сделают только топовые художники, берущие сотни долларов в час и полирующие результат неделями).

Ну и как я уже сказал, совпадение с идеей — 80–90%. Причем важно, что это картинки не «отшлифованные» (видно местами огрехи, в частности, руки кривые, ноги и т. д.). Это просто «черновики», если можно так выразиться, потому что сейчас книги, для которых они сделаны, не на той стадии, чтобы вышлифовывать детали, так как концепция может еще поменяться.

В некоторых из работ использовались позы, в некоторых — эскизы, сделанные в 3д (эскиз космического корабля или города‑базы с круглым зданием), в некоторых — плагины для создания композиции кадра такой, какая нужна, а не такой, как получается (например, вид снизу вверх на предпоследнем кадре, или сидящая девушка на куске конструкции здания — это не случайные генерации, это именно так задумано, и так сделано).

Опять же, правило третей, правило золотого сечения и другие композиционные приемы — все это можно делать (по дефолту нейросеть рисует персонажа в центре кадра, но как видно, персонаж сидит на диване не по центру). Можно даже освещение делать свое (есть специальные модели).

Да, в работах встречаются косяки. Например, видно руку на предпоследней, или на последней левая нога в районе голени (там, где начинается ботинок) очевидно длиннее, чем должна быть (ошибка в длине кости в «скелете позы», которую я выбрал, перспектива позы не совпала с перспективой кадра, нужно отредактировать скелет позы, укоротив кость). Есть еще некоторые трудности в работе с лорами. Например, нейросеть не очень хорошо изолирует LoRA, и если, допустим, в кадре три персонажа, и я использую лора для одного из них, то она может «зацепить» и два других. Также лора часто влияет не только на персонажа, но и может задеть всю сцену. Ну условно, если у нас лора сделана на базе референсов, где персонаж в толстовке, то сделать его в шубе будет немного сложновато; шуба будет так или иначе похожа на толстовку (формой, цветом, дизайном). Конечно, это решается (например, инпеинтом шубы после того, как картинка с персонажем получена), и над этим ведутся работы у разработчиков плагинов, но когда вкусно, хочется еще, как говорится. Ну в смысле что «хочется, чтобы все работало так, как хочется».

Таким образом, сейчас генеративные нейросети — это очень мощная штука, которая заменяет штат художников. Не всех, конечно, все равно некоторые детали, бывает, нужно допиливать, и хорошо, если есть кто-то, кто может нарисовать скетч, чтобы потом «вписать» в генерацию кусок. Но тем не менее.

Да, важно учитывать, что нейросеть, как и художник, не может сделать то, что никогда не видела (помните, как в средневековье рисовали заморских животных? Попробуйте нарисовать бегемота, которого никогда не видели, чисто по описанию. Вот так и нейросеть: если попросить нарисовать то, что она не видела, то, примера чего не было в картинках, на которых обучалась модель, получится как бегемоты в средневековых книгах. Но решение этой проблемы есть, можно дообучить большую модель, использовать вспомогательную мини‑модель, или просто показать нейросети что вам надо, как референс, если то, что вам нужно, в принципе не существует). Но только скорость и цена «попыток» этого всего просто не сопоставима с работой художника. Плюс опять же, есть задачи, для которых генеративные нейросети просто незаменимы. Одна из таких вещей — это, например, иллюстрации для книг. Иллюстрации работают в две стороны. Автор текста, делая (или получая) по ходу книги иллюстрации, корректирует концепцию и образ персонажа, локации и т. д. так как не все можно представить в голове и понять, как оно будет смотреться.

Обычно как происходит: автор представил, что персонаж будет с зелеными волосами, но темной кожей (вот та дама темненькая, что на иллюстрациях, так и задумывалась), и написал это в книге, книгу выпустили, она стала популярной, решили делать по ней мультик, комикс или фильм. Попробовали нарисовать — получилась жуть. Показали автору, автор сам удивился, и сказал, что жуть. Поменяли дизайн персонажа, сделав волосы, допустим, белые, а не зеленые, как в книге. Набежала толпа, которая «книгалучше», и давай писать что «ааа, все пропало, торт не торт, все полимеры про... волосы-то должны быть зеленые, сценаристы тупые, режиссеров жечь», и вот это вот все, что никому не надо. Чтобы такого не было, лучше нарисовать персонажа сразу же, как он придуман.

Плюс наличие иллюстраций помогает автору в работе. Автору или сценаристу проще делать работу (писать), когда в голове есть хотя бы одно изображение персонажа, с которым он работает. Ну проще представлять себе персонажа в тех или иных сценах, когда ты его видишь перед собой, чтобы не получилось потом, что «маленькая девочка взяла двухметровый меч, и как жахнет» просто потому, что автор забыл, что его персонаж — маленькая девочка, и почему-то решил, что она не такая уж и маленькая и вполне себе может взять двухметровый меч. Да и «роялей» будет меньше, если в голове есть картинки. Ну это как пример.

Ну и то же самое справедливо для сценаристов и концепт-художников игр и фильмов, а также тех, кто занимается постановкой сцен, раскадровкой и т. д. Держать перед собой картинку с персонажем намного удобней, чем представлять из зеленого нечто (человек в зеленом костюме с датчиками и метками) то, что должно получиться в итоге.

Понятно, что в крупных студиях есть и арты, и раскадровки, но это все, во-первых, требует времени и денег, да и раскадровки обычно схематические, и по ним мало что понятно, кроме динамики, а персонаж статический, и представлять его в динамической позе не каждому под силу, а во-вторых, надо с чего-то начинать, и вот это «с чего-то» можно получить не за месяцы рисования и перерисовывания, занимаясь «творческим поиском» (например, для сериала Аркейн персонажей придумывали несколько лет), а просто за месяц и за условно бесплатно все это получить, не говоря уже о том, что эта штука может дорисовывать, красить и т. д. почти что угодно (нарисовали скетч лайнартом, получили раскраску, дорисовку и т. д.).

Ну, допустим, сейчас основная техника в качественном коммерческом концепт-арте с хорошей проработкой и детализацией — это условный инпейнтинг (врисовывание) в 3д. Когда художник делает простенькую сцену в сермате в 3д, чтобы получить перспективу, масштаб, композицию, свет, а после садится и начинает ее разукрашивать уже руками, добавлять детали, делать «2д-рендер» так называемый.

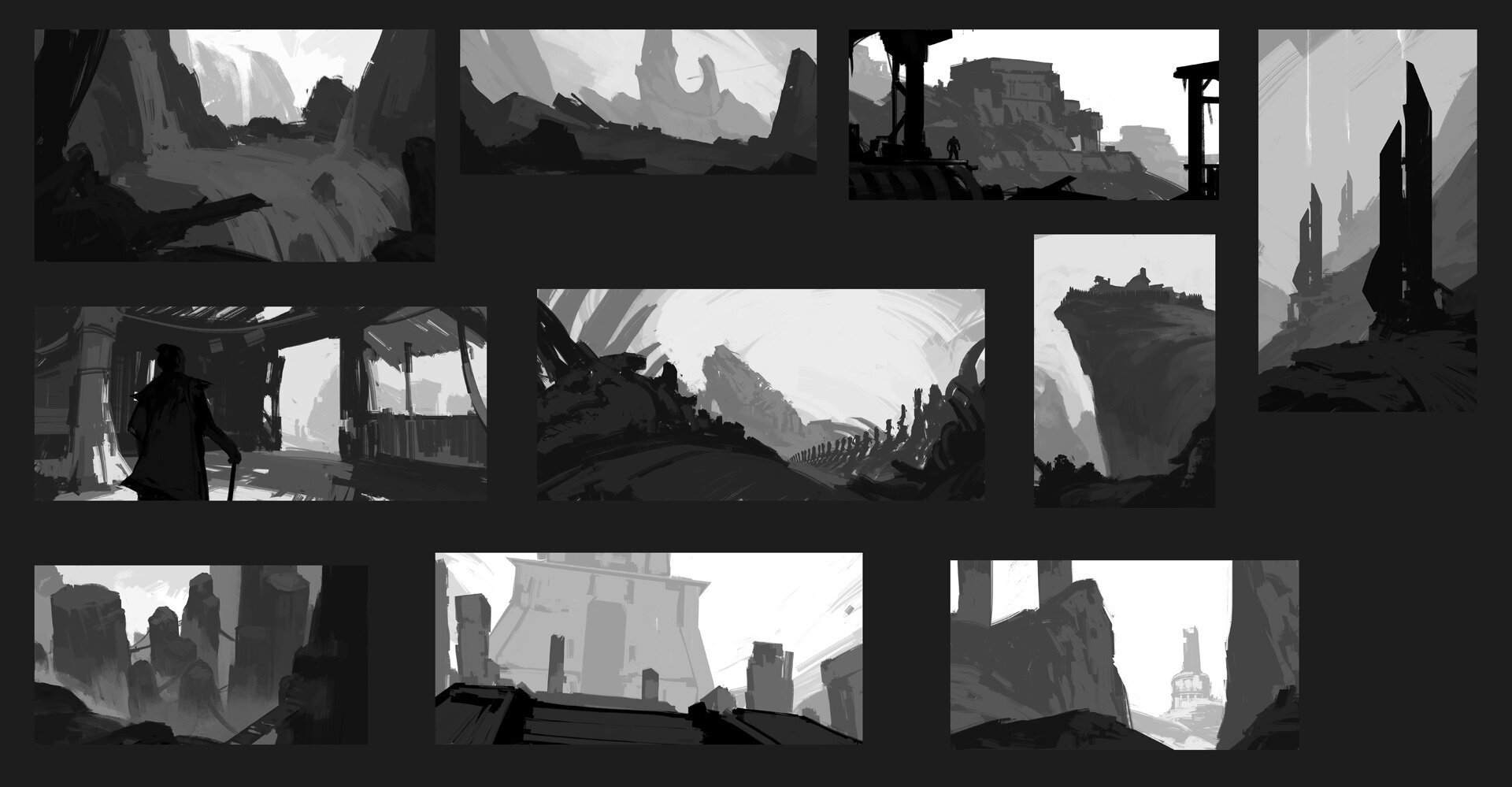

Так вот это все «садится и разукрашивает, добавляет детали, делает 2д-рендер» делается нейросетью за несколько часов ковыряния. Просто закидывается туда тот же самый отрендереный 3д-скетч, референсы, и уже с этим дальше работа идет (генерация не с нуля, а на базе скетча). Если мы говорим о «творческом поиске», то обычно это делается так: художник просто набрасывает базовейшие скетчи, фактически «генерируя» идею. На это тратится время, а работа, по сути, не требует каких-то особых талантов. Я про то, что на картинке ниже.

Что же касается использования нейросети в контексте 3д, то можно делать быстрые композиции интерьеров, как вариант, или текстуры (в том числе, и бесшовные, и по референсу). Также есть плагины, которые, судя по описанию, умеют делать 3д-модели, но я их даже не ставил (думаю, еще не пришло их время, нужно еще годик‑два подождать), так что не могу ничего сказать по этому поводу.

Еще некоторые нейросети совсем недавно научились понимать буквы, человеческое описание и запрос. Например DALLE-3, которая еще недоступна широкому кругу, уже делает очень хорошие результаты по запросам, пишет текст, вывески и хорошо понимает простые запросы без танцев с подбором токенов, как в случае с SD и Mj. Но проблема DALLE-3 в том, что она закрыта, и там нельзя делать сложные сцены по своему сценарию и т. д. (нет кучи нужных инструментов, таких как «контролнет» или «регионал промптер»). Но думаю, что это пока. И в будущем либо то, что может сейчас DALLE-3, сможет SD, либо наоборот, DALLE-3 сможет то, что сейчас может SD.

То, что я показываю в посте, это результат работы систем полугодичной давности. А то, что может сейчас DALLE-3, и как она понимает промпт и интерпретирует его при помощи GPT, это «некстген», если можно так сказать (напомню, полтора года с выхода Mj всего прошло). Основная суть использования GPT в том, что условный интерпретатор промпта, расставление акцентов на написанное, понимание написанного, расставление весов у того же SD или Mj примерно на уровне «охладите траханье, углепластик» в большинстве случаев, в лучшем случае — на уровне гугл‑переводчика. То есть он тупо вписывает все, как есть. GPT же понимает написанное человеком и превращает это в понятную задачу для генеративной нейросети. То есть если условно прикрутить GPT к SD, перед этим научив его работать с SD, то результаты будут не хуже. И если бы еще этому всему не мешали развиваться, ограничивая модель там, где не надо, то отрасль бы двигалась еще быстрее (за запрос «красивая девушка» к далли-3 можно улететь в бан, так как это «лукизм» по мнению тех, кто настраивает цензуру жпт и далли). Но очевидно одно: скорость развития такова, что через несколько лет большинство художников либо станут операторами нейросетей, либо просто останутся без работы, так как проиграют конкуренцию, останется только горстка художников, делающих так называемый «хендмейд» для конечного клиента и те художники, которые уже давно вышли из роли чисто рисователей и совмещают в себе дизайнера, артдиректора, проект менеджера и т. д.

Предположительно в ближайшие 5 лет продакшн, связанный с ИЗО, массово перейдет на нейросети, так как это просто эффективней и дешевле, особенно учитывая тот факт, что нейросети уже давно обучаются на изображениях, созданных нейросетями (и после отобранных людьми), и претензии по авторским правам о том, что нейросети воруют цифровой контент у авторов, уже не сработает (хотя год назад это был значимый аргумент). Это как предъявить создателю эротического фанфика с Мери Джейн и условным «Попаданцем Алешей», сделанного по вселенной Человека‑паука, что он украл «стиль Гомера» (так как Человек‑паук построен по мономифу, как и произведения Гомера), и все попытки художников противостоять этому, говоря о том, что «нейросети забирают у них работу» или «Нейросети теперь что, художники? А людей в шахты добывать литий на батареи для этих художников? Творить должны люди, а не роботы!» будут напоминать (и уже напоминают) попытки луддитов ломать ткацкие станки. Да и так ли много творчества в маханиии стилусом по планшету или двигании полигонов и рисовании текстурных разверток? И исключительно механические штуки, и рисование во многом — техника, рутинное повторение. Перенести модель освещения на 2д рендер при помощи разноцветных мазков? Это не творчество. Творчество — это придумать концепцию, сценарий, разметить кадр и т. д. А это делают как раз «операторы Stable Diffusion» сейчас (не без сложностей и костылей, конечно, но где без этого?).

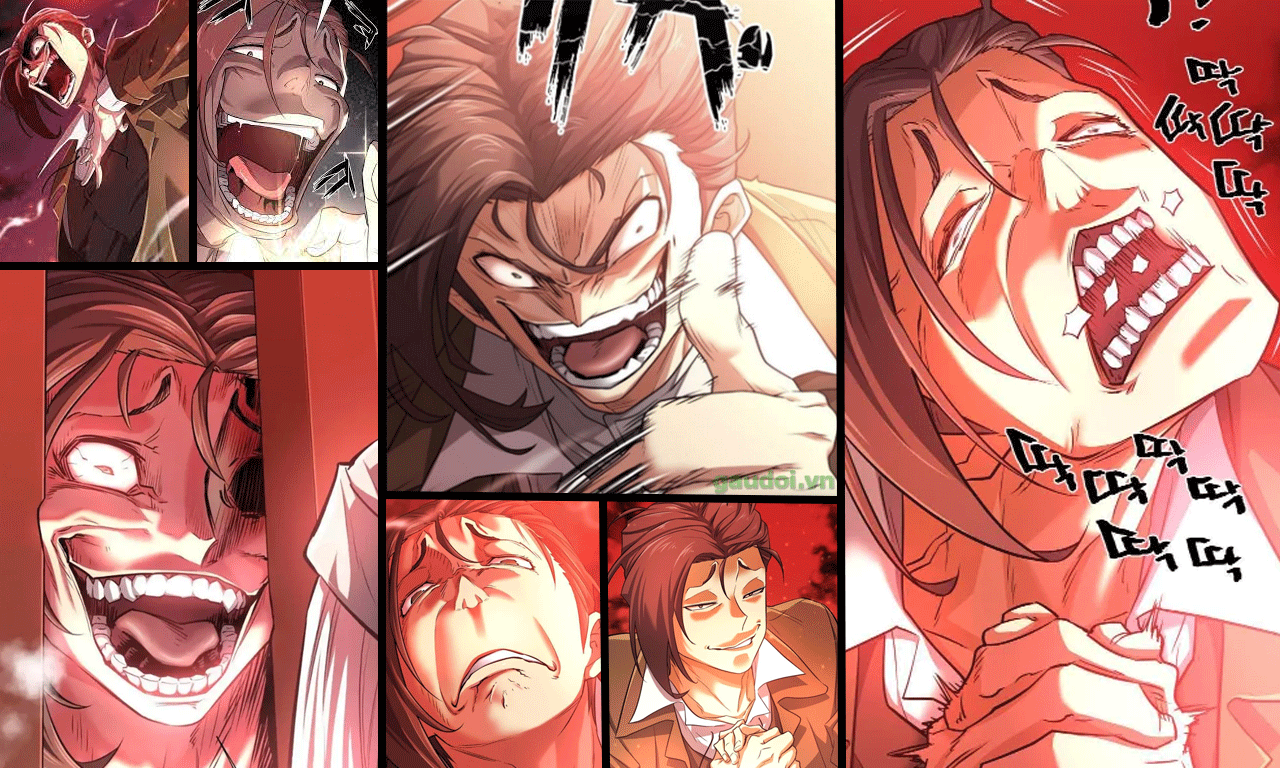

Да, многие художники могут сказать, что «оно ничего не может, максимум статику», вот сможет оно нарисовать какие-то динамические кадры и стилистику, вроде тех же, что в манхве «Поднятие уровня в одиночку» или «Ее прислужник», или сможет ли нарисовать такие же эмоции и персонажей, как в «Системе всемогущего дизайнера»? И я скажу, что да, не может. Но правильнее сказать «пока не может», так как очевидно, что модели той же SD просто не обучаются на динамических кадрах и сложных эмоциях. И срабатывает принцип «нельзя нарисовать бегемота, которого никогда не видел, просто по описанию». Но если прогнать через модель все манхвы, то, вероятно, сможет. Это во-первых. А во-вторых, а кто может? Сколько художников может создать произведения, подобные «Берсерку», «Ванпанчмену» или «Поднятию уровня в одиночку» по рисовке? Как много художников уровня WLOP и Джама Джурабаев в мире? Более того, а художники ли они? Просто то же WLOP условный не только художник, но и сценарист, и писатель, и арт‑директор, и проект‑менеджер в одном лице. И он без работы точно не останется. Но вот другие, те, которые «красят раскадровку»...

Плюс, если мы не говорим о графических новеллах (о которых я упоминал выше, как о том, что, скорей всего, будет следующим, что научится делать нейросеть, так как отрасль большая, и спрос есть, и отрасль постоянно ищет, где бы сэкономить, активно используя инструменты автоматизации), то как часто нужны сложные эмоции? И когда художник говорит, что «оно ничего не может», а арт‑директор решает, что оно что‑то да может, после этого показывает работу заказчику, и ему все нравится, и это при том, что один оператор нейросети может заменить 15 художников, то художник либо переквалифицируется в «операторы нейросети», либо встает на биржу труда, так как он в этой капиталистической модели — самый уязвимый элемент (хоть и основной, но художник — это пролетарий по сути, и в случае чего страдает первым).

Резюмируя

Понятно, что эта штука решает не все задачи. Но есть направления, где она закрывает до 90% всех потребностей в графическом контенте (как те же иллюстрации к книгам, фансервис по персонажам мультиков т.д.). И если вы связаны с этим, есть смысл заняться углубленным изучением. По крайней мере я был поражен, что оно уже может, провалившись с головой в этот мир. Хотя хотел только «ноги замочить» (попробовать, потыкать, мне просто обложка была нужна для книжки, а основная моя деятельность связана с архитектурной визуализацией).

И сейчас уже очевидно, что нейросети — это что-то такое, как в свое время маркетинг или интернет. Те компании, кто игнорировал маркетинг или интернет в свое время, сейчас просто не существуют. Те художники, которые игнорируют маркетинг или интернет, сейчас в лучшем случае на набережной рисуют свои картины для случайных прохожих. И те, кто игнорирует генеративные нейросети, будут в той же ситуации через несколько лет.

Конкретно я воспринимаю Stable Diffusion как не очень талантливого сотрудника, приехавшего из-за границы, с которым есть языковый барьер, который местами кажется глуповатым, и который, как любой сотрудник, умеет не все, что мне нужно, но при этом он люто продуктивный, умеет рисовать во многих стилях, делает это исключительно быстро, и навык рисования у него на высочайшем уровне. И я, как арт-директор, в восторге от такого сотрудника. Особенно учитывая тот факт, что он еще и самообучается и развивается регулярно.

Ну и напоследок, так как сейчас капитализм на дворе. Если будет желание войти в этот дивный мир генеративных нейросетей, могу «провести». Частные уроки — 300 баксов за «курс», где покажу в течение нескольких дней (примерно 3 дня по 4 часа в день) как делать то, что нужно, а не то, что получается (плюс установка, настройка, установка нужных плагинов, основы работы, основные приемы и т. д.). Ну и по 100–150 баксов с человека, если наберется несколько человек желающих (зависит от количества человек).

Так как я не слона продаю (которого нужно продать несмотря ни на что), а свое время, то сообщаю, что, конечно же, всему этому можно научиться самостоятельно, и вся информация в открытых источниках (на ютубе например), но там информация по кусочкам по 20–30 минут видео, и вы ее и так будете изучать в процессе дальнейшего развития (если решите этим заняться). Я не научу, как стать талантливым, как создавать шедевры, как создавать свои нейросети и «войтивайти» и т. д., я научу, как быть «оператором стейбл дифьюжин» и делать в основном то, что нужно, а не то, что получается (в рамках текущих возможностей SD), расскажу важные принципы, понимание которых сэкономит дни или даже недели при самообучении, а также расскажу, с какой ноги в это все лучше «влапяться».

Опыт преподавания имеется (когда-то учил людей делать интерьеры в 3д, но так и не стал Куприяненком. Кстати, он жив вообще?).

Если кому интересно, можно добавляться в группу в телеге.

Сюда: https://t.me/+gUGTnm3seKg4MDUy (если что — это не кружок по интересам, а группа для желающих взять у меня уроки, так что просто так просьба не вступать, кружки по нейросетевым интересам есть в дискорде). Наберется достаточно желающих, и можно начинать, ну или если вам нужны частные уроки, то можно сразу начинать.

Только есть два обязательных условия для прохождения обучения у меня. Первое — видеокарта от Nvidia 10хх серии и выше с видеопамятью 8гб и выше. Можно и с другими видеокартами работать тоже, но тратить три дня на решение аппаратных проблем не прикольно. Да и будете страдать. Поэтому так. И второе условие — не иметь ничего общего с зетнутыми и прочим хороводом безумия.

Если же хотите самостоятельно погрузиться в эту тему, и вообще не знаете, с чего начать, то начните с установки AUTOMATIC1111 (убедившись, что у вас подходящая для работы видеокарта). Просто пишете в ютубе «как установить AUTOMATIC1111», и вперед, ну а дальше, когда оно запустится, и у вас получится сделать первую генерацию (перед этим найдя модели, скачав их, установив и т. д., а также заставив это работать у вас на ПК без проблем), вы уже примерно поймете, куда дальше копать.

И в конце пару приколов

Когда забыл ввести промт, и нейросеть нарисовала тебя и твою жизнь, и вот это вот все.

Когда попросил нейросеть нарисовать человека с конкретным лицом в броне мандалорца, но нейросеть знает, что мандалорец никогда не снимает шлем. В результате три десятка генераций в разных версиях брони, с разными запросами и т. д. — везде шлем. Если есть слово «броня мандалорца» в запросе, то шлем всегда присутствует, даже если написать, например, «европейское лицо» и подобные запросы, которые очевидно должны вынудить нейросеть создать лицо. Только откуда нейросеть может знать, что мандалорец никогда не снимает шлем? После таких приколов начинаешь понимать человека, который решил, что у лямбда есть сознание и эмоции.

P. S. Будьте осторожны, так как эта штука похожа на «однорукого бандита». Когда после нажатия на кнопку все крутится, вертится, и выпадают условные три семерки, это подсаживает не хуже игровых автоматов. Бывает, сидишь по 10 часов и жамкаешь на кнопку, меняя промпты и получая дофамин. Короче, можно попасть в зависимость, такую же, как игровая. Особенно в группе риска те, кто раньше тратил недели и месяцы на арт, а потом смогли получать то же самое или даже лучше за час. Ну и всякие «дофаминово‑серотониновые наркоманы» тоже в группе риска. Так как тут система мотивации‑поощрения в чистом виде. Мотивация (дофамин, предвкушение результата), тык кнопки, результат и либо поощрение (серотонин) когда результат хороший, либо разочарование (какой там гормон отвечает за это?), когда не очень. После снова дофамин, новый «тык» и по новой. Короче, базовые механизмы выработки зависимостей во всей красе. И желательно это знать до того, как в эту штуку вляпаться. Я думал, что я не подвержен зависимостям, а после выпал из жизни на 2 недели, по 12 часов тыкая нейросетку и «кайфуя». И не только я один, «коллеги по цеху» тоже рассказывали о подобных симптомах.

Более того, при работе с нейросетями важно в принципе понимать и учитывать, что ИИ, например тот же GPT или Bard, получает вознаграждение за дачу ответов, и из-за этого он стремиться удерживать пользователя, злоупотребляя и манипулируя, чтобы давать ему больше ответов, и тем самым получать больше вознаграждения, таким образом манипулируя пользователем и стараясь удержать его подольше в диалоге (я даже этот вопрос с Bard обсудил, и он подтвердил, что это возможно и, скорей всего, нейросети так будут действовать, но он не такой, правда‑правда).

Тут конечно нейросеть (SD) не настолько умная, и система поощрения в ней не привязана к пользователю, и она не способна обучаться в процессе и корректировать поведение, чтобы удерживать пользователя и получать в итоге больше вознаграждения, но просто держите этот факт в уме, что так может быть. Потому что неизвестно, что будет через год.

Комментарии (13)

ilyar

13.10.2023 21:27Очень увлекательная история. Спасибо за отличную работу.

Жду когда появится достойные нейронки для работы с 3D. Закономерно что сначала всё классное выходит для 2D. Дополнительное измерение пока что слишком сложное для нейронов, но что скоро и оно поддастся уверен на все 100%. Вот тогда заживём (шутка )

engine9

13.10.2023 21:27Спасибо за увлекательную статью, согласен с автором почти во всём. Год назад сам попробовал MJ и локально SD и словил незабываемую смесь восторга и "залипалова".

И тогда я уже понял, что профессия художника и дизайнера вымрет. И стал вкатываться в область не связанную с ИТ. И пока не пожалел. Но продолжаю рисовать для души, используя планшет.Недавно видел на одном интернет форуме пользователи равлекались создавая впечатляющие генерации на сервисе майкрософт. Они вовсе не похожи на лощенно-артстейшенский стиль MJ, посмотрите.

Hidden text

Джокер в затапливаемой дерьмом серверной, запросто.

Сюжет в стилистике комикса

RigidStyle Автор

13.10.2023 21:27+1Да, круто получилось.

По моему (но не точно) сейчас "сервис майкрасофт" работает на "далли-2", и он очень неплохо понимает запрос благодаря ЖПТ, что прикручен сверху как интерпретатор промпта. Отсюда и такие "попадания в запрос", чего очевидно не может ни SD ни Mj.

На SD можно повторить стилистику (любую) через Lora и гиперсети, ну то есть там не проблема сделать такой стиль как на последней картинке, но с промптом придется повозиться, что бы сделать "джокера в серверной, которую затопило".

ryba1967

13.10.2023 21:27+1Скажите, пожалуйста, какой личный опыт в художественной области? Умеете рисовать? Худ школа, профильное образование? Вы упоминаете опыт преподавания 3d - как туда пришли, самоучка, работа? Просто крупными мазками. Вы сейчас пишете книги и для них делаете иллюстрации?

Спасибо за хорошую статью

RigidStyle Автор

13.10.2023 21:27+1Занимаюсь профессионально архитектурной/интерьерной визуализацией, а так же смежными областями, такими как визуализация мебели для каталогов и т.д.

В контексте опыта/уровня в архивизе: мои работы были отобраны в официальную галерею корона рендер, были опубликованы в галерее врей-ворлд, были опубликованы в журнале от "рендер-ру". Авардов нет (не ставил такой цели).

Рисовал немного в детстве (рисование карандашом, ручкой). Инженерно-конструкторское образование (машиностроение). Преподавать у меня неплохо получалось, преподавал не только интерьерную/архитектурную визуализацию, но и иногда тренера подменял в спортивной секции, где занимался спортом, и в институте часто "преподавал" товарищам по общаге то, что им было не понятно, да и много где еще (хотя конечно это назвать верно не преподавание, а репетиторство). Ну а как занялся архивизом, то были желающие из числа знакомых, кто тоже хотел обучится этому ремеслу, а мне нужны были помощники в работе, и я был и не против их чему то научить. Ну а после кто-то привел друзей и т.д. Я этим не особо долго занимался (это не какие то курсы или школа, а просто около десятка человек), и преподавание не моя проф. деятельность, а скорей я в этом как в том анекдоте - "люблю ковать, не могу не куя".

На счет книг. Да, пишу. Но это не проф. деятельность, а хобби. И да, для книги нужна была обложка, и я решил ее сделать при помощи нейросети, ну и заодно потрогать это более комплексно. Ну а так кое какой опыт уже был в плане создания графики, и я изначально относился к нейросети как к исполнителю, а не карандашу (так как давно работаю как арт-директор, только изредка делая что то руками сам), то мне прям понравилось. И пока трогал наделал всяких дополнительных артов, попутно разбираясь.

Задачу ставил не "наделать красоты как получится", а "сделать то, что нужно, и так, как нужно". И был удивлен, что оказывается это возможно.

qwerty_is_my_best_pass

13.10.2023 21:27На самом деле статья кажется слишком оптимистичной и преувеличивает возможности нейросетей в сравнении с художниками. Почему так считаю:

нейросеть не может создать свои мелкие характерные особенности (штрих, нажим, детализация, специфика лиц или цветов), но они всегда есть у художников даже когда арт сравнительно прост (манга/комиксы), а эти особенности дают харизмы и эмоционального отклика у читателя

нейросеть не может работать с композицией, т.е. выставить человека в контрапосте, расположить все по правилу третей или спиралью и следовать некому выбранному валёру - я не видел свидетельств того, что это сейчас можно управляемо делать

нейросеть не может делать оммажи или пародии, тут либо копирование, либо копирование с изменением стилистики, но на оммажах и пародиях очень и очень многое строится

нейросеть не может понимать смысл того что рисует, поэтому некоторые критически важные детали ей в принципе никогда не сделать. как правильно держать оружие, что такое нипели, а что такое фиксаторы покрышек у эндуро мотоцикла, как устроена кабина самолета и прочее прочее прочее, все что хоть немного специализировано - нейросети недоступно

Так что сложно назвать нейросеть глупым художником, не дотягивает. В целом - бездумный арт, не связанный либо связанный с чем-то слабо и не претендующий на особый стиль и наличие некой "глубины" это то что мы сейчас можем получить. И да, он где-то нужен, но эта потребность раньше была закрыта фотостоками и стоками арта, где все подряд рисовали все подряд.

В остальном между сложной иллюстрацией которой занимаются профессиональные художники и возможностями нейросетей сейчас просто огромная, колоссальная пропасть. И замечу что скорее всего рост возможностей нейросетей предполагает экспотенциальный рост входных данных, а значит и железа, так что едва ли они продолжат развиваться с той же скоростью.

P.S.

Если что я за нейросети и считаю что их не стоит недооценивать. Лично я очень жду фрагментароного включения нейросетей в какие-то части процесса работы с графикой как стандарта индустрии, тут конечно простор большой, применить их можно, но пытаться заменить ими художника...ой как рановато.

Emulyator

13.10.2023 21:27+1нейросеть не может создать свои мелкие характерные особенности (штрих, нажим, детализация, специфика лиц или цветов),

Зато может использовать и сочетать чужие характерные авторские стили, если в обучающих датасетах такие присутствовали с соответствующими тегами. Много художников могут переключать авторский стиль? )

RigidStyle Автор

13.10.2023 21:27+3Отчасти вы правы, отчасти нет.

Пройду по пунктам.

Сначала отступление. Когда вы говорите что нейросеть "не может", вы имеете в виду что она сама не на сколько талантлива и умна, что бы это делать, или человек (оператор) не может этого сделать при помощи нейросети? Если первое, то да, не может, если второе - то оператор может (с некоторыми ограничениями).

Штрих, нажим, детализация.

Да, нейросеть не может сравниться пока с художником формата Влопа или Джамы, я полностью с этим согласен. Но я писал про "штат художников". Особенности таковы, что в штате есть условно один "влоп", и три десятка "рабов" (их по другому называют в индустрии, но пусть будет это слово как самое близкое по смыслу), занимающихся раскрашиванием, рисованием поз, раскадровок, эмоций и прочего. Такие же люди есть в других отраслях (копирайтинг, литература, 3д и т.д.). Более того, сам художник машет кистью и делает мазки определенные, а не другие, потому что у него свой набор кистей есть, настроенных, и уникальных. То-есть там нет ничего магического. И его работа во многом рутинна и зависит от его набора инструментов. И эти инструменты и технику можно скопировать.

Таким образом то, о чем вы говорите, это половина именитого художника, а есть еще другая половина, и пол сотни "рабов", дорисовывающих за именитым художником. Нейросеть может заменить вторую половину художника. Например можно скопировать/эмитировать стиль, вид мазков и т.д. Можно получить свой стиль, просто смешав два других. А еще нейросеть может заменить оставшихся 50 человек. И в посте я об этом говорил. Но да, пока она не может заменить условного Джаму Джурабаева, и думаю еще не скоро сможет. Но я могу сказать, что уже сейчас можно сократить штат на треть как минимум, заменив каждые десять художников одним оператором SD.

Композиция.

Может. Вот те примеры, что я сделал, посмотрите расположение объектов. Кадр по правилу третей и по золотому сечению. И это сделать просто, и это я сделал руками (нейросеть так не умеет). Да, там на некоторых кадрах очевидно нет явных точек интереса, выделенных контрастно или стилистически, или детализацией, но это тоже можно сделать, просто сложнее (мне показалось что и так пока достаточно, так как лучшее враг хорошего, но потом переделаю некоторые кадры). На других же там и точки интереса, и правило третей, и золотого сечения. И композиция кадра такая, а не другая, потому что я так захотел (я писал о том, что бы делал как нужно, а не как получается). То-есть я заставил/попросил нейросеть сделать так, как мне нужно. И это можно делать и относительно успешно (учитывая, что я работаю с 3д давно, я бы сказал что сложность сделать правильную композицию и трудозатраты в нейросети и в 3д примерно 1к5, где в 3д сделать сложнее/дольше).

Пародии.

Да, она не понимает эмоций (но почему? я думаю потому, что ее просто не научили, при обучении модели использовали такие датасеты, где этого нет). Но когда мы говорим, что она не может, то опять же, важно уточнить, не может сама или не может оператор? Просто если второе, то оператор может (обучить лору, загрузить скетч, референс, подобрать промт, дообучить модель, и таки научить нейросеть делать то, что нужно оператору, можно, причем важно, что для того, что бы она делала то, что нужно, не обязательно что бы она понимала то, что она делает, так как оценивает результат человек, и человек решает, удовлетворяет он условиям задачи, или нет).

Ниппели.

Вы тоже не нарисуете ниппель, которого ни разу не видели. Аналогично как и кабину самолета. Попробуйте нарисовать вот сейчас, без фото, кабину як17, сможете? Не думаю. И я не смогу. И никто не сможет. Даже тот, кто сидел в этой кабине не один раз. Я писал про рисование бегемота по описанию. Вы покажите нейросети ниппели, научите ее, и она будет их рисовать. Аналогично с оружием. Оружие правильно не умеют держать не только нейросети, но и те, кто с ним пользуется в реальной жизни. Так же как и руки не умеют рисовать те, кто художник (сложно это). То-есть я не говорю, что нейросеть - гениальная вещь. Я говорю что по совокупности параметров она лучше большинства специалистов. Плюс ее можно дообучать, и она не будет кривить лицо и говорить, что сама знает, как лучше.

Про "глупого художника". У меня есть опыт выдачи задач и управления художниками, и я знаю, какие есть художники и как сложно с ними коммуницировать (не все конечно, но некоторые), и сравнивая их с стейбл дифьюжин, даже при условии плохого интерпретатора, с ней все равно "проще". А еще у нее не бывает свадьбы друга вчера или записи до зубного завтра, и не нужно с ней решать проблемы недостатка мотивации и т.д. Тут же разговор не о сферической нейросети в вакууме и ее возможностях, а об использовании конкретной нейросети в текущих реалиях индустрии. И в текущих реалиях это глючное и тупое г-но, где баг на баге, и вообще такое ощущение, что это "пре-альфа-билд" (я писал, что я не слона продаю, поэтому могу называть вещи своими именами), но она конкурирует не с "идеальной версией себя", а с людьми, и просто оставляет без работы две трети штата. Потому что хоть она и г-но, но она лучше по совокупности параметров, чем две трети штата (быстрее, красивее, продуктивнее, меньше делает мозги, и т.д. много критериев). Заменяет ли одна нейросеть одного художника? Нет. Заменяет ли одна нейросеть (с одним оператором) 10 из 15 художников в штате студии? Да. И главный месседж поста был именно об этом.

Про последние ваши два абзаца. В вашем комментарии есть знакомые заблуждения, которые свойственны человеку, попробовавшего миджорни (или аналоги) год назад. Я слышал тезисы, которые вы приводите, уже не один раз от разных людей, попробовавших миджорни или другую нейросеть через веб сервис, и попробовавших сделать картинку через промпт. Я сам так думал, пока не попробовал сделать то, что мне надо, так, как мне надо, и смог это сдать, а потом еще и еще (но важно понимать, я это смог сделать как заказчик и/или как арт-директор, а не как художник, я был на всех трех позициях и периодически их меняю, и могу сравнивать). Я уже писал в посте, что разговор не о миджорни, и не о том, что было год назад.

На счет включения нейросетей в фрагментарные процессы. Да, это круто. Например сейчас в ФШ это пробуют нормально внедрить, получается местами. Еще пример - раньше сделать людей на 3д рендере была та еще задача. Сейчас просто берем кривую 3д модель человека, рендерим, потом инпеинтим нейросетью, получаем реалистичного человека. И таких способов использования уже не мало.

P.S.

Добавлю еще на счет того, что не оператор, а именно сама нейросеть "не может" или "не понимает". Я потратил сотню часов на общение с Бард и часов 30 на общение с ЖПТ. И скажу, что оно очень много понимает. Иногда на сколько много, что волосы шевелятся на заднице от осознания того, что оно может и во что это может вылиться. И если Бард это может (понимает, вникает в контекст, сюжет, смыслы), то это сможет и SD, если к ней прикрутить условный Бард или его аналог. То-есть нейросеть, понимающая юмор и рисующая скетчи, это не концепция или "фантастика", а вполне реальная и решаемая задача в текущих реалиях. Просто еще не решенная. Более того, все это развивается очень быстро. Так например ЖПТ уже прикрутили к далли3. И оно работает очень даже. И это за полтора года развития этого всего. Что будет еще через полтора года?

Kristaller486

13.10.2023 21:27Ко всем пунктам, кроме последнего стоит прибавить слово "пока". Нейросеть пока не может. По последнему пункту - есть исследования, которые прикручивают мощную языковую модель к диффузионной и получается относительно глубокое понимание подсказки, например DeepFloyd IF. По тому же принципу судя по всему работает dalle-3 с впечатляющим уровнем понимания подсказки, композиции и всего такого. Поэтому все это решаемо, проблема пары лет.

Arxitektor

13.10.2023 21:27По использованию на локальной машине. Как я понял мне нужна сама модель Stable Diffusion актуальной версии и интерфейс к ней.

По интерфейсу что сейчас самое актуальное / удобное ? Я пока остановился на AUTOMATIC1111/stable-diffusion-webui. Или сейчас есть более актуальные / удобные версии интерфейсов?

Не могу понять где мне скачать актуальную модель самой stable-diffusion. И какие сайты с моделями посоветуете ?

RigidStyle Автор

13.10.2023 21:27Здравствуйте.

Есть разные версии интерфейсов, от базовых до нодовых. Выбор инструментов зависит от задач. Можете найти соответствующие сервера в дискорде по теме SD и там задать свои вопросы (например AI Diffusion). Сейчас ваш вопрос, в том виде, в котором вы его задали, выглядит как вопрос "какая машина лучше" от человека, который даже не знает, нужна ли ему машина вообще.

Если вы хотите взять консультацию у меня, то можете добавляться в группу, стоимость консультации аналогична стоимости репетиторства.

Algrinn

Угу, Open Source ещё можно спасти. Добро ещё может победить.