MVP дата-центра

История началась осенью 2021 года с посадочной страницы (разумеется, на jquery, яжбэкендер). На ней предлагалось «собрать» компьютер с GPU, чтобы затем взять его в аренду. Я выводил различные комплектующие (GPU, CPU, RAM, SSD), доступные в ритейле, кое-как высчитывал цену аренды и далее вёл потенциальных клиентов в Телеграм для обсуждения деталей. К началу 2022 года была проверена масса различных гипотез о том, какие комплектующие «ок», какие нет.

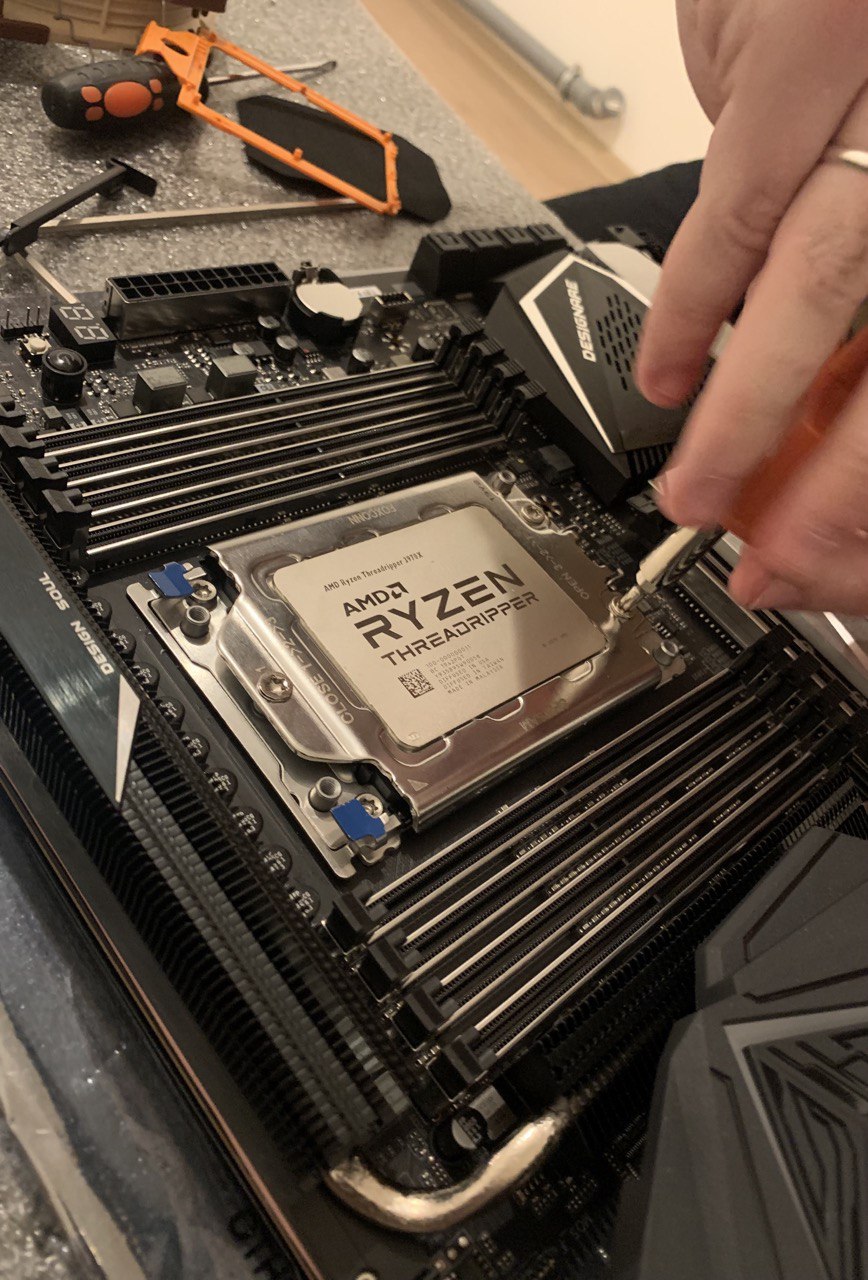

Например, был клиент, запросивший 32-ядерный AMD Threadripper 3970X, мы договорились о сборке в течение месяца, я закупил комплектующих на 250К₽, комп был собран, поставлена Windows Server 2019, адаптированы некоторые драйверы, которые поддерживали Windows 10, не 2019 и так далее... А клиент перестал выходить на связь ????. Конечно, стало понятно, что аренда таких конфигураций слишком дорогое удовольствие и под конкретные задачи их обычно просто покупают. Примерно через 4 месяца после этого мне удалось продать эту сборку на авито по себестоимости человеку, который приехал специально за ней из Минска с пачкой наличности ????. И уже затем картинка того, какие конфигурации действительно берут в аренду стала вырисовываться. Теперь уже без предоплаты мы не предоставляем серверы в аренду и даже не начинаем закупать комплектующие, если сборка какая-то особенная.

Стали появляться первые реальные клиенты, поэтому была сделана интеграция с банком, онлайн-кассой и ОФД (по одному API от банка), посадочная переписана на ReactJS, на нём же с теми компонентами написан зачаток личного кабинета клиента с пополнением баланса и выводом его клиенту, плюс некий список арендуемых компьютеров.

В качестве помещения была выбрана пустующая ипотечная квартира с ремонтом от застройщика (стены, ламинат и ванная комната — это всё, что там было). Был собран стеллаж, в который я поместил первые пару компьютеров. Интернет куплен у местного провайдера на физлицо под названием «800 Мбит/с».

Бизнес-идея была такая: десктопное железо (а-ля Kimsufi) + дискретные GPU = экономия клиента в 3-4 раза по сравнению с серверными аналогами. Все машины были спрятаны за роутером с 1 статическим IP и port forwarding'ом до конкретного компьютера. Да, всё верно, задачи клиентов не лежали в области хостинга веб-сайтов или даже работы 1C. В основном это были дата-сатанистыdata scientists, обучающие свои нейронки. Именно поэтому им не подходили решения от Селектела и прочих, где видеокарта с ОЗУ не меньше 24 Гб стоила от 80К₽, а в случае падения или недоступности я компенсировал 100% простоя округлённого до суток (т.е. обычно это было 2400% компенсации ????) для компенсации не-такой-высокой-отказоустойчивости. На втором месте по численности были рабочие места (VDI, только не виртуальные, а на физических компьютерах) под Photoshop, DaVinci Resolve, hashcat, GTA 6 и т.п.

По мере заселения новостройки, в течении полугода обслуживания нескольких клиентов, от интернета в «800 Мбит/с» осталась только вторая часть «Мбит/с», клиенты скидывали speedtest'ы, где мог быть 4 Мбит/с и потери пакетов в 8-10%. Меня такой расклад не устраивал и клиентов тоже.

Поэтому до подключения заготовленных тушек (платформ) дело не дошло — нужно было поработать над качеством самой локации, переходить от MVP и проверки гипотез спроса и ценности к созданию чего-то более качественного. Как минимум, с т.з. интернет-канала. Плюс, иногда отключали электричество, самый длинный отрезок составил 40 минут. У каждого компьютера была своя UPS, что спасло ситуацию в целом. Однако, интернет отключался вместе с э/э во всём доме, поэтому для многих клиентов это было равнозначно отключению э/э (хотя даже это для некоторых было не критично). Решено было собрать принципиально новую схему работы, сменив локацию. В том числе с целью увеличить кол-во киловатт (в квартире было 13 кВт), так как расчётное макс.потребление 1 компьютера было от 450 до 750 Вт, то кол-во компьютеров было в районе 15-17, чтобы можно было ещё и свет включить с чайником без риска вылететь ????

## Кастдевы клиентов

## Поиск инвесторов в дата-центр

Новая локация

Помещение было найдено на территории завода с двумя вводами (2 независимые подстанции) и пока арендодатель расчищал завалы, мы приступили к проектированию.

Были арендованы 2 помещения общей площадью ~50 кв. м, одно ~22 кв.м под сборочную, второе ~28 кв.м под серверную, оборудовано металлической дверью и 50 кВт э/э.

Размеры выбранных стеллажей были 2000 мм в высоту и ширину, 600 мм в глубину. Поэтому по проекту влезало 9 таких стеллажей по 12-14 серверов и 3 UPS'ки у стены. Итого максимальная ёмкость, которую можно было достичь была 126 компьютеров формата Mid Tower (плюс, предусмотрели, чтобы в каждом стеллаже была полка под Full Tower, т.е. 4 Full Tower на 1 стеллаж), что было избыточно, учитывая кол-во киловатт. тем не менее, мы договорились с арендодателем, что при желании (и за доп. деньги) они смогу подвести ещё 50 кВт в будущем в течении полугода. Что я посчитал приемлемым.

Сразу же было заложено 3 UPS'ки по 40 kVA каждая (~36 кВт). На территорию завода 2 независимых ввода, при этом весь корпус переключается между ними вручную в случае плановых работ или аварий арендодателем. Поэтому 1 UPS'ка подключается к 1 электрощиту, плюс 1 UPS резервная. Через систему байпасов и автоматов электрощитках, мы с командой заложили возможность выводить из эксплуатацию любую UPS, переключая нагрузку на UPS №1, она физически подключена ко всем электрощиткам и всем нагрузкам, на байпасах прописано какой вентиль за что отвечает, в электрощитках приклеены схемы подключений.

Как только грязные работы были проведены, мы начали перевозить компьютеры по мере возможности и подключать их через времянки в один из электрощитков, защищая теми же индивидуальными UPS'ами, что в предыдущей локации. Это спасало от перепадов напряжения (производство всё таки), которые пришли на смену отключениям э/э.

Мы переезжали с февраля по март 2023. До этого мне казалось, что если сотрудник чего-то не может, то это сделаю я. Однако, в процессе я научился нанимать фрилансеров на разовые работы — этот урок стоил мне сорванной спины (стал нанимать грузчиков) и расплавившегося в руках болтачуть не стоил жизни во время подключения аккумуляторов в одну из UPS (стал нанимать электриков). Теперь перед действиями я советуюсь с релевантными специалистами: с меня эскиз задачи, с них возражения, корректировки и конечное решение, когда задача детализирована и экономически целесообразна. Так получилось мини-КБ, в котором стали появляться различные решения, например, стойки для десктопного железа.

## Прошивка промышленных UPS

## Как поднять цены и не потерять клиентов## Десктопные карты в серверных ОС

## Почему б/у GPU — это как ставки на спорт

Линейка выделенных серверов (без дискретной GPU)

Появился клиент, которой симпатизировал моему подходу в создании и развитии дата-центра, и ему было интересно работать только на своём железе и в своём ЦОДе. Подход, о котором я пишу, можно охарактеризовать как проверка гипотез и переизобретение тех вещей, которые можно сделать дешевле без существенной потери в отказоустойчивости. Так появилась идея продать мой дата-центр и себя в рабствотоп-менеджеры с KPI привязанными к успешности проекта на рынке. Мы договорились об испытательном сроке, цели запустить 100+ серверов, продаже бизнеса через 3 месяца и ударили по рукам.

Проект заключается в том, чтобы запустить сервера на десктопном железе, поэтому можно было забыть про дискретные видеокарты. Плюс, помахать рукой уходящим в закат Hetzner и другим европейским дата-центрам с выделенными серверами на AMD Ryzen и Intel Core. Если убрать из уравнения дискретные видеокарты, то минимальный занимаемый компьютером объём можно резко сократить без потери в эффективности охлаждения. Поэтому я достал свои старые эскизы стойки для десктопного железа — проект не пошедший в работу из-за экономической нецелесообразности, для GPU-серверов дешевле было найти б/у корпус на авито, чем делать металлический каркас самостоятельно.

У моего клиента-покупателя-бизнеса были в аренде и требовали миграции из Европы в РФ десятки серверов с конкретными характеристиками и имелись хотелки по их изменению в лучшую сторону. Поэтому мы выбрали Ryzen'ы последнего поколения (Zen 4) с DDR5 и сформировали конфигурации под стать AX-52 и AX-102 от Hetzner. А чтобы разметить 100+ серверов в нашем небольшом помещении максимально бюджетно, спроектировали стойки под десктопное железо.

## Как подружить хотелки внутренних и внешних клиентов

## Гадание не анализе конкурентов

Стойки для десктопного железа

Напомню, что габариты стеллажей для GPU-серверов (читай «произвольной конфигурации») 2000х2000х600 мм. Поэтому высота стоек для нормального функционирования холодной комнаты должна была быть 2000 мм, а глубина позволяет быть до 600 мм. Следующим шагом был расчёт минимальной высоты для 1 компьютера. Оптимистичные 4 см превратились в 5, затем в 7.5, в итоге, после обнаружения достойных CPU кулеров, оказалось, что высота полки должна быть 10 см.

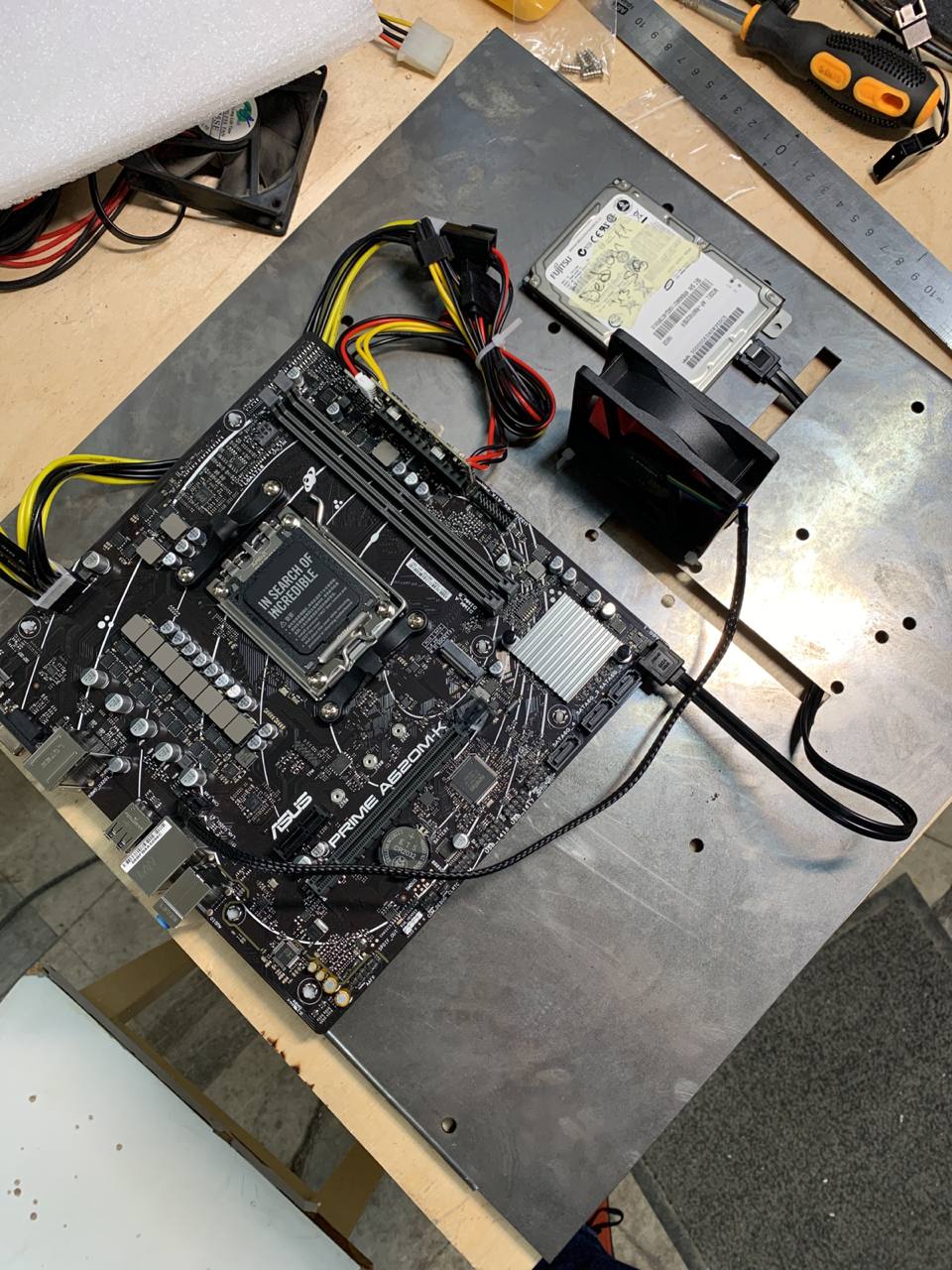

Нужно поддерживать размеры материнских плат от microATX до E-ATX, плюс корпусный вентилятор для охлаждения, плюс возможные диски 2.5", плюс допуски по бокам, итого 400х400 мм под полочку для сервера, плюс выносная планка для кабель менеджмента (например, разводки витой пары) на 20 см (тесты показали, что удобен именно такой размер). Чтобы сэкономить на блоках питания, решено было поставить 1 мощный блок (на ~3 кВт) на всю стойку и сделать разводку 12 В до каждой полки. Позже я узнал, что бигтехи в OpenComputeProject пришли примерно к такому же решению многими годами раньше меня. Далее скучные расчёты сечения проводов, создание специальных переходников на EPS8 + PCIE на PicoPSU для каждой материнки и так далее. Затем изготовление полочек из старых компьютерных корпусов с помощью смекалки, болгарки и молотка. А так же тестирование результата на каждом этапе. Например, фото ниже показывает одно из первых тестирований. Из него мы узнали как страшно крепить материнку близко к краю ???? и что сборка каркаса гайками вовнутрь при выдвижении полки без салазок подстраховывает администратора от падения полки ????

Видео раннего тестирования полки и проводки до неё.

В итоге было сформировано понимание того, что удобно, а что может быть опасным (у нас же нет слазок, например). Методом проверки различных гипотез мы пришли к определённому формату металлического каркаса, пластин в полки с защитой от провисания, креплениями для материнской платы и отверстиями для кабелей и крепления 2.5" дисков. И затем заказали производство полок по своему эскизу в компании, занимающейся металлопрокатом, с лазерной резкой и ЧПУ.

Большое фото с материнкой на стальной полке

Ограниченность пространства в нашей локации внесла свои коррективы — холодная комната оказалась необитаемойнепроходимой, поэтому стойки сделаны так, чтобы полки доставались из горячей комнаты, а кабели не сильно мешали этому процессу. Однако, новые стойки делаются по-другому. Их конструкция даёт возможность доставать пластину с сервером с обеих сторон стойки. На фото слева вы можете видеть первую MVP стойку, запущенную в эксплуатацию. Большинство решений тестируются на ней, поэтому она такая страшная в том числе, IP KVM и 2U кулеры под сокет AM5 (фото ниже) для охлаждения CPU с TDP до 150 Вт (если поварпроизводитель нам не врёт) вместо 125 Вт у классических кулеров...

Следующее поколение стоек

Практика показала, что у подхода собственных стоек для десктопного железа большая экономия средств и места в сравнении с использованием стеллажей и корпусов. Однако, имеются недостатки:

-

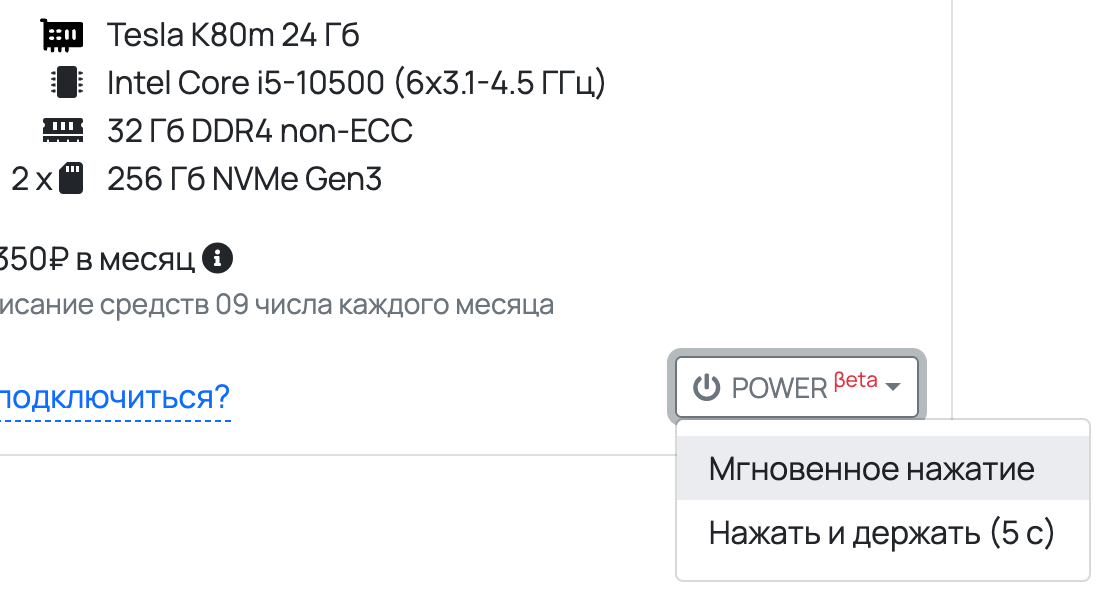

Для корпоративного клиента, управлять питанием на уровне стоек, вместо управления питанием на уровне сервера — это «ок», но нужен аналог PDU с удаленным управлением (такие стоят от 120К₽). У нас уже есть решение, которое интегрируется прямо в стойки нашего формата, сейчас оно проходит тестирование в бою для нескольких полок. За основу взяты девайсы умного дома, перепрошиты, подключены к нашему серверу и управляются по API из личного кабинета. В зависимости от требований к стойкам, это может быть как управление power button, так и управление электропитанием полки с физической кнопкой в стойке.

Управление power button из личного кабинета В десктопном железе отсутствует IPMI. Поэтому прямо сейчас мы проектируем решение в своём духе бюджетно и с достаточной отказоустойчивостью. Оно претендует скорее на звание IP KVM (аналоги стоят в районе 400К₽), так как IPMI PCIe-платы должны стоить так же как материнская плата ATX ????. В принципе, для клиента это может быть «ок» ставить IPMI плату ценой в 1/3 от управляемого железа. Но ещё неизвестно, есть ли программная совместимость между, например, ASPEED AST 2500 BMC и мат.платой от MSI на чипсете AMD B650 или <любое другое сочетание IPMI чипа и мат платы с сокетом AM5>. Мы же решили пойти путём удалённого KVM, совмещённого с управлением питанием полки и power button сервера. А задачи мониторинга остальных параметров системы (которые есть в IPMI) решить программным путём, пусть и не так круто, как это сделано в распаянных в материнской плате IPMI, главное, чтобы оказалось достаточно круто для наших клиентов.

Post Scriptum

Надеюсь, моя история показалась вам забавной: создатель «домашнего дата-центра» претендует на exit (нет), несмотря на отсутствие сертификации от Uptime Institute, аттестации ФСТЭК и так далее. Я решил не продавать компанию, а продолжить её развитие на чуть более широком рынке десктопного железа в принципе, не обязательно с дискретной GPU. И если вас интересуют стойки для десктопного железа (в т.ч. по вашим требованиям) или запуски мини-дата-центра для корпоративных нужд, велком в личку ???? @maxvyaznikov.

Комментарии (41)

strm

20.10.2023 21:32+2Имеется ли что-нибудь по типу прайс-листа чтоб сориентироваться по ценам аренды имеющегося железа или это все обсуждается в индивидуальном порядке?

Получается ли конкурировать с сервисами по типу vast.ai/clore.ai etc и сдаете ли там свои серверы в случае их простоя из-за отсутсвия клиентов?

По части KVM возможно окажется полезным вот этот проект https://github.com/pikvm/pikvm#the-future-v3-platform-work-in-progress

ha7y Автор

20.10.2023 21:32+2Есть 2 прайса:

Серверы на базе AMD Ryzen по стоечкам, копикат Hetzner AX Line ???? https://unit7.cloud/dedicated_servers/

GPU-серверы произвольной конфигурации ???? https://unit7.cloud/gpu_server_configurator/

vast.ai/clore.ai — это агрегаторы чужих GPU-серверов, у нас серверы свои. Чтобы «конкурировать» пока не дотягиваем до их уровня. В случае простоя пока не сдаём, такие мысли были, спасибо за напоминание!

По части KVM. Да, спасибо, буквально вчера его обсуждали!

old_bear

20.10.2023 21:32+3Итоговое фото, другой вендор мат.плат, другие CPU-кулеры, новые полочки

О, вы таки пришли к использованию top-down кулеров, с достаточно крупным вентилятором чтобы обдувать и материнку (по крайней мере важные части, вроде вторичных преобразователей и M.2 SSD), что добавляет разумной надёжности за относительно небольшие деньги.

У меня был похожий опыт с микросистемами минимальной высоты для домашнего использования. В итоге я понял, что чисто горизонтальный продув, пусть он и выглядит геометрически более правильным, требует использования мелких и скоростных вентиляторов серверного типа. А это дорого и/или шумно.Вообще статья понравилась, и ваш подход к решению задачи выглядит очень рационально.

отсутствие сертификации от Uptime Institute, аттестации ФСТЭК и лицензии связи. Я решил не продавать компанию, а продолжить её развитие

Надеюсь, что у вас таки есть exit plan на случай, если ваш бизнес дорастёт до того размера, который заинтересует

налоговуюуважаемых людей. Или если какой-то из ваших клиентов наследит в вашу сторону чем то расходящимся с генеральной линией партии...

ha7y Автор

20.10.2023 21:32«О, вы таки пришли к использованию top-down кулеров, с достаточно крупным вентилятором чтобы обдувать и материнку»

Да, именно так. Мы бегали по рынку CPU-кулеров и наткнулись на top-down формат, пока не набрели на «ID-Cooling IS-50X V3», который охлаждает в т.ч. зону VRM. Хотя он подходит не ко всем материнским платам с сокетом AM5 (что было неожиданно).

«exit plan на случай, если ваш бизнес дорастёт до того размера, который заинтересует

налоговуюуважаемых людей»Представляете, какого размера должны быть выручка и прибыль, чтобы им заинтересовались? — Вот за эти лет 10 роста такой план и появится ????

«Или если какой-то из ваших клиентов наследит в вашу сторону чем то расходящимся с генеральной линией партии»

Да, план есть. В основном, он заключается в соблюдении законов и открытой жизненной позиции.

select26

20.10.2023 21:32+3он заключается в соблюдении законов

Хм, а лицензия на передачу данных есть (а она необходима в вашем случае) и согласованные с УФСБ специальные условия?

Как только вы действительно начнёте соблюдать все требования, ваши цены неожиданно сравняются, а то и превысят HETZNER. Увы.

Про ИФНС я даже не упоминаю.И любой ваш конкурент или недруг, который возьмёт у вас в аренду сервер и совершит с него противоправные действия, поставит крест не только на вашем бизнесе, но и на вашей свободе.

Я тоже был таким. И построил крупный телеком в гараже. И знаю не понаслышке то, о чем написал.

Но это было 20 лет назад. Сейчас я бы не стал так рисковать.

ha7y Автор

20.10.2023 21:32+1Круто, спасибо! Проработаю риски с юристами чуть глубже. Тут, кстати, новый закон с 1 декабря обязывает зарегистрироваться в РКН и всё такое. Так что, да, приключений ещё будет.

Про цены Hetzner. По цене с ними конкурировать не получается, там цена капитала гораздо ниже (больше длинных денег). Поэтому цены не то, что ниже их не сделать, но и близко к ним не приблизиться. Я бы тут процитировал генерального Селектела, но сейчас уже не найду эти комменты под какой-то статьёй на vc. Суть в том, что пока на рынке РФ цены такие, что мой дата центр жизнеспособен и прибылен (и политика РКН работает как попутный ветер). Как только что-то изменится, то и я буду менять бизнес.

nitro80

20.10.2023 21:32+9Про канал на новом месте ничего не сказали

ha7y Автор

20.10.2023 21:32+3Да, пардон. На новом месте арендовали сначала 200 МБит/с, затем 1 Гбит/с, на прошлой неделе провели оптику с физическим каналом в 10 Гбит/с, пока работает на 2 Гбит/с. Смотрим. Подход тот же: прилаживать бизнес к запросам клиентов.

Есть понимание, что нужно подключать +1 интернет-провайдера для отказоустойчивости и тоже по оптике. Но пока проблема с enterprise коммутаторами в стране, эту задачу не просто решить в лоб. Пока что мы ушли в глубокое перепроектирование сети. А уже затем выплывем оттуда с конкретными критериями к интернет-провайдерам.

Taywox

20.10.2023 21:32Да не только с enterprise коммутаторами, а вообще с таким оборудованием и адекватности цен :(

Dantte

20.10.2023 21:32+2Здравствуйте.

У вас 2 пути, если хотите развиваться дальше как хостинг-провайдер, то вам потребуется своя AS, и свой блок IP адресов, PI или PA. После того, как у вас появляется своя AS, вы обязаны соблюдать требования по установке СОРМ, а потом и ТСПУ. Теоретически, есть возможность закрывать эти вопросы по типу IaaS, некоторые upstream провайдеры предоставляют такую услугу.

Главное, найдите грамотного сетевика, кто поможет вам с проектированием и строительством сети.

qid00000000

20.10.2023 21:32+1Надеюсь, у вас есть понимание, что на десктопных оперативках нет коррекции ошибок :)

Хотя у самого ноутбук работал в роли своего сервера под пет проекты пару лет и без проблем

ha7y Автор

20.10.2023 21:32+8Да, есть. Разным клиентам нужны разные вещи. Мои согласны на ускорение на ~15% в обмен на риск ошибок в ОЗУ. Как-то так. Т.е. скорость работы важнее отсутствия ошибок. Разные клиенты, разные задачи, разные требования к железу.

Sergei_Erjemin

20.10.2023 21:32+10Полностью симпатизирую проекту и подходу, но вот придут с требованиями поставить СОРМ и установить прочие "плюшки" -- так сразу этот колхоз и прикроется. Хорошо, если еще никого не посадят. :((((

select26

20.10.2023 21:32СОРМ - это спецусловия лицензии на ТУС и ПД. Там санкции - приостановление деятельности. А подтянут не за это, а за "осуществление предпринимательской деятельности без соответствующих разрешений (лицензий) для отдельных видов деятельности". В народе - незаконное предпринимательство. В зависимости от размера полученного дохода - статья была уголовная и несмешная совершенно.

Я тоже симпатизирую. Но не реализованному проекту, а идее. Спрос есть. И ниша свободна. Но порог входа - не сотни тысяч. Делать сразу нужно по уму. И уж как минимум, не переживать за свою свободу.

Я уж не говорю про резервирование питания, свою AS с несколькими аплинками, пожаро-охранную сигнализацию и службу безопасности.

alexEtse

20.10.2023 21:32+2В народе - незаконное предпринимательство.

Не в народе, а в том самом УК РФ ст.171. А вот в КоАП РФ ст.14.1 это называется "Осуществление предпринимательской деятельности без государственной регистрации или без специального разрешения (лицензии)".

Хотя суть та же.

Правда есть поддержанное в своё время РКН мнение, что деятельность хостеров не подпадает под услуги связи. Если, конечно, хостер "до кучи" не предоставляет сервисы почты, ВКС, или еще чего-то в этом духе.

Но зато от ряда других обязанностей это не освободит, в частности - по реагированию на запросы РКН по удалению информации; по сбору, хранению и предоставлению гос. органам информации о действиях своих пользователей...

select26

20.10.2023 21:32+2Правда есть поддержанное в своё время РКН мнение, что деятельность хостеров не подпадает под услуги связи.

К сожалению, давно уже не так. Выделяешь клиенту IP - оказываешь услуги ПД. Увы.

Даже IX'ы подтянули.

alexEtse

20.10.2023 21:32+2К сожалению, давно уже не так. Выделяешь клиенту IP - оказываешь услуги ПД. Увы.Даже IX'ы подтянули.

Ну не совсем не так - под услугу связи подпадает колокейшен, т.к. там оборудование клиентское. При сдаче в аренду своих ресурсов - услуга связи на самом хостере и заканчивается.

С IX вообще в своё время намутили еще в "Законе о Чебурнете", а в этом году еще и ТСПУ туда решили поставить (большая часть закона, конечно, о другом, но в конце аккуратно втиснули ТСПУ). Каждую кроссировку, похоже, пропускать через ТСПУ надо будет, хе-хе.

Правда есть свежачок от Горелкина от лета этого года, пока внесёные которым изменения в т.ч. в закон "О связи" еще не полностью вступили в силу (и в отношении которого шум спустили в сторону использования иностранный емейлов при регистрации, "замылив" остальные положения этого закона) - там хостеров действительно "донагрузили" СОРМом прямо в законе и требованием включаться в реестр. Так что для них особой разницы теперь уже не будет в этом плане.

eresik

20.10.2023 21:32Это получается комната 28 м2 будет нагреваться обогревателем мощностью 50 киловатт??? (а вроде бы и больше хотите потом).

Жарковато.

Taywox

20.10.2023 21:32+2Так не все уходит в тепло, при правильной вентиляции вообще не проблема, у меня приход был 75киловатт , расход 46 киловатт, но это на GPU фермах, стояло 5 выдувных промышленных ( постоянно работало 3, остальные 2 в зависимости от погодных условий) вход через фильтры без нагнетания, снизу помещения, метр от пола, но помещение было небольшое и отдельно стоящее.

SergeyMax

20.10.2023 21:32+1Так не все уходит в тепло

А куда девается?))

ha7y Автор

20.10.2023 21:32Ну. Киловатт-то 50, но это максимум, на что способна местная проводка. Например, в розетке у вас дома максимум 3 кВт, но это не значит, что от этой розетки нужно отводить 3 кВт тепла, верно? Это значит, что есть вероятность того, что в ней может быть пиковая нагрузка в 3 кВт. Т.е. в какой-то момент времени может получиться так, что 3 чайника одновременно будут кипятиться.

У нас стоит промышленный кондиционер, который всё отводит достаточно эффективно.

SergeyMax

20.10.2023 21:32-1Ну если в этом смысле, то конечно да. Просто у нас был энергетик, который при расчёте тепловыделения постоянно пытался КПД оборудования посчитать)

mirwide

20.10.2023 21:32Обычно, это всё таки проблема и самая сложная часть в проектировании серверной/ЦОД. Чтобы подача воздуха была не в метре от пола, а в фальшпол, иначе оборудование тоже должно быть в метре от пола. И чтобы фрикулинг справлялся с задачей, а он в принципе не может справляться если на улице +30.

novikovalegal

20.10.2023 21:32+3"От интернета 800 Мбит/с осталась только вторая часть - Мбит/с" Как же я ржу ????????????????

assad77

20.10.2023 21:32+1А вы знакомы с pikvm? А то может свой ipkvm и не понадобится

ha7y Автор

20.10.2023 21:32Да, спасибо! Мы как раз с ним прямо сейчас и экспериментируем. Для 1 компьютера 1 pikvm — это понятно, как далее масштабировать решение на всю стойку, встроить его туда, выдавать права доступа пользователям, шифровать и так далее.

kulhaker478

20.10.2023 21:32Есть ли программная совместимость между, например, ASPEED AST 2500 BMC и мат.платой от MSI на чипсете AMD B650 или <любое другое сочетание IPMI чипа и мат платы с сокетом AM5>

А должна быть? BMC по большей части прикидывается вполне устройствами и общается по стандартным интерфейсам. Максимум в биосе будет настройка сети, как на материнках Supermicro. Другой вопрос по барабану ли, самой железке с BMC к кому она общается, а даже если нет, то OpenBMC в помощь. Хотелось бы этот момент поподробнее уточнить, далеко не все вкурсе этих тонкостей (даже я)

И ещё вопрос, а есть ли вообще отдельные платы расширения с ASPEED за адекватные деньги? Всё ещё горю желанием при сборке домашней рабочей станции воткнуть туда IPMI. Но смотря на ценники современных плат (аля ASUS IPMI/ASRock Rack PAUL), возникает мысль, что проще купить плату со встроенным BMC

kroks

20.10.2023 21:32По поводу IP-KVM - у себя на проектах использовал комбинацию 8x1 KVM с TCP-IP/RS232 управлением и IP-KVM tinypilotkvm.com (который под капотом является RbPi + Python обертки и nginx), и в который можно зайти по SSH и подтюнить оболочку

Devd

20.10.2023 21:32Использую сборку pikvm на платках OrangePi Zero + HDMI USB. Получилось сделать даже кнопки Power / Reset.

ulex2006

20.10.2023 21:32"мусорные" сервера, вполне себе решения для ЦОД, в свое время в Московском департаменте ИТ поднимался вопрос о строительстве либо аренде таких вариантов.

Gradiens

20.10.2023 21:32А ваш клиент/покупатель бизнеса был готов к тому, что вы откажетесь его продавать? Как удалось в итоге договориться?

ha7y Автор

20.10.2023 21:321) Мы изначально строили отношения, исходя из 2-х вероятных исходов.

2) Я произвожу стойки для десктопного железа и являюсь реселлером их серверов. А благодаря этой статье, не только для них ????

Thomas_Hanniball

Примерно так и зарождались раньше хостинг провайдеры. Удачи вам в своих начинаниях.

ha7y Автор

Спасибо большое!