Доброго времени суток!

Представляю вашему вниманию чек-лист из 100 вопросов по Data Science. Вопросы покрывают 5 областей: SQL, Python, Machine Learning, статистику и собственно саму DS.

Кому это вообще может быть полезно:

желающему получить оффер в сфере DS

тому, кто уже давно дата-сайнтист, но хочется освежить какие-то алгоритмы/темы

кто хочет поменять стек на что-то в области анализа и присматривается к DS

Собрал здесь самые частые вопросы с собесов на позицию джуна Data Science, получился так сказать 95% доверительный интервал всех возможных вопросов. Так что если разобраться в этих вопросах, с большой вероятностью Авито, Тинькофф и что у нас там ещё делает DS примет вас к себе на борт.

А если с синдромом самозванца проблем нет, то смело пробивайтесь в FAANG* (*MAANG), успехов)

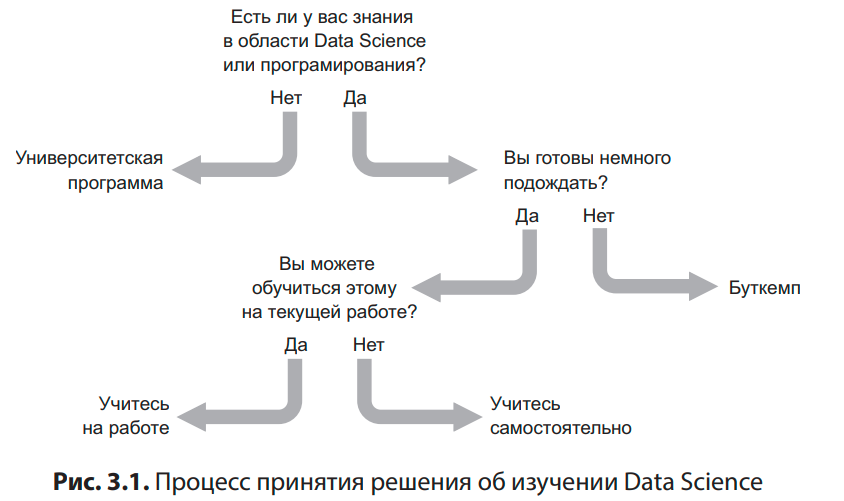

Ну и в качестве интерлюдии, гениальная схема о том, как изучать DS. Нет, ну правда же)

Кстати, если вам реально хочется изучать Data Science, массу годного контента вы найдёте в моём тг канале — это разборы заданий с собесов и масса полезных инструментов. А вот телеграм канал для тех, кто хочет изучить машинное обучение — нейронные сети, машинное обучение, Python. Вот ещё папка с годными ресурсами по Python и МО — поможет в подготовке к собесу и работе в области DS.

Параллельно к этой статье я запилил ролик с разбором части этих вопросов (в основном по Python), прошу — https://youtu.be/6Pk4OgdNxXQ

Тут посты с вопросами по машинному обучению.

Ок, переходим к вопросам. Поехали!

Содержание

Секция "Статистика"

Что такое нормальное распределение?

Средняя проектная оценка в группе из 10 учеников получилась 7, а медиана 8. Как так получилось? Чему больше доверять?

Какова вероятность заражения пациента, если его тест позитивен, а вероятность заболевания в его стране составляет 0.1%?

Что такое центральная предельная теорема? В чем заключается ее практический смысл?

Какие примеры набора данных с негауссовым распределением вы можете привести?

Что такое метод максимизации подобия?

Вы баллотируетесь на пост, в выборке из 100 избирателей 60 будут голосовать за вас. Можете ли вы быть уверены в победе?

Как оценить статистическую значимость анализа?

Сколько всего путей, по которым мышь может добраться до сыра, перемещаясь только по линиям клетки?

В чем разница между линейной и логистической регрессией?

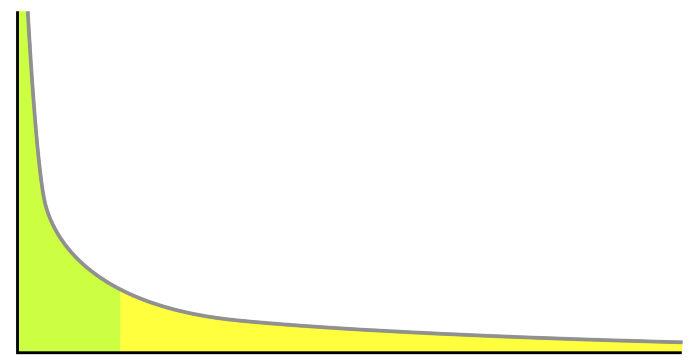

Приведите три примера распределений с длинным хвостом. Почему они важны в задачах классификации и регрессии?

Суть закона больших чисел

Что показывает p-значение (значимая вероятность)

Что такое биномиальная формула вероятности?

Счетчик Гейгера записывает 100 радиоактивных распадов за 5 минут. Найдите приблизительный 95% интервал для количества распадов в час.

Как рассчитать необходимый размер выборки?

В каких случаях вы бы использовали MSE и MAE?

Когда медиана лучше описывает данные, чем среднее арифметическое?

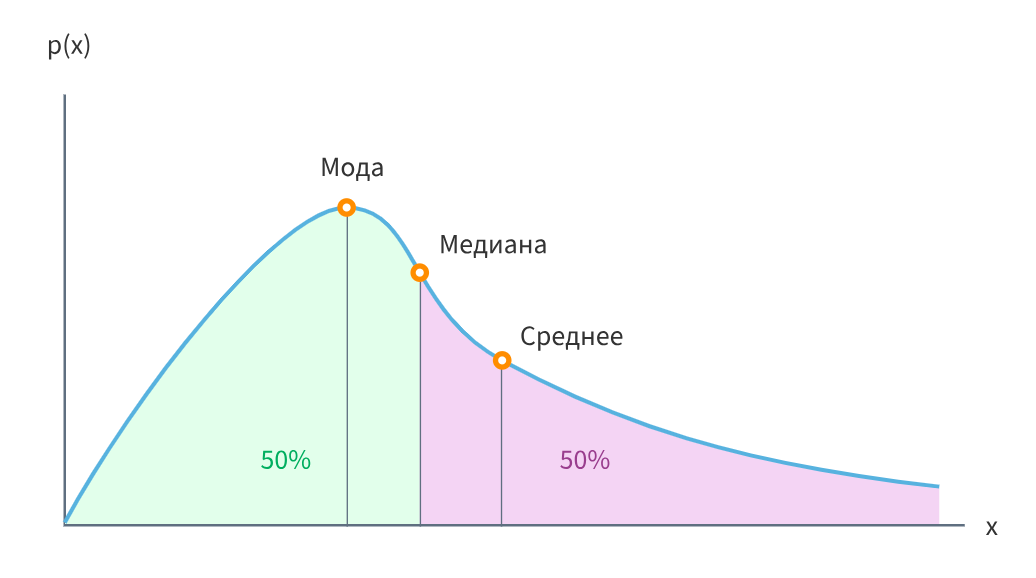

В чём разница между модой, медианой и матожиданием

Секция "SQL"

В чем заключается разница между MySQL и SQL Server?

Что делает UNION? В чем заключается разница между UNION и UNION ALL?

Как оптимизировать SQL-запросы?

Выведите список сотрудников с зарплатой выше, чем у руководителя

Какие оконные функции существуют?

Найдите список ID отделов с максимальной суммарной зарплатой сотрудников

В чём разница между CHAR и VARCHAR?

Выберите самую высокую зарплату, не равную максимальной зарплате из таблицы

Чем отличаются SQL и NoSQL?

В чём разница между DELETE и TRUNCATE?

Пронумеруйте строки в таблице employee

Пронумеруйте строки в таблице в разрезе отдела по зарплате

Какие есть уровни изоляции транзакций?

Секция "Python"

Какие отличия есть у Series и DataFrame в Pandas?

Напишите функцию, которая определяет количество шагов для преобразования одного слова в другое

В чём преимущества массивов NumPy по сравнению с (вложенными) списками python?

В чём отличие между map, apply и applymap в Pandas?

Самый простой способ реализовать скользящее среднее с помощью NumPy

Поддерживает ли Python регулярные выражения?

Продолжи: "try, except, ..."

Как построить простую модель логистической регрессии на Python?

Как выбрать строки из DataFrame на основе значений столбцов?

Как узнать тип данных элементов из массива NumPy?

В чём отличие loc от iloc в Pandas?

Напишите код, который строит все N-граммы на основе предложения

Каковы возможные способы загрузки массива из текстового файла данных в Python?

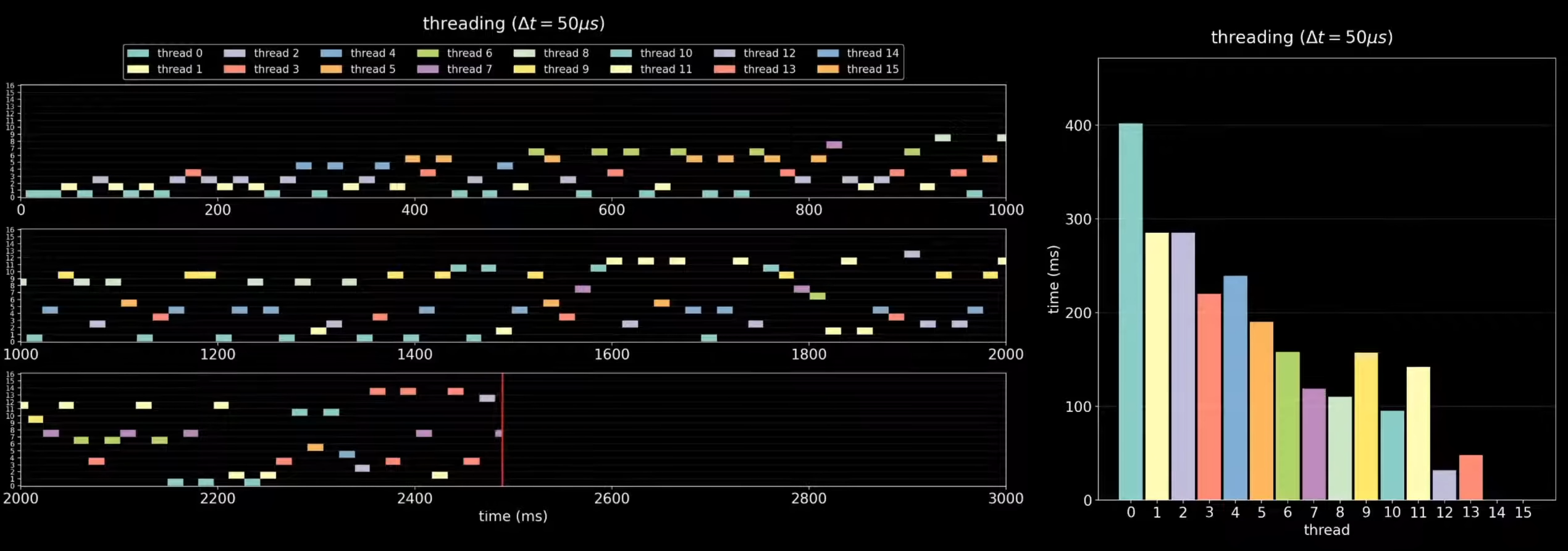

Чем отличаются многопоточное и многопроцессорное приложение?

Как можно использовать groupby + transform?

Напишите финальные значения A0, ..., A7

Чем отличаются mean() и average() в NumPy?

Приведите пример использования filter и reduce над итерируемым объектом

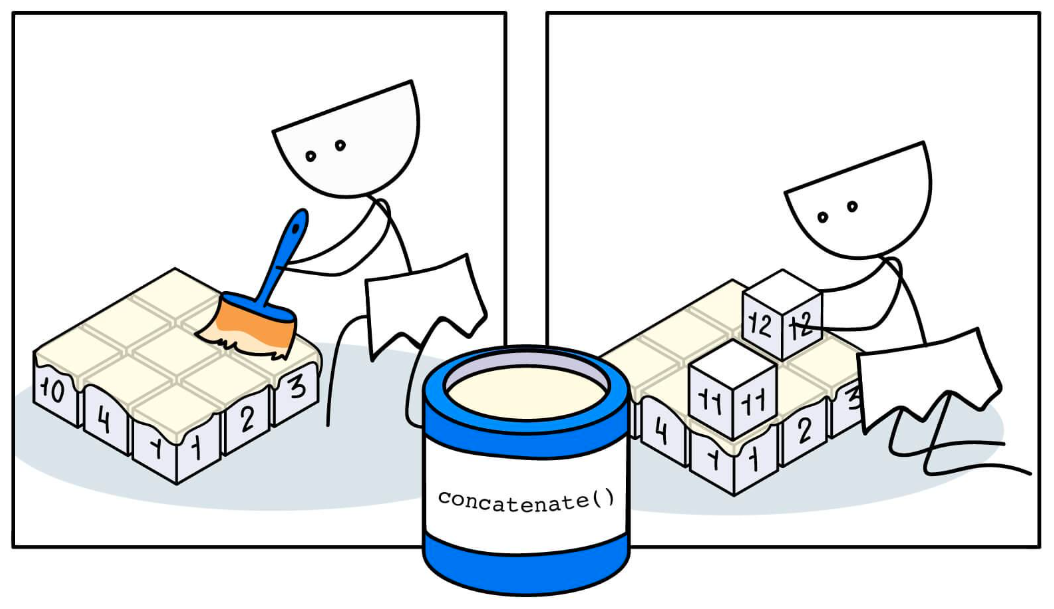

Как объединить два массива NumPy?

Напишите однострочник, который будет подсчитывать количество заглавных букв в файле

Как бы вы очистили датасет с помощью Pandas?

array и ndarray — в чём отличия?

Вычислите минимальный элемент в каждой строке 2D массива

Как проверить, является ли набор данных или временной ряд случайным?

В чём разница между pivot и pivot_table?

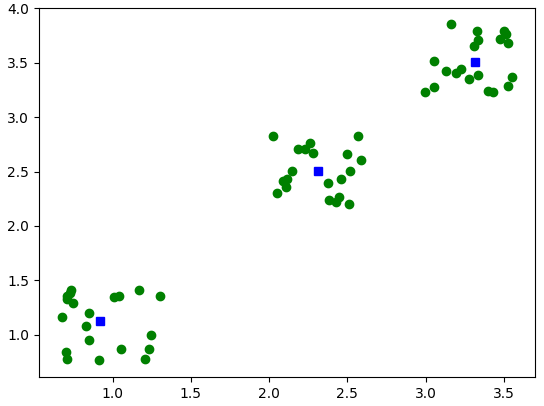

Реализуйте метод k-средних с помощью SciPy

Какие есть варианты итерирования по строкам объекта DataFrame?

Что такое декоратор? Как написать собственный?

Секция "Data Science"

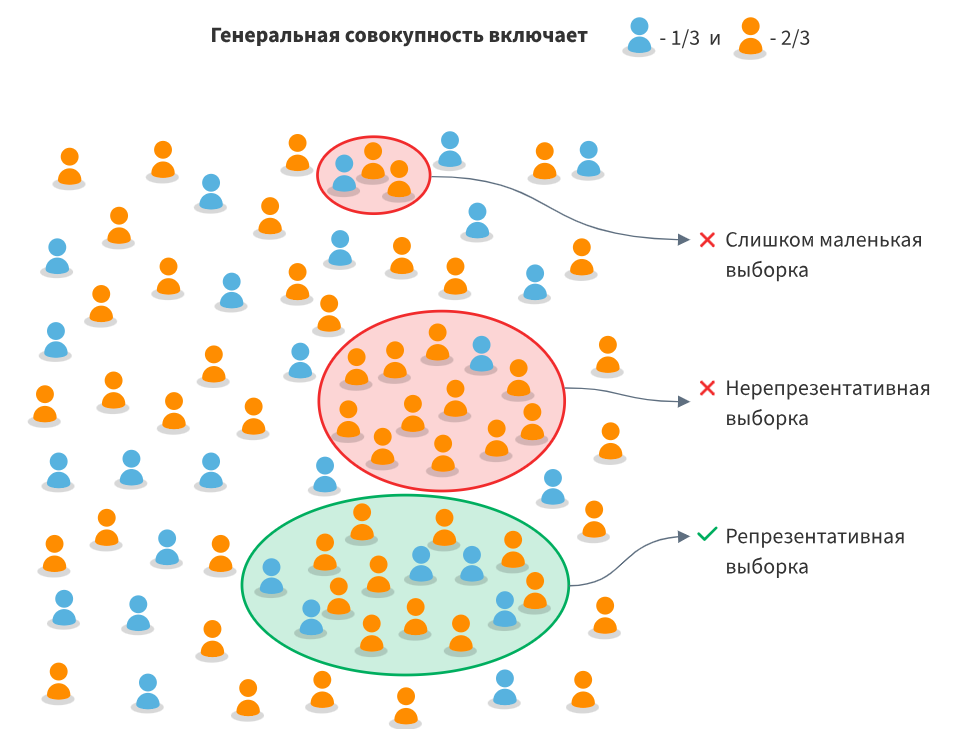

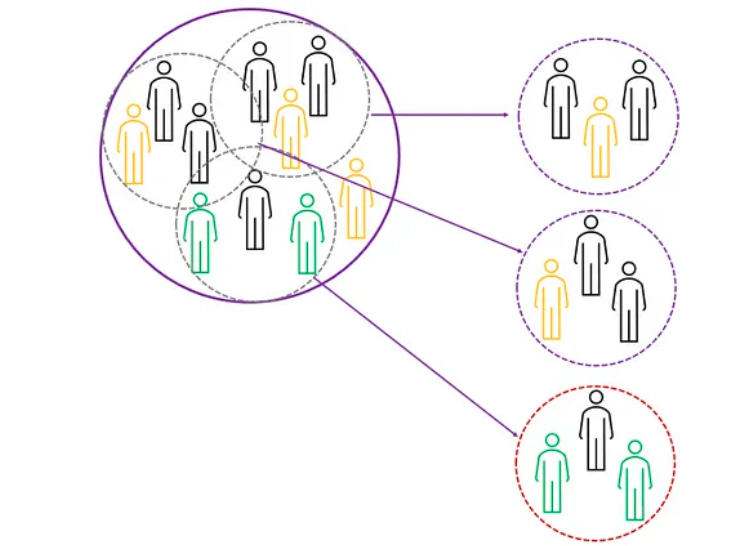

Что такое сэмплирование? Сколько методов выборки вы знаете?

Чем корреляция отличается от ковариации?

Что такое кросс-валидация? Какие проблемы она призвана решить?

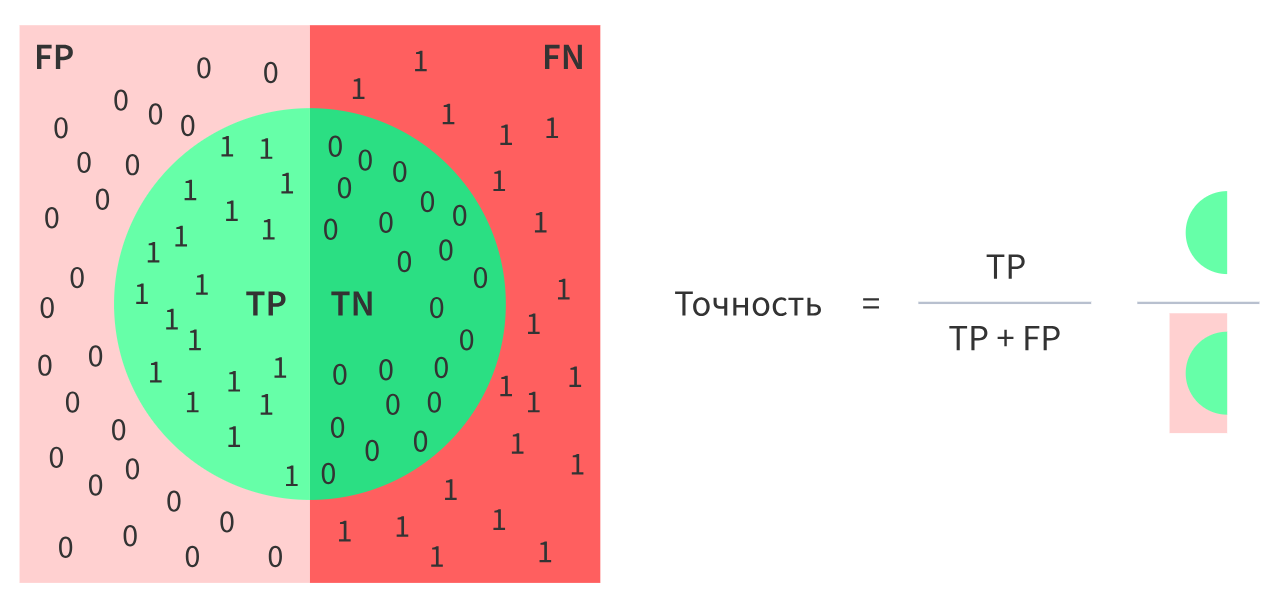

Что такое матрица ошибок? Для чего она нужна?

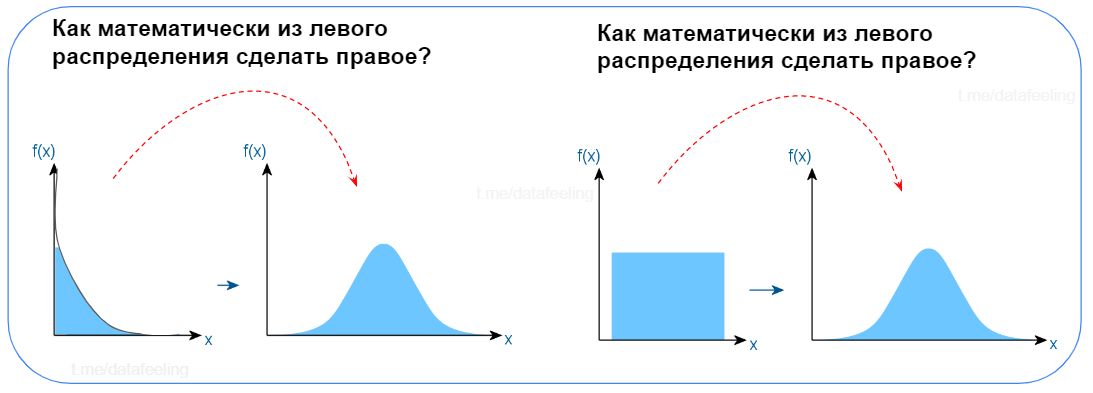

Как преобразование Бокса-Кокса улучшает качество модели?

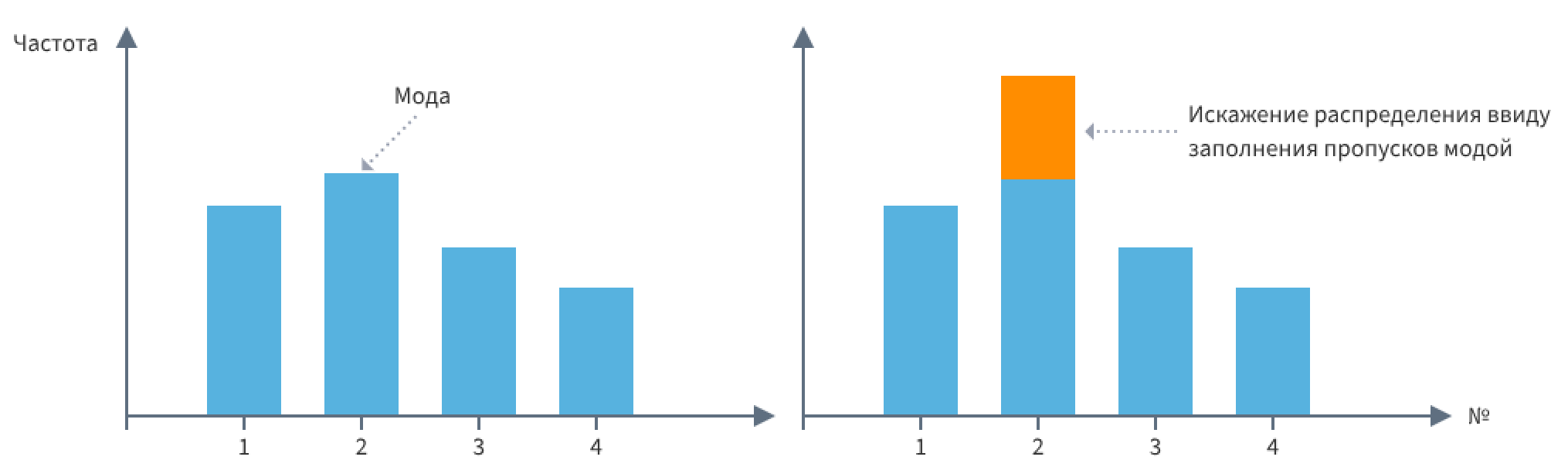

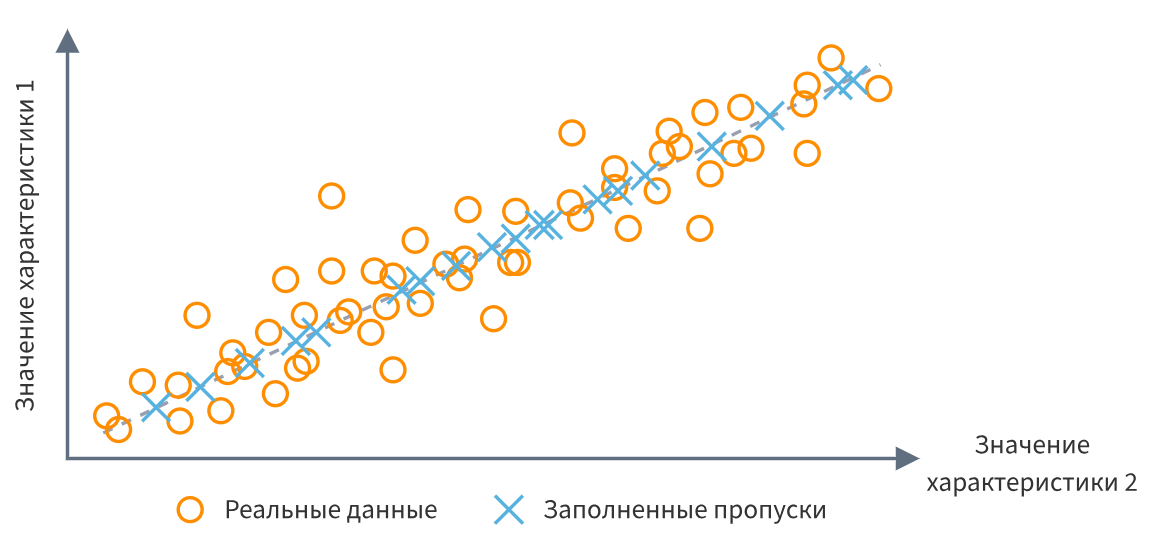

Какие методы можно использовать для заполнения пропущенных данных, и каковы последствия невнимательного заполнения данных?

Что такое ROC-кривая? Что такое AUC?

Что такое полнота (recall) и точность (precision)?

Как бы вы справились с разными формами сезонности при моделировании временных рядов?

Какие ошибки вы можете внести, когда делаете выборку?

Что такое RCA (root cause analysis)? Как отличить причину от корреляции?

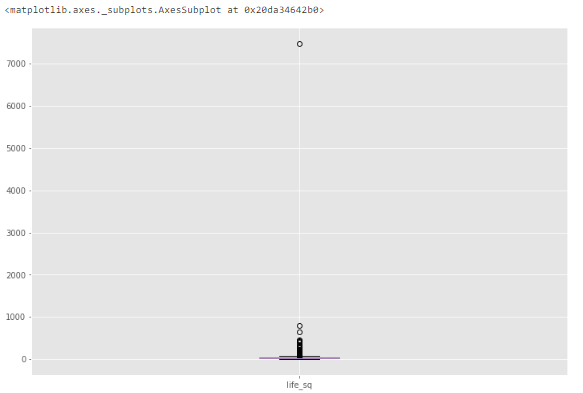

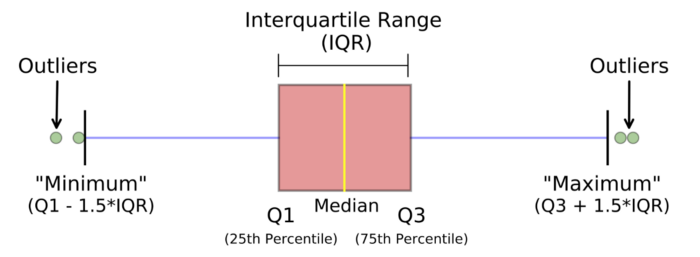

Что такое выброс и внутренняя ошибка? Объясните, как их обнаружить, и что бы вы делали, если нашли их в наборе данных?

Что такое A/B-тестирование?

В каких ситуациях общая линейная модель неудачна?

Является ли подстановка средних значений вместо пропусков допустимым? Почему?

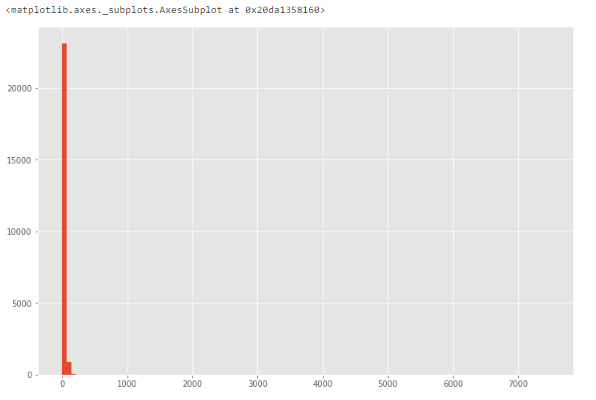

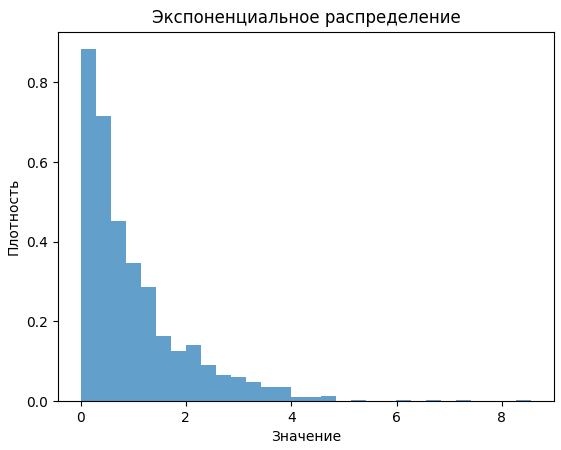

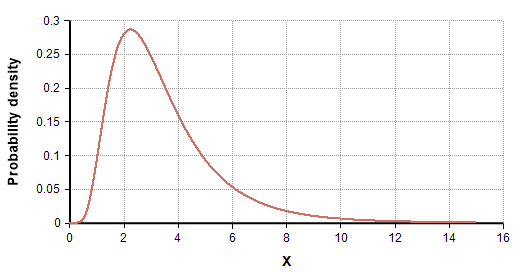

Есть данные о длительности звонков. Разработайте план анализа этих данных. Как может выглядеть распределение этих данных? Как бы вы могли проверить, подтверждаются ли ваши ожидания?

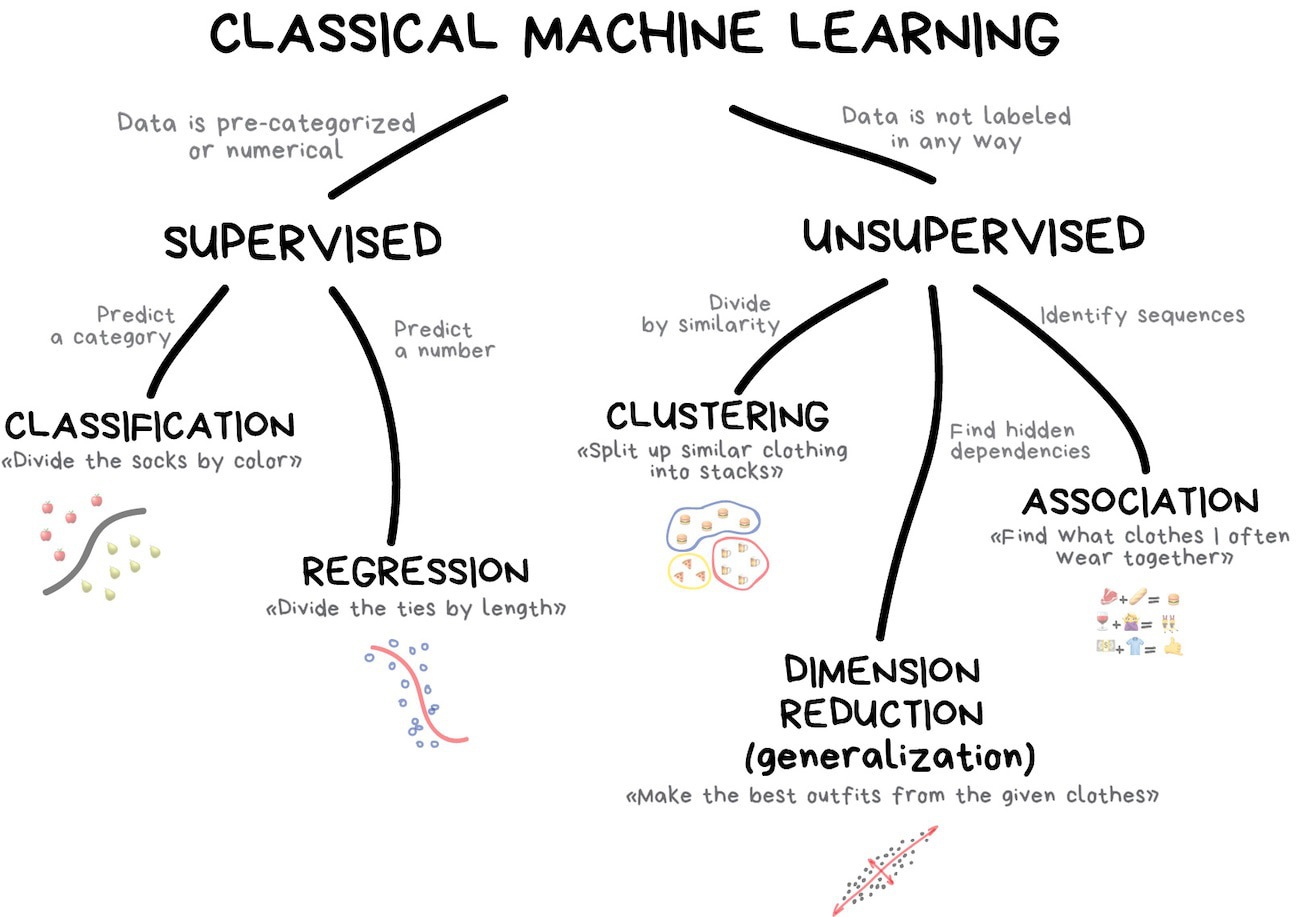

Секция "Machine Learning"

Что такое векторизация TF/IDF?

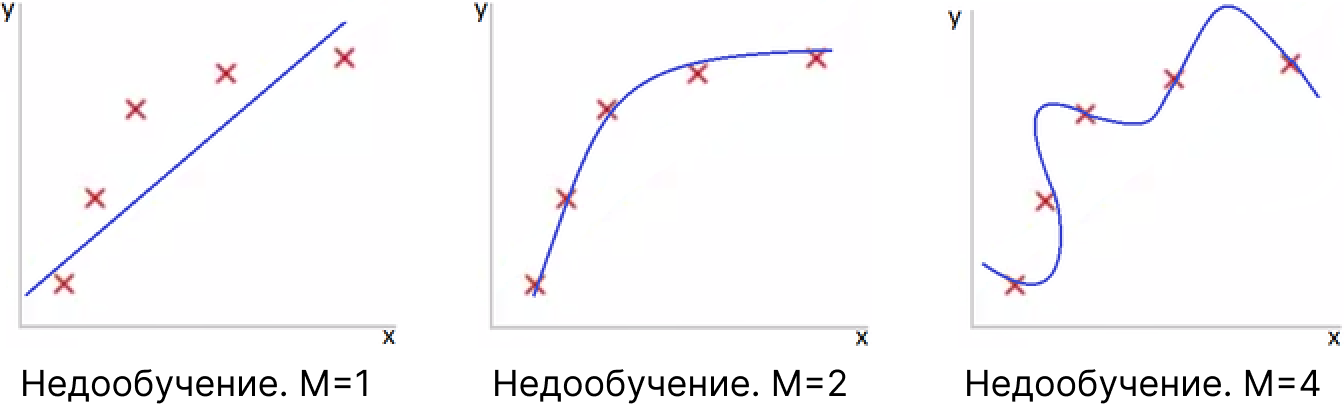

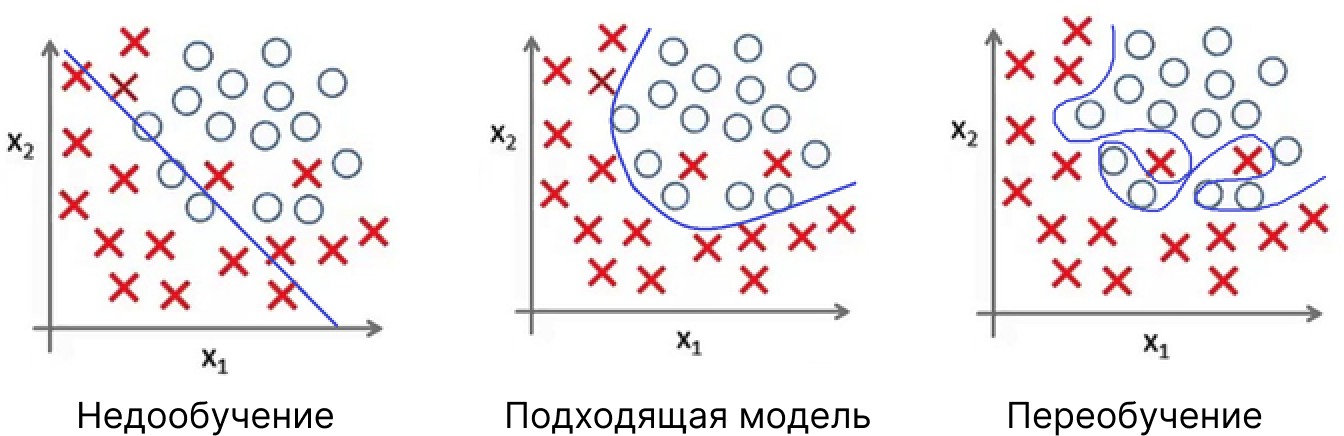

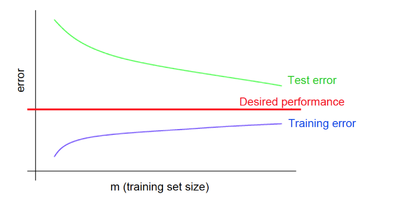

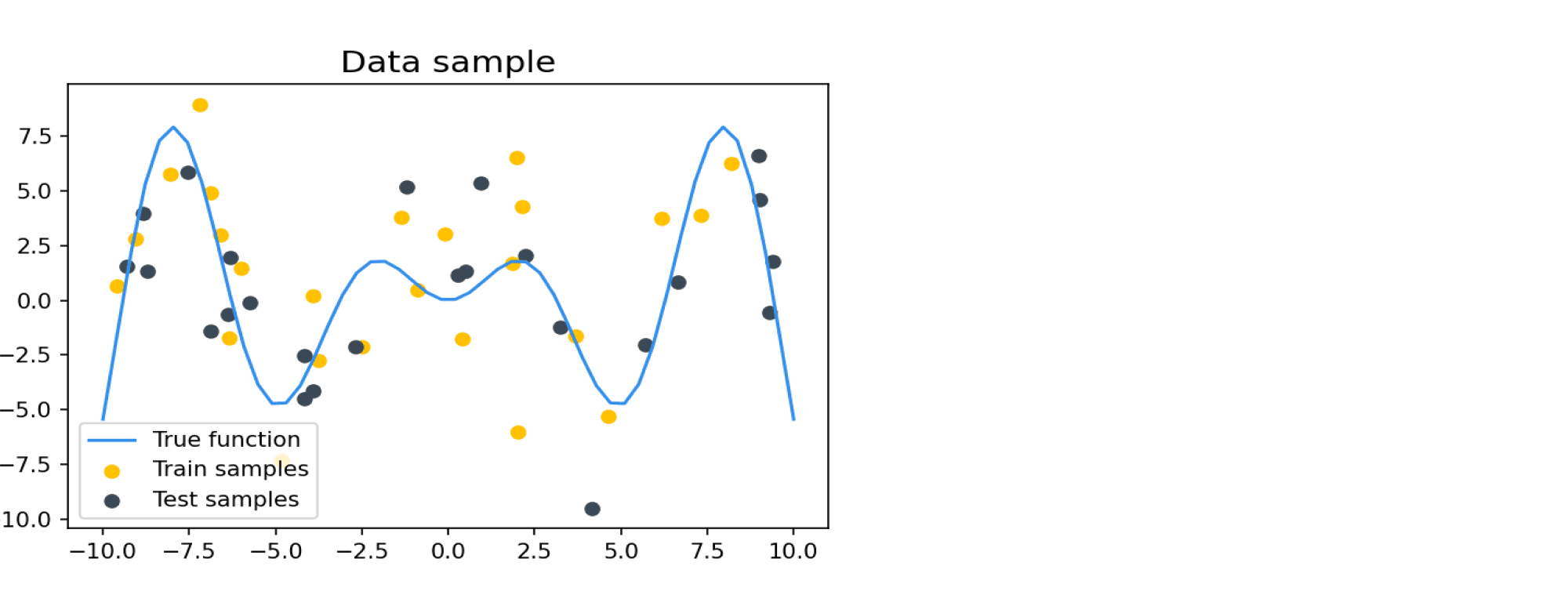

Что такое переобучение и как его можно избежать?

Вам дали набор данных твитов, задача – предсказать их тональность (положительная или отрицательная). Как бы вы проводили предобработку?

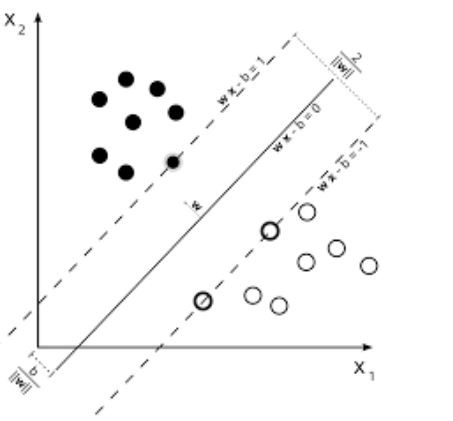

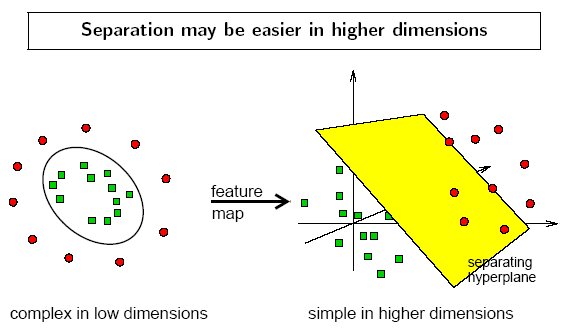

Расскажите про SVM

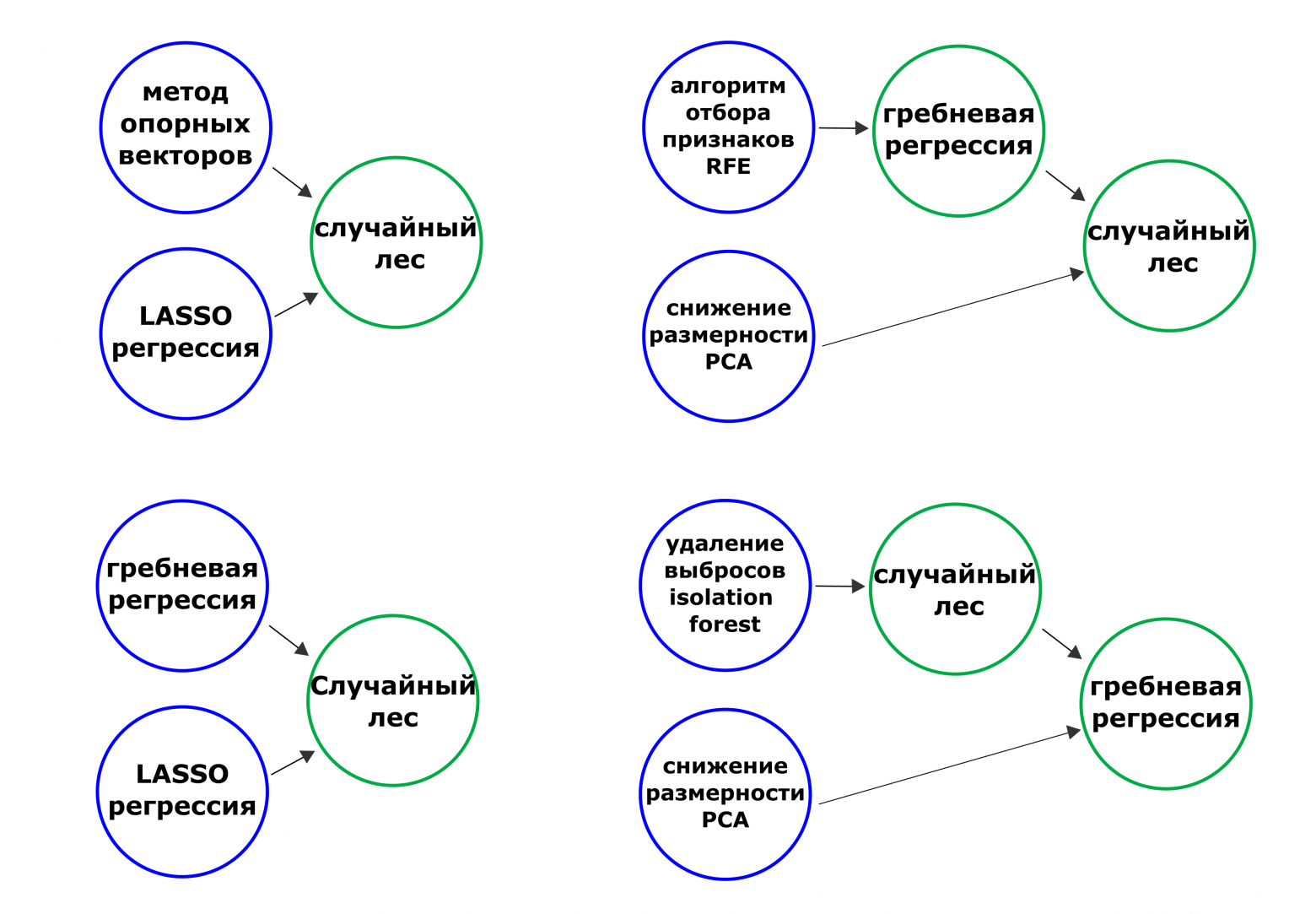

В каких случаях вы бы предпочли использовать SVM, а не Случайный лес (и наоборот)?

Каковы последствия установки неправильной скорости обучения?

Объясните разницу между эпохой, пакетом (batch) и итерацией.

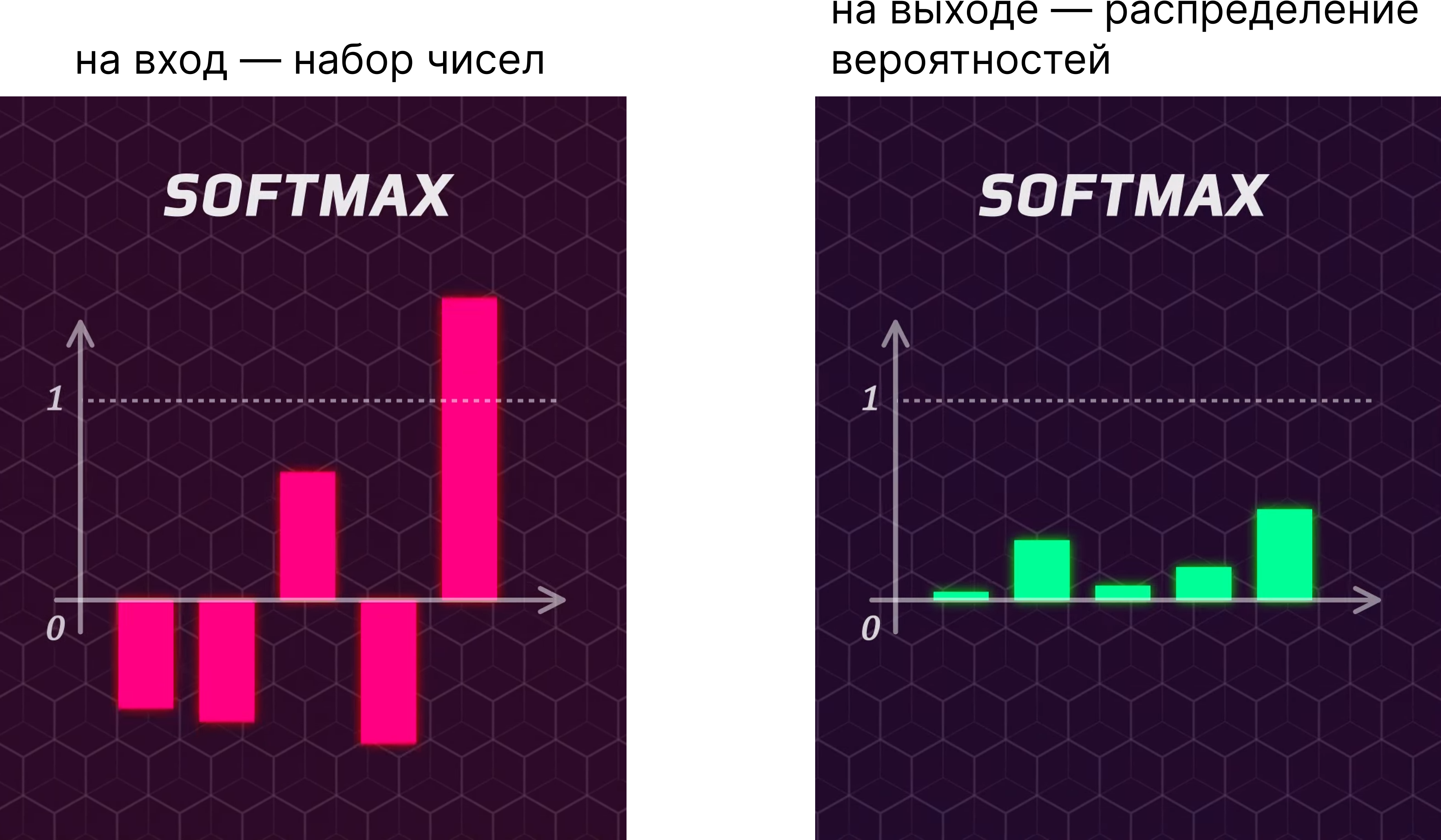

Почему нелинейная функция Softmax часто бывает последней операцией в сложной нейронной сети?

Объясните и дайте примеры коллаборативной фильтрации, фильтрации контента и гибридной фильтрации

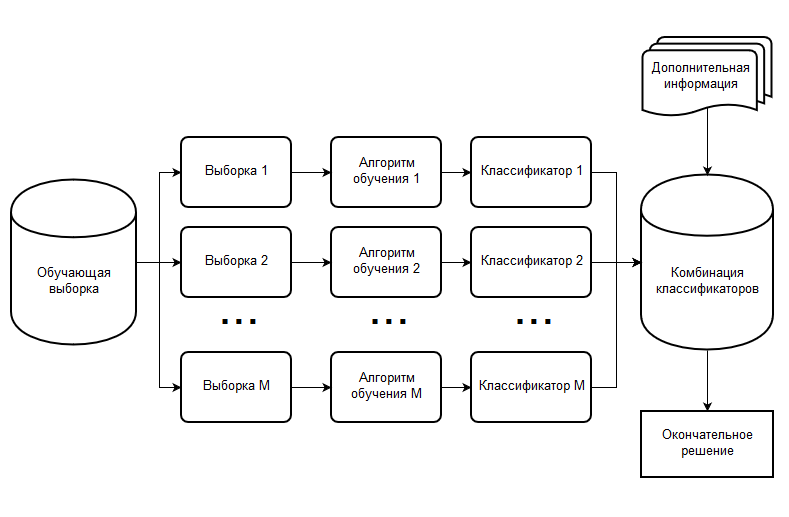

В чем разница между bagging и boosting для ансамблей?

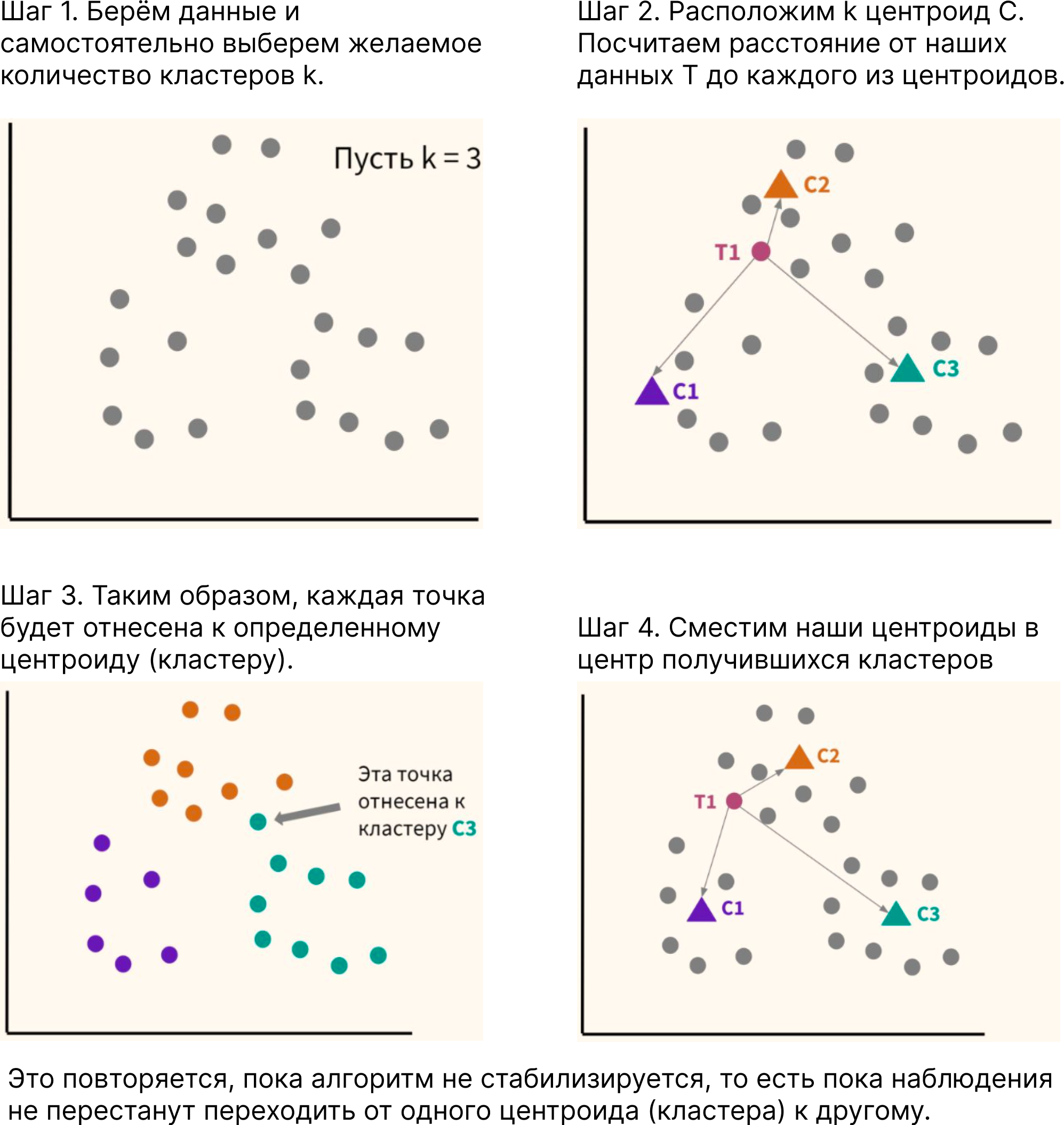

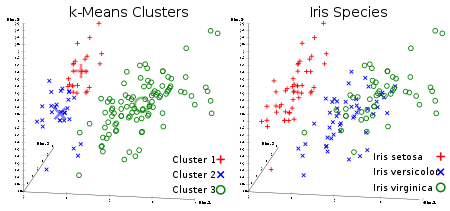

Как выбрать число k для алгоритма кластеризации «метод k-средних» (k-Means Clustering), не смотря на кластеры?

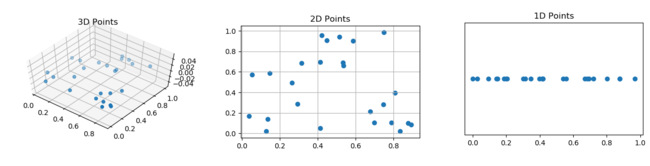

Как бы вы могли наиболее эффективно представить данные с пятью измерениями?

Что такое ансамбли, и чем они полезны?

В вашем компьютере 5Гб ОЗУ, а вам нужно обучить модель на 10-гигабайтовом наборе данных. Как вы это сделаете?

Всегда ли методы градиентного спуска сходятся в одной и той же точке?

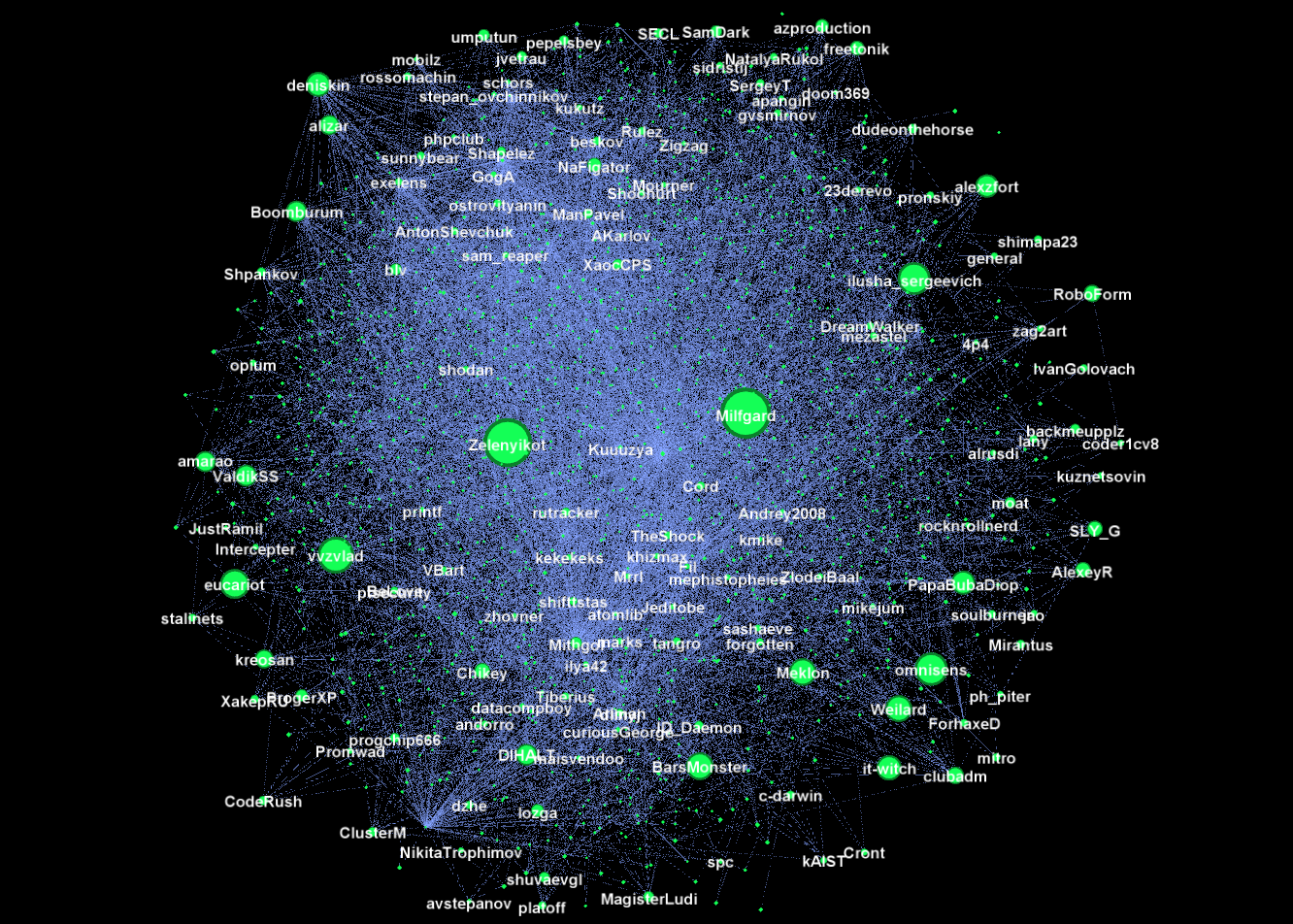

Что такое рекомендательные системы?

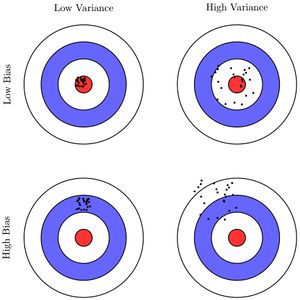

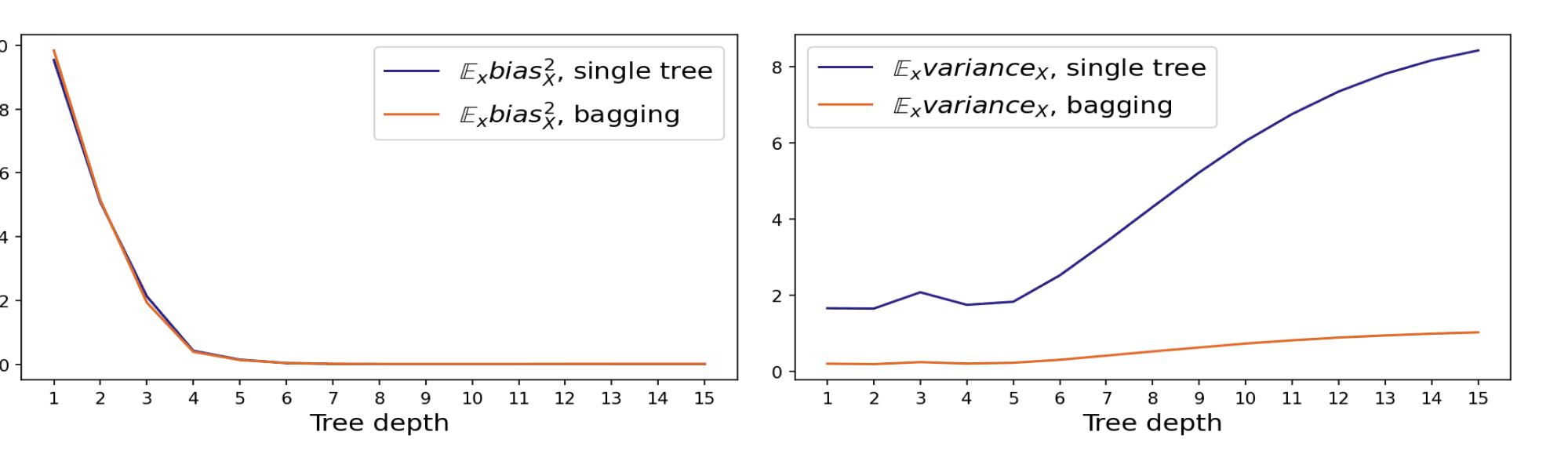

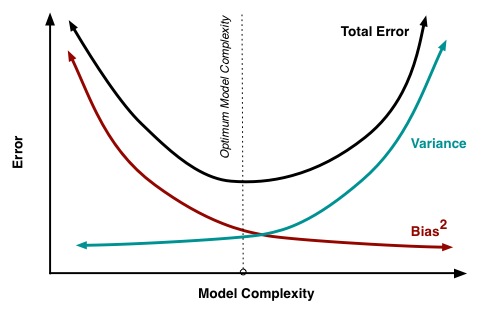

Объясните дилемму смещения-дисперсии (bias-variance tradeoff) и приведите примеры алгоритмов с высоким и низким смещением.

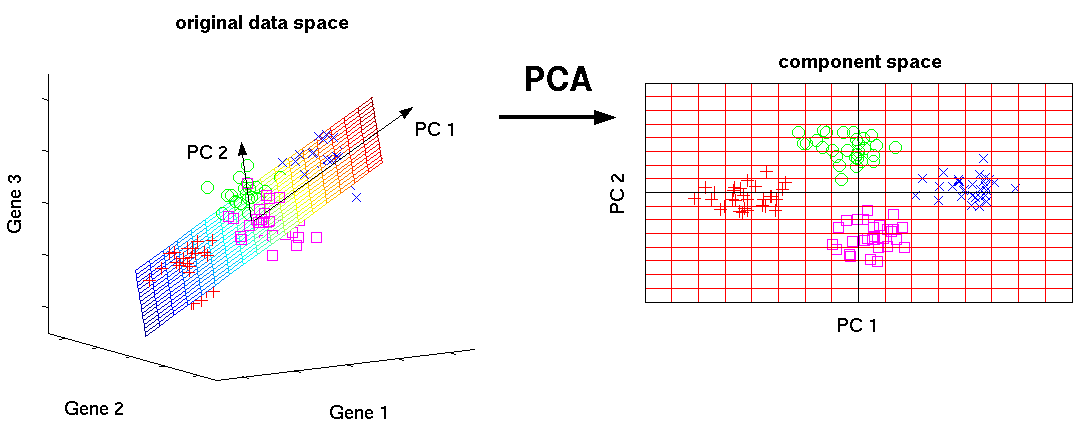

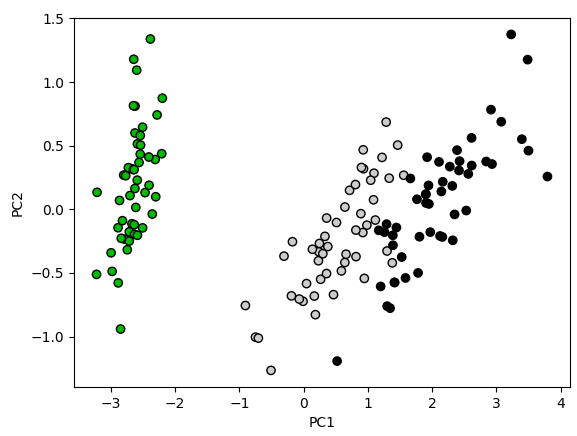

Что такое PCA, и чем он может помочь?

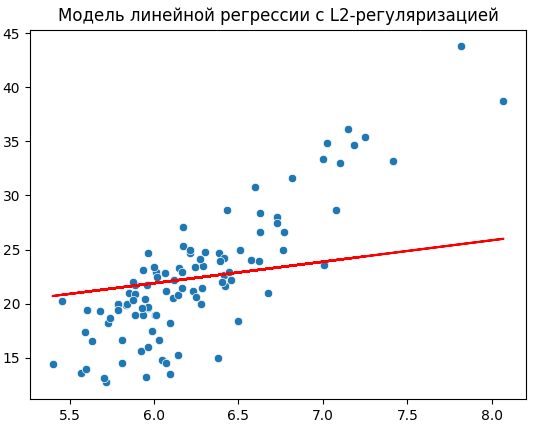

Объясните разницу между методами регуляризации L1 и L2.

Секция "Статистика"

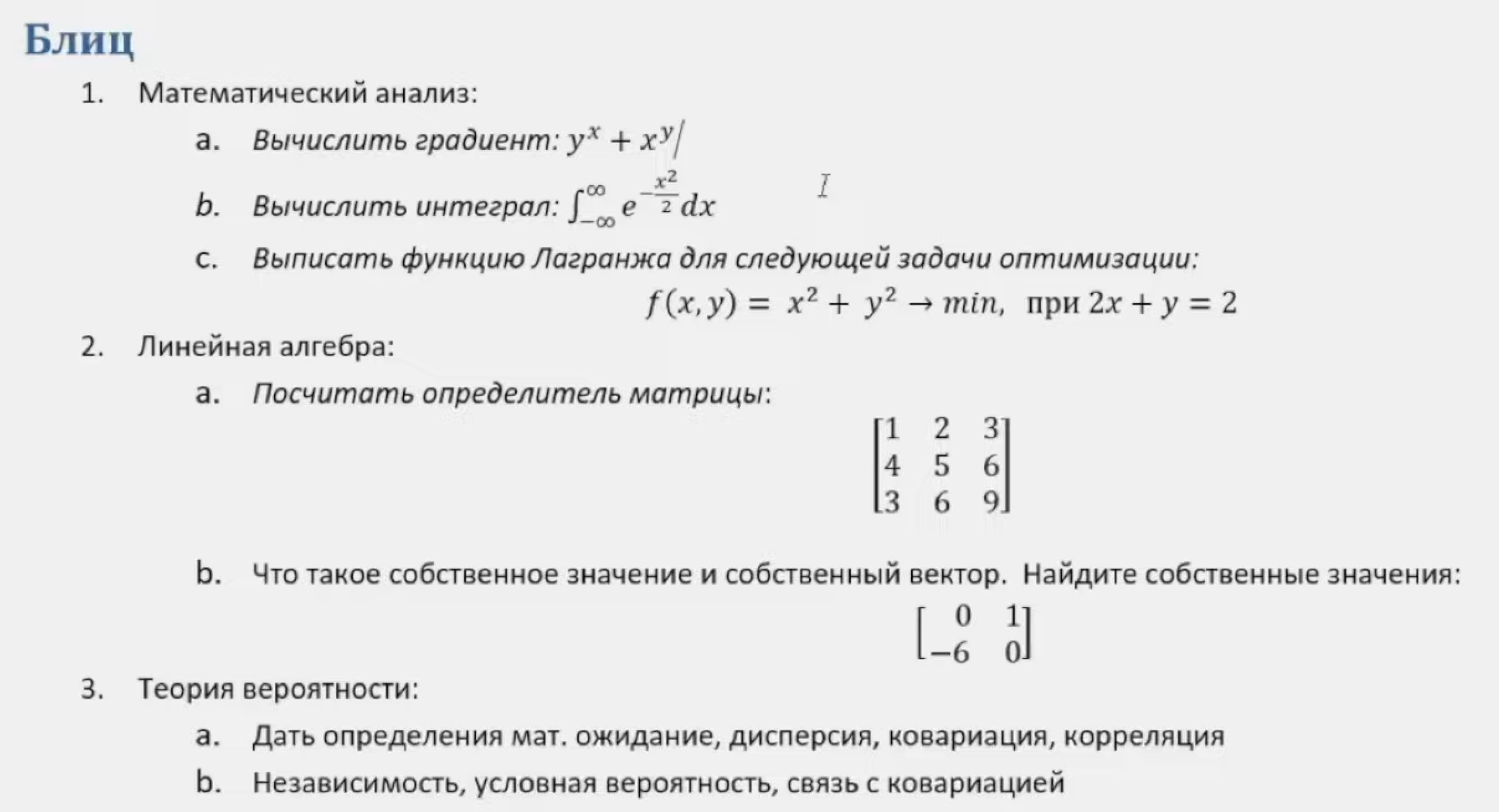

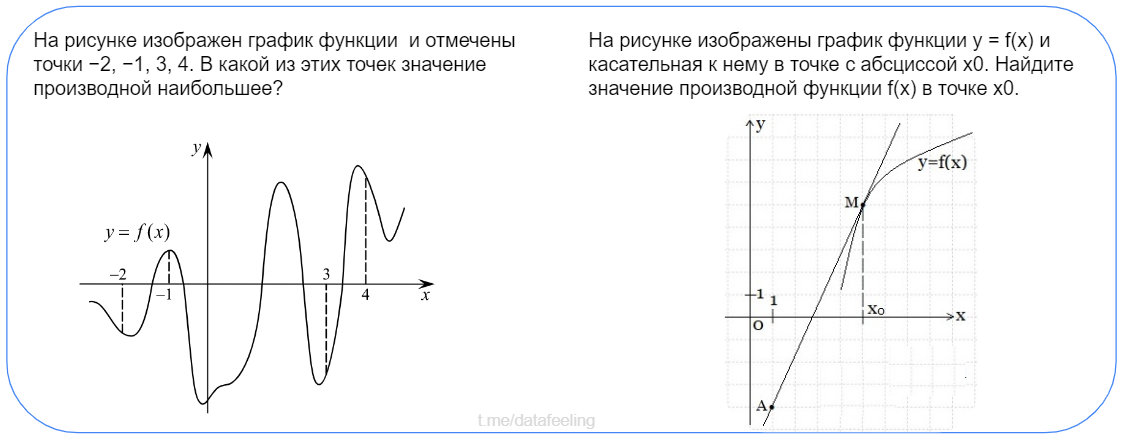

Вообще, если вы думаете, что матаном, производными и вычислением градиента мучают только свежеиспечённых выпускников-стажёров, то это не совсем так.

Вот, гляньте на задания с собеседования в ВТБ (спасибо Вадим) на позицию Data Science.

В целом, задания простые, но из-за отсутствия практики с ними могут быть проблемки. Так что на всякий случай перед собеседованием вспомните подобные базовые штуки из анализа, линейки, теорвера и прочих.

Да и вообще, учите матан — не зря же Миша Ломоносов говорил, что это ум в порядок приводит)

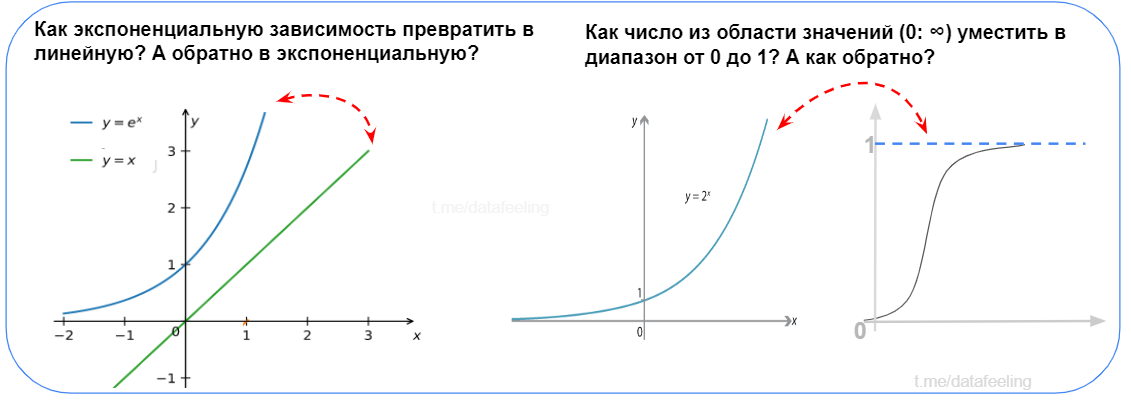

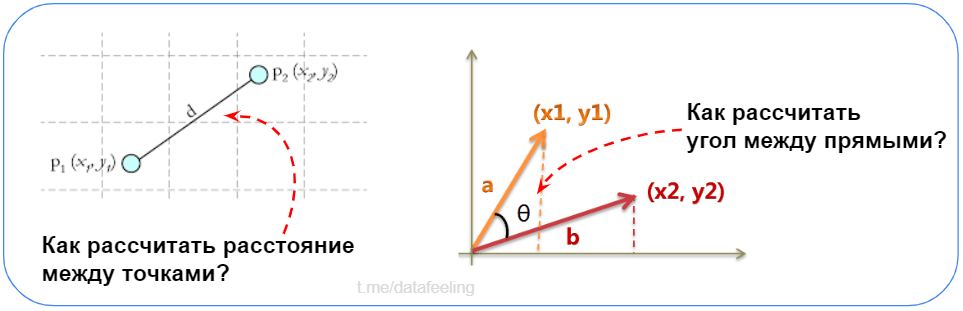

Перед тем, как перейти к разным вопросам по статистике и т.д. можно пройти вот такой замечательный тест, насколько в голове ещё сохранились основы (тест позаимствован из статьи)

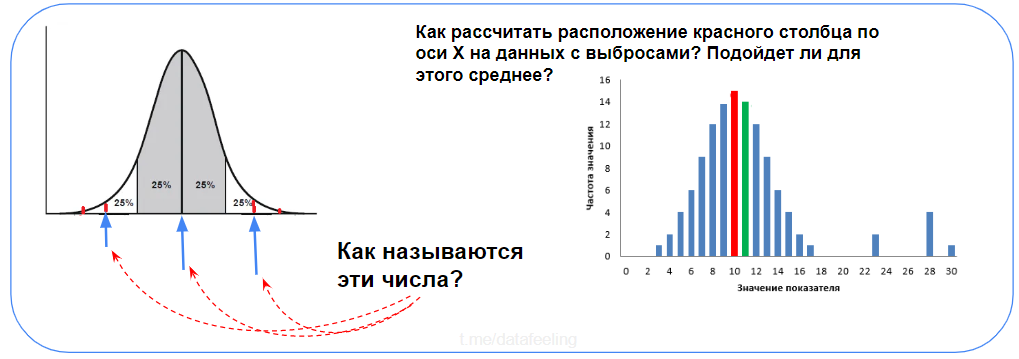

Что такое нормальное распределение?

А что, вдруг кандидат не знает ¯\_(ツ)_/¯

Нормальное распределение (Гаусса) задаётся такой функцией плотности вероятности:

тут параметр — математическое ожидание (среднее значение), медиана и мода распределения, а параметр

— среднеквадратическое отклонение,

— дисперсия распределения.

А это график нормального распределения и процент попадания случайной величины на отрезки, равные среднеквадратическому отклонению.

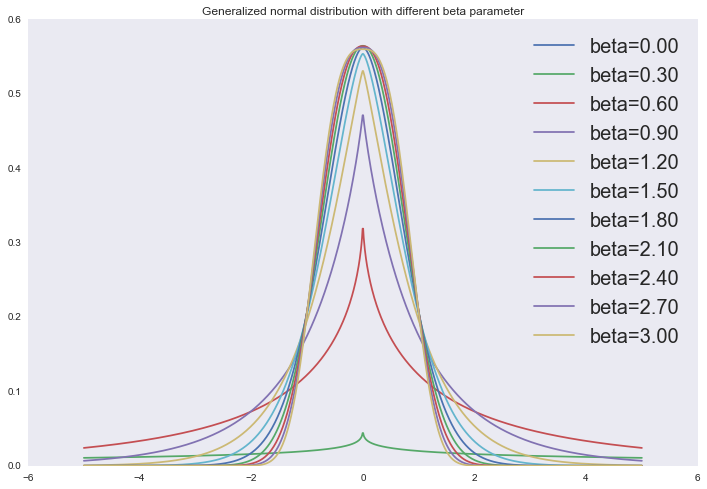

Кстати, если хочется блеснуть на собесе, можно упомянуть обобщённую формулу нормального распределения:

Отрисовать это можно так:

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import gennorm

x = np.linspace(-5, 5, 1000)

for beta in np.linspace(0, 3, 11):

plt.plot(x, gennorm.pdf(x, beta=beta), label='beta=%0.2f' % beta)

plt.legend(loc='upper right', prop={'size': 10})

plt.title('Generalized normal distribution with different beta parameter')

plt.show()

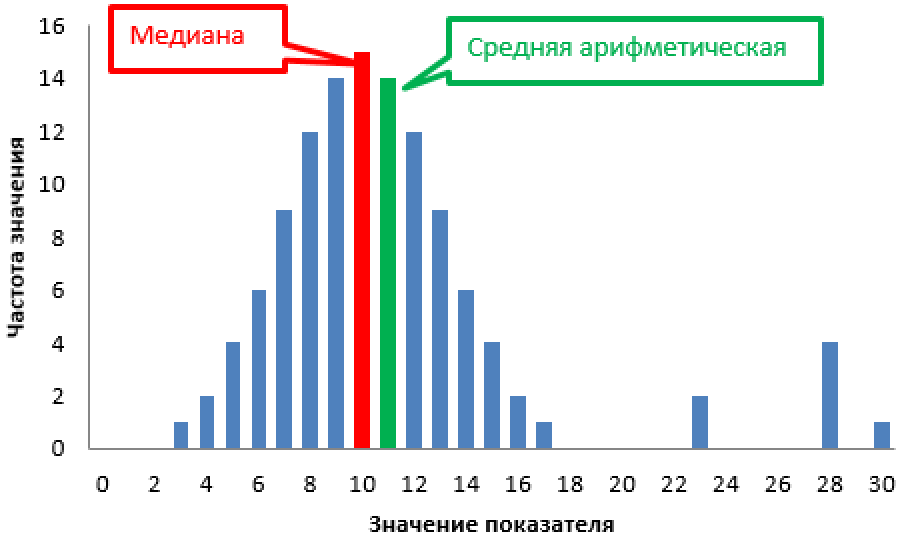

Средняя проектная оценка в группе из 10 учеников получилась 7, а медиана 8. Как так получилось? Чему больше доверять?

Это простой вопрос.

Если средняя оценка в группе – 7, а медиана – 8, это может означать, что в группе есть несколько учеников, которые получили довольно низкие оценки, что снизило среднюю оценку, но при этом большинство учеников получили более высокие оценки, что повысило медиану.

Доверять в данном случае можно обоим показателям, но важно учитывать их интерпретацию. Средняя оценка подвержена влиянию крайних значений, так что если в группе есть несколько учеников с низкими оценками, это существенно снизит среднюю оценку. Медиана же отражает значение, которое разделяет выборку на две равные части, и не подвержена такому влиянию крайних значений.

Чему больше доверять - зависит от цели анализа данных. Если интересует общая картина и средний уровень успеваемости группы, то лучше использовать среднюю оценку. Если же интересует типичный уровень успеваемости учеников, то лучше использовать медиану.

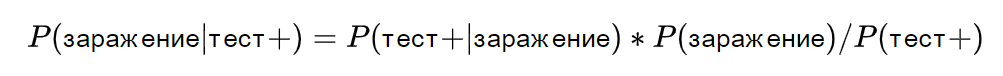

Какова вероятность заражения пациента, если его тест позитивен, а вероятность заболевания в его стране составляет 0.1%?

Для решения этой задачи нам нужно знать чувствительность и специфичность теста. Чувствительность теста - это вероятность того, что тест даст положительный результат у зараженного пациента. Специфичность теста - это вероятность того, что тест даст отрицательный результат у незараженного пациента.

Допустим, что у нашего теста чувствительность 95% и специфичность 99%. Это означает, что из 100 зараженных пациентов тест правильно определит 95, а из 100 незараженных пациентов тест правильно определит 99.

Теперь мы можем использовать формулу Байеса для вычисления вероятности заражения при положительном тесте:

где - вероятность получить положительный тест при наличии заражения,

- вероятность заражения в популяции,

- общая вероятность получить положительный тест.

Подставляя значения, получаем:

Таким образом, вероятность заражения пациента при положительном тесте составляет около 8.7%.

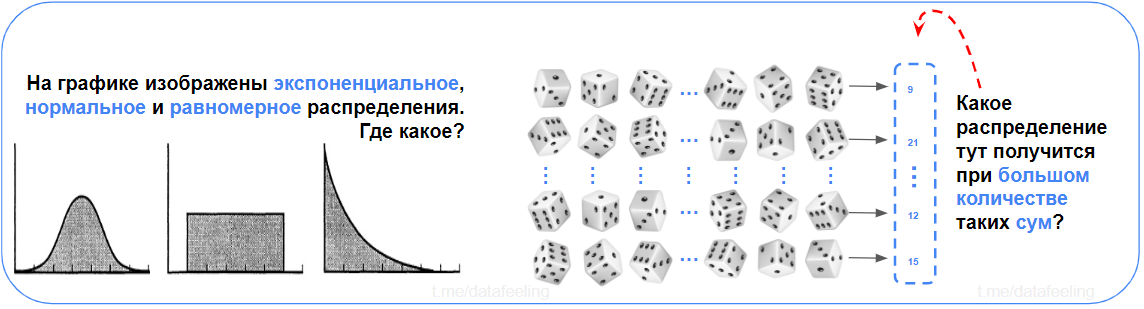

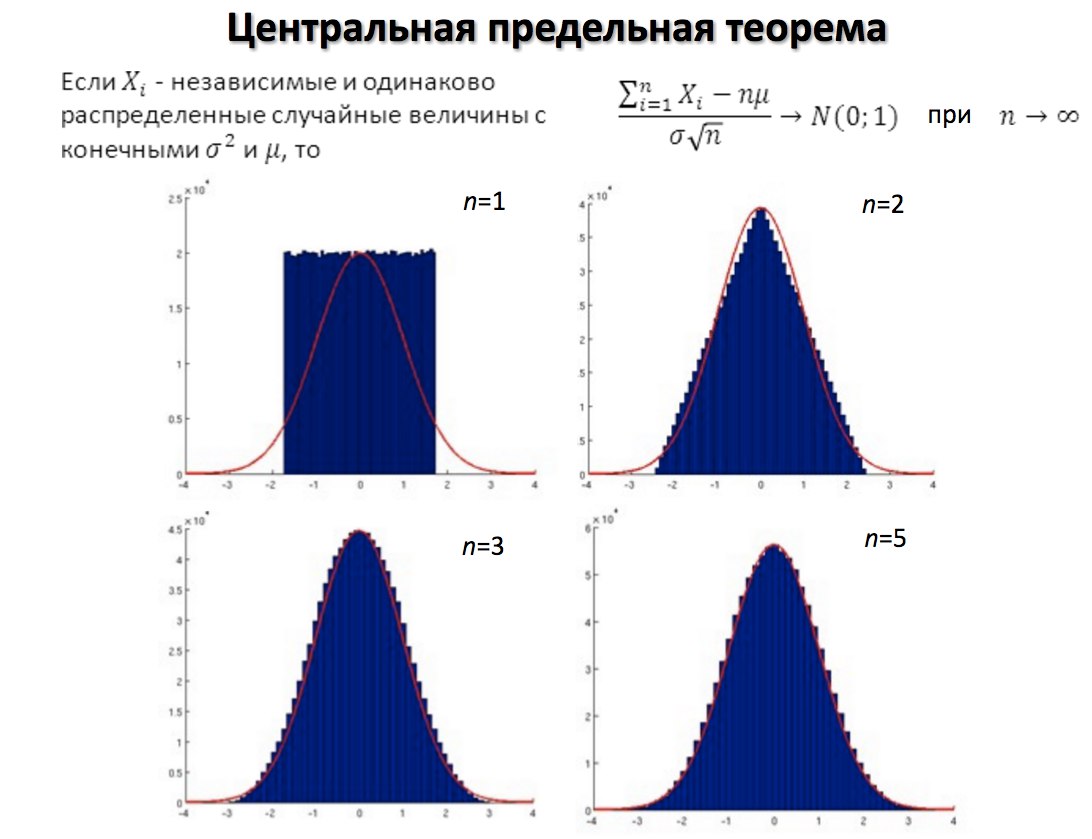

Что такое центральная предельная теорема? В чем заключается ее практический смысл?

Пока не далеко ушли от нормального распределения, обсудим центральную предельную теорему (ЦПТ).

В общем, центральная предельная теорема (ЦПТ) говорит о том, что сумма достаточно большого количества слабо зависимых случайных величин с примерно одинаковыми масштабами имеет распределение, близкое к нормальному.

Центральная предельная теорема важна, поскольку она используется при проверке гипотез и расчете доверительных интервалов.

Практическая мощь ЦПТ в том, что она позволяет использовать нормальное распределение для аппроксимации суммы случайных величин при любом распределении величин. Это облегчает анализ и позволяет делать выводы о средних значениях и доверительных интервалах.

Нет точного ответа, насколько большим должен быть размер выборки, чтобы можно было применить ЦПТ, но в целом это зависит от асимметрии распределения выборки:

если распределение симметрично, иногда достаточно размера выборки всего 15

если распределение асимметрично, обычно требуется размер выборки не менее 30

если распределение крайне асимметрично, может потребоваться размер выборки 40+

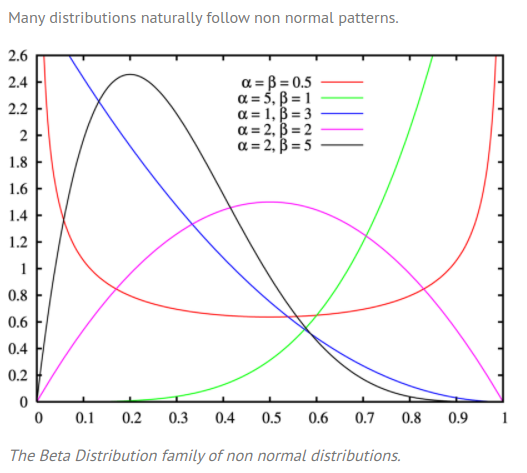

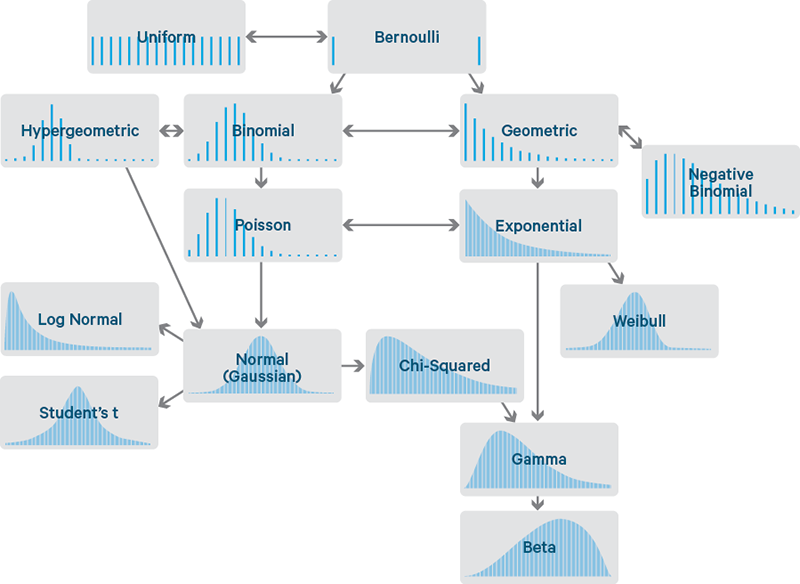

Какие примеры набора данных с негауссовым распределением вы можете привести?

Можно сразу привести такие примеры:

Любые категориальные данные не будут иметь ни гауссова, ни логнормального распределения.

Экспоненциальные распределения. Например, количество времени, которое продержится автомобильный аккумулятор или время до следующего землетрясения.

Количество несчастных случаев — часто это распределение Пуассона

Срок службы продуктов обычно соответствует распределению Вейбулла

А вообще, если подробнее, то существует множество распределений, которые отличаются от нормального:

Бета-распределение

Гамма-распределение (Обратное гамма-распределение)

Логистическая дистрибуция

Распределение Максвелла-Больцмана

Распределение Пуассона

Перекошенное распределение

Симметричное распределение

Равномерное распределение

Унимодальное распределение

Распределение Вейбулла

Что такое метод максимизации подобия?

Во-первых, это один из методов оценки параметров статистической модели. Он основан на максимизации функции подобия, которая измеряет, насколько хорошо модель соответствует наблюдаемым данным.

Метод используется для оценки параметров модели путем выбора таких значений параметров, которые максимизируют вероятность получения наблюдаемых данных при условии данной модели.

Всё это держится на принципе максимального правдоподобия — «оценки параметров модели должны быть выбраны так, чтобы вероятность получения наблюдаемых данных была максимальной»

Метод используется для оценки таких параметров моделей, как линейная регрессия, логистическая регрессия, скрытые марковские модели и другие.

А вот так выглядит сам процесс максимизации подобия:

Формулировка статистической модели, которая описывает зависимость между наблюдаемыми данными и параметрами модели.

Определение функции подобия, которая измеряет, насколько хорошо модель соответствует наблюдаемым данным.

Максимизация функции подобия путем выбора таких значений параметров модели, которые максимизируют вероятность получения наблюдаемых данных.

Оценка параметров модели на основе найденных значений, которые максимизируют функцию подобия.

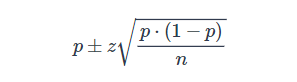

Вы баллотируетесь на пост, в выборке из 100 избирателей 60 будут голосовать за вас. Можете ли вы быть уверены в победе?

Примем для простоты, что у вас только один соперник.

Также примем, что желаемый доверительный интервал составляет 95%. Это даст нам z-оценку 1.96.

В нашей задаче p = 0.6, z = 1.96, n = 100, что дает доверительный интервал [50.4, 69.6].

Таким образом, при доверительном интервале 95% вы можете расслабиться, только если ничего не имеете против победы с минимальным перевесом. В противном случае придется добиться 61 голоса из 100 опрошенных, чтобы не беспокоиться.

Как оценить статистическую значимость анализа?

Суть статистической значимости состоит в определении того, существует ли реальное основание в разнице между выбранными для исследования показателями, или это случайность? С данным понятием тесно связаны «нулевая» и «альтернативная» гипотезы.

Нулевая гипотеза гласит, что внесение коррективов ничего не поменяет, то есть сравниваемые объекты равнозначны в своих свойствах и нет смысла что-либо менять. Суть исследования заключается в опровержении гипотезы.

Альтернативная (исследовательская) гипотеза подразумевает сравнение, в результате которого один объект показывает себя эффективнее, чем другой.

Одним из распространенных методов оценки статистической значимости является использование t-теста. t-тест позволяет сравнить средние значения двух групп и определить, есть ли статистически значимая разница между ними. Результаты t-теста представляются в виде значения t-статистики и p-значения.

t-статистика - это мера разницы между средними значениями двух групп. Чем больше значение t-статистики, тем больше разница между группами.

p**-значение** - это вероятность получить наблюдаемую разницу между группами, если на самом деле разницы нет. Если p-значение меньше заданного уровня значимости (обычно 0,05), то разница считается статистически значимой.

Для оценки статистической значимости анализа можно использовать следующие шаги:

Сформулировать нулевую гипотезу (H0) и альтернативную гипотезу (H1). Нулевая гипотеза предполагает, что разницы между группами нет, а альтернативная гипотеза предполагает наличие разницы.

Выполнить соответствующий статистический тест, например, t-тест.

Получить значения t-статистики и p-значения.

Сравнить полученное p-значение с уровнем значимости (обычно 0,05). Если p-значение меньше уровня значимости, то разница считается статистически значимой.

Сделать выводы на основе результатов теста. Если разница статистически значима, то можно считать, что результаты анализа не являются случайными.

Итак, для оценки статистической значимости нужно провести проверку гипотезы. Сначала определяют нулевую и альтернативную гипотезы. Затем рассчитывают p – вероятность получения наблюдаемых результатов, если нулевая гипотеза верна. Наконец, устанавливают уровень значимости alpha. Если p < alpha, нулевая гипотеза отвергается – иными словами, анализ является статистически значимым.

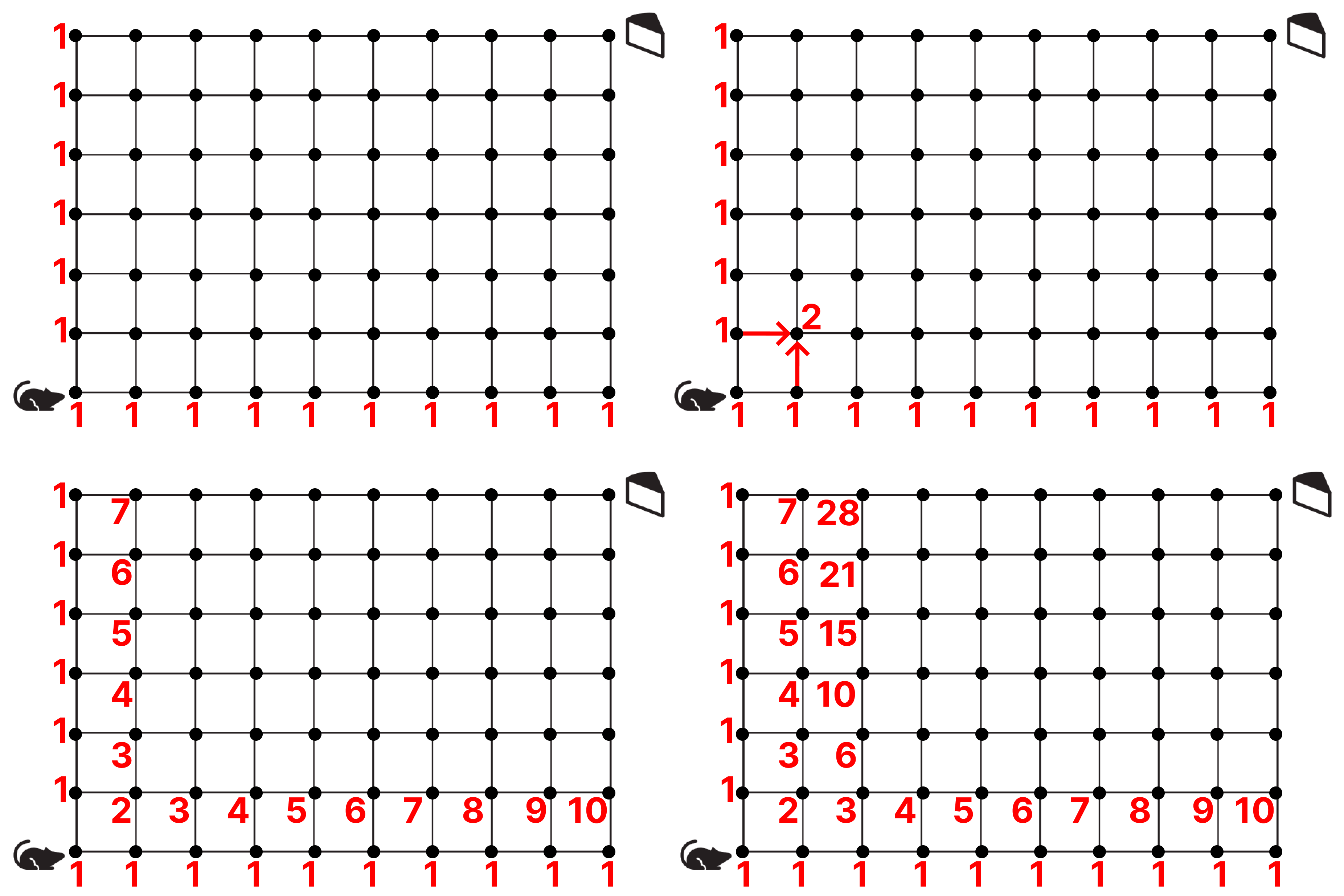

Сколько всего путей, по которым мышь может добраться до сыра, перемещаясь только по линиям клетки?

Внезапно задача, да ещё какая-то странная. Есть идеи, как можно посчитать все пути?

Это задание удивительно напоминает одно из задание ОГЭ по информатике. Решается просто, ничего особенного. Отмечаем узлы, мышь использует 2 команды: вправо и вверх, в каждом узле отмечаем число — сумму чисел из других узлов, откуда можно попасть в этот. Таким образом мы первый раз получаем число 2 — потому что в текущий узел можно попасть из узлов с числами 1, поэтому 1+1.

И так мы делаем, пока не дойдём до последнего узла, получаем 5005.

Задание, кстати, позаимствовано из «Data Science для карьериста»)

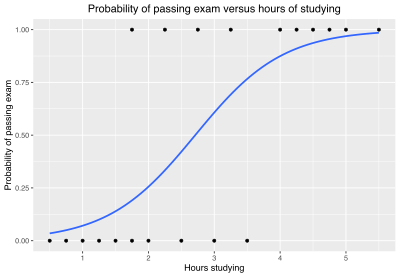

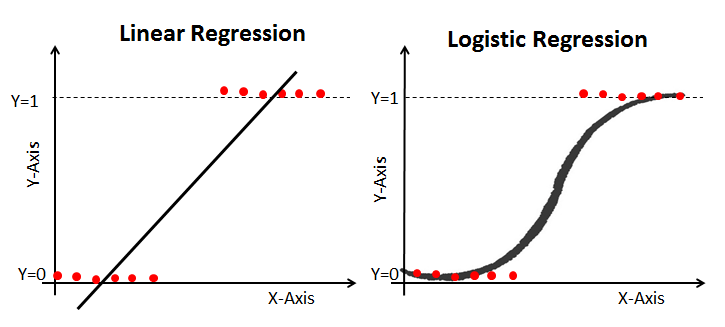

В чем разница между линейной и логистической регрессией?

Если сразу к ответу — линейную регрессию можно использовать для прогнозирования непрерывной зависимой переменной по шкале значений. Логистическая регрессия используется, когда ожидается результат бинарной операции (например, «да» или «нет»).

Линейная регрессия |

Логистическая регрессия |

|

|---|---|---|

Что это |

Статистический метод прогнозирования выходного значения по набору входных значений. |

Статистический метод прогнозирования вероятности принадлежности выходного значения к определенной категории по набору категориальных переменных. |

Зависимость |

Линейная зависимость, представленная прямой линией. |

Логистическая или сигмоидальная зависимость, представленная S-образной кривой. |

Уравнение |

Линейное. |

Логарифмическое. |

Тип обучения под наблюдением |

Регрессия. |

Классификация. |

Тип распределения |

Нормальное/гауссовское. |

Биномиальное. |

Лучше всего подходит для |

Задач, требующих прогнозирования непрерывной зависимой переменной по шкале. |

Задач, требующих прогнозирования вероятности появления категориальной зависимой переменной из фиксированного набора категорий. |

Линейная регрессия – это статистический метод, в котором линия (или n-мерная плоскость в случае множества параметров) подстраивается под данные. Он используется для регрессии – когда целевое значение представляет собой действительное число.

К линейной регрессии допускается 4 основных допущения:

Есть линейная зависимость между зависимой переменной и регрессорами, то есть модель, которую вы создаете, соответствует имеющимся данным.

Ошибки или остатки данных обычно распределяются и независимы друг от друга

Существует минимальная мультиколлинеарность между объясняющими переменными

Гомоскедастичность. (короче, дисперсия вокруг линии регрессии одинакова для всех значений предикторной переменной).

Логистическая регрессия – это метод классификации. Это трансформация линейной регрессии посредством функции сигмоиды, возвращающей вероятность соответствия входного набора классу 0 или классу 1.

Приведите три примера распределений с длинным хвостом. Почему они важны в задачах классификации и регрессии?

Три практических примера: степенной закон, закон Парето и продажи продуктов (например, продукты-бестселлеры против обычных).

При решении задач классификации и регрессии важно не забывать о распределении с длинным хвостом, поскольку редко встречающиеся значения составляют существенную часть выборки. Это влияет на выбор метода обработки выбросов. Кроме того, некоторые методики машинного обучения предполагают, что данные распределены нормально.

Вообще, выбрать нужное распределение не проблема, ведь их существует уйма:

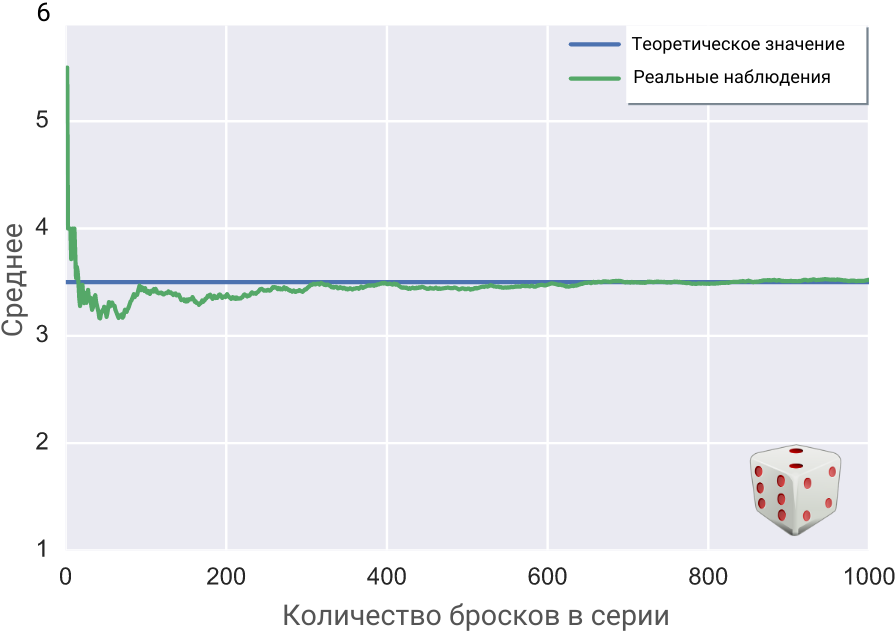

Суть закона больших чисел

Если очень просто — при увеличении количества реальных попыток случайная величина стремится к своему теоретически вычисленному ожидаемому значению (к матожиданию).

Бросим игральный кубик десять раз. Затем запишем среднее значение всех десяти бросков: сложим все выпавшие очки и поделим на 10.

После этого подбросим снова, но теперь уже серией из двадцати бросков, и также запишем среднее. Сумму выпавших очков поделим на 20.

Закон больших чисел утверждает, что при увеличении количества бросков от серии к серии среднее арифметическое всех выпавших в ней очков будет стремиться к определённому числу, которое называется математическим ожиданием.

Для игрального кубика оно равно среднему арифметическому очков на его шести гранях:

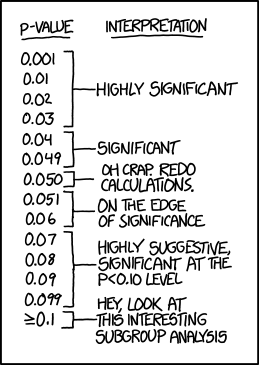

Что показывает p-значение (значимая вероятность)

Значимая вероятность — это величина, применяемая при статистической проверке гипотез. Представляет собой вероятность того, что значение проверочной статистики используемого критерия (t-статистики Стьюдента, F-статистики Фишера и т.д.), вычисленное по выборке, превысит установленное p-значение.

Другими словами, p-значение – это наименьшее значение уровня значимости (т.е. вероятности отказа от справедливой гипотезы), для которого вычисленная проверочная статистика ведет к отказу от нулевой гипотезы. Обычно p-значение сравнивают с общепринятыми стандартными уровнями значимости 0,005 или 0,01.

P-значение используется для проверки значимости результатов после статистического теста гипотезы. P-значения помогают анализирующему делать выводы и всегда находятся в диапазоне между 0 и 1.

P-значение, превышающее 0.05, обозначает недостаточные доказательства против нулевой гипотезы – а это значит, что нулевая гипотеза не может быть отвергнута.

P-значение, меньшее 0.05, обозначает сильные доказательства против нулевой гипотезы – это значит, что нулевая гипотеза может быть отвергнута.

P-значение, равное 0.05, находится на границе, то есть мы не можем сделать уверенного вывода о том, можно ли отвергнуть нулевую гипотезу.

Итак, если p-value — это вероятность получить такие или более выраженные различия при условии, что в генеральной совокупности никаких различий на самом деле нет, то какое, на ваш взгляд, верное утверждение:

Компьютерные игры — причина агрессивного поведения с вероятностью 96%.

Вероятность того, что агрессивность и компьютерные игры не связаны, равна 0.04.

Если бы мы получили p-уровень значимости больше, чем 0.05, это означало бы, что агрессивность и компьютерные игры никак не связаны между собой.

Вероятность случайно получить такие различия равняется 0.04.

Все утверждения неверны.

Давайте разберём все ответы по порядку:

1 утверждение — пример ошибки корреляции: факт значимой взаимосвязи двух переменных ничего не говорит нам о причинах и следствиях. Может быть, это более агрессивные люди предпочитают проводить время за компьютерными играми, а вовсе не компьютерные игры делают людей агрессивнее.

2 утверждение. Всё дело в том, что мы изначально принимаем за данное, что никаких различий на самом деле нет. И, держа это в уме как факт, рассчитываем значение p-value. Поэтому правильная интерпретация: «Если предположить, что агрессивность и компьютерные игры никак не связаны, то вероятность получить такие или еще более выраженные различия составила 0.04».

3 утверждение. А что делать, если мы получили незначимые различия? Значит ли это, что никакой связи между исследуемыми переменными нет? Нет, это означает лишь то, что различия, может быть, и есть, но наши результаты не позволили их обнаружить.

4 утверждение. Это напрямую связано с самим определением p-value. 0.04 — это вероятность получить такие или ещё более экстремальные различия. Оценить вероятность получить именно такие различия, как в нашем эксперименте, в принципе невозможно!

Вот такие подводные камни могут скрываться в интерпретации такого показателя, как p-value. Поэтому очень важно понимать механизмы, заложенные в основании методов анализа и расчета основных статистических показателей.

Подробное объяснение, что такое p-value

Что такое биномиальная формула вероятности?

Биномиальная формула вероятности — используется для вычисления вероятности того, что определенное количество событий произойдет в серии независимых испытаний с 2 возможными исходами. Формула выглядит следующим образом:

Биномиальный закон распределения широко используется в Data Science для моделирования случайных событий с 2 исходами. Вот примеры генерации чисел и построения графика.

Генерация случайных чисел с биномиальным распределением. Этот код генерирует 100 случайных чисел с биномиальным распределением с параметрами n=10 и p=0.5:

import numpy as np

n = 10 # количество испытаний

p = 0.5 # вероятность успеха

random_numbers = np.random.binomial(n, p, 100)

print(random_numbers)

Визуализация биномиального распределения. Биномиальное распределение с параметрами n=10 и p=0.5 можно воспроизвести так:

import numpy as np

import matplotlib.pyplot as plt

from scipy.stats import binom

n = 10 # количество испытаний

p = 0.5 # вероятность успеха

x = np.arange(0, n+1)

y = binom.pmf(x, n, p)

plt.bar(x, y)

plt.xlabel('Количество успехов')

plt.ylabel('Вероятность')

plt.title('Биномиальное распределения')

plt.show()

Счетчик Гейгера записывает 100 радиоактивных распадов за 5 минут. Найдите приблизительный 95% интервал для количества распадов в час.

Поскольку это задача на распределение Пуассона, среднее = лямбда = дисперсия, что также означает, что стандартное отклонение = квадратному корню из среднего.

Доверительный интервал 95% соответствует z-оценке 1.96.

Одно стандартное отклонение = 10.

То есть, доверительный интервал равен 100 +/- 19.6 = [964.8, 1435.2].

Как рассчитать необходимый размер выборки?

Вспомним пару терминов для начала.

Генеральная совокупность – множество всех объектов, среди которых проводится исследования.

Выборка – подмножество, часть объектов из всей популяции, которая непосредственно участвует в исследовании.

Ошибка первого рода — (α) вероятность отвергнуть нулевую гипотезу, в то время как она верна.

Ошибка второго рода — (β) вероятность не отвергнуть нулевую гипотезу, в то время как она ложна.

1 — β — статистическая мощность критерия.

и

— средние значения при нулевой и альтернативной гипотезе.

При неизвестной величине генеральной совокупности, когда результат отражается в виде показателя относительной доли, число элементов выборки, обеспечивающее количественную репрезентативность, может быть вычислено по формуле:

где — доверительный коэффициент, показывающий, какова вероятность того, что размеры показателя не будут выходить за границы предельной ошибки,

— доля единиц наблюдения, обладающих изучаемым признаком,

— доля единиц наблюдения, не обладающих изучаемым признаков,

— допустимая ошибка выборки.

Если используется выборка без возврата и размер генеральной совокупности известен, то для определения необходимого размера случайной выборки при использования относительных величин (долей) применяется формула:

где — число наблюдений генеральной совокупности

Неплохая статья на Хабре — Как определить размер выборки?

В каких случаях вы бы использовали MSE и MAE?

MSE (средняя квадратичная ошибка) — это оценка среднего значения квадрата ошибок, различие между предсказанием и фактическим значением. Эту метрику удобно использовать для выявления аномалий. MSE применяется в ситуациях, когда нам надо подчеркнуть большие ошибки и выбрать модель, которая дает меньше больших ошибок прогноза. Грубые ошибки становятся заметнее за счет того, что ошибку прогноза мы возводим в квадрат. MSE сильнее штрафует за большие отклонения по сравнению со MAE, и поэтому более чувствителен к выбросам.

MAE (средняя абсолютная ошибка) — это оценка того, насколько близки предсказания к фактическим значениями. Эта метрика менее чувствительна к выбросам и может дать общее представление о качестве модели. А ещё она выдает результат, который проще интерпретировать.

Итог: если у нас сильные аномалии в значениях, то используем MAE; если аномалий мало, можно использовать MSE.

Неплохая лекция от ИТМО — Оценка качества в задачах классификации и регрессии

Когда медиана лучше описывает данные, чем среднее арифметическое?

Сильные стороны среднего арифметического:

среднее арифметическое учитывает все значения в наборе данных.

это интуитивно понятная метрика, которая широко используется во многих областях.

Минусы:

среднее арифметическое очень чувствительно к выбросам — отдельным значениям, которые значительно отличаются от других в этом датасете, в большую или меньшую сторону. Выбросы могут искажать среднее значение, давая тем самым неверное представление о центральной тенденции в данных.

Медиана — это мера центральной тенденции, которая представляет собой серединное значение набора данных, расположенного в порядке от меньшего к большему. Например, в наборе данных {3, 7, 12, 16, 19} медианой будет 12.

Плюсы:

медиана менее чувствительна к выбросам, чем среднее арифметическое, и более устойчива к влиянию нескольких экстремальных значений.

медиану легче посчитать для больших датасетов, особенно если база данных проиндексирована и отсортирована правильно. Например, при анализе времени отклика веб-сайта с миллионами пользователей найти медианное значение будет быстрее и эффективнее, чем считать среднее арифметическое.

Минусы:

медиана не дает никакой информации о разбросе данных или о том, насколько изменчивы эти значения.

В общем, отдавать предпочтение медиане или среднему — это зависит от качества выборки. Когда в данных значительное количество выбросов в положительную или отрицательную сторону, медиана искажается не так сильно, как среднее значение. Ну и медиана в некоторых случаях считается быстрее.

В чём разница между модой, медианой и матожиданием

Мода - это значение, которое встречается наиболее часто в наборе данных. Если есть несколько значений, которые встречаются одинаковое количество раз и чаще всего, то набор данных считается мультимодальным. Мода полезна для определения наиболее типичного значения в наборе данных.

Медиана - это среднее значение, которое разделяет набор данных на две равные части. Для нахождения медианы, данные сортируются по возрастанию или убыванию, и значение, находящееся посередине, выбирается в качестве медианы. Если набор данных имеет четное количество значений, то медиана будет средним значением двух центральных значений.

Математическое ожидание (среднее значение) - это сумма всех значений в наборе данных, деленная на количество значений. Математическое ожидание представляет собой среднее значение, которое можно использовать для оценки центральной тенденции данных. Оно чувствительно к выбросам и может быть искажено экстремальными значениями.

Предположим, у нас есть следующий набор данных: {2, 4, 6, 6, 8}

Мода — 6, так как оно встречается наиболее часто в наборе данных.

Медиана — отсортируем данные по возрастанию: 2, 4, 6, 6, 8. Значение, находящееся посередине, является медианой, это 6.

Математическое ожидание — суммируем все значения и делим на их количество: (2 + 4 + 6 + 6 + 8) / 5 = 5.2 — это и есть математическое ожидание.

Если распределение симметричное, то мода, математическое ожидание и медиана совпадают. А вот при асимметрии распределения медиана смещается от моды в сторону более длинного «хвоста». При этом медиана всегда меньше математического ожидания.

Секция "SQL"

В чем заключается разница между MySQL и SQL Server?

Давайте сразу к сути, вот в этой табличке можно увидеть все важные отличия:

MySQL |

SQL Server |

|

|---|---|---|

Что это |

Система управления реляционными базами данных с открытым исходным кодом от Oracle. |

Собственная система управления реляционными базами данных от Microsoft. |

Поддержка различных платформ |

MySQL поддерживает больше платформ, чем SQL Server. |

Microsoft SQL Server поддерживает меньше платформ, чем MySQL. |

Поддержка языков программирования |

MySQL поддерживает больше языков программирования, чем SQL Server, например Perl и Haskel. |

SQL Server поддерживает меньше языков программирования, чем MySQL. |

Возможности |

В MySQL имеется более широкий спектр коннекторов и интеграций от сторонних производителей. |

SQL Server позволяет фильтровать сразу несколько баз данных. Можно также остановить запрос, не завершая весь процесс. |

Возможности масштабирования |

В MySQL предусмотрены функции, которые делают его масштабируемым, но не в такой степени, как SQL Server. |

SQL Server использует сжатие, расширенное разделение и технологию in-memory для обеспечения высокомасштабируемой среды. |

Производительность |

MySQL использует пул соединений и кэширование запросов для обеспечения высокой производительности. |

При работе в масштабируемой среде SQL Server реагирует лучше, чем MySQL. |

Язык и синтаксис запросов |

MySQL использует SQL в качестве языка запросов и употребляет в своем синтаксисе обратные кавычки. |

SQL Server использует SQL в качестве языка запросов и употребляет двойные кавычки в своем синтаксисе. |

Коннекторы и интеграции |

Для MySQL предусмотрено большее количество интеграций, чем для SQL Server. |

В SQL Server существует больше интеграций с продуктами Microsoft. |

Поддержка и документация по продукту |

MySQL – это система с открытым исходным кодом. |

SQL Server – это собственное платное программное обеспечение. |

Возможности безопасности |

С помощью MySQL можно редактировать базы данных во время выполнения. |

В SQL Server нельзя редактировать файлы или получать к ним доступ во время выполнения. |

Ну вот и всё, собственно, это самые основные различия между MySQL и SQL Server.

Что делает UNION? В чем заключается разница между UNION и UNION ALL?

В языке SQL операция UNION применяется для объединения двух наборов строк, возвращаемых SQL-запросами. Оба запроса должны возвращать одинаковое число столбцов, и столбцы с одинаковым порядковым номером должны иметь совместимые типы данных.

Скажем, у нас есть вот такие 2 таблицы sales2005 и sales2006.

При выполнении такого SQL-запроса

(SELECT * FROM sales2005)

UNION

(SELECT * FROM sales2006);

получается результирующий набор, однако порядок строк может произвольно меняться, поскольку ключевое выражение ORDER BY не было использовано:

В результате отобразятся две строки с Иваном, так как эти строки различаются значениями в столбцах. Но при этом в результате присутствует лишь одна строка с Алексеем, поскольку значения в столбцах полностью совпадают.

Применение UNION ALL дает другой результат, так как дубликаты не скрываются. Выполнение запроса:

(SELECT * FROM sales2005)

UNION ALL

(SELECT * FROM sales2006);

даст следующий результат, выводимый без упорядочивания ввиду отсутствия выражения ORDER BY:

Итак, подводя итог, между UNION и UNION ALL такие отличия

UNION:

Оператор UNION объединяет результаты запросов и удаляет дублирующиеся строки из результирующего набора.

Если два запроса в операторе UNION возвращают одинаковые строки, то в результирующем наборе будет только одна копия этих строк.

UNION ALL:

Оператор UNION ALL также объединяет результаты запросов, но не удаляет дублирующиеся строки.

Если два запроса в операторе UNION ALL возвращают одинаковые строки, то в результирующем наборе будут присутствовать обе копии этих строк.

Как оптимизировать SQL-запросы?

Если сразу перейти к ответу, то вот пара практических приёмов.

Используйте индексы: Убедитесь, что у вас есть индексы на столбцах, которые часто используются в условиях WHERE и JOIN. Использование правильных индексов может значительно ускорить выполнение запросов.

Избегайте использования символьных функций в условиях: Использование функций, таких как LIKE, с паттернами, начинающимися с символов, может замедлить выполнение запросов из-за невозможности использования индексов.

Ограничение выборки: Получайте только те столбцы, которые действительно нужны. Используйте SELECT только для необходимых столбцов, а не для всех.

Избегайте использования подзапросов, где это возможно: Иногда, использование JOIN может быть более эффективным, чем подзапросы.

Используйте EXPLAIN: Используйте инструменты, такие как EXPLAIN (в зависимости от вашей СУБД), чтобы понять, как СУБД выполняет запрос, и узнать, где возможны улучшения.

Вот ещё несколько советов, часть перекликается с приёмами выше.

1. Выберите правильный тип данных для столбца

Каждый столбец таблицы в SQL имеет связанный тип данных. Вы можете выбирать из целых чисел, дат, переменных, логических значений, текста и т.д. При разработке важно выбрать правильный тип данных. Числа должны быть числового типа, даты должны быть датами и т.д. Это чрезвычайно важно для индексации. Взглянем сюда:

SELECT employeeID, employeeName

FROM employee

WHERE employeeID = 13412;

Этот запрос извлекает идентификатор и имя сотрудника с идентификатором 13412. Что, если тип данных для employeeID — строка? Вы можете столкнуться с проблемами при использовании индексации, поскольку это займет много времени, когда это должно быть простое сканирование.

2. Табличные переменные и объединения

Когда у вас есть сложные запросы, такие как получение заказов для клиентов, вместе с их именами и датами заказа, вам нужно нечто большее, чем простой оператор выбора. В этом случае мы получаем данные из таблиц клиентов и заказов. Вот где вступают в силу объединения. Глянем на пример соединения:

SELECT Orders.OrderID, Customers.CustomerName, Orders.OrderDate

FROM Orders

INNER JOIN Customers ON Orders.CustomerID=Customers.CustomerID;

Табличные переменные — это локальные переменные, которые временно хранят данные и обладают всеми свойствами локальных переменных. Не используйте табличные переменные в объединениях, как SQL видит их как одну строку. Несмотря на то, что они быстрые, табличные переменные плохо работают в соединениях.

3. Используйте условное предложение WHERE

Условные предложения WHERE используются для подмножества. Допустим, у вас есть такая ситуация:

- if SEQ_VAR in (1, 2, 3) & diff(DATE_VAR2, DATE_VAR1) ≥ 0

— elif SEQ_VAR in (4, 5, 6) & diff(DATE_VAR2, DATE_VAR1) ≥1

— else diff(DATE_VAR2, DATE_VAR1) ≥2

С условным предложением WHERE это будет выглядеть так:

SELECT

DAT.ID_VAR,

DAT.SEQ_VAR,

DAT.NUM_VAR,

DATE_VAR1,

DATE_VAR2,

TRUNC(DATE_VAR2) - TRUNC(DATE_VAR1) AS LAG_IN_DATES

FROM

CURRENT_TABLE DAT

WHERE

(TRUNC(DATE_VAR2) - TRUNC(DATE_VAR1)) >= CASE WHEN SEQ_VAR IN (1,2,3) THEN 0 WHEN SEQ_VAR IN (4,5,6) THEN 1 ELSE 2 END

ORDER BY ID_VAR, SEQ_VAR

4. Используйте SET NOCOUNT ON

При выполнении операций INSERT, SELECT, DELETE и UPDATE, используйте SET NOCOUNT ON. SQL всегда возвращает соответствующее количество строк для таких операций, поэтому, когда у вас есть сложные запросы с большим количеством соединений, это может повлиять на производительность.

С SET NOCOUNT ON SQL не будет подсчитывать затронутые строки и улучшить производительность.

В этом примере ниже мы предотвращаем отображение сообщения о количестве затронутых строк.

USE AdventureWorks2012;

GO

SET NOCOUNT OFF;

GO

-- Display the count message.

SELECT TOP(5)LastName

FROM Person.Person

WHERE LastName LIKE 'A%';

GO

-- SET NOCOUNT to ON to no longer display the count message.

SET NOCOUNT ON;

GO

SELECT TOP(5) LastName

FROM Person.Person

WHERE LastName LIKE 'A%';

GO

-- Reset SET NOCOUNT to OFF

SET NOCOUNT OFF;

GO

5. Избегайте ORDER BY, GROUP BY и DISTINCT

Использование ORDER BY, GROUP BYи DISTINCT только в случае необходимости. SQL создает рабочие таблицы и помещает туда данные. Затем он организует данные в рабочей таблице на основе запроса и затем возвращает результаты.

6. Полностью уточняйте имена объектов базы данных

Цель использования полностью определенных имен объектов базы данных — устранить двусмысленность. Полное имя объекта выглядит так:

DATABASE.SCHEMA.OBJECTNAME.

Когда у вас есть доступ к нескольким базам данных, схемам и таблицам, становится важным указать, к чему вы хотите получить доступ. Вам не нужно этого делать, если вы не работаете с большими базами данных с несколькими пользователями и схемами, но это хорошая практика.

Поэтому вместо использования такого оператора:

SELECT * FROM TableName

Вам следует использовать:

SELECT * FROM dbo.TableName

7. Узнайте, как полностью защитить свой код

Базы данных хранят всевозможную информацию, что делает их основными целями атак. Распространенные атаки включают SQL-инъекции, когда пользователь вводит инструкцию SQL вместо имени пользователя и извлекает или изменяет вашу базу данных. Примеры SQL-инъекций:

textuserID = getRequestString("userID");

textSQL = "SELECT * FROM Users WHERE userID = " + textuserID;

Допустим, у вас есть это, вы textuserIDполучите ввод от пользователя. Вот как это может пойти не так:

SELECT * FROM Users WHERE userID = 890 OR 1=1;

Поскольку 1=1 всегда верно, он будет извлекать все данные из таблицы Users.

Вы можете защитить свою базу данных от SQL-инъекций, используя параметризованные операторы, проверки ввода, очистку ввода и т. Д. Как вы защищаете свою базу данных, зависит от СУБД. Вам нужно будет разобраться в своей СУБД и ее проблемах безопасности, чтобы вы могли писать безопасный код.

8. используйте LAG и LEAD для последовательных строк

Функция LAG позволяет запрашивать более одной строки в таблице одновременно без необходимости присоединяться к таблице. Она возвращает значения из предыдущей строки таблицы.

LAG(expression [,offset[,default_value]]) OVER(ORDER BY columns)

Функция LEAD делает то же самое, но и для следующей строки.

LEAD(expression [,offset[,default_value]]) OVER(ORDER BY columns)

Отказ от использования самостоятельных соединений повышает производительность, поскольку уменьшается количество операций чтения. Но, вы должны проверить, как LEAD и LAG влияют на производительность запросов.

Хорошая статья по оптимизации SQL-запросов

Выведите список сотрудников с зарплатой выше, чем у руководителя

Сразу напишем этот SQL-запрос:

SELECT a.*

FROM employee a, employee b

WHERE b.id = a.chief_id

AND a.salary > b.salary

Данный SQL-запрос выбирает все столбцы из таблицы "employee" для записей, где зарплата сотрудника больше зарплаты его начальника. Запрос использует две таблицы "employee a" и "employee b", где "b.id" равно "a.chief_id".

Этот запрос позволяет найти сотрудников, у которых зарплата выше, чем у их начальников. Он использует связь между таблицами "employee a" и "employee b" по полю "chief_id", чтобы сравнить зарплаты сотрудников и их начальников.

Например, если у нас такая таблица "employee":

id |

name |

chief_id |

salary |

|---|---|---|---|

1 |

John |

2 |

5000 |

2 |

Peter |

3 |

4000 |

3 |

Sarah |

NULL |

3000 |

4 |

Emily |

2 |

4500 |

то результатом выполнения данного запроса будет:

id |

name |

chief_id |

salary |

|---|---|---|---|

1 |

John |

2 |

5000 |

4 |

Emily |

2 |

4500 |

Таким образом, запрос выбирает сотрудников, у которых зарплата выше, чем у их начальников, и возвращает все столбцы для этих сотрудников.

Неплохое видео в тему, кстати — Карьера в DATA SCIENCE: TOP-50 Вопросов на собеседовании // PART 1

Какие оконные функции существуют?

В SQL есть пара оконных функций; они позволяют выполнять вычисления и агрегирование данных внутри определенного окна или группы строк. Их 3 группы: агрегирующие (сумма, количество, минимум...), ранжирующие, функции смещения. Вот основные:

-

ROW_NUMBER(): присваивает уникальный номер каждой строке внутри определенного окна

SELECT ROW_NUMBER() OVER (ORDER BY column_name) AS row_number, column_name FROM table_name;тут

ROW_NUMBER()присваивает уникальный номер каждой строке в столбцеcolumn_name, сортируя строки по возрастанию значения столбцаcolumn_name -

RANK(): присваивает ранг каждой строке внутри определенного окна на основе заданного порядка сортировки

SELECT RANK() OVER (ORDER BY column_name) AS rank, column_name FROM table_name;здесь функция

RANK()присваивает ранг каждой строке в столбцеcolumn_name, сортируя строки по возрастанию значения столбцаcolumn_name -

DENSE_RANK(): тоже присваивает ранг каждой строке внутри определенного окна на основе заданного порядка сортировки, но без пропусков в рангах

SELECT DENSE_RANK() OVER (ORDER BY column_name) AS dense_rank, column_name FROM table_name;тут

DENSE_RANK()присваивает ранг каждой строке в столбцеcolumn_name, сортируя строки по возрастанию значения столбцаcolumn_nameбез пропусков в рангах -

COUNT(): используется для подсчета количества строк внутри определенного окна

SELECT COUNT(column_name) OVER (PARTITION BY partition_column) AS count, column_name FROM table_name;здесь

COUNT()подсчитывает количество строк в столбцеcolumn_nameвнутри каждого раздела, заданного столбцомpartition_column -

SUM(): считает сумму значений столбца внутри окна

SELECT SUM(column_name) OVER (PARTITION BY partition_column) AS sum, column_name FROM table_name;тут

SUM()вычисляет сумму значений столбцаcolumn_nameвнутри каждого раздела, заданного столбцомpartition_column -

MAX(): используется для нахождения максимального значения столбца внутри определенного окна

SELECT MAX(column_name) OVER (PARTITION BY partition_column) AS max, column_name FROM table_name;тут

MAX()находит максимальное значение столбцаcolumn_nameвнутри каждого раздела, заданного столбцомpartition_column -

MIN(): используется для нахождения минимального значения столбца внутри окна

SELECT MIN(column_name) OVER (PARTITION BY partition_column) AS min, column_name FROM table_name;тут мы находим минимальное значение столбца

column_nameвнутри каждого раздела, заданного столбцомpartition_column

Вообще, это не все оконные функции, их больше. А какие ещё функции вы знаете?)

Найдите список ID отделов с максимальной суммарной зарплатой сотрудников

Нужный SQL-запрос выглядит так:

WITH sum_salary AS

(SELECT department_id,

SUM(salary) salary

FROM employee

GROUP BY department_id)

SELECT department_id

FROM sum_salary a

WHERE a.salary = (SELECT MAX(salary)

FROM sum_salary)

Этот SQL-запрос выполняет несколько действий.

Первая часть с ключевым словом WITH создает временную таблицу sum_salary, которая содержит результаты агрегации. В данном случае она вычисляет сумму зарплат сотрудников для каждого отдела. Таким образом, во временной таблице будут два столбца: department_id и salary, где department_id - это идентификатор отдела, а salary - сумма зарплат всех сотрудников в этом отделе.

Затем осуществляется основной запрос:

SELECT department_id

FROM sum_salary a

WHERE a.salary = (SELECT MAX(salary)

FROM sum_salary)

В этой части запроса выбираются department_id из временной таблицы sum_salary, где salary равна максимальной зарплате, найденной во временной таблице sum_salary.

Вот в принципе и всё, этот SQL-запрос возвращает идентификаторы отделов, у которых сумма зарплат всех сотрудников является максимальной среди всех отделов.

В чём разница между CHAR и VARCHAR?

CHAR и VARCHAR - это два разных типа данных для хранения символьных строк в SQL. Вот их отличия:

CHAR:

CHAR используется для хранения фиксированной длины символьных строк.

Поэтому длина строки для CHAR всегда остается постоянной и занимает фиксированное количество памяти, даже если реальная строка короче.

Неиспользуемое пространство в конце строки заполняется пробелами или нулевыми символами. То есть, если определить столбец с типом CHAR(10) и внести в него значение "Hello", то оно будет сохранено как "Hello " (с пятью пробелами в конце).

VARCHAR:

VARCHAR используется для хранения переменной длины символьных строк.

Длина строки для VARCHAR может изменяться в зависимости от реальной длины внесенных данных.

Занимает только столько места, сколько нужно. Скажем, если определить столбец с типом VARCHAR(10) и внести в него значение "Hello", то оно будет сохранено как "Hello" (точно так же, никаких пробелов в конце)

Итого, разница между CHAR и VARCHAR:

Основное отличие в способе хранения данных. CHAR занимает фиксированное количество памяти, VARCHAR занимает только столько места, сколько нужно.

А вот так это можно использовать, простецкий пример:

CREATE TABLE users (

id INT,

name CHAR(10),

email VARCHAR(50)

);

INSERT INTO users (id, name, email) VALUES (1, 'John', 'john@example.com');

INSERT INTO users (id, name, email) VALUES (2, 'Jane', 'jane@example.com');

Тут мы создаем таблицу users с тремя столбцами: id типа INT, name типа CHAR(10) и email типа VARCHAR(50). И вставляем две строки данных в эту таблицу.

Выберите самую высокую зарплату, не равную максимальной зарплате из таблицы

Запрос, который нам нужен будет выглядеть как-то так:

SELECT MAX(salary)

AS Second_Highest_Salary

FROM employee

WHERE salary !=

(SELECT MAX(salary)

FROM employee)

Разберём, что тут происходит. Запрос выполняет поиск второй по величине зарплаты среди сотрудников в таблице employee. Запрос состоит из двух частей:

-

Внешний запрос:

Используется функция

MAX(salary)для нахождения максимальной зарплаты среди всех сотрудников.Результат этого запроса будет называться "Second_Highest_Salary"

-

Внутренний запрос:

Используется функция

MAX(salary)для нахождения максимальной зарплаты среди всех сотрудников.Этот запрос используется в условии

WHERE salary != (SELECT MAX(salary) FROM employee), чтобы исключить сотрудников с максимальной зарплатой из результата внешнего запроса.

Таким образом, результатом выполнения данного запроса будет вторая по величине зарплата среди всех сотрудников в таблице employee.

Ну а работает запрос как-то так. Скажем, в таблице employee такие записи:

employee_id |

salary |

|---|---|

1 |

5000 |

2 |

6000 |

3 |

4000 |

4 |

7000 |

5 |

3000 |

Тогда результат будет:

Second_Highest_Salary |

|---|

6000 |

Чем отличаются SQL и NoSQL?

Зачем этот вопрос тут? Ну, это очень здорово, когда разраб не привязан к одной технологии и понимает, что не SQL единым. В некоторых ситуациях лучше использовать NoSQL-решения, гибкость и умение выбирать стек с учётом задачи поднимает разработчика в топ.

Начнём пожалуй с плюсов SQL:

Базы данных SQL просты в использовании. Даже люди, не имеющие опыта работы с базами данных, могут научиться использовать базы данных SQL, пройдя небольшое обучение.

Они очень универсальны и могут использоваться для любых целей - от небольших персональных до крупных корпоративных баз данных, нуждающихся в хранении данных.

Базы данных SQL надежны. Они предназначены для обработки больших объемов данных и транзакций без потери или повреждения базы данных. Если в них используется распределенная база данных, это может обеспечить безопасность. В распределенной базе данных подобные базы данных находятся в разных местах.

Их можно масштабировать. Их можно легко расширить, чтобы вместить больше данных и пользователей по мере необходимости. Вы получаете больше места для хранения данных.

Большинство крупных поставщиков баз данных поддерживают базы данных SQL. Это означает, что у предприятий есть много вариантов, когда дело доходит до выбора базы данных SQL.

Их поддерживает сильное сообщество разработчиков. Это сообщество обеспечивает поддержку и ресурсы для предприятий и частных лиц, использующих базы данных SQL.

Какие же отличия между SQL и NoSQL?

Базы данных SQL - это реляционные базы данных. Это означает, что данные организованы в таблицы, и каждая таблица имеет определенную структуру. Таблицы связаны друг с другом посредством отношений. Это делает базы данных SQL очень мощными для хранения данных, доступ к которым должен осуществляться определенным образом.

Базы данных NoSQL - это нереляционные базы данных. Это означает, что данные хранятся в виде набора документов. У этих документов нет определенной структуры, и они не связаны друг с другом отношениями. Таким образом, они больше подходят для хранения данных, к которым не нужно обращаться определенным образом.

Одно из основных различий между базами данных SQL и NoSQL заключается в способе масштабирования. Базы данных SQL используют вертикальное масштабирование, то есть они масштабируются за счет увеличения мощности сервера. Базы данных NoSQL используют горизонтальное масштабирование, то есть они масштабируются путем добавления большего количества серверов.

Еще одно различие заключается в том, что базы данных SQL обычно дороже в обслуживании, чем базы данных NoSQL. Базы данных SQL требуют большего администрирования, например, создания и поддержки индексов и представлений. Базы данных NoSQL зачастую менее затратны, так как требуют меньше администрирования.

Базы данных SQL также обычно более сложны, чем базы данных NoSQL. Это связано с тем, что базы данных SQL должны следовать правилам ACID (атомарность, согласованность, изоляция и долговечность), что может сделать их более медленными и сложными. С другой стороны, базы данных NoSQL часто более просты и могут быть быстрее, поскольку им не нужно следовать правилам ACID.

С SQL-решениями все знакомы, поэтому приведу примеры популярных NoSQL БД:

MongoDB - популярная база данных NoSQL. Это документо-ориентированная база данных, простая в использовании и масштабируемая. MongoDB также очень гибкая, позволяющая хранить широкий спектр типов данных. Они могут работать с большими данными.

Cassandra - еще одна популярная база данных NoSQL. Это база данных, ориентированная на столбцы, которая разработана для обеспечения высокой доступности и масштабируемости. Cassandra часто используется для хранения больших объемов данных.

HBase - это база данных, ориентированная на столбцы, построенная на основе файловой системы Hadoop. HBase разработана для масштабируемости и производительности. HBase часто используется для анализа данных в режиме реального времени.

Redis - это надежная база данных in-memory, которая часто используется для кэширования. Redis быстра и может использоваться для многих приложений.

Неплохое сравнение SQL и NoSQL на Хабре

В чём разница между DELETE и TRUNCATE?

И DELETE, и TRUNCATE используются для удаления данных из таблицы. Но они имеют большие отличия.

DELETE используется для удаления одной/нескольких строк из таблицы. Она является частью языка DML (Data Manipulation Language) и позволяет удалить строки, удовлетворяющие определенному условию.

DELETE FROM employees WHERE department = 'HR';

Здесь все строки из таблицы employees, где значение столбца department равно 'HR', будут удалены.

Команда TRUNCATE используется для удаления всех строк из таблицы. Она является частью языка DDL (Data Definition Language) и выполняет операцию над всей таблицей, а не над отдельными строками.

TRUNCATE TABLE employees;

Тут все строки из таблицы employees будут удалены.

И ещё различия между DELETE и TRUNCATE

Скорость выполнения: TRUNCATE выполняется быстрее, чем DELETE, потому что она не записывает каждую удаленную строку в журнал транзакций и не сохраняет возможность отката операции удаления. Это делает TRUNCATE более эффективным при удалении больших объемов данных.

Восстановление данных: DELETE можно отменить с помощью операции отката транзакции, в то время как TRUNCATE не может быть отменен. После выполнения TRUNCATE, данные будут потеряны без возможности их восстановления.

Ну и с связи с отличиями выше использование ресурсов: DELETE использует больше ресурсов, так как записывает каждую удаленную строку в журнал транзакций и может вызвать фрагментацию данных. TRUNCATE не записывает каждую удаленную строку и не вызывает фрагментацию данных.

Пронумеруйте строки в таблице employee

Нам нужен вот этот запрос:

SELECT ROW_NUMBER() over(ORDER BY id)

as id_num

FROM employee

Что же тут происходит?

Выбираем все строки из таблицы

employeeПрименяем функцию

ROW_NUMBER()для присвоения каждой строке уникального номера в порядке, определенном выражениемORDER BY idПереименовываем столбец с номерами строк в

id_numс помощью выраженияas id_num

Таким образом, данный запрос возвращает все строки из таблицы employee с дополнительным столбцом id_num, содержащим уникальные номера строк, отсортированные по значению столбца id

Вот в целом и всё.

Пронумеруйте строки в таблице в разрезе отдела по зарплате

Сразу напишем нужный SQL-запрос, вот он:

SELECT ROW_NUMBER() over (PARTITION BY department ORDER BY salary) salary_num FROM employee

Этот SQL-запрос выполняет нумерацию (назначает номера) для каждой записи в таблице employee в зависимости от их зарплаты внутри каждого отдела.

-

ROW_NUMBER() over (PARTITION BY department ORDER BY salary):ROW_NUMBER()- это оконная функция, которая назначает уникальный номер (последовательный) для каждой строки в каждой группе результатов.OVER- используется для определения оконной рамки для функции.PARTITION BY department- это указывает, что операцияROW_NUMBER()будет выполняться отдельно для каждого уникального значения в столбцеdepartmentORDER BY salary- определяет порядок, в котором будут назначены числа внутри каждой группы - зарплаты будут упорядочены по возрастанию.

-

salary_num FROM employee:salary_num- это название, под которым будут возвращены назначенные номера.FROM employee- указывает, что данные берутся из таблицыemployee

Таким образом, данный запрос вернет таблицу, в которой каждая строка будет содержать уникальный номер (последовательный) для каждой записи в каждом отделе в зависимости от их зарплаты, упорядоченной по возрастанию.

В целом, запрос довольно простой и несложный, думаю, с ним всё понятно.

Какие есть уровни изоляции транзакций?

Что ж, в SQL официально существуют различные уровни изоляции транзакций, которые определяют, как одна транзакция видит изменения, внесенные другими транзакциями. Вот они:

Read Uncommitted (Чтение неподтвержденных данных): Этот уровень изоляции позволяет транзакции видеть изменения, внесенные другими транзакциями, даже если они еще не были подтверждены. Это самый низкий уровень изоляции и может привести к проблемам, таким как "грязное чтение" и "неповторяющееся чтение".

Read Committed (Чтение подтвержденных данных): Этот уровень изоляции позволяет транзакции видеть только подтвержденные изменения других транзакций. Это означает, что транзакция не будет видеть изменения, которые еще не были подтверждены другими транзакциями. Однако, другие транзакции могут вносить изменения в данные, которые уже были прочитаны текущей транзакцией, что может привести к проблеме "неповторяющегося чтения".

Repeatable Read (Повторяемое чтение): Этот уровень изоляции гарантирует, что транзакция будет видеть одни и те же данные при повторном чтении в рамках той же транзакции. Другие транзакции не смогут вносить изменения в данные, которые уже были прочитаны текущей транзакцией. Однако, другие транзакции могут вносить новые данные, которые будут видны текущей транзакции.

Serializable (Сериализуемость): Этот уровень изоляции обеспечивает полную изоляцию транзакций. Он гарантирует, что транзакция будет видеть данные так, как если бы она работала в изоляции, то есть так, как если бы она была единственной транзакцией, работающей с данными. Это предотвращает проблемы "грязного чтения", "неповторяющегося чтения" и "фантомного чтения".

Каждая СУБД может иметь свои собственные реализации и названия для этих уровней изоляции. Например, в SQL Server они называются "Read Uncommitted", "Read Committed", "Repeatable Read" и "Serializable".

В PostgreSQL они называются "Read Uncommitted", "Read Committed", "Repeatable Read" и "Serializable".

Давайте перейдём к практике. Вот пример использования уровня изоляции транзакций в SQL Server:

SET TRANSACTION ISOLATION LEVEL <уровень изоляции>

BEGIN TRAN

-- Ваш код транзакции

COMMIT

Скажем, чтобы установить уровень изоляции "Read Uncommitted", можно написать такой запрос:

SET TRANSACTION ISOLATION LEVEL READ UNCOMMITTED

BEGIN TRAN

-- Ваш код транзакции

COMMIT

Attention: уровень изоляции может быть установлен только в начале транзакции и будет действовать до ее завершения.

Это была самая суть по уровням изоляции, а вообще тема довольно глубокая.

Годнота с Хабр — Уровни изоляции транзакций с примерами на PostgreSQL

Секция "Python"

Кто знает, откуда картинка?

Как ни крути, рабочая лошадка для Data Science — это Python (вообще ещё есть R с Julia). Поэтому понимать свой рабочий инструмент крайне важно. Недавно я опубликовал статью 100 вопросов для подготовки к собесу Python — если вы ориентируетесь во всех этих вопросах, то скорее всего проблем с Python у вас нет.

Разумеется, в DS используется не сырой питон — он уже давно оброс классными библиотеками: NumPy, Pandas, SciPy, Matplotlib, Seaborn, Plotly, Scikit Learn. Ну и всякие TensorFlow и PyTorch для Machine Learning. Овладевание этими либами сильно упростит работу и повысит ваш уровень дата-сайнтиста.

Ну а здесь, в этой секции, давайте затронем более специализированные вопросы по Python, вопросы, довольно сильно связанные с DS.

Какие отличия есть у Series и DataFrame в Pandas?

Сперва пару слов о Series.

Тип данных Series в библиотеке Pandas представляет собой одномерный массив с метками, который может содержать данные различных типов, таких как числа, строки, булевы значения и т.д. Series похож на простой словарь типа dict, где имя элемента будет соответствовать индексу, а значение – значению записи.

Ну и вот так мы можем работать с Series.

Создание Series из списка:

import pandas as pd

data = [10, 20, 30, 40, 50]

series = pd.Series(data)

print(series)

# вывод

# 0 10

# 1 20

# 2 30

# 3 40

# 4 50

# dtype: int64

Создание Series из словаря:

import pandas as pd

data = {'a': 10, 'b': 20, 'c': 30}

series = pd.Series(data)

print(series)

# вывод

# a 10

# b 20

# c 30

# dtype: int64

Для Series существует множество разных методов:

head() — возвращает первые несколько элементов

tail() — возвращает последние несколько элементов

describe() — возвращает основные статистические характеристики Series, такие как среднее значение, стандартное отклонение и т.д.

value_counts() — возвращает количество уникальных значений

sort_values() — сортирует значения

mean() — возвращает среднее значение

sum() — возвращает сумму

max() — возвращает максимальное значение

min() — возвращает минимальное

Теперь про DataFrame.

DataFrame - это одна из основных структур данных в библиотеке Pandas для анализа данных на языке Python. Это двумерная таблица с метками строк и столбцов, где каждый столбец может содержать разные типы данных.

Создавать DataFrame можно например так:

Создание DataFrame из списка списков:

import pandas as pd

data = [['Alice', 25], ['Bob', 30], ['Charlie', 35]]

df = pd.DataFrame(data, columns=['Name', 'Age'])

print(df)

# вывод:

# Name Age

# 0 Alice 25

# 1 Bob 30

# 2 Charlie 35

Создание DataFrame из словаря:

import pandas as pd

data = {'Name': ['Alice', 'Bob', 'Charlie'], 'Age': [25, 30, 35]}

df = pd.DataFrame(data)

print(df)

# вывод:

# Name Age

# 0 Alice 25

# 1 Bob 30

# 2 Charlie 35

Для DataFrame есть масса методов, вот основные:

head() — возвращает первые несколько строк DataFrame

tail() — возвращает последние несколько строк

info() — выводит информацию о DataFrame, включая типы данных и количество ненулевых значений

describe() — возвращает статистическую сводку для числовых столбцов DataFrame

shape — возвращает размерность DataFrame в виде кортежа (количество строк, количество столбцов).

columns — возвращает список названий столбцов

index — возвращает индексы строк

loc[] — индексация по меткам строк и столбцов

iloc[] — индексация по целочисленным позициям строк и столбцов

dropna() — удаляет строки или столбцы с отсутствующими значениями

fillna() — заполняет отсутствующие значения определенным значением или стратегией

groupby() — группирует данные по заданному столбцу или набору столбцов

merge() — объединяет два DataFrame по заданному столбцу или набору столбцов

Ну и наконец, сравним Series и DataFrame:

Series |

DataFrame |

|

|---|---|---|

Структура данных |

Одномерный массив с метками (индексами) |

Двумерная таблица с метками (индексами) для строк и столбцов |

Размерность |

Одномерный |

Двумерный |

Индексация |

Имеет только один индекс, который может быть задан явно или автоматически создан |

Имеет два индекса: индекс строк и индекс столбцов, которые могут быть заданы явно или автоматически созданы |

Структура данных в памяти |

Хранит только один столбец данных и индексы |

Хранит несколько столбцов данных и два индекса |

Создание |

Можно создать из списка, массива, словаря или другой Series |

Можно создать из списка, массива, словаря или другого DataFrame |

Применение функций |

Можно применять функции к каждому элементу Series |

Можно применять функции к каждому столбцу или строке DataFrame |

Объединение данных |

Нельзя объединять несколько Series в один объект без создания DataFrame |

Можно объединять несколько DataFrame в один объект |

Кроме того, в DataFrame есть дополнительные возможности, такие как группировка данных, агрегирование, сортировка, фильтрация и многие другие, которых нет в Series.

Если остались вопросы, я отсылаю к замечательной документации

Напишите функцию, которая определяет количество шагов для преобразования одного слова в другое

Интересное задание, наша функция должна принимать на вход 3 аргумента:

begin_word = "same"

end_word = "cost"

word_list = ["same", "came"," case", "cast", "lost", "last", "cost"]

И при таких аргументах наша функция shortest_transformation должна возвращать 5, потому что на основе данного списка получить 'cost' из 'same' можно минимум за 5 шагов.

def shortest_transformation(begin_word, end_word, word_list) -> 5

Поскольку последовательность преобразования будет такой:

'same' -> 'came' -> 'case' -> 'cast' -> 'cost'

Что ж, осталось запилить эту функцию. Какие есть варианты? Пишите)

В чём преимущества массивов NumPy по сравнению с (вложенными) списками python?

Основное преимущество массивов NumPy перед списками Python заключается в том, что NumPy использует более оптимизированную память и имеет более эффективные методы работы с массивами (из-за реализации на C), что делает его подходящим выбором для работы с большими объемами данных и научных вычислений.

Например, с NumPy вы можете выполнять бродкастинг (broadcasting), матричные операции и другие векторизованные вычисления с более высокой производительностью, чем при использовании вложенных списков.

Некоторые из основных преимуществ NumPy:

Более оптимизированная память, что позволяет NumPy работать быстрее с большим объемом данных

Встроенные методы для выполнения арифметических операций, таких как сумма и произведение, которые могут работать сразу над всеми элементами массивов.

Возможность выполнять матричные операции и другие векторизованные вычисления.

Простой синтаксис для выполнения операций над массивами.

Возможность конвертировать массивы NumPy в другие формы данных, такие как списки Python или таблицы Pandas.

Eсли вы работаете с массивами данных, над которыми нужно выполнять научные вычисления, то использование NumPy будет более предпочтительным вариантом, чем использование списков Python.

Вообще, это довольно большая тема, но на этом пока остановимся.

В чём отличие между map, apply и applymap в Pandas?

В библиотеке Pandas есть 3 метода: map(), apply() и applymap(), которые используются для модификации данных в DataFrame или Series. Отличие в том, как они работают с данными: целиком или строчно/постолбцово. Ещё отличие между ними в том, к чему можно их применять.

map() — только к Series

apply() и к Series, и к DataFrame

applymap() только к DataFrame.

map()- применяется только к объекту Series и выполняет операции поэлементно. Он принимает в качестве аргумента словарь, объект Series или функцию и применяет ее к каждому элементу Series.

import pandas as pd # 0 1

s = pd.Series([1, 2, 3]) # 1 2

print(s) # 2 3

# dtype: int64

print(s.map(lambda x: x * 2)) # 0 2

# 1 4

# 2 6

# dtype: int64

apply()- может быть применен как к объекту Series, так и к объекту DataFrame. При применении к объекту Series, он работает построчно или постолбцово и применяет функцию к каждому элементу или ряду/столбцу. При применении к объекту DataFrame, он также работает построчно или постолбцово, но применяет функцию к каждой строке или столбцу

import pandas as pd

df = pd.DataFrame({'A': [1, 2, 3], 'B': [4, 5, 6]})

print(df)

# A B

# 0 1 4

# 1 2 5

# 2 3 6

# построчное применение # A B

print(df.apply(lambda x: x * 2)) # 0 2 8

# 1 4 10

# 2 6 12

# постолбцовое применение

print(df.apply(lambda x: x.max())) # A 3

# B 6

# dtype: int64

applymap()- Этот метод применяется только к объекту DataFrame и выполняет операции поэлементно. Он принимает в качестве аргумента функцию и применяет ее к каждому элементу.

Кстати, applymap() скоро has been deprecated, поэтому use map instead, говорит Python.

import pandas as pd

df = pd.DataFrame({'A': [1, 2, 3], 'B': [4, 5, 6]})

print(df)

# A B

# 0 1 4

# 1 2 5

# 2 3 6

print(df.applymap(lambda x: x * 2)) # A B

# 0 2 8

# 1 4 10

# 2 6 12

Таким образом, map() применяется только к Series, apply() может быть применен как к Series, так и к DataFrame, а applymap() применяется только к DataFrame.

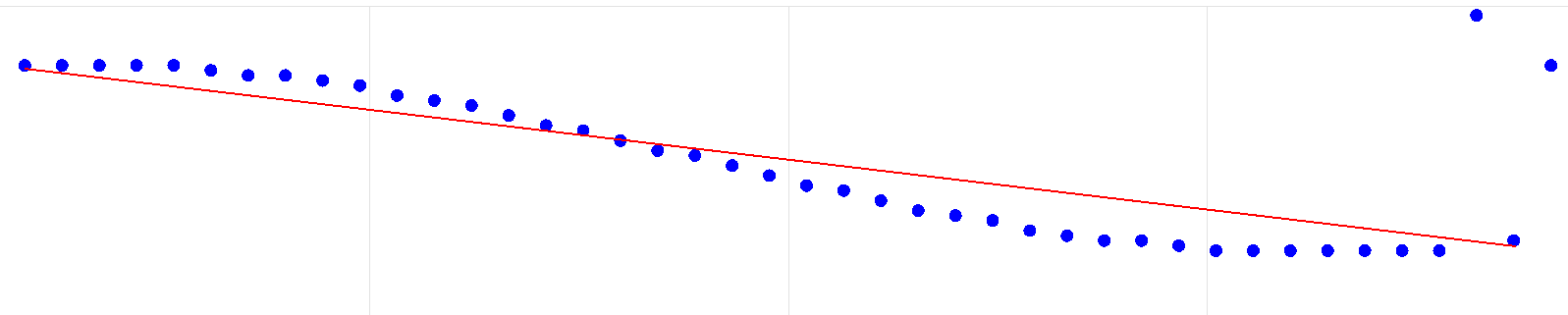

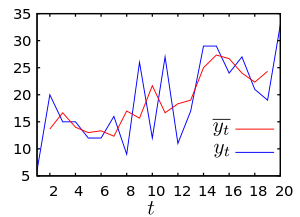

Самый простой способ реализовать скользящее среднее с помощью NumPy

Скользящее среднее (moving average, MA) — функция, значения которой равны некоторому среднему значению исходной функции за предыдущий период.

Вот например график исходной функции (синий) и его скользящая средняя (красная) с шириной окна n = 2

Самый простой способ реализовать скользящее среднее с помощью NumPy - использовать функцию np.convolve() для вычисления скользящего среднего. Как-то так:

import numpy as np

def moving_average(x, n):

weights = np.ones(n) / n

return np.convolve(x, weights, mode='valid')

x = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10]

n = 3

result = moving_average(x, n)

print(result)

# [2. 3. 4. 5. 6. 7. 8. 9.]

Тут мы определяем функцию moving_average(), которая принимает массив x и размер окна n. Функция использует np.convolve() для вычисления скользящего среднего с весами, равными 1/n. Режим 'valid' гарантирует, что результат будет иметь ту же длину, что и исходный массив.

Attention, в этом примере мы используем режим 'valid', который означает, что выходной массив будет иметь меньшую длину, чем исходный массив. Если вам нужно сохранить длину исходного массива, вы можете использовать режим 'same', но это потребует небольшой модификации кода.

Поддерживает ли Python регулярные выражения?

...если вы решили проблему при помощи регулярных выражений — теперь у вас две проблемы ©

Да, Python поддерживает использование регулярных выражений (regex). В стандартной библиотеке Python имеется модуль re, который предоставляет множество функций для работы с регулярными выражениями. Этот модуль позволяет выполнять различные операции, такие как поиск, замена, разбиение текста на подстроки и проверку совпадений с шаблоном регулярного выражения.

Вот, кстати, основные компоненты регулярных выражений, лично я довольно часто ими пользуюсь:

\w- соответствует всем символам "слов". Символы слов являются буквенно-цифровыми (a-z, A-Z символы и подчеркивание).\W- соответствует символам "не слов". Все, кроме буквенно-цифровых символов и подчеркивания.\d- соответствует символам "цифр". Любая цифра от 0 до 9.\D- символы "не цифр". Все, кроме с 0 до 9.\s- символы пробела, в т.ч. символы табуляции и разрывы строк.\S- всё, кроме пробелов..- любой символ, кроме разрыва строки.[A-Z]- символы в диапазоне; например,[A-E]будет соответствовать A, B, C, D и E.[ABC]- символы в заданном наборе; например,[AMT]будет соответствовать только A, M и T.[^ABC]- символы, отсутствующие в заданном наборе. Например,[^A-E]будет соответствовать всем символам, кроме A, B, C, D и E.+- одно или несколько вхождений предыдущего символа. Например,\w+вернет ABD12D в виде единственного соответствия вместо шести разных совпадений.*- ноль или более вхождений предыдущего символа. Например,b\w*соответствует полужирным частям в фразе b, bat, bajhdsfbfjhbe. В целом, он соответствует нулю или более символам "слова" после "b".{m, n}- не менее m и не более n вхождений предыдущего символа.{m,}будет соответствовать не менее m вхождений, и верхнего предела для совпадения не будет.{k}будет соответствовать точно k вхождениям предыдущего символа.?- ноль или одно вхождение предыдущего символа. Например, это может быть полезно при поиска двух вариантов написания для одной и той же работы. Например,/behaviou?r/будет соответствовать как behavior, так и behaviour.|- соответствует выражению до или после "pipe" символа. Например,/se(a|e)/соответствует как see, так и sea.^- ищет регулярное выражение в начале текста или в начале каждой строки, если включен многострочный флаг.$- ищет регулярное выражение в конце текста или в конце каждой строки, если включен многострочный флаг.\b- предыдущий символ соответствует, только если это граница слова.\B- предыдущий символ соответствует только в том случае, если граница слова отсутствует.(ABC)- это сгруппирует несколько символов вместе и запомнит подстроку, соответствующую им, для последующего использования. Это называется скобочной группой.(?:ABC)- это также объединяет несколько символов вместе, но не запоминает совпадение. Это незапоминаемая скобочная группа.\d+(?=ABC)- это будет соответствовать символу(-ам), предшествующему(?=ABC), только если за ним следуетABC. ЧастьABCне будет включена в массив совпадений. Часть\d- это всего лишь пример. Это может быть любая строка регулярного выражения.\d+(?!ABC)- это будет соответствовать символу(-ам), предшествующему(?!ABC), только если за ним не следуетABC. ЧастьABCне будет включена в массив совпадений. Часть\d- это всего лишь пример. Это может быть любая строка регулярного выражения.

Для работы с регулярными выражениями в Python обычно используются строковые литералы с префиксом r (raw string), которые позволяют использовать специальные символы без экранирования. Например, регулярное выражение для поиска слов, начинающихся на "a" и заканчивающихся на "b", может быть записано так:

import re

text = "apple and banana are fruits, but apricot is not"

pattern = r"\ba\w*b\b"

matches = re.findall(pattern, text)

print(matches) # output: ['apple', 'apricot']

Здесь функция re.findall() выполняет поиск всех совпадений с шаблоном регулярного выражения pattern в строке text и возвращает список найденных подстрок.

Продолжи: "try, except, ..."

Существует try — except — finally и есть try — except — else. И даже можно объединить:

try:

... # попробует сделать это

except:

... # обработка исключения

else:

... # выполнится, если не выполнился except

finally:

... # выполнится всегда

Ну вот собственно и всё