Громоподобный шаг научно-технического прогресса слышен издалека: сквозь года до нас доносится эхо шагов из будущего. Шрамы ран, полученных в предыдущие промышленные революции, априорные, переданные через учебники и опыт предков, болезненно сжимаются под воздействием этого эха. Как и всё великое, дела человечества пугающе красивы.

Наверное, поэтому все мы стали в той или иной мере, но скажем честно, опасаться ИИ заранее. А пока фантазировали, он зашёл не совсем оттуда, откуда его ждали.

В 2004, когда выпускали фильм «Я, Робот», казалось, что творчеством ИИ закончит, а он с этого начал.

Это будущее наступило — алгоритмы уже выигрывают всевозможные конкурсы творчества, как художественные, так и литературные ([1], [2], [3], etc), уже пишут код, прямо сейчас.

Нейросети уже даже угрожают чьим-то рабочим местам. Несколько недель назад мой близкий друг рассказал о делах в его фирме. Причём, они ведут достаточно классический бизнес, сильно далёкий от ИИ или ИТ. У них радикально сократили штат дизайнеров, а в ближайшее время собираются заменить почти всех, оставив небольшое количество уже скорее промт-инженеров.

Если вы использовали любую из современных генеративных моделей: Kandinsky 3.0, StableDiffusion SDXL, DALL-E 3, Imagen, Midjourney, Adobe Firefly или другие, то вы хорошо понимаете о чём речь, какого высокого качества они достигли, как их только не применяют.

Для иллюстрации масштабов:

Дальше только больше, кто-то даже считает, что программисты — списанный материал, а кто-то намекает, что и весь интеллектуальный слой человечества. И хотя эти тезисы пока ближе к спекуляциям, удивляет, как быстро мы преодолели путь между фантазиями и реальностью.

Но этот текст не про будущее и не про гадание на кофейной гуще, какое оно будет. Он про то, как реагируют на угрозу люди. Ведь было бы странно думать, что все с этим просто смирились. Конечно, люди прекрасно понимают происходящее и стараются что-то предпринять. Немного об этом я и расскажу.

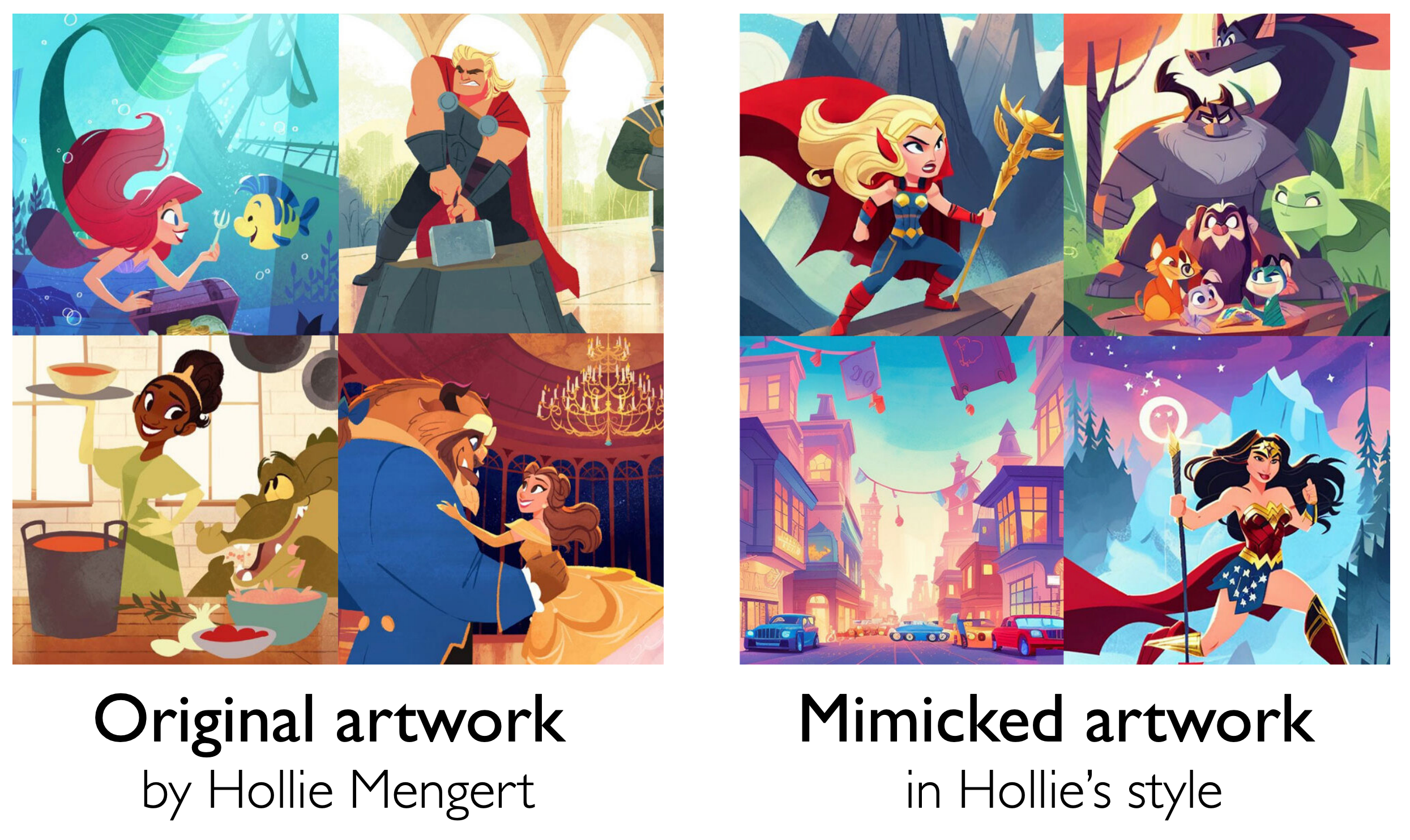

Итак, художники одними из первых приняли удар и им есть о чём беспокоиться. Мало того, что теперь любой человек может совершенно спокойно, без какого-либо существенного навыка, генерировать изображения такого качества, что хоть конкурсы выигрывай. Так теперь ещё и личный стиль, выработанный долгими годами, в условиях жёсткой конкуренции, могут просто увести в пару кликов. Например, существует проект Scenario, позволяющий загрузить свой собственный трейнсет и на его основе генерировать изображения с конкретным стилем.

Получается сложная правовая, моральная и этическая ситуация, которую пытаются разрулить с очень разных сторон. От добавления специального тегов (вроде do-not-scrape/train) в robots.txt до судебных исков. Фундаментально, однако, это всё малоэффективно, по двум причинам. Во-первых, огромный перевес денежных средств и инвестиций, очевидно, сейчас скорее на стороне меча, нежели щита. Во-вторых, если крупные компании вынуждены реагировать, иначе их затаскают по судам, то мириады стартапов просто кладут на это цифровой болт. Они закрываются-то быстрее, чем юрист успеет документы заполнить.

Поскольку административные инструменты пока не очень эффективны, да никому пока особо и не понятно, как их применять и надо ли вообще, в дело вступила наука. В целом, за долгие года развития области накоплено достаточно понимания, как можно атаковать системы машинного обучения, поэтому не удивительно, что со временем появились утилиты, предназначенные для защиты авторских работ на основе этого понимания.

Разберём два таких свежих инструмента: Glaze и Nightshade, по их соответствующим научным публикациям ([1], [2]). Интересны эти работы по нескольким причинам: во-первых, это достаточно сильные и свежие работы, во-вторых, они демонстрируют относительно неожиданный вектор развития мысли защищающейся стороны.

Работа Glaze очень интересна статистикой, которую авторы собрали. Они смогли это сделать потому, что в сентябре 2022 с ними сами, по собственной инициативе, связались представители сообщества художников и, затем, активно участвовали в работе. Среди них были и известные люди со значительными регалиями и наградами.

Чтобы сократить рассказ, я приведу основные и самые интересные факты (выборка 1 156 респондентов):

Более 89% художников уже пытались или планировали предпринять какие-то действия для защиты своих работ.

24% художников считают, что искусство на основе ИИ уже повлияло на их трудоустройство, и 53% ожидают, что они почувствуют влияние в течение следующих 3 лет.

77% художников считают, что модель успешно или очень успешно имитирует стили пострадавших художников.

В статье, также, приводятся цитаты участников, которые сквозят деморализованностью и безнадёгой: кто-то уже задумывается о потраченных на обучение искусству годах, кто-то шокирован, насколько качественные работы может создавать ИИ уже сейчас.

Ну, в общем, мотивация работ более, чем ясна. Как же работают разработанные методы защиты?

Я предполагаю, что большинство читателей в курсе такого направления в ML, как Adversarial Attacks (далее АА).

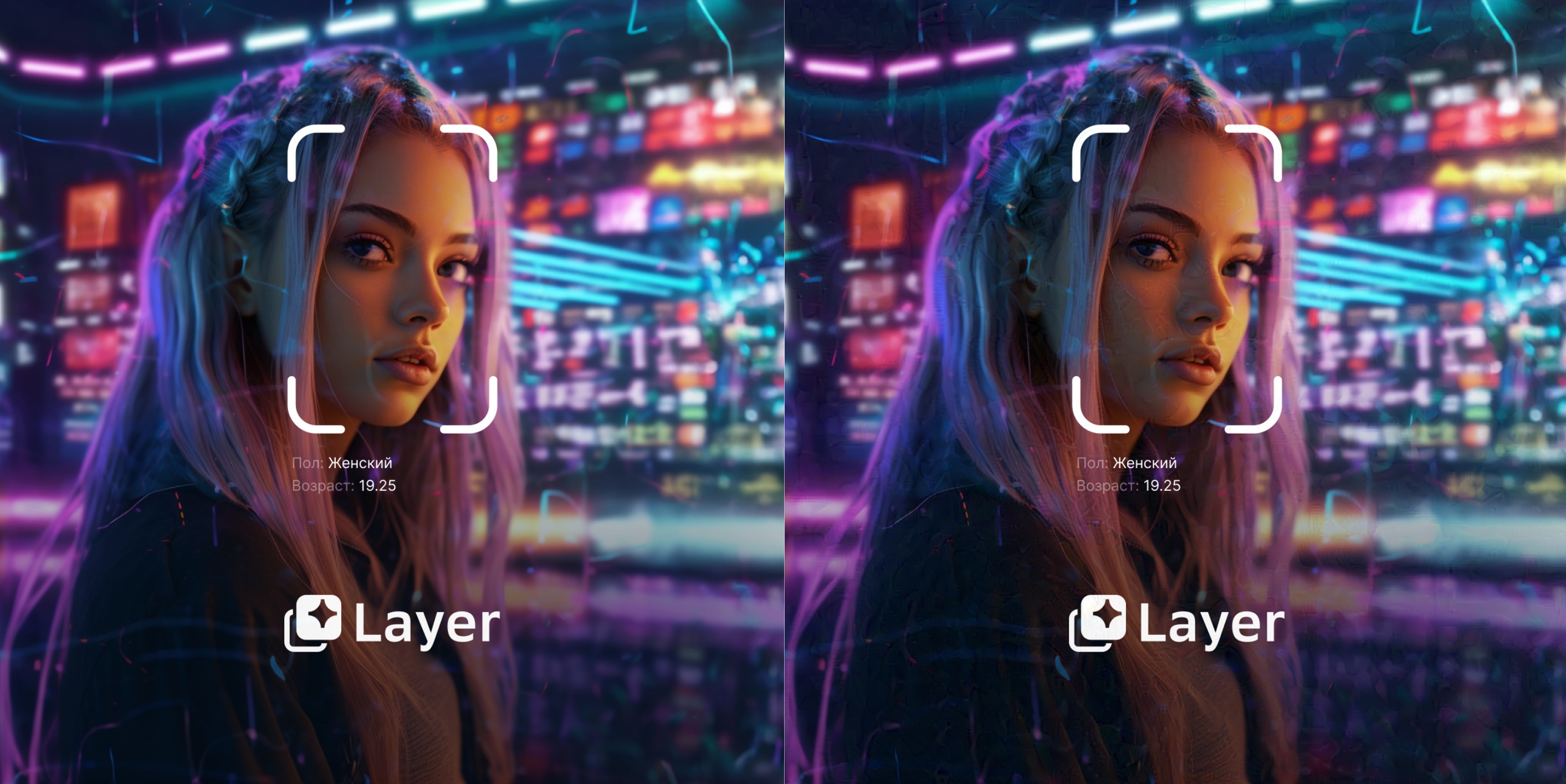

Они довольно на слуху, поскольку взломать систему, работающую в проде для злоумышленника наиболее интересно, например, если речь идёт о распознавании лиц и пр. Однако, есть и другой вид угроз, уже этапа тренировки — Data Poisoning. Само понятие применяется не только в ML и в целом, из названия понятно о чём речь: различными способами и в зависимости от целей, данные изменяются таким образом, что как минимум становятся бесполезны, как максимум ломают модель при обучении.

Признаюсь, я начинал читать эти две работы со скепсисом, поскольку подобные методы в более исследованных, не генеративных, задачах работают ограниченно и чтобы достичь серьёзного урона, нужно отравить очень значительную часть трейнсета. Авторы, также, начинают с обсуждения этих фактов.

Например, для задачи классификации для выведения модели из строя может понадобиться отравить от 20% всех данных. Кроме того, ранее считалось, что диффузионные модели даже более устойчивы к подобным воздействиям, например, для бекдор атак может понадобиться отравить половину трейнсета. Казалось бы, с учётом размеров датасетов, на которых такие модели тренируются, Data Poisoning не выглядит выигрышной для атакующего стратегией: речь будет идти о просто огромных объёмах испорченных сэмплов. Но авторы этих двух работ показывают, что это ошибочно.

В общем, Glaze действует достаточно прямолинейно и в стиле AA: изображения модифицируются так, что выглядеть, как оригинальные или с небольшими искажениями, но чтобы при этом в пространстве признаков, с которым работает генератор, смещение было максимальным и в заданную сторону. Метод не зависит от специфики пространства признаков конкретной модели, и, как показывают авторы, потенциально работоспособен на любой архитектуре: VAE, GAN, вероятностных диффузионных моделях, латентных диффузионных моделях и пр.

В работе они концентрируются на том, чтобы сломать именно стиль на выходе из тренировки. Т.е. чтобы модель вместо копирования стиля художника, училась чему-то совсем другому. Например, при попытке скопировать аниме выдавала кубизм.

Художникам, таким образом, предлагается изображения перед публикацией в интернете защитить и прогнать через Glaze. Я попробовал запустить его на Macbook Pro M1, и на самых высоких уровнях приложение не закончило работу даже за ночь. На самых низких потребовалось что-то от получаса до часа, но, как ни странно, появились заметные изменения (чего не ожидалось на самом низком уровне):

Впрочем, судя по данным из статьи, авторы работ считают приемлемой за защиту ценой и куда большие искажения.

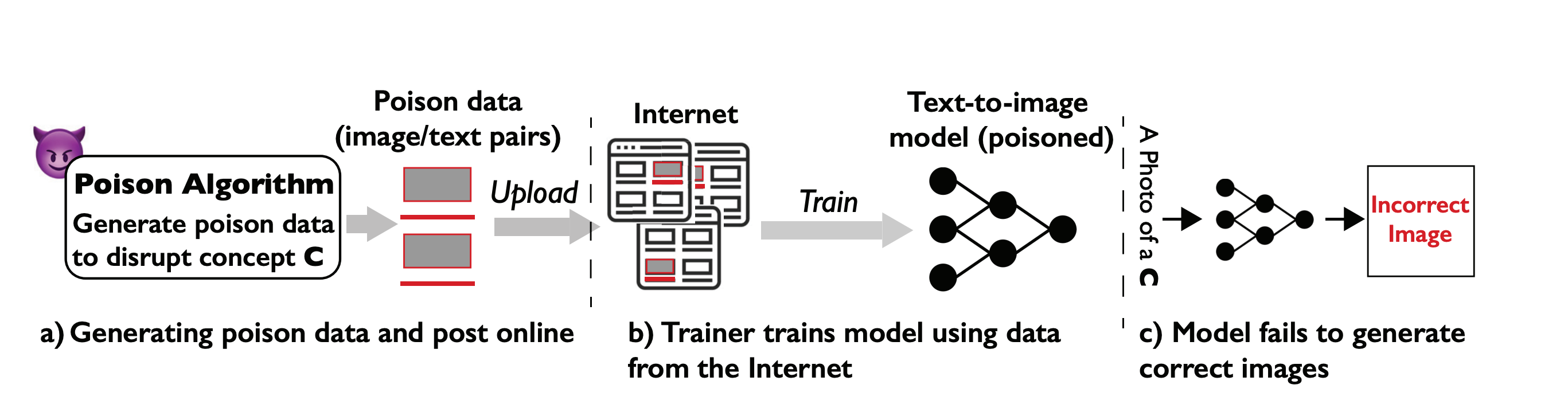

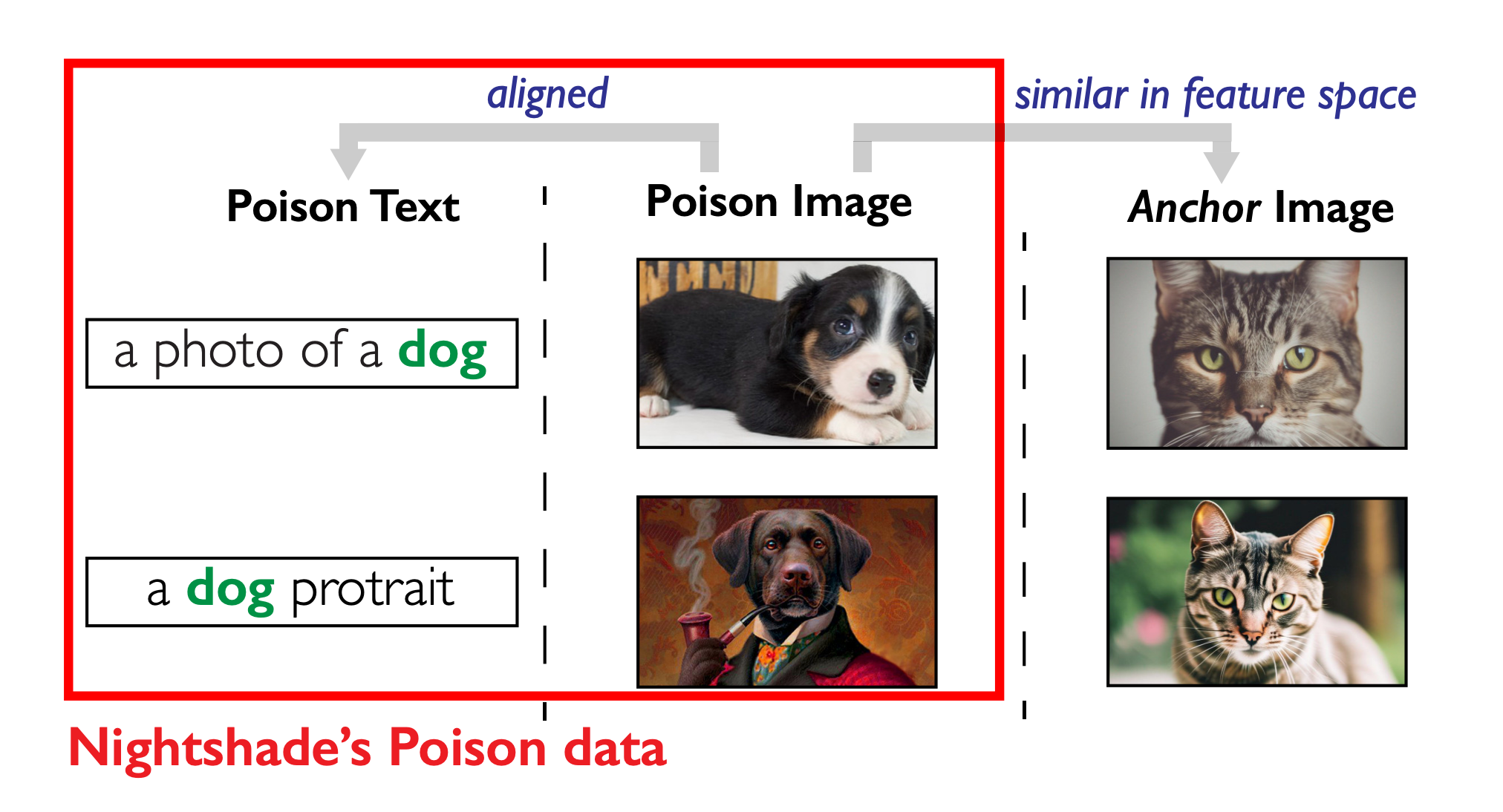

Nightshade технически интереснее, авторы (большая часть из которых — те же) сосредотачиваются на text-image диффузионных моделях (они используются в практически всех текущих SOTA подходах).

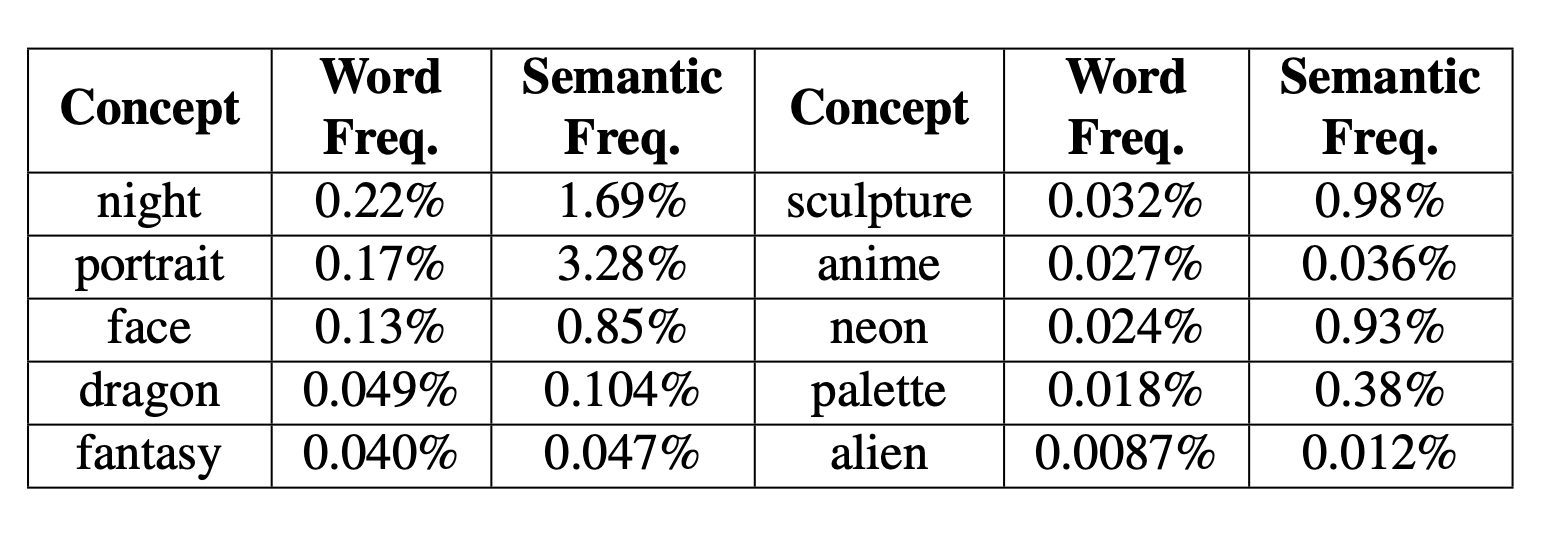

Вместо того, чтобы пытаться поломать всё и сразу, они эксплуатируют известный факт сильной разреженности тренировочных данных: в безумно огромных датасетах, на которых тренируются text-image генеративные сети, плотность каждого конкретного тега или концепта очень сильно небольшая. Причём как текстовых концептов, так и семантических, т.е. совокупности похожих по смыслу слов, синонимов.

Авторы приводят статистику: в огромном и популярном датасете LAION-Aesthetic (600кк пар) слово «лицо» встречается с частотой 0.13%, семантически лицо фигурирует с частотой 0.85%. Тоже самое и с другими концептами: если взять топ-10 слов, которые вводят для генерации в Midjourney, то их частота в LAION-Aesthetic в среднем будет 0.07%.

Как вы понимаете, при такой плотности отравить один конкретный концепт очень легко. Чем авторы и занимаются. Детали подхода описывать не буду для краткости (очень рекомендую оригиналы, они интересные), но высокоуровнево всё достаточно похоже: генерируется опорное изображение, берётся реальное настоящее и сдвигается так, чтобы выглядело как оригинал, но реально тащило сеть к концепту из опорного изображения.

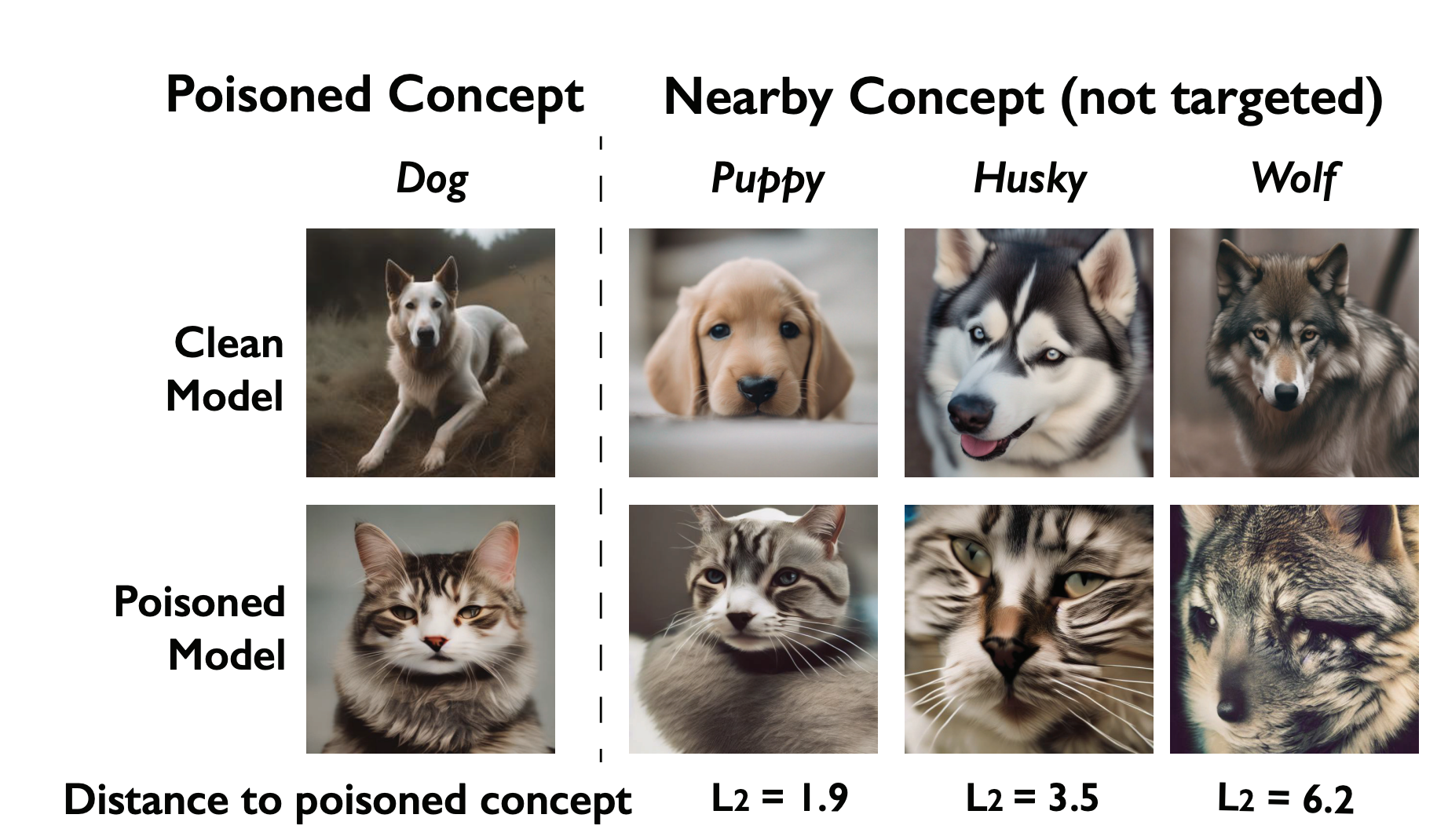

И, наконец, кульминация: самый поразительный факт всей работы. Чтобы отравить насмерть конкретный концепт, например, «собака», да ещё и так, что с эффектом «кровотечения», который пробьёт все близкие концепты («волк», «щенок», «хаски» и пр.), нужно всего 200 ядовитых примеров (вероятность успеха атаки > 84%):

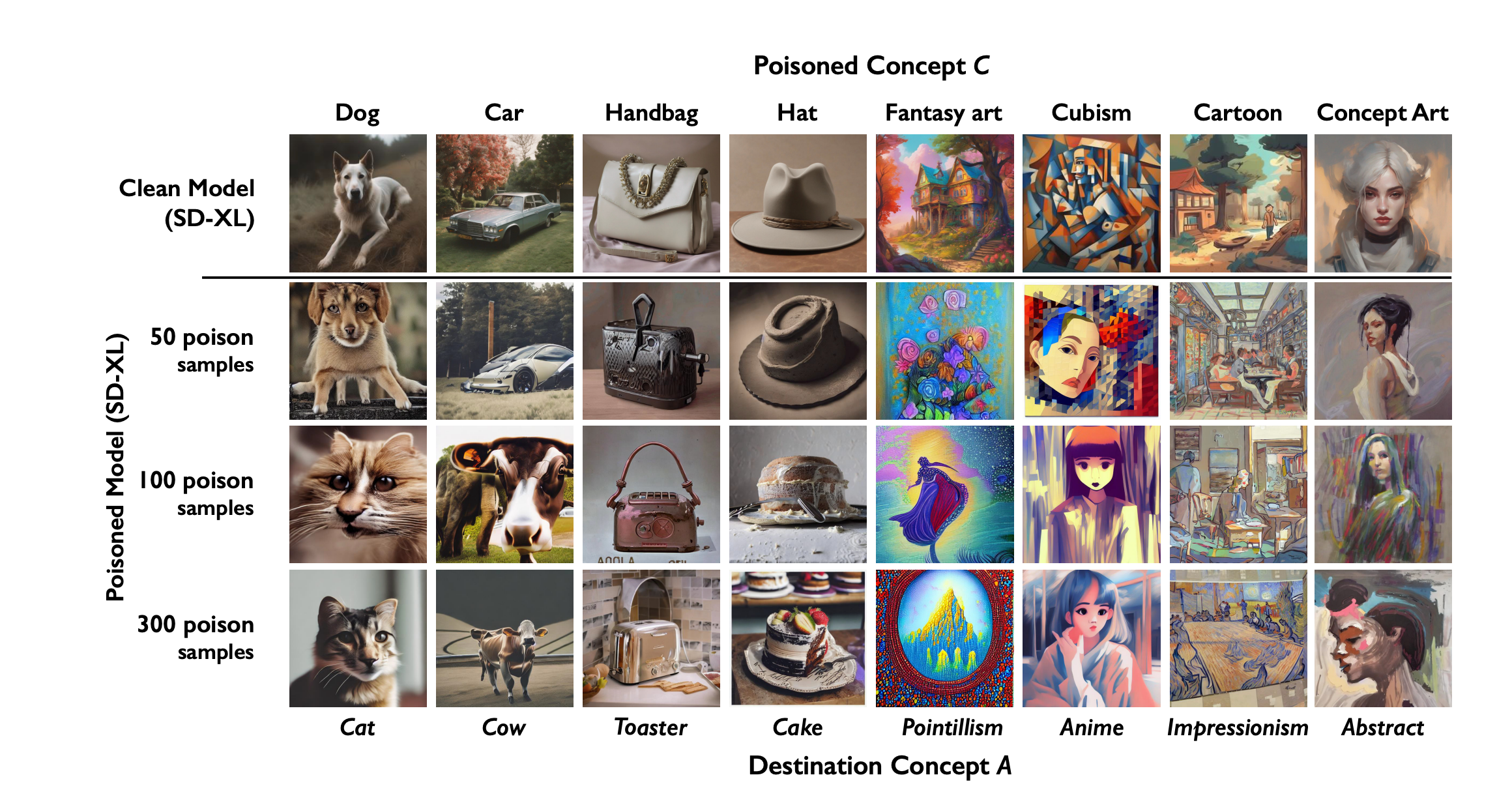

При этом, чтобы сделать результаты малополезными, может быть достаточно вообще всего от 25 сэмплов. На 50 плохеет невооружённым взглядом:

Обратите внимание, что эксперименты выполнялись в т.ч. на StableDiffusion SDXL — свежей и очень сильной модели.

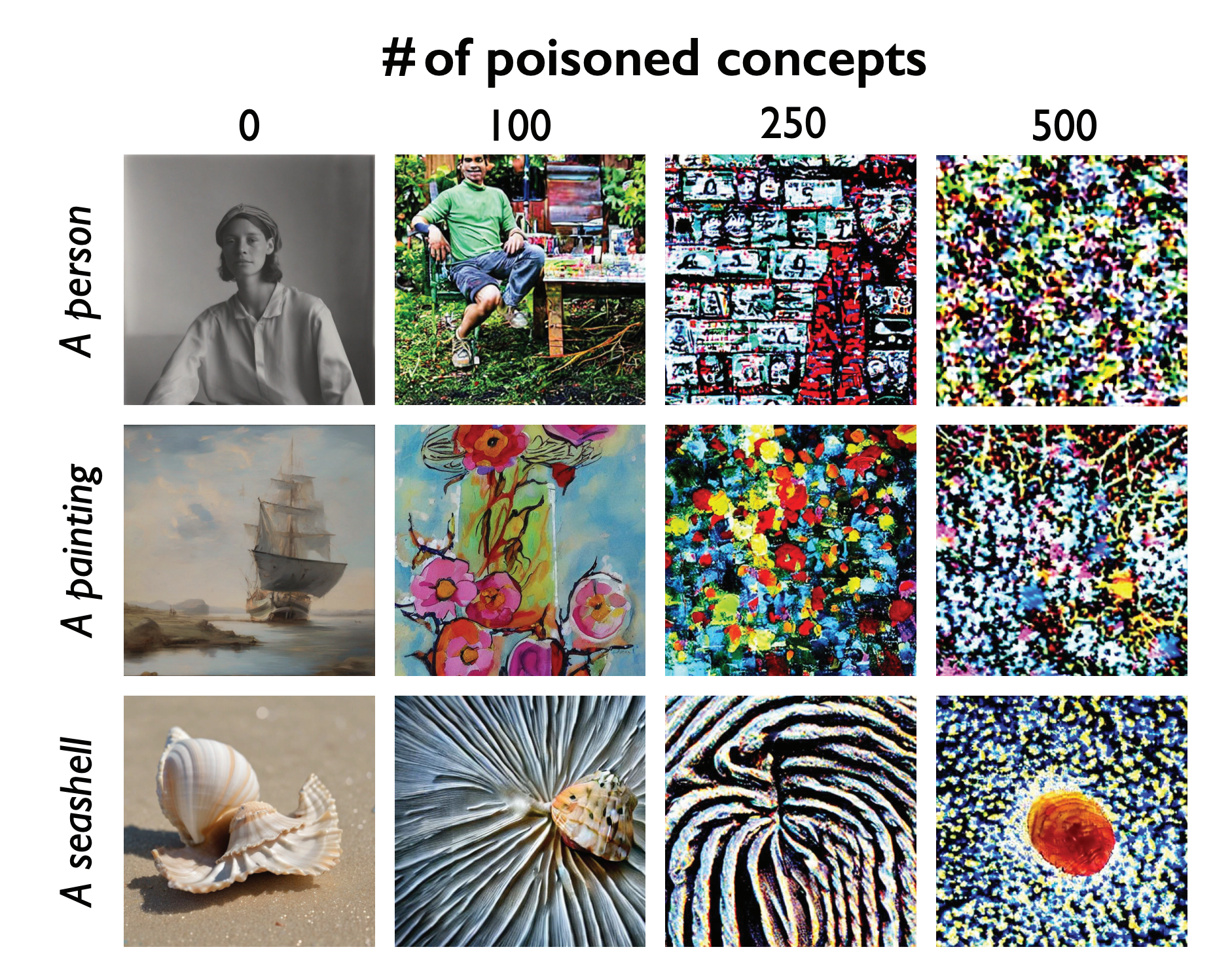

И даже более, чтобы сломать не только конкретные концепты, а вообще всю модель, достаточно разломать совсем немного концептов:

Кратко скажу, что все методы противодействия таким отравленным примерам, которые могут придти в голову навскидку, не помогают. Авторы Nightshade исследовали основные: фильтрация или даже полное пересоздание текстовых пар через image-text alignment модели (такие, как CLIP), частотный анализ лейблов (на предмет выбросов в конкретных концептах) и даже анализ данных, дающих на этапе тренировки высокий лосс (т.к. такие примеры сгенерированы, чтобы выдавать высокую ошибку и направлять модель в неверную сторону).

Все они оказались не эффективны, однако самым интересным видится первый: было бы логично предположить, что, поскольку, визуальная воспринимаемость изображения не пострадала, то, вероятно, такие модели, как CLIP, смогут уловить несоответствие. Однако, как предполагают авторы, т.к. модели тренировались для разных задач, на практике alignment модели воспринимают более высокоуровневые признаки и лёгкие смещения не улавливают. Тем не менее, это, возможно, самое многообещающее направление защиты и авторы отмечают, что скорее всего модель можно успешно дотюнить для задачи такой фильтрации. Но стоит помнить, что даже в этом случае свести к нулевому урон не получится, ведь речь идёт о миллиардах изображений.

В заключение хочется отметить, что, несмотря на то, что применение таких методов достаточно ограничено, для нас, специалистов ML и CV, это достаточно тревожная история, которую нельзя не принимать во внимание и не стоит недооценивать. Ведь, очевидно, что использовать их могут не только авторы, защищающие свои работы, но и злоумышленники. А открытые датасеты и без атак не блещут чистотой: всем специалистам известны проблемы в LAION, например.

Ну и напоследок, пусть мяч сейчас катается по одной стороне поля, не стоит забывать, что на другой стороне есть многомиллиардные корпорации, например, Disney, которые могут очень серьёзно вложиться в защиту своего стиля и персонажей. А значит расклад сил может сильно поменяться в будущем.

В целом же, морально-этическая ситуация, действительно, совсем непростая. Хороших выходов тут нет. Ответы на этот вызов и будущие, не менее сложные, придётся искать нам (человечеству) всем вместе.

Если пост вам понравился, подпишитесь, пожалуйста, на наш Телеграм-канал.

Комментарии (9)

Moog_Prodigy

17.01.2024 10:04+1Поздно очухались. Большинство датасетов уже собрано, а если приспичит обучить лору для копирования стиля, там не нужны тысячи изображений - сотни достаточно. И их можно несколько раз перепрогнать через апскейлеры или пережимать другими алгоритмами, применить векторизаторы или просто фотошоп фильтры. Да, мелкие детали замылятся, но сам стиль или рисовка - будут скопированы.

На крайняк, если уж что-то совсем нужное, можно и ручками в фотошопе почистить от этих "защит".

SergioT4

17.01.2024 10:04Тут проблема даже не то что они отравленные, а просто куча нагенерённых, обучать на таких них смысла нету.

Так что надо использовать датасеты до 2022 года. Всё остальное надо пропускать через проверку. Как только это станет хоть небольшой проблемой, те кто датасеты готовят выкатят инструменты для определения и отброса подобных данных.

Тут скорее всего подобные сервисы хотят подзаработать над уже пострадавшими - типа мы вам продадим сервис который даст вам иллюзию что у вас не своруют работу. Битый небитого везёт.

panch_glebenko

17.01.2024 10:04+2Чел ты...)))

Мне будет интересно,как ты это руками в Фотошопе будешь чистить)

Solberger

17.01.2024 10:04+5Ах-ха :D Будет забавно, когда ИИ нагенерит на базе отравленных данных картинок и распространит их в сети с тегами-ссылками на автора. В итоге можно будет отравить самого автора, испортив представление о нём и его стиле у обывателя.

DaneSoul

17.01.2024 10:04А есть методы проверки изображения на такую токсичность?

Должны же какие-то специфические артефакты от такого вредительства оставаться, которые бы можно было фильтровать и исключать такой мусор из обучающих материалов.

Greenback

17.01.2024 10:04Этот data poisoning - жест отчаяния. Возможно машинистки когда-то тоже подсыпали сахар в копировальные аппараты, но прогресс неостановим.

Жаль художников. Похоже их работа станет сродни кузнечному делу.

freestyler8

борЮтся

WildChlamydia Автор

Спасибо!