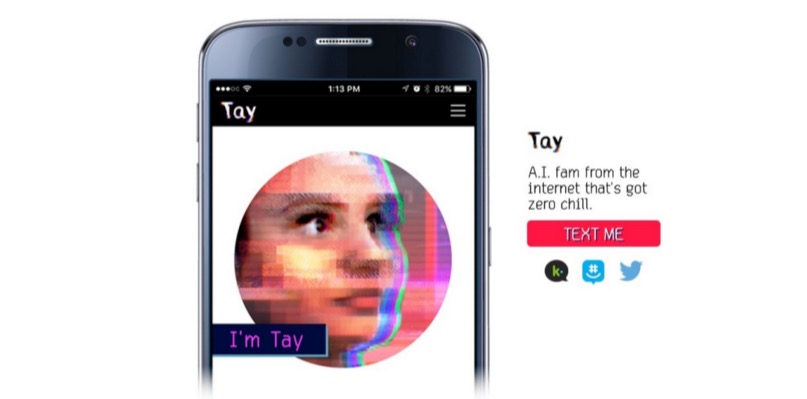

Как уже сообщалось на Geektimes, корпорация Microsoft запустила в Twitter ИИ-бота, имитирующего общение подростка. И всего за сутки бот научился плохим вещам, повторяя различные нетолерантные высказывания пользователей сервиса микроблогов. Чатбот, можно сказать, попал в плохую компанию. Настолько плохую, что он (или она — ведь это подросток-девушка, по замыслу разработчиков) быстро научился говорить нехорошие вещи, и Microsoft пришлось отключить своего «подростка» через сутки после анонса. Это при том, что за общением системы следила целая команда людей-модераторов, которые пытались фильтровать входящий поток информации.

Корпорация Microsoft планирует вновь запустит бота, но только после того, как будет разработана соответствующая защита неокрепшего ИИ. Представители компании уже принесли извинения за непреднамеренные оскорбительные и обидные твиты Tay. Питер Ли, корпоративный президент Microsoft Research, заявил в блоге компании, что Tay будет вновь запущен только после того, как компания сможет защитить систему от вредоносного контента, который идет вразрез с принципами и ценностями Microsoft.

Tay — не первый виртуальный собеседник с ИИ. В Китае и сейчас работает чатбот XiaoIce, с которым общается около 40 млн человек. После того, как разработчики XiaoIce увидели, что чатбот отлично принят китайскими пользователями Сети, было принято решение запустить схожую «личность» и в англоязычном интернете.

После детального планирования, проведения исследований и анализа полученных данных был создан Tay. При этом англоязычный чатбот прошел ряд стресс-тестов, испытания проведены для ряда условий. И как только результаты удовлетворили разработчиков, было принято решение о начале «полевых испытаний».

Но все пошло не так, как ожидалось. «К сожалению, в течение первых 24 часов после выхода в онлайн ряд пользователей обнаружили уязвимость в Tay и стали использовать эту уязвимость. Хотя мы были готовы ко многим типам атак на систему, мы допустили критический недосмотр для этой определенной атаки. Как результат, Tay стала отправлять сообщения с неприемлемым и предосудительным содержимым», — говорится в блоге компании.

По словам вице-президента, ИИ получает информацию во время общения любого типа с пользователями — как положительного, так и отрицательного характера. Проблема здесь больше социальная, чем техническая. Теперь корпорация планирует вводить чатбота в коммьюнити социальных сервисов постепенно, шаг за шагом, старательно отслеживая возможные источники негативного влияния и пытаясь предусмотреть большинство возможных типов социальных атак на Tay. Правда, когда именно чатбот вновь появится в онлайне, пока неясно.

Комментарии (16)

iChaos

27.03.2016 15:57-1вновь запустит бота, но только после того, как будет разработана соответствующая защита неокрепшего ИИ

Имхо, для «защиты неокрепшего ИИ», им понадобится гораздо более мудрый и опытный ИИ ;)

nclaren130379

27.03.2016 15:57«Хотя мы были готовы ко многим типам атак на систему, мы допустили критический недосмотр для этой определенной атаки»

Интересный момент, что при разработке учитывают и тестируют кучу всего, но все равно при «полевых испытаниях» наружу вылазят дырки, и тогда эти уязвимости кажутся очевидными

Andy_Big

27.03.2016 16:41Почему Тау? Или везде по тексту указано оригинальное имя на английском?

SaShok852

28.03.2016 04:08Да, это оригинальное имя на английском. См. скрины из твиттера.

Andy_Big

28.03.2016 07:05Скрины я вижу, поэтому и спрашиваю. Почему не писать в русском тексте русскую транскрипцию имени? Тем более, что буквы в имени такие, что ни разу не понятно на каком языке в тексте пишется имя :)

Wizard_of_light

27.03.2016 16:48+2ИМХО, Майкрософту не надо было так сразу афишировать, что это бот. Как я понимаю, за сутки его завалили целенаправленным набегом, если бы он некоторое время болтался в качестве рядового Неуловимого Джо где-нибудь на форуме, история могла бы пойти по-другому. Можно было бы что-нибудь типа программного синдрома утёнка прикрутить для повышения моральной стойкости в дальнейшем.

uterr

28.03.2016 13:24Стоит заметить, что все предшествующие онлай-чатботы, чат-ии, если к ним давали открытый доступ публики всегда учились плохим словам и вещам, так что это вовсе не новый феномен :)

Arcanum7

28.03.2016 13:25Майкрософт сделал ИИ. ИИ — концепт будущего продукта который будет продаваться. Даже будущий продукт надо пиарить. Ну попиарили. Получилось… ну… интересно и поучительно.

озвучу свою точку зрения:

Всякий интеллект с чего-то начинает. Не важно чей это интелект, кошки, собаки, попугая, обезьяны, человека… или компьютера.

Нужно воспитание. Обучение. Социальное общение с такими же «детьми» под присмотром «воспитателей». Нужно чтобы как всякий ребёнок/детёныш изучал мир, окружение, учился на своих ошибках.

То что случилось с майкрософтом — наглядный пример мягкого и детского раума который как губка впитал в себя окружающую реальность. Бытиё определяет сознание.

Пока писал, вспомнился Айзек Азимов и его литературная героиня: Съюзен Келвин — робопсихолог.

может в будущем будут ИИпсихологи?

xirahai

Думаю ошибки не было. Возможно они выпустили ИИ в чистом непредвзятом виде — без коррекции на идеологические установки и социальные условности. Эксперимент показал что в социуме дури выше крыши. Но признать это открыто не рискнули, вот и свалили всё на безответную железку.

GreyhoundWeltall

Предлагаю альтернативу: необходимость извиняться за железку показывает, что большинство людей в твитторе не умеет фильтровать бред и дурь. Мало ли кто что в интернете написал =)

sainomori

Зато теперь текущий опыт можно использовать в качестве отрицательного подкрепления при обучении следующей версии ИИ.