Пока маркетологи обмазываются BigData и бегают в таком виде на пресс-конференциях, я предлагаю просто скачать бесплатный инструмент с тестовыми наборами данных, шаблонами процессов и начать работать.

Закачка, установка и получение первых результатов — минут 20 максимум.

Я говорю про RapidMiner — опенсорсную среду, которая при всей своей бесплатности некисло «уделывает» коммерческих конкурентов. Правда, сразу скажу, что разработчики всё равно её продают, а в опенсорс отдают только предпоследние версии. Дома можно попробовать потому, что есть вообще бесплатные сборки со всей-всей логикой с всего лишь двумя ограничениями — максимальный объем используемой памяти 1 Гб и работа только с обычными файлами (csv, xls и т.п.) в качестве источника данных. Естественно, в малом бизнесе это тоже не проблема.

Что надо знать про RapidMiner

Вот интерфейс. Вы закидываете данные, а потом просто перетаскиваете операторы в GUI, формируя процесс обработки данных. От вас — только понимание того, что вы делаете. Весь код берёт на себя среда. «Под капот» можно, конечно, залезть, но в большинстве случаев это просто не надо.

Важные фичи

- Хороший GUI. По сути, каждый функциональный блок собран в кубик. Ничего нового в подходе, но очень крутое исполнение. Обычно разница между классическим программированием и визуальным сильно бьёт по функциональности. Например, в SPSS Modeler всего 50 узлов, а тут целых 250 в базовой загрузке.

- Есть хорошие инструменты подготовки данных. Обычно предполагается, что данные готовятся где-то ещё, но тут уже есть готовый ETL. В том же коммерческом SPSS возможностей для подготовки куда меньше.

- Расширяемость. Есть старый добрый язык R. Полностью интегрированы операторы система WEKA. В общем, это не «детский сад» и не закрытый фреймворк. Надо будет спуститься на низкий уровень — без проблем.

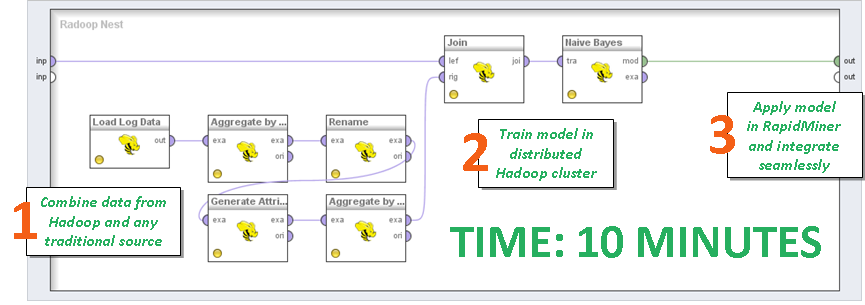

- Дружит с Hadoop (отдельное платное расширение с незамысловатым названием Radoop), причём как с чистым, так и с коммерческими реализациями. То есть когда вы решите молотить не табличку XLS с демо-набором данных, а боевую БД, да еще и при помощи модного ныне Apache Spark — всё сразу встанет как надо. Самое приятное — писать код не надо. Можно в майнере аналитиком написать скрипт через всё тот же GUI и отдать в обработку.

- Архитектурно данные снаружи. Ставим платформу, грузим данные и начинаем смотреть, где какие кореляции, что можем спрогнозировать. Это и плюс, и минус, почему — ниже.

- Кроме IDE есть ещё сервер. Rapid Miner Studio создаёт процессы, а на сервере их можно публиковать. Что-то типа планировщика — сервер знает, какой процесс когда запускать, с какой частой, что делать, если где-то что-то отвалилось, кто отвечает за каждый из процессов, кому как отдавать ресурсы, куда выгружать результаты. В общем, все-все-все современные плюшки.

- А ещё сервер же умеет сразу строить минимальные отчёты. Можно выгружать не в XLS, а рисовать графику прямо там. Это нравится маркетингу маленьких компаний и удобно для небольших проектов. И, естественно, это очень недорого (даже в коммерческой версии) в сравнении с Моделлером и SAS. Но — сразу говорю — области применения у них разные.

- Быстрое развитие. Только поднялся серьезный шум вокруг Apache Spark — через пару месяцев вышел релиз о поддержке базового функционала.

Минусы

- Деньги. С 2011 года в опенсорс уходит предпоследняя версия продукта. С выходом новой предыдущая становится опенсорсной. Cтартер не позволяет строить процессы, обработка которых съест больше гигибайта оперативной памяти. Триал две недели.

- Компания по Гартнеру не самая большая. Это плохо для внедрения и поддержки, потому что своими силами они это делать не могут. С другой стороны, всё это для больших бизнесов по политике компании отдаётся на интеграторов (то есть, как раз нам).

- Авторитет компании пока не накоплен — внедрений не так много, молодая. За SAS ещё никого не увольняли, даже если бюджет в три раза выше, а здесь имя не на слуху.

- Плохо с консалтингом, нет формализованных процессов техподдержки. Предполагается, что это всё делают, опять же, интеграторы. Мы и делаем, но с точки зрения большого бизнеса нельзя не упомянуть про эту особенность.

- Не все вещи анализируются на сервере, в некоторых случаях платформа пробует агрегировать данные на локальной машине. Это плохо, когда модель требует всей базы, то есть когда нельзя взять и прогнать алгоритм на небольшом куске данных. Предполагается, что вы используете Hadoop или аналог для решения этой проблемы. Там всё есть.

- Аналитика классических баз данных (то, что не Big Data по критерию многообразия) на шаг позади классических решений. То есть если вы захотите сделать предагрегацию перед выгрузкой in-database, то это нужно задать ручками явно, сам RapidMiner до этого не догадается.

RapidMiner vs IBM SPSS Modeler

У RM гораздо шире функциональные возможности по обработке, банально больше узлов. С другой стороны, в SPSS есть режимы «автопилота». Авто-модели (Auto Numeric, Auto Classifier) — перебирают несколько возможных моделей с разными параметрами, выбирают несколько лучших. Не сильно опытный аналитик может построить на таком адекватную модель. Она почти наверняка будет уступать в точности построенным опытным специалистом, но есть сам факт — можно построить модель ничего не понимая в этом. В RM есть аналог (Loop and Deliver Best), но он все же требует хотя бы выбрать модели и критерии выбора лучшего. Автоматическая предобработка данных (Auto Data Prep) — другая известная фишка SPSS — иначе и чуть более муторно реализована в RapidMiner.

В SPSS сборка данных выполняется одним узлом Automated Data Preparation, галочками проставляется, что нужно сделать с данными. В RapidMiner — собирается из атомарных узлов в произвольной последовательности.

RapidMiner vs SAS

По возможностям «сделать что угодно» RM выше, но, в конечном итоге, с помощью какой-то матери и некоторых усложнений можно получить тот же результат и в SAS. Но здесь совершенно другой подход — придётся переучиваться, если вы привыкли к SAS. Ещё SAS предоставляет множество вертикальных решений — банки, ритейл. Платформа разговаривает с пользователем на его бизнес-языке. RM более абстрактен, в нём придётся самому формулировать, что есть что.

RapidMiner vs Demantra

Не совсем правильно сравнивать эти два пакета, но важно для иллюстрации того, как работает RM. Oracle Demantra (и, очень грубо, все схожие продукты под конкретную индустрию или задачу)- это готовый пакет, заточенный под конкретные задачи закупок и поставок. Там есть конкретные операции — загрузили данные о продажах, получили прогноз по закупкам товара. Одна модель, очень много готовых шаблонов. Дорого, круто и под большой бизнес.

С другой стороны, в RM можно повторить всё то же самое, но половину логики придётся изобретать заново. Это очень удобно для data scientist’ов в плане кастомизации и гибкости конечного решения, но крайне сложно для бизнес-пользователей — они просто не увидят знакомых слов и инструментов

Архитектура

Задачи

Итак, перед нами чистое поле для решения любых задач. Наиболее частые в России, решающиеся такими инструментами — это:

- Анализ транзакций (например, банковских) для противодействия мошенничеству.

- Клиентская аналитика. Это самая горячая тема. Проще всего и выгоднее всего бывает выстроить модель оттока клиентов и отмечать флагом тех, кто к этому готов. Для рынка телекомов, например, переход абонента куда-то ещё — это трагедия, потому что людей больше не становится. Поэтому за флажок «клиент может убежать» они готовы платить реальные деньги.

- Персональные рекомендации. Это любит розница — что кому предложить. Как раз тот случай, когда вы только-только не купили презервативы, а про вас уже запомнили, что через несколько месяцев нужно давать скидки на детское питание.

- Прогнозирование поставок и продаж. При том, что есть готовые пакеты для этого, RapidMiner тупо дешевле. Не надо покупать Боинг, если у вас средний бизнес. И не надо покупать тот же JDA (он стоит как два Боинга). Нет, там всё очень круто и по возможностям, и по интеграции — но банально мало кто может позволить себе это купить.

- Текстовая аналитика — о чём люди пишут. Например, анализ эмоционального оттенка отзывов или комментариев в автоматическом режиме. Это «50 жаловались на связь в Волгограде по улице Победы», «20 похвалили сервис», «Основная причина недовольства абонентов — частые разрывы соединения» и так далее.

- Часто бывает нужна готовая интеграция на уровне базы и веб-сервисов. По сути, тут ничего не надо писать, задаётся только частота опроса, какие модель и процесс использовать, и кто потребитель. Для асинхронных или месячных отчётов ещё проще, есть даже подтягивания данных из Дропбокса для совсем малого бизнеса и готовая интеграция с Амазоновскими сервисами.

- Коммерческий RapidMiner очень хорошо работает с большими данными. Exadata и Vertica — классические базы данных 2.0 или массивно-параллельные СУБД — поддерживаются «во все тяжкие».

А это моя (и не только моя) любимая тема — метамоделирование. Для тех, кто немного в стороне от этого — разные модели часто находят разные взаимосвязи, формируя на одной и той же выборке разные результаты. И ошибаются часто тоже в разных местах. И это нужно использовать — составить ансамбль моделей (Model Ensemble) Например, оператор Vote (голосование) — учитываются «мнения» всех моделей, входящих в ансамбль и на выход выдается результат, набравший наибольшее количество «голосов». Или один из наиболее популярных среди «продвинутых» data scientist’ов метод Bagging (Bootstrap Aggregation) — обучение нескольких моделей на разных подвыборках исходных данных с последующим усреднением их результатов.

Миграция

Что могу сказать по опыту нескольких переходов на RapidMiner: тут важно отметить, что с точки зрения Data Science впечатления положительны. Технологически немного хуже — очистка данных пошла труднее, мы уже привыкли к парадигме и простоте SPSS и SAS. Здесь нужно было больше перестраивать мозг — всё делается совсем по-другому. Очень разные архитектурные реализации, поэтому сразу говорю — мигрировать самостоятельно будет достаточно сложно в плане компетенций специалистов. Учиться надо заново. Но для нас и заказчиков результат того стоил.

Очень много приятых мелких фишек. Например, имеет смысл сказать про «макросы» — это параметры работы процесса, которые можно использовать в любой его точке. Например, в качестве макроса можно использовать имя файла, дату его создания, среднее значение какого-либо атрибута данных, наилучшую достигнутую точность, номер итерации, последнее время запуска процесса. Часто выручает при создании нетривиальных операций обработки. К примеру, с помощью макроса может быть ограничено время выполнения операции, при этом порог времени не фиксируется, а является расчетным параметром — зависит от размера данных, времени суток (ночные оптимизации могут выполняться дольше).

Из недавнего — строили модель для прогнозирования пассажиропотока. Вот тут уже мы использовали RM на 100%, т.к. строили все «с нуля» и некуда было оглядываться, не нужно было переносить существующие процессы и пытаться их повторить на другом инструменте.

Что делать, чтобы начать

Вот ссылка на закачку собранного релиза с официального сайта.

Если у вас данных мало — просто пользуйтесь, пока не надоест, компания прекрасно понимает, что их полную версию покупает только средний и большой бизнес. Если данных мало — вам будет важно знать, что цены фиксированные, не зависят от заказчика.

Если чувствуете, что штука крутая, но хочется освоить быстро — приходите к нам в учебный центр. Мы — официальный партнёр RapidMiner, и по итогам курсов выдаются сертификаты.От вас — базовые знания матстатистики (хотя бы представлять, что такое выбросы, среднее значение, нормальное распределение и дисперсия) и базовые знания компьютера. Мы дадим свои наборы данных от одного немецкого телекома, если у вас нет своего (или приносите в обезличенном виде его тоже) и вместе соберём кейс по прогнозированию оттока клиентов. А потом смоделируем модель исходя из того, сколько денег есть на их удержание. Например, есть 10 тысяч рублей и 100 000 клиентов — нужно выбрать из них тех, кого дешевле удержать, и кто больше принесет компании денег в перспективе. Попасть в наиболее вероятного клиента и максимизировать конечную выгоду (это, кстати, называется Uplift Modeling или, если вы больше привыкли к терминологии SAS — Incremental Response Modeling).

И ещё раз: версия Starter полноценная с точки зрения аналитического функционала, а, значит, proof-of-concept вашей идеи для вашей компании можно сделать абсолютно бесплатно.

Комментарии (22)

vitaly_KF

31.03.2015 20:46Благодарю за пост!

Но, я так и не понял один момент.

В Версии 6 (текущей) я не смогу выкачать данные из какого-либо сайта из-за ограничения бесплатной версии.

А в версии 5.3 (предыдущей) — эти ограничения также присутствуют или предыдущая версия становится бесплатной и полностью функциональной?

convex Автор

01.04.2015 11:32Все верно, по заверениям разработчиков с выходом следующей мажорной версии предыдущая становится открытой.

Ограничения бесплатной 6-ой версии на текущую опенсорсную (5.3) не распространяются.

Однако, вы можете заметить, что 6-ая версия по сравнению с 5-ой сильно прибавила в функциональности, т.е. далеко не все вы сможете найти в опенсорсной версии.

selenite

31.03.2015 21:14+2Перечитал, но так и не понял про опенсорс и наличие ограничения в 1гб. Взаимоисключающие пункты же.

BelBES

31.03.2015 21:32Вот судя по всему исходники этого пакета, правда я не пробовал собирать:

github.com/rapidminer/rapidminer

convex Автор

01.04.2015 11:39Внесу немного ясности:

1. Вы можете взять исходники предыдущей версии и собрать сами RapidMiner без ограничений, но старый (версия 5.3).

2. Вы можете взять бесплатно Starter (уже собранный) текущей версии (6.3) – 1 Гб и без подключения к БД.

3. Вы можете попробовать триал текущей версии 14 дней – там нет этих ограничений.

4. И вы можете купить пункт (3) уже в долгое пользование.

Кого давит 1 Гб на процесс — собирайте код (или зарегистрируйтесь на сайте, потом можно скачать бинарники). Для большинства же малого бизнеса достаточно стартера, поскольку там функционал аналитики тот же. Если расчёт у вас ещё и разовый, вроде анализов результатов за год, то можно настроить процесс в Starter и взять триал, чтобы перемолотить данные. А потом решить, стоит покупать полную версию или нет.

kypexin

31.03.2015 22:45+1Уважаемые коллеги vitaly_KF, selenite и BelBES, насколько я могу судить сам по своему опыту работы с RapidMiner разных версий, бесплатная community edition 5.3 имеет те же ограничения по памяти, что и бесплатная 6.x (1 Гб). Там всё-таки есть некая внутренняя хитрость для соблюдения баланса между open-source и business-source моделями, но я не в курсе подробностей про техническую сторону этих ограничений, может быть уважаемый автор пояснит более подробно.

И опять же, влияние этих ограничений очень сильно зависит от рода решаемых задач, от данных, от подхода. Да, когда я только познакомился с бесплатной версией RapidMiner и радостно скормил туда датасет из ~ 100.000 строк * 50 атрибутов (половина из которых были далеко не бинарными) для дальнейшего моделирования «чего-нибудь эдакого», разумеется сразу же больно налетел (и не раз) на ограничение по памяти. Очень помогло дальнейшее осмысление того, что же я делаю, предварительная аккуратная подготовка данных и разумный подход к использованию разных алгоритмов. Могу сказать, что даже с минимальным опытом работы в бесплатной версии я достаточно быстро ушёл от постоянной нехватки памяти и она потом возникала уж совсем по серьёзным поводам, когда данные действительно ну никак не умещались. Для ознакомления, обучения и прогона тренировочных моделей и так далее — в самый раз. Да, изначально тренировался на не очень больших датасетах. Да, в продакшене и на реальных больших данных конечно скорее всего нужна будет лицензионная версия. Ну так и продукт-то в конечном итоге коммерческий.

BelBES

31.03.2015 23:08Да, когда я только познакомился с бесплатной версией RapidMiner и радостно скормил туда датасет из ~ 100.000 строк * 50 атрибутов (половина из которых были далеко не бинарными) для дальнейшего моделирования «чего-нибудь эдакого», разумеется сразу же больно налетел (и не раз) на ограничение по памяти.

100к объектов с ~50 признаками это на самом деле не очень много. Например при анализе данных пользователей соц. сетей число записей обычно >1M. Там и R обычно лажать начинает, если пользоваться только стандартными средствами…

Могу сказать, что даже с минимальным опытом работы в бесплатной версии я достаточно быстро ушёл от постоянной нехватки памяти и она потом возникала уж совсем по серьёзным поводам, когда данные действительно ну никак не умещались.

Ну ок, потребность в памяти вы обошли. А когда упретесь в производительность, то какое-нибудь GPGPU уже так просто не получится прикрутить скорей всего. А в томже Python можно заюзать, например, Theano и запараллелить код на GPU практически бесплатно.

Да, в продакшене и на реальных больших данных конечно скорее всего нужна будет лицензионная версия. Ну так и продукт-то в конечном итоге коммерческий.

А смысл платить за него и привязываться к проприетарному инструменту, если за интерпретатор python или за gcc никто денег вообще не просит? В продакшене и пооптимизировать код надо и тестов понаписать и т.д. и т.п., что сделать проблематично в случае RM. Т.ч. преимущества RM совсем не очевидны, чтобы за него еще и платить…

kypexin

31.03.2015 23:28Сергей, я разумеется не имел в виду, что датасет 100.000 x 50 у меня в памяти сам по себе не поместился. Но несколько преобразований атрибутов (например, если выбранный алгоритм работает только с биноминальными атрибутами, а у меня в столбцах строки) — раз, и уже вместо 50 атрибутов их 5000. Условный пример, конечно, но думаю идея понятна — страшны не сами исходные данные, а их возможные преобразования и вынужденное повышение размерности, например.

Но в целом сравнивать RM и Python/R/gcc/etc я честно говоря смысла не вижу. Это ведь изначально совершенно разные инструменты и разные среды, хоть и могут использоваться для сходных задач машинлёрнинга и датамайнинга. Мне в RM лично очень удобна скорость и визуальная простота построения моделей, наглядность и вообще возможность сосредоточиться исключительно на концептуальном понимании модели, а не на написании кода (честно признаюсь, код писать не слишком люблю, и стесняться тут нечего). Но есть же и другие задачи, где мне например R удобнее, например проще какие-то интерактивные дашборды сделать в Shiny, или использовать в R Studio какой-то специфический package для поиска аномалий — всё зависит.

Да, а ещё, отвлекаясь от этих сравнений, хочу заметить, что сам RM позиционирует себя в первую очередь (ну, в одну из самых первых) как платформу для бизнес-аналитики — а это большой плюс для тысяч бизнес-аналитиков, которых кодить вообще не умеют, а им собственно и не надо, благодаря в том числе и визуальным инструментам как RapidMiner и другим подобным.

BelBES

31.03.2015 23:38Условный пример, конечно, но думаю идея понятна — страшны не сами исходные данные, а их возможные преобразования и вынужденное повышение размерности, например.

Тем не менее, чем больше данных на входе — тем все печальней при обработке становится)

Мне в RM лично очень удобна скорость и визуальная простота построения моделей, наглядность и вообще возможность сосредоточиться исключительно на концептуальном понимании модели, а не на написании кода (честно признаюсь, код писать не слишком люблю, и стесняться тут нечего).

Ну, видно у вас такой стиль разработки… у меня фаза построения модели обычно на листе бумаги происходит, а дальше уже в код превращается.

а это большой плюс для тысяч бизнес-аналитиков, которых кодить вообще не умеют, а им собственно и не надо

Плох тот бизнес-аналитик, который не является математиком, а для математика не должно быть проблем с написанием кода)

convex Автор

01.04.2015 12:13+1А смысл платить за него и привязываться к проприетарному инструменту, если за интерпретатор python или за gcc никто денег вообще не просит?

Вы выводите вопрос в плоскость «opensource vs proprietary». Почему вообще эти глупые люди вокруг платят за софт, а не используют опенсорс? Почему у того же SAS 70 тысяч клиентов, они что дураки все, можно же на R/Python/etc все самому написать? Почему же люди покупают Cloudera и HortonWorks, а не используют Apache Hadoop?

Скорость разработки, удобство использования пользователями, управление правами доступа из коробки, оптимизации производительности, различные бесшовные интеграции из коробки, простота поддержки, разработка силами не ученых и математиков. Можете продолжить список.

Отдельное удовольствие – управлять разработкой команды из ученых и математиков. Я знаю несколько историй с печальным концом, начинавшихся со слов «класс, сейчас мы соберем ВМКшников и ШАДовцев, дадим им данные и будет у нас счастье».

Плох тот бизнес-аналитик, который не является математиком, а для математика не должно быть проблем с написанием кода)

По пальцам одной руки могу пересчитать бизнес-аналитиков, с которыми мне приходилось работать, и которые при этом хорошо владеют «математикой» в своей индустрии. При этом, поверьте, большинство бизнес-аналитиков отлично разбираются в предметной области и знают, что им и для чего нужно.

А хороший математик-программист – в большинстве случаев никудышный бизнес-аналитик.

Поэтому эти роли все нормальные организации и руководители, как правило, разносят если не в разные отделы, то на разных людей точно.

BelBES

01.04.2015 12:42Вы выводите вопрос в плоскость «opensource vs proprietary». Почему вообще эти глупые люди вокруг платят за софт, а не используют опенсорс?

Нет, мне интересно, зачем платить конкретно за эту утилиту, т.к. лично я не нашел в ней ни одного преимущества перед полностью открытыми решениями.

Cekory

01.04.2015 00:43Интересно, а кто-нибудь пользовался Knime? По описанию очень похоже на RapidMiner, но базовая версия без таких неприятных ограничений.

convex Автор

01.04.2015 12:08Пользовался. Периодически скачиваю, смотрю как развивается. До такого же детального сравнения я, наверное, не доберусь. Предлагаю скачать и то, и другое и сделать выводы самому.

Лично мое впечатление – я не смог все, что мне было тогда нужно (года полтора назад дело было) реализовать на KNIME. Плюс приходилось костыли городить из базовых блоков и loop'ов на функционал, который, как мне кажется, должен был бы быть в продукте. Я конкретику привести не вспомню сейчас, могу поискать, может где-то стрим сохраненный остался.

Ну и RM приятнее гораздо в работе (имхо, естественно).

BelBES

Когда-то пытался поиграться с этим RapidMiner'ом… по личным ощущениям, это программа для тех, кто хочет заниматься BigData, но не умеет программировать. Т.е. поиграться можно, но пользоваться постоянно не удобно.

Старые добрые R, или Python + бибилиотеки, по моему, гораздо удобней, да и возможностей больше + кроссплафторменность.

convex Автор

Про широту возможностей — нельзя не согласиться. Но тут другой момент уже — Assembler, конечно, круче по возможностям чем C, но с последним работать многим приятнее и понятнее…

Про удобство программирования на R и Python над визуальным интерфейсом — достаточно спорный тезис.

Да, и про кроссплатформенность я забыл упомянуть — RM работает на Windows, Linux и Mac. Причем все компоненты, и Studio, и Server.

kypexin

Неумение программировать не должно закрывать путь в Big Data! :)

keyf

Да, не стоит ставить клеймо на человеке за неумение программировать! Может он кофе делает вкусный, все профит для его хозяина-программиста :)

kypexin

Если серьёзно, то (см. п. 3 «Важных фич») — есть R extension, с помощью которого можно создать кастомный элемент процесса с произвольным кодом/скриптом на R внутри, это если чего-то не хватает и есть необходимость какой-то кусок алгоритма написать руками.

BelBES

Если совсем серьезно, то

Вот эти два но лишают использование этого пакета всякого смысла. Не знаю как обстоят дела в малом бизнесе, но для моих любительских экспериментов с алгоритмами обработки данных такие ограничения не приемлемы. Для работы с, например, данными пользователей соц. сетей удобней их хранить в какой-ниубь SQL базе данных, а стоит в изысканиях появиться слову Deep, как оказывается, что памяти много не бывает никогда.

А смысл тогда вообще использовать RM? Если весь пайплайн писать на одном языке, то в случае работоспособности его будет значительно проще причесать и отправить в продакшн.

convex Автор

Чисто для понимания – у ближайших конкурентов (кроме KNIME, о чем комментарий ниже) вообще нет бесплатных версий в каком-либо виде (SAS University Edition – не в счет, он для студентов), только триалы.

А описанная вами «любительская» задача далека от медианы аналитических задач даже среднего бизнеса. Нет, SNA и deep learning это круто, конечно, но далеко от «everyday data science» большинства аналитиков и разработчиков.

BelBES

А можно какие-нибудь примеры типичных задач, которые народ в индустрии решает?