Примечание. Среднее арифметическое не совсем точно отображает реальную картину

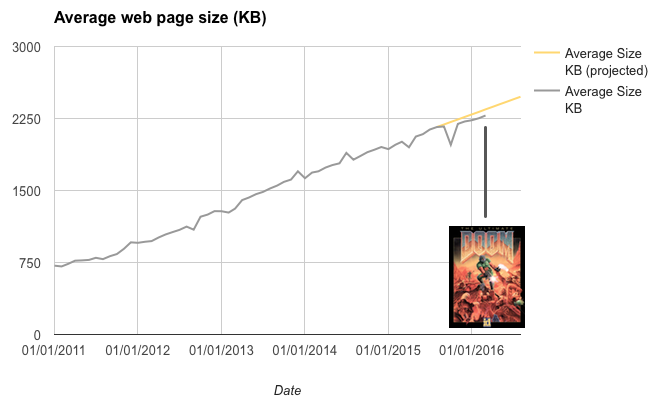

Наконец-то наступил момент, когда можно честно сказать: web is doomed, и это не будет преувеличением. По статистике HTTP Archive, в апреле 2016 года средний размер веб-страницы сравнялся с размером инсталлятора культовой игры Doom.

Помните эту игру со встроенным движком 3D-рендеринга, многочисленными уровнями, картами, спрайтами и звуковыми эффектами? Всё это равняется теперь одной средней веб-страничке.

График вверху наглядно демонстрирует то, что называется кризисом ожирения сайтов (кстати, статья об ожирении сайтов на Хабре занимает 12,2 МБ). Средний размер текстовых в своей основе страниц по каким-то причинам стабильно растёт уже много лет подряд. Хорошая новость в том, что в последние месяцы рост немного замедлился, но всё равно тенденция пугающая. То, что вчера считалось «жирной» страницей, сегодня считается нормой, а завтра будет образцом элегантного дизайна.

А разве на веб-страницах стало больше информации? Почему страница с твитом на несколько слов занимает больше мегабайта?

Если проанализировать статистику HTTP Archive, то можно заметить несколько интересных тенденций. Например, если сравнить размер веб-страниц сайтов топ-10 со всеми остальными сайтами.

Как видим, на самых популярных сайтах веб-страницы гораздо меньше по размеру, чем на остальных. И ещё одна интересная вещь: в то время как весь веб постепенно жирнеет, самые популярные сайты становятся легче!

Умный читатель заметит, что среди сайтов топ-10 — несколько поисковых систем, так что им легче держать себя в форме. Но всё равно остаётся в силе второй пункт: уменьшение их объёма.

2015-й год явно был кризисным для веба, пишет Ронан Кремин (Ronan Cremin), ведущий веб-разработчик компании Afilias Technologies. — Многие события сигнализируют о том, до какого низкого уровня опустилась производительность: в iOS внедрили блокировщики рекламы, Facebook и Google анонсировали о технологиях для ускорения загрузки веб-страниц, даже NY Times сравнила интернет-рекламу с алкоголем: как говорил Гомер Симпсон, алкоголь — это причина и решение всех жизненных проблем. То же самое можно сказать об интернет-рекламе, из-за которой и происходит, в значительной степени, раздутие веб-страниц. Неудивительно, что всё больше пользователей решают установить блокировщики рекламы, а вслед за Safari в iOS и разработчики других браузеров подумывают о том, чтобы интегрировать блокировщик рекламы в стандартный браузер.

Проблема в том, что мы не уделяем внимания производительности, считает Ронан Кремин: «Новый JavaScript модуль галереи? Конечно, почему нет? Ух ты, новый веб-шрифт тут хорошо смотрится, почему не добавить новый инструмент аналитики, раз уж мы здесь? Стоит ли уменьшать картинку 6000 пикселов? Да ну, браузер об этом позаботится вместо нас».

В принципе, происходящее сейчас вполне нормально. Так часто бывает с технологиями — они проходят путь от ранних экспериментов к чрезмерному злоупотреблению, а потом всё устаканивается до нормального состояния. Похоже на то, что производительность веб-страниц сейчас тоже постепенно становится приоритетом. Медленно, но верно происходят изменения. Например, WordPress добавил поддержку отзывчивых изображений в версии 4.4 — одно это должно заметно повлиять на средний размер веб-страниц в интернете, ведь под WordPress работает 26% всех веб-сайтов. В Drupal 8 сделано то же самое.

Начнёт проявляться обратная связь. Когда ключевые сайты повысят своё быстродействие, остальные станут казаться ещё медленнее. Google может даже пойти дальше — и понижать позиции «медленных» сайтов в поисковой выдаче. Тогда необходимость оптимизации дойдёт даже до самых тугодумов.

Комментарии (84)

Hellsy22

22.04.2016 23:53-20Задача 3D-рендера тривиальна по сравнению с задачей динамического размещения множества элементов на странице. Что же до графики, то Doom работал в режиме 320x200 и даже там спрайты хорошо смотрелись лишь на среднем расстоянии. А сейчас распространенное разрешение 1920x1080. Один бэкграунд может легко занять мегабайт. А главная страничка какого-нибудь агрегатора смешных картинок — больше десяти. Мы смотрим в браузерах анимированные гифки размером в десятки мегабайт и видео в HD-качестве, размером в сотни.

DrSavinkov

23.04.2016 00:17+171) Что мешает использовать для бэкграунда векторные изображения? Не говоря о том, что иногда яркий бэкграунд просто раздражает.

2) Дальше — задача рендера НЕ тривиальна и состоит из многошаговой фильтрации картинки со всякими глубинами и отсечениями невидимых деталей. Разместить же столбиком 100+ постов в facebook — элементарно, Ватсон! Считай смещение и размер предыдущего и применяй к следующему.

3) Смешные картинки не обязательно сразу грузить в оригинальном разрешении — для предпросмотра существуют миниатюры. Слава здравому смыслу, гифки и видео загружаются преимущественно по запросу, либо при явной ценности(как на youtube) — автоматически. Остаётся только текст, который, к счастью, не стал весить больше.

Я не обладаю навыками веб-разработчика, но базовые знания JS и html имеются и порой взгляд на код страницы с прикрученными тут и там вызовами к ajax и отложенная подгрузка скриптов меня удивляют и огорчают. Оно конечно сокращает объём кода, хранимого на сервере, но существенно увеличивает число запросов к этому коду. Пару лет назад где-то на хабре даже статья была про падение скорости загрузки страниц из-за такой фрагментации.Hellsy22

23.04.2016 05:33-11. А вы посмотрите сколько весит более-менее приличная SVG-картинка, прежде чем предлагать такую «оптимизацию».

2. В Doom используется доработанная обратная трассировка. «Глубины, отсечения, многошаговая фильтрация» — это все появилось потом, с развитием реального 3D.

3. А это и есть миниатюры. Картинки высокого разрешения обычно прячутся под кат или загружаются по клику.

Оно конечно сокращает объём кода, хранимого на сервере

Динамическая и отложенная загрузка нужны для экономии трафика и времени пользователя. Чтобы ему не пришлось перегружать заново всю страницу, инициализировать все скрипты, тащить из кэша заново все картинки (и хорошо еще если из кэша). А вот как раз на стороне сервера все становится сложнее — проще было бы генерить страницы по шаблонам целиком.

Alexsandr_SE

23.04.2016 08:01+3> Картинки высокого разрешения обычно прячутся под кат или загружаются по клику.

Часто они грузятся целиком и масштабируются уже самим браузером. Попадались сайты, где главная страничка весит больше 100мб!!! из-за таких вот картинок в оформлении.

Vedomir

23.04.2016 10:39+2либо при явной ценности(как на youtube) — автоматически.

Вот за такие фразы как «явная ценность» временами хочется сделать с разработчиками что-то нехорошее. Ведь приходится ставить специальные плагины для браузера, которые хоть как-то спасают от крайне неприятного и навязываемого насильно автопроигрывания на youtube.

DrSavinkov

23.04.2016 11:23Я имел в виду автопроигрывание конкретно того видео, страницу с которым открыли. Ну и при запуске плейлиста. Мне не очень нравится «Автоматическое воспроизведение», потому что качество подбора видео в нём оставляет желать лучшего. Поэтому у меня оно отключено.

Vedomir

23.04.2016 12:32+4Я имел в виду именно это. Автопроигрывание конкретно того видео, страницу с которым открыли. С моей точки зрения это очень неприятное и неправильное поведение. Оно означает что сайт за меня решает на чем именно и когда именно я должен фокусировать внимание.

Даже если я специально открыл страницу с видео я вполне возможно хочу сначала прочитать описание и название и потому уже начинать смотреть. А в большинстве случаев я вообще читаю какую-нибудь другую страницу, вижу на ней ссылку с видео и перед тем как начать просмотр как миниму дочитываю до конца то предложение или абзац в котором попалась ссылка. А может и вообще статью в целом, а видео открываю чтобы не искать потом на него ссылку в тексте.

К сожалению современные сми не рассчитаны на серьезную концентрацию на чем-то одном, напротив они все рассчитаны на непрерывное переключение внимания между маленькими и изолированными кусочками информации.

Это сильно вредит качеству получаемой информации и ее осмыслению.chersanya

23.04.2016 20:03+1Справедливости ради, если ютуб открыть в фоновой вкладке, то воспроизведение не начнётся до того, как сам перейдёшь на эту вкладку. Так что с открытием сразу нескольких ссылок на видео проблем нет, они не начнут все сразу играть.

wormball

23.04.2016 21:57+1Справедливости ради, это сподобились сделать только один-два месяца назад. По крайней мере у меня это тогда появилось. А до этого приходилось каждый раз лихорадочно искать вкладки, с которых идёт звук.

DrZlodberg

23.04.2016 23:49+1Всё-таки сделали? Приятная новость. Сам спасаюсь только с помощью плагина «click to play per-element». Кстати он ещё помогает от флеш-баннеров, которые правда сейчас активно заменяются js-анимашками (спасает noscript) и css-анимашками (тут уже только stylish, но это уже только для часто посещаемых, ибо требует хитрой настройки) Все плагины для Firefox, хотя возможно и для других браузеров есть аналоги.

Отключение gif-анимации вроде не помогает, хотя раньше в Opera вроде был режим когда грузился только один кадр, и догружался весь только по клику. Сейчас вроде в фоксе весь грузится независимо от настройки.

demimurych

23.04.2016 11:30+21) Потому что не всегда хочется для бэкграунда вектор. А хочется фото.

2) В случае именно ДУМА — тривиальна. Там нет многошаговой фильтрации и глубин. Более того, дум никогда не был 3д игрой. Более того, дум это тот же фулфинштейн 3д работавший на 286. Использована точно та же технология. Поверьте человеку который дизассемблировал оба проекта. С точки зрения сложности алгоритма, современная веб-страница может быть на порядок сложнее логики дума.

ID Software в то время сотворили чудо — они смогли создать визуализацию которая внешне напоминала 3d и при этом ей не требовалось серьезных вычислительных мощностей. В этом им нужно отдать должное. Но с точки зрения современных технологий, дуум может напрограммировать любой студент на javascript.

Vedomir

23.04.2016 12:49+2Потому что не всегда хочется для бэкграунда вектор. А хочется фото.

Сама идея картинки на фоне достаточно спорная. Я еще не видел сайтов где она была бы действительно нужна и полезна. Чаще всего она только портит дизайн.

На больших сайтах вроде гугла, яндекса или хабра как правило фоновых картинок как раз и нет.

Zergos_Z

25.04.2016 17:29Дело в том, что все зависит строго от специфики ресурса. Если основной контент, который потребляет пользователь ресурса — текстовая информация, то на ресурсе должно быть максимум текстовой информации. Если это фотографии или видео, то должно быть видео.

Вот вы привели в пример google, но попрошу вас открыть гугл, открыть раздел картинки, и сделать любой запрос. У меня получилось 1.2мб.

Изначально все сайты старались уменьшить свой размер исключительно из-за того, что у пользователей был плохой интернет. Сейчас у более половины пользователей интернет работает со скоростью больше 1мбит/с, что вполне позволяет наполнять свой сайт так, как захочется и в этом нет ничего плохого. Это прогресс, который как известно не остановить.

Лично мне все эти возмущения по поводу увеличения размера страниц напоминают рассуждения на лавочке возле подъезда о том, что раньше было лучше.

Vedomir

27.04.2016 15:35А если туда добавить фоном фотографию весом в мегабайт как предлагает автор исходного комментария?

Один бэкграунд может легко занять мегабайт.

Речь изначально шла именно о ненужной информации которой забиваются веб-страницы.

Я собственно больше про нее писал, а не про размер.

xerxes

23.04.2016 09:27+10До чего мы дошли — шедевр в виде движка графики Doom, который все копировали и смогли сделать на таком уровне только в одной компании, теперь называется тривиальной задачей… Посмотрел бы я на вам, если бы вам показали код Дума, поняли бы он хоть что-нибудь там. И по сравнению с чем? С отображением таблиц, текста и столбиков. (facepalm)

herr_kaizer

23.04.2016 15:33-5Можно поинтересоваться, что особо сложного можно найти в думовском движке?

herr_kaizer

23.04.2016 23:32+2Минусаторы — ответить на вопрос кто-нибудь может?

Псевдотрехмерность придумали задолго до Doom, и BSP-деревья в играх тоже научились использовать до него. Популярность игры обсуловлена качественностью реализации, а вовсе не технической составляющей. По сравнению с тем же Build думовский движок не умел вообще ничего.AllexIn

24.04.2016 00:03Вы хотите чтобы в играх были революционные научные идеи?

Так не бывает. Parallax ставших модным меньше десяти лет назад — был математически описан, лет 40 назад, если не ошибаюсь.

Игры никогда не были изначальным источником революционных идей.

Уникальность дума в том, что в нем были реализованы вещи, которые хоть и существовали до него — но не были использованы настолько эффективно и красиво, как это было сделано в думе.

herr_kaizer

24.04.2016 00:37+2Посмотрел бы я на вам, если бы вам показали код Дума, поняли бы он хоть что-нибудь там

Я отвечал в контексте этой фразы, это касается именно что технической реализации. Красивость и эффектность дума — заслуга рисовальщиков и геймдизайнеров, а вовсе не движка.

В любом случае, спор бессмысленный и предлагаю его прекратить.AllexIn

24.04.2016 09:05+2Красивость и эффектность дума — заслуга рисовальщиков и геймдизайнеров, а вовсе не движка.

Именно техническая реализация дума — основная фишка дума.

Ваше сравнение с Build Engine вообще не корректное. Ибо Doom требовал 386, а Duke — уже 486. А это совершенно разные процессоры. Наверное это вам кажется сейчас тривиальным. Но тогда, дум был написан под процессор, который страшно тупит на float операциях. Потому что, внезапно, Doom не требовал FPU для своей работы. А Duke — требовал.

Посадите рядом двух школьников и заставьте их делить числа. Одного — столбиком, а второго — с калькулятором.

Вот Doom — позволял добиться скорости калькулятора имея лишь школьника делящего столбиком.

Повторюсь: Doom был инженерной революцией, а не научной. Ничего уникального там нет. Но именно инженерно он гениален для того времени.

У меня есть четкое ощущение, что вы не очень-то знакомы с теорией разработки игр.

neverice

25.04.2016 16:23Алгоритмическая сложность. Она не сравнима с разработкой веб страницы (даже не фреймворка, а банальной страницы). В DOOM было реализовано множество идей, которые были революционны для того времени и тех ресурсов. Просчет столкновений, псевдо 3Д, вертикаль без вертикали (герой не может целиться вверх-вниз, но может стрелять), ИИ противников. Это задачи, которые по своей алгоритмической сложности даже близко не стоят к большинству веб фреймворков и тем более веб страницам.

Hellsy22

23.04.2016 22:14+11. Не шедевр.

2. Не копировали. Некоторые использовали.

3. Не было никакого уровня. Движки и их модификации выходили каждый год. Их делали все подряд.

4. У меня не было проблем ни с Си, ни с ассемблером для x86. Я еще в школьные годы реализовал несколько 3D движков чисто из любопытства. А ваше мнение на чем основывается? Вы вообще хотя бы в общих чертах представляете, как работает рейкастинг?

xerxes

23.04.2016 23:443. Цитирую вики:

«Doom is considered to be one of the pioneering first-person shooter games, introducing to IBM-compatible computers features such as 3D graphics, third dimension spatiality, networked multiplayer gameplay, and support for player-created modifications with the Doom WAD format.»

Обращаю внимание на слово introducing и one of the pioneering.

4. Представляю, но в общих чертах.

Если это действительно так, то я рад за вас, вы очень крутой и принадлежите к тем редким людям, кто это может делать. Но при чем тут вы и все остальные? Ни один из моих знакомых даже в университетах на IT-специальностях не реализовывали 3D-движки. Не надо кокетничать и делать вид, что это норма. Зачем вы своё знание опускаете?

Мое мнение основывается на здравом смысле на знании мнения других людей. Вы говорите как подросток в стиле «плёвое дело, я с крыши одной многоэтажки на крышу другой перепрыгиваю, любой может». Но это его личное видение мира и его личные понты.

Или, может, у вас есть опыт создания части 3Д-движка по готовому алгоритму, что и дает вам иллюзию легкости, а опыта создания браузера нет, что дает вам иллюзию сложности. Но Doom создавался, когда алгоритмов еще не было.

Кармак говорил, что сложность современных 3Д-движков превзошла сложность операционных систем или программ НАСА. Не слышал, чтобы кто-то говорил подобное про браузеры.

Вы видели исходный код Дума? Не знаю как вам, но по мне он сложный, большой и непонятный. Думаю, такой же он и для большинства программистов. А вот в движке браузера разобраться гораздо легче.

Чтобы реализовать хотя бы raycasting, надо было читать научные исследования, понимать их, реализовывать и додумывать алгоритмы. Как это может считаться тривиальной задачей? Как тогда назвать, прости господи, компилятор? Супер тривиальной задачей? А простую программу? Гипер-супер тривиальной задачей?AllexIn

24.04.2016 00:083Д движок — это матрица проекции и сканлайн. Любой студент второкурсник на около-математической специальности сможет сделать 3Д движок за пару вечеров не особо напрягаясь.

Лично у меня вообще нет высшего образования, но я хорошо понимаю как работает 3Д и могу без гугла написать софтверный рендер.

Но я также не согласен и с вашим оппонентом.

Потому что есть разница между «могу написать 3Д рендерер» и «могу написать эффективный 3Д рендерер».

Не сложно написать 3Д рендерер во времена, когда мобильный телефон мощнее компьютера десятилетней давности. У меня, датчик влажности в доме прикручен к процессору, который мощнее чем то, на чем дум запускали двадцать лет назад…

А вот написать этот рендерер, чтобы он работал на 386 — это совсес другая задача.Hellsy22

24.04.2016 03:33+1Оптимизация для 386 тоже была не особо сложной: ассемблер, трассировка «линий» через целочисленное переполнение вместо деления, а для компенсации эффекта «рыбьего глаза» — заранее просчитанный массив. В общем, никакой плавающей арифметики и долгих операций. Вообще, самая большая проблема того времени была в чудовищно медленной видеопамяти. Trident даже просто перерисовывать весь экран не позволял больше 20-25 раз в секунду. Иногда оказывалось выгоднее хранить в памяти предыдущий кадр и пересылать только изменения.

AllexIn

24.04.2016 09:07Да, всё просто когда постфактум рассуждаешь над реализацией. Вот только тогда, этого почему-то никто сделать не мог.

Hellsy22

24.04.2016 03:18+23. Это общие слова. Даже у ID Software Дум был не первой игрой — Wolfenstein 3D вышел раньше, а еще раньше Catacomb 3D. Движок аналогичный Wolf-у был в Blake Stone (вышел чуть раньше Дума). На несколько месяцев позже вышел движок для SSI (Ravenloft, Menzoberranzan) который поддерживал большую часть фич дума — текстуры на полу и потолке, этажность и обладал бонусом — динамическим освещением (пролетающий фаербол менял цвет текстур). Другое дело, что в самой игре спрайты были нарисованы ужасно, но к движку это уже не относится.

4. Ваши знакомые просто этим не занимались. Рейкастинг — это аналог «Hello world!» в мире 3D движков.

Кармак говорил про современные 3D-движки, которые действительно очень сложны за счет многообразия решаемых задач.

Что же касается браузеров, то есть хороший пример: в движке webkit более 6 миллионов строк кода. Просто браузер не выглядит как что-то сложное на пользовательском уровне и принимается как должное.

bapewka

23.04.2016 10:48+4>Задача 3D-рендера тривиальна по сравнению с задачей динамического размещения множества элементов на странице.

Забыли тег сарказма?

Lex4art

23.04.2016 03:04+1Боюсь что ради громкого словца в измерениях банально не учитывали кэширования и хранения всех этих скриптов, фоновых картинок и файлов стилей, после которого на все остальные страницы домена остаются лишь десятки килобайт текста и HTML + изображения (PNG стали использовать чаще + размеры картинок выросли до FullHD и далее, вот и все «проблемы», ИМХО). Сжиматели траффика в браузерах — вообще не понятно зачем приплели, они нужны только мобильным пользователям с помегабайтной оплатой и связью переменного качества.

DistortNeo

23.04.2016 12:27+1Проблема не только в трафике, но и в производительности браузера у клиента. Да, скрипты, стили, фон кэшируются, но при каждой загрузке страницы браузер вынужден парсить всё каждый раз заново. Это приводит к тормозам и повышенному потреблению памяти, что для мобильных устройств пока ещё критично.

zhigalin

23.04.2016 13:14+1О да, вот только максимальный размер кеша в фаирфоксе 1 гигабайт.

И он у меня забивается за неделю.

А ещё быдлокодеры сделавшие ~50% сайтов в интернете про кеш и не слышали.Alexey2005

23.04.2016 14:40Можно попытаться кэширующий прокси поднять и настроить прямо на локальной машине.

Atreyer

23.04.2016 07:55+2Запоминаю жирные сайты и стараюсь обходить стороной, сейчас у меня дилемма с рамблером, ищу, чем заменить

— он стал совершенно не юзабельным…

Ilyasyakubov

23.04.2016 09:43а чем яндекс с гуглом плохи? не троллинг, действительно интересно чем хорош (был хорош) Рамблер

Atreyer

23.04.2016 12:13Гугл основной, его менять не нужно.Яндекс (с моей точки зрения) агрегатор с нормальным набором дополнительных услуг, но я уже пользуюсь приложениями Гугл, а агрегаторы мне не нравится.

Рамблер- на основной странице, без переходов, находятся все основные новости, однако в течении примерно 7-9 последних месяцев сайт настолько перегрузили рекламой, что больше трёх страниц пк не открывает, а вылетающие со всех сторон панели… вызывают с?а?т?а?н?у? негативную раздражающую реакцию(собственно -последняя капля)

immaculate

23.04.2016 09:55+15Еще одна проблема, на сайтах с пользовательским контентом (geektimes/habrahabr и другие) пользователи добавляют в статьи полноразмерные картинки весом во много мегабайт прямо с фотоаппарата. Кто-нибудь пишет, например, статью, как сделал фонарик на светодиоде, и три картинки:

— батарейка: 5 Мб

— плата с однм резистором и светодиодом: 6 Мб

— фото фонарика: 7Мб (размер 6000x4000 пикселей)

Я полгода нахожусь на очень медленном интернете через телефон (часто Gprs/Edge), к тому же еще и с небольшими дорогими тарифами (типа 2 Гб за 500 рублей), и такие статьи просто вымораживают.

Давно бы уже сделали автоматическое пережатие в статьях… Хотя, к сожалению, все сайты теперь еще и подгружают тысячи фреймворков, все это в сумме ненамного меньше трафика съедает, а также постоянно обновляется и загружается снова… Приходится все чаще бегать класть деньги на счет телефона… :(

Vedomir

23.04.2016 10:40+5Давно бы уже сделали автоматическое пережатие в статьях…

Может все-таки миниатюру со ссылкой?

ValdikSS

23.04.2016 12:14Поставьте себе на сервер ziproxy и настройте его на пережатие всех больших картинок.

hoarywolf

23.04.2016 15:37судя по тому, что коммент был про полноразмерные картинки, под пересжатием подразумевалось ресайз картинок, а не zip сжатие

ValdikSS

23.04.2016 15:48Стоило бы вам прочитать возможности программы, прежде чем писать комментарий.

hoarywolf

23.04.2016 17:07Я бы с удовольствием, но у них документация неизвестно где спрятана на сайте

Из того, что нашел говорится только про ухудшение качества jpeg для уменьшения объема, но не слова про ресайз. Посоветуйте где почитать про ресайз

atomlib

23.04.2016 13:36+1Пережатие же вроде должно быть. Все картинки рехостятся на «Хабрасторидже», а тот жмёт до 1920 по большей из сторон.

asdfghjk12

23.04.2016 15:36immaculate

Давно сделали веб-браузеры, которые автоматически сжимают весь траффик… Пережимая на своём сервере слишком большие картинки и подсовывая пользователю сжатые. В Операмобиле это работало ещё во времена Симбиана…

Hellsy22

24.04.2016 07:09У многих пользователей как минимум стомегабитный безлимитный интернет, на котором эти три картинки загрузятся меньше, чем за две секунды. Их удобство тоже чего-то стоит, верно? А для людей с… очень особенными условиями доступа к интернету существуют плагины. В конце-концов вы можете арендовать VPS (нынче это стоит копейки) и настроить на нем прокси, который будет пережимать или вовсе замещать картинки так, как это удобно лично вам.

sumanai

23.04.2016 10:08+1> Google может даже пойти дальше — и понижать позиции «медленных» сайтов в поисковой выдаче.

Мне казалось, что производительность уже давно является одним из ранжирующих факторов.

fzzr

23.04.2016 10:34Спасибо за перевод с Reddit. Если по делу, мне кажется что автор статьи совершенно прав на счёт тенденции к уменьшению размера и, надеюсь, оптимизации количества запросов. Когда же всех достанут эти ужасные тежеловесные лендинги, где полезного контента менее 10%, а остальное — битмапы и статистика?

RDEshka

23.04.2016 10:34Далеко ходить не надо. Взять эту страницу. Сколько на ней «ненужной информации»… Я открыл почитать статью, почитать комменты. Меня в данный момент не интересует ничего кроме этой статьи — зачем мне выдавать всю остальную информацию (снизу, сверху, справа, слева)? И тут еще нет рекламы!!! А про некоторые сайты и говорить не хочется, не то что открывать… Мне нравится функция в EDGE — режим чтения… НО он включается лишь после полной загрузки страницы… Может когда нибудь появятся нормальные сайты где будет текст и фотографии к теме…

Vedomir

23.04.2016 10:42+1С моей точки зрения это уже перебор. Сайты где вообще нет меню и навигации кроме одной маленькой кнопочки тоже раздражают.

stepik777

23.04.2016 12:33+1> И тут еще нет рекламы!!!

Есть, выключите AdBlock.

DrSavinkov

23.04.2016 12:43+3Даже с выключенным адблоком её не слишком много, на мой взгляд. И она не пытается заставить «кликать» себя, закрывая собой контент.

ExplosiveZ

23.04.2016 13:02Да просто для какой нибудь легкой фигни, подключают сотню другую библиотек, каждая по 20мб, все функции почти идентичны. Вот и проблема.

herr_kaizer

23.04.2016 17:56Библиотеки по 20 мегабайт? Это что за монстры такие? Ангуляр 40 килобайт весит.

tormozedison

23.04.2016 14:44https://play.google.com/store/apps/details?id=net.fro9.android.app.textbrowserfree

wormball

23.04.2016 22:03+1Грузить по два мегабайта — это ещё цветочки. А ягодки — то, что эти загруженные страницы потом занимают в памяти по два гигабайта! Вот буквально сейчас у меня на курсере страница просто с текстом на два экрана занимает эти самые 2 гб. А в среднем порядка 300 мб. Вот за это можно бы и расстрелять.

typ6o0jiehb

25.04.2016 10:00Расстраивает эта тенденция! есть же места, где канал 128 кбит/с считается нормой (и стоит несколько тысяч руб в месяц). Например сайт dom.gosuslugi.ru у меня загружался 2330,64 секунды (http://imgur.com/d7qdPuh), как считаете, это нормально?

NeoCode

ИМХО, вся эта новомодная хрень еще и неудобна. Для меня например старая добрая пагинация удобнее чем сайт который сам себя подгружает через ajax. Твиттер вообще тяжко использовать, стоит случайно щелкнуть не туда и все, текущая позиция страницы слетела и приходится откручивать по новой.

Vedomir

Не могу не присоединиться. Такое ощущение что современные сайты рассчитаны исключительно на мимолетное проглядывание самых новых записей или комментариев.

Любое обращение к чему-то за пределами крохотного кусочка того что появилось прямо сейчас требует муторных и многократных прокликиваний или прокруток с прогрузкой.

Со старой доброй пагинацией если прочитаешь несколько страниц чего-то и на время прекратишь чтение то всегда можно вернуться на конкретную страницу.

В обсуждениях полностью теряется понятие ветки комментариев — так как каждый раз грузится только крохотный кусочек то даже при наличии прямой ссылки на комментарий ветка обсуждения не грузится, грузится только он один и в лучшем случае предыдущий — выдранные из контекста.

Такое ощущение что следующим шагом станет вообще полное отключение любых архивов и показ исключительно небольшой порции самого свежего контента, причем даже не по дате а того, который считает нужным показать сайт. Хотя кажется в фэйсбуке и вконтакте что-то похожее уже и реализовано.

Darth_Malok

Во вконтакте лента выводится только за последнюю неделю. Возможно сделано и для того, чтобы сайт регулярно посещали. Заходишь во вконтакт реже раза в неделю — имеешь шанс пропустить что-то интересное от друзей/сообществ.

Vedomir

Мне сама эта ориентация на непрерывную выдачу/потребление информации каждый день и каждый час кажется неправильной.

Во-первых она обесценивает саму информацию. Невозможно с такой скоростью создавать качественный контент и его волей-неволей приходится заменять информационным мусором где по сто раз пережевывается одно и то же. В таком мусоре теряется действительно важная информация.

Во-вторых качественную информацию невозможно потреблять с такой скоростью. Опять же волей-неволей переключаешься на поверхностное проглядывание без глубокого вникания.

В общем чисто телевизионная модель в ее худшей ипостаси.

Я ее для себя решил вообще отказом от классических соцсетей и скоростных новостных лет. Читаю избранные блоги с аналитикой — с хабра, ЖЖ и некоторых других мест через RSS. Некоторые журналы. Читаю тогда, когда есть время нормально осмыслить прочитанное. Те люди которые регулярно пишут хорошие качественные статьи в блоги (ЖЖ например) как правило физически не могут делать это быстро, обновления появляются раз в несколько недель.

Что характерно, я практически ничего не потерял с точки зрения осведомленности по сравнению с теми знакомыми которые как раз постоянно читают ленты новостей. Наоборот какие-то интересные новости до меня часто доходят раньше (если взять ту же политику например) просто потому что не тонут в шуме.

Но если вернуться к статье и обсуждению — очень печально когда подобная телевизионная модель проталкивается на технологическом уровне.

AllexIn

Это всё решается жесткой фильтрацией. Использую вконтакт как агрегатор новостей от интересных мне сообществ. Жестко отфильтровал мусорные сообщества, даже те, которые иногда дают полезную инфу. В итоге осталось три сообщества, которые регулярно постят что-то.

Мусорность контента и дикая скорость его штамповки — это не проблема сообщество и социальных сетей. Это проблема потребителей. Есть потребитель на весь этот шлак.

IRainman

Что же мне всё это напоминает, ах да, зомбоящик и знаете я им не пользуюсь.

ВК у меня уже давно остался только в формате мессенджера (Kate Mobile) ибо есть несколько человек с которыми можно связаться либо через Skype либо через VK, а у Skype нормального клиента уже не под какую платформу нет.

Alexey2005

Следующим шагом станет отказ от текста в Интернете. Тенденция уже сейчас прослеживается. Текстового контента всё меньше — сплошь фото, видео, подкасты эти дурацкие. То, что раньше можно было просмотреть за полминуты, теперь требует не менее 10 минут на просмотр.

AllexIn

Даже сраные анекдоты в картинки запихивают, :(

cjfynjy

Maxmaxmaximus

ИМХО, вся эта новомодная крутотерь еще и удобна. Для меня например старая злая пагинация не удобнее чем сайт который сам себя подгружает через ajax. Твиттер вообще легко использовать, стоит случайно щелкнуть не туда и все, текущая позиция страницы поменялась на нужную и не приходится откручивать по новой.

Maxmaxmaximus

кококок нисагласин кококо минус минус =) кококо и сюда минус кококо

Maxmaxmaximus

как я знатно перетролилл дегенерата который ни каких аругмнетов не привел, я лишь реверснул его комментарий который должен иметь, по его логике такой же вес. но стадо тупых изнасилованных жизнью хаброблядек не осилило иронию. кроме того я еще и про карму начал разговаривать, от чего у месного планктона вообще взрывается =) хииххи сучки.

дути бути какие все злиие минусану минусану,. вот атк вот, даже атвичать ни буду минусану, его камминтарий уже празрачный а значит нас мнга азначит он ниправ, кококо минусану стадо стадо кококо. нахуй идите ущербные дигенераты ^_^

тут видимо тока одноклеточные батаны и терпилы выживают. так что идите ка нахуй дети шлюх, Меня зовут Иван Вольнов и запомните это имя, я самый крутой хокаге который будет строить роботов ^_^

DrSavinkov

Я вот поленился дописать раньше вам сообщение, когда был только первый ваш пост. Так сейчас не поленюсь.

Итак, вы, как вы выразились, «реверснули» комментарий. От этого он приобрёл обратный оригинальному комментарию смысл и вызвал острое чувство диссонанса у тех, кто видел до этого оригинал. Несколько читателей сочли ваш комментарий настолько не совпадающим с их мнением, что не поленились минусануть. Ваша же реакция была на уровне дошкольника: «Со мной не согласны — ну и сами дураки», что вы в весьма оскорбительной форме выразили, написав второй пост. Спустя три с половиной часа вы увидели, как рейтинг ваших комментариев стремится к существенно отрицательным значениям и написали третий пост, в котором попытались представить всё произошедшее как заранее спланированный акт поджигания стульев путём написания своего первого, а затем и второго комментария. Не удивлюсь, если и третий ваш комментарий отхватит свою долю внимания читателей.

Daniyar94

Вы просто напросто показали свою невоспитанность, быдловатость, и очень толстый троллинг. Я так же не согласен с первым комментарием, который вы пытались «потроллить». Но заметьте ваш комментарий не конструктивнее (просто очень глуппый троллинг). Потом пошли маты, жалобы на пользователей, и прочее. Если вам так пофиг на карму, вы бы даже эти два комментария (которые кстати не несут никакой смысловой нагрузки) и не писали. Уходите пожалуйста на 4chan или паблики вконтакте, там вам место

AllexIn

Досвидания. :(

Maxmaxmaximus

пака((99

zenhower

Я как-то зашел на сайт нужной мне компании. Хотел узнать где они находятся.

Но ссылки на «Контакты», «О нас», «Карта проезда» были расположены в подвале сайта.

И этот подвал был доступен ровно секунду, пока подгружалась очередная порция новостей.

nerudo

Мир принадлежит быстрым и метким!

Prototik

Ну или тем, кто отключит интернет :)

DrSavinkov

Скайнет?)

vmchaz

Namynnuz

Это к вопросу о необходимости проводить естественный отбор среди дезигнеров путём отстрела по юзабилити…