Дмитрий Малютов мало что может рассказать о своём творении.

Он работает в исследовательском отделе IBM, и часть своего времени посвящает созданию систем машинного обучения, решающих задачи корпоративных клиентов компании. Одна такая программа разрабатывалась для большой страховой компании. Задание было непростым, требовался сложный алгоритм. Когда пришло время объяснять результаты клиенту, возникла заминка. «Мы не могли объяснить им эту модель, потому что они не разбирались в машинном обучении».

А даже если бы и разбирались, это могло им не помочь. Потому что моделью была искусственная нейросеть, программа, принимающая данные нужного типа – в нашем случае, дела клиентов страховой компании – и находившая в них шаблоны. Подобные сети используются на практике уже полстолетия, но недавно они испытали возрождение, и помогают совершать прорывы везде, от распознавания речи и переводов до игры в Go и робомобилей.

И несмотря на все успехи нейросетей, есть у них и одна проблема: никто, по сути, не знает точно, как они работают. А значит, никто не может предсказать, когда они ошибутся.

Возьмём, к примеру, ситуацию, о которой недавно поведала исследователь в области машинного обучения Рич Каруана [Rich Caruana] со своими коллегами. Они описали опыт команды из Медицинского центра Питтсбургского университета, использовавшей МО для предсказания возникновения осложнений у больных пневмонией. Они стремились к тому, чтобы отправлять пациентов с небольшим риском на амбулаторное лечение, и экономить места в госпиталях. Они попробовали разные методы, в том числе различные нейросети, а также деревья решений, созданные программами, выдававшие понятные человеко-читаемые правила.

Нейросети оказывались правы чаще, чем другие методы. Но когда исследователи и врачи обратились к человеко-читаемым правилам, они заметили нечто неприятное: одно из правил предписывало врачам отправлять домой больных пневмонией, у которых была астма, несмотря на то, что больные астмой очень плохо переносят осложнения.

Модель сделала, что ей было поручено: обнаружила шаблоны в данных. Плохой совет был результатом неточности в данных. В правилах госпиталя была прописана отправка астматиков с пневмонией в отделение интенсивной терапией, и это правило так хорошо работало, что астматики почти не сталкивались с осложнениями. А без особого ухода результаты их лечения были бы совсем другими.

Это происшествие показывает большое значение возможности интерпретации результатов. «Если система, основанная на правилах, выяснила, что астма понижает риски, конечно, и нейросеть это тоже выучила»,- писал Каруана с коллегами – но работу нейросети люди не могли интерпретировать, и её странные заключения по поводу астматиков было бы сложно объяснить (1). Если бы у них не было интерпретируемой модели, предупреждает Малютов, «можно было бы случайно поубивать людей».

Поэтому многие не торопятся ставить на загадочные нейросети. Когда Малютов представлял свою аккуратную но непонятную нейросетевую модель своему корпоративному клиенту, он предложил им и альтернативную систему, основанную на правилах, работу которой он мог просто объяснить. Вторая модель работала менее аккуратно, чем первая, но клиент решил использовать её – несмотря на то, что для работающей с математикой и точными данными страховой компании важна была любая доля процента точности. «Они лучше её понимали,- говорит Малютов. – Они высоко ценят интуицию».

Даже правительства начинают беспокоиться по поводу растущего влияния непонятных пророков от нейросетей. В ЕС недавно предложили ввести «право на объяснение», которое позволяло бы гражданам требовать прозрачности алгоритмических решений (2). Но такой закон сложно будет ввести, поскольку регистраторы не дали чёткого определения «прозрачности». Непонятно, является ли этот просчёт результатом непонимания проблемы или признанием её сложности.

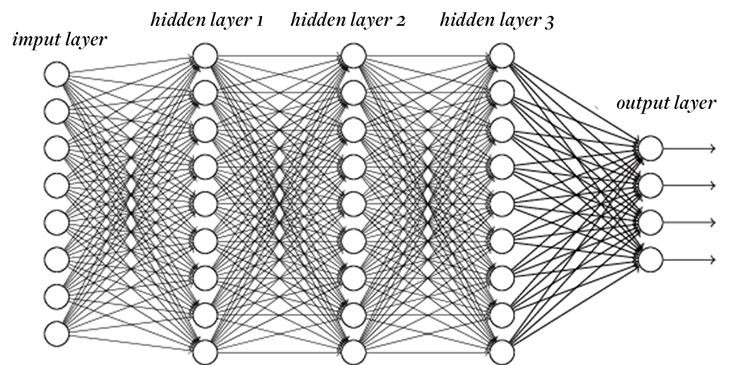

На самом деле, некоторые верят, что это определение невозможно дать. Пока что, хотя мы знаем всё по поводу того, что делают нейросети – ведь это, по сути, просто компьютерные программы – мы очень мало что можем сказать о том, почему они это делают. Сети состоят из множества, иногда из миллионов, отдельных элементов, называемых нейронами. Каждый нейрон преобразовывает множество чисел на входы в одно число на выходе, которое потом передаётся дальше одному или нескольким нейронам. Как и в мозгах, нейроны делятся на «слои», группы клеток, принимающих данные от нижнего слоя и отправляющих его на верхний.

Нейросети тренируются путём скармливания им данных, а затем регулировки связей между слоями до тех пор, пока вывод сети не начнёт наилучшим образом соответствовать просчитанному. Невероятные результаты последних лет появились благодаря серии новых техник, сделавших возможным быструю тренировку глубоких сетей, со многими слоями между первым вводом и окончательным выводом. Одна из популярных глубоких сетей AlexNet используется для категоризации фотографий – и, помечая их, способна распознавать такие тонкие моменты, как отличия пород померанский шпиц и ши-тцу. Она содержит более 60 миллионов «весов», каждый из которых сообщает каждому нейрону о том, сколько внимания нужно уделять каждому кусочку входных данных. «Чтобы говорить о понимании работы сети,- говорит Ясон Йосинский, программист из Корнеллского университета, работающий в компании Geometric Intelligence,- нужно обладать пониманием этих 60 миллионов чисел».

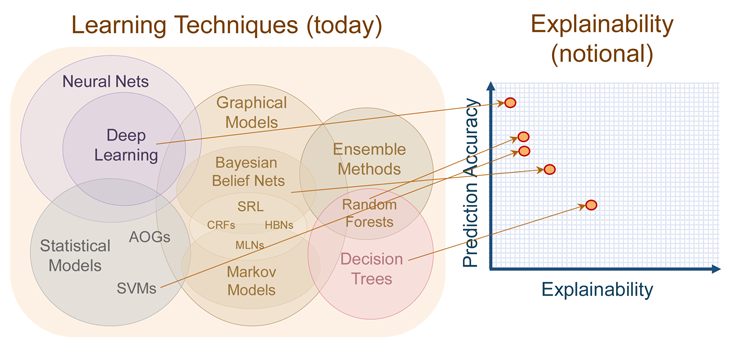

И даже если было бы возможно настолько разобраться в работе нейросети, это не всегда нужно. Требование точного понимания её работы можно рассматривать, как ещё один набор ограничений, мешающий модели вырабатывать «чистые» решения, зависящие лишь от входа и выхода, потенциально способный уменьшать точность модели. На конференции DARPA руководитель программы Дэвид Ганнинг [David Gunning] обрисовал текущее положение нейросетей на графике, который демонстрирует, что глубокие сети – это наименее понятные из современных методов. На другом конце спектра – деревья решений, основанные на правилах системы, ценящие объяснимость выше эффективности.

Наиболее точные и наименее понятные методы – глубокие сети. Затем по увеличению понятности и уменьшению точности идут алгоритм «случайный лес», статистические модели, байесовские сети, и деревья решений.

В результате, современное машинное обучение выступает в роли оракула: получить точный ответ о том, что случится, или же понятное, но неточное объяснение того, что случится? Объяснение помогает нам вырабатывать стратегию и адаптироваться, а также знать, когда модель перестанет работать. Знание о том, что случится, помогает нам реагировать соответствующим образом в ближайшем будущем.

Такой выбор может быть сложным. Некоторые исследователи надеются устранить необходимость выбора – чтобы у нас был и слоёный торт, и его понимание. Интересно, что самые многообещающие исследования относятся к нейросетям как к объектам эксперимента – на манер биологических изысканий – вместо того, чтобы рассматривать их, как чисто математические объекты. Йосинский, к примеру, говорит, что он пытается понять глубокие сети «как мы понимаем животных, или даже людей». Он и другие программисты заимствуют технологии исследований из биологических областей, и заглядывают в нутро нейросетей словно неврологи в мозг: пробуя отдельные части, составляя каталоги того, как внутренности сетей реагируют на небольшие изменения ввода, и даже удаляя кусочки и наблюдая за тем, как остальные компенсируют их отсутствие.

Построив интеллект нового типа с нуля, учёные теперь разбирают его на части, применяя к этим виртуальным организмам цифровые микроскопы и скальпели.

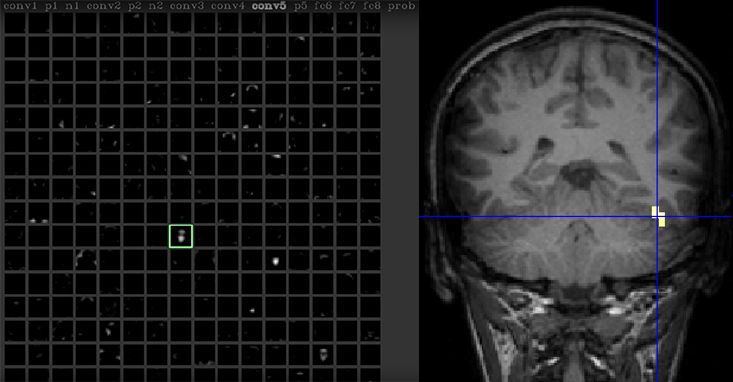

Йосинский сидит за компьютером и говорит в веб-камеру. Данные с камеры скармливаются глубокой нейросети, в то время, как сама сеть подвергается анализу в реальном времени при помощи программы Deep Visualization, разработанной Йосинским с его коллегами. Переключаясь между экранами, Йосинский увеличивает один из нейронов сети. «Этот нейрон, судя по всему, реагирует на лица»,- говорит он на видеозаписи взаимодействия (3). В мозгу людей также существуют такие нейроны, многие из которых скапливаются в отделе мозга под названием «веретенообразная лицевая область». Эта область, открытая в различных исследованиях, начавшихся в 1992 году (4, 5), стала наиболее испытанным наблюдением в неврологии. Но если те исследования требовали применения таких сложных вещей, как позитронно-эмиссионная томография, Йосинскому достаточно одного кода.

Один нейрон в нейросети реагирует на лицо Йосинского так же, как одна из областей мозга реагирует на лица.

Этот подход позволяет ему связать искусственные нейроны с идеями или объектами, понятными человеку, типа лиц, что в результате может превратить нейросети в понятные инструменты. Его программа может указать, какое из свойств картинки более других стимулирует лицевой нейрон. «Мы можем увидеть, что он ещё сильнее бы отреагировал, если бы, например, глаза были темнее, а губы розовее»,- говорит он.

Для Синтии Рудин [Cynthia Rudin], профессора по компьютерным наукам и электронике из Университета Дюка, эти интерпретации по результатам не нравятся. Её исследование занимается построением систем МО на основе правил, применяемых к таким областям, как приговоры к тюремному заключению или медицинские диагнозы, где человеко-читаемые интерпретации не только возможны, но и критически важны. Но в областях, связанных со зрением, как она говорит, «интерпретации зависят исключительно от наблюдателя». Мы можем упростить ответ сети, определив лицевой нейрон, но как убедиться, что мы не ошиблись? Сомнения Рудин отражает известный афоризм, утверждающий, что для системы зрения может не существовать модели проще, чем сама система зрения. «Можно придумать много объяснений того, что делает сложная модель,- говорит она. – И что же нам, просто выбрать одно из них и признать его правильным?».

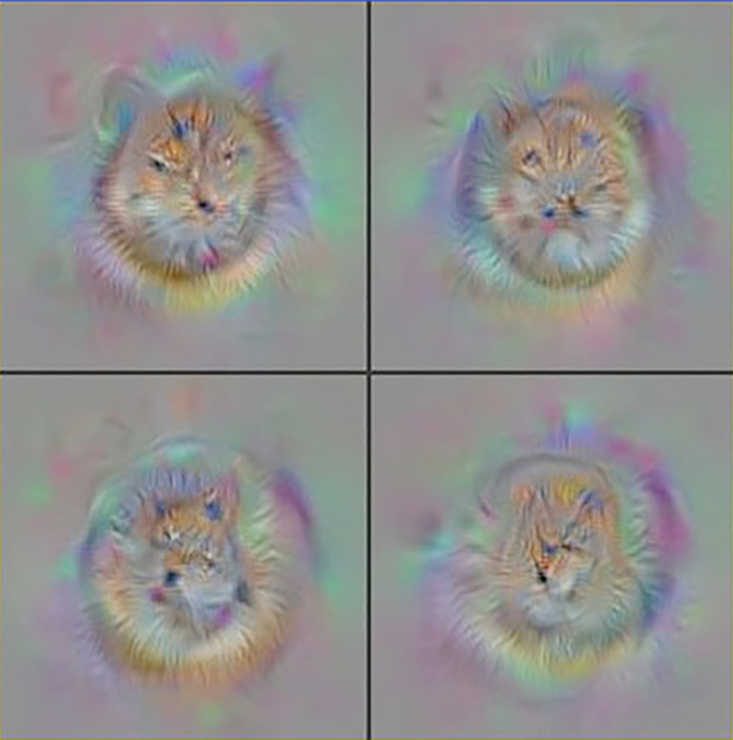

Инструмент Йосинского может частично опровергнуть эти сомнения, работая задом наперёд и открывая, что сеть сама по себе «хочет» оказаться правдивой – нечто вроде искусственного идеала. Программа начинает с сырой статики, затем попиксельно уточняет её, обрабатывая изображение при помощи процесса, обратного обучению. В результате она находит картинку, вызывающую максимально возможный ответ у выбранного нейрона. В применении к нейронам AlexNet метод выдаёт карикатурные изображения для отмеченных категорий.

Идеальные версии котов, созданные Deep Visualization.

Это, видимо, подтверждает заявления Йосинского о том, что лицевые нейроны ищут лица, в некоем общем смысле. Но есть проблема – для создания таких изображений процедура полагается на статистические ограничения (естественных предков изображения), которые ограничивают её созданием только изображений, содержащих структуры, встречающиеся в изображениях реального мира. Если убрать эти ограничения, инструменту всё равно удаётся найти картинку, вызывающую максимальный отклик, но эта картинка выглядит, как шум. Йосинский показал, что во многих случаях предпочитаемые AlexNet выглядят для людей, как шум. Он признаёт, что «довольно легко разобраться, как заставить нейросети выдавать что-то экстремальное».

Во избежание этих ловушек, Друв Батра [Dhruv Batra], ассистент-профессор по электронике и компьютерам в Вирджинском технологическом университете использует для интерпретации работы глубоких сетей экспериментальный подход более высокого уровня. Вместо поиска шаблонов в их внутренней структуре – «люди и поумнее меня работали над этим», сомневается он – он исследует поведение сетей через роботизированную версию отслеживания движений глаз. Его группа в проекте под руководством аспирантов Абхишека Даса [Abhishek Das] и Харша Агравала [Harsh Agrawal] задаёт нейросети вопросы об изображении, например, есть ли на картинке на окне шторы (6). В отличие от систем типа AlexNet, сеть Даса разработана так, чтобы работать с небольшой порцией картинки. Она двигает виртуальным глазами по изображению, пока не решает, что набрала довольно информации для ответа. После тренировки такая сеть очень хорошо работает, и отвечает на вопросы не хуже лучших людей.

Дас, Батра и коллеги затем захотели понять, как сеть принимает решения, изучая, на какие части изображений сеть обратила внимание. К удивлению, они обнаружили, что в ответе на вопрос про шторы, сеть даже не смотрит на окно. Она сначала смотрит на низ картинки, и прекращает смотреть, если находит кровать. Видимо, в наборе начальных данных для тренировки сетей, окна со шторами присутствовали в спальнях.

И хотя этот подход открывает некоторые аспекты работы нейросетей, он даже усложняет проблему интерпретации их работы. «Машины учатся не фактам о мире,- говорит Батра. – Они учатся фактам о представленном наборе данных». То, что они так сильно завязаны на предоставленных им данных, затрудняет составление общих правил их работы. Более того, если вы не знаете, как это работает, вы не знаете, когда оно ошибётся. А когда они ошибутся, то, по опыту Батры, «они сделают это ужасно позорно».

Некоторые преграды, с которыми встречаются исследователи, знакомы учёным, изучающим человеческий мозг. Вопросы интерпретации изображений работы мозга сейчас очень популярны, хотя и не так сильно известны. В обзоре от 2014 года когнитивный невролог Марта Фара [Martha Farah] писала, что «беспокоит то, что изображения работающего мозга больше похожи на изобретения исследователей, чем на наблюдения» (7). Появление этих проблем в очень разных видах интеллектуальных систем может говорить о том, что эти проблемы являются препятствиями не в изучении того или иного вида мозга, а в изучении самого понятия интеллекта.

Являются ли поиски понимания работы сетей бесплодной затеей? В блогпосте от 2015 года «Миф об интерпретируемости моделей» Захари Липтон [Zachary Lipton] из Калифорнийского университета в Сан-Диего предложил критичный взгляд как на мотивацию, стоящую за попытками понять работу нейросетей, так и на ценность создания интерпретируемых моделей МО на больших массивах данных. Он подал свою работу на симпозиум по дисциплине «интерпретируемость с точки зрения человека» (организованный Малютовым с коллегами) на конференции по машинному обучению (ICML), проходящей в этом году. (8)

Липтон указывает, что многие учёные не согласны с самой концепцией интерпретируемости, что, по его мнению, означает, что либо интерпретируемость плохо понимают, или что у этого понятия много разных значений. В любом случае поиски интерпретируемости могут не дать нам простых и прямых объяснений того, почему нейросеть выдала такой результат. В блогпосте Липтон аргументирует, что в случае гигантских наборов данных исследователи могут подавить своё желание интерпретировать результаты и просто «поверить в эмпирический процесс». Он считает, что одной из целью этой области является «построение моделей, способных обучаться на большем количестве параметров, которое когда-либо сможет обработать человек», и требование интерпретируемости может ограничить модели и не дать им развить весь свой потенциал.

Но такая возможность будет и преимуществом, и недостатком: если мы не понимаем, как сеть создаёт выходные данные, мы не знаем, какие особенности входных данных были важны, или что вообще можно рассматривать, как входные данные. Например, в 1996 году Адриан Томпсон [Adrian Thompson] из Сассекского университета использовал программу для разработки электронного контура, основанную на принципах, схожих с работой нейросетей. Контур должен был просто различать две разных тональности звука. После тысячи итераций по размещению и смене местами радиокомпонентов, программа нашла решение, работающее почти идеально.

Но Томпсон удивился, узнав, что контур использовал меньше компонентов, чем понадобилось бы инженеру-человеку. При этом несколько из них не были соединены с остальными, но они, каким-то образом, всё равно нужны были для правильной работы контура.

Он начал разбирать контур на части, и после нескольких экспериментов понял, что в его работе использовались небольшие помехи, возникавшие в соседних компонентах. Не участвовавшие в контуре компоненты влияли на него, приводя к малым флюктуациям в местных электрических полях. Инженеры обычно стремятся избавиться от таких взаимодействий из-за их непредсказуемости. Естественно, при попытке скопировать этот контур с участием другой партии таких же компонентов, или даже при смене окружающей температуры, контур переставал работать.

Этот контур продемонстрировал типичный признак результата работы тренированных машин: он компактный и наиболее упрощённый, очень хорошо приспособлен для своего окружения, и вовсе неработоспособен в других условиях. Они выбирают невидимые для инженеров свойства, но не могут знать о том, есть ли эти свойства где-то ещё. Исследователи МО пытаются избежать таких явлений, названных ими «сверхспециализацией», но при увеличении случаев использования таких алгоритмов в жизненных задачах их уязвимость станет видна.

Для Санджеев Арора [Sanjeev Arora], профессора информатики из Принстонского университета, эта проблема служит основной мотивацией для поиска интерпретируемых моделей, позволяющих людям вмешаться и подстроить сеть. Арора отмечает, что в отсутствие интерпретируемости у МО есть две очень серьёзные проблемы. Первая – пригодность для компоновки, когда при решении задачи нужно принимать так много решений (игра в го или вождение автомобиля), что не всегда понятно, какие из них привели к неудаче. «Обычно когда мы что-то разрабатываем, мы понимаем, что делают отдельные части, а затем собираем их вместе»,- говорит он. Это позволяет людям подстраивать компоненты, не соответствующие данному окружению.

Вторая проблема – «территориальная приспособляемость», то есть, возможность гибко применять знания, полученные в одном месте, к другому. У людей это получается хорошо, но машины могут ошибаться весьма неожиданно. Арора описывает случаи, в которых машины совершенно не способны подстраиваться под самые малые изменения контекста, в отличие от людей, делающих это с лёгкостью. К примеру, сеть, обученная чтению формальных документов, типа статей Википедии, оказывается неспособной понимать сообщения в твиттере.

С этой точки зрения интерпретируемость необходима. Но понимаем ли мы значение этого слова? Пионер компьютерных исследований, Марвин Минский, придумал фразу «сознание как чемодан» для понятий вроде сознания или эмоций, используемых нами при описании нашего интеллекта (9). Эти слова отражают работу множества разных процессов, спрятанных в «чемодане». И пока мы будем изучать эти слова-замены более фундаментальных концепций, мы будем ограничены возможностями языка. Может ли при изучении ИИ интерпретируемость оказаться таким же словом?

И хотя многие исследователи, с которыми я общался, оптимистично полагают, что теоретики когда-нибудь откроют чемодан и обнаружат простой набор правил, управляющих машинным (и, возможно, человеческим) обучением, нечто вроде "Математических начала натуральной философии" Ньютона, другие предупреждают, что этого вряд ли стоит ожидать. Массимо Пиглюччи [Massimo Pigliucci], профессор философии Нью-Йоркского городского университета предупреждает, что понимание естественных наук – и ИИ в том числе – может оказаться тем, что философ Людвиг Витгенштейн [Ludwig Wittgenstein] называл «сборной концепцией», такой, которая допускает множество различных определений. Если «понимание» и придёт, оно может оказаться похожим не на физические концепции, а на понятия из эволюционной биологии. Вместо «Начал» у нас в руках может оказаться "Происхождение видов".

Это, конечно, не значит, что глубокие сети станут предвестниками некоего нового типа жизни. Но они могут оказаться так же сложны для понимания, как жизнь. Инкрементальные, экспериментальные подходы и интерпретация по результатам могут оказаться не отчаянными метаниями в темноте в поисках света. Наоборот, это может быть единственный доступный нам свет. Интерпретируемость может открыться по частям, как набор примеров-прототипов «видов», систематизированных по контекстно-зависимым объяснениям.

На конференции ICML некоторые докладчики призывали определить «интерпретируемость». Вариантов было столько же, сколько и выступающих. Подискутировав, участники пришли к соглашению, что для интерпретируемости модели она должна быть простой. Но при попытке определить «простоту» группа опять разделилась. Будет ли простейшей та модель, что полагается на минимальный набор свойств? Та, что делает наиболее чёткие разделения? Наименьшая из программ? Симпозиум закрылся без согласия участников, заменивших одну зарождающуюся концепцию другой.

Как говорит Малютов, «простота – это не так просто».

Ссылки

1. Caruana, R., et. al Intelligible models for healthcare: Predicting pneumonia risk and hospital 30-day readmission. Proceedings of the 21th ACM SIGKDD International Conference on Knowledge Discovery and Data Mining 1721-1730 (2015).

2. Metz, C. Artificial Intelligence Is Setting Up the Internet for a Huge Clash with Europe. Wired.com (2016).

3. Yosinski, J., Clune, J., Nguyen, A., Fuchs, T., & Lipson, H. Understanding neural networks through deep visualization. arXiv:1506.06579 (2015).

4. Sergent, J., Ohta, S., & MacDonald, B. Functional neuroanatomy of face and object processing. A positron emission tomography study. Brain 115, 15–36 (1992).

5. Kanwisher. N., McDermott, J., & Chun, M.M. The fusiform face area: A module in human extrastriate cortex specialized for face perception. The Journal of Neuroscience 17, 4302–4311 (1997).

6. Das, A., Agrawal, H., Zitnick, C.L., Parikh, D., & Batra, D. Human attention in visual question answering: Do humans and deep networks look at the same regions? Conference on Empirical Methods in Natural Language Processing (2016).

7. Farah, M.J. Brain images, babies, and bathwater: Critiquing critiques of functional neuroimaging. Interpreting Neuroimages: An Introduction to the Technology and Its Limits 45, S19-S30 (2014).

8. Lipton, Z.C. The mythos of model interpretability. arXiv:1606.03490 (2016).

9. Brockman, J. Consciousness Is a Big Suitcase: A talk with Marvin Minsky. Edge.org (1998).

Комментарии (44)

VenomBlood

15.09.2016 22:13+1Действительно ли искусственный интеллект непостижим?

Заголовок очень желтый. Что значит "непостижим"?

"Часы на руке соседа — они непостижимы" — вот как это звучит. У нас есть 7 миллиардов примеров интеллекта и заявлять о невозможности скопировать его — это странно, даже одного примера было бы достаточно.

chaynick

16.09.2016 14:52Вопрос — как именно вы трактуете слово непостижим? Если вы говорите что у вас 7 миллиардов примеров постижимого интеллекта — то я вас разочарую, большинство людей не постигают и свой интеллект (иначе бы психотерапевты и прочие остались бы не у дел).

Далее, рассуждать о том что если есть объект, то скопировать его можно верно лишь до объекта не сложнее вилки. Дальше начинают возникать вопросы в технологиях и «черном ящике» что в большинстве случаев становится сильным препятствием для копирования. Скажем Китай обладает полной документацией по обслуживанию Ал-31Ф, и на основе этого попытались построить свой WS-10A. Результат — теоретически одинаковые двигатели, практически же…

Проблему начальную правда устранили, подняли межкапитальный ресурс до 1500 часов, но вот с надежностью и реальной тягой так и не справились. В результате Китай тихо и мирно продолжает закупать у нас двигатели, несмотря на свой «такой же».

VenomBlood

16.09.2016 19:42Вы подменяете понятия. Никто не спорит что сильного ИИ нету сейчас и то что не факт что он появится в ближайшем будущем, или не факт что он сможет работать без очень крутых производительных генераторов случайных чисел и т.д… Но слово "непостижим" в целом все же больше о принципиальной возможности. А принципиально мы видим что человека (разум) создать можно — значит можно сделать этот разум и искуственно.

Mad__Max

16.09.2016 23:49То что мы его скопируем — не значит что мы будем понимать как он работает, т.к. мы в общем-то не понимаем и то как работает естественный эталон.

Такое ощущение что возражали на заголовок «искусственный интеллект недостижим». А речь и в заголовке и в самой статье о постижимости, а не достижимости. Уже сейчас удается создавать нейронные сети(слабые формы ИИ), которые работают(и неплохо), но даже их создатели не могут разобраться как именно они работают.

VenomBlood

16.09.2016 23:53Ну а разве "понять" — это что то невозможное?

Да и про ИНС не согласен. Что значит "не могут разобраться как они работают"? Как они работают — прекрасно известно, иногда с математической точностью доказаны оптимальные методы. Как они работают на бытовом уровне — тоже понятно, это всего лишь отображение из одного множества в другое, как и любая другая функция. Что именно не понятно? Скорее речь о том что система не является идеальной и решение не выражается кратко аналитически.

Mad__Max

17.09.2016 00:22МОжет быть возможно, может быть и нет (если объект и механизмы его действия окажутся слишком сложными для понимания). Этот вопрос собственно и задается, тут нигде не было утверждения что постичь не возможно.

Как тренировать(обучать) и какие конфигурации для каких задач более эффективны — это не понимание как они работают. Этот работа с ними как «черным ящиком», для которого экспериментально нащупали набор эмпирических правил позволяющих его использовать на практике.

Вот с соседней ветке аналогию с EmDrive хорошую подкинули. Известно как его сделать(и не сложно). Известно как включать, известно что влияет на его параметры (увеличили мощность — увеличалась тяга, увеличили добротность контура — пропорциональная увеличилась тяга, поменяли геометрическую форму — тяга поменялась тоже по известном эмпирическому закону) и тд…

Значит ли это что мы понимаем как он работает? Разумеется нет — это непонятный черный ящик с интересными эффектами. Сказать что мы понимаем как он работает можно будет после того как будет создана и доказана теория объясняющая физику его работы.

В случае ИНС это было бы выведения неких общих(универсальных) принципов использование которых позляло бы объяснить любое (ну или практически любое) действие предпринятое сетью или как сформировался ответ на любые поданные на вход данные.

В случае с естественным интелелектом — достаточно его само спросить. В случае алгоритмической программы — в любом момент можно посмотреть все логические действия, выборы, ветвления, вычисления и т.д.

В случае же ИНС ответ в случшем случае будет в стиле: ну вот потому что тут и тут вот такие вот веса между вот этими группами нейронов. А почему такие веса? Ну вот такие сформировались как-то сами сформировались в процессе обучения при использовании вот этой вот выборки обучающих данных. Использовали бы другую выборку — сформировались бы какие-то другие веса (и даже заранее нельзя сказать а было бы конкретное решение/ответ от этого другим или осталось тем же не проверив все это экспериментально).

VenomBlood

17.09.2016 00:29если объект и механизмы его действия окажутся слишком сложными для понимания

Есть математическое доказательство того что что-то невозможно понять в принципе? Если что Теорема Геделя о Неполноте — это не о том.

действие предпринятое сетью или как сформировался ответ на любые поданные на вход данные.

А что сейчас не понятно? Анализ можно без проблем провести и сказать что именно привело к конкретному решению.

Ну вот такие сформировались как-то сами сформировались в процессе обучения при использовании вот этой вот выборки обучающих данных

Не "как-то сами", а опять же вполне можно провести анализ и понять в чем причина. Некоторые вещи — они да, могут получиться случайно или благодаря шуму, но в чем здесь проблема с объяснением? Да, модель шумит, но мы же не говорим что не понимаем как работает оперативка если иногда срабатывает коррекция ошибок, хотя тоже ситуация сродни шумам.

zim32

15.09.2016 23:57+1Сколько уже шума из-за некорректного по сути использования термина искуственный Интеллект. Маркетологи теперь не знают как объяснить что это вовсе не интеллект?

old_bear

16.09.2016 00:15А в «автопилоте» Теслы нейросеть используется? Если да, то первые звоночки уже прозвенели. И дальнейшие перспективы внедрения алгоритмов, логику работы которых мы не понимаем, несколько пугают.

VenomBlood

16.09.2016 01:03+5А в водителе автобуса нейросеть используется?

HappyLynx

16.09.2016 10:15+2Логику работы водителя автобуса мы как раз вполне неплохо понимаем благодаря эмпатии, даже когда он делает ошибки, мы можем объяснить, почему он их делает. А тех людей, логику работы нейросетей которых мы не понимаем, мы таки изолируем от общества в мягких комнатах и пытаемся лечить.

А то ходишь ты такой на работу, один коллега с тобой всегда приветлив, здоровается, а в очередной день он тебе на твое «здравствуйте» перо в бок засаживает просто так (причину никто не узнает, но с точки зрения нейросети коллеги: просто на тебе в этот день был малиновый галстук и зеленые туфли). Как думаете, что будет дальше с таким коллегой?

fireSparrow

16.09.2016 19:11«А тех людей, логику работы нейросетей которых мы не понимаем, мы таки изолируем от общества в мягких комнатах и пытаемся лечить.»

Нет. Принудительная госпитализация возможна только в случаях, когда подтверждён диагноз тяжёлого психического расстройства врачом соответствующей специализации.

И даже в случае подтверждённого диагноза принудительная госпитализация возможно только при по крайней мере одном из следующих условий:

· непосредственная опасность лица, недобровольно госпитализируемого в психиатрический стационар, для себя или окружающих, или

· его беспомощность, то есть неспособность самостоятельно удовлетворять основные жизненные потребности, или

· существенный вред его здоровью вследствие ухудшения психического состояния, если лицо будет оставлено без психиатрической помощи.

Это для России, но в большинстве цивилизованных стран всё обстоит похожим образом.

А так — люди постоянно друг друга не понимают. Бывает, что пара живёт в браке годы, и всё-равно супруги не могут понять логику и мотивацию друг друга.

VenomBlood

16.09.2016 19:35Какая разница что мы можем объяснить почему он делает ошибки, если в ближайшем будущем он будет в среднем делать их больше чем автопилот?

old_bear

16.09.2016 16:45-1Помимо аргументов, который привёл предыдущий оратор, остаётся вопрос ответственности. Общество устроено так, что ограничителем для деяний индивида служит ответственность за деяния, которые признаны обществом нежелательными, падающая на этого индивида. Финансовая ответственность, тюрьма, смерть в результате права на самозащиту и вот это всё.

Может быть это и не слишком хорошо работает в больших масштабах, типа ответственности руководителя гипотетической страны за миллионы гипотетических погибших в гипотетической войне, но на бытовом уровне вполне себе работает — если вы нанесёте кому-то вред, вас могут посадить, а если полезете к кому то в дом с нехорошими целями — вас могут застрелить. Т.е. подразумевается, что индивид несёт ответственность как минимум в пределах своей свободы, здоровья и жизни. И пострадавшие (или их родные) вполне могут удовлетвориться этими пределами.

Но теперь посмотрим на ситуацию, когда человека убил механизм с нейросетью внутри. Кто будет нести ответственность за это — автор кода нейросети, тот кто производил обучение, тот кто готовил обучающую выборку или ещё кто-то? Найти виновного в данной ситуации практически невозможно. Понятно, что можно сгладить проблему путём страхования рисков, возникающих в следствии работы нейросети. Но страхование никак не закрывает вопрос ответственности, который является основополагающим в саморегуляции человеческого общества.

В принципе, все те же проблемы могут проявляться и с «обычными» автоматами или другим оборудованием, работа которого может влиять на жизнь и здоровье. И проявляются, как в том же Therac-25, например. Но тут хотя бы есть возможность с пристойной достоверностью определить виновника. В случае же с нейросетями такого варианта нет, по крайней мере на настоящий момент.

VenomBlood

16.09.2016 19:38Откуда столько кровожадности? Почему вам обязательно надо найти козла отпущения? А когда на вас метеорит упадет — вы тоже будете искать "виноватого"? А когда подскользнетесь в поле?

Даже если количество смертей от автопилотов будет в точности таким же как количество смертей если бы эти автомобили водили люди — это уже огромный плюс, потому что нам не придется сажать людей которые сонные сели за руль или не заметили светофор. Это же отлично, общество выиграет. Причем тут саморегуляция? Это вообще не в тему. Отсутствие виноватого на самом деле — даже лучше присутствия оного при прочих равных.

old_bear

16.09.2016 23:59>>Откуда столько кровожадности? Почему вам обязательно надо найти козла отпущения?

Где я писал, что это моя личная точка зрения? Или вы подразумеваете, что лично я придумал уголовный кодекс, тюрьмы и вот это всё? Я просто поделился своими, весьма очевидными, наблюдениями об устройстве современного общества. Если вам это устройство не нравится, какой смысл перенаправлять ваше недовольство на меня?

VenomBlood

17.09.2016 00:06Вообще то мир не совсем так устроен. Есть понятие "несчастный случай". Можно даже кого-то убить и быть полностью невиновным. Например если вы запускаете салют (где разрешено), а у соседа от этого инфаркт.

zirix

16.09.2016 21:23> А в водителе автобуса нейросеть используется?

Нет. Искусственная нейронная сеть и мозг имеют очень мало общего.

Кроме того мозг это не только структура из нейронов, но еще и программа/прошивка заложенная при рождении и именно в этой прошивке находится интеллект, а не в нейронах.

Машинным обучением эту прошивку создать невозможно.

VenomBlood

16.09.2016 21:54Не воспринимайте буквально, вроде достаточно очевидно что смысл был в том, что люди тоже ошибаются, водитель может принять тень от птицы за бегущее животное, резко затормозить или перестроитсья и попасть в ДТП, да куча вариантов когда человек может тоже накосячить. Главное в том чтобы во первых ДТП было меньше при полном контроле автоматики и чтобы автоматика ставила всегда жизнь пассажиров своего авто в приоритет.

TimsTims

16.09.2016 01:35+1«Всё, что тяжелее воздуха — летать не может!» (с)

«Искусственный интеллект непостижим!»

ajanami23

16.09.2016 15:13Может, если атмосфера, в которой оно собралось летать, еще более тяжелая (читай плотная).

TimsTims

16.09.2016 16:41Поздравляю с первым комментарием за 3 года! Вам явно стоит прокачать сарказмодетектор.

Hateman31

16.09.2016 19:24Это уже не полет, а плавание какое-то.

Mad__Max

16.09.2016 23:53Ну не зря же полеты на аппаратах легче воздуха (или в более общей формулировки — легче окружающего газа) называются именно воздухоплаванием. До того как появились аппараты тяжелее воздуха был вообще синонимом полета.

dom1n1k

16.09.2016 02:48Я считаю, что в буквальном воплощении — да, ИИ непостижим в сколько-нибудь обозримом будущем (об очень далеком и необозримом не говорим). Но нечто сходное и функционально подменяющее в каких-то задачах — почему бы и нет.

Это похоже на ситуацию с полетом — птичий полет ведь невозможно точно воспроизвести даже сейчас, со всеми современными технологиями. Точнее, можно воспроизвести приблизительно, но это будет очень криво и печально. Однако есть самолеты — устройства не копирующие птиц буквально, устроенные иначе, но тем не менее неплохо исполняющие требуемые от них функции.

dipsy

16.09.2016 08:06+1Не об этом речь, скорее про EmDrive, представьте что он бы работал, давал бы мощную тягу, все бы им пользовались, летали бы, но без малейшего представления за счет чего он работает.

vvadzim

16.09.2016 15:09+1Так уже было. Тысячи лет назад каменные плоты в воде тонули, деревянные плавали. И люди пользовались. А потом появился Архимед и всех посчитал.

Wesha

16.09.2016 02:54+3> Вторая модель работала менее аккуратно, чем первая,

Статья явно была переведена нейросетью, причём недоучившейся.

«Accurate» — это «точный», а не «аккуратный». Соответственно, фраза оригинала «This second, interpretable, model was less accurate than the first» переводится как «эта вторая, обяснимая, модель была менее точной, чем первая.»

Надмозгу привет передавайте.

andrey_aksamentov

16.09.2016 09:18Раньше считал что создать ИИ подобный человеческому невозможно, так как для этого нужно быть умнее человека.

Теперь придерживаюсь теории, что однажды появится гений способный обрисовать как оно должно быть, и основываясь на этом другие гении смогут создать что то работающее…

LittleWolfWerewolf

16.09.2016 10:10А оно обычно так и получается. Долгие-долгие копания, потом взгляд человека с незашоренным взглядом, альтернативный подход — и прорыв.

AlekseiMorozov19730316Ru

16.09.2016 10:09>современное машинное обучение выступает в роли оракула:

>получить точный ответ о том, что случится,

>или же понятное, но неточное объяснение того, что случится?

Это попытка выдать желаемое за действительное и расплывчатая формулировка одновременно. Предсказать точно, «что случится» в действительно сложной системе — невозможно. Можно лишь прогнозировать, что «может случиться».

fivehouse

16.09.2016 10:27Когда при разговоре об ИИ рисуют псевдонейронные сети, показывают распознаваемые картинки, вспоминают статистическое машинное моделирование называя это обучением, аппелируют к IBMам, то можно сразу понять, что видимо для современного распространенного мышления ИИ реально не постижим.

daiver19

16.09.2016 13:30И несмотря на все успехи нейросетей, есть у них и одна проблема: никто, по сути, не знает точно, как они работают

Что значит «не знают»? А алгоритмы обучения наугад придумывали? Сложно объяснить, почему веса именно такие, а не другие, но в самой идее НС нет ничего загадочного.

Даже правительства начинают беспокоиться по поводу растущего влияния непонятных пророков от нейросетей.

Не, ну раз правительства беспокоятся…

Она сначала смотрит на низ картинки, и прекращает смотреть, если находит кровать. Видимо, в наборе начальных данных для тренировки сетей, окна со шторами присутствовали в спальнях.

Ну и о чем это говорит? Правильно, о важности создания правильного тестового набора. Как это относится к теме статьи вообще?

Например, в 1996 году Адриан Томпсон [Adrian Thompson] из Сассекского университета использовал программу для разработки электронного контура, основанную на принципах, схожих с работой нейросетей.… После тысячи итераций по размещению и смене местами радиокомпонентов…

…

При этом несколько из них не были соединены с остальными, но они, каким-то образом, всё равно нужны были для правильной работы контура.

Перевожу на более программистский язык: некий инженер использовал алгоритм оптимизации (не, ну а чо, в НС они тоже используются), который (о чудо) нашел оптимальное решение. При этом в программе решения был баг, из-за которого некоторые компоненты не были соединены с другими.

Дальше не читал, извините.

Wesha

17.09.2016 00:17+1> При этом несколько из них не были соединены с остальными, но они, каким-то образом, всё равно нужны были для правильной работы контура.

Слышал я про эту хохму. Там транзистор оказался подключенным к остальной схеме одной лишь базой — но без него всё отказывалась работать. Тайна оказалась в том, что при таком подключении этот транзистор служил антенной, на которую принималась искомая частота как наводка от плохо заэкранированного БП в соседней комнате.

slavaZim

16.09.2016 15:09Тут какая-то неверная формулировка. Ученые знают, как работают сети, все это формально математически описано и доказано полностью. Непонятно, что происходит в каждом конкретном случае обучения большой масштабной сети. Невозможно интерпретировать получившийся в итоге огромный многомерный массив параметров.

Что касается возможности эксплойта — так наш мозг тоже можно эксплойтить, почитайте о всяких способах вызывать иллюзию, введя мозг в заблужение.

zim32

16.09.2016 18:08А почему нельзя во время обучения сохранить где-то метаданные которые бы говорили какие входные данные привели к каким изменениям весов. А во время работы сети так сказать делать обратное — говорить какие нейроны привели в такому-то результату и почему? Или оно так не работает?

Moog_Prodigy

16.09.2016 21:17Уже какой-то черный ящик получается. Свой мозг понять тоже не можем. То ли мы глупые такие, то ли рекурсия и инертность мышления срабатывает.

Давайте уже договоримся, кто мы есть, и почему водителю автобуса совершать ошибку можно, а НС — нельзя.

wOvAN

Интеллект это на мой взгляд одна из форм эволюции.

Может не стоит пытаться создать готовый интеллект, а разработать систему реализующую эволюцию?

dfgwer

Самый опасный путь создания ИИ. Эволюция беспощадна и безжалостна

Volutar

На самом деле зависит от правил выживания в процессе этой эволюции. Они теоретически могут быть и не основаны на конкуренции и «поглощении». Эгоизм можно извратить.

dfgwer

Да действительно. Хотя не очень хорошо представляю себе как отбирать добрых ИИ, для создания следующего поколения.

Volutar

Природа изобрела очень классную штуку как «пол», которая помогает двигать естественный отбор в направлениях, отличных от тех, которые свойственны бактериям и вирусам.

«Божественная рука сверху» просто не справится с задачей отбора и отсеивания из-за огромного количества объектов, а автоматизация процесса отбора за счёт гендерных различий — вполне может сработать. Достаточно научиться создавать «притягательность» альтруистическим чертам. Надо будет проанализировать всю мотивационную цепочку от инстинктов до альтруизма (в высших когнитивных слоях), и просто внедрить этот инстинкт, ведущий к альтруизму.

Поскольку это будет всё-таки виртуальная среда, то проблемы с тем, чтобы размножить пострадавшего (или даже погибшего) альтруиста не будет проблемой. Да, это будет грубый чит, но почему бы и нет, в качестве эксперимента?

Voliker

Зачем грубо читерить, если можно просто создать серию правил, благодаря которой различным «сущностям» будет выгодно объединяться в группы без внутренней конкуренции? У человечества, например, даже при наличии внутренней конкуренции в группах развились различные кодексы морально-этических правил, а при её отсутствии для ИИ такие кодексы будут не нужны, он и так не будет видеть смысла в нанесении вреда своим «союзникам».