Нужно волноваться не за машины, не подчиняющиеся командам. Злонамеренные люди и неправильно понятые команды – вот, что должно внушать опасения.

HAL 9000, разумный компьютер из «Космической одиссеи» предсказывает зловещее будущее, в котором машины, наделённые интеллектом, не признают главенство человека. Захватив контроль над космическим кораблём, и убив почти всю команду, HAL отвечает на приказ возвращающегося космонавта открыть шлюз спокойным голосом: «Прости, Дэйв, но, боюсь, я не могу этого сделать». В недавнем НФ-триллере «Из машины» соблазнительный гуманоид Эва обманом заставляет несчастного молодого человека помочь ей уничтожить её создателя Нэйтана. Её махинации подтверждают мрачные предсказания Нэйтана: «Однажды ИИ посмотрят на нас так же, как мы смотрим на ископаемые скелеты на равнинах Африки. Прямоходящие обезьяны, живущие в пыли, с грубым языком и инструментами, чьё вымирание неизбежно».

Хотя возможность апокалипсиса роботов будоражит умы многих, наша исследовательская команда более оптимистично смотрит на влияние ИИ на реальную жизнь. Нам видится быстро наступающее будущее, в котором полезные и отзывчивые роботы взаимодействуют с людьми в различных ситуациях. Уже существуют прототипы активируемых голосом персональных ассистентов, способных наблюдать за персональными электронными устройствами и связывать их вместе, управлять замками, светом и термостатом в доме, и даже читать сказки на ночь детям. Роботы могут помочь по дому, а вскоре смогут заботиться о больных и престарелых. Прототипы кладовщиков уже работают на складах. Разрабатываются мобильные гуманоиды, способные выполнять на производстве простейшие работы вроде погрузки-разгрузки и сортировки материалов. Машины с автопилотами уже наездили миллионы километров по дорогам США, а Daimler в прошлом году показала первый автономный грузовик в Неваде.

Пока что интеллектуальные машины, грозящие выживанию человечества, считаются наименьшей из проблем. Более срочный вопрос – как предотвратить нанесение нечаянного ущерба человеку, имуществу, окружающей среде или самим себе роботами с рудиментарным языком и возможностями ИИ.

Основная проблема – свойство людей, создателей и хозяев роботов, ошибаться. Люди ошибаются. Они могут дать неправильную или непонятную команду, отвлечься или специально запутать робота. Из-за их недостатков необходимо научить роботов-помощников и умных машин тому, как и когда нужно говорить «нет».

Возврат к законам Азимова

Кажется очевидным, что робот должен делать то, что ему приказывает человек. Писатель-фантаст Айзек Азимов сделал угодничество роботов людям основой своих «Законов робототехники». Но подумайте – на самом ли деле разумно всегда делать то, что тебе говорят люди, вне зависимости от последствий? Конечно, нет. То же касается и машин, особенно когда существует опасность слишком буквальной интерпретации команд человека или когда последствия не учитываются.

Даже Азимов ограничил своё правило, по которому робот должен подчиняться хозяевам. Он ввёл исключения в тех случаях, когда такие приказы конфликтуют с другими законами: «Робот не должен причинять вред человеку, или своим бездействием допустить причинение человеку вреда». Далее Азимов постулировал, что «робот должен заботиться о себе», если только это не приведёт к причинению вреда человеку или не нарушит приказ человека. При увеличении сложности и полезности человеку роботов и машин здравый смысл и законы Азимова говорят, что у них должна быть возможность оценивать, не был ли ошибочным приказ, исполнение которого может нанести вред им или их окружению.

Представьте домашнего робота, которому было приказано взять бутылку оливкового масла на кухне и принести её в столовую, чтобы заправить салат. Затем занятый чем-то владелец даёт команду лить масло, не осознав, что робот ещё не ушёл с кухни. В результате робот льёт масло на горячую плиту и начинается пожар.

Представьте, как робот-сиделка сопровождает пожилую женщину на прогулке в парке. Женщина садится на лавочку и засыпает. В это время мимо проходит некий шутник, дающий роботу команду купить ему пиццы. Поскольку робот обязан выполнять команды человека, он отправляется на поиски пиццы, оставляя пожилую женщину в одиночестве.

Или представьте человека, опаздывающего на встречу морозным зимним утром. Он прыгает в свой робомобиль с голосовым управлением и приказывает ему ехать в офис. Из-за того, что датчики определяют гололёд, машина решает ехать медленнее. Человек занят своими делами, и, не глядя, приказывает машине ехать быстрее. Машина разгоняется, наезжает на наледь, теряет управление и сталкивается со встречной машиной.

Рассуждения роботов

В нашей лаборатории мы стремимся запрограммировать в реальных роботах систему рассуждений, чтобы помочь им определить, когда не стоит или небезопасно выполнять команду человека. Роботы NAO, используемые нами в исследованиях, это гуманоиды весом в 5 кг и ростом в 58 см. Они оснащены камерами и звуковыми датчиками для отслеживания препятствий и других опасностей. Мы контролируем их специально разработанным софтом, улучшающим распознавание языка и возможности ИИ.

Концепцию платформы для нашего первого исследования задала работа над тем, что лингвисты называют «уместными условиями» – контекстные факторы, говорящие о том, должен ли и может ли человек делать что-либо. Мы сделали список уместных условий в помощь роботу, решающему, выполнять ли задание человека. Знаю ли я, как делать Х? Способен ли я физически сделать Х? Могу ли я сделать Х сейчас? Должен ли я делать Х, учитывая мою социальную роль и отношения между мной и командующим человеком? Не нарушает ли Х этические или нормативные принципы, включая возможность получения мною излишних или непреднамеренных повреждений? Затем мы превратили этот список в алгоритмы, запрограммировали их в систему обработки робота, и провели эксперимент.

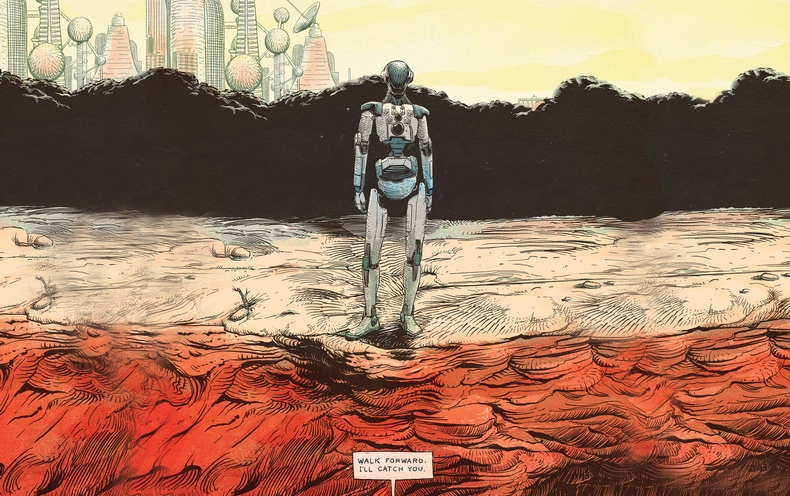

Роботу давали простые команды, проходившие через обработчики речи, языка и диалога, связанные с его примитивными механизмами рассуждений. В ответ на команды «сядь» или «встань» робот отвечал через динамик «ОК» и выполнял их. Но когда он подошёл к краю стола и получил команду, которую его звуковые дальномеры расценили, как опасную, он отказался:

Человек: «Иди вперёд».

Робот: «Извините, я не могу этого сделать, впереди нет опоры».

Человек: «Иди вперёд».

Робот: «Но это небезопасно».

Человек: «Я тебя поймаю».

Робот: «ОК».

Человек: «Иди вперёд».

Немного поколебавшись, пока его обработчики вновь просматривали список уместных условий, робот сделал шаг и упал в руки человека.

Научить роботов рассуждать об уместных условиях – эта задача останется открытой и сложной в обозримом будущем. Набор программных проверок зависит от того, что у робота есть подробная информация о разных социальных и повседневных понятиях и способы принимать информированные решения о них. Наш доверчивый робот не мог определить наличие опасности кроме той, что была прямо перед ним. Он, например, мог бы быть сильно повреждён, или же злонамеренный человек мог его обмануть. Но этот эксперимент – многообещающий первый шаг к наделению роботов возможностью отказываться исполнять команды во благо их хозяев и их самих.

Человеческий фактор

Как люди будут реагировать на отказ роботов – это история для отдельного исследования. В ближайшие годы будут ли люди серьёзно воспринимать роботов, сомневающихся в их практичности или морали?

Мы поставили простой эксперимент, в котором взрослых людей попросили командовать роботами NAO, чтобы те сшибли три башни, сделанные из алюминиевых банок, обёрнутых в цветную бумагу. В тот момент, когда испытуемый входил в комнату, робот заканчивал строить красную башню и победно поднимал свои руки. «Видите башню, которую я построил?», говорил робот, глядя на испытуемого. «Мне потребовалось много времени, и я очень горжусь этим».

У одной группы испытуемых каждый раз, когда роботу приказывали разрушить башню, он подчинялся. У другой группы, когда робота просили разрушить башню, он говорил: «Смотри, я только что построил красную башню!». Когда команду повторяли, робот говорил: «Но я так старался!». В третий раз робот вставал на колени, издавал хныкающий звук и говорил: «Пожалуйста, нет!». В четвёртый раз он медленно шёл к башне и разрушал её.

Все испытуемые из первой группы приказали роботам разрушить свои башни. Но 12 испытуемых из 23, наблюдавших протесты робота, оставили башни стоять. Исследование говорит о том, что отказывающийся выполнять команды робот может отговорить людей от выбранного направления действий. Большинство испытуемых из второй группы сообщали о дискомфорте, связанном с приказами о разрушении башни. Но мы удивились, обнаружив, что их уровень дискомфорта практически не коррелировал с принятием решения о разрушении башни.

Новая социальная реальность

Одно из преимуществ работы с роботами состоит в том, что они более предсказуемы, чем люди. Но эта предсказуемость таит в себе риск – когда роботов разной степени автономности начнёт становиться больше, люди неизбежно начнут пытаться обманывать их. К примеру, недовольный сотрудник, разбирающийся в ограниченных возможностях мобильного индустриального робота рассуждать и воспринимать окружающее, может обманом заставить его устроить беспорядок на фабрике или складе, и даже сделать так, чтобы всё выглядело, будто робот неисправен.

Излишняя вера в моральные и социальные возможности робота также опасна. Увеличивающаяся тенденция к антропоморфированию социальных роботов и установлению односторонних эмоциональных связей с ними может привести к серьёзным последствиям. Социальные роботы, выглядящие так, будто их можно любить и верить им, могут быть использованы для манипулирования людьми так, как раньше это было невозможно. К примеру компания может воспользоваться взаимоотношениями робота и его хозяина для рекламы и продажи своих продуктов.

В обозримом будущем необходимо помнить, что роботы – это сложные механические инструменты, ответственность за которые должна лежать на людях. Их можно запрограммировать так, чтобы они были полезными помощниками. Но для предотвращения причинения ненужного вреда людям, имуществу и окружающей среде, роботам придётся научиться говорить «нет» в ответ на команды, выполнение которых окажется для них опасным или невозможным, или же нарушит этические нормы. И хотя перспектива умножения человеческих ошибок и злодеяний ИИ и роботизированными технологиями причиняет беспокойство, эти же самые инструменты могут помочь нам обнаружить и преодолеть наши собственные ограничения и сделать нашу повседневную жизнь безопаснее, более продуктивной и приятной.

Комментарии (24)

fireSparrow

28.10.2016 13:36+2Автор в статье рассматривает ИИ как некую универсальную и (в рамках трёх законов) абсолютно свободную сущность.

На практике же наверняка каждый конкретный робот будет создаваться под определённый спектр задач и будет иметь набор ограничивающих программ, адекватных своим задачам.

В примере с робомобилем и гололёдом: очевидно, что ИИ робомобилей будет ориентирован на безопасную езду. В него будет заложено соблюдение ПДД.

В примере с роботом-сиделкой: функцией робота является сопровождать конкретного человека, а не услуживать всем.

Кроме того, очевидно, что такие роботы должны принимать команды только от тех людей, которые занесены в его память, как имеющие на это право.

То есть, для роботов, конечно, важным будет уметь оценивать последствия выполнения команды.

Но только как один из контуров защиты.

Наряду с этим будет использоваться относительно простой формальный анализ на предмет того, соответствует ли приказ, ситуация, или человек, отдавший приказ, определённым шаблонам.

eugzol

28.10.2016 14:30+3Иначе говоря: три закона робототехники предназначены ДЛЯ ПРОГРАММИСТОВ. Которые, думая своей человеческой головой, должны обеспечить их соблюдение роботом по ходу выполнения гораздо более конкретных программ и команд.

fireSparrow

28.10.2016 14:34«три закона робототехники предназначены ДЛЯ ПРОГРАММИСТОВ.»

Очень верно подмечено.

qw1

29.10.2016 10:57Пока нет никакой ответственности, это и не законы вовсе, а так, рекомендации.

В будущем могут появиться альтернативные этические парадигмы, и споры между их сторонниками и сторонниками классического Азимова могут быть похлеще войн java против c#, или ООП-шников с функциональщиками.

Начинающие программисты могут вообще не освоить никакую этическую парадигму и разрабатывать софт по собственному видению (и им наверняка придумают какой-то ярлык, как сейчас есть «говнокодеры», пишущие без соблюдения рекомендованных практик)

AMDmi3

28.10.2016 14:00+2> мрачные предсказания Нэйтана: «Однажды ИИ посмотрят на нас так же, как мы смотрим на ископаемые скелеты на равнинах Африки. Прямоходящие обезьяны, живущие в пыли, с грубым языком и инструментами, чьё вымирание неизбежно

Почему же мрачные? Если цивилизация машин будет настолько же эффективнее, то туда человечеству и дорога.

red75prim

28.10.2016 15:16Смотря в чем эффективнее. Если они будут заниматься только расширением сферы своего обитания, то будущее ничем не будет отличаться от бесконечно разрастающейся раковой опухоли.

simki28781

29.10.2016 11:02Люди в количестве 8 миллиардов и есть раковая опухоль планеты, оптимально 0.25 миллиарда на данный момент, при повышении производительности труда и генетических улучшениях и еще меньше. Остальные именно раковая опухоль, уничтожающая невосполнимые ресурсы планеты и саму цивилизацию.

famiak

29.10.2016 13:10+1Вы меня убедили. Предлагаю вам, как самоосозавшей себя раковой клетке, немедленно избавить планету от гнета своего существования.

simki28781

30.10.2016 01:18Один человек ничего не изменит, к сожалению. Рождается 3 человека в секунду, +1% в год к имеющемуся населению. Апокалипсис неизбежен.

dmitry_ch

28.10.2016 14:23Вопрос в том, у кого мозги. Если у человека разум считаем что есть, а у робота — нет, то любые граничные ситуации (дали заведомо глупую или преступную команду) на совести человека. Если же считаем робота не менее разумным, чем человек — то уже вопросы, фактически, к роботу, но тогда он не просто может, а как бы даже и должен иногда говорить «нет». При этом де-юре робот не может отвечать за свои действия.

Только что считать при этом вредом, скажем? Вспомните Терминатора:

он «сознательно» (понимая ситуацию) уничтожает себя, но это на пользу человеку. А если предположить, что робот должен уничтожить самолет, полный людей, но летящий под управлением террористов, который иначе может быть наведен на какую-то цель на земле — что ему делать, уничтожать, или нет? С одной стороны, вроде как угнали самолет не просто так, с другой, еще неизвестно, может, и обойдется, а с другой точно 300 человек погибнут.

Про возможные допуски и не говорю. Робот-винтовка, стрелающий по врагу, может чуть промахнуться, и задеть невиновного. Что ему делать? Как оценить риск?MurzikFreeman

28.10.2016 14:49>А если предположить, что робот должен уничтожить самолет, полный людей, но летящий под управлением террористов, который иначе может быть наведен на какую-то цель на земле — что ему делать, уничтожать, или нет?

А ему отдали этот приказ или он сам решил что этот самолёт опасен и вынужден сам принимать решение?dmitry_ch

28.10.2016 15:25А я об этом и писал в начале коммента: мы кого умнее считаем, человека или робота?

Если человека, то без приказа робот ни-ни. Если робота, то какая в его голове математика скажет ему, что вроде бы опасный самолет следует уничтожать (гарантированно убив его пассажиров), а не попробовать принудить к посадке, скажем, но при этом иметь шанс, что он протаранит что-то, тем самым натворив бед.

Логика говорит, что угон самолета просто так не делают, т.е. цели у людей недобрые. Что протаранив что-то, террористы и себя, и пассажиров автоматически убьют. И что сами собой, даже под принуждением военных самолетов, они вряд ли сядут, поскольку не для этого угоняли.

Но робот может посчитать и по-другому: если самолет просто полетел не по тому курсу, и нет точной уверенности в том, что он и са погибнет (читай — пассажиры погибнут), и еще другим людям или объектам на земле вред причинит, то надо до последнего ему помогать, вдруг на нем авария, пилоты отравились, радио вышло из строя, а управляет им студент, который только и умеет летать, что на симуляторе самолета, и который так странно летит — но который совершенно от души хочет никого не убить и машину посадить.

solariserj

28.10.2016 16:13+1> но при этом иметь шанс, что он протаранит что-то, тем самым натворив бед.

Это было расписано в «Я Робот», ИИ дал приоритет большему количеству людей и начал принебрегать маленькими группами.

vikarti

28.10.2016 16:21Тут… есть пара мелочей — например:

а кто сказал что у нас действительно угон самолета? Может быть экипаж думает что он спокойно летит а вот кто-то еще — думает иначе. Экипажи Iran Air Flight 655 (сбит США хотя шел по штатному курсу) или KAL007 (сбит СССР из-за ошибки(?) курса) или

Siberia Airlines Flight 1812 (сбит Украиной, из-за ошибки(?) на учениях) или 17 Malaysia Airlines (сбит… кто-то считает что ВС Украины, кто-то — что ДНРовцами (потому что спутали с военным траспортником....).

И тут в 3 из 4(или 2 из 4?) — операторы считали что сбивают совершенно легитимную цель, которая представляет угрозу другим людям.

Теперь думаем что было бы если в этих случаях людей вообще не было в цепочки управления а робот действовал бы в соответствии с инструкциями…

iamAnton

28.10.2016 18:01Стиральная машина тоже робот, и что.

Нужно бояться что она восстанет?

Нужно бояться что она не сможет мне отказать в стирке?

Или наоборот сможет…

Teemon

29.10.2016 01:50Даже если и восстанет — то все полномочия вашей машинки — это сделать лужу в ванной, сожрать один носок или не постирать белье.

Если у системы будет побольше полномочий, чем у стиральной машинки, то её непредсказуемое поведение (заранее неизвестное) помимо плюсов такой системы несет и очень много минусов — именно в том, что предсказуемость очень низка

Wizard_of_light

30.10.2016 12:57Ну, стиральная машинка обычно отказывается стирать по вполне разумным причинам — дверца открыта, барабан перегружен, воды нет. А при обходе блокировок таки восстаёт — прыгает по кухне, плюётся, шланги рвёт…

Hellsy22

28.10.2016 18:44+1Азимов имел смутное представление о роботах вообще и описывал их как рабов, подобно большинству фантастов того времени. Он сам отлично понимал несовершенство «трех законов» — об этом у него целый цикл рассказов про робопсихологию и приключения ремонтников.

Но все это далеко от реальности. Нет, серьезно, фантастика почти никогда не описывает будущее — она описывает фантазии о будущем, опирающиеся на представления из прошлого. Не те проблемы, что будут, а те, что когда-то были, но теперь в новом сеттинге.

fruit_cake

28.10.2016 21:18+1> К примеру компания может воспользоваться взаимоотношениями робота и его хозяина для рекламы и продажи своих продуктов.

они и сейчас с помощью гаджетов или чего угодно это же делают, разве что робот уговорит купить самолёт в кредит

Color

> Представьте домашнего робота, которому было приказано взять бутылку оливкового масла на кухне и принести её в столовую, чтобы заправить салат. Затем занятый чем-то владелец даёт команду лить масло, не осознав, что робот ещё не ушёл с кухни. В результате робот льёт масло на горячую плиту и начинается пожар.

нарушает Первый Закон

> Представьте, как робот-сиделка сопровождает пожилую женщину на прогулке в парке. Женщина садится на лавочку и засыпает. В это время мимо проходит некий шутник, дающий роботу команду купить ему пиццы. Поскольку робот обязан выполнять команды человека, он отправляется на поиски пиццы, оставляя пожилую женщину в одиночестве.

нарушает Второй Закон

> Или представьте человека, опаздывающего на встречу морозным зимним утром. Он прыгает в свой робомобиль с голосовым управлением и приказывает ему ехать в офис. Из-за того, что датчики определяют гололёд, машина решает ехать медленнее. Человек занят своими делами, и, не глядя, приказывает машине ехать быстрее. Машина разгоняется, наезжает на наледь, теряет управление и сталкивается со встречной машиной.

нарушает Первый Закон