Новое поколение железа в лице GTX 1080 и 1070 буквально похоронило результаты прошлогодних систем и рынок флагманского б/у железа, а «младшие» линейки в лице GTX 1060 и 1050 закрепили успех в более доступных сегментах. Владельцы GTX980Ti и прочих Titan’ов рыдают крокодильими слезами: их убер-пушки за много тысяч рублей разом потеряли 50% стоимости и 100% понтов. Сама NVIDIA заявляет, что 1080 быстрее, чем прошлогодний TitanX, 1070 легко «наваляет» 980Ti, а сравнительно бюджетная 1060 сделает больно владельцам всех остальных карточек.

Так ли это, откуда растут ноги высокой производительности и что с этим всем делать в преддверии праздников и внезапных финансовых радостей, а также чем именно себя порадовать, можно узнать в этой длинной и немного занудной статье.

Компанию Nvidia можно любить или… не любить, но отрицать то, что именно она в данный момент является лидером в области видеокартостроения станет только попаданец из альтернативной вселенной. Так как Vega от AMD ещё не анонсирована, флагманские RX’ы на Polaris’е мы так и не увидели, а R9 Fury с её 4 Гб экспериментальной памяти откровенно не может считаться перспективной карточкой (VR и 4K, всё же, захотят чуть больше, чем у неё есть) — имеем что имеем. Пока 1080 Ti и условные RX 490, RX Fury и RX 580 являются лишь слухами да ожиданиями, у нас с вами есть время разобраться в текущей линейке NVIDIA и посмотреть, чего достигла компания за последние годы.

Бардак и история происхождения Pascal’я

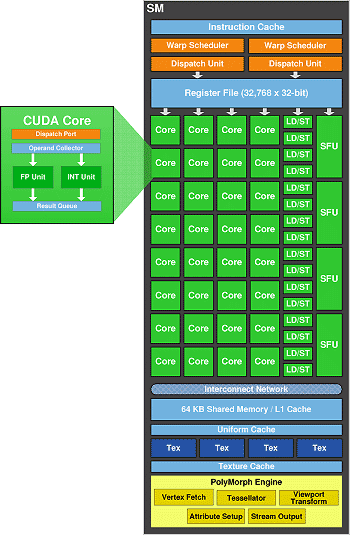

NVIDIA регулярно даёт поводы «не любить себя». История с GTX 970 и её «3.5 Гб памяти», «NVIDIA, Fuck you!» от Линуса Торвальдса, полная порнография в линейках десктопной графики, отказ от работы с бесплатной и куда более распространённой системой FreeSync в пользу своей проприетарщины… В общем, поводов хватает. Один из самых раздражающих лично меня — это то, что было с прошлыми двумя поколениями видеокарт. Если брать грубую характеристику, то «современные» графические процессоры пошли со времён поддержки DX10. А если искать «дедушку» 10-й серии сегодня, то начало современной архитектуры будет в районе 400-й серии видеоускорителей и архитектуры Fermi. Именно в нём окончательно сформировалась идея «блочной» конструкции из т.н. «ядер CUDA» в терминологии NVIDIA.

Fermi

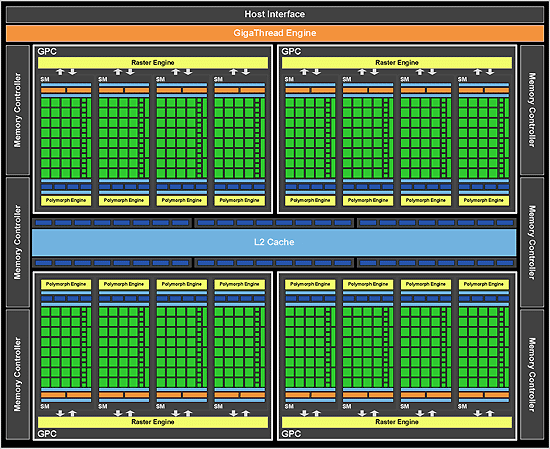

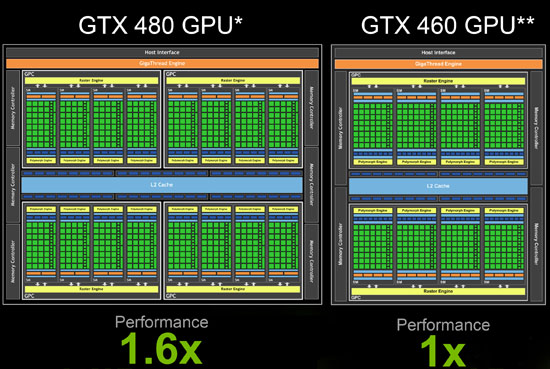

Если видеокарты 8000-й, 9000-й и 200-й серий были первыми шагами в освоение самого понятия, «современной архитектуры» с универсальными шейдерными процессорами (как у AMD, да), то 400-я серия уже была максимально похожа на то, что мы видим в какой-нибудь 1070. Да, у Fermi остался небольшой Legacy-костыль от прошлых поколений: шейдерный блок работал на удвоенной частоте ядра, отвечавшего за расчёт геометрии, но общая картинка у какой-нибудь GTX 480 не сильно отличается от какой-нибудь 780-й, мультипроцессоры SM объединены в кластеры, кластеры общаются через общий кеш с контроллерами памяти, а результаты работы выводит общий для кластера блок растеризации:

Блок-схема процессора GF100, использовавшегося в GTX 480.

В 500-й серии был всё тот же Fermi, чуть улучшенный «внутри» и с меньшим количеством брака, так что топовые решения получили 512 CUDA-ядер вместо 480 у предыдущего поколения. Визуально же блок-схемы вообще кажутся близнецами:

GF110 — сердце GTX 580.

Кое-где поднарастили частоты, чуть изменили дизайн самого чипа, никакой революции не было. Всё те же 40 нм техпроцесс и 1.5 ГБ видеопамяти на 384-битной шине.

Kepler

С приходом архитектуры Kepler изменилось многое. Можно сказать, что именно это поколение дало видеокартам NVIDIA тот вектор развития, который привёл к возникновению текущих моделей. Изменилась не только архитектура GPU, но и сама кухня разработки нового железа внутри NVIDIA. Если Fermi был направлен на поиск решения, которое обеспечит высокую производительность, то Kepler сделал ставку на энергоэффективность, разумное использование ресурсов, высокие частоты и простоту оптимизации игрового движка под возможности высокопроизводительной архитектуры.

В дизайне GPU были произведены серьёзные изменения: за основу взяли не «флагманский» GF100 / GF110, а «бюджетный» GF104 / GF114, использовавшейся в одной из самых популярных карточек того времени — GTX 460.

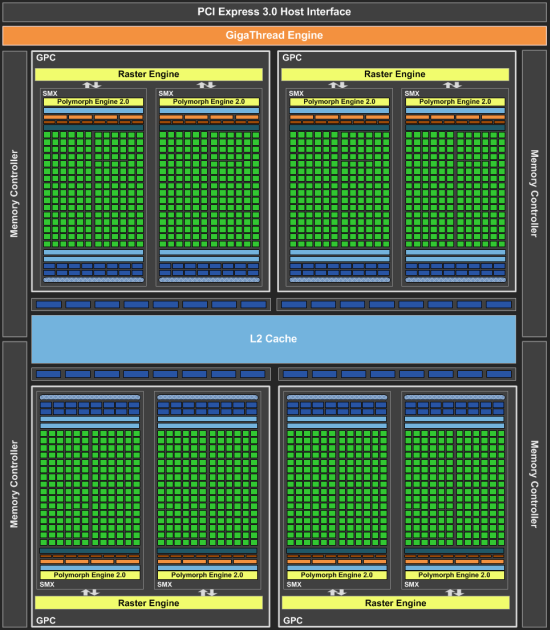

Общая архитектура процессора стала проще за счёт использования всего двух больших блоков с четырьмя унифицированными модулями шейдерных мультипроцессоров. Выглядела разводка новых флагманов примерно так:

GK104, установленный в GTX 680.

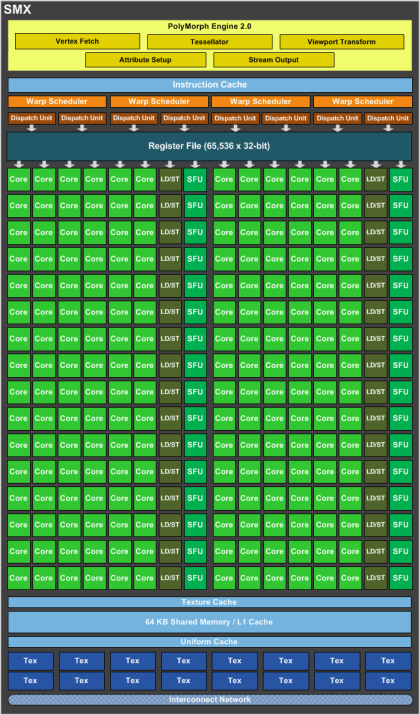

Как вы видите, каждый из вычислительных блоков существенно прибавил в весе относительно прошлой архитектуры, и был назван SMX. Сравните строение блока с тем, что изображено выше, в разделе Fermi.

Мультипроцессор SMX графического процессора GK104

Шестисотая серия не имела видеокарт на полноценном процессоре, содержащем шесть блоков вычислительных модулей, флагманом была GTX 680 с установленным GK104, а круче неё — только «двухголовая» 690-я, на которой было разведено просто два процессора со всей необходимой обвязкой и памятью. Спустя год флагман GTX 680 с незначительными изменениями превратился в GTX 770, а венцом эволюции архитектуры Kepler стали видеокарты на базе кристалла GK110: GTX Titan и Titan Z, 780Ti и обычная 780. Внутри — всё те же 28 нанометров, единственное качественное улучшение (которое НЕ досталось консьюмерским видеокартам на базе GK110) — производительность с операциями двойной точности.

Maxwell

Первой видеокартой на архитектуре Maxwell стала… NVIDIA GTX 750Ti. Чуть позже появились её обрезки в лице GTX 750 и 745 (поставлялась только как встроенное решение), и на момент появления младшие карточки реально встряхнули рынок недорогих видеоускорителей. Новая архитектура обкатывалась на чипе GK107: крохотном кусочке будущих флагманов с огромными радиаторами и пугающей ценой. Выглядел он примерно так:

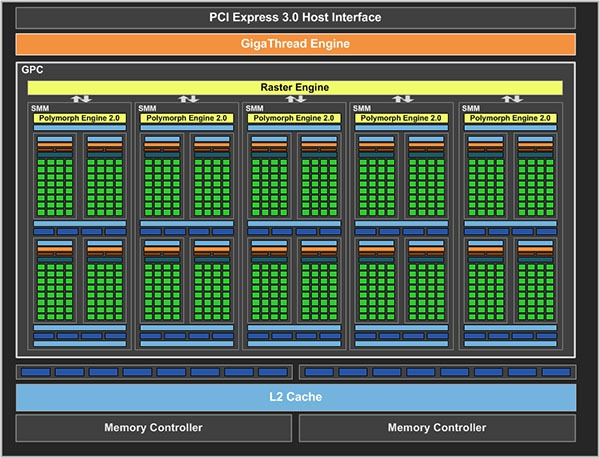

Да, всего один вычислительный блок, но насколько сложнее он устроен, нежели у предшественника, сравните сами:

Вместо крупного блока SMX, который использовался как базовый «строительный кирпичик» в создании GPU используются новые, более компактные блоки SMM. Базовые вычислительные блоки Kepler’а были хороши, но страдали от плохой загрузки мощностей — банальный голод инструкций: раскидать инструкции по большому количеству исполнительных элементов система не могла. Примерно те же проблемы были у Pentium 4: мощность простаивала, а ошибка в предсказании ветвлений стоила очень дорого. В Maxwell’е каждый вычислительный модуль разделили на четыре части, выделив каждой из них собственный буфер инструкций и планировщик варпов — однотипных операций над группой потоков. В результате эффективность выросла, а сами графические процессоры стали гибче, чем их предшественники, а самое главное — ценой малой крови и достаточно простого кристалла отработали новую архитектуру. История развивается по спирали, хе-хе.

Больше всего от нововведений выиграли мобильные решения: площадь кристалла выросла на четверть, а количество исполнительных блоков мультипроцессоров — почти вдвое. Как назло, именно 700-я и 800-я серии устроили основной бардак в классификации. Внутри одной только 700-й встречались видеокарты на архитектурах Kepler, Maxwell и даже Fermi! Именно поэтому десктопные Maxwell’ы, чтобы отстраниться от мешанины в предыдущих поколениях, получили общую серию 900, от которой впоследствии отпочковались мобильные карточки GTX 9xx M.

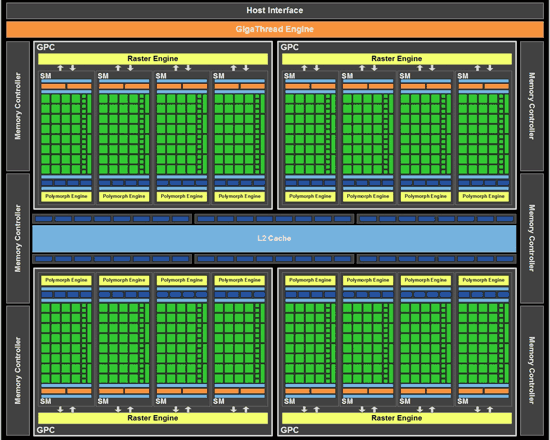

Pascal — логическое развитие архитектуры Maxwell

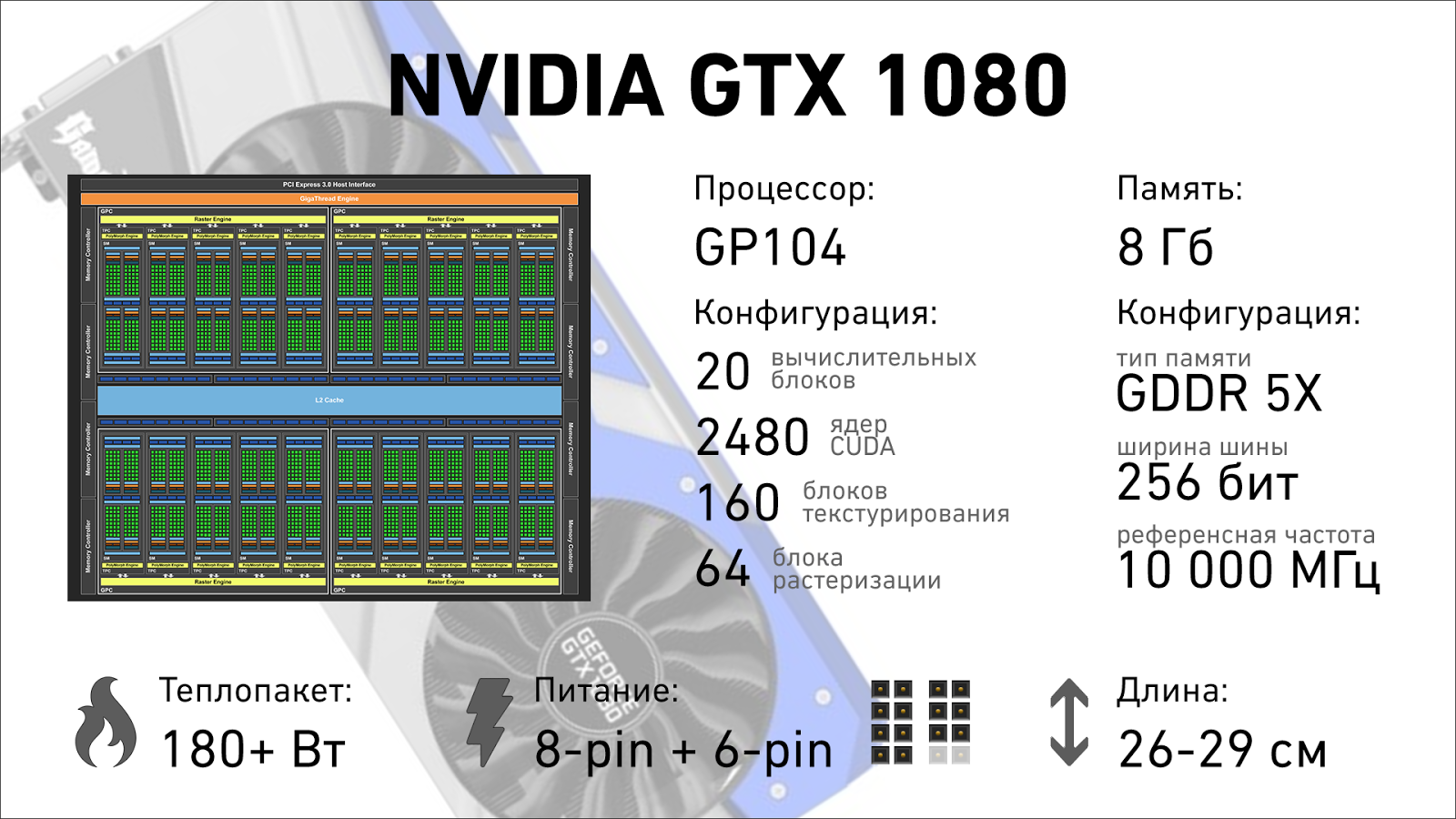

То, что было заложено в Kepler’е и продолжено в поколении Maxwell осталось и в Pascal’ях: первые потребительские видеокарты выпущены на базе не самого крупного чипа GP104, который состоит из четырёх кластеров обработки графики. Полноразмерный, шестикластерный GP100 достался дорогущему полупрофессиональному GPU под маркой TITAN X. Впрочем, даже «обрезанная» 1080 зажигает так, что прошлым поколениям становится дурно.

Улучшение производительности

Основа основ

Maxwell стал фундаментом новой архитектуры, диаграмма сравнимых процессоров (GM104 и GP104) выглядит почти одинаково, основное отличие — количество упакованных в кластеры мультипроцессоров. В Kepler’е (700-е поколение) было два больших мультипроцессора SMX, которые разделили на 4 части каждый в Maxwell’е, снабдив необходимой обвязкой (сменив название на SMM). В Pascal’е к имеющимся восьми в блоке добавили ещё два, так что их стало 10, а аббревиатуру в очередной раз перебили: теперь единичные мультипроцессоры вновь называются SM.

В остальном — полное визуальное сходство. Правда, внутри изменений стало ещё больше.

Двигатель прогресса

Изменений внутри блока мультипроцессоров неприлично много. Дабы не вдаваться в совсем уж занудные подробности того, что переделали, как оптимизировали и как было раньше, опишу изменения совсем коротко, а то некоторые и так уже зевают.

Перво-наперво Pascal’ям поправили ту часть, которая отвечает за геометрическую составляющую картинки. Это необходимо для мультимониторных конфигураций и работы с VR-шлемами: при должной поддержке со стороны игрового движка (а усилиями NVIDIA эта поддержка быстро появится) видеокарта может один раз посчитать геометрию и получить несколько проекций геометрии для каждого из экранов. Это существенно снижает нагрузку в VR не только в области работы с треугольниками (тут прирост просто двукратный), но и в работе с пиксельной составляющей.

Условная 980Ti будет считать геометрию дважды (для каждого глаза), а затем заполнять текстурами и выполнять пост-обработку для каждого из изображений, обработав в сумме порядка 4.2 миллиона точек, из которых реально использоваться будет около 70%, остальное будет отрезано или попадёт в область, которая попросту не отображается для каждого из глаз.

1080 обработает геометрию единожды, а пиксели, которые не попадут в итоговое изображение просто не будут рассчитываться.

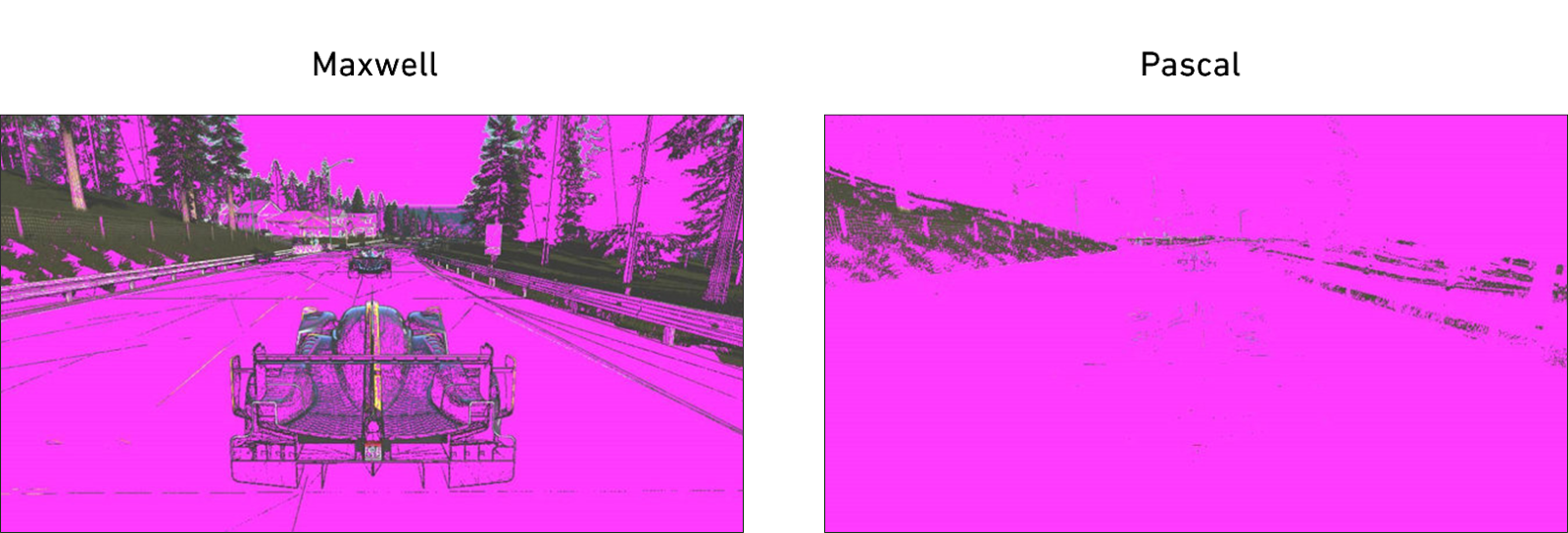

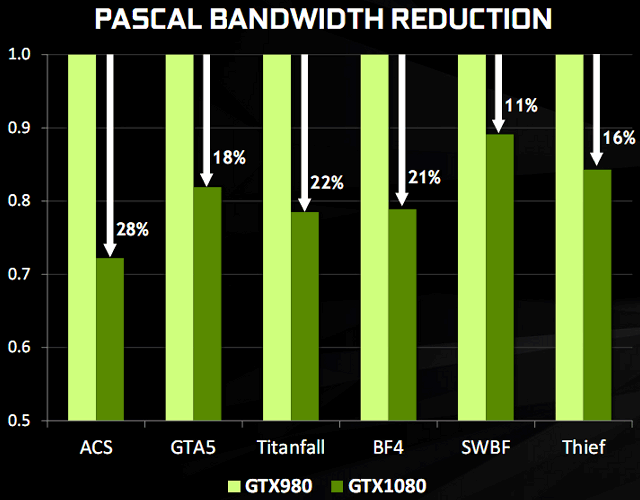

С пиксельной составляющей всё, на самом деле, ещё круче. Так как наращивание пропускной способности памяти можно вести только по двум фронтам (увеличение частоты и пропускной способности за такт), и оба способа стоят денег, а «голод» GPU по части памяти всё явственней выражен с годами из-за роста разрешения и развития VR остаётся улучшать «бесплатные» методы увеличения пропускной способности. Если нельзя расширить шину и поднять частоту — надо сжать данные. В предыдущих поколениях аппаратное сжатие уже было внедрено, но в Pascal его вывели на новый уровень. Опять же, обойдёмся без скучной математики, и возьмём готовый пример от NVIDIA. Слева — Maxwell, справа — Pascal, залиты розовым цветом те точки, чья цветовая составляющая подвергалась сжатию без потерь качества.

Вместо передачи конкретных тайлов 8х8 точек, в памяти находится «средний» цвет + матрица отклонений от него, такие данные занимает от ? до ? объёма исходных. В реальных задачах нагрузка на подсистему памяти снизилась от 10 до 30%, в зависимости от количества градиентов и равномерности заливок в сложных сценах на экране.

Этого инженерам показалось мало, и для флагманской видеокарты (GTX 1080) использована память с повышенной пропускной способностью: GDDR5X передаёт вдвое больше бит данных (не инструкций) за такт, и выдаёт в пике более 10 Гбит/с. Передача данных с такой сумасшедшей скоростью потребовала полностью новой топологии разводки памяти на плате, а в сумме эффективность работы с памятью выросла на 60-70% по сравнению со флагманами прошлого поколения.

Уменьшение задержек и простоя мощностей

Видеокарты давно занимаются не только обработкой графики, но и сопутствующими вычислениями. Физика часто привязана к кадрам анимации и замечательно параллелится, а значит намного эффективнее считается на GPU. Но самым большим генератором проблем за последнее время стала VR-индустрия. Многие игровые движки, методологии разработки и куча других технологий, используемых для работы с графикой просто не были рассчитаны на VR, случай перемещения камеры или изменения положения головы пользователя в процессе отрисовки кадра просто не обрабатывался. Если оставить всё как есть, то рассинхронизация видеопотока и ваших движений будет вызывать приступы морской болезни и попросту мешать погружению в игровой мир, а значит «неправильные» кадры просто приходится выбрасывать после отрисовки и начинать работу сначала. А это — новые задержки в выводе картинки на дисплей. Положительным образом на производительности это не сказывается.

В Pascal’е учли эту проблему и внедрили динамическую балансировку нагрузки и возможность асинхронных прерываний: теперь исполнительные блоки могут либо прервать текущую задачу (сохранив результаты работы в кеш) для обработки более срочных задач, либо попросту сбросить недорисованный кадр и заняться новым, значительно снижая задержки в формировании изображения. Основной бенефициар здесь, само собой, VR и игры, но и с расчётами общего назначения данная технология может помочь: симуляция столкновения частиц получила прирост производительности в 10-20%.

Boost 3.0

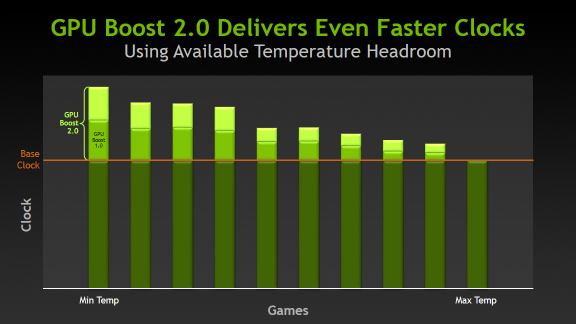

Автоматический разгон видеокарты NVIDIA получили достаточно давно, ещё в 700-м поколении на базе архитектуры Kepler. В Maxwell’е разгон улучшили, но он всё равно был мягко говоря так себе: да, видеокарта работала чуть быстрее, пока это позволял теплопакет, зашитые с завода дополнительные 20-30 мегагерц по ядру и 50-100 по памяти давали прирост, но небольшой. Работало это примерно так:

Даже если по температуре GPU был запас, производительность не росла. С приходом Pascal инженеры перетряхнули и это пыльное болото. Boost 3.0 работает по трём фронтам: анализ температуры, повышение тактовой частоты и повышение напряжения на кристалле. Теперь из GPU выжимаются все соки: стандартные драйвера NVIDIA этого не делают, а вот софт вендоров позволяет в один клик построить профилирующую кривую, которая будет учитывать качество конкретно вашего экземпляра видеокарты.

Одной из первых на этом поприще стала компания EVGA, её утилита Precision XOC имеет сертифицированный NVIDIA сканер, который последовательно перебирает весь диапазон температур, частот и напряжений, добиваясь максимальной производительности на всех режимах.

Добавьте сюда новый техпроцесс, высокоскоростную память, всяческие оптимизации и снижение теплопакета чипов, и результат будет просто неприличный. C 1500 «базовых» МГц у GTX 1060 можно выжать больше 2000 МГц, если попадётся хороший экземпляр, а вендор не облажается с охлаждением.

Улучшение качества картинки и восприятия игрового мира

Производительность увеличили по всем фронтам, но есть ряд моментов, в которых качественных изменений не было несколько лет: в качестве выводимой картинки. И речь идёт не о графических эффектах, их обеспечивают разработчики игр, а о том, что именно мы видем на мониторе и то, как выглядит игра для конечного потребителя.

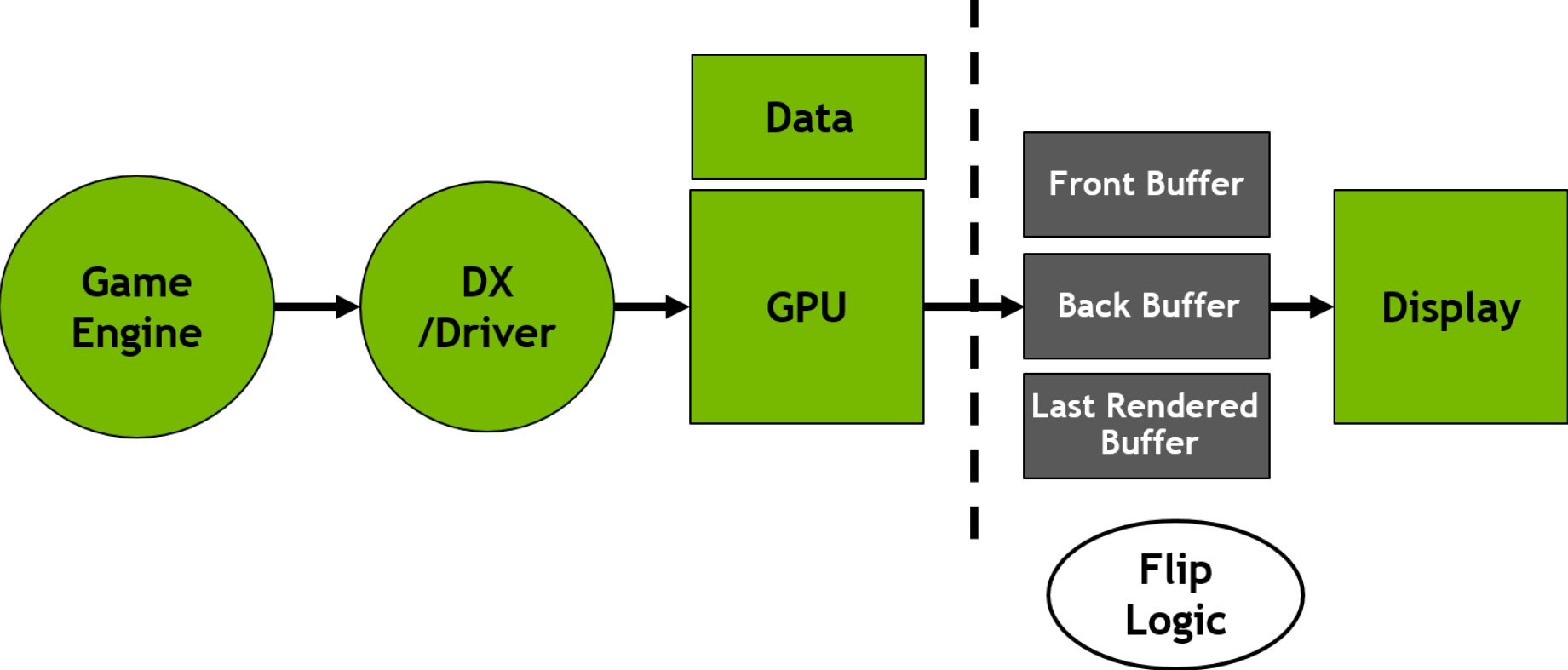

Быстрая вертикальная синхронизация

Самая главная фишка Pascal’я — тройной буфер для вывода кадров, обеспечивающий одновременно сверхнизкие задержки в отрисовке и обеспечение вертикальной синхронизации. В одном буфере хранится выводимое изображение, в другом — последний отрисованный кадр, в третьем — рисуется текущий. Прощайте, горизонтальные полосы и разрывы кадров, здравствуй, высокая производительность. Задержек, которые устраивает классический V-Sync здесь нет (так как никто не сдерживает производительность видеокарты и она всегда рисует с максимально возможной частотой кадра), а на монитор отправляются только полностью сформированные кадры. Я думаю, что после нового года напишу отдельный большой пост про V-Sync, G-Sync, Free-Sync и вот этот новый алгоритм быстрой синхронизации от Nvidia, слишком уж много подробностей.

Нормальные скриншоты

Нет, те скрины, что есть сейчас — это просто позор. Почти все игры используют кучу технологий, чтобы картинка в движении поражала и захватывала дух, и скриншоты стали реальным кошмаром: вместо потрясающе реалистичной картинки, складывающейся из анимации, специальных эффектов, эксплуатирующих особенности человеческого зрения, вы видите какое-то угловатое непойми что со странными цветами и абсолютно безжизненной картинкой.

Новая технология NVIDIA Ansel решает проблему со скринами. Да, её имплементация требует интеграцию специального кода от разработчиков игр, но реальных манипуляций там минимум, а вот профит громадный. Ansel умеет ставить игру на паузу, передаёт управление камерой в ваши руки, а дальше — простор для творчества. Можно просто сделать кадр без GUI и полюбившемся вам ракурсе.

Можно отрисовать имеющуюся сцену в ультра-высоком разрешении, снимать 360-градусные панорамы, сшивать их в плоскость или оставлять в трёхмерном виде для просмотра в VR-шлеме. Сделать фотографию с 16 битами на канал, сохранить её в своеобразном RAW-файле, а дальше играть с экпозицией, балансом белого и прочими настройками так, что скриншоты вновь станут привлекательными. Ждём тонны крутого контента от фанатов игр через год-другой.

Обработка звука на видеокарте

Новые библиотеки NVIDIA Gameworks добавляют множество фич, доступных разработчикам. В основном они нацелены на VR и ускорение различных вычислений, а также повышение качества картинки, но одна из фич наиболее интересна и достойна упоминания. VRWorks Audio выводит работу со звуком на принципиально новый уровень, считая звук не по банальным усреднённым формулам, зависящим от расстояния и толщины препятствия, но выполняет полную трассировку звукового сигнала, со всеми отражениями от окружения, реверберацией и поглощением звука в различных материалах. У NVIDIA есть хороший видео-пример на тему того, как работает эта технология:

Смотреть лучше в наушниках

Чисто теоретически, ничто не мешает запускать такую симуляцию на Maxwell’е, но оптимизации по части асинхронного выполнения инструкций и новая система прерываний, заложенные в Pascal’ях, позволяет проводить расчёты, не сильно влияя на кадровую частоту.

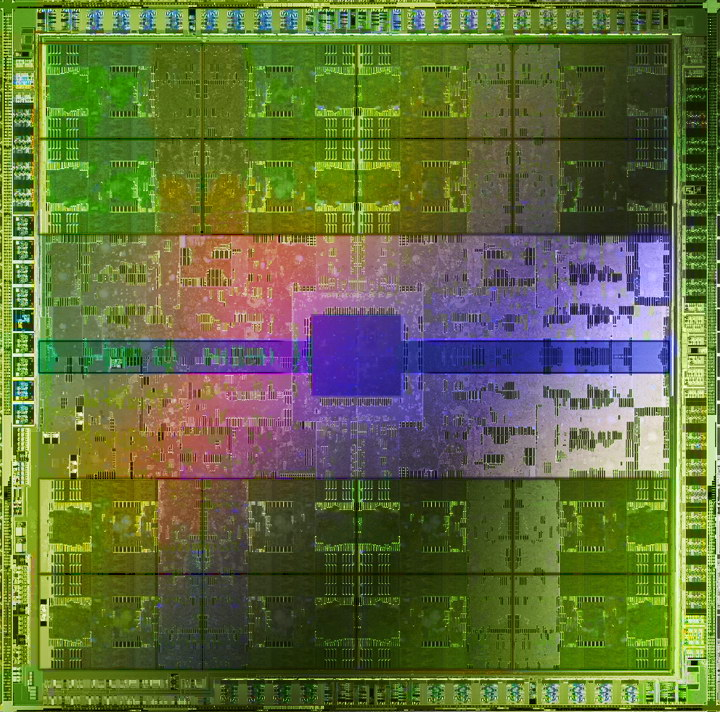

Паскаль в сумме

Изменений, на самом деле, ещё больше, и многие из них настолько глубоко в архитектуре, что по каждому из них можно написать огромную статью. Ключевые новшества — улучшенный дизайн самих чипов, оптимизация на самом низком уровне в части геометрии и асинхронной работы с полной обработкой прерываний, множество фич, заточенных на работу с высокими разрешениями и VR, и, разумеется, безумные частоты, которые не снились прошлым поколениям видеокарт. Два года назад 780 Ti едва перешагнула рубеж в 1 ГГц, сегодня 1080 в ряде случаев работает на двух: и здесь заслуга не только в уменьшенном с 28 нм до 16 или 14 нм техпроцессе: многие вещи оптимизированы на самом низком уровне, начиная с дизайна транзисторов, заканчивая их топологией и обвязкой внутри самого чипа.

Для каждого отдельного случая

Линейка видеокарт NVIDIA 10-й серии получилась по-настоящему сбалансированной, и достаточно плотно покрывает все игровые юз-кейсы, от варианта «в стратегии и диаблу играть» до «хочу топ-игры в 4k». Игровые тесты выбраны по одной простой методике: охватить как можно больший диапазон испытаний как можно меньшим набором тестов. BF1 — отличный пример хорошей оптимизации и позволяет сравнить в одинаковых условиях производительность DX11 против DX12. DOOM выбран по той же причине, только позволяет сравнить OpenGL и Vulkan. Третий «Ведьмак» здесь выступает в роли так-себе-оптимизированной-игрушки, в которой максимальные настройки графики дают прикрутить любому флагману просто в силу говнокода. Он использует классический DX11, который проверен временем и отлично отработан в драйверах и знаком игроделам. Overwatch отдувается за все «турнирные» игры, в которых хорошо оптимизирован код, по факту интересен тем, насколько высок средний FPS в не сильно тяжёлой с графической точки зрения игре, заточенной на работу в «среднем» конфиге, доступном по всему миру.

Сразу дам некоторые общие комментарии: Vulkan очень прожорлив в плане видеопамяти, для него эта характеристика — один из главных показателей, и вы увидите отражение этому тезису в бенчмарках. DX12 на карточках AMD ведёт себя значительно лучше, чем у NVIDIA, если «зелёные» в среднем показывают просадку по FPS на новых API, то «красные», наоборот, прирост.

Младший дивизион

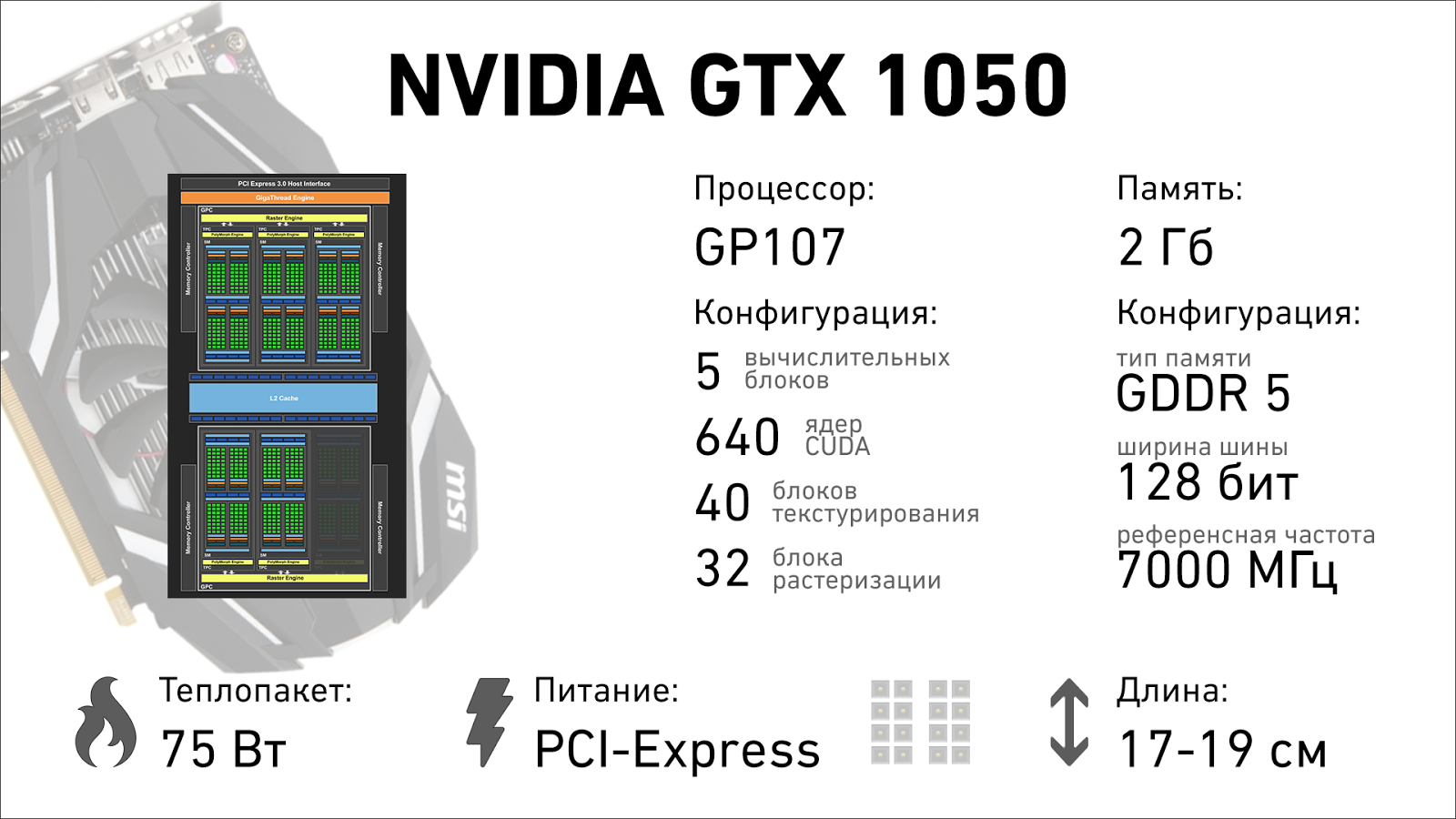

GTX 1050

Младшая NVIDIA (без букв Ti) не так интересна, как её заряженная сестрица с буквами Ti. Её удел — игровое решение для MOBA-игр, стратегий, турнирных шутеров и прочих игр, где детализация и качество картинки мало кого интересует, а стабильная частота кадров за минимальные деньги — то, что доктор прописал.

На всех картинках отсутствует частота ядра, потому что она индивидуальна для каждого экземпляра: 1050 без доп. питания может не гнаться, а её сестра с 6-pin разъёмом легко возьмёт условных 1.9 ГГц. По части питания и длины изображены наиболее популярные варианты, всегда можно найти видеокарту с другой схемой или другим охлаждением, которое не впишется в указанные «нормативы».

DOOM 2016 (1080p, ULTRA): OpenGL — 68 FPS, Vulkan — 55 FPS;

The Witcher 3: Wild Hunt (1080p, MAX, HairWorks Off): DX11 — 38 FPS;

Battlefield 1 (1080p, ULTRA): DX11 — 49 FPS, DX12 — 40 FPS;

Overwatch (1080p, ULTRA): DX11 — 93 FPS;

В GTX 1050 установлен графический процессор GP107, доставшийся ей от старшей карты с небольшой обрезкой функциональных блоков. 2 ГБ видеопамяти не дадут разгуляться, но для киберспортивных дисциплин и игры в какие-нибудь танки она отлично подойдёт, благо цена на младшую карточку начинается с 9.5 тысяч рублей. Дополнительное питание не требуется, видеокарте достаточно 75 Ватт, поступающих с материнской платы по слоту PCI-Express. Правда, в этом ценовом сегменте есть ещё и AMD Radeon RX460, который с теми же 2 ГБ памяти стоит дешевле, а по качеству работы почти не уступает, а за примерно те же деньги можно получить RX460, но в версии на 4 ГБ. Не то что бы они ему сильно помогали, но какой-никакой запас на будущее. Выбор вендора не так важен, можно брать то, что есть в наличии и не оттягивает карман лишней тысячей рублей, которую лучше потратить на заветные буквы Ti.

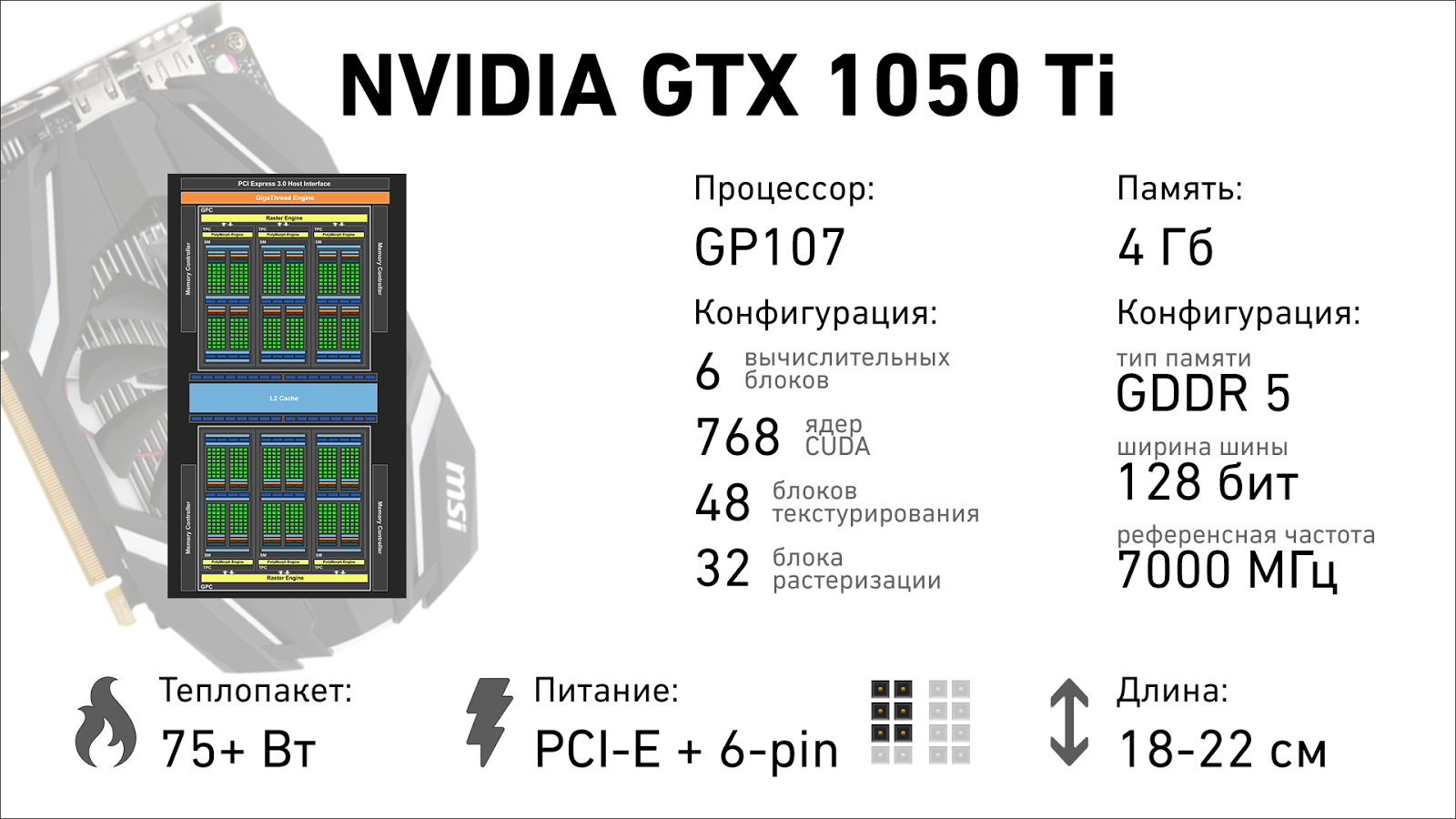

GTX 1050 Ti

Около 10 тысяч за обычную 1050 — неплохо, но за заряженную (или полноценную, называйте как хотите) версию просят не многим больше (в среднем, на 1-1.5 тысячи больше), а вот её начинка куда интереснее. К слову, вся серия 1050 выпускается не из обрезки / отбраковки «больших» чипов, которые не годятся для 1060, а как полностью самостоятельный продукт. У неё меньше техпроцесс (14 нм), другой завод (кристаллы выращивает фабрика Samsung), и есть крайне интересные экземпляры с доп. питанием: тепловой пакет и базовое потребление у неё всё те же 75 Вт, а вот разгонный потенциал и возможность выйти за рамки дозволенного — совсем другие.

Если вы продолжаете играть на разрешении FullHD (1920x1080), не планируете апгрейда, а ваше остальное железо в пределах 3-5 летней давности — отличный способ поднять производительность в игрушках малой кровью. Ориентироваться стоит на решения ASUS и MSI с дополнительным 6-пиновым питанием, неплохи варианты от Gigabyte, но цена уже не так радует.

DOOM 2016 (1080p, ULTRA): OpenGL — 83 FPS, Vulkan — 78 FPS;

The Witcher 3: Wild Hunt (1080p, MAX, HairWorks Off): DX11 — 44 FPS;

Battlefield 1 (1080p, ULTRA): DX11 — 58 FPS, DX12 — 50 FPS;

Overwatch (1080p, ULTRA): DX11 — 104 FPS.

Средний дивизион

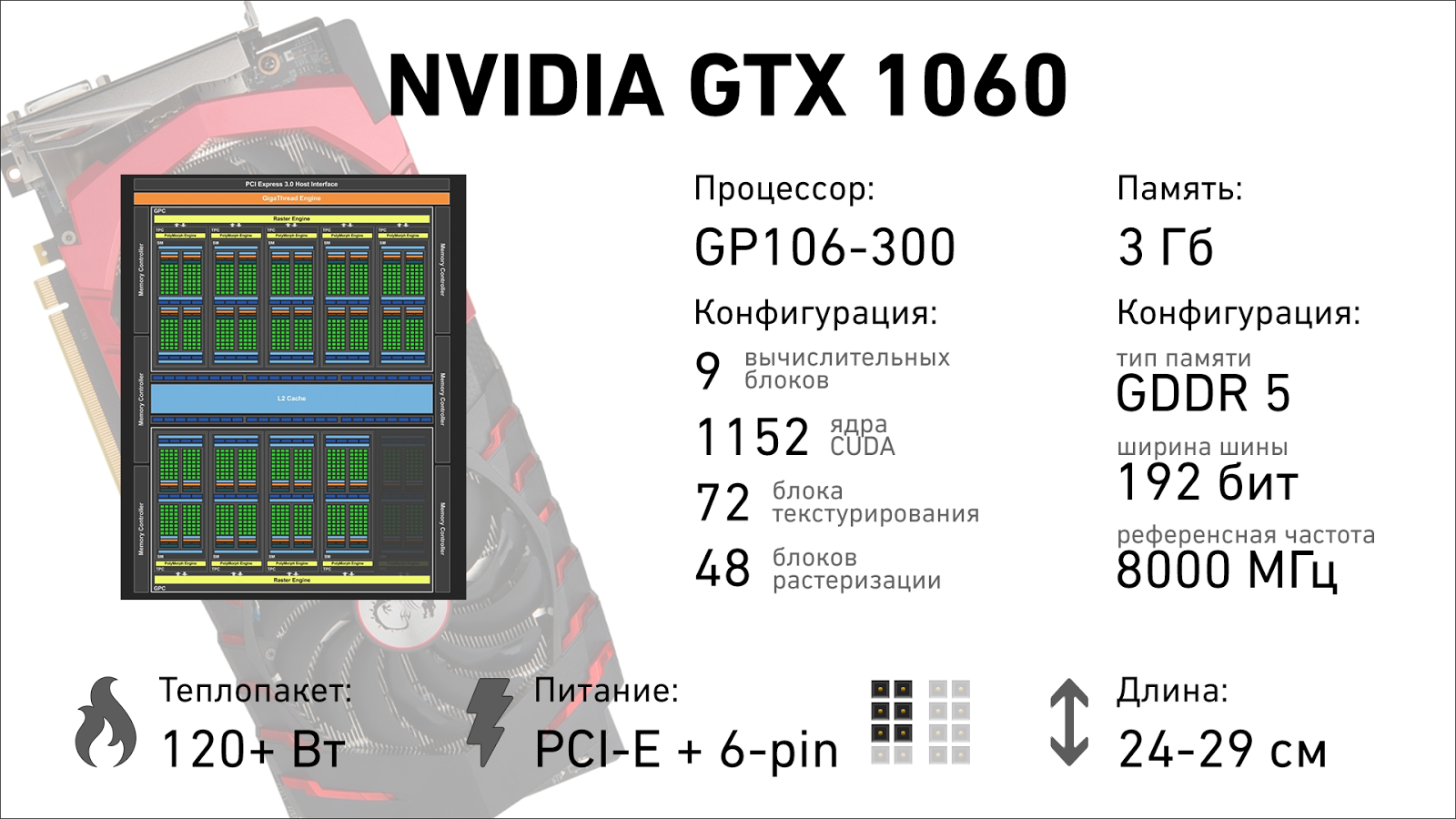

Видеокарты 60-й линейки давно считались оптимальным выбором для тех, кто не хочет тратить много денег, и вместе с тем играть на высоких настройках графики во всё, что выйдет в ближайшие пару лет. Началось это ещё со времён GTX 260, у которой было две версии (попроще, 192 потоковых процессора, и пожирнее, 216 «камней»), продолжалось в 400, 500, и 700-м поколениях, и вот NVIDIA вновь попала в практически идеальное сочетание цены и качества. Вновь доступны две версии «середнячка»: GTX 1060 на 3 и 6 ГБ видеопамяти отличаются не только объёмом доступной оперативки, но и производительностью.

GTX 1060 3GB

Королева киберспорта. Умеренная цена, потрясающая производительность для FullHD (а в киберспорте редко используют разрешение выше: там результаты важнее красивостей), разумный объём памяти (3 ГБ, на минуточку, стояло два года назад во флагмане GTX 780 Ti, который стоил неприличных денег). В плане производительности младшая 1060 легко наваливает прошлогодней GTX 970 с приснопамятным 3.5 ГБ памяти, и легко таскает за уши позапрошлогодний суперфлагман 780 Ti.

DOOM 2016 (1080p, ULTRA): OpenGL — 117 FPS, Vulkan — 87 FPS;

The Witcher 3: Wild Hunt (1080p, MAX, HairWorks Off): DX11 — 70 FPS;

Battlefield 1 (1080p, ULTRA): DX11 — 92 FPS, DX12 — 85 FPS;

Overwatch (1080p, ULTRA): DX11 — 93 FPS.

Тут безусловный фаворит по соотношению цены и выхлопа — версия от MSI. Неплохие частоты, бесшумная система охлаждения и вменяемые габариты. За неё просят-то всего ничего, в районе 15 тысяч рублей.

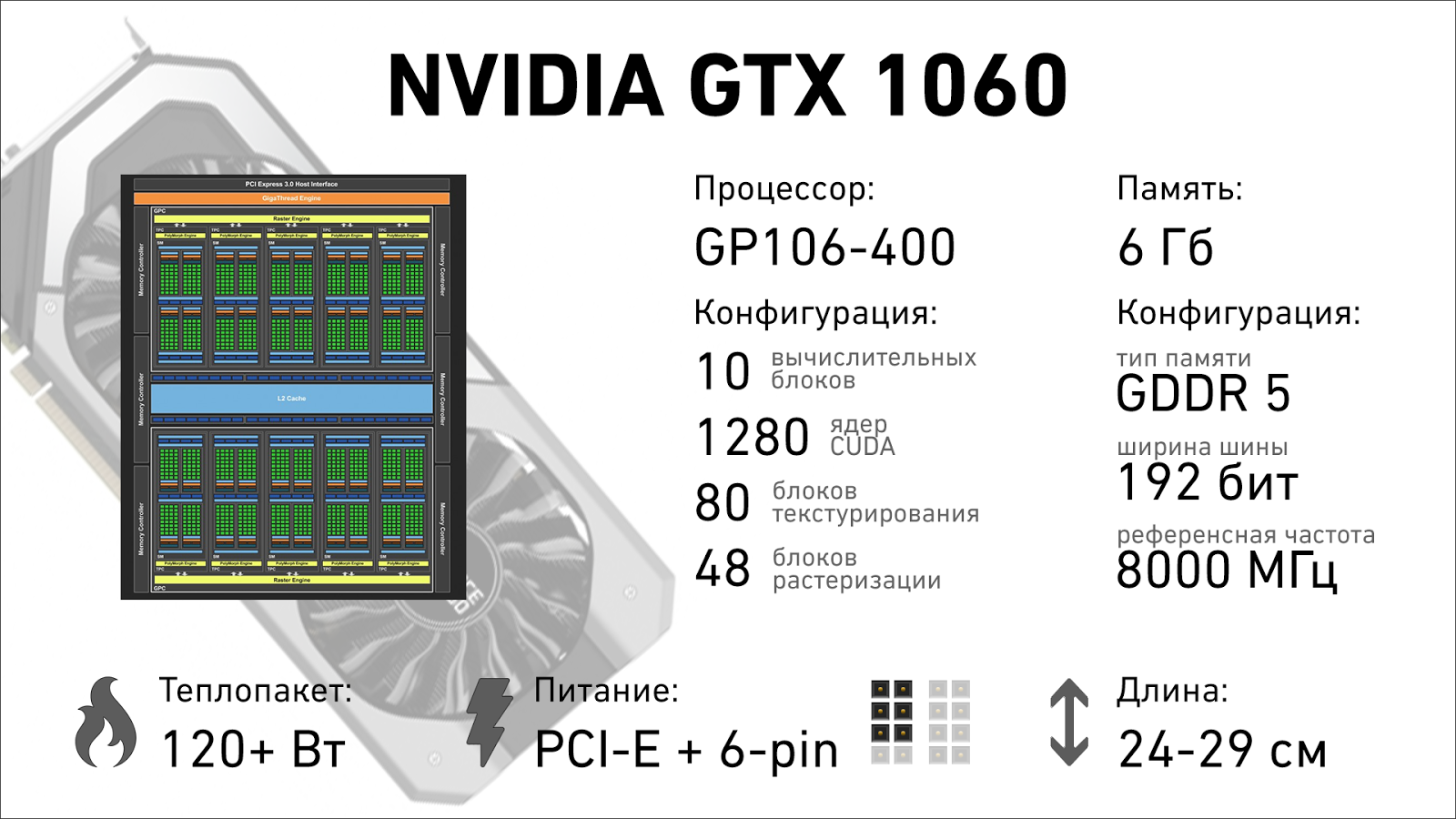

GTX 1060 6GB

Шестигигабайтная версия — бюджетный билет в VR и высокие разрешения. Она не будет голодать по памяти, чуть быстрее во всех тестах и уверенно будет выигрывать у GTX 980 там, где прошлогодней видеокарте станет мало 4 ГБ видеопамяти.

DOOM 2016 (1080p, ULTRA): OpenGL — 117 FPS, Vulkan — 121 FPS;

The Witcher 3: Wild Hunt (1080p, MAX, HairWorks Off): DX11 — 73 FPS;

Battlefield 1 (1080p, ULTRA): DX11 — 94 FPS, DX12 — 90 FPS;

Overwatch (1080p, ULTRA): DX11 — 166 FPS.

Хочется ещё раз отметить поведение видеокарт при использовании API Vulkan. 1050 с 2 ГБ памяти — просадка по FPS. 1050 Ti с 4 ГБ — почти вровень. 1060 3 ГБ — просадка. 1060 6 Гб — рост результатов. Тенденция, думаю, понятна: для Vulkan надо 4+ ГБ видеопамяти.

Беда в том, что обе 1060 — видеокарты не маленькие. Вроде, и теплопакет разумный, и плата там реально небольшая, но многие вендоры решили просто унифицировать систему охлаждения между 1080, 1070 и 1060. У кого-то видеокарты в высоту 2 слота, но длиной 28+ сантиметров, кто-то сделал их короче, но толще (2.5 слота). Выбирайте внимательней.

К сожалению, дополнительные 3 ГБ видеопамяти и разблокированный вычислительный блок обойдутся вам в ~ 5-6 тысяч рублей сверху к цене 3-гиговой версии. В данном случае самые интересные варианты по цене и качеству у Palit. ASUS выпустил монструозные 28-сантиметровые системы охлаждения, которые лепит и на 1080, и на 1070, и на 1060, и такая видеокарта мало куда поместится, версии без заводского разгона стоят почти столько же, а выхлоп меньше, а за сравнительно компактные MSI просят больше, чем у конкурентов при примерно том же уровне качества и заводского разгона.

Высшая лига

Играть на все деньги в 2016 году сложновато. Да, 1080 — безумно крута, но перфекционисты и железячники знают, что NVIDIA СКРЫВАЕТ существование супер-флагмана 1080 Ti, который должен быть неимоверно крут. Первые спецификации уже просачиваются в сеть, и понятно, что зелёные ждут шага от красно-белых: какой-нибудь убер-пушки, которую моментально можно будет поставить на место новым королём 3D-графики, великой и могучей GTX 1080 Ti. Ну а пока имеем что имеем.

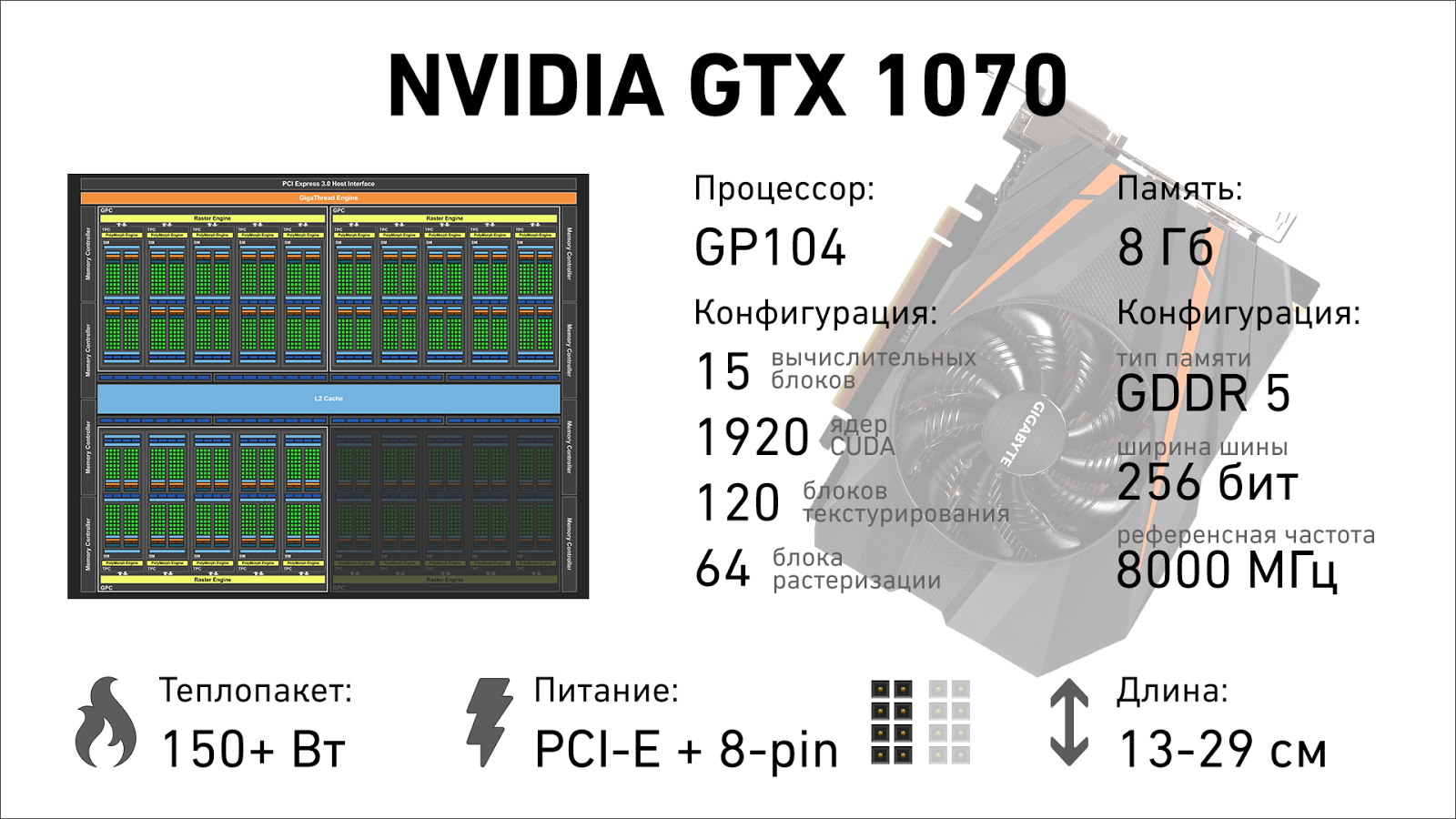

GTX 1070

Прошлогодние приключения мегапопулярной GTX 970 и её не-совсем-честных-4-гигабайт-памяти активно разбирались и обсасывались по всему интернету. Это не помешало ей стать самой популярной игровой видеокартой в мире. В преддверии смены года на календаре она удерживает первое место в Steam Hardware & Software Survey. Оно и понятно: сочетание цены и производительности было просто идеальным. И если вы пропустили прошлогодний апгрейд, а 1060 кажется вам недостаточно крутой — GTX 1070 ваш выбор.

Разрешения 2560х1440 и 3840х2160 видеокарта переваривает на ура. Система разгона Boost 3.0 постарается подкидывать дров тогда, когда возрастает нагрузка на GPU (то есть в самых тяжёлых сценах, когда FPS проседает под натиском спецэффектов), разгоняя процессор видеокарты до умопомрачительных 2100+ Мгц. Память легко получает 15-18% эффективной частоты сверх заводских показателей. Монструозная штука.

Внимание, все тесты проведены в 2.5k (2560x1440):

DOOM 2016 (1440p, ULTRA): OpenGL — 91 FPS, Vulkan — 78 FPS;

The Witcher 3: Wild Hunt (1440p, MAX, HairWorks Off): DX11 — 73 FPS;

Battlefield 1 (1440p, ULTRA): DX11 — 91 FPS, DX12 — 83 FPS;

Overwatch (1440p, ULTRA): DX11 — 142 FPS.

Понятное дело, вытянуть ультра-настройки в 4k и никогда не проседать ниже 60 кадров в секунду не под силу ни этой карточке, ни 1080, но играть на условных «высоких» настройках, отключив или немного снизив самые прожорливые фичи можно в полном разрешении, а в плане реальной производительности видеокарта легко задаёт жару даже прошлогодней 980 Ti, которая стоила почти вдвое дороже. Самый интересный вариант у Gigabyte: они ухитрились запихать полноценную 1070 в корпус ITX-стандарта. Спасибо скромному теплопакету и энергоэффективному дизайну. Цены на карточки стартуют с 29-30 тысяч рублей за вкусные варианты.

GTX 1080

Да, флагман не имеет букв Ti. Да, он использует не самый крупный GPU, доступный NVIDIA. Да, здесь нет крутейшей памяти HBM 2, а видеокарта не выглядит, как «Звезда смерти» или, в крайне случае, имперский крейсер класса «Звёздный разрушитель». И да, это самая крутая игровая видеокарта, которая сейчас есть. Одна одна берёт и запускает DOOM в разрешении 5k3k с 60 кадрами в секунду на ультра-настройках. Ей подвластны все новые игрушки, и ближайшие год-два она не будет испытывать проблем: пока новые технологии, заложенные в Pascal станут распространены, пока игровые движки научатся эффективно загружать имеющиеся ресурсы… Да, через пару лет мы будем говорить: «Вот, посмотрите на GTX 1260, пару лет назад для игры с такими настройками вам нужен был флагман», а пока — лучшая из лучших видеокарт доступна перед новым годом по весьма разумной цене.

Внимание, все тесты проведены в 4k (3840x2160):

DOOM 2016 (2160p, ULTRA): OpenGL — 54 FPS, Vulkan — 78 FPS;

The Witcher 3: Wild Hunt (2160p, MAX, HairWorks Off): DX11 — 55 FPS;

Battlefield 1 (2160p, ULTRA): DX11 — 65 FPS, DX12 — 59 FPS;

Overwatch (2160p, ULTRA): DX11 — 93 FPS.

Останется только решить: оно вам надо, или можно сэкономить и взять 1070. Играть на «ультре» или «высоких» настройках особой разницы нет, благо современные движки отлично рисуют картинку в высоком разрешении даже на средних настройках: в конце концов, у нас с вами не мыльные консоли, которые не могут обеспечить достаточно производительности для честного 4k и стабильных 60 кадров в секунду.

Если отбросить самые недорогие варианты, то лучшее сочетание цены и качества снова будет у Palit в варианте GameRock (около 43-45 тысяч рублей): да, система охлаждения «толстая», 2.5 слота, но видеокарта короче конкурентов, а пару из 1080 ставят редко. SLI потихоньку умирает, и даже живительная инъекция высокоскоростных мостов его не особо выручает. Вариант ASUS ROG неплох, если у вас установлено множество доп. девайсов и перекрывать лишние слоты расширения вам не хочется: их видеокарта в толщину ровно 2 слота, но требует 29 сантиметров свободного пространства от задней стенки до корзины с жёсткими дисками. Интересно, осилят ли Gigabyte выпуск и этого монстра в ITX-формате?

Итоги

Новые видеокарты NVIDIA просто похоронили рынок Б/У железа. На нём выживает только GTX 970, которую можно урвать за 10-12 тысяч рублей. Потенциальным покупателям Б/У 7970 и R9 280 часто некуда её поставить и попросту не прокормить, а многие Б/У варианты попросту бесперспективны и как дешёвый апгрейд на пару лет вперёд никуда не годятся: памяти мало, новые технологии не поддерживаются. Прелесть нового поколения видеокарт именно в том, что даже неоптимизированные под них игрушки идут значительно бодрее, чем на ветеранах GPU-чартов прошлых лет, а что будет через год, когда движки игр научатся использовать всю силу новых технологий — и представить сложно.

GTX 1050 и 1050Ti

Увы, рекомендовать покупку самого недорогого Pascal’я я не могу. RX 460 обычно продаётся на тысячу-другую дешевле, и если у вас бюджет ограничен настолько, что вы берёте видеокарту «на последние» то Radeon объективно является более интересным вложением денег. С другой стороны, 1050 немного быстрее, и если цены в вашем городе на эти две видеокарты почти не отличаются — берите её.

1050Ti, в свою очередь, отличный вариант для тех, кому сюжет и геймплей важнее наворотов и реалистичных волос в носу. У неё нет бутылочного горлышка в виде 2 ГБ видеопамяти, она не «стухнет» через год. Можете доложить денег на неё — сделайте это. Ведьмак на высоких настройках, GTA V, DOOM, BF 1 — без проблем. Да, придётся отказаться от ряда улучшений, типа сверхдлинных теней, сложной тесселяции или «дорогого» просчёта самозатенения моделей ограниченной трассировкой лучей, но в пылу битвы вы забудете про эти красивости после 10 минут игры, а стабильные 50-60 кадров в секунду дадут куда больший эффект погружения, чем нервные скачки от 25 до 40, но с настройками на «максимум».

Если у вас стоит какая-нибудь Radeon 7850, GTX 760 или младше, видеокарты с 2 ГБ видеопамяти и меньше — можете смело менять.

GTX 1060

Младшая 1060 порадует тех, кому кадровая частота от 100 FPS важнее, чем графические навороты. Вместе с тем, она позволит комфортно играть во все вышедшие игрушки в FullHD разрешении с выоскими или максимальными настройками и стабильными 60 кадрами в секунду, да и по цене сильно отличается от всего, что идёт после неё. Старшая 1060 с 6 гигабайтами памяти — бескомпромиссное решение для FullHD с запасом производительности на год-другой, знакомства с VR и вполне приемлемый кандидат для игры в высоких разрешениях на средних настройках.

Менять вашу GTX 970 на GTX 1060 смысла нет, потерпит ещё годик. А вот надоевшие 960, 770, 780, R9 280X и более древние агрегаты можно смело обновлять до 1060.

Топ-сегмент: GTX 1070 и 1080

1070 вряд ли станет такой же популярной, как GTX 970 (всё же, у большинства пользователей цикл обновления железа — раз в два года), но по соотношению цены и качества, безусловно, достойное продолжение 70-й линейки. Она просто перемалывает игры на мэйнстримовом разерешнии 1080р, легко справляется с 2560х1440, выдерживает мытарства неоптимизированных 21 к 9, и вполне способна отображать 4k, пусть и не на максимальных настройках.

Да, SLI бывает и таким.

Говорим «давай, до свиданья» всяким 780 Ti, R9 390X и прочим прошлогодним 980-м, особенно если хотим играть в высоком разрешении. И, да, это лучший вариант для любителей собрать адскую коробчонку в формате Mini-ITX и пугать гостей 4k-играми на 60-70 дюймовом телевизоре, которые запускаются на компьютере размером с кофеварку.

GTX 1080 легко заменяет любую связку из предыдущих видеокарт, кроме пары 980Ti, FuryX или каких-нибудь зубодробительных Titan’ов. Правда, энергопотребление таких монструозных конфигов не идёт ни в какое сравнение с одной 1080, да и к качеству работы спарок есть претензии.

На этом у меня всё, мой подарок вам на новый год — этот гайд, а уж чем порадовать себя — выбирайте сами :) С наступающим!

Комментарии (82)

zookko

29.12.2016 20:03+2Ещё бы Ризен у АМД удался и Оптан у Интела — и тогда 2017 вообще лютый по железу год будет.

Да ещё и в конце года будет инфа по Вольте…

xforce

29.12.2016 20:07+1А можно вопрос?

Самая главная фишка Pascal’я — тройной буфер для вывода кадров

и далее, по описанию — обычный Tripple buffer, который был кажись в риве тнт, если не раньше и он наоборот увеличивал задержку. В чем новшество?

Alaunquirie

29.12.2016 20:47В том, что тройная буфферизация уменьшает артефакты изображения, но не убирает полностью разрывы. В буфферы копируются кадры вне зависимости от их состояния, и если ваша видеокарта выдаёт условных 90 кадров в секунду, а монитор умеет показывать только 60, то читать монитор будет полтора кадра. При включённом FastSync в буфер попадают только полностью отрисованные кадры, и монитор при превышении кадровой частоты будет получать только полные кадры. Да, кое-какие задержки появляются, но они намноооооооооого меньше тех, которые выдаёт V-Sync.

Fenyx_dml

07.01.2017 00:16Спасибо за обращение внимания на этот момент. Так бы и не знал. Недавно как раз купил 1060 на замену старенькой 570 (а в прошлом году хотел было взять 970, но в связи со скачками курса и определенными личными обстоятельствами решил что это не обосновано). В этом году все же купил, но уровнем пониже — 1060. Кстати сказать, 570 — предтоп в свое время покупался «всего» за 13 тыс., а мейнстрим 1060 (6 гиговая) нынче вышел в «всего» 17,5 тыс (это еще с учетом бонусов от предыдущих покупок в 1,5 тыс), а полная цена от 19 (ну есть чуть дешевле, но более тоскливые варианты), а 1070, которую я в общем-то и хотел приобрести (т.к. монитор у меня 2560х1440), стоит от 27, что более чем в 2 раза дороже чем 570 и для меня не приемлемо. Понятно что дело в очередном одревянивании рубля, а не в удорожании видиокарт, но зарплата-то не выросла в 2 раза, а плясать как ни крути, приходится от неё. Это я так, к слову «всего» применительно к цене.

А в настройках драйвера к сожалению нет такого пункта «fastsync». Перевели слишком усердно — пункт в самом низу списка выглядит как просто «быстро»! Вот надмозги! Включил одновременно её и тройной буфер. Надо только сравнить с предыдущим вариантом «адаптивная синхронизация», которая включает синхру при высокой частоте кадров и отключает, если видюха не справляется и дает частоту меньше монитора. Тоже неплохой был вариант. Буду ждать развернутого сравнения, как обещано.

А еще хотелось бы все таки увидеть какие-то рекомендации о том, где именно можно увидеть всё это новое богатство. Предложенный набор игрушек лично меня ни сколько не вдохновляет — это уж дело вкуса… А еще хотелось бы увидеть разбор перспектив многокарточных конфигов. nV сделала легкий взмах серпом пояй… контактам sli в семействе младших карт, чтобы не оказалось что две 1060 в одном компе так же быстры и при том дешевле одной 1080. Однако в DX12, я знаю, есть возможность использовать мульти-гпу режим и его собственными средствами (причем эффективнее чем слай-кросфайр -суррогатами). Где-то это есть или ожидается? Это я к тому, что на мои 1440р через год-два где-то может и не хватить одной 1060, но купить вторую к тому времени будет не просто а очень просто и дешево. Дешевле чем обновить до тогдашних вариантов. Я думал что может выпустят какую-нибудь 1060ti, с контактами, но не случилось. Вот интересно, есть ли перспективы у моих ожиданий?..

Fenyx_dml

08.01.2017 11:01Как будто никому не интересно, ну ладно… Проверил на fallout 4. На входе в даймонд сити при отключенном vsync частота кадров около 57-59 к/сек (во всех других местах 80 и более). Если подвигать мышью видны разрывы на изображении. Включил freeesync+triple buffer. Частота осталось той же самой, но разрывы пропали. Правда выпадения кадров естественно никуда не делись — если быстро повернуться на месте — видно подергивание движения там где видюха не успела сформировать кадр. В общем, работает отлично, но для идеальной плавности надо чтобы частота кадров не падала ниже мониторной.

RedVelvet

29.12.2016 20:09Долго маялся выбирая из 1060 зеленых и 480 й красных. Выбрал последнюю и надо сказать не разочаровала.

wOvAN

29.12.2016 20:30AMD разочаровывает в последствии, когда не выпускает драйверы под новые оси, в то время как NVidia поддерживает драйверы даже для очень старых карт под новые ОС, не задействует возможности карт для современных нужд, как например декодирования 4k не появилось на ряде прошлых, даже очень мощных, моделей AMD, в то время как NVidia в этом плане выжала из своих карт все возможное.

MurzikFreeman

30.12.2016 09:55в то время как NVidia поддерживает драйверы даже для очень старых карт

Просто замечательно они их поддерживают. С каждым новым обновлением ждёшь, какая игра перестанет нормально работать следующей? Уж не знаю, связано это с их попыткой исправлять кривые руки разработчиков игр или просто с желанием «урезать» функционал старых моделей, чтобы лучше покупали новые, но с каждым обновлением драйверов начинаются проблемы с играми которые раньше работали нормально. Уже доходило до того, что у меня был набор из четырёх разных версий драйверов, с каждой из которых нормально шла только одна игра. Это вот так они поддерживают старые карты? (GTX 690).

severgun

30.12.2016 12:49+1Бред.

Да бывают багнутые релизы, но зачастую сразу же выходят фиксы. И никто вам не мешает откатиться. В то время как AMD действительно кидает поддержку. Как на WIN так и на linux. Например под 4000 серию уже нет дров, в то время как нвидиа 8000 спокойно работает.MurzikFreeman

30.12.2016 13:09Вот и откатываюсь. Только откатываться приходится не чтобы подождать фикса, а чтобы вообще поиграть. pCARS, нормально работает только на версии которую качал два месяца назад. Чтобы поиграть в Planetside2 мне придётся ставить драйвер годичной давности, на новых 15 кадров в секунду. И они не собираются это исправлять.

RussianNeuroMancer

30.12.2016 16:45> так и на linux

А вот не надо, пожалуйста. Поддержку проприетарного драйвера действительно прекращают, но он, тем более на старых картах, собственно и нафиг не нужен. То, что в Windows требует бубна и шаманств (читай — правильных версий драйверов, и неочевидной процедуры установки) а в частности, гибридные конфигурации Intel iGPU + Radeon dGPU, в Linux просто работает сразу из коробки со свободными драйверами, достаточно лишь вписать «DRI_PRIME=1 steam» в ярлык Стима. И это при том, что пары GPU, в которых хотя бы один из двух GPU не работает в Win10, в Win10 вообще не завести. В прошлом аналогичная ситуация была с ноутбуками HP, у которых интеграшка 42xx, а дискретка из шеститысячных — со свободными драйверами в Linux пахало, а проприетарные в Windows только древние с сайта вендора (в которых ещё не выкинули поддержку pre-Evergreen карт).

maniacscientist

30.12.2016 13:55> 690

Двухчип же. Все, кто покупают двухчип, принимают оферту: мне настолько не хватает флагманского одночипа, что готов на любые проблемы.

Проблемы возникают даже когда карта актуальна. Одни ждуны SLI-профайлов чего стоятMurzikFreeman

30.12.2016 14:17Когда у меня возникают проблемы в режиме SLI, я молчу в тряпочку, я знал на что иду (хоть и не подозревал что будет всё настолько плохо). Проблемы остаются и при использовании только одного ядра. Хотя вопроса об обновлении драйверов это всё же не снимает. Зачем ломать то, что уже работало? От секты мучеников CrossFireX я слышал о проблемах, но адепты уверяют что с каждым обновлением часть проблем уходит, а не добавляются новые. Что не так с NVidia?

maniacscientist

30.12.2016 14:48Хм, у меня тоже кеплер (780), деградацию видел только один раз — в Метро2033 пропали пылинки на свету.

Fenyx_dml

06.01.2017 18:07Что за чушь? Я только неделю как сменил свою старую 570 и никаких засад с драйверами никогда не видел. Правда я не игроман — не играю во все новые распиаренные игрухи. Может в каких-то из них что-то такое и было. Но вряд ли. Опыт показывает, что винда у активных пользователей (которые постоянно что-то устанавливают, удаляют, переустанавливают..) со временем портится. Какие-то файлы или ключи реестра или еще что-то говняются и начинаются странные спотыкания на ровном месте. Сам недавно всё снес из-за странностей работы с видеокамерой. Но у меня -то винда стояла с тех самых пор как вышла 7--ка после висты, так что давно пора было. И такие примеры наблюдаются регулярно. У знакомого перестала одна игруха запускаться… Все «очистки системы» не помогли. Переставили винду (а была она порядком засрана) — куда что делось! Так что прежде чем гнать волну на такую злобную nv, надо бы разобраться в чем действительно причина.

YoMan

29.12.2016 22:53Посмотрел тесты и не понял чем же она Вас не разочаровала…

kranky

30.12.2016 00:43А по тестам как раз и видно чем: Джифорс быстрее примерно на 10%, но дороже примерно на 25%

Structure

30.12.2016 13:42А по новым тестам 1060 уже и не впереди.

Да и у AMD есть FreeSync. С ней еще большая экономия($100-200) на мониторе.

Zavtramen

30.12.2016 01:28+3А я долго маялся выбирая из 1060 зеленых и 480 й красных. Выбрал первую и надо сказать не разочаровала ;)

GennPen

29.12.2016 20:39GTX 1050(Ti) для HTPC — идеальный вариант: маленькая, холодная, производительная и не требует доп.питания.

RussianNeuroMancer

30.12.2016 16:47Зачем дискретная видеокарта в HTPC? У меня до сих пор справляется Radeon HD 6310 из E-350, тянет вплоть до 1080p 60 fps.

NarutoUA

29.12.2016 21:19А куда делся Titan X Pascal?

zookko

29.12.2016 21:43Очевидно, автор, рассматривает только карты, которые можно купить в магазине.

Новый Титан нельзя. В России он вообще недоступен для заказа.

Alaunquirie

30.12.2016 01:23Он в РФ не продаётся, а тем, кому он реально нужен, такая статья ни к чему.

Kenya-West

30.12.2016 07:19Говорим «давай, до свиданья» всяким 780 Ti, R9 390X и прочим прошлогодним 980-м, особенно если хотим играть в высоком разрешении.

Вот блин, купил её сдуру год назад… Впрочем, видюшка до сих пор радует на Full HD, ни лагов, ни багов, дровишки свежие выходят каждый месяц. Думаю, ещё пару лет протянет, и потом куплю какой-нибудь GTX 1280 Ti SubZero Edition…

BeyondBright

30.12.2016 12:41+1Я приобрёл 1070 и, сказать честно, просто в восторге. Возможно, конечно, что это у меня на контрасте такие радости (была 760я), но карточка просто огонь. В 1080р я просто не задумываюсь о настройках графики, просто на максимум выкручиваешь и всё, если уже очень хочется. А если не хочется, то карточка почти и не греется (зимой теперь проблема — в небольшой комнате компьютер имел стратегическое значение для отопления). Теперь, наверное, нужно будет взять 1440р монитор с G-Sync и посмотреть, как это будет выглядеть.

Ilyasyakubov

30.12.2016 14:37Как ни странно, GTA V на максимально возможных настройках графики в 1080p ставит на колени мою GTX1080. Так что задумываться все же иногда нужно ;)

Alaunquirie

30.12.2016 15:52Что-то не так с конфигом, я выжимал больше 60 FPS на 1080р в 4k. Проц? Память? Что-то ещё? А, ну и вопрос настроек Motion Blur'а / DoF'а, они в GTA на колени поставят кого угодно. :(

Ilyasyakubov

30.12.2016 15:59Motion blur выключен, dof включен. У меня тени на макс и дистанция прорисовки на макс — может в этом косяк. Но я же хотел получить максимально возможное качество картинки (кроме mb — он нафиг не нужен)

Ilyasyakubov

30.12.2016 16:03Совсем забыл: MSAA естественно выключен — с ним было бы совсем худо. FXAA включен

BeyondBright

30.12.2016 17:13Как ниже уже написали, проверьте antialiasing и его версию. Очень рекомендую разобраться, там теперь зоопарк из разных версий.

Tufed

30.12.2016 14:01Раз уж тут тема про видеокарты, закину и я свой вопрос: взял palit 1060 3Gb на замену GT640. И получил нестабильную систему. FPS в среднем вырос, но через каждый 15-120 секунд случаются просадки на 1-3сек с комфортных 70-80fps до неприемлемых 5-15fps. С чем это связано уже второй месяц бьюсь в поисках. C GT640 такого не было, даже позволяла на второй монитор фильмы одновременно выводить, и на большинстве игр это не отражалось. Драйвера ставил, менял, сносил все, пробовал 3 разные версии из последних. Думал что БП не тянет (китай 800W), но смена не помогла тяжелый Zalman 600 даёт тот же эффект. Система FX8350+16RAM+SSD+WIN7. Носил карту к другу с похожей, но чуть слабее системой но win10 — работает без нареканий. Может кто сталкивался? где копать? ТП в группе вконтакте только руками разводят.

lolipop

30.12.2016 15:22взять отдельный жесткий диск и накатить чистую винду, если проблема уйдет — значит дело было не

в бобинев железе.

f1ac

30.12.2016 18:35Похоже на перегрев и троттлинг. Я бы поставил msi afterburner и понаблюдал за температурой и частотами при просадках.

mrigi

30.12.2016 14:13Не знаю что у вас там на 1080 идет в 4К, но у меня GTA5 в 2560x1600 (все на макс) она уже с трудом переваривает. Загрузка всё время на 100%, т.е. запаса нет вообще никакого. Тот же Овервоч с маштабированием выше 122% тоже начинает терять фпс. Все-таки я надеялся что карточка будет немного мощнее.

Ilyasyakubov

30.12.2016 14:42Overwatch в 3840*2160 все на макс ниже 60 не опускается, если убрать верт.синх, то fps ~80. А вот GTA V да, даже на 1920*1080 все на макс. просаживает fps до 40 местами.

mrigi

30.12.2016 15:26Поставьте «масштаб прорисовки» на 200% и сразу получите 30-40 фпс. Так что нет, у вас не всё на макс.

LaoAx

30.12.2016 15:12в небольшой комнате компьютер имел стратегическое значение для отопления

Это божественно! У меня 2х560. Топка обогревает всю комнату.

BeyondBright

30.12.2016 17:17Я не шутил, совершенно. При небольшой кубатуре у меня было стабильно +4 граду чисто от компа.

Ilias

30.12.2016 15:54Можно пару вопросов?

Имеет ли смысл сейчас менять 980ti и если да то на что? Даст ли 1070 заметный скачок в производительности или для этого надо 1080?

И как именно и почему умирает SLI?

Alaunquirie

30.12.2016 15:59+1980Ti менять смысла особого не вижу, разница с 1080 есть, но не такая, чтоб сломя голову нестись в магазин. Если вам не критично играть на ультра-фигультра настройках со всеми-всеми доп. плюшками — я б подождал годик.

SLI умирает (как и все многочиповые конфиги) из-за всё более и более активного применения в играх темпоральных техник (использования информации с прошлого кадра), что сильно бьёт по производительности, скажем, при работе в режиме чередования кадров. У видеокарты просто нет предыдущего кадра, есть пред-предыдущий. А значит надо предыдущий запросить у сестрицы по SLI-мосту, или не использовать эту фичу. NVIDIA вроде как дала разработчикам возможность вручную управлять SLI-производительностью в новых API, параллелить нагрузку и всё такое, но судите сами: много у кого стоят две видеокарты? Будут разработчики активно тратить человеко-часы на интеграцию новых фич, отладку, полировку, оптимизацию? Или этим должна заниматься NVIDIA в других играх? Ну и Legacy-костыли самой технологии потихоньку дают о себе знать.

k12th

30.12.2016 16:04То есть нет смысла строить SLI/CrossFire-систему?

Fagot63

30.12.2016 17:36Еще и не все игры поддерживают.

k12th

30.12.2016 17:46Ну я так понял, что для тех, которые прям совсем не поддерживают, можно одну карточку временно отключать?

Alaunquirie

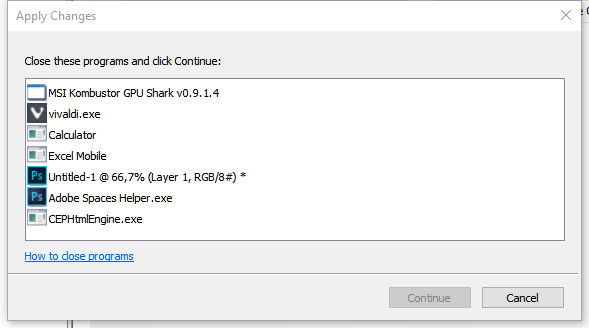

30.12.2016 18:53Нет, для части игр вторая видеокарта болт пинает. Включать-выключать SLI накладно, надо кучу всяких программ повыключать. В этот раз что-то мало их, обычно там ещё скайп болтается, телеграм, ещё что-нибудь, пару раз просило даже explorer.exe закрыть.

GennPen

30.12.2016 15:59+1Имеет ли смысл сейчас менять 980ti и если да то на что? Даст ли 1070 заметный скачок в производительности или для этого надо 1080?

980ti и 1070 имеют примерно равную производительность, да и 1080 не сильно оторвалась, не стоит овчинка выделенки

kosmos89

02.01.2017 16:37Коротко: половина (а может и больше) игр его не поддерживает. А половина оставшихся безбожно глючит.

Ilias

02.01.2017 17:03я почему то всегда считал что поддержка SLI в играх — это просто оптимизация. а так игровая графика распределяется по картам на уровне драйверов, прозрачно для игр.

kosmos89

02.01.2017 18:18Во-первых, если nvidia не протестировала игру со SLI и не пометила игру, как совместимую, то он там просто не включится. А таких игр много. И даже если включить насильно, во многих играх это просто нормально не заработает. Будут дерганья, визуальные глюки, черный экран и прочее. Иногда FPS вырастает вдвое, но фактически просто по два раза показывается один и тот же кадр.

Даже «поддерживаемые» игры зачастую глючат. Например, в WarThunder на земле появляются черные мерцающие квадраты.

В общем, я решил, что SLI больше никогда не поставлю.

Ilias

02.01.2017 18:21блин, а вот это реально интересно. я про такое ни разу не слышал вообще. может быть напишете статью про текущую ситуацию со SLI? с неким обзором современных игр с официальной поддержкой и без.

kosmos89

02.01.2017 21:12К сожалению (нет, к счастью!), SLI я уже разобрал и в наличии осталась одна видеокарта. А писать по памяти, боюсь много где совру…

Alaunquirie

03.01.2017 22:00Зато у меня есть парочка видеокарт, думаю, можно и написать статью о том, как всё «замечательно» в зелёном лагере двухвидяшном.

Fagot63

04.01.2017 16:53Буду ждать. Сам подумывал докупить еще одну 980 через годик, как производительности перестанет хватать. А то полноценно по тестировать SLI у друга нет возможности.

SanekPlus

30.12.2016 15:59Может кто, разбирающийся — напишет статью про производительность CUDA? А то, что-то не очень понятно. Например вроде как например GTX 580 при ее 512 ядрах CUDA будет производительней (или также) при рендеринге видео чем более старший собрат GTX 660 с 960 ядер куда.

Есть какая-то таблица реальной производительности может?

Silentfog

30.12.2016 16:49Странно, звук почему-то совершенно не объёмный на демо-ролике про новую возможность симуляции отражений звука. Возможно источник является моно-записью и реверберация работает с ним как с моно-сигналом, такой же эффект наблюдается при работе с таким звуком в аудио-редакторах.

kosmos89

02.01.2017 19:27Потому что источник звука совмещен с камерой. В момент когда его отсоединяют можно уловить разницу между ушами. Правда объемность при этом заметить сложно.

Fagot63

04.01.2017 16:56Сам поздно обратил внимание(когда уже написал), что источник звука либо совмещен с камерой, либо строго позади. Поэтому и стерео эффекта нет.

Silentfog

05.01.2017 19:15Совмещение с камерой всё же я думаю не должно реверберацию тоже превращать в моно-эффект. Думаю всё же, что источник мог быть моно-записью и обработка реверберацией повела себя с ним именно как с моно-записью. В аудиоредакторах, например, для создания стерео-реверберации — монозапись надо заведомо переопределить как стереозвук — и тогда реверберация становится объёмной. Здесь же явно все отражения собраны посередине, что в таком помещении как на видео не должно происходить. Временами здесь звук перемещается влево и вправо, но это простой Panning

khamitimur

30.12.2016 16:49Пару месяцев назад приобрёл 1060 6Gb от Asus. Доволен, как слон. Да, длинная, но спокойно поместилась в корпус, и это у меня ещё для дисков посадки не снимаются. ИМХО, для 1080p монитора лучше карту не найти.

Nouk

30.12.2016 16:49Забыли уточнить, что мобильные версии видеокарт теперь не имеют приставку «М» и отличаются производительностью лишь на 5-10% от десктопной версиии. Как было ранее — 960М имела уровень производительности 760 и тд. Лишь некоторые монстры, например GX700, имел в себе полноценную 980 без приставки «М». Сейчас все гораздо лучше, купить ноутбук с 1060, ты получаешь 1060, без всяких недомолвок)

Dr_Zoidberg

30.12.2016 17:08+1Жду свой EVGA ASC Gaming GTX 1080. Все никак не привезут. Спасибо за статью, очень интересная!

Alaunquirie

30.12.2016 18:54Не забудьте из неё все соки Precision Tool'ом выжать, помогает избежать просадок по FPS в тяжёлых сценах. :)

eugenios

31.12.2016 02:19Удивительно, что новая 1080 founders edition еще и тихая. В простое тише моего ныне покойного hdd из серии WD Green. И електричества ест мало — комп с i7-6700 потребляет 50 Вт, опять же в простое.

Smitak

31.12.2016 05:09-1Замечательная производительность, отлично. Но посмотрим сколько будут жить эти видеокарты на новом техпроцессе, учитывая, что их ещё и «буст» гонит до 2000. Охх чувствую лететь они будут массово…

Если и на 28-нм чипы отслаивались от посадочной пластины довольно часто и далеко не всегда из-за любителей разгона, то теперь по логике это должно происходить раза в 4 чаще. Только если они не изменили способ изготовления чипов для продления их жизненного цикла…

GennPen

31.12.2016 14:23+1Если и на 28-нм чипы отслаивались от посадочной пластины

Какая взаимосвязь техпроцесса и отвала чипа?

mm7

04.01.2017 01:44А как насчет OpenCL?

Хочется чего-то бюджетного чтоб быстро считать гидродинамику на решетках Больцмана. (на Линуксе)

Чего порекомендуете?

Orient

04.01.2017 13:18Вы думаете, что для гидродинамики именно на решётках Больцмана что-то подходит больше? Вряд ли nvidia сделали специализированную версию железа для какого-то выделенного класса алгоритмов.

mm7

04.01.2017 21:00Я спрашивал про OpenCL.

Про алгоритм просто упомянул, для ясности.

(Для решетки Больцмана есть разные реализации, и на OpenCL, и на Cuda, и для обычных ЦПУ.

Просто, я думаю, OpenCL самое стандартное для такого типа задач, которое должно работать на всем, и на красном и на зеленом. А Cuda пропраитарное, только для зеленых.)

maniacscientist

08.01.2017 18:10Вычислительный шейдер в OpenGL — ещё более «стандартное» решение. Там достаточно просто чтобы меса реализовывала версию 4.3

St_androsik

05.01.2017 01:53Короткие версии 1060 есть как минимум у Gigabyte, EVGA и Zotac, с длинной от 17, если память мне не изменяет. Это так, если кому интересно.

zookko

Осталось дождаться 1080Ти и старшую Вегу — посмотреть, что за монстров выкатят на этот раз.

Alaunquirie

Сам жду с нетерпением. Само собой, это не мэйнстримовое железо, и оно мало кому доступно, но безумно интересно, что там будет. У 1080Ti, ожидаемо, 10 Гб памяти, отключат пару-тройку кластеров в GP 100 и, скорее всего, будет GDDR5X, а не HBM 2. А вот что нарисует AMD — пока полная загадка. Впрочем, так даже лучше — больше интрига, приятнее потенциальный сюрприз от красных. Надеюсь, у них получится достойный флагман.

StjarnornasFred

Копипастить с 4PDA (4pda.ru/2016/12/19/331868) — это явно не то, чего ожидают читатели Geektimes.