Океаны холодны, темны и наполнены кинетической энергией, что делает их идеальным местом для построения дата-центров. Чуть более года назад Microsoft погрузила шкаф серверов, заключенных в герметичный металлический контейнер, в океан. Через несколько месяцев они подняли капсулу на поверхность, она была покрыта водорослями и моллюсками, будто прошло не несколько месяцев, а много лет. Но серверы внутри продолжали работать в прохладе и сухости. Не это ли будущее дата-центров? Команда инженеров Microsoft, работающих в рамках проекта Natick, полагают, что в этом будущее.

Зарождение идеи

Все началось в 2013 году, когда сотрудник Microsoft, Шон Джеймс (Sean James), занимающийся внедрением новых технологий в центры обработки данных, служивший на подводной лодке ВМС США, предложил идею размещения серверных ферм под водой, что вызвало сомнения у некоторых из его коллег. Но только не у него.

Sean James (Cloud Infrastructure & Operations Team)

Реализация этой идеи, по его мнению, не только должна была снизить расходы на охлаждение машин — огромные расходы для многих операторов центров обработки данных (около 40% всего счета за электроэнергию — охлаждение), но также затраты на строительство, упростить управление этими установками с использованием возобновляемых источников энергии и даже улучшить их производительность.

Вместе с Тоддом Роулингсом (Todd Rawlings), другим инженером Microsoft, Джеймс распространил внутренний документ, пропагандирующий эту концепцию. В нем объяснялось, как создание центров обработки данных под водой может помочь Microsoft и другим провайдерам, применяющих облачные технологии, удовлетворять феноменальные потребности в росте с сохранением высокой степени экологичности решения.

Команда Natick: Eric Peterson, Spencer Fowers, Norm Whitaker, Ben Cutler, Jeff Kramer (слева направо)

Во многих крупных компаниях такие диковинные идеи, вероятно, тихонько умирают еще в зародыше, но только не в Microsoft, где исследователи уже имеют историю решения жизненно важных для компании проблем в инновационных направлениях, даже если проект находится далеко за пределами основной деятельности Microsoft и в реализации которого еще нет должного опыта. Ключ к успеху в том, что Microsoft собирает команды инженеров, не только среди своих специалистов, но и среди компаний-партнеров.

Четверо человек сформировало ядро команды, которой было поручено проверить далеко идущую идею Джеймса. И уже в августе 2014 года начал организовываться проект, получивший вскоре название Natick, лишь по той причине, что исследовательская группа любила называть проекты никак по другому, как названиями городов в Массачусетсе. И всего через 12 месяцев был готов прототип центра обработки данных, который предстояло погрузить на дно Тихого океана.

Трудности в реализации проекта

Недостатка в трудностях реализации проекта Natick не наблюдалось. Первой проблемой стало, конечно, обеспечение сухого пространства внутри большого стального контейнера, погруженного в воду. Другая проблема была в охлаждении. Нужно было придумать как лучше всего использовать окружающую морскую воду для охлаждения серверов внутри. И, наконец, возникал вопрос борьбы с ракушками и другими формами морской жизни, которые неизбежно будут облепливать погруженное судно — явлением, которое знакомо каждому, кто когда-либо держал лодку в воде в течение длительного периода времени. Прилипчивые ракообразные и подобные им, становились проблемой потому, что они мешали отводу тепла от серверов в окружающую среду (воду). Сначала эти проблемы пугали, но постепенно были разрешены, часто с применением проверенных временем решений от морской индустрии.

Установка серверной стойки в контейнер проекта Natick

Но зачем все эти сложности? Конечно, охлаждение серверов при помощи морской воды приведет к снижению затрат на охлаждение и может улучшить работу за счет других преимуществ, также, но зато погружение центра обработки данных в воду сопряжено с очевидными затратами и неудобствами. Попытка поставить тысячи серверов на морское дно действительно имеет смысл? Мы считаем, что имеет, и причин этому несколько.

Первая заключается в том, что это обеспечит Microsoft возможность быстро наращивать мощность, где и когда это необходимо. Корпоративное планирование стало бы менее обременительным, так как не нужно было строить объекты задолго до того, как они действительно потребуются, в ожидании более позднего спроса. Для отрасли, которая тратит миллиарды долларов в год на строительство постоянно растущего числа дата-центров, быстрое время отклика может обеспечить огромную экономию средств.

Вторая причина та, что подводные центры обработки данных могут быть построены быстрее, чем наземные, что достаточно просто понять. Сегодня строительство каждой такой установки уникально. Оборудование может быть одним и тем же, но строительные нормы, налоги, климат, рабочая сила, электроснабжение и сетевое подключение везде разные. И эти переменные влияют на продолжительность строительства. Мы также наблюдаем их влияние на производительность и надежность дата-центров, где идентичное оборудование демонстрирует различные уровни надежности в зависимости от того, где расположен дата-центр.

Как мы видим, Natick будет состоять из набора «контейнеров» — стальных цилиндров, каждый из которых будет содержать, возможно, несколько тысяч серверов впоследствии. Вместе они составили бы подводный дата-центр, находящийся в нескольких километрах от побережья и расположенный между 50 и 200 м под водой. Контейнеры могли бы либо плавать над морским дном на некоторой промежуточной глубине, и быть пришвартованными кабелями к дну океана, или они могли разместится на самом морском дне.

После развертывания модуля центра обработки данных он будет оставаться на своем месте, пока не придет время заменять серверы, которые он содержит. Или, возможно, изменятся рыночные условия, и его решат переместить куда-нибудь еще. Это настоящая изолированная среда, а это значит, что администраторы системы будут работать удаленно, и никому не удастся исправить ситуацию или заменить часть оборудования во время функционирования модуля.

Теперь представьте, что к этой концепции применяется процесс производства «точно в срок». Контейнеры можно было построить на заводе, снабдить серверами и подготовить к отправке в любую точку мира. В отличие от случая на суше, океан обеспечивает очень однородную среду, где бы вы ни находились. Поэтому никакая настройка контейнеров не потребовалась бы, и мы могли бы установить их быстро везде, где вычислительная мощность в дефиците, постепенно увеличивая размер подводной инсталяции для удовлетворения требований к производительности по мере роста. Цель Natick состоит в том, чтобы иметь возможность запускать центры обработки данных на прибрежных сайтах в любой точке мира в течение 90 дней с момента принятия решения о развертывании.

Уменьшение задержек к пользователям

Большинство новых дата-центров построены в местах, где электричество недорогое, климат достаточно прохладный, земля дешевая, и объект не мешает людям, живущим поблизости. Проблема с этим подходом заключается в том, что очень часто приходится ставить центры обработки данных вдалеке от населенных пунктов, что уменьшает скорость реакции серверов на запросы из-за роста latency.

Для интерактивных приложений, в которых происходит онлайн-взаимодействие с пользователем, эти задержки могут быть существенны и приводить к проблемам при больших значениях. Мы хотим, чтобы веб-страницы грузились быстро, а видеоигры, такие как Minecraft или Halo, были быстрыми и не лагали. В последующие годы будет появляться все больше и больше приложений с большим количеством взаимодействий, в том числе поддерживаемых HoloLens Microsoft и другими технологиями дополненной реальности. Так что действительно необходимо, чтобы серверы были ближе к людям, которых они обслуживают, что редко случается сегодня.

Возможно это покажется удивительным, но почти половина населения Земли живет не далее, чем 100 км от берега моря. Таким образом, размещение дата-центов у побережья вблизи прибрежных городов, сделает их значительно ближе к пользователям, нежели сегодня.

Экономия средств на охлаждении

Если этого основания недостаточно, примите во внимание экономию средств на охлаждении. Исторически системы охлаждения в центрах обработки данных потребляли почти столько же энергии, сколько сами серверы, так как применялись механические системы охлаждения.

В последнее время многие операторы центров обработки данных перешли на охлаждение при помощи воздуха, забираемого с окружающей среды — free-cooling, вместо механического охлаждения воздуха они просто используют очищенный воздух снаружи. Это намного снижает затраты энергии на охлаждение, которые составляют уже не 50% от общего потребления, а лежат в пределах 10-30%. Однако в некоторых местах температура окружающего воздуха слишком высока или имеет сезонные колебания, таким образом подобные центры обработки данных могут быть эффективны лишь в высоких широтах, вдали от населенных пунктов, что увеличивает задержки к пользователям.

Более того, дата-центры использующие охлаждение типа free-cooling, могут потреблять довольно много воды. Так как зачастую используется испарение, чтобы немного охладить воздух, продуваемый через серверы. Это проблематично в районах, подверженных засухе, таких как Калифорния, или где растущее население истощает местные водоносные горизонты, как это происходит во многих развивающихся странах. Но даже если вода в изобилии, добавление её в воздух делает электронику более подверженную к коррозии.

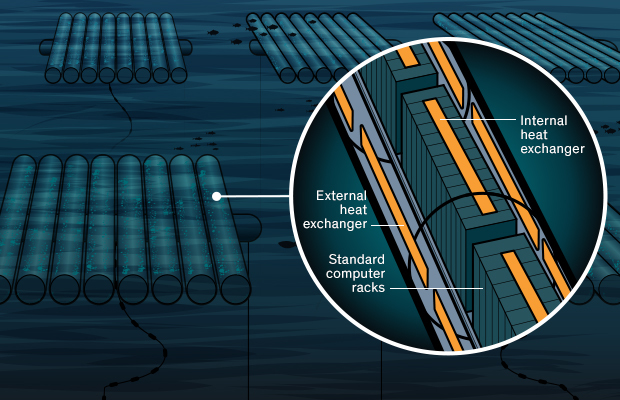

Архитекторы проекта Natick решают все эти проблемы. Внутренняя часть контейнера дата-центра состоит из стандартных компьютерных стоек, к которым крепятся теплообменники, отводящие тепло с воздуха в теплопроводную и теплоемкую жидкость, схожую с обычной водой. Затем эта жидкость закачивается в теплообменники на внешней стороне контейнера, которые, в свою очередь, отдают тепло в окружающий океан. Охлажденная жидкость затем возвращается во внутренние теплообменники для повторного цикла.

Конечно, чем холоднее окружающий океан, тем лучше эта схема будет работать. Чтобы получить доступ к холодной морской воде даже в летнее время или в тропиках, нужно будет поместить контейнеры с оборудованием достаточно глубоко. Например, на глубине 200 метров вблизи восточного побережья Флориды температура воды не повышается выше 15°C на протяжении года.

Прототип

Тесты прототипа установки Natick, которая получила название «Leona Philpot» (в честь игрового персонажа Xbox), начались в августе 2015 года. Установка была погружена на глубину всего лишь 11 метров в Тихом океане, вблизи города Сан-Луис-Обиспо в Калифорнии, где температура воды колеблется в пределах 14-18°C в течении года.

Серверная стойка, используемая в прототипе модуля подводного дата-центра, была заполнена, как реальными серверами, так и фиктивными нагрузками, которые потребляют такое же количество энергии, что и сервер

Серверная стойка, используемая в прототипе модуля подводного дата-центра, была заполнена, как реальными серверами, так и фиктивными нагрузками, которые потребляют такое же количество энергии, что и серверВ ходе этого 105-дневного эксперимента было показано, что возможно поддерживать серверы охлажденными до таких же температур, как и с применением механического охлаждения, но с невероятно низкими энергозатратами — всего 3 процента. Эти энергозатраты значительно ниже, чем у любого промышленного или экспериментального центра обработки данных, о котором известно сегодня.

Кроме того отпала необходимость в содержании персонала на месте, местах для парковки, тревожных кнопках и охране. В контейнере была создана атмосфера без применения кислорода, что делает возникновение пожара невозможным, а управление оборудованием может осуществляться из комфортного офиса сотрудниками Microsoft. Более того из атмосферы контейнера был также удален весь водяной пар и пыль. Это сделало среду очень комфортной для электроники, что минимизировало проблемы с распределением тепла и коррозией разъемов.

Взгляд в будущее. Будущие дата-центры будут значительно длиннее прототипа, и каждый из них будет содержать большое количество серверных стоек. Электроника будет охлаждаться за счет передачи отработанного тепла в окружающую морскую воду с использованием внутренних и внешних теплообменников.

Защита окружающей среды и обеспечение энергией

Корпорация Майкрософт стремится защищать окружающую среду. Например, для удовлетворения своих потребностей в электроэнергии, компания использует как можно больше возобновляемых источников энергии. В той мере, в какой это возможно. Однако все же приходится проводить компенсацию выбросов углерода. В соответствии с этой философией компания планирует развертывать будущие подводные дата-центры вблизи прибрежных источников возобновляемой энергии — будь-то прибрежная ветровая электростанция или какая-либо морская энергетическая система, которая использует силу приливов, волн или течений.

Эти источники энергии обычно присутствуют в изобилии на шельфе, а это значит, что будет возможность размещать оборудование близко к людям и иметь доступ к большому количеству зеленой энергии одновременно. Подобно тому, как наземные дата-центры становятся толчком к построению новых инфраструктур по обеспечению возобновляемыми источниками энергии, аналогичное может произойти и с подводными центрами обработками данных. Вероятно их наличие будет стимулировать строительство новых инфраструктурных объектов, которые обеспечат экологически чистой энергией не только подводные дата-центры, но и население.

Другим фактором, который следует учитывать, является то, что традиционно генерируемая электроэнергия не всегда легко доступна, особенно в развивающихся странах. Например, 70 процентов населения Африки к югу от Сахары не имеют доступа к электрическим сетям вообще. Поэтому, если вы хотите построить центр обработки данных и сделать доступными сервисы для такого населения, вероятно вам также нужно будет предоставить им и электроэнергию.

Как правило электричество передается на большие расстояния с применением высоковольтных линий передач и напряжений от 100 000 вольт или выше, для уменьшения потерь, но в конечном счете серверы используют то же самое низкое напряжение, что и ваш домашний компьютер. Для снижения напряжения в сети до значений, пригодных для серверного оборудования, обычно требуется три отдельных устройства. Вам также понадобятся резервные генераторы и множество батарей для обеспечения питания в случае отказа энергосети.

Размещение подводных дата-центров вблизи прибрежных источников энергии позволило бы инженерам упростить инфраструктуру. Во-первых, можно было бы подключиться к электросети с более низким напряжением, что позволило бы исключить некоторые преобразователи напряжения на пути к серверам. Во-вторых, подключая серверы к независимым энергосетям, питаемым энергией ветра или морскими турбинами, можно обеспечить отказоустойчивость. Это уменьшит, как электрические потери, так и вложения средств в целом в общую архитектуру центра обработки данных, которая защитит от отказа местной электросети.

Дополнительное преимущество этого подхода в том, что воздействие на землю будет оказывать разве что оптоволоконный кабель или два кабеля, которые будут использоваться для передачи данных из подводного дата-центра.

Вопросы и изыскания

Первый вопрос, который задает почти каждый, кто узнает об этой идее: А как электроника будет оставаться сухой? Правда состоит в том, что поддерживать сухой климат внутри контейнера с серверами не сложно. Морская промышленность научилась сохранять оборудование сухим в океане задолго до того, как появились первые компьютеры, причем зачастую в гораздо более неблагоприятных условиях, чем те, которые могут быть в рамках данного проекта.

Второй вопрос, который стоял на ранней стадии, — как охладить серверы наиболее эффективно? Команда проекта исследовала ряд экзотических подходов, включая использование специальных диэлектрических жидкостей и материалов с фазовым переходом, а также необычные теплоносители, такие как газообразный гелий под высоким давлением и сверхкритический углекислый газ. Хотя такие подходы имеют свои преимущества, они также вызывают большие проблемы.

Исследователи продолжают изыскания в области применения экзотических материалов для охлаждения, однако, в ближайшей перспективе, реальной необходимости в них не предвидится. Охлаждение при помощи воды и использование радиаторных теплообменников в рамках проекта Natick обеспечивают очень экономичный и эффективный механизм охлаждения, который отлично работает со стандартными серверами.

Биологическое обрастание и влияние окружающей среды

Более существенно, по-нашему мнению то, что подводный дада-центр будет привлекать морскую жизнь, образуя искусственный риф. Этот процесс колонизации морскими организмами, называемый биологическим обрастанием, начинается с одноклеточных существ, за которыми следуют несколько более крупные организмы, которые питаются этими клетками, и так далее по пищевой цепи.

После 105 дней пребывания в воде части капсулы с оборудованием стали покрыты морской жизнью в результате явления биологического обрастания, знакомого яхтсменам

Когда исследователи погрузили прототип Natick на дно, крабы и рыба собрались вокруг в течении суток и стали обживать новое жилище. Исследовали были счастливы, что создали дом для этих существ, поэтому одной из основных сложностей в дизайне стал вопрос того, как поддерживать эту среду обитания, не препятствуя способности подводного дата-центра поддерживать серверы внутри достаточно охлажденными.

В частности, известно, что биологическое обрастание внешних теплообменников нарушит отвод тепла с этих поверхностей. Таким образом, исследовали начали исследовать использование различных противообрастающих материалов и покрытий — даже активных средств устрашения с использованием звукового или ультрафиолетового света — в надежде усложнить появление живых организмов. Хотя физически теплообменники можно чистить, полагаться на такие вмешательства, было бы неразумно, учитывая цель — максимально упростить обслуживание.

К счастью, теплообменники контейнера Natick оставались чистыми во время первого развертывания, несмотря на то, что они находились в очень неблагоприятной среде — мелководье и вблизи берега, где океаническая жизнь наиболее распространена. Однако биологическое обрастание остается областью активных исследований, и исследователи продолжают изучать её с упором на подходы, которые не будут наносить ущерб морской среде.

Отказ оборудования, безопасность и воздействие на окружающую среду

Самой большой проблемой, с которой столкнулись исследователи во время тестирования, стал выход оборудования из строя и невозможность замены конкретного сервера в серверной стойке или жесткого диска, сетевой карты либо другого компонента конкретного сервера. Реагировать на аппаратные сбои приходится только удаленно и автономно. Потому в этом направлении ведется активная работа даже в обычных наземных центрах обработки данных Microsoft, чтоб повысить способность обнаружения и обеспечить возможность устранения сбоев без участия человека. Аналогичные методы и опыт будет применен к дата-центрам Natick в будущем.

А как насчет безопасности? Данные надежно защищены от виртуальной или физической кражи, если они размещаются под водой? Абсолютно. Natick обеспечит такое же шифрование и другие гарантии безопасности, что и у наземных центров обработки данных Microsoft. В то же время, поскольку ни один человек не будет присутствовать рядом с контейнерами с оборудованием физически, Natick будет получать данные об изменениях в окружающей среде при помощи датчиков, в том числе сообщит о случаях присутствия любых неожиданных посетителей.

Вы можете также задаться вопросом, будет ли тепло, выделяемое подводным центром обработки данных, оказывать негативное воздействие на местную морскую среду. Скорее всего, нет. Любая теплота, выделяемая контейнером Natick, быстро перемешается с прохладной водой и унесется течением. Вода в нескольких метрах ниже по течению от контейнера Natick будет теплее всего лишь на несколько тысячных долей градуса в лучшем случае.

Поэтому воздействие на окружающую среду будет очень незначительным. Это важно, потому что в будущем обязательно будет построено намного больше подводных дата-центров и вероятно, что люди начнут работать под водой для их поддержки и обеспечения.

ВЫВОДЫ

На первый взгляд идея управления дата-центрами, которые размещаются на холодном океаническом дне, выглядит весьма привлекательной: капсула, заполненная стойками с серверами, требует постоянного и точного контроля температуры. Почему не переложить эту работу на холодное океаническое дно, где температура воды близка к 0 градусам по Цельсию?

Команда Natick, работающая над внедрением этого решения, именно такого мнения. Их идея — размещение центров обработки данных в океане вблизи побережья: «более половины населения Земли проживает не далее 200 км от береговой линии», говорит один из инженеров проекта в фильме, приводя аргументы за размещение серверов в океане близ берега:

Основная задача — уменьшить расстояние между пользователями и запрашиваемыми данными, иметь возможность развернуть облачную инфраструктуру в изолированных контейнерах в течении 90 дней в нужной локации по всему миру, что позволит сэкономить на доставке данных к пользователям и стать ближе к ним, а также сэкономить на охлаждении и питании, сделать центры обработки данных более экологически чистыми.

Получится ли задуманное? Наверняка. Уже получилось, вопрос только в том, когда подводные дата-центры будут распространены в промышленных масштабах. Сегодня Microsoft владеет более 100 дата-центрами по всему миру, в которых размещается свыше миллиона серверов, свыше $15 млрд. расходуется на IT-инфраструктуру ежегодно, возможно, в скором времени, дата-центры все же начнут строить и под водой.

Статья опубликована при содействии хостинг-провайдера ua-hosting.company. Потому, пользуясь случаем, хотим напомнить об акции:

VPS (KVM) c выделенными накопителями (полноценный аналог выделенных серверов начального уровня от $29) в Нидерландах и США бесплатно на 1-3 месяца для всех + бонус 1 месяц для geektimes

Не забывайте, что Ваши заказы и поддержка (сотрудничество с Вами), позволят опубликовать в будущем еще большее количество интересного материала. Будем признательны Вам за Ваши отзывы и критику и за возможные заказы. ua-hosting.company — рады сделать Вас счастливее.

Комментарии (26)

HellMaster_HaiL

13.03.2017 20:21Админы-подводники?

HostingManager

14.03.2017 10:18Администраторы смогут обслуживать данную инфраструктуру удаленно. К тому же, очень сомневаюсь, что кто-то будет нырять на 200 метров. Даже промышленные водолазы очень редко когда работают на таких глубинах, ввиду необходимости прохождения длительной декомпрессии. Так что, вполне вероятно, что обслуживание будет проходить исключительно путем извлечения капсулы на поверхность.

gimntut

14.03.2017 06:34Это как же осложнится жизнь полицейских, которые захотят ворваться в датацентр и изъять сервера.

«более половины населения Земли проживает не далее 200 км от береговой линии»

Надо было прикрепить к статье опрос «Какое расстояние от вас до ближайшего океана?»

Мне кажется, больше половины населения России окажется дальше 200 км.

С другой стороны, эту технологию, наверное, можно применять не только в океане, но в водохранилищах.

Или даже создавать специальные искусственные водоёмы, без живности или наоборот с осетрами всякими, которым подогретая вода придётся по вкусу.

HostingManager

14.03.2017 10:16Не поверите, но население России (146 млн) составляет всего лишь 2% от населения Земли (7.3 млрд). Так что расчеты верны, основная концентрация населения — у океанов. Хотя в водоемах также не мешает никто размещать подобные инфраструктурные объекты, Вы правы.

rPman

14.03.2017 08:50+1Не понимаю, почему оказывается удобнее размещать сервер под водой, вместо того чтобы просто гонять теплоноситель вода/берег (корабль)?

Ilyato

14.03.2017 09:58А какое давление будет поддерживаться внутри этой капсулы?

HostingManager

14.03.2017 10:09Поскольку плотность газа должна быть достаточно высока, чтоб эффективно отводить тепло, то стоит предположить, что давление должно быть не менее атмосферного. Однако, как было упомянуто в статье:

Команда проекта исследовала ряд экзотических подходов, включая использование специальных диэлектрических жидкостей и материалов с фазовым переходом, а также необычные теплоносители, такие как газообразный гелий под высоким давлением и сверхкритический углекислый газ. Хотя такие подходы имеют свои преимущества, они также вызывают большие проблемы.

Возможно, если оборудование будет работать под высоким давлением внутренней атмосферы, теплоотвод может быть эффективнее.

Pakos

14.03.2017 11:11Интересно, для работы электрогенератора Пельтье нужна разница температур, а тут как раз она есть. Вопрос в эффективности — имеет ли смысл его размещать, КПД, цена, ресурс и объём выработки под вопросом.

Искать особо лень (да и наверняка майкросовтофцы рассматривали вариант), но что увидел — генератор от выхлопа 120+градусов — 24В, 5-7Вт весит 63кг. Здесь будет поменьше (рессеивать тепло будет внешняя обшивка), но на смешной сервер даже 250Вт нужно будет полсотни таких — они займут всё место. Питать ими можно будет разве что насосы прокачки теплоносителя, но стоит ли — цена, надёжность и лишние детали явно не добавят плюсов такому ДЦ.

potan

14.03.2017 18:39Почему капсулы заполнены газом, а не жидкостью?

HostingManager

14.03.2017 23:58Видимо потому, что уже разработанная система отвода тепла от шкафов — достаточна и прослойка воздуха получается совсем небольшой между сервером и радиатором с жидкостью, который отводит тепло.

fabervox

14.03.2017 23:59Может быть, потому-что продукты горения могут возникать в жидкостях, но не в газе. Во всяком случае, на современных подстанциях выше 6кВ, используются вакуумные или элегазовые выключатели, там цель гасить даже не горение, а дугу.

nikolajbezcelovecnyj

15.03.2017 19:13можно использовать подводные лодки тут тебе и атомный реактор и размер и мобильность.

Fan_Fan

Не понятно, почему они не строят дата-центры на Аляске или в условиях вечной мерзлоты. На Аляске, кстати, можно использовать это тепло для отопления домов.

HostingManager

Алсяка слишком удалена и есть масса других мест, помимо Аляски, обратите внимание на важный момент в статье — смысл проекта в том, чтоб стать географически ближе к пользователям. Уменьшить задержки (latency).

Но думаю, что какие-то дата-центры на Аляске есть.

fabervox

Так ведь и речь идет, уже не об экономии на охлаждении, приближающейся к 100%.

Нельзя достигнуть энергетический КПД больше, да и даже близко к 100%, а тут пожалуйста, вычисления — полезное действие, тепловыделение, как следствие процесса вычисления, тоже полезное действие, значит в сумме, полезного действия может быть больше. Представьте что на электростанциях, никогда не использовалось бы тепло для отопления, сколько энергии ушло бы впустую. Впрочем физические законы, не позволяют получить КПД больше, а вот философия может помочь в том что считать полезным действием)

Ещё интересный подход в охлаждении давно попадался, кажется на мембране(когда она ещё была жива) читал новость, что IBM сделала экспериментальный процессор(начинка стандартная изменения в сборке) с интегрированной капиллярной системой охлаждения, с чем поставила рекорд энергоэффективности суперкомпьютеров(во всяком случае там так писали) ), впрочем не это главное. Они там использовали высокие температуры(что-то там 65 градусов что ли), и принудительной циркуляцией добивались и охлаждения процессора и поддержания температуры в системе охлаждения. Беглым поиском статью не нашел, если интересно, найду, кину ссылку.

Here_and_Now

интересно

fabervox

Вчера, название оттолкнуло, IBM обещает миру суперкомпьютер в кубике сахара.

Here_and_Now

Спасибо. Это получается водные трубки сразу и в сокет и в материнскую плату будут встроены.

fabervox

Если учесть, что в последнее время стараются уместить, всё в систему на кристале(SoC), то понятие материнской платы сильно изменится, к моменту реализации и достижения популярности, каких-то таких систем охлаждения. Скорее всего они будут чем-то вроде DIN рейки, т.е. просто местом крепления процессоров, видеокарт, памяти, интерфейсных плат, винчестеров и м.б. каких-то плат питания, если БП не будут иметь нужных напряжений/регулирования.

Ну и вспоминается такой момент, из «разборки» чипа Baikal-T1.

Т.е. уместив всю систему на кристале[-ах], уменьшив интерфейсы, разведение контактов можно сделать как в box-процессорах охлаждение, зашив всё красивой «крышечкой» с креплением на рейку. А вывести минимум контактов, питания по напряжениям(если будут нужны разные), также небольшое кол-во на интерфейсы, и «фитинги» охлаждения.

И если цены на киловатт, будут неплохие, сетевая инфраструктура будет улучшаться, то роль суперкомпьютеров, заменят распределенные отопительные системы. С теплыми широтами будет сложнее, но может это подтолкнет к развитию систем кондиционирования.

И так смотришь сисадмины будут работать в ЖЕКах, обслуживающих такие системы)

Но для такого светлого будущего, нужен чей-то смелый шаг… или кризис который сделает всех смелее.

stychos

А что там такого в box-процессорах? Все эти тысячи ножек у всех современных процессоров — именно по питанию.

fabervox

У BOX? Крышечка, которая обеспечивает лучшее охлаждение, за счет того что первично тепло распределяется на большую поверхность, без недостатков термопасты и неидеального монтажа/поверхности радиатора.

В основном по питанию кол-во ножек, но если бы лишь по питанию, то можно было бы зашить разводку под крышечку. Там все же остается довольно много и не по питанию, например AMD только вот вот, вобрал в себя северный мост. Когда на материнке из не силовых элементов останется флеш биоса и один чип на всё остальное, вот тогда там действительно не будет лишних пинов.

stychos

Не, не взлетит.

reff

Например, потому, что нельзя охлаждать оборудование сухим очень холодным воздухом. На Хабре была статья про (от?) полярного админа.

HostingManager

Да, Вы правы. Воздух нагревают очень холодный, ибо большой разницы температур не должно быть. Это тоже не гуд.