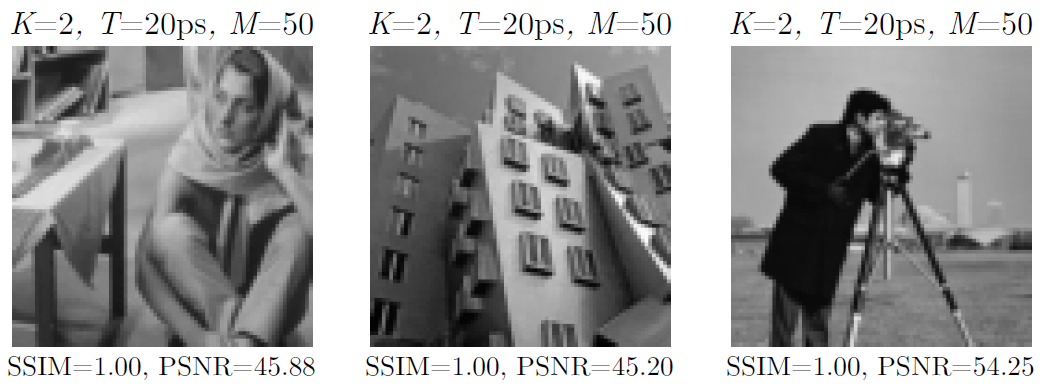

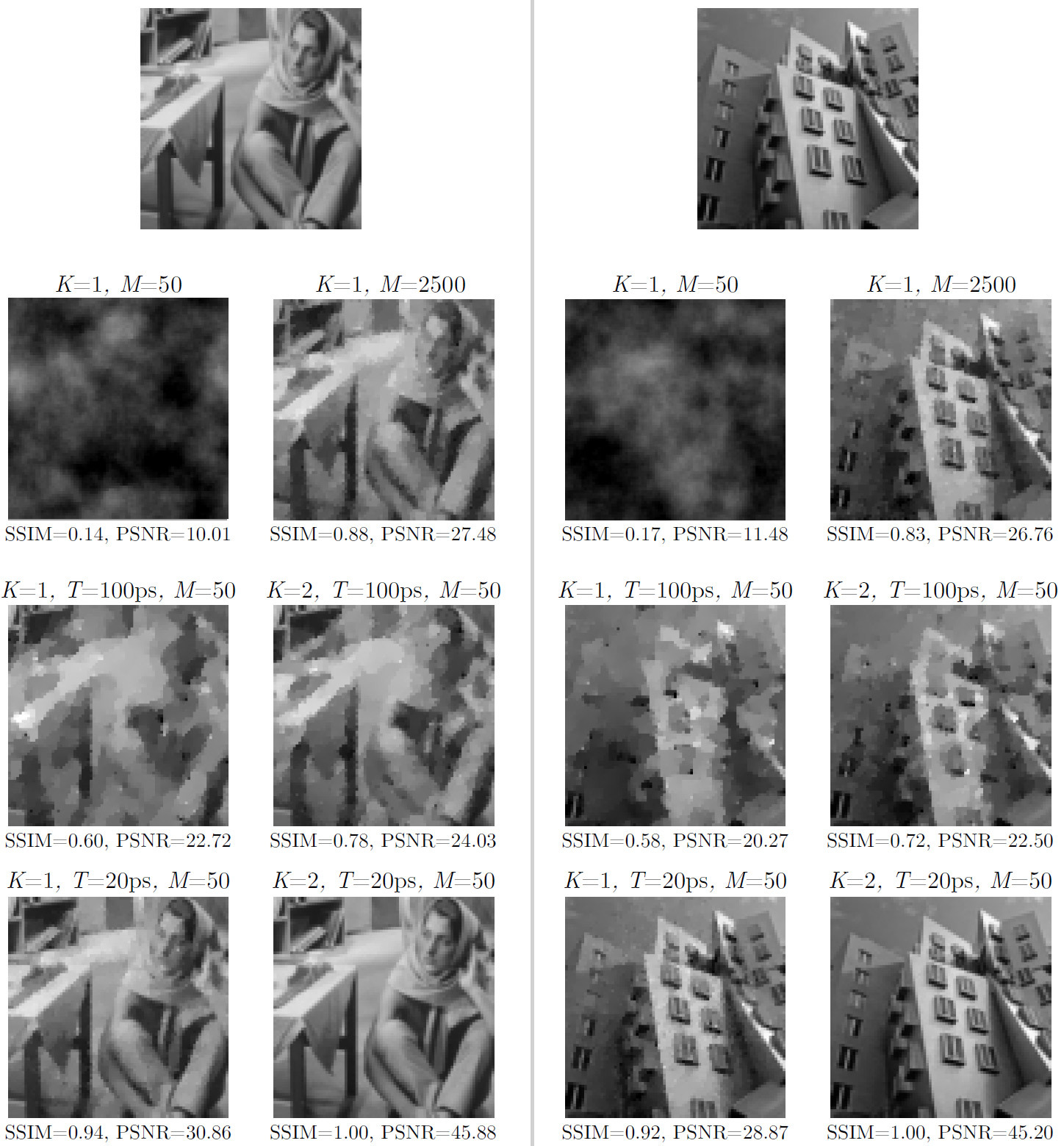

Образцы фотоснимков, сделанных новой однопиксельной камерой с подсветкой всего по 50 шаблонам из случайного распределения Бернулли (M=50)

В традиционной цифровой фотосъёмке принято использовать объектив, который формирует световой поток и направляет его на матрицу светочувствительных элементов — ПЗС или КМОП сенсор цифровой камеры. Считается, что чем больше элементов в матрице, тем лучше фотография: 20 миллионов элементов лучше, чем 13 миллионов. Это один из основных показателей качества фотографии, вместе со светосилой объектива и плотностью самих элементов (чем меньше плотность, тем больше физический размер матрицы, тем меньше искажений и наводок дают элементы).

Но что если у фотоаппарата вообще нет объектива, а светочувствительная матрица состоит из 1 (одного) пикселя? Современные цифровые технологии обработки сигналов действительно позволяют очень быстро собрать и обработать световой поток одним-единственным светочувствительным элементом. В этом случае фотоаппарату не нужны не объектив, ни большая матрица. То есть фотоаппаратура заменяется на компьютерные вычисления.

Техника однопиксельной фотосъёмки является частью нового подхода, который называется вычислительной фотографией. Сюда же относятся и другие инновационные вычислительные методы для манипуляций над световым потоком: склейка панорам, расширение динамического диапазона за счёт многократной экспозиции с разными выдержками, камеры светового поля, даже пресловутую щелевую фотосъёмку можно отнести в эту категорию.

В вычислительной фотографии объект съёмки подвергается измерениям, которые затем декодируются для получения изображения. Одна из фундаментальных задач — избавиться вообще от объектива, поскольку это самая дорогая и тяжеловесная часть фотоаппарата. При достаточно мощном процессоре объектив не нужен.

Одно из наиболее перспективных направлений вычислительной фотографии — сжатие измерений (compressive sensing). Именно использование такой техники даёт возможность сконструировать однопиксельную камеру, впервые описанную в литературе в 2008 году. Оригинальная модель однопиксельной камеры представляет собой оптический компьютер, состоящий из одного светочувствительного диода, цифрового микрозеркала (DMD), двух линз и аналого-цифрового преобразователя.

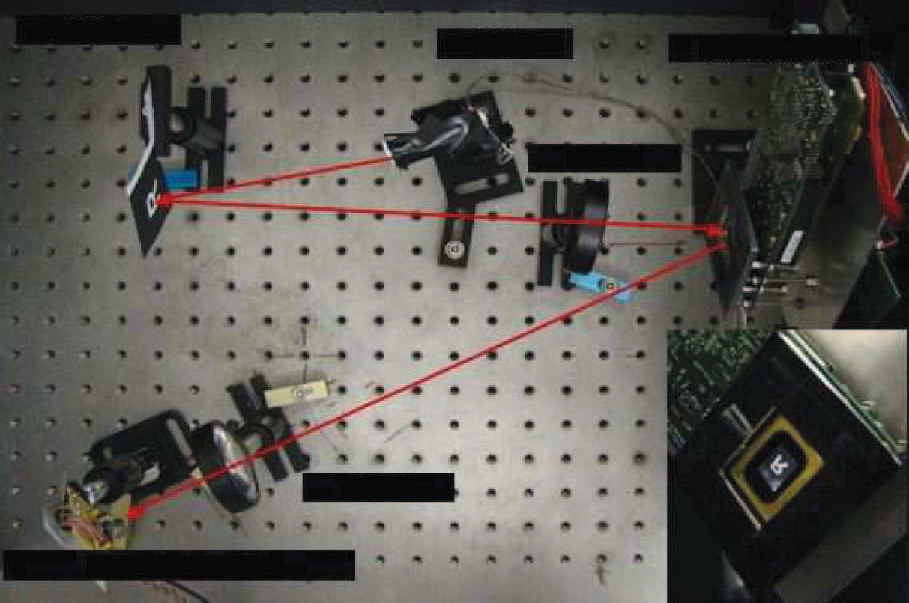

Оригинальная модель однопиксельной камеры в лаборатории (2008)

Несмотря на такую примитивную конструкцию с одним фотодиодом камера вполне узнаваемо фиксировала объекты при съёмке. В данном случае цифровое микрозеркало выступает в роли пространственного модулятора света (ПМС) — необходимого элемента любой однопиксельной камеры. В роли ПМС может быть и другое устройство, которое накладывает определённой пространственной модуляции на луч света под управлением компьютера. Так сигнал кодируется, а после его регистрации и записи — раскодируется обратно и формирует изображение.

Реконструкция измерений, сделанных фотодиодом, в виде чёрно-белого и цветного изображений 256?256 пикселей (вторая и третья фотографии) в модели образца 2008 года. На первом изображении — оригинальное изображение

Однопиксельная камера требует проведения тысяч последовательных измерений, где скорость является ключевым фактором. Чем быстрее проводятся измерения — тем лучше (желательно, чтобы объект не двигался во время измерений).

Технологический прогресс не стоит на месте, и сенсоры последнего поколения способны регистрировать сигнал гораздо быстрее, чем предыдущие, что открывает новые возможности для создания однопиксельных камер лучшего качества. В недавнем номере журнала IEEE Transactions on Computational Imaging за 20 марта 2017 года описана современная однопиксельная камера с подсветкой объекта, которая работает во временном масштабе пикосекунд.

Авторы научной работы из лаборатории Media Lab при Массачусетском технологическом институте объясняют, что пикосекундный интервал позволяет различать отдельные фотоны, поступающие на сенсор с различных точек объекта с миллиметровым разрешением. При этом сенсор регистрирует больше информации от этого фотона, чем просто факт поступления (в отличие от обычного пикселя), так что требуется меньше масок в качестве ПМС.

Однопиксельные камеры с интервалом в пикосекунду или меньше создавались и раньше, но они страдали от низкой чувствительности. Хорошую чувствительность демонстрировал Single Photon Avalanche Photodiode (SPAD) — на уровне современных КМОП, но у него была низкая скорость работы, десятки пикосекунд между измерениями.

В новой научной работе описано устройство, которое сочетает в себе преимущества всех однопиксельных камер, созданных ранее: оно работает в масштабе пикосекунд и демонстрирует чувствительность как у SPAD. Эксперименты показали, что для получения качественных изображений в таком временном масштабе измерений им требуется в 50 раз меньше шаблонов подсветки, чем в традиционных однопиксельных камерах. То есть сформировать изображение можно в 50 раз быстрее.

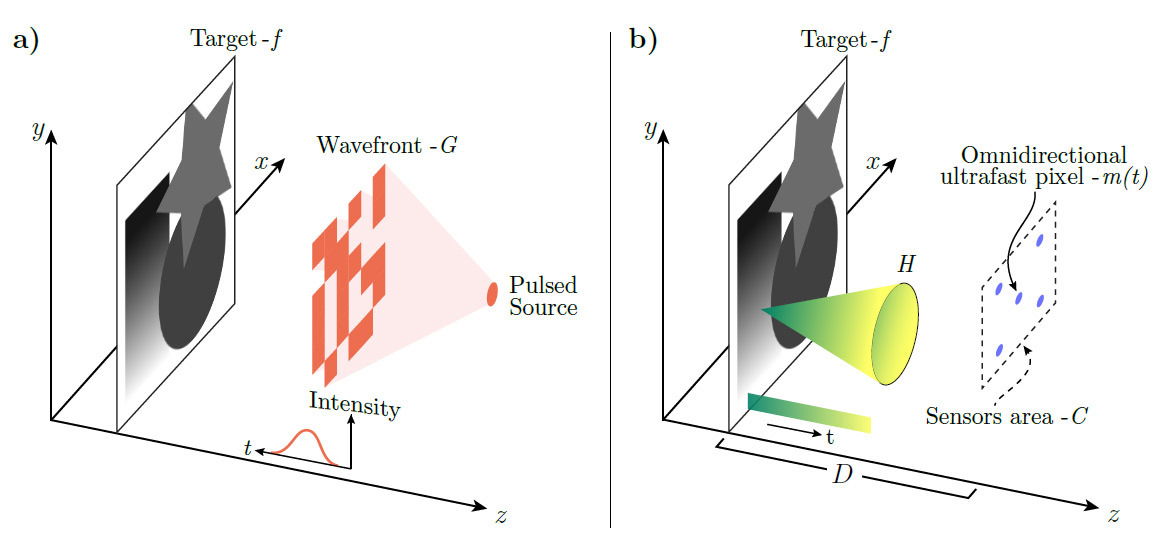

Принцип работы сверхбыстрой однопиксельной камеры образца 2017 года: (a) подсветка с модулированием волнового фронта; (b) измерения времени прихода отражённых фотонов сверхбыстрым всенаправленным сенсором

Принцип работы камеры показан из иллюстрации. Нужно понимать, что каждая точка фотографируемого объекта отражает световой конус. Регистрируя фотоны из конуса, можно делать вывод о форме всего объекта целиком и о расстоянии до каждой точки.

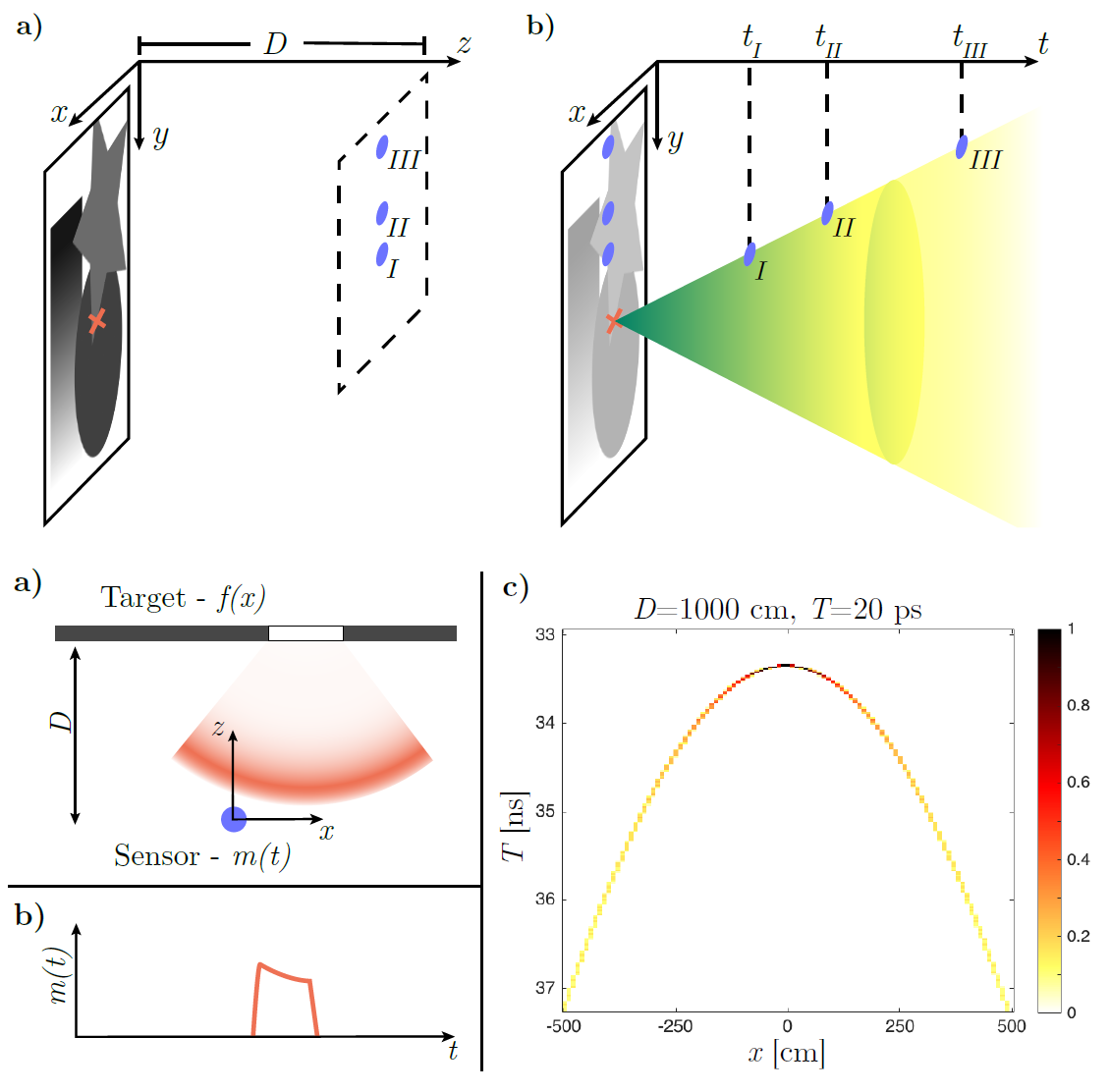

Регистрация фотонов из светового конуса в разных точках пространства (вверху) и анализ сигнала (внизу)

Камера демонстрирует отличное качество фотосъёмки. На следующих образцах приводится сравнение фотографий образца (вверху) обычной однопиксельной камерой с 50 и 2500 шаблонами подсветки (второй ряд), а также однопиксельной камеры новой конструкции (третий и четвёртый ряд). Шаблоны подсветки выбираются из случайного распределения Бернулли в {?1, 1}, как и в эксперименте с обычной однопиксельной камерой. Обратите внимание, что в образцах с новой камеры используется всего 50 шаблонов.

Как видим, у новой разработки качество съёмки гораздо выше даже при кардинальном уменьшении шаблонов подсветки.

Описанная конструкция однопиксельной камеры с активной подсветкой значительно превосходит аналогичные однопиксельные камеры по ряду технических характеристик. Это даёт возможность рассчитывать, что в будущем подобные дешёвые камеры без подвижных частей могут найти практические применение в повседневных бытовых приборах.

Научная работа опубликована 20 марта 2017 года в журнале IEEE Transactions on Computational Imaging (doi:10.1109/TCI.2017.2684624, pdf).

Комментарии (52)

nazarpc

30.03.2017 22:21+5- У тебя какая камера в телефоне?

- 1 пиксель:)

choupa

30.03.2017 22:26+3Я так понимаю, что от далёких объектов приходит меньше света, т.к. светой конус расходится. Это можно учесть в вычислениях. Но как быть с небом — оттуда отражённый поток не придёт вовсе. И то же время камера никак не учитывает собственное свечение объектов. Отсюда я заключаю, что небо на снимке будет абсолютно чёрным. Однако на фото танцующего дома небо — вполне себе небо, да ещё с облаками.

Чёт я не догоняю явно.

И вообще это скорее не камера, т.к. не передаёт объеты, как их видим мы: с тенями и прочими источниками света, а скорее тахеометр, сканирующий трёхмерную сцену.

lv333

30.03.2017 23:08+2Тут более понятно описано этот эффект, хотя сама система сложнее. А вообще мне это все чем то напомнило механическое телевидение

kAIST

30.03.2017 23:55+4Спасибо. Много противоречий статьи в популярной механики и этой на гигтаймсе, которая больше похожа на «учёный изнасиловал журналиста».

Цель такой камеры не избавиться от объектива, а уменьшить количество сенсоров света, которые в некоторых случаях намного дороже чем массив из движущихся микролинз.

Например, для традиционной фотографии в видимом диапазоне, гораздо дешевле оставить классическую матрицу. А вот для таких девайсов, как тепловизоры, возможно будет дешевле использовать всего один чувствительный элемент, а остальное делать уже по этой технологии.

lv333

31.03.2017 00:08+2Именно о тепловизоре я и подумал в первую очередь, когда понял принцип работы этого устройства :)

edd_k

31.03.2017 08:11-2И разнообразная "умная" техника будущего (домашняя, к примеру), которой необходимо электронное "зрение", но обвешать ее обычными объективами — не вариант.

Хотя вроде и малюсенькими объективами, которые в телефоны пихают, можно обойтись...

iliasam

31.03.2017 17:38+2В статье идет речь про фотокамеру, которой обязательно наличие активной подсветки. В случае тепловизора внешняя подсветка бесполезна — важно зарегистрировать именно излучаемое объектами излучение.

А вот тепловизоры с механическим сканированием и одним датчиком появились очень давно — матриц микроболометров тогда просто не было.

Sadler

31.03.2017 06:19+1Однако на фото танцующего дома небо — вполне себе небо, да ещё с облаками.

Вы так говорите, будто авторы работы хотя бы одно реальное фото вне лаборатории своей камерой сделали. Смотрите фото стенда в статье, все «фото» сделаны на нём, а сами изображения изначально плоские и достаточно известные.

choupa

30.03.2017 23:47Так ведь нет, это не то. Там система зеркал, являясь маской пассивно воспринимает падающий свет, а здесь речь идёт о вспышке, на которую накладывается маска, а потом принимаем назад отражённый световой фронт, который уже размазан во времени, за счёт разного расстояния до объектов сцены… Я так по крайней мере понял.

И ещё вспомнилась такая шпионская технология времён электронно-лучевых мониторов. Если в тёмной комнате работает монитор, то наблюдая с большим временным разрешением отсветы в комнате, даже издали, и даже с закрытыми шторами, можно получить развёртку луча и, тем самым, восстановить изображение на экране. Тут принцип, можно сказать, тот же, только пикосекундные времена.

ilansk

31.03.2017 08:21+1Всё же технология найдет своего потребителя как в фототехнике так и мониторах этак в году 2037м от Р.Х.

ruYeti

31.03.2017 08:31Считается, что чем больше элементов в матрице, тем лучше фотография: 20 миллионов элементов лучше, чем 13 миллионов. Это один из основных показателей качества фотографии...

И снова) Не качества, а разрешения.SandroSmith

31.03.2017 15:48+1Нет, ну конечно, если на 13МП горизонт завален и резкости нет, то 20МП не спасут ситуацию. Но при прочих равных качество всё таки растёт. Нелинейно, но растёт.

aamonster

01.04.2017 01:16Не обязательно. Больше пикселей на том же размере матрицы — большая часть матрицы занята промежутками между пикселями, меньше общая площадь пикселей, больше шум.

Gryphon88

01.04.2017 01:43Если плюнуть на цену, как это делают астрономы (спецархитектура, охлаждение жидким гелием), то пока хватает фотонов, качество будет расти. Правда, с определенного эквивалентного размера пиксела асимптотически

aamonster

01.04.2017 08:04Ну, у астрономов особый случай: они и физический размер матрицы могут увеличивать с чистой совестью, и вообще от классических матриц уходить. Рассказывали мне про чудо-девайс, ловящий одиночные фотоны. По сути, матрица — один «пиксель», при попадании фотона получаем разные напряжения на 4 электродах и по ним считаем координаты попадания — совсем как на сенсорном экране.

Вот это я понимаю — однопиксельная матрица, а какое у неё ISO — даже подумать боюсь.

SandroSmith

01.04.2017 01:49Вот сейчас вообще не понял. Каким образом при увеличении количества пикселей будут увеличиваться промежутки между ними?

aamonster

01.04.2017 07:56Нарисуйте ручкой квадрат 1x1 см.

Разделите его на квадратики 2x2 мм. Какую часть квадрата заняли линии?

А теперь попробуйте разделить на квадратики поменьше — скажем, 0.5x0.5 мм. Много места осталось в квадратиках? Вот.

Т.е. увеличение мегапухелей без увеличения физического размера матрицы — технически сложная задача, надо менять техпроцесс (уменьшать промежутки), если просто гнаться за количеством — увеличится шум.

Alexsandr_SE

31.03.2017 10:04совсем не уверен, что даже при большем увеличении скорости сканирования это хорошее решение. микролинзы или зеркала есть. Получается от подвижных механизмов мы не избавились, а объектив просто вынесли дальше самого аппарата. Вопрос где и зачем это применять? Скорее всего опять создадут массив однопиксельных сенсоров для нужд практических.

Shtorkin

31.03.2017 10:22На картинках не пример съемки, а сравнение качества в зависимости от параметров. Светотеневого рисунка при такой съемке быть не может

Caelwyn

31.03.2017 12:58+1Как-то на заре телевидения использовалать подобрая техника съёмки бегущим лучём. Суть была в том что вместо камеры был один светочувствительный элемент, объект съёмки сидел в полной темноте, и по нему бегал тонкий луч света (развёртка). Соответсвенно фотоэлемент и замерял отражённый от объекта свет.

Zenitchik

31.03.2017 15:29«Камера пишет панораму».

Съёмка поверхностей Луны и Венеры производилась именно такими камерами.

Gryphon88

31.03.2017 13:05Я правильно понял (из статей по ссылкам), что камера смотрит в задний фокус линзы и снимает по факту преобразование Фурье изображения?

qbertych

31.03.2017 15:52+1В принципе да, это far-field imaging. Но это не главная их фишка.

Главная фишка — в том, что они одновременно освещают разные участки объекта. Если они находятся на разном расстоянии от диода, то свет с одного края объекта будет приходить быстрее, чем с другого. То есть за один прием можно считать не один пиксель, а несколько.

Отсюда и минусы: быстрые лавинные диоды — это дорого. А еще они боятся яркого света. И с, кхм, динамическим диапазоном у них не все хорошо. Ну и быстрый импульсный источник здесь тоже не помешал бы.

P. S. Вот страничка разработчиков, там еще и видео есть.

Gryphon88

31.03.2017 16:45Спасибо большое. Из одной этой гифки я понял больше, чем по статье. Ещё такой вопрос: если у нас есть сверхбыстрая камера и модулирующее зеркало или иной девайс для structured illumination, получается, можно пересчитать все источники света в фокальном плане?

qbertych

31.03.2017 17:07Насколько я понимаю, да. Но тут появляются проблемы с разрешением: у лучших SPADов оно около 50 пс, это полтора миллиметра по воздуху. То есть освещать участки слишком близко друг к другу не стоит.

sergehog

31.03.2017 13:19+3Digital Micromirror Device (DMD) это не не просто цифровое микрозеркало, а большой двухмерный массив микро-зеркал.

Поступающий от объекта свет сфокусированный линзой проходит модуляцию на DMD, т.е. только какие то рандомные пиксели выбираются а потом другой линзой сводятся в одну точку, в которой стоит оптический сенсор (тот самый однопиксельный).

Это все равно что если мы взяли какие-то рандомные пиксели картинки, сложили их вместе и получили одно значение.

Но таких измерений делается не одно, а много, впрочем гораздо меньше чем пикселей в самой картинке.

Предполагая что у нас какая-то натуральная сцена перед нами, а не набор рандомных паттернов — мы можем наложить условия на sparsity (разряженость или как бы сказать малое количество не-нулей) в какой-то трансформации для этой сцены.

И используя математическую магию аналогичной знаменитой бритве Оккамы, можно (попытаться) найти это разряженное представление, а следовательно и восстановить сигнал (изображение в нашем случае).

И называется это не вычислительная фотография (тут Ализар видимо перевел термин Computational Imaging) а Compressive Sensing (тут я не знаю как перевести на русский — наверно что то Компрессирующее Измерение, но лучше вообще не переводить )

По сравнению с обычными фото-камерами данный подход далеко не самый удачный, но стоит нам захотеть рассматривать не видимый свет, а какой-нибудь другой эффект, инфра-красное излучение, ультрафиолет, электронные эффекты, или еще что-то, где современные кремниевые технологии не добились такого успеха как в видимом свете, то преимущества Compressive Sensing перед этой самой механической разверткой становятся очевидны.

Опять же, сейчас делают multi-spectral camera которые снимают сразу во многих диапазонах. Правда делают они это не одним пикселем а чем-то вроде Бйер-Паттерном но для многих цветов. В этом случае тоже применяется Compressive Sensing чтобы восстановить все цветовые каналы во всех пикселях в хорошем разрешении, которое было бы невозможно в случае применения обычной интерполяции.

Прелесть этого подхода,

qbertych

31.03.2017 16:37Как выше Gryphon88 заметил, было бы интересно модулировать не изображение, а его Фурье-образ — там много приятных моментов появляется. Во-первых, качество картинки будет плавно расти с количеством итераций. Потом есть новая степень свободы — фаза преобразования, это простор для оптимизации. Наконец, можно "открывать" сразу много пикселей, чтоб сигнал был больше (без Фурье это сразу бы снизило пространственное разрешение).

Gryphon88

31.03.2017 16:49на эту тему есть статья «Asymmetric-detection time-stretch optical microscopy (ATOM) for ultrafast high-contrast cellular imaging in flow», я её до конца не понял, но Вы, надеюсь, превозможете

qbertych

01.04.2017 00:29Да я скорее фазовые маски имел в виду. Статья по ссылке — это просто праздник оптики какой-то. Про то, как они юстируют два объектива, да еще чтобы свет в обе стороны проходил, даже задумываться не хочется ;).

(А вот почему k-space filtering увеличивает фазовый контраст, до меня так и не дошло.)

Gryphon88

01.04.2017 01:50Методически это все просто, только дорого и долго. Если выкинуть ту часть, что про разные длины волн, то по сложности и цене примерно сравняется с классической схемой флуоресцентной микроскопии. У этой толпы китайцев была более ранняя статья, где они рассказывают принцип работы более подробно, в этой статье они рассказывают, как улучшили метод, чтобы делать десятки тысяч полных кадров в секунду. Моих знаний физики с математикой хватило только на то, чтобы понять, почему оно вообще работает, а вот качество картинки и возможные факапы прикинуть не смог. Надо бы перечитать, есть в этом методе некое благородное безумие :)

qbertych

01.04.2017 13:41Там один чирп при прохождении через объективы — это уже прекрасно. Еще напрягает дифрешетка — ее поверхность наверняка не лежит в фокальной плоскости, поэтому возможны артефакты формы пучка и, как результат, сюрпризы при заведении в волокно.

Gryphon88

31.03.2017 17:00На сколько я понимаю, за счет однопиксельной камеры дополнительно можно снизить влияние семплинга на камеру: при дискретизации из-за квадратного пикселя и ненулевой его площади теряется линейность оптической системы, и теряется часть высоких частот

qbertych

31.03.2017 17:15В лоб вряд ли — у SPADов размер площадки в районе сотен микрон против единиц у CMOS/CCD. Но если аккуратно модулировать освещение объекта, то почему бы и нет? SEM так и работает — у него разрешение определяется размером электронного пучка.

alexhott

02.04.2017 13:30ну если предположить что весь объект освещается одним источником, то взяв за базу какую либо точку

можно и без подсветки определить разность в расстоянии между базой и остальными точками.

Но пока такой точности достичь сложно.

Вот для космических аппаратов вполне может сгодиться. Подлетаешь к марсу и одним датчиком без линз его поверхность мониторишь. Там с линзами при посадке проблемы были

Wizard_of_light

02.04.2017 14:41Интересно, но для весьма специфичных областей. Там пара подводных скал есть:

— динамичные процессы — проблема. Все вон стараются от построчного считывания к покадровому убежать, а тут даже не построчное, а попиксельное считывание;

— слабоосвещённые процессы — проблема. Фотоприемник видит каждый кусок сцены долю секунды, чем больше разрешение — тем ниже экспозиция.

valuxin

06.04.2017 14:34-1Рад наблюдать, что есть активные разработки в сфере фото технологий отличные от классических и привычных:) Надеюсь, лет через 10, в потребительских камерах объектив как таковой утратит свою надобность в повседневной жизни:)

SonicNet

06.04.2017 14:45Скоро спецслужбам что бы нас фотографировать достаточно будет датчика освещения. Или уже достаточно!?

kerberos464

Вначале подумал, что уже первое апреля наступило...