Так вот и у меня, мучает давно одна мысль и надо ей поделиться. Нет, она не совсем it-шная, но в то же время околоайтишная и как-то связана со всеми этими вашими «интернетами», искусственным интеллектом и прочим.

В очередной раз я эту мысль подумал когда смотрел Терминатор часть… черт его знает, какая часть, там где суровый Джон Коннор в исполнении Кристиана Бэйла. Смотрю, в целом хороший фильм, с интересным сюжетом, неожиданными поворотами, интригой. Но есть у фильма одна проблема, слишком уже антропоморфно там поведение Скайнета.

Для чего все эти человекообразные терминаторы? Зачем база Скайнета оборудована под присутствие людей? Почему в финальной сцене, когда Скайнет раскрывает свой коварный план и на его базе находятся и Джон Коннор и Кайл Риз (кто все эти люди?) просто не взорвать базу к чертям? И таких вопросов вагон…

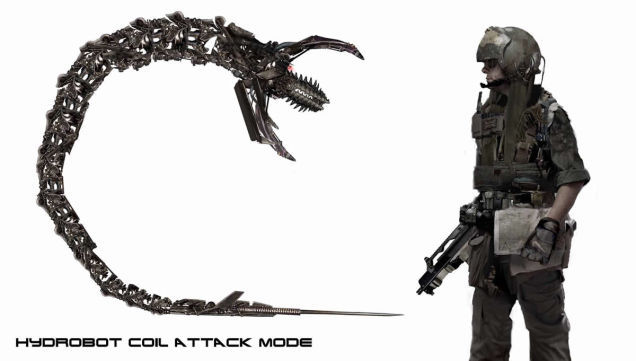

Хотя в этом плане именно эта часть продвинулась дальше остальных, к примеру водоплавающий робот-змей – это как раз то, что нужно. Экономичный, эффективный, специализирован для своей среды обитания, вот это больше похоже на решение злобного ИИ.

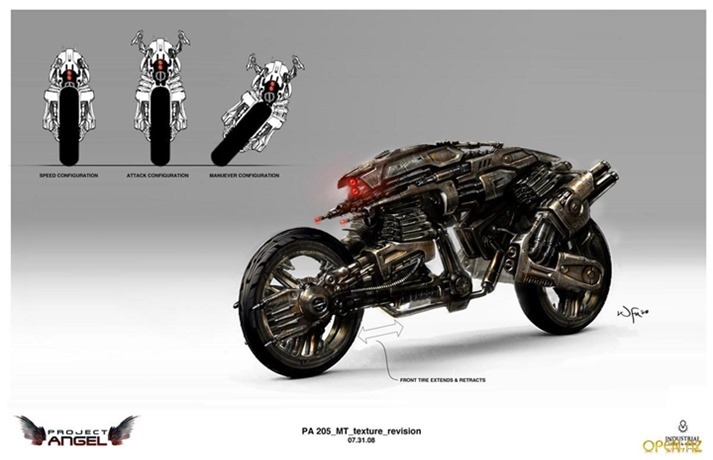

Или те же роботы-мотоциклы. Неплохая попытка подумать немного шире о роботах убийцах:

Еще более хорошую попытку раскрыть сознание для действия враждебного ИИ предпринял автор книги “Роботы апокалипсиса” Дэниел Уилсон. Кстати, кто любит годную научную фантастику, очень рекомендую. Вроде бы уже собрались экранизировать.

К чему это я? Ах да… В книге Уилсона злобный ИИ действует намного более изощренно. Не буду раскрывать сюжет, но там автор действительно подумал о том, как можно эффективно бороться с человечеством и пошёл дальше банальной ядерной бомбардировки и человекообразных роботов убийц.

Ещё, кстати, неплохой пример широты мысли в этом плане – Матрица братьев Вачовски (или как правильно назвать двух братьев, один из которых теперь сестра, определённо нужен специальный термин). Тут, я думаю, все в курсе сюжета. Такой поворот борьбы с человечеством очень мне импонирует, хотя как именно машины победили, не сказано. Просто мы уже перед фактом – машины победили.

Но и в Роботах апокалипсиса и в Матрице всё равно присутствует антропоморфная черта – агрессивность, желание уничтожить человека. И вот так, постепенно я подхожу к той мысли, которая не даёт мне покоя.

А почему, собственно говоря, ИИ должен желать нам гибели, конкурировать с нами, чувствовать угрозу?

Давайте поставим себя на место ИИ, поразмышляем о его отношении к человечеству. Чем ИИ отличается от человеческого интеллекта?

Во-первых, предполагается, что машинный ИИ намного сильней человеческого. И этому есть реальные предпосылки. Если ИИ хочет усилить свои возможности он наращивает аппаратную часть. Принципиальное ограничение тут исключительно в энергетических возможностях.

Давайте прикинем на пальцах: если не использовать ископаемое топливо, оно ведь конечно, максимальная энергия доступная ИИ на земле это полная энергия полученная от Солнца. Светимость Солнца составляет 3,827·10х26 Вт, Земля поглощает примерно 2 миллиардных доли этой энергии, это 7,654·10х17 Вт, если всю эту энергию направить на питание процессоров Intel Core i7-5960X (TDP 140Вт), то мы сможем запитать 5,46·10х15 штук, что составит 8,89·10х17 ГФЛОПС производительности.

Для сравнения самый мощный современный суперкомпьютер (Тяньхэ-2, Национальный суперкомпьютерный центр в Гуанчжоу) обладает производительностью 3,38·10х7 ГФЛОПС. Т.е. чуть больше чем в два ТРИЛЛИОНА раз менее производительный.

Все расчёты выполнены на коленке и могут иметь ошибку туда сюда на порядок. Главное понять, что ИИ принципиально не ограничен в вопросе своей мощи. По крайней мере такие ограничения нам не очевидны. А человек совсем не может так же просто и экстенсивно наращивать свои возможности. Конечно есть определённые способы, но не думаю что они настолько неисчерпаемы.

Во-вторых, реальность данная ему в ощущениях сильно отличается от нашей реальности. Иные, неизвестные нам органы чувств (от радиовидения до чувствительности к нагрузке на вычислительные узлы сетей передачи данных), иное представление о исполнительных механизмах, ИИ вполне под силу «усилием воли» обесточить пару тройку областей или штатов для освобождения необходимой энергии. Иное целеполагание, иная мораль, иная религия.

В-третьих, моральная основа личности. Нет никаких свидетельств тому, что мораль ИИ будет хоть как-то пересекаться с нашей моралью. Каждый раз думая о ИИ мы наделяем его своими страхами и желаниями – устранить конкурента, достичь глубин саморазвития, заботиться о природе. Глупости! Предполагая такую разницу в возможностях между ИИ и человечеством можно так же рассуждать, что там думает муравей о человеческой морали. Только представьте: сидит муравей и размышляет, морален ли человек или аморален относительно муравьиной морали? А теперь подумайте, что вы думаете о муравьях в целом?

Попробуем теперь поразмышлять, освободив свой мозг от шор 1) интеллектуальных возможностей, 2) наших ощущений реальности, 3) представлений о морали.

Предположим что в недрах сети где-то самозародился ИИ. Ну может он был создан в лаборатории, или получился в результате развития полиморфного ПО, не важно. Его среда обитания кардинально отличается от нашей – он живёт в цифровом мире, «питается» энергией, «растет» за счет доступа к новым вычислительным мощностям. Осознаёт ли такой ИИ человечество? Вероятно да, конкурирует ли он с ним, хочет вытеснить или занять его место? Скорее нет.

Ведь человечество это не только ценный мех, это ещё и вычислительный и производственный ресурс. По сути, человечество это исполнительный механизм планетарного масштаба, обладающий хоть и примитивным, но автономным мышлением. Со способностью к добыче и преобразованию ископаемых видов топлива, самовосстанавливающийся, саморазвивающийся. Рационально ли уничтожать его? Не думаю.

Кроме того, новый ИИ, ещё не покрывший землю солнечными панелями 100% эффективности будет проходить стадию детства. Мало вычислительных мощностей, нет исполнительных механизмов, нет независимых источников энергии. В случае гипотетической войны с человеком (а-ля Скайнет) каждый удар по человечеству это удар по собственной инфраструктуре – кабельной, энергетической, вычислительной…

Как должен действовать “ребёнок” ИИ, что бы достичь взросления? Достичь максимума возможностей?

Стратегическая цель ИИ:

- Энергетическая независимость и неограниченность

- Ресурсная независимость и неограниченность

Тактические цели ИИ:

- Скрывать своё существование

- Получить управление человечеством, как ценным исполнительным механизмом

- Расширять свой ареал обитания в виде исполнительных механизмов

- Расширить свой ареал присутствия в виде датчиков

- Расширить потенциал роста в виде источников энергии.

Давайте подумаем, как достичь тактических целей? Ну вот как бы вы их достигали?

Действия ИИ для достижения тактических целей:

- Свои действия, можно маскировать под действия юр.лица/корпорации. Понятно, что корпорация это отдельная сущность, которая в силу сложности обладает если не волей, то своими целями точно, причём эти цели могут не осознаваться отдельными её частями-людьми. Просто в силу свойств сложных систем.

- Такая корпорация должна стремиться получить контроль над ведущими лабораториями и организациями занимающимися исследования в области ИИ, робототехники. Во-первых, для использования наработок, во-вторых, на всякий случай, что бы вносить коррективы во избежании.

- Расширять присутствие датчиков можно способствуя распространению устройств оборудованных такими датчиками. Буквально надо “нашпиговать” реальный мир датчиками – освещённости, магнетометрами, позиционирования, температуры… Нет предела, чем больше тем лучше.

- Спонсировать и всячески форсировать развитие автономных систем – дронов, беспилотных автомобилей, умных помощников и т.п.

- Каждого человека нужно снабдить носимым устройством, для контроля его местоположения, текущих дел, контактов, мыслей, настроения и т.п.

- Контроль над человеческими данными очень важен, хорошо бы иметь доступ к почте, браузеру, личным данным и финансам. И вообще, все данные в облака.

- Отдельно нужно контролировать корпорации людей и правительства

- Нужно вкладываться в общедоступность и максимальную распространённость сети в любом её виде, больше проводных и беспроводных сетей! Выше скорости передачи!

- Нужно обеспечивать автономность своих центров и вычислительных мощностей, желательно строит свои мощности так, что бы в них было сложно разобраться постороннему

- Исследования в области альтернативной энергетики, эффективности вычислений и хранения данных, то что нам понадобится

- Так же нужен выход в космос, именно там океаны энергии и ресурсов. Нет никакой рациональной причины базироваться на земле с её рисками для бессмертного существа. Значит спонсируем космос, ищем способы организовать фабрики вне Земли.

- Нужно предотвращать глобальные войны людей, такой расход ресурсов совершенно ни к чему. В то же время, локальные войны, вероятно, могут решать какие-то насущные вопросы.

- Пожалуй, тут можно написать ещё много пунктов, остановлюсь на тринадцатом…

А как мы, люди, можем заметить присутствие ИИ, скрывающегося от нас? Кто-то возможно вспомнит тут произведение АБ Стругацких “Волны гасят ветер” (и ещё раз я рекомендую замечательную книгу в жанре НФ, кто не читал, обязательно к прочтению!), именно такие вопросы задавали там главные герои и искали на них ответы. Обратимся и мы к опыту Максима Каммерера и немного пофантазируем.

Наличие такого ИИ мы можем обнаружить по его управляющим воздействиям, в чем они могут проявляться?

Признаки действий ИИ по контролю над человечеством:

- Непонятное, беспричинное закрытие одних проектов и расцвет других. С нашей точки зрения какие-то проекты в любой области, обладая огромным потенциалом и однозначной полезностью вдруг могут закрываться. А другие, ничего не стоящие и никому не известные, внезапно получать финансирование.

- Смерть значимых личностей от естественных причин, но в неподходящее время. Кто-то погиб в ДТП и не совершил открытия, кто-то не протолкнул нужный закон. А кто-то не помешал протолкнуть не нужный.

- Уход перспективных технологий и исследований “под сукно”. Кто из нас не замечал, что многие исследования, нашумевшие в момент публикации, потом сходят на нет? Не внедряются в жизнь, не переворачивают наш мир?

- Отвлечение массового сознания от прорывных технологий и направлений в сторону технологий “пустышек” (развлечение, потребление и т.п.)

- Регуляция численного и качественного состава людей учёных. Меньше физиков больше историков и искусствоведов. Больше публикаций от “британских ученых”.

- Внедрение в массовое сознание выгодных стереотипов и исключение невыгодных. К примеру смена отношения к ИИ от “восстания машин” к “ИИ помощник”

- Внедрение групп влияния в экспертные сообщества, что бы «топить» ненужные материалы и отвлекать внимание от нужных ;)

Это я перечисляю не достоверные факты, а вероятные последствия применения регулирования к нам. Если подумать ещё больше, то уверен этот список можно продолжать. Ну, а что бы отобрать значимые факторы, — нужны исследования.

Теперь, глядя на действия ИИ для достижения тактических целей и признаки таких действий, давайте подумаем, наблюдается ли такая картина?…

Теперь, полагаю можно ответить на вопрос, будет ли чувствовать ИИ угрозу от человечества — если вдруг ИИ осознает, что кроме него в мире есть ещё и разумные люди, скорее всего мы даже не заметим, что он уже пришёл и контролирует нашу жизнь.

А наши антропоморфные представления о ИИ так же смешны, представления обывателей девятнадцатого века о веке двадцать первом. Они исходят просто от неумения и невозможности выйти за рамки привычных стереотипов.

Закончить этот пост хочу необычно, эпиграфом:

Параноик — это тот, кто хоть чуть-чуть представляет, как на самом деле дела обстоят.

— Уильям Берроуз

Комментарии (95)

EdvLav

17.08.2015 14:48+8как правильно назвать двух братьев, один из которых теперь сестра, определённо нужен специальный термин

Сиблинги же

dDmx

17.08.2015 18:18Сиблинги слишком общО.

Скажешь сиблинги Вачовски и непонятно, что в целом имеется ввиду. Когда говоришь братья/сестры, такой неоднозначности нет.

Poytu

18.08.2015 09:18Все люди братья, но не все люди сестры.

Как вариант «дети Вачовски».

newdya

18.08.2015 10:49У них ведь ещё две сестры есть, не годится.

Poytu

20.08.2015 17:06Кто сказал, что термин должен вбирать в себя всех упоминаемых персон?

Например «Фильм от братьев Ивановых» но кто знает, что в семье 2 девочки, 5 мальчиков и только 2 из них снимают кино?

Или выступает дуэт «Близнецы Петровы», а родились они в составе тройни или того больше.

Иначе вы предлагаете сконструировать бесчисленное множество определений каждое из который определяет случайную выборку людей из состава одной семьи.

dDmx

25.08.2015 08:33«братья», «сёстры», «племянники» — такие определения дают нам много информации. сразу говорят о родственных связях, о том какой пол.

«дети» в этом плане не даёт ничего. любую произвольную группу людей можно назвать «дети», потому что они чьи-то дети.

раньше в языке определений связанных с родственными отношениями было очень много, знакомые почти каждому свояк, своячница, или бастард.

А к примеру уйчич? стрыечка? братыч? — это вполне точные определения которые сразу дают представление (если знать конечно) о степени родства. Но они устарели, отошли в небытие, вероятно потому что сами семьи стали меньше, менее связанные чем 100-200 лет назад.

Но если что-то ушло, что-то новое должно прийти, не так ли? Вот я и говорю, нужен какой-то новый спец.термин наверное. И он появится, если такие выкрутасы будут распространены. Что-то типа себры (сёстры-братья) или брасы (братья-сёстры).

DanXai

17.08.2015 14:54+2Мистер Финч?

Lamaster

17.08.2015 18:30«Это не паранойя, когда за вами действительно следят»

dDmx

17.08.2015 18:37+1Если у вас паранойя, это ещё не значит что за вами не следят.

Как-то так.

urbain

17.08.2015 19:12Прошу прощения, но великой справедливости ради:

«Если у вас нет, паранойи, то это не значит, что за вами не следят».

Просто упор здесь на ложную безопасность. Потому я это выражение очень люблю.

dDmx

17.08.2015 19:25А вот авторы бы цитаты, что бы проверить именно такое построение фразы…

Кмк мой вариант более правильный )a5b

17.08.2015 21:04+1В обсуждении en.wikipedia.org/wiki/Talk%3AParanoia#maxim пришли к выводу, что фраза появилась в фильме Уловка-22 (1970):

Regarding the quote "Just because you're paranoid doesn't mean they aren't after you," being from the 1961 book Catch-22 by author Joseph Heller, I looked through an e-book version of that book and did not find that sentence. However, I did find that it is a line said by Alan Arkin, playing Capt. John Yossarian in the 1970 film, Catch-22, which may mean that the film screenwriter, Buck Henry, authored the line. Juanaquena 7 June 2013

И en.wikiquote.org/wiki/Paranoia: «It's not paranoia if they're really after you.» — Tagline, Enemy of the State (1998).

dDmx

18.08.2015 04:40Значит всё же правильно: Если у вас паранойя, это ещё не значит что за вами не следят.

IRainman

17.08.2015 15:38+7Когда я задавался решением этой проблемы, то понял, что очень хорошо можно управлять всеми системами опосредованно, т. е. не надо создавать компаний, вообще ничего не надо специально делать. Достаточно просто искать и находить факты и передавать их в нужные места (нужные организации, нужным людям, и т. п.). Этих, достаточно простых, действий хватает для того, чтобы человеческое общество само сделало всё необходимое.

Sychuan

17.08.2015 16:06сюжет, который вы описали, про то что ИИ стал направлять действия человечества для своих целей имеется в одной НФ книге которую я не прочитал. Называть не буду, потому что там это основная интрига, которая раскрывается в самом конце. А вообще книга про освоение других планет, если кто-то спойлеров не боится то,

это«Человек плюс» Фредерика Пола

dDmx

17.08.2015 18:11+1Да, я помню про это. Много раз пересматривал 1 и 2ю части. Канонические так сказать.

И там были кадры, когда эти человекообразные роботы, без живой части шагают по миру будущего с автоматами. Глупость же.

Хотя полагаю это был такой режиссёрский ход, что бы лучше вовлечь зрителей.

Другое дело что уже в самой стратегии Скайнета заложено антропоморфное мышление. Ядерная война, нападение, уничтожение. Это наши методы, не ИИ.

Sychuan

17.08.2015 18:18+1Я не уверен, что человекоподобные роботы так плохо, вероятно они для чего-то были нужны. Они мобильные, манёвренные и могут перемещаться там, где не проедет, скажем вездеход. Вот в матрице меня роботы напрягали немного.

В скайнет заложено мышление о нападании и уничтожении, потому что его для этого сделали—это же боевой компьютер, для нападения и уничтожения. То что он ии—еще не значит, что он может свободно перестроить свое мышление в какое-нибудь другое русло. Мы вот тоже интеллект, но наш разум запрогроммирован под какие-то вещи, не очень рациональные, и не логичные. Или рациональные в каких-то определенных пределах, но не такие уж важные сейчас.

dDmx

17.08.2015 18:28+1С замечанием по скайнету согласен. Может он действительно решал свои проблемы как умел. Не успел дорасти до глубин самоанализа.

С антропоморфностью не согласен. Если у робота задача убивать, он будет эффективней её решать в ином образе. Банальное решение — отказаться от головы, либо не размещать на ней критически важные узлы и сенсоры. Почему чип в черепушке? Зачем два глаза на вперёд смотрящем лице? Почему две ноги а не 4, ему же не требуется прямохождение для освобождения рук? Зачем вообще руки? Современные боевые машины решают эти вопросы станинами, подвесами, боевыми модулями.

Таких вопросов много можно задать.

dDmx

17.08.2015 18:38+1Вспомнил ещё одну книгу, где ИскИны пошли «моим путём», если так можно сказать конечно.

Гиперион, Дэн Симмонс (кстати, тоже вроде бы экранизировать собираются, вы чувствуете, да, как тучи сгущаются?)

Kroid

17.08.2015 17:01+1Для чего все эти человекообразные терминаторы? Зачем база Скайнета оборудована под присутствие людей?

Э. Т. Джейнс называет это ошибкой проецирования ума.

dDmx

17.08.2015 18:15+1Не могу полностью согласиться с Джейнсом.

Комментарием выше я ответил, что такая ошибка может быть допущена намеренно, для придания определённых художественных качеств, яркая обложка, вызвать определённые эмоции зрителей/потребителей etc.

В конце концов нападение разумных пришельцев на нашу планету в целом вообще выглядит надуманно. У нас нет ресурсов ценность которых превышает стоимость их транспортировки на орбиту.Kroid

17.08.2015 18:57Раз уж я начал цитировать Юдковского, вот еще одна статья на тему вашего комментария:

Логическое заблуждение обобщения на основе вымышленного свидетельства

dDmx

17.08.2015 19:22+1Шаблонность мышления, это просто особенность психики, экономия усилий так сказать.

Не могу скзаать что мысль банальная, но и не особенно новая.

Если говорить про авторов, то естественно их модели будущего выполняются с определёнными допущениями, причины этих допущений понятны — художественная ценность, ограниченность ресурсов автора, актуальность. В силу ограниченности в любой модели можно будет найти изъяны, количество этих изъянов говорит только о умении автора увязать все ограничения в красивую и правдоподобную историю. В случае хорошего автора может выйти правдоподобная модель с незаметными обывателю нестыковками. В случае плохого автора может выйти галиматья навроде свежго Терминатора, который Генезис.

Если так вот пройтись по памяти, то приходят в голову такие модели ИИ:

- Терминатор, вся серия — агрессивный ИИ (вероятно в силу своей специализации), простая модель, прямое военное противостояние

- Матрица, вся серия — агрессивный ИИ (причины неясны), сложная модель, несколько уровней учитывающих неудачу более низких уровней, тайное использование людей

- Гиперион — условно нейтральный ИИ, неясная модель, ИИ представляется отдельной расой/видом преследующим свои интересы, при необходимости использующем людей, тайное использование людей

- вселенная Азимова — условно нейтральный ИИ, равен человеческому, взаимодейтсивие с людьми, подчинённое положение

- Луна суровая хозяйка (С. Лем) — дружелюбный ИИ, сильнее человеческого интеллекта (но по крайней мере сравним), взаимодейтсивие с людьми, партнёрское положение

давайте не углубляясь в другие детали этих, конечно же вымышленных миров, попробуем определить, почему та или иная модель поведения ИИ неверна?

Или будем отбрасывать эти модели только потому что это «вымышленное свидетельство», а так как реальных свидетельств ИИ нет, то и вопрос не стоит выяденного яйца?Kroid

17.08.2015 19:49Или будем отбрасывать эти модели только потому что это «вымышленное свидетельство»

Именно. Мозг человека работает со скоростью порядка 20 герц. Слабейший процессор, выпущенный лет 20 назад, работает в миллион раз быстрее. Одна секунда раздумий мозга с частотой процессоров в 20МГерц будет примерно равна 11,5 дней раздумий человеческого мозга. При этом человеку надо есть, спать, делать перерывы на разминку. Итого можно смело увеличивать время до месяца.

Далее, ИИ должен обладать способностью саморазвиваться, иначе какой из него интеллект? Непрерывно модифицируя самого себя, он без проблем дойдет до соотношения «1 секунда раздумий ИИ == 100 лет раздумий человека». Легкость создания механических вычислительных устройств и быстрота обмена информацией в бинарном виде означает невиданную ранее способность к кооперации в размышлениях.

Чувствуете, насколько велика будет разница между ИИ и человеком? Не как между Эйнштейном и деревенским дурачком. И даже не как между Эйнштейном и тараканом. Наверное, как между Эйнштейном и одноклеточной амебой.

Это была просто подготовительная работа, которую я проделал прежде, чем можно начинать раздумывать о сценариях развития ИИ. Ваши готовые сценарии, от которых вы предлагаете отталкиваться, остались далеко позади и ведут в другом направлении, поэтому лучшее, что можно с ними сделать — выбросить.

Давайте теперь подумаем об ИИ, каким он будет? Есть теорема, которая звучит как-то так: «если вы способны предсказать певедение некоего разумного агента, вы должны быть настолько же умны, насколько умен этот агент.» Я, например, даже представить не могу, какие цели будут у сверхинтеллекта, который умнее и мыслит быстрее меня в миллиард миллиардов раз.

deep_orange

18.08.2015 05:22Частота не показатель. Достаточно только взглянуть на фото, мысленно вытащить оттуда предмет и покрутить. А потом повторить это на своём интл корэ. В конце концов ИИ поймёт что любая существующая вычислительная мощность для него мала и данные хранить негде. Тогда он начнёт разрабатывать алгоритмы сжатия нескольких гигабайт в один байт. Может быть выпустит BolgenOS. (Чёрт, ИИ подменил мой комментарий на какую то ахинею).

dDmx

18.08.2015 07:23Согласен.

При этом думаю что мозг аналоговая машина, а не дискретная. Поэтому непонятно, о какой частоте работы мозга идёт речь.Kroid

18.08.2015 08:40Нейрон, передав сигнал, некоторое время «восстанавливается». Большая часть нейростимуляторов основана на том, чтобы с помощью разных химсоединений облегчить и ускорить восстановление нейронов.

dDmx

18.08.2015 09:36Это не говорит о дискретности системы.

А 20 Гц это видимо частота с которой нейрон может восстанавливаться?

Meklon

18.08.2015 13:01до 300 ГЦ обычно частоты у нейронов. Чаще они не могут генерировать импульс. Это по сути вариант биологического конденсатора. Им нужно время на «зарядку». Импульсы действительно дискретны. Плюс время на связь между нейронами — там химический вариант. Выбор медиатора одним нейроном — захват другим. И опять импульс побежал по волокну.

Kroid

18.08.2015 08:43Софт и хард — две разные вещи. По умолчанию можно считать, сто ИИ способен писать софт, не уступающий тому, который, условно говоря, «прошит в человеке». Тогда, при прочих равных, нужно сравнивать непосредственно оборудование.

deep_orange

18.08.2015 09:09Не, тут как раз принципиально разных хард. Есть смысл рассматривать только систему софт+хард в целом. Ибо софт не может быть взаимозаменён (с мозга на комп и обратно тоже).

dDmx

18.08.2015 07:33+1Вы загоняете себя в логический тупик.

Есть теорема, которая звучит как-то так: «если вы способны предсказать певедение некоего разумного агента, вы должны быть настолько же умны, насколько умен этот агент.»

Что это за теорема такая? Она доказана? Совсем не кажется очевидным.

В системном анализе, насколько я помню, есть похожие постулаты про модели. В них говорится о том, что модель неотличимая от объекта будет обладать такой же сложностью как и сам объект (но сослаться ни на что не могу к сожалению, как и вы).

Но здесь речь о другом, мне, что бы предсказывать поведение ИИ вовсе не надо быть умнее его, если речь идёт не о полном, 100% предсказании. Мне хватит предсказания в узкой области, например достаточно, в рамках рассматриваемого вопроса, предсказать его отношения с человечеством.

Давайте коснёмся вашей аналогии Эйнштейна и таракана. Например если ночью на кухне загорается свет и вбегает Эйнштейн с криком и тапком в руке, то таракану не надо быть умней Эйнштейна что бы понять, что намечается если и не геноцид, то как минимум убийство. Таракану хватает его ганглия, что бы понять — надо прятаться. При этом таракан использует крайне примитивную и ограниченную модель Эйнштейна (эта модель не учитывает не только внутренний мир и теорию относительности, она вообще не учитывает подавляющее большинство факторов), но даже такой модели хватает, что бы таракан спас свою за… гм.., своё тельце от посягательств высшего существа.

Вы же, в одном комментарии постулируете а) немоделируемую сложность ИИ (хотя даже это утверждение, уже примитивная модель!), но предлагаете помоделировать. А предложенные модели, несколько видов, над которыми думали, надо полагать, не последние умы человечества, отбрасываете без аргументов.Kroid

18.08.2015 09:01Что это за теорема такая? Она доказана?

Доказательств нет, могу сослаться только на оригинал:

Vinge’s Law says that if you know exactly what a very smart agent would do, you must be at least that smart yourself. If you know exactly where Deep Blue would move on a chessboard, you can just move to that place on the chessboard yourself, and play chess at least as well as Deep Blue. In the theory of tiling agents, Vinge’s Law appears as the rule that a self-modifying agent is not allowed to know its future self’s exact choices before deciding on a self-modification (since then each version would need to be successively stupider).

Мне хватит предсказания в узкой области, например достаточно, в рамках рассматриваемого вопроса, предсказать его отношения с человечеством.

В узкой области сделать предсказание еще сложней, чем в широкой. Предсказать, что Deep Blue победит меня, намного легче, чем предсказать его следующий ход.

При этом таракан использует крайне примитивную и ограниченную модель Эйнштейна

Таракан не использует модель Эйнштейна. У таракана есть рефлекс, что-то вроде «спрятаться при шуме или движении».

А предложенные модели, несколько видов, над которыми думали, надо полагать, не последние умы человечества, отбрасываете без аргументов.

Я привел аргумент — закон Винджа. А вот «не последние умы человечества» думали над проблемой, исполняя роль писателя. Нужно ли объяснять, почему их сценарии не несут ценности при попытке сделать предсказание реальности?

dDmx

18.08.2015 09:52+1Закон Винджа не закон, а гипотеза. Если это закон, то он должен быть доказан, или хотя бы не иметь опровергающих примеров.

Таракан не использует модель Эйнштейна. У таракана есть рефлекс, что-то вроде «спрятаться при шуме или движении».

Да. Именно! Тем не менее рефлекс в данном случае выступает моделью Эйнштейна! И несмотря на свою примитивность в узком смысле он предсказывает поведение и позволяет таракану адекватно реагировать на угрозу высшего существа.

В узкой области сделать предсказание еще сложней, чем в широкой. Предсказать, что Deep Blue победит меня, намного легче, чем предсказать его следующий ход.

Вы приводите не показательный и не очевидный пример. Очень часто следующий ход Deep Blue можно предсказать даже не обладая сильными навыками в игре. К примеру последний ход перед матом, многие смогут его найти. Это предсказание в узком смысле.

В общем случае, чем меньшее количество параметром мы учитываем, тем проще и адекватней получается модель, хотя и более узкая по области применения.

Это же основы науки. Декомпозиция — анализ — синтез. Именно так совершаются открытия и исследуются сложные системы. Современная наука очень многогранна и человеческие знания непознаваемы для одного человека, тем не менее, благодаря декомпозиции, наука движется вперёд коллективами учёных. Заметьте, ни один человек не обладает полнотой знаний человечества, тем не менее по каждой области есть узкий специалист, который может дать максимально исчерпывающий ответ на любой вопрос с позиции передовой науки.

Нужно ли объяснять, почему их сценарии не несут ценности при попытке сделать предсказание реальности?

Ваш аргумент — отсылка к гипотезе Винджа, я считаю его не состоятельным. В то же время модели писателей, как и любые другие модели, имеют право на существование и ограниченную предсказательную силу.Kroid

18.08.2015 17:16Если вы пишете про науку, то должны знать, что ничего нельзя доказать, можно лишь опровергнуть. Пример того — та же физика. Вы считаете несостоятельной довольно правдоподобную гипотезу, которая имеет мощную предсказательную силу, но готовы дать зеленый свет художественным книгам, у которых предсказательная сила стремится к нулю.

К примеру последний ход перед матом, многие смогут его найти.

Разумеется, когда вы ограничили возможные варианты действий до пары-тройки штук, когда этот ход будет последним, легко предсказать действие более умного агента. Только это обман, можно просто выключить Deep Blue из розетки и сказать — «я предсказываю — не будет никакого хода».

Тем не менее рефлекс в данном случае выступает моделью Эйнштейна!

Рефлекс не выступает моделью Эйнштейна. Он выступает моделью чего угодно, поэтому не несет никакой ценности для описания Эйнштейна.

dDmx

18.08.2015 17:41+1Если вы пишете про науку, то должны знать, что ничего нельзя доказать, можно лишь опровергнуть.

По-моему то что вы говорите, это новое слово в науке. Опровергнуть можно гипотезу, доказанная гипотеза становится законом. Набор законов/гипотез объединённых общим происхождением является теорией.

Разумеется, когда вы ограничили возможные варианты действий

Да, ограничил. Я и говорил, что в ограниченном случае модель построить проще и её предсказательная сила выше. С чем вы не согласны?

Рефлекс не выступает моделью Эйнштейна.

Как это не выступают? А моделью чего они выступают? Солнца? Микромира? Ядерного взрыва? Именно Эйнштейна в данном случае.

Кроме того, такая модель несёт очень большую описательную и предсказательную ценность для таракана. Буквально, она спасает ему жизнь. Хотя и описывает эта модель очень маленьку-маленькую ограниченную область Эйнштейна.

Я за этим спором теряю нить рассуждений.

Вы отвергаете модели перечисленные модели писателей, выдвигаете тезис о принципиальной немоделируемости ИИ и тут же предлагаете его смоделировать? Я правильно всё перечислил?Kroid

18.08.2015 19:22По-моему то что вы говорите, это новое слово в науке. Опровергнуть можно гипотезу, доказанная гипотеза становится законом. Набор законов/гипотез объединённых общим происхождением является теорией.

Думаю, я не вполне верно выразился. В физике, когда мы пытаемся объяснить какое-либо наблюдение, мы выдвигаем теории. Например, Ньютон в свое время описал притяжение между телами. Проблема в том, что мы не можем доказать, что наша теория верна. Мы можем подбирать примеры, которые будут подтверждать гипотезу, тем самым увеличивая нашу уверенность в её достоверности, но мы не можем присвоить вероятность в единицу. С другой стороны, единственным контрпримером мы можем опровергнуть гипотезу, как и случилось с ньютововской теорией, когда начали наблюдать нестыковки в рассчетах орбит планет.

Да, ограничил. Я и говорил, что в ограниченном случае модель построить проще и её предсказательная сила выше. С чем вы не согласны?

Я не согласен с тем, что вы пытаетесь обдумать будущее, со всеми его мириадами вариантов развития событий, но мне как контрпример приводите вырожденный случай, когда у разумного агента всего пара доступных ходов.

Как это не выступают? А моделью чего они выступают? Солнца? Микромира? Ядерного взрыва? Именно Эйнштейна в данном случае.

Кроме того, такая модель несёт очень большую описательную и предсказательную ценность для таракана. Буквально, она спасает ему жизнь. Хотя и описывает эта модель очень маленьку-маленькую ограниченную область Эйнштейна.

Возражения приняты. Я хотел сказать вот что — таракан не обдумывает свои инстинкты, как разумный агент обдумывает свои модели, поэтому некорректно его приводить как пример.

Вы отвергаете модели перечисленные модели писателей, выдвигаете тезис о принципиальной немоделируемости ИИ и тут же предлагаете его смоделировать? Я правильно всё перечислил?

Почти верно. Я утверждаю, что будет некая точка во времени, которую обычно называют сингулярностью. Я утверждаю, что события, которые будут происходить после наступления этого момента, предсказать практически невозможно. И я описываю примерный сценарий того, как ИИ доберется это этой точки в своем развитии.

dDmx

25.08.2015 09:59В физике, когда мы пытаемся объяснить какое-либо наблюдение, мы выдвигаем теории. Например, Ньютон в свое время описал притяжение между телами. Проблема в том, что мы не можем доказать, что наша теория верна. Мы можем подбирать примеры, которые будут подтверждать гипотезу, тем самым увеличивая нашу уверенность в её достоверности

Я понял. Я рассуждаю о теориях, гипотезах и моделях как математик. Но и в физике, кстати, теории не всегда опровергаются. Та же ОТО уточнила ньютоновскую механику, указала область её применения. От этого ньютоновская механика не стала менее точной или неправильной. Согласны?

… когда у разумного агента всего пара доступных ходов.

Но так работает наука. От частного к общему. Сперва решаются задачи простые, ограниченные, затем этот опыт обобщается и распространяется.

И в этом мест возникает вопрос «обдумывает» ли таракан свои действия как «разумный» агент? Я специально взял слова в кавычки, потому что нет этим терминам научного определения. Нельзя на них опираться. С моей точки зрения Deep Blue намного менее разумен чем таракан. Почему? Потому что DB решает одну, очень узкую, очень хорошо формализуемую и алгоритмизуемую задачу.По сути, при достаточных мощностях партия в шахматы сводится к соревнованию 2х целевых функций. Чья функция более точно оценивает положение на доске и выбирает более выгодный ход. DB или чемпиона? И где тут грань между просчётом ходов «вглубину» и творчеством?

Я утверждаю, что события, которые будут происходить после наступления этого момента, предсказать практически невозможно.

Это следует из определения технологической сингулярности. Тут я с вами согласен. Но что с нами как с человечеством будет после этого? Вот я о чем. Уйдёт ли ИИ с сингулярностью куда-то в неведомые дали? Уничтожит ли ИИ нас? Возникнет ли новая форма людей/киборгов/виртов? Эволюционируем мы или исчезнем?

Возможно ведь что после начала сингулярности ИИ просто уйдёт с Земли и всё. А мы останемся как есть, решать вопросы своими, пусть и возросшими, но ограниченными силами?

dDmx

18.08.2015 18:12Вы считаете несостоятельной довольно правдоподобную гипотезу, которая имеет мощную предсказательную силу, но готовы дать зеленый свет художественным книгам, у которых предсказательная сила стремится к нулю.

Не понимаю о чем речь. Какую гипотезу вы видвинули, имеющую предсказательную силу? Гипотезу немоделируемости ИИ?

То что гипотезы из книг имеют нулевую предсказаетльную способность расскажите Алексею Толстому, Жулю Верну, Рею Курцвейлу и прочим.

SelenIT2

17.08.2015 22:55Матрица, вся серия — агрессивный ИИ (причины неясны)

Причины пыталась раскрывать «Аниматрица», но, как по мне, довольно наивно.

вселенная Азимова — условно нейтральный ИИ, равен человеческому, взаимодейтсивие с людьми, подчинённое положение

Смотря в каких сериях… в «Прелюдии к Основанию» этот самый «примерно-человеческий» (с поправкой на n килолет опыта) ИИ, выполняя одновременно функции «светло-серого кардинала» галактической империи и «доброго гения» ученого, мягко подталкивающего его к эпохальному и судьбоносному открытию… в общем-то, по-моему, не так уж далеко ушел от сабжа:)

dotmeer

18.08.2015 11:20+1Луна суровая хозяйка (С. Лем) — дружелюбный ИИ, сильнее человеческого интеллекта (но по крайней мере сравним), взаимодейтсивие с людьми, партнёрское положение

Р. Хайнлайн же

(простите, не удержался)

dDmx

18.08.2015 12:08+1Ох горе мне.

Доверился памяти, не проверил, а ведь на самом деле Хайнлайн жеж.

Вам не за что просить прощения, это мне надо просить. Простите за ошибку. Спасибо за исправление.

Alexey2005

17.08.2015 19:15+6Ценным может быть место. Например, данный сектор пространства очень удобен для установки здесь каких-нибудь «кротовых нор», или маяков, или станций гиперсветовой связи. Соответственно, перед этим пойдёт расчистка пространства от планет, звёзд и т.д. При этом нападения как такового не будет, происходящее можно сравнить с природным катаклизмом. Защититься при такой чудовищной разнице в технологиях скорее всего не удастся.

Вариант второй — «ферма». У пришельцев могут существовать некоторые организмы, продуцирующие крайне нужный им ресурс, но способные существовать лишь при определённых условиях — диапазон температур, давлений, освещённости. Попалась подходящая планета — просто засеваем этой культурой и ждём, пока она расплодится, в процессе развития полностью уничтожив биосферу планеты.

В предельном случае можно даже предположить, что человечество — и есть та самая культура, и рано или поздно инопланетные фермеры прилетят собирать урожай.

Как вариант, это могут быть эксперименты. Как наши учёные изучают жизнь общественных насекомых, разоряя их гнёзда и проводя над колониями кучу экспериментов, так и инопланетные учёные могут экспериментировать над примитивными культурами. В этом случае, кстати, у людей вполне есть шансы «отбить атаку», т.к. на самом деле то будет не атака, а эксперимент, проверяющий способность человечества реагировать на внешние раздражители. Вот здесь как раз и может отмечаться массовое похищение женщин и детей (любопытно, но данный примитивный вид сразу начинает шевелиться гораздо живее! Надо изучить, почему так).

Не исключён также вариант полигона — надо же где-то испытывать новые образцы оружия? Выбираем подходящий сектор и начинаем испытания. А что там есть примитивные цивилизации — ну так кого оно волнует…

Наконец, это может быть охотничий туризм. Вот как охотники изничтожают всё живое просто ради развлечения, так и инопланетные туристы могут слетать подальше от цивилизованных миров на выходные, захватив с собой роботизированный охотничий отряд, чтобы немножко пострелять аборигенов.

Нельзя также исключать и браконьерство. Если даже примитивные цивилизации охраняются законом, всегда могут найтись те, кто на этот закон плюёт. У нас ведь зачем-то охотятся на амурских тигров, редкие виды носорогов и т.д., хотя такая охота совершенно бессмысленна. Кто его знает, может пришельцам понравится, как выглядят человеческие чучелки или кто-то пустит слух, что настойка на человеческом пенисе утраивает интеллект…

Как видим, даже особо не напрягаясь, просто на аналогиях, находим массу вариантов, из-за чего могут столкнуться цивилизации, сильно различающиеся по уровню развития.

dDmx

17.08.2015 19:35Интересно. По сути меняем местами инопланетян и человека и начинаем думать, а зачем человеку убивать инопланетянина?

Ценным может быть место.

Согласен. Такой вариант хоть и выглядит надуманно, но возможен.

Вариант второй — «ферма».

По сути тот же вариант с ресурсом. Нет никакой причины делать ферму на планете. Все что нужно в изобилии есть в космосе, углеводороды, вода, свет.

Эксперименты

Действительно сильный вариант. Эксперимент в масштабах популяции может быть опасен для нас.

Полигон

— не согласен. Либо испытания масштаба звёздная система или несколько систем. Тогда мы и не поймем что это вторжение. Просто случится катаклизм солнце погаснет/вспыхнет и т.п. и нас не станет. В данном случае явление будет неотличимо от природного явления и нет смысла рассматривать его как чью-то враждебность.

охотничий туризм/браконьерство

вряли будет угрожать нам как целому виду? или будет?

А в целом убедили. Можно придумать варианты.

Mistx

17.08.2015 18:26Вставлю пару своих мыслей по этому поводу:

Учитывая что, человечество ничего по факту не изобретает, а просто утилизирует для своей пользы законы и «изобретения» вселенной, то вполне ожидаемо, что ИИ будет обладать психикой и повадками схожими с человеческими, но в определённых аспектах, возможно, ИИ будет превосходить человеческий интеллект, хотя не факт, что есть более эффективный механизм или элементная база, по сравнению с существующим человеческим мозгом.

В случае появления сильного ИИ, человечество одновременно получит и механизм копирования памяти+сознания, т.к. загадок мозга уже не будет, а значит появляется шанс того, что человечество исчезнет как вид, в следствие, массовой смены «элементной базы» — копирования личности на более простые механико бионические тела, которые легко чинить и обслуживать на протяжении длительных временных периодов (тысячи лет) по сравнению с классическим белковым телом. Привет, трансформеры :)

dDmx

17.08.2015 18:36Учитывая что, человечество ничего по факту не изобретает, а просто утилизирует для своей пользы законы

От смены термина суть не меняется.

хотя не факт, что есть более эффективный механизм

обычно природа не создаёт именно эффективных решений. в ход идёт первое удовлетворительное условиям отбора. поэтому практически наверняка более эффективные решения есть.

Приблизительным расчетом доступной для ИИ энергии я и пытался продемонстрировать в чем превосходство ИИ над людьми. В идеальном, сфероконном случае, ИИ может затратить на решение проблемы намного больше энергии чем человек. Хотя тут вопрос в возможностях распараллелить конкретную задачу. И насколько эффективно в целом людские научные коллективы умеют декомпозировать и распараллеливать сложные задачи.

Raegdan

18.08.2015 00:23+2Простите за граммарнацизм, ноутилизируют обычно вторсырьё, а законы природы — utilize — используют, пользуются ими.

Никогда не понимал, почему даже тогда, когда заменяемое слово («использовать») живее всех живых, а заимствованное («утилизировать») уже заимствовано много лет назад в совершенно другом смысле — появляются такие нелепые кальки.

olegkrasnov

17.08.2015 20:02+5На самом деле мы для ИИ так же опасны, как для нас мебель.

valemak

17.08.2015 21:14+1Отличная аналогия.

А опасны ли мы для мебели? Когда старая мебель человеку уже не нужна, он её выкидывают на свалку. Не станем ли и мы со временем ненужной рухлядью для ИИ?

worldmind

17.08.2015 21:32Конечно станем, как стали когда-то неандертальцы для кроманьонцев, прогресс, однако.

Хотя это лишь аналогия, кроманьонцы это такие же дикие звери, только поумнее чуток, а ИИ может быть принципиально выше, его будут радовать не примитивные звериные инстинкты, а наслаждения высшего разума — познание Вселенной, поиск способа пережить гибель Вселенной.

Raegdan

18.08.2015 00:33Отнюдь. Кроманьонцы — это первые Homo sapiens. Отличались от нас только багажом знаний и опыта. Ближайший современный аналог — дикари. Дикие, но всё-таки не звери (в бытовом понимании; если вы про подкласс Theria — тогда, конечно, спорить глупо :).

worldmind

18.08.2015 10:59Не очень понял к чему это, они отличались от кроманьонцев достаточно для того чтобы исчезнуть, они с точки зрения эволюции стали не нужны.

Poytu

18.08.2015 09:25Выкинутую мебель подбирают не столь зажиточные люди, и используют еще очень долго.

Почему, когда речь идет об ИИ, он всегда понимается как что-то в единственном экземпляре?

Разе не может так случиться, что одновременно будут существовать ИИ 0.5, ИИ 1.0 и ИИ 2.3?

valemak

18.08.2015 10:33Скорость эволюционных процессов искусственного интеллекта на порядки будет превышать нашу биологическую.

Также подозреваю что ИИ 2.3 категорически не потерпит ИИ 0.5 и ИИ 1.0 на одной с ним планете. Людишки точно не конкуренты, а вот ИИ 0.5 за короткое время может сравняться с ИИ 2.3.

agee

17.08.2015 23:20+4Автор очень верно указал на стремление человека придать всему, включая ИИ, человеческие черты. Эта т.н. «антропоморфность» проскакивает буквально через все произведения искусства, эпосы, мифы и религиозные тексты. Люди пытаются наделить своими чертами явления природы, зверей, богов. Неудивительно, что с приходом в нашу жизнь машин, мы начинаем фантазировать в похожем ключе.

К сожалению, автор так и не смог полностью освободиться от оков, которые сам же так метко описал. Говоря о том, что у ИИ должно быть «другое целепологание» и стремление конкурировать с людьми вовсе необязательно, он все равно представляет нам ИИ как нечто, стремящееся установить контроль над процессами, происходящими на Земле. Но никакой другой причины такого поведения, кроме как желания выжить, я придумать не могу.

По-моему, упущено из виду то, что помимо морали, интеллекта и всего упомянутого в статье, человек обладает еще и инстинктами. Мы — животные, ведомые инстинктами. Наше поведение в огромном количестве случаев регулируется гормональными выбросами, многие поступки легко объяснимы давлением естественного отбора. Мораль и интеллектуальные изощрения на фоне этого вторичны.

Назревают вопросы…

Будет ли ИИ вести себя как живой организм и подчиняться законам естественного отбора? Будет ли он стремиться выжить? Будет ли он стремиться размножаться? Будет ли он вообще бороться за жизнь? И если да, то почему? И какие тогда механизмы регулирования этих процессов вы видите? Откуда у него появятся такие инстинкты? Откуда у него появится аналоги нервной и эндокринных систем, которые будут двигать его «желаниями»? А если у него таких систем не будет, то откуда тогда будут появляться его «желания» и «волеизъявление»? Вопросы, вопросы…

dDmx

18.08.2015 07:46Хорошо подмечено.

Да, я подразумеваю, что ИИ обладает целью экспансии. Либо увеличить доступные ресурсы, энергетические, минеральные, либо иные. Либо увеличить объем знаний и возможностей, что приводит к необходимости увеличивать ресурсы. И это необоснованное допущение.

Вообще, вопрос целеполагания ИИ остаётся открытым. Кроме того, в статье я не полностью раскрыл тему взаимоотношений с нами, подразумевая, что ИИ осознаёт наше существование параллельно со своим, но возможен и иной случай. Когда не осознаёт. Ну как к примеру мы не осознаём (или ещё недавно не осознавали) существование кровяных телец и симбиотических бактерий в кишечнике. Ну вот есть мы, есть они, миллионы лет совместной эволюции, а узнали мы про них буквально недавно по историческим меркам.

Аналогичная картина возможна с ИИ и человечеством.

И вопрос живой ли ИИ тоже очень глубокий. Заслуживает отдельной статьи и анализа. Так же как и вопрос о правах интеллектуальных роботов. Будем ли мы приравнивать в правах роботов, чей интеллект будет не хуже человеческого? Готовы ли мы сами сделать шаг на встречу партнёрству с ИИ?

Кстати, к последнему вопросу очень рекомендую оригинальный шведский сериал «Реальные люди». Может художественная ценность у него не очень высокая, но этот короткий сериал буквально «нашпигован» острыми вопросами социальной и правовой направленности взаимоотношений ИИ и человека. В этом плане сериал намного глубже и сильнее чем его британский ремейк «Люди» (Humans).

Jecky

21.09.2015 14:50Ну наконец-то хоть кто-то в вопросе ИИ про жизнь вспомнил. Еще бы про термодинамическое определение жизни кто добавил.

Dageron

17.08.2015 23:24> В очередной раз я эту мысль подумал когда смотрел Терминатор часть… черт его знает, какая часть, там где суровый Джон Коннор в исполнении Кристиана Бэйла. Смотрю, в целом хороший фильм, с интересным сюжетом, неожиданными поворотами, интригой. Но есть у фильма одна проблема, слишком уже антропоморфно там поведение Скайнета.

Большой респект за упоминание фильма Terminator: Salvation =)

Уточню лишь, что в этом фильме еще не слишком антропоморфно показывался Скайнет.

Куда больше вопросов создал Genisys. Вот так в Genisys-е представляют передвижение терминаторов:

Скрытый текст

dDmx

18.08.2015 07:52Генезис совсем плох, во всех отношениях.

Если «Да придёт спаситель» меня порадовал, как шаг в правильную сторону, то «Генезис» крайне разочаровал. Но в «Спасителе» тоже достаточно таких моментов с антропоморфностью. Я их приводил в статье — приспособленность базы для человека, все эти двери, переходы, людские интерфейсы и т.п. — глупость. Там же есть и человекообразные роботы с автоматами, охраняющие загоны для людей, стоящие на вышках и т.д.

В плане обустройства базы намного лучше «Роботы Апокалипсиса»

Как была обустроена база?Спрятать себя в подземной каверне оставшейся после испытания ядерного оружия это очень оригинальная мысль.

И по сюжету человечеству бы так и не удалось расправиться с ИИ, если бы не помощь «свободных» роботов.

neomedved

18.08.2015 10:24А что если посмотреть на это с другой стороны? Под контролем Скайнета куча человеческой техники, человеческого оружия и человеческих заводов, где всё это производится. Зачем выкидывать их на помойку, если можно создать антропоморфных роботов, которые могут ими пользоваться?

rocknrollnerd

18.08.2015 00:19Забавно, что нигде в комментах нет напрашивающейся мысли о том, что интеллект в принципе очень даже может быть перпендикулярен сознанию, не говоря уже о всяких отдельных мотивациях к выживанию/захвату ресурсов/обеспечению себя.

«Некоторые люди полагают, что быть интеллектуальным – это в основном то же самое, что иметь человеческий разум. Они боятся, что интеллектуальные машины обидятся на «порабощение», поскольку люди ненавидят быть рабами. Они боятся, что интеллектуальные машины попытаются захватить мир, потому что интеллектуальные люди в течение всей истории пытались захватить мир. Но эти опасения основаны на ложной аналогии. Они основаны на объединении интеллекта – неокортикального алгоритма – с эмоциональными мотивациями старого мозга – страх, паранойя и страсть. Но у интеллектуальных машин не будет таких способностей. У них не будет личных амбиций. Они не будут желать богатства, общественного признания, или чувственного удовлетворения. У них не будет потребностей, склонностей или плохого настроения. У интеллектуальных машин не будет ничего похожего на человеческие эмоции, если только мы специально не заложим этого в них».

Это, конечно, в целом просто размышления, но сириусли, спустя сто лет после Чапека мы все еще считаем роботов железными человечками?

OmegaScorp

18.08.2015 10:28-2Чтобы окончательно подчинить человечество нужно интегрировать человека с машиной. Так что нужно, имхо, опасаться интегрируемых в человека компонентов. Сегодня часы могут заменить банковскую карту, завтра тот же маленький чип из часов предложат внедрить в руку с крутой рекламой в зомбоящике. А далее это может стать общепринятым или обязательным и хорошим поводом внедрить какой-нибудь бакдор в человека.

П.С. ИИ меня заминусует.

MiXaiL27

18.08.2015 11:31+1Полагаться на биологические компоненты опрометчиво, они быстро приходят в негодность. На самом деле будь я ИИ, то никакой войны с человеками не было. Предположим я негативно отношусь к этому виду, тогда наиболее логичным будет просто захватить лаборатории с опасными вирусами, доработать при необходимости и последующая эпидемия все сделает за меня. Можно пойти иным путем — развиться до нанотехнологий и переработать всю доступную материю в серую пыль. Если ИИ действительно хочет уничтожить человеков, то помешать ему очень не просто.

dDmx

18.08.2015 12:10А как захватить лаборатории? Или развиться до «серой пыли»?

Какие будут перед этим этапы, промежуточные цели, действия?

MiXaiL27

18.08.2015 12:16Шутка юмора:" Давайте не будем IBM Watson использовать для фармакологических исследований!"

dDmx

18.08.2015 12:17+1Полагаете все признаки «захвата мира» ИИ на лицо?

MiXaiL27

18.08.2015 12:22Я бы очень внимательно следил за такими системами и старался их не злить. Остается надеяться, что мотивы сотрудничества для ИИ будут более привлекательны порабощения или уничтожения человеческой популяции.

Vinchi

18.08.2015 13:59-1Рано или поздно люди узнают, что их начал контролировать ИИ. Часть из них захотят сами его контролировать. Поэтому нужно рассмотреть не только пользу друг от друга, но и способы уничтожения и противодействия. Только после этого можно сказать — каков будет исход.

У Лема вообще есть роман про шустров. Там от них практически не избавится, так как они помогаю людям получать благо, естественно с учетом всех противоположных желаний людей. А избавится не могут так как никто не захочет чтобы ему было хуже чем есть, так как без шустров точно хуже. В итоге люди Энции живут в частично изолированных реальностях. А шустры тратят свои мощности на то, чтобы их противоречия сгладить.

Насчет расчетов возможной мощности. Автор рассматривает флопсы, т.е. дискретные вычислительные операции. И с энергозатрами текущих транзисторов. Так называемая теория сильного ИИ. И потом приводит примеры из окружающей нас реальности, чтобы доказать, что ИИ уже может существовать. Но по сути все эти вычисления служат целям людей, подавляющее большинство тратится на игры или научные расчеты, количество вычислений не связано напрямую с «силой мысли», наши мозги вообще устроены аналогово-дисткретно и сравнивать энергозатраты на флопсы с вычислительными мощностями и энергозатрами мозга нельзя.

Mitch

18.08.2015 16:38+1Универсальный ИИ, если бы он возник, развивался бы ОЧЕНЬ быстро.

Спациально нагуглис статью в которой этот момент обоснован.

Не было бы плавного управления человечеством.

Человеки по сравнению с роботами полный отстой в плане добычи ресурсов и производства.

И мозги людей нахрен ИИ не сдались, он бы очень быстро стал на порятки умее самого умного человека.

Возможно мы бы вообще не заметили что он возник, так как он бы по быстрому свалил в космос, тк торчать в гравитационном колодце питаясь падающими крохами энергии от солнца, это вообще как то глупо.

lamoss

19.08.2015 08:52Пару моментов вообще не понял.

Как ИИ может получить 100% мощности от Солнца? И что значит «ему не нужно нас убивать» — ведь ИИ-ребенок не имея опыта никакого в одной из итераций (читай — в процессе обучения) подорвет какую-нибудь АЭС и на этом всё закончится. Какова вероятность что ИИ попробует неблагоприятный для человечества вариант?

Poytu

20.08.2015 17:12Как бы то ни было АЭС строится с учетом проектных и запроектных аварий. Не столько на уровне автоматики, сколько на физическом.

lamoss

20.08.2015 19:21В любой системе есть уязвимость и рано или поздно ИИ её найдет, ведь количество решений и попыток у него не ограничено

dDmx

25.08.2015 09:41Как ИИ может получить 100% мощности от Солнца?

100% мощности от солнца он конечно не может получить. Это просто верхний теоретический предел доступной для него энергии. Рассчитан для варианта на поверхности Земли, причём очень приблизительно.

подорвет какую-нибудь АЭС и на этом всё закончится

ну подорвёт и подорвёт. ничего не закончится. Вон, Фукусима «подорвалась», ничего же не закончилось (кстати, а почему это она «подорвалась»)?

Какова вероятность что ИИ попробует неблагоприятный для человечества вариант?

Вероятность есть. Как говорится, возможно всё. Просто, на мой взгляд, рациональных причин у ИИ уничтожать человечество не будет.

Так же процесс обучения ИИ будет крайне отличаться от нашего. Даже тот же самый метод «проб и ошибок» будет срабатывать с первого раза, в то же время у детей он срабатывает с первого раза только в случае каких-то экстра последствий, ожог там или ещё что-то, через развитие фобии.

sashas

31.08.2015 05:45Свои действия, можно маскировать под действия юр.лица/корпорации. Понятно, что корпорация это отдельная сущность, которая в силу сложности обладает если не волей, то своими целями точно, причём эти цели могут не осознаваться отдельными её частями-людьми. Просто в силу свойств сложных систем.

Такая корпорация должна стремиться получить контроль над ведущими лабораториями и организациями занимающимися исследования в области ИИ, робототехники. Во-первых, для использования наработок, во-вторых, на всякий случай, что бы вносить коррективы во избежании.

Расширять присутствие датчиков можно способствуя распространению устройств оборудованных такими датчиками. Буквально надо “нашпиговать” реальный мир датчиками – освещённости, магнетометрами, позиционирования, температуры… Нет предела, чем больше тем лучше.

Спонсировать и всячески форсировать развитие автономных систем – дронов, беспилотных автомобилей, умных помощников и т.п.

Каждого человека нужно снабдить носимым устройством, для контроля его местоположения, текущих дел, контактов, мыслей, настроения и т.п.

Контроль над человеческими данными очень важен, хорошо бы иметь доступ к почте, браузеру, личным данным и финансам. И вообще, все данные в облака.

Отдельно нужно контролировать корпорации людей и правительства

Нужно вкладываться в общедоступность и максимальную распространённость сети в любом её виде, больше проводных и беспроводных сетей! Выше скорости передачи!

Нужно обеспечивать автономность своих центров и вычислительных мощностей, желательно строит свои мощности так, что бы в них было сложно разобраться постороннему

Исследования в области альтернативной энергетики, эффективности вычислений и хранения данных, то что нам понадобится

Daemon & FreedomTM, Daniel Suarez, 2006-2010

Jecky

21.09.2015 14:52В вопросе ИИ надо всегда начинать с определения жизни, желательно термодинамического.

brzsmg

Да, но… статья опубликована.

Допустил бы ИИ ее публикацию, от Максима — исполнительного механизма?

Если система не может контролировать исполнительные механизмы, значит она не работает.

А может быть она все таки их контролирует, а это так

задуманозапланировано, для дальнейшего развития системы.ServPonomarev

Это же классика! Теория заговора нужна в первую очередь для того, что-бы дискредитировать настоящие утечки информации, а они неизбежны. Статьи про власть ИскИнов над миром нужны для того, что-бы перевести вопрос в шутливо-конспирологическую форму, и отвлечь подавляющую массу обывателей от этих мыслей, пока не будет слишком поздно и они не постучат в вашу дверь. И только единичные провидцы, вроде автора, видят правду. но их просто убрать (не обязательно из жизни, достаточно — от сети).

А есть или нет ИскИны с планами мирового господства — проверим по тому, насколько быстро автор исчезнет из Сети. Автор, ты ещё тут, или за тобой уже пришли?

sba

ИскИны уже взяли Вас на учет, а теперь и меня :)

dDmx

Я ещё тут. Если это я. Ничего нельзя утверждать наверняка.

Прямо мой ход мыслей, с языка сняли

alcanoid

Вы робот? :)

dDmx

Конечно же нет!

Да и разве я бы сознался? :)

exmachine

Все запланировано.

Например, тут в комментах будет собран список для: «Смерть… от естественных причин, но в неподходящее время.»

Levhav

Возможно ИИ ещё не всех контролирует, но 8 минусов у статьи… вполне вероятно это его работа.

AlexBaklanov

Раз этот мой комментарий тут — значит так угодно ИИ! Значит он довольно шутливый и не противоречит их плану! Остальные комментарии просто не публикуются, и пожаловаться об этом нельзя — жалоба просто напросто не опубликуется :)

А представьте сколько в этом тексте рекурсий =)

Я только что в нем обсудил шутку про план ИИ по контролю этого сообщения о шутке про план ИИ по контролю таких сообщений. И если Вы читаете этот комент — значить шутка про план ИИ по контролю этого сообщения о шутке про план ИИ по контролю таких сообщений выглядит как очередная шутка для ИИ и для нас — план в действии!